Untersuchungen zur kooperativen Fahrzeuglokalisierungin

Werbung

Fakultät für Elektrotechnik und Informationstechnik

Professur für Nachrichtentechnik

Diplomarbeit

Untersuchungen zur kooperativen Fahrzeuglokalisierung

in dezentralen Sensornetzen

Marcus Obst

Chemnitz, den 5. Februar 2009

Prüfer:

Prof. Dr.-Ing. Gerd Wanielik

Betreuer: Dipl.-Ing. Eric Richter

Obst, Marcus

Untersuchungen zur kooperativen Fahrzeuglokalisierung

in dezentralen Sensornetzen

Diplomarbeit, Fakultät für Elektrotechnik und Informationstechnik

Technische Universität Chemnitz, Februar 2009

Zusammenfassung

Die dynamische Schätzung der Fahrzeugposition durch Sensordatenfusion ist eine der

grundlegenden Aufgaben für moderne Verkehrsanwendungen wie zum Beispiel fahrerlose Transportsysteme oder Pre-Crash-Sicherheitssysteme.

In dieser Arbeit wird ein Verfahren zur dezentralen kooperativen Fahrzeuglokalisierung

vorgestellt, das auf einer allgemeinen Methode zur Fusion von Informationen mehrerer

Teilnehmer beruht. Sowohl die lokale als auch die übertragene Schätzung wird durch

Partikel dargestellt.

Innerhalb einer Simulation wird gezeigt, dass sich die Positionsschätzung der einzelnen

Teilnehmer im Netzwerk im Vergleich zu einer reinen GPS-basierten Lösung verbessert.

Inhaltsverzeichnis

Abbildungsverzeichnis

v

Tabellenverzeichnis

vii

Abkürzungsverzeichnis

ix

Verwendete Formelzeichen

xi

1 Einleitung

1.1 Motivation . . . . . .

1.2 Ziel der Arbeit . . .

1.3 Stand der Forschung

1.4 Aufbau der Arbeit .

.

.

.

.

1

1

2

3

4

.

.

.

.

.

.

.

.

.

.

.

.

.

5

5

7

7

8

10

11

12

13

14

15

17

18

21

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

2 Grundlagen

2.1 Prinzip der Positionsschätzung unter Unsicherheit

2.2 Wahrscheinlichkeitstheorie . . . . . . . . . . . . .

2.2.1 Wahrscheinlichkeitsdichte . . . . . . . . .

2.2.2 Normalverteilung . . . . . . . . . . . . . .

2.2.3 Bedingte Wahrscheinlichkeit . . . . . . . .

2.2.4 Satz von Bayes . . . . . . . . . . . . . . .

2.3 Markovprozess . . . . . . . . . . . . . . . . . . . .

2.4 Bayes-Filter . . . . . . . . . . . . . . . . . . . . .

2.4.1 Chapman-Kolmogorov-Gleichung . . . . .

2.4.2 Berücksichtigung von Beobachtungen . . .

2.4.3 Kalman-Filter . . . . . . . . . . . . . . . .

2.5 Globales Navigationssatellitensystem . . . . . . .

2.6 Zustandsraum und Bewegungsmodell . . . . . . .

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

3 Partikel-Filter

23

3.1 Grundgedanke . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 26

3.1.1 Repräsentation der Wahrscheinlichkeitsdichtefunktion . . . . . . 28

i

Inhaltsverzeichnis

3.2

3.3

3.4

3.5

Sequentielle Monte-Carlo-Methode . . . .

3.2.1 Monte-Carlo-Integration . . . . . .

3.2.2 Importance Sampling . . . . . . . .

3.2.3 Sequentielles Importance Sampling

3.2.4 Wahl der Proposal Density . . . . .

Resampling . . . . . . . . . . . . . . . . .

3.3.1 Resampling-Verfahren . . . . . . .

3.3.2 Weitere Verfahren und Probleme .

Bestimmung des Erwartungswertes . . . .

Varianten des Partikel-Filters . . . . . . .

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

4 Dezentralisierte Datenfusion

4.1 Problembeschreibung . . . . . . . . . . . . . . . . . . . . . . . .

4.2 Covariance Intersection . . . . . . . . . . . . . . . . . . . . . . .

4.3 DDF im Partikel-Raum . . . . . . . . . . . . . . . . . . . . . . .

4.3.1 Umwandlung in eine kontinuierliche Verteilungsfunktion

4.3.2 Fusion durch Multiplikation und Division . . . . . . . . .

5 Umsetzung – CoVelLoc

5.1 Ground Truth-Simulation . . . . . . . . . . . . . . . . . . .

5.1.1 Parameter der Ground Truth-Simulation . . . . . . .

5.2 Filter und Modelle . . . . . . . . . . . . . . . . . . . . . . .

5.2.1 Zeitsynchronität . . . . . . . . . . . . . . . . . . . . .

5.2.2 Initialisierungsproblem . . . . . . . . . . . . . . . . .

5.2.3 Ablauf der klassischen Positionsschätzung . . . . . .

5.2.4 Ablauf der dezentralisierten Positionsschätzung . . .

5.3 Einarbeiten des Differenzvektors . . . . . . . . . . . . . . . .

5.3.1 Verschiebung einer Gaußverteilung unter Unsicherheit

5.3.2 Verschiebung der Parzenverteilung . . . . . . . . . .

5.3.3 Verschiebung im Partikel-Raum . . . . . . . . . . . .

5.3.4 Verschiebung im Partikel-Raum mit Sigma-Punkten .

5.3.5 Vergleich und Auswahl . . . . . . . . . . . . . . . . .

5.4 Vermeiden von Dateninzest . . . . . . . . . . . . . . . . . .

5.4.1 Zwei unabhängige Filter pro Fahrzeug . . . . . . . .

5.4.2 Teilweise kooperative Lokalisierung . . . . . . . . . .

5.4.3 DDF im Partikel-Raum . . . . . . . . . . . . . . . .

5.5 Adaptive Anzahl der Partikel . . . . . . . . . . . . . . . . .

ii

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

29

29

31

32

35

37

40

43

44

45

.

.

.

.

.

47

48

49

51

52

54

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

57

58

59

60

60

61

62

62

64

65

68

69

71

76

77

77

77

78

78

Inhaltsverzeichnis

6 Ergebnisse

6.1 Initialisierungsphase . . . . . . . . . . . . . . . . .

6.2 Klassische Positionsschätzung . . . . . . . . . . . .

6.3 Dezentralisierte Positionsschätzung . . . . . . . . .

6.3.1 Einfluss der Anzahl von Fahrzeugen . . . . .

6.3.2 Einfluss der Genauigkeit des Differnzvektors

6.4 Einfluss der simulierten GPS-Messung . . . . . . .

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

81

81

83

86

86

89

89

7 Zusammenfassung

91

8 Schlussbemerkung und Ausblick

92

A Mathematische Gleichungen

93

A.1 Mehrdimensionale Parzen Density Estimation . . . . . . . . . . . . . . 93

B Matlab-Skripte

95

Literaturverzeichnis

97

iii

Abbildungsverzeichnis

1.1

Schematische Darstellung der kooperativen Fahrzeuglokalisierung. . . .

2

2.1

2.2

2.3

2.4

2.5

2.6

2.7

Prinzip der Positionsschätzung durch Sensordaten-Fusion. . . . . . . .

Wahrscheinlichkeit als Fläche unter der Dichtefunktion interpretiert. . .

Dichtefunktion der Standardnormalverteilung. . . . . . . . . . . . . . .

Schematische Darstellung eines Hidden Markov Modells erster Ordnung.

Das Kalman-Filter als optimale Lösung im Sinne von Bayes. . . . . . .

Positionsbestimmung eines GNSS. . . . . . . . . . . . . . . . . . . . . .

Darstellung der Komponenten des Zustandsvektors. . . . . . . . . . . .

6

9

9

13

18

19

21

3.1

3.2

3.3

24

25

3.4

3.5

3.6

3.7

3.8

3.9

Nichtlineare Transformation einer normalverteilten Zufallsvariable. . . .

Einordnung des Partikel-Filters innerhalb der Bayes-Filter. . . . . . . .

Beschreibung und Transformation einer Wahrscheinlichkeitsdichteverteilung durch Partikel . . . . . . . . . . . . . . . . . . . . . . . . . . . .

Importance Sampling-Algorithmus . . . . . . . . . . . . . . . . . . . . .

Graphische Darstellung der Partikel-Degeneration. . . . . . . . . . . . .

Schematische Darstellung des Resampling-Schrittes. . . . . . . . . . . .

Selektionsschritt des Multinomialen Resampling. . . . . . . . . . . . . .

Systematisches Resampling anhand einer diskreten Verteilung. . . . . .

Ablaufdiagramm des allgemeinen Partikel-Filter-Algorithmus. . . . . .

27

33

37

39

41

42

46

4.1

4.2

4.3

4.4

Einfluss des Parameters ω auf den CI-Algorithmus. . . . . . . . . . . .

Intuitive Multiplikation zweier Partikel-Verteilungen . . . . . . . . . . .

Multiplikation zweier Partikel-Verteilungen. . . . . . . . . . . . . . . .

Einfluss der Bandbreite h auf das Ergebnis der Parzen Density Estimation.

50

51

52

55

5.1

5.2

5.3

5.4

Systemarchitektur der kooperativen Fahrzeuglokalisierung (CoVelLoc).

Ablauf der klassischen Positionsschätzung. . . . . . . . . . . . . . . . .

Verschiebung der marginalisierten Verteilung zwischen zwei Fahrzeugen

Verschiebung der kontinuierlichen gaußschen Schätzung um den gaußschen Differenzvektor . . . . . . . . . . . . . . . . . . . . . . . . . . . .

58

63

66

v

67

Abbildungsverzeichnis

5.5

Verschiebung einer Partikel-Verteilung durch Uncertain Parzen Density

Estimation . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

5.6 Schematische Darstellung der Addition zweier Partikel-Verteilungen . .

5.7 Addition zweier Partikel-Verteilungen. . . . . . . . . . . . . . . . . . .

5.8 Beschreibung einer 1d-Normalverteilung durch Sigma-Punkte. . . . . .

5.9 Addition zweier Partikel-Verteilungen mit Sigma-Punkten. . . . . . . .

5.10 Baumartige Netztopologie . . . . . . . . . . . . . . . . . . . . . . . . .

6.1

6.2

6.3

6.4

6.5

6.6

6.7

Partikel-Verteilung nach der Initialisierung . . . . . . . . . . . . . . . .

Zeitliche Entwicklung der Partikel nach der Initialisierung. . . . . . . .

Geschätzte Position und Ground Truth eines Fahrzeuges auf Basis der

klassischen Positionsbestimmung. . . . . . . . . . . . . . . . . . . . . .

Geschätzte Position und Ground Truth eines Fahrzeuges auf Basis der

dezentralisierten Positionsschätzung. . . . . . . . . . . . . . . . . . . .

Mittlerer quadratischer Fehler des kooperativen Filters für drei Fahrzeuge.

Einschwingvorgang des Filters am Beispiel zweier Fahrzeuge. . . . . . .

Darstellung der GPS-Rohdaten . . . . . . . . . . . . . . . . . . . . . .

vi

69

71

72

73

74

79

82

84

85

87

88

88

90

Tabellenverzeichnis

3.1

Gegenüberstellung der wichtigsten Partikel-Filter-Varianten. . . . . . .

45

5.1

5.2

Standardwerte für die Simulation der Ground Truth. . . . . . . . . . .

Gegenüberstellung der Komplexität der vorgestellten Algorithmen zur

Verschiebung einer diskreten Partikel-Verteilung unter Unsicherheit. . .

59

6.1

6.2

Mittlerer quadratischer Fehler für eine verschiedene Anzahl von kommunizierenden Fahrzeugen nach 300 Zeitschritten . . . . . . . . . . . .

Mittelwert des mittleren quadratischen Fehlers von drei Fahrzeugen zu

verschiedenen Zeitpunkten für unterschiedliche Werte von σ. . . . . . .

vii

76

89

89

Abkürzungsverzeichnis

CDF

Cumulative Density Function

CI

Covariance Intersection

CoVelLoc

Cooperative Vehicle Localization

CPF

Centralised Particle Filter

CTRV

Constant Turn Rate and Velocity

DGPS

Differential Global Positioning System

DDF

Dezentrale Daten Fusion

EKF

Extended Kalman Filter

EGNOS

European Geostationary Navigation Overlay Service

GNSS

Globales Navigationssatellitensystem

GPS

Global Positioning System

HMM

Hidden Markov Model

IMU

Inertial Measurement Unit

INS

Inertiales Navigationsssytem

ITS

Intelligente Transport Systeme

KLD

Kullback-Leibler-Divergenz

PF

Partikel-Filter

KF

Kalman Filter

RMSE

Root Mean Squared Error. Mittlerer quadratischer Fehler

SIS

Sequential Importance Sampling

SIR

Sequential Importance Resampling

SMCM

Sequentielle Monte-Carlo-Methode

UKF

Unscented Kalman Filter

WDF

Wahrscheinlichkeitsdichtefunktion

ix

Verwendete Formelzeichen

X

Zufallsvariable X

Ω

Raum der Elementarereignisse einer Zufallsvariable X

Fx (x)

Verteilungsfunktion

fx (x)

Wahrscheinlichkeitsdichtefunktion

FN

approximiertes Integral durch Monte-Carlo-Methode

e

Fehler der Monte-Carlo-Integration

µ

Mittelwert

σ

Standardabweichung

σ2

Varianz

Σ

Kovarianzmatrix

N (µ, σ)

Normalverteilung mit den gegebenen Parametern

E

Erwartungswert

P (x)

Wahrscheinlichkeit

P (x, y)

Verbundwahrscheinlichkeit

P (x|y)

Bedingte Wahrscheinlichkeit

P ∗ (x)

zu P (x) proportionale Wahrscheinlichkeit

Q(x)

Proposal Density

η

Normierungskonstante

~x

Zustandsvektor

k

Zeitpunkt k

Zk

alle Messungen bis zum Zeitpunkt k

xk

Systemzustand zum Zeitpunkt k

xi

Verwendete Formelzeichen

(i,j)

∆pk,m

Doppeldifferenz zwischen Knoten k und m für Satelliten i und j

S

Partikel-Set

N

Anzahl der Partikel

Nef f

Anzahl der effektiven Partikel

ωi

Gewicht des i-ten Partikel

δ(x)

Kronecker-Delta

f~(~xk−1 )

nichtlineares Systemmodell

~h(x~k )

nichtlineares Messmodell

ωk

Prozessrauschen

vk

Messrauschen

F

Übergangswahrscheinlichkeit

K(PN , PM )

Kullback-Leibler-Abstand zwischen den Verteilungen PN und PM

h

Bandbreite für Parzen Density Estimation

hopt

optimale Bandbreite für Parzen Density Estimation

h∗

modifizierte Bandbreite für Parzen Density Estimation

d

Anzahl der Dimensionen

Vn

Fahrzeug/Vehicle n

∆d~12

gaußscher Differenzvektor

K(x)

skalierter Gaußkern

xii

1 Einleitung

Die Position eines Fahrzeuges möglichst genau zu bestimmen, ist auf dem Forschungsgebiet der Intelligenten Transport Systeme (ITS) sowohl für Sicherheitssysteme (PreCrash-Analyse) als auch Navigationssysteme ein wichtiges zu lösendes Teilproblem.

Ungeachtet der vielschichtigen Forschungsbemühungen der letzten Jahre zur Verbesserung der Genauigkeit und Zuverlässigkeit von Positionierungssystemen, existiert weiterhin eine Vielzahl ungelöster Probleme. Beispielsweise lässt sich eine hochgenaue

Positionsschätzung mit der aktuell verfügbaren Technik nur durch den Einsatz teurer Sensoren (z.B. Mehrfrequenzempfänger oder zusätzlich Fahrzeugsensoren) realisieren.

1.1 Motivation

Eine mögliche Verbesserung lässt sich durch die Zuhilfenahme kooperativer Algorithmen erreichen. Im Moment gibt es vielseitige Bestrebungen auf dem Gebiet der

IT-System, die Positionsbestimmung durch kooperative Ansätze zu verbessern. Der

Grundgedanke besteht dabei darin, eine sogenannte Fahrzug-zu-Fahrzeug-Kommunikation

(Car2Car) einzusetzen. Eine große Anzahl verschiedener Forschungsprojekte innerhalb

der EU1 und der Bundesrepublik beschäftigen sich mit dieser Problematik, um die Verkehrssicherheit und Effizienz zu erhöhen.

In der vorliegenden Arbeit soll ein möglicher Ansatz zur kooperativen Fahrzeuglokalisierung mit dem Ziel einer genaueren Positionsbestimmung vorgestellt werden.

1

An dieser Stelle sei auf die Bemühungen der Car2Car-Initiative der Europäischen Union verwiesen:

http://www.car-to-car.org/

1

1 Einleitung

1.2 Ziel der Arbeit

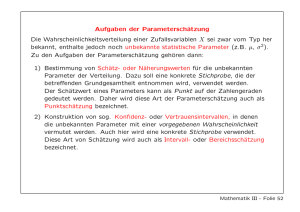

Der Grundgedanke dieser Arbeit besteht im Austausch der Messungen eines globalen Navigationssatellitensystems (GNSS) zwischen den einzelnen Teilnehmern über

ein kabelloses Übertragungsmedium. Unter der Annahme, dass alle Teilnehmer eine

Teilmenge der verfügbaren Satelliten nutzen, können systematische Fehler des GNSS

teilweise kompensiert und ein hochgenauer Differenzvektor zwischen den jeweiligen

Teilnehmern berechnet werden. Alle verfügbaren Informationen (Differenzvektor, Positionsmessung des GNSS, Geschwindigkeitsmessung der Fahrzeugsensoren) können

anschließend mit einem komplexen Datenfusionsalgorithmus zusammengeführt werden. Der in dieser Arbeit beschriebene Algorithmus basiert auf einem Partikel-Filter

in Kombination mit einem nichtlinearen Bewegungsmodell der Fahrzeuge. Mit den

verfügbaren Messwerten kann das Filter für jedes Fahrzeug im Netzwerk eine Position

schätzen, die hinsichtlich der Genauigkeit einer GNSS-Position überlegen ist. Abbildung 1.1 verdeutlicht das beschriebenen System schematisch.

GPS

GPS

GPS

Abbildung 1.1: Schematische Darstellung des in dieser Arbeit unter dem Namen CoVelLoc vorgestellten Systems zur kooperativen Fahrzeuglokalierung. Jedes Fahrzeug besitzt einen

lokalen GPS-Empfänger sowie einen Partikel-Filter. Die daraus resultierende geschätzte Position wird ständig ausgetauscht.

2

1.3 Stand der Forschung

Diese Arbeit beschreibt die Details der vorgeschlagenen kooperativen Lokalisierungsmethode mit dem Schwerpunkt auf der dezentralen Datenfusion. Die Ergebnisse werden durch eine rechnergestützte Simulation erlangt und anschließend diskutiert. Auch

der Einfluss von limitierenden Faktoren wie der verfügbaren Bandbreite wird betrachtet.

1.3 Stand der Forschung

Bisherige Forschungen zur kooperativen Fahrzeuglokalisierung werden nachfolgend vorgestellt und deren jeweilige Kernaussage erläutert. Prinzipiell lassen sich die vorgeschlagenen Lösungen in zentrale und dezentrale Verfahren einordnen. In [Sanguino,

2008] wird ein zentraler Ansatz zur Schätzung der Position von Fußgängern mit Hilfe

eines Kalman-Filters vorgestellt. Die auftretenden Korrelationen werden somit implizit

durch die Verarbeitung in einem großen Zustandsraum beachtet. Das in [Edelmayer

et al., 2008] vorgestellte System benutzt für jeden Teilnehmer ein eigenes KalmanFilter, führt die eigentlich Datenfusion aber auch auf einer zentralen Instanz, dem

Fusions-Filter, durch. In den Arbeiten [Karam et al., 2006b] und [Karam et al., 2006a]

wird ein dezentraler Ansatz vorgestellt, bei dem jedes Fahrzeug einen großen Zustandsvektor mit den Schätzungen aller Teilnehmer vorhält. Dieser wird nur durch Messwerte der lokalen Sensoren aktualisiert. Zusätzlich existiert ein weiterer Zustandsvektor,

in den empfangene Informationen eingearbeitet werden. Eine dezentrale Datenfusion

mit einem Partikel-Filter wird in [Rosencrantz et al., 2003] gezeigt. Allerdings wird

dort keine Rücksicht auf eine Korrelation der empfangenen Daten genommen. In den

Arbeiten [Ong et al., 2008], [Ong et al., 2006a] und [Ong et al., 2005b] einer australischen Forschergruppe wird erstmals ein konsistenter dezentraler Fusionsalgorithmus

auf Basis eines Partikel-Filters vorgestellt. Dabei schätzen die einzelnen Teilnehmer

den Zustand eines Objektes, es handelt sich um einen Multiple Target Tracker.

Diese Arbeit grenzt sich durch folgende Eigenschaften von den eben vorgestellten Verfahren ab:

Durch den Einsatz eines Partikel-Filters kann ein nichtlineares Bewegungsmodell

ohne Einschränkungen benutzt werden.

Der Ansatz ist vollständig dezentral. Jeder Teilnehmer schätzt nur seinen Zustand, kann aber Schätzungen von anderen Teilnehmern verarbeiten.

3

1 Einleitung

Die Anforderungen an die Netztopologie sind sehr gering. Teilnehmer können

dynamisch hinzukommen oder das Netzwerk verlassen.

Durch eine geschickte Transformation kann die empfangene Schätzung als Schätzung des eigenen Fahrzeuges interpretiert werden. Somit schätzt jeder Teilnehmer

implizit auch alle anderen Fahrzeuge.

Reduzierung der notwendigen Bandbreite zur Laufzeit möglich.

1.4 Aufbau der Arbeit

Der Aufbau der Arbeit gliedert sich wie folgt:

Im zweiten Kapitel werden grundlegende mathematische Kenntnisse, insbesondere der

Wahrscheinlichkeitstheorie, kurz erklärt. Des weiteren wird das Bayes-Filter als Grundlage des Partikel-Filters vorgestellt. Die grundsätzlichen Eigenschaften eines globalen

Navigationssatellitensystems werden genauso wie die Bedeutung eines Bewegungsmodells erläutert.

Aufbauend darauf folgt im dritten Kapitel eine umfangreiche Vorstellung des PartikelFilters. Dabei wird sowohl auf die zu Grunde liegende Monte-Carlo-Theorie eingegangen als auch eine Abgrenzung zu anderen Bayes-Filter-Implementierungen wie dem

Kalman-Filter gezogen. Abgerundet wird dieses Kapitel durch die Vorstellung von

drei in dieser Arbeit umgesetzten Resampling-Verfahren.

Im vierten Kapitel werden verschiedene Methoden zur dezentralen Datenfusion vorgestellt. Ziel ist es dabei, das Problem des Dateninzest zu vermeiden und somit ständig

eine konsistente Positionsschätzung zu gewährleisten. Neben der Covariance Intersection als grundlegende Methode, werden verschieden Verfahren zur Datenfusion im

Partikel-Raum erläutert.

Kapitel fünf gibt einen Überblick der konkreten Umsetzung innerhalb dieser Arbeit.

Das mit dem Namen CoVelLoc bezeichnet System wird vorgestellt. Die im Laufe dieser

Arbeit aufgetretenen Probleme sowie deren Lösungen werden erklärt.

Die Ergebnisse der Simulation des CoVelLoc-Systems sowie theoretische Schlussfolgerungen werden im sechsten Kapitel dargelegt.

Abschließend folgt eine Zusammenfassung sowie ein Ausblick auf zukünftige Herausforderungen.

4

2 Grundlagen

In diesem Kapitel werden mathematische Grundlagen sowie Verfahren, die für das

weitere Verständnis der Arbeit notwendig sind, erklärt. Ein besonderes Augenmerk

wird dabei auf die Wahrscheinlichkeitsrechnung, als Basis der Filtertechnologie, gelegt.

Die prinzipielle Funktionsweise der Positionsbestimmung durch GPS wird genauso wie

die Bedeutung eines Bewegungsmodells vorgestellt.

2.1 Prinzip der Positionsschätzung unter Unsicherheit

In einem Fahrzeug stehen in der Regel die Daten des ABS-Sensors, Geschwindigkeit

und Drehrate, permanent zur Verfügung. Diese Informationen werden mit einer Frequenz von 50 Hz über den Fahrzeugbus (z.B. CAN-Bus oder FlexRay) verschickt und

können anschließend ausgelesen werden. Ist die initiale Position eines Fahrzeugs bekannt, kann durch das Verfahren der Inertialen Navigation (siehe INS in [Prasad et al.,

2005] und [Grewal et al., 2001]) in Kombination mit einem Bewegungsmodell für das

Fahrzeug die Positionsschätzung erfolgen. Dazu werden die Messwerte der Sensoren in

das Bewegungsmodell eingesetzt und anschließend die neue Position bestimmt.

Im Zusammenhang mit einem Inertialen Navigations-System kann ein globales Satellitennavigationssystem (GNSS ) wie GPS oder Galileo wertvolle Dienste leisten.

Ein GNSS liefert periodisch (mit ca. 4 Hz) eine absolute Position in einem globalen

Kooardinatensystem. Diese Information kann zum einen zur Bestimmung der inertialen Position im INS-Algorithmus genutzt werden, andererseits aber auch ständig die

Schätzungen des Bewegungsmodells beurteilen und beeinflussen. Die Verschmelzung

beider Sensordaten wird in einem Filter durchgeführt. Abbildung 2.1 verdeutlicht die

Integration von INS und GNSS graphisch.

Da sowohl die Messwerte des ABS-Sensors als auch die Koordinaten, die ein GNSS

liefert, immer mit Unsicherheit behaftet sind, muss dies im Fusionsschritt berücksichtigt werden. Ein wahrscheinlichkeitstheoretischer (probabilistischer) Ansatz stellt ein

leistungsfähiges Mittel zur Bewältigung dieser Aufgabe bereit.

5

2 Grundlagen

Geschwindigkeit

Bewegungsmodell

x-/y-Position

Drehrate

Filter

(Partikel-Filter)

Ausrichtung

Eingang

(IMU)

Ausgang

(Schätzung)

x-/y-Position

Beobachtung

(GNSS/GPS)

IMU + GNSS = Sensordaten-Fusion

Abbildung 2.1: Prinzip der Positionsschätzung durch Sensordaten-Fusion. Die aus den

ABS-Sensoren (IMU) des Fahrzeugs gewonnenen Informationen werden mit Hilfe des Bewegungsmodells vorhergesagt und anhand von Beobachtungen durch ein Satellitennavigationssystem beurteilt. Zu jedem beliebigen Zeitpunkt steht eine (mit Unsicherheit behaftete)

Schätzung der Position und Ausrichtung bereit.

6

2.2 Wahrscheinlichkeitstheorie

2.2 Wahrscheinlichkeitstheorie

Die Wahrscheinlichkeitsrechnung ist ein Werkzeug, das innerhalb der vorliegenden Arbeit zur Modellierung unsicherer Prozesse genutzt wird. Die Bewegung eines Fahrzeuges unter Unsicherheit verknüpft mit der fehlerbehafteten Messung eines Positionssensors führt beispielsweise auf einen neuen Zustand. Durch die Verknüpfung dieser

beiden Informationen kann eine genauere Aussage über den Aufenthaltsort des Fahrzeuges getroffen werden, als wenn die Informationen einzeln genutzt würden. Für das

weitere Verständnis ist es deswegen wichtig, dass sowohl wahrscheinlichkeitstheoretische Notationen als auch Begriffe eingeführt werden.

Eine Zufallsvariable X kann verschiedene Werte annehmen. Der genau Zusammenhang

wird dabei durch eine reelle Funktion X(ω), die auf dem Raum Ω der Elementarereignisse definiert ist, angegeben. Die Werte X(ω), die die Zufallsvariable X annehmen

kann, nennt man Realisierungsmenge von X.

X = {x : x = X(ω), ω ∈ Ω}

(2.1)

Man unterscheidet zwischen diskreten und kontinuierlichen Zufallsvariablen. Diskrete

Zufallsvariablen besitzen ein abzählbare Menge von Realisierungen, während kontinuierliche Zufallsvariablen auf beliebige Werte abbilden. In der weiteren Betrachtung

wird ausschließlich auf kontinuierliche Zufallsvariablen eingegangen.

2.2.1 Wahrscheinlichkeitsdichte

Im Zusammenhang mit Zufallsvariablen stellt sich oft die Frage, wie wahrscheinlich

ist es, dass ein bestimmtes Ereignis x eintritt? Eine Antwort auf diese Frage liefert die

kumulative Verteilungsfunktion

Fx (x) = P (X ≤ x)

− ∞ < x < ∞.

(2.2)

Die Verteilungsfunktion Fx (x) gibt an, mit welcher Wahrscheinlichkeit P Realisierungen kleiner als eine Schranke x sind. An den Begriff der Wahrscheinlichkeit sind laut

Definition von Kolmogorov folgende drei Bedingungen [Wendel, 2007] geknüpft:

1. Die Wahrscheinlichkeit eines Ereignisses ist immer größer oder gleich Null.

2. Die Wahrscheinlichkeit eines sicheren Ereignisses ist Eins.

7

2 Grundlagen

3. Für zwei sich gegenseitig ausschließende Ereignisse ist die Wahrscheinlichkeit,

dass eines eintritt, gleich der Summe der Einzelwahrscheinlichkeiten.

Die erste Ableitung der Verteilungsfunktion ergibt die Wahrscheinlichkeitsdichtefunktion (oft abgekürzt als Dichtefunktion):

fx (x) =

dFx (x)

.

dx

(2.3)

Im Falle einer kontinuierlichen Zufallsvariable ist die Wahrscheinlichkeit dafür, dass

sie einen bestimmten Wert xi annimmt, gleich 0. Daher betrachtet man immer die

Wahrscheinlichkeit dafür, dass X in einem endlichen Intervall [a, b] liegt. Das Integral

über die Dichtefunktion liefert den gesuchten Wert.

Zb

P (a ≤ X ≤ b) =

fx (x) dx

(2.4)

a

Die Verteilungsfunktion Fx (x) erhält man als Integral über die Dichtefunktion:

Zx

Fx (x) =

fx (x) dx.

(2.5)

−∞

Die Wahrscheinlichkeit P (X ≤ x) kann mit Berücksichtigung der Grenze x als Fläche

unter der Dichtefunktion interpretiert werden (siehe Abbildung 2.2). Da Dichtefunktionen normiert sind, beträgt die Fläche unter der gesamten Kurve Eins:

Z∞

fx (x) dx = 1

(2.6)

−∞

2.2.2 Normalverteilung

Die Normal - oder Gaußverteilung (Glockenkurve) ist eine der wichtigsten kontinuierlichen Wahrscheinlichkeitsverteilungen und spielt im Rahmen der Filterung eine zentrale

Rolle. Einerseits beschreibt sie das Verhalten bestimmter Vorgänge, z.B. das einer fehlerbehafteten Sensormessung, sehr gut und zum anderen lässt sie sich mathematisch

einfach handhaben. Selbst in Anwendungsfällen, in dennen streng genommen keine

Normalverteilung vorliegt, wird man auf Grund der fehlenden Informationen oft eine

8

2.2 Wahrscheinlichkeitstheorie

fx (x)

P (X ≤ x)

x

x

0

Abbildung 2.2: Wahrscheinlichkeit als Fläche unter der Dichtefunktion interpretiert.

fx (x)

0, 4

x

µ

−σ

σ

Abbildung 2.3: Dichtefunktion der Standardnormalverteilung mit den Parametern µ = 0

und σ 2 = 1.

Normalverteilung annehmen. Die Dichte- und die Verteilungsfunktion der Normalverteilung sind durch

fx (x) = √

Fx (x) = √

1

e−

2πσ 2

Zx

1

2πσ 2

(x−µ)2

2σ 2

e−

(t−µ)2

2σ 2

(2.7)

dx

(2.8)

−∞

gegeben. Hierbei repräsentiert x die normalverteilte Zufallsvariable, σ 2 die Varianz und

µ den Mittelwert der Verteilung. Eine Besonderheit der Normalverteilung ist, dass man

sie durch die beiden Parameter µ und σ 2 vollständig parametrisch beschreiben kann.

In Abbildung 2.3 ist die Dichtefunktion einer typischen Normalverteilung mit ihren

Kennwerten dargestellt.

Die in der Literatur gebräuchliche Notation

X ∼ N (µx , σx2 )

9

2 Grundlagen

ist eine kompakte Schreibweise für die Definition einer normalverteilten Zufallsvariable

X mit dem Mittelwert µx und der Varianz σx2 .

Bisher wurde lediglich der eindimensionale Fall (x ist eine skalare Zufallsvariable)

betrachtet. Die Normalverteilung erlaubt ebenfalls eine Ausdehnung auf beliebig viele

~

Dimensionen und wird somit zu einer multivariaten Verteilung des Zufallsvektors X.

~ ∼ N (~µ, Σ)

X

(2.9)

T

1

1

~ ) Σ−1 (~x − µ

~)

fX (~x) = det(2πΣ)− 2 e 2 (~x − µ

(2.10)

Die Mittelwerte werden im Mittelwertsvektor µ

~ zusammengefasst, die Varianzen entsprechend in der Kovarianzmatrix Σ, einer positiv semidefiniten, symmetrischen Matrix, abgebildet.

2.2.3 Bedingte Wahrscheinlichkeit

Die gemeinsame Wahrscheinlichkeit zweier Zufallsvariablen X und Y bezeichnet man

als Verbundwahrscheinlichkeit, bei der für X der Wert x und für Y der Wert y eintritt.

Sie ist durch die Gleichung

P (x, y) = P (X = x und Y = y)

(2.11)

definiert. Sind beide Zufallsvariablen X und Y stochastisch voneinander unabhängig,

ergibt sich die Verbundwahrscheinlichkeit zu:

P (x, y) = P (x) · P (y)

(2.12)

Um auszudrücken, wie wahrscheinlich es ist, dass X den Wert x annimmt, unter der

Voraussetzung, dass Y bereits den Wert y angenommen hat, dient die Bedingte Wahrscheinlichkeit. Die Abhängigkeit wird wie folgt ausgedrückt:

P (x|y) = P (X = x|Y = y)

(2.13)

Sind X und Y voneinander abhängig, ergibt sich

P (x|y) =

P (x, y)

P (y)

mit P (y) > 0

P (x, y) =P (x|y) · P (y) = P (y|x) · P (x)

10

(2.14)

(2.15)

2.2 Wahrscheinlichkeitstheorie

ansonsten, für Unabhängigkeit

P (x|y) =

P (x) · P (y)

= P (x).

P (y)

(2.16)

Sind X und Y voneinander unabhängig, erhält man durch die Bedingte Wahrscheinlichkeit keine weiteren Informationen.

2.2.4 Satz von Bayes

Durch Umformen von Gleichung (2.14) und anschließender Integration über y der

Verbunddichte P (x, y) lässt sich die Dichte P (x) berechnen.

Z

Z

P (x) = P (x, y) dy = P (x|y) P (y) dy

(2.17)

Dieser Schritt wir als Marginalisierung bezeichnet und stellt zugleich die Anwendung

des Gesetzes der Totalen Wahrscheinlichkeit dar.

Aus Gleichung (2.14) und (2.15), der Bedingten Wahrscheinlichkeit, folgt direkt der

Satz von Bayes, der einen Zusammenhang zwischen P (x|y) und der Inversen“ P (y|x)

”

herstellt:

P (y|x) P (x)

P (x, y)

=

P (y)

P (y)

P (x|y) P (y)

P (x, y)

P (y|x) =

=

P (x)

P (x)

P (x, y) = P (x|y) P (y) = P (y|x) P (x)

P (x|y) =

(2.18)

(2.19)

(2.20)

Gleichungen (2.19) und (2.20) sind alternative Formulierungen des Satz von Bayes, die

für später Ableitungen in dieser Arbeit benötigt werden.

Der Satz von Bayes spielt bei der Schätzung von Systemzuständen durch Fusionieren

von Modell und Sensormessungen eine zentrale Rolle. Nimmt man an, dass x eine

Zustandsgröße ist, die aus der Messung y abgeleitet wurde, dann bezeichnet man die

Wahrscheinlichkeit P (x) als a priori-Wahrscheinlichkeitsverteilung. In P (x) sind alle

Informationen enthalten, die bis zum Zeitpunkt vor der Datenfusion mit P (y) zur Verfügung standen. Die Wahrscheinlichkeit P (x|y) wird a posteriori-Wahrscheinlichkeit

genannt. Mit dem Satz von Bayes ist es nun möglich, die gesuchte a posteriori-Wahrscheinlichkeit P (x|y) aus der inversen“ Wahrscheinlichkeitsverteilung P (y|x) und der

”

11

2 Grundlagen

a priori-Wahrscheinlichkeitsverteilung P (x) zu berechnen. Für Problemstellungen, wie

die Positionsschätzung eines sich bewegenden Objekts, gibt P (y|x) die Wahrscheinlichkeit dafür an, dass die Messung y für den Fall des Zustandes x eintritt. Die im

Zähler von Gleichung (2.18) enthaltene Wahrscheinlichkeit P (y) ist von x unabhängig

und wird deshalb als Normierungsfaktor η des Satz von Bayes bezeichnet.

P (x|y) = η P (y|x) P (x)

(2.21)

2.3 Markovprozess

Als Markovkette oder Markovprozess bezeichnet man einen stochastischen Vorgang

dessen zukünftige Entwicklung sich aus Kenntnis einer begrenzten Vorgeschichte bzw.

dem gegenwärtigen Zustand vorhersagen lässt.

P (Xn = xn |Xn−1 = xn−1 , Xn−2 = xn−2 , . . . , X1 = x1) =

P (Xn = xn |Xn−1 = xn−1 , Xn−2 = xn−2 , . . . , Xn−m = xn−m )

(2.22)

Ist für eine Vorhersage des nächsten Zustandes allein der gegenwärtige Zustand ausreichend, spricht man von einem Markov-Prozess erster Ordnung (m = 1). Der aktuelle

Zustand beinhaltet somit die gesamte Historie des Prozesses.

P (Xn = xn |Xn−1 = xn−1 )

(2.23)

Die Entwicklung von einem Zustand in den nächsten, ist durch die Übergangswahrscheinlichkeit festgelegt.

In Abbildung 2.4 ist die schematische Darstellung eines Hidden Markov Modells (HMM)

erster Ordnung zu sehen. Hidden“ bedeutet dabei, dass der Zustand xk nicht direkt

”

sichtbar ist. Die Beobachtung zk lässt allerdings Rückschlüsse auf xk zu. Der verborgene Zustand xk ist nur von seinem direkten Vorgänger xk−1 abhängig, weitere

Abhängigkeiten bestehen nicht. Für die Messung zk trifft die gleiche Annahme zu, sie

ist ausschließlich von xk abhängig.

12

2.4 Bayes-Filter

k−1

k

k+1

Zeit

zk−1

zk

zk+1

Messung

xk+1

Zustand

p(zk |xk )

xk−1

p(xk |xk−1 )

xk

Abbildung 2.4: Schematische Darstellung eines Hidden Markov Modells erster Ordnung.

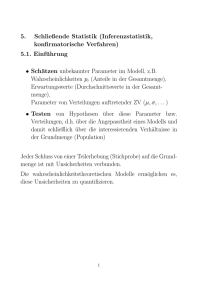

2.4 Bayes-Filter

Unter dem Bayes-Filter oder Bayes-Algorithmus versteht man ein Verfahren zur dynamischen Schätzung der a posteriori-Wahrscheinlichkeitsdichteverteilung eines Systemzustandes unter Berücksichtigung von Stellgrößen und Beobachtungen. Oftmals ist es

dabei notwendig, dass in jedem Zeitschritt k, in dem eine Beobachtung beziehungsweise Messung erfolgt, eine neue Schätzung berechnet wird. In diesem Falle spricht man

von einem rekursiven Filter. Ein rekursives Filter verarbeitet die Daten sequentiell, so

dass es nicht zwingend ist, die gesamte Historie vorzuhalten und in jedem Zeitschritt

wiederholt zu berechnen. Der übliche Ablauf gliedert sich in zwei Schritte: die Vorhersage (Prediction) und die Aktualisierung (Update). Im Vorhersageschritt wird das

Systemmodell zur Evolution der Zustandswahrscheinlichkeitsdichte von einem Beobachtungszeitpunkt zum nächsten unter Berücksichtigung von Stellgrößen verwendet.

Da der Zustandsübergang in der Regel mit Unsicherheiten behaftet ist, wird die vorhergesagte Wahrscheinlichkeitsdichtefunktion eine höhere Streuung (verglichen mit der

a posteriori-Wahrscheinlichkeitsdichte) aufweisen. Erst der Aktualisierungsschritt, der

die letzte Beobachtung einarbeitet, liefert die endgültige (meist schmalere) a posteriori Wahrscheinlichkeitsdichte des Systemzustandes. Allgemein lässt sich ein Schritt des

Bayes-Filters durch

a posteriori WDF =

Messwahrscheinlichkeit × a priori WDF

Normierungskonstante

a posteriori WDF ∝ Messwahrscheinlichkeit × a priori WDF

formulieren ( [Lefebvre et al., 2005]).

13

2 Grundlagen

Das Bayes-Filter ermittelt die Schätzung des Zustandes xk in Abhängigkeit aller verfügbaren Messungen Zk = {zi |i = 1, . . . , k} bis zum Zeitpunkt k. Dabei werden rekursiv die beiden Schritte der Vorhersage und der Aktualisierung ausgeführt. Das

Ableiten der Wahrscheinlichkeit eines neuen Zustandes aus einer Messung und dem a

priori Wissen wird oft auch als Bayes-Inferenz bezeichnet.

2.4.1 Chapman-Kolmogorov-Gleichung

Die zeitliche Entwicklung einer Dichtefunktion, also die Vorhersage von xk−1 zu xk ,

lässt sich über die Chapman-Kolmogorov-Gleichung beschreiben. Der zu schätzende

Systemzustand xk soll ein Markov-Prozess erster Ordnung sein. Daraus ergibt sich,

dass der Zustand vollständig durch xk−1 beschrieben ist, eine Abhängigkeit von weiter

zurückliegenden Systemzuständen besteht nicht. Die Eigenschaft der Vollständigkeit

wird durch folgende Gleichungen ausgedrückt:

P (xk |xk−1 , xk−2 , . . . , x0 ) = P (xk |xk−1 )

(2.24)

P (xk |xk−1 , Zk−1 ) = P (xk |xk−1 )

(2.25)

Mit Zk−1 sind alle bis zum Zeitpunkt k − 1 aufgetretenen Beobachtungen gemeint.

Hinsichtlich der Evolution von xk stellt Zk−1 allerdings keine zusätzliche Bedingung

dar, da bereits alle vorliegenden Beobachtungen in xk−1 eingeflossen sind.

Die Wahrscheinlichkeitsdichte P (xk |Zk−1 ) soll nun als Funktion von P (xk−1 |Zk−1 ) angegeben werden. Durch Integration der Verbunddichte, erhält man die marginale Dichte

Z

P (xk , Zk−1 ) = P (xk , xk−1 , Zk−1 ) dxk−1 .

(2.26)

Aufgrund der bayeschen Regel P (A, B) = P (A)P (B|A) = P (B)P (A|B) kann der

Integrand umgeschrieben werden:

Z

P (xk |xk−1 , Zk−1 )P (xk−1 , Zk−1 ) dxk−1

P (xk , Zk−1 ) =

(2.27)

Durch erneutes Anwenden der bayeschen Regel auf den zweiten Term ergibt sich

Z

P (xk , Zk−1 ) =

P (xk |xk−1 , Zk−1 )P (xk−1 |Zk−1 )P (Zk−1 ) dxk−1 .

14

(2.28)

2.4 Bayes-Filter

Da P (Zk−1 ) von Xk−1 unabhängig ist, kann die Dichte vor das Integral gezogen und

durch sie dividiert werden:

P (xk , Zk−1 )

=

P (Zk−1 )

Z

P (xk |xk−1 , Zk−1 )P (xk−1 |Zk−1 ) dxk−1

(2.29)

Die bayesche Regel auf der linken Seite der Gleichung erneut anwenden und die

Markov-Eigenschaft erster Ordnung auf der rechten Seite ausnutzen:

Z

P (xk |Zk−1 ) =

P (xk |xk−1 )P (xk−1 |Zk−1 ) dxk−1 .

(2.30)

Gleichung (2.30) wird als Chapman-Kolmogorov-Gleichung bezeichnet und beschreibt

die zeitliche Entwicklung der Wahrscheinlichkeitsdichtefunktion eines Zufallsvektors

xk .

2.4.2 Berücksichtigung von Beobachtungen

Tritt zum Zeitpunkt k eine neue Beobachtung auf, erfolgt das sogenannte BayesUpdate. Dabei wird die mittels der Chapman-Kolmogorov-Gleichung vorhergesagte

Wahrscheinlichkeitsdichtefunktion P (xk |Zk−1 ) aufgrund der letzten Beobachtung zk

aktualisiert. Die a posteriori-Wahrscheinlichkeitsdichte P (xk |Zk ) kann unter Verwendung der bayesschen Regel wie folgt berechnet werden:

P (xk |Zk ) = P (xk |zk , Zk−1 )

(2.31)

P (xk , zk , Zk−1 )

P (zk , Zk−1 )

(2.32)

=

Für Zähler und Nenner des Quotienten werden die ebenfalls über die bayessche Regel

gewonnen Zusammenhänge

P (xk , zk , Zk−1 ) = P (zk |xk , Zk−1 )P (xk , Zk−1 )

(2.33)

und

P (zk , Zk−1 ) = P (zk |Zk−1 )P (Zk−1 )

15

(2.34)

2 Grundlagen

eingesetzt:

P (xk |Zk ) =

P (zk |xk , Zk−1 )P (xk , Zk−1 )

.

P (zk |Zk−1 )P (Zk−1 )

(2.35)

Das erneute Anwenden der bayesschen Regel auf den Term P (xk , Zk−1 ) des Zählers

und anschließendes Kürzen von P (Zk−1 ) führt zu

P (xk |Zk ) =

P (zk |xk , Zk−1 )P (xk |Zk−1 )

P (zk |Zk−1 )

(2.36)

Aus der Annahme von Gleichung (2.25) folgt schließlich die vollständige Formel für

das Bayes-Update:

P (xk |Zk ) =

P (zk |xk )P (xk |Zk−1 )

P (zk |Zk−1 )

(2.37)

wobei der Term des Nenners die Normalisierungskonstate

Z

η = P (zk |Zk−1 ) =

P (zk |xk )P (xk |Zk−1 ) dxk

(2.38)

darstellt, die von der Wahrscheinlichkeit P (zk |xk ), dem Messmodell, abhängt.

Gleichung (2.37) beschreibt den Einfluss von Beobachtungen auf die Dichtefunktion

des Systemzustandes. Zusammen mit Gleichung (2.30), der zeitlichen Vorhersage des

Systemzustandes, ist damit das allgemeine zeitdiskrete Filterproblem im Sinne von

Bayes formal gelöst.

Zusammenfassend lässt sich sagen, dass der optimale bayessche Filteralgorithmus die

a posteriori-Wahrscheinlichkeitsdichte des Zustandes xk in Abhängigkeit von Beobachtungen und Steuerinformationen bis zum Zeitpunkt k schätzt. Dabei wird vorausgesetzt, dass das System als Markovprozess beschreibbar und der Zustand somit

vollständig ist. Für eine konkrete Umsetzung dieses Algorithmus sind drei Wahrscheinlichkeitsdichtefunktionen notwendig: die Initialverteilung P (x0 ), die Messwahrscheinlichkeit P (zk |xk ) sowie die Zustandsübergangswahrscheinlichkeit P (xk |xk−1 ).

Die rekursive Vorhersage der a posteriori-Wahrscheinlichkeitsdichte durch Gleichung

(2.30) und (2.37) ist allerdings nur eine konzeptionelle Lösung, die sich im Allgemeinen

nicht analytisch bestimmen lässt. Dazu wäre es notwendig, die gesamt Wahrscheinlichkeitsdichte in Form eines unendlich großen Vektors vorzuhalten. Nur für den Spezial-

16

2.4 Bayes-Filter

fall eines linearen System- und Messmodells sowie gaußverteilter Zufallsvariablen ist

eine exakte und vollständige Lösung möglich: das Kalman-Filter. Allgemeine Verfahren beruhen entweder auf Approximationen (Extended Kalman Filter oder Gaußschen

Summen-Filter) oder suboptimalen Bayes-Algorithmen wie dem Partikel-Filter.

2.4.3 Kalman-Filter

Das Kalman-Filter setzt voraus, dass sich die Wahrscheinlichkeitsdichte zu jedem Zeitpunkt durch eine Normalverteilung beschreiben lässt und damit eindeutig aufgrund

der beiden Parameter Mittelwert und Kovarianz charakterisiert ist. Wird zusätzlich

ein lineares System- und Messmodell angenommen, gelingt mit dem Kalman-Filter

eine vollständige analytische Lösung des Bayes-Algorithmus aus Abschnitt 2.4.2 . Hinsichtlich jeden Kriteriums (z.B. des mittleren quadratischen Fehlers) ist die Lösung

optimal.

Die vollständige Herleitung für das Kalman-Filter in n Dimensionen findet sich u.a.

in [Plessis, 1997] und [Zarchan und Musoff, 2005]. In diesem Abschnitt soll lediglich die

konkrete Gleichung des Bayes-Algorithmus für eine Dimension unter der Bedingung

des Kalman-Filters gezeigt und graphisch verdeutlicht werden. Nimmt man an, dass

die a priori-Wahrscheinlichkeitsdichte und die Messwahrscheinlichkeit mit

P (x) ∼ N (µ1 , σ12 )

P (z|x) ∼ N (µ2 , σ22 )

gegeben sind, dann ergbit sich die a posteriori-Wahrscheinlichkeitsdichte zu

P (x|z) ∼ N (µ̂, σ̂ 2 )

wobei

σ̂ 2 =

σ12 σ22

σ12 + σ22

µ̂ =

µ2 σ12 + µ1 σ22

.

σ12 + σ22

Damit ist eine geschlossene analytische Lösung des Bayes-Algorithmus gefunden (eine

ausführliche Herleitung findet sich in [Köhler, 2005]). In Abbildung 2.5 ist der beschriebene Sachverhalt graphisch dargestellt. Aus der unsicheren a priori-Wahrscheinlichkeitsdichte

P (x) und der Messwahrscheinlichkeit P (z|x) wird durch die Bayes-Inferenz eine neue

17

2 Grundlagen

P (x|z)

P (z|x)

P (x)

x/z

2

2, 8

6

Abbildung 2.5: Das Kalman-Filter als optimale Lösung im Sinne von Bayes. Die gaußsche

a priori WDF P (x) wird durch eine Iteration des Kalman-Filters mit der ebenfalls gaußschen

Messwahrscheinlichkeit P (z|x) kombiniert. Ergebnis ist die sicherere (da kleinere Varianz)

Aussage P (x|z). (µ1 = 6, µ2 = 2, σ12 = 4, σ22 = 1, µ̂ = 2, 8, σ̂ 2 = 0, 8)

Aussage gebildet. Die Varianz von P (x|z) ist deutlich kleiner. Im Umkehrschluss bedeutet dies gleichzeitig, dass das Wissen über den Systemzustand aufgrund einer Messung aktualisiert und verbessert wurde.

2.5 Globales Navigationssatellitensystem

Ein globales Navigationssatellitensystem (GNSS) ermöglicht den Teilnehmern die Bestimmung ihrer Position. Dazu werden die von verschiedenen Satelliten abgestrahlten

Signale empfangen und kombiniert. Heute übliche GNS-Systeme sind u.a. das amerikanische GPS (ehemals Navstar), das russische GLONASS und das sich noch im

Aufbau befindende Galileo der Europäischen Union.

Die Positionsbestimmung erfolgt durch die Messung der Laufzeit des Signales von

Satellit zu Empfänger. Da sich elektromagnetische Signale mit Lichtgeschwindigkeit

ausbreiten, ergibt sich die Entfernung zwischen Sender um Empfänger aus:

Entfernung (Pseudorange) = Lichtgeschwindigkeit × (Signallaufzeit + Zeitfehler)

Die Signallaufzeit zwischen Sender (Satellit) und Empfänger lässt noch keine eindeutige Positionsaussage zu, deswegen muss ein GNSS-Empfänger immer mit mindestens

vier unabhängigen Satelliten in Kontakt stehen und die jeweiligen Laufzeiten messen.

18

2.5 Globales Navigationssatellitensystem

Satellit 1

Unsicherheit der

Abstandsmessung

Satellit 2

Satellit 3

Unsicherheit der Position

Abbildung 2.6: Positionsbestimmung eines GNSS mit Hilfe von drei unabhängigen Satelliten. Die Laufzeitmessung zwischen dem GNSS-Empfänger und einem Satelliten liefert einen

Pseudorange. Durch die Kombination von drei Pseusoranges kann bereits eine grobe Positionsbestimmung erfolgen. Die Messung eines zusätzlichen vierten Satelliten korrigiert den

Zeitfehler.

Aus den vier Werten kann dann ein Gleichungssystem aufgestellt werden, das sich

durch ein Optimierungsverfahren (meist eine gewichtete Lösung im Sinne der kleines

Quadrate) lösen lässt: Das Ergebnis ist die aktuelle Position und Uhrzeit. Stehen mehr

Satelliten zur Verfügung, wird das Ergebnis genauer.

Genauigkeit und typische Fehlerquellen

Nachfolgend wird die zu erwartende Genauigkeit sowie typische Fehlerquellen am Beispiel von GPS erläutert.

Handelsübliche GPS-Empfänger liefern typischerweise mit einer Frequenz von ca. 4 Hz

eine absolute Position (auch GPS-Fix genannt). Die Position setzt sich dabei, je nach

Sichtbarkeit der Satelliten, aus mindestens vier Laufzeitmessungen zusammen. Die

übliche Genauigkeit liegt bei ca. 10-20 Metern1 Standardabweichung. Der Fehler besteht zum einen aus einem Offset (z.B. durch Laufzeitunterschiede der Uhren, atmosund ionisphärische Störungen) zum anderen aber auch aus sich sprunghaft ändernden

Komponenten. Gerade in Ballungsgebieten kann es zu sogenannten Multipath-Effekten

1

Unter Zuhilfenahme von Diensten wie DGPS bzw. EGNOS lassen sich durchaus Standardabweichungen von ca. 1 m erreichen. Da diese Dienster allerdings nicht immer Verfügbar sind, werden

sie in der weiteren Betrachtung nicht berücksichtigt.

19

2 Grundlagen

kommen. Die Signale der einzelnen Satelliten werden u.U. an Hauswänden reflektiert

und haben somit unterschiedliche Laufzeiten.

Pseudorange Doppeldifferenzmessung

Das in [Graas und Braasch, 1991] vorgestellte Verfahren der Smoothed Pseudorange

Double Differences erlaubt die hochgenaue Bestimmung der Relativposition zwischen

zwei GPS-Empfängern. Benutzt man diese zusätzliche Information in einem kooperativen INS/GNSS-Filter, kann die absolute Positionsbestimmung der einzelnen Teilnehmer weiter verbessert werden. In [Sanguino, 2008] wurde diese Methode erfolgreich für

die Lokalisierung von Personen eingesetzt. Die dabei angenommene Standardabweichung betrug 5 Meter. Verglichen mit der Standardabweichung eines einfachen GPSEmpfängers hat sich der Fehler halbiert.

Unter einer Pseudorange Doppeldifferenzmessung versteht man die Linearkombination

der Pseudorangemessung zwischen jeweils zwei Satelliten und zwei Empfängern. Die

Pseudorange Doppeldifferenzen werden für die Empfänger k und m mit den Satelliten

j und l wie folgt berechnet:

(j,l)

(j)

(l)

∆pk,m = ∆pk,m − ∆pk,m

(2.39)

wobei

(j)

(j)

(2.40)

(l)

(l)

(2.41)

∆pk,m = pk − p(j)

m

∆pk,m = pk − p(l)

m

die Differenzen der Pseudoranges zwischen den beiden Empfängern zum jeweils gleichen Satelliten sind.

In einer praktischen Umsetzung ist darauf zu achten, dass die für die PseudorangeDifferenzmessung verwendeten Signallaufzeiten nur eingeschränkt für die Berechnung

des GPS-Fix benutzt werden sollten, da andernfalls unbekannte Korrelationen auftreten. Werden diese nicht berücksichtigt, kann es zum Unterschätzen der Fehler und

somit zum Divergieren des Filters kommen.

20

2.6 Zustandsraum und Bewegungsmodell

y

Fahrzeug i

θi

yi

xi

x

Abbildung 2.7: Darstellung der Komponenten Position und Ausrichtung des Zustandsvektors ~xi für das i-te Fahrzeug. Diese werden mit Hilfe eines vereinfachten CTRVBewegungsmodells geschätzt und vorhergesagt.

2.6 Zustandsraum und Bewegungsmodell

Für die Positionsschätzung eines Fahrzeuges durch ein Filter bietet es sich an, die

Zustandsgrößen Position und Ausrichtung zu schätzen und in einem dreidimensionalen

Zustandsvektor

T

~x = x y θ

(2.42)

zusammenzufassen. Hierbei bezeichnen x und y die Position und θ die Ausrichtung.

Abbildung 2.7 zeigt die Bedeutung der einzelnen Größen graphisch. Da sich die Freiheitsgrade einer Bewegung von Fahrzeugen aufgrund von technischen Gegebenheiten

(wie z.B. Lenkwinkel) gut einschränken lassen, kann ein Bewegungsmodell benutzt

werden um die Komponenten des Zustandsvektors aus Gleichung (2.42) zeitlich zu

prädizieren. Ein Überblick der gängigen Bewegungsmodelle findet sich in [Schubert

et al., 2008].

In dieser Arbeit wird auf das Constant Turn Rate and Velocity-Modell (CTRV) aus

[S. S. Blackman, 1999] zurückgegriffen. Das CTRV-Modell betrachtet die Eingangsgrößen Geschwindigkeit v und Drehrate2 ω als stückweise konstante Parameter und

2

Die Drehrate gibt die Rotation um die z-Achse eines Fahrzeuges an.

21

2 Grundlagen

berechnet für ein gegebenes T die vorhergesagte Position und Ausrichtung:

v

v

sin

(ωT

+

θ

(t))

−

sin

(θ

(t))

+

x(t)

ω

ω

~x(t + T ) = − ωv cos (ωT + θ (t)) + ωv sin (θ (t)) + y(t) .

ωT

+

θ(t)

(2.43)

Für den Fall einer Geradeausfahrt (ω = 0) vereinfacht sich das Modell zu

v cos (θ (t)) T + x(t)

~x(t + T ) = v sin (θ (t)) T + y(t) .

θ(t)

(2.44)

Da der in dieser Arbeit verwendete Zustandsvektor ~x nur dreidimensional ist, ändert

sich auch die Gleichung (2.43) im Vergleich zum ursprünglichen CTRV-Modell aus

[S. S. Blackman, 1999], das zusätzlich die Größen v und ω angibt.

Obwohl das CTRV-Modell für die Modellierung einer Fahrzeugbewegung gut geeignet

ist, hat es in der hier angegebenen Form einen entscheidenden Nachteil: Das Modell

kann eine Drehung des Fahrzeuges im Stand vorhersagen, ohne dass ein reales Fahrzeug

(mit Ackermann-Lenkung, siehe [Choset et al., 2005]) dazu in der Lage wäre. Dies kann

nur durch eine zusätzliche Parameterprüfung außerhalb der CTRV-Gleichung oder ein

anderes Bewegungsmodell verhindert werden.

22

3 Partikel-Filter

Die Annahme, dass sowohl die Beobachtungen als auch der Zustandsübergang des

Systemmodells einer linearen Funktion unterliegen, sind zwingende Voraussetzungen

für den erfolgreichen Einsatz des Kalman-Filters. Das Kalman-Filter verdankt seine Effektivität der Tatsache, dass es möglich ist, die Parameter der resultierenden

Normalverteilung durch eine geschlossene analytische Lösung zu ermitteln. Unglücklicherweise werden sich die meisten realen Probleme komplexer gestalten: System- und

Messmodell sind nichtlinear. In Abbildung 3.1 ist exemplarisch dargestellt, was durch

die nichtlineare Transformation einer Normalverteilung geschieht: Im Beispiel ist das

Ergebnis P (y) eine multimodale Wahrscheinlichkeitsdichteverteilung, die nicht mehr

korrekt durch die Parameter einer Normalverteilung beschreibbar ist.

Um diesen Beschränkungen beizukommen, wurde eine Vielzahl unterschiedlicher nichtlinearer approximativer Filterverfahren entwickelt. Während einige dieser Methoden

sehr generell sind, beschränken sich andere auf spezielle Anwendungsgebiete. Nach [Ristic et al., 2004] lassen sich die nichtlinearen Filter in vier große Gruppen einteilen:

analytische Approximationen, nummerische Approximationen, gaußsche Summenfilter und Sampling-Verfahren. Einer der prominentesten Vertreter für die Zustandsschätzung nichtlinearer System ist das Erweiterte Kalman Filter (EKF) [Zarchan und

Musoff, 2005]. Das EKF beruht auf der Linearisierung des Systemmodells durch eine Taylor-Reihe erster Ordnung im Punkt des Mittelwertes der Verteilung. Dadurch

kann die Forderung der Linearität für kleine Abtastintervalle des Filters aufgeben werden. Während sich das EKF einer analytischen Approximation bedient, versucht das

Unscented Kalman Filter [Julier und Uhlmann, 1997a] die Nichtlinearität durch eine

statistische Näherung zu schätzen. Dazu wird die Verteilung anhand fest vorgegebener Stützstellen, die anschließend nichtlinear transformiert werden, beschrieben. Die

Integrale aus Gleichung (2.30) und (2.37) des Bayes-Algorithmus (siehe Abschnitt 2.4)

durch eine Summe zu ersetzen, ist ein Grundgedanke, der in Gitter-basierten Methoden

zum Einsatz kommt. Damit die nummerische Näherung im Bezug auf den kontinuierlichen Zustandsraum ausreichend gut ist, muss die Auflösung des Gitters entsprechend

fein gewählt werden. Im Zusammenhang mit mehrdimensionalen Problemen ist dies

eines der rechenintensivsten Verfahren überhaupt [Doucet und de Fretias, 2001], da die

23

3 Partikel-Filter

y

f (x)

x

P (x)

P (y)

Abbildung 3.1: Nichtlineare Transformation einer normalverteilten Zufallsvariable. Der

untere rechte Graph zeigt die ursprüngliche eindimensionale Gaußverteilung, die durch die

nichtlineare Funktion f (x) transformiert wird. Im oberen linken Graph ist das Ergebnis zu

sehen: Die wahre Wahrscheinlichkeitsdichte (blau) wird durch die Normalverteilung (rot)

nicht korrekt wiedergegeben.

Komplexität exponentiell mit der Anzahl der Dimensionen wächst. Die Schätzung einer

beliebigen Wahrscheinlichkeitsdichte durch eine Summe mehrerer Normalverteilungen

wird als gaußscher Summenfilter bezeichnet. Im Gegensatz zum EKF oder UKF lassen

sich damit sogar multimodale Probleme bearbeiten [Ristic et al., 2004]. In [Ristic et al.,

2004] wird ebenfalls darauf hingewiesen, dass die Wahl der Anzahl der Normalverteilungen und ihrer Parameter allerdings ein nicht zu unterschätzendes Problem darstellt.

Eine umfassende Vorstellung der verschiedenen Bayes-Implementierungen findet sich

in [Arulampalam et al., 2002].

Das EKF und das UKF als auch der gaußsche Summenfilter erzielen bei großen Nichtlinearitäten schlechte Ergebnisse (siehe [Thrun et al., 2005] und [Doucet und de Fretias,

2001]). Im Vergleich zu Gitter-basierten Verfahren sind sie jedoch weniger rechenintensiv. Das UKF kommt während der Linearisierung sogar ohne die Jakobimatrix aus

und wird daher auch als ableitungsfreies Filter bezeichnet.

24

Gitter-basierte

Verfahren

Topologische

Verfahren

Kalman-Filter

PartikelFilter

Extended /

Unscented

Kalman-Filter

Gaußscher

Summenfilter

diskret

kontinuierlich

Bayes-Filter

Abbildung 3.2: Einordnung des Partikel-Filters hinsichtlich der wichtigsten Bayes-Filter

Implementierungen nach [Fox, 2003]. Die gepunktet umrahmten Filter sind in der Lage optimale Lösung im Sinne von Bayes zu erzeugen.

Ein weiteres sehr vielseitiges Verfahren stellt das Partikel-Filter dar. Es handelt sich

beim Partikel-Filter um eine nichtparametrische Umsetzung des Bayes-Filters, der die

Wahrscheinlichkeitsdichteverteilung durch eine endliche Anzahl von gewichteten Stützstellen (Samples) beschreibt. Das Partikel-Filter gliedert sich in die große Gruppe der

Sequentiellen Monte-Carlo-Methoden (SMCM)1 ein und ist damit ein statistisches Verfahren. Wie der Namen bereits andeutet, liegen dabei Annahmen aus der Spieltheorie

zugrunde. Grob gesagt, versucht man durch Simulation vieler Systemzustände und

der anschließenden Bewertung in Abhängigkeit ihrer Entwicklung über der Zeit, eine

möglichst gute Schätzung des zu erwartenden Ergebnisses abzugeben. In Abbildung

3.2 ist die Einordnung des Partikel-Filters in die große Gruppe der Bayes-Filter zu

sehen ( [Fox, 2003]). Partikel-Filter zeichnen sich u.a. durch folgende Eigenschaften

aus (u.a. [Dellaert et al., 1999]):

Sie sind sehr vielseitig einsetzbar.

Sie sind einfach zu implementieren.

Im Vergleich zu Gitter-basierten Verfahren benötigen sie deutlich weniger Speicher.

Partikel-Filter können multimodale Verteilungen schätzen.

Eine Parallelisierung des Algorithmus ist ohne weiteres möglich.

1

Siehe [Hammersley und Morton, 1954] und [MacKay, 1998] als Einführung in die Monte-CarloTheorie.

25

3 Partikel-Filter

Sie erlauben das Berücksichtigen von weiteren Bedingungen: So ließe sich z.B.

für die Positionsschätzung im Zusammenhang mit einer Straßenkarte leicht eine

Plausibilitätsprüfung realisieren.

Im restlichen Teil dieses Kapitels werden die Grundlagen zum allgemeinen Verständnis

des Partikel-Filters vorgestellt. Anschließend werden spezifische Modifikationen des

Standard-Partikel-Filters, die in dieser Arbeit zum Einsatz kommen, erläutert.

3.1 Grundgedanke

Das Partikel-Filter [Gordon et al., 1993] repräsentiert die Schätzung einer Wahrscheinlichkeitsdichtefunktion durch eine endliche Anzahl N zufällig gewählter Stützstellen

der Dichtefunktion des Zustandes. Zusammen mit einem Gewicht ergibt jede Stützstelle ein sogenanntes Partikel. Die Menge aller Einzelpartikel wird im Partikel-Set S

zusammengefasst:

S = {hxi , ωi i |i = 1, . . . , N }

wobei xi jeweils einen konkreten Zustand und ωi einen nichtnegativen Wichtungsfaktor darstellt. Die Stützstellen beziehungsweise Partikel, werden dabei entsprechend der

kontinuierlichen Verteilung des Zustandes gewählt. Dies ist möglich, da eine Dualität

zwischen den Stichproben (Stützstellen) einer Verteilung und der Verteilung selbst,

aus der sie gezogen wurden, besteht [Smith und Gelfand, 1992]. Umgekehrt lässt sich

die ursprüngliche Verteilung jederzeit aus den Stichproben rekonstruieren (z.B. durch

Histogramm-Schätzung [Thrun et al., 2005] oder Kernel Density Estimation [Silverman, 1986]). Diese Annahme gilt allerdings nur für eine ausreichend große Anzahl von

Partikeln. Nach dem Gesetz der Großen Zahlen, ist die Beschreibung durch unendlich

viele Partikel identisch mit der kontinuierlichen Verteilungsfunktion. Sind es weniger

Partikel, handelt es sich dagegen um eine Approximation. In Abbildung 3.3 ist die Idee

der Darstellung durch Partikel für eine Normalverteilung zu sehen. Anstatt die Dichteverteilung durch die exponentielle Form der Normalverteilung darzustellen, werden

zufällig gezogene Partikel genutzt. Man erkennt, dass an den Stellen, an denen viele

Partikel dicht beieinander liegen (die räumliche Dichte ist hoch), die Wahrscheinlichkeit dafür, dass der wahre Systemzustand sich an diesem Ort befindet, sehr hoch ist.

Durch diese nichtparametrische Repräsentation ist es möglich, eine Vielzahl von Verteilungen zu beschreiben. Die korrekte nichtlineare Transformation der Partikel ist in

Abbildung 3.3 ebenfalls ersichtlich.

26

3.1 Grundgedanke

y

f (x)

x

P (x)

P (y)

Abbildung 3.3: Beschreibung und Transformation einer Wahrscheinlichkeitsdichteverteilung durch Partikel. Im unteren rechten Graph wurden 100 Stichproben (Partikel) aus der

Normalverteilung P (x) gezogen. Nachdem die Partikel durch die nichtlineare Funktion f (x)

transformiert wurden, sind sie entsprechend der Dichtefunktion P (y) verteilt (linker oberer

Graph) (Quelle: [Thrun et al., 2005]).

27

3 Partikel-Filter

Für die Herleitung des Partikel-Filters wird von einem nichtlinearen System- und Messmodell ausgegangen:

~xk = f~(~xk−1 ) + ω

~k

~zk = ~h(~xk ) + ~vk

(3.1)

(3.2)

Das Systemrauschen ω

~ k und das Messrauschen ~vk sind unkorreliert und werden durch

die Dichtefunktion Pω~ k und P~vk beschrieben. Es muss sich nicht zwangsläufig um eine

Normalverteilung handeln. Aus dem System- und Messmodell und den jeweiligen Dichtefunktionen des Rauschens folgt die wahrscheinlichkeitstheoretische Beschreibung des

Systemmodells, die Übergangswahrscheinlichkeit

P (xk |xk−1 ) = F(xk , f (xk−1 ), Pwk )

(3.3)

und die Beschreibung des Messmodells, die Messwahrscheinlichkeit

P (zk |xk ) = F(zk , h(xk ), Pvk ).

(3.4)

3.1.1 Repräsentation der Wahrscheinlichkeitsdichtefunktion

Die Idee des Partikel-Filters beruht auf der Darstellung einer beliebigen Wahrscheinlickeitsdichte durch eine bestimmte Anzahl von Partikeln. Durch N zufällig (aus der

Verteilung) gezogene Partikel

xi ∝ P (x|Z)

(3.5)

kann die Dichte P (x|Z) durch folgende Summe approximiert werden (Das Symbol ∝

aus Gleichung (3.5) repräsentiert hierbei das Ziehen einer Zufallszahl entsprechend

einer Wahrscheinlichkeitsdichte):

P (x|Z) ≈

N

X

ωi · δ(x − xi ).

(3.6)

i=1

P

Die Summe aller Gewichte ωi muss 1 ergeben: N

i=1 ωi = 1. Oft werden die einzelnen

Gewichte in der Initalisierungsphases des Partikel-Filters mit ωi = 1/N angenommen.

Das Kronecker-Delta δ(x), ist eine Funktion, die durch folgende Eigenschaft gekenn-

28

3.2 Sequentielle Monte-Carlo-Methode

zeichnet ist:

(

δ(x) =

0 wenn x 6= 0

1 wenn x = 0

Für N → ∞ verschwindet der Approximationsfehler und die Partikel-Darstellung

entspricht der kontinuierlichen Dichtefunktion. Gleichung (3.6) stellt dann nicht mehr

nur eine Näherung sondern ein äquivalente Beschreibung dar.

3.2 Sequentielle Monte-Carlo-Methode

Unter der Sequentiellen Monte-Carlo-Methode versteht man ein Verfahren, das einen

rekursiven (sequentiellen) Bayes-Filter durch Monte-Carlo-Simulation umsetzt2 . Wenn

eine ausreichend große Anzahl von Partikeln, die entsprechend einer Verteilung gezogen

wurden, zur Verfügung steht, können die im Allgemeinen nicht lösbaren Integrale aus

Gleichung (2.30) und (2.37) durch eine Approximation ersetzt werden. In der Praxis

ist es allerdings nur selten möglich, die Stichproben (Partikel) direkt aus der konkreten

Verteilung zu ziehen (genau diese Verteilung soll der Partikel-Filter schätzen!). Deswegen ist eine Modifikation der ursprünglichen Monte-Carlo-Methode notwendig: das

sogenannte Importance Sampling. Kurz gesagt, werden die Partikel jetzt nicht mehr

aus der ursprünglichen Verteilung gezogen, sondern aus einer dazu proportionalen, bekannten Verteilung generiert und anschließend mit einem Proportionalitätsfaktor, dem

Gewicht, versehen. Der nächste Schritt besteht darin, das Importance Sampling auf ein

rekursives Vorgehen zu erweitern. Der Sequentielle Importance Sampling-Algorithmus

(SIS) stellt somit die einfachste Form des Partikel-Filters dar. Ohne einen zusätzlichen Selektionsschritt divergiert dieser Algorithmus allerdings mit fortlaufender Zeit.

Erst die Einführung dieses als Resampling bezeichneten Zwischenschrittes in [Gordon

et al., 1993] führt zu einem robusten Verfahren. Eine umfassende Einführung in die

Monte-Carlo-Theorie findet sich in [Robert und Casella, 2004] und [Liu, 2001].

3.2.1 Monte-Carlo-Integration

Grundsätzlich lässt sich die Zielstellung der Monte-Carlo-Methode in zwei Teilprobleme zerlegen [MacKay, 1998]:

2

Partikel-Filter sind eine konkrete Umsetzung der Sequentiellen Monte-Carlo-Methode.

29

3 Partikel-Filter

Eine bestimmte Anzahl N von Stichproben aus einer gegebenen Verteilung P (x)

zu generieren.

Den Erwartungswert einer Funktion hinsichtlich der Verteilung P (x) zu schätzen.

Innerhalb des Partikel-Filters soll die a posteriori-Wahrscheinlichkeitsdichte rekursiv

geschätzt werden. Laut Bayes-Algorithmus aus Abschnitt 2.4 ist es dazu im Allgemeinen notwendig, dass mehrdimensionale Integral (2.37) zu lösen. Die Monte-CarloIntegration stellt nun ein prinzipielles Verfahren zur numerischen Bestimmung eines

mehrdimensionalen Integrals bereit. Zur Lösung des allgemeinen Integrals

Z

(3.7)

F = g(x) dx

mit x ∈ Rnx

wird die Funktion in g(x) = f (x) · P (x) zerlegt. Es wird angenommen, dass für eine

ausreichend große Anzahl N von unabhängigen Stichproben {xi |i = 1, . . . , N } aus der

Verteilung P (x), das Integral

Z

F = f (x) · P (x) dx

(3.8)

durch die Summe

N

1 X

FN =

f (xi )

N i=1

(3.9)

ersetzt werden kann. Für N → ∞ konvergiert die geschätzte Summe FN gegen den

wahren Wert des Integrals F . Der Fehler der Monte-Carlo-Integration, e = FN −

F , ist unabhängig von der Dimension nx , nur die Anzahl der Stichproben ist ausschlaggebend. Dies ist eine wertvolle Eigenschaft der Monte-Carlo-Integration, die

sie von der deterministischen, numerischen Integration der Gitter-basierten Verfahren unterscheidet. Innerhalb des Bayes-Algorithmus entspricht P (x) der a posterioriWahrscheinlichkeitsdichte des zu schätzenden Zustandes. Im Allgemeinen kann man

allerdings aus der a posteriori-Wahrscheinlichkeitsdichte keine Stichproben ziehen, da

diese meist multivariat, nichtgaußsch und nur hinsichtlich eines Proportionalitätsfaktors bekannt ist (siehe [Doucet und de Fretias, 2001] und [Ristic et al., 2004]). Der

nächste Schritt besteht in der Einführung des Importance Sampling-Algorithmus als

Alternative zur nummerischen Integration von Gleichung (3.8).

30

3.2 Sequentielle Monte-Carlo-Methode

3.2.2 Importance Sampling

Idealerweise werden die einzelnen Stichproben X direkt aus der Zielverteilung3 P gezogen. Anschließend konvergiert die Schätzung FN nach Gleichung (3.9) für N → ∞

gegen F . In der Praxis steht jedoch oft nur eine zu P proportionale Verteilung P ∗ zur

Verfügung [MacKay, 1998],

P (x) = P ∗ (x)/Z

(3.10)

die an den Stellen x ausgewertet werden kann. Das Ziehen von Stichproben ist allgemein aber weder aus P (x) noch aus P ∗ (x) möglich. Deswegen wird eine neue, einfachere, Verteilungsdichte Q(x), aus der nun Stichproben gezogen werden können, eingeführt. Auch Q(x) kann an allen Stellen x bezüglich einer multiplikativen Konstante

ZQ ausgerechnet werden.

Q(x) = Q∗ (x)/ZQ

(3.11)

Die neu eingeführte Verteilungsdichte Q wird in der Literatur mit dem Namen Sampler,

Proposal oder Importance Density bezeichnet.

Der Importance Sampling-Algorithmus schreibt vor, dass aus der Verteilung Q N

Stichproben beziehungsweise Samples {xi }N

i=1 zu ziehen sind. Hätte man die Stichproben direkt aus der Zielverteilung P gewonnen, währe die Schätzung nach Gleichung

(3.9) ausreichend. Durch das zufällige Generieren von Stichproben aus Q ist die Schätzung allerdings für Stützstellen deren Funktionswert Q(xi ) größer als P (xi ) ist, nicht

mehr korrekt. Der Schätzalgorithmus überschätzt diesen Bereich. Ist Q(xi ) hingegen

kleiner als P (xi ), wird die Wahrscheinlichkeit an dieser Stelle xi unterschätzt. Um diesen Fehler, der durch das Ziehen aus der falschen Verteilung Q zustande kommt, zu

kompensieren, wird das Gewicht ωi eingeführt:

ωi =

P ∗ (xi )

.

Q∗ (xi )

(3.12)

Mit dem Hintergedanken, dass eine Normierung der Gewichte ωi auf Eins erforderlich

3

In der englischen Literatur wird die Zielverteilung als Target Density bezeichnet.

31

3 Partikel-Filter

ist, verändert sich Gleichung (3.9) nun zu

N

P

FN =

ωi f (xi )

i=1

N

P

.

(3.13)

ωi

i=1

Damit die Gewichte in jedem möglichen Punkt berechnet werden können, ist es wichtig,

dass sowohl P als auch Q auf der selben Grundmenge definiert sind. Des weiteren

erkennt man leicht, dass das Importance Sampling nur funktionieren kann, wenn sich

P und Q ähnlich sind, d.h überdecken. In Abbildung 3.4 ist das Importance Sampling

graphisch dargestellt. Das eigentliche Ziel, Stichproben aus der Verteilung P zu ziehen

(Abbildung 3.4a) kann nicht direkt erreicht werden. Stattdessen werden Samples aus

der Verteilung Q generiert (Abbildung 3.4b). Damit die Samples aus Q überhaupt die

Verteilung P annähern, wird nun für jede Stichprobe ein Gewicht aus dem Quotienten

P (xi )/Q(xi ) gebildet. Das Ergebnis ist die Partikel-Darstellung in Abbildung 3.4c, die

eine äquivalente Beschreibung zu Abbildung 3.4a darstellt.

3.2.3 Sequentielles Importance Sampling

Das Importance Sampling ist eine allgemeine Methode zur Lösung eines mehrdimensionalen Integrals. Statt einer nummerischen Integration, wird bei der Monte-CarloSimulation eine statistische Integration vorgenommen. Dazu werden Stichproben, denen jeweils ein Gewicht zugeordnet ist, aufsummiert. Um das Importance Sampling

auf ein nichtlineares Filterproblem im Sinne des Bayes-Algorithmus anzuwenden, ist

ein weiterer Schritt notwendig: die Rekursion. Diese sequentielle oder auch rekursive

Verarbeitung stellt den grundlegenden rekursiven Monte-Carlo-Filter, das Sequential

Importance Sampling (SIS), dar. Das Partikel-Filter oder besser der SIS-Algorithmus

ist eine Umsetzung des rekursiven Bayes-Filters durch Monte-Carlo-Simulation, wobei

P ∗ der zu schätzenden a posteriori-Wahrscheinlichkeitsverteilung entspricht.

Für die Herleitung des SIS-Algorithmus ist die Betrachtung des Zustands über der Zeit

notwendig, deswegen werden nachfolgend Zeitindizes eingeführt. Es wird von folgenden

32

3.2 Sequentielle Monte-Carlo-Methode

0, 2

0, 2

0, 1

0, 1

0

−4

−2

0

2

4

6

8

(a) Die Zielverteilung P soll durch Partikel repräsentiert werden.

0

−4

−2

0

2

4

0, 1

−2

0

2

4

6

8

(c) Um die Verteilung P korrekt darzustellen werden die

Stichproben aus Q mit einem Korrekturfaktor, dem Gewicht

P (xi )/Q(xi ), versehen.

Abbildung 3.4: Darstellung und Bedeutung der Gewichte während des Importance Sampling

im Partikel-Filter-Algorithmus.

33

8

(b) Da das Generieren von Stichproben aus P nicht möglich

ist, werden Samples aus der Proposal Density Q gezogen.

0, 2

0

−4

6

3 Partikel-Filter

Festlegungen ausgegangen:

Xk = {xj | j = 0, . . . , k}

...

Folge aller Zustände bis zum Zeitpunkt k

P (Xk |Zk )

...

Verbundwahrscheinlichkeit zum Zeitpunkt k

P (xk |Zk )

< Xki , ωki > | i = 1, . . . , N

...

marginale Dichte

...

Partikel-Repräsentation von P (Xk |Zk )

P

i

wobei Xki die Stützstellen mit den zugehörigen Gewichten ωki (diese sind auf N

i=1 ωk =

1 normiert) darstellt. Die Verbundwahrscheinlichkeit kann nun durch die gewichtete

Summe in Form von Partikeln beschrieben werden:

P (Xk |Zk ) ≈

N

X

ωki δ(Xk − Xki ).

(3.14)

i=1

Die normalisierten Gewichte ωki werden nach dem Importance Sampling aus Abschnitt