Kontextnutzung bei der automatischen Begri sbildung

Werbung

Kontextnutzung bei der automatischen Begrisbildung und

Klassikation

Ute Schmid, Peter Geibel und Fritz Wysotzki

1 Vorbemerkung

Das TU-geforderte interdisziplinare Forschungsprojekt \Kognition und Kontext" war im ersten Antragszeitraum (1993-1994) aus den Teilgebieten Informatik (Formale Modelle), Psychologie und Linguistik zusammengesetz. Im zweiten Antragszeitraum (1995-1996) wurde

zusatlich das Gebiet \Kunstliche Intelligenz" (KI) beteiligt. Hauptaufgabe der KI im Projekt

war es, das den psychologischen Experimenten zum Textverstehen zugrundegelegte Konzept

der raumlichen Mentalen Modelle zu formalisieren und als Prozemodell des Textverstehens

zu implementieren. Eine ausfuhrliche Diskussion zum Thema \Mentale Modelle und Kontext"

gibt das Papier von Hornig. Die KI-Arbeiten sind unter anderem in [WSH97] dokumentiert.

Im folgenden wollen wir nicht die spezischen Arbeiten der KI-Gruppe im Projekt darstellen, sondern aufzeigen, wie das Thema Kontextnutzung bei der Begrisbildung mit Methoden des Maschinellen Lernens bearbeitet werden kann. Kontextabhangigkeit der Semantik

von Begrien war das zentrale Thema der Informatik und Linguistik im Projekt \Kognition

und Kontext".

2 Einleitung

Menschliche Informationsverarbeitung zeichnet sich durch die eziente Nutzung von Kontextinformation aus ([SHH+ 93]). Beispielsweise kann die Erkennung von Objekten ([BMR82])

oder die Festlegung von Wortbedeutungen ([Swi79]) durch Kontext erleichtert werden. Ein

wesentliches Merkmal von Kontext ist, da Relationen eines Objekts oder sprachlichen Ausdrucks zu anderen Objekten oder sprachlichen Ausdrucken zur Verfugung gestellt werden: Ein

rotes Achteck, das in Relation zu einer Strae steht, kann einfacher als Stopschild identiziert

werden, als dasselbe rote Achteck, das isoliert oder in Relation zu einem Tisch dargeboten

wird. Die Bedeutung des Nomens \Bank" kann in Relation zu \Park" oder \Geld" zu \Sitzgelegenheit" bzw. \Geldinstitut" desambiguiert werden. Ein Mann kann nur dann als Vater

identiziert werden, wenn eine Relation \ist Erzeuger" oder \ist Erziehungsberechtigter" zu

anderen Menschen (Sohnen und Tochtern) existiert.

Im folgenden stellen wir dar, wie Kontextinformation im Bereich der automatischen Informationsverarbeitung berucksichtigt werden kann. Dabei konzentrieren wir uns auf den Bereich

der Begrisbildung und Klassikation. Zunachst werden wir den klassischen Zugang zur Begrisreprasentation - den Merkmalsraum-Ansatz - darstellen und einige Probleme dieses Ansatzes aufzeigen. Im Anschlu stellen wir eine Methode zur kontextabhangigen Klassikation

vor, die von Geibel und Wysotzki ([UW81, WKS81, GW95, GW96a, GW96b]) entwickelt wurde. Wir werden darstellen, wie diese Methode zur Modellierung von Kontextinformation in den

Bereichen Szeneninterpretation und der semantischen Interpretation von naturlichsprachigen

Ausdrucken eingesetzt werden kann. Abschlieend werden wir auf Anwendungsmoglichkeiten

der kontextabhangigen Begrisbildung im Bereich raumliches Schlieen eingehen.

3 Prototypen und Merkmalsraume

U blicherweise geht man davon aus, da unser Gedachtnis nicht als Ansammlung von konkreten Objekten, mit denen wir Erfahrungen gesammelt haben, sondern durch Begrie oder

Kategorien organisiert ist. Begrie sind abstrakte Beschreibungen fur Mengen von Objekten,

die gemeinsame Eigenschaften (Merkmale) besitzen. Begrisbildung meint entsprechend, die

Konstruktion einer intensionalen aus einer extensionalen Beschreibung.

In klassischen merkmalsbasierten Ansatze, wie etwa von [KF63] oder von [SSR74], werden

Begrie durch die explizite Angabe von Merkmalslisten deniert. Die hier zugrundeliegende Annahme, da alle Mitglieder einer Kategorie bestimmte Merkmale gemeinsam haben,

die generell bestimmend fur die Klassizierung von Objekten sind, ist jedoch problematisch.

Naturliche Kategorien zeichnen sich eher dadurch aus, da die Kategoriengrenzen unscharf

und variabel sind. Beispielsweise kann gezeigt werden ([Lab73]), da die Zeichnung einer

Tasse je nach Kontext als \Tasse" (Kontext: Kaee), als \Suppenschale" (Kontext: Essen)

oder auch als \Vase" (Kontext: Blumen) identiziert wird. Die der Objektklassikation zugrundeliegenden Merkmale werden also durch den Kontext vorgegeben. Zudem kann gezeigt

werden, da bestimmte Objekte schneller als Mitglieder einer Kategorie identiziert werden

konnen als andere (z.B. \Spatz" bzw. \Huhn" als \Vogel"). Dies spricht dafur, da Objekte

entsprechend ihrer Merkmalsauspragungen als unterschiedlich typisch fur einen Begri wahrgenommen werden.

Diesen Beobachtungen tragt [Ros73] in ihrer Prototypen-Theorie Rechnung. Kategorien

werden aufgrund der Familienahnlichkeit ihrer Mitglieder gebildet. Objekte1 sind in einem

mehrdimensionalen Merkmalsraum angeordnet. Eine Kategorie entspricht einem Cluster von

Objekten fur die gilt, da sie zueinander ahnlicher sind als zu Objekten anderer Kategorien.

Der Centroid des Clusters ist der Prototyp einer Kategorie, also das Objekt, das die meisten

gemeinsamen Attribute mit allen anderen Kategoriemitgliedern besitzt. Der Prototypenansatz wurde in den Merkmalsraum-Ansatzen der KI aufgegrien (vgl. [SHH+ 93]). Es existieren

beispielsweise verschiedene Cluster-Verfahren, in denen Objekte bezuglich ihrer A hnlichkeit

auf verschiedenen Merkmalen zu Kategorien zusammengefat werden ([Leb87]). Neue Objekte

konnen - zum Beispiel mit der k-nachste-Nachbarn-Methode - einer Kategorie zugeordnet werden. Weitere Methoden sind Entscheidungsbaumverfahren ([UW81]), statistische Methoden

(Diskriminanzanalyse) sowie kunstliche neuronale Netze (Perzeptron-Algorithmen, [MP69]).

Wahrend bei Clusterverfahren die Kategorien \automatisch" gebildet werden, werden bei den

weiteren genannten Verfahren die Kategorien (Klassen) mit vorgegeben. Es wird eine (lineare) Funktion gesucht, die den Merkmalsraum in Gebiete mit gleichen Klassenzugehorigkeiten

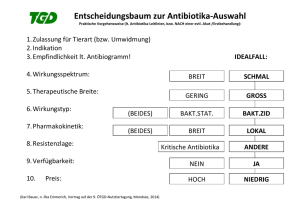

trennt (siehe Abbildung 1).

Bei allen genannten Verfahren sind die Merkmale, die der Klassikation zugrundeliegen,

vorgegeben. Eine durch Kontext induzierte unterschiedliche Betonung der Relevanz einzelner

Merkmale ist nur schwierig zu realisieren. Unterschiedliche Merkmalsraume konnten aufgrund

von Kontext-Hinweisen ausgewahlt oder aber bei Bedarf aufgebaut werden. Beide Strategien

1

Rosch unterscheidet in ihrem Ansatz nicht eindeutig zwischen Objekten (ein konkretes Exemplar der

Gattung Hund) und Begrien/Kategorien.

50

Abbildung 1: Merkmalsraum-Methoden: (a) Clusterverfahren (b) Trennung des Raums in

Gebiete gleicher Klassenzugehorigkeit

widersprechen jedoch Grundanforderungen an Speicher- oder Verarbeitungsezienz informationsverarbeitender Systeme: Eine Reprasentation durch verschiedene Kontexte indizierter

Merkmalsraumreprasentationen derselben Objekte im Gedachtnis geht auf Kosten des Speichers; die Konstruktion von Merkmalsraumen im Kontext einer aktuellen Anfrage geht auf

Kosten der Verarbeitungszeit. Alternativ konnte Kontext als weiteres Merkmal eingefuhrt

werden. Entsprechend muten Interaktionen zwischen Kontext und den ubrigen Merkmalen berucksichtigt werden. Zudem ist die Metrik von Merkmalsraumen abhangig von der

gewahlten Skalierung der Merkmale. Damit wird die Sinnhaftigkeit der Klassizierung neuer

Objekte fragwurdig. Schlielich ist es bei merkmalsbasierten Ansatzen kaum moglich, strukturierte Objekte (wie Szenen oder sprachliche Ausdrucke) zu beschreiben. Das heit, Informationen uber Beziehungen innerhalb eines komplexen Objektes oder zwischen Objekten konnen

nicht modelliert werden.

4 Kontextabhangige Begrisbildung und Klassikation

Im folgenden stellen wir ein zu Merkmalsraumkonzepten alternatives Verfahren vor, das

auf strukturierten Objekten deniert ist. Die Klassikation erfolgt kontextabhangig, indem

die verschiedenen \Rollen" die ein Objekt in verschiedenen Situationen einnehmen kann

berucksichtigt werden (vgl. das \Tasse"-Beispiel im vorangegangenen Abschnitt). Als Kontext

wird wird dabei all das betrachtet, was direkt oder indirekt mit einem Objekt in Relation

steht.

4.1 Strukturierte Objekte

Strukturierte Objekte sind Strukturen, die aus Elementarobjekten und Relationen zwischen

diesen Elementarobjekten bestehen. Wir werden im folgenden exemplarisch eine Welt aus

Spielzeugbausteinen betrachten, wie sie von P. H. Winston in einer der ersten Arbeiten zum

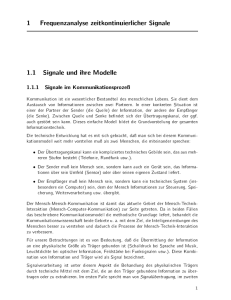

relationalen Lernen untersucht wurde ([Win75]). Beispielsweise kann das in Abbildung 2 dargestellte "Tor\ als strukturiertes Objekt aufgefat werden, bei dem die Elementarobjekte in

den Relationen \tragt", \neben" und \beruhrt nicht" zueinander stehen. Strukturierte Objekte konnen als Graphen dargestellt werden, wobei die Elementarobjekte durch die Knoten

und die Relationen durch die Kanten des Graphen reprasentiert werden. Elementarobjekte

werden durch Elementarattribute, also durch einen Merkmalsvektor im ublichen Sinne gekennzeichnet. Wir werden im folgenden nur wahrheitswertige Elementarattribute betrachten,

51

die als Markierung des jeweiligen Knotens dargestellt werden. So wird beispielsweise der linke tragende Block in Abbildung 2 durch den Knoten v1 dargestellt, der die Markierung b

tragt. Kanten werden im Graphen als gerichtete Pfeile reprasentiert, die als Markierung die

Relationen zwischen Start- und Zielknoten tragen. Gibt es mehrere Relationen, so werden

diese aus Grunden, die spater klar werden, durch + voneinander getrennt. Wir werden die

Relationssymbole s fur "tragt\ (engl. "supports), n fur "neben\ (engl. "next to\) und d fur

beruhrt nicht\ (engl. "does not touch\) verwenden. Die beiden tragenden Blocke in Abbil"dung

2 stehen beispielsweise nebeneinander und beruhren sich nicht, was durch den Ausdruck

n + d an der von v1 zu v2 fuhrenden Kante ausgedruckt wird. Da die Relationen n und d

beide symmetrisch sind, gibt es eine ebenfalls mit n + d markierte Kante, die von v2 zu v1

fuhrt.

S1:

v3

s

n+d

v1

b

b

b: block

s

v2

n+d

n: neben

d: beruehrt-nicht

s: traegt

b

Abbildung 2: Reprasentation des strukturierten Objektes S1 durch einen Graphen

In einer zugunsten der Verstandlichkeit etwas vereinfachten Form kann ein strukturiertes

Objekt als relationale Algebra S = (V; R) dargestellt werden. Die Tragermenge V enthalt die

Knotenbezeichner als Reprasentationen der Elementarobjekte des strukturierten Objektes,

wahrend in der Liste R die geltenden Relationen fur die Elementarobjekte angegeben sind.

Elementarattribute werden als einstellige Relationen in R aufgenommen. Das strukturierte

Objekt S1 in Abbildung 2 wird auf diese Weise durch die Algebra S1 = (V1; R1) mit V1 =

fv1; v2; v3g und R1 = fb(v1), b (v2), b(v3), s (v1; v3), s (v2; v3), n (v1; v2), d (v1; v2), n (v2; v1),

d (v2 ; v1)g beschrieben. Bei Verwendung von hochstens zweistelligen Relationen kann man

jeder Algebra S in eineindeutiger Weise einen Graphen G(S ) zuordnen. Wir werden deshalb

nicht zwischen der Algebra S und dem Graphen G(S ) unterscheiden.

Das Besondere und gleichzeitig das Hauptproblem der von uns gewahlten relationalen

Darstellungsweise besteht darin, da zur Beschreibung eines strukturierten Objektes wie S1

in Abbildung 2 explizite Bezeichnungen wie v1 , v2 und v3 fur die Elementarobjekte eingefuhrt

werden mussen. Denn die Wahl der Bezeichner und ihrer Reihenfolge ist nicht informationstragend und somit willkurlich. So kann man aus der Algebra S1 durch Umnumeriung der

Knoten, d.h. durch Anwendung des Isomorphismus = fv1 7! v2 ; v2 7! v3; v3 7! v1 ; g die inhaltliche gleichbedeutende, aber syntaktisch verschiedene Struktur S10 = (S1) = (fv2; v3; v1g,

fb (v2), b(v3), b (v1), s (v2; v1), s (v3; v1), n (v2; v3), d (v2; v3), n (v3; v2), d (v3; v2)g) erzeugen. Im

allgemeinen Fall kann man aus einer Ausgangsalgebra S mit n Elementarobjekten n! unterschiedliche isomorphe Varianten erzeugen, wenn man die zur Verfugung stehende Bezeichnermenge fest lat. Umgekehrt mu ein informationsverarbeitendes, z.B. ein lernendes System

in der Lage sein, isomorphe Varianten von Strukturen zu identizieren, was normalerweise zu

exponentieller Berechnungskomplexitat fuhrt.

Eine naturlichsprachliche Beschreibung des Tores in Abbildung 2 wie beispielsweise "Das

Tor besteht aus zwei tragenden und einem tragendem Block\ umgeht dieses Problem, indem

sie statt durch explizite Bezeichner die Elementarobjekte durch ihren funktionalen Kontext

52

innerhalb der Gesamtstruktur charakterisiert. Naturlich sollte sich die Beschreibung des funktionalen Kontexts nicht selbst wieder auf die Bezeichner der Elementarobjekte beziehen, da

sonst das Isomorphieproblem in abgewandelter Form wieder auftreten wurde. Diese Idee liegt

dem Ansatz von Geibel und Wysotzki zur kontextabhangige Klassikation zugrunde, der im

folgenden beschrieben werden wird. Man beachte, da die Knoten v1 und v2 in S1 nicht durch

ihren funktionalen Kontext unterschieden werden konnen. Die beiden Objekte besitzen also

dieselbe Funktion innnerhalb der Struktur. In der naturlichen Sprache spiegelt sich dies in

der Verwendung des Plurals zusammen mit der Charakterisierung der Knotenklasse ("zwei

tragende Blocke\) wieder.

Mathematisch exakt ist ein Kontext eines Knotens v 2 V eine Teilalgebra S 0 = (V 0 ; R0)

von S mit v 2 V 0 , wobei V 0 V gilt, und R0 durch Einschrankung von R auf V 0 entsteht. Die Tiefe des Kontexts eines Knotens v 2 V wird durch die maximale Entfernung

eines Kontextknotens zu v bestimmt, wobei die Entfernung bezuglich der verbindenden Relationen deniert ist. So kann man den Gesamtkontext der Tiefe 1 des Knotens v1 in S1

durch die Algebra K1(v1 ) = (fv1; v2; v3g; fb (v1); s (v1; v3); d (v1; v2); n (v1; v2)g) beschreiben. Zur Unterscheidung von Knoten benotigen wir i.a. nur einen Teil der Kontextinformation. Ziehen wir zur Unterscheidung der Knoten v1 und v3 noch den 1-Gesamtkontext

K1(v3) = (fv1; v2; v3g, fb(v3); s(v1; v3); s(v2; v3)g) von v3 heran, so stellen wir fest, da es

genugt, zur Unterscheidung die s -Relationen, also die Teilkontexte (fv1; v2g; fs (v1; v3)g) und

(fv1 ; v2; v3g, fs (v1; v3); s (v2; v3)g) zu betrachten. Dies ist auch aus der naturlichsprachlichen

Beschreibung des Tores zu ersehen. Der Kontext der Tiefe 0, also die Elementareigenschaften

genugen nicht zur Unterscheidung, da es sich bei allen Objekten um Blocke handelt.

Sollen Objekte nicht nur unterschieden werden, sondern ist diesen wie in Abbildung 3 eine

Klasse zugeordnet, so kann eine Begribeschreibung mithilfe der klassizierungsrelevanten

Kontexte bzw. Teilkontexte der Knoten erlernt werden. Im folgenden wollen wir versuchen,

eine Begrisbeschreibung fur die Klasse "Torpfeiler\ (gp fur engl. "gate post\) zu erlernen.

Objekte, die keine Torpfeiler sind, besitzen die Klasse ngp (engl. "not gate post\).

Wie oben erwahnt, sollten Kontextbeschreibungen nicht selbst von Knotenbezeichnern

abhangen. Solche isomorphieinvarianten Kontextbeschreibungen konnen mit dem im folgenden dargestellten Verfahren gewonnen werden ([GW95]). Dazu stellen wir ein strukturiertes

Objekt S = (V; R) durch seine Adjazenzmatrix A(S ) dar. Jedem Knoten v wird ein Zeilenbzw. Spaltenindex i(v ) zugeordnet. In die Diagonale der Matrix werden die Relationssymbole

der Elementarattribute eingetragen, wahrend der Eintrag an der Stelle (i(v ); i(v 0)) alle Relationssymbole r enthalt, fur die r(v; v 0) 2 R gilt. Zusatzlich wird die Inverse s0 einer Relation s

eingetragen, wenn die Beziehung s(v 0; v ) 2 R gilt, und s nicht symmetrisch ist. Die einzelnen

Relationssymbole werden mit einem + verknupft, das hier die Rolle eines Mengenoperators

spielt. Mit i(v ) = i erhalt man fur die Struktur S1 in Abbildung 2 die Adjazenzmatrix

1

0

b

n+d s

s C

A(S1) = B

A

@ n+d b

s0

s0

b

Aus der Adjazenzmatrix konnen wir die Kontexte der Tiefen 0 und 1 fur jeden Knoten ablesen.

So wird das Elementarobjekt v1 durch die erste Spalte und Zeile charakterisiert. Der 0-Kontext

von v1 umfat lediglich sein Elementarattribut b. Die erste Zeile umfat die Relationssymbole

der auslaufenden Kanten von v1 , wahrend die Spalte die einlaufenden Kanten abdeckt. Die

ein- und auslaufenden Kanten stellen zusammen den Gesamtkontext der Tiefe 1 dar. Hohere

Kontexttiefen erhalt man, wenn man die Adjazenzmatrix formal potenziert.

i

53

P

Wie ublich denieren wir das Quadrat der Matrix A = (a ) als A2 = ( a a ).

Man beachte, da die Matrizeneintrage a selbst wieder Summen von Relationssymbolen

darstellen konnen. Bei der Bildung eines Produkts a a mu darauf geachtet werden, da

die Reihenfolge der Relationssymbole nicht vertauscht wird { die Multiplikation ist also nicht

kommutativ. Hohere Potenzen der Adjazenzmatrix konnen entsprechend berechnet werden.

Auf diese Weise ergibt sich das Quadrat der Adjazenzmatrix von S1 zu

i;j

i;j

j

j;k

i;j

i;j

bb + d d + d n + nd + nn

bd + bn + d b + nb + ss 0

bs 0 + s 0 d + s 0 n + s 0 b

A(S1 ) =

2

+ ss

0

j;k

bd + bn + db + nb + ss 0

bb + dd + dn + nd + nn

bs 0 + s 0 d + s 0 n + s 0 b

+ ss

0

bs + d s + ns

bs + d s + ns

bb + 2s 0 s

+ sb

+ sb

!

Der Eintrag (1; 1) der Matrix enthalt alle zyklischen Pfade der Lange 2 des Knotens v1,

also solche, die bei v1 beginnen und enden. Das Elementarattribut b wird dabei als Schleife

aufgefat. Der Nichtdiagonaleintrag (1; 2) enthalt alle Pfade der Lange 2, die am Knoten

v1 beginnen und am Knoten v2 enden. Pfade groerer Lange erhalt man durch Berechnung

hoherer Potenzen der Adjazenzmatrix. Allgemein enthalt der Eintrag (i(v ); i(v0)) der Matrix

A alle Pfade der Lange n, die bei v beginnen und bei v0 enden.

Der n-Kontext eines Knotens v wird durch die Menge aller zyklischen, sowie ein- und

auslaufenden Pfade der Lange n zusammen mit ihrer Vielfachheit isomorphieinvariant charakterisiert. Betrachtet man nun die Pfade als Attribute des Knotens, wobei wir zyklische

Pfade als p , einlaufende als p+ und auslaufende als p schreiben, so ist ihr Attributwert fur

einen Knoten v innerhalb einer Struktur S wie folgt deniert. Fur ein Attribut p ist der

Attributwert val (p ; v ) die Anzahl des Auftretens von p in A (S )(i(v ); i(v)). Fur p ist der

Attributwert val (p ; v ) die Anzahl des Auftretens von p in den Eintragen A (S )(i(v ); i(v 0))

mit v 6= v 0. Fur p+ ist der Attributwert val (p+ ; v ) die Anzahl des Auftretens von p in den

Eintragen A (S )(i(v 0); i(v )) mit v 6= v 0 .

Es gilt also beispielsweise val (b ; v ) = 1 fur jeden Knoten v 2 V , da alle Objekte Blocke

sind. Diskriminierend zwischen den beiden Torpfeilern und dem Dach ist der Pfad s : es gilt

val (s + ; v1) = val (s + ; v2) = 0, aber val (s ; v3) = 2. Im Gegensatz zu v1 und v2 besitzt v3 zwei

einlaufende s -Kanten. Das Attribut s kann also als "wird getragen\ gedeutet werden.

Es mu erwahnt werden, da die Charakterisierung des Kontexts durch knotenfreie Pfade zwar isomorphieinvariant, jedoch nur approximativ moglich ist. D.h. man kann Beispiele

konstruieren, bei denen Knoten mit nichtisomorphem Kontext eine identische Kontextbeschreibung besitzen. Hier sind stark regulare Graphen zu nennen, die jedoch in praktischen

Anwendungen nicht auftauchen und von eher theoretischem Interesse sind. Durch komplexitatstheoretische U berlegungen kann man zeigen, da man das Problem nur umgehen kann,

indem man die Knotenbezeichner wieder einfuhrt, was dann zu einem wesentlich hoheren

Berechnungsaufwand fuhrt.

Ist nun eine Trainingsmenge gegeben, die Strukturen mit kontextabhangig klassizierten

Knoten enthalt, so kann aus dieser durch Potenzieren aller Adjazenzmatrizen und Ermittlung

der darin enthaltenen Pfade zunachst ein Attributvektor bestimmt werden. Mithilfe dieses

Attributvektors kann jedem Trainingsobjekt, also jedem Knoten innerhalb seines jeweiligen

Graphen ein Merkmalsvektor zugeordnet werden, der den Kontext des Knotens isomorphieinvariant beschreibt.

Im Beispiel aus Abbildung 3 ergeben sich die Adjazenzmatrizen der zusatzlichen Beispiele

n

c

c

c

n

n

n

c

54

S1:

ngp

v3

b

s

s

n+d

gp

v1

n+d

b

v4

ngp

v3

b

b

S2:

n+d

v1

v2

n+d

b

S3:

ngp

v3

b

s

n

v2

v1

b

ngp

b

s

ngp

ngp

s

s

ngp

gp

v2

b

n

ngp

b

Abbildung 3: Teil einer einfachen Trainingsmenge

S2 und S3 zu

1

0

b

n +d s "

B n +d b

" sC

C

A(S )=B

B@ s 0 "

A

b "C

2

und

"

s0

" b

1

0

b n s

A(S )=B

@ n b s CA

3

s 0 s0 b

wobei " die Tatsache ausdruckt, da keine Relation zwischen den Knoten besteht. Aus Platzgrunden sparen wir uns die Angabe der quadrierten Matrizen, da die Pfade auch direkt an

den Graphen abgelesen werden konnen.

Der fur diese Trainingsmenge bei Kontexttiefe 3 berechnete Attributvektor wird sehr lang.

Zur Erklarung des eigentlichen Lernverfahrens werden wir deshalb nur den Teilattributvektor

A = (b ; n ; d+; ds ; ss0 ; dss )

betrachten, in dem einige Attribute ihrer Kontexttiefe entsprechend geordnet sind. Eine Vorauswahl bzw. Vorsortierung der Attribute nach ihrer Trennfahigkeit kann auch mit statistischen und informationstheoretischen Ansatzen vorgenommen werden, s.z.B. [UW81]. Durch

Ermittlung der Attributwerte fur die Knoten in der Trainingsmenge aus Abbildung 3 erhalten wir die klassizierten Merkmalsvektoren in Tabelle 1. Im folgenden Abschnitt wollen wir

uns der Frage zuwenden, wie aus dieser Trainingsmenge ein kontextabhangiger Klassikator

gelernt werden kann.

c

c

4.2 Der Lern- und Klassikationsalgorithmus CAL2

Im Gegensatz zu Merkmalsraum-Ansatzen werden Begrie in unserem Ansatz prozedural,

durch Entscheidungsregeln (Entscheidungsbaume), reprasentiert. Ein Entscheidungsbaum

tragt an seinen Blattern Klassensymbole, wahrend die inneren Knoten mit zu testenden Eigenschaften, d.h. mit Attributen markiert sind. Die von einem Testknoten ausgehenden Kanten

55

Knoten

(S1; v1)

(S1; v2)

(S1; v3)

(S2; v1)

(S2; v2)

(S2; v3)

(S2; v4)

(S1; v1)

(S1; v2)

(S1; v3)

Merkmalsvektor

(1; 1; 1; 1; 1; 1)

(1; 1; 1; 1; 1; 1)

(1; 0; 0; 0; 0; 0)

(1; 1; 1; 1; 0; 0)

(1; 1; 1; 1; 0; 0)

(1; 0; 0; 0; 0; 0)

(1; 0; 0; 0; 0; 0)

(1; 1; 0; 0; 1; 0)

(1; 1; 0; 0; 1; 0)

(1; 0; 0; 0; 0; 0)

Klasse

gp

gp

ngp

ngp

ngp

ngp

ngp

ngp

ngp

ngp

Tabelle 1: Die transformierte Trainingsmenge

sind mit sich gegenseitig ausschlieenden Bedingungen an die getestete Eigenschaft markiert.

In einer induktiven Denition ist ein Entscheidungsbaum also entweder ein Klassenknoten c

oder aber ein zusammengesetzter Entscheidungsbaum test [bed 1 ! eb 1; : : :; bed ! eb ] mit

einem Testattribut test und zu den Bedingungen bed 1 ; : : :; bed gehorenden Unterentscheidungsbaumen eb 1 ; : : :; eb . Besitzt ein Attribut test einen endlichen Wertebereich f1; : : :; lg,

so kann bed beispielweise der Test auf den Attributwert i sein.

Soll ein neues Objekt x klassiziert werden, so wird bei einem atomaren Entscheidungsbaum eb = c das Klassensymbol c als Klassikationsergebnis (eb ; x) zuruckgeliefert.

Bei einem zusammengesetzten Entscheidungsbaum hingegen wird zunachst der Attributwert

val (test; x) berechnet. Zur weiteren Klassikation wird nun derjenige Entscheidungsbaum eb

betrachtet, dessen Bedingung bed fur den errechneten Attributwert val (test ; x) erfullt ist,

d.h. (eb ; x) = (eb ; x). Gilt keine der Bedingungen bed , so wird die Zuruckweisungsklasse

? als Klassikationsergebnis zuruckgegeben.

Ist eine Trainingsmenge mit vorklassizierten Merkmalsvektoren gegeben, so kann mit Hilfe des an psychologischen Untersuchungen orientierten inkrementellen Entscheidungsbaumverfahrens CAL2 ([UW81, WKS81]) eine intensionale Begrisbeschreibung gewonnen werden.

Man geht dazu zunachst von volligem Unwissen aus, das als atomarer Entscheidungsbaum mit

dem Klassensymbol c = ? reprasentiert wird. Nun bietet der Lehrer sukzessive die Beispiele

aus der Trainingsmenge zusammen mit ihrer tatsachlichen Klasse an. Das neue Beispiel x

mit der Klasse k wird zunachst mit dem bisher gelernten Entscheidungsbaum eb klassiziert.

Stimmen errechnete und tatsachliche Klasse uberein, d.h. gilt (eb ; x) = k so wurde das neue

Objekt richtig klassiziert. Der Entscheidungsbaum eb kann unverandert beibehalten werden,

es gilt also

eb0 = eb :

Wird hingegen die Klasse ? ermittelt, so kann der Entscheidungsbaum uber die Klasse

von x noch keine Aussage treen. Es sei blatt (eb ; x) nun derjenige Blattknoten von eb , den

x bei der Klassikation mit eb erreicht. Gilt (eb ; x) = ?, so ist blatt (eb ; x) mit ? markiert.

Ersetzt man diesen Stern durch die tatsachliche Klasse k von x, so erhalt man den neuen

Entscheidungsbaum

eb 0 = eb [blatt (eb ; x) k] ;

l

l

l

l

i

i

i

i

i

56

der x korrekt klassiziert.

Als dritten und letzten Fall nehmen wir an, da eine falsche und von ? verschiedene

Klasse k0 ausgegeben wird. Nun wird der Baum verfeinert, indem das mit k0 markierte Blatt

blatt (eb ; x) durch einen neuen Testknoten mit einem Attribut test ersetzt wird, das auf dem zu

blatt (eb ; x) fuhrenden Pfad noch nicht verwendet wurde. Da jeweils nur das gerade anliegende

Trainingsobjekt bekannt ist, hat der neue Unterbaum die Form test [1 ! ?; : : :; val (test; x) !

k; : : :; l ! ?]. Auch in diesem Fall wird x durch den neuen Baum

eb 0 = eb 0 = eb [blatt (eb ; x)

test [1 ! ?; : : :; val (test; x) ! k; : : :; l ! ?]

richtig klassiziert. Durch die vorgenommene Modikation des Baumes werden i.a. einige

vor x angebotenen Objekte nicht mehr richtig klassiziert. Deshalb mu eine endliche Trainingsmenge dem Lernverfahren solange zyklisch angeboten werden, bis alle Objekte richtig

klassizert werden.

Soll der Baum durch Hinzunahme eines neuen Attributs erweitert werden, so kann es vorkommen, da auf dem von x durchlaufenen Pfad im Baum schon alle Attribute verwendet

wurden. In diesem Fall besitzt x die gleiche Merkmalsbeschreibung wie ein anderes Trainingsbeispiel der Klasse k0, d.h. die Klassen sind nicht disjunkt. Nicht disjunkte Klassen konnen

durch Fehler beim Messen der Klasse oder von Attributwerten zustande kommen, oder dadurch, da sich die Beispiele nicht ausreichend mithilfe der verwendeten Attribute beschreiben lassen. Nichtdisjunkte Klasseneinteilungen konnen mit dem Entscheidungsbaumverfahren

CAL3 ([UW81]) erlernt werden.

Wir wollen uns nun wieder der kontextabhangigen Klassikation zuwenden und zeigen wie

man mit CAL2 aus der in Tabelle 1 dargestellten Trainingsmenge einen kontextabhangigen

Klassikator lernen kann, der das Konzept Torpfeiler beschreibt. Es sei eb(0) = ? der initiale

Baum. Das erste Objekt (S1 ; v1) mit der Klasse gp wird als ? klassiziert, d.h. zuruckgewiesen.

Gema der Fallunterscheidung von CAL2 wird der Stern durch das richtige Klassensymbol

gp ersetzt. Wir erhalten so den berichtigten Baum eb (1) = gp , der nun jedem Objekt die

Klasse gp zuordnet. Das zweite Trainingsbeispiel (S1 ; v2) hat die Klasse gp und wird deshalb

richtig klassiziert. Der Baum bleibt somit unverandert, d.h. es gilt eb (2) = eb (1) = gp .

Beim dritten Beispiel (S1; v3) mit der Klasse ngp tritt aber eine Falschklassikation auf.

Der Baum mu also unter Zuhilfenahme des ersten Attributes b verfeinert werden. Wir

erhalten so den neuen Baum eb (3) = b [0 ! ?; 1 ! ngp ]. Da alle folgenden Beispiele in

der Trainingsmenge Blocke der Klasse ngp sind, andert sich der Baum nicht, bis im nachsten

Durchlauf der Trainingsmenge vom Lehrer wiederum das Objekt (S1 ; v1) angeboten wird.

Es wird falschlicherweise als ngp klassiziert, der Baum mu also unter Verwendung eines

weiteren Tests verfeinert werden. Durch Anwendung der dritten Regel erhalten wir den neuen

Baum

20!?

"

eb (8) = b 64 1 ! n 0 ! ?

1 ! gp

c

c

c

Das nachste Beispiel (S1; v2) wird wieder richtig klassiziert. Im zehnten Lernschritt fuhrt

(S1 ; v3) zum Ersetzen von ? durch ngp . Der neue Baum ist also

eb (10)

20!?

"

= b 64 1 ! n 0 ! ngp

1 ! gp

c

57

Durch weiteres zyklisches Anbieten der Trainingsmenge erhalt man schlielich den Entscheidungsbaum

20!?

66

eb = b 666 1 ! n

4

c

2 0 ! ngp

2 0 ! ngp

66

"

64 1 ! d 64

ngp

1 ! ds 01 !

! gp

+

der alle Objekte der Trainingsmenge richtig klassiziert.

Durch Weglassen des redundanten Tests b kann dieser Baum zu

c

2 0 ! ngp

2 0 ! ngp

66

"

n 64 1 ! d 64

! ngp

1 ! ds 10 !

gp

+

vereinfacht werden. Weitere Regeln zur Vereinfachung von Entscheidungsbaumen nden sich

in [UW81]. Man beachte, da die beiden Attributs ss0 und dss nicht zum Baumaufbau

verwendet wurden. Hatte man allerdings dss als ersten Test verwendet, so hatte man eine sofortige Trennung der Klassen und damit eine wesentlich kurzere Konzeptbeschreibung

erreicht.

Um eine verstandlichere Darstellung des Konzeptes Torpfeiler in Baumform zu erhalten,

konnen wir anhand der Trainingsmenge aus den Pfaden wieder vollstandige relationale Strukturen rekonstruieren (s. [GW96b]) und erhalten so den relationalen Entscheidungsbaum

c

c

2 0 ! ngp

2 0 ! ngp

66

"

eb (v ) = n(v; v ) 64 1 ! d(v ; v ) 6

4 1 ! d(v; v ); s(v ; v ) 0 ! ngp

1 ! gp

1

2

3

3

4

als Funktion des zu klassizierenden Objektes v . Ein Torpfeiler ist nach dieser Denition also

ein Objekt, neben dem ein weiteres Objekt v1 steht, das von einem Objekt v2 nicht beruhrt

wird, und das selbst ein anderes Objekt v3 nicht beruhrt, welches wiederum ein Objekt v4

tragt. Die Information, da es sich bei v1 , v2 und v3 in den Trainingsbeispielen um ein und

dasselbe Objekt handelt, ist bei der Konstruktion der Attribute verlorengegangen, kann jedoch

aus der Trainingsmenge wiedergewonnen werden. Unter Berucksichtigung dieser Identitaten

erhalten wir aus dem zum Klassensymbol gp fuhrenden Pfad die Klassikationsregel

8 v; v ; v [n(v; v ) ^ d(v ; v) ^ (d(v; v ) ^ s(v ; v ))] ! gp (v)

1

4

1

1

1

1

4

Die Regel kann unter Berucksichtigung der Tatsache, da d eine symmetrische Relation ist,

aquivalent

8 v; v1; v4 [n(v; v1) ^ d(v; v1) ^ s(v1; v4)] ! gp (v)

umgeformt werden.

58

5 Weitere Anwendungsbeispiele

5.1 Erwerb von Prasuppositionen fur die Semantik von Aktionsverben

Die operationale Bedeutung von Aktionsverben wie z.B. "geben\ kann durch gultige und

ungultige U bergange zwischen relational beschriebenen Zustanden charakterisiert werden

([Sal79]). So stellt der Satz "Peter gibt Maria das Buch\ nur dann einen gultigen Satz dar,

wenn Peter in einer gegebenen oder vorausgesetzten Ausgangsituation das Buch tatsachlich

besitzt. Nachdem der Vorgang des Gebens abgeschlossen ist, hat das Buch den Besitzer gewechselt: Maria besitzt nun das Buch. Wenn wir davon ausgehen, da die Tiefenstruktur des

Satzes gegeben ist, dann konnen wir einen solchen Zustandsubergang wie in Abbildung 4

darstellen. Der Bezug zwischen Ausgangs- und Endsituation und der stark vereinfachten Tiefenstruktur geben(Peter, Maria, Buch) wird uber die Bezeichner der Elementarobjekte, also

Peter, Maria und Buch vermittelt. Das + zeigt an, da der Satz "Peter gibt Maria das Buch\

durch das Situationspaar korrekt charakterisiert wird. Ist beispielsweise

durch einen vorausBuch

Buch

hat

hat

+

Peter

Maria

Peter

Maria

geben(Peter,Maria,Buch)

ist

ist

Mensch

ist

ist

Gegenstand

ist

Mensch

ist

Gegenstand

Abbildung 4: Peter gibt Maria das Buch

gehenden Text die zusatzliche Information gegeben, da nicht Peter sondern Maria das Buch

besitzt, so kann das Buch nicht mehr Maria gegeben werden, und "Peter gibt Maria das Buch\

stellt keine semantisch gultige Aussage mehr dar, s. Abbildung 5.

Buch

Buch

hat

hat

Peter

Maria

Peter

Maria

geben(Peter,Maria,Buch)

ist

Mensch

ist

ist

ist

Mensch

Gegenstand

ist

ist

Gegenstand

Abbildung 5: Peter gibt Maria das Buch

Wir konnen nun das Verb "geben\ als dreistellige Operation geben (x; y; z ) mit x="Geber\,

y="Empfanger\, z="Gegebenes\

auassen, die durch ihre Modikationen am Ausgangszu-

stand und durch ihr Anwendbarkeitsbedingungen beschrieben wird. Die Abbildung 4 zeigt

eine mit + markierte gultige Anwendung der Operationen geben auf die Objekte Peter, Maria und Buch, wahrend die Abbildung 5 eine ungultige Anwendung der Operation zeigt, die

deshalb mit markiert ist. Innerhalb einer (Ausgangs-) Situation sind also Knotentripel durch

die Moglichkeit der Anwendung einer geben -Operation auf das Knotentripel kontextabhangig

als + oder klassiziert. Es liegt also eine Verallgemeinerung der im letzten Abschnitt ein59

gefuhrten kontextabhangigen Klassikation von Knoten vor.

Eine Moglichkeit zur Reprasentation von Operationen stellen Produktionsregeln dar, die

durch Add- und Delete-Listen sowie durch ihre Anwendbarkeitsbedingungen charakterisiert

werden. Die Add- und Delete-Listen fur geben (x; y; z ) konnen direkt am gultigen Beispiel

geben(Peter,Maria,Buch) aus Abbildung 4 abgelesen werden. Geloscht wird die Relation

hat(Peter,Buch), hinzugefugt wird hat(Maria,Buch). Durch Einsetzen von Variablen erhalt

man fur geben (x; y; z ) die Add-Liste [hat(y,z)] und als Delete-Liste [hat(x,z)], die auch das

Beispiel in Abbildung 6 charakterisieren. Besitzt ein weiteres Beispiel fur geben andere Addund Deletelisten, oder sogar andere Argumente (Rollen), so mu dieses Beispiel einem anderen Bedeutungstyp von geben zugeordnet werden. Unterschiedliche Bedeutungstypen eines

Verbs konnen auf diese Weise automatisch bestimmt werden.

Buch

Buch

hat

hat

+

Jerry

Tom

Tom

Jerry

geben(Tom,Jerry,Buch)

ist

ist

Tier

ist

ist

Gegenstand

ist

ist

Gegenstand

Tier

Abbildung 6: Tom gibt Jerry das Buch

Mit den Anwendbarkeitsbedingungen ist es schon etwas schwieriger. Wahlen wir die

Ausgangssituation von Abbildung 4 als sehr spezische Vorbedingung, so stellt der Zustandsubergang in Abbildung 6 keine gultige Anwendung von geben mehr dar, da Tom und

Jerry keine Menschen sind. Unter zusatzlicher Berucksichtigung des Negativbeispieles in Abbildung 7, konnen wir jedoch die allgemeinere Anwendbarkeitsbedingung hat(x,z), not gegenstand(x), not gegenstand(y) formulieren, die sowohl die Ausgangssituationen von Beispiel 4

und 6 als gultige Ausgangsituationen charakterisiert, als auch die Ausgangssituationen der

Beispiele 5 und 7 ausschliet.

Sind zusatzlich Beschreibungen von Begrishierarchien gegeben, wie z.B. 8 x mensch(x)

! lebewesen(x) und 8 x tier(x) ! lebewesen(x), so kann die Anwendbarkeitsbedingung von

geben (x; y; z ) auch als hat(x,z), lebewesen(x), lebewesen(y) dargestellt werden.

Seil

Seil

hat

hat

Buch

Buch

Hammer

Hammer

geben(Buch,Hammer,Seil)

ist

ist

ist

ist

ist

Gegenstand

ist

Gegenstand

Abbildung 7: Das Buch gibt dem Hammer das Seil

Ein Lernverfahren wie z.B. TRITOP ([GW97]) ist in der Lage die Anwendungsbedingung der Operation geben aus geeigneten Beispielausgangsituationen eines Bedeutungstyps

60

zu lernen. Die Anwendungsbedingung von geben wird dann durch den Entscheidungsbaum

21!

2

"

66 1 ! gegenstand(x) ! 64

0 ! gegenstand(y ) 10 !

D(x; y; z) = hat(x; z) 64

!+

0!

dargestellt, der als dreistellige Funktion D(x; y; z ) von Objekten (x; y; z ) in einer gegebenen

Situation die Gultigkeit der Anwendung von geben (x; y; x) angibt. Auf diese Weise konnen

nicht nur Prasuppositionen, sondern auch Selektionsbeschrankungen und mehrstellige Constraints gelernt werden.

5.2 Kontextabhangige Prozesse beim raumlichen Schlieen

Kontextabhangige Prozesse spielen auch beim raumlichen Schlieen eine Rolle. Ein moglicher

Anwendungsbereich ist der Erwerb von Routenwissen ([SW75], [HBS95], [MS95]). Routen sind

gerichtete Wege von einem Ausgangs- zu einem Zielpunkt. Wissen uber Abzweige wird lokal,

in Abhangigkeit von Wegmarken, reprasentiert, beispielsweise \wenn ich an der Apotheke

bin, mu ich die nachste Strae nach rechts einbiegen". Wegmarken sind visuell wahrnehmbare Objekte, deren Aussehen unter verschiedenen Wahrnehmungsperspektiven variieren kann.

Die Aufgabe ist also, eine Wegmarke im Kontext unterschiedlicher Blickrichtungen zu identizieren. In informationsarmen Umgebungen, wie beispielsweise bei Fluren mit Turen und

Abzweigen, ist es zusatzlich notig, bei gegebener Perspektive gleichaussehende Wegmarken

(ein Abzweig, eine Tur) durch Kontextinformation zu diskriminieren.

Im zweiten Fall kann unser Verfahren zur kontextabhangigen Klassikation unmittelbar eingesetzt werden. Ein Weg wird durch Wegmarken als Knoten und Verbindungen als

Kanten reprasentiert. Es wird solange die Kontexttiefe erweitert, bis alle Wegmarken unterscheidbar sind, also alle Diagonalelemente der Adjazenzmatrix unterschiedlich sind. Im

ersten Fall kann folgende Strategie verfolgt werden: Jede Wegmarke wird als strukturiertes

Objekt reprasentiert. Dabei erhalten identische Wegmarken, die aus unterschiedlichen Blickperspektiven wahrgenommen wurden, gleiche Klassenbezeichnungen. Durch unser Verfahren

zur kontextabhangigen Klassikation werden dann diejenigen Teilstrukturen jeder Wegmarke

identiziert, die unter allen Perspektiven invariant bleiben. Die Klassikationsaufgabe ist nun

nicht mehr, ein Elementarobjekt durch seine Relationen zu anderen Objekten zu charakterisieren, sondern, Strukturmerkmale zu identizieren, die ein komplexes Objekt (oder eine

Klasse von Objekten) eindeutig charakterisiert. Betrachten wir das Torbeispiel aus Abschnitt

3.1 (Abbildung 2), entsprache dies der Aufgabe, Objekt S1 als \Tor" und Objekte S2 bis S3 als

\Nicht-Tor" zu klassizieren. Diese Aufgabe kann ebenfalls mit unserem Verfahren realisiert

werden ([GW96a, GW96b]).

6 Diskussion

Wir haben dafur argumentiert, Kontext als all das zu betrachten, was zu einem Objekt direkt

oder indirekt in Relation steht und ein Verfahren zur automatischen Begrisklassikation

vorgestellt, das Kontext in diesem Sinne berucksichtigt. Die dabei erzeugten Klassikationen

reprasentieren Begrie als abstrakte relationale Strukturen, die die Rolle bzw. Funktion von

Objekten beschreiben. Begrie sind in unserem Ansatz also funktional charakterisiert. Neue

61

Objekte konnen einem Begri zugeordnet werden, indem diese abstrakten Strukturen als

sequentielle Entscheidungsregeln aufgefat werden, mit denen gepruft werden kann, ob ein

Objekt bestimmten Selektionsbeschrankungen genugt. Begrie sind in unserem Ansatz also

sowohl strukturell als auch prozedural (Entscheidungsregeln) reprasentiert.

\Begri" ist in unserem Ansatz sehr weit gefat. Ein Begri ist eine abstrakte Reprasentation, die aus Wahrnehmungsinformation oder aus sprachlicher Information aufgebaut werden kann. Damit entsprechen Begrie dem von [Kos80] geforderten abstrakten Reprasentationsformat, das sprachlichen und visuellen Realisierungen zugrunde liegt. Auch Problemlosewissen, das beispielsweise als Produktionsregeln reprasentiert werden kann, kann in

unserem Sinne als \Begri" aufgefat werden. So haben wir in Abschnitt 4.3 dargestellt, wie

Prasuppositionen fur die Semantik von Aktionsverben erworben werden konnen. Behandelt

man Problemloseoperatoren analog zu solchen Aktionsverben, kann der Erwerb von Anwendungsbedingungen fur Operatoren, also Produktionsregeln in unserem Ansatz beschrieben

werden.

Literatur

[BMR82] I. Biedermann, R.J. Mezzanotte, and J.C. Rabinowitz. Scene perception: Detecting

and judging objects undergoing relational violations. Cognitive Psychology, 14:143{

177, 1982.

[GW95] Peter Geibel and Fritz Wysotzki. Induction of Context Dependent Concepts. In

Proceedings of the 5th International Workshop on Inductive Logic Programming,

Leuven, Belgium, 1995.

[GW96a] Peter Geibel and Fritz Wysotzki. Learning relational concepts with decision trees.

In Lorenza Saitta, editor, Machine Learning: Proceedings of the Thirteenth International Conference. Morgan Kaufmann Publishers, San Fransisco, CA, 1996.

[GW96b] Peter Geibel and Fritz Wysotzki. Relational learning with decision trees. In

W. Wahlster, editor, Proceedings of the 12th European Conference on Articial

Intelligence. John Wiley and Sons, Ltd., 1996.

[GW97] Peter Geibel and Fritz Wysotzki. A logical framework for graph theoretic decision

tree learning. Proc. ILP-97, to appear, 1997.

[HBS95] T. Hermann, H. Buhl, and K. Schweizer. Zur blickpunktbezogenen Wissensreprasentation: Der Richtungseekt. Zeitschrift fur Psychologie, 203:1{23, 1995.

[KF63] J.J. Katz and J.A. Fodor. The structure of a semantic theory. Language, 39:170{

210, 1963.

[Kos80] S. Kosslyn. Image and Mind. Harvard UP, Cambridge, MA, 1980.

[Lab73] W. Labov. The boundaries of words and their meanings. In C.-J.N. Bailey and

R.W. Shuy, editors, New Ways of Analysing Variation in English, pages 340{373.

Georgetown University Press, Washington, DC, 1973.

[Leb87] M. Lebowitz. Experiments with incremental concept formation: Unimem. Machine

Learning, 2:103{138, 1987.

62

[MP69]

[MS95]

[Ros73]

[Sal79]

[SHH+ 93]

[SSR74]

[SW75]

[Swi79]

[UW81]

[Win75]

[WKS81]

[WSH97]

M.L. Minsky and S. Papert. Perceptrons, an introduction to computational geometry. MIT Press, Cambridge, MA, 1969.

H. A. Mallot and B. Scholkopf. Learning of cognitive maps from sequences of views.

In Proc. of the European Symposium on Articial Neural Networks, Brussels, 1995.

E.H. Rosch. Natural categories. Cognitive Psychology, 4:328{350, 1973.

Sharon C. Salveter. Inferring conceptual graphs. Cognitive Science, 3(2):141{166,

1979.

G. Strube, C. Habel, B. Hemforth, L. Konieczny, and B. Becker. Kognition.

In G. Gorz, editor, Einfurung in die Kunstliche Intelligenz, chapter 4. AddisonWesley, Bonn, 1993.

E.E. Smith, E.J. Shoben, and L.J. Rips. Structure and process in semantic memory:

A feature model for semantic decisions. Psychological Review, 81:214{241, 1974.

A.W. Siegel and S. H. White. The development of spatial representations of large/scale environments. In H. W. Reese, editor, Advances in Child Development

and Behavior, volume 10, pages 1{55. Academic Press, New York, 1975.

D. A. Swinney. Lexical access during sentence comprehension: (Re)consideration

of context eects. Journal of Verbal Learning and Vebal Behavior, 18:645{659,

1979.

S. Unger and F. Wysotzki. Lernfahige Klassizierungssysteme. Akademie-Verlag,

Berlin, 1981.

P.H. Winston. Learning structural descriptions from exmaples. In P. H. Winston,

editor, The Psychology of Computer Vision, pages pp. 157{210. McGraw-Hill, .

New York, 1975.

F. Wysotzki, W. Kolbe, and J. Selbig. Concept Learning by Structured Examples

- An Algebraic Approach. In Proceedings of the Seventh IJCAI, 1981.

F. Wysotzki, U. Schmid, and E. Heymann. Modellierung raumlicher Inferenzen

durch Graphen mit symbolischen und numerischen Constraints. In C. Umbach,

M. Grabski and R. Hornig, editors, Perspektive in Sprache und Raum, pages 105126. DUV, Wiesbaden, 1997.

63