Rechner-Arithmetik

Werbung

Rechner-Arithmetik

Vorlesung im SS 2001/2002

Norbert Th. Müller

Abteilung Informatik

Universität Trier

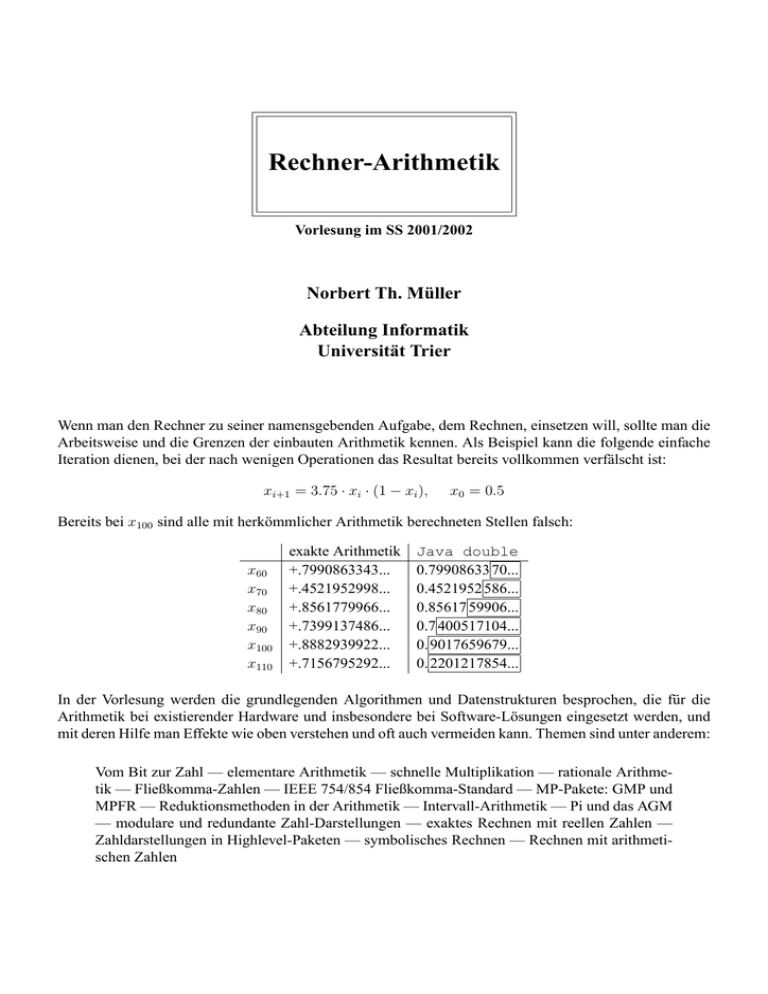

Wenn man den Rechner zu seiner namensgebenden Aufgabe, dem Rechnen, einsetzen will, sollte man die

Arbeitsweise und die Grenzen der einbauten Arithmetik kennen. Als Beispiel kann die folgende einfache

Iteration dienen, bei der nach wenigen Operationen das Resultat bereits vollkommen verfälscht ist:

xi+1 = 3.75 · xi · (1 − xi ),

x0 = 0.5

Bereits bei x100 sind alle mit herkömmlicher Arithmetik berechneten Stellen falsch:

x60

x70

x80

x90

x100

x110

exakte Arithmetik

+.7990863343...

+.4521952998...

+.8561779966...

+.7399137486...

+.8882939922...

+.7156795292...

Java double

0.79908633 70...

0.4521952 586...

0.85617 59906...

0.7 400517104...

0. 9017659679...

0. 2201217854...

In der Vorlesung werden die grundlegenden Algorithmen und Datenstrukturen besprochen, die für die

Arithmetik bei existierender Hardware und insbesondere bei Software-Lösungen eingesetzt werden, und

mit deren Hilfe man Effekte wie oben verstehen und oft auch vermeiden kann. Themen sind unter anderem:

Vom Bit zur Zahl — elementare Arithmetik — schnelle Multiplikation — rationale Arithmetik — Fließkomma-Zahlen — IEEE 754/854 Fließkomma-Standard — MP-Pakete: GMP und

MPFR — Reduktionsmethoden in der Arithmetik — Intervall-Arithmetik — Pi und das AGM

— modulare und redundante Zahl-Darstellungen — exaktes Rechnen mit reellen Zahlen —

Zahldarstellungen in Highlevel-Paketen — symbolisches Rechnen — Rechnen mit arithmetischen Zahlen

Inhaltsverzeichnis

Literatur

Inhaltsverzeichnis

1 Einleitung

1.1 ganzzahlige Arithmetik .

1.2 Lineare Algebra . . . . .

1.3 Grenzwerte . . . . . . .

1.4 Iterierte Funktionen . . .

1.5 Die Ariane-5-Explosion .

1.6 Der Pentium-Bug . . . .

1.7 Der Patriot-Scud-Vorfall

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

6

6

7

7

9

9

10

12

2 Natürliche / ganze Zahlen

2.1 Notationen, natürliche Zahlen und Berechenbarkeit

2.2 Ganze Zahlen . . . . . . . . . . . . . . . . . . . .

2.3 Die Multiplikation natürlicher Zahlen . . . . . . .

2.4 Divisions-Algorithmen . . . . . . . . . . . . . . .

2.5 Redundante Zahl-Notationen . . . . . . . . . . . .

2.6 Modulare Arithmetik . . . . . . . . . . . . . . . .

2.7 Kompakte Notationen . . . . . . . . . . . . . . . .

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

13

13

26

28

31

33

35

36

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

3 Rechnen mit rationalen Zahlen

38

4 Fließkomma-Arithmetik

42

5 Intervall-Arithmetik

68

6 Darstellungen und Orakel-Turingmaschinen

72

7 Berechenbarkeit und topologische Räume

85

Literatur

[Av61] A. Avizienis, Signed-Digit Number Representations for Fast Parallel Arithmetic, IRE Transactions on Electronic Computers Vol. EC-10 (1961) 389-400 34

[Ba88] D.H. Bailey, The computation of π to 29,360,000 Decimal Digits Using Borweins Quartically Convergent

Algorithm Mathematics of Computation Vol. 50 Number 181 (1988) 238-296

[Bo87] J.M. Borwein & P.B. Borwein, Pi and the AGM, A study in analythic number theory, Wiley, New York,

1987

[BoCa90] H. Boehm & R. Cartwright, Exact Real Arithmetic: Formulating real numbers as functions. In T. D.,

editor, Research Topics in Functional Programming, 43-64 (Addison-Wesley, 1990)

[BSS89] L. Blum & M. Shub & S. Smale, On a theory of computation and complexity over the real numbers:

NP-completeness, recursive functions and universal machines, Bulletin of the AMS 21, 1, July 1989

[Bt75] R.P. Brent, The complexity of multiple precision arithmetic, Proc. Seminar on Complexity of Computational

Problem Solving, Queensland U. Press, Brisbane, Australia (1975) 126-165

2

Literatur

Literatur

[Bt76] R.P. Brent, Fast multiple precision evaluation of elementary functions, J. ACM 23 (1976) 242-251

[Bt78] R.P. Brent, A Fortran multiple precision package, ACM Trans. Math. Software 4 (1978), pp 57-70

[Br96] V. Brattka, Recursive characterisation of computable real-valued functions and relations, Theoret. Comput.

Sci. 162 (1996),47-77

[Br99] V. Brattka, Recursive and Computable Operations over Topological Structures, Thesis, Informatik Berichte

255 - 7/1999, FernUniversität Hagen

[BrHe94] V. Brattka & P. Hertling, Continuity and Computability of Relations, Informatik Berichte 164 - 9/1994,

FernUniversität Hagen,

[BrHe95] V. Brattka & P. Hertling, Feasible Real Random Access Machines, Informatik Berichte 193 - 12/1995,

FernUniversität Hagen,

[BrHe98] V. Brattka & P. Hertling, Feasible Real Random Access Machines, Journal of Complexity 14(4):490526,1998

[Bro12] L. E. J. Brouwer, Über Abbildungen von Mannigfaltigkeiten. Math. Ann.,71:97-115, 1912 71

[CoAa89] Cook, S.A. und Aanderaa, S.O., On the minimum computation time of functions, Trans. Amer. Math. Soc.

142 (1969) 291-314

[EdPo97] A. Edalat & P. Potts, A new representation for exact real numbers, Proc. of Mathematical Foundations of

Programming Semantics 13, Electronic notes in Theoretical Computer Science 6, Elsevier Science B.V., 1997,

URL: www.elsevier.nl/locate/entcs/volume6.html

[FiSt74] Fischer, M.J. und Stockmeyer, L.J. Fast on-line integer multiplication, J. Comput. System Scis. 9 (1974)

317-331

[Gr02] T. Granlund, GMP 4.0, http://www.swox.com/gmp/ 24

[GL00] P. Gowland, D. Lester, The Correctness of an Implementation of Exact Arithmetic, 4th Conference on Real

Numbers and Computers, 2000, Dagstuhl, 125-140

[HM00] S. Heinrich & E. Novak et al., The Inverse of the Star-Discrepancy depends linearly on the Dimension,

Acta Arithmetica, to appear

[HS66] F. C. Hennie and R. E. Stearns, Two-tape simulation of multitape Turing machines Journal of the ACM,

13(4):533-546, 1966 18

[Ka96] W. Kahan, IEEE Standard 754 for Binary Floating Point Arithmetic, URL: www.cs.berkeley.edu/˜wkahan/ieee754status/ieee754.ps, 1996

[Ke96] R. B. Kearfott. Interval computations: Introduction, uses, and resources. Euromath Bulletin, 2(1):95-112,

1996. 68, 71

[Kl93] R. Klatte & U. Kulisch et al., C-XSC , a C++ Class Library for Extended Scientific Computing (Springer,

Berlin 1993)

[Kn73] Knuth, Donald Ervin : The Art Of Computer Programming (Volume 1 / Fundamental Algorithms ). Second

Edition. Reading: Addison-Wesley, 1981. 39

[Kn81] Knuth, Donald Ervin : The Art Of Computer Programming (Volume 2 / Seminumerical Algorithms ). Second

Edition. Reading: Addison-Wesley, 1981. 13, 31, 32, 36

3

Literatur

Literatur

[Ko91] K. Ko, Complexity Theory of Real Functions, (Birkhäuser, Boston 1991) 72

[KoFr88] Ko, K., Friedman, H., Computing Power Series in Polynomial Time, Adv. in Appl. Mathematics 9 (1988)

40-50

[Ku96] U. Kulisch, Memorandum über Computer, Arithmetik und Numerik (Universität Karlsruhe, Institut für angewandte Mathematik) 7, 9

[Mm96] V. Ménissier-Morain, Arbitrary precision real arithmetic: design and algorithms, J. Symbolic Computation,

1996, 11 8

[MJM89] Jean-Michel Muller, Arithmetique des Ordinateurs, Masson, Paris, 1989 7

[MJM97] Jean-Michel Muller, Elementary Functions, Birkhäuser, Boston, 1997 47

[Mo62] R. E. Moore, Interval Arithmetic and Automatic Error Analysis in Digital Computing, Ph.d. Dissertation, Department of Mathematics, Stanford University, Stanford, California, Nov. 1962. Published as Applied

Mathematics and Statistics Laboratories Technical Report No. 25. 68

[Mu86] N.Th. Müller, Subpolynomial complexity classes of real functions and real numbers, Proc. 13th ICALP,

Lecture notes in computer science 226 (Springer, Berlin) pages 284-293 (1986) 34

[Mu87] N.Th. Müller, Uniform computational complexity of Taylor series, Proc. 14th ICALP, Lecture notes in

computer science 267 (Springer, Berlin) pages 435-444 (1987) 34

[Mu88] N.Th. Müller, Untersuchungen zur Komplexität reeller Funktionen, Dissertation (FernUniversität Hagen,

1988)

[Mu93] N.Th. Müller, Polynomial Time Computation of Taylor Series, Proc. 22 JAIIO - PANEL ’93, Part 2, Buenos

Aires, 1993, 259-281

(also available at http://www.informatik.uni-trier.de/˜mueller)

[MuMo93] Müller, N.Th. & Moiske, B., Solving initial value problems in polynomial time, Proc. 22 JAIIO - PANEL ’93, Part 2, Buenos Aires, 1993, 283-293 (URL:

http://www.informatik.uni-trier.de/˜mueller)

[Mu96] N.Th. Müller, Towards a real Real RAM: a Prototype using C++, (preliminary version), Second Workshop

on Constructivity and Complexity in Analysis, Forschungsbericht Mathematik-Informatik, Universität Trier 9644, Seiten 59-66 (1996) (URL: http://www.informatik.uni-trier.de/˜mueller)

[Mu97] N.Th. Müller, Towards a real RealRAM: a Prototype using C++, Proc. 6th International Conference on

Numerical Analysis, Plovdiv, 1997

[Mu98] N.Th. Müller, Implementing limits in an interactive RealRAM, 3rd Conference on Real Numbers and Computers, 1998, Paris, 13-26 (URL: http://www.informatik.uni-trier.de/˜mueller)

[Mu01] N.Th. Müller, The iRRAM: Exact Arithmetic in C++, Computability and Complexity in Analysis CCA2000, Lecture notes in computer science 2064 (Springer, Berlin, 2001) 222-252 40, 48

[Mu02] N.Th. Müller, Real Numbers and BDDs, Electronic Notes in Theoretical Computer Science, Vol. 66.1, 2002

35

[Pa00] B. Parhami, Computer Arithmetic: Algorithms and Hardware Designs, Oxford University Press, New York,

2000 24, 28, 29, 34, 42

[PFM74] Patteron, Fischer, Meyer, An Improved Overlap Argument for On-Line Multiplication SIAM-AMS Proceedings Vol 7, 97-111, 1974 31

4

Literatur

Literatur

[Rio94] M. Riordan, ftp://ripem.msu.edu/pub/bignum/BIGNUMS.TXT

[Sch80] A. Schönhage, Storage Modification Machines, SIAM J. on Computing 9(3):490-508, 1980 31

[Sch90] A. Schönhage, Numerik analytischer Funktionen und Komplexität, Jber. d. Dt. Math.-Verein. 92 (1990)

1-20

[TZ99] J.V. Tucker, J.I. Zucker, Computation by ‘While’ programs on topological partial algebras, Theoretical Computer Science 219 (1999) 379-420

[We87] K. Weihrauch, Computability (volume 9 of: EATCS Monographs on Theoretical Computer Science), (Springer, Berlin, 1987) 13

[We94] Weihrauch, K., Grundlagen der effektiven Analysis, correspondence course, FernUniversität Hagen, 1994

[We95] K. Weihrauch, A Simple Introduction to Computable Analysis, Informatik Berichte 171 - 2/1995, FernUniversität Hagen 72

[We96] Weihrauch, K., Computability on the probability measures on the Borel sets of the unit interval, in: Second

workshop on computability and complexity in analysis, Universität Trier, Mathematik - Informatik, technical

report 96-44

[We97] K. Weihrauch, A Foundation for Computable Analysis, Proc. DMTCS´96, (Springer, Singapore, 1997) 6689 72

[We00] K. Weihrauch, Computable Analysis. An Introduction, Springer, Berlin 2000 36, 48, 72

[Zi00] P. Zimmermann, MPFR: A Library for Multiprecision Floating-Point Arithmetic with Exact

Rounding, 4th Conference on Real Numbers and Computers, 2000, Dagstuhl, 89-90, see also

http://www.loria.fr/projets/mpfr/ 46

5

1 EINLEITUNG

1 Einleitung

Stichworte: Integer-Überlauf, Beispiele von Kulisch und Jean-Michel Muller... Ariane-5, Patriot-Scud,

Pentium-Bug

Wenn man mit dem Rechner rechnet, so treten gelegentlich unerwartete Effekte auf, die zeigen, dass es

wichtig ist, sich der Möglichkeiten und Grenzen der Arithmetik von Computern bewusst zu werden. In

dieser Vorlesung werden wir Hardware- und Software-Lösungen zur Arithmetik auf verschieden Zahlmengen untersuchen, wobei sowohl praktische als auch theoretische Aspekte Beachtung finden.

In der englischen Sprache bedeuted hat das Wort arithmetic ebenso wie das Wort compute auch die einfache Bedeutung Rechnen, frei übersetzt heißt der Titel Rechnerarithmetik dieser Vorlesung also RechnerRechnen. Viele heutige Anwendungen von Rechner rechnen kaum noch, sondern sie werten nur noch aus,

was einer weiteren Bedeutung des Wortes Computer (der Auswerter) eigentlich näher kommt.

Im Internet findet man eine Bibliography zum Thema Computer Arithmetic unter liinwww.ira.uka.de/bibliography/Th

(von Peter Kornerup, eher praxisorientiert, mit z.Zt. ca. 600 Artikeln) unv zum Thema Constructivity, Computability and Complexity in Analysis (eher theorieorientiert, Vasco Brattka et.al. ca 500 Artikel) unter www.informatik.fernuni-hagen.de/import/cca/publications/bibliography.html Weitere themenrelevante Links sind:

• www.cs.wisc.edu/ arch/www/

• www.cs.wisc.edu/ arch/sigarch/SIGARCH.html ACM Special Interest Group on Computer Architecture, eher praxisorientiert

Als Motivation werden wir zunächst einige eher theoretische Beispiele für problembehaftete Berechnungen

betrachten, bevor wir anhand dreier realer Katastophen kurz die möglichen Auswirkungen des falschen

Umgangs mit Zahlen beleuchten.

Beispiele für Arithmetik-bezogene Software-Fehler finden sich im Internet unter www5.in.tum.de/persons/huckle/bu

Wir werden hier drei dieser Fehler ansprechen: die Ariane-5-Explosion (4. Juni 1996), der Patriot-ScudVorfall (25. Februar 1991) und den Pentium-Bug (1994/1995).

1.1 ganzzahlige Arithmetik

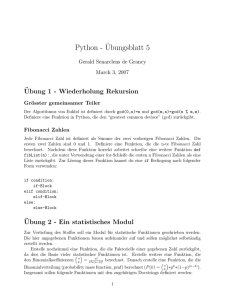

Wir betrachten folgendes kleine C++-Programm ganze_zahlen.cc:

#include <iostream.h>

int main (){

long x=3, i;

for ( i=1;i<=10;i++ ) {

x=x*x;

cout << x << endl;

}

}

Übersetzt mit g++ -Wall -g -o ganze_zahlen ganze_zahlen.cc, entstehen als Ausgabe

hier die folgenden eher zufällig aussehenden Zahlen:

6

1.2 Lineare Algebra

1 EINLEITUNG

9

81

6561

43046721

-501334399

2038349057

-1970898431

120648705

1995565057

-1876701183

Eine allgemeine Erklärung dieses Verhaltens finden wir in Kapitel über natürliche Zahlen.

1.2 Lineare Algebra

In [Ku96] findet man folgendes Beispiel: Betrachte das einfache lineare Gleichungssystem A ∗ x = b mit

µ

¶

µ ¶

64919121 −159018721

1

A = (aij ) =

und b = (bi ) =

41869520.5 −102558961

0

Als Lösungsformel ergibt sich

x1 = a22 /(a11 · a22 − a12 · a21 )

x2 = −a21 /(a11 · a22 − a12 · a21 )

Mit double precision Variablen erhält man für die Lösung:

x̃1 = 102558961, x̃2 = 41869520.5

Die exakten Werte sind jedoch:

x1 = 205117922, x2 = 83739041

Vier einfache Rechenoperationen führen also bereits zu komplett falschen Resultaten!

Ähnliche Probleme gibt es bei computergestützer Geometrie, wo es beispielsweise sehr schwer sein kann,

festzustellen, ob ein Punkt der Ebene im Innern eines Polygones liegt oder nicht.

1.3 Grenzwerte

Das folgende Beispiel stammt aus [MJM89]: Betrachte die Folge

a0 =

61

1130 − 3000/an−1

11

, a1 = , an+1 = 111 −

2

11

an

Wogegen konvergiert diese Folge?

Das folgende kleine Programm liefert eine Lösung (?)

7

1.3 Grenzwerte

1 EINLEITUNG

#include <iostream.h>

int main (){

float a=11.0/2.0, b=61.0/11.0, c;

for (long i=1;i<=20;i++ ) {

cout << a << endl;

c=111-(1130-3000/a)/b;

a=b; b=c;

}

}

Als Resultat ergibt sich (gerundet auf eine Nachkommastelle):

i

1

2

3

4

5

6

7

8

9

10

float

5.5 5.6 5.6 5.7 .5.7 5.7 4.6 −20.5 134.1 101.5

double 5.5 5.6 5.6 5.7 5.7 5.7 5.8

5.8

5.8

5.9

exakt

5.5 5.6 5.6 5.7 5.7 5.7 5.8

5.8

5.8

5.9

i

11

12 13 14

15

16

17

18

19

20

float 100.1

100.0

double 5.9 5.9 6.5 15.4 67.5 97.1 99.8

100.0

exakt

5.9 5.9 5.9 5.9 5.9 5.9

6.0

Die exakten Werte können dabei mit rationaler oder exakter reeller Arithmetik bestimmt werden. Die Berechnungen liefern also ziemlich schnell komplett falsche Werte. Man kann leicht zeigen, dass der exakte

Wert der Iteration bei

6n+1 + 5n+1

an =

6n + 5n

liegt, also lim an = 6.

Eine Erklärung des Phänomens ist , dass die Funktion

f (x) := 111 −

1130 −

x

3000

x

drei Fixpunkte besitzt: 5,6 und 100, wobei 100 ein anziehender Fixpunkt ist, während 5 und insbesondere

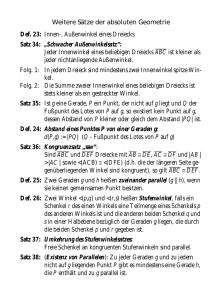

6 abweisende Fixpunkte sind (vgl.z.B. [Mm96]). Die folgenden Graphiken zeigen den Funktionsverlauf

von f allgemein und in Nähe der Fixpunkte:

120

111-(1130-3000/x)/x

111-(1130-3000/x)/x

5.4

100

5.2

80

60

5

40

4.8

20

4.6

0

20

40

60

80

100

4.6

8

4.8

5

5.2

5.4

1.4 Iterierte Funktionen

1 EINLEITUNG

111-(1130-3000/x)/x

111-(1130-3000/x)/x

6.4

100.4

6.2

100.2

6

100

5.8

99.8

5.6

99.6

5.6

5.8

6

6.2

6.4

99.6

99.8

100

100.2

100.4

1.4 Iterierte Funktionen

Sehr hartnäckig ist die folgende einfache Iteration, bei der nach wenigen Operationen das Resultat bereits

vollkommen verfälscht ist. Auch sie findet sich z.B. in [Ku96] (logistische Gleichung, chaotisches System

ohne Konvergenz):

xi+1 = 3.75 · xi · (1 − xi ), x0 = 0.5

Bereits bei x100 sind alle mit herkömmlicher Arithmetik berechneten Stellen falsch:

x60

x70

x80

x90

x100

x110

exakte Arithmetik

+.7990863343...

+.4521952998...

+.8561779966...

+.7399137486...

+.8882939922...

+.7156795292...

Java double

0.79908633 70...

0.4521952 586...

0.85617 59906...

0.7 400517104...

0. 9017659679...

0. 2201217854...

Während bei der Grenzweriteration im vorigen Abschnitt rationale Arithmetik verwendet werden konnte,

um richtige Werte zu finden, versagt sogar diese hier. Im Abschnitt über exakte Arithmetik werden wir

untersuchen, wie die Vergleichswerte bestimmt wurden.

1.5 Die Ariane-5-Explosion

Am 4. Juni 1996 endete der Jungfernflug der Ariane-5 bereits nach ca. 40 Sekunden:

Der offizielle Report der ESA zu dieser milliardenteuren Panne findet sich unter www.esa.int/export/esaCP/Pr_33_19

Ein kurzer Film zur Explosion findet sich bei CNN: www.cnn.com/WORLD/9606/04/rocket.explode/ariane.mov.

9

1.6 Der Pentium-Bug

1 EINLEITUNG

Grund der Explosion war folgender: Ein Leitsystem (mit Gyroskopen und Beschleunigungsmessern) versuchte, die Horizontalgeschwindigkeit aus einer 64bit Variablen in 16 Bit zu speichern, machte wegen des

entstehenden Überlaufes eine Fehlermeldung und schaltete sich ab. Redundante Auslegung dieses Systems

half nicht: Das zweite Leitsystem benutzte die gleiche Software.

Der On-Board-Computer der Ariane interpretierte die Fehlermeldungen als Flugdaten und versuchte daraufhin eine abrupte Kurskorrektur. Als die Booster-Raketen abzureissen drohten, wurde die Rakete sicherheitshalber gesprengt.

Bei den Ariane-4-Raketen hatte die selbe Zuweisung keine Probleme gemacht, aber die Ariane-5 war

schneller... Weitere Absurdität: Die Bestimmung der Horizontalgeschwindigkeit wäre nach dem Start gar

nicht mehr notwendig gewesen...

1.6 Der Pentium-Bug

Die ersten Pentium-Chips von Intel (von 1994) hatten einen Fehler in der Divisionsroutine, aufgedeckt von

Prof. Thomas Nicely, Lynchburg College. Kosten: ca. 400Mio $

Aus www.mackido.com/History/History_PentBug.html:

In mid ’94 Intel (and independant parties) found a floating point bug in their processor. While it

is not unusual for Hardware bugs in processors it is rare that they are this serious, furthermore

Intel went out of their way to hide the bug. It was about 6 months later that Intel finally went

public with the bug (1). Even then Intel did not valuntarily go public with the bug, it was

because other people were discovering it and a thread started on the internet.

Dr. Thomas Nicely was the first guy to publicly discover the bug, and he contacted Intel Tech

Support regarding this bug on Monday 24 October (call reference number 51270). But he was

soon silenced by Intel with an NDA as Intel tried to bury the problem. (2) The bug was found

on many different pentiums including the 60, 66, 75 and 90 mhz pentium chips, and effected

millions of users.

Erläuterung von Intel zu dem Problem: support.intel.com/support/processors/pentium/fdiv/wp/

www.eee.bham.ac.uk/dsvp_gr/roxby/ee4a3/Lecture2/sld013.htm

A software bug encoded in hardware (Halfhill, 1995)

Divide algorithm uses a look up table with 1066 entries, but when downloading the coefficients

to the PLA section, only 1061 were loaded due to an error in a for loop! Committed to silicon

and never checked...

Aus www.ku.edu/cwis/units/IPPBR/pentium_fdiv/pentgrph.html :

Intel Pentium chips manufactured before a certain date have a bug in their floating point processor which returns less than full precision results for some combinations of divisor and

dividend when performing a Floating point DIVision (FDIV). A well known operation which

exhibits this phenomenon is 4195835/3145727. You can check to see if your Pentium has the

FDIV bug by entering the following formula in the Windows calculator:

(4195835/3145727) ∗ 3145727 − 4195835

10

1.6 Der Pentium-Bug

1 EINLEITUNG

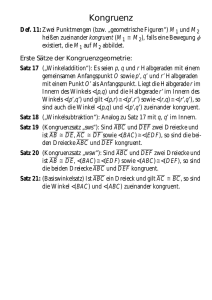

The image below is a 3d graph of the function x/y in the region of 4195835/3145727. Specifically, the region is:

4195833.0 <= x <= 4195836.4

3145725.7 <= y <= 3145728.4

On a 486/66, the function graphs as a monotonically increasing surface with the low point in

the foreground corner (where x is low and y is high) and a high point in the background corner

(where x is high and y is low). On a Pentium with the FDIV bug there are two triangular areas

in the region where an incorrect result is returned. The correct values all would round to 1.3338

and the incorrect values all would round to 1.3337, an error in the 5th significant digit.

An archive of principal papers on the Pentium FDIV bug is available at: www.mathworks.com/company/pentiu

Spott:

Q: Why didn’t Intel call the Pentium the 586?

A: Because they added 486 and 100 on the first Pentium and got 585.999983605.

Eine Untersuchung der Ursachen des Fehler findet sich z.B. in citeseer.nj.nec.com/pratt95anatomy.html

Weitere Links:

www.maa.org/mathland/mathland_5_12.html

www.mathworks.com/company/pentium/index.shtml

11

1.7 Der Patriot-Scud-Vorfall

1 EINLEITUNG

1.7 Der Patriot-Scud-Vorfall

Am 25.2.1991, während des Golfkrieges, versagte eine Amerikanische Patriot-Abwehrbatterie bei einer

heranfliegenden Irakischen Scud-Rakete. Diese traf ein Lager, tötete 28 Soldaten und verletzte etwa 100

weitere.

Weitere Links dazu:

www.ima.umn.edu/ arnold/disasters/patriot.html

www.fas.org/spp/starwars/gao/im92026.htm

Als Grund stellte sich heraus, dass die Umrechnung der Uhrzeit zu ungenau war: Die Systemuhr (Hardware

mit einer Auflösung von 0.1 s) der Abschussanlage wurde in einer Routine mit 0.1 multipliziert (dargestellt

als 24-Bit-Fixpunktzahl), um die Zeit in Sekunden zu berechnen. Wegen der ungenauen internen Darstellung der Zahl 0.1 war nach 100 Stunden Betriebszeit ein Fehler von ca. 0.34 Sekunden entstanden. Da eine

Scud mit 1,676 m/s fliegt, konnte sie sich in dieser Zeit mehr als 500 Meter bewegen und war daher nicht

mehr erreichbar.

Da folgende einfache C++-Programm zeigt den gleichen Effekt auf. Wegen anderer Hardware ist der Fehler

hier allerdings etwas kleiner, nämlich ‘nur’ 0.00536442:

#include <iostream.h>

int main (){

float tenth = 1.0 / 10.0;

long dauer= 1000*3600;

cout << "Fehler: " << dauer * tenth - dauer/10 << endl;

}

12

2 NATÜRLICHE / GANZE ZAHLEN

2 Rechnen mit natürlichen und ganzen Zahlen

Stichworte: Berechenbarkeitsmodelle, Zweier-Komplement-Darstellung, modulare Arithmetik, elementare Algorithmen, schnelle Multiplikation, GMP, redundante Zahl-Darstellungen, signed-digits,...

2.1 Notationen, natürliche Zahlen und Berechenbarkeit

Reale Rechner basieren (auf unterster Ebene) auf binärer Logik, d.h. sie verarbeiten Worte über dem Alphabet B = {0, 1}. Wenn wir nun mit anderen Daten, insbesondere mit Zahlmengen wie N, Z, Q, R, . . .

rechnen möchten, müssen wir die darzustellenden Mengen geeignet codieren. Daher verschlüsselt man

üblicherweise die Elemente der Mengen, auf denen man rechnen möchte. Wir werden hier die Begriffe in

der Form verwenden, wie sie üblicherweise in der Rekursionstheorie verwendet werden, vgl. z.B. [We87].

Basis ist dabei immer die Menge Σ∗ aller Worte über einem endlichen Alphabet Σ. Σk sei die Menge der

Worte der Länge k, λ sei das leere Wort.

Viele der in diesem Abschnitt angesprochenen praxis-orientierten Algorithmen werden auch im Standardwerk [Kn81] von Knuth behandelt.

2.1 Definition. Eine Notation ν einer Menge X ist eine (evtl. partielle) surjektive Abbildung

ν : Σ∗ ÂX

2

Anmerkungen: (i) Ist ν eine Notation von X, so gibt es für jedes x ∈ X (mindestens) ein w ∈ Σ∗ mit

ν(w) = x. Dann wird w als ‘Name’ von x bezeichnet. Jedes x ∈ X hat also einen oder mehrere Namen,

aber nicht jedes w ∈ Σ∗ muß Name eines x ∈ X sein.

(ii) Da Σ∗ abzählbar ist und Notationen surjektiv sind, muß jede ‘notierbare’ Menge X ebenfalls abzählbar

sein. Insbesondere sind damit die reellen Zahlen nicht ‘notierbar’.

(iii) Meist werden wir als Alphabet B verwenden. Bereits die Betrachtung der gesamten Menge B∗ ist

eine Abstraktion, da reale Rechner ja nur einen endlichen Speicher besitzen. Zudem ist die Hardware des

Rechners auf feste Wortlängen festgelegt, etwa Bi mit i ∈ {8, 16, 32, 64}.

Bei natürlichen Zahlen ist folgende binäre (totale) Notation (·)2 naheliegend, bei der wir die Bits 0 und 1

mit den natürlichen Zahlen 0 und 1 identifizieren:

2.2 Definition. Die Binär-Notation (·)2 : B∗ → N sei definiert durch:

(bn . . . b0 )2 :=

n

X

bi · 2i

i=0

sowie (λ)2 := 0 .

2

Damit sind zum Beispiel 101 und 0101 beides „Namen“ der natürlichen Zahl 5 in Binärnotation.

Anstelle der Zahl 2 kann man jede beliebige natürliche Zahl r ≥ 2 als Basis der Notation verwenden:

13

2.1 Notationen, natürliche Zahlen und Berechenbarkeit

2 NATÜRLICHE / GANZE ZAHLEN

2.3 Definition. Es sei Σr := {0, 1, . . . , r−1}. Die r-adische Notation (·)r : Σ∗r → N sei definiert durch:

(dn . . . d0 )r :=

n

X

di · ri

i=0

sowie (λ)r := 0 .

2

Um zu zeigen, dass jedes (·)r surjektiv ist, kann man induktiv die folgende Eigenschaft nachprüfen:

2.4 Lemma. Für alle r und k ∈ N gilt:

{(w)r | w ∈ Σkr } = {0, . . . rk − 1}

2

(·)2 ist auch die Form, in der natürliche Zahlen in der Rechnerhardware dargestellt werden. Da hier die

Wortlänge fest ist, kann man nur zunächst einmal nur endliche Bereiche notieren.

Beispiele:

typedef unsigned int u_int32_t mit 32 Bit, Werte-Bereich {0, . . . , 4294967295}

typedef unsigned short u_int16_t mit 16 Bit, Werte-Bereich {0, . . . , 65535}.

Damit haben wir viele verschiedene Möglichkeiten, natürliche Zahlen zu notieren. Im Wesentlichen sind

diese jedoch gleichwertig. Da dies bei den später definierten Darstellungen reeller Zahlen nicht der Fall

sein wird, führen wir hier schon die Begriffe ein, die in analoger Form bei R wichtig sein werden. Zunächst

definieren wir Turing-Maschinen (nach Alan M. Turing, 1936) und die dadurch implizierten Begriffe von

Berechenbarkeit und Komplexität. Wohl allgemein akzeptiert ist die Church’sche These (erstmals 1935

formuliert, wenn auch für ein anderes Berechnungs-Modell):

Die mit Turing–Maschinen berechenbaren Funktionen sind genau die im

intuitiven Sinne „berechenbaren“ Funktionen (auf Worten).

Eine einheitliche Definition dieser Turingmaschinen existiert nicht, aber die wesentlichen Komponenten

sind stets ähnlich. Ferner sind viele der mit Turingmaschinen erzielten Resultate von den Feinheiten der

Definitionen unabhängig. Dennoch ist eine exakte Angabe der hier verwendeten Definition sinnvoll, um

später Beweisideen ausformulieren zu können.

Eine Turingmaschine wird bei uns wie folgt arbeiten: Mit Hilfe einer endlichen ‘Kontrolleinheit’ kann sie

verschiedene ‘Bänder’ bearbeiten: (a) ein endliches Band, auf dem die Maschine ihre Eingabe erhält, (b)

ein einseitig unendliches Band, auf das die Ausgabe geschrieben wird und (c) eine feste Anzahl beidseitig

unendlicher Arbeitsbänder, auf denen Daten gespeichert werden können.

Jedes dieser Bänder ist in Zellen unterteilt, in denen jeweils ein Zeichen eines vorgebenen endlichen Alphabetes gespeichert werden kann. Zu jedem Band existiert genau ein beweglicher ‘Kopf’, der auf einer

der Zellen des Band positioniert ist. Die Turingmaschine kann in einem Schritt genau ein Zeichen eines

Bandes verarbeiten (also das Zeichen unter dem Kopf des Bandes lesen oder überschreiben) oder aber den

Kopf eines Bandes um eine Zelle verschieben.

Damit die Turingmaschine die Möglichkeit hat, Anfang und Ende des (endlichen) Eingabebandes zu erkennen, ist dieses mit Bandendemarkierungen versehen. Graphisch können wir eine Turingmaschine mit

zwei Arbeitsbändern also wie folgt darstellen:

14

2.1 Notationen, natürliche Zahlen und Berechenbarkeit

2 NATÜRLICHE / GANZE ZAHLEN

#

$

6 Eingabeband (nur lesen)

...

#

Ã

endliche

Kontrolle

"

!

...

6 Arbeitsband (lesen/schreiben)

...

...

6 Arbeitsband (lesen/schreiben)

...

Ausgabeband (nur schreiben)

6

2.5 Definition. Eine Turingmaschine M mit k Arbeitsbändern ist definiert als ein 7-Tupel (Z, Σ1 , Σ2 , ∆, δ, z0 , ze )

mit den folgenden Komponenten:

• Z endliche ‘Zustandsmenge’,

• Σ1 endliches Eingabealphabet, Σ2 endliches Ausgabealphabet,

• ∆ endliches ‘Bandalphabet’ mit einem ‘Leer’-Zeichen (‘Blank’) B ∈ ∆,

• z0 ∈ Z ‘Anfangszustand’,

• ze ∈ Z ‘Endzustand’,

• δ ‘Übergangsfunktion’.

δ ist dabei eine Abbildung von Z \ {ze } in die Menge der bei der Turingmaschine möglichen Operationen,

die wir erst später angeben werden.

Zur Beschreibung der Auswirkungen dieser Operationen auf die Bänder und die Kontrolleinheit der Turingmaschine verwenden wir ‘Konfigurationen’. Den Inhalt eines Bandes werden dabei in einem Wort

u↑av festhalten, wobei der Pfeil ↑ vor dem Zeichen a steht, auf dem der Kopf des Bandes positioniert ist.

Entsprechend gibt das Wort u den Inhalt des Bandes links vom Kopf und v den Inhalt des Bandes rechts

vom Kopf an. Vom Ausgabeband, das ja nur beschrieben werden darf, brauchen wir uns nur den bereits

beschriebenen linken Teil u zu merken. Die Menge K der Konfigurationen der Turingmaschine M wird

also definiert als die Menge

∗

+

K := Z × Σ∗2 × Σ1 ◦{↑}◦Σ1 × (∆∗ ◦{↑}◦∆+ )k

Dabei sei Σ1 := Σ1 ∪ {#, $} das um die ‘Bandendemarker’ # und $ erweiterte Eingabealphabet. Bei

einer solchen Konfiguration

κ = (z, ua , ue ↑ae ve , u1 ↑a1 v1 , . . . , uk ↑ak vk )

15

2.1 Notationen, natürliche Zahlen und Berechenbarkeit

2 NATÜRLICHE / GANZE ZAHLEN

wird ua als Inhalt des Ausgabebandes bezeichnet, ue ↑ae ve als Inhalt des Eingabebandes und ui ↑ai vi als

Inhalt des Arbeitsbandes i; z ist der Zustand der Konfiguration κ.

Zu einer ‘Eingabe’ w ∈ Σ∗1 definieren wir eine ‘initiale’ oder ‘Anfangskonfiguration’ IM (w) durch:

IM (w) := (z0 , λ, ↑#w$, ↑B, . . . , ↑B)

Hier steht der Kopf des Eingabebandes also auf dem linken Bandendemarker. Die Menge Ke der Endkonfigurationen ist definiert als

Ke := {κ ∈ K | der Zustand von κ ist der Endzustand ze }

Ein Schritt der Turingmaschine wird dann über die Einzelschritt-Funktion −→

: K ÂK beschrieben. Mit

M

ihr werden die Auswirkungen aller bei der Turingmaschine möglichen Operationen beschrieben: Es sei

κ = (z, ua , ue ↑ae ve , u1 ↑a1 v1 , . . . , uk ↑ak vk )

eine Konfiguration. Dann gilt κ−→

κ0 , falls einer der folgenden Fälle eintritt (abhängig von der beim

M

Zustand z von κ auszuführenden Operation):

1. (Schreiben auf das Ausgabeband)

Ist δ(z) = (A, x, z 0 ) (mit x ∈ Σ2 , z 0 ∈ Z), so ist

κ0 = (z 0 , ua ◦ x, ue ↑ae ve , u1 ↑a1 v1 , . . . , uk ↑ak vk )

2. (Testen auf Eingabeband und Verzweigen)

Ist δ(z) = (E, x, z1 , z2 ) (mit x ∈ Σ1 ∪ {#, $}, z1 , z2 ∈ Z), so ist

κ0 = (z 0 , ua , ue ↑ae ve , u1 ↑a1 v1 , . . . , uk ↑ak vk )

½

mit

0

z :=

z1 ,

z2 ,

falls x = ae

falls x 6= ae

3. (Kopf auf Eingabeband nach rechts)

Ist δ(z) = (E, R, z 0 ) (mit z 0 ∈ Z), so ist

κ0 = (z 0 , ua , w0 , u1 ↑a1 v1 , . . . , uk ↑ak vk )

½

mit

0

w =

ue ae ↑ve

ue ↑ae ve ,

falls ve =

6 λ

falls ve = λ

4. (Kopf auf Eingabeband nach links)

Ist δ(z) = (E, L, z 0 ) (mit z 0 ∈ Z), so ist

κ0 = (z 0 , ua , w0 , u1 ↑a1 v1 , . . . , uk ↑ak vk )

½

mit

0

w =

u↑xae ve

ue ↑ae ve ,

falls lg(ue ) ≥ 1, d.h. ue = ux mit x ∈ Σ1

falls ue = λ

16

2.1 Notationen, natürliche Zahlen und Berechenbarkeit

2 NATÜRLICHE / GANZE ZAHLEN

5. (Schreiben auf Arbeitsband i)

Ist δ(z) = (i, x, z 0 ) (mit 1 ≤ i ≤ k, x ∈ ∆, z 0 ∈ Z), so ist

κ0 = (z 0 , ua , ue ↑ae ve , u1 ↑a1 v1 , . . . , ui ↑xvi , . . . , uk ↑ak vk )

6. (Testen auf Arbeitsband i und Verzweigen)

Ist δ(z) = (i, x, z1 , z2 ) (mit 1 ≤ i ≤ k, x ∈ ∆, z1 , z2 ∈ Z), so ist

κ0 = (z 0 , ua , ue ↑ae ve , u1 ↑a1 v1 , . . . , uk ↑ak vk )

½

mit

0

z :=

z1 ,

z2 ,

falls x = ai

falls x 6= ai

7. (Kopf auf Arbeitsband i nach rechts)

Ist δ(z) = (i, R, z 0 ) (mit 1 ≤ i ≤ k, z 0 ∈ Z), so ist

κ0 = (z 0 , ua , ue ↑ae ve , u1 ↑a1 v1 , . . . , w0 , . . . , uk ↑ak vk )

½

mit

0

w =

ui ai ↑vi

ui ai ↑B,

falls vi =

6 λ

falls vi = λ

8. (Kopf auf Arbeitsband i nach links)

Ist δ(z) = (i, L, z 0 ) (mit 1 ≤ i ≤ k, z 0 ∈ Z), so ist

κ0 = (z 0 , ua , ue ↑ae ve , u1 ↑a1 v1 , . . . , w0 , . . . , uk ↑ak vk )

½

mit

0

w =

u↑xai vi

↑Bai vi ,

falls lg(ui ) ≥ 1, d.h. ui = ua mit x ∈ ∆

falls ui = λ

2

Auf dem Eingabeband können die Bandendemarkierungen # und $ also erreicht und getestet, aber nicht

überschritten werden. Ferner kann die Eingabe nicht verändert werden. Das Ausgabeband kann nur beschrieben, aber nicht wieder gelesen werden. Geschriebene Zeichen werden jeweils rechts an die bereits

produzierte Ausgabe angefügt, eine explizite Bewegung des Kopfes des Ausgabebandes brauchen wir daher nicht. Bei der (endlichen) Darstellung der Arbeitsbänder werden bei Bedarf Blanks hinzugefügt, so daß

die Maschine hier kein Bandende erreichen kann. Damit scheinen für die Maschine diese Bänder unendlich

lang zu sein.

Die oben definierte initiale Konfiguration stellt damit eine leeres Ausgabeband, ein Eingabeband, bei dem

der Kopf auf dem linken Bandende steht, und Arbeitsbänder, auf denen (für die Maschine) nur Blanks

stehen, dar. Da δ für den Endzustand nicht definiert ist, ist die Einzelschrittfunktion auf Endkonfigurationen

nicht anwendbar.

n

Ausgehend von −→

wird die n-fache Iteration −→

: K ÂK der Einzelschrittfunktion wie bei Funktionen

M

M

n

n

0

üblich definiert: Es gilt κ−→

κ , wenn Konfigurationen κ0 , . . . , κn existieren mit κ0 = κ, κi−1 −→

κi für

M

M

1≤i≤n sowie κn = κ0 . Eine n-fache Iteration entspricht also n Schritten der Maschine M . Insbesondere

17

2.1 Notationen, natürliche Zahlen und Berechenbarkeit

2 NATÜRLICHE / GANZE ZAHLEN

0

∗

gilt κ−→

κ0 genau dann, wenn κ = κ0 gilt. Schließlich sei −→

⊆ κ × κ die transitive und reflexive Hülle

M

M

∗

n

0

0

der Einzelschrittfunktion, d.h. κ−→

κ ⇐⇒ (∃n)κ−→

κ.

M

M

Da δ für Endzustände nicht definiert ist, gibt es bei Turingmaschinen zu jeder Anfangskonfiguration IM (w)

∗

maximal eine (aber gelegentlich auch keine einzige) Endkonfiguration κ mit IM (w)−→

κ. Im folgenden

M

wird also wohldefiniert einer Turingmaschine die von ihr berechnete Funktion als Semantik zugewiesen.

2.6 Definition. Die Funktion fM : Σ∗1 ÂΣ∗2 , die von der Turingmaschine M berechnet wird, ist definiert

durch: Es gilt fM (w) = v genau dann, wenn eine Endkonfiguration κ existiert, die als Inhalt des Ausgabe∗

bandes das Wort v hat und für die IM (w)−→

κ gilt. Existiert keine solche Endkonfiguration, so ist fM (w)

M

undefiniert.

2

2.7 Definition. Die (Zeit-)Komplexität TM : Σ∗1 ÂN einer Turingmaschine M ist definiert durch

½

n

n

(∃κ ∈ Ke )IM (w)−→

κ

M

TM (w) :=

undefiniert sonst

Wir sagen: M arbeitet in Zeit O(t) (für t : N → N) auf einer Menge G ⊆ Σ∗1 , wenn es eine Konstante

c ∈ N gibt, so daß TM (w) ≤ c · t(lg(w)) + c für alle w ∈ G gilt. M arbeitet in polynomialer (bzw.

linearer) Zeit, wenn M in Zeit O(nk ) für ein k ∈ N (bzw. O(n)) arbeitet. Entsprechend sagen wir, daß

eine Funktion f in Zeit O(t) (polynomialer Zeit/linearer Zeit) auf G berechenbar ist, wenn eine Maschine

M mit f = fM existiert, die in entsprechender Zeit auf G arbeitet.

2

Anmerkung: Später wird meist Def(f ) 6= Σ∗1 sein, so daß TM (w) nicht auf ganz Σ∗1 definiert ist. Die

Komplexität einer Maschine M wird uns zudem meist nur für spezielle Eingaben interessieren (also auf

Def(fM )).

einer Menge G ⊂

6=

Bei der Definition der Turingmaschinen hatten wir Arbeitsbänder in beliebiger Anzahl und ein beliebig

großes Arbeitsalphabet zugelassen. Beide Komponenten können reduziert werden (ohne Beweis):

2.8 Lemma. Reduktion des Arbeitsalphabetes:

Zu jeder Turingmaschine M gibt es eine Turingmaschine M 0 mit der gleichen Zahl von Arbeitsbändern

und dem Arbeitsalphabet Σ = {B, 1}, so daß fM = fM 0 und TM 0 (w) ≤ c · TM (w) für alle w ∈ Def(fM )

und eine Konstante c gilt.

Reduktion der Zahl der Arbeitsbänder:

Zu jeder Turingmaschine M mit k Arbeitsbändern gibt es eine Turingmaschine M 0 mit nur einem Arbeitsband, so daß fM = fM 0 und TM 0 (w) ≤ c · TM (w)2 für alle w ∈ Def(fM ) und eine Konstante c gilt.

2

Anmerkungen: (i) Stehen zwei Arbeitsbänder zur Verfügung, so kann die obige Zeitschranke verbessert

werden: Zur Simulation einer beliebigen festen Zahl von Arbeitsbändern mit zwei Arbeitsbändern reichen

c · TM (w) · log TM (w) + c Schritte aus [HS66].

(ii) Für Aussagen zur Fragen der Berechenbarkeit sind die Zahl der Arbeitsbänder und die Größe des

Arbeitsalphabetes damit offensichtlich nicht relevant.

(iii) Wegen der nur linearen Änderung der Komplexität bei der Reduktion des Arbeitsalphabetes können

wir dessen Größe in Zukunft ignorieren. Nur ein oder zwei Arbeitsbänder zu benutzen, könnte die Komplexität der in folgenden betrachteten Algorithmen jedoch signifikant verändern. Die Komplexitätaussagen

werden also im folgenden stets für Turingmaschinen mit fester, aber beliebig hoher Zahl von Bändern formuliert werden, selbst wenn dies nicht jedes Mal ausdrücklich gesagt wird.

18

2.1 Notationen, natürliche Zahlen und Berechenbarkeit

2 NATÜRLICHE / GANZE ZAHLEN

2.9 Definition. Eine Funktion f : Σ∗1 ÂΣ∗2 heißt berechenbar (oder partiell–rekursiv), wenn es eine Turingmaschine M mit f = fM gibt. Es sei

PR := {f : Σ∗1 ÂΣ∗2 | f ist berechenbar }

2

Anmerkung: Die Abkürzung PR ergibt sich aus partiell–rekursiv: Da es Turingmaschinen M gibt, die

nicht bei jeder Eingabe ihre Berechnung beenden, ist fM nicht unbedingt eine totale Funktion. Die Beziechnung ‘rekursiv’ kommt von einer ersten Definitionen von Berechenbarkeit mit einem rekursiven Definitionsmechanismus (Kleene, 1937, ‘µ–rekursive’ Funktionen).

2.10 Satz. Für alle berechenbaren Funktionen f, g ∈ PR ist auch f ◦ g berechenbar.

2

Anmerkung: Es ist f ◦g(w) := f (g(w)), dabei ist insbesondere f ◦g(w) undefiniert, wenn g(w) undefiniert

ist oder aber f (g(w)) undefiniert ist.

Die damit exakt definierten Begriffe von Berechenbarkeit und Komplexität kann man nun auch auf notierte

Mengen übertragen:

2.11 Definition. Seien ν1 : Σ∗1 ÂX und ν2 : Σ∗2 ÂY Notationen von X bzw. Y . Eine Funktion g : X ÂY

heißt (ν1 , ν2 )–berechenbar , wenn eine Funktion f ∈ PR existiert, so daß für alle w ∈ Σ∗1 gilt: Existiert

g(ν1 (w)), so auch ν2 (f (w)) und

g(ν1 (w)) = ν2 (f (w)).

2

Die (ν1 , ν2 )–Berechenbarkeit einer Funktion g : X ÂY kann wie folgt in einem Diagramm veranschaulicht werden:

- Y (ideelle Ebene)

X

g

6

6

ν1

ν2

Σ∗1

f

- Σ∗ (reale Ebene)

2

Die obigen Definition fordert nun, dass das Diagramm für alle w ∈ Def(g ◦ ν1 ) kommutiert:

g ◦ ν1 (w) = ν2 ◦ f (w).

Gegeben ist also eigentlich w (was wir über ν1 als Element von X interpretieren). Daraus berechnen wir

(mit dem „realen“ Turingmaschinen–Modell) einen Wert f (w), den wir wiederum als Element von Y und

als Wert der Funktion g interpretieren.

2.12 Beispiel. Als wichtiges Beispiel für die Programmierung mit Turingmaschinen betrachten wir binäres

Zählen, hier in Form einer Funktion fbin : B∗ → N mit

fbin (x) = (Länge von x)2

19

2.1 Notationen, natürliche Zahlen und Berechenbarkeit

2 NATÜRLICHE / GANZE ZAHLEN

Bei der Angabe der Turingmaschine werden wir ein Flußdiagramm verwenden. Operationen mit nur einem

möglichen Folgezustand werden durch ein Rechteck dargestellt, bei zwei möglichen Folgezuständen nehmen wir ein Karo. Jedem Zustand der Maschine entspricht dabei ein solches Viereck im Flußdiagramm; in

den einzelnen Vierecken steht die jeweils zu auszuführende Operation. Bei δ(z) = (i, x, z1 , z2 ) steht also

i : x im Karo für den Zustand z, die Verbindung zu z1 und z2 wird mit Pfeilen im Diagramm markiert (Beschriftung ‘ja’ am Pfeil zu z1 , ‘nein’ am Pfeil zu z2 ). Der Anfangszustand wird durch einen einlaufenden

Pfeil markiert, im Rechteck des Endzustandes steht ‘HALT’. Da die Bezeichnung der einzelnen Zustände

meist unwichtig ist, werden wir im Diagramm die Zustände selbst nur selten angeben. Die Zahl der Arbeitsbänder und das Arbeitsalphabet werden wir meist gesondert angeben, sie lassen sich häufig aber auch

aus dem Diagramm leicht ablesen.

Das folgende Flußdiagramm definiert damit eine Turingmaschine mit einem Arbeitsband und dem Arbeitsalphabet ∆ = {0, 1, B}:

?

1:0

-

?

E:R

?

´Q ja

´

Q

´E : $Q

- Kopie Arbeitsband

´

Q

auf Ausgabeband

Q

´

Q´

nein

?

Erhöhe Inhalt vom

Arbeitsband um 1

?

HALT

Die beiden „Teilroutinen“ zum Inkrementieren bzw. Kopieren lassen sich wie folgt genauer spezifizieren

(am Ende des Inkrementierens steht der Kopf des Arbeitsbandes am rechten Ende der gespeicherten Daten):

20

2.1 Notationen, natürliche Zahlen und Berechenbarkeit

2 NATÜRLICHE / GANZE ZAHLEN

Inkrementieren

-

?

´Q nein

´1 : 1Q

´

Q

Q´

?

1:0

1:1

-

?

1:R

?

?

´Q

nein

Q

´

1:L

Q1 : B´

Q´

ja

?

1:L

?

Kopieren

-

?

1:L

?

´Q

nein

Q

´

Q1 : B´

Q´

ja ¾

?

1:R

6

A:0

A:1

6

ja

?

´Q

´Q

ja ´1 : BQ nein

- ´1 : 0Q nein

´

´

Q

Q

Q´

Q´

6

?

Hier ergibt sich als Komplexität beispielsweise TM (λ) = 11. Zur Abschätzung der Komplexität im Fall

w 6= λ setzen wir n := lg(w) und wählen k ∈ N0 minimal mit n < 2k ≤ 2n. Insbesondere ist dann

sicherlich TM (w) ≤ TM (w̄) mit lg(w̄) = 2k .

Beim Inkrementieren von 0 bis 2k haben wir dann die folgenden Fälle vorliegen (in Klammern die Zahl

des Auftretens dieser Fälle):

1

( · 2k -fach)

2

1

( · 2k -fach)

4

1

( · 2k -fach)

8

letztes Zeichen wird 1

letztes Zeichen wird 0, vorletztes wird 1

zwei letzte Zeichen werden 0, drittletztes wird 1

...

21

2.1 Notationen, natürliche Zahlen und Berechenbarkeit

2 NATÜRLICHE / GANZE ZAHLEN

also ergibt sich als Schranke für den Gesamtaufwand zum Inkrementieren:

∞

∞

X

X

1 k

i (∗)

k

· 2 · (5i) = 5 · 2

= 5 · 2k · 2 = 10 · 2k ≤ 20n

i

i

2

2

i=1

i=1

f 0 (p) =

1

(1−p)2

=

∞

P

i=1

i · pi−1 , insbesondere also:

∞

P

i=1

i

2i

=

∞

P

1

pi = 1−p

für

i=0

∞ ¡ ¢

P

i−1

1

i 21

= 12 11 2 = 2.

2

(1− 2 )

i=1

Die Abschätzung (∗) erhalten wir dabei wie folgt: Setze f (p) :=

0 < p < 1, also

Beim Kopieren erhalten wir als Schranke für den Aufwand 6k + 2 Schritte, da n in binärer Notation aus k

Zeichen besteht. Damit ist TM (w) ≤ 20 lg(w) + 6 log lg(w) + 2, d.h. M arbeitet in linearer Zeit.

2

2.13 Beispiel. Für die Notation endlicher Alphabete Σ und der jeweiligen Wortmenge Σ∗ eignen sich

„Blockcodes“: Wähle k mit 2k ≥ n und eine beliebige surjektive Funktion ι : Bk ÂΣ.

Dann kann man νΣ : B∗ ÂΣ∗ wie folgt definieren: Es sei νΣ (w) := x1 . . . xm (mit xi ∈ Σ), wenn

w = ι(x1 ) ◦ ι(x2 ) ◦ . . . ◦ ι(xm ) ◦ w0 für ein w0 ∈ B∗ mit lg(w0 ) < k gilt, ansonsten sei νΣ (w) undefiniert.

Ist ι eine bijektive Funktion, so ist die resultierende Notation νΣ damit sogar total.

Wählen wir zum Beispiel Σ = B, k = 1 und ι(1) = 1, ι(0) = 0, so ergibt sich insbesondere νB (w) = w als

„Notation“ der Worte über B.

2

Im folgenden werden wir uns daher oft auf Σ1 = Σ2 = B beschränken können.

Um mehrstellige Funktionen zu betrachten, benutzen wir eine Standardmethode, wie man aus gegebenen

Notationen νi von Mengen Xi Notationen von Tupeln aus Elementen dieser Mengen erzeugen kann. Dazu

verwenden wir (möglichst einfach gehaltene) surjektive Abbildungen

prk : B∗ → (B∗ )k (für k ∈ N),

und

pr∗ : B∗ →

[

(B∗ )k

k∈N

mit denen wir Worte w in voneinander unabhängige Komponenten pr1k (w), . . . prkk (w) bzw. pr1∗ (w), pr2∗ (w), . . .

zerlegen können,

Zunächst definieren wir prk durch die Angabe der einzelnen Komponentenfunktionen (oder Projektionen)

prik für 1 ≤ i ≤ k: Zur Definition von prik (w) für ein Wort w = x1 . . . xn , xj ∈ B, wählen wir m ∈ N

maximal so, daß bei der Teilfolge

xi xk+i x2k+i x3k+i x4k+i . . .

von w alle vorkommenden x(2j+1)k+i für 0 ≤ j < m den Wert 1 haben. Dann setzen wir

prik (w) := xi x2k+i x4k+i . . . x2(m−1)k+i

Die Werte x(2j+1)k+i sind damit Indikatoren, ob x2jk+i noch „gültig“ ist, w = x1 . . . xn wird also so

interpretiert, daß auf eine Gruppe von jeweils k „Wert-Bits“ eine Gruppe von ebenfalls k „Indikator-Bits“

folgt. prk sei schließlich definiert durch prk (w) := (pr1k (w), . . . , prwk (w)). Damit ist zum Beispiel

pr2 (10 11 01 11 10 1) = (101, 01)

22

2.1 Notationen, natürliche Zahlen und Berechenbarkeit

2 NATÜRLICHE / GANZE ZAHLEN

Die Funktion pr∗ definieren wir durch pr∗ (w) := prk (w̄) mit k := lg(pr12 (w)) und w̄ := pr22 (w).

Als ‘Inverse’ zu den prk definieren wir die ‘Paarung’ <w1 , . . . , wk > von Worten:

<w1 , . . . , wk > := das (eindeutig bestimmte) w mit:

prk (w) = (w1 , . . . , wk ),

lg(w) = 2 · k · max{lg(wi ) | 1 ≤ i ≤ k} und

w enthält möglichst viele 0-en.

Damit ist z.B. <10, 000> = 101100110001.

Anmerkung: (i) Die Surjektivität von prk und damit auch von pr∗ ist offensichtlich, da die einzelnen prik

voneinander unabhängig sind.

(ii) Der Nachweis, daß prik ∈ PR für alle k und i mit i ≤ k gilt, ist eine einfache Programmierübung mit

Turingmaschinen.

(iii) Bei der Funktion prk (w) sind die einzelnen ‘verschlüsselten’ Worte in w verzahnt gespeichert, dazu

müssen die Worte zum Teil künstlich verlängert werden. Als Alternative könnten die Worte einfach hintereinander gespeichert werden, unter Verwendung eines geeigneten Trennmechanismus (der natürlich auch

das Gesamtwort auch verlängert). Die gewählte Variante hat den Vorteil, daß die Komplexität beim Zugriff

auf eine der Komponenten prik (w) nur von k und der Länge von prik (w) abhängt, aber völlig unabhängig

ist von den anderen Komponenten.

2.14 Beispiel. Sind ν1 , . . . , νk Notationen von Mengen X1 , . . . , Xk , so definieren wir eine Notation

(ν1 , . . . , νk ) : B∗ ÂX1 × . . . × Xk

durch

(ν1 , . . . , νk )(w) := (ν1 pr1k (w), . . . , νk prkk (w))

Ist ν Notation einer einzelnen Menge X, so definieren wir ν k : B∗ → X k durch

ν k := (ν, . . . , ν)

| {z }

k

und ν ∗ : B∗ Â

S

k∈N

X k durch

ν ∗ (w) := (ν(v1 ), . . . , ν(vm )),

wobei m und die einzelnen vi sich aus pr∗ (w) = (v1 , . . . , vm ) ergeben.

2

2.15 Lemma. Die Addition natürlicher Zahlen + : N2 → N ist für jedes r in linearer Zeit ((·)2r , (·)r )berechenbar.

2

Beweis: Die Projektionsfunktionen sind so definiert, dass es in linearer Zeit möglich ist, die einzelnen

Komponenten einer Eingabe zu extrahieren und jeweils auf ein eigenes Arbeitsband zu kopieren. Wir werden daher im folgenden stets implizit annehmen, dass die Argumente so vorliegen. Da führende Nullen den

Wert bei r-adischer Notation nicht verändern, können wir hier zudem annehmen, dass die zwei Argumente

v und w, die wir zu addieren haben, gleich lang sind.

23

2.1 Notationen, natürliche Zahlen und Berechenbarkeit

2 NATÜRLICHE / GANZE ZAHLEN

Es seien also v = vk−1 . . . v0 und w = wk−1 . . . w0 aus Σ∗r gegeben, gesucht ist ein Wort u mit (u)r =

(v)r +(w)r . Diese Addition können wir dann analog zur Schulmethode für die Addition von Dezimalzahlen

durchführen: Wir definieren einen „Start-Übertrag“ s0 := 0 und berechnen wir induktiv die eindeutig

bestimmten Werte ui ∈ Σr und die neuen Überträge si+1 ∈ B mit ui + r · si+1 = vi + wi + si :

ui := (vi + wi + si ) mod r und si+1 := (vi + wi + si ) div r

Induktiv ergibt sich 0 ≤ vi + wi + si ≤ 2r − 1 und damit auch si+1 ∈ B. Ebenfalls induktiv ergibt

sich (vi . . . v0 )r + (wi . . . w0 )r = (si+1 ui . . . u0 )r . Wir können das gesuchte u also als u := sk uk−1 . . . u0

definieren.

2

Die lineare Zeitkomplexität ergibt sich sofort.

In der Rechnerhardware (mit r = 2) hat notwendigerweise das Resultat u einer Addition die gleiche Länge

wie die Argumente v und w. Dort wird daher u := uk . . . u0 gesetzt, was natürlich nur bei sk = 0 korrekt

ist. Daran kann also ein Overflow erkannt werden. Zudem erhalten wir dann (u)r = (v)r + (w)r mod 2k .

Bei 32-Bit-Rechnern ergibt sich daher auch i.A. (ohne Warnung!) 0 als Summe von 4294967295 + 1.

Der obige Algorithmus erfordert eine strikte Sequentialisierung der Addition. Bei einer Hardware-Implementierung

bedeuted dies jedoch eine große Schaltkreistiefe und damit eine lange Signallaufzeit, wenn einfache Volladdierer verwendet werden. Durch Methoden wie Carry-look-ahead kann diese Zeit deutlich reduziert

werden [Pa00].

Wenn wir natürliche Zahlen voneinander subtrahieren wollen, ergibt sich das Problem, dass negative Resultate entstehen können. Daher verwenden wir hier folgende Form:

½

2.16 Korollar. Die Funktionen

• y :=

x−

x − y, falls x ≥ y

0,

falls x < y

½

und

GEQ(x, y) :=

1, falls x ≥ y

0, falls x < y

sind für jedes r in linearer Zeit (((·)r , (·)r ), (·r ))-berechenbar.

2

Beweis: Wie oben können wir uns auf die Betrachtung von v = vk−1 . . . v0 und w = wk−1 . . . w0 aus Σ∗r

beschränken. Jetzt setzen wir jedoch

ui := (vi − wi − si ) mod r und si+1 := (vi − wi − si ) div r

woraus sich induktiv (vi . . . v0 )r − (wi . . . w0 )r = (ui . . . u0 )r − si+1 · ri+1 . ergibt. Damit erhalten wir

GEQ(x, y) = sk und (v)r − (w)r = (uk−1 . . . u0 )r im Falle von sk = 0.

2

2.17 Beispiel. Die Addition- und Subtraktionsroutinen für gleich lange Worte finden sich auch in der

GMP[Gr02]. Wir betrachten hier nur die “generische“ C-Fassung dieser Routinen, die auf AssemblerCode verzichtet. Als Alphabet Σr wird dabei im Falle von 32-bit-Rechnern der volle Umfang von unsigned long

verwendet, hier „limb“ als Verallgemeinerung von „digit“ genannt: typedef unsigned long int mp_li

Das folgende Programm ist ein leicht modifizierter Auszug aus der Datei aors_n.c, in der diese maschinenungebunde Fassungen von Addition und Subtraktion eingeführt werden. Die Bibliothek enthält jedoch

auch für viele CPU-Typen handoptimierte Assembler-Routinen.

24

2.1 Notationen, natürliche Zahlen und Berechenbarkeit

mp_limb_t

mpn_add_n (mp_ptr res_ptr,

{

register mp_limb_t x, y,

register mp_size_t j;

...

cy = 0;

do

{

y = s2_ptr[j];

x = s1_ptr[j];

y += cy;

/*

cy = (y < cy);

/*

y = x + y;

/*

cy += (y < x);;

/*

res_ptr[j] = y;

}

while (++j != 0);

2 NATÜRLICHE / GANZE ZAHLEN

mp_srcptr s1_ptr, mp_srcptr s2_ptr, mp_size_t size)

cy;

previous carry/borrow into second operand */

new carry from that

*/

add

*/

and its carry

*/

return cy;

}

Interessant ist dabei, wie die (hier regelmäßigen!) Overflows bei der Addition von limbs durch einen

anschließenden Größenvergleich abgefangen werden. Viele (aber nicht alle!) Prozessortypen bieten als

Maschinen-Operation bereits analoge Addition oder Subtraktion mit Carry an, die aber in der Regel aus

Hochsprachen nicht zugänglich sind.

2

Wie bereits angegeben, ist die Menge PR der berechenbaren Funktionen unter Substitutionen abgeschlossen. Daraus ergibt sich die Transitivität der Berechenbarkeit bzgl. Notationen:

2.18 Satz. Seien ν1 , ν2 , ν3 Notationen von M1 , M2 , M3 , sei g : M1 ÂM2 und h : M2 ÂM3 . Ist g (ν1 , ν2 )–

berechenbar und ist h (ν2 , ν3 )–berechenbar, so ist h ◦ g : M1 ÂM3 (ν1 , ν3 )–berechenbar.

2

Beweis: Seien f1 , f2 ∈ PR gegeben mit

∀w ∈ Def(gν1 ) gν1 (w) = ν2 f1 (w),

∀v ∈ Def(hν2 ) hν2 (w) = ν3 f2 (w),

Dann gilt für alle w ∈ Def(h ◦ g ◦ ν1 ) ⊆ Def(g ◦ ν1 )

h ◦ g ◦ ν1 (w) = h ◦ (ν2 ◦ f1 (w))

= ν3 ◦ f2 ◦ f1 (w).

Mit f2 ◦ f1 ∈ PR ist h ◦ g also (ν1 , ν3 )–berechenbar.

(⇒ f1 (w) ∈ Def(h ◦ ν2 ))

2

Bei den als Beispiel verwendeten Notationen sind die Definitionen zum Teil recht willkürlich, zum Teil

auch nicht vollständig ausgeführt. Schon kleine Modifikationen an den Definitionen führen zu anderen

Notationen, etwa die Änderung von ι bei νΣ . Es stellt sich also die Frage, wie man zwei Berechenbarkeitsbegriffe auf einer Menge vergleicht, die von zwei verschiedenen Notationen herrühren:

25

2.2 Ganze Zahlen

2 NATÜRLICHE / GANZE ZAHLEN

2.19 Definition. Seien ν, ν 0 Notationen einer Menge X.

(a) ν 0 heißt auf ν reduzierbar ( in Zeichen ν 0 ≤ ν), wenn ein f ∈ PR existiert mit

(∀w ∈ Def(ν 0 )) ν 0 (w) = νf (w).

(b) ν 0 und ν heissen (berechenbar) äquivalent (in Zeichen ν 0 ≡ ν), wenn ν 0 ≤ ν und ν ≤ ν 0 gilt.

2

Anmerkung: Bei ν 0 ≤ ν kann man also Namen bzgl. ν 0 mit einem f ∈ PR in Namen bzgl. ν übersetzen. Ferner ist „ν 0 ≤ ν“ gleichwertig mit „idX ist (ν 0 , ν)-berechenbar“ für die Identität idX : X →

X, idX (x) := x. Damit ergibt sich sofort:

2.20 Satz. Seien ν1 , ν2 äquivalente Notationen einer Menge X und ν 0 Notation einer weiteren Menge X 0 .

Dann gilt:

(a) g : X ÂX 0 ist (ν1 , ν 0 )-berechenbar genau dann, wenn g (ν2 , ν)-berechenbar ist.

(b) h : X 0 ÂX ist (ν 0 , ν1 )-berechenbar genau dann, wenn h (ν 0 , ν2 )-berechenbar ist.

2

Modifikationen bei der Definition einer Notation sind also erlaubt und ohne (wichtige) Auswirkungen,

wenn dabei äquivalente Notationen entstehen.

2.21 Lemma. Die Notationen (·)r sind alle äquivalent!

2

Beweis: als Übung

2.2 Ganze Zahlen

Ganze Zahlen werden in Rechnerhardware meist in der „Zweierkomplement-Notation“ notiert:

2.22 Definition. Die „Zweierkomplement-Notation“ (·)zk : B∗ \ {λ} → Z ist definiert durch:

½

(vk vk−1 . . . v0 )zk :=

(vk−1 . . . v0 )2

−2k + (vk−1 . . . v0 )2

falls vk = 0

falls vk = 1

¾

=

k−1

X

vi · 2i − vk · 2k .

i=0

2

Beispiele sind (010101)zk = (10101)2 = 21, (101010)zk = −25 + (01010)2 = −22. Es ergibt sich:

2.23 Lemma. Für alle k ∈ N gilt:

(Bk )zk = {x ∈ Z | 0 ≤ x ≤ 2k − 1 ∨ 0 − 2k ≤ x ≤ 2k − 1 − 2k }

= {x ∈ Z | −2k ≤ x ≤ 2k − 1}

2

26

2.2 Ganze Zahlen

2 NATÜRLICHE / GANZE ZAHLEN

Damit ist (·)zk sicher surjektiv. Ferner kann man am ersten Zeichen eines Wortes v = vk . . . v0 das Vorzeichen von (v)zk ablesen: Es gilt (v)zk ≥ 0 ⇔ vk = 0.

Normalerweise kann die Länge der Worte bei der Zweierkomplementdarstellung im Computer nur einige

wenige, feste Werte annehmen; in C++ sind dies beim Typ short int 16 Bit (= 2 Byte) und beim Typ

long int 32 Bit (= 4 Byte). Damit ergeben sich folgende Bereiche, die dargestellt werden können:

short int −215 .. 215 − 1, d.h. − 32768 .. 32767

long int −231 .. 231 − 1, d.h. − 2.147.483.648 .. 2.147.483.647

Der entscheidende Vorteil der Zweierkomplement-Notation

ist die

einfache Realisierung von AdPk−1 i

Ptechnisch

k

k

i

dition (und Subtraktion): Da (vk . . . v0 )zk = i=0 vi 2 −vk 2 = i=0 vi 2 −vk 2k+1 = (vk . . . v0 )2 −vk 2k+1

gilt, kann man die Zweierkomplementaddition auf die normale Addition von Dualzahlen zurückführen: Es

seien v = vk . . . v0 und w = wk . . . w0 gegeben. Zur Addition von (v)zk und (w)zk führen wir zunächst

eine normale Dualaddition von vk . . . v0 und wk . . . w0 mit Ergebnis uk . . . u0 =: u und letztem Übertrag

sk+1 durch, d.h. es ergibt sich (v)2 + (w)2 = (u)2 + sk+1 2k+1 . Damit folgt

(v)zk + (w)zk = (v)2 − vk 2k+1 + (w)2 − wk 2k+1

= (u)2 + 2k+1 (sk+1 − vk − wk )

= (u)zk + 2k+1 (uk + sk+1 − vk − wk )

Auf jeden Fall gilt also (v)zk + (w)zk mod 2k+1 = (u)zk mod 2k+1 . Wir unterscheiden nun zwei Fälle:

• Die Summe (v)zk + (w)zk ist im Zweierkomplement als Wort der Länge k+1 darstellbar: Dann gilt

−2k ≤ (v)zk + (w)zk < 2k ,−2k ≤ (u)zk < 2k und damit |(u)zk − ((v)zk + (w)zk )| < 2k+1 . Es folgt

(u)zk = (v)zk + (w)zk und uk + sk+1 = vk + wk .

• Die Summe (v)zk + (w)zk ist nicht mit nur k+1 Zeichen darstellbar (d.h. es liegt ein overflow vor):

Es sei also (v)zk + (w)zk < −2k oder (v)zk + (w)zk ≥ 2k . Wegen −2k ≤ (u)zk < 2k ergibt sich

uk + sk+1 6= vk + wk .

Overflow liegt genau dann vor, wenn uk + sk+1 6= vk + wk gilt, ansonsten ist (u)zk = (v)zk + (w)zk .

Eine alternative Notation der ganzen Zahlen benutzt stellt Vorzeichen und Betrag der Zahl getrennt dar

(„sign-magnitude“):

2.24 Definition. Die „sign-magnitude-Notation“ (·)sm : B∗ \ {λ} → Z ist definiert durch:

(w)2 , falls v = 0w für ein w ∈ B∗

−(w)2 , falls v = 1w für ein w ∈ B∗

(v)sm =

0

falls v = λ

2

Das erste Bit eines Wortes stellt also das Vorzeichen dar. Der Wertebereich ergibt sich zu

2.25 Lemma. Für alle k ∈ N gilt(Bk+1 )sm = {x ∈ Z | 1 − 2k ≤ x ≤ 2k − 1}.

27

2

2.3 Die Multiplikation natürlicher Zahlen

2 NATÜRLICHE / GANZE ZAHLEN

Insbesondere hat dann die Zahl Null auch bei jeder festen Wortlänge zwei Namen: 000 . . . und 100 . . ..

Diese Notation wird oft benutzt, wenn die Wortlänge nicht fixiert ist, sondern variabel bleibt (d.h. bei

Software-Lösungen). Als Beispiel kann hier GMP (GNU Multiple Precision Arithmetic Library) dienen.

Die entsprechende Deklaration in GMP.h lautet:

typedef struct

{

int _mp_alloc;

int _mp_size;

mp_limb_t *_mp_d;

} __mpz_struct;

/* Number of *limbs* allocated and pointed

to by the _mp_d field. */

/* abs(_mp_size) is the number of limbs the

last field points to. If _mp_size is

negative this is a negative number. */

/* Pointer to the limbs. */

2.26 Lemma. (·)zk und (·)sm sind äquivalent. Die Umrechnung ist in linearer Zeit möglich.

Die Addition und die Subtraktion ganzer Zahlen sind in linearer Zeit ((·)2sm , (·)sm )-berechenbar.

2

Beweis: Bei gegebenem v = (vk . . . v0 ) gilt im FallePvk = 0 sofort (v)zk =

wi = 1 − vi ,

sm . Setzen

P(v)

Pwir

k−1

k−1 i

i

k

i

so erhalten wir für vk = 1 sofort (v)zk = −2k + k−1

v

2

=

−2

−

w

2

−

2

= −(1 +

i

i=0

i=0

Pk−1 i

Pk−1 i=0 i i Pk−1 i

k

(wk−1 . . . w0 )2 ) und (v)sm = − i=0 vi 2 =

i=0 wi 2 −

i=0 2 = −2 + 1 + (wk−1 . . . w0 )2 . Ein

Algorithmus zum Nachweis der Äquivalenz muß also lediglich Bits invertieren und dann binär 1 addieren

oder subtrahieren.

Die Algorithmen zur Addition und Subtraktion könnte man durch Umwandlung ins Zweierkomplement

ausführen. Es ist jedoch schneller, entsprechend der Vorzeichenkombination der Argument eine einfache

Binäraddition oder Subtraktion durchzuführen. Tritt der Fall ein, dass bei einer Binärsubtraktion das Ergebnis negativ würde, so vertauscht man die zwei Argumente, subtrahiert erneut und korrigiert dies über

das Vorzeichen des Resultates.

2

2.3 Die Multiplikation natürlicher Zahlen

Während für Additionen ganzer Zahlen die Zweierkomplement-Notation von Vorteil ist, ist bei Multiplikationen und Divisionen die Sign-Magnitude-Notation einfacher in der Handhabung. Hier kann man nun

zwei Teile unterscheiden: Die (triviale) Bestimmung des Vorzeichens des Resultates und die Multiplikation

(oder Division) der natürlichwertigen Anteile der Argumente. Aus diesem Grund werden wir im folgenden

auch nur die Multiplikation natürlicher Zahlen untersuchen.

Die Computer-Hardware wird wieder auf binärer Darstellung aufbauen (müssen), während Softwarelösungen wie GMP diese Hardware-Multiplikationen als Basisoperationen verwenden können. Hier ist es

also auch wieder sinnvoll, die r-adischen Zahlen mit großer Basis r zugrunde zu legen (d.h. r = 232 bei

32-Bit-Rechnern), da dann die Algorithmen im praktischen Einsatz wesentlich schneller werden.

Wie Multiplikationen in Hardware durchgeführt werden können, werden wir nur am Rande streifen. In

[Pa00] wird dieses Thema ausführlich behandelt.

28

2.3 Die Multiplikation natürlicher Zahlen

2 NATÜRLICHE / GANZE ZAHLEN

P

Sind v = vk−1 . . . v0 und w = wk−1 . . . w0 gegeben, so erhalten wir (v)r · (w)r = 0≤i<k wi ri · (v)r . Damit

können wir zunächst die Multiplikation mit (w)r auf die Multiplikationen von (v)r mit den einzelnen

Stellen wi reduzieren, deren Resultate dann nach entsprechendem Links-Shifts (für die Multiplikationen

mit den Potenzen ri von r) addiert werden.

Für die Einzel-Multiplikationen brauchen wir zusätzlich noch das „kleine Ein-mal-Eins“, d.h. eine Tabelle

(oder Funktion) (x, y) 7→ (u, s) mit x · y = s · r + u für x, y, u, s ∈ Σr .

2.27 Lemma. (Multiplikation mit Konstanten)

Eine natürliche Zahl kann in r-adischer Notation mit einer konstanten Zahl in linearer Zeit multipliziert

werden.

2

Beweis: Wir betrachten zunächst den Fall (vk−1 . . . v0 )r · m mit einer Zahl m ∈ Σr . Ähnlich wie bei

der Addition setzen wir s0 := 0 und induktiv ergeben sich mit dem kleinen Ein-mal-Eins ui , si+1 aus

si+1 · r + ui = vi · m + si .

Allerdings ist hier nicht mehr si ∈ B, stattdessen kann si beliebige Werte aus Σr annehmen. Wegen

vi · m + si ≤ (r−1)2 + r−1 = (r−1) · r bleibt der Übertrag jedoch stets einstellig.

Induktiv ergibt sich (vi . . . v0 )r · m = (ui . . . u0 )r + si+1 · ri+1 , d.h. als Produkt ergibt sich (sk uk−1 . . . u0 )r .

Ist der Multiplikator mehrstellig, so zerlegen wir in in seine einzelnen Stellen, die wir getrennt multiplizieren und jeweils direkt aufaddieren. Bei festen Multiplikator ergibt sich also insgesamt ein linearer

Aufwand.

2

Anmerkung: Bei den üblichen PC-Prozessoren gibt es einen Assemblerbefehl, der zwei 32-Bit-Zahlen

multipliziert und eine 64-Bit-Zahl als Resultat ergibt. Beim ebenfalls vorhandenen Multiplikationsbefehl

mit 32-Bit-Ergebnis werden wie üblich die oberen 32 Bit abgeschnitten. In der GNU-C-Bibliothek (und

entsprechend dem GCC-Compiler) können die 64-Bit-Werte als unsigned long long int angesprochen werden.

Es ergibt sich sofort:

2.28 Lemma. (Schul-Methode zur Multiplikation)

Natürliche Zahlen können in r-adischer Notation in quadratischer Zeit O(n2 ) multipliziert werden.

2

Im Spezialfall r = 2 ist das kleine Ein-mal-Eins ziemlich trivial, daher reduziert sich die Multiplikation

dort auf folgende einfache Additionen:

X

(v)2 · (w)2 =

(v0i )2

i:wi =1

Weitere Möglichkeiten, die Multiplikation auf der Hardware-Seite, d.h. mit fester Wortlänge k, zu optimieren, findet man in [Pa00]. Wir werden im folgenden die Asymptotik für k → ∞ untersuchen, wo

wesentlich bessere Resultate als die gezeigte quadratische Laufzeit zu erreichen sind.

Wir beginnen mit dem Algorithmus des russischen Mathematikers Karatsuba, 1963 veröffentlicht. Die

Grundidee besteht darin, die Multiplikation langer Zahlen rekursiv auf kürzere Multiplikationen zurückzuführen, unter Inkaufnahme einiger zusätzlicher Schiebe- und Additionsoperationen.

29

2.3 Die Multiplikation natürlicher Zahlen

2 NATÜRLICHE / GANZE ZAHLEN

2.29 Lemma. (Karatsuba-Algorithmus)

Natürliche Zahlen können in r-adischer Notation in Zeit O(nlog2 3 ) ≈ O(n1.58496 ) multipliziert werden. 2

Beweis: Seien v und w gegeben, wobei wir o.B.d.A annehmen, dass sie gleiche gerade Länge 2n haben

(evtl. durch führende Nullen). Es ist als v = v2n−1 . . . v0 und w = v2n−1 . . . v0 . Wir zerlegen beide in zwei

Hälften:

vh := v2n−1 . . . vn vl := vn−1 . . . v0

wh := w2n−1 . . . wn

wl := wn−1 . . . w0

Damit ist z.B. (v)r = (vh )r · rn + (vl )r

Somit haben wir für das Produkt beider Zahlen die Gleichung

(v)r · (w)r = (r2n +rn ) · ((vh )r · (wh )r )

+rn · ((vh )r − (vl )r ) · ((wl )r − (wh )r )

+(rn +1) · ((vl )r · (wl )r )

Diese Gleichung reduziert die Multiplikation zweier 2n-stelliger Zahlen auf drei Multiplikationen von nstelligen Zahlen, da sich die „überzähligen“ Terme genau aufheben. Diese n-stelligen Multiplikationen

können nun entweder rekursiv über die gleiche Formel oder aber direkt mit der obigen „Schul-Methode“

berechnet werden.

Wenn T (n) die benötigte Zeit für eine Multiplikation n-stelliger Zahlen ist, ergibt sich also T (2n) ≤

3T (n) + cn. Wählt man c0 = 3T (1) + c, so ergibt sich induktiv T (2k ) ≤ c0 (3k − 2k ), also sicherlich

T (2k ) ≤ c0 3k . Es folgt

T (n) ≤ T (2dlog2 ne ≤ c0 3dlog2 ne ≤ c0 31+log2 n ≤ 3c0 2log2 n·log2 3 = 3c0 nlog2 3

2

Die Karatsuba-Methode ist nur eine Spezial-Form einer allgemeineren Vorgehensweise, bei der man eine

Zahl in d + 1 kürzere Komponenten zerlegt, die mittels 2d + 1 Multiplikationen und durch geeignete Linearkombinationen zusammengesetzt das Gesamt-Produkt ergeben. Die Grundidee dieser Methode stammt

vom russischen Mathematiker A.L. Toom; S.A. Cook zeigte 1966, wie diese Idee für schnelle Computerprogramme eingesetzt werden konnte:

2.30 Lemma. (Toom-Cook-Algorithmus mit fester Teilung)

Für jedes gegebene ε > 0 können natürliche Zahlen in r-adischer Notation in Zeit c(ε)n1+ε multipliziert

werden. Dabei ist c(ε) von n unabhängig.

2

Einschub:

Toom-Cook-Multiplikationsmethode

30

2.4 Divisions-Algorithmen

2 NATÜRLICHE / GANZE ZAHLEN

Wählt man die Anzahl d + 1 der Teile, in die man die Argumente v und w zerlegt, in Abhängigkeit

von der Länge von v und w, so läßt sich die asymptotische Entwicklung der Komplexität weiter nach

unten drücken. Allerdings muß man dann auch die Polynom-Koeffizienten explizit berechnen (statt sie wie

oben einer festen Tabelle entnehmen zu können). Daher werden statt der Lagrange-Interpolationsformel

auch Differenzenschemata zur Interpolation verwendet. Damit lässt sich die aymptotische Schranke für die

Komplexität der Multiplikation weiter sehr stark drücken:

2.31 Lemma. (Toom-Cook-Algorithmus mit variabler Teilung, ohne Beweis,

vgl. [Kn81])

√

2 log n

Natürliche Zahlen können in r-adischer Notation in Zeit O(n log n · 2

) multipliziert werden.

2

Verwendet man statt der hier benutzten r−adischen Notation in Zwischenschritten eine „modulare“ Notation, so kann man noch schneller multiplizieren: Der schnellste bekannte Algorithmus zur Multiplikation

mit dem Turingmaschinen-Modell stammt von Schönhage und Strassen:

2.32 Lemma. (Schönhage-Strassen-Algorithmus, ohne Beweis, vgl. [Kn81])

Natürliche Zahlen können in r-adischer Notation in Zeit O(n log n · log log n) multipliziert werden.

2

Es ist nicht bekannt, ob bei dem von uns benutzten Turing-Maschinen-Modell schneller multipliziert werden kann als angegeben. Auf anderen Rechnermodellen (pointer machine, storage modification machine

[Sch80]) ist es allerdings sogar möglich, in linearer Zeit zu multiplizieren.

Als untere Schranke gibt es für den allgemeinen Fall nur die (triviale) lineare Laufzeit. Für spezielle Berechnungsmodelle (online-Arithmetik) gibt es die untere Schranke n log n/ log log n [PFM74]

Der Karatsuba-Algorithmus, einfache Fassungen des Toom-Cook (Zerlegung in drei Teile) und die SchönhageStrassen-Methode sind z.B. in der GMP-Bibliothek implementiert. Eine Tuning-Routine aus GMP 4.0

lieferte zum Beispiel für Pentium-III-5ooMHz CPUs, dass es sinnvoll wäre, Karatsuba ab n = 23, ToomCook ab n = 139 und die Schönhage-Strassen-Methode ab n = 4864 einzusetzen. (Für einen 900-MHzAthlon ergaben sich als Werte analog: n = 26, 177, 9472.)

Da die Komplexität der Multiplikation noch nicht eindeutig bestimmt werden konnte, werden wir im

folgenden einfach eine Funktion M dafür ansetzen. Bei heutigen Kenntnisstand wäre also M(n) =

n log n log log n. Wir werden bei der Definition zwei Bedingungen an diese Komplexitätsschranke stellen, die erstmals bei [PFM74] auftauchen und benutzt werden, um Glattheitseigenschaften der Schranke

vorzuschreiben. In ähnlicher Bedeutung werden diese Bedingungen öfter benutzt. Wir werden sie erst später motivieren können, da wir hier den Beweis der unteren Schranke nicht weiter verfolgen.

2.33 Definition. M : N → N sei im folgenden die beste (bekannte) Komplexitätsschranke für die Multiplikation von natürlichen Zahlen bei r-adischer Notation und dem Turingmaschinen-Modell mit beliebiger

fester Zahl von Arbeitsbändern. Wir verlangen zudem, dass M monoton ist und 2M(n) ≤ M(2n) ≤

cM(n) + c für alle n ∈ N und eine Konstante c gilt.

2

2.4 Divisions-Algorithmen

Im Bereich der natürlichen Zahlen ist unter einer Division immer einer Division mit Rest zu verstehen, d.h.

bei gegebenem y 6= die Zerlegung einer Zahl x in zwei Zahlen p und q < y mit x = p · y + q, d.h. p = b xy c,

q = x mod y.

31

2.4 Divisions-Algorithmen

2 NATÜRLICHE / GANZE ZAHLEN

Wir werden in einem späteren Kapitel zeigen, dass die Division so schnell ausgeführt werden kann wie

eine Multiplikation. Zunächst werden wir jedoch die Schul-Methode zur Division analysieren, bei der man

eine Stelle des Quotienten „errät“ und dann entsprechend den Dividenden korrigiert.

Als Basis-Operation brauchen wir hier die Möglichkeit, zweistellige Zahlen durch einstellige Zahlen mit

Rest zu dividieren. Genauer: wir nehmen an, dass wir zu v, w ∈ Σr , w 6= 0 und s < w Werte u ∈ Σr und

s0 < w bestimmen können, so daß

u · w + s0 = (sv)r

Bei r = 2 ist dies trivial: Hier ist nur w = 1 und damit s = 0 von Interesse, also muß hier s0 = 0 und

u = v gelten.

Wir betrachten zuerst den Fall, dass der Divisor nur einstellig ist:

2.34 Lemma. (Schul-Methode zur Division, einstellig)

Division mit Rest ist bei natürlichen Zahlen in r-adischer Notation bei einem einstelligen Divisor in Zeit

O(n) möglich.

2

Beweis: Wir betrachten die Division einer als (v)r gegebenen Zahl durch ein w ∈ Σr Der Einfachheit

halber indizieren

P k−i wir die einzelnen Stellen von v jetzt von links nach rechts, also v = v0 . . . vk−1 mit

(v)r =

vi r .

Wir setzen zunächst s0 = 0 und dann wieder iterativ ui und si so daß ui · w + si+1 = (si vi )r : Hier gilt dann

(v0 . . . vi )r = (u0 . . . ui ) · w + si+1

Insgesamt erhalten wir also (v0 . . . vk−1 )r div w = (u0 . . . uk−1 )r Rest sk

2