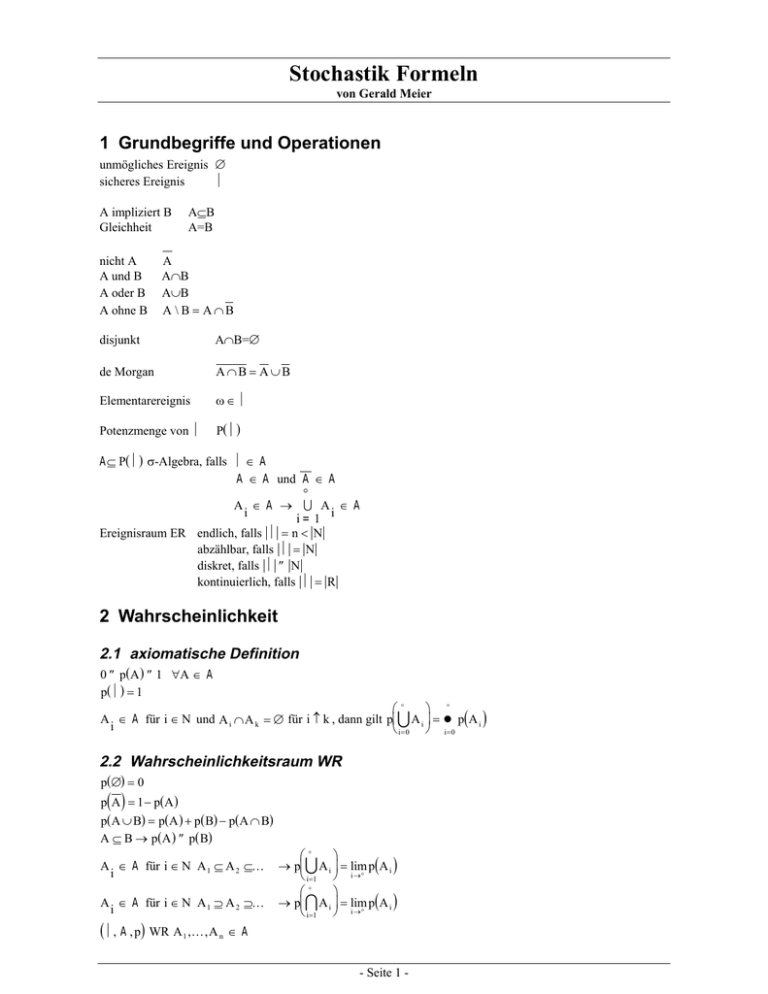

Stochastik Formeln

Werbung

Stochastik Formeln

von Gerald Meier

1 Grundbegriffe und Operationen

unmögliches Ereignis ∅

Ω

sicheres Ereignis

A impliziert B

Gleichheit

nicht A

A und B

A oder B

A ohne B

A⊆B

A=B

A

A∩B

A∪B

A \ B = A∩B

disjunkt

A∩B=∅

de Morgan

A∩B = A ∪B

Elementarereignis

ω∈ Ω

Potenzmenge von Ω

P(Ω)

A ⊆ P(Ω) σ-Algebra, falls Ω ∈ A

A ∈ A und A ∈ A

∞

A ∈ A → U A ∈ A

i

i

i= 1

Ereignisraum ER endlich, falls Ω = n < N

abzählbar, falls Ω = N

diskret, falls Ω ≤ N

kontinuierlich, falls Ω = R

2 Wahrscheinlichkeit

2.1 axiomatische Definition

0 ≤ p( A ) ≤ 1 ∀ A ∈ A

p(Ω) = 1

∞

∞

A ∈ A für i ∈ N und A i ∩ A k = ∅ für i ≠ k , dann gilt pU A i = ∑ p(A i )

i

i= 0 i= 0

2.2 Wahrscheinlichkeitsraum WR

p(∅) = 0

( )

p A = 1 − p(A )

p(A ∪ B) = p(A ) + p( B) − p(A ∩ B)

A ⊆ B → p(A ) ≤ p( B)

A ∈ A für i ∈ N A 1 ⊆ A 2 ⊆K

i

A ∈ A für i ∈ N A 1 ⊇ A 2 ⊇K

i

(Ω, A , p) WR A 1 ,K , A n ∈ A

∞

→ pU A i = lim p(A i )

i=1 i →∞

∞

→ pI A i = lim p(A i )

i=1 i →∞

- Seite 1 -

- Gerald Meier: Stochastik Formeln n

n

n

n

n

n +1

→ pU A i = ∑ p(A i ) − ∑ p(A i ∩ A k ) + ∑ p(A i ∩ A k ∩ A s )−K+(−1) pI A i

i = 1 i =1

i =1

i , k =1

i , k , s =1

i< k

i< k < s

pU A i ≤ ∑ p(A i )

i

i

2.3 diskrete Wahrscheinlichkeitsräume WR

Gleichverteilung / LAPLACE-Verteilung

1

A

∀ω ∈ Ω

Ω=N

p(ω) =

p(A ) =

N

N

Geometrische Verteilung

p( k ) = (1 − p) ⋅ p

k

2.4 kontinuierliche Wahrscheinlichkeitsräume WR

Gleichverteilung

β−α

p([α, β]) =

b−a

a≤α≤β≤ b∈R

3 Bedingte Wahrscheilichkeit

3.1 Definition

p(A B) =

p(A ∩ B)

p( B)

3.2 Anwendungen

3.2.1 Multiplikationssatz

p(A ∩ B) = p( B) ⋅ p(A B)

p(A ) > 0

(

p( B) > 0

) (

)

(

p(A 1∩K∩A n ) = p(A 1 ) ⋅ p A 2 A 1 ⋅ p A 3 A 1 ∩ A 2 ⋅K⋅p A n A 1 ∩ A 2 ∩K∩A n −1

)

3.2.2 MARKOV-Kette

(

) (

)

) = p(A ) ⋅ p(A A ) ⋅ p(A A )⋅K⋅p(A

A 1K A n mit p A k A 1∩K∩A k −1 = p A k A k −1 → MARKOV-Kette

→ p(A 1∩K∩A n

1

2

1

3

2

n

A n −1

)

3.2.3 Satz von der totalen Wahrscheinlichkeit

A 1K A n Zerlegung von Ω

p( B) = ∑ p(A k ) ⋅ p( B A k )

n

k =1

3.2.4 Pfadregeln

1. Die Wahrscheinlichkeit für das Eintreten eines Pfades ist gleich dem Produkt der Wahrscheinlichkeiten der

Äste des Pfades

2. Die Wahrscheinlichkeit eines Ereignisses ist gleich der Summe der Wahrscheinlichkeiten derjenigen Pfade,

die das Ereignis bilden.

3.2.5 Formel von BAYES

(Ω, A , p) WR A 1 ,K , A n ∈ A

p(A k ) ⋅ p( B A k )

(

)

p Ak B =

∑ p( B A ) ⋅ p(A )

n

j= 1

j

Zerlegung von Ω p(A k ) > 0, B ∈ A , p( B) > 0

für k = 1K n

j

- Seite 2 -

- Gerald Meier: Stochastik Formeln -

3.2.6 Stochastische Unabhängigkeit

p(A ∩ B) = p(A ) ⋅ p( B)

A und B unabhängig → p(A ) = p(A B) , p( B) = p( B A )

pI A j = ∏ p A j

j∈J j∈J

( )

3.3 BERNOULLI-Verteilung

p(ω) = p k ⋅ (1 − p)

n− k

4 Zufallsvariablen

5 Diskrete Zufallsvariablen

Verteilungsfunktion VF: FX ( x) =

p( x m ≤ X ≤ x n ) =

∑p

k:x k ≤ x

k

n

∑pk

k=m

5.1 Gleichverteilung / LAPLACE-Verteilung

X(Ω) = {x1 , K , x n }

p k = p( X = x k ) =

1

n

k=1,...,n

Anwendung: Bei Zufallsvariablen ZVa mit endlich vielen Werten, die keinen bevorzugen.

5.2 Geometrische Verteilung

X(Ω) = N 0

p k = p( X = k ) = p ⋅ (1 − p)

k

Anwendung: ∞-stufiges BERNOULLI-Experiment.

5.3 Binominalverteilung

X(Ω) = N 0

n

n− k

p k = p( X = k ) = b( k; n, p) = ⋅ p k ⋅ (1 − p)

k

Anwendung: n-stufiges BERNOULLI-Experiment (Ziehen mit Zurücklegen). Es werden n Teile herausgegriffen.

Die Wahrscheinlikeit ein Ausschußteil zu ziehen ist p. Es weren k Ausschußteile gezogen.

Wahrscheinlichste Anzahl von Erfolgen: für festes n, gesucht k bei dem p maximal wird

k = k max = [( n + 1) ⋅ p] - Nachkommastellen werden abgeschnitten

( n + 1) ⋅ p ∈ N → k max,1 = ( n + 1) ⋅ p , k max,2 = k max,1 − 1

Wahrscheinlichkeit dafür, daß Erfolgsanzahl aus Intervall stammt: p( k 1 ≤ X ≤ k 2 ) =

k2

n

∑ k ⋅ p ⋅ (1 − p)

k

n− k

k = k1

5.4 POISSON-Verteilung

X(Ω) = N 0

p k = p( X = k ) = p( k; λ): =

Für n>>1 und p<<1 ist b( k; n, p) ≈ p( k; n ⋅ p)

λk − λ

⋅e

k!

λ>0

Anwendung: Die POISSON-Verteilung wird als Näherung für die Binominaverteilung verwendet - unter oben

aufgeführten Voraussetzungen.

- Seite 3 -

- Gerald Meier: Stochastik Formeln -

5.5 Hypergeometrische Verteilung

N, M, n ∈ N, N − M ≥ 0

M N − M

⋅

k n−k

p k = p( X = k ) = h( k; n, M , N − M ) =

X(Ω) = N 0

N

n

p k ≠ 0 nur für k ≤ n, k ≤ M , n − k ≤ N − M

Anwendung: Stichproben ohne Rückgabe: Der Posten umfaßt N Teile - darunter M Ausschußteile. n Teile

werden entnommen, darunter k Ausschußteile.

Grenzwertsatz: lim h( k; n, M , N − M ) ≈ b( k; n, M N )

N →∞

M = pN

5.6 MOIVRE-LAPLACE-Asymptotik

STIRLING-Formel: n! ≅ n n ⋅ e − n ⋅ 2πn für n → ∞

Definitionen: ϕ( x) =

1

2π

⋅e

−

x2

2

GAUSS-/Normalfunktion

x

G ( x) = ∫ ϕ( t )dt

−∞

erf ( x) = G ( x) − 21

Fehlerfunktion

Satz: G (∞) = 1

G (− x) = 1 − G ( x)

1

G ( x) ≅ 1 − ⋅ ϕ( x)

x

MOIVRE-LAPLACE-Asymptotik

k - np

gilt für n, k → ∞

Mit 0 < p < 1, q = 1- p, x =

npq

k − np

⋅ ϕ

npq npq

Damit erhält man gute Näherungen für npq > 9 . Damit gilt für BERNOULLI-Experimente

k − np

k − np

− G 1

p( k 1 ≤ X ≤ k 2 ) ≅ G 2

npq

npq

oder genauer

k − np + 0,5

k − np − 0,5

− G 1

p( k 1 ≤ X ≤ k 2 ) ≅ G 2

npq

npq

n

b( k; n, p) = ⋅ p k ⋅ q n − k ≅

k

1

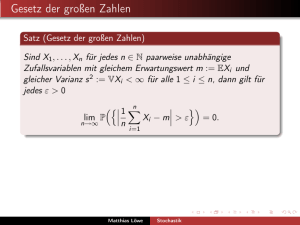

5.7 BERNOULLI-Gesetz der großen Zahl

n-stufiges BERNOULLI-Experiment mit der Erfolgswahrscheinlichkeit p. k Anzahl des Eintretens eines

bestimmten Ereignisses, h n = k n die relative Häufigkeit. Für jedes ε > 0 gilt

(

)

p h n − p ≤ ε → 1 für n → ∞

6 Stetige Zufallsvariablen

x

Verteilungsfunktion: FX =

∫ f ( t )dt

Dichte(-funktion): f

−∞

p( a ≤ X ≤ b) = p( a < X ≤ b) =K = FX ( b) − FX ( a )

Dichte symmetrisch bezüglich a → p( X ≤ a − x) = p( a + x ≤ X) → p( a − x) = p( a + x)

- Seite 4 -

- Gerald Meier: Stochastik Formeln -

6.1 Normalverteilung

(

)

ZVa X normalverteilt mit Parametern µ und σ ( µ, σ > 0) bzw. N µ, σ -verteilt:

2

(

)

1

Dichte: f X ( x): = ϕ x; µ, σ : =

2

2 πσ

( x− µ )

⋅e

2

=

2σ

2

x− µ

⋅ ϕ

σ σ

1

2

x

x− µ

2

2

Verteilungsfunktion: FX ( x): = Φ x; µ, σ : = ∫ ϕ x; µ, σ dx = G

σ

−∞

b− µ

a−µ

p( a < X < b) = G

p( X − µ < kσ) = 2 G ( k ) − 1

− G

σ

σ

(

)

p( X − µ < σ) = 0,683

(

(

ϕ x; µ, σ

2

) symmetrisch zu x = µ

)

p( X − µ < 2σ) = 0,955

p( X − µ < 3σ) = 0,997

Anwendung: Die Zufallsvariable ZVa entsteht durch Überlagerung einer großen Anzahl unabhängiger Effekte,

wobei jeder nur einen kleinen Einfluß auf die ZVa hat (Meßfehler,...).

6.2 Exponentialverteilung

ZVa exponentialverteilt mit Parameter α (α > 0) :

0

für x < 0

Dichte: f X ( x) =

- αx

für x ≥ 0

α ⋅ e

0

für x < 0

Verteilungsfunktion: FX ( x) =

− αx

für x ≥ 0

1 − e

p( X ≤ x + h X ≥ x) = p( X ≤ h) ∀x, h > 0 ⇔ X ist exponentialverteilt

Anwendung: Lebensdauer von Schaltelementen, radioaktiver Zerfall, ...

6.3 Funktionen von ZVa mit Dichten

f Y ( x) =

Y = g( X )

1.) g′ > 0

d

dx

FY ( x) =

→

f Y ( x) =

d

dx

→

f Y ( x) =

d

dx

→

f Y ( x) =

d

dx

d

dx

p( g( X) ≤ x)

(

)

g′( g ( x))

f ( g ( x) )

F ( x) =

g′( g ( x))

f ( x ) + f (− x )

( )

FY ( x) =

−1

f X g ( x)

−1

−1

2.) g′ ≠ 0

3.) g( x) = x

2

X

−1

Y

FY x =

X

X

2 x

→ weiteres Seite 35

6.4 ZVa vom gemischten Typ

ZVa vom gemischten Typ ↔ nicht stetig und diskret

Sprungstellen x k mit Sprunghöhe: p k = p X = x k

(

x

Verteilungsfunktion: FX ( x) = ∫ f X ( t )dt +

−∞

∑p

k :x k ≤ x

)

k

7 Charakteristische Größen

7.1 Erwartungswert

7.1.1 diskrete ZVa

Erwartungswert: EX = ∑ x k ⋅ p k

k

- Seite 5 -

- Gerald Meier: Stochastik Formeln -

1

⋅ ∑ pk

n k

EX = n ⋅ p

EX =

diskrete Gleichverteilung:

Binomialverteilung:

Hypergeometrische Verteilung: EX = n ⋅ p = n ⋅

EX = λ

POISSON-Verteilung:

M

N

7.1.2 stetige ZVa

∞

Erwartungswert: EX = ∫ x ⋅ f X ( x)dx

−∞

a+b

Gleichmäßige Verteilung: EX =

2

EX = µ

1

EX =

α

Normalverteilung:

Exponentialverteilung:

7.1.3 ZVa vom gemischten Typ

xk = k ⋅ h

Mittelwert: X =

∞

∑x

k =−∞

k

⋅ pk

∞

Erwartungswert: EX = ∫ xdF( x) = lim X h

h →∞

−∞

7.1.4 Rechenregeln

E( aX + b) = aEX + b

E( X − EX) = 0 X → X-EX heißt zentrieren

( )

diskrete ZVa: E( g( X)) = ∑ g x i ⋅ p i

∞

i

stetige ZVa: E( g( X)) = ∫ g( x) ⋅ f X ( x)dx

−∞

X → X-EX heißt Zentrierung

7.2 Varianz und Standardabweichung

Varianz: D X:= E( X − EX)

2

2

Standardabweichung: σX := D X

2

7.2.1 diskrete ZVa

2

D X:=

diskrete Gleichverteilung:

1

n

∑x

k

2

k

1

− ∑ xk

n k

D X:= n ⋅ p ⋅ (1 − p)

2

2

Binomialverteilung:

Hypergeometrische Verteilung: D X:= n ⋅ p ⋅ (1 − p ) ⋅

2

D X=λ

2

POISSON-Verteilung:

N−n

N −1

7.2.2 stetige ZVa

2

stetige Gleichverteilung: D X:=

Normalverteilung:

( b − a)2

D X:= σ

2

12

2

- Seite 6 -

p=

M

N

- Gerald Meier: Stochastik Formeln -

1

2

D X:=

α

Exponentialverteilung:

2

7.2.3 Rechenregeln

( )

D X:= E X − ( EX)

2

2

2

2 X

D = 1

σX

2

E( X − c) = minimal ⇔ c = EX

2

2

2

D ( aX + b ): = a ⋅ D X

X→

X

heißt Normierung

σX

X − EX

heißt Standardisierung

X→

σX

7.2.4 TSCHEBYSCHEFF-Ungleichung

p( X − EX ≥ c) ≤

2

D X

c

p( X − EX > c) <

2

p( X − EX ≤ c) > 1 −

2

D X

c

2

2

D X

c

p( X − EX < c) ≥ 1 −

2

2

D X

c

2

Weitere charakteristische Größen → Skript Seite 39 ff

8 Zufallsvektoren

8.1 Definition und Verteilungsfunktion

X

1

n

n-dimensionaler Zufallsvektor n-ZVe: X = M :Ω → R

Xn

x < y ⇔ x k < y k ∀k = 1,K , n

X < x: = {ω X(ω) < x}

Verteilungsfunktion: FX ( x) = p( X ≤ x) für x ∈ R

n

Sätze: 0 ≤ FX ( x) ≤ 1

FX ist in jeder Variablen xk monoton wachsend

FX ist in jeder Variablen xk rechtsseitig stetig

lim FX ( x) = 0 für alle k

x k →−∞

lim FX ( x) = 1 für alle k

x k →∞

Definitionen: FX = lim FZ ( x, y , u) Rand- oder Marginalverteilung

y , u →∞

F( X ,Y ) = lim FZ ( x, y , u)

u →∞

FX ( x y , u ) = p( X ≤ x Y = y , U = u ) bedingte Verteilungsfunktion von X

(

)

( )

( )

ZVa X1,...,Xn unabhängig FZ x1 ,K , x n = F1 x1 ⋅K⋅Fn x n

8.2 Diskrete n-ZVe

o.B.d.A. n=2

Einzelwahrscheinlichkeit EW: p ik = p X = x i , Y = y k

(

)

- Seite 7 -

- Gerald Meier: Stochastik Formeln -

Verteilungsfunktion VF:

F( X ,Y ) ( x, y ) =

∑p

ik

i , k :x i ≤ x , y k ≤ y

- Seite 8 -

- Gerald Meier: Stochastik Formeln -

(

)

:= p( Y = y ) = ∑ p

p i . := p X = x i = ∑ p ik

EW der Randverteilung:

k

p .k

unabhängige X und Y ⇔

k

ik

i

p ik = p i . ⋅ p .k

8.3 (Absolut-) Stetige ZVe

o.B.d.A. n=2

x y

FZ ( x, y ) =

Verteilungsfunktion VF:

Dichte der Randverteilung: f X ( x ) =

∫ ∫ f ( x, y)dydx

Z

−∞−∞

∞

∫ f(

−∞

X ,Y )

( x, y)dy

f ( X ,Y ) ( x, y )

Dichte der bedingten VF:

f X ( x y) =

X un Y unabhängig ⇔

f ( X , Y ) ( x , y ) = f X ( x) ⋅ f Y ( y )

f Y ( y)

8.4 Charakteristische Größen

o.B.d.A. n=2

∞

∞ ∞

−∞

−∞−∞

Erwartungswert: EX = ∫ x ⋅ f X ( x)dx =

∞ ∞

∫ ∫ x ⋅ f ( x, y)dxdy

Z

∫ ∫ g( x, y) ⋅ f ( x, y)dxdy

Eg( X, Y) =

Z

−∞−∞

(

)

bei diskreten ZVa: Eg( X , Y) = ∑ g x i , y k p ik

i ,k

(

)

Rechenregeln: E X1 +K+ X n = EX1 +K+ EX n

ZVa unabhängig ⇒ E( X, Y) = EX ⋅ EY

Kovarianz: cov( X, Y) = E( X − EX) ⋅ E( Y − EY)

→ cov( X, X) = D X

2

→ cov( X, Y ) = E( X, Y ) − EX ⋅ EY

→ cov( X, Y) = 0 ⇐ X, Y unabhängig

2

2

2

→ D ( X + Y ) = D X + D Y + 2 cov( X, Y)

n

n 2

2

→ X1,...,Xn paarweise unabhängig ⇒ D ∑ X i = ∑ D X i

i =1 i =1

(

Kovarianzmatrix: Bik = cov X i , X k

)

→ Skript Seite 47

Korrelationskoeffizient: ρ( X, Y) =

cov( X, Y )

D X⋅ D Y

→ ρ( X, Y) ≤ 1

2

2

→ ρ( X , Y) = 1 ⇔ Y = aX + b mit sgn( a ) = sgn( ρ)

→ ρ( X, Y) = 0 ⇐ X und Y sind unabhängig

→ ρ=0 unkorreliert, ρ>0 positiv korreliert, ρ<0 negativ korreliert

- Seite 9 -

- Gerald Meier: Stochastik Formeln -

9 Grenzwerte

9.1 Konvergenz

Xn konvergiert sicher gegen X

falls lim X n ( ω) = X(ω)

X n → X

Xn konvergiert fast sicher gegen X

falls pω lim X n ( ω) = X(ω) = 1

n →∞

Xn

→ X

Xn konvergiert stochastisch gegen X

falls lim p X n − X < ε = 1 ∀ε > 0

X n → X

Xn konvergiert in Verteilung gegen X falls lim FX n ( x) = FX ( x )

Definitionen: X n

→ X

s

fs

p

iV

n →∞

n →∞

(

)

n →∞

Hierarchie: X n

→ X ⇒ X n → X ⇒ X n

→ X ⇒ X n → X

s

fs

p

iV

9.2 Übersicht

Kolmogoroff

n

2

∑ Xk − EXk

k =1

E

→0

n

2

2

n + ∑ Xk − EXk

k =1

(

)

(

)

Markov

Xn genügt schwG

D Xn → 0

2

Tschebyscheff

xn unabhängig

oder unkorreliert

D Xn → 0

2

Kolmogoroff

xn unabhängig

2

∞

D Xk

∑ 2 <∞

k =0 n

Poisson

xn unabhängig

2-Pkt.-Verteilung

Xn genügt stG

xn unabhängig

identisch

D Xn muß nicht∃

2

- Seite 10 -

Bernoulli

xn unabhängig

2-Pkt.-Verteilung

identisch