Rechnerübung Simulation

Werbung

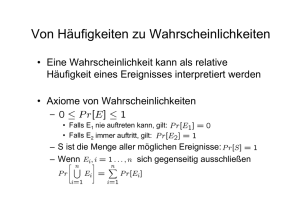

LEHRSTUHL FÜR TECHNISCHE DIENSTLEISTUNGEN UND OPERATIONS MANAGEMENT TECHNISCHE UNIVERSITÄT MÜNCHEN Rechnerübung Simulation Übungsaufgaben mit Musterlösungen Dipl.-Wirt.-Inf. Philipp Melchiors Report SOM – 1 3. Auflage Januar 2010 TECHNICAL REPORT Arcisstraße 21, 80333 München, Germany All rights reserved. No part of this publication may be reproduced or transmitted in any forms or by any means, electronic or mechanical, including photography, recording, or any information storage and retrieval system, without permission in writing form from the author. 1 Grundlagen der Simulation a) Beschreiben Sie den Zusammenhang zwischen System, Zustand, Ereignis und Modell. Ein System ist eine Gruppe von Objekten, die miteinander durch regelmäßige Interaktionen oder Abhängigkeiten im Hinblick auf einen Zweck vereinigt sind. Ein Systemzustand wird durch die zu einem Zeitpunkt t relevanten Eigenschaften (repräsentiert durch Zustandsvariablen) der Systemelemente charakterisiert. Ereignisse sind augenblickliche Erscheinungen z. B. Ankunft eines Kunden, die zu einer Änderunmg des Systemzustandes führen z.B. durch Änderung des Wertes der Variable WIP eines Process-Moduls. Ein Modell ist eine Repräsentation eines Systems mit dem Zweck das System zu untersuchen. b) Beschreiben Sie das grundlegende Vorgehen bei Simulation 1. Problemformulierung und Planung der Studie. 2. Definition der Ziele von Simulation. 3. Formulierung eines (konzeptionellen) Modells. 4. Erhebung von Daten. 5. Übersetzung des konzeptionellen Modells in ein softwarebezogenes Modell. 6. Prüfung, ob übersetztes Modell das reale System repräsentiert (Validierung). 7. Experimentdesign. 8. Simulationsläufe. 9. Analyse der Ergebnisse 10. Dokumentation (des Simulationsmodells und des Simulationsprojektes). c) Erläutern Sie die Funktion von Statistical Accumulators und nennen Sie ein Beispiel. Statistical Accumulators sind Variablen, die das System beobachten und passiv sind i. S. v. Nicht-Teilnahme am Geschehen. Beispiel: Die bislang maximale Warteschlangenlänge wird nicht im Simulationsmodell verwendet, sondern dient lediglich Auswertungszwecken. 2 Simulation mit ARENA a) Skizzieren Sie kurz die Funktion der folgenden Module 1. Process: Definition von Prozessen 2. Schedule: Spezifikation von zeitabhängigen Größen durch Angabe von Paaren aus Wert der Größe u. Dauer, für die der Wert festgelegt ist. 3. Record: Erstellung von Aufzeichnungen von definierten Punkten eines Simulationsmodells. 4. Create: Generierung von Entities, die durch das System laufen. b) Erstellen Sie das Flow-Chart (keine Submodelle) für den im folgenden beschriebenen Prozess (einschließlich der Ankunftsprozesse) und geben Sie an, welche ARENAFlow-Chart-Module Sie verwenden. Geben Sie den Modulen aussagekräftige Namen, so dass deren Funktion im Modell ersichtlich wird: Eine Verpackungsmaschine verpackt 2 Arten von Produkten: Produkt 1 wird nur in eine Folie eingeschweisst, während Produkt 2 zusätzlich noch in einen Karton gesteckt wird. Beachten Sie, dass die Maschine lediglich 1 Produkt gleichzeitig bearbeiten kann. Da der Verpackungsprozess 2 alternative Vorgehen hat (Produkt 1 wird nur eingeschweisst, während Produkt 2 erst eingeschweisst und anschließend in einen Karton gesteckt wird), wird hier der Prozess detailliert unter Verwendung von Seize, Delay und Release-Modulen modelliert. Mögliche Modellierung des Sachverhalts: Create Ankunft Produkt 1 Seize Decide Delay 0 0 True Maschinenbelegung Create Delay Produkt 2? Einschweissen Verpacken in Karton Release Maschinenfreigabe Dispose Abgang 0 0 Ankunft Produkt 2 False 0 c) Erläutern Sie kurz, mit welchen Modulen sich zeitabhängige Ankunftsprozesse modellieren lassen. Mit Schedule: Type: Arrival: Ankunftsrate spezifiziert durch Wert und Dauer der Gültigkeit. Im Create-Modul unter der Rubrik Time Between Arrivals: Angabe des Namen des Schedule-Moduls und Type: Schedule. Bemerkung: Alternativ lässt sich die Modellierung auch mit einem Schedule vom Typ other realisieren, wobei mit dem Schedule eine zeitvariante Größe spezifiziert werden kann. Der Name des Schedule lässt sich dann als Parameter im Rahmen einer Verteilungsspezifikation für die Zwischenankunftszeiten (Time Between Arrivals) im Create-Modul nutzen. 3 Input-Analyse a) Erläutern Sie das grundlegende Vorgehen bei der Input-Analyse. 1. Sammlung von Daten über das interessierende System. 2. Identifikation einer Familie von Wahrscheinlichkeitsverteilungen z. B. PoissonVerteilung, Normalverteilung über den betrachteten Teilprozess. 3. Wahl von Parametern, die eine spezifische Instanz einer Verteilungsfamilie bestimmen. 4. Bewertung einer gewählten Verteilung z. B. mit Anpassungstests. b) Welche Verteilung würden Sie für die Beschreibung der Dauer eines mehrstufigen Produktionsprozesses verwenden, bei der die Dauern der einzelnen Stufen jeweils mit Parameter λ exponentialverteilt sind? Erlang-Verteilung c) Welche Funktion haben Anpassungstests im Rahmen der Input-Analyse ? Nennen Sie die beiden Anpassungstests, die vom Input-Analyzer unterstützt werden und erläutern Sie, wann welcher Test verwendet werden sollte? Mit Anpassungstests wird geprüft, ob die Annahme, dass eine Verteilung aufgrund einer vorliegenden Stichprobe als gerechtfertigt angesehen werden kann. Die Parameter der Verteilung sind typischerweise empirisch aus Stichprobendaten geschätzt. Tests, die vom Input-Analyzer unterstützt werden: – χ2 -Test – Kolmogorov-Smirnov-Test Der χ2 -Test wird bei hinreichend großen Stichproben verwendet, so dass die erwartete Häufigkeit für alle Kategorien gegeben mindestens 5 beträgt. Der Kolmogorov-Smirnov-Test kann auch für kleinere Stichprobengrößen verwendet werden. Nachteil ist allerdings, dass wenn Verteilungsparameter geschätzt werden, das Signifikanzniveau unterschätzt wird. Daher sollte bei hinreichend großen Stichproben der χ2 -Test bevorzugt werden. Beispiel (nicht Teil der Antwort): Setzt man den kritischen Wert der Test-Statistik des K-S-Tests für ein Signifikanzniveau von 5%, dann kann es sein, dass bei Zutreffen von der Verteilungshypothese H0 der kritische Wert nur mit einer Wahrscheinlichkeit von z. B. 2% überschritten und damit geringeres Signifikanzniveau erreicht wird. Dies bedeutet, dass die Wahrscheinlichkeit dafür, dass eine zutreffende Verteilungsannahme irrtümlicherweise verworfen wird (Fehler 1. Art), sinkt. Deswegen wird der Test auch als konservativ bezeichnet. Gleichzeitig steigt die Wahrscheinlichkeit, dass eine falsche Verteilungsannahme akzeptiert wird (Fehler 2. Art). Erläuterung zum Prinzip der Anpassungstests (nicht Teil der Antwort): Es wird unterstellt, dass die Beobachtungswerte einer bestimmten aber unbekannten Verteilung folgen. Die Beobachtungswerte stellen eine Stichprobe dar, die man sich als das 4 Resultat einer Folge von Zufallsexperimenten vorstellen kann, wobei das Ergebnis eines Zufallsexperimentes der unbekannten Verteilung folgt. Mit Hilfe der zu testenden theoretischen Verteilung (deren Parameter auf Basis von Stichprobendaten geschätzt worden sind) soll die unbekannte Verteilung approximiert werden. Um zu testen, ob die Verteilung die unbekannte Verteilung der Grundgesamtheit (aller möglichen Beobachtungswerte) hinreichend gut approximiert, wird zunächst die Hypothese (H0 ) aufgestellt, dass die geschätzte zu testende Verteilung der ungekannten Verteilung entspricht. Grundidee bei dem χ2 -Test (und dem KolmogorovSmirnov (KS)-Test) ist, dass die (relativen) Häufigkeiten in dem Histogramm einer Stichprobe und der Verlauf der Wahrscheinlichkeitsfunktion bzw. Dichte-Funktion der Warscheinlichkeitsverteilung ähnlich sein sollten abgesehen von Unterschieden aufgrund des Zufalls bzw. der Tatsache, dass die Stichprobe nur einen begrenzten Umfang hat (Gesetz der großen Zahlen). Die Abweichung der Daten der Stichprobe zu den theoretisch zu erwartenden Daten der zu testenden Verteilung wird durch ein bestimmtes Testgröße z. B. T bei dem χ2 -Test ermittelt. Durch die Abweichung, gemessen durch die Testgröße, lassen sich nun alle möglichen Stichprobenereignisse charakterisieren. Da nun für die Testgröße die Wahrscheinlichkeitsverteilung bekannt ist (unter der Annahme von H0 ), lässt sich nun über den Wertebereich der Testgröße ein (nicht-kritischer) Bereich definieren (beginnend mit 0 und nach oben beschränkt durch einen kritischen Wert). In diesem liegt der Wert der Testgröße unter Annahme, dass H0 zutrifft mit einer Wahrscheinlichkeit von 1 − α. Falls nun die Testgröße außerhalb dieses Bereiches d.h. oberhalb des kritischen Wertes (und damit im kritischen Bereich) liegt, so liegt ein unter der Annahme H0 ein Fall vor, der zu den nur selten auftretenden Fällen (gekennzeichnet durch eine ungewöhnlich hohe Abweichung) gehört, so dass angenommen werden kann, dass H0 nicht zutrifft. Die Größe α wird auch als Signifikanzniveau des Tests bezeichnet und gibt die Wahrscheinlichkeit an, dass für den Fall, dass H0 doch zutrifft, H0 irrtümlicherweise abgelehnt wird (Fehler 1. Art), da ein solcher seltener Fall aufgetreten ist. d) Geben sind die Anzahl der Kundenankünfte pro Stunde, die in einem Beobachtungszeitraum von 100 Stunden festgestellt worden sind. Es wird eine Poissonverteilung unterstellt. Schätzen Sie den fehlenden Parameter und führen Sie den χ2 -Test durch. Kann an der Hypothese der Poissonverteilung mit dem geschätzten Parameter festgehalten werden, wenn ein Signifikanzniveau von 5% unterstellt wird? n Oi 1 3 2 12 3 10 4 20 5 19 6 12 7 13 8 3 9 5 10 2 11 0 12 1 5 Zunächst muss der Parameter der Poissonverteilung geschätzt werden: Die Wahrscheinlichkeitsfunktion der Poissonverteilung (als Verteilungsfamilie) lautet: f (x) = λx −λ ·e x! λ ist die mittlere Ankunftsrate pro Zeiteinheit (hier Stunde). 3 · 1 + 12 · 2 + 10 · 3 + ... + 10 · 2 + 1 · 12 100 = 4, 96 λ = Damit ergibt sich als Wahrscheinlichkeitsfunktion: f (x) = 4, 96x −4,96 ·e x! Durchführung des χ2 -Tests: Oi =beobachtete Häufigkeit Ei theoretisch erwartete Häufigkeit= pi · n mit n =Stichprobenumfang pi Wahrscheinlichkeit für Kategorie i k =Anzahl Kategorien Test-Größe/-Statistik: T = k X (Oi − Ei )2 i=1 Ei Für jede Kategorie k muss gelten Ei > 5. n Oi 1 3 2 12 3 10 4 20 5 19 6 12 7 13 8 3 9 5 10 2 11 0 12 1 Ei f (1) · 100 = 0, 035 · 100 = 3, 5 f (2) · 100 = 0, 086 · 100 = 8, 6 14,3 17,7 17,5 14,5 10,3 6,4 3,5 1,7 0,8 0,3 Da für die Kategorien 1 und 2 sowie 9-12 Ei < 5 ist, können diese Kategorien zusammengefasst werden und man erhält: 6 n 1-2 3 4 5 6 7 8 9-12 Oi 15 10 20 19 12 13 3 8 Ei 12,1 14,3 17,7 17,5 14,5 10,3 6,4 6,3 Nun kann die Testgröße berechnet werden und man erhält: T = k X (Oi − Ei )2 i=1 Eu (15 − 12, 1)2 (10 − 14, 3)2 (20 − 17, 7)2 (8 − 6, 3)2 + + + ... + 12, 1 14, 3 17, 7 6, 3 = 5, 819 = Das Signifikanzniveau beträgt α = 0, 05. Für die Anzahl der Freiheitsgrade ν der χ2 -Verteilung ergibt sich k − s − 1 = 8 − 1 − 1 = 6 mit s =Anzahl der geschätzten Parameter der Verteilung (Hier nur 1 Parameter: λ). Damit ergibt sich als kritischer Wert T6;0,05 = 12, 6 (in der Quantil-Tabelle in der Zeile für ν = 6 und der Spalte χ20,05 abzulesen). (Hinweis: In der Literatur wird zur Bezeichnung der Testgröße statt T auch χ2 verwendet.) Da offensichtlich T = 5, 819 < T6;0,05 = 12, 6, kann die Hypothese H0 , dass die geschätzte Verteilung die unbekannte Verteilung in der Realität repräsentiert, nicht fallengelassen werden. e) Was bedeutet der p-Wert in der Ausgabe des Input-Analyzers. Bei welchen Werten ist es empfehlenswert eine bestimmte Verteilung zu verwenden? Der p-Wert gibt das Signifikanzniveau des Tests an (Wahrscheinlichkeit, dass H0 irrtümlicherweise abgelehnt würde, wenn H0 wahr ist), wenn der berechnete Testgrößenwert der kritische Wert wäre. Alternativ kann man auch sagen, dass der p-Wert die Wahrscheinlichkeit angibt, mit welcher der Wert der Testgröße oder Teststatistik der aktuellen Stichprobe (bei Erfüllung von H0 ) bei einer beliebigen Stichprobe (auch einer anderen Stichprobe derselben Grundgesamtheit) überschritten wird. Ab einem Wert von p ≥ 0, 1 kann von einer guten Übereinstimmung zwischen der bestimmten Verteilung und den Stichprobendaten (bzw. deren Verteilung), und ab einem Wert von p < 0, 05 von einer schlechten Übereinstimmung ausgegangen werden. Erläuterung (nicht Teil der Antwort): Ist der p-Wert hoch, so bedeutet dies, dass die Häufigkeitsverteilung einer beliebigen Stichprobe von dem Umfang der aktuellen Stichprobe bei Annahme der Hypothese H0 , mit hoher Wahrscheinlichkeit p eine größere Abweichung von der theoretischen Wahrscheinlichkeitsverteilung besitzt, als die in der aktuellen Stichprobe gemessene Abweichung. Daher kann man von einer guten Entsprechung der unbekannten Verteilung und der zu testenden 7 Verteilung ausgehen. 8 Ergebnis-Analyse a) Die folgende Ausgabe wurde nach einem Simulationsexperiment mit 50 Replikationen und einer Replikationslänge von 10000 Stunden erhalten: Erläutern Sie die Bedeutung der Angaben mit jeweils einem Satz. – Average: Mittelwert der replikationsbezogenen Mittelwerte der Warteschlangenlänge. – Half Width: Halbe Breite des 95%-Konfidenzintervalls, um diesen Mittelwert. – Maximum Average: Maximaler replikationsbezogener Mittelwert (X r ). – Minimum Average: Minimaler replikationsbezogener Mittelwert. – Minimum Value: Minimaler beobachteter Wert der Warteschlangenlänge aller Replikationen. – Maximum Value: Maximaler beobachteter Wert der Warteschlangenlänge aller Replikationen. b) Schätzen Sie ab, um wieviel sich die Halbbreite verringert, wenn Sie die Anzahl der Replikationen verdoppeln. Da der Stichprobenumfang n ≥ 30 kann eine Approximation der t-Verteilung durch die Standardnormalverteilung erfolgen und man erhält für das Konfidenzintervall, wenn man die Formel von Folie 178 (Skript) verwendet: Ã S S P X − z1−α/2 √X r ≤ µ ≤ X + z1−α/2 √X r R R ! =1−α X ist der Mittelwert über alle replikationsbezogenen Mittelwerte X r . R ist die Anzahl Replikationen. Bemerkung: Verwendet man alternativ die Formel von Folie 183 (Skript) zur Schätzung der Varianz von X, so kann man auch schreiben: ³ ´ P X − z1−α/2 SX ≤ µ ≤ X + z1−α/2 SX = 1 − α Im folgenden wird allerdings die erstere Formulierung verwendet: Damit ist die Halbbreite gegeben durch: S z1−α/2 √X r R Bei einem 95% Konfidenzintervall ist α = 0, 05. Damit ist z = z0,975 = 1, 96. Um die Halbbreite bei R = 100 abzuschätzen, fehlt noch die Abschätzung für die Standardabweichung SX r . Die lässt sich aus den Angaben wie folgt berechnen: S √X r · 1, 96 = 10, 41 ⇐⇒ SX r = 37, 556 50 9 Damit ergibt sich für die Halbbreite bei 100 Replikationen: 37, 556 √ · 1, 96 = 7, 361 100 Hinweis zur Berechnung der Varianz: 2 SX ist der Schätzer für die Varianz der replikationsbezogenen Mittelwerte X r um r den Mittelwert X und wird daher wie folgt berechnet (siehe auch Skript zum Varianzschätzer S. 172): 2 SX = r R ³ ´2 1 X Xr − X R − 1 r=1 2 SX ist der Schätzer für die Varianz von X und wird wie folgt berechnet (siehe auch Formel im Skript S.183): 2 SX = R ³ ´2 X 1 2 1 SX r = Xr − X R R · (R − 1) r=1 Hintergrund ist der Zusammenhang zwischen der Varianz der Stichprobenmittelσ2 2 wertes X und der Varianz der Zufallsvariablen X: σX = nX mit n als Stichprobenumfang. c) Wozu dient der Warm-Up? Bei Systemen, die im stationären Zustand betrachtet werden, besteht bei Simulation (im Gegensatz zu dem realen System) das Problem, dass in einem definierten Ausgangszustand z. B. System leer der Simulationszeitraum beginnt. Durch den Anfangszustand wird das Systemverhalten eine gewisse Zeit beeinflusst, was die Statistiken ggü. den Statistiken des realen Systems verzerren würde. Durch eine hinreichend lange Aufwärmphase, nach der die Statistiken gelöscht werden, wird sichergestellt, dass die Statistiken erst dann erfasst werden, wenn der Ausgangszustand das Systemverhalten nicht mehr beeinflusst (wie das auch bei dem realen System im stationären Zustand der Fall ist). 10 d) Erläutern Sie die Vorgehensweise bei Anwendung des Welch-Verfahrens zur Bestimmung der Warm-Up-Länge? 1. Durchführung einer Simulation mit R Replikationen mit m Beobachtungswerten. 2. Bildung eines Mittelwertes für jeden Beobachtungswert i über alle Replikationen X i = 1 R R P r=1 Xir . 3. Berechnung der zentrierten gleitenden Durchschnitte X i (w) über die Werte X i mit einer Gliederzahl 2w + 1. 4. Eintragung der Werte X i (w) in einen Graphen und Bestimmung des Zeitpunktes, ab dem der Graph einen gleichmäßigen Verlauf annimmt. Falls der Zeitpunkt nicht bestimmt werden kann, kann folgendes versucht werden: a) Erhöhung von w und Wiederholung ab Schritt 3 b) Falls auch für hohe w keine Bestimmung möglich ist, dann Durchführung weiterer Replikationen und Wiederholung ab Schritt 2. e) Um den Einfluss der Prioritätsregeln Kürzestete Operationszeit (KOZ), Größte Restbearbeitungszeit (GRB) und die Meisten Auszuführenden Arbeitsgänge (MAA) zu testen haben Sie ein Produktionssystem (vgl. Beispiel zu Sequenzen im Rahmen des Advanced Transfer Panels) für 10000 Zeiteinheiten (ohne Warm-Up) mit 10 Replikationen simuliert. Die folgende Tabelle zeigt für jede Replikation und Prioritätsregel die mittlere Durchlaufzeit (W S r ). Replikation 1 2 3 4 5 6 7 8 9 10 KOZ 25,59 25,00 25,65 26,50 25,41 26,66 24,58 25,11 26,76 25,38 GRB MAA 26,81 26,80 26,17 26,19 27,64 27,73 28,92 28,92 26,71 26,67 28,94 28,87 25,33 25,41 26,34 26,42 28,77 28,86 26,78 26,81 Prüfen Sie, ob die KOZ-Regel die beste Regel darstellt, indem Sie einen geeigneten Alternativenvergleich durchführen bei einem Konfidnenzniveau von 95%. Um zu prüfen, ob die KOZ-Regel die beste Regel darstellt, ist es sinnvoll diese als Referenzalternative zu verwenden. Bei K = 3 Alternativen müssen somit K − 1 = 2 paarweise Vergleiche durchgeführt werden. Dazu werden für jeden paarweisen Vergleich die mittlere Differenz über jede Replikation sowie die Varianz des Mittelwertes bestimmt. Ein Gesamtkonfidenzniveau von 95% für alle Vergleiche wird gefordert d.h. dass die Konfidenzintervalle um die einzeln Mittelwerte alle (gleichzeitig) mit einer Wahrscheinlichkeit von 95% die wahren Mittelwerte überdecken. Würde man die Konfidenzintervalle einzeln betrachten, so würde die Möglichkeit vernachlässigt werden, 11 dass die Intervalle zwar für sich genommen zwar die wahren Werte mit hoher Wahrscheinlichkeit überdecken, aber möglicherweise nicht gleichzeitg (Überdeckung des wahren Wertes durch ein Konfidenzintervall ist als Ereignis zu verstehen!). Dies hat zur Konsequenz, dass die Konfidenzniveaus für die einzelnen Vergleiche höher gesetzt werden müssen. Mit Hilfe der Bonferroni-Ungleichung erhält man als Konfidenzniveau für die Vergleiche: 1−α=1− 0.05 = 0, 975 = 97, 5% 2 Probe: Gemäß Bonferroni-Ungleichung erhält man damit das gewünschte GesamtKonfidenzniveau: 1− K−1 X αk = 1 − (K − 1)α = 1 − 2 · (1 − 0, 975) = 0, 95 = 95% k=1 Für die Differenzen der Vergleiche ergibt sich zunächst: Replikation 1 2 3 4 5 6 7 8 9 10 KOZ 25,59 25,00 25,65 26,50 25,41 26,66 24,58 25,11 26,76 25,38 GRB 26,81 26,17 27,64 28,92 26,71 28,94 25,33 26,34 28,77 26,78 ZGRB 1,22 1,17 1,99 2,42 1,30 2,28 0,75 1,23 2,01 1,40 MAA 26,80 26,19 27,73 28,92 26,67 28,87 25,41 26,42 28,86 26,81 ZM AA 1,21 1,19 2,08 2,42 1,26 2,21 0,83 1,31 2,10 1,43 Für den Mittelwert und die Varianz des Mittelwertes als Schätzer für die wahre aber unbekannte Differenz des ersten Vergleiches ergibt sich: 1 (1, 22 + 1, 17 + 1, 99 + 2, 42 + 1, 30 + 2, 28 + 0, 75 + 1, 23 + 2, 01 + 1, 40) 10 = 1, 577 ´ 1 1³ = (1, 22 − 1, 577)2 + (1, 17 − 1, 577)2 + . . . + (1, 40 − 1, 577)2 = 0, 03 10 9 Z GRB = SZ2 GRB Daraus ergibt sich für die Standardabweichung: SZ GRB = 0, 175 Da der Stichprobenumfang klein ist, muss hier die t-Verteilung für die Konfidenzintervallberechnung verwendet werden: Mit α = 0, 025 (97,5% Konfidenzniveau) wird das 99%-Quantil der t-Verteilung mit n − 1 = 9 verwendet: t0,99;9 = 2, 821. 12 Für die Halbbreite ergibt sich hGRB = 2, 821 · 0, 175 = 0, 494, so man für das erste Konfidenzintervall erhält: [1, 577 − 0, 494; 1, 577 + 0, 494] = [1, 083; 2, 071] Für den zweiten Vergleich ergibt sich zunächst für Mittelwert und Varianz des Mittelwertes: 1 (1, 21 + 1, 19 + . . . + 1, 43) = 1, 604 10 ´ 1 1³ = (1, 21 − 1, 604)2 + (1, 17 − 1, 604)2 + . . . + (1, 43 − 1, 604)2 = 0, 03 10 9 Z M AA = SZ2 M AA Da die Varianz gleich bleibt, bleibt auch die Halbbreite mit hM AA = 0, 569 gleich und man erhält folgendes Konfidenzintervall: [1, 604 − 0, 494; 1, 604 + 0, 494] = [1, 11; 2, 098] Da beide Konfidenzintervalle 0 nicht überdecken, kann bei einem Konfidenzniveau von 95% davon ausgegangen werden, dass die KOZ-Regel die beste Regel darstellt. 13