Kapitel 4 Intervallschätzer, einfache Hypothesentests und Prognosen

Werbung

Kapitel 4

Intervallschätzer, einfache

Hypothesentests und Prognosen

“The greatest enemy of knowledge is not

ignorance, it is the illusion of knowledge.”

(Stephen Hawking)

Im letzten Kapitel haben wir den Erwartungswert und die Varianz des OLSSchätzers berechnet und gezeigt, dass der OLS-Schätzer unter den Gauss-Markov

Annahmen erwartungstreu und effizient ist, d.h. nicht nur im Mittel richtig liegt,

sondern auch eine ‘größtmögliche Genauigkeit’ bietet.

Man beachte, dass die Gauss-Markov Annahmen über die Störterme keine spezifischen Verteilungsannahmen erforderten, sondern nur, dass die Störterme der Grundgesamtheit εi alle aus der gleichen Verteilung mit Mittelwert Null und konstanter

Varianz σ 2 stammen (also ‘identically distributed’ sind), und dass die Reihenfolge der

Ziehungen keine Rolle spielt, d.h. dass die εi untereinander stochastisch unabhängig

sind (E(εi εj ) = 0 für i 6= j).1 Dieses Annahmenset kann kompakt geschrieben werden als εi ∼ iid(0, σ 2 ). Das Modell mit diesem Annahmenset ist in der Literatur

als ‘Klassisches Lineares Regressionsmodell’ (CLRM für ‘classical linear regression

model’ ) bekannt.

Diese ‘größtmögliche Verlässlichkeit’ ist zwar beruhigend, aber für Entscheidungen

ist es manchmal trotzdem wichtig zu wissen, wie groß die ‘Genauigkeit’ tatsächlich

ist. Um etwas über die Genauigkeit aussagen zu können werden wir eine Formel

entwickeln, die es uns erlaubt, aus den Stichprobendaten ein Intervall zu berechnen,

das uns zusätzlich etwas über die ‘Genauigkeit’ des Schätzers verrät, einen Intervallschätzer. Die bekanntesten Intervallschätzer sind Konfidenzintervalle (‘confidence interval’, abgekürzt CI).

Auch Intervallschätzer beruhen auf der Idee der wiederholten Stichprobenziehungen

(repeated sampling). Ein Konfidenzintervall mit einem Signifikanzniveau von 5%

(d.h. α = 0.05) erlaubt z.B. die Aussage, dass wir damit rechnen können, dass von

100 Intervallen – die aus 100 Zufallsziehungen berechnet wurden – 95 Intervalle den

wahren Wert enthalten.

P P

Zur Erinnerung: E(U V ) =

i

j ui vj f (ui , vj ). Stochastische Unabhängigkeit bedeutet

f

(u

,

v

)

=

f

(u

)f

(v

),

bei

stochastischer

Unabhängigkeit gilt also E(U V ) =

i j

i

j

P P

u

v

f

(u

)f

(v

),

daraus

folgt

E(U

V

)

=

E(U

)E(V

).

i

j

i

j i j

1

118

Intervallschätzer, Hypothesentests und Prognosen

119

Für die Berechnung solcher Intervallschätzer benötigen wir erstmals die Annahme

der Normalverteilung. Wenn die Störterme εi neben den bereits früher angeführten Gauss-Markov Annahmen zusätzlich noch normalverteilt sind spricht man vom

CNLRM (Classical Normal Linear Regression Model ). Dies wird häufig kompakt

geschrieben als

yi = β0 + β1 xi + εi ,

εi ∼ nid(0, σ 2 )

wobei nid für ‘normally, independent and identically distributed’ steht. In Zukunft

werde ich dies häufig als εi ∼ N (0, σ 2) schreiben, wobei ich das Symbol N für die

Normalverteilung verwende (dagegen bezeichnet N die Stichprobengröße).

Zusätzlich wird implizit angenommen, dass die Verteilung der εi stochastisch unabhängig von der erklärenden x Variable ist (keine Endogenität). Dies ist auf jeden

Fall gewährleistet, wenn die erklärende x Variable deterministisch ist (‘fixed in repeated sampling’ ).

In diesem Fall gilt für yi = β0 +β1 xi +εi selbstverständlich auch yi ∼ N (β0 +β1 xi , σ 2 ),

denn aus der einführenden Statistik wissen wir, dass jede lineare Funktion einer

normalverteilten Zufallsvariable selbst wieder normalverteilt ist. Wenn also die εi

(und damit auch die yi ) normalverteilt sind, sind deshalb auch die OLS-Schätzer b

normalverteilt, P

denn wie wir bereits früherP

gezeigt haben sind OLS-Schätzer linear

in y (z.B. b1 = i wi yi mit wi = (xi − x̄)/ j (xj − x̄)2 , siehe Seite 93).

Wenn die OLS-Schätzer b0 und b1 normalverteilt sind kann man außerdem zeigen,

dass sie zudem varianzminimal in der Klasse aller erwartungstreuen Schätzfunktionen sind, unabhängig ob linear oder nicht (siehe C.R. Rao, 1965)!

In diesem Kapitel werden wir nun erstmals Gebrauch von der Normalverteilungsannahme machen und die bereits im letzten Kapitel berechneten OLS-Schätzer sowie

deren Standardfehler für statistische Tests und für die Bestimmung von Konfidenzintervallen verwenden.

Die Normalverteilungsannahme ist nicht ganz so restriktiv wie sie auf den ersten

Blick erscheinen mag, da einerseits die Störterme vieler datengenerierender Prozesse tatsächlich annähernd normalverteilt sind, und in anderen Fällen der zentrale

Grenzwertsatz unter nicht allzu strengen Annahmen sicher stellt, dass die Stichprobenkennwertverteilungen (sampling distributions) ziemlich rasch gegen eine Normalverteilung konvergieren, und deshalb zumindest asymptotisch gültig bleiben.

Sowohl für Hypothesentests als auch für die Berechnung von Konfidenzintervallen ist

eine Standardisierung von Zufallsvariablen erforderlich. Für diese Standardisierung

sind Erwartungswert und Standardfehler der geschätzten Parameter erforderlich.

Für die Berechnung der Standardfehler der Koeffizienten

P wird die Varianz von εi

(Var(εi ) := σ 2 ) benötigt, da z.B. Var(b1 ) := σb21 = σ 2 / (xi − x̄)2 . Da σ 2 ein unbeobachtbarer Parameter der Grundgesamtheit ist, muss ein Schätzer s2 dafür aus

den Stichprobendaten berechnet werden.PIm letzten Kapitel haben wir bereits gezeigt, dass für das bivariate Modell s2 = i e2i /(N − 2) ein solcher erwartungstreuer

Schätzer für σ 2 ist.

Im nächsten Abschnitt werden wir zunächst zeigen, dass wann immer wir für die

Standardisierung den geschätzten Standardfehler s2 anstelle des meist unbekannten

‘wahren’ σ 2 der Grundgesamtheit verwenden, die resultierende Teststatistik nicht

mehr normalverteilt ist, sondern t-verteilt ist.

Intervallschätzer, Hypothesentests und Prognosen

120

In den beiden darauf folgenden Abschnitten werden wir dies für die Berechnung von

Konfidenzintervallen und für Hypothesentests nützen. Im letzten Abschnitt werden

wir uns schließlich mit Prognosen beschäftigen.

4.1

Von der Normalverteilung über die Standardisierung zur t-Verteilung

Wir beginnen mit einer kurzen Wiederholung der einführenden

Statistik. Dort wurP

de gezeigt, dass der Stichprobenmittelwert v̄ = 1/N vi einer normalverteilten

Zufallsvariable v selbst wieder eine normalverteilte Zufallsvariable ist.2

Wenn

vi ∼ N µ, σ 2

dann ist der Mittelwert

v̄ =

wieder normalverteilt mit

N

1 X

vi

N i=1

v̄ ∼ N

σ2

µ,

N

Sowohl für Hypothesentests als auch für die Bestimmung der Konfidenzintervalle muss eine Standardisierung auf Mittelwert Null und Standardabweichung Eins

durchgeführt werden (z-Transformation).

Im Falle des Mittelwerts ist diese z-transformierte Zufallsvariable

v̄ − µ

z = σ ∼ N (0, 1)

√

N

Wenn σ bekannt ist, ist diese z-transformierte Zufallsvariable selbst wieder normalverteilt, und mit Hilfe der Standardnormalverteilungstabelle können die üblichen

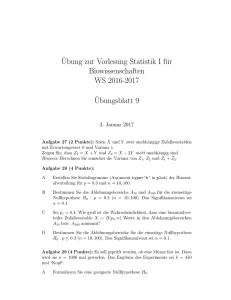

Tests durchgeführt werden (vgl. Abbildung 4.1).

Das Problem besteht darin, dass die Standardabweichung σ ein Parameter der

Grundgesamtheit ist, und deshalb nur in den seltensten Fällen bekannt sein dürfte.

Wenn σ unbekannt ist muss es aus den Daten geschätzt werden, und ebenfalls aus

der einführenden Statistik ist bekannt, dass

v

u

N

u 1 X

t

s=

(vi − v̄)2

N − 1 i=1

ein unverzerrter Schätzer für σ ist.

Es scheint also naheliegend, für die z-Transformation einfach σ durch s zu ersetzen,

aber leider ist die daraus resultierende Zufallsvariable z̃ nicht mehr normalverteilt

v̄ − µ

z̃ = s ≁ N (0, 1)

√

2

N

Der Mittelwert v̄ ist eine lineare Funktion der einzelnen vi . Deshalb gilt dies auch in kleinen

Stichproben.

121

Intervallschätzer, Hypothesentests und Prognosen

f (v̄)

µ2 = −2

σµ2 = 0.4

0.8

0.6

µ1 = 1.5

σµ1 = 0.5

0.4

0.2

-3

µ2

-2

-1

µ3

0

1

0.4

-2

-1

2

3

v̄

Standardisierte

Verteilung mit:

µz = 0

σz = 1

0.2

-3

µ1

0

1

2

3

z

Abbildung 4.1: Normalverteile Zufallsvariable mit unterschiedlichen Erwartungswerten und Varianzen können auf Erwartungswert Null und Varianz Eins standardisiert werden.

Das Problem resultiert daraus, dass der geschätzte Standardfehler s ebenso wie v̄

eine Zufallsvariable ist. Deshalb ist z̃ das Verhältnis zweier Zufallsvariablen, und es

gibt keinen Grund anzunehmen, dass das Verhältnis zweier Zufallsvariablen auch

wieder normalverteilt ist, auch wenn der Zähler normalverteilt ist.

Aber wir erinnern uns in der einführenden Statistik gehört (und hoffentlich auch bewiesen) zu haben, dass das mit Hilfe des geschätzten Standardfehlers s berechnete

z̃ einer t-Verteilung folgt. Genau dies wollen wir nun ausführlich für das Regressionsmodell zeigen.

Wir starten mit einer Zusammenfassung der Ergebnisse des 3. Kapitels

Intervallschätzer, Hypothesentests und Prognosen

b1

s2b1

122

P

ẍi yi

= P 2

ẍi

2

s

= P 2

ẍi

b0 = ȳ − b1 x̄

P 2

x

2

2

Pi 2

sb0 = s

N ẍi

s

2

=

P

e2i

N −2

wobei s2 das Quadrat des Standardfehlers der Regression ist, ein unverzerrter

Schätzer für die Varianz der Störterme σ 2 .

s2b0 und s2b1 sind die geschätzten Varianzen der geschätzten Koeffizienten b0 und

b1 . Die Quadratwurzeln dieser Varianzen werden Standardfehler der Koeffizienten

genannt.

Wir wollen nun zeigen, dass

b0 − β0

∼ tN −2

sb0

und

b1 − β1

∼ tN −2

sb1

das heißt, dass die mit Hilfe der geschätzten Standardfehler standardisierten Koeffizienten t-verteilt mit N − 2 Freiheitsgraden sind.

Um dies zu zeigen beginnen wir mit der t-Verteilung. Aus der einführenden Statistik

ist bekannt, dass das Verhältnis einer standardnormalverteilten Zufallsvariable und

der Wurzel einer davon unabhängig χ2 -verteilten Zufallsvariable, dividiert durch die

Freiheitsgrade, t−verteilt ist3

q

N (0, 1)

χ2N −2 /(N − 2)

∼ tN −2

Eine standardnormalverteilte Zufallsvariable für den Zähler des obigen Bruchs erhalten wir z.B. durch eine Standardisierung (z-Transformation) von b1

b1 − β1

∼ N (0, 1)

σb1

(4.1)

p

p

P

wobei σb1 := Var(b1 ) = σ 2 / (xi − x̄)2 .

Für den Nenner des obigen Bruchs erinnern wir uns, dass die Quadratsumme einer

standardnormalverteilten Zufallsvariable χ2 verteilt ist. Wenn die Stichprobenresiduen normalverteilt sind, d.h. ei ∼ N (0, σ 2 ), folgt

P 2

P

ei

(yi − b0 − b1 xi )2

=

∼ χ2N −2

2

2

σ

σ

3

Dieses Ergebnis wurde von W.S. Gosset, dem Chef-Braumeister der Guinness Brauerei, 1919

unter dem Pseudonym “Student” veröffentlicht, vgl. Ziliak (2008).

123

Intervallschätzer, Hypothesentests und Prognosen

wobei wir durch σ 2 dividieren müssen damit die Varianz Eins wird.

P 2

Unter Verwendung des Standardfehlers der Regression s2 =

ei /(N − 2) (siehe

Gleichung (3.5), Seite 102) können wir dies umschreiben zu

P 2

(N −2)s2

P

(N − 2)s2b1

(N − 2)s2

ei

(xi −x̄)2

=

=

=

2

P σ

σ2

σ2

σb21

(xi −x̄)2

P

P

da s2b1 = s2 / (xi − x̄)2 und σb21 = σ 2 / (xi − x̄)2

Deshalb ist der folgende Ausdruck χ2 -verteilt

(N − 2)s2b1

∼ χ2N −2

2

σb1

(4.2)

Nun können wir aus der standardnormalverteilten Zufallsvariable (4.1)und der χ2 verteilten Zufallsvariablen (4.2) eine t-verteilte Teststatistik ‘bauen’, da

N (0, 1)

q 2

∼ tN −2

χN−2

N −2

⇒

r

b1 −β1

σb1

(N −2)s2b

1

(N −2)σb2

1

=

b1 −β1

σb1

sb1

σb1

=

b1 − β1

∼ tN −2

sb1

Die schöne Überraschung dabei ist, dass sich die unbekannte Populationsvarianz σ 2

herauskürzt, und man erhält eine einfache t-verteilte Teststatistik, die unmittelbar

aus den Daten berechnet werden kann.

b1 − β1

∼ tN −2

sb1

q

p

P

P

s2 / i (xi − x̄)2 , sowie s2 = i e2i /(N − 2).

d 1 ) soll andeuten, dass es sich um eine empirische Varianz

Das Dach über Var bei Var(b

handelt, da die Varianz von b1 mit Hilfe des Schätzers s2 anstelle der wahren Varianz

d 1 ) ist also selbst wieder eine Zufallsvariable.

σ 2 berechnet wurde; Var(b

Ähnlich kann man zeigen, dass

mit sb1 :=

d 1) =

Var(b

b0 − β0

∼ tN −2

sb0

Diese Größen sind Beispiele für Teststatistiken. Eine Teststatistik ist – ähnlich wie

ein Schätzer – eine Formel, in die man die Stichprobendaten einsetzen kann, und die

als Ergebnis eine Kenngröße liefert, deren theoretische Verteilung bekannt ist, und

die deshalb für Hypothesentests genützt werden kann.

Diese Teststatistiken wollen wir nun für die Bestimmung von Konfidenzintervallen

der Koeffizienten und für statistische Tests verwenden.

Vorher wollen wir aber noch einmal betonen, dass – wann immer die Standardfehler

der Koeffizienten aus den Daten geschätzt werden – der kritische Wert nicht der

Standardnormalverteilung entnommen werden darf, sondern einer t Verteilung.

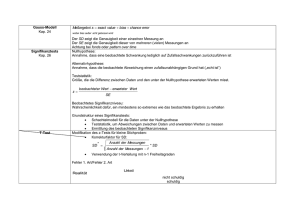

Die t-Verteilung ist ähnlich wie die Standardnormalverteilung symmetrisch, hat aber

dickere ‘Schwänze’ (‘tails’ ; siehe Abbildung 4.2). Für große N konvergiert die tVerteilung gegen die Standardnormalverteilung. De facto macht es ab einer Stichprobengröße N > 30 kaum einen Unterschied, ob man in der t-Verteilungstabelle

oder in der Standardnormalverteilungstabelle nachschlägt.

124

Intervallschätzer, Hypothesentests und Prognosen

f (X)

ν > 120

0.4

ν=5

0.2

−5

−4

−3

−2

−1

ν=1

0

1

2

3

4

5

Abbildung 4.2: Vergleich der Dichtefunktionen einer t-Verteilung mit ν Freiheitsgraden (blau) und einer Standard-Normalverteilung

4.2

Intervallschätzer und Konfidenzintervalle

Punktschätzer dienen zur Schätzung eines unbekannten Parameters einer Grundgesamtheit auf Grundlage einer einzelnen Stichprobe. Die OLS-Punktschätzer b0

und b1 haben wir bereits im letzten Kapitel berechnet. Unter den Gauss-Markov

Annahmen und der Normalverteilungsannahme (also den CNLRM Annahmen) gilt

σ2

b1 ∼ N β1 , P

(xi − x̄)2

P

σ 2 x2i

b0 ∼ N β0 , P

N (xi − x̄)2

Von diesen Punktschätzern wissen wir, dass sie unter den Gauss-Markov Annahmen

unverzerrt und effizient sind, also die kleinste Varianz aller linearen Schätzfunktionen

haben.

Punktschätzer liefern eine Schätzung für den interessierenden Parameter der Grundgesamtheit, aber sie können nicht gleichzeitig die Unsicherheit der Schätzung vermitteln. Für diesen Zweck werden wir nun Intervallschätzer entwickeln, die zusätzlich

eine Beurteilung der Unsicherheit (oder Präzision) einer Schätzung erlauben.

Intervallschätzer beruhen auf Punktschätzern, erlauben aber darüber hinausgehend eine Abschätzung der Genauigkeit der Schätzung. Er gibt – vereinfacht gesprochen – ein Vertrauensintervall um den geschätzten Wert des Parameters an, das

auch eine Beurteilung der Signifikanz erlaubt. Zur Berechnung eines solchen Vertrauensintervalls um die geschätzten Parameter benötigen wir die vorhin hergeleitete

Verteilung der standardisierten OLS-Koeffizienten.

Wenn die Varianz der Störterme der Grundgesamtheit σ 2 bekannt wäre, könnten wir

125

Intervallschätzer, Hypothesentests und Prognosen

wie üblich durch z-Transformation eine standardnormalverteilte Prüfgröße z bilden

z-Stat(b0 ) =

z-Stat(b1 ) =

b0 − β0

b0 − β0

∼ N (0, 1)

= q P 2

xi

σb0

P

σ N (xi −x̄)2

b1 − β1

b1 − β1

=q

2

σb1

P σ

(xi −x̄)2

∼ N (0, 1)

Wenn die Varianz σ 2 aus der Stichprobe geschätzt werden muss sind – wie im letzten

Abschnitt gezeigt – die entsprechenden Teststatistiken t-verteilt

t-Stat(b0 ) =

t-Stat(b1 ) =

b0 − β0

b0 − β0

= q P 2

∼ tN −2

xi

sb0

s N P(xi −x̄)

2

b1 − β1

b1 − β1

=

∼ tN −2

√P s

sb1

2

(xi −x̄)

Für Intervallschätzer wird meist eine konkrete Wahrscheinlichkeit angegeben, ein

Konfidenzniveau, das die Angabe eines (1 − α) Konfidenzintervalls (oder Vertrauensbereichs) ermöglicht.

Ein 95% Konfidenzintervall (α = 0.05) gibt z.B. an, dass wir bei 100-facher Wiederholung des Versuchs (Ziehungen) damit rechnen können, dass 95 der berechneten

Konfidenzintervalle den wahren Parameter enthalten.

Für eine standardnormalverteilte Zufallsvariable z gilt bekanntlich

P [z ≤ −1.96] = P [z ≥ +1.96] = 0.025

und

P [−1.96 ≤ z ≤ +1.96] = 1 − 0.05 = 0.95

wobei 1.96 der kritische Wert z0.025 der Standardnormalverteilung ist.4

Daraus folgt (für k = 0, 1)

bk − βk

P −1.96 ≤

≤ +1.96 = 0.95

σbk

Dies ermöglicht die Berechnung eines 95% Konfidenzintervalls, aber es kann

natürlich auch für jede andere Wahrscheinlichkeit α ein entsprechendes Konfidenzintervall berechnet werden. Der von der Forscherin gewählte Wert von α wird Signifikanzniveau genannt (engl. ‘significance level’ oder auch ‘size of a test’ ; im vorhergehenden Beispiel wurde α = 0.05 gewählt5 ). Der zum α gehörende kritische Wert

4

Die Wahrscheinlichkeit, dass eine standardnormalverteilte Zufallsvariable einen Wert kleiner

als −1.96 annimmt ist 0.025, bzw. 2.5%. Da die Wahrscheinlichkeit, dass sie einen Wert größer

als +1.96 annimmt, ebenfalls 2.5% beträgt, ist die Wahrscheinlichkeit dafür, dass sie einen Wert

kleiner als −1.96 oder größer als +1.96 annimmt, 0.05, bzw. 5%.

5

Das Signifikanzniveau von α = 5% hat sich traditionell eingebürgert, obwohl Rosnow & Rosenthal (1989) vermutlich Recht haben wenn sie behaupten: “God loves 0.06 nearly as much as

0.05.”

126

Intervallschätzer, Hypothesentests und Prognosen

f (b)

0.50

0.25

(1 − α)

α/2

−4

−3

−2

−1

0

α/2

1

2

3

4

Abbildung 4.3: Konfidenzintervall für eine standardnormalverteilte Zufallsvariable.

der Normalverteilung zα/2 kann in jeder Tabelle für die Standardnormalverteilung

nachgeschlagen werden.

bk − βk

P −zα/2 ≤

≤ +zα/2 = 1 − α

σbk

Wenn σ durch die Stichprobenschätzung s ersetzt wird ist der kritische Wert tcα/2

der t-Tabelle zu entnehmen, aber das Prinzip bleibt gleich

bk − βk

c

c

≤ +tα/2 = 1 − α

P −tα/2 ≤

sbk

Wir lösen den Ausdruck in der Klammer nach dem unbeobachtbaren βk (k = 0, 1),

über das wir eine Aussage machen wollen

bk − βk

c

c

P −tα/2 ≤

≤ +tα/2 = 1 − α

sbk

P −tcα/2 · sbk ≤ bk − βk ≤ +tcα/2 · sbk = 1 − α

P −bk − tcα/2 · sbk ≤ −βk ≤ −bk + tcα/2 · sbk = 1 − α

P +bk + tcα/2 · sbk ≥ βk ≥ bk − tcα/2 · sbk = 1 − α

also

Dieses Intervall

P bk − tcα/2 · sbk ≤ βk ≤ bk + tcα/2 · sbk = 1 − α

bk − tcα/2 · sbk ; bk + tcα/2 · sbk

wird allgemein als Konfidenzintervall bezeichnet. Wenn hypothetisch unendlich viele Stichproben gezogen würden, so würden wir bei einem Signifikanzniveau von 5%

erwarten, dass 95% der berechneten Konfidenzintervalle den wahren Wert βk enthalten.

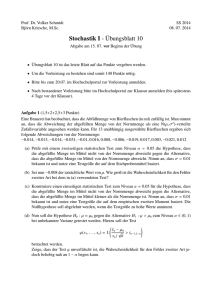

Abbildung 4.4 veranschaulicht das Prinzip. Die Abbildung zeigt den ‘wahren’ Wert

β und die Konfidenzintervalle aus sieben Stichproben. Wir sehen, dass sechs dieser

127

Intervallschätzer, Hypothesentests und Prognosen

Konfidenzintervalle den ‘wahren’ Wert β enthalten, nur die fünfte Stichprobe (b5 )

führt zu einem Konfidenzintervall, das den ‘wahren’ Wert β nicht enthält. Bei unendlich oft wiederholten Stichprobenziehungen würden wir ein solches Resultat in

nicht mehr als 5% der Fälle erwarten.

Man beachte, dass sich die Konfidenzintervalle nicht nur durch die Lage der geschätzten b unterscheiden, sondern auch unterschiedlich breit sind, da auch sb eine Zufallsvariable ist.

f (b)

Grundgesamtheit

(1 − α)

α/2

c

b

b

β

Wiederholte

Stichprobenziehungen

b1

c

b

c

b

α/2

c

b

b2

b3

b4

c

b

b5

c

b

b6

c

b

b7

Abbildung 4.4: ‘Wahres’ β [= E(b)] und Konfidenzintervalle für 7 Stichproben.

Quelle: nach Bleymüller et al. 2002, S. 86.

Beispiel: Angenommen, wir haben eine Regressionsgleichung

ŷi

=

10.45 − 2.48 xi

(4.32)

(1.62)

N = 19, R2 = 0.74

wobei die

q Werte in Klammern unter den Koeffizienten die geschätzten Standardfehler

d k ) der Koeffizienten sind.

sb := Var(b

k

Da N = 19 haben wir 17 Freiheitsgrade, und der kritische t-Wert für 17 Freiheitsgrade und ein Signifikanzniveau von 5% ist tc17,0.025 = 2.11

Ein 95% Konfidenzintervall für b0 erhalten wir

[10.45 − 2.11 × 4.32; 10.45 + 2.11 × 4.32]

128

Intervallschätzer, Hypothesentests und Prognosen

bzw.

[1.335; 19.565]

Wie ist dies zu interpretieren? Wenn wir hypothetisch unendlich viele Stichproben

aus einer normalverteilten Grundgesamtheit von y (bei gegebenen x) ziehen würden,

und wir würden für jede dieser Stichproben auf Grundlage des geschätzten b0 und

des Standardfehlers von b0 ein z.B. 95% Konfidenzintervall berechnen, dann würden

95% dieser so ermittelten Konfidenzintervalle den wahren Wert β0 enthalten.

Ähnlich erhalten wir das Konfidenzintervall für b1

[−2.48 − 2.11 × 1.62; −2.48 + 2.11 × 1.62]

bzw. [−5.898; +0.938]

Noch einmal: da b1 und sb1 Zufallsvariablen sind erhält man für jede Stichprobe ein

anderes Konfidenzintervall. Würden wir z.B. 100 unabhängige Stichproben ziehen

würden wir bei einem gewählten Signifikanzniveau von 5% erwarten, dass 95 der

berechneten Konfidenzintervalle den ‘wahren’ Wert β1 enthalten.

Achtung: Dies erlaubt uns nicht zu sagen, dass der ‘wahre’ Wert β1 mit 95% Wahrscheinlichkeit im Konfidenzintervall [−5.898; +0.938] liegt. Intervallschätzer und

Konfidenzintervalle beruhen auf der Idee der wiederholten Stichprobenziehungen

(‘repeated sampling’ ). Sobald eine Stichprobe gezogen ist enthält das dazugehörige Konfidenzintervall den wahren Wert β oder es enthält ihn nicht, es gibt keine

Möglichkeit dazwischen.

Abbildung 4.4 verdeutlicht dies. Wenn wir zufällig Stichprobe 5 (mit b5 ) gezogen

hätten liegt das wahre β nicht im Konfidenzintervall. Wenn wir behaupten würden,

das wahre β liegt mit 95% Wahrscheinlichkeit in diesem Konfidenzintervall, dann

wäre dies offensichtlich Unsinn, denn ganz offensichtlich liegt das wahre β mit 100%

Sicherheit außerhalb des fünften Konfidenzintervalls!

Wir fassen die Schritte zur Bestimmung eines Intervallschätzers bk für βk (k = 0, 1)

noch einmal zusammen:

1. Berechnung des Punktschätzers bk , und – falls σ 2 unbekannt ist – eines

Schätzers s2 für σ 2 .

2. Festlegung eines Signifikanzniveaus α und Bestimmung des dazugehörigen kritischen Wertes tcα/2 für N − 2 Freiheitsgrade (für eine bivariate Regression mit

unbekanntem σ 2 ).

3. Berechnung des Intervallschätzers

P [bk − tcα/2 · sbk ≤ βk ≤ bk + tcα/2 · sbk ] = 1 − α

4. Interpretation des Intervallschätzers; unter den angeführten Annahmen

können wir davon ausgehen, dass bei wiederholten Stichprobenziehungen

(1 − α)100% der geschätzten Konfidenzintervalle den ‘wahren’ Wert β enthalten.

Man beachte, dass das Konfidenzintervall ceteris paribus umso enger ist, je . . .

Intervallschätzer, Hypothesentests und Prognosen

129

• größer das frei gewählte Signifikanzniveau α ist,

• kleiner die Varianz σ 2 (bzw. dessen Schätzer s2 ), und

• größer die Stichprobe (N) ist.

4.3

Einfache Hypothesentests

Wir haben bisher Punkt- und Intervallschätzer für unbekannte Parameter der

Grundgesamtheit berechnet. Selbstverständlich kann dieses Instrumentarium auch

eingesetzt werden um Hypothesen über die Grundgesamtheit empirisch zu testen.

4.3.1

Grundlagen

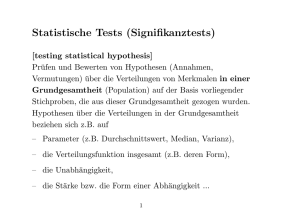

Bei Hypothesentests wird generell von einer Vermutung über eine Eigenschaft (oder

einen Zusammenhang in) der Grundgesamtheit ausgegangen. Mit Hilfe von stichprobenartig erhobenen Daten wird überprüft, inwieweit diese Daten mit den postulierten Eigenschaften der Grundgesamtheit (bzw. des datengenerierenden Prozesses)

kompatibel sind.

Wir werden nun die Stichprobenkennwertverteilung (‘sampling distribution’) von

b heranziehen um eine Methode zu entwickeln, die es uns erlaubt zu beurteilen,

inwieweit die Stichprobendaten mit einer Hypothese kompatibel sind.

Hypothesen werden in der Statistik generell mit der logischen Alternative zur Anfangsvermutung präsentiert, die akzeptiert wird, wenn die Hypothese selbst verworfen werden muss.

Die Nullhypothese (H0 ) wird dabei solange als ‘wahr’ betrachtet, bis sie durch

einen statistischen Test verworfen werden kann. Die Alternativhypothese (HA

oder manchmal auch H1 ) – die logische Alternative zur Nullhypothese – steht dabei

für alle Ergebnisse, die der Nullhypothese widersprechen. Sowohl Null- als auch Alternativhypothese sind immer Aussagen über unbeobachtbare Parameter der Grundgesamtheit! Ist das Stichprobenergebnis bei Gültigkeit der Nullhypothese (man sagt

auch ‘unter der Nullhypothese’) sehr unwahrscheinlich, so wird die Nullhypothese

verworfen; andernfalls wird sie akzeptiert.

Es ist üblich die Nullhypothese als ‘Negativhypothese’ zu formulieren, mit der behauptet wird, dass die zur Alternativhypothese komplementäre Aussage wahr sei,

d.h. die Nullhypothese behauptet häufig das Gegenteil der Anfangsvermutung.

Allerdings ist man in der Wahl, was Null- und was Alternativhypothese sein soll,

nicht völlig frei, sondern diese Wahl muss statistisch-technischen Anforderungen

genügen. Als Faustregel kann man sich merken, dass die Nullhypothese immer das

‘ist gleich’ (=, bzw. ≥ oder ≤) Zeichen enthalten muss.

Bei der Hypothesenformulierung ist insbesondere darauf zu achten, dass der postulierte Zusammenhang in der Grundgesamtheit so präzise wie möglich in die Form

einer statistisch testbaren Hypothese überführt wird. Das bedeutet auch, dass die

Intervallschätzer, Hypothesentests und Prognosen

130

Stichprobe in allen relevanten Eigenschaften der Grundgesamtheit entsprechen sollte.

Ein Hypothesentest in der Tradition von Neyman-Pearson ist schließlich eine Entscheidungsregel, die uns erlaubt, anhand der empirischen Evidenz zwischen Null- und

Alternativhypothese zu entscheiden.

Achtung: getestet wird die Nullhypothese, nicht die eigentlich interessierende operationalisierte Anfangsvermutung (Alternativhypothese). Fast immer muss die ceteris paribus Bedingung akzeptiert werden. Deshalb sollte man sich unbedingt Klarheit

über die spezifischen Annahmen verschaffen (z.B. unterscheiden sich die Stichproben

wirklich nur in dem hier interessierenden Zusammenhang oder sind Scheinkorrelationen zu befürchten? Ist die Stichprobe wirklich zufällig gezogen, oder ist ein sample

selection bias zu befürchten?).

Manchmal wird diese Art des Testens mit einem Indizienprozess in einem Gerichtsverfahren verglichen: Die prinzipiell geltende Unschuldsvermutung (sprich Nullhypothese) darf erst bei entsprechend überzeugenden Indizien verworfen werden. Die

Rolle des Staatsanwaltes (der Ökonometrikerin) ist es genügend Indizien zu sammeln, um die Unschuldsvermutung (Nullhypothese) ‘glaubhaft’ verwerfen zu können.

Die Ökonometriker suchen ihre Indizien in der Stichprobe, und die Stelle der Geschworenen wird von einem Signifikanzniveau übernommen. Dieser Vergleich hinkt

allerdings etwas, da Gerichtsverfahren z.B. nicht auf wiederholten Experimenten

beruhen.6

Aber ähnlich wie in einem Indizienprozess von der Unschuldsvermutung wird in der

Statistik von der Gültigkeit der Nullhypothese ausgegangen. Es ist offensichtlich

nicht das gleiche, ob von der Schuld eines Angeklagten ausgegangen wird und dieser

seine Unschuld beweisen muss, oder ob prinzipiell von der Unschuld ausgegangen

wird und die Schuld (Vermutung) erst vom Staatsanwalt (Ökonometriker) bewiesen

werden muss (Umkehr der Beweislast).

Die Nullhypothese stellt bei Hypothesentests die Basis dar, von der aus entschieden

wird, ob die Alternativhypothese akzeptiert werden darf oder nicht. Nur wenn die

Evidenz aus der Stichprobe ‘kaum’ mit der Nullhypothese in Übereinstimmung zu

bringen ist, darf sie zugunsten der Alternativhypothese verworfen werden.

Die Rolle der Statistik liegt also nicht darin etwas zu beweisen, sondern darin, die jeweilige Gegenbehauptung mit möglichst überzeugenden Argumenten zu entkräften.

Die Hypothesen sollten aus der ökonomischen Theorie gewonnen werden, müssen

aber fast immer durch ‘gesunden Menschenverstand’ und ähnliche Quellen ergänzt,

bzw. präziser spezifiziert werden.

Achtung: Informationen aus der Stichprobe dürfen nie zur Bildung von Hypothesen

verwendet werden (‘data mining’ )! Der sicherste Schutz davor ist die Stichprobe

erst anzusehen, wenn die Hypothesen bereits gebildet sind. Hypothesen betreffen

immer Aussagen über die unbeobachtbare Grundgesamtheit, nie Aussagen über die

Stichprobe.

6

siehe z.B. Liu, T. and C. Stone (2006), ‘Law and Statistical Disorder:

Statistical Hypothesis Test Procedures And the Criminal Trial Analogy’, Working Papers from Ball State University, Department of Economics, No 200601,

http://web.bsu.edu/cob/econ/research/papers/bsuecwp200601r1liu.pdf

Intervallschätzer, Hypothesentests und Prognosen

131

Testkriterien:

Eine Teststatistik ist ganz allgemein eine Formel die angibt, wie die Nullhypothese

mit der Evidenz (den Indizien) aus der Stichprobe konfrontiert werden kann. Sie ist

selbst eine Zufallsvariable, deren theoretische Verteilung bekannt ist. Wenn die empirische Teststatistik – d.h. der Wert der Teststatistik, den man erhält, wenn man

die Beobachtungen der Stichprobe in die Formel einsetzt – in den Verwerfungsbereich

(‘region of rejection’, ‘critical region’ ) fällt, wird die Nullhypothese verworfen, anderenfalls muss sie akzeptiert werden. Der Verwerfungsbereich ist dabei eine Teilmenge aus dem Stichprobenraum, die Komplementärmenge dazu wird Annahmebereich

(‘acceptance region’ ) genannt.

Ein statistischer Test wird im Idealfall in folgenden Schritten durchgeführt (vgl.

Kmenta 1990, S.120ff):

Ausgangssituation: Formuliere die Annahmen und nicht zu testenden Hintergrundhypothesen ( z.B. b ist normalverteilt mit . . . )

Schritt 1 Formuliere die Alternativ- und Nullhypothese (z.B. HA : β 6= 0,

β = 0)

H0 :

Schritt 2 Wähle die Teststatistik (z.B. t-Stat = b/sb ).

Schritt 3 Bestimme die Verteilung der Teststatistik unter der Annahme, dass die

Nullhypothese gilt (z.B. b/sb ∼ tN −2 )

Schritt 4 Wähle das Signifikanzniveau und bestimme den Annahme- und Verwerfungsbereich (z.B. akzeptiere die Nullhypothese wenn −1, 96 ≤ b/sb ≤ +1, 96;

anderenfalls verwirf die Nullhypothese)

Schritt 5 Ziehe die Stichprobe und werte sie aus (liegt der berechnete Wert der

Teststatistik innerhalb/außerhalb des Annahmebereichs?)

Schritt 6 Formuliere die Schlussfolgerung (z.B. ‘die Hinweise aus der Stichprobe

führen zu einer Beibehaltung/Ablehnung der Nullhypothese’)

Achtung: Die Stichprobe wird erst am Ende des Verfahrens analysiert!

4.3.2

Zweiseitige Hypothesentests

Bei Hypothesen- bzw. Parametertests wird stets von einer Vermutung bezüglich

eines Parameterwertes der Grundgesamtheit ausgegangen. Die im Rahmen der Regressionsanalyse vermutlich häufigste Vermutung ist, dass zwischen zwei Variablen

x und y ‘ein Zusammenhang’ besteht, d.h. dass im Modell

yi = β0 + β1 xi + εi

gilt: β1 6= 0.

132

Intervallschätzer, Hypothesentests und Prognosen

Üblicherweise wird die Gegenbehauptung zu dieser ‘Anfangsvermutung’ als Nullhypothese angenommen, und die ‘Anfangsvermutung’ als Alternativhypothese bezeichnet, also

H0 :

HA :

β1 = 0

β1 6= 0

Obwohl dies der mit Abstand häufigste Test ist kann natürlich gegen eine andere Zahl

als Null getestet werden, z.B. könnte getestet werden ob der Wert der Einkommenselastizität gleich Eins (Nullhypothese) oder ungleich Eins (Alternativhypothese)

ist.

Deshalb formulieren wir die Nullhypothese etwas allgemeiner

H0 :

HA :

βk = βk0

βk 6= βk0

wobei k = 0, 1 (für β0 , β1 ) und in βk0 die Anfangsvermutung zum Ausdruck kommt

(wie schon erwähnt ist die häufigste Nullhypothese βk0 = 0). Um die Schreibweise zu

vereinfachen wollen wir im weiteren den Subindex k weglassen, aber im Gedächtnis

behalten, dass dies jeweils für β0 und β1 gilt.

Im Folgenden wollen wir mit β 0 den Wert bezeichnen, der mit der Nullhypothese

getestet werden soll.

Wenn die H0 : β = β 0 wahr ist (d.h. unter der Annahme der Gültigkeit der Nullhypothese) kann man im Konfidenzintervall β durch β 0 ersetzen

P [b − tcα/2 · sb ≤ β 0 ≤ b + tcα/2 · sb ] = 1 − α

Dies lässt sich wieder umformen in ein um b zentriertes Konfidenzintervall

P [β 0 − tcα/2 · sb ≤ b ≤ β 0 + tcα/2 · sb ] = 1 − α

oder

β 0 − tcα/2 sb ; β 0 + tcα/2 sb

Wenn die Nullhypothese β = β 0 wahr ist (!) und wir unendlich viele Stichproben

ziehen, dann

h würden wir erwarteni in (1 − α) × 100% der Fälle einen Wert für b im

Intervall β 0 − tcα/2 sb ; β 0 + tcα/2 sb zu erhalten.

Tatsächlich können wir üblicherweise nur eine Stichprobe beobachten. Wenn die

Nullhypothese in der Grundgesamtheit wahr ist, dann ist es sehr unwahrscheinlich,

dass das für diese Stichprobe berechnete b nicht in dieses Konfidenzintervall fällt.

Wenn nun das in dieser Stichprobe berechnete b aber tatsächlich außerhalb des

Konfidenzintervalls liegen sollte widerspricht dies der Nullhypothese. Wir können

also mit einer Irrtumswahrscheinlichkeit von α × 100% die Nullhypothese verwerfen

und deshalb die (eigentlich interessierende) Alternativhypothese akzeptieren.

Diese Überlegungen lassen sich auch grafisch demonstrieren. Wenn die GaussMarkov Annahmen erfüllt sind, die Störterme der Grundgesamtheit normalverteilt

133

Intervallschätzer, Hypothesentests und Prognosen

sind (εi ∼ N (0, σ 2 )) sowie ein Schätzer s2 für σ 2 aus der Stichprobe berechnet wurde, und wenn die Nullhypothese wahr ist, dann ist der standardisierte Schätzer für

die Regressionskoeffizienten t-verteilt mit N − 2 Freiheitsgraden

b − β0

∼ tN −2

sb

Abbildung 4.5 zeigt die standardisiere Stichprobenkennwertverteilung von b unter

Gültigkeit der Nullhypothese β = β 0 . Die beiden schraffierten Flächen an den Enden

der Verteilung decken gemeinsam α×100% der Gesamtfläche ab (in diesem Fall 5%).

Wenn eine tatsächliche Realisation von b in den schraffierten Bereich fällt ist dies

bei Gültigkeit der Nullhypothese ein sehr unwahrscheinliches Ereignis, deshalb kann

man die Nullhypothese mit einer Irrtumswahrscheinlichkeit von α × 100% verwerfen, man sagt, der geschätzte Wert ist auf einem Signifikanzniveau von α × 100%

statistisch signifikant vom Wert der Nullhypothese verschieden.

f (b)

(1 − α)

α/2

β 0 − tcα sb

2

Verwerfungsbereich

β0

α/2

β 0 + tcα sb

Annahmebereich

b

2

Verwerfungsbereich

Abbildung 4.5: Wahrscheinlichkeitsverteilung eines Schätzers b unter der Prämisse, dass H0 : β = β 0 wahr ist. Man beachte, dass die der Grafik zugrunde liegende Information ausschließlich aus der statistischen Theorie folgt, nicht aus den Stichprobendaten! Erst in einem

nächsten Schritt wird aus den Daten der Wert der empirischen tStatistik berechnet und überprüft, in welchen Bereich dieser fällt.

Beispiel: Angenommen, wir haben eine Regressionsgleichung

ŷi

=

10.45 − 2.48 xi

(4.32)

(1.62)

N = 19, R2 = 0.74

wobei die Werte in Klammern unter den Koeffizienten die geschätzten Standardfehler

sbk der Koeffizienten sind.

Intervallschätzer, Hypothesentests und Prognosen

134

Um zu testen, ob die beiden geschätzten Koeffizienten auf dem 5% Niveau von Null

verschieden sind berechnen wir die entsprechende t-Statistiken

10.45 − 0

b0 − β00

=

= 2.42 ∼ tN −2

sb0

4.32

−2.48 − 0

b1 − β10

t-Stat(b1 ) =

=

= −1.531 ∼ tN −2

sb1

1.62

t-Stat(b0 ) =

Der kritische t-Wert für 17 Freiheitsgrade und α/2 = 0.025 ist 2.11, deshalb können

wir die Nullhypothese β0 = 0 auf einem Signifikanzniveau von 5% verwerfen (|2.42| >

tc ), während die Nullhypothese β1 = 0 auf diesem Signifikanznveau nicht verworfen

werden kann (| − 1.531| < tc ).

Da diese t-Statistiken für die statistische Beurteilung des Regressionsoutputs derart

wichtig sind werden sie von allen gängigen statistischen Software Programmen standardmäßig ausgegeben, wobei diesen Statistiken jeweils die Nullhypothese βk = 0

zugrunde liegt. Der Wert der ausgegebenen t-Statistik ist deshalb einfach Koeffizient

dividiert durch Standardfehler: t-Stat(bk ) = bk /sbk .

Die Vorgangsweise für einen zweiseitigen Parametertest kann folgenderweise zusammengefasst werden:

1. Formulierung von Alternativ- und Nullhypothese

H0 :

HA :

β = β0

β 6= β 0

2. Überprüfen, ob alle zugrunde liegenden Annahmen (korrekte Spezifikation,

unverzerrte Stichprobe, etc.) erfüllt sind.

3. Festlegung eines Signifikanzniveaus α und Ermittlung des dazugehörigen kritischen Wertes tcα/2 für N − 2 Freiheitsgrade mittels einer t-Tabelle und Bestimmung des Akzeptanz- und Verwerfungsbereichs, z.B.

Akzeptanzbereich: −tcα/2 bis +tcα/2

Verwerfungsbereich: −∞ bis −tcα/2 und +tcα/2 bis +∞.

4. Berechnung des Punktschätzers b und des Standardfehlers von b (sb ) aus der

Stichprobe.

5. Berechnung der empirischen Teststatistik, z.B. der t-Statistik

t=

b − β0

sb

6. Überprüfen, ob der empirische Wert der t-Statistik in den Akzeptanz- oder

Verwerfungsbereich fällt. Fällt der berechnete Wert der t-Statitik in den Verwerfungsbereich kann die Nullhypothese verworfen werden.

135

Intervallschätzer, Hypothesentests und Prognosen

4.3.3

Einseitiger Hypothesentest

Bisher haben wir die Nullhypothese in einer Form spezifiziert, dass β einen bestimmten Wert β 0 annimmt (z.B. β = 0), und die Ablehnungsbereiche von H0 lagen an

beiden Rändern der Verteilung.

Häufig hat man es aber mit ‘gerichteten’ Hypothesen der Form

H0 :

HA :

β ≤ β0

β > β0

zu tun.

Auf den ersten Blick mag es unmöglich erscheinen diese Hypothese zu testen, da

β ≤ β 0 unendlich viele Fälle umfasst. Es zeigt sich allerdings, dass es genügt den

aus Sicht der Forscherin potentiell ungünstigsten Fall zu wählen, nämlich dass die

Nullhypothese H0 : β = β 0 wahr ist. Wenn diese Nullhypothese verworfen werden

kann, so können auch alle β < β 0 verworfen werden, deshalb genügt es H0 : β = β 0

gegen HA : β > β 0 zu testen.

Abbildung 4.6 zeigt den Unterschied zwischen ein- und zweiseitigen Hypothesentests. Die obere Abbildung zeigt den bisherigen zweiseitigen Test, die untere Abbildung einen rechtsseitigen Test. Wenn der rechtsseitige Test ebenfalls auf einem 5%

Signifikanzniveau durchgeführt werden soll muss offensichtlich die ‘kritische Wahrscheinlichkeitsmasse’ auf der rechten Seite verdoppelt werden, d.h. die schraffierte

Fläche am rechten Ende deckt α × 100% der gesamten Fläche ab (in diesem Fall

5%). Deshalb wird man nicht den kritischen Wert tcα/2 , sondern tcα wählen.

Wenn wir vermuten β ≤ β 0 und aus einer Stichprobe einen Wert b > β 0 + tcα sb

erhalten (also einen t-Wert, der in den schraffierten Verwerfungsbereich fällt), so ist

dies nur ‘schwer’ mit der Nullhypothese vereinbar und wir werden die Nullhypothese

mit einer Irrtumswahrscheinlichkeit von α × 100% verwerfen. Implizit bedeutet dies,

dass wir die Alternativhypothese akzeptieren.

Die Vorgangsweise für einen einseitigen t-Test kann folgendermaßen zusammengefasst werden:

1. Formulierung von Alternativ- und Nullhypothese

H0 :

HA :

β ≤ β0

β > β0

oder

H0 :

HA :

β ≥ β0

β < β0

und überprüfen, ob alle zugrunde liegenden Annahmen (korrekte Spezifikation,

unverzerrte Stichprobe, etc.) erfüllt sind.

Hinweis: das ‘gleich’ Zeichen (≥ oder ≤) gehört stets zur Nullhypothese.

2. Festlegung eines Signifikanzniveaus α und Ermittlung des dazugehörigen kritischen Wertes tcα für N − 2 Freiheitsgrade mittels einer t Tabelle

3. Bestimmung des Akzeptanz- und Verwerfungsbereichs.

136

Intervallschätzer, Hypothesentests und Prognosen

f (b) Verwerfungs-

Verwerfungsbereich

Annahmebereich

bereich

Zweiseitig:

H0 : β 6= β 0

(1 − α)

α/2

β0

β 0 − tcα sb

2

α/2

β 0 + tcα sb

b

2

f (b)

Einseitig:

H0 : β ≤ β 0

α

(1 − α)

β0

β 0 + tcα sb

Annahmebereich

b

Verwerfungsbereich

Abbildung 4.6: Zweiseitiger und rechtsseitiger Test mit gleichem Signifikanzniveau

α.

Akzeptanzbereich:

Verwerfungsbereich:

H0 : β ≤ β 0

HA : β > β 0

H0 : β ≥ β 0

HA : β < β 0

−∞ bis +tcα

+tcα bis +∞

−tcα bis +∞

−∞ bis −tcα

Hinweis: Als Merkhilfe können Sie sich einprägen, dass der Verwerfungsbereich

stets zur Gänze im Bereich der Alternativhypothese liegt!

4. Berechnung des Punktschätzers b und dessen Standardfehlers aus der Stichprobe.

5. Ermittlung des empirischen Werts der Teststatistik, d.h. des t-Wertes eines

Regressionskoeffizienten b

b − β0

t=

sb

6. Überprüfen, ob der empirische Wert der Teststatstik in den Akzeptanz- oder

den Verwerfungsbereich fällt.

Intervallschätzer, Hypothesentests und Prognosen

137

Beispiel: Angenommen, wir haben eine Regressionsgleichung

ŷi

10.45 − 2.48 xi

(4.32)

(1.62)

N = 19, R2 = 0.74

=

wobei die Werte in Klammern unter den Koeffizienten wieder die geschätzten Standardfehler sbk der Koeffizienten sind. Wir vermuten einen negativen Zusammenhang

zwischen x und y, deshalb sind Null- und Alternativhypothese

H0 :

HA :

β1 ≥ 0

β1 < 0

Können wir aufgrund dieser Regression die Nullhypothese β1 ≥ 0 auf einem Signifikanzniveau von 5% verwerfen? Der geschätzte Koeffizient ist zwar negativ, aber ist

er ‘genügend negativ’ um die Nullhypothese überzeugend verwerfen zu können?

Der empirische Wert der t-Statistik ist

t-Stat(b1 ) =

−2.48 − 0

b1 − β1

=

= −1.531 ∼ tN −2

sb1

1.62

Der kritische t-Wert für 17 Freiheitsgrade und ein Signifikanzniveau von 5% ist 1.74.

Wenn die Nullhypothese β1 ≥ 0 wahr ist würden wir einen positiven Wert für b1

erwarten, allerdings könnte ein nur leicht negativer Wert noch mit der Nullhypothese

kompatibel sein. Der Akzeptanzbereich für die Nullhypothese ist deshalb in diesem

Beispiel [−1.74, +∞], und der entsprechende Verwerfungsbereich [−∞, −1.74]. Der

empirisch ermittelte Wert t = −1.531 fällt eindeutig in den Akzeptanzbereich, das

heißt, die Nullhypothese darf nicht verworfen werden!

Was sind Akzeptanz- und Verwerfungsbereich für folgende Null- und Alternativhypothese?

H0 :

HA :

β1 ≥ −1

β1 < −1

Der kritische t-Wert für 17 Freiheitsgrade und ein Signifikanzniveau von 5% ist nach

wie vor 1.74.

Der Akzeptanzbereich bleibt deshalb unverändert und erstreckt sich von −1.74 bis

+∞, und ebenso der Verwerfungsbereich [−∞, −1.74].

Was sich ändert ist der empirische t-Wert, nämlich

t-Stat(b1 ) =

b1 − β1

−2.48 − (−1)

=

= −0.91

sb1

1.62

Dieser Wert fällt wieder eindeutig in den Akzeptanzbereich, deshalb kann die Nullhypothese nicht verworfen werden.

Analog dazu können Akzeptanz- und Verwerfungsbereich für

H0 :

HA :

β1 ≤ −1

β1 > −1

Intervallschätzer, Hypothesentests und Prognosen

138

angegeben werden. Der Akzeptanzbereich erstreckt sich von −∞ bis +1.74, und der

Verwerfungsbereich ist deshalb [+1.74, +∞]. Der bereits vorhin ermittelte empirische t-Wert −0.91 fällt also wieder in den Akzeptanzbereich, die Nullhypothese kann

nicht verworfen werden.

In diesem Beispiel kann also weder die Nullhypothese β1 ≤ −1 noch die Nullhypothese β1 ≥ −1 verworfen werden.

4.3.4

p-Wert

Bisher haben wir ein Signifikanzniveau α vorgegeben und überprüft, ob der aus der

Stichprobe ermittelte t-Wert in die Akzeptanz- oder Ablehnungsregion fällt. Lag der

aus der Stichprobe ermittelte t-Wert im Verwerfungsbereich wurde die Nullhypothese zugunsten der Alternativhypothese verworfen.

Mittlerweile geben so gut wie alle Statistikprogramme einen p -Wert aus, der die

Interpretation vereinfachen soll.

Der p-Wert gibt die Wahrscheinlichkeit an, dass bei Gültigkeit der Nullhypothese

ein zufälliger Versuch (Stichprobenziehung) ein mindestens so ‘extremes’ Ergebnis

liefert wie der beobachtete. Der p-Wert wird manchmal auch als marginales Signifikanzniveau bezeichnet, da er das Niveau angibt, ab dem die Nullhypothese gerade

zu verwerfen ist.

Die Vorgangsweise soll anhand eines rechtsseitigen Tests erläutert werden.

Man berechnet zuerst aus der Stichprobe den empirischen t-Wert und benutzt diesen

t-Wert um ein Konfidenzintervall (−∞, t] zu bilden (im Unterschied zum vorhergehenden Konfidenzintervall (−∞, tcα ]).

Anschließend fragt man, wie groß unter Gültigkeit der Nullhypothese die Wahrscheinlichkeit p ist, bei wiederholten Stichprobenziehungen einen t-Wert außerhalb

dieses Intervalls zu erhalten. Die Nullhypothese wird abgelehnt, wenn p < α. Abbildung 4.7 veranschaulicht die Vorgangsweise.

Die Vorgangsweise für einen zweiseitigen Test erfolgt analog, in diesem Fall bezeichnet der p -Wert die Wahrscheinlichkeitsmasse, die außerhalb des Intervalls [−t, t]

liegt; es ist also einfach die doppelte Fläche eines einseitigen Tests zu verwenden.

Die Nullhypothese wird wieder abgelehnt, wenn p-Wert < α (siehe Abbildung 4.8).

Computerprogramme berechnen den p-Wert meist mit Hilfe der Verteilungsfunktion

Z t

F (t) =

f (x) dx

−∞

Für einen zweiseitigen Test ist der p-Wert

p-Wert = 2(1 − F (|t|)

wobei |t| der Absolutwert der berechneten Teststatistik ist, und F in diesem Fall die

Verteilungsfunktion bezeichnet (nicht die F -Statistik!).

Der p-Wert hat im Vergleich mit dem traditionellen t-Wert den Vorteil, dass er ohne

Nachschlagen in einer Tabelle interpretiert werden kann und außerdem direkter zum

Ausdruck bringt, wie deutlich die Nullhypothese abgelehnt oder akzeptiert worden

139

Intervallschätzer, Hypothesentests und Prognosen

f (t)

α

t

t tcα

f (t)

p -Wert

t

t

Abbildung 4.7: Einseitiger Parameter Test auf Basis des t- und p -Wertes.

f (t)

p -Wert

t

t

Abbildung 4.8: Zweiseitiger Parameter Test auf Basis des p -Wertes.

ist. Andererseits hat der traditionelle t-Wert den Vorteil, dass mit seiner Hilfe auch

andere Nullhypothesen als β = 0 getestet werden können, oder dass übliche Konfidenzintervalle berechnet werden können. In der ökonometrischen Literatur werden

aus diesem Grund eher die Standardfehler der Koeffizienten (oder t-Statistiken) als

die p-Werte angegeben.

4.3.5

Ein numerisches Beispiel

Gegeben seien folgende 5 Beobachtungen für x und y:

Intervallschätzer, Hypothesentests und Prognosen

y: 2.6 1.6 4.0

x: 1.2 3.0 4.5

140

3.0 4.9

5.8 7.2

Berechnen Sie die Punktschätzer b0 und b1 , deren Standardabweichungen sb0 und

sb1 , die t-Statistiken und das Bestimmtheitsmaß R2 .

y

x

y

ẍ

ẍy

y2

ẍ2

x2

1

2.60 1.20 −0.62 −3.14

1.95 0.38 9.86

1.44

2

1.60 3.00 −1.62 −1.34

2.17 2.62 1.80

9.00

3

4.00 4.50

0.78

0.16

0.12 0.61 0.03 20.25

4

3.00 5.80 −0.22

1.46 −0.32 0.05 2.13 33.64

5

4.90 7.20

1.68

2.86

4.80 2.82 8.18 51.84

Summe: 16.10 21.70

0.00

0.00

8.73 6.49 21.99 116.17

P

wobei ÿi = yi − ȳ, mit ȳ = 1/N 5i=1 yi = 16.10/5 = 3.22, usw.

Anhand dieser Tabelle können einfach die Koeffizienten b0 und b1 berechnet werden

P

ẍi yi

8.73

b1 = Pi 2 =

≈ 0.397

21.99

i ẍi

b0 = ȳ − b1 x̄ = (16.1/5) + 0.397 × (21.7/5) ≈ 1.498

Mit Hilfe dieser geschätzten Koeffizienten können nun die gefitteten y (b

y ) und die

geschätzten Residuen ei berechnet werden: ybi = b0 + b1 xi und ei = yi − ybi = yi −

b0 − b1 xi .

1

2

3

4

5

Summe:

yb

e

e2

1.974 0.626 0.392

2.688 -1.088 1.184

3.283 0.717 0.513

3.799 -0.799 0.639

4.355 0.545 0.297

16.100 0.000 3.026

Mit Hilfe der Quadratsumme der Residuen können wir einen Schätzer für die Varianz

der Störterme εi berechnen

P 2

3.026

2

i ei

s =

=

= 1.008564

N −2

3

und den Standardfehler der Regression

sP

r

2

3.026

i ei

s=

=

= 1.004273

N −2

3

Dieser gestattet uns nun die Berechnung der Standardabweichungen der Koeffizienten sb0 und sb1

s

r

s2

1.008564

P 2 =

sb1 =

= 0.21415

21.99

i ẍi

s P

r

s2 x2i

1.008564 × 116.17

P 2 =

sb0 =

= 1.03224

N ẍi

5 × 21.99

Intervallschätzer, Hypothesentests und Prognosen

141

Nun haben wir die Koeffizienten b0 und b1 sowie deren Standardabweichungen sb0

und sb1 berechnet und können diese für Hypothesentests nützen.

Wenn die Nullhypothese getestet werden soll, ob kein Zusammenhang zwischen x

und y besteht, also

H0 : β1 = 0

HA : β1 6= 0

erhalten wir die Teststatistik

t-Stat(b1 ) =

0.397

b1 − 0

=

= 1.853

sb1

0.21415

Der kritische Wert der t-Verteilung für ein 5% Signifikanzniveau ist für 3 Freiheitsgrade tc0.025 = 3.1824.

Unser aus der Stichprobe berechneter Wert t-Stat(b1 ) = 1.853 ist deutlich kleiner,

also dürfen wir die Nullhypothese β1 = 0 auf einem Signifikanzniveau von 5% nicht

verwerfen!

Ähnlich können wir die Nullhypothese β0 = 0 testen. Die entsprechende Teststatistik

ist

b0

1.498

t-Stat(b0 ) =

=

= 1.451

sb0

1.03224

Da der kritische Wert für ein 5% Signifikanzniveau wieder tc0.025 = 3.1824 ist, darf

auch die Nullhypothese β0 = 0 nicht verworfen werden.

Um den p-Wert von b0 zu berechnen benötigen wir die Fläche unter der Dichte

der t-Verteilung mit 3 Freiheitsgraden, die links von 1.451 liegt. Da diese Fläche

gleich dem Wert der Verteilungsfunktion an der Stelle 1.451 ist können wir diese mit einem geeigneten Programm berechnen, in EViews z.B. mit der Funktion

@ctdist(1.451,3) (für cumulated t-distribution, Wert, Freiheitsgrade)), und erhalten als Ergebnis Ft (1.451, 3) = 0.8787. Die Fläche unter der t-Verteilung rechts von

1.451 ist 1 − 0.8787 = 0.1213, und da es sich um einen zweiseitigen Test handelt

benötigen wir das Doppelte dieser Fläche (links von −1.451 und rechts von +1.451),

also ist der p-Wert von b0 gleich 2(1 − 0.8787) = 0.2426.

Ähnlich für b1 , Ft (1.853, 3) = 0.9195, der p-Wert von b1 ist also 2(1 − 0.9195) =

0.16098.

Schließlich ist noch das Bestimmtheitsmaß R2 zu berechnen

P 2

e

3.026

2

R =1− P i i 2 =1−

= 0.534

6.49

i (yi − ȳ)

Diese Werte können mit einem entsprechenden Computerprogramm natürlich weit

einfacher berechnet werden. Mit EViews erhalten wir z.B. folgenden Output:

Dependent Variable: Y

Included observations: 5

Variable

Coefficient Std. Error t-Stat.

Prob.

C

1.498

1.032

1.451

0.243

X

0.397

0.214

1.853

0.161

R-squared

0.534 SE of regression

1.00427

142

Intervallschätzer, Hypothesentests und Prognosen

4.3.6

Typ I und Typ II Fehler

Selbst wenn die Nullhypothese wahr ist, und deshalb nicht verworfen werden sollte, können wir uns irren und sie irrtümlich verwerfen. Selbst wenn alle Annahmen

erfüllt sind und wir keine Fehler gemacht haben müssen wir – wenn der Test sehr oft

mit unterschiedlichen Stichprobendaten wiederholt wird (repeated sampling) – in α

Prozent der Fälle mit einem Wert der Teststatistik rechnen, der uns zur Ablehnung

der Nullhypothese veranlasst, obwohl sie richtig ist (Verwerfungsfehler, d.h. unberechtigte Verwerfung der Nullhypothese). Die Wahrscheinlichkeit dafür wird durch

den Typ I Fehler beschrieben. Im Falle eines einfachen t-Tests eines Regressionsmodells veranlasst uns ein Typ I Fehler z.B. an einen Zusammenhang zwischen x und

y zu glauben, obwohl in der Grundgesamtheit kein solcher Zusammenhang existiert.

Das Signifikanzniveau α (auch ‘size of a test’ genannt) ist also definiert als

α = P [Typ I Fehler]

= P [Verwerfung H0 |H0 wahr]

Durch die Wahl des Signifikanzniveaus kann die Wahrscheinlichkeit eines Typ I Fehlers (d.h. eine richtige Nullhypothese zu verwerfen), unmittelbar gesteuert werden.

Wann immer die potentiellen Kosten eines Typ I Fehlers sehr hoch sind sollte ein

entsprechend kleines Signifikanzniveau gewählt werden (z.B. α ≤ 0.01).

Aber es kann auch ein anderer Fehler passieren, nämlich dass eine falsche Nullhypothese irrtümlich nicht verworfen wird. Dies wird als Typ II (oder β-) Fehler

bezeichnet. Zum Beispiel, Im Falle eines Typ II Fehlers existiert tatsächlich ein

Zusammenhang zwischen x und y, aber wir verwerfen die Nullhypothese nicht, es

handelt sich also um einen ‘Nicht-Verwerfungsfehler’.

Tabelle 4.1 zeigt Typ I und Typ II Fehler, und Tabelle 4.2 zeigt den Vergleich mit

einem Gerichtsurteil.

Tabelle 4.1: Typ I und Typ II Fehler

Entscheidung auf

Grundlage eines

statistischen Tests:

Nullhypothese H0

wird nicht verworfen

Nullhypothese H0

wird verworfen

Wahrer

Sachverhalt:

H0 ist wahr

korrekte Entscheidung

(1 − α)

Typ I Fehler

Wahrer

Sachverhalt:

H0 ist falsch

Typ II Fehler

korrekte Entscheidung

(1 − β: “Power ”)

Während die Wahrscheinlichkeit eines Typ I Fehlers durch Wahl des Signifikanzniveaus vorgegeben werden kann, ist dies für den Typ II Fehler nicht so einfach möglich,

denn die Wahrscheinlichkeit eines Typ II Fehlers hängt von der Verteilung um das

‘wahre’ β ab.

Zur Illustration gehen wir von einer sehr einfachen Null- und Alternativhypothese

aus, nämlich

H0 :

HA :

β = β0

β = βA

143

Intervallschätzer, Hypothesentests und Prognosen

Tabelle 4.2: Vergleich Typ I und Typ II Fehler mit einem Gerichtsurteil

Gericht fällt

Entscheidung

“unschuldig”

Gericht fällt

Entscheidung

“schuldig”

Angeklagter

ist unschuldig

Angeklagter

ist schuldig

richtige Entscheidung

Schuldiger wird

freigesprochen

Unschuldiger

wird verurteilt

richtige Entscheidung

f (b)

Verteilung

unter H0

Verteilung

unter HA

bc

βA

bc

x

b

β 0Typ II Typ I

Fehler Fehler

Akzeptiere H0

Verwirf H0

f (b)

Verteilung

unter H0

Verteilung

unter HA

bc

β 0 Typ II

Fehler

Akzeptiere H0

x

bc

βA

Typ I

Fehler

b

Verwirf H0

Abbildung 4.9: Typ I und Typ II Fehler: Durch die Wahl eines höheren Signifikanzniveaus (d.h. kleineren α) sinkt die Wahrscheinlichkeit eines

Typ I Fehlers, aber dadurch steigt die Wahrscheinlichkeit eines

Typ II Fehlers.[Folien: local, www]

Intervallschätzer, Hypothesentests und Prognosen

144

wobei β 0 und β A fixe Zahlen sind. Abbildung 4.9 zeigt diesen Fall. Die linke durchgezogene Verteilung ist die Stichprobenkennwertverteilung von b unter Gültigkeit

der Nullhypothese. Wenn die Nullhypothese tatsächlich wahr ist fallen bei oftmaliger Wiederholung α × 100 Prozent der geschätzten b in den Bereich rechts von x

(einseitiger Test), und die schraffierte Fläche darüber gibt die Wahrscheinlichkeit

für einen Typ I Fehler an.

Ein Typ II Fehler passiert hingegen, wenn eine tatsächlich falsche Nullypothese

nicht verworfen wird. Wenn die Nullypothese falsch ist muss die Alternativhypothese wahr sein, in diesem einfachen Fall also β = β A . Die rechte strichlierte Verteilung

in Abbildung 4.9 zeigt die Stichprobenkennwertverteilung von b wenn tatsächlich

die Alternativhypothese richtig ist. Die Wahrscheinlichkeit dafür, dass die Alternativhypothese richtig ist, aber die Nullhypothese nicht abgelehnt wird, entspricht

der horizontal schraffierten Fläche in Abbildung 4.9 (die Fläche unter der strichliert

gezeichneten Verteilung links von x).

In der Realität wissen wir nicht, ob die Null- oder die Alternativhypothese richtig

ist, deshalb wissen wir auch nicht welche der beiden Stichprobenkennwertverteilungen die wahre ist. Aber wir wissen, dass nur entweder die Nullhypothese oder die

Alternativhypothese richtig sein kann.

Wenn die durchgezogene Stichprobenkennwertverteilung (unter H0 ) die wahre Verteilung ist, machen wir bei einem einseitigen Test in α × 100 Prozent der Fälle

einen Typ I Fehler. Wenn aber die Alternativhypothese wahr ist und die strichlierte

Stichprobenkennwertverteilung (unter HA ) die wahre Verteilung ist, dann machen

wir mit einer Wahrscheinlichkeit, die durch die Fläche des horizontal schraffierten

Bereichs (links von x) gegeben ist, einen Typ II Fehler. Man beachte, dass der Wert

des Typ II Fehlers von der Annahme über das wahre β abhängt.

Die untere Grafik von Abbildung 4.9 zeigt den gleichen Zusammenhang für ein

kleineres Signifikanzniveau α.

Daraus lassen sich zwei wichtige Schlussfolgerungen ziehen:

1. Die Wahrscheinlichkeit von Typ I und Typ II Fehler sind invers verknüpft,

d.h. je niedriger die Wahrscheinlichkeit ist einen Typ I Fehler zu machen,

umso höher ist die Wahrscheinlichkeit eines Typ II Fehlers. Dies erkennt man,

wenn man die obere und untere Grafik in Abbildung 4.9 vergleicht, die für

unterschiedliche Signifikanzniveaus gezeichnet sind.

2. Die Wahrscheinlichkeit eines Typ II Fehlers ist umso höher, je näher β A bei

β 0 liegt.

Auch wenn es nicht möglich ist beide Arten von Fehler zu kontrollieren, so kann man

doch zeigen, dass diese Teststrategie zumindest ‘bestmöglich’ in dem Sinne ist, dass

sie für eine gegebene Wahrscheinlichkeit eines Typ I Fehlers die Wahrscheinlichkeit

eines Typ II Fehlers minimiert.

4.3.7

Trennschärfe eines Tests (‘Power of a Test ’)

Wie bereits ausgeführt sind bei einem statistischen Test zwei Fehler möglich: Typ

I Fehler – Ablehnung einer wahren Nullhypothese, und Typ II Fehler – Akzeptanz

145

Intervallschätzer, Hypothesentests und Prognosen

einer falschen Nullhypothese. Die Wahrscheinlichkeit, mit der eine falsche Nullhypothese tatsächlich abgelehnt wird (also kein Typ II Fehler gemacht wird), wird

Trennschärfe oder ‘Power’ eines Tests genannt.

Die Trennschärfe eines Tests gibt an, mit welcher Wahrscheinlichkeit tatsächliche

Unterschiede durch einen statistischen Test aufgedeckt werden können. Da die Wahrscheinlichkeit einen vorhandenen Unterschied nicht festzustellen durch den Typ II

Fehler angegeben wird, ist die Trennschärfe Eins minus die Wahrscheinlichkeit für

einen Typ II Fehler (vgl. Abbildung 4.10).

Power = P [Verwerfung H0 |H0 ist falsch]

= 1 − P [Akzeptanz H0 |H0 ist falsch]

= 1 − P [Typ II Fehler]

Die ‘Power ’, also die Wahrscheinlichkeit mit der eine falsche Nullhypothese

tatsächlich verworfen wird, sollte natürlich möglichst nahe bei Eins liegen.

f (b)

Verteilung

unter H0

Verteilung

unter HA

‘Power ’

β0

β

b

Abbildung 4.10: Die ‘Power’ oder Trennschärfe eines Tests ist Eins minus Wahrscheinlichkeit eines Typ II Fehlers, also die Wahrscheinlichkeit,

mit der eine falsche Nullhypothese tatsächlich verworfen wird.

Im vorhergehenden Beispiel hatten wir eine sehr einfache Null- und Alternativhypothese, nämlich H0 : β = β 0 und HA : β = β A . Nun wollen wir eine etwas

realistischere Alternativhypothese untersuchen, nämlich

H0 :

HA :

β = β0

β 6= β 0

Dies ändert nichts für den Typ I Fehler (wahre H0 verwerfen), dieser wird nach wie

vor durch das gewählte Signifikanzniveau angegeben.

Aber in diesem Fall kann die Wahrscheinlichkeit für einen Typ II Fehler (falsche

H0 akzeptieren) nicht mehr durch eine einfache Zahl angegeben werden, sondern

hängt vom wahren und unbeobachtbaren β ab. Wenn β sehr nahe bei β 0 liegt wird

ceteris paribus die Wahrscheinlichkeit für einen Typ II Fehler höher sein, und also

die Power des Tests niedriger sein.

Intervallschätzer, Hypothesentests und Prognosen

146

Wie Abbildung 4.10 zeigt hängt die ‘Power’ außer vom Signifikanzniveau α auch

vom unbeobachtbaren ‘wahren’ Wert β der Grundgesamtheit ab, und ist deshalb

unbeobachtbar. Aber man kann die Power als Funktion aller möglichen β darstellen.

Diese Funktion zwischen Trennschärfe und möglichen ‘wahren’ Parameterwerten der

Grundgesamtheit wird Teststärkefunktion (power function) genannt.

Beispiel: Gegeben folgende Schätzung

yi

=

6.505 + 0.31xi

(3.02)

(0.082)

R2 = 0.42, N = 24

(Standardfehler in Klammern)

Wir interessieren uns für den Steigungskoeffizienten b, der in dieser Stichprobe den

Wert 0.31 hat. Den wahren Wert in der Grundgesamtheit bezeichnen wir mit β.

Um die Powerfunktion für b mit α = 0.05 zu berechnen benötigen wir zuerst das

95% Konfidenzintervall für b

b − tc(22,α=0.025) × sb ≤ β ≤ b + tc(22,α=0.025) × sb

0.31 − 2.074 × 0.082 ≤ β ≤ 0.31 + 2.074 × 0.082

da der kritischer Wert der t-Verteilung tc(22,α=0.025) = 2.074 ist. Also ist für die

H0 : β = 0.31 und α = 0.05 das Konfidenzintervall

0.14 ≤ β ≤ 0.48

Die Größe des Typ II Fehlers hängt von β ab. Für die grafische Darstellung wählen

wir eine spezifische Alternativhypothese, nämlich

H0 : β = 0.31,

HA : β = 0.5

und berechnen für diese den Typ II Fehler und die Power.

Abbildung 4.11 zeigt das Prinzip: wenn die Nullhypothese β = 0.31 richtig ist, ist

die Stichprobenkennwertverteilung von b die mit durchgezogener Linie gezeichnete

Verteilung um 0.31. Wenn hingegen die Alternativhypothese richtig sein sollte ist

die Stichprobenkennwertverteilung von b die mit strichlierter Linie gezeichnete Verteilung um β = 0.5 (eine dritte Möglichkeit lassen wir im Moment nicht zu, d.h. wir

nehmen an, dass entweder β = 0.31 oder β = 0.5, aber wir wissen nicht, welche der

beiden Hypothesen wahr ist).

Wenn die Nullhypothese tatsächlich richtig ist, machen wir mit Wahrscheinlichkeit

α einen Typ I Fehler. Wenn hingegen die Alternativhypothese (β = 0.5) richtig ist,

können wir die Wahrscheinlichkeit für einen Typ II Fehler einfach berechnen

P (Typ II Fehler|β = 0.5) = P (0.14 ≤ b ≤ 0.48|β = 0.5)

0.14 − 0.5

0.48 − 0.5

= P

≤t≤

0.082

0.082

= P (−4.39 ≤ t ≤ −0.244)

= Φtdf=22 (−0.244) − Φtdf=22 (−4.39))

= 0.404746 − 0.000116 = 0.40463

147

Intervallschätzer, Hypothesentests und Prognosen

f (b)

4

3

2

1

Typ II

Fehler

0

0.31

0.5

0.14

b

0.48

Standardisierung:

f (t)

Typ II

Fehler

-5

-4

-4.39

-3

-2

-1

Power

0

-0.244

1

2

3

t

Abbildung 4.11: Berechnung des Typ II Fehlers für H0 : β = 0.31, HA : β = 0.5;

[Folien: local, www]

Intervallschätzer, Hypothesentests und Prognosen

148

wobei Φtdf=22 (−0.244) der Wert der Verteilungsfunktion einer t-Verteilung mit 22

Freiheitsgraden an der Stelle −0.244 ist;

in EViews: @ctdist(Wert, degrees of freedom); z.B. @ctdist(-0.244,22) =

0.404746

Die Trennschärfe oder Power ist einfach Eins minus die Wahrscheinlichkeit für einen

Typ II Fehler:

Power = 1 − P (Typ II Fehler) = 1 − 0.40463 = 0.59537

Bisher haben wir die Power nur für eine sehr spezielle Alternativhypothese berechnet, nämlich HA : β = 0.5. Üblicherweise umfasst die Alternativhypothese alle

Fälle, die nicht durch die Nullhypothese abgedeckt werden, also z.B. H0 : β = 0.31

und HA : β 6= 0.31.

Offensichtlich ist die Power eine Funktion des β, das unter der Alternativhypothese

angenommen wurde, und da die Alternativhypothese unendlich viele Fälle enthält

scheint die Situation aussichtslos. Man kann aber die Power zumindest für viele verschiedene β berechnen, und den Zusammenhang zwischen β und der Power grafisch

darstellen. Diese Vorgangsweise ergibt die Power- oder Trennschärfe-Funktion.

Da die händische Berechnung dieser vielen Power’s für die einzelnen β etwas mühsam

wäre, lässt man diese Arbeit besser den Computer erledigen.

Das folgende EViews Programm berechnet die Power in Schritten von 0.01 für alle β

zwischen −0.3 und 1.2 (also für insgesamt 150 verschiedene β) und stellt sie grafisch

dar. Abbildung 4.12 zeigt das Ergebnis.

wfcreate u 150

series Power

series Beta

!j = 1

for !i = -0.3 to 1.2 step 0.01

Beta(!j) = !i

Power(!j) = 1 - (@ctdist((0.48 - !i)/0.082,22) - _

@ctdist((0.14 - !i)/0.082,22))

!j = !j + 1

next

graph POWERFUNKT.xyline Beta Power

POWERFUNKT.addtext(t) "Power-Funktion"

show POWERFUNKT

Wiederholungsfrage: Wie sieht die Power-Funktion für einen einseitigen Test aus?

149

Intervallschätzer, Hypothesentests und Prognosen

Power-Funktion

1.0

POWER

0.8

0.6

0.4

0.2

0.0

-0.4

-0.2

0.0

0.2

0.4

0.6

0.8

1.0

1.2

1.4

BETA

Abbildung 4.12: Power Funktion

Effizientere Schätzfunktionen erlauben trennschärfere Tests

Die ‘Power’ eines Tests nimmt mit der Stichprobengröße zu. Abbildung 4.13 zeigt

in der oberen Grafik die Power für eine kleine Stichprobe (kleines N), und in der

unteren Grafik für eine große Stichprobe. Die zugrunde liegende Null- und Alternativhypothese ist in beiden Grafiken gleich. Offensichtlich ist die ‘Power’ bei der

großen Stichprobe deutlich größer!

Man beachte, dass die Power aus zwei Gründen zunimmt: erstens ist die Varianz

der unbeobachtbaren wahren Verteilung bei einer größeren Stichprobe kleiner, und

zweitens liegt der kritische Wert der Verteilung tcαg näher beim β 0 .

Abbildung 4.14 zeigt zwei typische Teststärkefunktionen, eine mit kleinerer ‘Power’

(strichlierte Linie) und eine mit größerer ‘Power’.

4.3.8

Ein Wort zur Warnung

Statistische vs. theoretische Gültigkeit

Statistische Tests setzen korrekt spezifizierte Modelle voraus. Sind die Modelle falsch

spezifiziert sind die Tests nicht interpretierbar.

Typisches Beispiel: Die Zahl der Störche in Österreich korrelierte lange Zeit hoch signifikant mit der Anzahl der Geburten. Warum? Beide folgten einem Trend, die Zahl

der Geburten nahm mit dem Einkommen ab, die Zahl der Störche mit der Umweltverschmutzung. Die nicht berücksichtigte Variable Trend (‘omitted variable’) erklärt

die Korrelation zwischen den zwei kausal nicht verknüpften Variablen. Dies ist nur

ein Beispiel für die altbekannte Tatsache, dass Korrelation, oder eine signifikante

Teststatistik, kein Garant für Kausalität ist!

150

Intervallschätzer, Hypothesentests und Prognosen

f (b)

Verteilung

unter H0

Verteilung

unter HA

‘Power ’

tcαk

β0

β

b

f (b)

großes

N

Verteilung

unter H0

Verteilung

unter HA

kleines

N

Power

b

β

b

tcαg tcαk

0

b

β

Abbildung 4.13: Die ‘Power’ eines Tests nimmt mit der Stichprobengröße N zu.

1.0

0.5

α

0

β0

b

Abbildung 4.14: Teststärkefunktionen (‘Power Functions’) für zwei Tests (zweiseitig). Die durchgezogene Teststärkefunktion hat eine größere

‘Power’ als die strichlierte.

Teststatistiken sind kein Substitut für eine Theorie, sondern ein Komplement, d.h.

Teststatistiken sind nur in Kombination mit einer gültigen theoretischen Erklärung

Intervallschätzer, Hypothesentests und Prognosen

151

sinnvoll, wie seit langer Zeit bekannt ist

“In 1948, Frederick Mosteller (1916-) argued that a ‘third kind of error’

was required to describe circumstances he had observed, namely:

• Type I error: ‘rejecting the null hypothesis when it is true’.

• Type II error: ‘accepting the null hypothesis when it is false’.

• Type III error: ‘correctly rejecting the null hypothesis for the wrong

reason’.”7

Ein nettes Beispiel dafür liefert die Medizin8

“Selbstversuche haben in der Medizin Tradition. An die Grenze der

menschlichen Belastbarkeit ging dabei der angehende Arzt Stubbins

Ffirth am Anfang des 19. Jahrhunderts. Er war überzeugt, dass Malaria nicht ansteckend ist, sondern auf übermäßige Hitze, Essen und Lärm

zurückzuführen sei.

Um seine These zu erhärten, setzte er sich selbst der Krankheit aus.

Zuerst brachte er nur kleine Mengen von frischem Erbrochenem in sich

selbst zugefügte kleine Kratzer ein. Danach tropfte er kleine Mengen in

seine Augen. Am Ende der Testreihe aß er die frischen Exkremente eines

Kranken. Wie durch ein Wunder blieb er tatsächlich gesund. Er sah seine

Behauptung somit belegt.”

Der wackere Stubbins Ffirth konnte damals nicht wissen, dass die Malaria durch

den Biss der weiblichen Stechmücke Anopheles übertragen wird, sein heldenmütiger

Verzehr frischer Exkremente lieferte offensichtlich keinen Beweis für die Richtigkeit

seiner Hypothese.

Ein humorvoller Vorschlag für einen Typ IV Fehler stammt von dem Harvard Ökonom Howard Raiffa, “solving the right problem too late” ;-)

Statistische Signifikanz und ‘Relevanz’ einer Variablen

Manchmal wird statistische Signifikanz mit der Bedeutung einer Variable verwechselt (Effektstärke). Statistische Signifikanz sagt nichts darüber aus, ob die Größe des

gemessenen Koeffizienten auch praktisch relevant ist. Da der geschätzte Koeffizient

auch von der Dimension abhängt, in der die Variablen gemessen wurden, kann es

manchmal nützlich sein, den Koeffizienten einer Variable mit dem Mittelwert dieser

Variable zu multiplizieren (bk x̄k ), um einen Eindruck von der quantitativen ‘Bedeutung’ einer Variable zu bekommen. Ein Zusammenhang kann zwar statistisch hoch

signifikant sein, aber für praktische Zwecke völlig bedeutungslos sein!

7

zitiert aus Wikipedia: http://en.wikipedia.org/wiki/Type_I_error; Quelle: Mosteller, F.,

A k-Sample Slippage Test for an Extreme Population, The Annals of Mathematical Statistics,

Vol.19, No.1, (March 1948), pp.58-65.

8

zitiert aus http://science.orf.at/science/news/149922, [05.11.2007].

Intervallschätzer, Hypothesentests und Prognosen

152

Signifikanz und Stichprobengröße

Umso größer eine Stichprobe ist, umso eher ist ein t-Test signifikant. Wenn die

Stichprobe sehr groß ist kann fast jede Nullhypothese verworfen werden.

für N → ∞ : t =

β

b

≈ =∞

se(b)

0

Trotzdem muss das Resultat nicht von praktischer Bedeutung sein, denn die Signifikanz sagt z.B. nichts über die ökonomische Bedeutung (Relevanz) eines Ergebnisses

aus.

Mein persönlicher Rat ist in erster Linie auf die geschätzten Koeffizienten und die

Konfidenzintervalle zu achten.

Die Gültigkeit von Test hängt von einer Reihe von Annahmen ab, die oft schwer zu

überprüfen sind, z.B.

• ist die vorliegende Stichprobe tatsächlich eine Zufallsstichprobe, oder ist ein

sample selection bias zu befürchten?

• ist die der Hypothese zugrunde liegende Kausalitätsvorstellung tatsächlich angebracht, oder ist simultane Kausalität zu befürchten?

• wurden alle relevanten Einflussfaktoren berücksichtigt, oder könnte das Ergebnis durch eine unbeobachtete Variable verursacht worden sein (omitted variable

bias)?

• usw.

Ein Test ist in erster Linie eine Entscheidungsregel, aber diese Entscheidungsregel

ist nur anwendbar, wenn sie auf zutreffender Information beruht. Erinnern Sie sich,

die erste Tugend einer Wissenschaftlerin ist Skepsis; fragen Sie sich stets ‘was könnte

das Ergebnis, dass Sie zu sehen glauben, sonst verursacht haben als das, was Sie zu

sehen wünschen?’ Tests können – vernünftig angewandt – ein sehr mächtiges und

nützliches Werkzeug sein, aber man kann damit auch ziemlich viel Unfug anrichten.

Ein statistischer Test ist übrigens auch nie ein Beweis für irgendetwas, es gibt keine

statistischen Beweise im Sinne der Logik!

Zusammenfassend: Blindes Vertrauen ist meistens dumm. Blindes Vertrauen in

einen statistischen Test ist davon keine Ausnahme.

Intervallschätzer, Hypothesentests und Prognosen

4.4

153

Prognosen

“Prediction is very difficult, especially

(Niels Bohr)

about the future.”

“Que Sera, Sera,

The future’s not ours, to see

Whatever will be, will be

(Doris Day)

Que Sera, Sera”

Eine der wesentlichen Aufgaben von Ökonometrikerinnen ist die Erstellung von Prognosen. Wie kann man die Ausprägung einer Zufallsvariablen prognostizieren, die

nicht beobachtet wurde (z.B. der Wert der Variablen y in der nächsten Periode T +1,

oder der Konsum einer Person, die nicht befragt wurde)?

Gebräuchlichen Konventionen entsprechend bezeichnen wir den zu prognostizierenden Wert der abhängigen Variablen mit y0 . In vielen Fällen wird dies der Wert der

nächsten Periode sein, d.h. yT +1 . Den entsprechenden Wert der erklärenden Variablen bezeichnen wir mit x0 .

Da Prognosen hauptsächlich für Zeitreihen relevant sind verwenden wir t als Index

über die Beobachtungen, und bezeichnen die Größe der Stichprobe mit T .

Offensichtlich können Prognosen mit Hilfe einer Regression sehr einfach durchgeführt

werden. Wenn z.B. eine Gleichung

ybt = 15 + 2.5xt

geschätzt wurde, kann für ein x0 = 4 sofort der Wert y0 = 25 prognostiziert werden.

In diesem Abschnitt werden wir nicht nur einfache Prognosen diskutieren, sondern

auch Konfidenzintervalle für die prognostizierten Werte ermitteln.

Prinzipiell unterscheidet man zwischen “bedingten” und “unbedingten” Prognosen.

Bei einer bedingten Prognose wird von einem a priori bekannten Wert der erklärenden Variable x0 im Prognosezeitraum ausgegangen. Eine bedingte Prognose macht

also Aussagen über eine interessierende Variable y, bedingt auf Annahmen über die

x Variable. Berechnet wird sie einfach, indem man x0 in die geschätzte Regressionsgleichung einsetzt.

Oft möchte man aber einfach eine bestmögliche Prognose für y, ohne spezifische

Annahmen über die x treffen zu müssen. Eine solche Prognose nennt man eine

unbedingte Prognose. Um eine solche unbedingte Prognose machen zu können müssen