Wahrscheinlichkeitsrechnung

Werbung

Wahrscheinlichkeitsrechnung

8. Februar 2013

1

Geschichtliches

Die mathematische Wahrscheinlichkeitstheorie fand ihre Anfänge in Frankreich (siehe [Gurtner] S. 5-6). Der

Philosoph und Literat Chevalier de Méré (1607-1684) beschäftigte sich hauptberuflich mit dem Würfelspiel. Die

Bank (de Méré) gewann immer dann, wenn ein Spieler bei vier Würfen mit je einem Würfel wenigstens eine

Sechs warf. Die Grundlage dieser Regeln führten dazu, dass Herr de Méré sehr reich wurde. Um noch mehr Geld

zu verdienen, änderte er die Regeln etwas ab. Die Bank gewann nun, wenn ein Spieler bei 4 Würfen wenigstens

eine doppelte Sechs würfelte. Ab diesem Zeitpunkt verlor de Méré fast sein ganzes Vermögen. Der Chevalier

de Méré stellte daraufhin im Jahr 1654 dem Mathematiker Blaise Pascal (1623-1662) zwei Fragen über die

Wahrscheinlichkeit bei Glücksspielen. Daraufhin beschäftigten sich sowohl Pascal als auch der Mathematiker

Pierre Fermat (1601-1655) mit der Wahrscheinlichkeitsrechnung.

Aufgrund des niedrigen Entwicklungsstandes der Naturwissenschaft damaliger Zeit bildeten Glücksspiel und Fragen von Demographie und Versicherung noch lange Zeit den einzigen konkreten Gegenstand zur Entwicklung

der Begriffe und Methoden der Wahrscheinlichkeitsrechnung. (siehe [Physikwiki])So beschäftigte sich zum Beispiel Graunt mit der Sterbewahrscheinlichkeit in Abhängigkeit vom Lebensalter, Johan De Witt (1625-1672)

und Edmund Halley (1656-1742) stellten auf der Grundlage ähnlicher Überlegungen Tabellen für Rentenzahlungen auf. Auch Isaac Newton (1643-1727) nutzte wahrscheinlichkeitstheoretische Gedanken in der Histographie

und der Fehlerrechnung und befasste sich in einem unveröffentlichten Manuskript um 1665 mit geometrischen

Wahrscheinlichkeiten.

Der formale mathematische Apparat, mit dessen Hilfe die entstehenden Aufgaben gelöst wurden, wurde von

elementaren arithmetischen und kombinatorischen Methoden bestimmt.

Das erste bekannte Buch, das sich mit der Wahrscheinlichkeitsrechnung beschäftigt, wurde im Jahr 1657 vom

niederländischen Naturwissenschaftler Christiaan Huygens (1629-1695) verfasst. Es trug den Titel „De Ratiociniis in Aleæ Ludo“ (über Schlussfolgerungen beim Würfelspiel) und behandelt Fragen, die bei einem Briefwechsel

zwischen Pascal und Fermat aufkamen. Huygens verwandte in diesem Werk aber nicht den Begriff "Wahrscheinlichkeit", sondern nutzte den schon von Pascal gebrauchten "Wert der Hoffnung" - heute als Erwartungswert

bezeichnet. Huygens wurde 1663 aufgrund seiner Leistungen auf dem Gebiet der Astronomie als erster Ausländer in die Londoner Royal Society aufgenommen und führte er aber auch die Wahrscheinlichkeitsrechnung

in England ein, wo sie auf fruchtbaren Boden traf. Bereits ein Jahr später benutzte John Tillotson, Erzbischof

von Canterbury, in “On the Wisdom of Being Religious” Huygens Erwartungswert, um zu beweisen, dass sich

der Glaube an Gott lohne. Sei die Wahrscheinlichkeit, dass Gott tatsächlich existiert, noch so gering, so habe

aufgrund des unendlichen Gewinns im Himmel das „Spiel Gottes” einen unendlich hohen Erwartungswert.

Zu Beginn des 17. Jahrhunderts entwickelte sich die Wahrscheinlichkeitsrechnung als eine Theorie der Glücksspiele. Doch bald darauf erkannten Versicherungsgesellschaften ihren praktischen Nutzen und begannen sie für

die Berechnung von diversen Unfallswahrscheinlichkeiten zu verwenden.

1

Wichtige Fortschritte in der Entwicklung der Wahrscheinlichkeitsrechnung sind dem Schweizer Mathematiker

Jakob Bernoulli (1655-1705) zuzuschreiben. Sein Hauptverdienst ist wohl der Satz von Bernoulli, auch das Gesetz der großen Zahlen genannt. „Das Gesetz der großen Zahlen besagt, dass sich die relative Häufigkeit eines

Zufallsergebnisses immer weiter an die theoretische Wahrscheinlichkeit für dieses Ergebnis annähert, je häufiger

das Zufallsexperiment durchgeführt wird.“ Erkenntnisse auf dem Gebiet der Kombinatorik (beispielsweise taucht

hier erstmals der Begriff Permutation auf) und eine vollständige Diskussion der Binomialverteilung, aber es wurden auch erstmals unendliche Folgen von identischen Zufallsprozessen untersucht. Diese sind für den Spezialfall

zweier möglichen Ausgänge noch heute als Bernoulli-Ketten bekannt.

Die Weiterentwicklung der Wahrscheinlichkeitsrechnung wurde stark vorangetrieben durch die bedeutenden

Anforderungen, welche die Naturwissenschaften stellten. Die bedeutendsten Fortschritte sind zweifellos dem

französischen Mathematiker Pierre Laplace (1749-1827) zu verdanken, aber auch Abraham de Moivre (16671754) und Siméon Poisson (1781-1840) haben entscheidende Erkenntnisse eingebracht.

Abraham de Moivre leitete in einer 1733 veröffentlichten Arbeit die Nominal-Verteilung der Wahrscheinlichkeit

als Näherung der Binominalverteilung ab und stellte eine zur Stirlingschen Formel äquivalente Formel auf.

Zuvor im Jahr 1718 publizierte er bereits das Buch "The doctrine of chances", in welchem er Methoden zur

Lösung von Aufgaben, die mit Glücksspielen im Zusammenhang stehen, systematisch darstellte und vervollkommnete. 1730 folgte dann "Miscellanea analytica" (Analytische Beiträge).

Theoretische Probleme der Völkerkunde und des Versicherungswesens verband Leonhard Euler (1707-1783)

mit Fragen der Wahrscheinlichkeitsrechnung und Nikolaus Bernoulli (1695-1726) formulierte das "Petersburger

Spiel", mit dessen Lösung sich viele Gelehrte beschäftigten.

Die Frage nach der Berechnung der Wahrscheinlichkeit von Hypothesen, wenn schon Beobachtungsergebnisse

vorliegen, warf Daniel Bernoulli (1700-1782) als erster auf. Die Lösung hierzu stammt von Thomas Bayes (gest.

1751), welcher aus den nach ihm benannten Formeln noch weitere Ausdrücke zur Lösung spezieller Probleme

herleitete.

Den nächsten großen Fortschritt brachte Simon Pierre de Laplace (1749-1827), der in seinem 1812 veröffentlichten Buch "Théorie analytique des probabilités" als erster eine Definition der Wahrscheinlichkeit gab. Sein

Werk stellte eine Widerlegung der damals anerkannten These dar, dass eine strenge mathematische Behandlung

der Wahrscheinlichkeit nicht möglich sei. Hierbei definiert Laplace die Wahrscheinlichkeit eines Ereignisses als

Ergebnis aus der Anzahl der dem Ereignis günstigen Fälle, dividiert durch die Anzahl der überhaupt möglichen

Fälle. Laplaces Zugang zur Wahrscheinlichkeit war intuitiv, da er hinter allen Phänomenen eine Gleichverteilung

vermutete. Die Laplacesche Definition bezieht sich auf eine ideale Welt vollkommener Symmetrie. Dabei wird

das Definitionsproblem jedoch zu einem Anwendungsproblem, da man es nur auf die Frage verschiebt, wie weit

man mit dieser idealen Welt Wirklichkeit erfassen kann.

Poisson verallgemeinerte sowohl das Bernoullische Gesetz der großen Zahlen als auch die Sätze von MoivreLaplace auf den Fall unabhängiger Versuche, wobei die Wahrscheinlichkeit für das Eintreten eines Ereignisses

von der Nummer des Versuchs abhängig ist. In diesem Zusammenhang leitete er auch eine neue Wahrscheinlichkeitsverteilung her, die Poisson-Verteilung.

Ein Aufschwung der Wahrscheinlichkeitsrechnung setzte zu Beginn des 19. Jahrhunderts ein, angeregt vor allem

durch unterschiedliche naturwissenschaftliche Fragestellungen sowie Anwendungen in der Physik. So berechnete

der österreichische Physiker Ludwig Boltzmann (1844-1906) die Wahrscheinlichkeiten der Geschwindigkeiten

von Gasmolekülen. Weiters legte der britische Mathematiker Karl Pearson (1857-1936) den Grundstein für die

mathematische Statistik.

Die Entwicklung ist ab Mitte des 19. Jh. bis fast Ende der zwanziger Jahre des 20. Jh. in bedeutendem

Maße mit den Namen russischer Gelehrter wie Pafnuti L. Tschebyschew (1821-1894), A.A. Markow und A.M.

Ljapunow verknüpft. Vorbereitet wurde dieser Erfolg durch W.J. Bunjakowski, welcher die Untersuchungen über

die Anwendung der Wahrscheinlichkeitsrechnung auf die Statistik, insbesondere auf Versicherungsprobleme und

2

die Bevölkerungsstatistik in Rußland, weitgehend förderte. Er schrieb auch das erste russische Lehrbuch der

Wahrscheinlichkeitsrechnung, das einen großen Einfluß auf die Entwicklung des Interesses an dieser Wissenschaft

in Rußland ausübte.

P.L. Tschebyschew, A.A. Markow und A.M. Ljapunow führten den Begriff der zufälligen Größe ein und verwendeten ihn ausgiebig, worin auch die Hauptbedeutung ihrer Arbeiten besteht. So entstanden zum Beispiel die

"Markowschen Ketten" und der Grenzwertsatz von Ljapunow.

Allerdings gab es bis zum 20. Jahrhundert keine präzise Grundlage für die Wahrscheinlichkeitsrechnung. 1899

erklärte der deutsche Mathematiker David Hilbert (1862-1943) dieses Fehlen einer Grundlage als eines der wichtigsten ungelösten mathematischen Probleme. Ein entscheidende Beitrag war die Entwicklung der Maßtheorie

durch Émile Borel im Jahr 1901, woraus wenig später die Integrationstheorie nach Henri Lebesgue.

Ab 1918 entwickelte der österreichische Mathematiker Richard von Mises eine "statistische Wahrscheinlichkeitstheorie", bei welcher er die Wahrscheinlichkeit als Grenzwert von relativen Häufigkeiten definiert.

In den dreißiger Jahren wurden dann die Grundlagen für die Theorie der stochastischen (zufälligen) Prozesse geschaffen, die heute eine der Hauptforschungsrichtung in der Wahrscheinlichkeitsrechnung ist.bundenes Wachsen

deren Bedeutung.

2

Mathematisierung

(siehe [Montag] und [Galata Scheid])

Das Zufallsexperiment ist ein Vorgang der

• nach bestimmten Vorschriften ausgeführt wird

• beliebig oft wiederholbar ist

• bei dem das Ergebnis vom Zufall abhängt

• bei welchem die Ergebnisse bei mehrfacher Durchführung voneinander unabhängig sind.

Beispiel: Werfen eines Würfels:

Elementarereignis: Jedes Zufallsexperiment besitzt eine Reihe möglicher elementarer Ereignisse mit der Eigenschaft dass immer nur ein bestimmtes Ereignis auftreten kann.

Beispiel: Zufallsexperiment: Werfen eines Würfels (sechs mögliche Elementarereignisse [1. . . ..6])

Ereignisraum: Besitzt ein Zufallsexperiment n mögliche Elementarereignisse, dann bildet die Menge aller Elementarereignisse den Ereignisraum E, dieser kann endlich oder unendlich sein.

Beispiele:

• Werfen eines Würfels E = {1, 2, 3, 4, 5, 6}

• Das einmalige Werfen einer Münze E = {Zahl, Kopf}

• Zweimaliges Werfen einer Münze E = {KK, KZ, ZK, ZZ}

Ergebnis: Teilmenge von des Ergeignissraumes: Würfeln einer geraden Zahl

3

2.1

Klassischer Wahrscheinlichkeitsbegriff - Kombinatorik

Die Wahrscheinlichkeit ist ein Maß, das zur Quantifizierung der Sicherheit bzw. Unsicherheit des Eintretens

eines bestimmten Ereignisses dient, das im Rahmen eines Zufallsexperimentes abläuft. Um

P (E) =

Anzahl der günstigen F älle

Anzahl der möglichen F älle

berechnen zu können braucht muss man die “Anzahl von Fällen” bestimmen.

1. Geordnete Stichproben mit Zurücklegen: Die Objekte sind unterscheidbar (geordnet). Die Anzahl der

Möglichkeiten änderte sich von Wiederholung zu Wiederholung nicht (zurücklegen).

Anzahl der Möglichkeiten für Stichproben vom Umfang k aus einer Menge mit n Elementen :

nk

2. Geordnete Stichproben ohne Zurücklegen: Die Objekte sind unterscheidbar (geordnet). Die Anzahl der

Möglichkeiten änderte sich von Wiederholung zu Wiederholung (kein zurücklegen).

Anzahl der Möglichkeiten für Stichproben vom Umfang k aus einer Menge mit n Elementen :

nk = n · (n − 1) · . . . · (n − k + 1) =

n!

(n − k)!

3. Ungeordnete Stichproben mit Zurücklegen: Die Objekte sind nicht unterscheidbar (ungeordnet). Die Anzahl der Möglichkeiten änderte sich von Wiederholung zu Wiederholung nicht (zurücklegen).

Anzahl der Möglichkeiten für Stichproben vom Umfang k aus einer Menge mit n Elementen :

(n + k − 1)!

n+k−1

=

k

k! (n − 1)!

4. Ungeordnete Stichproben ohne Zurücklegen: Die Objekte sind nicht unterscheidbar (ungeordnet). Die

Anzahl der Möglichkeiten änderte sich von Wiederholung zu Wiederholung (kein zurücklegen).

Anzahl der Möglichkeiten für Stichproben vom Umfang k aus einer Menge mit n Elementen :

n!

n

=

k

k! (n − k)!

2.2

Statistischer Wahrscheinlichkeitsbegriff

Hier betrachtet man die Wahrscheinlichkeit P (A) als den Wert, gegen den die relative Häufigkeit des Ereignisses

A bei unendlich vielen, unabhängigen Wiederholungen des Zufallsexperiments unter identischen Bedingungen

konvergiert.

Sei hn (A) die absolute Häufigkeit des Auftretens von A bei n-maliger Wiederholung des Zufallsexperiments.

Dann ist die relative Häufigkeit von A:

hn (A)

fn (A) =

n

Die Wahrscheinlichkeit von A ist nach dem statistischen Wahrscheinlichkeitsbegriff definiert als:

P (A) = lim fn (A)

n→∞

Wegen 0 ≤ fn (A) ≤ 1 ∀n ∈ N, gilt 0 ≤ P (A) ≤ 1.

Beispiel: Zufallsexperiment: Werfen einer Münze, Konvergenz gegen 1/2

4

2.3

Axiomatischer Wahrscheinlichkeitsbegriff

Als Lösung des von Hilbert formulierten Problems wird heute die 1933 veröffentlichte Wahrscheinlichkeitsdefinition des russischen Mathematikers Andrej N. Kolmogorow (1903-1987) angesehen.

Axiomensystem:

1. Jedem beliebige Ereignis A aus einer Menge von möglichen Ereignissen kann eine positive reelle Zahl als

Wahrscheinlichkeit zugeordnet werden. Nichtnegativtät: 0 ≤ P (A)

2. Das sichere Ereignis hat die Wahrscheinlichkeit 1. Normierung: P (E) = 1

3. Die Wahrscheinlichkeit, dass entweder das eine oder das andere von zwei unabhängigen Ereignissen eintritt,

entspricht der Summe der Wahrscheinlichkeiten der einzelnen Ereignisse. P (A ∪ B) = P (A) + P (B).

2.4

Wahrscheinlichkeitsverteilungen

Unter einer Zufallsvariablen X eines Zufallsexperiments versteht man eine Funktion, die jedem Ereignis Ei der

Ergebnismenge eien Zahl zuordnet: X : Ei → X (Ei )

Ordnet man nun jedem Wert dieser Zufallsvariablen ihre Wahrscheinlichkeit zu, so entsteht eine Wahrscheinlichkeitsverteilung (Wahrscheinlichkeitsfunktion).

Unter einer Wahrscheinlichkeitsverteilung f der Zufallsvariablen X versteht man die Funktion mit f : xi →

P (X = xi ): Der Funktionswert gibt die Wahrscheinlichkeit an, dass X den Wert xi annimmt.

2.4.1

Diskrete Wahrscheinlichkeitsverteilung - Bsp. Binomialverteilung

Die Binomialverteilung (siehe [poisson]) ist eine zweiparametrige, diskrete Verteilung. Sie gibt die Wahrscheinlichkeit für die Anzahl des Auftretens eines Ereignisses bei der mehrmaligen Ausführung eines Zufallsversuchs

mit zwei möglichen Ergebnissen, konstanter Wahrscheinlichkeit und voneinander unabhängigen Ausführungen

an (Bernoulliexperiment).

n

P (X = k) =

pk (1 − p)n−k

k

Die Parameter sind n und p. Der Parameter n gibt die Anzahl der Wiederholungen des Zufallsexperiments an,

p die Wahrscheinlichkeit für das Auftreten eines Ereignisses bei einem einzelnen Versuch.

Die Verteilungsfunktion der Binomialverteilung ist die Summe der Wahrscheinlichkeiten von null bis zum zu

errechnenden Wert.

k X

n

P (X ≤ k) =

pi (1 − p)n−i

i

i=0

Klassisches Beispiel hierfür ist das mehrmalige Werfen einer Münze, oder das Würfeln von Sechsern bei einem

Würfelspiel wird häufig verwendet. Es sind zwei Ereignisse definiert, „Würfeln einer Sechs“ und „Würfeln einer

anderen Zahl“. Die Wahrscheinlichkeit eine Sechs zu würfeln, ist immer p = 1/6, die eine andere Zahl als Sechs

zu würfeln (1-p) = 5/6.

5

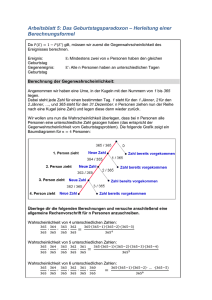

Abbildung 1: Wahrscheinlichkeitsfunktion der Binomialverteilung

2.4.2

Stetige Wahrscheinlichkeitsverteilung - Bsp. Normalverteilung

Eine stetige Zufallsvariable X mit der Wahrscheinlichkeitsdichte f : R → R, gegeben durch

1 x−µ 2

1

f (x) = √ e− 2 ( σ )

σ 2π

heißt N µ, σ 2 -verteilt, normalverteilt mit den Parametern µ (Erwartungswert) und σ 2 (Varianz).

Im Fall µ = 0 und σ 2 = 1 wird diese Verteilung Standardnormalverteilung genannt. Die Dichtefunktion der

Standardnormalverteilung ist

1 2

1

ϕ(x) = √ e− 2 x

2π

Die Verteilungsfunktion der Normalverteilung ist gegeben durch:

1

F (x) = √

σ 2π

2.5

ˆ

x

1

e− 2 (

t−µ 2

σ

) dt

−∞

Maßtheorie, σ-Algebra1

• Das Grundgerüst der maßtheoretischen Wahrscheinlichkeitstheorie bildet der Wahrscheinlichkeitsraum

(Ω, A, P ). Dabei bezeichnet Ω in der Integrationstheorie den Definitionsbereich der zu integrierenden

1

http://de.wikipedia.org/wiki/Geschichte_der_Wahrscheinlichkeitsrechnung

6

Abbildung 2: Normalverteilung

Funktionen. Hier ist es die Menge aller elementaren Ereignisse, von denen nur jeweils genau eines gleichzeitig eintreten kann – etwa die sechs Ausgänge „1”, „2”, . . . , „6” eines Würfelwurfes.

• A ist eine σ-Algebra auf Ω und enthält Teilmengen von Ω, also aus Elementarereignissen zusammengesetzte Ereignisse (beispielsweise das Ereignis, dass der Würfel eine gerade Augenzahl zeigt, also {2, 4,

6}). Dieσ-Algebra muss jedoch nicht alle Teilmengen von Ω enthalten, sondern nur solche, für die eine

sinnvolle Wahrscheinlichkeit definiert werden kann.

• P ist ein Maß, das jedem Ereignis A ∈ A eine Wahrscheinlichkeit P (A) ≥ 0 zuordnet, sodass gewisse

Bedingungen erfüllt sind. Da Maße von Borel ursprünglich geometrisch als Verallgemeinerung von Flächeninhalten motiviert waren, wird beispielsweise gefordert, dass die leere Menge das Maß Null hat, also

P (∅) = 0. In die Sprache der Stochastik übersetzt bedeutet das, dass die Wahrscheinlichkeit, dass keines

der in Ω aufgeführten Ereignisse eintritt, gleich Null ist, Ω das Experiment also vollständig beschreibt. Des

Weiteren wird sinnvollerweise gefordert, dass das Maß (die Fläche) der Vereinigung disjunkter Mengen

gleich der Summe der einzelnen Maße (Flächen) ist. Hier bedeutet das, dass falls zwei Ereignisse nie

gleichzeitig eintreten können (wie eine gerade und eine ungerade Augenzahl im selben Wurf: die Mengen

{1, 3, 5} und {2, 4, 6} sind disjunkt), die Wahrscheinlichkeit dafür, dass eines der beiden auftritt, genau

der Summe der einzelnen Wahrscheinlichkeiten entspricht. Das Gleiche wird auch für abzählbare, aber

nicht für überabzählbare Vereinigungen gefordert. Der einzige Zusatz, der in der Wahrscheinlichkeitstheorie gegenüber der gewöhnlichen Maßtheorie gemacht werden muss, ist die Normierung des gesamten

Raumes auf Wahrscheinlichkeit eins, also P (Ω) = 1.

• Mengen, deren Maß Null ist, werden als Nullmengen bezeichnet, wie etwa eine Gerade in der Ebene, die

keine Fläche hat. In der Wahrscheinlichkeitstheorie sagt man von Nullmengen, dass sie fast sicher nicht

eintreten. Dadurch wird das oben beschriebene Dilemma, dass sich Zufallsexperimente aus lauter unmöglichen Ereignissen zusammensetzen können, aufgelöst. Auch eine Ebene setzt sich aus vielen parallelen

Geraden zusammen, von denen jede die Fläche Null hat. Da aber überabzählbar viele Geraden im Spiel

sind, entsteht kein Widerspruch zu den von P geforderten Eigenschaften. Dadurch kann erstmals klar

zwischen einem Ereignis unterschieden werden, das zwar eintreffen kann, aber Wahrscheinlichkeit Null hat

(das ist eine Nullmenge), und einem solchen, das überhaupt nicht eintreten kann (etwa die Augenzahl

sieben beim Würfelwurf, die nicht in Ω enthalten ist).

7

Abbildung 3: Die Brownsche Bewegung

3

Physikalische Anwendungen

3.1

Brown’sche Bewegung

Beobachtet man sehr kleine Teilchen die in einer Flüssigkeit oder einem Gas schweben, so beobachtet man

Bewegungen deren Richtung und Geschwindigkeit dauernd wechseln. Die Bewegungen sind umso lebhafter je

kleiner die Teilchen sind. Dieses Phänomen wurde vom Botaniker R. Brown (1773 - 1858) entdeckt. Die Energie

der Bewegung kleinster Teilchen ist aber gerade die Wärmeenergie, d.h. dass Wärme als statistisches Phänomen

aufgefasst werden kann. Die Bahn eines Teilchens wechselt die Richtung so oft, dass man nur eine mittlere

Verschiebung des Teilchnes wahrnimmt. A. Einstein definierte 1905 den Wiener Prozess in seiner heutigen

Gestalt. Einsteins Motivation war es, die Bewegung der brownschen Partikel durch die molekulare Struktur des

Wassers zu erklären – ein Ansatz, der damals äußerst kontrovers war, heute aber unbestritten ist – und diese

Erklärung mathematisch zu untermauern. Damit gelang es ihm für kugelförmige Teilchen mit dem Radius r das

mittlere Verschiebungsquadrat

2

hr (t)i =

kT t

3πrη

zu berechnen. Hierbei ist η die Viskosität und T die Temperatur des Fluides.

Ein Stochastischer Prozess ist die mathematische Beschreibung von zeitlich geordneten, zufälligen Vorgängen.

Er ist dann eine Familie von Zufallsvariablen Xt . Ein Wiener-Prozess ist ein zeitstetiger stochastischer Prozess,

der normalverteilte, unabhängige Zuwächse hat. Benannt wurde der Prozess, der auch als Brownsche Bewegung

bekannt ist, nach dem amerikanischen Mathematiker Norbert Wiener.

3.2

Quantenstatistik

(siehe [semibyte], [Fichtner],[Mahler])

• Maxwell-Boltzmann: Beliebig viele unterscheidbare Teilchen in einem Zustand;

• Bose-Einstein: Beliebig viele ununterscheidbare Teilchen in einem Zustand;

• Fermi-Dirac: Maximal eines von ununterscheidbaren Teilchen in einem Zustand.

8

Abbildung 4: Vergleich der mittleren Besetzungszahlen der Statistiken Maxwell-Boltzmann, Bose-Einstein und

Fermi-Dirac

Abbildung 5: Besetzungszahlen eines Fermigases im Grundzustand und für eine angeregte Konfiguration

9

Abbildung 6: Fermi Dirac Verteilung bei verschiedenen Temperaturen

3.2.1

Fermi-Dirac-Statistik

Quantenstatistik für ein aus Fermionen (Elementarteilichen mit halbzahligem Spin, sie unterliegen dem PauliPrinzip) bestehendes im Gleichgewicht befindliches System. Die Energie eines solchen Fermigases berechnet

sich dadurch, dass a man die Einteilchenenergien der einzelnen Fermionen aufaddiert. Anders ausgedrükt: Man

bestimmt die möglichen Einteilchenenergien des Systems und die Besetzungszahl des entsprechenden Einteilchenniveaus.

Mit Hilfe der vollständigen Induktion

über N kann man zeigen, dass die Zahl der Konfigurationen für k Teilchen

N

in N Zuständen den Wert

annimmt. Die Fermi-Verteilung gibt die mittlere Zahl ni der miteinander

k

nichtwechselwirkenden Fermionen im Zustand i mit der mittleren Energie Ei an:

ni =

exp

2s + 1

i Ei −µ

kB T

+1

Diese Besetzungsverteilung beschreibt allgemein die Gleichgewichtsverteilung in einem thermodynamischen System, in dem pro Zustand maximal ein Teilchen untergebracht werden kann, d.h. wo auf feste vorgegebene Plätze

immer nur ein Teilchen untergebracht werden kann.

10

3.2.2

Bose-Einstein-Statistik

Sie beschreibt die statistische Verteilung von nach der Quantenmechanik nichtunterscheidbaren Teilchen mit

ganzzahligem Spin (0, 1, 2, ...), d.h. Bosonen (sie unterliegen nicht dem Pauli-Prinzip). Ein Zustand i darf

von beliebig vielen Teilchen besetzt sein. Die Eigenschaft der Photonen zu den Bosonen zu gehören, ist für das

Laserprinzip von Bedeutung. Es können sich beliebig viele Photonen in ein und dem selben Zustand an ein und

demselben Ort mit identischer Phase befinden. Die Bose-Einstein-Verteilung beschreibt die mittlere Teilchenzahl

ni nicht miteinander in Wechselwirkung stehender Teilchen mit ganzzahligem Spin im Zustand i mit der Energie

Ei .

ni =

exp

2s + 1

i Ei −µ

kB T

−1

wobei: si Spin, ni Teilchenzahl, µ chemisches Potential, Ei Energie des i-ten Zustandes

Phononen: Bose-Einstein-Verteilung gibt die Wahrscheinlichkeitsverteilung n (ω) einen Zustand der Energie ~ω

im thermischen Gleichgewicht bei der Temperatur T zu finden:

1

n (ω, T ) =

exp

~ω

kB T

−1

Ein Phonon ist ein Quasiteilchen, das in der theoretischen Festkörperphysik verwendet wird, um die Eigenschaften der quantenmechanisch beschriebenen Gitterschwingungen in einem Kristall mit Hilfe eines vereinfachten

Modells beschreiben zu können. Phononen sind delokalisiert, das heißt ein Phonon existiert im ganzen Kristallgitter und lässt sich keinem bestimmten Ort zuordnen.

Literatur

[Gurtner]

Markus Gurtner: Bedingte Wahrscheinlichkeiten, Die Lösung des Ziegenproblems. Fachbereichsarbeit aus Mathematik, members.chello.at/gurtner/Fachbereichsarbeit.pdf

[Physikwiki]

https://www.univie.ac.at/physikwiki/index.php/LV013:LV-Uebersicht/WS07_08/

Arbeitsbereiche/Wahrscheinlichkeitsrechnung

[Montag]

Torsten Montag: Statistik III - Wahrscheinlichkeitsrechnung, GRIN Verlag

[Galata Scheid] Robert Galata, Sandro Scheid: Deskriptive und Induktive Statistik für Studierende der BWL,

Carl Hanser Verlag, München

[poisson]

http://www.poissonverteilung.de/binomialverteilung.html, Zugriff am 8.2.2012

[semibyte]

http://www.semibyte.de/wp/physics/atomphysics-qm/grundlagen-quantenmechanik-undstatistik/

[Fichtner]

Manuskript zur Vorlesung Grundlagen der Quantenmechanik und Statistik – basierend auf

Vorlesungen gehalten von H. Fichtner, Fakultät für Physik und Astronomie der Ruhr-Universität

Bochum, Institut für Theoretische Physik Weltraum- und Astrophysik – Bochum 2009

[Mahler]

Skript zur Vorlesung: Thermodynamik und Statistik von Prof. Dr. G. Mahler, Wintersemester

2001 / 2002, Version September 2005

11