Mathematik A für Elektrotechnik/Informationstechnologie T. von der

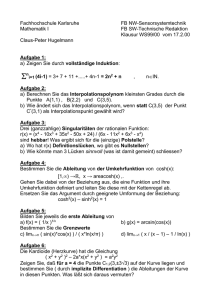

Werbung

Mathematik A für Elektrotechnik/Informationstechnologie

T. von der Twer

Inhaltsverzeichnis

Kapitel 1. Mengen, Zahlenmengen, Abbildungen, Logik, Rechnen

1. Ein wenig Logik

2. Die natürlichen Zahlen, vollständige Induktion bzw. Rekursion

3. Elementare Grundkenntnisse zum Rechnen

1

7

12

13

Kapitel 2. Elementare Vektorrechnung und analytische Geometrie

1. Affiner Raum und Vektorraum

2. Längen und Winkel: Euklidischer Raum

3. Vektorprodukt und Spatprodukt

17

17

29

33

Kapitel 3. Komplexe Zahlen

1. Motivierungen

2. Konstruktion des Körpers (C, +, ·, 0, 1)

3. Beispiele zum kartesischen Rechnen mit komplexen Zahlen

4. Polarkoordinatendarstellung komplexer Zahlen

39

39

39

42

44

Kapitel 4. Reelle Funktionen

1. Besondere Eigenschaften reeller Funktionen

2. Die Grundfunktionen

3. Zusammensetzung von Funktionen

4. Grenzwert bei Funktionen und Stetigkeit

5. Ableitung reeller Funktionen (eindimensionaler Fall)

6. Grundlegende Resultate im Zusammenhang mit Ableitungen

7. Das eindimensionale Integral

47

48

50

54

60

67

74

80

Kapitel 5. Lineare Algebra

1.

2.

3.

4.

5.

6.

7.

8.

9.

10.

11.

103

Die Struktur endlichdimensionaler Vektorräume

Lineare Abbildungen

Matrixdarstellung einer linearen Abbildung

Verknüpfungen von linearen Abbildungen und Matrizen

Transformation von Matrizen (Basiswechsel)

Anwendungen des Rechnens mit Matrizen

Räume mit Skalarprodukt und Isometrien

Determinanten

Eigenwerte und Eigenvektoren; Diagonalisierung

Symmetrische Bilinearformen, deren Diagonalisierbarkeit, Klassifikation von Quadriken

Der Satz von Sylvester

iii

103

107

112

115

119

121

124

128

139

143

154

KAPITEL 1

Mengen, Zahlenmengen, Abbildungen, Logik, Rechnen

Von welchen Gegenständen, ’Dingen’, ’Objekten’handelt die Mathematik? Wir wollen diese Frage

nicht zu tief angehen, sondern praktisch danach fragen, welche mathematischen Objekte man kennen

sollte, um Mathematik in√einer Ingenieurwissenschaft anwenden zu können. Da sind einmal die Zahlen

wie 1, 2, aber auch −2, 13 , 2, e, π, schließlich j (die komplexe Zahl mit der Eigenschaft j 2 = 1. Wichtig ist

es nun, die Zahlen nicht nur einzeln zu haben, sondern in ihren jeweiligen Gesamtheiten zu sehen. Dann

sind wir bei den Zahlenmengen. Sie bilden nur Beispiele für Mengen, man braucht weitere, etwa Mengen

von Punkten in einem geometrischen Raum, Mengen von Funktionen. Wir werden sogleich sehen, dass

Mengen wie die der reellen Zahlen nicht interessant sind als Mengen, sondern erst mit ihren Operationen

(Verknüpfungen) wie +, ·. So etwas nennt man eine Struktur. Mathematik handelt also wesentlich von

Strukturen. Das reicht noch nicht, sondern man braucht noch Abbildungen zwischen Strukturen.

Im folgenden Abschnitt werden alle grundlegenden Objekte eingeführt, mittels deren man alles Weitere beliebig Komplizierte zusammensetzen kann. Zugehörige Grundbegriffe und Bezeichnungen müssen

sorgfältig gelernt werden; denn deren Verfügbarkeit entscheidet darüber, ob man einen Text (nicht nur in

mathematischen Werken, sondern auch natur- und ingenieurwissenschaftlichen) versteht oder eigenständig Probleme zu lösen vermag.

0.1. Mengen, Teilmengen und Mengenoperationen. Wir benötigen folgendes Wissen über

Mengen: Zunächst das elementare Verständnis, dass eine Menge beliebige wohlunterschiedene Objekte

als Elemente umfasst und dass für eine Menge A stets eindeutig feststeht, ob ein beliebiges Objekt x zu

A gehört oder nicht, Element von A ist oder nicht. Symbolisch:

x ∈ A für: x ist Element von A

x ∈

/ A für: x ist nicht Element von A.

Man hat folgende beiden wichtigen Arten, eine Menge festzulegen:

{x1 , ..., xn } ist die Menge, deren Elemente genau die Objekte x1 , ..., xn sind.

{ x ∈ A| x hat die Eigenschaft E} ist die Menge aller Objekte aus der Menge A,

welche die Eigenschaft E haben. Auch in der Version, dass keine ’Grundmenge’ A

vorgegeben ist.

Beispiele: 1 ∈ {1, 2, 3} , 4 ∈

/ {1, 2, 3} , 2 ∈ { x| x ist ganze Zahl und x ist durch 4 teilbar} . Insbesondere

hat man die leere Menge ∅ := {} , welche gar kein Element enthält.

Für zwei Mengen A, B definiert man die Teilmengenbeziehung so:

A ⊂ B (lies: ’A ist Teilmenge von B’) : ⇐⇒ für alle x gilt: (wenn x ∈ A, dann x ∈ B) .

Dabei haben wir ein wenig mathematische Notation benutzt: Das Zeichen ⇐⇒ zwischen zwei Aussagen

bedeutet, dass diese Aussagen gleichwertig sind, also aus der einen immer auf die jeweils andere geschlossen

werden kann. Der Doppelpunkt bedeutet, dass diese Gleichwertigkeit definitorisch festgelegt wird (die

Teilmengenbeziehung, symbolisch ⊂, wird oben erst definiert).

Zwei Mengen sind nach Definition genau dann gleich, wenn sie dieselben Elemente haben, das heißt

A = B : ⇐⇒ (A ⊂ B und B ⊂ A) .

Beispiele: {2} = Menge aller geraden Primzahlen. Die leere Menge ist Teilmenge von jeder Menge. In

der Menge der reellen Zahlen interessieren vielfach Teilmengen gewisser Form, die man Intervalle nennt:

Für reelle Zahlen a ≤ b definiert man: [a, b] := { x ∈ R| a ≤ x ≤ b} (’abgeschlossenes Intervall’) und

1

2

1. M ENGEN, ZAHLENM ENGEN, ABBILDUNGEN, LOGIK, RECHNEN

(a, b) := { x ∈ R| a < x < b} (’offenes Intervall’). Es sollte nun klar sein, wie [a, b) und (a, b] zu verstehen

sind.

Man hat folgende wichtigen Operationen, die aus Mengen neue Mengen machen - die Doppelpunkte

bei den Gleichheitszeichen bedeuten definitorische Gleichheit:

A∩B

A∪B

A\B

A×B

:

:

:

:

An

:

Mengenoperationen

= { x| x ∈ A und x ∈ B} (Durchschnitt, A geschnitten mit B)

= { x| x ∈ A oder x ∈ B} (Vereinigung, A vereinigt mit B)

= { x| x ∈ A und x ∈

/ B} (Mengendifferenz, A minus B)

= { (x, y)| x ∈ A und y ∈ B} (kartesisches Produkt, A Kreuz B),

dabei bezeichnet (x, y) das geordnete Paar der Objekte x, y.

= { (x1 , ..., xn )| für alle i mit 1 ≤ i ≤ n gilt xi ∈ A} (mehrfaches

kartesisches Produkt der Menge A mit sich selbst, die Elemente sind

die Folgen der Länge n (n eine natürliche Zahl, im interessanten Fall

größer als 1) von Objekten aus A.

0.2. Die wichtigen Zahlenmengen, und der Körperbegriff.

N : = {1, 2, 3, ...} Menge der natürlichen Zahlen

N0 : = {0, 1, 2, 3, ...}

Z : = {..., −3, −2, −1, 0, 1, 2, 3, ...} Menge der ganzen Zahlen

m

Q : =

m, n ∈ Z, n = 0 Menge der rationalen Zahlen

n

R : = Menge aller reellen Zahlen

C : = { a + jb| a, b ∈ R} (Menge aller komplexen Zahlen)

Dabei wurden alle außer R wenigstens einigermaßen definiert, hier wurde nur das Symbol erklärt. Grundlegendes zu N folgt im Abschnitt 3 dieses Kapitels, Genaueres zu C in Kapitel 4. Tatsächlich ist es sehr

schwierig, die Menge der reellen Zahlen zu definieren. Was man als Anwender wissen darüber wissen

sollte, wird hier kurz zusammengestellt:

√

Zunächst einmal stellt man fest, dass Q ’Löcher’ hat, z.B. ist 2 ein Punkt des Zahlenkontinuums,

der Zahlengeraden, aber keine rationale Zahl. R hat nun gerade den Sinn, die rationalen Zahlen zur

vollständigen Zahlengerade zu erweitern, dass es überhaupt keine Löcher mehr gibt. Insgesamt hat man

Folgendes:

1.) Man kann mit +, ·, 0, 1 rechnen wie in Q, man sagt, (R, +, ·, 0, 1, <) bildet einen angeordneten

Körper, und das bedeutet im Einzelnen:

a) Es gelten folgende Axiome (Grundforderungen) für die Addition, mit denen (R, +, 0) eine abelsche

Gruppe wird (d.h. kommutative Gruppe), und zwar allgemein für alle Zahlen x, y, z ∈ R:

(x + y) + z

0+x

−x + x

x+y

=

=

=

=

x + (y + z) (Assoziativgesetz)

x (neutrales Element)

0 (inverses Element − x für jedes x)

y + x (Kommutativgesetz)

b) Es gelten ferner folgende Axiome für die Multiplikation, mit denen (R \ {0}, ·, 1) ebenfalls eine

kommutative Gruppe wird (man beachte: Damit ist bereits ausgesprochen, dass 0 = 1 sein muss, weil

1 ∈ R \ {0}), allerdings ist die Multiplikation auch mit der Zahl Null ausführbar, d.h. für alle Zahlen

1. M ENGEN, ZAHLENM ENGEN, ABBILDUNGEN, LOGIK, RECHNEN

3

x, y, z ∈ R gilt:

x (yz)

1·x

x−1 x

xy

=

=

=

=

(xy) z

x

1 für x = 0

yx

Hinweis: Für x−1 schreibt man bei den Zahlen im allgemeinen x1 (x nicht Null!).

c) Ferner gilt folgendes wichtige Distributivgesetz, dass Addition und Multiplikation verbindet:

x (y + z) = xy + xz.

d) Die Ordnungsbeziehung hat folgende axiomatischen Eigenschaften:

nicht x <

wenn x <

x >

Mit P :

P +P ⊂

Wichtige Folgerungen sind:

x

y und y < z, so x < z (Transitivität)

0 oder x = 0 oder x < 0 (genau einer der Fälle tritt ein)

= { x ∈ R| x > 0} (Menge der positiven Zahlen) gilt:

P und P · P ⊂ P (d.h.: x, y ∈ P , dann xy ∈ P , analog für · ).

Wenn x < y, so x + c < y + c, für alle x, y, c.

Wenn x < y und c > 0, so xc < yc.

Die Beziehung ≤ (kleiner oder gleich) wird so definiert: x ≤ y : ⇐⇒ x < 0 oder x = y. Sie hat analoge

Eigenschaften, natürlich stets x ≤ x im Unterschied zu <.

e) Nun die Vollständigkeitseigenschaft der reellen Zahlen (alles Vorige gilt auch für (Q, +, ·, 0, 1)!),

zusammen mit der archimedischen Eigenschaft:

Eine Menge A ⊂ R heißt nach oben beschränkt, wenn es eine Zahl M ∈ R gibt, so dass x ≤ M für

alle x ∈ A. Vollständigkeitseigenschaft: Jede nach oben beschränkte nicht leere Menge A ⊂ R hat

eine kleinste obere Schranke α ∈ R, so dass x ≤ α für alle x ∈ A, aber für alle β < α gibt es noch

mindestens eine Zahl x ∈ A, so dass x > β.

Die archimedische Eigenschaft lautet: Zu jeder reellen Zahl x gibt es eine natürliche Zahl n > x.

Wichtige Folgerungen: Eine nichtleere nach unten beschränkte Menge reeller Zahlen hat stets eine

größte untere Schranke. Zu jeder reellen Zahl x > 0 gibt es eine natürliche Zahl n mit n1 < x. Zum

Verhältnis der rellen zu den rationalen Zahlen hat man: Zwischen zwei verschiedenen reellen Zahlen gibt

es stets eine rationale, und vor allem: Jede reelle Zahl kann mit einem beliebig kleinen Fehler durch eine

rationale Zahl angenähert werden.

0.3. Terme (Rechenausdrücke) für reelle Zahlen, und Gleichungen. Mit den Operationen

+, ·, .. und Konstanten wie 0, 1, e, π sowie Variablen x, y, x1 ,... bildet man beliebig zusammengesetzte

Rechenausdrücke oder Terme. Dabei hat man auf notwendige Klammern und Klammerersparnisregeln

zu achten. Beispiel: (x + e) (1 + y) 1+x

y+z . Es kommt noch mehr hinzu, wenn man Potenzen bildet und

Funktionssymbole benutzt, Beispiel: sin (1 + xn ) . (Zu den Funktionen vgl. den nächsten Abschnitt.) Was

tut man mit solchen Rechenausdrücken, und welche Rolle spielen die Buchstaben dabei?

1.) Man setzt in einen Rechenausdruck für die Buchstaben, die keine Konstanten (Eigennamen wie

e, π) sind, Zahlen ein und wertet den Rechenausdruck aus. (Dies ist geläufig, aber es wäre ganz falsch,

die Mathematik für Anwender darin erschöpft zu sehen - das ist vielmehr noch fast gar nichts!)

2.) Man formt gemäß den oben formulierten Gesetzen und weiteren Folgerungen daraus Rechenausdrücke gleichwertig um, so dass

man

Zwecke günstigere Form erhält.

eine für die 2angestrebten praktischen

x−1

2

Beispielsweise f (x) = 2 − 13 x + 4 + 15 x = − 15

x − 2. Oder x(1+x)

= − x1 + 1+x

. Oder x2 − 3x + 1 =

2

x − 32 − 54 .

3.) Man hat eine allgemeingültige Gleichung t2 (x, y, ...) = t2 (x, y, ...) zwischen zwei Termen t1 und

t2 und setzt für die freien Variablen x, y, ... beliebige Rechenausdrücke ein, um eine neue allgemeingültige

Gleichung zu erhalten. Beispiel: in x (y + z) = xy + yz setzt man für x ein: x + y, für y: x, für z:

y und erhält: (x + y) (x + y) = (x + y) x + (x + y) y. Gleichwertiges Umformen mit Kommutativgesetz

4

1. M ENGEN, ZAHLENM ENGEN, ABBILDUNGEN, LOGIK, RECHNEN

2

und Distributivgesetz sowie Anwendung des Assoziativgesetzes führt dann zu (x + y) = x2 + 2xy + y 2 .

(Genaueres zum Einsetzen im Abschnitt ’Ein wenig Logik’.)

hat

(nicht allgemeingültig!) wie etwa x2 + x − 1 = 0, Solution is:

√ eine

√ 4.) Man

Bestimmungsgleichung

1

1

1

1

x = − 2 + 2 5 , x = − 2 − 2 5 und löst diese Gleichung unter Verwendung gleichwertiger Umformungen oder auch einer fertigen Formel. Man sucht hier eine einfache Beschreibung der Erfüllungsmenge

dieser Gleichung, wobei man den Zahlenbereich festlegen muss, in dem man Lösungen sucht. Im Beispiel

etwa:

1 1√

1 1√

x ∈ R| x2 + x − 1 = 0 = − −

5, − +

5 .

2 2

2 2

√

2

Natürlich sagt man lieber: Die einzigen reellen Lösungen von x + x − 1 = 0 sind x1,2 = − 12 ± 12 5.

5.) Bestimmungsgleichung mit äußeren Parametern:

x2 +px+q = 0 ist die Normalform der quadratischen Gleichung. Darin ist die Variable x Unbestimmte, die Variablen p, q dagegen spielen eine ganz andere Rolle, sie sind äußere Parameter, d.h. man stellt

sich vor, ihre Werte seien in beliebiger Weise ’von außen’ fixiert.

Die angestrebte Lösung gibt eine Lö p 2

2

− q, was im Falle p2 − q > 0

sungsformel für beliebige Werte von p, q. Man hat x1,2 = − p2 ±

2

2

zwei verschiedene reelle Lösungen der Gleichung ergibt, im Falle p2 − q = 0 nur die einzige reelle Lö 2

sung x = − p2 , im verbleibenden Fall p2 − q < 0 überhaupt keine reelle Lösung. Daran sollte man sich

gewöhnen: Lösen eines Problems mit äußeren Parametern bedeutet: Beim Rechnen werden die äußeren

Parameter einfach wie Konstanten der Art e, π ’durchgezogen’, aber bei gewissen Rechenoperationen

stößt man gewöhnlich auf Fallunterscheidungen.

Der zweckmäßige Umgang mit Rechenausdrücken fordert stets das Wahrnehmen des ’Typs’ eines

vorliegenden Rechenausdrucks. Parallel zu den Rechenausdrücken typisiert man die Gleichungen. Liegt

ein einfacher Typ vor, so kann man an dazu bekannte Verfahren anknüpfen. Liegt ein schwieriger Typ

vor, so wird man nicht naiv einfache Lösungen eines Problems erwarten. Folgende grobe Einteilung sollte

man kennen:

Typen von Rechenausdrücken für reelle Zahlen

Lineare Ausdrücke in x sind ax + b (man unterscheidet noch ’linear im engeren Sinne’,

dann muss b Null sein, und ’affin’ mit beliebiger Konstanten b

Lineare Ausdrücke in x1 , ..., xn sind a1 x1 + ... + an xn + b (wieder mit der feineren Unterscheidung)

Ein Polynom in x ist ein Ausdruck a0 + a1 x + ... + an xn .

p (x)

Ein gebrochen rationaler Ausdruck in x ist

, mit Polynomen p, q (q nicht die Konstante 0)

q (x)

Algebraische Ausdrücke sind solche, bei denen auch zusätzlich gebrochene Exponenten auftreten.

Transzendente Ausdrücke sind solche, bei denen transzendente Funktionen wie sin, ln auftreten.

Man sollte wissen: Nur lineare Gleichungen und lineare Gleichungssysteme sowie quadratische Gleichungen kann man einfach lösen. Hinzu kommt das Lösen von einfachsten Gleichungen unter Benutzung von

Umkehrfunktionen, vgl. dazu den nächsten Abschnitt. Die Methoden für kompliziertere Gleichungen sind

völlig anderer Art - fast immer sucht man dann mit den Mitteln der Analysis Näherungslösungen. Übrigens gibt es lediglich für Polynomgleichungen bis zum 4. Grad noch Lösungsformeln, darüber hinaus

kann man beweisen, dass es solche Formeln gar nicht geben kann! Später erst werden wir in der Lage sein,

so etwas wie sin(x) mit einem Rechenausdruck zu erfassen, der eine Verallgemeinerung eines Polynoms

darstellt.

Zum Grundwissen gehört ferner, dass man ein Polynom wie 2− x2 + 1 x3 − x + 1 in die geordnete

Standardform schnell überführen kann. (’Ordnen nach Potenzen von x’, Zusammenfassen der Koeffizienten (Vorfaktoren für die Potenzen) im Kopf!). Im Beispiel lautet die Endform: 1 + x − x2 − x5 . Man sollte

stets solche Endformen als Gestalten im Kopf haben und bei einem vorliegenden Ausdruck wahrnehmen,

dass man eine solche Endform erreichen kann.

Eine Bemerkung zu Rechenausdrücken und Gleichungen: Man achte stets darauf, ob man

einen Rechenausdruck bearbeitet oder eine Gleichung. Rechenausdrücke formt man um, Gleichungen

2x

auch, aber aus 2x

3 kann man nicht gleichwertig 2x machen, wohl aber aus der Gleichung 3 = 3 die

gleichwertige Gleichung 2x = 9. Gleichwertigkeit von Termen t1 , t2 bedeutet die Allgemeingültigkeit der

1. M ENGEN, ZAHLENM ENGEN, ABBILDUNGEN, LOGIK, RECHNEN

5

Gleichung t1 = t2 . Gleichwertigkeit von zwei Gleichungen t1 = t2 , u1 = u2 bedeutet dagegen, dass folgende

Aussage allgemeingültig ist: t1 = t2 ⇐⇒ u1 = u2 . Der Doppelpfeil bedeutet ’genau dann, wenn’, also

’wenn..., dann...’ in beiden Richtungen. Vorsicht: Oft wird von Anfängern aus x2 = y 2 gefolgert: x = y.

Das ist falsch, wenn die Zahlen nicht als positive vorauszusetzen sind. Man hat nur: x = y =⇒ x2 = y 2 ,

nicht die umgekehrte Richtung. Sondern: x2 = y 2 ⇐⇒ x = y oder x = −y.

Niemals schreibe man =⇒ , ⇐⇒ zwischen Rechenausdrücke - sie gehören nur zwischen Aussagen,

um eine neue Aussage zu formen.

Man geht ’schrittweise’ vor. Das sollte aber nicht dazu führen, dass man etwa in einem Rechenausdruck nur einen Teilausdruck gleichwertig ersetzen will und eine falsche Gleichung schreibt, die ’den Rest

vergisst’. Wenn nötig, führe man eine Nebenrechnung auf.

Eine Bemerkung zur Verallgemeinerung des Begriffs ’Rechenausdruck’ auf beliebige

Strukturen: Die Teilmengen einer Grundmenge G bilden mit den Verknüpfungen ∪, ∩ ebenfalls eine

Struktur, und man bildet Terme wie A ∩ (B ∪ C) usw., genau wie bei den Zahlen, nur stehen die Buchstaben für Mengen, und an die Stelle der Zahlenoperationen wie +, · treten die Mengenoperationen ∪, ∩.

Später werden wir Vektorräume haben und bilden Terme von Vektoren.

0.4. Abbildungen und Funktionen. Man ordnet Zahlen andere Zahlen eindeutig zu, etwa jeder

reellen Zahl ihr Quadrat. Das ist wieder eine reelle Zahl. Das Ganze fasst man symbolisch so zusammen:

f: R → R

x → x2

Die erste Zeile liest man: ’f geht von R nach R’, das meint: Jeder reellen Zahl x ∈ R wird durch f eine

reelle Zahl (eindeutig!) zugeordnet. Die zweite Zeile (sie die Zuordnungsvorschrift) liest man: ’Der Zahl

x wird ihr Quadrat x2 zugeordnet’, und dies Resultat nennt man auch f(x), was man liest: ’f von x’.

Das ist eine ’von’-Klammer, die man stets laut so lesen sollte. Verwechslung mit einer Multiplikation ist

fatal und unterläuft Anfängern häufig. Manchmal ist es selbstverständlich, dass man von reellen Zahlen

redet, dann formuliert man gern kürzer ’die Funktion f(x) = x2 ’ oder noch kürzer ’die Funktion x2 ’.

Man denke aber stets an die eindeutige Zuordnung x → x2 . Bei Funktionen wird in starkem Maße

wieder die Grundtechnik des Einsetzens wichtig: Im Beispiel f (x) = x2 (die Gleichung ist definitorisch

allgemeingültig für den jeweiligen Zusammenhang, gilt also für alle x) hat man etwa f (x + y) = (x + y)2

(um das Eingesetzte muss man Klammern setzen!). ’f von ...’ zu bilden, bedeutet, in den Rechenausdruck

für f einzusetzen, nicht etwa mit ihm zu multiplizieren!

Hinweis zu einer etwas altväterlichen, aber immer noch nützlichen Sprechweise: Bei einer Funktion

f(x) nennt man gern x die unabhängige Variable und f(x) die abhängige.

Den Zuordnungsbegriff formuliert man nun ganz allgemein so: Seien A und B Mengen, und a → f (a)

gebe eine eindeutige Vorschrift, nach der jedem Element a ∈ A genau ein Element f(a) ∈ B zugeordnet

wird, dann ist f eine Abblidung von A nach B. Symbolisch:

f: A →

B

.

a → f(a)

Das lohnt sich in dieser Allgemeinheit, z.B. Ist + : R2 → R eine Abbildung, die jedem Paar (x, y) von

reellen Zahlen eindeutig die Summe x + y zuordnet. Ebenso ist ∩ eine Abbildung, die jedem Paar von

Teilmengen einer vorgegebenen Grundmenge wieder eine solche Teilmenge zuordnet. Eine Spiegelung

an einer Ebene im dreidimensionalen Raum ordnet jedem Punkt des Raumes seinen Spiegelungspunkt

(bezüglich der vorgegebenen Ebene) zu. Oder: Sie schalten Widerstände der Werte R1 , ..., Rn zusammen

und ordnen jeder Folge (R1 , ..., Rn ) positiver Zahlen den Gesamtwiderstand der Schaltung zu, der sich

eindeutig aus den vorgegebenen Widerständen errechnet.

Zur vollständigen Angabe einer Abbildung gehören drei Dinge: Definitionsbereich (im Schema: A),

Wertebereich (oder Zielmenge) (im Schema: B) und Zuordnungsvorschrift. Oftmals ergeben verschiedene

Vorschriften dieselben Resultate. Wenn das der Fall ist, so handelt es sich um ein und dieselbe Abbildung.

Beispiel: sin(x) oder cos (x − π/2) . Wenn es bei A, B um Mengen von Zahlen oder endlichen Zahlenfolgen

handelt, sagt man gern ’Funktion’ statt ’Abbildung’, ansonsten sind die Begriffe gleich.

Es gibt ein paar stets interessierende Eigenschaften bei Abbildungen, die wir nunmehr definieren:

Eine Abbildung f : A → B heißt injektiv (genau) dann, wenn für alle a1 , a2 ∈ A gilt: f (a1 ) =

f (a2 ) =⇒ a1 = a2 . (Man verwechsle das nicht mit der Eindeutigkeit, die man definitorisch für jede

6

1. M ENGEN, ZAHLENM ENGEN, ABBILDUNGEN, LOGIK, RECHNEN

Abbildung verlangt, die sieht formal so aus: Für alle a1 , a2 ∈ A gilt: a1 = a2 =⇒ f(a1 ) = f (a2 ) .

Man beachte stets, dass man =⇒ nicht ohne weiteres herumdrehen darf. Zum Beispiel gilt für die oben

erwähnte Quadratfunktion f : R → R, f(x) = x2 die letztere Eigenschaft, aber sie ist nicht injektiv, da

etwa f (2) = f(−2) = 4.

Eine Abbildung f : A → B heißt surjektiv (genau) dann, wenn für alle b ∈ B mindestens ein a ∈ A

gibt, so dass f (a) = b ist. Zum Beispiel ist f : R → R, f(x) = x2 auch nicht surjektiv, weil etwa b = −2

niemals als Quadrat einer reellen Zahl herauskommt.

Eine Abbildung f : A → B heißt bijektiv (genau) dann, wenn f injektiv und surjektiv ist. Zum

Beispiel ist die Funktion f : R → R, f(x) = x3 bijektiv.

Man versteht diese Eigenschaften leichter in dieser Form: Injektivität einer Funktion f : A → B

bedeutet, dass eine Gleichung f (a) = b für jedes b ∈ B höchstens eine Lösung a hat. Surjektivität: Die

Gleichung hat für jedes b ∈ B mindestens eine Lösung, Bijektivität: ’genau eine Lösung’.

Wenn eine Abbildung f : A → B bijektiv ist - und nur dann, existiert eindeutig die zugehörige

Umkehrfunktion f −1 (man denke nicht an f1 , das ist eine Gefahr bei dieser Notation), die man dann

völlig allgemein so defnieren kann: f −1 : B → A, b → das eindeutig bestimmte a ∈ A, so dass f (a) = b.

Beispiele: f : R≥0 → R≥0 (Menge der reellen Zahlen ≥ 0 jeweils), f (x) = x2 ist bijektiv (das macht man

oft so, dass man Definitionsbereich und Wertebereich geeignet einschränkt, eine bijektive

Abbildung zu

√

erhalten). Die Umkehrfunktion ist die Wurzelfunktion f −1 : R≥0 → R≥0 , f −1 (x) = x. Ebenso:

sin : [− π2 , π2 ] → [−1, 1]

x

→ sin (x)

ist bijektiv, die Umkehrfunktion heißt arcsin (Arkussinus).

Man merke sich: Ist f : A → B umkehrbar, so hat man f −1 f (a) = a und f f −1 (b) = b für alle

a ∈ A, b ∈ B.

Es sei f : A → B. Dann bildet man für C ⊂ A und D ⊂ B:

f

f (C) : = { f (a)| a ∈ C} , speziell Bild (f ) := f (A) , ferner

−1

(D) : = { a ∈ A| f(a) ∈ D} .

Man nennt f(C) auch ’Bild von C’ und f −1 (D) ’Urbild von D’. Speziell heißt f (A) das Bild der Abbildung f und wird gern bezeichnet mit Bild (f ). Der Wertebereich B ist im allgemeinen größer als Bild(f ) .

Beide Mengen fallen genau dann zusammen, wenn f surjektiv ist. Achtung: für die Bildung f −1 (D) muss

nicht etwa die Umkehrfunktion von f existieren! Beispiel: Für tan: R → R (nicht umkehrbar!) hat man

tan−1 ({0}) = { kπ| k ∈ Z} .

Umkehrfunktionen anzuwenden bedeutet ein wichtiges Mittel zum Auflösen von häufig auftretenden

Gleichungen, etwa löst man die Gleichung 3ex−2 = 5 durch Anwenden der Logarithmusfunktion auf

beiden Seiten, das ergibt ln (3) + x − 2 = ln (5) , also eindeutig x = 2+ln(5)

ln(3) . Man beachte jedoch, dass z.B.

1

die Gleichung sin (x) = 2 nicht eindeutig zu lösen ist. Anwendung der Umkehrfunktion arcsin ergibt nur

die Lösung im Bereich [− π2 , π2 ], das ist π/6. Symmetrisch zu π/2 liegt eine zweite Lösung der Gleichung,

also π/2 + (π/2 − π/6) = 56 π. Alle weiteren Lösungen der Gleichung erhält man durch Addieren von kπ

mit ganzen Zahlen k.

Scharen von Funktionen: Oft hat man im Rechenausdruck für eine Funktion noch einen äußeren

Parameter, etwa f(t) = sin (ωt) . t ist die unabhängige Variable, ω äußerer Parameter. Dann kann man

an eine bestimmte Funktion denken, mit irgendwie fixiertem Wert ω > 0. (Damit wird dann wieder

wie mit einer Konstanten gerechnet, s.o.) Man kann aber auch daran denken, dass man alle Funktionen

fω (t) = sin (ωt) als Schar von Funktionen auf einmal anschaut, für alle Zahlen ω > 0. Man wird dann etwa

zur Veranschaulichung die Graphen einiger Exemplare aufzeichnen und an die Kurven den zugehörigen

Wert von ω schreiben.

0.5. Endliche und unendliche Folgen. Eine endliche Folge von Objekten a1 , ..., an ∈ A notiert

man (a1 , ..., an ) oder auch (ai )1≤i≤n . Genau lässt sie sich verstehen als Abbildung f : {1, ..., n} → A,

mit f (i) = ai für 1 ≤ i ≤ n. Es kommt also auf die Reihenfolge an, und die Schreibweise (a1 , ..., an )

gibt einfach die Bildfolge zu (1, ..., n) . Insbesondere werden für uns die endlichen Folgen reeller Zahlen

wichtig, das sind Koordinatendarstellungen von Vektoren. Vektoren spielen in Physik und speziell in der

Elektrizitätslehre eine tragende Rolle.

1. EIN W ENIG LOGIK

7

Für die Analysis (Lehre von den reellen Funktionen) und bereits für das Verständnis der rellen Zahlen

selbst benötigt man unendliche Folgen reeller Zahlen. Man schreibt sie: (an )n∈N oder auch kürzer (an )n .

(Es könnte auch N0 heißen.) Ausgeschrieben also a1 , a2 , ... und so immer fort. Dabei ist an ∈ R für alle

n ∈ N. Wichtig zu verstehen ist: an ist nur das n− te Folgenglied, also eine Zahl. Aber (an )n ist die

gesamte Folge. Wie schon die endlichen Folgen können wir auch die unendlichen wieder als Abbildungen

verstehen: Es liegt einfach eine Abbildung f : N → R vor, mit f(n) = an für alle natürlichen Zahlen.

Wir wollen einen Grund dafür angeben, warum Folgen wichtig sind: Wie bereits erwähnt, kann man viele

reelle Zahlen wie e nur durch einen Bruch oder eine endliche Dezimalzahl nähern. Das möchte man aber

mit beliebiger Genauigkeit tun. Die Lösung des Problems: Man gibt eine unendliche Folge von Zahlen an,

welche die gewünschte Zahl so gut nähern, wie man möchte.

Folge sollte die’schwierige’

Die angegebene

1

1

1

reelle Zahl dann als Grenzwert haben. Beispiel: die Folge 1 + 11 + 1·2

+ 1·2·3

+ ... + 1·2·...·n

hat e als

n

Grenzwert. Aussagen über die verbleibenden Fehler stellt die Mathematik dann bereit.

Später werden auch Folgen von Funktionen wichtig. also (fn )n , wobei fn jeweils eine Funktion ist. Der

praktische Sinn erklärt sich wie bei den Zahlenfolgen: Es soll der Funktionswert einer schwierigen Funktion

f an beliebiger Stelle

für x als Grenzwert

einer Zahlenfolge angegeben werden. Beispiel: ex

x allgemein

x

x

x

x

als Grenzwert von 1 + x + 1·2 + ... + 1·2·...·n n . Hier wäre f(x) = ex , fn (x) = 1 + x + 1·2

+ ... + 1·2·...·n

.

0.6. Ein Überblick über die benötigten mathematischen Objekte. Man braucht sich nicht

vor einem unübersehbaren Zoo mathematischer Objekte zu fürchten: Aus den bereits angeführten kann

man alles Weitere machen. Wenn es sehr kompliziert wird, dan liegt vielleicht eine Abbildung vor, deren Definitionsbereich und Wertebereich beide Funktionenmengen sind. Das nennt man dann auch einen

Operator, und ein solcher ist Ihnen bereits aus der Schule bekannt: die Ableitung - sie macht aus einer

Funktion eine neue Funktion. Ähnlich das bestimmte Integral: Es macht aus einer Funktion eine Zahl.

Vielmehr sollte man darauf achten, dass man versteht, welche naturwissenschaftlichen Gegenstände mit

welchen mathematischen so gut beschrieben werden können, dass man sie geradezu identifiziert: Etwa

elektrostatische Felder und Abbildungen, welche jedem Raumpunkt einen Vektor zuordnen (den Feldvektor an dieser Stelle). Man nennt sie Vektorfelder. (Ein Vektorfeld auf einer Ebene sieht also ähnlich wie

eine Wiese aus, nur hat man sich die Grashalme völlig gerade vorzustellen.)

1. Ein wenig Logik

In der Mathematik geht man nicht nur mit Rechenausdrücken um, sondern vor allem auch mit

Gleichungen und allgemeiner mit Aussagen. Grundsätzlich ist es wichtig, den Unterschied zwischen der

bloßen Benennung eines Objekts und der Behauptung einer Aussage zu beachten. Auch eine Aussage hat

man oft als ein Objekt zu betrachten, das man erst einmal fixiert, um dann etwa zu untersuchen, ob diese

Aussage wahr ist oder ob sie auch anderen Aussagen folgt. Wie bildet man mathematische Aussagen?

Welche Typen sind besonders wichtig, und welche logischen

Regeln gibt es dafür?

Elementare Aussagen sehen so aus: 2 ≥ 3, sin π2 = 1, 6Z ⊂ 3Z. Von diesen Aussagen sind die beiden

letzten offenbar wahr, die erste ist falsch.

Nun bildet man aus elementaren Aussagen zusammengesetzte, das geschieht einmal mit Partikeln

wie ’und’, ’oder’, ’nicht’, ’wenn...,so,...’, zum anderen mit den Quantifikatoren ’für alle...’, ’es gibt...’.

1.1. Minimale Logik und zugehörige Notation. Unter einer Aussageform versteht man etwas

wie eine Aussage, das aber zusätzlich freie Variablen enthalten kann. Beispiel: 2 < 3 ist eine Aussage,

aber x < 3 eine Aussageform. Erstere ist im Beispiel wahr, letztere wird erst wahr oder falsch, wenn man

für x eine konkrete Zahl einsetzt (genauer: einen Namen für eine konkrete Zahl). Wozu Aussageformen?

Man möchte etwa eine Allaussage oder Existenzaussage machen - dann braucht man einen Aussagekern,

der eine Aussageform ist, z.B.: ∃x ∈ R : x < 3 ist offenbar richtige Existenzaussage.

8

1. M ENGEN, ZAHLENM ENGEN, ABBILDUNGEN, LOGIK, RECHNEN

Aussagen und Aussageformen verbindet man mit einigen logischen Verknüpfungen zu neuen, dabei

sollte man diese kennen:

A ∧ B (lies : A und B) ist genau dann wahr, wenn A und B beide wahr sind.

A ∨ B (lies : A oder B) ist genau dann wahr, wenn mindestens eine der beiden Aussagen wahr ist.

A ⇒ B (lies : wenn A, so B) ist genau dann wahr, wenn A falsch ist oder B wahr.

A ⇐⇒ B (lies : A genau dann, wenn B) ist genau dann wahr, wenn A,B beide wahr

oder beide falsch sind.

∀xA (x) (lies : für alle x gilt A (x) ) ist genau dann wahr, wenn für jedes Element c der

Grundmenge, von der jeweils die Rede ist, gilt, dass A (c)

∃xA (x) (lies : es gibt ein x, so dass gilt : A (x) ) ist genau dann wahr, wenn es mindestens ein

Element der Grundmenge (von der die Rede ist) gibt, so dass A (c) wahr ist.

:

Hinweis Sehr gern benutzt man ∀x ∈ R : A (x) oder ∃x ∈ R : A (x) usw.

Wir werden oft ’und’, ’oder’ sagen und keine Kürzel dafür verwenden. Ebenso ’nicht A’ statt so etwas wie

⇁ A. Aber Pfeil und Doppelpfeil sind recht nützlich und führen vilefach zu größerer Übersichtlichkeit.

Folgende logischen Äquivalenzen und Schlussweisen sollte man kennen:

1.) Anwendung eines Allsatzes auf spezielle Beispiele:

∀xA (x)

A (x/t) (Aussageform A (x) , für x ein Term t eingesetzt)

2.) Modus-ponens-Regel:

A

A =⇒ B

B (aus A und A =⇒ B schließe B)

Folgende logischen Äquivalenzen sind immer wieder nützlich:

(A =⇒ B)

nicht (A ∧ B)

nicht (A ∨ B)

nicht ∀xA (x)

nicht ∃xA (x)

⇐⇒

⇐⇒

⇐⇒

⇐⇒

⇐⇒

(nicht B =⇒ nicht A)

(nicht A ∨ nicht B)

(nicht A ∧ nicht B)

∃x (nicht A (x))

∀x (nicht A (x))

Bei einer solchen logischen Äquivalenz kann man von der linken Seite auf die rechte schließen und umgekehrt.

1.2. Eine etwas weiter ausgearbeitete Logik∗ .

1.2.1. Aussagenlogische Verknüpfungen und zugehörige Regeln. Wir setzen voraus, dass A, B, C, ...

stets Aussagen sind, jede eindeutig wahr oder eindeutig falsch. Wir ordnen den Aussagen A, B, ...

Wahrheitswerte zu, w(A) = 1, wenn A wahr ist, sonst w(A) = 0. Hier sind die wichtigen aussagenlogischen

Verknüpfungen und die Fortsetzung der Wahrheitswertefunktion w auf die zusammengesetzten Aussagen:

A∧B

A∨B

⇁ A

(gelesen : A und B), w(A ∧ B) := w(A)w(B)

(gelesen : A und B), w(A ∨ B) := min(1, w(A) + w(B)) = 1 − (1 − w (A)) (1 − w (B))

(gelesen : nicht A), w( ⇁ A) := 1 − w (A)

A ⇒ B (gelesen : wenn A, so B), w(A ⇒ B) := 1 − w(A)(1 − w(B))

A ⇐⇒ B (gelesen : A genau dann, wenn B),

w(A ⇐⇒ B) := w(A)w(B) + (1 − w(A)) (1 − w (B))

Es ist vor allem wichtig, diese Zusammensetzungen intuitiv richtig zu verstehen und zu nutzen: Anfänger

sollten sich vor allem klar machen, dass A ⇒ B inhaltlich bedeutet: A falsch oder B wahr, oder auch:

1. EIN W ENIG LOGIK

9

Es kann nicht sein, dass A wahr und B falsch ist. Eine zusammengesetzte Aussage kann ihrer Form nach

allgemeingültig sein. Das bedeutet: Ihr Wahrheitswert ist immer 1, gleichgültig, welche Wahrheitswerte

die darin mit Buchstaben bezeichneten Aussagen haben. Ferner gibt es nützliche Äquivalenzen, die man

so formuliert: ’Die Aussage A ⇐⇒ B ist allgemeingültig’. Hier ist eine kleine Liste der wichtigsten Fälle

- man verabredet, dass ⇁ stärker bindet als alle anderen aussagenlogischen Verknüpfungen, dass ferner

∧, ∨ stärker binden als ⇒, ⇐⇒:

Folgende Aussagen sind für alle Aussagen A, B, C allgemeingültig:

⇁⇁ A ⇐⇒ A

⇁ (A ∧ B) ⇐⇒ ⇁ A ⇁ B

⇁ (A ∨ B) ⇐⇒ ⇁ A∧ ⇁ B

(A ⇒ B) ⇐⇒ ⇁ A ∨ B

(A ⇒ B) ⇐⇒ ⇁ (A∧ ⇁ B)

(A ⇒ B) ⇐⇒ (⇁ B ⇒⇁ A)

(A ∧ B ⇒ C) ⇐⇒ (A ⇒ (B ⇒ C))

Diese Äquivalenzen kann man alle direkt mit den angegebenen Regeln für die Funktion w überprüfen,

Im Beispiel der vorletzten Äquivalenz:

w (⇁ B ⇒⇁ A) =

=

=

=

1 − w (⇁ B) (1 − w (⇁ A))

1 − (1 − w (B)) (1 − (1 − w (A)))

1 − w (A) (1 − w (B))

w (A ⇒ B)

Da die Aussagen A ⇒ B und ⇁ B ⇒⇁ A somit stets dieselben Wahrheitswerte haben, hat die Aussage

(A ⇒ B) ⇐⇒ ⇁ A ∨ B stets den Wahrheitswert 1, ist mithin allgemeingültig.

Eine günstige Sprechweise ist es, A ⇒ B so auszudrücken: ’A ist hinreichend für B’, oder auch: ’B

ist notwendig für A’. Beispiel: Ist eine Funktion f an der Stelle x0 differenzierbar, so ist sie dort auch

stetig. Oder: Differenzierbarkeit von f in x0 ist hinreichend für Stetigkeit von f in x0 .Oder: Stetigkeit

in x0 ist notwendig für Differenzierbarkeit in x0 . Aber man weiß, dass Stetigkeit in x0 nicht hinreichend

für Differenzierbarkeit in x0 ist, bzw. Differenzierbarkeit nicht notwendig für Stetigkeit. Die angegebenen

Äquivalenzen kann man natürlich als Regeln lesen: Aus der einen Seite folgt die andere, und umgekehrt.

Es gibt aber noch eine aussagenlogische Regel von überragender Bedeutung:

Modus-ponens-Regel :

Aus A ⇒ B und A folgt B.

Das kann man auch so ausdrücken: Die Aussage ((A ⇒ B) ∧ A ⇒ B) ist allgemeingültig. Diese Regel

wendet man fortlaufend an, wenn man eine längere logische Schlusskette produziert, etwa überlegt: Die

Funktion f(x) = x3 ist überall differenzierbar. Da die Ableitung außer bei x0 = 0 überall > 0 ist, ist die

Funktion streng monoton steigend. Außerdem ist f überall stetig, da differenzierbar. Aber eine stetige

Funktion nimmt auf einem Intervall [a, b] mit zwei Werten c, d auch jeden Wert dazwischen an. Es folgt:

3

Betrachtet man f auf das Intervall [a, b] eingeschränkt, a < b, so ist a3 der kleinste

3 3 Wert, b der größte,

und f(x) durchläuft mit x ∈ (a, b) jeden Wert dazwischen. Jeder Wert aus a , b wird genau einmal

angenommen. Man beachte, dass hier eine Vielzahl von Anwendungen der Modus-ponens-Regel vorliegt:

f ist überall differenzierbar und: Wenn f überall differenzierbar ist, so ist f überall stetig. Also ist f

überall stetig. Dann geht es weiter: Aus der Stetigkeit folgt wieder Neues, das gilt also wiederum für

unsere konkrete Funktion f. Ferner sind die benutzten Sätze der Art: ’Für alle Funktionen f gilt:...’, und

wir haben für f unsere konkrete Funktion f (x) = x3 eingesetzt. Diesen logischen Vorgang erklären wir

genauer im nächsten Abschnitt.

Eine allgemeine Bemerkung zur Aussagenlogik: Aussagenlogik ist völlig primitiv in dem Sinne,

dass man mit der angegebenen Funktion w den Wahrheitswert einer beliebigen Zusammensatzungen aus

den Wahrheitswerten der Bestandteile schematisch ausrechnen kann. Insbesondere kann man mit einem

Computerprogramm die Allgemeingültigkeit in endlich vielen Schritten prüfen. Das wird ganz anders,

wenn Variablen für Objekte von Strukturen und Zeichen für Beziehungen und Funktionen auftreten

10

1. M ENGEN, ZAHLENM ENGEN, ABBILDUNGEN, LOGIK, RECHNEN

sowie die Quantifikatoren ’für alle...’, ’es gibt...’. Wir werden im nächsten Abschnitt sehen, dass dann

Kreativität gefragt ist. Man kann sogar mathematisch beweisen, dass es kein Computerprogramm geben

kann, das allgemein die auftretenden Grundaufgaben zu lösen vermag.

1.2.2. Der Umgang mit Variablen und Quantifikatoren. Die wichtigste Form mathematischer Aussagen ist die der Allaussagen: ’Für alle ... gilt:...’. Die einfachsten Beispiele dafür sind allgemeingültige

Rechenformeln, etwa:

Für alle x, y, z

Für alle Mengen A, B gilt:

∈ R gilt: x (y + z) = xy + xz,

A ∪ (B ∩ C) = (A ∪ B) ∩ (A ∪ C) .

Dabei lässt man fast stets den Vorpann ’für alle ...’ weg und schreibt bequem nur die Gleichung, mit

den Buchstaben als freien Variablen, mit dem Verständnis: Wenn man für die Buchstaben irgendwelche

Objekte aus dem betreffenden Bereich einsetzt, so entsteht eine gültige Formel. Diese Formel ist im

allgemeinen wieder von allgemeiner Art, dass man wieder für Buchstaben beliebige Objekte einsetzen

kann. Beim Einsetzen hat man folgende Grundregeln zu beachten:

Grundregeln für das Einsetzen :

Für dieselbe freie Variable muss überall dasselbe Objekt eingesetzt werden.

Für verschiedene freie Variablen darf dasselbe Objekt eingesetzt werden.

Wird für eine freie Variable ein zusammengesetztes Objekt eingesetzt, ein Rechenausdruck,

so muss dieser eingeklammert werden (was manchmal nach Überlegung entfallen kann).

Beispiel: Eine korrekte Einsetzung in x (y + z) = xy + xz ist:

(a + b) ((a + b) + a) = (a + b) (a + b) + (a + b) a.

Man kann also folgern:

(a + b) (2a + b) = (a + b)2 + (a + b) a.

Was wurde wofür eingesetzt, wo wurden Klammern gesetzt, welche von den regulär gesetzten Klammern

können entfallen? Im Zusammenhang mit den Allaussagen hat man die folgende wichtigste logische

Quantifikatorenregel:

Aus ∀xα (x) folgt stets α (x/t) .

Dabei steht ∀xα (x) abkürzend für ’für alle x gilt: α (x)’, und α (x/t) bedeutet die Formel α mit der

Einsetzung des Rechenausdrucks (Terms) t für die freie Variable x. Dabei darf α sogar beliebig kompliziert

mit aussagenlogischen Verknüpfungen und weiteren Quantifikatoren sein.

Ein ganz anderer Typ von Gleichungen sind Bestimmungsgleichungen, etwa x2 +x−1 = 0 oder y = x2 .

Sie sind offenbar nicht allgemeingültig, vielmehr sind die Variablen darin Unbestimmte (Unbekannte),

und man

die Lösungsmenge

der Gleichung, im ersten Fall ist das ’auszurechnen’, es kommt die

√

√ sucht

1

1

1

1

Menge

−

−

5,

−

+

5

heraus,

im zweiten Fall ist die Lösungsmenge die Menge der Zahlenpaare

2 2

2 2

(x, y) ∈ R2 y = x2 . Diese kann man nicht einfacher ausdrücken, wohl aber feststellen, dass es sich um

den Graphen einer differenzierbaren Funktion handelt, auch um die Bahn einer differenzierbaren Kurve,

usw.

Wir verbinden Modus-ponens-Regel und Einsetzungsregel zum wichtigsten logischen Instrument:

Aus ∀x (α (x) =⇒ β (x)) und α (x/t) folgt β (x/t) .

Vorn steht der wichtigste Typ von Allaussagen überhaupt, neben den oben erwähnten allgemeingültigen Formeln. Damit haben wir genau das, was man bei jeglicher Anwendung der allgemeinen mathematischen Resultate benötigt.

Aber woher kommen die Allaussagen, deren Gültigkeit man voraussetzen kann? Einmal kommen sie

von den Grundaxiomen der Mathematik, z.B. von denen der Strukturen (N, +, ∗), (R, +, ∗) usw. Die

meisten sind jedoch zu beweisende Sätze, wobei die Grundtechnik eines solchen Beweises folgende ist:

Man möchte (∀a ∈ A) (α (a)) beweisen. Dazu setzt man a als beliebiges Element von A voraus (’Sei a ∈ A

beliebig ...’). Dann beweist man α(a). Da über a nichts weiter als a ∈ A vorausgesetzt war, hat man die

Aussage (∀a ∈ A) (α (a)) bewiesen.

Es gibt aber noch zwei weitere grundlegende Typen von mathematischen Aussagen:

Existenzaussagen: Es gibt x aus der Menge A, so dass α(x). Kurz: (∃x ∈ A) α (x) . Das bedeutet:

Man kann ein Objekt a ∈ A angeben, so dass α (a) eine gültige Aussage ist. Zum Beispiel ist 6 durch

1. EIN W ENIG LOGIK

11

3 teilbar, weil ∃n ∈ Z (3n = 6) eine gültige Aussage ist, mit der Einsetzung von 2 für n in 3n = 6.

Achtung - es ist eine weit verbreitete Unsitte, Existenzquantoren ebenso wegzulassen wie Allquantoren,

und die Folgen sind verheerend! Man beachte ferner: ’es gibt ein’ bedeutet mathematisch stets: ’es gibt

mindestens ein’, keine Eindeutigkeit, zum Beispiel kann man bei der wahren Aussage ∃n ∈ Z (n > 5) in

’n > 5’ einsetzen: n = 6, aber auch n = 1000. Beides liefert die Gültigkeit der Existenzaussage, gemäß

der folgenden allgemeinen Einsetzungsregel für Existenzaussagen:

α (x/t) =⇒ ∃xα (x) .

Ein zweiter Aspekt von Existenzaussagen: Wie nutzt man für weitere Folgerungen eine bereits bewiesene

oder vorauszusetzende Existenzaussage (∃x ∈ A)α (x)? Dazu formuliert man einfach: ’Sei a ∈ A derart,

dass α (a) gilt’. Auf diese Weise hat man den Existenzquantor beseitigt und eine günstige Form für die

weitere Arbeit. Allerdings darf man ohne weitere Begründung nichts sonst als nur eben α(a) für das Objekt

a verlangen. Ein Beispiel: Von einer stetigen Funktion f auf einem Intervall [a, b] mit f (a) = f (b) = 0,

die nicht konstant auf [a, b] ist, weiß man, dass f in (a, b) ein Extremum hat, das sogar global für [a, b]

ein solches ist. Also hat man (∃x ∈ (a, b)) (∀y ∈ [a, b]) f (y) ≤ f (x). Man sagt: ’Sei ξ ein solches, also

(∀y ∈ [a, b]) f(y) ≤ f (ξ)’. Ist f zusätzlich auf (a, b) differenzierbar, so ist f ′ (ξ) = 0. Somit folgt aus der

Existenzaussage (∃x ∈ (a, b)) (∀y ∈ [a, b]) f (y) ≤ f(x) die Existenzaussage (∃x ∈ (a, b))f ′ (x) = 0.

Zur Verneinung von Allaussagen und Existenzaussagen hat man folgende logisch allgemeingültigen Äquivalenzen:

⇁ ∀xα (x) ⇐⇒ ∃x ⇁ α (x)

⇁ ∃xα (x) ⇐⇒ ∀x ⇁ α (x)

Aussagen vom Typ ’für alle x gibt es y, so dass α (x, y)’: Diese Aussagen sind schon recht kompliziert, aber für die Mathematik elementar notwendig. Etwa ’Es gibt keine größte reelle Zahl’ bedeutet:

Zu jeder reellen Zahl x gibt es eine reelle Zahl y, so dass y > x. Kurz: (∀x ∈ R)(∃y ∈ R)(y > x). Man

argumentiert, um die Gültigkeit einer solchen Aussage zu zeigen, so: Sei x0 eine beliebige reelle Zahl. (Auf

diese Weise ist der Allquantor beseitigt - wir betrachten x0 als Konstante, als Eigennamen einer reellen

Zahl!) Dann ist x0 + 1 > x0 . Dies folgern wir aus der Grundregel: Wenn a > b, so a + c > b + c mit der

Einsetzung 1 für a, 0 für b, x0 für c. Mit x0 + 1 > x0 ergibt die Einsetzungsregel für Existenzaussagen:

(∃y ∈ R)y > x0 . Da dies für jedes konkrete x0 ∈ R gilt, haben wir (∀x ∈ R)(∃y ∈ R)(y > x).

Dies war ein besonders einfaches Beispiel einer Aussage der angesprochenen Form, das aber genau

die typischen logischen Schritte zeigt, eine solche Aussage zu bestätigen. Wir wollen wenigstens noch zwei

substantielle Beispiele aufführen, um die überragende Bedeutung dieser Form zu zeigen:

Erstes Beispiel: Begriff der Stetigkeit einer Funktion f an der Stelle x0 . Nach Definition ist

f in x0 genau dann stetig, wenn (∀ε > 0) (∃δ > 0) (∀x ∈ R) (|x − x0 | < δ =⇒ |f (x) − f (x0 )| < ε) . Man

beobachtet: Mit dem zweiten Allquantor ist die Aussage sogar noch komplizierter, aber der Kern der

Sache liegt bei ε und δ. Wir wollen zeigen, dass f (x) = x2 stetig ist in x0 = 1. Wir setzen

eine beliebig

kleine Zahl ε > 0 voraus. Zu finden ist eine Zahl δ > 0, so dass aus |x − 1| < δ folgt: x2 − 12 < ε, für

2

|x2 −1|

−1

alle Zahlen x. Wir haben xx−1

= x + 1. Also |x−1| = |x + 1| . Setzen wir δ = min(1, 2ε ), so haben wir für

alle Zahlen x:

2

x − 12 ≤ |x + 1| |x − 1| < 2δ ≤ ε , wenn |x − 1| < δ.

2

Beachten Sie, dass die logische Struktur genau die des simpleren Beispiels ist, die Idee also, δ mit der

gewünschten Eigenschaft als Ausdruck in ε anzugeben. Gerade hier, im ’Finden eines δ mit den verlangten Eigenschaften passend zu ε’, liegt die oben erwähnte benötigte Kreativität. Diese Aufgabe kann im

Einzelfall beliebig schwierig sein und kann im allgemeinen nicht von einem Computer gelöst werden, man

braucht intuitives ’Sehen’, Strategie, Wahrnehmung und Erfahrung, Flexibilität. Seien Sie darum nicht

enttäuscht, wenn Sie am Anfang nur mit großer Anstrengung eine kleine Sache dieser Art hinbekommen!

→

Zweites Beispiel: ’Jeder Vektor −

x ∈ V (V Vektorraum über R) kann als Linearkombination

−

→

−

→

der Vektoren a 1 , ..., a n dargestellt werden’. Dies

sie

der linearen

→ist eine

Standardaussage, wie

in

n

→

→

Algebra typisch auftritt. Ausgeschrieben lautet sie: ∀−

x ∈ V (∃(λ1 , ..., λn ) ∈ Rn ) −

x = k=1 λk −

a k.

Abschließend bemerken wir noch, dass auch Aussagen vom Typ ’Es gibt ..., so dass für alle ...’

bedeutsam sind. Einmal kommen Sie als Verneinungen der Aussagen ’Für alle ... gibt es ..., so dass ...’

vor. Aber sie haben auch ihre eigene Bedeutung darin, dass ein Objekt sich zu allen anderen in gewisser

Weise verhält. Die Form ’∃∀’ ist zum Beispiel bei Begriffen wie gleichmäßiger Stetigkeit wichtig, und solche

12

1. M ENGEN, ZAHLENM ENGEN, ABBILDUNGEN, LOGIK, RECHNEN

Begriffe bereiten Anfängern immer wieder typische Schwierigkeit - nur deswegen, weil die eigentlich völlig

einsichtige logische Struktur nicht gesehen wird. Darum hier ein einfaches Beispiel zum Vergleich zwischen

’∃∀’ und ’∀∃’: (∀x ∈ R) (∃y ∈ R) x + y = 0 ist ein wahrer Satz (wähle y = −x, diese Einsetzung liefert

das für die Existenz (hier einzige) passende Beispiel). Aber (∃y ∈ R) (∀x ∈ R) x + y = 0 ist offenbar ein

falscher Satz. Dagegen ist (∃y ∈ R) (∀x ∈ R) x + y = x wahr, nämlich mit der Einsetzung 0 für y in

(∀x ∈ R) x + y = x. Man beachte, dass aus ∃y∀xα (x, y) stets folgt ∀x∃yα (x, y) , aber nicht umgekehrt.

2. Die natürlichen Zahlen, vollständige Induktion bzw. Rekursion

Die natürlichen Zahlen bilden eine Grundstruktur, welche die Mutter aller Kombinatorik ist und daher auch für Anwender von eigenem Interesse ist, die eher an die reellen Zahlen denken. Die fundamentale

Eigenschaft der natürlichen Zahlen: Man fängt mit 1 an (wahlweise mit 0) und erzeugt alle weiteren natürlichen Zahlen durch Nachfolgerbildung. Dabei verlangt man, dass die Nachfolgerabbildung injektiv ist.

1 ist die erste in der Ordnung, selber kein Nachfolger. Daraus folgt ein wichtiges Prinzip für Definitionen

von Funktionen f : N → B und für Beweise von Aussagen der Form ∀ (n ∈ N) A (n) . Wir formulieren

das in zwei Sätzen, die unmittelbar aus folgendem Grundaxiom für die Struktur der natürlichen Zahlen

folgen: Jede nichtleere Menge natürlicher Zahlen hat ein kleinstes Element.

S 1. Prinzip der Definition durch Rekursion (Induktion): Das Schema f(1) = a, f(n + 1) =

α(n, f (n)) definiert mit einem beliebigen Rechenausdruck α eindeutig eine Funktion f : N → B, wobei B

eine Menge sein muss, die a und alle weiteren Werte α (n, f(n)) enthält.

S 2. Prinzip des Beweises mit vollständiger Induktion: Aus den Aussagen A (1) (’Induktionsanfang’) und ∀ (n ∈ N) (A(n) =⇒ A (n + 1)) (’Induktionsschluss von n auf n + 1’) folgt die Aussage

∀ (n ∈ N) A (n) .

Beispiel: f(1) = 1, f (n + 1) = f (n) + n + 1 definiert eindeutig eine Funktion N → N. Der Rechenausdruck α ist hier: f(n) + n + 1. Man kann nun mit Induktion beweisen: ∀ (n ∈ N) f (n) = n(n+1)

.

2

n(n+1)

1·2

Hier ist die Aussage A(n) : f (n) =

. A (1) besagt: f (1) = 2 . Das stimmt. Damit ist der

2

Induktionsanfang gemacht. Nun der Induktionsschluss: Die Aussage A(n) =⇒ A (n + 1) ist allgemein für n ∈ N zu beweisen. Sie lautet: Wenn f (n) = n(n+1)

, dann f (n + 1) = (n+1)(n+2)

. Aber

2

2

n(n+1)

nach rekursiver Definition ist f (n + 1) = f (n) + n + 1. Wenn nun f (n) =

, so haben wir

2

n

n(n+1)

(n+1)(n+2)

f (n + 1) =

+ n + 1 = (n + 1) 2 + 1 =

. Man beachte: Wir mussten nur A (n + 1)

2

2

beweisen unter der Voraussetzung, dass A (n) bereits gültig ist. Das ist viel weniger, als etwa A (n + 1)

allgemein zu beweisen! Aber das Prinzip besagt, dass dies zusammen mit dem Induktionsanfang bereits

ausreicht, ∀ (n ∈ N) A (n) zu beweisen. Es sei betont: A(n) =⇒ A (n + 1) kann auch dann allgemeingültig sein, wenn tatsächlich A (n) für alle n falsch ist, nehmen Sie für A (n) etwa die Aussage: ’Alle

natürlichen Zahlen sind gerade und ungerade’. Wenn n gerade und ungerade ist, dann ist es auch n + 1.

Diese ’wenn..., dann...’-Aussage ist allgemeingültig.

Bemerkung zur Begründung aus dem Prinzip vom kleinsten Element: Wenn A (n) für

mindestens eine natürliche Zahl falsch wäre, so wäre die Menge der Zahlen m, für die A (m) falsch ist,

nicht leer, hätte also ein kleinstes Element m0 . Nun kann wegen der Gültigkeit von A (1) die Zahl m0

nur größer als 1 sein. Aber dann gilt A (m0 − 1) . Mit dem Induktionsschluss müsste aber dann auch

A (m0 ) richtig sein, wir haben also einen Widerspruch. (Ähnlich kann man das Prinzip der Definition

durch Rekursion begründen.)

Bemerkung zu einer Verallgemeinerung der Prinzipien: Wie oben formuliert, greift man

für n + 1 nur auf den unmittelbaren Vorgänger n zurück. Aber die Prinzipien bleiben gültig, wenn

man sogar den Rückgriff auf alle Vorgänger erlaubt. Dazu zwei Beispiele: Mit f(0) = 1, f(1) = 1,

f(n + 2) = f(n + 1) + f (n) wird korrekt eine Funktion f : N0 → N definiert. Die rekursive Definition

greift hier auf zwei Vorgänger zurück. Folgendes Beispiel macht Gebrauch von beliebigen Vorgängern:

Man möchte induktiv beweisen, dass jede natürliche Zahl eindeutig in Primfaktoren zerlegt werden kann

und argumentiert für den Induktionsschluss so: Sei n > 2 eine natürlich Zahl. Dann ist n entweder

selbst Primzahl (und die Behauptung stimmt also), oder aber es gibt Zahlen r, s ∈ N, r, s ≥ 2, mit der

Eigenschaft rs = n. Für r, s existiert aber bereits (gemäß verallgemeinerter Induktionsvoraussetzung!) je

eine Primfaktorzerlegung. Die braucht man nur zusammenzufügen und erhält eine solche für n. Es wird

also auf die Behauptung für beliebig weit zurückliegende Vorgänger r, s zurückgegriffen.

3. ELEM ENTARE GRUNDKENNTNISSE ZUM RECHNEN

13

3. Elementare Grundkenntnisse zum Rechnen

Hier werden einige wichtige aus der Schule bekannte Dinge noch einmal bewusster gemacht und einige

Ergänzungen angebracht.

3.1. Anwendungen des Distributivgesetzes. Ein dringender Rat: Ausdrücke wie (x + 1) (x + 2)

sollte man nicht ’automatisch’ ausmultiplizieren, wo das keinen Nutzen bringt, sondern Schaden. Bei

f(x) = (x+1)(x+2)

sieht man sofort die Nullstellen, nach Ausmultiplizieren nicht mehr. Bei g(x) =

x2 +1

x+3

sieht

man

sofort die Pole, mehr noch: Man kann schnell in die für das Integrieren z.B. nützli(x+1)(x+2)

2

1

che Form x+1 − x+2 überführen (Partialbruchzerlegung), entscheidend ist dabei gerade, dass der Nenner

faktorisiert ist.

Weiter: Niemand hat ein Problem damit, die Gleichung 2x − 3 = 4 + 5x zu lösen. Das ist eine lineare

Gleichung mit einer Unbekannten. Stichwort: Zusammenfassen der x− Glieder, der konstanten Glieder,

Trennen, fertig. Also 3x = −7, x = − 73 . Was man sich dabei gewöhnlich nicht klar macht: Nach Subtraktion von 2x erhält man rechts u.a. 5x − 2x, und Anwendung des Distributivgesetzes gerade in der

anderen Richtung - Ausklammern, nicht Ausmultiplizieren - ergibt die gewünschte Zusammenfassung zu

3x. Das rächt sich bitter: Viele Anfänger geraten in größte Schwierigkeiten, wenn eine Gleichung (in x)

zu lösen ist wie (2a + 3) x + 4 = (a − 1) x + 2 (ähnlich, wenn die Vorfaktoren komplexe Zahlen sind oder

gar Ausdrücke mit großem Summenzeichen.) Zunächst wird die Struktur ’lineare Gleichung mit einer

Unbestimmten’ nicht gesehen. Dann wird nicht erkannt, dass genau die Anwendung des Distributivgesetzes wie im ersten Beispiel zur Lösung führt, also: ((2a + 3) − (a − 1)) x = −2, besser im Kopf direkt

−2

. Nun droht wieder die

die Differenz im Faktor vor x ausführen, Resultat: (a + 4) x = −2. Also x = a+4

Gefahr, dass die benötigte Fallunterscheidung unterbleibt. Das Resultat lautet: 1. Fall: a = −4. Dann ist

−2

die eindeutige Lösung der Gleichung x = a+4

. 2. Fall: a = −4. Dann bedeutet (a + 4) x = −2 einfach

0x = −2. Die Gleichung hat also keine Lösung x für a = −4.

3.2. Bruchrechnung. Wie man Brüche kürzt, erweitert, addiert, multipliziert, dividiert, sollte bekannt sein. Es sollte auch kein Zweifel darüber sein, dass bei einem Bruch der Zähler Null sein darf, der

Nenner aber nicht, weil ab die eindeutige Lösung von xa = b (Unbestimmte: x) sein soll, und die existiert

eindeutig nur im Falle a = 0. Auf Korrektheit und Geschicklichkeit in der Anwendung kommt es an.

Etwa: Kaum jemand versagt darin, 12 + 13 auszurechnen. Aber wie steht es mit dem direkten Übersehen

von

ab

1

1

1 = a + b?

a + b

So etwas sollte auch dann noch gehen, wenn a, b wiederum kompliziertere Ausdrücke sind. (Im Beispiel

sollte man nicht die Summe im Nenner bilden und dann den Kehrwert, sondern mit ab erweitern).

1+ √ 1

x+1

Noch ein Beispiel: Wie kann man die Nullstellen sehen von 1 − √x+1

? Hier ist vorauszusehen, dass

die Form ’ein doppelbruchfreier Bruch’ erreicht werden kann und hilft:

√

1

1 + √x+1

x− x+1

1− √

=

.

x+1

x+1

√

Übersehen Sie das schnell? Also weiter mit Bruchrechnung:

Eine Nullstelle x muss erfüllen: x− x + 1 = 0,

√

aber x+1 = 0. Es bleibt die Gleichung x = x + 1. Steht die Unbestimmte unter einem Funktionszeichen

(hier Wurzel), so versucht man es stets mit Anwendung

der Umkehrfunktion, was natürlich nur in einfa√

chen Fällen gelingt. Hier: x2 = x+1, also x = 12 ± 12 5. Nun würden viele Anfänger hereinfallen und diese

beiden Nullstellen angeben. Aber die quadratische Gleichung ist nicht gleichwertig zur ursprünglichen,

sondern nur eine Folgerung davon. Eine Lösung der ursprünglichen√Gleichung muss also unter den beiden

Lösungen der quadratischen

Gleichung sein. Ferner folgt aus x = x + 1, dass x√> 0. Tatsächlich ist die

√

Bedingung x = x + 1 gleichwertig zu x2 = x+ 1 und x > 0. Also ist x0 = 12 + 12 5 die einzige Nullstelle.

3.3. Potenzrechnung. Bei √

Potenzen denke man nicht nur an natürliche Exponenten wie a5 , son4

3/4

dern auch an gebrochene: a

= a3 (nur für a ≥ 0 definiert), an die negativen: a−x = a1x , später auch

daran, dass die Exponenten beliebige reelle Zahlen sein dürfen. Grundlegende allgemeingültige Formeln,

14

1. M ENGEN, ZAHLENM ENGEN, ABBILDUNGEN, LOGIK, RECHNEN

die man kennen sollte - a > 0 ist vorauszusetzen:

a0

ax ay

(ax )y

= 1

= ax+y

= axy

√

√

3

√ √

4

Es folgt zum Beispiel: ab = a b für a, b ≥ 0. Auch a6 a3 = a3 . Oder a8 a4 = a3 . Es sollte bewusst

√

√

√

sein, dass (a + b)n nicht etwa an + bn ist, a + b nicht etwa a + b.

3.4. Das große Summenzeichen und Ähnliches. Wenn man eine Summe hat wie a1 + a2 +

... + a1000 , so benötigt man wohlwollende Ergänzung des Lesers bei den Pünktchen, außerdem ist die

Schreibweise nicht sehr praktisch. Drastischer wird das noch etwa bei (a11 + a12 + ... + a1n ) + ...(am1 +

am2 + ... + amn ). Summen beliebig festzulegender Längen oder gar unendlicher haben wir sehr oft zu

bilden. Daher definieren wir nach dem Prinzip der Rekursion:

0

ak := 0,

k=1

n+1

n

ak :=

k=1

ak + an+1 .

k=1

Man denke aber stets auch noch anschaulich mit den Pünktchen:

n

k=1

ak = a1 + ... + an (für n ≥ 1). Diese

Bildung führt man auch mit anderen Verknüpfungszeichen analog aus, etwa

Oder für Mengen:

n

n

k=1

k=1

ak = a1 · ... · an für n ≥ 1.

An = A1 ∩ ... ∩ An für n ≥ 1. Wir haben ein paar für das Weitere sehr nützliche

Rechengesetze für das große Summenzeichen, die einfach aus den Rechengesetzen für die Addition sowie

dem Distributivgesetz folgen - die Klammern in der dritten Zeile könnten fehlen, sie sollen nur das genaue

Lesen unterstützen:

n

c = nc

k=1

n

ak +

k=1

n

bk

k=1

n

cak

n

=

(ak + bk )

k=1

n

= c

k=1

ak

k=1

m n

m m

n

n

ai

bj =

ai

bj =

bj

ai

i=1

j=1

m n

i=1

ai bj

i=1 j=1

Beispiele:

=

j=1

j=1

i=1

ai bj

1≤i≤m, 1≤j≤n

n

n+1

n

n

n

n

n

(ak+1 − ak ) =

ak −

ak = an+1 − a1 ,

(ak + bk )2 =

a2k +

b2k + 2

ak bk . (Zuk=1

k=2

k=1

k=1

k=1

k=1

k=1

nächst die binomische Formel auf (ak + bk )2 im Innern der Summe anwenden, dann auseinanderziehen.)

n

3.5. Die Binomialkoeffizienten. Wenn man (x + y) für n ∈ N ausmultipliziert, so erhält man

nach Distributivgesetz ’jeder mit jedem’ lauter Glieder xk yn−k , 0 ≤ k ≤ n. Zu diesen Gliedern gehört ein

Vorfaktor (’Koeffizient’), und dann wird alles addiert. Nun tritt xk y n−k genau so oft auf, wie man aus

den n Faktoren x + y das Glied x k mal, y entsprechend n − k mal auswählen kann. Diese Anzahl kann

man wie folgt ausrechnen:

Wir benötigen eine kleine Vorbereitung: Wie viele Möglichkeiten gibt es, k Objekte anzuordnen?

Nennen wir diese Anzahl g(k) Für k = 0 ist das ein wenig merkwürdig, aber man kann sagen: Da ist

nichts anzuordnen, und es gibt genau eine Möglichkeit, nichts zu tun. Also g (0) = 1. Für k = 1 ist klar:

3. ELEM ENTARE GRUNDKENNTNISSE ZUM RECHNEN

15

g(1) = 1. Weiter g(2) = 2. Aber wie geht es weiter? Abzählen hilft nicht bei großem k.Aber wir erhalten

folgende Rekursionsformel: g(k+1) = (k + 1) g (k) . Begründung: Aus den k+1 Objekten wählen wir eines

aus, bestimmen für dies den Ordnungsplatz. Das kann man auf k + 1 Weisen tun. Der Rest kann auf g (k)

Weisen angeordnet werden. Also multiplizieren sich diese Anzahlen zu g(k + 1), was die Rekursionsformel

ergibt. Nach dem Prinzip der Definition durch Rekursion ist mit g (0) = 1, g (k + 1) = (k + 1) g (k) eine

k

eindeutige Funktion bestimmt, und man sieht sofort, dass g (k) =

m für k ≥ 1. Man schreibt nun k!

m=1

(lies: ’k Fakultät’) für g(k) und hat:

S 3. Die Anzahl der Anordnungen einer Menge von k Elementen (k ∈ N0 ) ist k!, wobei 0! = 1,

(k + 1)! = (k + 1) k!. k! ist auch die Anzahl der Bijektionen einer Menge von k Elementen auf sich selbst.

S 4. Sei f(n,k) für 0 ≤ k ≤ n die Anzahl der Möglichkeiten, k Elemente aus einer Menge mit n

Elementen auszuwählen. Dann gilt:

n

n!

.

f(n, k) =

:=

k! (n − k)!

k

(Man liest das Symbol nk : ’n über k’.)

Folgerung:

(x + y)n =

n n k n−k

x y

k

k=0

Die Formel ist schnell begründet: Für k = 0 stimmt sie offenbar: Kein Element auszuwählen, dafür hat

man offenbar genau eine Möglichkeit. Wählt man k Elemente aus, k > 0, entsprechend n ≥ k > 0,

so hat man n Möglichkeiten für die erste Auswahl des ersten Elementes, für die nächste n − 1, usw.

k−1

Das macht

(n − m) Möglichkeiten, da die Anzahlen für die Einzelschritte zu multiplizieren sind.

m=0

Diese Zahl muss man durch k! teilen, da sie die Anzahl der Möglichkeiten ist, k Elemente in einer ganz

k−1

(n−m)

bestimmten Reihenfolge auszuwählen. Nun erweitert man den Bruch

n!

k!(n−k)! . Alternativ könnte man auch die Rekursionsformel

n+1

n

n

=

+

, 1≤k≤n

k

k−1

k

m=0

k!

mit (n − k)! und erhält

beweisen durch direktes Ausrechnen (Bruchrechnung!), und zeigen, dass die Funktion f (n, k) diese Rekursionsformel erfüllt. (Die Randfälle f (n, 0) = 1 und f (n, n) = 1 sind ohnehin klar.) Die Binomialkoeffizienten bilden bekanntlich das Pascalsche Dreieck.

KAPITEL 2

Elementare Vektorrechnung und analytische Geometrie

Zur naturwissenschaftlichen Motivierung für Vektoren: Eine Geschwindigkeit ist bei näherem Hinsehen nicht einfach eine Zahl ≥ 0 (’so viel Meter pro Sekunde’), sondern es gehört eine Richtung

im Raum dazu - selbst im eindimensionalen Raum, durch ein Vorzeichen ausgedrückt. Will man eine

Richtung im Raum (wir nehmen den dreidimensionalen Anschauungsraum) und eine Länge in einem

mathematischen Objekt beschreiben, so tut man das zweckmäßig auf zwei Weisen: Einmal mit einem

geometrischen Pfeil, dessen Richtung die gewünschte angibt und dessen Länge der verlangte Betrag ist.

Zweitens beschreibt man einen solchen Pfeil mit seiner Koordinatendarstellung bezüglich eines geeigneten

dreidimensionalen Koordinatensystems (das sollte drei unabhängige Achsen haben). Warum braucht man

beide Beschreibungen? Mit den Pfeilen kann man Zusammenhänge geometrisch sehen und konstruieren,

mit der Koordinatendarstellungen Komplizierteres ausrechnen, notfalls auf einem Computer. Bekanntlich

kann man durch Addieren aus Kraftvektoren die resultierende Kraft durch einen einzigen Vektor darstellen. Da sieht man bereits, dass eine Mengen von Vektoren zusammen mit einer Addition eine wichtige

Struktur darstellt.

Nicht nur Geschwindigkeiten, Beschleunigungen und Drehmomente, auch elektrische und magnetische Feldstärke (je an einem Ort) werden mit Vektoren beschrieben. Auch hier spielt das Summieren eine

tragende Rolle, beispielsweise erhält man das elektrische Feld, das von einer Punktladung erzeugt wird,

einfach durch ’Überlagern’, d.h. Summieren der Feldvektoren. So kann man also aus einfachen, recht bekannten Feldern sehr komplizierte erzeugen und mathematisch problemlos beschreiben. Dazu kommt der

Abbildungsbegriff: Ein elektrostatisches Feld ist ein Vektorfeld, d.h. eine Abbildung, die jedem Raumpunkt genau einen Vektor zuordnet, den Feldvektor an diesem Punkt. Bei einem zeitlich veränderlichen

’Wechselfeld’ kommt noch als weitere unabhängige Variable die Zeit hinzu, das ergibt einfach wieder ein

Vektorfeld, nur haben die Eingabevektoren eine Dimension mehr.

Eine weitere Motivierung ganz anderer Art kommt hinzu: Naturwissenschaftliche Gegenstände haben vielfach eine geometrische Beschreibungskomponente: Man hat etwa eine elektrische Ladungsverteilung auf einem dreidimensionalen Metallkörper, der eine ganz bestimmte Form besitzt. Dann ist die

rechnerisch-geometrische Beschreibung des Körpers grundlegend für alle naturwissenschaftlichen Berechnungen. Das bedeutet: Analytische Geometrie ist ein Grundnahrungsmittel für Naturwissenschaften, nicht

etwas für mathematische Spezialisten. Man muss Kurven, Flächen und geometrische Körper im Raum

rechnerisch beschreiben, um etwa Gesamtladungen aus Ladungsdichten oder Spannungen aus elektrischen

Feldern auszurechnen. Ähnliches gilt natürlich auch für die Energie, die man benötigt, einen starren Körper gewisser Gestalt und Massenverteilung auf eine gewisse Kreiselgeschwindigkeit um eine Achse zu

bringen.

1. Affiner Raum und Vektorraum

1.1. Punkte im Anschauungsraum, Ortsvektoren und Koordinatensysteme. Vorbemerkung: Wir denken an die Dimension 3, können aber selbstverständlich jederzeit auf nur zwei Dimensionen

spezialisieren, auf der anderen Seite zeigt sich, dass sämtliche Begriffsbildungen dieses Abschnitts für

beliebige (endliche) Dimensionen taugen. Dimension 3 hat nur eben für das Unterbringen naturwissenschaftlicher Sachverhalte besondere Bedeutung, und es ist wichtig, die Anschauung in drei Dimensionen

zu schulen. (Diese Anschauung kann man dann mit großem Gewinn auf höhere Dimensionen einfach

übertragen.)

Die Menge aller Punkte des dreidimensionalen Anschauungsraums bezeichnen wir mit E 3 , die Elemente mit Großbuchstaben P, Q, P1 usw. Wir legen einen beliebigen Punkt O ∈ E 3 fest und stellen

→

bezogen auf O jeden Punkt P durch einen Vektorpfeil dar, der von O nach P geht. Das ist −

xO

P , der

17

18

2. ELEM ENTARE VEKTORRECHNUNG UND ANALYTISCHE GEOMETRIE

→

Ortsvektor von P bezüglich O. Die Menge V3O ist die Menge aller Ortsvektoren bezüglich O. −

xO

O speziell

ist der ’Nullvektor’ (ein zum Punkt degenerierter Pfeil).

Wir haben damit eine Bijektion

E 3 → V3O

.

→

P → −

xO

P

Wir können die Punkte des E 3 und damit auch die Ortsvektoren zahlenmäßig erfassen, indem wir ein

Koordinatensystem L wählen, das seinen Ursprung in O hat und drei unabhängige Achsen (genannt

x, y, z−Achse), mit angegebenen Einheiten und Orientierungen ’positiv-negativ’, die nicht in einer Ebene

liegen. Wir identifizieren die Achsen jeweils mit der reellen Zahlengeraden. Man erhält zum Punkt P

→

(gleichwertig: zum Ortsvektor −

xO

P ) wie folgt eindeutig ein Zahlentripel und umgekehrt zu jedem Zahlentripel eindeutig einen Punkt bzw. Ortsvektor: P wird parallel zur z− Achse auf die xy− Ebene projiziert,

dann der Projektionspunkt auf parallel zur x− Achse auf die y− Achse und parallel zur y− Achse auf die

x− Achse. Die abgelesenen Zahlen sind die y− Koordinate yPL und x− Koordinate xL

P . Analog erhält man

etwa nach Projektion von P auf die xz− Ebene parallel zur y− Achse und anschließender Projektion auf

die z− Achse parallel zur y− Achse die z− Koordinate zPL . Folgendes Bild zeigt ein Koordinatensystem

als Dreibein, einen Punkt und diese Projektionsvorgänge.

z

xP

P

xP

zP

y

x

yP

Damit haben wir Bijektionen

E3

3

→ R

xL

P

→

P

→ yPL =: −

xL

P (lies: ’Koordinatendarstellung von P bezüglich K’)

L

zP

→

→

und entsprechend V3O → R3 , −

x P → −

xL

P . (Ortsvektoren bekommen also dieselben Koordinatendarstellungen wie die zugehörigen Punkte.)

Kartesische Systeme: Wir haben nicht vorausgesetzt, dass die Achsen senkrecht aufeinander stehen, auch nicht gleiche Länge der Einheiten auf den Achsen. Ist beides der Fall, so heißt das System K

kartesisch. Beim Umgang mit Längen, Winkeln, Skalar- und Vektorprodukt brauchen wir solche, vorher

aber noch nicht. Bei dreidimensionalen Koordinatensystemen wählt man die Achsen für ein kartesisches

System zusätzlich so, dass sie ein Rechtssystem bilden, d.h. wie Daumen, Zeigefinger und Mittelfinger der

rechten Hand angeordnet sind. Erst bei Skalarprodukt und Vektorprodukt benötigt man zur praktischen

Erfüllung der sich stellenden Aufgaben kartesische Systeme; für die im Folgenden besprochenen linearen

Operationen allein können die Systeme beliebig sein.

Den Nutzen der Ortsvektoren sehen wir im Abschnitt 1.4.

1.2. Affiner Raum und freie Vektoren, Vektorraumbegriff. Im vorigen Abschnitt haben wir

naiv dem Anschauungsraum bereits eine Euklidische Struktur (mit Längen- und Winkelbegriff) unterstellt, aber die gehört hier eigentlich noch gar nicht her, sondern nur die des affinen Raums. Wir setzen

1. AFFINER RAUM UND VEKTORRAUM

19

nur voraus, dass E 3 ein affiner Raum ist. Das bedeutet: Hat man zwei Punkte P, Q, so kann die Strecke

von P nach Q (dargestellt durch einen Pfeil von P nach Q) von jedem anderen Punkt R aus in eindeutiger Weise abgetragen werden. Das heißt: Der Pfeil von P nach Q kann eindeutig parallel verschoben

werden, so dass er in R beginnt und entsprechend einem eindeutig bestimmten Punkt S endet. Im Falle

P = Q ist der Pfeil wieder degeneriert. Zweitens verlangen wir: Jeder Pfeil zwischen zwei Punkten kann

eindeutig gestreckt werden mit beliebiger Zahl α ∈ R, so dass seine Länge sich mit |α| multipliziert und

im Falle α < 0 seine Pfeilrichtung zusätzlich umgedreht wird. Multiplikation mit α = 1 ändert nichts

am Pfeil. Dabei soll die erwähnte Parallelverschiebung mit der Streckung vertauschbar sein. Man beachte: Dies bedeutet einen Längenvergleich nur in einer Raumrichtung jeweils - Strecken verschiedener

Raumrichtungen können nicht miteinander verglichen werden. Außerdem hat man nur den Winkelbegriff:

’parallel - nicht parallel’, mehr nicht. Schließlich bilden wir eine Summe von Pfeilen: Der Pfeil von P

nach Q plus der Pfeil von Q nach R ist der Pfeil von P nach R, für alle Punkte P, Q, R ∈ E 3 . Auch

für die Summe fordern wir die Vertauschbarkeit mit der Parallelverschiebung. Schließlich verlangen wir

die Vertauschbarkeit der Summenbildung (konkreter Pfeile) mit allen Streckungen sowie: Strecken mit β,

dann mit α ergibt Strecken mit αβ, und Strecken mit α + β ergibt dasselbe wie Addition der Pfeile, die

durch Strecken mit α bzw. β entstehen. Damit können wir aufsetzen:

−−→

→

Ein freier Vektor −

x = P Q ist die Menge (Klasse) aller Pfeile, die durch Parallelverschiebung des

Pfeils von P nach Q entstehen. Dieser Pfeil selbst ist ein Repräsentant dieser Klasse. Mit V3 bezeichnen

wir die Menge aller freien Vektoren. Zunächst haben wir folgende Koordinatendarstellungsabbildung für

→

die freien Vektoren: Es sei wieder ein Koordinatensystem L gegeben. Dann ist −

x L die Koordinatendar−

→

stellung des Repräsentanten von x , der Ortsvektor ist, also in O beginnt. Wir haben also eine Bijektion

V3 → R3 . Nun zu den wichtigen Rechenoperationen in V3 :

−

−→

→

→

→

Die Summe zweier freier Vektoren −

x ,−

y erhält man so: Man wählt Repräsentanten, so dass −

x = PQ

−

−

→

−

→

→

→

→

und −

y = QR, dann definiert man −

x +−

y := P R. Es kommt also die Klasse der Pfeile heraus, die

durch Parallelverschieben des Pfeils von P nach R entstehen. Folgendes Bild zeigt die geometrische

Vektoraddition. Es zeigt auch, dass bei ’Hintereinandersetzen’ und ’Parallelogrammergänzung’ dasselbe

herauskommt - es sollte klar sein, dass die Bilder stets nur Repräsentanten der freien Vektoren zeigen.

b

a

a+b

b

a

−−

→

→

Die Multiplikation eines freien Vektors −

x = P Q mit einer Zahl α ∈ R erklärt man entsprechend:

→

α−

x := die Klasse der Pfeile, die durch Parallelverschiebung aus einem mit α gestreckten Repräsentanten hervorgehen. Bemerkung: Dass diese Operationen eindeutige Resultate liefern, unabhängig von der

Repräsentantenwahl jeweils, folgt aus den oben verlangten Vertauschbarkeiten mit der Parallelverschie−−

→

−

→

bung.) Der Vektor P P heißt Nullvektor und wird mit 0 bezeichnet. Folgendes Bild zeigt anschaulich die

20

2. ELEM ENTARE VEKTORRECHNUNG UND ANALYTISCHE GEOMETRIE

geometrische Streckung eines Pfeils mit einem Skalar:

a

(-1)a

2a

Diese beiden Operationen: Addition von Vektoren und Multiplikation eines Vektors mit einer reellen

Zahl (einem Skalar) heißen die linearen Operationen.

−

→

Damit wird V3 zu einem Vektorraum über dem Körper R, das heißt: V3 , +, ·, 0 hat die in

folgender Definition festgelegten Eigenschaften:

−

→

D

1. Es sei (K, +, ·, 0, 1) ein Körper. Eine Menge V mit 0 ∈ V sei gegeben mit einer

inneren Verknüpfung + : V × V → V und einer äußeren Verknüpfung · : K × V → V. heißt Vektorraum

→

→

→

über dem Körper (K, +, ·, 0, 1) , wenn folgendes Axiomensystem erfüllt ist: Für alle −

x,−

y,−

z ∈ V und

alle Zahlen α, β ∈ K gilt:

→ −

−

→

x + −

y +→

z

−

→ −

0 +→

x

−

→

−

→

−x + x

−

→

→

x +−

y

−

→

(αβ) x

→

(α + β) −

x

−

→

−

→

α x + y

=

=

=

=

=

=

=

−

→

→

→

x +−

y +−

z

−

→

x

−

→

0

−

→

→

y +−

x

−

→

α βx

→

→

α−

x + β−

x

−

→

−

→

αx +αy

→

→

1·−

x = −

x

Bemerkung: Wie üblich haben wir Multiplikationszeichen sowohl bei ’Zahl mal Vektor’ als auch

’Zahl mal Zahl’ fortgelassen außer beim letzten Axiom. Ferner beachte man, dass ’+’ in α+β die Addition

→

→

→

der Zahlen im Körper meint, dagegen ’+’ in −

x +−

y die Addition der Vektoren in V . Ebenso ist bei α−

x

−

→

die Multiplikation des Skalars (der Zahl) α mit dem Vektor x gemeint, aber bei αβ die Multiplikation der

Zahlen α, β im Körper. Eigentlich hätte man das wie +V , +K und ·V , ·K zur Unterscheidung schreiben

müssen, aber das wäre sehr unübersichtlich. Außerdem ist die Nichtunterscheidung in der Bezeichnung

gerechtfertigt duch folgende Tatsache, die sich aus den Axiomen ergibt:

Man rechnet mit Ausdrücken der Vektorrechnung (Zahlterme und Vektorterme mit den

linearen Operationen) wie mit Zahlen,

nur kann man nicht etwa durch Vektoren teilen.

−

→

Es ist zu beobachten, dass V, +, 0 mit den ersten vier Axiomen gerade eine abelsche Gruppe wird.

Sehr wichtig sind die beiden Distributivgesetze (vorletztes und drittletztes Axiom).

1. AFFINER RAUM UND VEKTORRAUM

21

Zur Begründung

der

Gültigkeit der Axiome für V3 wollen nur zwei

Bilder

zeigen, welche das Assozia−

→

−

→

−

→

−

→

−

→

→

5

5

5

tivgesetz a + b + c = ( a + b)+ c und das Distributivgesetz λ a + b = λ−

a + λ5b veranschaulichen:

a

b

b+c

a+b

c

(a+b)+c = a+(b+c)

λb

λa

λ (a+b)

b

a

a+b

Bei einem Vektorraum trifft man stets folgende Definiton und kann die anschließenden Folgerungen

ziehen:

→

→

→

→

D

2 (Differenz von Vektoren). −

x −−

y := −

x + −−

y

Anschaulich hat man:

a-b

b

a

22

2. ELEM ENTARE VEKTORRECHNUNG UND ANALYTISCHE GEOMETRIE

−

→ → −

→ →

Man verifiziere im Bild: b + −

a − b =−

a , und merke sich die Anordnung.

→

→

F

1. Für alle Vektoren −

x ,−

y ∈ V und alle Zahlen α ∈ K gilt:

−

→

−

→

0x = 0

→

→

→

→

(−α)−

x = − α−

x , insbesondere − −

x = (−1) −

x

−

→

−

→

−

→

−

→

α x − y

= αx −αy.

→

−

→ −

→ −

→

→

→

→

→

Begründungen liefert man leicht: 0 = 0 + 0 , also 0−

x = (0 + 0) −

x = 0−

x + 0−

x , Addition von − 0−

x

−

→

−

→

−

→

−

→

liefert nun mit Assoziativgesetz und Inversengesetz 0 = 0 x . Zur zweiten Gleichung: (−α) x + α x =