1 Ergänzungen zu Statistik II

Werbung

QM2 15

1

1.1

1

Ergänzungen zu Statistik II

Stichprobenverteilungen

Produkträume.

In diesem Abschnitt geht es darum, einen geeigneten Wahrscheinlichkeitsraum

für die unabhängige Durchführung zweier Experimente zu konstruieren. Die Konstruktion soll nur an einem Beispiel durchgeführt werden, wobei jedoch klar werden dürfte, wie diese Konstruktion dann im allgemeinen Fall aussieht.

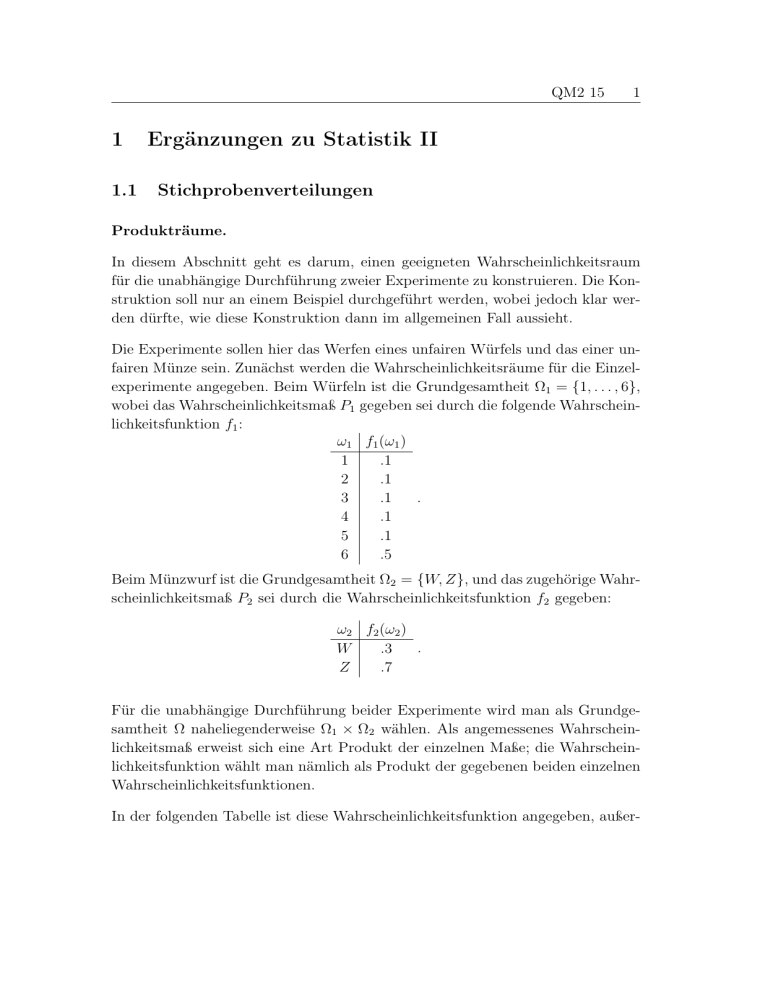

Die Experimente sollen hier das Werfen eines unfairen Würfels und das einer unfairen Münze sein. Zunächst werden die Wahrscheinlichkeitsräume für die Einzelexperimente angegeben. Beim Würfeln ist die Grundgesamtheit Ω1 = {1, . . . , 6},

wobei das Wahrscheinlichkeitsmaß P1 gegeben sei durch die folgende Wahrscheinlichkeitsfunktion f1 :

ω1 f1 (ω1 )

1

.1

2

.1

.

.1

3

4

.1

5

.1

6

.5

Beim Münzwurf ist die Grundgesamtheit Ω2 = {W, Z}, und das zugehörige Wahrscheinlichkeitsmaß P2 sei durch die Wahrscheinlichkeitsfunktion f2 gegeben:

ω2 f2 (ω2 )

.

W

.3

Z

.7

Für die unabhängige Durchführung beider Experimente wird man als Grundgesamtheit Ω naheliegenderweise Ω1 × Ω2 wählen. Als angemessenes Wahrscheinlichkeitsmaß erweist sich eine Art Produkt der einzelnen Maße; die Wahrscheinlichkeitsfunktion wählt man nämlich als Produkt der gegebenen beiden einzelnen

Wahrscheinlichkeitsfunktionen.

In der folgenden Tabelle ist diese Wahrscheinlichkeitsfunktion angegeben, außer-

1.1

Stichprobenverteilungen

QM2 15

2

dem stehen die ‚Faktoren‘ am Rand der Tabelle:

ω1 \ω2

1

2

3

4

5

6

W

.03

.03

.03

.03

.03

.15

.3

Z

.07

.07

.07

.07

.07

.35

.7

.1

.1

.1

.

.1

.1

.5

1

Dass die durch die Tabelle gegebene Funktion auf Ω1 × Ω2 tatsächlich eine Wahrscheinlichkeitsfunktion ist, rechnet man unmittelbar nach (die Summe der Zahlen

ist 1). Man macht sich auch leicht klar, dass dies so sein muss, denn zunächst

ergeben sich die Zahlen am rechten und unteren Rand durch zeilen- bzw. spaltenweises Aufsummieren (was nach Konstruktion offenbar so sein muss), und dann

ist die Summe dieser Summen jeweils 1, da ja jeweils die Werte einer Wahrscheinlichkeitsfunktion aufsummiert werden.

Betrachtet man auf dem so definierten Wahrscheinlichkeitsraum nun die beiden

‚Projektionen‘, die einem Paar (ω1 , ω2 ) einerseits ω1 und andererseits ω2 zuordnen

(inhaltlich heißt das, dass die Ergebnisse der Teilversuche isoliert betrachtet werden), so erhält man als Kontingenztafel dieser beiden Zufallsvariablen genau die

gerade untersuchte Tabelle. Man beachte allerdings, dass mit den beiden formal

gleich aussehenden Tabellen konzeptuell verschiedene Sachverhalte beschrieben

werden: einmal wird ein Wahrscheinlichkeitsmaß definiert und einmal eine Kontingenztafel zweier Zufallsvariablen angegeben.

Um dies auch formal korrekt aufzuschreiben, seien K1 und K2 die Funktionen auf

Ω1 ×Ω2 , die gerade die erste bzw. zweite Komponente eines Elementes von Ω1 ×Ω2

liefern; es gilt also K1 (ω1 , ω2 ) = ω1 und K2 (ω1 , ω2 ) = ω2 (eigentlich müsste man

K1 ((ω1 , ω2 )) schreiben). Die Funktionen K1 und K2 sind dann Zufallsvariablen

auf Ω1 × Ω2 mit Werten in Ω1 bzw. Ω2 . Die Tabelle oben kann dann auch als die

Kontingenztafel der gemeinsamen Verteilung von K1 und K2 gelesen werden.

Da in der Tabelle, als Kontingenztafel aufgefasst, sich die Zahlen als Produkte

der Randsummen ergeben, sind die beiden Projektionen unabhängig. Man hat

also insgesamt einen Wahrscheinlichkeitsraum für das zusammengesetzte Experiment definiert, bei dem die beiden Zufallsvariablen, die das Ergebnis der beiden

Teilexperimente angeben, einerseits unabhängig sind und andererseits die gleiche

1.1

Stichprobenverteilungen

QM2 15

3

Verteilung haben, wie die Ergebnisse der isoliert betrachteten Teilexperimente.

Damit erweist sich die Konstruktion des Wahrscheinlichkeitsmaßes auf Ω1 × Ω2

als angemessen, da dieses Wahrscheinlichkeitsmaß nun genau die Bedingungen

erfüllt, die sinnvoll von ihm zu fordern sind.

Das so konstruierte Maß bezeichnet man auch als das Produktmaß von P1 und

P2 . Als Abkürzung dient oft die Schreibweise P1 ⊗ P2 .

Nun mögen für das Würfeln und für das Münzwerfen zwei Gewinnspiele durch

zwei Zufallsvariablen definiert sein. Die Zufallsvariable X1 auf Ω1 und die Zufallsvariable X2 auf Ω2 sollen durch die folgenden Tabellen gegeben sein:

ω1 X1 (ω1 )

1

0

2

−2

3

−2

3

4

5

−2

6

3

ω2 X2 (ω2 )

.

W

−1

1

Z

Die Zufallsvariablen geben den Gewinn bzw. Verlust bei den einzelnen Spielen

an. Wären Würfel und Münze fair, so wären auch diese Spiele fair; so sind sie es

offenbar nicht.

Es geht nun darum, wie man das Spiel beschreibt, das aus den beiden einzelnen

Spielen zusammengesetzt ist, bei dem also jedesmal sowohl ein Würfel als auch

eine Münze geworfen werden. Auch hier sollen die beiden Einzelgewinne durch

zwei Zufallsvariable gegeben sein, die jetzt allerdings auf Ω1 × Ω2 definiert sein

sollen.

Ist das Ergebnis des zusammengesetzten Experiments gleich (ω1 , ω2 ), so soll natürlich der Gewinn des Würfelanteils des Spiels gleich X1 (ω1 ) sein und der des

Münzwurfanteils gleich X2 (ω2 ).

Ist das Ergebnis des zusammengesetzten Experiments also beispielsweise (3, W ),

so ist der Gewinn aus dem Würfelteil gleich X1 (3) = −2 und der Gewinn aus

dem Münzteil gleich X2 (W ) = −1.

Die Einzelgewinne aus dem zusammengesetzten Experiement sollen der Deutlichkeit halber hier mit X10 und X20 bezeichnet werden. Dies ist eine etwas umständliche Formulierung, die jedoch den momentanen Zwecken angemessen ist.

1.1

Stichprobenverteilungen

QM2 15

4

Normalerweise würde man die Einzelgewinne wieder mit X1 und X2 bezeichnen,

was allerdings nicht ganz korrekt ist, da die Symbole X1 und X2 schon verbraucht

sind (die verständige Leserin entnähme aber leicht dem Kontext, was jeweils gemeint ist).

Der Unterschied, auf den hier aufmerksam gemacht werden soll, liegt im Definitionsbereich; der Definitionsbereich von X10 und X20 ist Ω1 × Ω2 , während die

Definitionsbereiche von X1 und X2 hingegen Ω1 und Ω2 sind. Der Zusammenhang ist jedoch eng: es gilt Xi0 (ω1 , ω2 ) = Xi (ωi ) (eigentlich wäre Xi0 ((ω1 , ω2 )) zu

schreiben).

Es gilt dann also beispielsweise X10 (3, W ) = X1 (3) = −2.

Die gemeinsame Verteilung der beiden neuen (auf Ω1 × Ω2 definierten) Zufallsvariablen X10 und X20 lässt sich nun leicht angeben:

x1 \x2

−2

0

3

−1 1

.09 .21 .3

.03 .07 .1 .

.18 .42 .6

.3 .7 1

Man prüft sofort nach, dass die beiden Zufallsvariablen unabhängig sind und die

gleichen Verteilungen besitzen wie die entsprechenden Zufallsvariablen aus den

Einzelversuchen.

Die Unabhängigkeit ist natürlich keineswegs zufällig. Vielmehr liegt hier ein Spezialfall einer etwas allgemeineren Tatsache vor, die nun zunächst ergänzend behandelt werden soll.

Sind nämlich X und Y zwei unabhängige Zufallsvariablen auf einem Wahrscheinlichkeitsraum Ω, und sind g(X) und h(Y ) zwei Funktionen dieser Zufallsvariablen

(also neue Zufallsvariablen), so sind auch g(X) und h(Y ) unabhängig.

Zur Begründung hat man für zwei beliebige Mengen A und B aus dem Wertebereich von g und h die Unabhängigkeitsbedingung nachzuweisen, also zu zeigen,

dass (g(X))−1 (A) und (h(Y ))−1 (B) unabhängig sind. Nun ist aber (g(X))−1 (A) =

X −1 (g −1 (A)), da für ein Element ω ∈ Ω offenbar (g(X))(ω) = g(X(ω)) genau dann in A liegt, wenn X(ω) in g −1 (A) liegt, denn dies bedeutet ja genau,

dass g(X(ω)) ∈ A gilt. Entsprechend ist (h(Y ))−1 (B) = Y −1 (h−1 (B)). Aus der

Unabhängigkeit von X und Y folgt nun aber sofort die Unabhängigkeit von

1.1

Stichprobenverteilungen

QM2 15

5

X −1 (g −1 (A)) und Y −1 (h−1 (B)) und damit die Gesamtbehauptung.

Um diese allgemeine Tatsache nun auf den vorliegenden Fall anzuwenden, seien die beiden ‚Projektionen‘ von Ω1 × Ω2 auf Ω1 und Ω2 wieder mit K1 und

K2 bezeichnet. Die beiden untersuchten Variablen sind dann X10 = X1 (K1 ) und

X20 = X2 (K2 ) (es gilt ja offenbar X10 (ω1 , ω2 ) = X1 (ω1 ) = X1 (K1 (ω1 , ω2 )) =

(X1 (K1 ))(ω1 , ω1 ), entsprechend für X2 ).

Damit folgt die Unabhängigkeit von X10 und X20 aus der Unabhängigkeit von K1

und K2 gemäß der gerade behandelten allgemeineren Tatsache, wenn man dort

X = K1 , Y = K2 , g = X1 und h = X2 setzt.

Insgesamt ist es so gelungen, für zwei isolierte Experimente, deren (für einen

bestimmten Zweck - im Beispiel das Budget des Spielers) wesentliche Resultate

durch zwei Zufallsvariablen beschrieben werden, einen Wahrscheinlichkeitsraum

zu konstruieren, der die gemeinsame unabhängige Durchführung der Experimente beschreibt, und auf diesem zwei Zufallsvariablen zu definieren, die wieder die

wesentlichen Resultate der Einzelexperimente beschreiben, und die zusätzlich unabhängig sind.

Der Unterschied zwischen X1 und X10 (ebenso zwischen X2 und X20 ) liegt im Grunde nur darin, dass bei X10 noch ein weiteres Experiment sozusagen im Hintergrund

mit abläuft und bei X1 nicht, was in den unterschiedlichen Definitionsbereichen

zum Ausdruck kommt. Die Verteilungen von X1 und X10 sind hingegen gleich.

Genau auf die gleiche Art kann man für mehr als zwei Einzelexperimente einen

Wahrscheinlichkeitsraum definieren, der deren gemeinsame unabhängige Durchführung beschreibt; auch hier können wesentliche Resultate durch dann unabhängige Zufallsvariablen hervorgehoben werden.

Insbesondere ist es möglich, für vorgegebene Verteilungen einen Wahrscheinlichkeitsraum zu konstruieren, auf dem Zufallsvariablen definiert werden können, die

gerade die gegebenen Verteilungen besitzen und die zusätzlich unabhängig sind.

Dies ist für theoretische Zwecke, beispielsweise bei der Definition neuer Verteilungen, von entscheidender Wichtigkeit.

Ein Spezialfall kommt besonders häufig vor, nämlich der, dass dasselbe Experiment unabhängig mehrfach wiederholt wird.

In diesem Fall sei der angemessene Wahrscheinlichkeitsraum für die einmalige

Durchführung Ω0 mit dem Wahrscheinlichkeitsmaß P0 ; ein wesentliches Resultat

1.1

Stichprobenverteilungen

QM2 15

6

sei durch eine Zufallsvariable X gegeben.

Der Wahrscheinlichkeitsraum für die n-malige unabhängige Durchführung des

Experiments ist dann Ω = Ωn0 , versehen mit dem entsprechend den obigen Überlegungen zu definierenden Wahrscheinlichkeitsmaß P = P0 ⊗ P0 ⊗ . . . ⊗ P0 .

Die für die Versuche wesentlichen Resultate können dann durch Zufallsvariablen X1 , . . . , Xn beschrieben werden, von denen Xi gerade das Resultat des i-ten

Teilversuchs liefert; genauer gilt also

Xi (ω1 , . . . , ωn ) = X(ωi ) .

Diese Zufallsvariablen X1 , . . . , Xn sind gemeinsam unabhängig und besitzen alle

die gleiche Verteilung wie X.

Für diese Situation benutzt man auch abkürzend die Sprechweise, dass X1 , . . . , Xn

unabhängige Versionen von X sind.

Stichprobenverteilung von Varianzen und Kovarianzen.

Als Ausgangssituation seien X1 , . . . , Xn unabhängige Versionen einer Zufallsvariable X mit E(X) = µ und V(X) = σ 2 . Beschreibt man mit diesen Variablen die

Resultate von n unabhängigen Durchführungen eines Zufallsversuchs, so handelt

es sich hier um eine Stichprobe (die allerdings erst noch zu erheben ist).

Auf der Grundlage dieser Werte kann man dann die Varianz

S2 =

1X

(Xi − M )2

n

mit

M=

1X

Xi

n

2

mit den Xi also eine Zufallsvariable.

bilden. Hier ist SX

Für den Erwartungswert von S 2 gilt dann

E(S 2 ) =

n−1 2

σ ,

n

wie nun gezeigt werden soll.

Zunächst sei daran erinnert, dass für jede Zufallsvariable X die Beziehung

E(X 2 ) = V(X) + (E(X))2

(1)

gilt; dies ist nur die Umstellung der bekannten Formel V(X) = E(X 2 ) − (E(X))2 .

1.1

Stichprobenverteilungen

QM2 15

7

Die Varianz S 2 lässt sich nun bekanntlich auch schreiben als

S 2 = MX 2 − (MX )2 ,

woraus für den Erwartungswert die Beziehung

E(S 2 ) = E(MX 2 ) − E((MX )2 )

(2)

folgt; es sollen daher nun die beiden Erwartungswerte auf der rechten Seite dieser

Gleichung bestimmt und dann subtrahiert werden.

Zuerst geht es um MX 2 , also um den Mittelwert der Xi2 . Da die Xi unabhängige

Versionen von X sind, sind auch die Xi2 unabhängige Versionen von X 2 : da die

Verteilungen von Xi und X gleich sind, sind auch die Verteilungen von Xi2 und

X 2 gleich, und da die Xi unabhängig sind, sind auch die Xi2 unabhängig (vgl. den

Abschnitt über Produkträume für die Begründung im Fall von zwei Variablen).

Es folgt, dass der Erwartungswert von MX 2 gleich dem Erwartungswert von X 2

ist, womit sich nach (1) insgesamt

E(MX 2 ) = E(X 2 ) = σ 2 + µ2

(3)

ergibt.

Der nächste zu bestimmende Wert ist E((MX )2 ). Bekannt ist die Varianz von

MX , nämlich σ 2 /n. Setzt man in (1) für X den Mittelwert MX ein, so erhält man

E((MX )2 ) = V(MX ) + (E(MX ))2 =

σ2

+ µ2 .

n

(4)

Durch Einsetzen von (3) und (4) in (2) erhält man nun schließlich das gewünschte

Resultat

E(S 2 ) = E(MX 2 ) − E((MX )2 )

2

σ

σ2

n−1 2

2

2

2

= σ +µ −

+µ

= σ2 −

=

σ . n

n

n

Die Stichprobenvarianz S 2 ist also kein erwartungstreuer Schätzer für σ 2 , was

sich aber leicht korrigieren lässt: die korrigierte Stichprobenvarianz

s2 =

n

S2

n−1

1.1

Stichprobenverteilungen

QM2 15

8

schätzt σ 2 erwartungstreu.

Es liegt damit die Frage nahe, ob man etwas über den Erwartungswert von s

aussagen kann. Da Varianzen nichtnegativ sind, gilt immerhin

0 ≤ V(s) = E(s2 ) − (E(s))2 ,

woraus über (E(s))2 ≤ E(s2 ) die Beziehung

√

p

p

E(s) = (E(s))2 ≤ E(s2 ) = σ 2 = σ

folgt.

Gleichheit gilt hier nur in dem Fall, dass V(s) = 0 gilt, was nur dann eintritt,

wenn die möglichen Stichproben mit Wahrscheinlichkeit 1 die Varianz 0 haben,

also aus lauter gleichen Werten bestehen, was wiederum nur dann möglich ist,

wenn X nur einen möglichen Wert (mit Wahrscheinlichkeit 1) annehmen kann.

Der Fall der Gleichheit tritt also nur für völlig uninteressante Zufallsvariablen X

auf, die fast sicher konstant sind.

Bei Zufallsvariablen, die nicht (f.s.) konstant sind, gilt daher immer

E(s) < σ ,

durch s wird σ also ‚systematisch‘ unterschätzt.

Schließlich soll noch die Frage nach dem Erwartungswert der Stichprobenkovarianz beantwortet werden.

Man kann diese Frage auf die schon bekannten Ergebnisse über die Varianz zurückführen, indem man die folgende Beziehung ausnutzt:

V(X + Y ) − V(X − Y )

= V(X) + V(Y ) + 2 Kov(X, Y ) − (V(X) + V(Y ) − 2 Kov(X, Y ))

= 4 Kov(X, Y ) .

Die Kovarianz lässt sich also auch mit Hilfe der Varianz der Summe und der

Differenz ausdrücken.

Ganz analog erhält man auf empirischer Ebene die Formel

2

2

SX+Y

− SX−Y

= 4 KovX,Y .

1.1

Stichprobenverteilungen

QM2 15

9

Mit Hilfe dieser Formeln kann nun der Erwartungswert der Stichprobenkovarianz

bestimmt werden. Vorausgesetzt sind dabei wieder n unabhängige Versuche, in

denen nun zwei Variablen X und Y erhoben werden sollen. Schreibt man für

die Resultate der einzelnen Durchgänge wieder Xi und Yi , so kann man diese

Voraussetzung formal auch so schreiben, dass (X1 , Y1 ), . . . , (Xn , Yn ) unabhängige

Versionen der (nun ‚zweidimensionalen‘) Zufallsvariable (X, Y ) sein sollen.

Der Erwartungswert der Stichprobenkovarianz ist nun

1 2

1

2

2

2

E(KovX,Y ) = E

(SX+Y − SX−Y ) =

E(SX+Y

) − E(SX−Y

)

4

4

n−1

1 n−1

V(X + Y ) −

V(X − Y )

=

4

n

n

n−1 1

=

(V(X + Y ) − V(X − Y ))

n

4

n−1

Kov(X, Y ) .

=

n

Auch hier ist es also so, dass die Stichprobenkovarianz (im Betrag) die theoretische Kovarianz systematisch unterschätzt, was man leicht dadurch korrigieren

kann, dass man zur korrigierten Stichprobenkovarianz

n

KovX,Y

n−1

übergeht, die dann für Kov(X, Y ) erwartungstreu ist; die korrigierte Stichprobenkovarianz errechnet man dabei genauso wie die unkorrigierte, außer dass man im

letzten Schritt nicht durch n sondern durch (n − 1) dividiert.

Anmerkung zur Definition der Binomialverteilung.

Sind X1 , . . . , Xn unabhängige Versionen einer Variable X, die Bernoulli-verteilt

ist mit Erfolgswahrscheinlichkeit p, und ist

Y =

n

X

Xi ,

i=1

so heißt die Verteilung von Y auch Binomialverteilung mit den Parametern n und

p.

Die Abkürzung für diese Verteilung ist B(n, p).

1.1

Stichprobenverteilungen

QM2 15

10

Hat eine Variable U die B(n, p)-Verteilung, so schreibt man dafür auch kurz

U ∼ B(n, p).

Zu der Definition der Binomialverteilung ist anzumerken, dass hier eine Verteilung

definiert wird dadurch, dass eine Variable konstruiert wird, die diese Verteilung

besitzt (nämlich Y ).

Es geht dabei um die Definition einer Verteilung und nicht etwa um die Definition einer binomialverteilten Variable. Eine binomialverteilte Variable ist eine

Variable, deren Verteilung eine Binomialverteilung ist; keinesfalls muss eine solche Variable gleich einer Summe unabhängiger Bernoulli-verteilter Variablen sein

(auch wenn dies in vielen Fällen so sein wird).

Will man nun Eigenschaften von binomialverteilten Variablen zeigen (beispielsweise eine Formel für den Erwartungswert angeben), so genügt es oft, eine spezielle binomialverteilte Variable wie die Variable Y in der Definition zu benutzen;

sind die Eigenschaften nämlich nur abhängig von der Verteilung, so ist es gleichgültig, welche Variable bei der Argumentation benutzt wird, da das Ergebnis bei

allen Variablen das gleiche sein muss.

Der Erwartungswert lässt sich beispielsweise auch nur auf der Grundlage der

Verteilung berechnen (ist f die Wahrscheinlichkeitsfunktion der Verteilung, so

P

ist der Erwartungswert gleich

xf (x), wobei über alle möglichen Werte x der

Verteilung summiert wird). Daher haben alle Zufallsvariablen, die die gleiche

Verteilung besitzen, auch den gleichen Erwartungswert – in diesem Sinn hängt

der Erwartungswert nur über die Verteilung von der Zufallsvariable ab. Man kann

deshalb auch (nicht ganz korrekt) vom Erwartungswert der Binomialverteilung

sprechen (obwohl streng genommen nicht Verteilungen Erwartungswerte besitzen,

sondern Zufallsvariablen).

Um den Erwartungswert der B(n, p)-Verteilung (in diesem Sinn) zu bestimmen,

genügt es also, eine spezielle Variable mit dieser Verteilung zu benutzen (wie die

Variable Y in der Definition) und von dieser Variable den Erwartungswert zu

bilden (der sich für Y sofort zu n · p berechnet); jede andere Variable mit der

B(n, p)-Verteilung hat dann ebenfalls diesen Erwartungswert.

Als ein weiteres Beispiel soll gezeigt werden, dass die Verteilung von zwei unabhängigen binomialverteilten Variablen mit gleicher Erfolgswahrscheinlichkeit wieder binomialverteilt ist. Sind nämlich genauer Y1 ∼ B(n1 , p) und Y1 ∼ B(n2 , p)

1.1

Stichprobenverteilungen

QM2 15

11

unabhängig, und ist Y = Y1 + Y2 , so gilt

Y ∼ B(n1 + n2 , p) .

Zur Begründung seien X1 , . . . , Xn1 , Xn1 +1 , . . . , Xn1 +n2 unabhängige Bernoulli-verteilte Variablen mit Erfolgswahrscheinlichkeit p. Dass es solche Variablen gibt, ist

vielleicht nicht ganz selbstverständlich – man konstruiert sie jedoch beispielsweise

mit den bei den Produkträumen skizzierten Methoden.

Mit den Variablen Xi bildet man nun neue Variablen U1 und U2 als

U1 :=

n1

X

i=1

Xi

und

U2 :=

nX

1 +n2

Xi .

i=n1 +1

Dann gilt U1 ∼ B(n1 , p) und U1 ∼ B(n2 , p), U1 und U2 haben also die gleichen

Verteilungen wie Y1 und Y2 . Außerdem sind U1 und U2 unabhängig, was plausibel

ist, da ja die Xi , deren Summe sie jeweils sind, unabhängig sind (streng genommen

müsste dies allerdings auch noch genauer gezeigt werden).

Damit haben auch U1 und U2 die gleiche gemeinsame Verteilung wie Y1 und Y2 ,

denn die gemeinsame Verteilung ist durch die Einzelverteilungen und die Tatsache

der Unabhängigkeit schon vollständig bestimmt.

Schließlich ist auch die Verteilung von U = U1 + U2 gleich der von Y = Y1 + Y2 ,

denn es handelt sich bei diesen beiden Verteilungen um die Bildmaße der gleichen

W-Maße (Verteilungen von (U1 , U2 ) bzw. (Y1 , Y2 )) unter der gleichen Funktion

(Addition der beiden Komponenten).

P 1 +n2

Da jedoch nun U = ni=1

Xi die Summe von n1 + n2 unabhängigen BernoulliVariablen ist, ist die Verteilung von U eine B(n1 + n2 , p)-Verteilung und damit

auch die von Y . Multinomialverteilung.

Die Binomialverteilung kann verallgemeinert werden für den Fall, dass ein Versuch

nicht nur zwei mögliche Ergebnisse hat, sondern mehrere, nämlich e1 . . . , em , die

mit Wahrscheinlichkeiten p1 , . . . , pm auftreten.

Gefragt ist nach den Wahrscheinlichkeiten, mit denen bei n unabhängigen VersuP

chen die Werte ei jeweils genau ni Mal auftreten (dabei muss natürlich

ni = n

gelten).

1.1

Stichprobenverteilungen

QM2 15

12

Die gesuchte Verteilung ermittelt man völlig analog zum Vorgehen bei der Binomialverteilung; die Frage ist zunächst die, mit welcher Wahrscheinlichkeit ein

bestimmtes Gesamtergebnis auftritt, bei dem die Einzelwerte ei mit vorgegebenen

Häufigkeiten ni auftreten, wobei zusätzlich noch vorgeschrieben ist, bei welchem

Versuchsdurchgang welches Einzelergebnis auftreten soll. Wegen der Unabhängigkeit der Ziehungen ist die Wahrscheinlichkeit für jede solche spezielle Konstallation gleich

pn1 1 pn2 2 . . . pnmm ;

die Begründung ist völlig analog zu der im Fall der Binomialverteilung.

Die als nächstes zu beantwortende Frage ist die, wieviele derartige Gesamtergebnisse es gibt, bei denen vorgeschrieben ist, dass die Einzelergebnisse ei mit

den Häufigkeiten ni auftreten, wobei es nun jedoch gleichgültig ist, an welcher

Stelle welches Einzelergebnis auftritt. Ganz analog zu den Überlegungen bei der

Binomialverteilung ergibt sich hier als Anzahl der Multinomialkoeffizient

n!

.

n1 !n2 ! . . . nm !

Man fragt sich zur Begründung beispielsweise, auf wieviele Arten man die Menge

G der Nummern der Ziehungen so auf m Mengen Gi aufteilen kann, dass diese

Mengen jeweils genau ni Elemente enthalten. Die Menge Gi soll dabei gerade die

Nummern der Ziehungen enthalten, in denen das Ergebnis ei ist.

Insgesamt ist damit die Wahrscheinlichkeit, bei n unabhängigen Ziehungen die

Wertekombinationen ei mit den Häufigkeiten ni zu erhalten, gerade

n!

pn1 1 pn2 2 . . . pnmm .

n1 !n2 ! . . . nm !

Die Verteilung, die sich auf diese Weise ergibt, heißt auch Multinomialverteilung,

wobei offensichtlich ist, dass die Binomialverteilung gerade der Spezialfall ist, in

der die betrachtete Variable zwei mögliche Werte besitzt.

Zur Kontrolle kann man sich fragen, ob die Summe dieser Wahrscheinlichkeiten

über alle möglichen Häufigkeitskombinationen n1 , . . . , nm auch wirklich gleich 1

ist; dies folgt jedoch wie im Fall der Binomialverteilung aus der beim Multinomialkoeffizienten behandelten Gleichung

!n

m

X

X

n!

pn1 1 pn2 2 . . . pnmm ,

1 = 1n =

pi

=

n

!

n

!

.

.

.

n

!

1

2

m

i=1

(n1 ,...,nm )

in der über alle m-Tupel (n1 , . . . , nm ) summiert wird, die aus nichtnegativen

ganzen Zahlen bestehen, deren Summe n ist.

1.2

1.2

Stetige Verteilungen

QM2 15

13

Stetige Verteilungen

Die Einführung stetiger Zufallsvariablen erfordert einige Erweiterungen und Modifikationen der bisher betrachteten Wahrscheinlichkeitstheorie, die ja nur für

endliche Grundgesamtheiten galt. Diese Modifikationen erfordern mathematische

Voraussetzungen, die hier nicht zur Verfügung stehen. Trotzdem soll nun ein ungefährer Eindruck gegeben werden, welcher Art sie sind.

Die wesentliche Änderung ist die, dass nun unendliche Grundgesamtheiten zugelassen werden müssen, da Zufallsvariablen auf endlichen Grundgesamtheiten

nicht stetig sein können.

Man hat also den Begriff des Wahrscheinlichkeitsraums zu verallgemeinern in der

Weise, dass keine Einschränkungen über die Zahl der Ergebnisse gemacht werden.

Die Grundgesamtheiten Ω können also nun auch aus unendlich vielen Elementen

(Ergebnissen) bestehen. Es können dann die Wahrscheinlichkeiten einiger oder

sogar aller Ergebnisse gleich 0 sein (die Formulierung ist nicht ganz korrekt, gemeint sind natürlich die Wahrscheinlichkeiten von Ereignissen, die aus nur einem

Ergebnis bestehen).

Um Widersprüche zu vermeiden, muss man die Gleichsetzung von Ereignissen mit

Teilmengen von Ω aufgeben: Nur noch gewisse Teilmengen von Ω sind Ereignisse

und nicht mehr alle.

Zu Widersprüchen in einer ähnlichen Situation führt beispielsweise die Annahme

der Existenz eines Flächenmaßes auf dem R2 , das für alle Teilmengen definiert

ist und drei Eigenschaften besitzt, die man intuitiv von einem Flächenmaß fordern würde. Diese drei Eigenschaften sind die folgenden: Erstens soll das Maß

für Rechtecke sich als Breite mal Höhe berechnen. Zweitens soll das Maß einer

abzählbaren Vereinigung von disjunkten Teilmengen gleich der Summe der Maße der einzelnen Mengen sein (dies verallgemeinert das Analogon zum dritten

Axiom für endliche W-Räume). Drittens soll das Maß ‚translationsinvariant‘ sein

in dem Sinne, dass das Maß einer Menge (Fläche) sich nicht ändert, wenn man

diese Menge verschiebt. Gäbe es nun ein Flächenmaß mit diesen Eigenschaften,

so könnte man eine Teilmenge ‚konstruieren‘, deren Maß sowohl 0 als auch größer als 0 sein müsste. Hieraus folgt, dass ein derartiges Flächenmaß, das für alle

Teilmengen definiert ist, nicht existieren kann.

Wenn nun nicht mehr alle Teilmengen Ereignisse sein können, so wird man von

den Ereignissen immerhin fordern, dass die Mengenoperationen der Vereinigung,

1.2

Stetige Verteilungen

QM2 15

14

Durchschnittsbildung und Komplementbildung von Ereignissen wieder zu Ereignissen führen, denn diese Operationen haben ja für Ereignisse eine inhaltliche

Interpretation. Genauer fordert man, dass man beim Bilden von Komplementen und von abzählbar unendlichen Vereinigungen immer wieder Ereignisse erhält (ferner soll ∅ immer ein Ereigis sein). Die Menge der Teilmengen, die dann

Ereignisse sind, erhält durch diese Forderung eine Struktur, nämlich die einer

sogenannten σ-Algebra. Sie heißt daher auch manchmal Ereignisalgebra.

Die Definition eines Wahrscheinlichkeitsmaßes im allgemeinen Fall ist etwas komplizierter als im endlichen Fall; betroffen ist das dritte Axiom. Hier wird nun

gefordert, dass die Wahrscheinlichkeit einer abzählbar unendlichen Vereinigung

von disjunkten Ereignissen gleich der Summe der Wahrscheinlichkeiten dieser Ereignisse ist; statt um nur endlich viele Mengen geht es also jetzt um abzählbar

unendlich viele.

Die Begriffe des Erwartungswertes und der Varianz können nun auch nicht mehr

einfach durch Summationen definiert werden, vielmehr ist hierfür die Konstruktion eines geeigneten Integrals nötig.

Für den Erwartungswert und die Varianz (deren Definition nun einen geeigneten Integralbegriff voraussetzt), gelten dann weitgehend die gleichen Regeln und

Gesetze wie im endlichen Fall, so dass man die im endlichen Fall gewonnenen

Intuitionen weiter verwenden kann. Allerdings gibt es auch hier neue Probleme.

So gibt es nun gelegentlich reelle Zufallsvariablen, die keinen Erwartungswert

besitzen oder solche, deren Varianz unendlich groß ist.

Was die Unabhängigkeit von Zufallsvariablen angeht, so ist nun die alte Definition

nicht mehr tauglich. Nach dieser Definition waren ja zwei Zufallsvariablen X und

Y unabhängig, wenn für alle möglichen Werte x und y die Beziehung

P(X = x, Y = y) = P(X = x) P(Y = y)

galt. Da es nun möglich ist, dass alle denkbaren Werte x und y die Wahrscheinlichkeit 0 haben, wird diese Definition unbrauchbar. Die Definition der Unabhängigkeit im allgemeinen Fall ist die, dass für ‚zulässige‘ Teilmengen A und B nun

immer die Beziehung

P(X ∈ A, Y ∈ B) = P(X ∈ A) P(Y ∈ B)

gelten soll. Da diese Eigenschaft für endliche Wahrscheinlichkeitsräume sich als

äquivalent zur dortigen Definition erwiesen hatte, stehen die beiden Definitionen

1.2

Stetige Verteilungen

QM2 15

15

nicht im Widerspruch zueinander, vielmehr ist die frühere ein Spezialfall der

allgemeineren.

Die Multinormalverteilung.

Die Zufallsvariablen X1 , . . . , Xn heißen multinormalverteilt oder gemeinsam normalverteilt, wenn jede Linearkombination dieser Variablen, die nicht Varianz 0

besitzt, normalverteilt ist.

P

Jede Variable der Form

ai Xi + b, deren Varianz nicht 0 ist, soll also normalverteilt sein.

Insbesondere sind dann Summen oder Differenzen gemeinsam normalverteilter

Variablen normalverteilt, sofern ihre Varianz nicht 0 ist. Das gleiche gilt für die

Variablen Xi selber, da beispielsweise X1 = 1 · X1 + 0 · X2 + . . . + 0 · Xn + 0 eine

solche Linearkombination ist (entsprechend auch die anderen Xi ).

Sind X1 , . . . , Xn multinormalverteilt, so sind also alle einzelnen Xi normalverteilt. Die Umkehrung gilt keinesfalls: Aus der Normalverteiltheit der Variablen

X1 , . . . , Xn folgt nicht notwendigerweise deren gemeinsame Normalverteiltheit.

Der hier eingeführte Begriff der Multinormalverteilung ist für die multivariate

Statistik wohl die praktischste Verallgemeinerung der Normalverteilung auf mehrere Dimensionen. Leider ist für den Fall n = 1 eine (allerdings unbedeutende)

Inkonsistenz zu konstatieren: Eine einzelne Variable X, deren Varianz 0 ist, gilt

auch als multinormalverteilt, obgleich sie natürlich nicht normalverteilt ist. Einzelne normalverteilte Variablen sind hingegen immer auch multinormalverteilt.

Die Forderung in der Definition der Multinormalverteilung ist recht stark, so dass

es zunächst fraglich ist, ob es überhaupt multinormalverteilte Variablen gibt. Hier

gilt jedoch der folgende (hier nicht begründbare) Satz:

Sind X1 , . . . , Xn unabhängig und normalverteilt, so sind sie auch gemeinsam normalverteilt.

Darüber hinaus gilt die folgende bemerkenswerte Feststellung (die hier ebenfalls

nicht gezeigt werden kann):

Sind X und Y gemeinsam normalverteilt und unkorreliert, so sind sie unabhängig.

Für gemeinsam normalverteilte Variablen fallen also die Begriffe der Unabhängigkeit und der Unkorreliertheit zusammen, was ein Beleg dafür ist, wie stark der

1.2

Stetige Verteilungen

QM2 15

16

Begriff der gemeinsamen Normalverteiltheit ist, denn allgemein folgt ja nur aus

der Unabhängigkeit die Unkorreliertheit, nicht aber aus der Unkorreliertheit die

Unabhängigkeit.

Allgemeiner gilt für mehrere gemeinsam normalverteilte Variablen X1 , . . . , Xn ,

dass sie genau dann (gemeinsam) unabhängig sind, wenn sie paarweise unkorreliert sind.

Zur χ2 -Verteilung.

Für die Herleitung vieler Verteilungen von besonderer Wichtigkeit ist der folgende

Satz:

Sind X1 , . . . , Xn unabhängige Versionen von X ∼ N (µ, σ 2 ) und sind

n

M=

1X

Xi

n i=1

n

und

s2 =

1 X

(Xi − M )2

n − 1 i=1

Stichprobenmittelwert und korrigierte Stichprobenvarianz, so sind M und s2 unabhängig und es gilt

M ∼ N (µ, σ 2 /n)

und

(n − 1)s2

∼ χ2n−1 .

σ2

Die Begründung soll hier wenigstens für den Fall n = 2 gegeben werden. Hierzu sei Y = (X1 − X2 ). Als erstes soll gezeigt werden, dass M und Y gemeinsam normalverteilt und unabhängig sind. Um die gemeinsame Normalverteilung

nachzuweisen, muss gezeigt werden, dass jede Linearkombination dieser Variablen

normalverteilt ist oder Varianz 0 besitzt.

Sei also a1 M + a2 Y eine beliebige Linearkombination (es ist klar, dass additive

Konstanten hier irrelevant sind). Dann kann man dies umschreiben zu

a1 M + a2 Y = a1 (X1 + X2 )/2 + a2 (X1 − X2 ) = (a1 /2 + a2 )X1 + (a1 /2 − a2 )X2 .

Die gegebene Linearkombination ist also auch eine Linearkombination von X1

und X2 . Da X1 und X2 jedoch unabhängig und normalverteilt sind, sind sie

auch gemeinsam normalverteilt, weshalb jede Linearkombination (also auch die

gerade untersuchte) wieder normalverteilt ist oder Varianz 0 besitzt. Es folgt, wie

gewünscht, die gemeinsame Normalverteilung von M und Y .

1.2

Stetige Verteilungen

QM2 15

17

Die Kovarianz von M und Y bestimmt man zu

Kov(M, Y ) = Kov((1/2)(X1 + X2 ), X1 − X2 )

= (1/2)Kov(X1 + X2 , X1 − X2 ))

= (1/2) (Kov(X1 , X1 ) − Kov(X1 , X2 ) + Kov(X2 , X1 ) − Kov(X2 , X2 ))

= (1/2)(σ 2 − σ 2 ) = 0 ,

da ja Kov(X1 , X1 ) = Kov(X2 , X2 ) = σ 2 gilt. Die Variablen M und Y sind also

unkorreliert.

Da M und Y auch gemeinsam normalverteilt sind, folgt aus der Unkorreliertheit

sogar die Unabhängigkeit von M und Y .

Als nächstes soll gezeigt werden, dass s2 eine Funktion von Y ist; dann vererbt

sich nämlich die Unabhängigkeit von M und Y auf M und s2 .

In der Tat gilt

s2 =

1

(X1 − M )2 + (X2 − M )2 ,

(2 − 1)

wobei

1

1

1

(X1 + X2 ) = (X1 − X2 ) = Y

2

2

2

ist und entsprechend X2 − M = (1/2)(X2 − X1 ) = (−1/2)Y . Es folgt

2 2

Y

Y2

−Y

Y2

2

s =

=

.

+

=2

2

2

4

2

X1 − M = X 1 −

Nun bleiben nur noch die Aussagen über die Verteilungen von M und s2 . Die

Verteilung von M ist schon bekannt, und für s2 bemerkt man zunächst, dass

Y ∼ N (0, 2σ 2 ) gilt, denn einerseits ist der Erwartungswert von Y gleich

E(Y ) = E(X1 − X2 ) = E(X1 ) − E(X2 ) = µ − µ = 0 ,

andererseits ist die Varianz von Y wegen der Unabhängigkeit von X1 und X2

gleich der Summe der Varianzen von X1 und X2 , also 2σ 2 . Da dies ungleich 0 ist,

folgt auch noch die Normalverteilung von Y aus der gemeinsamen Normalverteilung von X1 und X2 .

√

Aus Y ∼ N (0, 2σ 2 ) folgt direkt Y /( 2σ) ∼ N (0, 1), woraus sich schließlich

2

(n − 1)s2

(2 − 1)s2

s2

Y2

Y

∼ χ21

=

= 2 = 2 = √

2

2

σ

σ

σ

2σ

2σ

1.2

Stetige Verteilungen

QM2 15

18

ergibt, da ja das Quadrat einer standardnormalverteilten Variable definitionsgemäß χ21 -verteilt ist.

Als Ergänzung soll nun noch die Begründung für den Fall n = 3 skizziert werden; sie lässt ahnen, wie die Begründung für den allgemeinen Fall etwa aussehen

würde. Allerdings kann man – mit geeigneten Hilfsmitteln, die hier noch nicht

zur Verfügung stehen – die nötigen Schritte auch viel eleganter, kürzer und vor

allem durchsichtiger formulieren.

Im Fall n = 3 bildet man neben dem Mittelwert M = (X1 + X2 + X3 )/3 zwei

geeignete neue Variablen, beispielsweise die Variablen

1

Y1 = √ (2X1 − X2 − X3 )

6

1

Y2 = √ (X2 − X3 ) .

2

Zunächst zeigt man dann analog wie oben, dass M , Y1 und Y2 gemeinsam normalverteilt sind. Dann bestimmt man – wieder genau wie oben – die Varianzen

und Kovarianzen, wobei sich herausstellt, dass die Kovarianzen alle 0 sind und

die Varianzen von Y1 und Y2 gleich σ 2 .

Man folgert wieder, dass M , Y1 und Y2 gemeinsam unabhängig sind. Aus Y1 und

Y2 stellt man als nächstes eine weitere Variable U her als

U = Y12 + Y22 ,

wobei sich die Unabhängigkeit von M , Y1 und Y2 auf M und U vererbt.

Bildet man andererseits als Vorstufe zur Varianz den Ausdruck

(X1 − M )2 + (X2 − M )2 + (X3 − M )2 ,

setzt man M = (X1 + X2 + X3 )/3 ein und formt das Ergebnis um, so stellt man

fest, dass es sich dabei gerade um U handelt (wobei auch U nach Einsetzen der

Ausdrücke für Y1 und Y2 entsprechend umzuformen ist).

Als Ergebnis erhält man

s2 =

1

2

1

1

(X1 − M )2 + (X2 − M )2 + (X3 − M )2 = U =

2

2

Y12 + Y22 ,

und hat damit (bis auf den Faktor 1/2) die Varianz s2 nicht mehr als eine Summe

von drei Termen dargestellt, sondern als eine Summe von zwei unabhängigen

1.2

Stetige Verteilungen

QM2 15

19

quadrierten normalverteilten Variablen. Dies ist die Stelle, an der sich die Zahl

der Freiheitsgerade bestimmt.

Berücksichtigt man, dass die Erwartungswerte von Y1 und Y2 beide 0 sind, so folgt,

dass Z1 = Y1 /σ und Z2 = Y2 /σ standardnormalverteilt und ebenfalls unabhängig

sind. An der Umformung

(n − 1) s2

2 s2

U

Y12 Y22

=

=

=

+ 2 = Z12 + Z22

σ2

σ2

σ2

σ2

σ

erkennt man schließlich noch, dass (n − 1)s2 /σ 2 auch in diesem Fall χ2 verteilt

ist, und zwar – wie behauptet – mit 2 Freiheitsgraden. Was die Zahl der sogenannten Freiheitsgrade angeht, so lädt der Name dazu ein,

Assoziationen zu produzieren. Solche Assoziationen können natürlich nicht die

(eher technische) Definition und die formalen Ableitungen ersetzen, sie sind jedoch als Merkhinweise durchaus nützlich und weisen bisweilen auch in die richtige

Richtung.

Bei den Freiheitsgraden der letzten Feststellung gibt es in der Tat eine recht

eingängige (Pseudo)-Argumentation: In der ursprünglichen Situation können alle

n Beobachtungen Xi unabhängig voneinander variieren, sie hätten in diesem Sinn

n ‚Grade der Freiheit‘. Beim Bilden von s2 werden zunächst die Abweichungen

der Xi vom Mittelwert M gebildet, also die Werte (Xi − M ), die dann quadriert

und aufsummiert werden. Diese Werte (Xi − M ) können jedoch nun nicht mehr

so unabhängig voneinander variieren wie die Xi , da ja bekanntlich die Summe der

Abweichungen vom Mittelwert immer 0 ist. So ist durch die ersten n − 1 Werte

(Xi − M ) der letzte Wert (Xn − M ) eindeutig festgelegt und hat gewissermaßen

im Vergleich zu Xn seine Bewegungsfreiheit verloren. Von den ursprünglich n

‚Graden der Freiheit‘ bleiben ‚also‘ nun nur noch n − 1 übrig.

Diese Argumentation veranschaulicht schön den ‚Verlust eines Freiheitsgrades‘

und ist in dieser Hinsicht nützlich. Sie ist auch harmlos, wenn man sie nicht mit

einer Begründung verwechselt. Die korrekte Begründung (die einen hier nicht vertretbaren mathematischen Aufwand erfordert) sieht natürlich anders aus, wobei

sich allerdings durchaus Elemente der betrachteten Argumentation wiederfinden.

In diesem Sinn ist die Argumentation nicht nur als Merkhinweis nützlich, sondern

weist sogar auch noch in die richtige Richtung.

Eine bemerkenswerte Eigenschaft der χ2 -Verteilungen ist ihr Verhalten beim Addieren:

1.2

Stetige Verteilungen

QM2 15

20

Sind Y1 ∼ χ2m und Y2 ∼ χ2n unabhängig, so gilt Y1 + Y2 ∼ χ2m+n .

Die Summe unabhängiger χ2 -verteilter Variablen ist also wieder χ2 -verteilt, wobei

sich die Freiheitsgrade addieren.

Um interessierten Leserinnen eine Vorstellung zu geben, wie derartige Aussagen

zu beweisen sind, soll hier skizzenhaft eine Begründung gegeben werden, die im

Wesentlichen korrekt ist (und vielleicht etwas komplizierter, als man erwarten

würde). Bei einigen Schritten fehlt die Rechtfertigung, wenngleich diese Schritte

intuitiv einsichtig sind; eine solche Rechtfertigung würde einige Vorarbeiten hinsichtlich Eigenschaften unabhängiger Variablen und gemeinsamer Verteilungen

erfordern. Um das Unterscheidungsvermögen für korrekte und nur plausibilisierende Argumentationen zu schulen, sind solche Stellen mit (∗) markiert.

Zur Begründung seien nun also X1 , . . . , Xm , Xm+1 , . . . , Xm+n unabhängige normalverteilte Zufallsvariablen. Man definiert dann neue Zufallsvariablen Ỹ1 und Ỹ2

als

m

m+n

X

X

2

Ỹ1 =

Xi

und

Ỹ2 =

Xi2 .

i=1

i=m+1

Diese Variablen sind dann definitionsgemäß χ2 -verteilt mit m und n Freiheitsgraden und zusätzlich unabhängig, da die Gruppen der Xi , aus denen sie gebildet

sind, voneinander unabhängig sind (∗).

Die Variablen Ỹ1 und Ỹ2 haben also die gleichen Verteilungen wie Y1 und Y2 . Da

die gemeinsame Verteilung von zwei unabhängigen Variablen durch die Einzelverteilungen bereits vollständig festliegt (∗), ist auch die gemeinsame Verteilung

von Ỹ1 und Ỹ2 gleich der gemeinsamen Verteilung von Y1 und Y2 (für diskrete

Variablen ist diese plausible Tatsache bekannt – die gemeinsame W-Funktion ist

das Produkt der Rand-W-Funktionen – und bei stetigen Variablen mit Dichte

gilt ja ein ähnlicher Satz).

Da die Verteilung einer Funktion f (X) einer Variablen X durch die Verteilung

der Variablen selbst vollständig bestimmt ist (∗) (für diskrete Variablen ist dies

bekannt), stimmen die Verteilungen von Ỹ1 + Ỹ2 und Y1 +Y2 überein (die Funktion

f ist hier die auf R × R definierte Addition, und die Rolle der Variablen X wird

hier einmal von (Ỹ1 , Ỹ2 ) und einmal von (Y1 , Y2 ) übernommen – die Variablen,

auf die die Funktion wirkt, sind also hier jeweils schon ‚zweidimensional‘).

1.2

Stetige Verteilungen

QM2 15

21

Die Verteilung von

Ỹ1 + Ỹ2 =

n+m

X

Xi2

i=1

ist jedoch defintionsgemäß eine

die Behauptung gezeigt ist. χ2m+n -Verteilung,

also auch die von Y1 +Y2 , womit

Zur F -Verteilung.

Sind X ∼ χ2n und Y ∼ χ2m unabhängig, und ist

U=

X/n

,

Y /m

so heißt die Verteilung von U auch F -Verteilung mit n Zähler- und m Nennerfreiheitsgraden.

Die Abkürzung für diese Verteilung ist Fn,m .

Die F -Verteilungen mit einem Zählerfreiheitsgrad sind eng mit den t-Verteilungen

verwandt:

Gilt V ∼ tn , so gilt V 2 ∼ F1,n .

2

Zur Begründung seien

p X ∼ N (0, 1) und Y ∼ χn unabhängig. Dann ist die Verteilung von W = X/ Y /n eine tn -Verteilung, die Verteilung von W stimmt also

mit der von V überein. Daher stimmt auch die Verteilung von W 2 mit der von V 2

überein (vgl. hierzu die Anmerkungen zur Verteilung der Summe zweier unabhängiger χ2 -Variablen). Die Variable W 2 ist aber gleich X 2 /(Y /n) = (X 2 /1)/(Y /n).

Da X 2 als Quadrat einer standardnormalverteilten Variablen eine χ21 -Verteilung

besitzt, und da mit X und Y auch Zähler und Nenner von W 2 unabhängig sind,

hat W 2 definitionsgemäß eine F1,n -Verteilung. Folglich besitzt auch V 2 diese Verteilung. Kehrwerte von F -verteilten Variablen sind wieder F -verteilt:

Gilt U ∼ Fn,m , so gilt 1/U ∼ Fm,n .

Zur Begründung seien X ∼ χ2n und Y ∼ χ2m unabhängig, W = (X/n)/(Y /m).

Dann besitzt W definitionsgemäß eine Fn,m -Verteilung, also die gleiche Verteilung

wie U . Folglich besitzen auch 1/U und 1/W die gleiche Verteilung. Wegen 1/W =

(Y /m)/(X/n) ist jedoch die Verteilung von 1/W eine Fm,n -Verteilung, und damit

auch die Verteilung von 1/U . 1.3

1.3

Spezielle Verfahren

QM2 15

22

Spezielle Verfahren

Anpassungstests.

Zum χ2 -Test auf eine feste Verteilung.

Bei Anpassungstests geht es um die Frage, ob eine gegebene Variable eine spezielle

Verteilung oder eine Verteilung aus einer bestimmten Klasse besitzt (beispielsweise eine Normalverteilung mit nicht spezifiziertem Erwartungswert und nicht

spezifizierter Varianz).

Hier wird zunächst der einfachere Fall behandelt, dass die Verteilung, um die

es geht, fest vorgegeben ist (beispielsweise eine spezielle Normalverteilung wie

N (100, 225)).

Die Nullhypothese ist die, dass die Verteilung der untersuchten Variable X gleich

dieser Verteilung V0 ist, die Alternativhypothese besagt hingegen, dass die Verteilung von X nicht V0 ist.

Beim χ2 -Test geht man in diesem Fall bekanntlich so vor, dass man zunächst

den Wertebereich der Variable X in J disjunkte Teilmengen Aj einteilt. Die

Wahrscheinlichkeiten dieser Teilmengen unter H0 seien die Zahlen pj0 . Unter H0

gilt also P(X ∈ Aj ) = pj0 . Die pj0 müssen dabei alle 6= 0 sein.

Im allgemeinen Fall, in dem die Verteilung von X nicht spezifiziert wird, sollen

diese Wahrscheinlichkeiten P(X ∈ Aj ) nur pj heißen.

Nach dieser Einteilung zieht man von der Variable X eine große unabhängige

Stichprobe vom Umfang N und ermittelt die Häufigkeiten fo,j , mit denen Werte

in diesen Teilmengen Aj auftreten. Diese Häufigkeiten werden verglichen mit

den Häufigkeiten fe,j = N pj0 , die man unter H0 ‚erwartet‘. (Eine unabhängige

Stichprobe ist natürlich eine solche, bei der die einzelnen Ziehungen durch das

Modell unabhängiger Zufallsvariablen beschrieben werden können; praktisch wird

man zur Rechtfertigung einer solchen Annahme zu gewährleisten suchen, dass die

Ergebnisse der einzelnen Ziehungen sich in keiner Weise gegenseitig beeinflussen

können.)

Der Vergleich wird mit der vorläufig als cN bezeichneten Statistik

J

X

(fo,j − fe,j )2

cN =

fe,j

j=1

1.3

Spezielle Verfahren

QM2 15

23

durchgeführt; die Nullhypothese wird auf dem Niveau α verworfen, wenn

cN ≥ χ2J−1; α

gilt.

Zur Rechtfertigung des Verfahrens ist zunächst klar, dass große Werte von cN gegen die Nullhypothese sprechen, weil in ihnen eine deutliche Diskrepanz zwischen

den erwarteten und den tatsächlichen Häufigkeiten zum Ausdruck kommt.

Die Form der Entscheidungsregel wird also auf jeden Fall die sein, dass die Nullhypothese dann zu verwerfen ist, wenn cN ≥ k gilt für einen kritischen Wert k,

der noch geeignet zu wählen ist. Die Wahl von k muss dann so geschehen, dass die

Wahrscheinlichkeit, H0 fälschlicherweise zu verwerfen, höchstens gleich dem gegebenen Signifikanzniveau α ist – mit anderen Worten sollte k bei der Verteilung

von cN unter H0 rechts α abschneiden.

Im hier vorliegenden Fall einer festen Verteilung V0 unter der Nullhypothese könnte man die Verteilung von cN unter H0 mit kombinatorischen Hilfsmitteln exakt

bestimmen, der Aufwand wäre allerdings meist sehr hoch. Erfreulicherweise konvergiert die Verteilung von cN jedoch für N → ∞ schwach gegen eine χ2J−1 Verteilung, wenn die Nullhypothese gilt.

Diese Konvergenzaussage kann hier nicht allgemein begründet werden; immerhin

soll gleich die Skizze einer Begründung für den Fall J = 2 gegeben werden.

Setzt man jedoch diese Konvergenz voraus, so hat man eine Rechtfertigung für

die oben gegebene Entscheidungsregel: Für hinreichend großes N sollten sich die

Verteilung von cN und die χ2J−1 -Verteilung nicht mehr allzustark unterscheiden

(im Hinblick auf ihre Verteilungsfunktionen), so dass die Zahl χ2J−1; α , die bei

der χ2J−1 -Verteilung rechts α abschneidet, auch bei der Verteilung von cN rechts

ungefähr α abschneiden wird. Mit anderen Worten ist der Fehler, den man macht,

wenn man als kritischen Wert k die Zahl χ2J−1; α wählt, nicht allzu groß – genauer

ist die Wahrscheinlichkeit eines Fehlers erster Art zwar dann nicht genau α, aber

(hoffentlich) von α auch nicht allzustark verschieden.

Der geschilderte Test ist also wenigstens näherungsweise ein Test zum Niveau α.

Es folgt nun die angekündigte skizzenhafte Begründung der Konvergenzaussage

für den Fall J = 2.

Hier geht es um den Fall mit zwei Bereichen Aj ; abkürzend sei p = p10 die

1.3

Spezielle Verfahren

QM2 15

24

Wahrscheinlichkeit für Werte in A1 . Die Wahrscheinlichkeit p20 für Werte in A2

ist dann natürlich 1 − p, was wie üblich mit q abgekürzt sei.

Wegen des unabhängigen Ziehens ist dann die Häufigkeit fo,1 von Ergebnissen

in A1 binomialverteilt, genauer gilt: fo,1 ∼ B(N, p). Da sich fo,1 und fo,2 zu N

ergänzen, gilt fo,2 = N − fo,1 .

Die erwarteten Häufigkeiten sind fe,1 = N p und fe,2 = N q = N − N p.

Damit erhält man

cN =

=

=

=

=

(fo,1 − N p)2 (fo,2 − N q)2

+

Np

Nq

2

(N − fo,1 − (N − N p))2

(fo,1 − N p)

+

Np

Nq

2

(fo,1 − N p) 1 1

+

N

p q

(fo,1 − N p)2 1

N

pq

2

(fo,1 − N p)

√

,

N pq

wobei (N p − fo,1 )2 = (fo,1 − N p)2 und p + q = 1 benutzt wurden.

Der Ausdruck

(fo,1 − N p)

√

N pq

ist aber gerade die z-Transformierte der Summe von N unabhängigen B(1, p)Variablen; wegen des zentralen Grenzwertsatzes konvergiert die Verteilung dieses

Ausdrucks daher für N → ∞ schwach gegen die N (0, 1)-Verteilung.

Es ist daher plausibel (und auch richtig), dass die Verteilung des Quadrats des

Ausdrucks (also von cN ) schwach gegen die Verteilung des Quadrats einer standardnormalverteilten Variable konvergiert, also gegen eine χ21 -Verteilung. Es folgen nun mehrere Bemerkungen zu diesem χ2 -Test.

1. Die Teststatistik cN hat meist den Namen χ2 . Die Bezeichnung cN wurde

hier nur deshalb verwendet, um voreilige Fehlassoziationen zu vermeiden

und um einige Tatsachen, beispielsweise im Zusammenhang mit der Konvergenz, besser formulieren zu können.

1.3

Spezielle Verfahren

QM2 15

25

2. In vielen Fällen findet hier eine ‚Vergröberung‘ der Hypothesen statt, nämlich in all den Fällen, in denen die Mengen Aj nicht alle nur aus einem

Element bestehen. Was nämlich untersucht wird, ist, ob die Häufigkeiten

für Beobachtungen in den Aj mit dem harmonieren, was man auf der Basis

der Wahrscheinlichkeiten pj0 dieser Mengen unter H0 erwartet.

Die Verteilung V0 unter H0 kommt also nur auf dem Umweg über die Wahrscheinlichkeiten pj0 ins Spiel, und man würde für alle Verteilungen V , die

mit der H0 -Verteilung in diesen Wahrscheinlichkeiten übereinstimmen, die

gleichen Testwerte und Entscheidungen erhalten, wenn man sie zur H0 Verteilung machen würde. Mit anderen Worten unterscheidet dieser Test

nicht zwischen V0 und allen weiteren Verteilungen, unter denen die Aj gleiche Wahrscheinlichkeiten besitzen wie unter V0 . Diese Verteilungen sollen

der Kürze halber in der weiteren Diskussion als bei den gegebenen Aj zu V0

äquivalente Verteilungen bezeichnet werden.

Man kann dies auch so ausdrücken, dass eigentlich nicht H0 getestet wird,

sondern die (schwächere, in diesem Sinn ‚vergröberte‘ oder ‚verwässerte‘)

Hypothese, dass die Wahrscheinlichkeiten der Aj gerade die pj0 sind, zu

denen V0 führt (aber eben auch viele andere Verteilungen). Formal wird

also eigentlich das modifizierte Hypothesenpaar

H00 : pj = pj0

H10

: nicht

für alle j = 1, . . . , J

H00

getestet. Das Verhältnis der alten zu den neuen Hypothesen ist nun so, dass

aus der Richtigkeit von H0 die von H00 folgt, aber nicht umgekehrt (außer

in dem Fall, dass die Aj alle nur ein Element enthalten) – hierin liegt die

‚Verwässerung‘. Entsprechend folgt aus der Gültigkeit von H10 die von H1 ,

aber wieder – außer in dem Sonderfall – nicht umgekehrt. (Man benutzt hier

die allgemeine logische Regel, dass „A → B“ und „(nicht B) → (nicht A)“

äquivalent sind.)

Die Vergröberung ist unkritisch, wenn man ein signifikantes Ergebnis erzielt,

da die dann akzeptierte H10 auch H1 impliziert. Probleme wirft hingegen ein

nichtsignifikantes Ergebnis auf, wie weiter unten ausgeführt wird.

3. Was die Zahl der Freiheitsgrade angeht, so gibt es für diesen und ähnliche

Fälle eine Faustregel, die folgendermaßen lautet:

# df

=

# FP(H1 )

−

# FP(H0 ) ,

1.3

Spezielle Verfahren

QM2 15

26

wobei das Zeichen ‚#‘ als Abkürzung für ‚Anzahl‘ steht, und wobei ‚df‘

und ‚FP‘ Abkürzungen für ‚Freiheitsgrade (degrees of freedom)‘ und ‚Freie

Parameter‘ sind. Die Faustregel lautet ausführlich dann so: Die Anzahl der

Freiheitsgrade ist die Differenz aus der Anzahl der freien Parameter unter

H1 und unter H0 .

Im hier betrachteten Fall ist zunächst zu klären, was unter ‚freien Parametern‘ zu verstehen ist. Parameter sind immer gewisse Kennwerte, die eine

Verteilung für einen bestimmten Zweck hinreichend genau charakterisieren.

Berücksichtigt man, dass im Sinne der Anmerkung 2 eigentlich die ‚vergröberte‘ oder ‚verwässerte‘ neue Nullhypothese H00 getestet wird, so ist in

dieser Formulierung naheliegend, die Wahrscheinlichkeiten p1 , . . . , pJ als Parameter zu bezeichnen. Unter H00 sind diese Wahrscheinlichkeiten festgelegt

(nämlich zu pj0 ), unter H10 hingegen nicht. Die Zahl der ‚freien‘ Parameter

ist unter H00 also 0, während sie unter H10 zunächst gleich J zu sein scheint.

Allerdings können die pj nicht völlig beliebige Werte annehmen, vielmehr

muss ihre Summe stets 1 ergeben. Dadurch ist immer ein Parameter durch

die Werte der restlichen J − 1 Parameter vollständig bestimmt. ‚Frei‘ sind

also nur J − 1 der pj .

Die Faustregel führt nach diesen Erläuterungen zur Anzahl

(J − 1) − 0 = J − 1

von Freiheitsgraden, was tatsächlich die richtige Anzahl ist; die Faustregel

hat in diesem Fall also recht.

Bei näherem Hinsehen sind die gerade gegebenen Erläuterungen sicher nicht

befriedigend, da es an präzisen Definitionen (beispielsweise des Begriffs ‚Parameter‘) fehlt. Für eine genauere Behandlung der aufgeworfenen Fragen

fehlen allerdings hier die Grundlagen, und da die Faustregel auch nur als

Faustregel und nicht mehr zu verstehen ist, sollte das Gesagte ausreichen.

4. Was die Approximation angeht (in Wahrheit ist die Teststatistik cN nur

näherungsweise χ2 -verteilt, man tut aber so, als hätte sie diese Verteilung),

so wird sie meist als ausreichend angesehen, wenn alle fe,j mindestens 5

sind.

5. Es gibt Korrekturformeln für kleine Stichprobengrößen.

6. Gelingt es nicht, die Nullhypothese zu verwerfen, so kann das eigentlich

nicht als Beleg dafür gewertet werden, dass diese Nullhypothese richtig ist.

1.3

Spezielle Verfahren

QM2 15

27

Einerseits nämlich ist über den β-Fehler nichts bekannt (er wird sehr groß

sein, wenn die tatsächliche Verteilung sich kaum von der unter H0 unterscheidet), und andererseits wird im Grunde nicht die eigentliche Nullhypothese H0 getestet, sondern nur die Vergröberung H00 , die nicht mehr zwischen der Verteilung V0 und allen anderen Verteilungen unterscheidet, die

bei den gegebenen Aj zu V0 äquivalent sind. Auch wenn man also ein nicht

signifikantes Ergebnis als Stützung für die Nullhypothese werten wollte, wäre dies nur eine Stützung für die ‚verwässerte‘ Nullhypothese H00 , aus der

H0 ja im Allgemeinen nicht folgt.

Etwas rigoroser formuliert kann man also ein nicht signifikantes Ergebnis

nicht ernsthaft als Beleg für H00 werten und als Beleg für H0 schon gar nicht.

7. Unglücklicherweise richtet sich jedoch das Interesse in vielen Situationen,

in denen der χ2 -Test angewendet wird, gerade auf eine ‚Stützung‘ der Nullhypothese (man möchte beispielsweise eine Normalverteilungsannahme, auf

der ein folgender Test beruht, rechtfertigen). Das Vorgehen in solchen Fällen ist meist so, dass man das Testniveau hochsetzt (also vielleicht von 5%

auf 20%) und hofft, dass sich dennoch kein signifikantes Ergebnis einstellt.

Auf diese Weise hat man dann den unbekannten β-Fehler wenigstens etwas

verkleinert.

8. In Programmen und in der Literatur findet sich bekanntlich statt einer

Angabe zum Signifikanzniveau ein p-Wert, der angibt, auf welchem Niveau

die gegebenen Daten gerade noch zu einem signifikanten Ergebnis geführt

hätten. In dem Fall, dass H0 ‚gestützt‘ werden soll, wird man also hoffen,

dass dieser Wert möglichst hoch ist (also vielleicht mindestens .2, besser

größer). Die naheliegende Regel ‚ je höher p, umso besser die Anpassung‘

ist in dieser naiven Form freilich nicht haltbar.

9. Für jede konkrete Verteilung V , die nicht bei den gegebenen Aj mit V0

äquivalent ist, gilt, dass die Power des Tests gegen 1 geht mit N → ∞, falls

V die wahre Verteilung von X ist. Falls also H10 (die Formulierung aus der

‚Vergröberung‘) stimmt, wird man bei großen Stichproben mit sehr großer

Wahrscheinlichkeit H0 zurückweisen.

10. Der noch zu besprechende Test von Kolmogoroff und Smirnoff ist bei stetigen Verteilungen eine Alternative zum χ2 -Test.

Delikat ist die Situation eines Forschers, der eine Nullhypothese stützen will,

an die er eigentlich gar nicht glaubt. Beispielsweise könnte diese Hypothese die

1.3

Spezielle Verfahren

QM2 15

28

sein, dass eine Variable eine bestimmte Normalverteilung besitzt. Wird zum Testen dieser Hypothese nun der χ2 -Test verwendet, so darf die Stichprobe nicht

zu klein sein, da ja der Test nur approximativ korrekt ist. Andererseits darf die

Stichprobe auch nicht zu groß werden, denn sonst wird die Wahrscheinlichkeit

eines (unerwünschten) signifikanten Ergebnisses hoch, da ja die Nullhypothese

streng genommen nicht gilt, und da deshalb mit wachsendem N diese Wahrscheinlichkeit gegen 1 geht (außer in dem Fall, in dem zwar nicht H0 , jedoch die

vergröberte H00 stimmt).

Man fragt sich womöglich, was ein solcher Forscher eigentlich tut, wenn er den

Test durchführt. Vielleicht wird er, um Auskunft gebeten, antworten, dass er zu

belegen versucht, dass die Abweichung der tatsächlichen Verteilung von X von

der unter der Nullhypothese angenommenen nicht allzu groß und daher harmlos ist. Ob sein Vorgehen zu diesem Zweck jedoch tauglich ist, hängt von einer

genaueren Spezifikation dessen ab, was unter tolerierbaren Abweichungen zu verstehen ist. An eine solche Spezifikation müssten sich dann weitere Überlegungen

anschließen...

Die Situation, dass die Richtigkeit eines theoretisches Modell belegt werden soll,

das aus formal-technischen Gründen die Rolle der Nullhypothese spielen muss,

ist keineswegs selten; die Schwierigkeiten sind dann immer ähnlich zu den hier

beschriebenen, und sie verschärfen sich, wenn bei genauerem Hinsehen gar nicht

erwartet wird, dass das Modell exakt stimmt, sondern es nur ‚ungefähr‘ stimmen

soll. Die Lösungsversuche sind meist ähnlich wie sie hier für den Test auf das

Vorliegen einer bestimmten Verteilung besprochen wurden.

Anzumerken ist übrigens, dass in sehr vielen anderen Fällen, in denen in dieser Art ein Modell als Nullhypothese getestet wird, die Teststatistik ebenfalls

approximativ χ2 -verteilt ist.

Der χ2 -Test für eine Verteilungsklasse.

Hier geht es um die Frage, wie man testen kann, ob die Verteilung einer Zufallsvariable X einer bestimmten Klasse angehört, ob X beispielsweise normalverteilt

ist, ohne dass diese Normalverteilung (durch Angabe von Erwartungswert und

Varianz) genau spezifiziert würde.

Der Test geht mit zwei Modifikationen genau so wie im Fall einer festen Verteilung

unter H0 . Diese Modifikationen sind die, dass erstens die Parameter der Verteilung

unter H0 geschätzt werden, worauf die zugehörige Verteilung die Rolle der festen

1.3

Spezielle Verfahren

QM2 15

29

Verteilung übernimmt, und dass zweitens die Zahl der Freiheitsgrade der χ2 Verteilung, die zur Festlegung des kritischen Wertes benutzt wird, um die Zahl

dieser geschätzten Parameter vermindert wird.

Dies soll am Beispiel des Tests auf Normalverteilung genauer erläutert werden; es

soll dabei zur Illustration ein konkreter hypothetischer Fall herangezogen werden.

Es geht in diesem Fall um die Frage, ob die Intelligenz X in einer bestimmten

Subpopulation (beispielsweise von Studierenden eines bestimmten Fachs) normalverteilt ist oder nicht (das Problem, dass X streng genommen gar nicht normalverteilt sein kann, sei hier ausgeklammert).

Die Hypothesen sind also die folgenden:

H0 :

X ist normalverteilt

H1 :

X ist nicht normalverteilt

Das Signifikanzniveau wird auf 5% festgelegt.

Die Normalverteilungen sind bekanntlich durch Erwartungswert µ und Varianz

σ 2 gekennzeichnet; diese beiden Zahlen sind die Parameter der Verteilung. Hier

bleiben bei H0 beide Werte offen. Es sind auch andere Fälle denkbar, in denen

man sich auf einen der beiden Parameter festlegt – es könnte beispielsweise sein,

dass die Varianz 225 generell vorausgesetzt wird.

Es soll später eine unabhängige Stichprobe vom Umfang 25 gezogen werden. Der

erste Schritt ist die Einteilung des Wertebereichs von X in geeignete Intervalle.

Die Häufigkeiten von Beobachtungen in diesen Intervallen sollen hinterher nach

Möglichkeit mindestens 5 sein, weshalb eine Einteilung in 4 Intervalle sinnvoll erscheint. Da man sicher ungefähre Vorstellungen von Erwartungswert und Varianz

von X hat, wird man die Intervalle so wählen, dass mit nicht wesentlich weniger

als 5 Beobachtungen pro Intervall gerechnet werden kann.

Hier soll die Intervalleinteilung folgendermaßen aussehen:

j Untergrenze von Aj

1

−∞

2

91.5

3

99.5

4

107.5

Obergrenze von Aj

91.5

99.5

107.5

∞

1.3

Spezielle Verfahren

QM2 15

30

Es ist eigentlich noch festzulegen, wie Werte auf den Intervallgrenzen zuzuordnen

sind. Einerseits ist das aber eigentlich unerheblich, wenn man an die Voraussetzung einer stetigen Verteilung glaubt, denn dann treten Werte auf den Grenzen

ja nur mit Wahrscheinlichkeit 0 auf. Andererseits umgeht die gegebene Einteilung

das Problem, da nur ganzzahlige Intelligenzwerte auftreten können (dies zeigt nur

wieder, dass man an die Normalverteiltheit von X gar nicht glauben kann).

Nun wird eine unabhängige Stichprobe gezogen. Als X-Werte mögen sich dabei

die folgenden Zahlen ergeben:

80, 115, 97, 102, 93, 120, 118, 83, 86, 100, 106, 92, 85,

118, 81, 82, 117, 115, 92, 117, 84, 99, 109, 118, 85

Von diesen Daten werden Mittelwert M und korrigierte Stichprobenstreuung s

ermittelt; die Ergebnisse sind M = 99.76 und s = 14.408.

Die zu diesen Parameterschätzungen gehörende Normalverteilung wird nun so

verwendet wie die H0 -Verteilung in der Situation des χ2 -Tests einer festen Verteilung.

Der nächste Schritt ist daher die Ermittlung der Wahrscheinlichkeiten der Aj

unter der Voraussetzung einer Normalverteilung mit Erwartungswert 99.76 und

Streuung 14.408. Zu diesem Zweck müssen die Intervallgrenzen z-transformiert

werden, worauf eine geeignete Tabelle die Werte der Verteilungsfunktion F der

Standardnormalverteilung für diese z-Werte liefert.

Man bekommt das folgende Ergebnis:

x

z

F (z)

91.5 −.57 .28

99.5 −.02 .49

107.5 .54

.71

Durch Differenzbildung ermittelt man nun leicht die Wahrscheinlichkeiten der

Aj . Da diese Wahrscheinlichkeiten auf Schätzungen beruhen, sollen sie mit p̂j0

bezeichnet werden – ein Dach ( ˆ ) weist ja oft darauf hin, dass der Kennwert

darunter geschätzt wurde.

1.3

Spezielle Verfahren

QM2 15

31

Die geschätzten Wahrscheinlichkeiten sind damit die folgenden:

Aj

( −∞, 91.5 )

( 91.5, 99.5 )

( 99.5, 107.5 )

( 107.5, ∞ )

p̂j0

.28

.21

.22

.29

Durch Multiplikation dieser Wahrscheinlichkeiten mit der gegebenen Stichprobengröße N = 25 erhält man die erwarteten Häufigkeiten fe,j , während man die

beobachteten Häufigkeiten einfach durch Auszählen ermittelt. Mit diesen Zahlen

können gleich auch die Summanden der Teststatistik cN bestimmt werden:

j fo,j fe,j (fo,j

1 8

7

2 5 5.25

3 3

5.5

4 9 7.25

− fe,j )2 /fe,j

0.1428

0.0119

1.1364

0.4224

Durch Summation der letzten Spalte erhält man schließlich für die Teststatistik

den Wert 1.7135. Üblicherweise ist der Name dieser Teststatistik χ2 , so dass das

Ergebnis meist als χ2 = 1.7135 notiert würde (die vorläufige Bezeichnung cN

dient nur der Bequemlichkeit bei einigen Formulierungen).

Der Test besteht nun darin, dass man diesen Wert mit dem 5%-Fraktil der χ21 Verteilung vergleicht. Dieser kritische Wert ist 3.841, weshalb das Ergebnis nicht

signifikant ist. Dass hier die χ2 -Statistik mit einem Freiheitsgrad verwendet wird,

liegt daran, dass zwei Verteilungsparameter geschätzt wurden, wodurch im Vergleich zur Situation einer festen Verteilung unter H0 eben gerade zwei Freiheitsgrade verloren gehen. Hätte man hingegen beispielsweise grundsätzlich eine Varianz von 225 vorausgesetzt, so hätte man nur den Erwartungswert geschätzt und

für die Streuung 15 eingesetzt. In diesem Fall wäre also nur ein Parameter geschätzt worden, weshalb zur Ermittlung des kritischen Wertes die χ2 -Verteilung

mit 2 Freiheitsgraden zu verwenden gewesen wäre.

Die Nullhypothese kann also nicht verworfen werden, was jedoch natürlich keineswegs bedeutet, dass man sich für ihre Richtigkeit entscheiden könnte (zu einem

solchen Ergebnis könnte man höchstens kommen, wenn man die Power des Tests

kennen würde und diese hinreichend hoch wäre; davon kann bei der denkbar

unexakten Alternativhypothese hier nicht die Rede sein).

1.3

Spezielle Verfahren

QM2 15

32

In vielen Situationen möchte man nun allerdings die Nullhypothese stützen, beispielsweise, weil man die Voraussetzung der Normalverteiltheit für weitere Tests

benötigt. Bekanntlich geht man dabei so vor, dass man ein höheres Signifikanzniveau wählt und hofft, dass der Test dennoch nicht signifikant wird (dieser Satz

ist deskriptiv und nicht normativ gemeint).

Wäre eine solche Stützung der Nullhypothese hier das Ziel gewesen, so hätte man

vielleicht α = .25 gewählt und als kritischen Wert 1.32330 erhalten. Der erhaltene

Wert 1.7135 wäre nun leider signifikant, womit auch nichts erreicht wäre, nichts

im Sinne der H0 und auch nichts im Sinne der H1 , da ja ein signifikantes Ergebnis

auf dem 25%-Niveau nichts wert ist.

Viele Computerprogramme hätten im vorliegenden Fall zu dem errechneten Wert

χ2 = 1.7135 einen p-Wert von .1905 ausgegeben. Da dieser Wert nahe an .2 liegt,

wären womöglich manche Praktiker damit zufrieden und würden sich berechtigt

fühlen, hinfort von der Normalverteiltheit von X auszugehen.

Es folgen noch einige Anmerkungen.

1. Die Faustregel ‚Anzahl der freien Parameter unter H1 minus Anzahl der

freien Parameter unter H0 ‘ für die Zahl der Freiheitsgrade liefert auch hier

die richtige Zahl – siehe jedoch Anmerkung 3.

2. Es gibt weitere Verfahren, die dem hier vorgestellten ähnlich sind; beispielsweise werden manchmal nicht die Grenzen der Aj vorgegeben, sondern

gleich deren z-Werte.

3. Zur Rechtfertigung des behandelten χ2 -Tests braucht man wieder eine Aussage über das Verhalten der Teststatistik cN für N → ∞. In der Tat konvergiert diese Teststatistik bei Vorliegen einer Verteilung aus der Verteilungsklasse der H0 wieder schwach gegen die χ2 -Verteilung mit den angegebenen Freiheitsgraden, sofern eine passende Methode der Parameterschätzung verwendet wird. Die hier referierte (und weitgehend übliche) Methode,

Mittelwert und korrigierte Stichprobenvarianz zu verwenden, gehört jedoch

leider nicht zu diesen passenden Methoden. In diesem Sinn ist das oben

geschilderte Verfahren nicht gerechtfertigt. Passende Methoden der Parameterschätzung sind beispielsweise die sogenannte ‚Minimum-χ2 -Methode‘

oder eine ‚Maximum-Likelihood-Methode‘, die auf den beobachteten Häufigkeiten in den Aj beruht. Diese Methoden werden allerdings praktisch

wohl kaum verwendet und werden daher hier auch nur erwähnt.

1.3

Spezielle Verfahren

QM2 15

33

4. Gelegentlich werden auch in dieser Testsituation geeignete Adaptationen

des Kolmogoroff-Smirnoff-Tests benutzt.

Der Kolmogoroff-Smirnoff-Test.

Eine Alternative zum χ2 -Test für eine feste Verteilung bietet oft der KolmogoroffSmirnoff-Test. Vorausgesetzt ist dabei, dass es sich bei der untersuchten Variable

X um eine reelle Zufallsvariable handelt. Unter der Nullhypothese soll die Verteilung zudem stetig sein.

Die Nullhypothese ist also wieder die, dass die Verteilung von X gleich einer

stetigen fest vorgegebenen Verteilung V0 mit Verteilungsfunktion F0 ist, während

die Alternativhypothese sagt, dass die Verteilung von X nicht V0 ist.

Als Daten werden die Werte von X bei einer unabhängigen Stichprobe vom Umfang N verwendet.

Die Idee des Tests ist nun sehr naheliegend: Man vergleicht die kumulierten relativen Häufigkeiten Fe (e: empirisch) der Stichprobe mit der Verteilungsfunktion

F0 und lehnt die Nullhypothese bei großen Diskrepanzen ab.

Die Durchführung des Tests soll an einem Beispiel illustriert werden. Hier sei die

Nullhypothese die, dass die Variable X eine N (1, 4)-Verteilung besitzt, dass X

also normalverteilt ist mit Erwartungswert 1 und Varianz 4. Als Stichprobe sollen

die Werte −1.8, 2.5, 3.8, 3.3, 3.5 vorliegen.

Die Gegenüberstellung der kumulierten relativen Häufigkeiten Fe und der Verteilungsfunktion F0 der N (1, 4)-Verteilung ergibt folgendes Bild:

1

.

........

........

....

...

...

.

.................................................................

..................

..........................

...................

................

.

.

.

.

.

.

.

.

.

.

.

.

........

.

.

.

.

.

.

.

.

.

..

..........

.................

.........

.........

.........

........

.

.

.

.

.

.

.

......

.

.

.

.

.

.

.

........

.......

...........

.......

.......

.......

.

.

.

.

.

.

....

.

.

.

.

.

.

..

.......

.......

.......

...........................................

.......

.......

.

.

.

.

.

.

.

........

........

.

.

.

.

.

.

...

........

........

..................................................................................................................................................................................................................................................

.........

.

.

.

.

.

.

.

.

.

.

.

............

..............

.................

.....................

.................................

.......................................................................................................................................................................................................................................................................................................................................................................................................................................................

F0

.5

Fe

x

1.3

Spezielle Verfahren

QM2 15

34

Die Teststatistik K ist nun die maximale absolute Abweichung zwischen den

beiden Graphen. Es sollte unmittelbar klar sein, dass eine maximale Abweichung

immer an einer der Stellen vorliegen wird, an denen Fe einen Sprung macht, also

gerade an einer der durch die Daten gegebenen Stellen.

Bei der Suche nach dem maximalen Abstand braucht man also nur diese x-Werte

berücksichtigen. Dort werden dann die Niveaus zu beiden Seiten der Sprungstelle

mit dem Wert der Verteilungsfunktion verglichen (es wird also zu dem Graphen

der kumulierten relativen Häufigkeitsverteilung Fe sozusagen noch der untere

‚Absprungspunkt‘ hinzugefügt, der ja streng genommen nicht dazugehört – nur

durch diese Hinzufügung ist übrigens garantiert, dass der ‚maximale Abstand‘

immer auch an (mindestens) einer Stelle wirklich vorliegt). Die größere der beiden

absoluten Diffenzen ist dann ein Kandidat für die maximale absolute Differenz

insgesamt.

Beispielsweise macht die empirische kumulative Häufigkeitsverteilung einen Sprung

an der Stelle x = 2.5, nämlich von .2 auf .4. Diese beiden Werte werden nun mit

dem Wert .7734 verglichen, den man für F0 an der Stelle 2.5 berechnet. Die beiden

absoluten Abstände (die Richtung der Abweichung wird also nicht berücksichtigt)

sind dann .5734 und .3734. Als Kandidat für den insgesamt maximalen Abstand

kommt natürlich nur der größere der beiden Werte, also .5734, in Frage.

In der folgenden Tabelle ist entsprechend für alle Datenpunkte der maximale

absolute Abstand D bestimmt:

x

Fe (x)

-1.8

0.2

2.5

0.4

0.6

3.3

3.5

0.8

3.8

1.

F0 (x)

0.0808

0.7734

0.8749

0.8944

0.9192

D(x)

0.1192

0.5734

0.4749

0.2944

0.1192

Der maximale Abstand insgesamt ist nun offenbar .5734, er liegt an der Stelle

x = 2.5 vor. Damit ist der Wert der Teststatistik K ermittelt: es gilt K = .5734.

Die Frage ist nun die, ob dieser Wert groß genug ist, um die Nullhypothese zu

verwerfen. Hierzu braucht man die Verteilung von K unter H0 .

Bemerkenswert ist, dass diese Verteilung nicht mehr von dem speziellen V0 abhängt; vielmehr ist die Verteilung von K bei festem N in allen Situationen die

1.3

Spezielle Verfahren

QM2 15

35

gleiche, in denen die Nullhypothese gilt, gleichgültig, welche Verteilung X dann

besitzt (natürlich muss diese Verteilung stetig sein).

Kritische Werte für K findet man in geeigneten Tabellen. Für den hier vorliegenden Fall liefert eine solche Tabelle für das 5%-Niveau den Wert .563. Da der Wert

K = .5734 größer ist als dieser kritische Wert, kann die Nullhypothese verworfen

werden; die Entscheidung lautet also, dass X keine N (1, 4)-Verteilung besitzt.

In vielen Tabellen sind eigentlich nicht die kritischen Werte für den hier beschriebenen ‚zweiseitigen‘ Test aufgeführt, sondern die für gewisse hier nicht behandelte

einseitige Tests, in denen man nur Abweichungen in eine Richtung (nach oben

oder nach unten) berücksichtigt. Wichtig ist nun, dass kritische Werte für diese

einseitigen Tests auf dem Niveau α auch für den zweiseitigen Test benutzt werden

können, allerdings auf dem Niveau 2α. Dies dürfte den Aufbau solcher Tabellen

etwas klarer machen.

Ganz genau betrachtet ist es so, dass bei einer solchen Benutzung der einseitigen

kritischen Werte die Wahrscheinlichkeit eines Fehlers erster Art beim zweiseitigen

Test oft sogar etwas kleiner ist als 2α. Dies hat zur Folge, dass der Test das

vorgegebene Niveau 2α einhält und in diesem Sinne korrekt ist. Es bedeutet aber

auch, dass dieses Niveau von 2α womöglich nicht ganz ausgeschöpft wird und

daher der Test durch eine Verkleinerung des kritischen Wertes vielleicht noch

etwas verbessert werden könnte (im Sinne der Power), ohne das vorgegebene

Niveau von 2α zu überschreiten.

Da die Verbesserung im Allgemeinen jedoch nicht besonders groß wäre, wird aus

Ökonomiegründen oft auf eine eigene Tabellierung der kritischen Werte für zweiseitige Tests verzichtet. Die Tests, die man dann mit der beschriebenen Verwendung der einseitigen kritischen Werte für den zweiseitigen Fall erhält, schützen

in vielen Fällen gewissermaßen die Nullhypothese stärker als es eigentlich nötig

wäre.

Tests mit der Eigenschaft, die Nullhypothese zu stark zu schützen, nennt man

auch konservativ.

Wenn man abschließend bei der Frage, ob eine Variable X eine bestimmte Verteilung V0 hat, die beiden Testmöglichkeiten χ2 und KS (Kolmogoroff-Smirnoff)

vergleicht, so spricht eigentlich fast alles für KS.

Zunächst ist dies ein exakter Test (die genaue Verteilung der Teststatistik unter