diplomarbeit - E

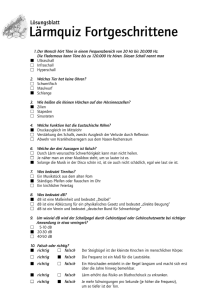

Werbung