Definitions- und Satzverzeichnis

Werbung

Definitions- und

Satzverzeichnis

5 Lineare Abbildungen

5.1 Lineare Abbildung . . . . . . . .

5.2 Rang, Bild, Kern . . . . . . . . .

5.3 Affine Linearität . . . . . . . . .

5.4 Abbildungsmatrix bzgl. Basen . .

5.5 Transformationsmatrix . . . . .

5.6 Eigenschaften einer Matrixnorm .

5.7 Frobenius-Norm . . . . . . . . . .

Höhere Mathematik 1

WS 2009/10

Inhaltsverzeichnis

I

Definitionen

3

1 Grundlagen

1.1 Mengen . . . . . . . . . . . . . . . . . . . . . . . .

1.2 Natürliche Zahlen und Vollständige Induktion . . .

1.3 Rationale und Reelle Zahlen . . . . . . . . . . . . .

1.3.1 Wurzeln . . . . . . . . . . . . . . . . . . . .

1.3.2 Beträge . . . . . . . . . . . . . . . . . . . .

1.3.3 Ungleichungen und Intervalle . . . . . . . .

1.3.4 Maximum, Minimum, Supremum, Infimum

1.4 Kombinatorik . . . . . . . . . . . . . . . . . . . . .

1.5 Trigonometrie . . . . . . . . . . . . . . . . . . . . .

1.6 Komplexe Zahlen . . . . . . . . . . . . . . . . . . .

1.6.1 Polardarstellung . . . . . . . . . . . . . . .

1.7 Funktionen . . . . . . . . . . . . . . . . . . . . . .

1.8 Axiomatik für N und R . . . . . . . . . . . . . . . .

1.8.1 Peano-Axiome . . . . . . . . . . . . . . . .

1.8.2 Zahlendarstellung, Basis . . . . . . . . . . .

1.8.3 Axiomatik für R . . . . . . . . . . . . . . .

1.9 Primzahlen . . . . . . . . . . . . . . . . . . . . . .

3

3

3

3

3

3

3

3

3

3

3

3

3

3

3

4

4

4

2 Matrizen und lineare Gleichungssysteme

2.1 Matrix . . . . . . . . . . . . . . . . . . . . .

2.2 Matrix-Addition und Skalar-Multiplikation

2.3 Matrix-Multiplikation . . . . . . . . . . . .

2.4 Einheitsmatrix . . . . . . . . . . . . . . . .

2.5 Äquivalente LGS . . . . . . . . . . . . . . .

2.6 Homogene LGS . . . . . . . . . . . . . . . .

2.7 Gauß’sches Eliminationsverfahren . . . . . .

2.8 Rang . . . . . . . . . . . . . . . . . . . . . .

2.9 Transponierte Matrix . . . . . . . . . . . . .

2.10 Symmetrische, schiefsymmetrische Matrix .

2.11 Gauß-Jordan-Verfahren . . . . . . . . . . .

2.12 Determinanten . . . . . . . . . . . . . . . .

2.13 Dreiecksmatrix, Stufenform . . . . . . . . .

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

4

4

4

4

4

4

4

4

4

4

4

4

4

4

3 Vektorräume

3.1 Gruppe . . . . . . . . . . . . . . . . . . . .

3.2 Körper . . . . . . . . . . . . . . . . . . . . .

3.3 Vektorraum . . . . . . . . . . . . . . . . . .

3.4 Unterraum . . . . . . . . . . . . . . . . . .

3.5 Kern . . . . . . . . . . . . . . . . . . . . . .

3.6 Linearkombination, lineare Hülle . . . . . .

3.7 Erzeugendensystem . . . . . . . . . . . . . .

3.8 Lineare Abhängigkeit . . . . . . . . . . . . .

3.9 Basis . . . . . . . . . . . . . . . . . . . . . .

3.10 Dimension . . . . . . . . . . . . . . . . . . .

3.11 Zeilen- und Spaltenraum . . . . . . . . . . .

3.12 Restklassen-Körper . . . . . . . . . . . . . .

3.13 Codes und Codewörter . . . . . . . . . . . .

3.14 Fehler erkennende und korrigierende Codes

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

4

4

5

5

5

5

5

5

5

5

5

5

5

5

5

4 Länge, Winkel, Skalarprodukte

4.1 Norm . . . . . . . . . . . . . . . . . . . . . . . . .

4.2 lp -Normen, Maximumsnorm . . . . . . . . . . . . .

4.3 Skalarprodukt . . . . . . . . . . . . . . . . . . . . .

4.4 Positive Definitheit . . . . . . . . . . . . . . . . . .

4.5 Winkel . . . . . . . . . . . . . . . . . . . . . . . . .

4.6 Orthogonalität . . . . . . . . . . . . . . . . . . . .

4.7 Orthogonalbasis . . . . . . . . . . . . . . . . . . . .

4.8 Orthogonale Zerlegung und orthogonale Projektion

4.9 Gram-Schmidt Orthogonalisierung . . . . . . . . .

4.10 Orthogonale Matrix . . . . . . . . . . . . . . . . .

4.11 Kreuzprodukt/Vektorprodukt . . . . . . . . . . . .

5

5

5

6

6

6

6

6

6

6

6

6

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

6

6

6

6

6

6

6

6

6 Eigenwerte und Matrixfaktorisierung

6.1 Eigenwert, Eigenvektor . . . . . . . . .

6.2 Algebraische Vielfachheit . . . . . . .

6.3 Eigenraum, geometrische Vielfachheit

6.4 Diagonalisierbarkeit (Funktion) . . . .

6.5 Diagonalisierbarkeit (Matrix) . . . . .

6.6 Ähnliche Matrizen . . . . . . . . . . .

6.7 Schur-Zerlegung (Algorithmus) . . . .

6.8 Singulärwertzerlegung (Algorithmus) .

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

6

6

6

7

7

7

7

7

7

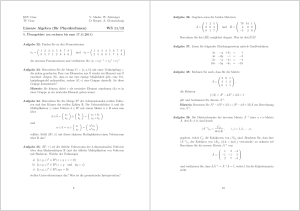

7 Folgen und Reihen

7.1 Beschränkte Folge . . . . . . .

7.2 Konvergenz . . . . . . . . . . .

7.3 Spezielle Grenzwerte, Divergenz

7.4 ε-Umgebung, Konvergenz . . .

7.5 Monotonie . . . . . . . . . . . .

7.6 Teilfolge . . . . . . . . . . . . .

7.7 Reihe, Folge der Partialsummen

7.8 Absolute Konvergenz . . . . . .

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

7

7

7

7

7

7

7

7

7

II

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

Sätze und Propositionen

1 Grundlagen

1.1 Rechenregeln: Mengen . . . . . . . . . .

1.2 Gerade und ungerade Zahlen . . . . . .

1.3 Vielfache von 3 . . . . . . . . . . . . . .

1.5 Periodische

Dezimalbrüche . . . . . . . .

√

2∈

/Q . . . . . . . . . . . . . . . . . .

1.6

1.7 Betrag, Wurzel, Dreiecksungleichung . .

1.8 Ungleichungen . . . . . . . . . . . . . .

1.9 Zahlendarstellung, Größte Zahl, Basis .

1.10 Summe, geometrische Summe . . . . . .

1.11 Kombinatorik . . . . . . . . . . . . . . .

1.12 Pascal’sches Dreieck . . . . . . . . . . .

1.13 Binomischer Lehrsatz . . . . . . . . . .

1.15 Sinus und Cosinus . . . . . . . . . . . .

1.16 Additionstheoreme . . . . . . . . . . . .

1.17 Additionstheoreme (Sonderfälle) . . . .

1.18 Tangens, Kotangens . . . . . . . . . . .

1.19 Sinusgleichungen . . . . . . . . . . . . .

1.20 Fundamentalsatz der Algebra . . . . . .

1.22 Komplexe Zahlen: Division . . . . . . .

1.23 Polardarstellung: Multiplikation . . . . .

1.24 Injektiv, surjektiv, bijektiv . . . . . . . .

1.25 Eindeutigkeit der Darstellung einer Zahl

1.26 R ist nicht abzählbar . . . . . . . . . . .

1.27 Fundamentalsatz der Arithmetik . . . .

1.28 Es gibt unendlich viele Primzahlen . . .

8

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

8

8

8

8

8

8

8

8

8

8

8

8

8

8

8

8

8

8

8

8

8

9

9

9

9

9

2 Matrizen und lineare Gleichungssysteme

2.1 Addition, Skalar-Multiplikation . . . . . .

2.2 Einheitsmatrix In , neutrales Element . . .

2.3 Matrixmultiplikation . . . . . . . . . . . .

2.4 Anzahl der Lösungen eines LGS . . . . . .

2.5 Äquivalent Umformungen . . . . . . . . .

2.6 Homogenität, triviale Lösung . . . . . . .

2.7 Rang . . . . . . . . . . . . . . . . . . . . .

2.8 Lösungen von homogenen LGS . . . . . .

2.9 Lösungen von inhomogenen LGS . . . . .

2.10 Rechenregeln: Transponierte Matrizen . .

2.11 Inverse einer Matrix . . . . . . . . . . . .

2.12 Invertierbarkeit einer Matrix . . . . . . .

2.13 Rechenregeln: Invertierbare Matrizen . . .

2.14 Berechnen einer Determinanten . . . . . .

2.15 Determinante der Einheitsmatrix . . . . .

2.16 Sarrus-Regel . . . . . . . . . . . . . . . . .

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

9

9

9

9

9

9

9

9

9

9

9

9

9

9

9

9

10

2.17

2.19

2.20

2.21

2.22

2.24

Rechenregeln: Determinanten . . . . . . . . .

Determinante einer oberen Dreiecksmatrix . .

Umformen einer Determinante . . . . . . . .

Kriterien für eindeutige Lösbarkeit eines LGS

Rechenregeln: Determinanten . . . . . . . . .

Cramer’sche Regel . . . . . . . . . . . . . . .

.

.

.

.

.

.

10

10

10

10

10

10

3 Vektorräume

3.1 Gruppen . . . . . . . . . . . . . . . . . . . . . . . .

3.2 Beispiele für Gruppen . . . . . . . . . . . . . . . .

3.4 Körper . . . . . . . . . . . . . . . . . . . . . . . . .

3.5 Beispiele für Körper . . . . . . . . . . . . . . . . .

3.6 Rechenregeln: Vektorraum . . . . . . . . . . . . . .

3.8 Rechenregeln: Untervektorraum . . . . . . . . . . .

3.11 Lineare Abhängigkeit . . . . . . . . . . . . . . . . .

3.12 Beispiel . . . . . . . . . . . . . . . . . . . . . . . .

3.13 Lineare Abhängigkeit, Nullvektor, Teilfamilie . . .

3.14 Lineare Abhängigkeit . . . . . . . . . . . . . . . . .

3.15 Linearkombination . . . . . . . . . . . . . . . . . .

3.16 Lineare Abhängigkeit . . . . . . . . . . . . . . . . .

3.17 K-VR mit zwei Basen ⇒ gleiche Anzahl Vektoren .

3.18 Basisergänzungssatz . . . . . . . . . . . . . . . . .

3.20 Basis . . . . . . . . . . . . . . . . . . . . . . . . . .

3.22 Dimension von Zeilen- und Spaltenräumen . . . . .

3.23 Rechenregeln: Zeilen- und Spaltenräume . . . . . .

3.24 Äquivalenz bei elementaren Operationen . . . . . .

3.25 Rangungleichung . . . . . . . . . . . . . . . . . . .

3.26 Dimensionsformel . . . . . . . . . . . . . . . . . . .

3.27 Invertierbarkeit, Dimension, Lin. Unabhängigkeit .

3.28 Restklassen-Körper, Modulo-Multiplikation . . . .

3.29 Existenz n-elementiger Körper Fn . . . . . . . . . .

10

10

10

10

10

10

10

10

10

10

11

11

11

11

11

11

11

11

11

11

11

11

11

11

4 Länge, Winkel, Skalarprodukte

4.4 Definition eines Skalarproduktes auf Rn

4.6 Positive Definitheit . . . . . . . . . . . .

4.7 Induzierte Norm des Skalarproduktes . .

4.8 Cauchy-Schwarz-Ungleichung . . . . .

4.10 Standard ONB, Lineare Unabhängigkeit

4.11 Orthogonale Zerlegungen . . . . . . . .

4.12 Orthogonaler Raum . . . . . . . . . . .

4.13 Orthogonale Projektion . . . . . . . . .

4.14 Abstand, Orthogonale Projektion . . . .

4.15 Rechenregeln: Orthogonale Matrizen . .

4.16 Rechenregeln: Kreuzprodukt . . . . . . .

.

.

.

.

.

.

.

.

.

.

.

11

11

11

11

11

11

11

12

12

12

12

12

5 Lineare Abbildungen

5.2 Bild(f ) ⊂ Y , Kern(f ) ⊂ X . . . . . . . . . . . . . .

5.5 f injektiv ⇔ Kern(f ) = {0} . . . . . . . . . . . . .

5.6 Dimensionsformel Bild, Kern . . . . . . . . . . . .

5.7 f : X → X ⇔ f bijektiv . . . . . . . . . . . . . . .

5.8 Lösungsmenge Ax = b, Kern, Rang, Inv.barkeit . .

5.10 Eigenschaften einer Basis . . . . . . . . . . . . . .

5.11 Anwendung der Abbildungsmatrix . . . . . . . . .

5.12 Invertierbarkeit der Transformationsmatrix . . . .

5.13 Basiswechsel mit Transformationsmatrix (Matrix)

5.14 Basiswechsel mit Transformationsmatrix (λ) . . .

5.15 Abbildungsmatrix bezüglich neuer Basen . . . . .

5.18 Induzierte Matrixnorm . . . . . . . . . . . . . . . .

5.19 Induzierte Maximums- und 1-Norm . . . . . . . . .

12

12

12

12

12

12

12

12

12

12

12

12

12

13

6 Eigenwerte und Matrixfaktorisierung

6.1 Eigenwerte, Charakteristisches Polynom . . . . . .

6.3 Determinante, Invertierbarkeit . . . . . . . . . . .

6.5 Algebraische und geometrische Vielfachheiten . . .

6.7 Lineare Unabhängigkeit von Eigenvektoren . . . .

6.8 Diagonale Abbildungsmatrix Af ⇒ f (vi ) = λi vi .

6.9 Abbildungs-, Diagonal- und Transformationsmatrix

6.10 Diagonaliserbarkeit, Eigenwerte, Eigenvektoren . .

6.13 Diagonalisierbarkeit, Eigenwerte . . . . . . . . . .

6.14 Symmetrie ⇒ ONB aus Eigenvektoren . . . . . . .

6.15 Ähnlichkeit, Diagonalisierbarkeit, Eigenwerte/vektoren . . . . . . . . . . . . . . . . . . . . . . . .

6.16 Symmetrie, positive Definitheit, Eigenwerte . . . .

6.17 Obere Schranke für Eigenwerte . . . . . . . . . . .

6.18 Euklidische Norm (Symmetrische Matrix) . . . . .

6.19 Euklidische Norm (Asymmetrische Matrix) . . . .

13

13

13

13

13

13

13

13

13

13

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

13

13

13

13

13

6.20 Schur-Zerlegung . . . . . . . . . . . . . . . . . . . .

6.24 Singulärwertzerlegung . . . . . . . . . . . . . . . .

6.25 Eigenschaften der Singulärwertzerlegung . . . . . .

13

13

13

7 Folgen und Reihen

7.2 Eindeutigkeit des Grenzwertes . . . . . . . . . . . .

7.3 Beschränkte Folge, Grenzwert . . . . . . . . . . . .

7.4 Beschränktheit, Konvergenz . . . . . . . . . . . . .

7.5 Grenzwert: Rechenregeln . . . . . . . . . . . . . . .

7.6 Grenzwert: Ungleichungen . . . . . . . . . . . . . .

7.8 Sandwich-Theorem . . . . . . . . . . . . . . . . . .

7.9 Beschränktheit, Monotonie, Konvergenz . . . . . .

7.10 Fixpunktgleichung, Rekursion . . . . . . . . . . . .

7.11 Bernoulli-Ungleichung . . . . . . . . . . . . . . .

7.13 Euler’sche Folge, Exponentialfunktion . . . . . . .

7.14 Konvergenz-Kriterium für Folgen (Cauchy) . . . .

7.15 Konvergenz von Teilfolgen . . . . . . . . . . . . . .

7.16 Divergenz, Teilfolgen . . . . . . . . . . . . . . . . .

7.17 Beschränktheit, konvergente Teilfolge (BolzanoWeierstraß) . . . . . . . . . . . . . . . . . . . .

7.18 Geometrische Reihe . . . . . . . . . . . . . . . . .

7.19 Harmonische Reihe . . . . . . . . . . . . . . . . . .

7.20 Rechenregeln: Reihen . . . . . . . . . . . . . . . . .

7.21 Konvergenz-Kriterium für Reihen (Cauchy) . . . .

7.22 Reihen-Konvergenz, Nullfolge . . . . . . . . . . . .

7.23 Absolute Konvergenz, Konvergenz . . . . . . . . .

7.24 Alternierende Reihe (−1)k ak (Leibniz-Kriterium)

7.25 Beschränktheit, Absolute Konvergenz . . . . . . .

7.26 Majoranten-Kriterium . . . . . . . . . . . . . . . .

7.27 Zeta-Reihe 1/kr . . . . . . . . . . . . . . . . . . .

7.29 Quotientenkriterium . . . . . . . . . . . . . . . . .

7.30 Quotientenkriterium für k → ∞ . . . . . . . . . . .

7.31 Wurzelkriterium . . . . . . . . . . . . . . . . . . .

14

14

14

14

14

14

14

14

14

14

14

14

14

14

14

14

14

14

14

14

14

14

14

15

15

15

15

15

3

man von einem Minimum von M: min(M ) = inf(M ). Jede nach

unten beschränkte Menge hat ein Infimum ∈ R.

Wenn M ⊂ R nicht nach oben bzw. unten beschränkt, dann schreibe sup(M ) = +∞ bzw. inf(M ) = −∞.

Teil I

Definitionen

1 Grundlagen

1.4

1.1

Mengen

Eine Menge ist eine Zusammenfassung bestimmter, wohlunterschiedener Objekte, die wir Elemente dieser Menge nennen.

Wenn x Element von M ist, dann schreibe x ∈ M , sonst x ∈

/ M.

Kardinalität |M | := Anzahl der Elemente von M .

∃

:=

,,es existiert”

∀

:=

,,für alle”

[n]

:=

{1, 2, ...n}

∅

:=

,,leere Menge”

k

S

Mi

:=

M1 ∪ M2 ∪ ... ∪ Mk

i=1

k

T

i=1

k

P

i=1

k

Q

Mi

:=

M1 ∩ M2 ∩ ... ∩ Mk

ai

:=

a1 + a2 + ... + ak

N

N0

Z

1.3

Q

R

1.3.1

1.5

cos(α) und sin(α) sind die Koordinaten des Punktes Pα auf dem

Einheitskreis mit Winkel α, also Pα = (cos(α), sin(α)).

sin(x)

tan(x) := cos(x) ∀ x 6= πk + π2 mit k ∈ Z

ai

:=

a1 · a2 · ... · ak

Natürliche Zahlen und Vollständige Induktion

:=

:=

:=

Rationale und Reelle Zahlen

:=

:=

1.6

Komplexe Zahlen

,,natürliche Zahlen” := {1, 2, 3, ...}

C := {(a, b) | a, b ∈ R} heißt die Menge der komplexen Zahlen.

,,natürliche Zahlen mit Null” := {0, 1, 2, 3, ...}

,,ganze Zahlen” := N0 ∪ {−n | n ∈ N} = {0, 1, −1, 2, −2, ...}Die Menge {(a, b) ∈ C | b = 0} ⊂ C entspricht R.

{m

n

,,rationale Zahlen” =

| m ∈ Z, n ∈ N}

,,reelle Zahlen” = ,,alle möglichen Dezimalzahlen”,

insb. auch nicht-endliche und nicht-periodische Zahlen.

Wurzeln

Beträge

(a, b) + (c, d) := (a + c, b + d)

(a, b) · (c, d) := (ac − bd, ad + bc)

(a, b) = (c, d) ⇔ a = c ∧ b = d

i := (0, 1) ,,imaginäre Einheit”

(a, b) = a + i · b

Re(a + ib) := a ,,Realteil von a + ib”

Im(a + ib) := b ,,Imaginärteil von a + ib”

a + ib := a√

− ib ,,Konjugierte Zahl zu a + ib”

|a + ib| := a2 + b2 ,,Betrag von a + ib”

(

a

−a

wenn a ≥ 0

wenn a < 0

Ungleichungen und Intervalle

Seien a, b ∈ R mit

[a, b]

:=

(a, b)

:=

(a, b]

:=

[a, b)

:=

[a, +∞)

:=

(a, +∞)

:=

(−∞, b]

:=

(−∞, b)

:=

Polardarstellung

p

x2 (

+ y2

+ arccos( xr ) für y ≥ 0

ϕ := arg(x + iy) :=

− arccos( xr ) für y ≤ 0

x = r cos(ϕ), y = r sin(ϕ)

r := |x + iy| =

Wenn a ∈ R, dann ist der Betrag von a |a| :=

1.3.4

∀ x 6= πk mit k ∈ Z

√

sin( π5 ) = 41 10 − 2 5 ,

arcsin(x) = y ⇔ x = sin(y)

arccos(x) = y ⇔ x = cos(y)

1.6.1

1.3.3

1

tan(x)

p

√

Sei n ∈ N und a ∈ R mit a ≥ 0. n a ist die eindeutige, nicht

negative reelle Lösung √

der Gleichung xn = a. Wenn n ungerade

und a < 0, dann ist − n −a Lösung der Gleichung xn = a.

1.3.2

Trigonometrie

Einheitskreis := Kreis um Ursprung mit Radius 1

Bogenlänge := Länge der Kreislinie

π ≈ 22

≈ 3, 14 := Bogenlänge des halben Einheitskreises

7

cot(x) :=

i=1

1.2

Kombinatorik

Q

n! := n

k=1 k = 1 · 2 · ... · n ,,n Fakultät”

0! := 1

n

n!

,,Binomial-Koeffizient”

:= k!(n−k)!

k

a < b.

{x ∈ R | a ≤ x

{x ∈ R | a < x

{x ∈ R | a < x

{x ∈ R | a ≤ x

{x ∈ R | a ≤ x

{x ∈ R | a < x

{x ∈ R |

{x ∈ R |

Q

zx

∧

∧

∧

∧

x ≤ b} ,,abgeschlossen”

x < b} ,,offen”

x ≤ b} ,,halboffen”

x < b}

}

}

x ≤ b}

x < b}

Maximum, Minimum, Supremum, Infimum

M ⊂ R heißt nach oben beschränkt ⇔ ∃b ∈ R mit x ≤ b ∀ x ∈ M .

b heißt dann obere Schranke von M .

M ⊂ R heißt nach unten beschränkt ⇔ ∃a ∈ R mit a ≤ x ∀ x ∈

M . a heißt dann untere Schranke von M .

M ⊂ R heißt beschränkt, wenn M nach oben und nach unten

beschränkt ist.

Q

P

P

zi = ( |zi |) (cos( ϕi ) + i sin( ϕi ))

x

= |z| (cos(xϕ) + i sin(xϕ))

1.7

Seien X, Y Mengen. Eine Funktion f von X nach Y ist eine

Teilmenge f ⊂ {(x, y) | x ∈ X, y ∈ Y } mit der Eigenschaft

|{y ∈ Y | (x, y) ∈ f }| = 1 ∀ x ∈ X.

Das zu x ∈ X durch f eindeutig zugeordnete y ∈ Y heißt Bild

von x und wird mit f (x) bezeichnet.

Schreibe: f : X → Y, x 7→ f (x).

Die Menge f −1 (y) := {x ∈ X | f (x) = y} heißt Urbild von y.

f heißt

injektiv wenn |f −1 (y)| ≤ 1 ∀ y ∈ Y

surjektiv wenn |f −1 (y)| ≥ 1 ∀ y ∈ Y

bijektiv wenn |f −1 (y)| = 1 ∀ y ∈ Y

Wenn ∃f : N → M , f surjektiv, dann heißt die Menge M

abzählbar.

1.8

M sei nach oben beschränkt. Die kleinste obere Schranke von

M heißt Supremum von M , sup(M ). Wenn sup(M ) ∈ M , dann

spricht man von einem Maximum von M: max(M ) = sup(M ).

Jede nach oben beschränkte Menge hat ein Supremum ∈ R.

M sei nach unten beschränkt. Die größte untere Schranke von M

heißt Infimum von M , inf(M ). Wenn inf(M ) ∈ M , dann spricht

Funktionen

1.8.1

Axiomatik für N und R

Peano-Axiome

1. 1 ∈ N

2. ∃ genau ein Nachfolger(n) ∀ n ∈ N

3. Jede Zahl ∈ N ist Nachfolger von höchstens einer Zahl ∈ N

4

2.7

Gauß’sches Eliminationsverfahren

1. Aufstellen von (A|b)

5. Für jede Teilmenge M ⊂ N gilt:

Wenn 1 ∈ M und Nachfolger(n) ∈ M ∀ n ∈ M , dann ist

M =N

2. Vorwärtselimination

mit

1.8.2

Zahlendarstellung, Basis

Axiomatik für R

R = {( a, a1 a2 a3 ... ) mit a ∈ Z, ai ∈ {0, ...9}}

P

−i

( a, a1 a2 a3 ... ) steht für x = a + ∞

i=1 ai 10 . ai heißt i-te Nachkommastelle von x.

P

−i mit x(0) := 0

x(n) := a + n

i=1 ai 10

x, y ∈ R sind gleich, wenn x(n) = y(n) ∀ n ∈ N oder

x = a, a1 a2 ...

ak

999... mit ak 6= 9

y = a, a1 a2 ...

(ak + 1)

000...

1.9

..

Zeilen-

3. Lösbarkeitstest

Sei b ∈ N, b ≥ 2, k ∈ N0 , ai ∈ {0, 1, ..., b − 1}.

( ak ak−1 ... a1 a0 )b ist eine Darstellung der Zahl

P

n = ki=0 ai bi zur Basis b.

1.8.3

elementaren

!

a011 ... a01n

0

0 0 a0mn

.

/Spaltenumformungen. Ziel:

...

4. Keine Zahl ∈ N hat den Nachfolger 1

4. Wenn lösbar: Rückwärtssubstitution

2.8

Rang

Sei A ∈ Rm×n , b ∈ Rm , Ax = b, (A|b).

Rang(A) :=Anzahl der ”Nicht-Komplett-Null-Zeilen”von A, wenn

(A|b) in Zeilenstufenform.

Rang(A|b) :=Anzahl der ”Nicht-Komplett-Null-Zeilen”von (A|b),

wenn (A|b) in Zeilenstufenform.

2.9

Transponierte Matrix

Sei A = (aij ) ∈ Rm×n . Dann ist AT ∈ Rn×m definiert durch

(AT )ij = aji . AT heißt Transponierte von A.

2.10

Primzahlen

Symmetrische, schiefsymmetrische Matrix

Sei A ∈ Rn×n (d.h. A quadratisch).

Eine Primzahl ist eine natürliche Zahl n > 1, die nur durch 1 und

sich selbst teilbar ist.

1. A heißt symmetrisch :⇔ AT = A.

2. A heißt schiefsymmetrisch :⇔ AT = −A.

2 Matrizen und lineare Gleichungssysteme

2.11

2.1

Prüft, ob A ∈ Rn×n invertierbar ist.

1. Erweitere mit Einheitsmatrix (A|In )

m, n ∈ N. Eine m × n Matrix ist ein rechteckiges Zahlenschema

der Form

a

a

... a

2. Vorwärtselimination bis (M |N ), wobei M in Zeilenstufenform sein soll.

1n

...

.

..

...

...

am1 am2 ... amn

abkürzende Schreibweise: A = (aij ) = (aij )i∈[m],j∈[n]

Rm×n ist die Menge aller m × n Matrizen mit reellen Komponenten. m×n heißt Dimension von A. Zwei m×n Matrizen A = (aij )

und B = (bij ) sind gleich, wenn ∀ i ∈ [m] , ∀ j ∈ [n] : aij = bij .

2.2

3. Rang(M ) = n ⇒ A invertierbar

4. Rückwärtselimination bis M = In . Man erhält (In |A−1 )

2.12

Matrix-Addition und Skalar-Multiplikation

Für A = (aij ) und B = (bij ) mit A, B ∈ Rm×n ist

für C := A + B wieder C ∈ Rm×n mit C = (cij ) und

∀ i ∈ [m] , ∀ j ∈ [n] : cij := aij + bij .

Für A = (aij ) ∈ Rm×n und λ ∈ R ist C := λA wieder

C ∈ Rm×n mit C = (cij ) und ∀ i ∈ [m] , ∀ j ∈ [n] : cij := λaij

Determinanten

1. Wenn A = a ∈ R1×1 , dann det(A) := a

2. Wenn A = ac db ∈ R2×2 , dann det(A) := ad − bc

3. Bezeichne mit Aij die (n−1)×(n−1) Matrix, die man durch

Löschen der i-ten Zeile und j-ten Spalte erhält.

n

P

det(A) :=

(−1)k+1 ak1 det(Ak1 ).

k=1

2.13

Dreiecksmatrix, Stufenform

∗

Matrix-Multiplikation

j=1

mal Spalte”

(

1

0

i=j

heißt n × n Einheitsmai 6= j

trix.

2.5

Äquivalente LGS

Zwei LGS Ax = b und Cx = d mit A ∈ Rm×n , b ∈ Rm und

C ∈ Rr×n , d ∈ Rr und x ∈ Rn , heißen äquivalent, wenn ihre

Lösungsmengen gleich sind.

2.6

.

0

Homogene LGS

Ein LGS Ax = b heißt homogen, wenn b = 0. Sonst: inhomogen.

0

∗

···

∗

∗

,,Untere Dreiecksmatrix”

!

0

∗

∗

,,Spalten-Stufenform”

3 Vektorräume

3.1

Einheitsmatrix

In = (bij ) ∈ Rn×n mit bij :=

∗

..

Für A = aij ∈ Rm×n und B = bij ∈ Rn×r ist C := AB ∈ Rm×r

n

P

definiert durch C = (cik ) und cik :=

aij bjk . Sprich: ,,Zeile

2.4

∗

0

..

..

2.3

∗

,,Obere” bzw.

∗

∗

,,Zeilen-” bzw.

.

.

∗

.

12

a21 a22 ... a2n

..

11

A=

...

Matrix

Gauß-Jordan-Verfahren

Gruppe

Eine Gruppe ist ein Paar (G, ∗), wobei G eine Menge und ∗ eine

Verknüpfung, d.h.

∗:

G×G→G

(x, y) 7→ x ∗ y

mit den Eigenschaften:

1. ∀ x, y, z ∈ G : (x ∗ y) ∗ z = x ∗ (y ∗ z) (Assoziativgesetz)

2. ∃e ∈ G : (neutrales Element von G)

(G1) ∀ x ∈ G : e ∗ x = x

(G2) ∀ x ∈ G, ∃x0 ∈ G : x0 ∗ x = e

Wenn außerdem noch ∀ x, y ∈ G : x ∗ y = y ∗ x gilt, dann heißt

G kommutativ oder abelsch.

5

3.2

Körper

3.7

Ein Körper ist ein Tripel (K, +, ·), wobei K eine Menge und +

und · Verknüpfungen sind,

+:

K×K →K

(x, y) 7→ x + y

·:

K×K →K

(x, y) 7→ x · y

mit den folgenden Eigenschaften:

(K1) (K, +) ist abelsche Gruppe, 0 sei neutrales Element, −x sei

Inverses zu x.

Erzeugendensystem

Sei V ein K-VR und U ein UVR von V . Dann heißen Vektoren v1 , . . . , vk ∈ V Erzeugendensystem für U , wenn U =

lin(v1 , . . . , vk ).

3.8

Lineare Abhängigkeit

V sei K-VR. v1 , . . . , vk ∈ V heißen linear abhängig, wenn

∃α1 , . . . , αk ∈ K, so dass α1 v1 + . . . + αk vk = 0 und NICHT

α1 = . . . = αk = 0.

(K2) ∀ x, y ∈ K ∗ := K\{0} : x · y ∈ K ∗ und (K ∗ , ·) ist abelsche

Gruppe, 1 sei neutrales Element, x−1 sei Inverses zu x.

3.9

(K3) ∀ x, y, z ∈ K : x · (y + z) = x · y + x · z, (x + y) · z = x · z + y · z

Eine Familie v1 , . . . , vk ∈ V , heißt Basis des VR V , wenn

3.3

1. v1 , . . . , vk linear unabhängig

Vektorraum

Sei K ein Körper. Ein K-Vektorraum ist ein Tripel (V, +, ·),

bestehend aus einer Menge V und Verknüpfungen

+:

V ×V →V

(x, y) 7→ x + y

·:

K×V →V

(λ, v) 7→ λ · v

mit den folgenden Eigenschaften:

(V1) (V, +) ist eine abelsche Gruppe. Ihr neutrales Element 0V

heißt Nullvektor, das zu v ∈ V inverse Element −v heißt zu

v negativer Vektor.

(V2) ∀ v, w ∈ V, λ, µ ∈ K :

(a)

(b)

(c)

(d)

3.4

(λ + µ) · v = (λ · v) + (µ · v)

λ · (v + w) = (λv) + (λw)

(λµ) · v = λ · (µ · v)

1·v =v

Unterraum

Sei V ein K-VR. Eine Teilmenge U ⊂ V heißt Unter(vektor)raum

(UVR) von V , wenn gilt:

1. U 6= ∅

2. lin(v1 , . . . , vk ) = V

3.10

Dimension

Ein VR V 6= {0} heißt endlich dimensional, wenn er eine Basis

mit endlich vielen Vektoren besitzt. Die Anzahl der Basisvektoren

beschreibt die Dimension von V , kurz dim(V ).

Vereinbarung: für V = {0} gelte dim(V ) = 0.

3.11

Zeilen- und Spaltenraum

Sei A ∈ Rm×n .

SA := lin(s1 , . . . , sn ) ⊂ Rm heißt Spaltenraum von A.

ZA := lin(z1 , . . . , zm ) ⊂ Rn heißt Zeilenraum von A.

3.12

Restklassen-Körper

(Zn , +n ) bildet abelsche Gruppe mit Zn := {0, 1, . . . , n − 1} mit

x +n y := x + y mod n.

Wenn n eine Primzahl ist, dann ist (Zn , +n , ·n ) ein Körper mit

x ·n y := x · y mod n. (Satz 3.28)

3.13

2. ∀ x, y ∈ U ⇒ x + y ∈ U

Codes und Codewörter

)n

3. ∀ x ∈ U, ∀ λ ∈ K ⇒ λ · x ∈ U

D.h. ein UVR ist ein in sich abgeschlossener Teil eines VR und

auch selbst ein VR.

3.5

Basis

Kern

Sei A ∈ Rm×n . Der Kern von A ist die Lösungsmenge des homogenen LGS

Ax = 0 : Kern(A) := {x ∈ Rn : Ax = 0}

Es gilt: Kern(A) ist UVR von Rn :

(Zp

= {(a1 . . . an ) : ai ∈ {0, . . . , p − 1}} ,,Menge aller Codewörter”

C ⊂ (Zp )n ,,Code”, Elemente ,,Codewörter”

d(a, b) := |{i ∈ [n] : ai 6= bi }| ,,Abstand der Codewörter a und b”

d(C) := min{d(a, b) : a, b ∈ C ∧ a 6= b} ,,Minimalabstand des

Codes C”

3.14

Fehler erkennende und korrigierende Codes

Code C ist. . .

. . . t Fehler erkennend ⇔ ∀ a, b ∈ C mit a 6= b: d(a, b) ≥ t + 1

. . . t Fehler korrigierend ⇔ ∀ a, b ∈ C mit a 6= b: d(a, b) ≥ 2t + 1

1. A · 0 = 0 ⇒ 0 ∈ Kern(A)

4 Länge, Winkel, Skalarprodukte

2. x, y ∈ Kern(A) :

⇒ A(x + y) = Ax + Ay = 0 + 0 = 0

⇒ x + y ∈ Kern(A)

4.1

3. x ∈ Kern(A), λ ∈ R :

⇒ A(λx) = λ(Ax) = λ0 = 0

3.6

Linearkombination, lineare Hülle

Sei V ein K-VR und {v1 , . . . , vk } eine Menge von Vektoren in V .

1. Eine Linearkombination von v1 , . . . , vk ist jede Summe der

Form

k

P

λ1 v1 + . . . + λk vk =

λi v i

mit Skalaren

i=1

λ1 , . . . , λk ∈

Norm

Sei V ein R- oder C-Vektorraum. Eine Abbildung k · k : V →

R, x 7→ kxk

heißt Norm auf V, wenn Sie folgende Eigenschaften hat:

(N1) Positive Definitheit

∀ x ∈ V ist kxk ≥ 0 und kxk = 0 ⇔ x = 0

(N2) Homogenität

∀ x ∈ V, λ ∈ R bzw. C : kλxk = |λ|kxk,

λ ∈ C : |λ| =

p

λλ

(N3) Dreiecksungleichung

∀ x, y ∈ V : kx + yk ≤ kxk + kyk

K

2. Die lineare Hülle von v1 , . . . , vk ist die Menge aller Linearkombinationen von v1 , . . . , vk :

k

P

λi vi : λ1 , . . . , λk ∈ K}

lin(v1 , . . . , vk ) := {

i=1

Die lineare Hülle heißt auch Spann, Erzeugnis oder der von

v1 , . . . , vk erzeugte/aufgespannte UVR. Sie ist ein UVR von

V.

4.2

lp -Normen, Maximumsnorm

Sei p ∈ [1; ∞), dann definiert man auf Rn die lp -Norm durch

1

kxkp := (|x1 |p + · · · + |xn |p ) p

und die l∞ -Norm oder Maximumsnorm durch

kxk∞ := max |xi |

1≤i≤n

6

5 Lineare Abbildungen

Skalarprodukt

1. Symmetrie:

∀ x, y ∈ V : hx, yi = hy, xi

5.1

Seien X, Y K-VR und f : X → Y eine Abbildung. f heißt linear

wenn

1. ∀ x1 , x2 ∈ X : f (x1 + x2 ) = f (x1 ) + f (x2 )

2. Linearität in jedem Faktor:

∀ x, y, z ∈ V : hx + y, zi = hx, zi + hy, zi

∀ x, y ∈ V, λ ∈ R : hλx, yi = λ hx, yi

2. ∀ x ∈ X, ∀ α ∈ K : f (αx) = αf (x)

3. Positive Definitheit:

∀ x ∈ V : hx, xi ≥ 0 mit hx, xi = 0 ⇔ x = 0

Also: f (αx + βy) = αf (x) + βf (y)

Ausschluss-Kriterium: f (0) 6= 0 ⇒ f nicht linear

5.2

Positive Definitheit

Eine Matrix A ∈ Rn×n heißt positiv definit, wenn gilt:

∀ x ∈ Rn \ {0} : xT Ax > 0

Winkel

hx,yi

kxkkyk

Wenn hx, yi = 0, (also ϕ = ](x, y) = π2 ) dann heißen x und y

zueinander orthogonal, wir schreiben x ⊥ y.

4.7

Orthogonale Zerlegung und orthogonale Projektion

Sei V ein R-VR mit Skalarprodukt h. , . i, U UVR von V, x ∈ V

beliebig.

Wenn x = xu + xu⊥ mit xu ∈ U und xu⊥ ∈ U ⊥ , dann heißt

x = xu + xu⊥ orthogonale Zerlegung von x bezüglich U und xu

ist die orthogonale Projektion von x auf U.

4.9

f : X → Y, B = {b1 , . . . , bn } Basis von X, C = {c1 , . . . , cm } Basis

von Y

f (b1 ) = α11 c1 + . . . + αm1 cm

α11 ... α1n Af =

∈ Rm×n

αm1 ... αmn

f (bn ) = α1n c1 + . . . + αnn cm

Geg: Basis v1 , . . . , vr eines VR oder UVR W

Ges: ONB von W

b1 :=

5.5

Transformationsmatrix

f : X → Y , B alte Basis von X, B 0 neue Basis von X

B ⇔ T B = (B)−1 · B 0 ⇔ T B 0 = (B 0 )−1 · B

B 0 = B · TB

0

B

B0

Y · x transformiert x (von rechts nach links) aus

Anschaulich: TX

der Basis X in die Basis Y.

In

In

0

0

Sonderfall B = In : TB

0 = B bzw. B = In : TB = B

Vgl. Satz 5.12, 5.13, 5.14, 5.15.

5.6

Eigenschaften einer Matrixnorm

1. Eine Norm k . . . k auf Rn×n heißt submultiplikativ, wenn

∀ A, B ∈ Rn×n : kABk ≤ kAkkBk

2. k . . . k auf Rn×n heißt verträglich mit k . . . kV auf Rn , wenn

∀ A ∈ Rn×n , ∀ x ∈ Rn : kAxkV ≤ kAkkxkV

Gram-Schmidt Orthogonalisierung

1. Normiere v1 :

Abbildungsmatrix bzgl. Basen

heißt Abbildungsmatrix von f bezüglich B und C

Orthogonalbasis

V sei R-VR mit Skalarprodukt h. , . i, Familie v1 , . . . , vk ∈ V \ {0}

heißt orthogonal, wenn ∀ i, j ∈ [k] , i 6= j : hvi , vj i = 0. Familie

heißt Orthogonalbasis von V, wenn sie Basis von V und orthogonal

ist. Eine Familie heißt orthonormal, wenn

(

1 i = j ∈ [k]

hvi , vj i = δij :=

0 i 6= j ∈ [k]

4.8

f : X → Y heißt affin linear, wenn es eine lineare Funktion g :

X → Y und a ∈ Y gibt mit ∀ x ∈ X : f (x) = g(x) + a

5.4

Orthogonalität

Affine Linearität

...

cos ϕ =

5.3

.

Sei V ein R-VR mit Skalarprodukt h. , . i , k . . . k dadurch induzierte

Norm, und x, y ∈ V \{0}. Der Winkel ϕ = ](x, y) ∈ [0, π] zwischen

x und y ist definiert durch

4.6

Sei f : X → Y linear.

Rang(f ) := dim(Bild(f ))

Bild(f ) := {y ∈ Y : ∃x ∈ X mit f (x) = y}

Kern(f ) := {x ∈ X : f (x) = 0} ⊂ X = f −1 (0)

...

4.5

Rang, Bild, Kern

...

4.4

Lineare Abbildung

..

4.3

Sei V ein R-VR. Eine Abbildung

hx, yi : V × V → R, (x, y) 7→ hx, yi

heißt (reelles) Skalarprodukt, wenn sie folgende Eigenschaften hat:

3. Die durch k . . . kV auf Rn induzierte Matrixnorm ist definiert

durch

kAxkV

kAk :=

sup

kxk

1

v

kv1 k 1

x∈Rn ,x6=0

2. Bestimme die zu b1 orthogonale Komponente von v2 :

z2 = v2 − hv2 , b1 i · b1 und normiere b2 = kz1 k z2

V

4. eine induzierte Norm heißt ,,natürliche Norm”.

2

3. Mach den Quatsch für 2 ≤ k ≤ r so weiter:

k−1

P

zk = v k −

hvk , bi i · bi

i=1

bk =

4.10

4.11

Rn×n

und

s

m P

n

P

i=1 j=1

AT A

= In , dann heißt A orthogonal.

Kreuzprodukt/Vektorprodukt

V ×V →V

a1 b1

Seien a = a2 ∈ R3 und b = b2 ∈ R3

a3

b

3

a2 b2

+ det

a b

3 3

a2 b3 −a3 b2

1 b1

a3 b1 −a1 b3 .

=

Dann a × b := − det a

a

b

a1 b2 −a2 b1

3 3

+ det

Frobenius-Norm

kAkF :=

1

z

kzk k k

Orthogonale Matrix

Wenn A ∈

5.7

a1 b1

a2 b2

a2ij

6 Eigenwerte und Matrixfaktorisierung

6.1

Eigenwert, Eigenvektor

Sei A ∈ Cn×n . λ ∈ C heißt Eigenwert von A, wenn es x ∈ Cn , x 6=

0 mit Ax = λx gibt. x heißt dann Eigenvektor zum Eigenwert

λ. Anm: λ = 0 erlaubt. λ ∈ R ⇒ ,,reeller Eigenwert”.

6.2

Algebraische Vielfachheit

Seien λ1 , ...λr ∈ C die paarweise verschiedenen Eigenwerte von A.

⇒ χA (t) = (λ1 − t)K1 · (λ2 − t)K2 · ... · (λr − t)Kr

Ki ist die algebraische Vielfachheit des Eigenwerts λi .

7

6.3

7 Folgen und Reihen

Eigenraum, geometrische Vielfachheit

Cn

Vλ = Kern(A−λIn ) ⊂

heißt Eigenraum von A zum Eigenwert

λ.

Vλ enthält die Eigenvektoren zum Eigenwert λ.

dim(Vλ ) := ,,geometrische Vielfachheit von λ”

(an )n∈N0 heißt beschränkt, wenn eine Zahl K ∈ R existiert, so

dass ∀ n ∈ N0 : |an | ≤ K

6.4

7.2

Diagonalisierbarkeit (Funktion)

Sei V ein VR und f : V → V Abbildung.

f heißt diagonalisierbar, wenn es eine Basis von V gibt, so dass

die Abbildungsmatrix von f bzgl. B eine Diagonalmatrix ist, also

außerhalb der Diagonalen nur Nullen hat.

7.1

Beschränkte Folge

Konvergenz

(an ) konvergiert gegen a ∈ R (ist konvergent), wenn für jede (beliebig kleine) Zahl ε > 0, ε ∈ R, eine natürlich Zahl Nε existiert,

mit

∀ ε > 0 : ∃Nε ∈ N : ∀ n > Nε : |an − a| < ε

n→∞

Schreibe dazu lim an = a, oder an −→ a.

n→∞

6.5

Diagonalisierbarkeit (Matrix)

7.3

A ∈ Rn×n heißt diagonalisierbar, wenn es eine invertierbare Transformationsmatrix T ∈ Rn×n und eine Diagonalmatrix

D ∈ Rn×n gibt mit

T −1 AT = D

Spezielle Grenzwerte, Divergenz

lim an = 0 ⇒ (an ) heißt Nullfolge.

n→∞

lim an = +∞ ⇔ ∀ K ∈ R, ∃NK ∈ N, ∀ n > NK : an > K.

n→∞

lim an = −∞ ⇔ ∀ K ∈ R, ∃NK ∈ N, ∀ n > NK : an < K.

n→∞

6.6

Wenn (an ) keinen Grenzwert a ∈ R hat, dann heißt (an ) divergent.

Insbesondere sind Folgen mit lim an = ±∞ divergent.

Ähnliche Matrizen

n→∞

Zwei Matrizen A, B ∈ Rn×n heißen ähnlich, wenn es eine invertierbare Matrix T ∈ Rn×n gibt mit T −1 AT = B.

6.7

lim an = a ⇔ ∀ ε > 0 : ∃Nε ∈ N : ∀ n > Nε : |an − a| < ε

Sei A0 ∈ Rn×n quadratische

Matrix. Gesucht: Obere Dreiecksmaλ1

∗

T

λ2

trix Q A0 Q =

mit EW auf Hauptdiagonalen.

.

..

1. Bestimme einen EW λ1 und EV v1 von A0

2. Bilde ONB

des Rn×n

mit v1 und n − 1 anderen Vektoren.

| |

|

V1 := v1 w2 ... wn ∈ Rn×n , orthogonal

|

|

|

e1

3. Berechne A

=

V1T A0 V1

λ

*

1

=

0

mit A1

A1

∈

4. Wiederhole Schritte 1 und 2 für A1 an Stelle von A0

⇒ V2 ∈ R(n−1)×(n−1) , orthogonal

⇒ A2 ∈ R(n−2)×(n−2)

λ2

∗

0

A2

0

..

5. Erweitere V2 mit In zu Vb2 :=

0

V2

0

0

∗

∗

A2

Sei A ∈ Rm×n , k = min(m, n).

..

.

1. Bestimme EW λi und EV vi von AT A ∈ Rn×n

Sortiere: λ1 ≥ . . . ≥ λn ≥ 0

Normiere die EV vi .

√

2. Berechneδi = λi für i ∈ [k]

δ1

0

Bilde Σ:

mit 0 zu m × n auffüllen δi 6= 0

0

3. Bilde V =

δk

|

|

v1 ... vn

|

|

4. Berechne u1 , . . . , uk mit ui = 1 Avi .

δi

|

|

Bilde U = u1 ... um

|

|

Falls m > n, ergänze zu ONB

≥1

Teilfolge

Eine Teilfolge der Folge (an ) ist eine Folge der Form (ank )k∈N ,

also an1 , an2 , an3 , . . . mit n1 < n2 < n3 < . . .

Reihe, Folge der Partialsummen

∞

P

k=1

ak ist konvergent, wenn die Folge ihrer Partialsum-

k=1

Singulärwertzerlegung (Algorithmus)

a >0 an+1

an

∈ Rn×n

λ1 ∗

0 λ2

≥ an ∀ n ∈ N, dann ist (an )

monoton steigend

> an

streng monoton steigend

≤ an

monoton fallend

< an

streng monoton fallend

Es gilt: an+1 ≥ an ⇔ an+1 − an ≥ 0 n⇔

7.7

.

Fertig, wenn Ai eindimensional oder Ai obere Dreiecksmatrix mit

EW auf Hauptdiagonalen.

Ergebnis: QT A0 Q mit Q = V1 · Vb2 · Vb3 · · ·

6.8

Wenn an+1

an+1

an+1

an+1

Die Reihe

Berechne Q2 = V1 Vb2 , so dass QT

2 A0 Q2 =

Monotonie

Sei (ak )k∈N eine Folge.

n

P

(sn )n∈N mit sn :=

ak ,,Folge der Partialsummen”

!

.

1

7.5

7.6

R(n−1)×(n−1) und EW λ1 aus Schritt 1

e2 = V T A1 V2 =

A

2

ε-Umgebung, Konvergenz

n→∞

Schur-Zerlegung (Algorithmus)

0

7.4

men (sn ) konvergiert:

∞

P

ak := lim sn

k=1

7.8

∞

P

k=1

n→∞

Absolute Konvergenz

ak heißt absolut konvergent, wenn

∞

P

k=1

|ak | konvergiert.

8

Teil II

Sätze und Propositionen

1 Grundlagen

1.1

Kombinatorik

1. Es gibt genau n! Möglichkeiten, n verschiedene Objekte in

eine Reihenfolge zu bringen.

Möglichkeiten eine Teilmenge der Größe

2. Es gibt genau n

k

k aus einer Menge der Größe n auszuwählen.

Rechenregeln: Mengen

1.12

1. (A ∩ B) ∩ C = A ∩ (B ∩ C)

2. A \ (B ∪ C) = (A \ B) ∩ (A \ C)

1.2

1.11

Pascal’sches Dreieck

1.

n

k

2.

n

0

Gerade und ungerade Zahlen

3.

G := {n ∈ Z : ∃k ∈ Z mit n = 2k}

U := {n ∈ Z : ∃k ∈ Z mit n = 2k + 1}

G∩U =∅

1.13

=

n+1

k

n

n

=

=1

n

k

n

P

n k−1

n k n−k

a b

k

k=0

Vielfache von 3

1.15

∀ n ∈ N : 22n − 1 ist durch 3 teilbar

+

Binomischer Lehrsatz

(a + b)n =

1.3

n n−k

=

Sinus und Cosinus

1. −1 ≤ cos(x) ≤ 1 , −1 ≤ sin(x) ≤ 1

1.5

Periodische Dezimalbrüche

1.6

1.7

√

2. cos(−x) = cos(x) , sin(−x) = − sin(x)

b1 ...bk

9...9

0, b1 . . . bk =

3. (cos(x))2 + (sin(x))2 = 1

4. ∀ k ∈ Z : cos(x + 2πk) = cos(x) , sin(x + 2πk) = sin(x)

2∈

/Q

5. ∀ k ∈ Z : sin(x) = 0 ⇔ x = πk , cos(x) = 0 ⇔ x =

+ πk

Betrag, Wurzel, Dreiecksungleichung

1.16

1. |a| ≥ 0

√

2.

a2 = |a| und a2 = |a|2

Additionstheoreme

1. cos(x + y) = cos(x) cos(y) − sin(x) sin(y)

2. sin(x + y) = sin(x) cos(y) + cos(x) sin(y)

3. |ab| = |a||b|

4. |a + b| ≤ |a| + |b|

1.8

π

2

1.17

Additionstheoreme (Sonderfälle)

1. sin(x +

Ungleichungen

2. cos(x −

Seien a, b, c ∈ R.

π

) = cos(x)

2

π

) = sin(x)

2

3. sin(π − x) = − sin(x − π) = sin(x)

1. Genau einer der Fälle a < b, b < a, a = b tritt ein.

4. cos(π − x) = − cos(x)

2. Wenn a < b und b < c, dann a < c

1.18

3. a < b ⇔ a + c < b + c

Tangens, Kotangens

4. Wenn c > 0 : a < b ⇔ ac < bc

1. tan(−x) = − tan(x) , cot(−x) = − cot(x)

5. Wenn c < 0 : a < b ⇔ ac > bc

2. ∀ k ∈ Z : tan(x + πk) = tan(x) , cot(x + πk) = cot(x)

1.9

Zahlendarstellung, Größte Zahl, Basis

Sei Basis b ∈ N, b ≥ 2. Dann gilt ∀ Länge L ∈ N

L

P

(b − 1)bi = bL+1 − 1

i=0

1.10

n

P

k=m

n

P

2.

ak =

n

P

ak )(

5.

k=

k=0

6.

n

P

k=0

7.

n

Q

k=0

bk

k=m

1.22

n

P

ai

n−m

P

Komplexe Zahlen: Division

1. zz = |z|2

2.

am+i

m

P

n

m

m P

n

P

P

P

(

ak bj ) =

(

ak bj )

bj ) =

j=1

k=1

n

P

Fundamentalsatz der Algebra

z

w

:=

zw

ww

=

ac+bd

c2 +d2

+ i cbc−ad

2 +d2

i=0

k=m

4. (

Sei a ∈ [−1, 1] , k ∈ Z. Die Gleichungen sin(x) = a bzw. cos(x) = a

haben die Lösungen x = arcsin(a) + 2πk, x = π − arcsin(a) + 2πk

bzw. x = ± arccos(a) + 2πk

Jedes Polynom hat mindestens eine komplexe Nullstelle.

n

P

i=m

ak =

n

P

ak + d

k=m

k=m

3.

n

P

(cak + dbk ) = c

Sinusgleichungen

1.20

Summe, geometrische Summe

1.

1.19

k=1 j=1

j=1 k=1

1.23

Polardarstellung: Multiplikation

z, w ∈ C, n ∈ N, z = r(cos Φ + i sin Φ)

1. |zw| = |z||w|

n(n+1)

2

2. arg(zw) = arg(z) + arg(w)

(

qk

=

1−q n+1

1−q

q 6= 1

n+1

q=1

n

P

q k = q k=0

k

=q

n(n+1)

2

(,,geometrische Summe”)

3. zw = |z||w|(cos(arg(z) + arg(w)) + i sin(arg(z) + arg(w))

4. |z n | = |z|n

5. arg(z n ) = n arg(z)

6.

1

z

=

1

(cos(−Φ)

r

+ i sin(−Φ))

9

1.24

Injektiv, surjektiv, bijektiv

2.7

Sei X, Y 6= ∅, f : X → Y .

1. Wenn f bijektiv, dann |X| = |Y |.

2. Wenn |X| = |Y |, dann f inj. ⇔ f bij. ⇔ f surj.

1.25

Eindeutigkeit der Darstellung einer Zahl

Jedes n ∈ N0 hat genau eine Darstellung zur Basis b.

2.8

Lösungen von homogenen LGS

A ∈ Rm×n , betrachte homogenes LGS Ax = 0

1. Die allgemeine Lösung des LGS enthält genau n − Rang(A)

freie Variablen.

1.26

R ist nicht abzählbar

1.27

Fundamentalsatz der Arithmetik

Jede natürliche Zahl > 1 lässt sich eindeutig in ihre Primfaktoren

zerlegen.

1.28

Rang

Rang(A) ≤ Anzahl der Zeilen von A = m

Rang(A) = Anzahl d. Zeilen mit Pivot = Anzahl d. Spalten mit

Pivot ≤ n

⇒ Rang ≤ min(m, n).

Es gibt unendlich viele Primzahlen

2. Das LGS hat genau dann x = 0 als einzige Lösung, wenn

Rang(A) = n.

2.9

Lösungen von inhomogenen LGS

A ∈ Rm×n , b ∈ Rm , b 6= 0, betrachte inhomogenes LGS Ax = b.

1. Ax = b lösbar ⇔ Rang(A) = Rang(A|b)

2 Matrizen und lineare Gleichungssysteme

2.1

Addition, Skalar-Multiplikation

1. A + B = B + A

2. Wenn Ax = b lösbar, dann existiert spezielle Lösung y von

Ax = b, so dass die allgemeine Lösung x von Ax = b geschrieben werden kann als x = y + z, wobei z die allgemeine

Lösung von Ax = 0 ist.

3. Wenn Ax = b lösbar, dann hat die allgemeine Lösung n −

Rang(A) freie Variablen.

2. (A + B) + C = A + (B + C)

3. A + 0 = A

Insbesondere: Ax

Rang(A) = n.

4. A + (−A) = 0

=

b eindeutig lösbar ⇔

Rang(A|b)

=

5. (λµ)A = λ(µA)

2.10

6. 1 · A = A

Rechenregeln: Transponierte Matrizen

7. (λ + µ)A = λA + µA

1. ∀ A, B ∈ Rm×n : (A + B)T = AT + B T

8. λ(A + B) = λA + λB

2. ∀ A ∈ Rm×n , α ∈ R : (αA)T = αAT

3. ∀ A ∈ Rm×n : (AT )T = A

2.2

Einheitsmatrix In , neutrales Element

∀A∈

2.3

Rm×n

: AIn = A und Im A = A

Rn×r , D

1. ∀ A, B ∈

∈

(A + B)C = AC + BC

D(A + B) = DA + DB

∈

Rl×m

2. ∀ A ∈ Rm×n , B ∈ Rn×r , α ∈ R

α(AB) = (αA)B = A(αB)

3. ∀ A ∈ Rm×n , B ∈ n×r , C ∈ Rr×l

A(BC) = (AB)C

2.4

Anzahl der Lösungen eines LGS

Sei Ax = b ein LGS. Dann gibt es genau drei Möglichkeiten:

1. |L| = 0

2. |L| = 1

3. |L| = ∞

2.5

5. ∀ a, b ∈ Rm×1 : aT b = bT a.

2.11

Matrixmultiplikation

Rm×n , C

4. ∀ A ∈ Rm×n , B ∈ Rn×r : (AB)T = B T AT

Äquivalent Umformungen

Ein äquivalentes LGS erhält man durch die folgenden elementaren

Umformungen:

1. Vertauschen zweier Gleichungen

2. Multiplikation einer Gleichung mit α ∈ R, α 6= 0

Inverse einer Matrix

1. Wenn BA = In , dann auch AB = In und umgekehrt.

2. Die Inverse A−1 von A ist eindeutig bestimmt.

2.12

Invertierbarkeit einer Matrix

A ∈ Rn×n ist genau dann invertierbar, wenn A den vollen Rang

hat (Rang(A) = n).

2.13

Rechenregeln: Invertierbare Matrizen

1. Wenn A ∈ Rn×n invertierbar, so auch A−1 , und (A−1 )−1 =

A

2. Wenn A, B ∈ Rn×n beide invertierbar, so auch AB, und

(AB)−1 = B −1 A−1

3. Wenn A ∈ Rn×n invertierbar, so auch AT , und (AT )−1 =

(A−1 )T

Bemerkung: A, B invertierbar ; A + B invertierbar

2.14

Berechnen einer Determinanten

1. ∀ j ∈ [n] : det(A) =

2. ∀ i ∈ [n] : det(A) =

Wenn Ax = b homogen, dann x = 0 Lösung des LGS

n

P

(−1)i+j · aij · det(Aij )

j=1

2.15

Homogenität, triviale Lösung

(−1)i+j · aij · det(Aij )

i=1

3. Addition des Vielfachen einer Gleichung zu einer anderen

Gleichung

2.6

n

P

Determinante der Einheitsmatrix

1. det(In ) = 1

2. det(αIn ) = αn

10

2.16

3 Vektorräume

Sarrus-Regel

Sei A =

a b c

d e f

g h i

.

3.1

Gruppen

1. Wenn x0 inverses Element zu x ist, dann gilt auch x ∗ x0 = e

2. ∀ x ∈ G : x ∗ e = x

det(A) = aei + bf g + cdh − gec − hf a − idb

3. Es gibt genau ein neutrales Element in G.

2.17

Rechenregeln: Determinanten

4. Zu jedem x ∈ G gibt es genau ein inverses Element x0 ∈ G

1. Gemeinsamer Faktor in einer Zeile:

−z1 −

−z1 −

det −α·zi − = α · det −zi −

−zn −

3.2

−zn −

Beispiele für Gruppen

1. (Z, +) ist abelsche Gruppe, 0 ist neutrales Element, −n ist

Inverses zu n ∈ Z

2. Summenzerlegung einer Zeile:

−z1 −

−z1 −

−z1 −

det −a+b− = det −a− + det −b−

2. (N0 , +) ist keine Gruppe

3. det(αA) = αn det(A)

4. (Q, +) und (R, +) sind abelsche Gruppen

−zn −

−zn −

2.19

−zn −

Determinante einer oberen Dreiecksmatrix

Wenn A = (aij ) ∈ Rn×n obere Dreiecksmatrix ist, dann ist

n

Q

det(A) =

aii

i=1

2.20

3. (Z, ·) ist keine Gruppe

5. (Q, ·) und (R, ·) sind keine Gruppen, weil 0 kein inverses Element hat.

6. (Q \ {0}, ·) und (R \ {0}, ·) sind abelsche Gruppen, 1 ist neutrales Element, x−1 oder x1 ist Inverses zu x ∈ Q.

3.4

Körper

(K, +, ·) Körper

Umformen einer Determinante

e aus A durch Vertauschen von zwei Zeilen ensteht,

1. Wenn A

e = −det(A).

dann det(A)

1. ∀ x ∈ K : 0 · x = x · 0 = 0

e aus A durch Multiplikation einer Zeile mit dem

2. Wenn A

e = αdet(A).

Faktor α entsteht, dann det(A)

3. Wenn x, y ∈ K, dann x · (−y) = (−x) · y = −(x · y).

2. Wenn x · y = 0 für x, y ∈ K, dann x = 0 oder y = 0.

e aus A durch Addition einer Zeile zu einer anderen

3. Wenn A

e = det(A).

entsteht, dann det(A)

Insbesondere: (−x) · (−y) = −((−x) · y) = −(−x · y) = xy

4. Wenn A zwei gleiche Zeilen hat, dann det(A) = 0.

3.5

Beispiele für Körper

1. (Q, +, ·) und (R, +, ·) und (C, +, ·) sind Körper.

Analog für Spalten statt Zeilen.

2.21

A∈

2. (Z, +, ·) ist kein Körper, da i.A. keine Inversen bzgl. ” · ”

existieren.

Kriterien für eindeutige Lösbarkeit eines LGS

Rn×n .

Die folgenden drei Aussagen sind äquivalent:

3.6

Rechenregeln: Vektorraum

K-VR (V, +, ·)

1. A ist invertierbar

2. A hat vollen Rang

1. ∀ v ∈ V : 0 · v = 0v

3. det(A) 6= 0.

2. ∀ v ∈ V : (−1) · v = −v

Wenn einer der drei Aussagen erfüllt ist, dann hat das LGS Ax = b

für jedes b ∈ Rn eine eindeutige Lösung.

3.8

Rechenregeln: Untervektorraum

1. 0v ∈ U

2.22

2. x ∈ U ⇒ −x ∈ U

Rechenregeln: Determinanten

1. det(AB) = det(A)det(B)

(aber: det(A + B) 6= det(A) + det(B))

3.11

2. det(AT ) = det(A)

3. Wenn A invertierbar, dann

det(A)det(A−1 ) = det(AA−1 ) = det(In ) = 1

1

⇒ det(A−1 ) = det(A)

4. Wenn B invertierbar, dann

det(B −1 AB) = det(B −1 )det(A)det(B) = det(A)

Sei k ∈ N, k ≥ 2, V ein K-VR, v1 , . . . , vk ∈ V . Dann

v1 , . . . , vk lin. abh. ⇔ ∃i ∈ [k] und ∃β1 , . . . , βi−1 , βi+1 , . . . , βk ∈ k

mit

vr = β1 v1 + . . . + βi−1 vi−1 + βi+1 vi+1 + . . . + βk vk

3.12

Beispiel

1 1 3

1

1 3

1 , 2 , 5

lin. abh. denn 1 + 2 2 = 5

2

2.24

Lineare Abhängigkeit

0

2

2

0

2

Cramer’sche Regel

Sei A ∈ Rn×n invertierbar, A =

| |

|

s1 s2 ... sn

| |

|

für die eindeutige Lösung x =

... ...

x1

xi

3.13

, b ∈ Rn . Dann gilt

!

von Ax = b :

xn

∀ i ∈ [n] : xi =

1

det

det(A)

|

|

|

|

|

s1 ... si−1 b si+1 ... sn

|

|

|

|

|

Lineare Abhängigkeit, Nullvektor, Teilfamilie

1. Jede (endliche) Familie von Vektoren, die den Nullvektor

enthält ist linear abhängig.

2. Jede endliche Familie von Vektoren, die eine linear

abhängigen Teilfamilie enthält, ist linear abhängig.

3. Jede Teilfamilie einer (endlichen) linear unabhängigen Familie, ist linear unabhängig.

11

Lineare Abhängigkeit

3.27

1. w ∈ lin(v1 , . . . , vk ) ⇔ lin(v1 , . . . , vk ) = lin(v1 , . . . , vk , w)

2. v1 , . . . , vk

lin.

unabh.

⇔

∀i

∈

lin(v1 , . . . , vi−1 , vi+1 , . . . , vk ) 6= lin(v1 , . . . , vk )

:

Linearkombination

Wenn v1 , . . . , vk Basis von K-VR V, dann existiert zu jedem w ∈

V genau ein n-Tupel (α1 , . . . , αn ) ∈ K n mit w = α1 v1 + . . . +

αn vn .

K-VR mit zwei Basen ⇒ gleiche Anzahl Vektoren

Sei V =

6 {0} K-VR mit zwei Basen v1 , . . . , vn und w1 , . . . , wm .

Dann n = m.

Existenz n-elementiger Körper Fn

Es gibt genau dann einen Körper mit genau n Elementen, wenn

n = pk , wobei p Primzahl und k ∈ N . Dieser Körper ist dann (bis

auf Namen der Elemente) eindeutig und wird mit Fn bezeichnet.

4 Länge, Winkel, Skalarprodukte

• oder

es

gibt

Vektoren

w1 , . . . , wl ,

v1 , . . . , vk , w1 , . . . , wl Basis von V ist.

so

dass

Für jede symmetrische und positiv definite Matrix A ∈ Rn×n

(spd-Matrix) gilt:

Die Abbildung (x, y) 7→ hx, yi mit hx, yi := xT Ay ist ein Skalarprodukt auf Rn .

4.6

Positive Definitheit

a11

Sei A =

a11 ... a1k an1

.

...

Basis

Definition eines Skalarproduktes auf Rn

...

Sei V ein K-VR mit dim(V ) = n ≥ 1. Dann:

1. Je n linear unabhängige Vektoren von V bilden eine Basis.

2. Jedes

Erzeugendensystem

mit

n

Vektoren

lin(v1 , . . . , vn ) = V ) ist eine Basis von V.

... a1n

...

• entweder v1 , . . . , vk sind Basis von V

4.4

.

Basisergänzungssatz

Sei V 6= {0} K-VR, der eine endliche Basis besitzt, und seien

v1 , . . . , vk linear unabhängig. Dann gilt:

3.20

3.29

..

3.18

Restklassen-Körper, Modulo-Multiplikation

n ist Primzahl ⇔ (Zn , +n , ·n ) ist Körper mit x·n y := x·y mod n.

Lineare Abhängigkeit

Wenn v1 , . . . , vn Basis des K-VR V, dann muss jede Familie

w1 , . . . , wm mit m > n linear abhängig sein.

3.17

3.28

... ann

∈

Rn×n symmetrisch. Hk

:=

...

3.16

Sei A ∈ Rn×n

A invertierbar

⇔ Rang(A) = n

⇔ det(A) 6= 0

⇔ Kern(A) = {0}

⇔ Spalten von A sind linear unabhängig

⇔ Zeilen von A sind linear unabhängig

⇔ dim(SA ) = dim(ZA ) = n

.

3.15

[k]

Invertierbarkeit, Dimension, Lin. Unabhängigkeit

..

3.14

ak1 ... akk

(d.h.

Dann gilt: A positiv definit ⇔ ∀ i = 1, . . . , n : det Hi > 0

3. Je n+1 Vektoren aus V sind linear abhängig.

4.7

3.22

Dimension von Zeilen- und Spaltenräumen

Sei A ∈

dim(ZA )

3.23

Rm×n .

Dann Rang(A) =

Rang(AT )

= dim(SA ) =

Rechenregeln: Zeilen- und Spaltenräume

Sei A ∈ Rm×n , Q ∈ Rn×n invertierbar, P ∈ Rm×m invertierbar.

Dann

1. SAQ = SA

Induzierte Norm des Skalarproduktes

Sei V ein R-VR und h. , . i ein beliebiges

p Skalarprodukt. Dann ist

die durch k . . . k : V → R und kxk := hx, xi definierte Abbildung

eine Norm auf V, genannt die ”durch h. , . i induzierte Norm”.

4.8

Cauchy-Schwarz-Ungleichung

Sei V ein R-VR mit Skalarprodukt h. , . i, und p

sei k . . . k die durch

h. , . i induzierte Norm, also ∀ x ∈ V : kxk := hx, xi. Dann

∀ x, y ∈ V : | hx, yi | ≤ kxkkyk

2. ZP A = ZA

4.10

Äquivalenz bei elementaren Operationen

Standard ONB, Lineare Unabhängigkeit

0

...

3.24

0

n

n

1. ei :=

10 ∈ R . e1 , . . . , en bildet ONB des R bzgl. des

...

1. Der Zeilenraum ZA einer Matrix A ändert sich bei elementaren Zeilenoperationen NICHT.

0

2. Der Spaltenraum SA einer Matrix A ändert sich bei elementaren Spaltenoperation NICHT.

3.25

Rangungleichung

Seien A ∈ Rm×n , B ∈ Rn×r .

Rang(AB) ≤ Rang(A)

Rang(AB) ≤ Rang(B)

3.26

Dimensionsformel

Rang(A) + dim(Kern(A)) = n

Standardskalarproduktes.

2. Wenn v1 , . . . , vk orthogonal, dann sind diese linear unabhängig.

4.11

Orthogonale Zerlegungen

Sei V ein R-VR mit Skalarprodukt h. , . i, v1 , . . . , vk ONB von V,

und x ∈ V . Dann gilt für die Darstellung x = α1 v1 + . . . + αk vk

von x, dass

∀ i ∈ [k] : αi = hx, vi i.

12

4.12

Orthogonaler Raum

5.8

Sei V ein R-VR mit Skalarprodukt h. , . i und U ⊂ V ein UVR von

V.

f :

⇔

⇔

⇔

⇔

⇔

⇔

U ⊥ := {v ∈ V, ∀ u ∈ U : hv, ui = 0}

heißt ”der zu U orthogonale Raum”. Es gilt:

1. U ⊥ ist UVR

Lösungsmenge Ax = b, Kern, Rang, Inv.barkeit

Rn

→ Rn ; f : x 7→ Ax

Ax = 0 hat nur triviale Lösung x = 0

Kern(f ) = {0}

f ist bijektiv

Ax = b hat eindeutige Lösung x ∀ b ∈ Rn

Rang(A) = n (vgl. 3.27)

A invertierbar

det(A) 6= 0

2. U ∩ U ⊥ = {0}

5.10

3. dim U ⊥ + dim U = dim V

Eigenschaften einer Basis

f : X → Y linear, B = {b1 , . . . , bn } Basis von X

Orthogonale Projektion

v1 , . . . , vk ist ONB von U ⇒ xU = hx, v1 i v1 + . . . + hx, vk i vk

hv1 ,vk i ... hvk ,vk i

4.14

γk

...

...

...

...

Ohne ONB von U : Entweder ONB erzeugen oder LGS lösen:

hv ,v i ... hv ,v i hx,v i k

γ1

1 1

1

P

k 1

mit xU =

=

γi vi

hx,vk i

i=1

Abstand, Orthogonale Projektion

Sei V ein R-VR mit Skalarprodukt h. , . i , k . . . k entsprechende

Norm, U UVR, x ∈ V, xu ∈ U orthogonale Projektion von x auf

U. Dann:

∀ y ∈ U : kx − xu k ≤ kx − yk

4.15

Rechenregeln: Orthogonale Matrizen

A ∈ Rn×n orthogonal. Dann ∀ x, y ∈ Rn :

1. Dann ist f eindeutig durch f (b1 ), . . . , f (bn ) bestimmt.

2. Bild(f ) = lin(f (b1 ), . . . , f (bn ))

3. {f (b1 ), . . . , f (bn )} Basis von Y ⇔ f bijektiv

5.11

Anwendung der Abbildungsmatrix

Wenn f : X → Y, b1 , . . . , bn Basis von X, c1 , . . . , cn Basis von Y,

Af Abbildungsmatrix

v = λ1 b1 + . . . + λn bn , f (v) = µ1 c1 + . . . + µm cm dann

µ1 λ1

Af

=

...

Die orthogonale Projektion xU des Vektors x in den VR U existiert

immer und ist eindeutig. Es gilt: x = xU + x⊥

U

...

4.13

µm

λn

5.12

Invertierbarkeit der Transformationsmatrix

B ist immer invertierbar und es gilt

TB

0

B )−1 = T B

(TB

0

B

0

1. A−1 = AT

2. hAx, Ayi = hx, yi

5.13

3. kAxk = kxk

Wenn X

Rn :=

|

|

B := b1 ... bn

|

| !

4. ](Ax, Ay) = ](x, y)

Es gilt: |λ| = 1 ∀ Eigenwerte λ ∈ C

4.16

Rechenregeln: Kreuzprodukt

Basiswechsel mit Transformationsmatrix (Matrix)

|

|

b01 ... b0n

|

|

B 0 :=

(Spalten =

b alte Basisvektoren)

(Spalten =

b neue Basisvektoren

B

dann B 0 = B · TB

0

Siehe auch Def. 5.5.

1. a ⊥ (a × b) und b ⊥ (a × b)

2. Fläche= ka × bk = kakkbk sin ϕ

5.14

3. a × a = 0

4. a × b = −b × a

Sei v = λ1 b1 + . . . + λn bn , und v = λ01 b01 + . . . + λ0n b0n

!

0

5. a × b = 0 ⇔ a und b linear abhängig

Dann

5.2

Bild(f ) ⊂ Y , Kern(f ) ⊂ X

Seien X,Y K-VR und f : X → Y linear.

Dann ist Bild(f ) UVR von Y und Kern(f ) UVR von X.

5.5

f injektiv ⇔ Kern(f ) = {0}

f linear und injektiv ⇔ Kern(f ) = {0}

5.6

Dimensionsformel Bild, Kern

f linear ⇔ dim(Bild(f )) + dim(Kern(f )) = dim(X)

5.7

f : X → X ⇔ f bijektiv

f : X → X linear, dim(X) endlich ⇔ f bijektiv

5.15

B ·

= TB

0

λ1

...

...

λ1

λn

6. ka × bk2 + ha, bi2 = kak2 kbk2

5 Lineare Abbildungen

Basiswechsel mit Transformationsmatrix (λ)

λ0n

Abbildungsmatrix bezüglich neuer Basen

Sei f : X → Y , B alte Basis von X, B 0 neue Basis von X, C alte

Basis von Y , C 0 neue Basis von Y . Dann:

0

C A TB

A0f = TC

f B0

5.18

Induzierte Matrixnorm

Sei k . . . kV Norm auf Rn und k . . . k die dadurch induzierte Norm

auf Rn×n .

1. k . . . k ist mit k . . . kV verträglich.

2. k . . . k ist submultiplikativ.

3. kAk =

sup

x∈Rn ,kxkV =1

4. kIn kV = 1

kAxkV

13

5.19

Induzierte Maximums- und 1-Norm

1. Die Maximumsnorm k . . . k∞ auf Rn induziert auf Rn×n die

n

P

,,maximale Zeilensumme”: kAk∞ := max

|aij |

i∈[n] j=1

induziert auf Rn×n die ,,maxin

P

male Spaltensumme”: kAk1 := max

|aij |

2. Die 1-Norm k . . . k1 auf

Rn

j∈[n] i=1

6 Eigenwerte und Matrixfaktorisierung

6.1

Eigenwerte, Charakteristisches Polynom

λ ∈ C ist Eigenwert von A ∈ Cn×n ⇔ λ ist Nullstelle des charakteristischen Polynoms

χA (t) := det(A − t · In )

6.3

Determinante, Invertierbarkeit

Seien λ1 , ...λr die Eigenwerte der Matrix A mit den algebraischen

Vielfachheiten K1 , ...Kr .

K2

Kr

1

a) det(A) = λK

1 · λ2 · ... · λr

b) A invertierbar ⇔ alle Eigenwerte von A sind 6= 0

6.5

Algebraische und geometrische Vielfachheiten

K n×n

a) Jedes A ∈

hat n (nicht notwendiger Weise verschiedene) Eigenwerte in C, d.h. die algebraischen Vielfachheiten

addieren sich zu n.

b) Algebraische und geometrische Vielfachheiten müssen nicht

übereinstimmen, aber es gilt immer

|{geometrische Vielfachheiten}|

≤

|{algebraische Vielfachheiten}|

6.7

Lineare Unabhängigkeit von Eigenvektoren

Sei A ∈ K n×n mit Eigenvektoren v1 , ...vr zu den paarweise verschiedenen Eigenwerten λ1 , ...λr . Dann ist die Familie v1 , ...vr linear unabhängig.

Symmetrie ⇒ ONB aus Eigenvektoren

6.14

Wenn A ∈ Rn×n symmetrisch ist, dann existiert eine ONB des

Rn aus Eigenvektoren von A und alle Eigenwerte sind reell (aber

nicht notwendiger Weise verschieden). Insb nach 6.10 ist A diagonalisierbar.

6.15

Ähnlichkeit,

vektoren

Diagonale Abbildungsmatrix Af ⇒ f (vi ) = λi vi

b) Zwei ähnliche Matrizen haben die gleichen Eigenwerte (evtl.

aber verschiedene Eigenvektoren)

c) Wenn A und B die gleichen Eigenwerte haben und die entsprechenden Vielfachheiten (algebraisch und geometrisch)

übereinstimmen, dann sind A und B ähnlich.

6.16

Symmetrie, positive Definitheit, Eigenwerte

Sei A ∈ Rn×n symmetrisch. Dann ist A positiv definit ⇔ Alle

Eigenwerte von A sind positiv.

6.17

Obere Schranke für Eigenwerte

Sei λ Eigenwert von A ∈ Rn×n . Dann ist |λ| ≤ ||A||, wenn ||.|| die

durch die Vektornorm ||.||V induzierte Norm ist.

Insb. gilt:

n

P

|λ| ≤ ||A||∞ = max

|aij | ,,max. Zeilensumme”

1≤i≤n j=1

n

P

|λ| ≤ ||A||1 = max

1≤j≤n i=1

6.18

|aij | ,,max. Spaltensumme”

Euklidische Norm (Symmetrische Matrix)

Sei A ∈ Rn×n symmetrisch, ||.|| die durch ||.||2 induzierte Norm

auf Rn×n .

||A||2 = max{|λ| : λ ist Eigenwert von A}

Euklidische Norm (Asymmetrische Matrix)

√

kAk2 = µmax , wenn µmax der betragsmäßig größte Eigenwert

T

von A A ist.

c) Wenn A n paarweise verschiedene Eigenwerte besitzt, dann

ist A diagonalisierbar.

Anm: Umkehrung von 6.10c gilt nicht!

A = In ist wegen In−1 In In = In = D diagonalisierbar, hat aber

wegen v = In v = λv nur λ = 1 als Eigenwert mit algebraischer

Vielfachheit n.

R = QT AQ , so dass R rechte obere Dreiecksmatrix ist.

T

Falls ∃λi ∈

/ R, dann existiert Q ∈ Cn×n mit R = Q AQ ∈ Cn×n .

Q heißt dann unitär (nicht orthogonal).

6.24

A∈

Diagonalisierbarkeit, Eigenwerte

Rn×n

Σ=

t)K2 ...(λ

0

δn

0 ... 0

.

..

...

falls m ≥ n.

0 ... 0

δ1 ≥ δ2 ≥ . . . ≥ δk ≥ 0 für k = min(m, n) und A = U ΣV T

Eigenschaften der Singulärwertzerlegung

1. ∀ i ∈ [k] : Avi = δi ui , AT ui = δi vi

ist genau dann diagonalisierbar wenn

t)K1 (λ

...

Sei A ∈ Rm×n . Dann existieren orthogonale Matrizen U ∈

n×n und diagonale Matrix Σ ∈ Rm×n mit

Rm×m

,V ∈ R

δ1

0 0 ... 0

falls m ≤ n.

Σ=

0 ... 0

δ01 δm

0

6.25

6.13

Singulärwertzerlegung

.

b) A diagonalisierbar ⇔ ∃ Basis v1 , ...vn von Rn , die nur aus

Eigenvektoren besteht.

(λi − t)Ki mit paarw. versch. λi ∈ R

Dann existiert eine orthogonale Matrix Q ∈ Rn×n mit

..

Diagonaliserbarkeit, Eigenwerte, Eigenvektoren

a) Wenn A diagonalisierbar ist mit T −1 AT = D, dann muss

D die Eigenwerte von A enthalten und die Spalten von T

bilden eine Basis des Rn mit den Eigenvektoren.

r

Q

i=1

.

6.10

A ∈ Rn×n und χA (t) =

..

Wenn A ∈ Rn×n Abbildungsmatrix einer diagonalisierbaren Abbildung, dann ist die Transformationsmatrix T ∈ Rn×n und Diagonalmatrix D ∈ Rn×n mit T −1 AT = D.

Schur-Zerlegung

.

Abbildungs-, Diagonal- und Transformationsmatrix

6.20

..

6.9

λn

...

0

...

..

.

f : V → V diagonalisierbar,

mit

Basis B = {v1 , ...vn } und Abbilλ1

0

dungsmatrix D =

⇒ f (vi ) = λi vi ∀ i ∈ [n]

Eigenwerte/-

a) Eine diagonalisierbare Matrix ist zu einer Diagonalmatrix

ähnlich.

6.19

6.8

Diagonalisierbarkeit,

t)Kr

2. AT = V ΣT U T hat die gleichen Singulärwerte wie A.

a) χA (t) = (λ1 −

r −

2−

mit paarweise verschiedenenen Eigenwerten λi ∈ R ∀ i ∈ [r]

3. δ12 , . . . , δk2 sind EW der Matrix AT A ∈ Rn×n mit EV

v1 , . . . , vk .

b) dim(Vλi ) = Ki ∀ i ∈ [r]

4. AT A = V DV T und D = ΣT Σ

14

7 Folgen und Reihen

7.15

7.2

n→∞

Konvergenz von Teilfolgen

lim an = a ⇔ Alle Teilfolgen von (an ) konvergieren gegen a

Eindeutigkeit des Grenzwertes

Sei (an ) eine konvergente Folge. Dann ist der Grenzwert eindeutig

bestimmt.

7.16

7.3

Zwei Teilfolgen einer Folge (an ) konvergieren gegen verschiedene

Grenzwerte ⇒ (an ) ist divergent.

Beschränkte Folge, Grenzwert

Divergenz, Teilfolgen

lim an = a ⇒ (an ) beschränkt

n→∞

7.17

7.4

Beschränktheit, konvergente Teilfolge (BolzanoWeierstraß)

Beschränktheit, Konvergenz

a) Beschränktheit ; Konvergenz, Bsp. an = (−1)n

b)

Jede beschränkte Folge hat (mindestens) eine konvergente Teilfolge.

lim an = ±∞ ⇒ (an ) nicht beschränkt

n→∞

c) an nicht beschränkt ; lim an = ±∞

7.18

n→∞

7.5

∞

P

Grenzwert: Rechenregeln

Geometrische Reihe

q k = lim

n→∞

k=0

1−q n+1

1−q

=

1

1−q

für |q| < 1

Folgen (an )n∈N und (bn )n∈N mit a = lim an und b = lim bn

n→∞

n→∞

7.19

a)

b)

c)

d)

e)

7.6

lim (an + bn ) = a + b

∞

P

n→∞

lim (an · bn ) = a · b

lim an

n→∞ bn

lim

√

n→∞

=

a

b

an =

1

k

k=1

n→∞

Harmonische Reihe

=∞

für b 6= 0

√

7.20

Rechenregeln: Reihen

Seien

∞

P

a für an ≥ 0 ∀ n ∈ N

lim |an | = |a|

k=1

n→∞

Grenzwert: Ungleichungen

∞

P

a)

∞

P

ak = a und

bk = b

k=1

(ak ± bk ) = a ± b

k=1

∃N ∈ N so dass an

an

Gilt nicht:

an

an

≤ bn ∀ n > N ⇒ a ≤ b

≥ bn

a≥b

∞

P

b)

(λ · ak ) = λ · a ∀ λ ∈ R

k=1

< bn

> bn

a<b

a>b

Anm: Vorsicht mit

∞

P

(ak · bk )

k=1

7.8

Sandwich-Theorem

Seien lim an = lim bn = d, Folge (cn )n∈N mit ∃N ∈ N : ∀ n >

N :

n→∞

ak ≤ cn

≤

n→∞

bn . Dann

existiert lim cn = d.

cn wird durch an von unten und

n→∞

von bn

von oben eingesperrt.

7.21

Konvergenz-Kriterium für Reihen (Cauchy)

Betrachte

∞

P

ak , sn :=

k=1

n

P

ak .

k=1

∞

P

7.9

Beschränktheit, Monotonie, Konvergenz

(an ) beschränkt und monoton steigend/fallend ⇒ (an ) konvergent

7.10

Fixpunktgleichung, Rekursion

a) Wenn (an )n∈N rekursiv durch an+1 = f (an ) definiert und

Grenzwert lim an existiert, dann muss der Grenzwert die

ak konvergiert

k=1

(sn )n∈N konvergiert

⇔

⇔ ∀ ε > 0 : ∃Nε ∈ N : ∀ n > m > Nε : |sn − sm | < ε

n

P

⇔ ∀ ε > 0 : ∃Nε ∈ N : ∀ n > m > Nε : |

ak | < ε

k=m+1

7.22

Reihen-Konvergenz, Nullfolge

Wenn

∞

P

n→∞

Fixpunktgleichung a = f (a) erfüllen

b) Nicht jede Lösung der Fixpunktgleichung a = f (a) ist Grenzwert, evtl. existiert gar kein Grenzwert. Bspw. negative

Lösungen für nur positiv definierte Folgen.

7.11

Bernoulli-Ungleichung

∀ x ∈ R mit x ≥ −1 und ∀ n ∈ N0 gilt

(1 + x)n ≥ 1 + nx

7.13

lim

n→∞

Euler’sche Folge, Exponentialfunktion

1+

x n

n

=: ex = exp(x) mit e ≈ 2, 72

k=1

ak konvergent, dann ist (ak )k∈N eine Nullfolge.

7.23

Absolute Konvergenz, Konvergenz

Wenn

∞

P

ak absolut konvergent, dann ist

ak auch konvergent.

k=1

k=1

7.24

∞

P

Alternierende Reihe (−1)k ak (Leibniz-Kriterium)

Sei (ak )k∈N mit ak ≥ 0 ∀ k ∈ N oder ak ≤ 0 ∀ k ∈ N eine monoton

∞

P

fallende Nullfolge. Dann konvergiert die Reihe

(−1)k · ak

k=1

Es gilt: exp(x + y) = exp(x) · exp(y)

7.25

7.14

Konvergenz-Kriterium für Folgen (Cauchy)

Eine Folge (an ) ist genau dann konvergent, wenn

∀ ε > 0 : ∃Nε : ∀ n, m > Nε : |am − an | < ε

d.h. die Abstände werden (für große Indizes) beliebig klein.

Beschränktheit, Absolute Konvergenz

Wenn die Folge der Partialsummen der Absolutbeträge (sn )n∈N

n

∞

P

P

mit sn :=

|ak | beschränkt ist, dann ist die Reihe

ak absolut

k=1

konvergent.

k=1

15

7.26

Majoranten-Kriterium

Seien (an )n∈N und (bn )n∈N Folgen