Analyse von Algorithmen (WS 2009/2010)

Werbung

Analyse von Algorithmen (WS 2009/2010)

1. Grundlegende Begriffe und einführende Beispiele

Eine Vorlesung wie diese sollte eigentlich mit einer „Definition“ des Begriffs Algorithmus beginnen, was jedoch alles andere als einfach, wenn nicht unmöglich ist. Intuitiv

versteht man unter einem Algorithmus jedenfalls eine Folge von Anweisungen zur

Lösung eines Problems, wobei in jedem Augenblick klar feststehen muss, welche

Operation als nächstes auszuführen ist, welche Operanden daran beteiligt sind und was

als nächster Schritt kommt. Entscheidend ist auch, dass der Algorithmus auf jeden Fall

nach endlich vielen Schritten (wenngleich deren Anzahl oft nicht vorhersagbar ist)

terminiert, wonach dann das Ergebnis der Berechnung feststeht. In erster Näherung

können wir einen Algorithmus mit einem Computerprogramm gleichsetzen, wobei dies

nachstehend noch präzisiert wird.

Zunächst aber die Frage: Was wird denn nun eigentlich berechnet? In allgemeinster

Form sind sowohl die Eingabegrößen eines Problems, als auch dann die möglichen

Ausgaben als Wörter, d.h. endlichen Zeichenketten, über einem endlichen Alphabet A

gegeben. Bezeichnet man die Menge dieser Wörter über A (einschließlich des leeren

Worts ε) wie üblich mit A*, so gibt es stets eine sog. Gödelisierung γ , d.h. eine

injektive und algorithmisch berechenbare Funktion γ : A*→ N (N bezeichnet dabei hier

und im folgenden die Menge der natürlichen Zahlen inklusive 0), die jedem solchen Wort

w ∈ A* in umkehrbar eindeutiger Weise eine natürliche Zahl γ ( n ) , seine sog. Gödelnummer, zuordnet. Auch die Frage, ob ein n ∈ N eine Gödelnummer eines Wortes

w ∈ A* ist und wie dieses w dann gegebenenfalls berechnet wird, kann für eine

Gödelisierung algorithmisch gelöst werden.

Es bedeutet somit keine wesentliche Einschränkung der Allgemeinheit, wenn wir im

Folgenden davon ausgehen, dass die Funktionswerte einer s-stelligen Funktion

f : N s → N berechnet werden. Funktionen dieser Bauart, deren sämtliche Funktionswerte mit Hilfe eines Algorithmus (in obigen intuitiven Sinne), berechnet werden

können, werden als (algorithmisch) berechenbar bezeichnet. Hierbei werden wir auch

oft den Fall zulassen, dass f nicht überall auf N s definiert ist, d.h. dass sie nicht, wie

man sagt, eine totale, sondern nur eine sog. partielle Funktion ist. Dort wo f nicht

definiert ist, soll dabei der der Berechnung zugrunde liegende Algorithmus nicht stoppen.

Nach dem sog. 2. Cantorschen Diagonalverfahren gibt es nun aber insgesamt überabzählbar viele Funktionen f : N s → N , andererseits jedoch aber sicher nur abzählbar viele

Algorithmen formuliert in irgendeiner festgewählten Sprache. Um zu einer solchen

Abzählung zu gelangen, betrachte man z.B. einfach alle zunächst der Länge nach und

innerhalb gleicher Länge dann lexikographisch geordneten Wörter über dem verwendeten

Alphabet und streiche davon diejenigen, die keinen Algorithmus darstellen. So gesehen

ist es also eine Ausnahme, dass eine Funktion f : N s → N in obigem Sinne berechenbar

ist! (Gottseidank verhält es sich aber für die in der Praxis betrachteten Funktionen gerade

umgekehrt!)

2

Um nun die Berechenbarkeit einer Funktion f : N s → N mittels eines

Computerprogramms zu präzisieren hat A. Turing 1936 seine berühmten und heute nach

ihm benannten Turingmaschinen (TM) eingeführt.

Eine Turingmaschine ist bestimmt durch

•

Eine endliche Menge Z von sog. Zuständen. Darunter sind zwei Zustände

ausgezeichnet, der Anfangszustand z 0 ∈ Z und ein Endzustand H, bei dessen

Erreichen die Maschine sofort anhält.

•

Ein Eingabealphabet A.

•

Ein Bandalphabet B. Dieses enthält ein spezielles Bandvorbelegungszeichen,

das im folgenden mit # bezeichnet wird und es gilt A ⊆ B \{#}

•

Eine sog. Überführungsfunktion δ : Z × B → Z × B × {L, R} . In der Praxis ist

sie oft zunächst nur als partielle Funktion gegeben und wird durch die

Festsetzung δ (z,a) = (H,a,R) für nicht definierte δ (a,z) zu einer totalen

Funktion vervollständigt. (Die Tabelle der Wert von δ wird oft auch die

Maschinentafel oder das Programm der TM genannt.)

Eine Turingmaschine kann jeden der endlichen Zustände in Z annehmen. Als Ein- und

Ausgabegerät steht ein beidseitig unendliches linear in Felder unterteiltes Band zur

Verfügung, wobei mittels eines kombinierten Schreib-Lese-Kopfs stets nur ein Feld

gelesen bzw. beschrieben werden kann. Die gelesenen und geschriebenen Symbole

entstammen dabei dem Bandalphabet B, wobei man im Prinzip mit nur zwei Symbolen,

⎮und # (letzteres für das Bandvorbelegungs- oder Leerzeichen) auskommen könnte. Eine

natürliche Zahl n kann dann z.B. durch einen Block von n+1 Strichen codiert werden

(Unäre Codierung).

Am Beginn ist die TM im Zustand z 0 und der Schreib-Lese-Kopf befindet sich auf dem

ersten Zeichen des auf dem Band befindlichen Eingabewortes geschrieben in dem

Eingabealphabet A. In der Folge werden jeweils in Abhängigkeit von dem Zustand z, in

dem sich die Maschine befindet und von dem gelesenen Bandsymbol a ∈ B die folgenden

Aktionen durchgeführt. Ist δ(z, a ) = (z1 , a 1 , b1 ) , so wird die Maschine in den Zustand z1

übergeführt, das Symbol a 1 auf das Band geschrieben und die Bewegung b1 des SchreibLese-Kopfes ausgeführt. Dabei bedeuten b1 = L eine Bewegung um ein Feld nach links,

und b1 = R eine Bewegung um ein Feld nach rechts.

Wir wollen nun annehmen, dass zu Beginn der Berechnung eines Funktionswerts

f ( x 1 ,..., x s ) von f : N s → N die Argumente x 1 ,..., x s sich (z.B. in unärer Codierung)

durch jeweils ein Leerzeichen getrennt auf dem Band stehen und der Schreib-Lese-Kopf

auf dem ersten Zeichen davon. Das Ergebnis der Berechnung soll dann jene natürliche

Zahl sein, welche bei der gewählten Codierung dem Block entspricht, in dem die

Maschine nach dem Abarbeiten des Programms zum Halten kommt. Wenn die TM nicht

stoppt, so ist f für dieses s-Tupel ( x 1 , x 2 ,..., x s ) undefiniert. Sind alle Funktionswerte

einer (i.allg. partiellen) Funktion f auf seinem Definitionsbereich für eine geeignete TM

in dieser Weise berechenbar, so wollen wir f Turing-berechenbar nennen.

3

Die bisher besprochenen Turingmaschinen können nur jeweils ein spezielles Problem

lösen. Es gibt aber auch sog. Universelle Turingmaschinen, welche alle

Turingmaschinen zur Lösung von speziellen Problemen emulieren können. Hierzu

müssen auf dem Eingabeband dann nicht nur die Daten, sondern auch die Maschinentafel

(in codierter Form) der betrachteten speziellen Turingmaschine vorliegen. Allerdings gibt

es, wie man zeigen kann, keinen Algorithmus um festzustellen, ob eine solche

Universelle Turingmaschinen für einen beliebigen Input immer stoppt, d.h. das sog.

Halteproblem ist nicht entscheidbar. Es ist dies also ein Beispiel für ein sinnvolles

Problem, für dessen Lösung es keinen Algorithmus gibt.

Ergänzend sei noch erwähnt, dass Turingmaschinen nicht nur bei der Berechnung von

Funktionen, sondern auch in der Spracherkennung eine sehr wichtige Rolle spielen.

Hierzu wird eine Teilmenge E von Z als Menge von sog. Endzuständen ausgezeichnet,

und ein Wort w über dem Eingabealphabet A wird von der TM erkannt bzw. akzeptiert,

wenn sie für diese Eingabe in einem Endzustand zu halten kommt. Sprachen über A, d.h.

Teilmengen von A*, die genau die von einer gewissen Turingmaschine erkannten Wörter

beinhalten, werden rekursiv aufzählbar oder semientscheidbar genannt. In der sog.

Chomsky-Hierarchie sind sie die sog. Sprachen vom Typ 0, d.h. der allgemeinste Typ

von Sprachen, welche durch eine sog. Grammatik definiert werden können (→ Theorie

der formalen Sprachen).

Ein anderer Zugang zur Berechenbarkeit von arithmetischen Funktionen benützt das

Konzept der Rekursivität. Man geht dazu aus von den folgenden Grundfunktionen,

welche auf jeden Fall als berechenbar angesehen werden:

1. Die Nachfolgerfunktion s: N → N mit s(x)=x+1.

2. Die konstanten Funktionen C nk : N n → N ( k ∈ N ) mit

C nk ( x 1 ,..., x n ) = k für alle x 1 ,..., x n ∈ N .

3. Die Projektionen Pkn : N n → N ( 1 ≤ k ≤ n ) mit

Pkn ( x 1 ,..., x n ) = x k für alle x 1 ,..., x n ∈ N .

Um daraus weitere berechenbare Funktionen zu gewinnen, bedient man sich folgender

Konstruktionsprinzipien zur Erzeugung arithmetischer Funktionen aus gegebenen.

1. Komposition:

Sind f : N m → N und g 1 ,..., g m : N n → N arithmetische Funktionen, so auch die

Funktion h : N n → N definiert durch

h ( x 1 ,..., x n ) = f (g 1 ( x 1 ,..., x n ),..., g m ( x 1 ,..., x n )) für alle x 1 ,..., x n ∈ N .

2. Primitive Rekursion

Für beliebige arithmetische Funktionen g : N n → N und h : N n +2 → N wird durch die

Rekursion

f ( x 1 ,..., x n ,0) = g ( x 1 ,..., x n )

4

f ( x 1 ,..., x n , y + 1) = h ( x 1 ,..., x n , y, f ( x 1 ,..., x n , y))

( x 1 ,..., x n , y ∈ N ) in eindeutiger Weise eine weitere arithmetische Funktion f : N n +1 → N

definiert.

3. Minimalisierung (Anwendung des µ-Operators)

Aus g : N n +1 → N kann durch

h ( x 1 ,..., x n ) = µy [g ( x 1 ,..., x n , y) = 0]

( x 1 ,..., x n ∈ N )

(für die rechte Seite lies: „kleinstes y, sodass g ( x 1 ,..., x n , y) = 0 “) eine weitere

arithmetische Funktion h : N n → N gewonnen werden, wobei man allerdings noch den

Fall betrachten muss, dass es überhaupt kein y mit g ( x 1 ,..., x n , y) = 0 gibt oder dass für

das kleinste derartige y nicht alle Funktionswerte g ( x 1 ,..., x n , u ) mit 0 ≤ u < y auch

wirklich definiert waren. In diesem Fall lässt man dann h ( x 1 ,..., x n ) undefiniert.

Funktionen, welche aus den Grundfunktionen durch (ev. wiederholte) Anwendung der

Komposition und primitiven Rekursion gewonnen werden können, heißen primitiv

rekursiv. Lässt man darüber hinaus auch noch die Anwendung des µ-Operators zu, so

heißen die so erhaltenen Funktionen µ-rekursiv, welche jedoch im Gegensatz zu

primitiv rekursiven Funktionen dann i.allg. nicht mehr total sind!

Lange Zeit war man der Meinung, mit dem Begriff der primitiv rekursiven Funktion

bereits den allgemeinsten Rekursionsbegriff gefunden zu haben, bis dann 1928

Ackermann mit seiner berühmten und heute nach ihm benannten Funktion A: N 2 → N ,

welche rekursiv durch

A(0,y)=y+1,

A(x+1,0)=A(x,1)

A(x+1,y+1)=A(x,A(x+1,y))

für alle x , y ∈ N definiert ist, ein Gegenbeispiel fand. Diese Funktion wächst, wie man

zeigen kann, so rasch, dass es zu jeder primitiv rekursiven Funktion g : N n → N stets ein

c ∈ N gibt, sodass

g ( x 1 , x 2 ,..., x n ) < A (c, x 1 + x 2 + ... + x n ) für alle x 1 ,..., x n ∈ N

gilt. Wäre aber A(x,y) primitiv rekursiv, so auch g(x):=A(x,x) (=A( P12 ( x , y), P12 ( x , y)) ,

woraus jedoch der Widerspruch g(c)=A(c,c)<A(c,c) folgen würde!

Andererseits kann man zeigen, dass die Ackermann-Funktion µ-rekursiv ist, d.h. das

Konzept der µ-Rekursivität ist echt umfassender. Man kann weiter zeigen, dass überhaupt

jede rekursiv „in sinnvoller Weise“ definierte Funktion (als Beispiel nehme man die

rekursive Definition der Ackermann-Funktion) auch bereits µ-rekursiv ist, d.h. man hat

mit µ-rekursiven Funktionen bereits das allgemeinste Konzept von rekursiven

Funktionen.

5

Ferner kann man zeigen, dass die rekursiven Funktionen mit den Turing-berechenbaren

Funktionen übereinstimmen, d.h. es gilt für arithmetische Funktionen

µ-rekursiv ⇔ (allgemein) rekursiv ⇔ Turing-berechenbar

Dies veranlasste Church 1936 zu folgender weitergehenden

Churchsche These: Jede intuitiv berechenbare Funktion ist rekursiv bzw. Turingberechenbar.

Diese heute allgemein anerkannte Hypothese kann man naturgemäß nicht beweisen (da

der Begriff „intuitiv berechenbar“ nicht exakt definiert ist), wohl aber könnte man sie

durch ein Gegenbeispiel widerlegen, so es eines gibt.

Obwohl also der Begriff der primitiven Rekursivität, wie wir gesehen haben, echt

spezieller ist als die (allgemeine) Rekursivität, haben doch sehr viele für die Praxis

wichtige arithmetische Funktionen die Eigenschaft primitiv rekursiv zu sein. Wir zählen

nachfolgend einige auf. (Die Aufzählung erfolgt dabei in einer Weise, dass stets nur

Funktionen verwendet werden, welche bereits vorher definiert wurden. Darüber hinaus

werden nur die Grundfunktionen, im besonderen die Nachfolgerfunktion s(x)=x+1,

verwendet.)

Vorgängerfunktion:

⎧ Pr ed(0) = 0

Pr ed ( x ) = ⎨

⎩Pr ed (s( x )) = x

Addition:

x+0= x

⎧

x+y=⎨

⎩ x + s( y) = s( x + y)

Produkt:

x *0 = 0

⎧

x*y = ⎨

⎩ x * s( y) = x + x * y

Potenzen:

⎧

x0 = 1

x y = ⎨ s( y)

= x *xy)

⎩x

Fakultät:

0!= 1

⎧

x!= ⎨

⎩s( x )!= s( x ) * x!

Modifizierte Differenz:

x −& 0 = x

⎧

x −& y = ⎨

⎩x −& s( y) = Pr ed( x −& y)

Signum-Funktion:

6

⎧ sg (0) = 0

sg(x)= ⎨

⎩sg (s( x )) = 1

Konträre Signum-Funktion:

sg( x ) = 1 −& sg( x )

Absolutdifferenz:

x − y = ( x −& y) + ( y −& x )

Minimum (zweier Argumente):

min( x, y) = x −& ( x −& y)

Maximum (zweier Argumente):

max(x, y) = y + ( x −& y)

Etwas komplizierter sind die entsprechenden Definitionen von Rest rem(x,y) und

Quotient quot(x,y) bei einer (Ganzzahl-) Division von x durch y. Die nachfolgende

Definition zeigt eigentlich, dass r(x,y) := rem(y,x) bzw. q(x,y) := quot(y,x) primitiv

rekursiv sind, aber wegen rem(x,y)= r (P22 ( x, y), P12 ( x , y)) (und analog für quot(x,y)) gilt

dies dann auch für rem(x,y) und quot(x,y). (Allgemein braucht also die Komponente für

den Nachweis der primitiven Rekursivität nicht unbedingt die letzte sein.)

Rest (bei der Division von x durch y):

rem(0, y) = 0

⎧

rem( x , y) = ⎨

⎩rem(s( x ), y) = sg ( y − s(rem( x , y)) ) * s(rem( x , y))

Quotient (bei der Division von x durch y)

quot (0, y) = 0

⎧

quot ( x , y) = ⎨

⎩quot (s( x ), y) = quot ( x , y) + sg (rem(s( x ), y))

Anzahl der Teiler von x

x

τ( x ) = ∑ sg (rem( x , y))

y =0

Im Folgenden betrachten wir auch Prädikate P( x 1 , x 2 ,..., x n ) , welche für jede Belegung

( x 1 ,..., x n ) ∈ N n den Wahrheitswert „wahr“ oder „falsch“ ergeben. Wir nennen dabei

P( x 1 , x 2 ,..., x n ) entscheidbar, wenn ihre charakteristische Funktion

⎧ 1, falls P(x 1 ,..., x n ) wahr

χ P ( x 1 ,.., x n ) = ⎨

⎩0, falls P(x 1 ,..., x n ) falsch

berechenbar ist. Ist χ P ( x 1 ,..., x n ) wenigstens für den ersten Fall χ P ( x 1 ,..., x n ) =1

berechenbar, so nennen wir P( x 1 , x 2 ,..., x n ) auch semi-entscheidbar. Ferner heißt

7

P( x 1 , x 2 ,..., x n ) rekursiv bzw. primitiv rekursiv, falls dies für seine charakteristische

Funktion gilt. Diese Sprechweisen gelten auch für die n-stellige Relation R P = χ −1 ({ 1 }) ,

auf N n , welche dem Prädikat

ordnet ist.

P( x 1 , x 2 ,..., x n ) in umkehrbar eindeutiger Weise zuge-

Nachfolgend werden einige primitiv rekursive Prädikate mit Hilfe ihrer charakteristischen Funktionen eingeführt.

Prädikat

Bedeutung

Charakteristische Funktion

xy

x teilt y

sg (rem(y,x))

x<y

x kleiner als y

sg ( y −& x )

x=y

x ist gleich y

sg ( x − y )

Pr(x)

x ist Primzahl

sg ( τ( x ) − 2 )

Vom Standpunkt der Programmierung ist noch festzuhalten, dass man bei der

Programmierung von primitiv rekursiven Funktionen bzw. Prädikaten stets mit sog.

LOOP-Programmen auskommt, welche außer Wertzuweisungen nur Schleifen (engl.

Loops) mit einer vorher genau festgelegten Anzahl von Schleifendurchläufen zulassen.

Im Gegensatz dazu können allgemein rekursive Funktionen nur mit sog. WHILEProgrammen berechnet werden, wo allgemeine Schleifen zugelassen sind, die bei Nichterfüllung einer bestimmten Bedingung verlassen werden. (Insbesondere ist also die

Anzahl der Schleifendurchläufe i. allg. vorher nicht bekannt.)

Prinzipiell ist noch zu sagen, dass es zu jedem rekursiven Programm immer auch ein

iteratives Gegenstück gibt, in der die rekursiven Aufrufe durch Iterationen, also

Schleifen, aufgelöst wurden. Besonders einfach ist dabei die iterative Auflösung, wenn

der rekursive Aufruf nur einmal vorkommt und zwar am Ende des Programms. Man

spricht dann auch von einer Tail-Recursion oder endständigen Rekursion. Die

iterative Lösung hat den Vorteil, dass sie oft schneller und weniger speicherplatzintensiv

ist. (Es müssen insbesondere keine Rücksprungadressen auf dem Runtime-Stack

gespeichert werden.)

Was die Komplexität, also den Aufwand bei der Lösung eines Problems am Computer

betrifft, so werden wir im folgenden fast ausschließlich die sog. Zeitkomplexität

betrachten, welche die Anzahl der elementaren Schritte zur Lösung eines Problems misst.

Daneben gibt es noch die Speicherplatzkomplexität und die Hardwarekomplexität,

welche sich auf den Speicherplatzbedarf bzw. die verwendete Hardware beziehen.

Bei der Messung der (Zeit-)Komplexität kann man nur in den seltensten Fällen eine

genaue Anzahl der Rechenoperationen T(n) in Abhängigkeit von der sog. Größe n des

Problems angeben. (Für eine zu sortierende Liste wäre n z.B. die Anzahl der Listenelemente.) Sehr oft muss man sich mit gröberen Abschätzungen begnügen, z.B. O(T(n)),

unter Verwendung der sog. Landausymbole. Da diese somit bei der Analyse von

8

Algorithmen eine große Rolle spielen, nachfolgend einige allgemeine Bemerkungen zu

diesem Thema.

Wir betrachten dazu ausschließlich reelle Funktionen f(n), die auf der Menge N der

natürlichen Zahlen definiert sind. Dann ist

O(g(n )) = {f (n ) es gibt ein C > 0 und ein n 0 ∈ N , sodass f (n ) ≤ C g (n ) für alle n ≥ n 0 }

die Menge aller derjenigen Funktionen f(n), von denen man sagt, dass sie höchstens so

rasch wachsen wie g(n). Statt f(n) ∈ O(g(n)) hat sich dabei die etwas ungenaue Bezeichnungsweise f(n)=O(g(n)) eingebürgert und das gilt in gleicher Weise auch für die noch

einzuführenden Symbole. Aus analytischer Sicht gilt ferner

f(n)=O(g(n)) ⇔ lim sup

n →∞

f (n )

g(n )

<∞

Analog dazu ist

Ω(g (n )) = {f (n ) es gibt ein C > 0 und ein n 0 ∈ N , sodass f (n ) ≥ C g (n ) für alle n ≥ n 0 }

die Menge aller derjenigen Funktionen f(n), von denen man sagt, dass sie mindestens so

rasch wachsen wie g(n). Aus analytischer Sicht gilt diesmal

f(n)= Ω (g(n)) ⇔ lim inf

n →∞

f (n )

g(n )

>0

Sehr wichtig ist auch die Menge

Θ(g(n )) := O(g (n )) ∩ Ω(g (n ))

und von ihren Elementen, also den Funktionen f(n), für die sowohl f(n)=O(g(n)) als auch

f(n)= Ω(g (n )) gilt (wofür man wieder f(n)= Θ (g(n)) schreibt),sagt man, dass sie gleich

rasch wachsen wie g(n). Es gilt somit

Θ(g(n )) = {f (n ) ∃ C1 , C 2 > 0 und ein n 0 ∈ N , sodass C1 g(n ) ≤ f (n ) ≤C 2 g(n ) ∀ n ≥ n 0 }

In der Praxis macht man dabei oft Gebrauch von

lim

n →∞

f (n )

g(n )

= C für ein C > 0 ⇒ f (n ) = Θ(g(n )) ,

wobei diese Bedingung jedoch nur hinreichend, aber nicht notwendig ist. Besonders

wichtig ist dabei noch der Spezialfall C=1. In diesem Fall schreibt man f(n)~g(n) und

nennt f(n) und g(n) asymptotisch gleich.

Zwei weitere Wachstumseigenschaften sind wie folgt definiert:

f (n ) = o(g(n )) :⇔ lim

n →∞

f (n )

g(n )

=0

(f(n) „wächst langsamer“ als g(n))

9

f (n ) = ω(g(n )) :⇔

f (n )

g(n )

→∞

(f(n) „wächst schneller“ als g(n))

Statt f (n ) ~ g(n ) kann man damit auch f(n)=(1+o(1))g(n) schreiben. Die asymptotische

Gleichheit von f(n) und g(n) ist insbesondere auch gleichwertig damit, dass der sog. relative Fehler

f (n ) − g (n )

g(n )

(aber i.allg. nicht der absolute Fehler f (n ) − g(n ) !), den man bei der Ersetzung von

f(n) durch g(n) begeht, für n → ∞ gegen 0 strebt.

Komplexitätsabschätzungen für den Rechenaufwand T(n) werden nun oft in der Form

T(n)=O(g(n)) (g(n) ist dann bis auf eine multiplikative Konstante C der sog. Worst Case)

oder in der Form T(n)= Θ (g(n)) (entspricht dem sog. Average Case) angegeben.

Gelegentlich kann man auch beweisen, dass für Algorithmen zur Lösung eines

bestimmten Problems ein gewisser Mindestaufwand auf jeden Fall erforderlich ist, was

man dann durch eine Beziehung der Form T(n)= Ω(g(n )) ausdrückt.

Bei vielen solchen Wachstumsabschätzungen von Algorithmen eine große Rolle spielt

das sog. Master-Theorem. Eine für unsere Zwecke ausreichend allgemeine

Formulierung lautet:

Satz 1.1: Sei T: R → R eine reelle Funktion, die für x ≤ 1 gleich 0 ist und ansonsten der

Rekursion

T( x ) = aT( x / b) + f ( x )

für gewisse reelle Konstanten a,b mit a ≥ 1, b > 1 und eine reelle Funktion f mit

f(x)= Θ( x k ) genügt. (Hier sind in der Formulierung der Rekursion auch noch „marginale

Abweichungen“ von x / b nach unten oder oben, wie z.B. ⎣x / b ⎦ und/oder ⎡x / b ⎤ erlaubt,

ohne dass sich an der nachfolgenden Aussage etwas ändert.) Es ist dann

⎧ Θ( x k ),

falls a < b k

⎪

T( x ) = ⎨ Θ( x k log b x ), falls a = b k

⎪ Θ( x log b a ), falls a > b k

⎩

(Im Fall a = b k ist wegen log b x = Θ(log c x ) auch irgendeine andere Basis c zulässig.)

Dieses Master-Theorem kommt besonders häufig bei Komplexitätsabschätzungen von

sog. Divide and Conquer Algorithmen zum Einsatz. Darunter versteht man

Algorithmen, bei denen (in Anlehnung an Caesar’s Wahlspruch „Divide et impera!“) ein

Problem in effizienter Weise in mehrere Teilprobleme zerlegt wird, sodass aus deren

Lösung sich dann die Lösung des ursprünglichen Problems ohne großen Aufwand

rekonstruieren lässt.

10

Als ein klassisches Beispiel für ein Divide and Conquer Verfahren sei hier MERGESORT angeführt, das zur Sortierung von Listen verwendet wird. Wir betrachten hier den

Fall, dass zu Beginn die Liste L in dem Feld [L[1],L[2],...,L[n]] abgelegt ist und diese

etwa aufsteigend sortiert werden soll. Die einfache Grundidee besteht nun darin, dass

man die Liste L in etwa gleich große Listen A und B zerlegt, diese kleineren Listen nach

der gleichen Methode rekursiv sortiert und schließlich aus den beiden sortierten Listen A

und B in einfacher Weise eine sortierte Liste von A macht. Die Details dazu können aus

dem nachfolgenden Derive-Programm ersehen werden:

Für den Aufwand bei MERGESORT, gemessen an der Anzahl C n der durchzuführenden

Vergleiche, wobei n die Anzahl der Listenelemente der zu sortierenden Liste L ist, gilt

dann die rekursive Beziehung:

C n = C ⎡n / 2 ⎤ + C ⎣n / 2 ⎦ + n für n > 1 und C1 = 0 .

Hierbei ist C ⎡n / 2 ⎤ bzw. C ⎣n / 2 ⎦ der Aufwand für das Sortieren der Teillisten A bzw. B und

n der Aufwand für das Zusammenfügen dieser sortierten Teillisten zu einer einzigen

sortierten Liste. (Zu diesem abschließenden „Einsortieren“ müssen nach dem „Reissverschlussprinzip“ nur jeweils die beiden ersten Elemente der zwei sortierten Teillisten

miteinander verglichen werden, um das einzusortierende Element zu bestimmen, welches

dann natürlich aus der entsprechenden Teilliste sofort entfernt wird. Dies wird solange

durchgeführt, bis eine der beiden Teillisten leer ist – also maximal n mal, wonach ev.

noch übrigbleibende Elemente der zweiten Teilliste einfach hinten angehängt werden.)

Für diese Rekursion gibt es sogar eine exakte Lösung, nämlich

C n = n ⎣log 2 n ⎦ + 2n − 2 ⎣log 2 n ⎦+1

(n ≥ 1)

Diese zeigt insbesondere, dass C n ~ n log 2 n (bzw. etwas gröber C n = Θ(n log 2 n ) ). Auf

dieses Ergebnis wäre man aber auch mit Hilfe des Master-Theorems gekommen, indem

man die rekursive Beziehung zunächst vereinfacht zu

C n = 2C n / 2 + n für n>1 und C1 = 0 .

und dann den hier zutreffenden 2. Fall a = b = 2 im Master-Theorem betrachtet.

Wir wollen nun eine grobe Einteilung von Problemen in verschiedene Komplexitätsklassen vornehmen. Es bedeutet hierbei keine Einschränkung der Allgemeinheit, wenn

wir nur Entscheidungsprobleme mit einer Antwort in {JA,NEIN} (oder auch {1,0} bzw.

11

{WAHR,FALSCH}) betrachten, da sich jedes Problem in ein oder mehrere

Entscheidungsprobleme umformulieren lässt.

Die einfachsten Probleme sind nun sicher diejenigen, für die es einen sog.

Polynomialzeitalgorithmus gibt, d.h. dessen Laufzeit T(n) sich durch T(n)=O( n k ) für

eine positive Konstante k nach oben hin abschätzen lässt. Die Klasse all dieser Probleme

wird im folgenden mit P bezeichnet. Solche Probleme werden auch als effizient

berechenbar oder praktikabel bezeichnet.

Eine weitere wichtige Komplexitätsklasse ist NP. Es ist dies die Klasse aller Probleme,

für es einen nichtdeterministischen Polynomialzeitalgorithmus gibt, was JA-Antworten betrifft. Darunter versteht man, dass eine konkret vorgelegte Lösung, welche zu

einer positiven Antwort führt, in Polynomialzeit auf Korrektheit überprüft werden kann.

Was nichtdeterministisch daran ist, ist die Art und Weise, wie man zur Lösung kommt.

(Im Extremfall durch eine Zufallswahl unter allen Möglichkeiten oder durch Raten!) Gilt

dasselbe, aber auf NEIN-Antworten bezogen, so erhält man die Komplexitätsklasse

co-NP. Trivialerweise gilt sowohl P ⊆ NP als auch P ⊆ co-NP.

Versucht man Probleme aus der Klasse NP dadurch zu lösen, indem man einfach alle in

Frage kommenden Lösungen mit Hilfe des Polynomialzeitalgorithmus überprüft, so

kommt man in der Regel auf Abschätzungen für die Laufzeit T(n) der Form

T(n)=O( e f ( n ) ). Es sind dies die Probleme mit exponentiellem Wachstum, welche zur

Komplexitätsklasse EXP gehören. Wenn dabei f(n) nicht allzu schnell wächst, genauer

wenn gilt f(n)=o(n), so spricht man auch von subexponentiellem Wachstum.

Eine andere Klasse ist RP (random polynomial time). Es ist dies die Klasse der

Probleme, für deren Lösung es ebenfalls einen Polynomialzeitalgorithmus gibt, wobei

jedoch die JA-Antworten mit einer Irrtumswahrscheinlichkeit ≤ 1/2 behaftet sind,

während die NEIN-Antworten stets korrekt sind. Indem man hier JA und NEIN

austauscht, kommt man analog wie oben zur Klasse co-RP. Wieder gilt nach Definition

P ⊆ RP und P ⊆ co-RP.

Auf Probleme in der Klasse RP stößt man häufig im Zusammenhang mit Primzahltests.

Als typisches Beispiel sei hier der sog. Rabin-Miller Test genannt, bei dem eine

vorgegebene ungerade Zahl N>1 in der Weise auf Primalität getestet wird , indem man N

zunächst in der Form

N = s2 t + 1 , ungerade, t > 0

darstellt und dann für eine Zufallszahl a mit 1<a<N überprüft, ob entweder

a s ≡ 1 mod N

gilt, oder unter den ersten t Gliedern u 0 , u 1 ,..., u t −1 der rekursiv durch

u 0 = a s mod N, u k +1 = u 2k mod N

Folge einmal –1 mod N vorkommt. Trifft dies zu, wird N als Primzahl akzeptiert,

ansonsten verworfen. Nach einem Satz von Rabin-Monier ist dann die

Fehlerwahrscheinlichkeit für die Aussage „N ist prim“ bei einem einzelnen Test < ¼ und

12

kann durch mehrfache Wiederholung des Tests sogar beliebig klein gemacht werden.

(Man beachte, dass im Gegensatz dazu ein Testergebnis „N ist zusammengesetzt“ stets

korrekt ist.)

Im Zusammenhang mit Primzahltests und Faktorisierungsproblemen nimmt man übrigens

als Maß für die „Größe“ des Problems üblicherweise nicht die zu untersuchende Zahl N

selbst, sondern die Anzahl n = ⎣log10 N ⎦ + 1 ihrer Stellen oder rechnerisch auch ln N, was

wegen n = Θ(ln N) in Komplexitätsabschätzungen auf dasselbe hinausläuft. Wie später

noch genauer ausgeführt wird, hat ein einzelner Rabin-Miller-Test dabei die Laufzeit

O(n 3 ) bzw. O( (ln N) 3 ).

Ist C irgendeine Komplexitätsklasse mit C ⊇ P und sind A,B ∈ C Probleme mit der

Eigenschaft, dass sich die Lösung von A in Polynomialzeit auf die Lösung von B zurückführen lässt, so sagt man A sei (polynomial) reduzierbar auf B und schreibt A ≤ P B .

Gilt sowohl A ≤ P B als auch B ≤ P A , so heißen A und B (polynomial) äquivalent, i.Z.

A ≡ P B . Die anschauliche Deutung: Im Falle A ≤ P B ist A höchstens so schwer wie B,

im Falle A ≡ P B sind A und B gleich schwer. Ist das Problem B aus einer

Komplexitätsklasse D mit D ⊇ C und so beschaffen, dass (bezogen auf D) sogar

A ≤ P B für alle A∈ C gilt, so nennt man es C-hart. Liegt darüber hinaus B sogar in C,

so nennt man es C-vollständig. Ist B ein C-hartes Problem und gilt B ≤ P B′ , so ist

wegen der Transitivität von ≤ P dann B′ ebenfalls C-hart.

Von besonderer Bedeutung für die Komplexitätstheorie sind NP-vollständige Probleme,

die also nach obigem gewissermaßen die „härtesten“ Probleme in der Klasse NP

darstellen, auf deren Lösung sich die Lösung aller anderen Probleme in NP zurückführen lassen. Würde man auch nur für eines der NP-vollständige Probleme zeigen

können, dass es in P liegt, so hätte dies NP ⊆ P , also weiter NP =P zur Folge. (Es

ist unbekannt, ob dies gilt, nach heutigem Stand jedoch eher unwahrscheinlich.)

Um zu zeigen, dass ein vorgegebenes Problem NP-vollständig ist, müsste man nach

obigem nur zeigen, dass es erstens in NP liegt und zweitens ein bereits als NPvollständig erkanntes Problem darauf reduzierbar ist. Dazu benötigt man allerdings ein

„allererstes“ Problem, von dem „auf normalem Weg“ zeigen kann, dass es NPvollständig ist. Diesen Zweck erfüllte historisch gesehen (Beweis von Cook, 1971) das

nachfolgende

SAT- Problem (Erfüllungsproblem der Aussagenlogik)

Gegeben: Eine Formel F der Aussagenlogik.

Gefragt: Ist F erfüllbar (engl. satisfiable), d.h. gibt es eine Belegung der Variablen mit

Wahrheitswerten, sodass F den Wert WAHR bekommt?

Das allgemeine SAT-Problem lässt sich auf ein ganz spezielles reduzieren, nämlich:

3-SAT (auch 3KNF-SAT genannt)

13

Gegeben: Eine Formel F der Aussagenlogik in konjunktiver Normalform (KNF) mit

höchstens 3 Literalen pro Klausel. (Unter Klauseln versteht man dabei die Maxterme der

KNF und unter Literalen deren mit ∨ verknüpften Komponenten.)

Gefragt: Ist F erfüllbar?

Damit ist es nach obigem nun relativ einfach, für eine Reihe weiterer Probleme den

Nachweis zu erbringen, dass sie NP-vollständig sind. Nachfolgend eine kleine Auswahl:

Mengenüberdeckung

Gegeben: k Mengen T1 ,..., Tk ⊆ M für eine feste Grundmenge M und ein n ≤ k .

Gefragt: Gibt es eine Auswahl von n Teilmengen Ti1 ,..., Ti n , deren Vereinigung M ist,

d.h. die M „überdecken“?

Cliquen-Problem

Gegeben: Ein ungerichteter Graph G=(V,E) und eine positive ganze Zahl k.

Gefragt: Besitzt G eine Clique der Größe mindestens k? (Eine Clique ist dabei eine

Teilmenge der Knotenmenge, wobei je zwei verschiedene Knoten durch eine Kante in E

verbunden sind.)

Knotenüberdeckung

Gegeben: Ein ungerichteter Graph G=(V,E) und eine positive ganze Zahl k.

Gefragt: Besitzt G eine „überdeckende Knotenmenge“ der Größe höchstens k? (Darunter

versteht man eine Teilmenge V ′ ⊆ V mit V ′ ≤ k , sodass für alle Kanten {u, v}∈ E gilt

u ∈ V ′ oder v ∈ V ′ .)

Rucksack-Problem (oder Teilmengen-Summen-Problem)

Gegeben: Positive ganze Zahlen a 1 ,..., a k und b.

Gefragt: Gibt es eine Teilmenge I ⊆ {1,2,..., k} mit

∑a

i∈I

i

= b?

Partition

Gegeben: Positive ganze Zahlen a 1 ,..., a k .

Gesucht: Gibt es eine Teilmenge I ⊆ {1,2,..., k} mit der Eigenschaft

∑a = ∑a

i∈I

i

i∉I

i

?

Bin Packing

Gegeben: Eine „Behältergröße“ b ∈ N + , n „Objekte“ a 1 ,..., a n ≤ b und eine Anzahl k>0

von Behältern.

Gefragt: Gibt es eine Abbildung f : {1,..., n} → {1,..., k} , sodass gilt

∑a

f (i)= j

i

≤ b für alle j=1,..,k,

14

d.h. gibt es eine Aufteilung der n Objekte auf die k Behälter, bei der kein Behälter

„überläuft“?

Gerichteter Hamilton-Kreis

Gegeben: Ein gerichteter Graph G=(V,E).

Gefragt: Besitzt G einen Hamiltonkreis, d.h. gibt es eine Permutation π der Knotenindexmenge {1,2,...,n}, sodass

( v π (i ) , v π( i +1) ) ∈ E für i = 1,2,...,n-1 und ( v π( n ) , v π(1) ) ∈ E .

Ungerichteter Hamilton-Kreis

Gegeben: Ein ungerichteter Graph G=(V,E).

Gefragt: Besitzt G einen Hamiltonkreis, d.h. gibt es eine Permutation π der Knotenindexmenge {1,2,...,n}, sodass

{v π (i ) , v π( i +1) } ∈ E für i = 1,2,...,n-1 und {v π ( n ) , v π(1) } ∈ E .

Travelling Salesman Problem (TSP)

Gegeben: Eine n x n Matrix (d ij ) von Distanzen zwischen n Städten und eine Zahl k>0.

Gefragt: Gibt es eine „Rundreise“ einer Gesamtlänge ≤ k , d.h. eine Permutation π von

{1,2,...,n}, sodass

n −1

(∑ d π ( i ),π ( i +1) ) + d π ( n ),π (1) ≤ k ?

i =1

Färbbarkeit von Graphen

Gegeben: Ein ungerichteter Graph G=(V,E) und eine positive ganze Zahl k.

Gesucht: Gibt es eine Färbung der Knoten von V mit k verschiedenen Farben, sodass

keine zwei benachbarten Knoten in G diesselbe Farbe haben?

Probleme aus der Klasse NP führen sehr häufig in natürlicher Weise auf Suchbäume.

Von einem ausgezeichnet Knoten – der Wurzel des Baumes – aus, werden dabei auf der

Suche nach Lösungen, welche gewissen ausgezeichneten Pfaden von der Wurzel zu den

Blättern des Baumes entsprechen, die Knoten des Baumes solange in systematischer

Weise abgesucht, bis man auf eine Lösung stößt. Hierbei gibt es zwei prinzipiell

verschiedene Suchmethoden, die Tiefensuche (engl. Depth First Search oder kurz DFS)

und die Breitensuche (engl. Breadth First Search oder kurz BFS).

Bei der Tiefensuche geht man von der Wurzel ausgehend und bei den Knoten jeweils die

erste noch nicht „abgearbeitete“ Verzweigung nehmend solange „in die Tiefe“, bis man

auf ein Blatt des Baumes stößt. Ist dieses keine Lösung des Problems, so geht man im

Zuge des Backtracking zum letzten Knoten zurück, welcher noch nicht abgearbeitete

Söhne (bzw. Nachbarn) besitzt und nimmt die nächste Verzweigung. In dieser Weise

fortfahrend kann man manchmal sehr schnell auf eine Lösung kommen, aber im worst

case ist der Aufwand in der Regel exponentiell.

15

Bei der Breitensuche werden dagegen laufend Knoten einer (anfangs leeren)

Warteschlange W hinzugefügt (beginnend mit der Wurzel des Baumes). In jedem Schritt

wird dann der jeweils erste Knoten der Warteschlange nach einer problemspezifischen

„Behandlung“ gestrichen und seine eventuelle Söhne (bzw. Nachbarn) in die

Warteschlange hinten eingereiht. Ist die Warteschlange leer, so ist man alle Knoten des

Baumes durchgegangen.

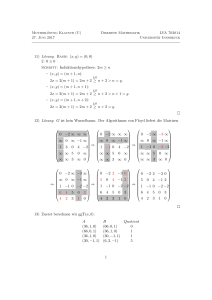

Beide Verfahren, die Tiefen- und die Breitensuche, lassen sich als verschiedene

Methoden der Durchnummerierung von Knoten eines Graphen ansehen, welche dann

jeweils die Reihenfolge vorgibt, in der die Knoten zur Lösung eines spezifischen

Problems „abgearbeitet“ werden, z.B.

1

2

3

1

6

5

8

7

4

Durchnummerierung bei Tiefensuche

2

5

3

6

4

7

8

Durchnummerierung bei Breitensuche

Eine Kombination aus Tiefensuche und Breitensuche sind sog. Branch and Bound

Algorithmen. Sie werden bei der Lösung von Optimierungsverfahren eingesetzt, bei

denen keine anderen effizienten Verfahren bekannt sind, z.B. bei NP-vollständigen

Optimierungsproblemen wie dem TSP. Muss etwa bei einem Problem eine Kenngröße

(z.B. bei TSP die Länge eines Rundweges) minimiert werden, so kann man oft für jeden

Knoten Schranken (engl. bounds) angeben, welche bei Vervollständigung von der durch

jeden Knoten gegeben partiellen Lösung (z.B. bei TSP die Länge des Weges durch alle

bis dahin besuchten Städte) zu einer vollständigen Lösung nicht unterschritten werden

können.

Bei TSP könnte man einen Bound z.B. folgendermaßen gewinnen: Man bildet zunächst

aus der Distanzmatrix D=( d ij ) der n Städte die sog. zeilenreduzierte Matrix D′ = (d ′ij ) ,

indem man von allen Elementen einer jeden Zeile ihr Minimum abzieht und danach in

völlig analoger Weise D′ die spaltenreduzierte Matrix D′′ = (d ′ij′ ) , indem man die

gleiche Prozedur spaltenweise durchführt. Die Gesamtsumme der Zeilen- und

Spaltenminima wäre dann ein Bound für das TSP, der nicht unterschritten werden kann.

Bei der praktischen Durchführung wird nun ein Pfad in dem Suchbaum bis zu einer

vollständigen Lösung verfolgt, wobei jeweils die Abzweigungen im Suchbaum

genommen werden, die zu Knoten mit minimalem Bound führen, was einer Tiefensuche

entspricht. Anschließend müssen dann nur noch jene Knoten abgearbeitet werden, welche

einen kleineren Bound als die schon gefundene vollständige Lösung haben, wobei die

Abarbeitung der noch in Frage kommenden Knoten wie bei einer Breitensuche geschieht.

In völlig analoger Weise können damit natürlich auch Maximierungsprobleme behandelt

werden.

16

2. Algorithmen auf Graphen

Wir wenden uns nun der Untersuchung konkreter Algorithmen zu, wobei der erste

Schwerpunkt den Algorithmen auf Graphen gewidmet ist. Um dabei für das folgende

eine feste Grundlage zu haben, wiederholen wir zunächst einige grundlegende

Definitionen der Graphentheorie.

Ein gerichteter Graph (oder Digraph) wird nachfolgender immer in der Form G=(V,E)

angegeben, wobei E ⊆ V × V wobei eine Relation auf der Menge V der Knoten des

Graphen ist. Die Elemente von E werden dabei auch Bögen oder (gerichtete) Kanten

genannt. Ist E symmetrisch und irreflexiv, so erhält man einen (ungerichteten oder

gewöhnlichen) Graphen. Da es dabei auf Unterscheidung der Richtung nun nicht mehr

ankommt, fasst man meist je zwei gegenläufige Kanten (u,v),(v,u) ∈ E zu einer

zusammen, welche mit {u,v} bezeichnet wird. Gelegentlich ist für einen (gerichteten oder

ungerichteten) Graphen auch noch eine Funktion w definiert, welche jedem Bogen bzw.

jeder Kante eine reelle Zahl zuordnet, wobei diese von der Problemstellung her meist

nichtnegativ ist. (Z.B. könnte diese Bewertung für einen Graphen, welcher ein

Straßennetz repräsentiert, die Längen bzw. die Transportkosten für die Straßenstücke

sein, welche die Knoten verbinden.) Man spricht in diesem Fall von bewerteten

Graphen.

Ist G=(V,E) ein gerichteter Graph und V = {v1 , v 2 ,..., v n } endlich, was wir im Folgenden

stets voraussetzen wollen, so kann die Relation E in einfacher Weise durch eine Matrix

A= (a ij ) , die sog. Adjazenzmatrix des Graphen, beschrieben werden, für die gilt

⎧ 1, falls (v i , v j ) ∈ E

a ij := ⎨

sonst

⎩ 0

Liegt darüber hinaus eine Bewertung w auf G vor, so wird auch oft die Matrix betrachtet,

bei der die entsprechenden Matrixeinträge die Bewertungen der Kanten sind. (Führt dabei

keine Kante von v i nach v j , so ist der entsprechende Matrixeintrag je nach

Problemstellung 0 oder ∞ .)

Anstelle von Adjazenzmatrizen, für deren Speicherung ja in jedem Falle V

2

Plätze

benötigt werden, ist es speziell bei Graphen mit wenig Kanten günstiger, sog. Adjazenzlisten zu betrachten, bei der für jeden Knoten v ∈ V die Menge A(v)= {w ∈ W ( v, w ) ∈ E}

(oft als verkettete Liste) abgespeichert wird. Nimmt man an, dass pro Knoten bzw. Kante

ein konstanter Speicherplatzbedarf benötigt wird (was allerdings nicht sehr realistisch ist,

da die Graphen ja unbeschränkt groß sein können), so ist dann O( V + E ) eine

Abschätzung für den gesamten Speicherplatzbedarf. Dies alles gilt natürlich auch für

ungerichtete Graphen, indem man sie, wie oben ausgeführt, als Spezialfälle von

gerichteten Graphen ansieht.

In einem gerichteten Graph (V,E) heißt nun jede Folge v 0 v1 ...v k mit v 0 , v1 ,..., v k ∈ V

und ( v 0 , v1 ), ( v1 , v 2 ),..., ( v k −1 , v k ) ∈ E eine (gerichtete) Kantenfolge. v 0 und v k heißen

dann (durch die Kantenfolge) verbunden. Die Zahl k wird dabei die Länge der

17

Kantenfolge genannt. Ist dabei v 0 = v k so spricht man von einer geschlossenen

Kantenfolge, sonst von einer offenen. Eine offene bzw. geschlossene Kantenfolge, die

jede Kante des Graphen enthält, wird (wie dann auch der Graph selbst) eulersch genannt.

Falls alle Knoten der Kantenfolge paarweise verschieden sind, spricht man von einer

Bahn oder einem (gerichteten) Weg, falls dies mit genau der Ausnahme v 0 = v k zutrifft

von einem Zyklus oder einem (gerichteten) Kreis. Ein Weg bzw. Kreis, der alle Knoten

des Graphen enthält, wird (wie dann auch der Graph selbst) hamiltonsch genannt.

Existieren in dem gerichteten Graphen keine Zyklen positiver Länge, so heißt er

azyklisch.

Alle zuvor eingeführten Begriffe lassen sich auch wieder auf ungerichtete Graphen

spezialisieren, wodurch man insbesondere die zu den Begriffen Bahn und Zyklus

analogen Begriffe Weg bzw. Kreis erhält. Statt azyklisch sagt man auch kreisfrei. Ein

ungerichteter kreisfreier Graph wird auch Wald genannt.

In ungerichteten Graphen (V,E) kann für alle a,b ∈ V

a ~ b :⇔ a und b sind durch einen Weg verbunden

eine Äquivalenzrelation definiert werden. Die Klassen der zugehörigen Partition heißen

die Zusammenhangskomponenten des Graphen. Besitzt der Graph nur eine

Zusammenhangskomponente (d.h. sind je zwei seiner Knoten verbunden), so heißt er

zusammenhängend. Diesen Zusammenhangsbegriff kann man in ganz analoger Weise

auch gerichteten Graphen einführen, was dann auf sog. stark zusammenhängende

gerichtete Graphen Graphen führt. Führt sie ist aber auch noch die Abschwächung sehr

wichtig, bei der man nur verlangt, dass der zugrundeliegende ungerichtete Graph (sein

sog. Schatten, der aus dem gerichteten Graphen im Wesentlichen durch Weglassung der

Kantenorientierung hervorgeht) zusammenhängend ist. In diesem Fall spricht man von

schwach zusammenhängenden gerichteten Graphen.

Ein ungerichteter Graph, welcher zusammenhängend und kreisfrei ist, wird Baum

genannt. Insbesondere sind also die Zusammenhangskomponenten eines Waldes stets

Bäume. Bäume sind besonders strukturierte Graphen, welche in vielen Anwendungen

eine wichtige Rolle spielen. Sie lassen sich auf verschieden Weisen einfach

charakterisieren, wie der folgende Satz zeigt:

Satz 2.1: Für einen (ungerichteten) Graphen G=(V,E) mit n Knoten sind folgende Aussagen äquivalent.

(1) G ist ein Baum.

(2) Je zwei Knoten von G sind durch genau einen Weg verbunden.

(3) G ist zusammenhängend, aber der Graph G e , der aus G durch Wegnahme einer

beliebigen Kante e ∈ E entsteht, ist nicht mehr zusammenhängend.

(4) G ist zusammenhängend und hat genau n-1 Kanten.

(5) G ist kreisfrei und hat genau n-1 Kanten.

18

(6) G ist kreisfrei, aber der Graph G v , w , welcher aus G entsteht, indem man zwei

ursprünglich nicht benachbarte Knoten v, w ∈ V durch eine Kante verbindet, enthält

genau einen nichttrivialen Kreis.

Ist G=(V,E) ein ungerichteter Graph, so heißt G ′ = (V ′, E ′ ) ein Teilgraph von G, wenn

gilt V ′ ⊆ V und E ′ ⊆ E . Gilt dabei insbesondere V ′ = V , so heißt G ′ ein spannender

Teilgraph von G. Ist ferner G zusammenhängend und G ′ ein spannender Teilgraph,

welcher ein Baum ist, so heißt G ′ auch spannender Baum oder ein Gerüst von G.

In vielen Anwendungen ist nun z.B. für einen zusammenhängenden ungerichteten

Graphen mit einer Bewertung ein Minimalgerüst gesucht, d.h. ein Gerüst, für welches

die Summe aller Bewertungen seiner Kanten minimal ist. (In obigem Beispiel eines

Straßennetzes sollten z.B. nach der “Stilllegung” von möglichsten Straßen doch alle

Knoten verbunden bleiben und die Summe der Distanzen insgesamt ein Minimum sein.)

Der nachfolgende Algorithmus von Kruskal ist vom Typ her ein sog. GreedyAlgorithmus. Damit ist gemeint, dass in den einzelnen Schritten des Algorithmus immer

gerade das gemacht wird, was im Moment das Beste zu sein scheint (“den besten Happen

zuerst”), um zu einer insgesamt optimalen Lösung zu gelangen.

Algorithmus 2.2 (Kruskal) Sei G=(V,E) ein zusammenhängender Graph mit einer

Bewertung w. Auf nachfolgende Weise erhält man dann für ihn ein Minimalgerüst:

1. Sortiere zunächst die Kantenmenge E = {e1 , e 2 ,..., e m } so um, dass danach gilt

w (e1 ) ≤ w (e 2 ) ≤ ... ≤ w (e m )

und setze zu Beginn

B ← ∅ , M ← {{v} v ∈ V} , k ← 1.

Die Elemente von M werden dabei im folgenden als “Komponenten” angesprochen.

(Tatsächlich repräsentieren sie die jeweiligen Zusammenhangskomponenten beim

sukzessiven Aufbau des Minimalgerüsts B.)

2. Füge die Kante e k zu B dazu , d.h. B:= B ∪ {e k } , falls die Endknoten von e k in

verschiedenen Komponenten K 1 , K 2 von M liegen und führe in diesem Fall die

Ersetzung

M ← (M \ { K 1 , K 2 }) ∪ {K 1 ∪ K 2 }

durch, d.h. die beiden Komponenten K 1 und K 2 werden zu einer “verschmolzen”.

3. Ist M = 1 , so stoppe das Verfahren mit der Ausgabe des Minimalgerüsts B. Ansonsten

setze k ← k+1 und fahre bei 2. fort.

Die Begründung, warum dieser Algorithmus funktioniert, basiert im Wesentlichen auf

folgenden

19

Satz 2.3: Sei G=(V,E) ein zusammenhängender Graph mit der Bewertung w und U ⊆ V .

Ist dann e 0 eine Kante, welche zwei Knoten in U und in V\U verbindet mit minimaler

Bewertung, so existiert stets ein Minimalgerüst B, welche diese Kante enthält.

Was die Komplexität des Kruskal-Algorithmus betrifft, so beträgt diese für den ersten

Schritt der Sortierung (z.B. mit Hilfe von Mergesort) O( E ln E ) und für die

Durchführung der Rekursion in 2. und 3. bei geschickter „Buchführung“ der

Zugehörigkeit der Knoten zu den Komponenten O( E ln V ) , was dann wegen

E ≤ V ( V − 1) / 2 < V ⇒ ln E = O(ln V )

2

zugleich die Gesamtkomplexität des Verfahrens ist. Insbesondere liegt also der KruskalAlgorithmus in der Komplexitätsklasse P.

Ebenfalls vom Typ „Greedy-Algorithmus“ ist der Dijkstra-Algorithmus zur Bestimmung

der kürzesten Wege zwischen einem festgehaltenen Knoten v 0 und einem beliebigen

Knoten v in einem (gerichteten oder ungerichteten) Graphen mit einer Bewertung w.

(„Kürzest“ ist dabei in Hinblick auf die Summe der Bewertungen längs eines Weges zu

verstehen.) In einer nachfolgenden Formulierung werden wir, um uns bez. des Typs des

Graphen nicht festlegen zu müssen, eine Kante von u nach v einfach mit uv bezeichnen,

wobei dann uv dann (u,v) bzw. {u,v} bedeutet, je nachdem, ob der Graph gerichtet ist

oder nicht.

Algorithmus 2.4: (Dijkstra) Sei G=(V,E) ein (gerichteter oder ungerichteter) Graph mit

einer nichtnegativen Bewertung w. Ist dann v 0 ∈ V ein festgewählter Knoten, so kann

dann für jeden Knoten v ∈ V in folgender Weise der Abstand d(v):=d(v, v 0 ) , sowie eine

Menge pred(v) aller unmittelbaren “Vorgänger” (auf einem kürzesten Weg von v

nach v 0 ) berechnet werden:

(1) Setze d ( v 0 ) ← 0, d(v) ← ∞ ∀ v ∈ V \{ v 0 } , pred(v):= ∅ ∀ v ∈ V , sowie U ← V.

(2) Falls U= ∅ , dann STOP, sonst weiter mit (3).

(3) Finde ein u ∈ U für das d(u) minimal ist. Ist d(u)= ∞ , dann ebenfalls STOP.

(4) Für alle v ∈ U mit uv∈E sei d(v):=min{d(v),d(u)+w(uv)}. Zusätzlich wird, falls der

neue Wert von d(v) kleiner als der alte ist, auch pred(v) aktualisiert: pred(v) ← {u}. (Ist

man dabei nicht nur an einem, sondern an allen kürzesten Wegen von v 0 nach v

interessiert, so hätte man im Fall der Gleichheit des alten und neuen Distanzwertes die

Ersetzung pred(v) ← pred(v) ∪ {u} vorzunehmen.)

(5) Setze U:=U\{u} und mach weiter mit (2).

Nach Beendigung des Algorithmus kann man zu jedem v ∈ V , welches von v 0 überhaupt

über einen Weg “erreichbar” ist, was sich in d(v)< ∞ ausdrückt, auch sofort einen

kürzesten Weg v 0 v1 ...v k von v 0 nach v = v k in der Weise angeben, indem man jeweils

ein v i −1 ∈ pred( v i ) in der Reihenfolge i = k,k-1,…,1 auswählt.

20

2

Wie man leicht sieht, ist der Rechenaufwand beim Dijkstra-Algorithmus O( V ) ), was

bedeutet, dass er ebenfalls sehr schnell und insbesondere auch wieder ein Polynomialzeitalgorithmus ist. Ferner kann man mit demselben Aufwand, indem man einfach alle

Kanten mit 1 bewertet, für jeden Graphen auch überprüfen, ob ein Knoten v von v 0 aus

erreichbar ist, da genau in diesem Fall nach Durchlaufen des Algorithmus d(v) einen

endlichen Wert hat.

Will man die kürzeste Distanz zwischen zwei beliebigen Knoten eines Graphen

feststellen, so könnte man im Prinzip den Dijkstra-Algorithmus V -mal durchführen,

indem man einfach den Startknoten alle Knoten des Graphen durchlaufen läßt, was dann

3

offensichtlich auf den Gesamtaufwand O( V ) führt.

Von derselben Komplexität, aber in der Praxis dann doch schneller ist der sog. WarshallFloyd Algorithmus. Sei dazu V= {v1 ,...., v n } die Knotenmenge eines (gerichteten oder

ungerichteten ) Graphen mit der Bewertung w und für jedes k ∈ {1,.., n} sei d ij( k ) die

kürzeste Länge eines Weges zwischen v i und v j , i,j=1,..,n, (“kürzest” wieder in Hinblick auf die Bewertung) , welcher nur Knoten aus der Menge {v1 ,...., v k } enthält.

Existiert überhaupt kein derartiger Weg, so setzen wir d ij( k ) = ∞ . Offensichtlich gilt dann

die rekursive Beziehung

d ij( k ) = min(d ij( k −1) , d ik( k −1) + d (kjk −1) ) , i,j,k=1,…,n

d.h. wir müssen bei Hinzunahme des Knotens v k jedesmal prüfen, ob es gegenüber dem

alten Weg ohne v k nun nicht vielleicht einen kürzeren Weg gibt, der aber dann von v i

nach v k und von v k weiter nach v j laufen muss, wobei diese beiden Teilwege nur

jeweils Knoten aus {v1 ,...., v k −1 } enthalten.

Der nachfolgende Algorithmus war ursprünglich von Warshall nur dazu konzipiert

worden, die transitive Hülle einer Relation zu bestimmen, d.h. die Bewertungen wurden

von ihm alle als 1 angenommen, und er wurde erst von Floyd auf die vorliegende

allgemeinere Form gebracht.

Algorithmus 2.5: (Warshall-Floyd)

Sei G = (V,E) ein (gerichteter oder ungerichteter) Graph mit der Bewertung w und der

Knotenmenge V= {v1 ,...., v n } . Nach Durchlaufen des folgenden Algorithmus enthält dann

d ij die Länge eines kürzesten Weges zwischen v i und v j , i,j=1,…,n, bezogen auf die

Bewertung:

1. Setze zu Beginn für i,j=1,…,n

⎧

0,

⎪

d ij ← ⎨ w(v i v j ),

⎪

∞,

⎩

falls i = j

falls v i v j ∈ E

falls v i v j ∉ E

21

2. Für alle k=1,..., n

für alle i=1,..., n

für alle j=1,..., n

falls d ik + d kj < d ij setze d ij ← d ik + d kj ,

Insbesondere können wir nach dem Durchlaufen des Algorithmus aus dem Erfülltsein der

Bedingung d ij < ∞ wieder ablesen, ob zwei Knoten v i und v j durch einen Weg verbunden sind oder nicht. Ferner können wir aus der Anzahl der Iterationen in Schritt 2,

welche ja n 3 beträgt, schließen, dass der Gesamtaufwand, wie bereits erwähnt,

3

tatsächlich von der Ordnung O( V ) ist.

Ein weiterer wichtiger Begriff für Graphen ist der Grad eines Knotens. Genauer

definieren wir für einen gerichteten Graphen G=(V,E) und für jeden Knoten v ∈ V den

Weggrad von v als die Anzahl der Bögen, welche von v “wegführen”, i.Z. d + ( v).

Analog heißt die Anzahl der Bögen, welche zu v “hinführen” der Hingrad von v, i.Z.

d − ( v). Bei Spezialisierung auf ungerichtete Graphen entfällt natürlich die Unterscheidung zwischen Hingrad und Weggrad und man spricht dann einfach vom Grad d(v)

des Knotens v.

Interpretiert man d + ( v) bzw. d − ( v) als die Summe der Elemente in der Zeile bzw.

Spalte der Adjazenzmatrix, welche zu v gehört, so ergibt sich daraus unmittelbar

Satz 2.6: Ist jedem gerichteten Graph G=(V,E) gilt

∑d

v∈V

+

( v) = ∑ d − ( v) = E

v∈V

Durch Spezialisierung auf ungerichtete Graphen, wo aber jetzt jede Kante gewissermaßen

„doppelt gezählt“ werden muss, erhält man daraus weiter

Folgerung 2.7 („Handschlaglemma“): In jedem ungerichteten Graphen G=(V,E) gilt

∑ d ( v) = 2 E ,

v∈V

d.h. die Summe aller Grade des Graphen ist gleich der doppelten Anzahl seiner Kanten.

Mit Hilfe des Gradbegriffs können wir auch eine einfache Bedingung für die Existenz

von geschlossenen eulerschen Kantenfolgen (auch eulersche Kreise oder Eulertouren

genannt) angeben:

Satz 2.8: Genau dann existiert in einem (ungerichteten) zusammenhängenden Graphen

G=(V,E) ein eulerscher Kreis, wenn alle seine Knoten geraden Grad haben.

Zu seiner Konstruktion bedient man sich des

Algorithmus 2.9 (Hierholzer): Sei G=(V,E) ein (ungerichteter) zusammenhängender

Graph, in dem alle Knoten geraden Grad haben. Dann erhält man auf folgende Weise

einen eulerschen Kreis:

22

1. Wähle vom einem beliebigen Startknoten v 0 ausgehend sukzessive Knoten v1 , v 2 ,...

mit der Eigenschaft, dass in der Kantenfolge v 0 v1 ...v i alle Kanten verschieden sind, bis i

eine Kantenfolge v 0 v1 ...v k erreicht wird, die nicht mehr in dieser Weise fortsetzbar ist

und dann aufgrund der gemachten Voraussetzungen notwendigerweise geschlossen sein

muss, d.h. es ist v k = v 0 . Ist die so erhaltenene Kantenfolge K 0 bereits ein eulerscher

Kreis, dann STOP.

2. Wähle einen Knoten w 0 = v j in K 0 , der mit einer noch “unbenutzten” Kante inzidiert

und konstruiere davon ausgehend so wie in 1. einen weitere Kantenfolge

K 1 = w 0 w 1 ...w m , die wieder nur bisher “unbenutzte” Kanten verwendet und für die dann

ebenfalls wieder w m = w 0 gelten muss. Mit Hilfe von K 1 wird nun K 0 “aktualisiert” zu

K 0 ← v 0 v1 ...v j w 1 ...w m −1 v j v j+1 ...v k

d.h. K 1 wird in K 0 “eingebettet”. Ist damit ein eulerscher Kreis erreicht, dann STOP,

ansonsten wird 2. solange wiederholt bis dies der Fall ist.

Ist der Graph in Form von Adjazenzlisten (A v ) v∈V gespeichert, so ist es naheliegend, die

“Buchhaltung “ über die Benutzung einer Kante uw in der Weise durchzuführen, dass

man u aus A w und w aus A v “streicht”, also jeweils die Ersetzung

A w ← A w \{u} und A u ← A u \{w}

durchführt. Am Ende des Durchlaufs sind dann alle Adjazenzlisten leer. Insbesondere

kann daher der Rechenaufwand durch O( E + V ) abgeschätzt werden.

Interessanterweise sind die scheinbar verwandte Probleme, ob ein Graph hamiltonsch ist

und wie gegebenenfalls ein hamiltonscher Kreis, d.h. ein Kreis, welcher jeden Knoten

des Graphen genau einmal enthält, gefunden werden kann, alles andere als trivial, und

gehören, wie wir bereits aus Kap. I wissen, zur Klasse NP. Es existieren dazu lediglich

Teilresultate, wie z.B. der folgende

Satz 2.10: Sei G=(V,E) ein ungerichteter Graph mit V ≥ 3. Gilt dann d(v) ≥ V /2, so ist

G hamiltonsch.

Für viele Problemstellungen, die gerichtete Graphen G = (V,E) betreffen, benötigen wir

eine sog. topologische Sortierung der Knotenmenge V, womit eine Durchnummerierung

V= {v1 , v 2 ,..., v n } gemeint ist, sodass stets gilt ( v i , v j ) ∈ E ⇒ i < j . Zunächst zeigt man

leicht folgenden

Satz 2.11: Genau dann lässt ein gerichteter Graph eine topologische Sortierung zu, wenn

er azyklisch ist.

Die Auffindung einer topologischen Sortierung geschieht dann mit Hilfe von

Algorithmus 2.12: Sei G=(V,E) ein azyklischer gerichteter Graph, welcher durch seine

Adjazenzlisten (A v ) v∈V gegeben ist. Auf folgende Weise erhält man dann eine

topologische Sortierung:

23

1. Berechne vorweg die Liste (d − ( v)) v∈V aller Hingrade, indem die Adjazenzlisten

durchlaufen werden.

2. Setze c ← 1 und U ← V.

3. Bestimme ein u ∈ U mit d − (u ) = 0 und setze ν (u) ← c, sowie d − ( v) ← d − ( v) − 1 für

alle v ∈ V mit (u,v) ∈ E .

4. Setze U ← U\{u}. Falls U= ∅ , dann STOP, sonst setze c ← c+1 und mach weiter bei 3.

Wiederum hat der Algorithmus dabei den gleichen Aufwand, wie der zur Erstellung bzw.

Verwaltung der Adjazenzlisten, nämlich O( E + V ).

Benötigt werden topologische Sortierungen z.B. bei der Berechnung von längsten Wegen

in Netzplänen. Unter einem Netzplan versteht man dabei einen azyklischen gerichteten

Graphen G mit einer reellen Bewertungsfunktion w, wobei darüberhinaus gefordert wird,

dass ein Knoten Q mit d − (Q) = 0 (eine sog. Quelle) und ein Knoten S mit d + (S) = 0

(eine sog. Senke) vorliegt, und dass er darüberhinaus schwach zusammenhängend ist,

d.h. ohne Berücksichtigung der Orientierung der Kanten gibt es stets einen (dann

ungerichteten) Weg zwischen zwei verschiedenen Knoten des Graphen.

In der sog. Netzplatztechnik geht es dann darum, für jeden Knoten des Netzplans den

längsten Weg (wieder im Sinne der Bewertung) eines jeden Knotens sowohl zur Quelle

als auch zur Senke zu bestimmen.

In den Anwendungen sind dann die Knoten des Netzplans gewisse Ereignisse (z.B. bei

einem Bauvorhaben das Erreichen von gewissen Stadien der Fertigstellung), die Quelle

ist das Startereignis (z.B. Baubeginn) und die Senke das Zielereignis. Durch

technologische Vorgaben können gewisse Ereignisse oft erst nach anderen eintreten, was

sich im Graphen so ausdrückt, dass es von einem früheren Ereignis E zu einem späteren

Ereignis F einen gerichteten Weg gibt, dessen Bögen alles Vorgänge sind, welche noch

ablaufen müssen, bevor das Ereignis F eintreten kann, wenn E schon eingetreten ist.

Wir denken uns die Knoten des Netzplanes mit den Nummern 9 bis n durchnummeriert,

wobei wir stets annehmen, dass diese topologisch sortiert sind.. Wenn die Bewertung d ij

der gerichteten Kante von i nach j die Zeitdauer darstellt, welche für den Vorgang, der

durch den Bogen von i nach j dargestellt wird, benötigt wird, so sind dann für

j=0,1,2,…,n die Größen

FTj (=Frühestmöglicher Termin für das Eintreten des Ereignisses j),

ST j (=Spätestmöglicher Termin für das Eintreten des Ereignisses j)

von großer Wichtigkeit. Graphentheoretisch ist dabei FTj nichts anderes als die Länge

eines im Sinne dieser Bewertung längsten Weges von 0 nach j und ST j die Differenz

FTn -(Länge eines längsten Wegs von j nach n).

Sie können mit der sog. Critical Path Method (abg. CPM) folgendermaßen rekursiv

berechnet werden:

24

Algorithmus 2.13 (CPM):

FT0 = 0, FTj = max{FTi + d ij (i, j) ∈ E}, j=1,2,…,n

bzw. (mit dem dann bekannten FTn )

STn = FTn , STi = min{ST j − d ij (i, j) ∈ E}, i=n-1,n-2,…,0.

Fallen FT i und ST i für einen Knoten i zusammen, so wird das dadurch repräsentierte

Ereignis ein kritischen Ereignis genannt, da es dafür keinen Puffer (=zeitlichen

Spielraum) gibt, will man die Mindestgesamtdauer des Projekts, nämlich FTn (auch krit.

Dauer genannt), nicht gefährden. Aus graphentheoretischer Sicht müssen alle diese

Knoten auf Wegen von maximaler Länge von der Quelle bis zur Senke, auch kritische

Pfade (engl. critical paths) genannt, liegen.

Ähnlich wie beim Dijkstra-Algorithmus müssen auch bei CPM alle Knoten

durchgegangen werden, wobei der Aufwand pro Knoten O( V ) beträgt, womit sich der

2

Gesamtaufwand daher zu O( V ) ergibt.

Abschließend noch ein Algorithmus zum Thema “Auftragsplanung mit Schlußterminen”.

Sei dazu eine Menge von n Aufträgen gegeben, die wir der Einfachheit halber mit 1,…,n

bezeichen. Jedem Auftrag i ist dabei ein Schlußtermin d i ∈ N* und ein Gewinn p i ∈ R +

zugeordnet. Die Aufträge werden dabei auf einer Maschine, die pro Zeiteinheit genau

einen Auftrag durchführen kann. Eine Teilmenge A ⊆ {1,..., n} von Aufträgen wollen wir

dabei zulässig nennen, falls es für A eine Anordnung i1 , i 2 ,..., i k ihrer Elemente gibt,

sodass d i1 ≥ 1, d i 2 ≥ 2, ... , d i k ≥ k , d.h. wenn jeder Auftrag von A vor seinem Schlußtermin erledigt werden kann. Natürlich sind wir in erster Linie an jenen zulässigen

Teilmengen A interessiert, für welche der Gesamtgewinn maximiert wird.

Für die Lösung dieser Aufgabe gibt es wieder einen “Greedy-Algorithmus”, dessen

Komplexität, wie man zeigen kann, O(n 2 ln n ) beträgt:

Algorithmus 2.14: Mit den oben eingeführten Bezeichnungen erhält man auf folgende

Weise eine Teilmenge A ⊆ {1,..., n} , für welche der Gewinn maximal ist:

1. Nummeriere zu Beginn, soweit dies erforderlich ist, die Aufträge so um, dass danach

gilt p1 ≥ p 2 ≥ K ≥ p i n und setze A ← ∅ und i ← 1.

2. Ist A ∪ {i} eine zulässige Lösung, so setze A ← A ∪ {i} .

3. Setzte i ← i+1. Falls i>n, dann STOP, sonst fahre mit 2. fort.

Wie nachstehend ausgeführt, führt ein solcher “Greedy-Ansatz”genau dann zum Erfolg,

wenn die Aufgabenstellung so interpretiert werden kann, dass optimale Lösungen in

einem sog. Matroid gefunden werden müssen. Um genauer darauf eingehen zu können

benötigen wir wieder einige Begriffe.

Sei dazu E eine endliche Menge und U eine nichtleere Menge von Teilmengen von E.

(E,U) heißt dann ein Teilmengensystem, wenn gilt

25

•

A ⊆ B, B ∈ U ⇒ A ∈ U.

Gilt darüber hinaus die sog. Austauscheigenschaft

•

A, B ∈ U, A < B ⇒ ∃ x ∈ B \ A: A ∪ {x} ∈ U

so spricht man von einem Matroid.

Ist ferner für ein Teilmengensystem (E,U) eine Gewichtsfunktion w: E → R vorgegeben, so ist dann das zugehörige Optimierungsproblem die Frage nach einer in U bez. ⊆

maximalen Teilmenge T, für welche das Gesamtgewicht

w ( T ) = ∑ w ( e)

e∈T

ein Maximum (oder auch ein Minimum, je nach Aufgabenstellung) ist. Beim

kanonischen Greedy-Algorithmus würde man dann in Analogie zu 4.14 so vorgehen, dass

man die Elemente von E nach absteigendem (bzw. für ein Minimum nach aufsteigendem)

Gewicht sortiert und zu einer anfänglich leeren Menge A in dieser Reihenfolge Elemente

e ∈ E dazugibt genau dann, wenn für sie A ∪ {e} ∈ U gilt.

Die so erhaltene Menge A wird jedoch im allgemeinen nicht optimal sein. Es gilt jedoch

der grundlegende

Satz 2.15: Sei (E,U) ein Teilmengensystem. Der kanonische Greedy-Algorithmus liefert

für das zugehörige Optimierungsproblem ganau dann für jede Gewichtsfunktion

w: E → R eine optimale Lösung, wenn (E,U) ein Matroid ist.

3. FFT oder schnelle Algorithmen für die Multiplikation

Werden mit Hilfe der „Schulmethode“ zwei Zahlen a,b ≤ N miteinander multipliziert, so

ist der Rechenaufwand offenbar von der Ordnung O( (ln N) 2 ), da dabei jede Ziffer von a

mit jeder Ziffer von b multipliziert wird und die Anzahl der Bitoperationen bei diesen

Operationen (nämlich der Anwendung des „kleinen 1 x 1“) nach oben beschränkt ist. Wie

wir in diesem Kapitel aber zeigen werden, gibt es speziell für große Zahlen weit bessere

Verfahren zur Multiplikation.

Eine erste einfache Möglichkeit wurde Karatsuba 1962 (in etwas komplizierterer Form

als nachfolgend beschrieben) angegeben. Denken wir uns dazu zwei positive ganze

Zahlen u und v mit je 2n Bits durch ihre Binärdarstellung gegeben, also

u = (u 2 n −1 ...u 1 u 0 ) 2 bzw. v = ( v 2 n −1 ...v1 v 0 ) 2

so können wir sie dann auch schreiben in der Form

u = 2 n U 1 + U 0 , v = 2 n V1 + V0 ,

wobei U 1 = (u 2 n −1 ...u n ) 2 , U 0 = (u n −1 ...u 0 ) 2 bzw. V1 = ( v 2 n −1 ...v n ) 2 , V0 = (u n −1 ...u 0 ) 2 ist.

Unter Benützung dieser Darstellungen gilt dann

26

uv = (2 2 n + 2 n ) U 1 V1 + 2 n ( U 1 − U 0 )(V0 − V1 ) + (2 n + 1) U 0 V0 .

Wie diese Formel zeigt, kommt man also bei der Multiplikation von zwei Zahlen mit je

2n Bits mit nur drei Multiplikationen von Zahlen mit je n Bit, sowie einigen einfachen

binären Schiebeoperationen und Additionen aus. Bezeichnet also T(n) die Anzahl der

Bitoperationen für die Multiplikation von zwei Zahlen mit je n Bit, so erhalten wir so die

Abschätzung

T(2n ) ≤ 3T(n ) + cn

für eine gewisse Konstante c > 0. Daraus folgt nun ähnlich wie in 1.1, dass gilt

Satz 3.1: Für die Multiplikation von zwei Zahlen mit je n Bits nach Karatsuba ist der

Rechenaufwand durch O(n lg 3 ) ≈ O(n 1.585 ) nach oben beschränkt.

Karatsuba’s Methode kann noch in der Weise verallgemeinert werden, dass man u und v

allgemeiner in r+1 (r ≥ 1 ) Binärblöcke unterteilt, also in der Form

u = U r 2 rn + ... + U1 2 n + U 0 bzw. v = Vr 2 rn + ... + V1 2 n + V0

darstellt, wobei die U j bzw. Vj jeweils Zahlen mit n Bits sind. Sind dann

U( x ) = U r x r + ... + U 1 x + U 0 bzw. V( x ) = Vr x r + ... + V1 x + V0

die zugehörigen Polynome und ist W(x) deren Produkt, also

W ( x ) = U( x )V( x ) = W2 r x 2 r + ... + W1 x + W0 ,

so gilt dann u = U(2 n ) bzw. v = V(2 n ) , sowie uv = W (2 n ) . Wir können daher uv leicht

berechnen, wenn wir die Koeffizienten von W(x) kennen.

Eine effiziente Möglichkeit, diese Koeffizienten zu berechnen, besteht nun darin, dass

man zunächst die 2r+1 Produkte

U(0)V(0) = W(0), U(1)V(1) =W(1), ... , U(2r)V(2r) = W(2r)

berechnet (obwohl bei U(j) und V(j) die Bitlänge von n in der Regel um einige Bits

überschritten wird, um zwar um maximal t Bits, wobei t nur von r abhängt, so ist der

Rechenaufwand für die Berechnung dieser Produkte doch von der Form T(n) + c1 n ). Es

zeigt sich dann, dass die gesuchten Koeffizienten einfach eine Linearkombination dieser

Produkte sind, sodass also rechnerisch nur die Berechnung dieser 2r+1 Produkte ins

Gewicht fällt. Insgesamt erhalten wir daher für den Rechenaufwand wieder eine

Abschätzung

T((r+1)n) ≤ (2r+1)T(n) +cn

mit deren Hilfe man dann leicht zeigen kann, dass allgemeiner gilt

Satz 3.2: Für jedes ε > 0 gibt es einen Multiplikationsalgorithmus derart, dass für die

Anzahl T(n) der Bitoperationen, welche für die Multiplikation von zwei Zahlen mit je n

Bits benötigt werden, gilt

T (n ) < c(ε)n 1+ε ,

27

wobei c(ε) eine nur von ε abhängige Konstante ist.

Dies bedeutet, dass es Algorithmen für die Multiplikation gibt, welche beliebig nahe an

eine lineare Abhängigkeit von n herankommen, was doch einigermaßen überraschend ist.

Im Detail gibt es aber noch eine Menge algorithmischer Feinheiten. Wir werden einige

von diesen an dem nachfolgendem Beispiel studieren. Sei dazu

u = (0100 1101 0010) 2 und v = (1001 0010 0101) 2

und r = 2. Die Polynome U(x) und V(x) haben dann folgendes Aussehen:

U( x ) = 4 x 2 + 13x + 2 bzw. V( x ) = 9x 2 + 2x + 5 .

Für die Werte von U(x), V(x) und W(x) = U(x)V(x) an den Stellen 0,1,2,3,4 erhalten wir

dann

U(0) =2,

U(1)=19,

U(2) =44,

U(3)=77,

U(4)=118;

V(0) =5,

V(1)=16,

V(2) =45,

V(3)=92,

V(4)= 157;

W(0) =10, W(1)=304, W(2)=1980, W(3)=7084, W(4) = 18526;

Es geht also im Folgenden darum, möglichst effizient die Koeffizienten von W(x) aus

den Werten W(0),...,W(4) zu berechnen. Dazu denken wir uns zunächst W(x) in der Form

W(x) = a 4 x 4 + a 4 x 3 + a 4 x 2 + a 4 x 1 + a 0

dargestellt, wobei

x k := x ( x − 1)...( x − k + 1) , k=0,1,...,4

die sog. faktoriellen Potenzen sind.

Diese faktoriellen Potenzen haben allgemein die folgende wichtige Eigenschaft, dass

∆x k := ( x + 1) k − x k = kx k −1 , k=0,1,2,...

d.h. durch Bildung dieser Differenzen erhält man einen Term, der äußerlich an eine

1.Ableitung für gewöhnliche Potenzen erinnert. Dies gilt dann auch für W(x) selbst:

∆W ( x ) := W ( x + 1) − W ( x ) = 4 a 4 x 3 + 3a 3 x 2 + 2a 2 x 1 + a 1

Dies kann man (in Analogie zu Mehrfachableitungen!) fortsetzen und erhält so

∆2 W ( x ) := ∆W ( x + 1) − ∆W ( x ) = 12a 4 x 2 + 6a 3 x 1 + 2a 2

∆3 W ( x ) := ∆2 W ( x + 1) − ∆2 W ( x ) = 24a 4 x 1 + 6a 3

∆4 W ( x ) := ∆3 W ( x + 1) − ∆3 W ( x ) = 24a 4

Man erhält so (in exakter Analogie zu den Formeln für die Koeffizienten einer Taylorreihe!)

(1 / k!)∆k W (0) = a k , k=0,1,2,...

28

womit die a k in einfacher Weise durch nachfolgendes Differenzenschema erhalten

werden können:

10

304

1980

7084

294

1676

5104

11442

1382/2 = 691

3428/2 = 1714

1023/3 = 341

1455/3 = 485

144/4 = 36

6338/2 = 3169

18526

Die erste Spalte wird dabei gebildet von W(0),W(1),...,W(4), die gesuchten Koeffizienten

a 0 , a 1 ,...., a 4 stehen in dieser Reihenfolge an der Spitze der Spalten von links nach rechts,

also a 0 = 10, a 1 = 294, ..., a 4 = 36 , d.h. es gilt

W ( x ) = 36x 4 + 341x 3 + 691x 2 +294 x 1 +10 =

= (((36( x − 3) + 341)(x − 2) + 691)( x − 1) + 294) x + 10 ,

wobei die letzere Formel eine einfache Möglichkeit angibt, die gesuchte „echte“ Polynomdarstellung

W ( x ) = w 4 x 4 + w 3 x 3 + .... + w 1 x + w 0

von W(x) zu gewinnen, nämlich

W(x) = 36x 4 + 125x 3 + 64x 2 + 69x + 10 .

Die Antwort auf die ursprünglich gestellte Frage lautet daher

1234 ⋅ 2341 = W(16) = 2888794,

wobei W(16) durch bloße binäre Addier- und Schiebeoperationen berechnet wird.

Wir verzichten hier darauf, dass in diesem Beispiel vorgestellte Verfahren noch weiter

auszuformalisieren und zu verfeinern, was dann zu dem sog. Toom-Cook-Algorithmus

führen würde, da wir im Folgenden gleich noch bessere Verfahren kennenlernen werden.

Dazu bedarf es allerdings einiger Vorbereitungen.

Nachfolgend bezeichne dazu (R,+,⋅ ,1), wenn nichts anderes gesagt wird, stets einen

kommutativen Ring mit Einselement.

Def. 3.3: ω ∈ R heißt eine n-te Einheitswurzel (n>0), wenn ω n = 1 , und eine primitive nte Einheitswurzel, wenn darüber hinaus noch gilt, dass n: = 1+1+...+1 (n-mal) eine

Einheit in R und ω n / p − 1 für keinen Primteiler p von n ein Nullteiler von R ist.

Bem. 3.4: Ist R nullteilerfrei, z.B. ein Körper, so vereinfacht sich obige Bedingung für

eine primitive n-te Einheitswurzel dahingehend, dass zwar ω n = 1 , aber ω n / p ≠ 1 für

jeden Primteiler p von n gelten muss. Dies ist wiederum äquivalent damit, dass n die

29

Ordnung von ω in der Einheitengruppe E(R) ist. Speziell für einen Körper Fq existieren

primitive n-te Einheitswurzeln also genau dann, wenn n ein Teiler von q-1 ist. Im

klassischen Fall R = C dagegen existieren stets primitive n-te Einheitswurzeln für

beliebiges n und sie sind alle von der Form exp(2πki/n), wobei 0 ≤ k < n und ggT(k,n)=1

gilt.

Für unsere Zwecke liegt die Bedeutung von primitiven Einheitswurzeln begründet in dem

Lemma 3.4: Für jede primitive n-te Einheitswurzel ω ∈R gilt:

(1) ω k − 1 ist kein Nullteiler in R allgemeiner für alle k mit 0 < k < n.

n −1

(2)

∑ω

jk

= 0 für alle k mit 0 < k < n.

j= 0

(3) Seien Ω = (Ω jk ) und Ω = ( Ω jk ) und die Matrizen definiert durch Ω jk := ω jk bzw.

Ω jk := ω − jk . Dann gilt ΩΩ = nI n , wobei I n hier und im folgenden die n-zeilige Einheits-

matrix bezeichnet. Insbesondere ist also (1/n) Ω die zu Ω inverse Matrix.

Damit sind wir nun bereit für

Def. 3.5: Für jede primitive n-te Einheitswurzel ω ∈ R wird die R-lineare Abbildung

DFTω : R n → R n ,welche für jeden Vektor a= (a 0 a 1 ,..., a n −1 ) ∈ R n definiert ist durch

a a (f (1), f (ω), f (ω 2 ),..., f (ω n −1 )) ( f ∈ R n )

wobei f(x) = a 0 + a 1 x + ... + a n −1 x ∈ R [x ] , d.h. also DFTω (a) = a Ω , die Diskrete Fouriertransformation (DFT) genannt.

Auf R n ist nun außer der punktweisen Addition, Multiplikation und Skalarmultiplikation

mit Elementen aus R eine weitere wichtige Operation definiert, die im Folgenden eine

große Rolle spielen wird.

Def. 3.6: Für beliebige Vektoren a = (a 0 , a 1 ,..., a n −1 ) und b = (b 0 , b1 ,..., b n −1 ) in R n ist

die sog. zyklische Faltung a * b definiert durch den Vektor c = (c 0 , c1 ,..., c n −1 ) ∈ R n , für

welchen gilt

c k :=

∑a b

i

i + j≡ k mod n

j

(0 ≤ k < n)

Bem. 3.7: Geht man von den Vektoren a = (a 0 , a 1 ,..., a n −1 ) , b = (b 0 , b1 ,..., b n −1 ) und c =

= (c 0 , c1 ,..., c n −1 ) zu den entsprechenden Polynomen f(x) = a 0 + a 1 x + ... + a n −1 x , g(x) =

= b 0 + b1 x + ... + b n −1 x bzw. h(x) = c 0 + c1 x + ... + c n −1 x in R[x] über, so sieht man

unschwer ein, dass c = a * b genau dann gilt, wenn f(x)g(x) ≡ h(x) mod ( x n − 1 ). Die

zyklische Faltung entspricht also aus algebraischer Sicht genau der Multiplikation in dem

Faktorring R[x]/( x n − 1 ).

Wie schon in der Definition angeführt, ist die DFT stets R-linear und wegen 2.4(3) auch

bijektiv. Eine weitere wichtige Eigenschaft ergibt sich aus

30

Satz 3.8: Für beliebige Vektoren a,b ∈ R n gilt

DFTω (a * b) = DFTω (a ) ⋅ DFTω (b)

wobei auf der rechten Seite dieser Gleichung die punktweise Multiplikation in R n

gemeint ist, d.h. die Abbildung DFTω ist ein Isomorphismus von (R n , * ) auf (R n , ⋅ ) .

Damit eröffnet sich der folgende „Plan“ für die Multiplikation zweier großer ganzer

Zahlen x,y > 0. Man stellt dazu x und y zunächst in einer geeignet gewählten Basis B dar,

also

n −1

x=

∑ x k B k und y =

k =0

n −1

∑y

k =0

k

Bk

wobei n so groß gewählt wird, dass mindestens die Hälfte der führenden „Ziffern“ von x

und y in diesen B-adischen Darstellung 0 sind. Durch dieses sog. Zero-padding wird

erreicht, dass die Polynommultiplikation von x und y mod ( B n − 1) zu einer „normalen“

Multiplikation von x und y wird. Mit Hilfe von 3.8 können wir dann die Faltung, welche

offensichtlich n 2 Multiplikationen benötigt, auf die punktweise Multiplikation zurückführen, welche nur mit n Multplikationen auskommt. Allerdings würde bei einer naiven

Anwendung der DFT dieser Vorteil durch die notwendigen Transformationen und Rücktransformationen von x und y wieder zunichte gemacht werden.

An dieser Stelle kommt nun eine Idee von Cooley und Tukey (1965) ins Spiel, welche

aus der DFT die FFT (= Fast Fourier Transform) macht, allerdings unter der

Voraussetzung, dass n eine Potenz von 2 ist.

Satz 3.9: Ist n = 2 ν , so gibt es eine Möglichkeit die DFT so durchzuführen, dass man mit

insgesamt 2 ν −1 ν Multiplikationen in R auskommt. Insbesondere bedeutet dies, dass die

Anzahl der Multiplikationen in R von der Ordnung O(n lg n) ist. Der zugehörige Algorithmus wird schnelle Fouriertransformation oder FFT genannt.

Bem. 3.10: In der Praxis wird nicht die rekursive Version der FFT verwendet, wie sie

durch den Beweis von 2.9 nahegelegt wird, sondern eine iterative Version, bei der eine

explizite Darstellung von Ω als Produkt von ν+1 Matrizen einfacher Bauart verwendet

wird, welche nacheinander auf den Ausgangsvektor angewandt werden. Leider können

wir darauf aus Zeitgründen nicht eingehen.

Eine weitere wichtige Frage bei der Anwendung der FFT auf unser Multiplikationsproblem ist die Wahl eines günstigen Rings R, wobei man natürlich ausnützen wird, dass die

Komponenten der zu transformierenden Vektoren ganze Zahlen sind. Es empfiehlt sich

daher die Wahl R = Z m , wobei m so groß gewählt wird, dass n (b − 1) 2 < m. Letzeres

deshalb, damit die beim Ausmultiplizieren von x und y entstehenden Terme

n −1

∑x

j= 0

k− j

yj , 0 ≤ k < n

31

unterhalb von m bleiben, d.h. keine Reduktion mod m und damit Verfälschung erfolgt.

Außerdem muss auch noch darauf geachtet werden, dass überhaupt eine primitive n-te

Einheitswurzel in Z m existiert. Von großem Nutzen ist daher das folgende

ν

Lemma 3.11: Sei n = 2 ν +1 und m = 2 2 + 1 für eine natürliche Zahl ν . Dann ist ω = 2

mod m eine primitive n-te Einheitswurzel in Z m .

Bem. 3.12: Wegen ω = 2 und der besonderen Gestalt von m lassen sich die

Multiplikationen in R = Z m mit den Potenzen von ω durch einfache Shift-Operationen

ausdrücken, deren Aufwand nur proportional zur Bitlänge der betrachteten Zahlen steigt.

Durch geschickte rekursive Anwendung dieser Fouriertransformation konnten Schönhage

und Strassen (1971) zeigen, dass die Multiplikation von zwei Zahlen mit je n Bit eine

asymptotische Komplexität von O( n ln n ln ln n ) hat.

Da wir in diesem Kapitel viele schnelle Algorithmen für die Multiplikationen großer

Zahlen kennengelernt haben, stellt sich die Frage, wie es diesbezüglich um die Division

steht. Wie wir im Folgenden zeigen werden, lässt sich aber die Division zweier Zahlen

auf nur einige wenige Multiplikationen zurückführen, sodass die oben angestellten

Betrachtungen dann auch für sie gelten.

Dies ergibt sich unmittelbar aus der einfachen Beobachtung, dass der Quotient u/v auch

als Produkt u ⋅ 1/v geschrieben werden kann und 1/v Nullstelle der Funktion 1/x – v ist.

Das Newtonverfahren zur iterativen Bestimmung dieser Nullstelle, nämlich

x n +1 = x n + x n (1 − vx n ) = 2x n − vx 2n