Bewegungen des menschlichen Auges: Fakten, Methoden und

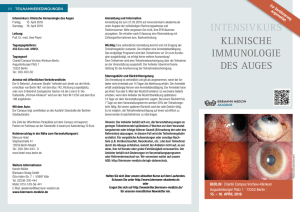

Werbung