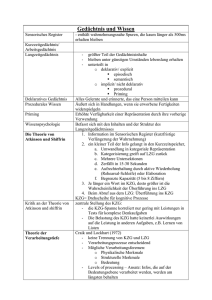

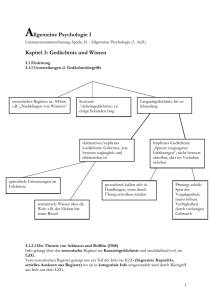

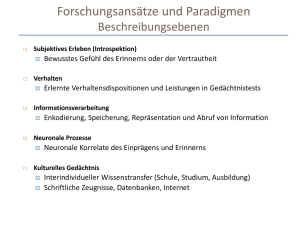

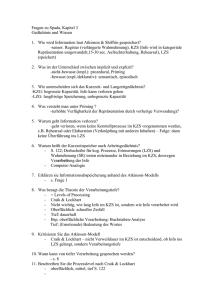

spada-kap3-gedachtnis-und

Werbung