spada-kap3-gedachtnis-und-wissen_ausfuhrlich

Werbung

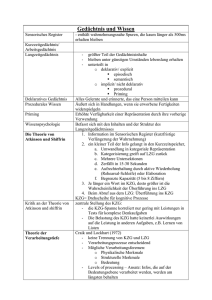

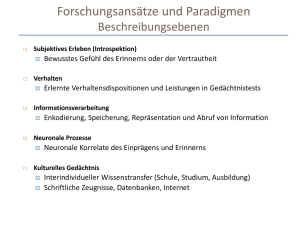

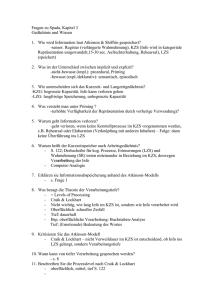

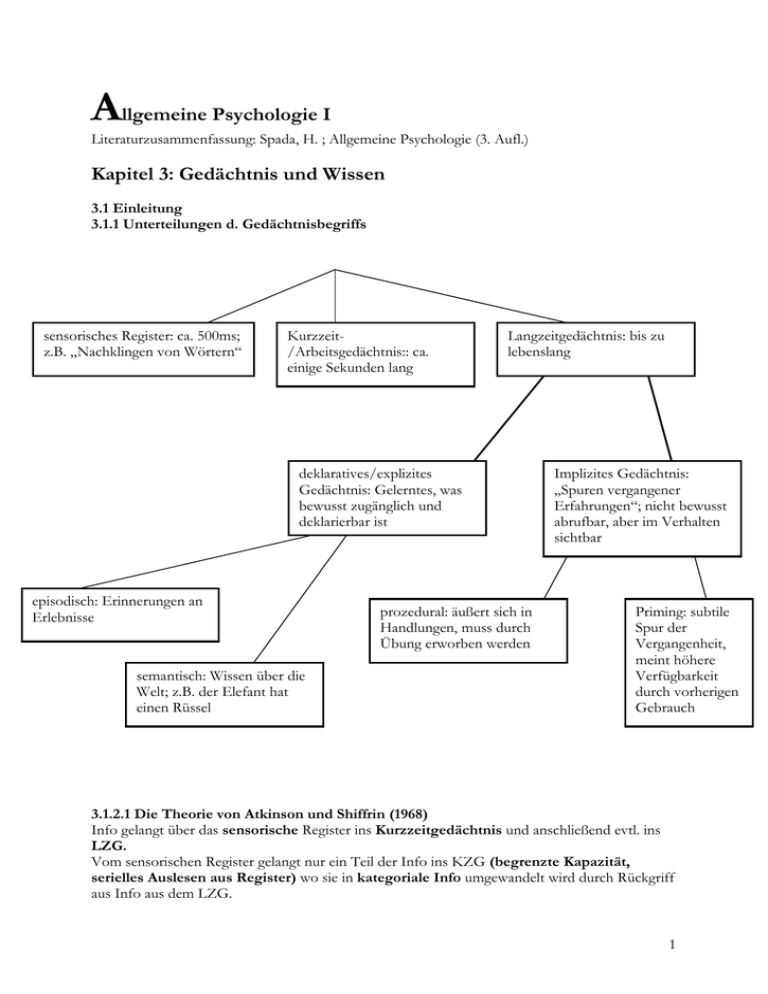

Allgemeine Psychologie I Literaturzusammenfassung: Spada, H. ; Allgemeine Psychologie (3. Aufl.) Kapitel 3: Gedächtnis und Wissen 3.1 Einleitung 3.1.1 Unterteilungen d. Gedächtnisbegriffs sensorisches Register: ca. 500ms; z.B. „Nachklingen von Wörtern“ Kurzzeit/Arbeitsgedächtnis:: ca. einige Sekunden lang Langzeitgedächtnis: bis zu lebenslang deklaratives/explizites Gedächtnis: Gelerntes, was bewusst zugänglich und deklarierbar ist episodisch: Erinnerungen an Erlebnisse semantisch: Wissen über die Welt; z.B. der Elefant hat einen Rüssel prozedural: äußert sich in Handlungen, muss durch Übung erworben werden Implizites Gedächtnis: „Spuren vergangener Erfahrungen“; nicht bewusst abrufbar, aber im Verhalten sichtbar Priming: subtile Spur der Vergangenheit, meint höhere Verfügbarkeit durch vorherigen Gebrauch 3.1.2.1 Die Theorie von Atkinson und Shiffrin (1968) Info gelangt über das sensorische Register ins Kurzzeitgedächtnis und anschließend evtl. ins LZG. Vom sensorischen Register gelangt nur ein Teil der Info ins KZG (begrenzte Kapazität, serielles Auslesen aus Register) wo sie in kategoriale Info umgewandelt wird durch Rückgriff aus Info aus dem LZG. 1 Die Info bleibt ca. 15-30s im KZS, 5-8 Elemente können jedoch durch rehearsal (aktive Wiederholung) länger behalten werden. Der Transfer ins LZG geschieht mit einer best. W’keit automatisch (je länger im KZS, desto wahrscheinlicher), wobei Elaboration (z.B. rehearsal) die W’keit noch erhöht. Im LZS kann die Info lebenslang bleiben, problematisch wird eher das „Wiederfinden“ der Info, denn sie muss ins KZS überführt werden, wenn Erinnerung stattfinden soll. 3.1.2.2 Die Theorie der Verarbeitungstiefe von Craik und Lockhart (1972) Kritik an Atkinson: Trennung von KZS und LZS Alternative: Die Verweildauer der Info im KZS ist irrelevant, die Tiefe der Verarbeitung (Aufnahme von Reizen Verarbeitung der physik. Merkmale Verarb. struktureller Merkmale Bedeutung) ist relevant für dauerhafte Repräsentationen Experimentell z.B. durch „Orientierungsaufgabe“, in der VPs zu jedem Wort verschieden tiefe Verarb. machen müssen, testbar (Theorie konnte nicht aufrecht erhalten werden) 3.2 Das Kurzzeit- oder Arbeitsgedächtnis 3.2.1 Die Unterscheidung von Kurzzeit- und Langzeitgedächtnis Untermauerung einer Unterscheidung zweier Systeme geschieht durch „Doppelte Dissoziationen“: d.h. man Einflussfaktoren identifiziert, welche nur auf das KZG wirken und andere, die nur auf das LZG wirken. Die wichtigsten stammen aus Exp. nut seriellen Positionskurven und von hirnverletzten Patienten. Kasten 3.1 Doppelte Dissoziationen und die Unterscheidung von Gedächtnissystemen Doppelte Dissoziationen: Nachweis, dass messbare Faktoren für die unterschiedlichen Systeme unabhängig voneinander variieren können. notwendig für Nachweis, dass A und B unabhängig sind - Dissoziationen bei natürlichen Variationen – interindividuelle Unterschiede: Faktorenanalyse - wenn Indikatoren für System A hoch auf einem und Indikatoren für System hoch auf einem anderen Faktor laden, ist die Unabhängigkeit bewiesen - natürliche Dissoziationen: ein Patient hat nur Ausfall in System A, ein anderer nur in SystemB - experimentelle Dissoziation: z.B. wenn Variable gefunden wird, die nur A und nicht B beeinflusst und umgekehrt, oder wenn dieselbe exp. Manipulation die Variablen a und b un entgegengesetzte Richtungen beeinflusst, oder z.B. wenn Gehirnakt. bei best. Aufgaben nur in best. Arealen gefunden werden - mehrere konvergierende Dissoziationen sind notwendig, da eine einzelne Variablen nie das ganze System beschreiben und somit immer auch mit Merkmalen verbunden sind, die nichts mit den Systemen zu tun haben, aber trotzdem die Dissoziation erzeugen können - Variablen für das gleiche System sollten miteinander assoziiert sein (nicht voneinander unabhängig) Kasten 3.2 Klassische experimentelle Paradigmen der Gedächtnisforschung - beginnt bei Ebbinghaus (1885) – ausschließlich deklaratives Gedächtnis und meistens sprachliches Material in Listen Beispiele: - Wiederkennen (recognition): Liste wird gelernt und anschließend muss entschieden werden ob präsentiertes Wort enthalten war oder nicht - Freie Wiedergabe (free recall): Nach Lernen muss möglichst viel in beliebiger Reihenfolge reproduziert werden 2 Wiedergabe in vorgegebener Reihenfolge (serial recall): Liste muss vorwärts oder rückwärts aufgesagt werden - Wiedergabe mit Hinweisreizen (cued recall): In Wiedergabephase helfen Hinweisreize ein Element einer Liste zu erinnern - Gezielte Wiedergabe (probed recall): Durch Indikator (probe) wird angezeigt, welches Wort erinnert werden soll; Spezialfall „Paarassoziations-Lernen“ - Untersuchte unabhängige Variablen anhand dieser Paradigmen: - Listenlänge, serielle Position - Behaltensintervall Variablen: Reaktionszeit, Prozentsatz richtiger Antworten Einige sind eher Kurzzeitgedächtnisaufgaben, andere eher LZG-Aufgaben ABER: Bezeichnung der Aufgaben dürfen nicht mit Gedächtnissystemen verwechselt werden (oft von beidem abhängig) - 3.2.1.1 Primacy- und Recency-Effekte in seriellen Positionskurven Serielle Positionskurve: Erinnerungsleistung für gelernte Begriffe wird über die Listenplätze der Begriffe abgetragen Primacy- und Recency-Effekte: Begriffe, die entweder am Anfang oder am Ende der Liste stehen, werden besser erinnert. Erklärungen: Primacy: kommt durch häufigeres Rehearsal zustande. (Rundus, 1971) Recency: letzte Begriffe werden oft zuerst genannt ( sind sie im Kurzzeitspeicher, während der Rest aus dem LZG abgerufen werden muss?) Empirische Dissoziationen: Man fand Faktoren, die nur für den ersten und mittleren Teil einer Liste positive Effekte haben (z.B. Darbietungsrate, Worthäufigkeit, Lernabsicht) Andere Faktoren, wie z.B. Kopfrechenaufgabe vor Wiedergabe, hatten nur negativen Effekt auf letzte Begriffe. ABER: Es gibt Recency-Effekte auch bei wochenlang unterbrochenen Listen (Rugbyspiele) hier sind die letzten Begriffe nicht mehr im KZG Lösung: Recency-Effekte kommen durch bessere Diskriminierbarkeit der jüngsten Elemente zustande (Crowder, 1982) Diskriminierbarkeit D: Intervall zwischen Elementen / Intervall zwischen Elementen und Wiedergabe Recency-Effekte sind auch ohne Unterteilung in KZG und LZG zu erklären Kasten 3.3 Verfahren zur Messung der Kurzzeit- und der Arbeitsgedächtnisspanne KZG-Spanne: - meistens anhand der seriellen Wiedergabe von Listen in Vorwärts-Reihenfolge, das Material sind meistens Ziffern - man beginnt mit kurzen Ziffern und wird dann länger - KZG - Spanne kann als die Länge der Liste, die eine Person mit 50% Wahrscheinlichkeit vollständig korrekt wiedergeben kann definiert werden - sie liegt im Mittel bei Erwachsenen zwischen 5 und 9 Ziffern (Miller) - da sich die Spanne bei Ziffern und Buchstaben kaum unterscheidet schloss Miller, dass das KZG sich eine best. Anzahl an „Chunks“ (Klumpen) merken kann - häufigste Aufgabe zur Messung der AG: Lesespanne – sie verbindet die kurzzeitige Erinnerung an Wortlisten mit der Verarbeitung von Sätzen 3 3.2.1.2 Selektive Ausfälle des Kurzzeit- und des Langzeitgedächtnisses Es gibt Hirnläsionen, die nur das langzeitige Erinnern beeinträchtigen (Patient H.M.) und andere, die nur die Kurzzeitgedächtnisspanne beeinflussen Unterscheidung von Kurz- und Langzeitgedächtnis ist sinnvoll. 3.2.2 Zugriff auf das Kurzzeitgedächtnis: Die Experimente von Sternberg Aufbau: VPs lernten kurze Listen und sollten anhand eines Testbegriffs sagen, ob er vorkam oder nicht. Modell: a) serielle Suche mit Abbruch vs. b) serielle Suche ohne Abbruch zu a): linearer Anstieg mit Listenlänge, allerdings hier bei positivem Ergebnis geringere Steigung zu b): linearer Anstieg mit Listenlänge, Verlauf unabhängig vom Befund Ergebnisse: linearer Anstieg konnte gezeigt werden, bessere Übereinstimmung mit dem „serielle Suche ohne Abbruch“ – Modell. (gibt aber auch andere Ergebnisse) Kritik: Annahme der seriellen Verarbeitung Daten sprechen eher für eine parallele Verarbeitung; bei der Sternberg-Aufgabe treten starke Recency-Effekte auf! Warum steigt die Reaktionszeit dann mit der Listenlänge an? – Nebenprodukt der seriellen Positionseffekte mehr „mittlere“ und somit schlechte Plätze bei längeren Listen langsamere Zugriffszeit 3.2.3 Vom Kurzzeit- zum Arbeitsgedächtnis: Probleme mit dem Modell von Atkinson und Shiffrin Kritik: zentrale Rolle des KZS – Verarbeitung der Info aus LZS und sensorischem Register und die Info, die in LZS gelangen soll, soll hier stattfinden. Menschen mit deutlich reduzierter KZG-Spanne kommen ebenfalls gut zurecht, Blockade des KZS durch wiederzugebende Reihen konnte Lernen nicht beeinträchtigen, nicht mal der Recency-Effekt wurde dadurch beeinflusst! Auch gibt es Befunde, dass die KZG-Spanne nur gering mit Leistungen in komplexen Denkaufgaben korreliert sind schwer zu erklären mit Atkinson-Modell neue Operationalisierung des KZG 3.2.4 Das Arbeitsgedächtnismodell von Baddeley Modifikationen am Kurzzeitgedächtnisbegriff: - Aufteilung des Arbeitsgedächtnis in 3 Komponenten: - zentrale Exekutive: für die Arbeit des Arbeitsgedächtnisses verantwortlich - phonologische Schleife, visuell-räumlicher Notizblock: „Sklavensysteme“, übernehmen kurzfristige Speicherung von Informationen Merken einer Zahlenreihe (s.o.) blockiert nicht Arbeitsgedächtnis, sondern zentrale Exekutive ist frei, da die Reihe in der phonologischen Schleife gespeichert wird 4 3.2.4.1 Die phonologische Schleife Besteht aus 2 Komponenten: phonologischer Speicher: Info kann hier für 2 Sekunden gehalten werden, und muss für weiteren Verbleib durch Artikulationsprozess aufgefrischt werden (passiv) Artikulationsprozess: Frischt Info auf – artikulatorische rehearsal-Schleife (aktiv) Evidenz: - phonologischer Ähnlichkeitseffekt: klanglich ähnliche Buchstaben/Wörter führen zu einer reduzierten Gedächtnisspanne; sogar visuelle Info wird nach Möglichkeit phonologisch enkodiert - Wortlängeneffekt: längere Wörter führen zu einer geringeren Gedächtnisspanne nicht bestimmte Anzahl („magische 7“), sondern gemerkt wird nur, was in ca. 2 Sekunden wiederholt werden kann (Dauer des Artikulationsprozesses) - Effekt der artikulatorischen Suppression: verringert die Kurzzeitgedächtnisspanne erheblich durch „blablabla“-Sagen die ganze Zeit; Wortlängeneffekt verschwindet und auch der phonologischen Ähnlichkeitseffekt bei visuellen verschwindet - irrelevante Sprache: Sprache im Hintergrund verringert die Kurzzeitgedächtnisspanne hat Sprache obligatorischen Zugang zu phonolog. Speicher?; Abschwächung des Effekts bei bei „steady state“-Ton 3.2.4.2 Der visuell räumliche Notizblock Evidenz: o Ähnlichkeitseffekt (analog zu phonolog.): Schlechtere Leistung, wenn Muster einer zu wiederholenden Serie ähnlich waren o „Raumweiteneffekt“ (analog zu Wortlänge): bislang kein Nachweis o Tapping (analog zu art. Suppr.): Tippen eines irrelevanten Musters beeinträchtig serielle Wiedergabe von Mustern o irrelevante Wahrnehmung: tritt u.a. in Abhängigkeit von der Gedächtnisaufgabe und den Stimuli ab (primär visuell vs. primär raumzeitlich) Unterscheidung zweier Komponenten? – Visuell vs. Räumlich ?? Abschließend: - relative Analogie des passiven Speicher zur phonolog. Schleife, allerdings wurde noch keine analoge aktive Komponente ausgemacht. 3.2.4.3 Die zentrale Exekutive - zuständig für die kognitive Arbeit im Arbeitsgedächtnis: - Überwachung von Denkprozessen/Handlungen, evtl. Eingriff - Routineaufgaben werden von Aktionsschemata erledigt, zentrale Exekutive greift ein, wenn etwas anderes gewünscht ist - Operationalisierung: Oft über Generieren von Zufallsfolgen, wo man eben nicht auf automatisierte Aktionsschemata zurückgreifen darf, da man sonst eher in z.B. alphabetische Folgen verfällt - weitere Aufgaben: Planung komplexerer kog. Aktivität, Koordination der „Sklavensysteme“ untereinander - Defizite: sog. „dysexekutives Syndrom“, zeigt sich z.B. in Verfall in routinierte Aktionsschemata, auch wenn diese nachweislich nicht zum Erfolg führen 5 3.2.5 Die Fraktionierung des Arbeitsgedächtnisses Unterscheidung von Subsystemen durch Nachweis doppelter Dissoziationen: - Doppelaufgabentechnik – Annahme: Interferenz innerhalb eines Subsystems ist größer als die Interferenz zwischen2 Subsystemen - Beispiele: - Nachdenken über log. Problem und Erzeugung einer zufälligen Buchstabenkombination (beides zentr. Exekutive) Leistungseinbuße - Kombination zweier sprachlicher Aufgaben, ... - Unterscheidung zwischen räumlichem und visuellem Teil des AGs konnte gezeigt werden - anderer Ansatz: korrelative Studien wenn Leistung hier hoch, dann da nicht oder doch - z.B. Belege für Unterscheidung von sprachlichem und visuell-räumlichen AG 3.2.6 Die Kapazität des Arbeitsgedächtnisses - Kapazität scheint für alle kogn. Leistungen ein wichtiger begrenzender Faktor zu sein - Verschiedene Ansätze: - AG hat begrenze Ressource, konkreter eine best. Menge an „Aktivierung“, die für verschiedene Speicherprozesse verteilt werden kann (z.B. bei der Lesespanne-Aufgabe müsste jedem Wort Aktivierung zugeschoben werden) gibt aber auch Situationen, wo „Speicheranforderung“ scheinbar nicht die Verarbeitung eines Problems beeinflusst – Unabhängigkeit voneinander ist schwer zu erklären. - Spurenzerfall (decay): Info geht verloren, wenn andere verarbeitet wird. Je länger Verarbeitung eines Satzes (bei Lesespanne), desto weniger Erinnerung anschließend an die Wörter) - Überschreibung von Repräsentationen: je ähnlicher sich Repräsentationen sind, desto eher überschreiben sie sich Erklärung für Ähnlichkeitseffekte - Aufmerksamkeit: Kapazität entspricht der Fähigkeit, Aufmerksamkeit auf etwas zu richten (nach Engle et al.) hohe Kapazität gleich hohes Steuerungsvermögen der Aufmerksamkeit. Für diesen Ansatz gibt es einige experimentelle Unterstützung Fazit: Offen bleibt, warum und wodurch die Fähigkeit zur exekutiven Kontrolle der Aufmerksamkeit begrenzt ist. 3.2.7 Die Grundlagen des Arbeitsgedächtnisses im Gehirn Lokalisierung der Aktivität ist abhängig vom Typ der Aufgabe: - sprachliches und „künstlich geometrisches“ Material eher links - kurzfristiges Speichern/Verarbeiten räumlicher Info eher rechts - exekutive Prozesse (weitere Verarbeitung notwendig): dorsolateraler präfrontaler Cortex Kapazität des AG für komplexe Denkaufgaben (?) – Bereich der generellen Intelligenz?? 3.3 Enkodierung und Abruf von Gedächtnisinhalten 3.3.1 Enkodierung neuen Wissens Nach Atkinson und Shiffrin: Wissen wird im LZS abgelegt, wenn es lange genug im KZS war. Info kann durch maintenance rehearsal im KZS gehalten werden Reicht also Durchlesen eines Textes? 6 3.3.1.1 Die Rolle semantischer Verarbeitung Modell von Atkinson konnte experimentell von Craik und Watkins in einer Kombination aus Orientierungsaufgabe und inzidenteller Lernaufgabe widerlegt werden Theorie der Verarbeitungstiefe (3.1.2.2) – konnte nicht aufrecht erhalten werden Durch TdV (s.o.) wurden jedoch 3 Fragen/Einsichten aufgeworfen: Art der Lernaktivität hat Einfluss auf Behaltensleistung; neues experimentelles Paradigma (Kombination aus Orientierungs- und inzidenteller Lernaufgabe) und „Was steckt hinter der semantischen Verarbeitung“ 3.3.1.2 Die Rolle der Lernabsicht - Orientierungsaufgabe wurde in 2 Gruppen aufgeteilt, eine Gruppe befand sich einer intentionalen, eine in einer inzidentellen Lernsituation: - nur die Orientierungsaufgabe zeigte, den schon bekannten, Effekt (Einfluss der semantischen Verarbeitung) Lernintention ist in dem Maße wirksam, als dass sie die Verarbeitungsart beeinflusst!? 3.3.1.3 Lernen durch Aufbau verständnisorientierter Repräsentationen Was passiert bei semantischer Verarbeitung? o aus semantischer Verarbeitung entsteht eine Repräsentation: hierfür ist semantische Elaboration erforderlich (Erstellen von Beziehungen zwischen Wörtern) o Zahl der Beziehungen bestimmt die Reproduktionsleistung je mehr Beziehungen desto höher ist das Verständnis des Satzes Lernleistung ist Nebenprodukt von Verstehensleistung 3.3.1.4 Der Aufbau verständnisorientierter Repräsentationen erfordert Zugriff auf semantisches Langzeitwissen Semantische Elaboration bringt Infos ins LZG, beruht aber auch auf semantischem Wissen im LZG semant. Wissen ist notwendig, um sinnvolle Verknüpfungen zu erstellen hierfür gibt es neurophysiologische Bestätigung (bildgebende Verfahren) Zugriff auf semantisches Langzeitwissen ist entscheidende Komponente beim Lernen Probleme: - falsche Erinnerungen durch verständnisorientierte Repräsentationen Einbau verwandter, jedoch nicht genannter Wörter Quelle der Info (Stimulus oder Vorwissen) wird hierbei verschleiert Gedächtnisillusionen 3.3.1.5 Der Aufbau verständnisorientierter Repräsentationen braucht Aufmerksamkeit Beispiel: Lesen wenn man müde ist keine Ahnung, was man gelesen hat Semantische Elaboration passiert nicht einfach so - Doppelaufgabe: auditiv dargebotene Wörter sollten gelernt werden, gleichzeitig musste eine visuelle Reaktionszeitaufgabe bewältigt werden Abnahme der Lernleistung Aufmerksamkeit ist notwendig, um Infos in LZG zu überführen - neuronaler Indikator semantischer Elaboration (präfrontal) wurde nur noch reduziert gemessen Elaboration geschieht nicht automatisch, sondern muss durch aufmerksamkeitsintensive Prozesse initiiert/aufrecht erhalten werden - über längere Zeit ist dies sowohl subjektiv als auch objektiv anstrengend Einrichtung „harter“ Arbeitszeiten, unterbrochen von Pausen, lohnt sich!!! 7 Kasten 3.4 Assoziative und relationale Repräsentationen: - Assoziative Repräsentationen haben keine Verknüpfungen mit anderen Merkmalen --> nur einfache Stimulus-Reaktions-Handlungen sind möglich (implizit) - relationale Repräsentationen: sind mit anderen Merkmalen verknüpft – sie haben Relationen (räumlich, zeitlich, ...) zu anderen Merkmalen, erlauben „relative“ Einordnung z.B. eines Ortes zu seiner Umgebung --> sind notwendig für flexible spätere Nutzung von Wissen 3.3.1.6 Verteilte Repräsentationen müssen zu Gedächtnisspuren zusammengebunden werden - elaborative Prozesse sind keine hinreichende Bedingung für Ablegen von Gedächtnisspuren (z.B. bei amnestischen Patienten mit Schädigungen am Hippokampus) Was ist die Aufgabe des Hippokampus? Hypothesen: - zunächst wird mittels aufmerksamkeitsintensiver Prozesse im frontalen Cortex und mit Hilfe gespeicherter Wortbedeutungen eine verständnisorientierte Repräsentation aufgebaut: bei einer Vorlesung z.B. vom Inhalt – es werden allerdings auch in anderen kortikalen Regionen andere Aspekte des Kontextes repräsentiert Hippokampus könnte die verschiedenen Informationen verknüpfen Speziellerer Ansatz: - Hippokampus als Ort relationaler Repräsentationen, die für flexible episodische Erinnerungen grundlegend sind - Funktion: Bruchstücke einer Gesamtrepräsentation führen zur Aktivierung der integrierten Repräsentation im Hippokampus, diese wiederum reaktiviert die Gesamtrepräsentation im kortikalen Netzwerk (sozusagen ein Bibliotheksindex im Hippokampus) - „Gedächtnisspuren“ im Hippokampus erfahren zeitl. Konsolidierung; diese Konsolidierung wird durch emotionale Aktivierung verstärtkt! Hippokampus als Integrierer und Modulierer (Verstärkung bei emotionalen Ereignissen) 3.3.1.7 Enkodierung ohne Beteiligung des HK: Implizites Lernen Bislang wurde nur der Gedächtnisteil des deklarativen/expliziten Wissens behandelt: notwendige Bedingung: Hippokampus (wahrscheinlich) Lernen funktioniert jedoch auch ohne Hippokampus: „Barbara“-Beispiel: Lernen, das nicht/wenig auf integrierten, flexiblen Repräsentationen aus verschiedenen Cortexbereichen beruht, könnte auch ohne HK möglich sein. Paradigma der „seriellen Reaktionsaufgabe“: VPs drücken, ohne ihr Wissen, bestimmte Sequenzen und werden langsamer in der Reaktion, wenn die Sequenz durchbrochen wird; VPs können sich jedoch nicht immer bewusst an die Sequenzen erinnern impliziter Lerneffekt Lernen, dass nicht zu bewusstseinfähigen Repräsentationen führt, aber Handlung dennoch beeinflusst assoziative Repräsentation Vorteil: Hippokampus ist nicht notwendig; verschiedene assoziative Repräsent. können gleichzeitig existieren keine zentrale Instanz für alle (wie HK) Nachteil: assoziative Repräsentationen sind nicht flexibel (Sequenz kann z.B. nicht rückwärts aufgesagt werden) Amnestische Patienten: - (relativ) normales Leben, was prozedurale/implizite Gedächtnisleistungen angeht (wo explizite Repräsentation nicht nötig/möglich ist) Trainingsprogramme 8 ABER: Implizites Lernen ist gradueller Natur dauert relativ lange (im Gegensatz zu „HKLernen“) 3.3.2 Die Beziehung zwischen Enkodierung und Zugriff auf Gedächtnisinhalte Eher eine künstliche Trennung; z.B. impliziert semantische Elaboration (3.3.1.3) bereits auch den Zugriff auf semantisches Langzeitwissen. Die Erklärung für dieses Phänomen wird allerdings erst deutlich, wenn man sich die Interaktion von Enkodierung und Zugriffsprozessen ansieht 3.3.2.1 Enkodierspezifität und „Transfer Appropriate Processing“ Warum ist in vielen Fällen semantische Elaboration während der Enkodierung entscheidend für eine gute Lernleistung? Exp. Von Morris et al.: VPs lasen Wörter und mussten entweder eine phonemische (z.B. reimt sich das Wort mit „Schäfer“) oder eine semantische Orientierungsaufgabe (z.B. ist es ein Insekt?) bearbeiten. Anschließend wurde in 2 Bed. die Erinnerungsleistung abgefragt in einer Bedingung sollte sie einfach entscheiden, ob ein gezeigtes Wort zuvor in der Lernliste war üblicher Verarbeitungstiefeneffekt zeigte sich in der anderen Bedingung sollten Wörter, die sich mit den Testwörtern reimen identifiziert werden hier wurde der Effekt umgekehrt: in der semantischen Bedingung wurden 33%, in der phonemischen Bed. 49% richtig identifiziert Interaktion zwischen Enkodierbedingung und Testbedingung ist dominierender Effekt: „Passung“ zwischen kognitiven Prozessen in der Enkodier- und der Zugriffsphase scheint entscheidender Faktor zu sein Wie lässt sich das erklären? - Zugriffssignal (retrieval cue): Repräsentation im Fokus der Aufmerksamkeit, die eine Art „Anfrage“ an das LZG darstellt; z.B. „Käfer“ führt zum Zugriff auf semantisches Wissen über Käfer (Insekt, ...). Dies und das Stimuluswort sind zusammen das Zugriffssignal Kritisch für Erinnerungsleistung ist die Ähnlichkeit der bei der Enkodierung und beim Zugriff beteiligten Repräsentationen Effekt der „Passung“ ist einer der generellsten Effekte der Gedächtnisforschung; es wird auch „Enkodierspezifität“ oder „transfer appropriate processing“ genannt Befunde zur Passung: - bezieht sich nicht nur auf Repräsentation des zu lernenden Materials, sondern auf alle Gegebenheiten in räumlich-zeitlichem Kontakt zum gelernten Inhalt Kontext (externe Umgebung, interne Zustände) state dependent learning - Exp. Von Baddeley: Erinnerungsleistung von unter Wasser oder am Strand gelernten Wörtern zeigt in jeweils “fremdem” Kontext deutlich Effekte des Kontexts, obwohl er völlig irrelevant war Kontextuelle Aspekte werden bei Enkodierung und Zugriff automatisch in aufgebaute Repräsentationen eingebaut wurde auch z.B. bei Marihuana gefunden: allgemein eher negativ, aber wenn, dann sollte es sowohl bei Enkodierung als auch bei Zugriff vorher geraucht werden Randbedingungen: - Passungseffekt ist allgemein größer, wenn gelernte Wörter frei reproduziert werden sollen, bei z.B. Hinweisreizen in der Testphase verschwindet der Effekt Kontext geht vor allem in Zugriffsrepräsentation ein, wenn sie selbstbestimmt aufgebaut werden muss 9 zeigt sich auch bei „Stimmung“: Stimmungsgleichheit zwischen Lern- und Testphase ist nur entscheidend, wenn Wörter in Enkodierphase selbständig auf einen Hinweisreiz hin generiert werden sollten; der Effekt verschwindet, wenn in Enkodierphase die Wörter einfach vorgelesen wurden Kontextfaktoren haben stärkeres Gewicht in krit. Repräsentationen, wenn externe Vorgaben keine Rolle spielen 3.3.2.2 Enkodierspezifität und Inhaltsadressierbarkeit Was bedeutet der „Passungseffekt für die Funktionsweise des Gedächtnis? - Beim Computer: jeder Speicher hat eindeutige Adresse, die allerdings völlig unabhängig von der gespeicherten Information ist; beim Absturz geht Zuordnung von Adresse und Information verloren Info wird verloren - beim Menschen: keine willkürlichen Adressen, sondern „Inhaltsadressierbarkeit“: Inhalt einer Gedächtnisspur ist selbst die Adresse - oft sind allerdings nur Bruchstücke der Gedächtnisspur in der Inhaltsadresse (sonst würde man die „Spuren“ quasi nicht mehr brauchen) Es gilt: Je ähnlicher Adresse/Zugriffssignal und Gedächtnisspur, desto wahrscheinlicher wird die komplette Spur aktiviert (Prinzip der Enkodierspezifität) Wie funktioniert so ein inhaltsadressierbares Gedächtnis? – weiß keiner, aber einige Computersimulationen können das Prinzip gut darstellen (3.4.2.2) Kurzfassung: - Repräsentation einer Erinnerung ist über Kortex verteilt - die Komponenten werden, vermutlich über den HK, miteinander assoziiert - eine Komponente (besser mehrere) kann nun als „Adresse“ für die anderen Komponenten dienen, je mehr Komponenten als Zugriffshinweise gegeben, desto besser 3.3.2.3 Warum semantische Elaboration beim Gedächtniszugriff hilft Wie ist dieser Befund mit dem Prinzip der „Enkodierspezifität“ vereinbar? - in den meisten Situationen wird Sprache verwendet um Bedeutung zu vermitteln VPs denken vor allem über gelernte Bedeutungen nach „semantische“ Zugriffhinweise werden erstellt in „normaler“ Zugriffsituation bei der Verwendung sprachlichen Materials gilt der Befund, da semantische Elab. eine gute Passung zu üblicherweise kreierten Zugriffhinweisen hat (natürlich gibt es Ausnahmen) Warum ist Anzahl der kreierten semantischen Verknüpfungen wichtig? - Prinzip der Passung: bei vielen Verknüpfungen ist die Wahrscheinlichkeit in der Testphase ein passendes Zugriffssignal zu erzeugen höher Fazit zu kritischen Faktoren der Enkodierung: - Passung zwischen Repräsentationen bei der Enkodierung und beim Zugriff - interne Zustände in beiden Phasen sollten ähnlich sein - viele generierte Zustände bei der Enkodierung führen zu höherer Erinnerungswahrscheinlichkeit - weiterer Faktor: Distinktheit von Gedächtnisspuren kommt noch 3.3.3 Missglückter Zugriff als Ursache des „Vergessens“ Ein rein „zeitlicher“ Effekt auf das Gedächtnis, der zum Vergessen führt, kann nicht nachgewiesen werden, da sich immer mehrere Faktoren neben der Zeit mitverändern. Zwei der anderen Faktoren/Ereignisse werden hier hervorgehoben 10 3.3.3.1 Vergessen durch zeitabhängige Veränderung der Enkodierspezifität - interner und externer Kontext verändern sich über die Zeit - z.B. ist es nach einer Woche wahrscheinlicher als nach einem Tag, dass man eine andere Stimmung hat - „Vergessen“ liegt hier also daran, dass der Zugriffshinweis nicht mehr hinreichend ähnlich zur abgelegten Gedächtnisspur ist Gedächtnisspur geht also nicht verloren, sie wird nur weniger gut auffindbar 3.3.3.2 Vergessen durch Interferenz Hier ist die „Ähnlichkeit“ von Gedächtnisspuren das entscheidende Kriterium - Vorteil: wenn man auf keine bestimmte Spur zugreifen muss (Was ist Hauptstadt der USA?) - Nachteil: wenn man bestimmte Spur braucht (Wie wars das erste Mal in Washington?) Quellenkonfusion: Einzelheiten verschiedener Besuche werden vermischt, da der Zugriffshinweis auf mehrere Spuren gut passt Solche Effekte der Konkurrenz von Gedächtnisspuren nennt man Interferenz Anmerkung: Diese Annahme gilt für ein Gedächtnissystem, das Spuren unabhängig voneinander bewahrt (Exemplartheorie), es gibt allerdings auch die Auffassung, dass ähnliche Einträge sich vermischen und dann trotz gutem Zugriffssignal nicht mehr unterscheidbar sind 3.3.3.3 Retroaktive und proaktive Interferenz - retroaktiv: spätere Gedächtnisspuren erschweren das Auffinden einer früheren Spur nimmt mit der Zeit zu - proaktiv: frühere Gedächtnisspuren erschweren das Auffinden späterer Spuren (sehr ähnlich) nimmt nicht direkt mit der Zeit zu, da das Kritische bereits vor der Abspeicherung vorhanden ist/war. proaktive Interferenz ist wichtig bei Messung der Kapazität des Kurzzeit/Arbeitsgedächtnisses: - wenn nacheinander mehrere Listen von Wörtern erinnert werden sollen, dann könnten die Durchgänge durch proaktive Interferenz verzerrt werden und somit nicht mehr unabhängig voneinander sein Kane & Engle fanden Zusammenhang zwischen gemessener Arbeitsgedächtniskapazität und der Anfälligkeit für proaktive Interferenz 3.3.3.4 Interferenz und Generalisierung - Interferenz ist logische Begleiterscheinung eines inhaltsadressierbaren Gedächtnis - Interferenz ist aber auch Voraussetzung für die Fähigkeit zur Generalisierung (z.B. Wo ist in einer fremde Stadt die Post – Erinnerung an eine andere Stadt wird ausgelöst proaktive Interferenz - also kann Interferenz auch etwas positives bewirken – durch „Intrusion“ eines früheren Ereignisses kann evtl. erfolgreich generalisiert werden. Sind wir der Interferenz hilflos ausgeliefert? 3.3.3.5 Interferenz und die Enkodierung distinkter Gedächtnisspuren Beispiel: Jemand sucht abends sein Auto immer zuerst an dem Platz vom Vortag. Das Problem konnte er lösen, indem er nach dem Parken an spezifische Aufgaben des Tages dachte und diese abends auf dem Weg zum Parkplatz noch mal rekapitulierte. Warum funktioniert das? - das Problem besteht in der Ähnlichkeit der Episoden Interferenz - Wenn die Episode mit besonderer Info angereichert wird, erhöht sich die Distinktheit der Spur Reduzierung der Interferenzgefahr 11 Erinnerung an bizarre/besondere Situationseigenschaften erhöht die Erinnerungsleistung Distinktheit ist neben der Enkodierspezifität ein zweites generelles Problem; beide sind potentiell voneinander unabhängig 3.3.3.6 Interferenz und Inhibition während des Gedächtniszugriffs - Konkurrenz von Gedächtnisspuren wird besonders deutlich bei schwachen Spuren, die mit stärkeren in Verbindung stehen - dennoch gelingt oft nach einiger Zeit die Erinnerung Postulat: Es gibt inhibitorischen Mechanismus, der die Repräsentation konkurrierender, starker Spuren unterdrückt und somit die Erinnerung an schwache Spuren erleichtert - Phänomen des zugriffsbedingten Vergessens: Zugriff auf Infos, die mit einem best. Zugriffssignal assoziiert ist, erschwert den Zugriff auf andere Infos, die mit demselben Signal assoziiert sind schwächere Info wird bei Zugriff von stärkerer unterdrückt - Existenz und Aufbau eines inhibitorischen Mechanismus sind noch unpräzise und umstritten 3.3.4 Wiedererkennen Hier stellt sich die Frage, ob man sich immer aktiv über einen Zugriffsprozess erinnern muss, oder ob Gedächtnisspuren auch anders zum Vorschein kommen können; z.B. in einem „unbestimmbaren Gefühl der Vertrautheit“ 3.3.4.1 Das Gefühl der Vertrautheit Wiedergabetests: Beruhen auf Gedächtnisspuren, die sowohl die Informationen als auch den Kontext (z.B. Liste) enthalten. Hätte man keine Repräsentation des Lehrkontexts (Liste) würde man nicht wissen, welche Wörter wiederzugeben wären. Wiedererkennenstest: Hier muss entschieden werden, ob ein Wort in der Liste enthalten war oder nicht. Dies kann entweder mittels bewusster Erinnerung geschehen, oder durch ein Gefühl der „Vertrautheit“ (familiarity) empirisch zeigen sich deutlich „besserer“ Ergebnisse in Wiedererkennenstests im Gegensatz zu Wiedergabetests: Wiedergabe testet das „pure Maß des Gedächtnisses für die Verknüpfung eines Inhalts mit dem Kontext“, Wiedererkennenstests testen sowohl dies, als ein „Gefühl“ der Vertrautheit. - Reproduktion hängt also stark von der Enkodierungsaktivität ab, während dies bei Wiedererkennenstests weniger der Fall ist Wiedererkennen beruht zum Teil auf Repräsentationen, die keine Verbindung zum Kontext haben Was ist die neurokognitive Grundlage solcher Repräsentationen? 3.3.4.2 Implizite Gedächtniseffekte - Priming: unbewusste Gedächtniseinflüsse, z.B. wenn Wortliste gelernt wurde und anschließend Wortfragmente gezeigt werden, die u.a. zu Wörter aus der Wortliste passen, dann werden diese häufiger genannt als andere (auch wenn kein Zusammenhang zwischen den beiden Aufgaben erkennbar ist) Gedächtniseinflüsse, die sich nur durch indirekte Tests messen lassen, nennt man auch implizites Gedächtnis - Priming-Effekte reagieren sensitiv auf Veränderungen des perzeptuellen Formats: z.B. bei Schriftänderung zwischen Lernen und Test oder wenn die Wörter nur gehört werden verschwinden sie Priming-Effekte sind abhängig von einer Übereinstimmung der perzeptuellen Ebene der Verarbeitung in Übungs- und Testphase (explizites Gedächtnis ist weniger abhängig davon) 12 Neurologische Befunde: - z.B. Lesen eines Wortes sollte theoretisch zu Veränderungen in kortikalen Regionen, die beim Lesen involviert sind führen - bei geprimten Wörtern zeigtsich bei wiederholtem Lesen des Wortes, dass in den verarbeitenden Kortexregionen weniger Aktivität vorhanden ist. Dies geht einher mit der Theorie, denn man geht davon aus, dass die beteiligten Repräsentationen bereits vorbereitet sind und daher weniger „neuronale“ Arbeit nötig ist - Priming funktioniert auch ohne durch HK in einheitliche Spur integriert zu werden - implizite Gedächtniseinflüsse sind auch bei amnestischen Patienten zu finden kein Einfluss des HK 3.3.4.3 Implizites Gedächtnis und das Gefühl der Vertrautheit Handelt es sich bei impliziten Gedächtniseffekten und beim „Gefühl der Vertrautheit“ um das gleiche Phänomen? - implizite Gedächtnisspuren erleichtern beispielsweise das Lesen eines Wortes ein wenig erhöhte Verarbeitungsflüssigkeit (fluency) Wird diese erhöhte Verarbeitungsflüssigkeit wahrgenommen? - Exp. Von Whittlesea et al: VPs sahen zunächst kurz eine Liste von 7 Wörtern, anschließend wurden Wörter gezeigt und es sollte entschieden werden, ob sie aus der Liste stammen oder nicht. Zusätzlich wurde die Sichtbarkeit der dargestellten Wörter manipuliert. - wenn Verarbeitungsflüssigkeit wahrgenommen wird, dann sollte VPs bei schlecht sichtbaren Wörtern eher angeben, es sei alt und umgekehrt Konnte bestätigt werden Durch stimulusbedingte Erhöhung der Verarbeitungsflüssigkeit kann Illusion ein Wort bereits zu kennen entstehen Der Effekt zeigt sich auch umgekehrt: erhöhte Verarbeitungsflüssigkeit führt auch zur Illusion der besseren Wahrnehmbarkeit Fazit: - Verarbeitungsflüssigkeit kann wahrgenommen werden - allerdings liegt hier ein unspezifisches Signal vor, das entweder auf Lernprozess oder auf perzeptuelle Gegebenheiten zurückgeführt wird - implizites Gedächtnis lässt sic als Ansammlung hochspezifischer Fertigkeiten verstehen wichtige Rolle im Alltag - Wahrnehmung der Verarbeitungsflüssigkeit stellt auch Infos zum Ausmaß des Wissens auf einem Gebiet dar - kann aber auch wegen seiner Unspezifität in die Irre führen (3.3.5.4) 3.3.5 Besseres Gedächtnis durch Gedächtnisforschung? Was hält die Forschung für Personen bereit, die sich in Lehr- oder Lernsituationen befinden? 3.3.5.1 Verstehen = Lernen - Lernen in pädagogischen Kontexten kann nicht vom Verstehen entkoppelt werden (3.3.1.1) verstandene Zusammenhänge werden unabhängig von der Lehrsituation wahrscheinlich erinnert (3.3.1.2) - Elaborative Prozesse, welche zum Verständnis führen, sind abhängig von der Aufmerksamkeit Lernsituation schaffen, wo Aufmerksamkeit fokussiert und Ablenkung vermieden wird (3.3.1.5) - je mehr Verstehensleistung geleistet wird, desto besser ist die Lernleistung (Verarbeitungstiefeparadigma) Lernmaterial sollte den Verstehensprozess nicht zu stark vereinfachen 13 Befunde: - strukturell mit einem Text kongruente Zusammenfassungen führen zu besserer Leistung bei textnaher Abfrage, aber zu schlechterer Leistung bei Transferaufgaben; bei inkongruenten Zusammenfassungen zeigte sich das Gegenteil - Erklärung: Herstellung der Kongruenz erfordert umfassende Elaboration, welche wiederum eine flexiblere Nutzung des Wissens vorbereitet 3.3.5.2 Techniken zur Verbesserung des Gedächtnisses Mnemotechniken - Grundprinzip besteht zumeist darin, neues Material nach erlerntem Enkodierschema zu bearbeiten - z.B. „Methode der Orte“: Bestimmter Weg durch bekannte Räumlichkeit als Enkodierschema (z.B. auf der Fußmatte liegt ne BANANE, auf dem Gartenpfad läuft ein PFERD, ...) - Objekte werden möglichst in interaktiver und distinkter Weise mit Orten verbunden führt auch im Alter noch zu beachtlichen Erfolgen Wirkweise: - bedeutungsvolle/bizarre Beziehungen werden hergestellt - erlerntes Enkodierschema/Abrufstruktur erlaubt Material in beliebiger Sequenz wiederzugeben Nutzen: - vor allem bei Informationen, die wenig Struktur beinhalten in pädagogischen Kontexten weniger nützlich beim Lernen konzeptueller Zusammenhänge kann dies wegen der willkürlichen Strukturierung sogar abträglich sein 3.3.5.3 Tests als Lerngelegenheiten Lernen für eine Prüfung: Text kann immer wieder gelesen und semantisch verarbeitet werde oder an eine Verarbeitungsphase schließt eine Bearbeitung möglicher Prüfungsfragen an --> zweite Variante in Exp. erfolgreicher in Prüfungssituation – umso mehr, desto mehr aktiver Zugriff auf gelerntes Wissen in „Testprüfung“ nötig war Erklärung: - Nachdenken im Kontext von Fragen führt zu Verknüpfungen zwischen Material und pot. Fragen --> Fragen werden zu Zugriffssignalen --> Prinzip der Enkodierspezifität 3.3.5.4 Verteilung von Übung und der trügerische Effekt des Gefühls der Bekanntheit Verteilung: Gemeint ist Verteilung von Lerndurchgängen über die Zeit Verteilungseffekte (spacing): Lange Pausen zwischen Lerndurchgänge führen zu deutlich besseren Lernleistungen – über Altersklassen und Materialien stabiler Effekt Erklärung: Argumentation über Gefühl der Vertrautheit: - in 2 schnell aufeinander folgenden Lerndurchgängen sollte Gefühl der Vertrautheit (durch Primingeffekte) relativ groß sein - dies führt im zweiten Durchgang zum Gefühl des „schon wissens“ --> geringere aktive Beschäftigung mit dem Material, im Gegensatz zu langer Pause zwischen Lernvorgängen Bestätigung: - Effekt der Verteilung verringert sich, wenn in beiden Durchgängen unterschiedliche Oberflächenmerkmale genommen werden (siehe implizites Lernen, siehe Primingeffekte) - Funktion des Gefühls der Vertrautheit: 14 grobes Signal für Wissen über Stimulus evtl. als Mechanismus eines Metagedächtnis, der Aufmerksamkeit „sinnvoll“ verteilen hilft - untermauert durch Exp., in denen nachgewiesen wurde, dass man von Verarbeitungsflüssigkeit auf Qualität der Gedächtnisleistung schließt Neurologische Befunde: - kortikale Aktivierung in relevanten Regionen geringer bei 2 schnell aufeinander folgenden Durchgängen --> semantische Verarbeitung wird durch dichtes „spacing“ reduziert --> bei Richtigkeit der Erklärung würde dies bedeuten, dass Gefühl d. Vertrautheit lernabträgliche Effekte haben kann --> Entgegenwirken durch lange Pausen --> Argument für „Testprüfungen“, weil hier Wissen besser eingeschätzt werden kann - 3.4 Die Repräsentation von Wissen – Formate und Inhalte Grundannahme: Inhalte des Geistes (u.a. Gedächtnisinhalte) sind als mentale Repräsentationen vorhanden Zwei verschiedene Formate: - propositionale Repräsentationen: Angelehnt an Sprache; evtl. immer zunächst (evtl. auch ausschließlich) vorhanden bei Lesen/Hören - analoge Repräsentationen: an bildlichen Darstellungen orientiert; wahrnehmungsnah Kasten 3.5 Analoge und propositionale Repräsentationen - beide Arten sind relational – unterscheiden sich in der Art der Relationen und der in Beziehung gesetzten Elemente Propositionale Repräsentationen: - die Einheiten sind Symbole die nach einer mentalen Syntax zu Propositionen verknüpft werden - Proposition: Aussage mit Wahrheitswert (wahr oder falsch) - sie können als Strukturen aus einem Prädikat und mehreren Argumenten geschrieben werden - Prädikat wird in Sprache oft durch das Verb ausgedrückt, die übrigen Komponenten sind die Argumente - Beispiel: Der Blitz verursachte einen Waldbrand --> CAUS(Blitz, Waldbrand, Vergangenheit) – CAUS entspricht dem Prädikat, zwei obligatorische Argumente folgen (Ursache, Folge) und ein optionales (Zeit) wird zugeordnet - Propositionen können auch als Grafen/Diagramme dargestellt werden - Propositionen können auch verknüpft werden, indem die eine als Argument in die andere eingeht (z.B. in DENKEN --> Peter denkt, dass der Blitz... - oder es können 2 Prädikate das gleiche Argument verwenden (z.B. IST-EIN (Blitz, elektr. Ladung) --> Ein Blitz ist eine elektrische Ladung) - sinnvolles Format insbesondere für Computer Analoge Repräsentationen: - hier entspricht jedes Element einer Repräsentation einem Objekt/Ereignis des repräsentierten Gegenstands - Relationen zwischen den Elemente entsprechen den Relationen zwischen den repräsentieren Objekten/Ereignissen 15 --> ein Element kann hier, im Gegensatz zu einem Symbol, nicht für eine Menge von Objekten stehen (3 Äpfel müssen durch durch 3 Elemente einer Repräsentation dargestellt werden, bei Propositionen genügen 2 Symbole, nämlich „3“ und „Apfel“) --> Element einer analogen Repr. kann nicht für eine Klasse/für einen Begriff stehen - hier sind Relationen zwischen den Elementen von selbst vorhanden – bei propositionalen müssen Relationen als eigene Elemente dargestellt werden --> analoge Repr. erlauben neue Relationen, ohne dass ein expliziter Folgerungsschritt vorangehen muss (Kreis rechts vom Quadrat rechts vom Dreieck als ein Schritt) 3.4.1 Propositionale und analoge Repräsentationen (beide relational) Gibt es analoge Repräsentationen? Nachweise: - Kosslyn et al. 1978: Vps sollten sich einfache Karte einer Insel merken und sie sich anschließend vorstellen vor dem innere Auge: dann sollten sie von einem vorgegebenen Punkt aus zu einem anderen und angeben, wann sie den Zielpunkt vorm innere Auge hätten --> dauerte umso länger, je weiter die beiden Punkte voneinander entfernt waren --> Erhalt der metrischen Information als Hinweis auf analoge Repräsentationen - auch Experimente zur mentalen Rotation (siehe auch Anderson) werden als Nachweis für den Erhalt metrischer Info und somit für analoge Repräsentationen herangezogen - auch neurologisch zeigen sich bestätigende Befunde: bei der visuellen Vorstellung sind ähnliche Hirnareale wie bei der visuellen Wahrnehmung aktiviert ABER: Kritiker negieren, dass Wahrnehmungen auf analogen Repräsentationen beruhen „Lösung“: - beide „Seiten“ nehmen unterschiedliche Formate von Repräsentationen an, wobei die eigentlich neuronal sind (und nicht bildlich oder so) - wichtig ist, dass unterschiedliche Information vorliegt, die unterschiedliche Verarbeitungsoperationen erlauben: eine Proposition kann nicht rotiert werden, und eine Negation kann z.B. nicht auf analoge Repräsentationen angewandt werden. 3.4.2 Konnektionistische Modelle des Gedächtnisses 3.4.2.1 Grundprinzipien konnektionistischer Modelle - Netzwerke aus stark vereinfachten Nervenzellen (units) und deren Verbindungen (connections) - Organisation in Schichten (Input-Schicht, Zwischenschicht, ...Output-Schicht) - Info-Aufnahme durch Aktivierung einiger Neuronen der Input-Schicht --> Weiterleitung zur Zwischenschicht --> zur Output-Schicht - jedes Neuron einer Schicht ist mit allen Neuronen der Zwischenschicht entweder excitatorisch oder inhibitorisch verbunden, allerdings unterschiedlich stark (teilweise auch Neuronen einer Schicht, oder von Schichten immer in beide Richtungen (lateral)) - unterschiedliche Aktivitätsmuster werden durch unterschiedliche Verbindungsstärken erzeugt - Info-Verarbeitung = Transformation der Aktivitätsmuster über die Schichten - Kontext ist wichtig, damit zwischen verschiedenen Assoziationen eines Inputs adäquat reagiert werden kann Wie wird hier Gedächtnisinhalt repräsentiert? - es gibt lokale und verteilte Repräsentationen lokal: - eindeutige Zuordnung zwischen Neuronen und zu repräsentierenden Einheiten --> z.B. Neuron = Buchstabe 16 verteilt: - z.B. Wörter, diese entsprechen einem Muster von Aktivierungen - Repräsentationen in einer Zwischenschicht: Aktivierungsmuster in Zwischenschichten spiegeln oft Regelhaftigkeiten im Lernmaterial wider --> best. Muster repräsentieren irgendwann also best. abstrakte Regularitäten (oft nicht vorhersehbar) --> hier sind Repräsentation nur noch als Muster von Aktivierung und einzelne Neuronen gar nicht mehr zu interpretieren. 3.4.2.2 Lernen in konnektionistischen Netzen Wissen ist hier in den Verbindungsstärken (auch: „Gewichte“) enthalten; Lernen besteht in der Anpassung der Gewichte 2 Arten von Lernen: 1) Lernen ohne Rückmeldung (unsupervised learning) 2) Lernen mit Rückmeldung (error-driven learning) zu1) - - beruht auf Hebb’schem Lernen: wenn 2 Neuronen gleichzeitg aktiv sind, wird die Verbindung verstärkt, wenn nur eins alleine aktiv ist, wird die Verbindung abgeschwächt assoziatives Lernen pendant im Gehirn: long-term potentiation (LTP) Lernen von Aktivierungsmustern: Input aktiviert Teilmenge der Neuronen, dadruch werden Verbindungen dazwischen verstärkt bei späterem unvollständigem Input entsteht zunächst unvollständiges Aktivierungsmuster mittels gelernter Verbindungsgewichte wird der Rest des Musters auch noch aktiviert zu2) Zwei Phasen: o zuerst bekommt Netz Input und generiert Output auf Basis vorhandener „Gewichte“ o dann erhält das Netz den gewünschten Output als Rückmeldung An jedem Neuron der Output-Schicht wird nun die Differenz zwischen selbst generiertem und erwünschtem Output berechnet Fehlersignal wird von jedem Empfängerneuron an seine Sendeneuronen rückgemeldet (Fehlerrückmeldung) Anpassung der Fehlerrückmeldung Änderung nach sog. „Delta-Regel“: Änderung= Lernrate*(Akt. Empfänger – Zielaktiv.)*Aktvierung d. Senderneurons Anwendung: - ohne Rückmeldung: Erinnerung an Ereignisse anhand unvollständigem Input (siehe inhaltsadressierbares Gedächtnis) Lernerfahrung erzeugt Aktivierungsmuster Repräsentation d. Gedächtnisinhaltes aktivierbar durch unvollst. Input oder Kontext (beim Wiedererkennen) - mit Rückmeldung: besonders geeignet für „Paarlernen“ und für Erwerb prozeduralen Wissens oder z.B. Lernen des Aussprache von englischen Wörtern 3.4.2.3 Generalisierung und Konzeptbildung Verteilte Repräsentationen sind für den Erwerb von Wissen unverzichtbar, denn sie haben zur Folge, dass ähnliche Inputs sich überlappen - ähnliche Inputs nutzen großteils gleiche Neuronen und Verbindungsgewichte - beim Lernen ähnlicher Inputs werden großteils gleiche Gewichte modifiziert Gelerntes wird auf andere Inputs generalisiert: der neue I2, der dem I1 ähnelt, aktiviert beinahe die gleichen Neuronen Input wird durch von I1 gelernten Gewichten weitergeleitet I2 wird in ähnliches Muster wie I1 überführt I2 ändert aber an einigen Punkten auch die Gewichte Annäherung beider Muster 17 über viele Inputs gemittelt ergibt sich ein generelles Muster, indem die „individuellen“ Abweichungen rausgemittelt werden Eintopf generalisierte Repräsentation Konzept wird repräsentiert ABER: einzelne Episoden gehen verloren (Details etc.) , wenn da nicht der Hippokampus wäre... Kasten 3.6 Das Hippokampus-Kortex-Modell des Gedächtnisses - Generalisierung ist nur mit verteilten Repräsentationen möglich im Vergleich mit der Realität würden hierdurch zu schnell Erinnerungen an Details verloren gehen (katastrophale Interferenz) - Erinnerungen an einzelne Episoden wären mit lokalen Repräsentationen besser realisierbar – ABER: dann wäre Übertragung auf ähnliche Inputs nicht mehr möglich - Arbeitsteilung im Gehirn (vermutlich): Kortex repräsentiert Ereignisse hochgradig überlappend, der Hippokampus separiert die Ereignisse relativ stark – auch nicht vollständig lokal sparsam verteilte Repräsentationen (weniger aktivierte Neuronen pro Schicht) Reduzierung der katastrophalen Interferenz 3.5 Episodisches Gedächtnis: Erinnerung an Erlebnisse Episodisches Gedächtnis: Erinnerung an erlebte Ereignisse, die zu einem best. Zeitpunkt stattgefunden haben Semantisches Gedächtnis: Wissen über die Welt unabhängig vom eigenen Erleben Autonoetisches Bewusstsein (nach Tulving, 1972): - episodisches Gedächtnis hat spezielle Beziehung zur erinnernden Person autonoetisches Bewusstsein - Erinnerung ist verbunden mit Bewusstsein, Subjekt der Erinnerung zu sein - wichtiges Unterscheidungskrit. für Abgrenzung von semantischem Wissen, dass es etwas (evtl. mit einem selbst) stattgefunden hat - erzeugt Gefühl d. Authentizität und Gewissheit (nicht bei semant. Wissen) – kann aber auch täuschen Neurologische Befunde: - autonoetisches Bewusstsein wird frontalem Kortex zugeordnet (Wheeler, 1997): beim Erwerb episodischer Infos ist links die Aktivität größer (siehe 3.3.1.4) und beim Versuch der Erinnerung ist rechts erhöhte Aktivität messbar (retrieval mode) - meiste Gedächtnisforschung versteht unter episodischem Gedächtnis die Erinnerung an ein best. Wort in einer Liste zu einem best. Zeitpunkt ABER: Wort aus Liste ist nicht besonders „unvergessliches Ereignis“ autobiografisches Gedächtnis als neuer Gegenstand der Gedächtnispsychologie (seit ca. 20 J.) 3.5.1 Autobiografisches Gedächtnis Uneinigkeit über Definition des autobiografischen Gedächtnis: z.T. da das „Selbst“ im autobiografischen Gedächtnis als Subjekt und auch als Gegenstand vorkommen kann. Arbeitsdefinition (nach Brewer 1986): Autobiografische Erinnerungen können sich auf spezifische Episoden beziehen oder auf generelle Klassen von Ereignissen im eigenen Leben (z.B. Mathematikstunde, aber keine bestimmte), und sie können als lebhafte, vorstellbare Erinnerung oder als abstraktes Wissen vorliegen ( autobiografisches Gedächtnis setzt sich aus episodischem und semantischem Wissen zusammen) 18 3.5.1.1 Der Zahn der Zeit – Vergessenskurven für das autobiografische Gedächtnis - Gedächtnisgenauigkeit wurde experimentell fast immer anhand von Wortlisten und deren Vergessen über kurze Zeiträume gemessen Vergessenskurven, nach denen die Erinnerungsgenauigkeit erst steil und dann immer flacher abfällt - autobiografisches Gedächtnis: ähnliche Kurven, jedoch flacher - Erhebung: retrospektive Befragungen und Tagebuchstudien Retrospektive Befragungen: - Vps bekommen Wörter, die Assoziationen auslösen o ungewöhnliche Vergessenskurve: Häufigkeit von Erinnerungen nimmt ab mit größerer Distanz zur Gegenwart, ABER: Häufung bei Alter von 20-30; keine Erinnerungen zum Alter 0-2 - Erklärung (Rubin, 1986): 3 Komponenten - normales Vergessen wie aus Laborstudien - häufige „Reminiszenzen“ an „beste Jahre“ – oft wiederholt Stärkung - infantile Amnesie: keine Erinnerungen an erste Lebensjahre - Probleme: Prüfung der Richtigkeit von Erinnerungen ist unmöglich Tagebuchstudien: - Beispiel: Wagenaar (1986) - 6 Jahre schrieb er täglich sein bemerkenswertestes Ereignis auf und dazu 5 Infos (Wo, wann, was, ...) und schätzte die Intensität ein gleiche Vergessenskurve über die Jahre zeigte sich (allmählich abflachend) ABER: unterschiedliche Effizienz der Hinweisreize: das „was“ war hilfreicher als z.B. das Datum - Erlebnisse mit hoher emotionaler Beteiligung führten zu besseren Erinnerungen, genauso wie Außergewöhnliches; angenehmes wurde besser als unangenehmes erinnert; unangenehmes in den letzten 2 Jahren wurde schlecht erinnert; Unangenehmes, was länger als 2 Jahre her war, wurde besser erinnert als Neutrales 3.5.1.2 Die Struktur des autobiografischen Gedächtnisses - autobiografisches Erinnerungen beziehen sich meist auf Ereignisse, welche in sinnvollem Zusammenhang stehen (Ursachen, Folgen, Teilereignisse, ...) oft ähnliche Struktur wie Geschichten einige nehmen „narrative“ Organisation an - ABER: Lebenserinnerungen erlauben zwischen z.B zwischen allgemeinen und detaillierten Beschreibungen zu wechseln eine Art „Hypertext“ und keine lineare Erzählung - autobiograf. Erinnerungen sind in Wissenstrukturen eingebettet die u.a Schemata, Skripts, Themen, Pläne,... genannt werden Infos über Kategorien v. Handlungen/Ereignissen und spezifische Fälle - Beispiel: Restaurant-Skript (Schank & Abelson): typische Abfolge von Handlungen, die alle in Teilhandlungen unterteilbar sind, Variationsmöglichkeiten sind eingebaut (zu Fuß/im Auto hin), Variablen sind eingebaut („Restaurantnationalität“, ...) - bei best. Restaurantbesuch: „Instantiierung“ des allg. Schemas im Gedächtnis Variablenwerte werden belegt Erinnerung = allg. Struktur + spez. Details episodisches und semantisches Gedächtnis sind eng verknüpft - Schemata: Wissensstrukturen, die z.B. Ereignisse, Handlungen, Objekte in Beziehung setzen - 2 Arten von Beziehungen: partonomisch (zeitlich, kausale und funktionale Beziehungen Hierarchie) und taxonomisch (zwischen allg. und spezifischen Schemata; z.B Zahnarzt Arzt Dienstleister, ...) 19 3.5.2 Die Zuverlässigkeit episodischer Erinnerungen Wie sehr kann man sich auf sein Gedächtnis verlassen? 3.5.2.1 Erinnerung als Rekonstruktion Schemata strukturieren Erinnerungen, aber sie können sie auch gestalten - anhand von Schemata werden oft Gedächtnislücken überbrückt automatische Ergänzung im Sinne des Schemas systematische Verzerrung der Erinnerung - z.B. werden in Experimenten, wenn man entscheiden soll, ob ein Satz in einer Geschichte vorkam oder nicht, oft skriptkonforme Handlungen zugefügt; auch die Reihenfolge von Ereignissen wird oft skriptkonform verzerrt (analog z.B. bei räumlichen Anordnungen) gleiches Problem wie bei der konnektionistischen Modellierung: Wissen wird zu generellen Schemata zusammengefasst, dadurch werden Details angepasst und nicht mehr explizit erinnert 3.5.2.2 Manipulation der Erinnerung: Die Beeinflussung von Augenzeugen Praktische Anwendung: Wie zuverlässig sind z.B. Zeugenaussagen? - wenn Erinnerung Rekonstruktion ist, sollte sie durch nachträglich gegebene Infos beeinflussbar sein - Exp. von Loftus & Palmer (1974): Variation in der Formulierung einer Frage beeinflusste die Zeugenaussage (Wie schnell fuhr das Auto, als es kontaktierte/anstieß/zusammenkrachte/...) - verzerrende Wirkung von Fehlinformation ist ein Fall retroaktiver Interferenz „Überschreiben“ der tatsächlichen Erinnerung - alternativ: beide Fassungen sind vorhanden, werden aber verwechselt Konzept d. Quellengedächtnisses (source memory) kann Einfluss von Fehlinformation auf episodisches Gedächtnis erklären: - Erinnerung daran, woher eine Repräsentation stammt (aus erster Hand erlebt, aus Zeitung, Vorstellung, etc.) - erlebte Episoden unterscheiden sich von vorgestellten durch einige Kriterien Entscheidung, ob sie echt ist oder nicht - Kriterien: viele sensorische Details (Farben, Gerüche, ...), räumlicher/zeitlicher Kontext, Kohärenz, Kompatibilität mit anderem Wissen - Fehlinformation möglich, wenn diese Kriterien verloren gehen und die falsche Erinnerung die Merkmale „gewinnt“ - z.B. sensorische Details gehen leicht verloren beim Erleben vieler ähnlicher Ereignisse allgemeine, schematische Erinnerung Schemata fungieren als Infoquellen „interne“ Verzerrung möglich auch eine Form der „Quellenverwechslung“ - Faktoren, die W’keit falscher Erinnerung erhöhen: suggestive Fragen, „Ja oder Nein“ – Fragen (insb. bei Kindern), Suggestibilität allgemein bei jüngeren höher als bei älteren Menschen; - Aufforderung zu Erinnerung an Ereignis, an welches man sich nicht spontan erinnert, kann ebenfalls falsche Erinnerung erzeugen lebhafte Vorstellung führt zu Anreicherung mit sensorischen Details bessere Erfüllung d. Krit. für „echte“ Erinnerung (Konzept d. Quellengedächtnis) - mehrmaliges Fragen hat ebenfalls Effekt - „gute“ Technik: „Kognitives Interview“ – Minimierung der verzerrenden Faktoren, Beachtung genereller Gedächtnisprinzipien (Enkodierspezifität „Zurückkehren“ an Tatort (mental); unterschiedliche Reihenfolgen des Geschehens erzählen Generierung verschiedener Zugriffssignale (cues) 20 3.5.2.3 Erinnerungen an traumatische Erlebnisse: Verdrängt und wiedergefunden? Können Erinnerungen an traumatische Ereignisse lange komplett verdrängt und nach Jahren dann wieder „ausgegraben“ werden? Kann man Erinnerungen durch Suggestion im Rahmen einer Therapie „erzeugen“? - Exp. zeigen, dass durch Suggestion Erinnerungen an Ereignisse erzeugt werden können, die nie stattgefunden haben - Loftus & Pickrell (1995): Vorgabe von 4 Ereignissen aus Kindheit, wovon eine falsch eins falsch war – 25% konnten auch zu falschem Ereignis detaillierte Infos geben; insgesamt waren die „echten“ jedoch „klarer“ und wurden ausführlicher beschrieben ABER: einige wussten nachher nicht, welches das falsche war! durch Suggestion ist Erinnerung erzeugbar (sogar teilweise an schwere Verbrechen möglich) Gibt auch Belege, dass traumatische Erlebnisse vergessen werden (Unfallopfer häufig) Ist aktive Verdrängung möglich? - zentraler Bestandteil der Freud’schen Theorie - Gedächtnisforschung: Anderson & Green forderten VPs auf sich bei einigen Wortpaaren in einer Übungsphase auf keinen Fall an das andere Wort auszusprechen – sie sollten alles tun, damit das Wort nicht ins Bewusstsein kam Erinnerung war nachher niedriger als an andere Pärchen im Labor scheint aktive Verdrängung also möglich zu sein – gilt das aber auch für persönlich Bedeutsames/Traumatisches??? 3.6 Semantisches Gedächtnis – Wissen über die Welt Semantisches Gedächtnis umfasst generelles Wissen – von persönlichen Erfahrungen abstrahiert: - geht zwar u.a. auch auf Erlebnisse zurück – ist aber nicht zu merken (z.B. Elefant hat Rüssel) - generelles Wissen besteht aus Begriffen und deren Beziehungen 3.6.1 Begriffe Begriffe/Konzepte: mentale Repräsentationen von Kategorien Kategorien: Klassen von Gegenständen die in irgendeiner Art gleichartig sind Begriffe: - Bausteine des Wissens - reduzieren Reize auf geringeres Maß und erlauben es Gelerntes auf neue Erfahrungen anzuwenden - Einordnung in Begriff --> mehrere Schlüsse über Objekt gehen einher (z.B. Kuh -> lebendig, Hufe, Gras, Milch...) Wie werden Begriffe repräsentiert – wie werden sie angewandt? - „ordentlich definierter“ Begriff: zeichnet sich durch begrenzte Menge definierender Eigenschaften aus als Regel für Zugehörigkeiten (ja oder nein) --> einige Begriffe können so sein - die meisten Begriffe haben jedoch unscharfe Ränder --> keine befriedigende kurze Def. möglich - alles was über einen Begriff gesagt werden kann, trägt auch zur Bedeutung bei --> Begriffe sind Bausteine, werden aber selbst auch durch Wissen geformt (z.B. hilft jeder neue Text, den Begriff „Psychologie“ zu verstehen) 21 3.6.1.1 Prototypen - unscharfe Begriffsgrenzen sind Ausdruck einer abgestuften Typikalität von Gegenstände für Begriffe (Amsel ist typischerer Vogel als Emu – VPs erkennen erstes schneller an als zweites) - weiteres Beispiel: „2“ ist typischere gerade Zahl als „324“ - Typikalität hängt von der Nähe des Gegenstands vom Mittelwert aller zugehörigen Gegenstände ab, die unter den Begriff fallen - teilweise ist auch Nähe zu „Ideal“ wichtig: z.B. ist 0-Kalorien Nahrung typischer für Diätnahrung als 50-Kalorien Nahrung, obwohl 0 nicht nah am Mittelwert liegt) - Exp. von Posner und Keele (1968): Vps sollten Punktmuster in 2 Klassen sortieren, wobei sie jeweils aus Verschiebungen von Punkten ausgehend von einem von zwei Prototypen bestanden, sie bekamen zunächst immer Rückmeldung – in einer Testphase sollten sie weitere Muster klassifizieren --> umso bessere Klassifizierung, je näher sie an den (vorher nicht gezeigten) Prototypen waren (am besten beim Prototypen selbst) --> für Prototypen selbst blieb der Effekt lange stabil - Erklärung: aus einer Menge von Exemplaren wird allmählich Prototyp gebildet --> Repräsentation als Prototyp --> Zuordnung anderer Gegenstände erfolgt über Ähnlichkeit ABER: Annahme, dass Begriffe durch Prototypen repräsentiert ist nicht unproblematisch: - Typikalitätsurteile sind flexibel und kontextabhängig: VPs die vorher Bauernhofgeschichte lasen sagen andere Tiere als Vps, die vorher Safarigeschichte gelesen haben 3.6.1.2 Begriffe als Mengen von Exemplaren Barsalou (1987): - Begriffe haben keine feste Repräsentation, sondern werden „ad hoc“ konstruiert – abhängig von Kontext - auch bei Exemplartheorien (3.3.5.2): nur Spuren von Exemplaren sind im Gehirn – kein semantisches Gedächtnis vorhanden (Exemplare gehören zum episodischen Gedächtnis) - Begriff: beobachtbare Fähigkeit von Menschen, gleichartige Gegenstände gleich zu behandeln - Exemplartheoretische Erklärung von Kategorisierung: - Gegenstand wird mit Repräsentationen ähnlicher Exemplare verglichen --> ähnlichkeitsabhängige Aktivierung der Repräsentationen --> „Echo“ (alle zusammen) - „Echo“ ist gewichtetes Mittel aller aktivierten Repräsentationen --> „ad hoc“-Prototyp - durch Mittelung geht Spezifisches verloren (siehe konnektionistische Modelle), wobei hier die Spezifität erst beim Abruf verloren geht - Exemplarmodelle haben nicht Problem der „katastrophalen Interferenz“, ABER: keine Erklärung für die unzähligen Exemplare ohne zu interferieren realisiert werden 3.6.1.3 Begriffe und Theorien – das Problem mit der Ähnlichkeit Bislang war „Ähnlichkeit“ das Konstrukt, was grundlegend für Begriffe war ABER: Welche Merkmale wählt unser kognitives System für die Ähnlichkeitsbestimmung aus? - z.B. haben Pflaumen und Rasenmäher viele gleiche Merkmale: sie wiegen weniger als 1000 kg, sie verbrennen, wenn man sie anzündet, sie können nicht sprechen, wenn sie runterfallen gehen sie kaputt (aus 200m), ... - Beschränkung auf perzeptuelle Merkmale: Trifft oft zu, aber z.B. fällt der „Delphin“ unter den Säugetierbegriff, obwohl er wie ein Fisch aussieht und nicht gerade wie ein prototyp. Säuger 22 relevante Merkmale hängen von theoretischem Wissen über Gegenstände ab - z.B. Lampe wird jeder Gegenstand genannt, der hergestellt wurde um Licht zu machen -> kausales Wissen bestimmt „Ähnlichkeit“ - Murphy & Medin (1985): Begriffbildung wird analog zu wissenschaftl. Theoriebildung verstanden (Bezug zur „Theorie-Theorie“): Menschen haben subjektive Theorien, Wissen bildet kohärentes und konsistentes Netzwerk über Annahmen zu Gesetzmäßigkeiten der Welt Grundlage zur Auswahl relevanter Merkmale kausale Rolle ist wichtig (z.B. bei Tieren/Pflanzen: Herkunft, genet. Bauplan) - Verallgemeinerung von Wissen auf andere Gegenstände möglich - Begriffe sind umso nützlicher, desto mehr Annahmen über Gesetzmäßigkeiten für die zugeordneten Gegenstände gültig sind Theory View Wissen ist „top down“ aufgebaut (ausgehend von theoret. Annahmen – Begriffe sind Bausteine, aber Gebäude und Bausteine entwickeln sich Hand in Hand. 3.6.2 Semantische Netzwerke Wie sehen nun die Wissensstrukturen aus, durch die Begriffe miteinander verknüpft werden? „Alter“ Ansatz: Semantisches Netzwerk - Begriffe bilden „Knoten“, Verbindungen zwischen „Knoten“ werden „Kanten“ genannt (S.185) - „Rückgrat“ bilden die Beziehungen zwischen Ober- und Unterbegriffen (nach Collins & Quilian, 1969) - Beispiel: Knoten „Hai“ wird mit Oberbegriff „Fisch“ verbunden; Merkmale werden auf der höchstmöglichen Ebene des Netzwerks an Begriffe angehängt („atmet“ wird an Tier angehängt, damit ist es für alle Tiere „abrufbar“), Unterbegriffe „erben“ Merkmale ökonomische Repräsentation im Netzwerk - exp. Überprüfung: Vps können z.B. „Kanarienvogel atmet“ langsamer als wahr klassifizieren als „Kanarienvogel fliegt“ je mehr Kanten zwischen den Knoten, desto langsamer - Probleme: falsche Sätze werden schneller zurückgewiesen, wenn verbundene Konzepte im Netzwerk weit voneinander entfernt sind (z.B. Auto ist ein Vogel schneller als Fledermaus ist Vogel), als wenn sie nah aneinander sind. - auch Typikalität kann nicht erklärt werden, z.B. wird „Amsel ist Vogel“ wird schneller akzeptiert als „Emu ist Vogel“ obwohl jeweils nur eine Kante im hierarchischen Modell dazwischenliegt Lockerung der hierarchischen Annahmen als Lösung? Collins & Loftus (1975): - Merkmale können sowohl mit Ober- als auch mit Unterbegriffen verknüpft werden - Kanten können verschieden stark sein sehr flexibles Modell, dass mit allem vereinbar ist Verlust der empirischen Prüfbarkeit Heute: - spezifische Annahmen des semantischen Netzwerks weitegehend verworfen, Modell aber noch aktuell - Annahme der Aktivierungsausbreitung ist aktuell: jeder Knoten hat jederzeit best. Aktivierungsgrad je größer, desto wahrscheinlicher ist die Möglichkeit des Abrufs aus LZG - Aktivierung wird über Kanten weitergeleitet (je stärker die Kante, desto mehr) - Phänomen des semantischen Primings - stützt Idee der Aktivierungsausbreitung: VP liest Wörter, über die möglichst schnell irgendwelche Entscheidungen getroffen werden müssen. Priming meint, dass 23 Reaktionszeit bei Verarbeitung verkürzt wird, wenn zuvor assoziiertes Wort bearbeitet wurde (z.B. erst Brot und dann Butter) Aktivierung hat sich über „Brot-Knoten“ ausgebreitet Voraktivierung von „Butter“ schnelleres Erreichen der notwendigen Aktivierung für „Butter“ - ähnelt konnektionistischem Modell: Unterschied ist, das in semant. Netzwerken die Aktivierungsausbreitung nur ein Teil der Info-Verarbeitung ist - anderer Teil ist „Prozessor“, der Infos im Netzwerk „liest“ beurteilt, ob Aktivierung vom einen Knoten zum anderen wandert, welcher Art die Kanten sind (z.B. „ist“; „hat“) 3.6.3 Mentale Modelle und subjektive Theorien Wie kann falsches Wissen zugunsten einer angemessenen Repräsentation überwunden werden? - falsches Wissen liegt nicht in gelegentlich falschen Verknüpfungen in semant. Netzwerken vor (z.B. ein Tier ist ein Auto) - es ist systematisch besteht aus kohärenten Annahmen (die sich evtl. gegenseitig stützen) Wissen ist ähnlich wie wissenschaftliche Theorien organisiert Wissen kann als subjektive Theorie/mentales Modell betrachtet werden - Beispielstudie (Kempton, 1985): bei Menschen konnten die „Rückkopplungs-Theorie“ und die „Ventil-Theorie“ für die Funktionsweise von Thermostaten identifiziert werden - unterschiedliches „Heizverhalten“ wird dadurch induziert - viele hatten auch Mischung aus beiden Theorien Menschen nutzen teilweise sich widersprechende Theorien zum selben Gegenstand Wissenspartitionierung (wird auch z.T. bei Experten gefunden) 3.7 Ausblick - fällt aus wegen Schnee und Glatteis 24