gewicht

Werbung

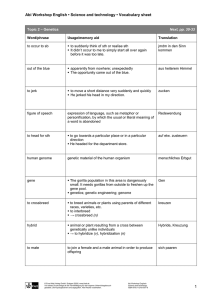

Nagl, Einführung in die Statistik Seite 119 4.4 Kreuztabellendarstellung zweidimensionaler Verteilungen In diesem Abschnitt wird für beide Merkmale (x und y) mindest nominales Skalenniveau vorausgesetzt. Die Anzahl der Merkmalsausprägungen soll überschaubar klein sein. Vorerst wird die Stichprobenbeschreibung vorgestellt, die anschließend auf die Populationsbeschreibung ausgedehnt wird Das x-Merkmal hat I Ausprägungen: x1, x2, ... ,xI, das y-Merkmal hat J Ausprägungen: y1, y2, ... , yJ. Die Kreuztabelle ‚kreuzt‘ x und y: Die Zelle ij betrifft UEen, die in x den Wert xi und in y den Wert xj haben: x=xi y=yj , bzw. (x=xi, y=yj) Beispiel: Zweidimensionale Häufigkeitsverteilung der Merkmale Ausbildung des Vaters und der Mutter. Volks-S. höhere S. Abi u.m. VaterAusbildung In den Zellen können verschiedene Arten von Maßzahlen dargestellt werden. Ausbildung der Mutter Volkshöhere Abi u. schule Schule mehr 5 0 0 3 2 0 0 3 2 8 x-Merkmal Häufigkeitskreuztabelle: in den Zellen stehen die Häufigkeiten: nij (Anzahl der UEen, die im xMerkmal die i. und in y die j. Ausprägung haben). y-Merkmal 1 2 j J y1 y2 ... yj ... yJ 1 x1 n11 n12 ... n1j ... n1J n1 2 x2 n21 n22 ... n2j ... n2J n2 . ... ... ... ... ... ... ... i xi ni1 ni2 ... nij ... niJ ni . ... ... ... ... ... ... ... I xI nI1 nI2 ... nIj ... nIJ nI n1 n2 nj nJ n Die Randhäufigkeiten für x ist jeweils die Summe der Häufigkeiten über die y-Ausprägungen: n i : j1 n ij . Der über Summieren ‚eliminierte J I n n : j i n ij i n i j n j J I I J Kreuztabelle der gemeinsamen Anteile pij : x-Merkmal D.h. Jede Häufigkeit wird durch n dividiert. y-Merkmal 1 2 j J y1 y2 ... yj ... yJ 1 x1 p11 p12 ... p1j ... p1J 2 x2 p21 p22 ... p2j ... p2J . ... ... ... ... ... ... ... i xi pi1 pi2 ... pij ... piJ . ... ... ... ... ... ... ... I xI pI1 pI2 ... pIj ... pIJ p1 p2 pj pJ n ij n . jüngere Geschw. Gleichheit-Freiheit-Präferenz G vor F egal F vor G nein 1 5 2 ja 4 0 2 5 5 4 Beispiel: Zusammenhang zwischen Jüngere Geschwister haben und Familienstand. Familienstand Mögliche Aussage: ledig nicht ledig ‚Jüngere Gejüngere schwister zu nein 8 1 9 Geschw. haben‘ führt ja 3 4 7 zu früherer 11 5 16 Bindung. 1.0 0.8 0.4 0.2 VS hS Abi 0 p1 p2 Angst vor Prüfungen ja nein 4 0 4 Vater- Volks-S. Ausbil- höhere S. 2 1 3 dung Abi u.m. 1 2 3 7 1.0 0.5 0 1.0 0.5 0 1.0 0.5 0 ja nein ja nein 7/10 3/10 1.0 0.2 1 VS 0.6 0.4 10 Das Stabdiagramm oben zeigt die Verteilungen für das y-Merkmal für jede Ausprägung von x. ja Entsprechend können auch alle Randhäufigkeiten durch n dividiert werden; dadurch entstehen die Randanteile für x (pi) und die Randanteile für y (pj). Ihre Summe ist jeweils = 1. 3 Angst vor P. ja nein VS. 4/10 0/10 4/10 hS. 2/10 1/10 3/10 Abi+ 1/10 2/10 3/10 1.0 Gesamt 0.5 0 0.8 pI 1 8 6 14 Formulieren Sie eine Aussage zu dieser Tabelle 0.6 pi 15 Beispiel: Zusammenhang zwischen Jüngere Geschwister haben und Gleichheit-Freiheit-Präferenz Mögliche Aussage: Höhere Ausbildung des Vaters senkt die Angst vor Prüfungen kann als Summe n dargestellt werden: 2 Aussage: ‚Bei Ehepaaren sind Männer besser ausgebildet als deren Frauen‘ Index‘ wird durch einen Punkt ersetzt. Entsprechend bei den Randhäufigkeiten für y: die Beispiel: Vaterausbildung und Angst vor Prüfungen Summe der Häufigkeiten über die x-Ausprägungen: n j : i 1 n ij . Auch die Stichprobengröße selbst 5 5 5 5 An den Rändern werden auch die Randverteilungen gezeigt. ja nein hS ja nein Abi 0 0 0.2 0.4 0.6 ja Gesamt 0 0.2 0.4 0.8 1.0 nein 0.6 0.8 1.0 Im Staffeldiagramm unten wird die Verteilung durch die Stapeldarstellung erreicht. Nagl, Einführung in die Statistik Seite 120 Bedingte Anteile erleichtern x-Bedingte Anteile Vergleiche zwischen für y: Gruppen. p ij = p XY i j p i j : p i. gemeinsame r Anteil Zeilenrand anteil Die Anteile werden für jede Gruppe berechnet, sodaß sie sich in jeder Gruppe auf 1 (100%) summieren. Pro Zeile gilt: p i1 ... p i J 1 Bei den zwei Merkmalen gibt es zwei verschiedene Arten der Bedingungen, die ‘Zeilen’-Bedingung (xBedingt) oder die ‘Spalten’Bedingung (y-Bedingt) y-Bedingte Anteile für x: p ij p iXYj : p i j : p.j p XY i j p i j ist der Anteil für y=yj, gegeben x=xi ja 0.8 VS 0.6 Angst vor P. ja nein VS. 1.00 0 0.40 hS. 0.67 0.33 0.30 Abi+ 0.33 0.67 0.30 0.4 0.2 ja nein hS ja Abi nein 0 0 0.2 0.4 0.6 ja Gesamt 0.70 0.30 1 z.B. 0.67 = (2/10)/ (3/10). 0 0.2 0.4 0.8 1.0 nein 0.6 0.8 1.0 Diese ‚Normierung‘ auf 100% pro Zeile erleichtert Vergleiche zwischen verschiedenen Ausbildungsstufen Spaltenbedingte Anteile: Angst vor P. ja nein VS. 4/7 0 0.40 hS. 2/7 1/3 0.30 Abi+ 1/7 2/3 0.30 Pro Spalte gilt: p1j ... p I j 1 Sprechweise für x-Bedingte Anteile: Anteil für eine yAusprägung, gegeben eine bestimmte x-Ausprägung (oder eine andere Bedingungsformulierungen) 1.0 Die x-Bedingten Zeilenanteile ergänzen sich auf 1 (100%). 0.70 0.30 1 Eine Spalte wird als Gruppe betrachtet (hier z.B. diejenigen, die Angst haben). Für diese Gruppe können ebenfalls die Anteile berechnet werden. Sie besagen dann, aus welchen Vaterausbildungsgruppen die ‚Angstvollen‘ ‚stammen‘. z.B. 2/7 = (2/10)/ (7/10). Der bedingte Anteil 0.67 bei den zeilenbedingten Anteilen in der zweiten Zeile ist daher der Ja-Anteil für Angst, gegeben der Vater hat höhere Schulbildung. Bzw. Von den Vätern mit höherer Schulbildung haben 67% der Söhne Angst vor Prüfungen. Demgegenüber die Formulierung für die gemeinsamen Anteile: 20% der UE haben sowohl einen Vater mit höherer Schulausbildung als auch Angst vor Prüfungen. Andere Schreibweise der p XY i j p i j wird auch bedingten Anteile: Die Bedingung wird hinter den ‘Al- so geschrieben: p( y=yj | x=xi ) ternativentrenner: |’ gesetzt Übersicht für die Berechnung der Anteile (gemeinsame, Rand- und bedingte). x-Bedingte Anteile für y y1 . yj . yJ Die Randanteile sind als Summe NUR der gemeinsamen Anteile zu berechnen! p ij p i p ij x1 . xi . xI Gemeinsame Anteile y1 . yj . yJ p11 . p1j . p1J p1 . . . . . pi1 . pij . piJ pi . . . . . pI1 . pIj . pIJ pI p1 pj pJ 1 Gem. Anteile für Angst und Ausbildung ja nein VS. 0.4 0 0.4 hS. 0.2 0.1 0.3 Abi+ 0.1 0.2 0.3 0.7 0.3 1 Summe in solchem Rundeck ist =1 p ij : p ij p i x1 p11 . xi . p i1 . xI . pI1 . . . . . p 1j . p ij . p Ij . p1J . . . piJ . . . pIJ p1 pi pI Ausbildungsbedingte Angstanteile ja nein VS. 1.00 0 0.40 hS. 0.67 0.33 0.30 Abi+ 0.33 0.67 0.30 y-Bedingte Anteile für x y1 . yj . yJ pi j p ij p j p i j p ij pj x1 . xi . xI p11 . p i1 . pI1 p1 . . . . . p1j . pIj . p1J . . . p iJ . . . p IJ pj pJ . pij Angstbedingte Ausbildungs-Anteile ja nein VS. 4/7 0 hS. 2/7 1/3 Abi+ 1/7 2/3 0.70 0.30 Nagl, Einführung in die Statistik Seite 121 Graphische Darstellung Die meisten eindimensionalen Diagramme können auf den vorliegenden Fall erweitert werden: Stab-, Staffel-, Kreis- und Netzdiagramme. Hier soll das strukturierte Staffeldiagramm (neuerdings auch Mosaic-Plot genannt (z.B. JMP)) vorgestellt werden, da es erlaubt, alle Arten von Anteilen in einem einzigen Diagramm darzustellen. Beim Strukturierten Staffeldiagramm (in horizonAusbildungsbedingte taler Form). Angstanteile Ausgehend von der Tabelle mit den zei-lenbedingten Anteilen werden die Zeilen-Randanteile pi (links im Diagramm) als Stapel aufgetragen. Die Pfeile zeigen einige der notwendigen Einträge: ja 1.00 0.67 0.33 0.70 VS. hS. Abi+ nein 0 0.33 0.67 0.30 0.40 0.30 0.30 1.0 Für jede Zeilen-Bedingung (xi) werden danach die 0.8 bedingten Anteile p i j sukzessiv eingetragen (in der VS. hS. Abi+ Höhe der Randanteilstrennstriche); d.h. eine Staffel wird nach rechts hin gebildet in der Höhe des RandAnteils. VS ja 0.6 0.4 0.2 hS ja Abi ja nein nein 0 Anschließend kann (unten im Diagramm) noch der yRandanteil als Staffel gezeichnet werden. Auf Grund der Konstruktion ist klar, daß die bedingten Anteile für jede Bedingung durch die Breite dargestellt wird. Da die Höhe jeder Staffel den Randanteil wiedergibt, stellen die Flächen jeweils die gemeinsamen Anteile dar, wegen: p ij p i p ij 0.40 0.30 0.30 0 0.2 0.4 ja 0.6 0.8 1.0 nein 0 0.2 0.4 0.6 0.8 Gesamt 0.70 ja 1.0 0.30 nein Die oberste Fläche im Diagramm ist gleich 0.40 (=0.40*1.0), die zweitoberste Ja-Fläche im Diagramm ist gleich 0.20 (=0.30*(2/3)), usw. Die Gesamtfläche ist gleich 1. Das entspricht der Summe über die gemeinsamen Anteile Populationsbeschreibung und Formulieren von Wahrscheinlichkeiten für Zufallsexperimente. Für die Beschreibung der Gesamtheit werden die ‚p’s durch ‚‘s ersetzt. Auch in der Population sind die ‚‘s Anteile, die die Zusammensetzung der ‚Urne‘ beschreiben. Alle übrigen Darstellungsarten können für die Population gleich behandelt werden. Beim Zufallsexperiment des Ziehens einer Einheit aus der Gesamtheit interessiert die Wahrscheinlichkeit, dass eine Einheit gezogen wird, das in x den Wert xi und in y den Wert yj hat. Dieses Ereignis wird durch die beiden Zufallsvariablen X und Y beschrieben, mit deren Hilfe die Wahrscheinlichkeitsaussage formuliert werden kann: P(X=xi Y=yj). Diese Wahrscheinlichkeit ist genau gleich dem Anteil in der Urne ij und wird auch als die gemeinsame Wahrscheinlichkeit bezeichnet. Den bedingten Anteilen entsprechende Wahrscheinlichkeitsaussagen sind die bedingten Wahrscheinlichkeiten, die ebenfalls wiederum numerisch gleich den bedingten Anteilen der Population sind: P(Y=yj | X=xi) = i j (das ist die Wahrscheinlichkeit, dass der gezogene y-Wert = yj ist unter der Bedingung, dass sein x-Wert = xi ist. Die entsprechende Gleichheit gilt auch für die Randwahrscheinlichkeit. 4.4.1 Unabhängigkeit zweier Merkmale Besondere Bedeutung hat bei theoretischen Überlegungen ein einfacher Spezialfall von Anteilskonstellationen, der es erlaubt komplexe Sachverhalte in überschaubare Einzelfragestellungen zu zerlegen. Oft dient der einfache Spezialfall nur als Vergleichsbasis zur real gegebenen Datenlage. Der Spezialfall wird Unabhängigkeit genannt. Da der Begriff der Unabhängigkeit auch in anderen Bereichen verwendet wird (z.B. Unabhängigkeit logischer Aussagen, lineare Unabhängigkeit in der Algebra), ist der Begriff zu spezifizieren. Einerseits soll von der Anteils-Unabhängigkeit der Merkmale gesprochen werden, andererseits von der probabilistischen (bzw. stochastischen) Unabhängigkeit zweier Zufallsvariablen. Die Beschreibung des Spezialfalls wird für die Populationsanteile formuliert. Nagl, Einführung in die Statistik Der einfache Spezialfall besteht darin, dass die bedingten y-Anteile bei allen Ausprägungen des x-Merkmals gleich sind. Anders formuliert: Die y-Verteilung ist in allen xGruppen gleich. Seite 122 Bedingte Anteile sind gleich für alle Gruppen i j = Ij (i=1,...,I-1) für jedes j (j=1,...,J) Es genügt die Forderung, dass alle gleich der letzten Gruppe sind Wenn die y-Verteilungen in allen Gruppen gleich sind, müssen diese y-Verteilungen gleich der y-Randverteilung sein Für alle Gruppen (i=1,...,I) gilt: ij = j Falls alle y-Verteilungen gleich sind, sind alle gemeinsamen Anteile proportional zu den Randanteilen (d.h. ist das Produkt der Randanteile) Für die gemeinsamen Anteile gilt bei Unabhängigkeit: ij = i j Falls alle y-Verteilungen gleich sind, sind ebenfalls alle x-Verteilungen gleich bei allen y-Ausprägungen. Zudem sind alle gleich den xRandverteilungen Ausbildungsbedingte Angstanteile bei Unabhängigkeit ja nein V 0.70 0.30 0.40 S. h 0.70 0.30 0.30 S. A 0.70 0.30 0.30 bi 0.70 0.30 1.0 0.8 VS ja nein hS ja nein 0.6 0.4 0.2 Abi ja nein 0 0 0.2 0.4 ja 0.6 0.8 1.0 nein 0 0.2 0.4 0.6 0.8 Gesamt 1.0 Bemerkung: Diese Bedingung folgt aus der vorherigen Forderung und umgekehrt. für jedes j (j=1,...,J) für alle Zellen i, j (i=1,...,I bzw. j=1,...,J) Bedingte Anteile sind gleich für alle jGruppen i j i (j=1,...,J) für jedes i (j=1,...,J) Denn: Nach der Regel für das Berechnen der gemeinsamen Anteile aus den bedingten gilt: ij i .Wegen = j gilt daher ij i j . ok. Beispiel: Jeder gemeinsame Anteil ist das Produkt aus den Randanteilen, falls Unabhängigkeit gilt Beispiel: Alle Zeilen haben gleiche bedingte Anteile d.h. die Ausbildungsverteilung ist gleich für alle Angstausprägungen. ij ij gemeinsame Anteile bei Unabhängigkeit ja nein VS. hS. Abi 0.28 0.21* 0.21 0.12 0.09 * 0.09 0.70 0.30 0.40 0.30 0.30 Angstbedingte Ausbildungsanteile bei Unabhängigkeit ja nein VS. hS. 0.40 0.30 0.40 0.30 0.40 0.30 Abi 0.30 0.70 0.30 0.30 0.30 Alle drei Formulierungen der Unabhängigkeit (für gemeinsame, x-Bedingte und y-Bedingte Anteile) sind äquivalent. Ist eine einzige erfüllt folgen daraus die beiden andern. Daher genügt es, bei einer Definition der Unabhängigkeit, eine einzige Forderung zu formulieren. Definition der (Anteils-)Unabhängigkeit zweier Merkmale: Zwei Merkmale x und y sind genau dann unabhängig, wenn jeder gemeinsame Anteil gleich dem Produkt der Randanteile ist: ij = i j für alle i,j- Konstellationen.. Definition der stochastischen Unabhängigkeit zweier Zufallsvariablen: Zwei Zufallsvariablen X und Y sind genau dann unabhängig, wenn für jede gemeinsame Wahrscheinlichkeit gleich dem Produkt der Randwahrscheinlichkeiten ist: P(X=xi Y=yj)= P(X=xi)P(Y=yj) für alle i,j-Konstellationen. Beide Definitionen formulieren die Produkteigenschaft in vergleichbarer Art. Von der Interpretation her setzt aber die Formulierung für Zufallsvariablen ein Zufallsexperiment voraus, während bei Anteilen eine solche Unterstellung nicht notwendig ist. 4.4.2 Test auf Unabhängigkeit zweier Merkmale (2-Test) Die Hypothese der Unabhängigkeit zweier Merkmale (beide mit nominalem Mindestskalenniveau) kann mit Hilfe des 2-Test (von PEARSON entwickelt) durchgeführt werden. Bei ordinalem Mindestskalenniveau des yMerkmals steht alternativ auch der KOLMOGOROFF-SMIRNOFF-Test zu Verfügung. Nullhypothese: Die beiden Merkmale sind unabhängig (z.B. Die gemeinsamen Populationsanteile sind als Produkt der Populationsrandanteile darstellbar, oder andere Formulierung). Für die Population gilt: ij i j (bzw. irgendeine andere Art der Unabhängigkeitsformulierung) Beispiel (Angst vor Prüfungen und Ausbildung des Vaters): Die beiden Merkmale sind unabhängig. Es besteht kein Zusammenhang. Der Anteil derer, die Angst vor Prüfungen haben, ist für alle Arten von Väterausbildung gleich groß. Nagl, Einführung in die Statistik Seite 123 In einer Stichprobe werden nur die Häufigkeiten des gemeinsamen Auftretens beobachtet, auf Grund derer die gemeinsamen und Randanteile berechnet werden können. gemeinsame und Randanteile ja nein VS. 0.40 0 0.40 hS. 0.20 0.10 0.30 Abi+ 0.10 0.20 0.30 0.70 0.30 n=10. Beobachtete Häufigkeiten nij und Randanzahl bzw. gemeinsame Anteile p ij Tabelle mit den beobachteten gemeinsamen und Randanteilen und Randanteile pi und pj erwartete gemeinsame Anteile unter Unabhängigkeit ja nein VS. 0.28 0.12 0.40 * hS. 0.21 0.09 0.30 Abi+ 0.21 0.09 0.30 0.70 0.30 Die unter Unabhängigkeit Auf Grund der beobachteten Randanerwarteten Anteile sind: teile können die unter Unabhängigp i p j keit erwarteten gemeinsamen Anteile (hypothetisch erwartete berechnet werden (=hypothetische Anteile) Anteile) Nur die Randanteile werden für die Bilddung des Produkts verwendet z.B. 0.70*0.40 Konstruktion der Teststatistik: Eine Maßzahl, die den Unterschied zwischen realen und hypothetischen gemeinsamen Anteilen in einer Zahl zusammenfasst, ist gesucht. Ist der Unterschied zwischen den hypothetisch geforderten Anteilen und den empirisch gefunden ‚zu groß‘? ‚Zu groß‘ würde bedeuten, dass die Hypothese der Unabhängigkeit nicht passt. Zwei schon früher betrachtete Maße können verwendet werden Ein Maß für den Unterschied kann auf Likelihood-Ratio-Chi**2= den Entropieüberlegungen aufgebaut LR2 = werden. Je größer das Maß, desto gröI J p i p j 2n p ij ln ßer die Unterschiede. Es wird Likep ij i 1 j1 lihood-Ratio-Chi**2 (LR2) genannt. Ein anderes Maß für den Unterschied PEARSON-Chi**2= hat K. Pearson entwickelt. Es ist die P 2 = Summe quadrierter, standardisierter Abweichungen der realen und hypotheI J (p p p ) 2 ij i j tischen gemeinsamen Anteile n p i p j i 1 j1 LR2= -2*10( 0.4*ln(0.28/0.4) + 0.0* ln(0.12/0.0)+ 0.2*ln(0.21/0.2) + 0.1* ln(0.09/0.1)+ 0.1*ln(0.21/0.1) + 0.2* ln(0.09/0.2) ) = -2*10(-0.2289558) = 4.579 Weiter muss dann untersucht werden, ob dies eine große Abweichung ist (etwa beim Stichprobenziehen, siehe unten) P2 = 10*( (0.4-0.28) 2/0.28+ (0.0-0.12) 2/0.12+ (0.2-0.21) 2/0.21+ (0.1-0.09) 2/0.09+ (0.1-0.21) 2/0.21+ (0.2-0.09) 2/0.09 = 10*0.36507=3.6507 Die Testverteilung für die Stichprobenmaßzahl LR2 (und P2) ist approximativ (n groß >20) Chi**2-verteilt mit df=(I-1)(J-1) Freiheitsgraden. Für kleines n können exakte Verteilungen konstruiert werden (FISHERs Exakt Test für je zwei dichotome Merkmale entwickelt; inzwischen erweitert auf größere Tabellen). Die durchschnittliche Häufigkeit pro Zelle sollte mindestens 5 sein (d.h. nicht zu viele Zellen bei einem gegebenen n). Das sehr konservative Kriterium (n p i p j 5) gilt vorrangig für P2, weniger für LR2. Es sollten aber insgesamt weniger als 20% solcher Zellen vorhanden sein, für die n p i p j <5. Beim Angstbeispiel sind die Voraussetzungen für die Anwendung der Verteilungsapproximation durch die 2-Verteilung nicht erfüllt (n zu klein). Auch die durchschnittliche Häufigkeit pro Zelle (10/6=1.667) ist zu klein. Kritischer Bereich Die Nullhypothese behauptet die Unabhängigkeit der beiden Merkmale. Die Nullhypothese wird abgelehnt, wenn die realen Anteile zu stark von den hypothetischen abweichen (gemessen durch die Teststatistiken LR2 bzw. P2). Bei sehr großer Teststatistik wird daher die Nullhypothese abgelehnt. Der kritische Bereich wird von rechts her bestimmt. Trotz aller Bedenken hinsichtlich der Verteilungsvoraussetzungen im Angstbeispiel soll die Vorgehensweise mit ihm demonstriert werden. Für ein vorgegebenes ist daher immer der BeAnzahl der Freiheitsgrade: reich: Fällt der beLR2 bzw. P2 I=3 (Zeilen), J=2 (Spalten). df=(I-1)(J-1)=2. rechnete Wert in 2 0.05 ((I-1)(J-1)) den kritischen Der kritische Wert bei =0.05 Bereich wird die ist 5.99. (siehe TabellenUnabhängiganhang) LR2=4.579 liegt nicht im keitshypothese kritischen Bereich H0 wird daher verworfen akzeptiert 0.6 0.5 0.4 0.3 0.2 0.1 0 0 1 2 3 4 5 6 2 0.05 (2) = 5.99 7 2 8 Kritischer Bereich Kritischer Bereich Nagl, Einführung in die Statistik Einfachere Berechnung von P2 Die Formel für PEARSON-Chi**2 kann etwas vereinfacht werden im generellen Fall. Seite 124 PEARSON-Chi**2= I J p ij2 P 2 = n 1 i 1 j1 p i p j Für zwei dichotome Merkmale p p p12 p 21 2 kann PEARSON-Chi**2 durch eine P2 = n 11 22 p1 p 2 p 1 p 2 sehr einfache Formel berechnet werden P2 = 10*( 0.42/0.28+ 0.02/0.12+ 0.22/0.21+ 0.12/0.09+ 0.12/0.21+ 0.22/0.09 - 1) = 10*0.36507=3.6507 10 0.4 * 0.3 0 * 0.3 2 Angst vor Prüfungen ja nein VS. 0.40 0 0.40 n VS 0.30 0.30 0.60 0.70 0.30 = 0.4 * 0.6 * 0.7 * 0.3 =P2=2.8571429 Likelihood-Ratio-Chi**2= I J I J I J n i n j LR2 = 2 n ij ln = 2 n ij ln n ij n i ln n i n j ln n j n ln n n ij n i 1 j1 i 1 j1 i 1 j1 4.5 Zusammenhangsmaße für qualitative Merkmale Der Zusammenhang zwischen den beiden Merkmalen soll durch eine Maßzahl beschrieben werden können, die normiert ist, d.h. etwa zwischen 0 und 1 (vielleicht auch zwischen –1 und 1) liegt. Der Nullwert soll anzeigen, dass kein Zusammenhang vorhanden ist, die obere Grenze soll den stärkst möglichen Zusammenhang signalisieren. Bei qualitativen Merkmalen kann im allgemeinen keine Richtung des Zusammenhangs in sinnvoller Art definiert werden, da die Ausprägungen bei Nominalskalen kein mehr oder weniger ausdrücken (Ausnahme: Für zwei dichotome Merkmale, die implizit wiederum als Intervallskalen interpretierbar sind, kann auch eine Richtung des Zusammenhangs angegeben werden). Der erste (und althergebrachte) Ansatz, Zusammenhangsmaße zu definieren, besteht darin, P2 so zu normieren, dass die normierten Werte zwischen 0 und 1 liegen. Der zweite Ansatz definiert PRE-Maße. 4.5.1 Normierungen von P2 Phi-Quadrat (= 2 ): Dabei wird P2 Phi**2= 2 := P2 / n = durch n dividiert. I J p ij2 p p 1 , 2 , i 1 j1 i j Der Wertebereich von 2 liegt aber wobei gilt: nicht immer zwischen 0 und 1. Er ist 0 2 min(I 1, J 1) immer größer oder gleich 0, aber die Bei Berücksichtigung der Art der mögliche obere Grenze ist nur dann Randverteilungen können engere 1, wenn I=2 oder J=2 ist. Beispiel: Prüfungsangst 2 =3.8507/10= ( 0.42/0.28+ 0.02/0.12+ 0.22/0.21+ 0.12/0.09+ 0.12/0.21+ 0.22/0.09 - 1)= 0.36507 0.36507 = 0.604 2 0 min(3 1, 2 1) =1, da die Tabelle 3 Zeile und 2 Spalten hat Grenzen formuliert werden CRAMERs v: Damit der Wert garantiert zwischen 0 und 1 liegt, wird zusätzlich durch min(I-1,J-1) dividiert. Aus historischen Gründen sind noch beachtenswert: PEARSONs c und TSCHUPROFFs t v c:= P 2 n min( I 1, J 1) 2 1 2 , t:= 2 ( I 1)(J 1) Codierten) Merkmalen den. Diese Werte liegen dann zwischen -1 und +1. p11p 22 p12 p 21 p1 (1 p1 )p 1 (1 p 1 ) r (=PEARSON Korrelation für dichotome Merkmale) min(I 1,J 1) v Da min(I-1, J-1)= 1, ist beim vorliegenden Beispiel v= c= 0.36507 1 0.36507 Beispiel: Wer sich anstrengt, wird belohnt Bei zwei dichotomen (Dummy- selbst kann direkt berechnet wer- Es gilt daher auch = = =0.517 a(=0) a (=1) 0.4 * 0.3 0 * 0.3 0.4 * 0.6 * 0.7 * 0.3 = b (=0) 0.30 0 0.30 b(=1) 0.30 0.40 0.70 0.12 0.24 * 0.21 0.60 0.40 0.535 Nagl, Einführung in die Statistik Seite 125 Der Zähler in der Formel für entspricht der Kovarianz. Cov(x,y)= ( p11p 22 p12 p 21 )*k Im Nenner sind die Wurzeln aus den beiden Varianzen für x und y zu erkennen. Daher entspricht genau dem Korrelationskoeffizienten r Auf Grund des allgemeinen BerechnungsscheVar(y)= p 1 (1 p 1 ) *k mas für Mittelwerte, Varianzen und Kovarianz: wobei k eine Konstante dargem.Anx y xp yp x2p y2p xyp stellt, die die Stichprobenkorteil (p) 0 0 p11 0 0 0 0 0 rektur beinhaltet: k=n/(n-1). 0 1 p12 0 p12 p12 p12 0 Die Konstante k kürzt sich bei 1 0 p21 p21 0 0 0 0 1 1 p22 p22 p22 p22 p22 p22 den Koeffizienten und d weg. Var(x) = p1 (1 p1 ) *k Cov(x,y)=0.12*k, Var(x)=0.24*k, Var(y)=0.21*k p2 Die Formeln für die Mittelwerte und Varianzen der Randverteilungen (jeweils eindimensional) von DummyMerkmalen sind von früher her bekannt. y-Anteilsdifferenz für den Vergleich der durch x gebildeten Gruppen. Das ist die Differenz der x-Bedingten yAnteile. Diese Differenz entspricht der Steigung in der Regressionsanalyse (wenn y der Prädikand und x der Prädiktor ist) x-Anteilsdifferenz für den Vergleich der durch y gebildeten Gruppen. Das ist die Differenz der y-Bedingten xAnteile. Diese Differenz entspricht der Steigung in der Regressionsanalyse (wenn x der Prädikand und y der Prädiktor ist) d y|x p p p12 p 21 11 22 p1 (1 p1 ) = p 22 p12 p2 p2 p22 p2 erhält man: x p 2 , y p 2 , usw. Cov(x,y)= k ( p 22 p 2 p 2 ) Nach Einsetzen für p2 und p2 folgt = k ( p11p 22 p12 p 21 ) Beispiel:Fs. x-Bedingte y-Verteilungen b (=0) 0.50 0 0.30 a(=0) a (=1) b(=1) 0.50 1.00 0.70 0.60 0.40 d y|x= 0.12/(0.60*0.40)=0.50 y-Anteilsdiff.: p p =1.00 - 0.50 = 0.50 22 12 Als Steigung: Cov(x,y)/Var(x)=0.50 d x| y p11p 22 p12 p 21 p 1 (1 p 1 ) = p 22 p 21 Beispiel:Fs. y-Bedingte x-Verteilungen b (=0) 1.00 0 0.30 a(=0) a (=1) d y|x= 0.12/(0.70*0.30)=4/7 y-Anteilsdiff.: p p 22 21 b(=1) 3/7 4/7 0.70 0.60 0.40 =4/7 – 0 = 4/7 Als Steigung: Cov(x,y)/Var(y) = 4/7 4.5.2 Beschreibung der PRE-Maße Für qualitative Merkmale wurden von GOODMAN & KRUSKAL (1954, 1958, 1963, 1972) PRE-Maße entwickelt. Das auf dem Konzept der Unsicherheit beruhende PRU-Maß (Proportional Reduction of Uncertainty) kann ebenfalls als PRE-Maß bezeichnet werden, da die Unsicherheit als Fehler einer generellen Art interpretiert werden kann. Die meisten PRE-Maße werden als a-posteriori (auf Grund der Kenntnis der Daten) berechnet; das einzige apriori (vor Ansehen der Daten) konzipierte PRE-Maß ist kappa. 4.5.2.1 A-priori PRE-Maße 4.5.2.1.1 GOODMANs Lambda () Die Regeln prädizieren die Modalausprägung; das Fehlermaß ist der Anteil (bzw. Anzahl) der Fehlprädiktionen. Konstruktionsschritte des PRE-Maßes für (genauer: xy) 1R Prädiktionsregel für Ry(MIT x)= Modalregel das y-Merkmal: Jeder pro x-Gruppe: UE wird als y-Wert Prädiktion der Modalausdie Modalausprägung prägung. seiner x-Gruppe Bei dieser Vorgehensweise zugesprochen. Auf können Fehlprädiktionen nur für diese Art kann das xFälle außerhalb der ModalausMerkmal berücksichprägungen entstehen (=Fehlerzellen) tigt werden. gemeinsame und Randanteile ja nein VS. 0 0.40 0.40 hS. 0.20 0.10 0.30 Abi 0.10 0.20 0.30 0.70 0.30 1.0 0.8 0.6 0.4 0.2 0 Modalausprägung VS. ja hS. ja Abi nein Modal Regel VS. ja hS. ja Abi nein VS hS Abi 1.0 0.5 0 1.0 F 0.5 0 1.0 F 0.5 0 F ja nein 1.0 Gesamt 0.5 0 Da bei der Prädiktion immer die Modalwerte verwendet werden, können Fehler nur in Zellen entstehen, die nicht die Modalwerte sind (sie werden Fehlerzellen genannt) ja nein ja VS. hS. Abi F nein F F Nagl, Einführung in die Statistik 1F. Definieren eines Fehlermaßes: Anzahl bzw. Anteil, der bei Anwendung der Regel Ry(MIT x) auf alle einzelnen UEen insgesamt entsteht. Seite 126 Fy(MIT x)=gem. Anteil der UEen in Fehlerzellen I = 1 max (p ij ) j i 1 OHNE-x Prädiktions- Ry(OHNE x)= Modalregel regel: Prädiktion der OHNE Aufgliederung 2R. y-Randnach x (=y-Rand) Modalausprägung Fy(OHNE x)= yAnzahl bzw. Anteil, Randanteil außerhalb des außerhalb der yModalwerts = 2F. RandI 1 max ( p j ) Modalausprägung i 1 3. Definition von als PRE-Index, daher wieder interpretierbar als prozentuale Fehler-Reduktion durch x VS. hS. Abi ja 0.40 0.20 0.10 nein 0 0.10 0.20 max 0.40 +0.20 +0.20 =0.80 Maximum pro Zeile jeweils addieren 3 ( p ij ) max j i 1 Fy(MIT x)= 1 – 0.80 =0.20. Der Fehler bei Befolgung der Modalkregel (mit Berücksichtigung von x) ist daher = 0.20. Das ist zugleich der Anteil der UEen in den Fehlerzellen (=0+0.10+0.10). Bei der y-Randverteilung ist die Modalausprägung: ja Ry(OHNE x): Daher wird OHNE Berücksichtigung von x jeder UE die Ausprägung ja zugesprochen Rand-Modal Regel immer ja Als Fehler Fy(OHNE x) definiert man den Fehler analog zum Fy(MIT x) : Anteil falscher Prädiktionen, die beim Anwenden von Ry(OHNE x) entstehen. R y (OHNE x ) 1 max (p j ) 1 0.70 0.30 j j = Der Fehler Fy(MIT x) =0.20, der Fehler OHNE x =0.30. Fy (OHNE x) - Fy (MIT x) Daher: = PRE =1 – (0.20/0.30)= 1 – (2/3)= 0.333 Fy (OHNE x) Die Berücksichtigung von x reduziert den Fehler um 33.3 % Problem: Modalwert bei gleichen Anteilen Falls der Modalwert nicht eindeutig ist bei (bei gleichen Beispiel: Entscheidet man sich in der zweiten Anteilen), muss man sich für einen Modalwert entschei- Zeile (x2) für y1, so ist F(MIT)=0.30; der Fehler den. Egal welcher Modalwert gewählt wird, ändert sich ist gleich groß bei der Entscheidung für y2 das Fehlermaß nicht, daher auch nicht . x1 x2 y1 0.40 0.30 0.70 y2 0 0.30 0.30 Grenzen der Anwendbarkeit: Falls bei einem y-Merkmal berechnet wird, das eine sehr schiefe Randverteilung hat, wird gleich 0 sein, obwohl große Unterschiede in den Anteilen der Zellen vorhanden sind, die auf Abhängigkeit hinweisen. x1 x2 y1 0.40 0.30 0.70 y2 0 0.30 0.30 y1 0.40 0.30 y2 0 0.30 0.40 0.60 Beispiel: Trotz der offensichtlichen Abhängigkeit des x- und y-Merkmals sind die Modalwerte bei der MIT- Regel immer y1 (Genau wie bei der OHNE-Regel). Daher ist gleich 0. Eigenschaft der Asymmetrie: Beispiel(Fortsetzung): xy wurde bereits oben Falls auf Grund des y-Merkmal das x-Merkmal prognostiziert wird, könnte ein yx berechnet werden. Die- berechnet=0. yx =(0.40-0.30)/0.40 =0.25 x1 x2 ses stimmt i.a. nicht mit xy überein. Symmetrisches Lambda: yx Beispiel(Fortsetzung): Fehler MIT in Richtung xy ist 0.30, in Beim symmetrischen Lambda werden beide Szenarien Richtung yy ebenfalls 0.30. Fehlersumme MIT =0.60 (Prädiktion von x durch y, danach Prädiktion von y Fehler OHNE in Richtung xy ist 0.30, in Richtung yx ist 0.40. durch x) durchexerziert. Die OHNE- ebenfalls wie die MIT-Fehler werden addiert. Für diese (addierten) Fehler Fehlersumme OHNE =0.70 wird der PRE-Index gebildet, der dann yx ist Symmetrisches Lambda: yx=(0.70-0.60) / 0.70 0.14 4.5.2.1.2 GOODMAN-KRUSKALs Tau () GOODMAN-KRUSKALs kann wiederum als PRE-Maß konzipiert werden. Mehrere Prädiktionsszenarien mit entsprechenden Regeln können konstruiert werden, die zum gleichen Fehlermaß führen. Als ein mögliches Szenario wird hier eine probabilistische Entscheidungsregel vorgestellt. Konstitutiv für GOODMAN-KRUSKALs aber ist, dass als Fehlermaß die qualitative Varianz (auch HERFINDAL-Index genannt) verwendet wird. Nagl, Einführung in die Statistik Seite 127 Konstruktionsschritte des PRE-Maßes für (genauer: xy): Ry(OHNE x)= EntscheiProbabilistische 2R. OHNE-x Regel: Alle dung auf Grund der yy-Rand Ausprägungen Rand-Urnenziehung werden im Verhältnis des realen VorkomPro einzelner Prädiktion mens in die ‚Entschei- wird die zufällig gezogene dungsurne‘ gefüllt. Ausprägung prädiziert. Beispiel: Die y-Rand-Verteilung bei Prüfungsangst ist 7 zu 3. 2F. Fehler OHNE x sei die qualitative Varianz der y-Randverteilung Die UE werde ebenfalls zufällig aus einer Urne gezogen. Dann kann die Wahrscheinlichkeit, einen Fehler zumachen, durch die Formel: 1- (0.302+0.702)= 0.42 berechnet werden. Das entspricht der qualitativen Varianz. Fy(OHNE x)= p 22 p 2J ) = 1 (p 21 J 1 p 2j j1 1R. Regel MIT x: pro xGruppe wird eine Entscheidungsurne (jeweils im Verhältnis der x-Bedingten Verteilung des yMerkmals) gefüllt. 1F. Fehler MIT x ist der nach dem xRandanteil gewichtete Mittelwert der qualitativen Varianz der yVerteilung der verschiedenen Gruppen 3. Definition von als PRE-Index, daher wieder interpretierbar als prozentuale FehlerReduktion durch x J = p j (1 p j ) Angst vor Prüfungen ja nein 0.70 0.30 Für die Prädiktion werden in einer Urne (Entscheidungsurne) 7 Ja-Kugeln und 3 Nein-Kugeln plaziert. Für die Prädiktion der Angst jeder einzelnen UE wird aus der Urne eine Kugel gezogen (mit Zurücklegen). Die gezogene Ausprägung wird prädiziert. j1 Ry(OHNE x)= Entscheidung für y-Ausprägung auf Grund der Urnenziehung aus der entsprechenden xUrne. Pro einzelner Prädiktion wird die zufällig gezogene y-Ausprägung prädiziert. I Fy(MIT x)= p i d i ( y) , i 1 Beispiel: Für die drei x-Gruppen wird je eine Entscheidungsurne gefüllt. Die erste enthält zu 100% ja, die zweite 2 ja- und eine nein-; die dritte enthält eine Ja- und 2 Neid-Kugeln. Für die Prädiktion wird in Abhängigkeit vom bekanntgemachten x-Wert die entsprechende Urne verwendet. Die gezogene Ausprägung wird prädiziert. Beispiel: Für die drei x-Gruppen werden die qualitativen Varianzen auf Grund der bedingten Anteile berechnet, Sie ihrerseits werden mit den x-Randanteilen gewichtet und aufsummiert: wobei d i ( y) 1 j1 p i2j J = j1 p (1 p ) J ij ij (=qualitative Varianz in der i. Gruppe) = Fy (OHNE x) - Fy (MIT x) Fy (OHNE x) Angst vor P. ja nein VS. 1.00 0 hS. 0.67 0.33 Abi+ 0.33 0.67 VS. hS. Abi i 1 2 3 ja nein 1 1.00 0.67 0.33 2 0 0.33 0.67 1 Jj1 pi2j 2 2 1-(1 +0 ) 1-(0.672+0.332) 1-(0.332+0.672) di(y) =0 =4/9 =4/9 pi 0.40 0.30 0.30 Summe di(y)pi 0 (1.2)/9 (1.2)/9 (2.4)/9 Fy(MIT x)= (2.4)/9= 0.2667 Der Fehler Fy(MIT x) =0.2667, der Fehler OHNE x =0.42. Daher: = PRE =1 – (0.2667/0.42)= 1 – 0.635= 0.365 Die Berücksichtigung von x reduziert den Fehler um 36.5 % (Das ist in diesem Szenario etwas mehr als im Modalszenario) . Eigenschaft der Asymmetrie: Falls auf Grund des y-Merkmal das x-Merkmal progBeispiel: Prädiktion Prüfungsangst(y) Ausbildung Vater(x). nostiziert wird, könnte ein yx berechnet werden. yx=0.192, Fx(OHNE y)=0.66, Fx(MIT y)= =0.533 Dieses stimmt i.a. nicht mit xy überein. Symmetrisches Tau: yx Beim symmetrischen Tau werden wiederum beide Szenarien (Prädiktion von x durch y, danach Prädiktion von y durch x) durchexerziert. Die OHNE- ebenfalls wie die MIT-Fehler werden addiert. Für diese (addierten) Fehler wird der PRE-Index gebildet, der dann yx ist 4.5.2.1.3 Das PRU-Maß Auch das PRU-Maß kann als PRE-Index konzipiert werden. Das U steht für Unsicherheit (engl. Uncertainty). Die Unsicherheit wird durch die mittlere Entropie gemessen. Die Regeln brauchen hier nicht näher untersucht werden. Sie bestehen darin, dass mit optimaler Fragestrategie (wie in Kap.2 dargestellt wurde) so lange gefragt wird, bis Sicherheit vorliegt. Die mittlere Entropie konnte als untere Optimalgrenze der Fragedauer (bei binärer Antwort) interpretiert werden. Nagl, Einführung in die Statistik Seite 128 Beispiel: Prüfungsangst –Randverteilung: 0.70 0.30 2F. Als Fehler OHNE x Fy(OHNE x) := h(y) Fy(OHNE x)= h ( y) =-1.4427* (0.70*ln(0.70) + 0.30*ln(0.30))= J wird die mittlere Ent1 -1.4427* (-0.6108643)= 0.8812909. : ropie der y p j ln(p j ) Die mittlere Entropie als ln( 2) j1 untere Optimalfragedauer für die yRandverteilung verRandverteilung beträgt 0.881. Sie kann durch ‚Verschiefung‘ der wendet Verteilung kleiner werden. Beispiel: Für die drei x-Gruppen wird die mittlere Entropie auf I 1F. Fehler MIT x ist der Fy(MIT x)= p i h i ( y) , Grund der bedingten Anteile berechnet; sie ihrerseits werden mit nach dem xden x-Randanteilen gewichtet und aufsummiert: i 1 Randanteil gewichtete ja nein wobei p ln(p ) h i ( y) p i pi h i ( y) Mittelwert der mittleij ij i 1 2 J 1 ren Entropie jeder 0 1ln(1)+0 0 0.40 0 h i ( y) p ln(p ij ) 12 1.00 0.67 0.33 2/3*ln(2/3)+ 1/3*ln(1/3) 0.918 0.30 0.2754 ln( 2) j1 ij bedingten y3 0.33 0.67 1/3*ln(1/3)+ 2/3*ln(2/3) 0.918 0.30 0.2754 Verteilung der ver(=mittlere Entropie in der Summe 0.5508 Fy(MIT x)= 0.5508 schiedenen Gruppen i. Gruppe) 3. Definition von PRU als PRE-Index; daher PRU = Der Fehler Fy(MIT x) = 0.5508, der Fehler OHNE x 0.881 interpretierbar als Fy (OHNE x) - Fy (MIT x) Daher: PRU = 1 – (0.5508 / 0.881) 0.375 Die Berücksichtigung von x reduziert die Unsicherheit prozentuale FehlerreFy (OHNE x) um 37.5 %. duktion bzw. Unsicherheitsreduktion durch x Andere Bezeichnungen für PRU: Unsicherheitskoeffizient oder Pseudo-R2 Eigenschaft der Asymmetrie: Falls auf Grund des y-Merkmal das x-Merkmal prognostiziert wird, könnte ein PRUyx berechnet werden. Dieses stimmt i.a. nicht mit PRU xy überein. Ebenso wie bei den anderen Maßen kann ein symmetrisches PRU konstruiert werden. Vergleich von Likelihood-Ratio-2 und PRU Der Zähler von I J I 1 J PRU kann auch so Fy(OHNE x)-Fy(MIT x)= h( y) - p i h i ( y) p j ln p j p i p ln p ij ij dargestellt werden: ln( 2) j1 i 1 i 1 j1 LR2 kann nach einigen Umformungen auch so dargestellt werden: I p i p j p ij i 1 j1 Fy(OHNE x)-Fy(MIT x) = Der Zähler von PRU ist proportional zu LR2 J LR2 = 2n p ij ln I h( y) p i h i ( y) = i 1 LR 2n ln( 2) 2 I J J 2n p j ln p j p i p ij ln p ij j1 i 1 j1 Beispiel: Prüfungsangst (n=10). Oben wurden bereits die Fehler berechnet: Fy(OHNE x)= h ( y) 0.881. Fy(MIT x) 0.551. Der Zähler von PRU ist: Fy(OHNE x)-Fy(MIT x) = I = h ( y ) p i h i ( y ) = 0.881 - 0.551 = 0.33. Andererseits wurde LR2 i 1 ebenfalls berechnet = 4.579. LR2 / (2*10*ln(2)) 0.33 4.5.2.2 Das a-priori-Maß Kappa () Die Prädiktionsregeln werden in Form von Aussagen a-priori (vor Sichten der Daten) festgelegt. Der große Vorteil dieses Maßes besteht darin, dass spezielle, auf Grund theoretischer Überlegungen gewonnene Aussagen maßgeschneidert überprüft werden können. J. COHEN(1960) hat ursprünglich für die Messung von Beurteilerübereinstimmung entwickelt , den Ansatz aber zu einem ‚gewichteten‘ weiterentwickelt (J. COHEN(1969)), das auch bei anderen Fragestellungen einsetzbar ist. HILDENBRANDT, ROSENTHAL u. LAING (1975) haben ein eigenes Maß für vorgegebene Aussagen entwickelt, das sie Del ( ) nannten. Dieses Maß ist identisch mit dem gewichteten , daher soll das Maß auch hier unter dem Namen behandelt werden. Das Maß soll ebenfalls als PRE-Maß entsprechend den Überlegungen von HILDENBRANDT, ROSENTHAL u. LAING (1975) entwickelt werden. Es unterscheidet sich von den a-posteriori PRE-Maßen insofern, als nur eine Regel für die Prädiktion (sowohl für die MIT x, wie für die OHNE x) von y betrachtet wird. Nagl, Einführung in die Statistik Die Regel R(xy) legt fest, bei welchen Ausprägungen von x welche Ausprägungen von y prädiziert werden. Folglich können in der Kreuztabelle Zellen definiert werden, die im Widerspruch zu der in der Regel enthaltenen Aussage stehen: die Fehlerzellen Seite 129 R(xy) legt für Ausprägungen von x fest, welche speziellen yWerte prädiziert werden sollen(z.b.x1 y2, x1 y3, x3y1 usw.). Die Zuordnungen als Paare (z.b. (x1,y2), (x1,y3), (x3,y1)) sind Zellen der Kreuztabelle. Wird einem bestimmten x-Wert (xi) einer oder mehrere y-Werte zugeordnet, sind die nicht zugeordneten y-Werte eine potentielle Fehlerquelle, daher Fehlerzellen zu xi genannt. Beispiel: Prüfungsangst. Die a-priori formulierte Aussage ‚Die Söhne von Vätern mit VS-Ausbildung haben Prüfungsangst, die Söhne von Vätern mit mindestens Abi haben keine Prüfungsangst‘ formuliert für bestimmVS Angst(ja) te x-Werte (Ausprägungen von VaterAbi+ Angst(nein) ausbildung) y-Werte-Zuordnungen. (VS, Angst(ja)), (Abi+,Angst(nein)) sind sehr übersichtlich in einer Kreuztabelle darstellbar (Zellen mit ). Angst vor P. ja nein VS. F hS. Abi+ F Der Ausprägung VS (als spezieller xWert) ist ‚ja‘ zugeordnet. In dieser Zeile (spezielles x) würde ‚nein‘ der Aussage widersprechen, sie ist daher eine Fehlerzelle. Das gleiche gilt bei der Ausprägung Abi+ für ‚ja‘, diese Zelle ist daher auch eine Fehlerzelle. Bei ‚hS.‘ hingegen gibt es keine Fehlerzelle, da in dieser Zeile keiner Zuordnung widersprochen werden kann. Die Fehlerzellen Fehlergewichte-Tabelle: können numerisch in ij y1 y2 . yJ der Fehlergewichtex1 11 12 . 1J Tabelle zusammengefaßt werden. x2 21 22 . 2J . ... ... . ... xI I1 I2 . IJ Insgesamt sind bei der vorliegenden Regel zwei Fehlerzellen vorhanden. Die Fehlergewichte-Kreuztabelle stellt nur eine Darstellung der Fehler in Form von Zahlen dar: In jeder Fehlerzelle wird eine 1 eingetragen. In den übrigen Zellen stehen Nullen. Fehlergewichte Tabelle: Angst vor P. ja nein VS. 0 1 hS. 0 0 Abi+ 1 0 1, wenn ij Fehlerzelle ij sonst 0, Die Regel wird für die Prädiktion aber nur dann eine ‚gute‘ Regel sein, wenn sie die wesentlichen Aspekte des Zusammenhangs zwischen x und y beschreibt. Daher wird zuerst der Fehler berechnet, der den real gegebenen Zusammenhang zwischen x und y berücksichtigt. Als Fehler MIT x wird der Anteil von Fehlprädiktionen gewählt, der bei Anwendung der Regel im real gegebenen Datensatz anfällt. Der Fehler MIT x entspricht der Summe aller gemeinsamer Anteile in den Fehlerzellen bzw. mit Hilfe der Fehlergewichte formuliert: I Fy(MIT x)= J ij p ij i 1 j1 Fy(MIT x) = als Summe der gemeinsamen Anteile in den Fehlerzellen = 0.10+0 = 0.10. Fy(MIT x) mit Hilfe der Fehlergewichte erfordert das Multiplizieren aller pij mit den entsprechenden ij (Produkt unten). Danach Fehlergemeinalle EleGewichte Produkt same Anmente der teile pij ij ij *pij Produktja nein ja nein ja nein Tabelle 0.40 0 0 0 1 0 VS. summieren 0.20 0.10 0 0 0 0 hS. =0.10 0 0 1 0.10 Abi+ 0.10 0.20 Bei den a-posteriori PRE-Maßen wurde jeweils eine eigene OHNE x-Regel entwickelt, die den möglichen Zusammenhang zwischen x und y vernachlässigt. Die OHNE x-Regel operationalisiert jeweils die Situation, in der für die Art der Regel kein Zusammenhang zwischen x und y erkennbar ist. Bei den qualitativen PRE-Maßen könnte an die Stelle der Erstellung der OHNE-x-Regel für die y-Randanteile die Erstellung einer Regel für die unter Unabhängigkeit erwarteten Anteile treten. Die vorliegende a-priori-Regel soll nun ebenfalls für die Nicht-Zusammenhang-Situation, nämlich die der Unabhängigkeit zwischen x und y bewertet werden. Die Regel R(xy) prädiziert bei verschiedenen x-Bedingungen unterschiedliche y-Werte (d. h. sie differenziert zwischen den x-Bedingungen), obwohl diese Differenzierung bei Unabhängigkeit nicht angemessen ist, da unter Unabhängigkeit alle x-Bedingten y-Verteilungen gleich sind. Trotzdem könnte der unter Unabhängigkeit berechnete Fehler eventuell klein sein. Daher wird dieser Fehler ‚OHNE x‘ als Basisvergleichsgröße verwendet; er misst, in welchem Ausmaß überflüssigerweise nach x differenziert wird. Nagl, Einführung in die Statistik Als Fehler OHNE x wird der Anteil von Fehlprädiktionen gewählt, der bei Anwendung der Regel bei auf den unter Unabhängigkeit erwarteten Datensatz anfällt. Definition von als PRE-Index: Um wie viel besser ist die Regel in der konkreten ZusammenhangsSituation im Vergleich zur Anwendung bei fiktiver Unabhängigkeit von x und y? Seite 130 Der Fehler OHNE x entspricht der Summe aller unter Unabhängigkeit erwarteten gemeinsamen Anteile in den Fehlerzellen bzw. mit Hilfe der Fehlergewichte formuliert: I Fy(OHNE x)= J ijp i p j i 1 j1 := Fy ( OHNE x) - Fy ( MIT x) . Fy ( OHNE x) vergleicht die Fehler der beiden Situationen: Regelanwendung unter Berücksichtigung des Zusammenhangs gegenüber der Regelanwendung unter Unabhängigkeitsannahme Fy(OHNE x) = als Summe der gemeinsamen Anteile in den Fehlerzellen = 0.21+0.12 = 0.33. Fy(MIT x) mit Hilfe der Fehlergewichte erfordert das Multiplizieren aller pipj mit den entsprechenden ij (Produkt unten). Danach unter Unabhängigkeit Fehleralle Eleerwartete gemeinsame Gewichte Produkt mente der Anteile pipj ij ij *pij Produktja nein ja nein ja nein Tabelle 0.28 0.12 0 0 1 012 VS. summieren 0.21 0.09 0 0 0 0 hS. =0.33 0 0 1 0.21 Abi+ 0.21 0.09 Der Fehler bei Anwendung der Regel auf die gegebenen Daten beträgt Fy(MIT x) = 0.10. Falls kein Zusammenhang zwischen x und y vorhanden wäre würde die Regelanwendung einen Fehler OHNE x 0.33 erzeugen. = (0.33-0.10) / 0.33=0.697 Die Regel ist daher beim gegebenen Zusammenhang gegenüber der Unabhängigkeitssituation um 69.7% besser Interpretation der MIT-x und OHNE-x Prädiktion im Einzelfall. Die konkrete Durchführung der Prädiktion im Einzelfall zeigt anschaulich die Methode, wie der Zusammenhang zwischen x und y in der OHNE-x Situation entkoppelt wird. Bei der MIT x Prädiktion werde aus einer Urne mit allen (x,y)-Paaren im Einzelfall genau ein Paar gezogen. Auf Grund der Kenntnis des xWerts wird zur y-Prädiktion die Aussage angewandt Fy(MIT x) kann hier als die Wahrscheinlichkeit interpretiert werden, dass bei der Anwendung der Regel auf ein reales (x,y)-Paar fehlerhaft prädiziert wird. Im Vaterausbildung-Angst-Beispiel wird eine Urne eingerichtet mit 4 Elementen (VS-ja), 2 mal (hS-ja), 1 mal (Abi+,ja), 1 mal (hS-nein) und 2 mal (Abi+,nein). Für eine Einzelprädiktion wird nun ein solches Paar gezogen (danach wieder zurückgelegt). Die Wahrscheinlichkeiten für jedes mögliche Ergebnis entspricht genau dem Anteil der Elemente in der Urne. Fy(MIT x) kann als Summe über die Wahrscheinlichkeiten der möglichen exklusiven Paar-Ereignisse berechnet werden. Bei der OHNE x Prädiktion werden zwei Urnen verwendet. Die ‚x-Urne‘ enthält alle xWerte, die ‚y-Urne‘ die y-Werte. Für den Einzelfall wird nun ein Zufallspaar gezogen (ein Element aus jeder Urne). Auf dieses Zufallspaar wird die Prädiktionsregel angewandt. Fy(OHNE x) kann als die Wahrscheinlichkeit interpretiert werden, dass bei der Anwendung der Regel auf ein zufällig gepaartes (x,y) fehlerhaft prädiziert wird. x und y sind bei diesen Paaren unabhängig. x hat daher keinen prädiktiven Wert für y Die x-Urne enthält insgesamt 10 x-Elemente: 4 mal VS, 3 mal hS und 3 mal Abi+. Die y-Urne enthält insgesamt 10 y-Elemente: 7 mal ja und 3 mal nein. Für eine Einzelprädiktion wird genau ein Element aus der xUrne und genau eines aus der y-Urne gezogen. Dadurch entsteht ein ‚künstliches‘ Paar. Dadurch wird der reale Zusammenhang zwischen x und y entkoppelt. Die Wahrscheinlichkeiten für jedes mögliche Paar-Ergebnis entspricht genau dem Produkt der Rand-Anteil der Elemente in der Urne. Unter Fy(OHNE x) kann als Summe über die möglichen ‚künstlichen‘ exklusiven Paar-Ereignisse berechnet werden. Der x-Wert eines real existierenden (x,y)-Paares ist daher unbekannt (in diesem Sinn ist Der x-Wert ist nur scheinbar ein Hilfe für die Prognose von y. die Bezeichnung ‚OHNE x‘ gemeint). Auf Grund dieser Interpretation kann der OHNE x –Fehler als die Wahrscheinlichkeit eines Fehlers bei nicht realem (‚fiktivem’) Zusammenhang bezeichnet werden. Interpretation des Fehlers OHNE-x als Maß der Präzision einer Aussage. Eine Aussage ist umso präziser, je Bei der Prädiktion der meisten quantitativen Merkmale ist die Aussage sehr präzis (z.B. Mittelwert- bzw. Regressionsprädiktionsaussagen ) Für einen x-Wert wird exakt ein y-Wert festgemehr Werte (Ausprägungen des legt. Es sind daher sehr viele (falls y stetig ist, unendlich viele) ausgeschlossen. Merkmals) sie ausschließt. Die Wetterregel ‚Kräht der Hahn auf dem Mist, ändert sich das Wetter oder es bleibt, wie es ist‘ ist nicht präzise, da kein Wert (ändern bzw. nicht ändern des Wetters) ausgeschlossen wird. Nagl, Einführung in die Statistik Seite 131 Präzision für die Prädiktion von y bei Bedingung xi: Bei Merkmalen mit wenigen y-Ausprägungen sollte für eine x-Bedingung nicht nur die Anzahl der ausgeschlossenen Ausprägungen betrachtet werden, sondern auch die Chance, mit der die ausgeschlossenen Ausprägungen überhaupt (insgesamt, Rand) vorkommen. Die Präzision einer bestimmten xBedingung xi für die Prädiktionsaussage von y ist gleich der Summe der Randanteile der Fehlerzellen in der i. x-Bedingung: Anwendungsbereich einer Aussage. Manche x-Bedingungen kommen selten, manche sehr oft vor. Daher werden nicht alle Teile der Prägdiktions-Regel gleich oft angewandt. Als Anwendungsbereich für eine spezielle xBedingung gilt der Anteil, mit dem die spezielle x-Bedingung vorkommt Präzision für die gesamte Prädiktion von y: Die Präzision für die gesamte Prädiktionsaussage ergibt sich aus den Einzelpräzisionen: gewichtet jeweils mit dem entsprechenden Anwendungsbereich. Die Regel legt für die x-Bedingungen die yKonsequenzen fest. Der Anwendungsbereich (engl. scope) der Regel für die i. x-Bedingung ist der Randanteil: p i J Präz(xi)= ij p j RandAnteil: j1 I i 1 J p i ijp j j1 I p2= 0.30 Falls eine x-Bedingung real selten vorkommt, wird auch der Regelteil, der sich auf diese Bedingung bezieht, selten angewandt. Anwendungsbereichs Anteile pi 0.40 VS. 0.30 hS. 0.30 Abi+ Daher gibt der Randanteil Auskunft über den Anwendungsbereich der Regel für die entsprechende Bedingung. Fehlergewichte ij xi ja nein 0 1 VS 0 0 hS 0 1 Abi+ p i Präz ( x i ) i 1 p1= 0.70 Berechnung der Präzision für die gesamte Aussage y-Präzision = I Beispiel: Für jede x-Bedingung kann die Präzision berechnet werden. In der hier definierten Präzision wird nicht nur berücksichtigt, wie viele y-Ausprägungen ausgeschlossen sind, sondern wie groß der Anteil in den insgesamt ausgeschlossenen yAusprägungen ist (gemessen durch die Randanteile): Fehlergewichte Produkt xi ij ij *pj Präz(xi) ja nein ja nein 0 0 1 0.30 0.30 =Präz(VS) VS 0 0 0 0 0.00 =Präz(hS) hS 0 0 1 0.70 0.70 =Präz(Abi+) Abi+ Randanteil: J ijp i p j Die so definierte Präzision für die i 1 j1 Gesamtprädiktion von y ist gleich dem Fehler(OHNE x) = Fy(OHNE x) p1= 0.70 Produkt ij *pj ja nein 0 0 0.70 0.30 0 0 Präz 0.30 0.00 0.70 Anw. Ber. Anw. Ber. *Präz 0.40 0.30 0.30 0.12 0.00 0.21 p2= 0.30 0.33 Die verschiedenen Formeln können an Hand der obigen Tabelle nachvollzogen werden, zugleich die Gleichheit mit Fy(OHNE x) Diese Interpretation erlaubt, als anteilige Fehlerreduktion gegenüber der ‚reinen‘ Präzision, die ebenfalls den realen Zusammenhang zwischen x und y nicht mit einbezieht. Weitere Anwendungen: 1 1 1 1 0 5 5 0 0.12 0 0.13 0 0.50 0 0.13 0.10 0.12 0.10 1 Für die Übereinstimmungsaussage (als Regel) kann der Fehler MIT x berechnet werden = Summe gemeinsamer Anteile außerhalb der Diagonalen = 0.20. Gemeinsame Anteile unter Unabhängigkeit 2. Beurteiler Wie groß wäre der Fehler bei 1 2 3 4 5 ‚zufälliger‘ Übereinstimmung 1 0.0168 0.0182 0.070 0.0182 0.0168 (Fehler OHNE x, unter Unab2 0.0180 0.0195 0.075 0.0195 0.0180 hängigkeit) = Summe gemein3 0.0576 0.0624 0.240 0.0624 0.0576 samer Anteile unter Unabh. 4 0.0156 0.0169 0.0169 0.0156 0.065 außerhalb der Diagonalen = 5 0.0120 0.0130 0.050 0.0130 0.0120 0.6948 5 0.12 0.13 0.50 0.13 0.12 =(0.6948-0.20)/ 0.6948 = 0.712. beantwortet hier die Frage: Um wie viel besser ist die tatsächliche Übereinstimmung gegenüber ‚zufälliger‘ Übereinstimmung: 71.2 % 1. Beurteiler Die reale Übereinstimmung könnte teils auch zufällig sein. Durch wird die über zufällige Gleichheiten hinausgehende Übereinstimmung gemessen 5 1. Beurteiler 1. Beurteiler Übereinstimmung zweier Merkmale Beispiel: Zwei Beurteiler klassifizieren 100 Spielsituation von Kindern danach, ob die Situation * Die Untersuchung der Übereinstimmung zwei- sehr kooperativ(1), kooperativ(2), indifferent(3), kompetitiv(4) oder aggressiv kompetitiv(5) ist. Bei Übereinstimmung der beiden Beurteiler ist jede verschieden klassifizierte Situation ein Fehler. er Merkmale setzt voDie Übereinstimmungsaussage kann in die Form einer Tabelle der Fehlergewichte gebracht werraus, dass die Auspräden: Gemeinsame Anteile gungen der Merkmale Fehlergewichte 2. Beurteiler 2. Beurteiler gleich sind. Oft wird 1 2 3 4 5 1 2 3 4 5 etwa die Übereinstim1 0.10 0.14 0 0.02 0 0.02 1 0 1 1 1 1 2 0.10 0.15 0 0.05 0 0 2 0 1 1 1 1 mung von zwei Beurtei3 0.40 0.48 0.02 0.03 0.03 0 3 0 1 1 1 1 lern untersucht. 4 0.10 0.13 0 0 0.03 0 4 0 1 1 1 1 0.14 0.15 0.48 0.13 0.10 1 Nagl, Einführung in die Statistik * Seite 132 Zwei Beispiele sollen zeigen, wie wichtig es ist, den Fehler OHNE x bei der Beurteilung der Gleicher Übereinstimmungsanteil (bzw. glei- Übereinstimmung zu beachten. Als Beispiele soll die Beurteilerübereinstimmung in zwei Ausprägungen (1, 2) untersucht werden. In beiden Beispielen ist der Fehler MIT x = 0.20. cher Fehler MIT x) kann gemeinsame Anteile, Links: Der ÜbereinRechts: Der Überein- gemeinsame Anteile, unterschiedlich starke real real stimmungsanteil von stimmungsanteil von Übereinstimmung be1 2 1 2 0.80 ist in Anbe0.80 ist in Anbe1 0.80 0.10 0.90 tracht der Randver1 0.40 0.10 0.50 deuten, je nachdem wie tracht der Randver2 0.10 0 0.10 2 0.10 0.40 0.50 teilung nicht sehr teilung sehr hoch. groß die Randanteile 0.90 0.10 1 0.50 0.50 1 hoch. sind. Mit Hilfe des Unter Unabhängigunter Unabhängigkeit Unter Unabhängigunter Unabhängigkeit Fehlers OHNE x kann keit ist ein höherer 1 2 1 2 keit ist der Übereindiese Scheinüberein1 0.81 0.09 0.90 Übereinstimmungs1 0.25 0.25 0.50 stimmungsanteil nur 2 0.09 0.01 0.10 anteil zu erwarten 2 0.25 0.25 0.50 stimmung korrigiert 0.50. 0.90 0.10 1 0.50 0.50 1 (F. OHNE x = 0.18) (F. OHNE x = 0.50) werden. =(0.18-0.20)/0.18= -0.1111 =(0.50-0.20)/0.50= 0.60 (sehr klein, sogar negativ) (recht groß) Asymmetrie zweier Merkmale Beispiel: Die Ausbildung des Vaters bzw. der Mutter (bei den ersten 20 UEen der Studentenunter* Bei vergleichbaren, suchung) gibt Hinweise auf das Heiratsverhalten der Elterngeneration. ordinalen Merkmalen Die Aussage ‚Männer heiraten keine Frauen, die besser ausgebildet sind als sie selbst‘ induziert kann die Fragestellung folgende Fehlergewichte. Gemeinsame Anteile Fehlergewichte-Tabelle untersucht werden, Bildung, Mutter Bildung, Mutter inwiefern das y-MerkVS hS Abi+ VS hS Abi+ mal größer ist als das x- Bildung Bildung VS 0.40 0.45 0.05 0 VS 0 1 1 Vater hS 0.15 0.10 0.25 0 Vater hS 0 0 1 Merkmal (bzw. umgeAbi+ 0 0.15 0.15 0.30 Abi+ 0 0 0 kehrt). 0.45 0.30 0.15 1 Der Fehler MIT x für die Aussage = 0.05 (=0.05+0+0) Der Fehler OHNE x für die Aussage = (0.30*0.45+0.15*0.45+0.15*0.25)= 0.24 (wenn x und y unabhängig sind). =1-(0.05/0.24)= 0.792. Die Aussage ‚Männer heiraten keine Frauen, die besser ausgebildet sind als sie selbst‘ reduziert den Prädiktionsfehler um 79.2% bei realer Kenntnis von x (gegenüber Zufallskenntnis von x). Logische Aussagen (speziell Konditional- und Bikonditionalaussage) * * Alle logischen Aussagen können als Prädiktionsregeln verwendet werden. Die Wahrheitstafeln der Aussagen sind die Fehlerzellen. Vor allem die Konditionalaussage (wenn, dann) wird oft verwendet. Sie hat nur eine Fehlerzelle. Die Bikonditionalaussage (‚wenn und nur wenn, dann‘ oder auch ‚dann und nur dann, wenn‘) verbindet zwei Konditionalaussagen und hat daher zwei Fehlerzellen. Beispiel: Die Aussage ‚Wenn jemand artig ist, dann wird er belohnt‘ (inklusive entsprechender stilistischer Umformulierungen) kann in die beiden Teilaussagen ‚jemand ist artig‘ (=a) und ‚jemand wird belohnt‘(=b) zerlegt werden. Werden die beiden Teilaussagen durch den Konditionalkonnektor () verbunden, ist das die logisch formale Darstellung der obigen Aussage: a b. Die Wahrheitstafel in Kreuztabellenform definiert die Wahrheitstafel Falsch- und Wahrwerte der zusammengesetzten Aussage: a b. b b (a bedeutet die Verneinung von a). W W a a F W Bitte BEACHTEN: Nur eine Konstellation (a b) ist falsch, wenn die Aussage a b gelten soll; d.h. nur wenn jemand artig war und nicht belohnt wurde, gilt die Aussage a b als widerlegt (in der umgangssprachlichen Verwendung wird der ‚wenn, dann‘Aussage oft andere Bedeutung beigemessen). z.B. Die Fehlergewichte entsprechen 1für die F-Zellen der Wahrheitstafel: Fy(MIT x)=0.10. Fy(OHNE x) = 0.40*0.50 = 0.20. =1-(0.10/0.20)= 0.50. D.h. wiederum 50% Verbesserung gegenüber purer Präzision. ggg Gem. Anteile pij b b a a 0.30 0.10 0.20 0.40 F.-gewichte ij b b 0 1 0 0 Beispiel: Die Aussage ‚Jemand wird dann und nur dann belohnt, wenn jemand artig ist‘ (inklusive entsprechender stilistischer Umformulierungen) wird aus den beiden Komponenten a und b durch den Bikonditionalkonnektor () verbunden dargestellt ab. Wahrheitstafel Diese Aussage kann durch zwei Konstellationen widerlegt b b werden: (a b) bzw. (a b). Diese Aussage entspricht W F a eher der umgangssprachlichen Verwendung der ‚wenn, dann‘a F W Aussage. z.B. Die Fehlergewichte entsprechen 1für die F-Zellen der Wahrheitstafel: Fy(MIT x)=0.10+0.20=0.30. Fy(OHNE x) = 0.40*0.50 + 0.60*0.50= 0.20+0.30=0.50. =1-(0.30/0.50)= 0.40. D.h. 40% Verbesserung gegenüber Präzision. Gem. Anteile pij b b a a ggg 0.30 0.10 0.20 0.40 F.-gewichte ij b b 0 1 1 0 Nagl, Einführung in die Statistik Seite 133 Unterschiedliche Gewichtung der Fehler (gewichtetes ) Bisher wurden die Fehlergewichte jeweils als 0 bzw. 1 definiert. Vor allem bei ordinalen oder intervallskalierten Merkmalen können Fehler unterschiedlich stark gewichtet werden (J. COHEN(1969). Diese Erweiterung wurde auch von HILDENBRANDT, ROSENTHAL u. LAING (1975) eingeführt. Fehlergewichte 2. Beurteiler 1 2 3 4 1 0 1 2 3 2 0 1 1 2 3 0 2 1 1 4 0 3 2 1 5 4 3 2 1 5 4 3 2 1 0 1. Beurteiler Die Fehlergewichte können wiederum als Fehlergewichtstabelle (bzw. FehlergewichteMatrix) dargestellt werden 1. Beurteiler Lineare Gewichte bei Beurteilerübereinstimmung für mindest ordinale Merkmale Beispiel wie oben: Zwei Beurteiler klassifizieren 100 Spielsituation von Kindern danach, ob die * Der Fehler wird linear Situation sehr kooperativ(1), kooperativ(2), indifferent(3), kompetitiv(4) oder aggressiv kompetihöher gewichtet bei tiv(5) ist. größerer Abweichung. Bei gleicher Beurteilung beider Experten ist das Fehlergewicht 0, bei Abweichung um eine PositiSeien i bzw. j die Werte, on 1 usw. dann sei: ij abs(i j) Gemeinsame Anteile * Fehlergewichte 2. Beurteiler 1 2 3 4 1 0.10 0 0.04 0 2 0.10 0 0.05 0 3 0.40 0.04 0.03 0.03 4 0.10 0 0 0.03 5 0 0 0 0 5 0.08 0 0 0 0.10 Fy(MIT x)=0.30. Entsprechend wird mit den gleichen Gewichten der Fehler OHNE x mit Hilfe der unter Unabhängigkeit erwarteten Anteile berechnet: Fy(OHNE x) =1.1824. =1- (0.30/1.1824)= 0.746 4 5 9 16 4 9 1 4 0 1 1 0 1. Beurteiler 1. Beurteiler Quadratische Fehler-Gewichte für mindest intervallskalierte Merkmale Beispiel: Obwohl im obigen Beispiel die Merkmale nicht Intervallskaliert sind, wird die mit * Der Fehler wird quadratisch höher gewichtet quadratischen Gewichten zu Demonstrationszwecken für die obigen Daten berechnet. Fehlergewichte Gemeinsame Anteile * Fehlergewichte bei größerer Abwei2. Beurteiler 2. Beurteiler chung. Seien i bzw. j 1 2 3 4 5 1 2 3 4 5 1 0 1 4 9 16 1 0.10 0 0.08 0 0.32 die Werte, dann 2 0 1 1 4 9 2 0.10 0 0.05 0 0 sei: ij (i j) 2 3 0 4 1 1 4 3 0.40 0.08 0.03 0.03 0 4 5 0 0 0 0 0.03 0 0.10 0 0 0.10 Fy(MIT x)=0.62. Entsprechend wird mit den gleichen Gewichten der Fehler OHNE x berechnet: Fy(OHNE x) =2.46. =1- (0.62/2.46)= 0.748 4.5.3 Stichprobeneigenschaften der PRE-Maße Die Stichprobeneigenschaften können unter unterschiedlichen Annahmen des Ziehens von Stichproben betrachtet werden. Hier soll der Fall betrachtet werden, eine Stichprobe der Größe n aus einer Population mit (I*J)Konstellation zu ziehen. In diesem Fall haben die (I*J) Häufigkeiten selbst eine Multinomial-Verteilung, (Parameter sind die (I*J) Populationsanteile). Die Eigenschaften für die Schätzung der PRE-Maße können nur für großes n betrachtet werden. Die PRE-Maße können konsistent via Maximum-Likelihood-Methode geschätzt werden (siehe GOODMAN & KRUSKAL (1963, 1972). Die Schätzer sind nicht erwartungstreu, sondern werden nur bei großem n erwartungstreu (asymptotisch erwartungstreu). Für großes n (mindestens 30) sind die PRE-Maße normalverteilt. Der approximative Erwartungswert strebt gegen das PRE-Maß der Population. Die Formeln für die Berechnung Varianzen der Stichproben-PRE-Maße werden in der nachfolgenden Tabelle zusammengestellt. Bemerkung: Da die Maße für die Stichprobe selbst schon mit griechischen Buchstaben abgekürzt wurden, ist die Gefahr für Verwechslungen zwischen Populations- und Stichprobenmaßzahlen in den Formeln vorhanden. Die Varianz des Schätzers für ein PRE-Maß (griechischer Buchstabe jeweils mit Dach) ist zu berechnen. Dabei gilt jeweils folgendes: Für die Varianz-Formeln selbst sollten die PopulationsMaßzahlen (PRE-Maße, gemeinsame und Randanteile) bekannt sein. Bei der Berechnung der Varianz werden aber die Populationswerte durch die jeweiligen Schätzwerte (PRE-Maße, gemeinsame und Randanteile in der Stichprobe) ersetzt. In den Beispielen wird daher nicht unterschieden zwischen Populations- und Stichprobenwerten (übrigens ist das n im folgenden Beispiel zu klein; zu Übungszwecken aber vorteilhaft). Nagl, Einführung in die Statistik Seite 134 Varianzformeln für PRE-Maße Varianz für lambda der Stichprobe: Var( ̂ ) Var( ̂ ) = 1n1 12 imi m 2 imi I(mmi ) , i i wobei: m ist der Index, für den die Zeilenrandanteile maximal ist, d. h. m max( j ) , j mi ist jeweils für die i. Zeile jener Index, für den in der i. Zeile der gem. Anteil maximal ist, d.h. im max( ij ) i Varianz für das tau der Stichprobe: Var( ̂ ) j 1 m mi I ( m mi ) 0 sonst Fy (OHNEx) 1 max( j ) Var( ̂ ) = 2ij Zudem gilt: I 2 3 0.20 0.10 0.70 0.10 0.20 0.30 im I( m mi ) 0.40 * 1 0.20 * 1 0.20 * 0 0.60 i i I 2 J Fy (OHNEx) 1 2 j j1 i 0.09 0.80 0.70 2*0.60 =0.24691358 ij =1-(0.49+0.09)=0.42. =0.365 (siehe oben) J bi , mit b i i2s i s 1 i 1 0 Std( ̂ ) = Var (ˆ ) 0.497 2 I J 2 I J a ij ij a ijij , i 1j1 i 1j1 a ij 2 j (1 ) =1 =2 =1 im 0.40 0.20 0.20 0.80 i i 9 wobei: m2 m3 m = 1- (0.2/ 0.3)=1/3 m =0.70 Var( ̂ ) = 2 / 3 1 j 1 1 n 1 2 Beispiel: Vaterausbildung und Angst vor Prüfungen. n=10. Anstelle der Populationsparameter werden die Stichprobenschätzungen I(m=mi) j 1 2 eingesetzt. 1 0.40 0 Fy (OHNEx) 0.30 m1 =1 1 J a ij ij 1 (1 )( 2) i 1 j1 i J a ij ij -0.003175 i 1 j1 Pro Zeile wird ein bi berechnet b1=0.402/ 0.402+02/ 0.402=1 b2=0.202/ 0.302+0.102/0.302=5/ 9. b3=0.102/ 0.302+0.202/0.302=5/ 9. 2 0 0.10 0.20 0.30 j aij i j 1 1 0.40 2 0.20 3 0.10 0.70 1 2 3 1 1/9 -1/9 7/9 2 -1.38 -0.27 0.40 Als Beispiel für ein a-Element: a21= -1.4 (0.635)+(2*0.20/0.30 - 5/9) =-1/9 Var( ̂ ) = 1 1 2 0.1067( 0.003)2 =0.0672 9 0.42 Std( ̂ ) = Var ( ˆ ) 0.497 Varianz für Pru (= ̂ ) der Stichprobe: Var( ̂ ) I J I J Var( ̂ ) = n11 12 a ij2 ij a ijij , i 1j1 i 1j1 2 wobei: Varianz für kappa der Stichprobe: Var( ̂ ) ij i J a ij ( 1) 1ln j ln Fy ( OHNEx) ln(2) j ln j j1 I a ij ij (1 )(c i d j ) Varianz für das StichprobenKappa: Var0( ̂ ) unter Geltung der Unabhängigkeit zwischen x und y I J Zudem gilt: a ij ij 1 i 1 j1 Unter Unabhängigkeit gilt für die Population: ij=ij und =0. Einsetzen in die obige Formel und Vereinfachen liefert: Var0( ̂ ) = wobei Std( ̂ )= Var ( ˆ ) 0.2037 Fehlergewichte ij pi xi ja nein VS hS Abi+ i Fy (OHNEx) iji j 1 1 2 Var( ̂ )= 1 0.5302(0.3751) 0.0415. 9 0.6112 c i ij j und d j ij i i j 2 0.128 -0.971 -0.278 i 1 j1 j i 1 2 3 1 -0.402 -0.808 -1.501 J 2 I J I J Var( ̂ )= n11 12 a ij2 ij a ijij , i 1j1 i 1 j 1 j aij a ij ij - 1 Zudem gilt: wobei: Gemeinsame Anteile(siehe oben). Bereits oben berechnet: Stichproben-Pru (= ̂ )=0.375. 0.611. I J 2 I c 2 J d 2 ij i j i i j j i 1 j1 i 1 j1 , 1 2 ci , dj und wie oben n 1 pj 0 0 1 0.70 1 0 0 0.30 dj 0.30 0.40 0.40 0.30 0.30 Var( ̂ )= 1 1 0.8( 0.6911) 2 = 9 0.332 =0.0787 Std( ̂ ) = Var ( ˆ ) 0.286 ci Gem. Anteile pij ja nein 0.30 0 0.70 0.40 0.20 0.10 0 0.10 0.20 Mit =0.33 (schon oben berechnet) und = 0.697 aij ja nein ci 0.30 0 0.70 dj -0.551 -0.275 2.112 0.30 2.388 -0.367 -1.01 0.40 Die Varianz unter Unabhängigkeit der beiden Merkmale ist meist größer als die Varianz ohne Unabhängigkeitsannahme 1 1 0.330.1110.183 2 0.33 Var0( ̂ ) = =0.1478 9 Std0( ̂ ) = Var0 ( ˆ ) 0.3845 Nagl, Einführung in die Statistik Seite 135 Problem: Die Varianz kann nicht unabhängig vom Populationswert des PRE-Maßes geschätzt werden (das Populations-PRE-Maß wird zur Berechnung der Varianz benötigt). Als Ersatz für das Populations-PRE-Maß wird zwar das Stichproben-PRE-Maß verwendet; so kann das Problem für praktische Zwecke bei großem n ausreichend gut umgangen werden. Es sei aber darauf verwiesen, dass bei anderen Schätzungen der Varianzen von Maßzahlen jeweils die Populations-Maßzahl selbst nicht in die Formel mit eingeht (z. B. Schätzung der Varianz des Mittelwerts, des Regressionskoeffizienten). 4.5.3.1 Konfidenzintervalle Da die PRE-Maße asymptotisch (bei großem n) normalverteilt sind, können für alle PRE-Maße Konfidenzintervalle berechnet werden. In den folgenden Beispielen sollen das Berechnen des Konfidenzintervalls und die damit verbundenen Probleme für zwei PRE-Maße ( und ) gezeigt werden. (1-)(1-)-KI= ˆ z 1Std( ˆ ) bzw. etwas Konfidenzintervall präziser: u = ˆ z ˆ ), 1Std ( für o = min( ˆ z 1Std(ˆ ),1) kappa der StichFalls die obere Grenze größer als 1 wird, wird sie gleich 1 probe(= ̂ ) (1-)Konfidenzintervall für tau der Stichprobe(= ̂ ) Für das Beispiel (siehe oben) wurde kappa bereits berechnet: ˆ 0.697 , ebenfalls die Standardabweichung Std( ̂ ) = Var ( ˆ ) 0.286 Für =0.05 gilt: z 0.95 1.96 . Das 95%-Kon- gesetzt. Falls die obere Grenze angepasst wird, ist 1 im Konfidenzintervall enthalten. fidenzintervall ist daher: 0.697 1.96*0.286 = (0.13644, 1] (1-)-KI= ˆ z 1Std (ˆ ) bzw. etwas präziser: u = max( ˆ z 1Std (ˆ ), 0)) Für das Beispiel (siehe oben) wurde tau bereits berechnet: ˆ 0.365, ebenfalls die Standardab- o = min( ˆ z 1Std (ˆ ), 1)) Untere und obere Grenze dem minimalen bzw. maximalen tau-Wert eventuell anpassen! Der angepasste Werte ist jeweils im Konfidenzintervall enthalten weichung Std( ̂ ) = Var ( ˆ ) 0.497 Für =0.05 gilt: z 0.95 1.96 . Das 95%-Kon- fidenzintervall ist daher: 0.365 1.96* 0.497 = [0, 1] 4.5.3.2 Testen von Hypothesen Im Prinzip könnten Hypothesen bezüglich der PRE-Maße implizit mit Hilfe der Konfidenzintervalle getestet werden, indem untersucht wird, ob das hypothetisierte Populations-PRE-Maß im Konfidenzintervall liegt. Für besonders großes n mag diese Vorgehensweise ausreichen. Wegen des oben charakterisierten Problems, dass die Varianz des Stichproben-PRE-Maßes funktional vom Populations-PRE-Maß abhängt, ist zu empfehlen, bei der Berechnung der Varianz das hypothetisierte PRE-Maß in der Formel zur Berechnung der Varianz (des Stichproben-PRE-Maßes) einzusetzen. Als Populationsanteile sollen werden weiterhin die geschätzten Stichprobenanteile eingesetzt werden. Für das Testen von Hypothesen bezüglich kappa schlagen HILDENBRANDT, ROSENTHAL u. LAING (1975) vor, in bestimmten Fällen (besonders bei Hypothesen, die nicht wirklich a-priori erstellt wurden), den Test unter Voraussetzung der Unabhängigkeit der Merkmale vorzusehen. Daher wurde die Formel für die Varianz unter Unabhängigkeit in der obigen Übersicht über die Varianzen der PRE-Maße eingefügt. Übungsaufgaben (4.3) 1. Erstellen Sie die Kreuztabelle (für die Personen 17-32) der beiden Merkmale: Vater- und Mutterausbildung. Interpretieren Sie das Ergebnis. a) Berechnen Sie gemeinsame und Randanteile b) Berechnen Sie x- und y-Bedingte Anteile. Interpretieren Sie die beide Arten von bedingten Anteilen. Nagl, Einführung in die Statistik 2. Bei Mobilitätsstudien werden die Väter-Sohnpaare untersucht zur Feststellung der Mobilität zwischen zwei Generationen. Es seien folgende bedingten Anteile gefunden worden: a) b) c) d) e) f) g) h) 3. Seite 136 US 0.70 0.20 0 US. MS OS Vaterschicht Sohnschicht MS 0.20 0.60 0.40 OS 0.10 0.20 0.60 0.6 0.3 0.1 Berechnen Sie die gemeinsamen Anteile Berechnen Sie die y-Bedingten Anteile. Interpretieren Sie die x- und y-Bedingten Anteile. Welchen Bedingungen müssten die x-Bedingten Anteile entsprechen bei völliger Chancengleichheit? Berechnen Sie Lambda () Berechnen Sie Tau () Berechnen Sie Phi () und Cramers v Testen Sie die Hypothese der Unabhängigkeit (n sei=1000) Die Kreuztabelle (für die Personen 1-55) der beiden Merkmale: Vater- und Mutterausbildung ist: a) Erstellen Sie ein strukturiertes Staffeldiagramm b) Berechnen Sie PRU c) Prüfen Sie die Hypothese der Unabhängigkeit der beiden Merkmale d) Berechnen Sie Phi und Cramers v. VaterAusbildung Ausbildung der Mutter Volkshöhere Abi u. schule Schule mehr 19 6 0 8 6 0 1 8 4 Volks-S. höhere S. Abi u.m. 28 20 4 25 14 13 52 4. Was ist eine prädiktive Beziehung zwischen x und y? Welche Bedingungen müssen zusätzlich erfüllt sein, damit die prädiktive als kausale Beziehung interpretiert werden darf? 5. Berechnen Sie Kappa a) Zu den Daten der Aufgabe 9 ein kappa für die Aussage: ‚Männer heiraten nur Frauen, denen sie ausbildungsmäßig mindestens gleichwertig sind’. b) Zu den Daten der Aufgabe 8 ein kappa für die Aussage: ‚Es gibt keinen sozialen Abstieg’. c) Zu den Daten der Aufgabe 8 ein kappa für die Aussage: ‚Wenn der Vater Unterschichtler ist, ist auch der Sohn Unterschichtler . 6. Die Aussage : 'Wenn jemand in einer Gruppe einen hohen Status hat, dann akzeptiert er die Normen der Gruppe' soll auf Grund der folgenden Kreuztabelle untersucht werden: a) b) c) d) 7. Akzeptieren der Normen ja nein Welches PRE-maß ist für diese Fragestellung angemessen ? Welches sind die Fehlerzellen ? Berechnen Sie das von Ihnen vorgeschlagene PRE-maß Fehler (Ohne x)? Fehler(Mit x)? Status niedrig hoch 40 30 20 10 Die Aussage : 'Die Mutter hat die gleiche Einstellung gegenüber der Tochter wie der Vater' soll auf Grund der folgenden Untersuchungsergebnisse untersucht werden: Einstellung a) b) c) d) e) 8. Welches PRE-maß ist für diese Fragestellung angemessen ? Berechnen das von Ihnen vorgeschlagene PRE-maß. Berechnen Sie auch phi**2 und PEARSON-chi**2 Berechnen Sie LR-chi**2. Berechnen Sie PRU Mutter Vater positiv negativ positiv negativ 40 20 0 40 Die Aussage über Kampfpiloten: 'Wenn jemand als zweites Kind in der Geschwisterreihenfolge geboren wird, ist er sehr erfolgreich' soll auf Grund folgender Kreuztabelle untersucht werden: a) Berechnen Sie kappa für die obige Aussage. b) Berechnen Sie tau. c) Berechnen Sie lambda. In Geschwisterreihenfolge geboren als erster andere Position Erfolgreich nein mittel sehr 10 30 10 10 30 10 Seite 137 Anteile für die Übereinstimmung der Klassifikation durch zwei Beurteiler. Berechnen Sie ein kappa für die Übereinstimmungsaussage b) Berechnen Sie ein kappa für die gewichtete (lineare Fehler) Übereinstimmung c) Berechnen Sie ein kappa für gewichtete (quadratische Fehler) Übereinstimmung Gemeinsame Anteile a) 1. Beurteiler 1. Beurteiler Häufigkeiten 2. Beurteiler 1 2 3 4 5 in die Statistik 1 10 0 Nagl, 2 0 Einführung 2 14 2 0 10 5 0 0 15 3 2 3 40 3 0 48 4 0 0 3 10 0 13 5 0 0 9.0 Gegeben 0 10 10seien die gemeinsamen 5 12 13 50 13 12 100 1 2 3 4 5 5 1 0.10 0 0.02 0 0 0.12 2 0 0.10 0.03 0 0 0.13 2. Beurteiler 3 4 0.02 0 0.05 0 0.40 0.03 0.10 0.03 0 0 0.50 0.13 5 0.02 0 0 0 0.10 0.12 0.14 0.15 0.48 0.13 0.10 1