5. Fehler getriebenes Aufgabenlernen

Werbung

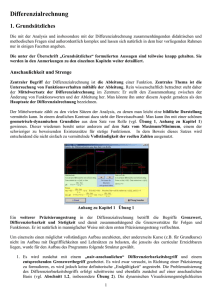

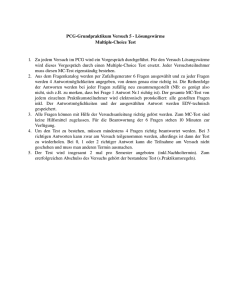

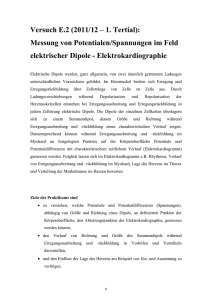

Neurokognition 5. 5.1. Seite 75 Fehler getriebenes Aufgabenlernen Überblick Die Fähigkeit zu lernen, wie man eine spezielle Aufgabe löst, ergänzt das Modelllernen. Einfach und allgemein gesagt bedeutet das Lösen einer Aufgabe, ein spezifisches Ausgabemuster zu einem Eingabemuster zu erzeugen. Die Eingabe definiert den Kontext, die Besonderheiten oder die Anforderungen der Aufgabe, und die Ausgabe ist die dazu passende Reaktion. Es wäre günstig, wenn man mit der Hebbschen CPCA-Lernregel, die für das Modelllernen entwickelt wurde, auch das Lösen von Aufgaben lernen könnte, weil dann dieselbe Regel für beide Aufgaben verwendet werden könnte. Deswegen wird im Folgenden zunächst mit Hilfe des Simulators untersucht, wie gut sie sich für diesen Zweck eignet. Es stellt sich heraus, dass sie leider nicht sehr geeignet ist. Ein besserer Lernmechanismus für diese Aufgabe ist das Fehler getriebene Lernen, als Deltaregel bezeichnet. Es verwendet die Abweichungen zwischen Ist- und SollAusgabe direkt um die Gewichte anzupassen. Diese Form des Lernens wird auch überwachtes Lernen genannt. Die Erweiterung der Deltaregel auf mehrere Schichten heißt Backpropagation, bei ihr wird der Fehler an der Ausgabe schichtenweise zurück propagiert, was die Anpassung der Gewichte erleichtert. Der ursprüngliche mathematische Mechanismus für die Implementierung des BackpropagationAlgorithmus ist zwar biologisch nicht plausibel, aber eine Variante davon, genannt GeneRec ist konsistent mit den bekannten Eigenschaften von LTP/LTD und ist allgemein vollkommen kompatibel mit der Biologie des Kortex. GeneRec benutzt zur Kommunikation der Fehlersignale bidirektionale Aktivierungspropagierung und erlaubt es Fehlersignalen, die irgendwo auftreten, das Lernen überall zu beeinflussen. 5.2. Die Verwendung des Fehlers für das Lernen: Die Deltaregel Das Ziel des Aufgabenlernens ist die Gewichte so anzupassen, dass für jedes Eingabemuster das korrekte Ausgabemuster erzeugt wird. Dazu benötigt man ein Maß dafür, wie gut das Netz die korrekten Ausgaben erzeugt, und eine Methode zur Anpassung der Gewichte, so dass sich die fehlerhaften Ausgaben verbessern. Dazu kann man den aufsummierten quadrierten Fehler (summed squared error, SSE) verwenden. Dieses Maß wird noch erweitert auf die Summe aller SSE über alle Ereignisse (Index t), so dass das gesamte Maß sich wie folgt ergibt: SSE t k ok 2 t (5.1) k tk ist der Zielwert (nicht zu verwechseln mit dem Ereignisindex t) und ok die aktuelle Ausgabeaktivierung, beide Funktionen der Zeit t. Der Wert von SSE ist 0, wenn die Ausgabe den Zielwert genau matcht, für alle Ereignisse in der Umgebung oder der Beispielmenge, größere Werte geben ein schlechteres Verhalten wieder. Das Ziel des Aufgabenlernens ist es, das Fehlermaß zu minimieren. Das Lernverfahren heißt deshalb Fehler getriebenes Lernen. SSE ist die Zielfunktion des Verfahrens. Eine Standardmethode zur Minimierung einer Funktion, die zudem sehr direkt ist, benutzt die Ableitung der Funktion nach den freien Parametern. Sie beschreibt, wie sich die Funktion ändert, wenn sich die Werte der Parameter ändern. Beim Netz bedeutet das konkret die Veränderung von SSE mit sich ändernden Gewichtswerten. Ist die Ableitung berechnet, dann können die Gewichte so Technische Universität Chemnitz Wintersemester 2006/07 Neurokognition Seite 76 angepasst werden, dass die Fehler des Netzes minimiert werden. Die Ableitung stellt deshalb die Grundlage für die Deltaregel dar. Sie ist allerdings nicht die direkte Ableitung, sondern eine modifizierte Form davon: wik t k ok si (5.2) si ist die Aktivierung der Eingabeeinheit und die Lernrate. Die Gewichte werden lokal und abhängig vom Fehler, also tk – ok, in der üblichen Weise verändert. Dieser Prozess wird Vertrauenszuweisung (credit assignment) genannt. Er ist die wichtigste berechnungstheoretische Eigenschaft der Fehler getriebenen Lernregeln. Die durch das Fehler getriebene Lernen erzeugten Repräsentationen können als Ergebnis der mehrfachen Vertrauenserfüllungs-Mechanismen betrachtet werden, d.h. eine Zusammenfassung der Synergien und Konflikte des Vertrauenszuweisungs-Prozesses über jedem Ein/Ausgabepaar der Trainingsmenge. Die Gewichte spiegeln hier die stärksten Lösungen der vorliegenden Aufgabe wider, d.h. diejenigen, die die meisten Ein/Ausgabepaare erfüllen, nicht die stärksten Korrelationen, wie das Hebbsche Lernen. 5.2.1. Ableitung der Deltaregel Die Ableitung von SSE aus Gleichung (5.1) nach dem Gewicht ergibt sich aus der Ableitung von SSE nach der Ausgabe ok mal der Ableitung von ok nach dem Gewicht, da die Ausgabe von der Gewichtsveränderung abhängt (Kettenregel): SSE SSE ok wik ok wik (5.3) Auf diese Weise kann man die Ableitungen immer weiter zurückführen, wenn das Netz mehrere Schichten hat. SSE für ein einzelnes Ereignis und ein Ein/Ausgabepaar ist die Funktion (tk – ok)2. Ihre Ableitung nach ok aus Gleichung (5.1) erfolgt nach der Kettenregel: SSE 2t k ok ok (5.4) Die Lernregel ist in dem Sinne lokal, als sie nur von einer einzelnen Ausgabe und einem einzelnen Ein/Ausgabepaar abhängt. Der Wert der Ausgabe hängt vom Gewicht und den sendenden Einheiten ab. Er ist ok si wik (5.5) i Auch hier wird nach dem Lokalitätsprinzip nur eine sendende Einheit betrachtet, die Ableitung von ok nach dem Gewicht ist also o k si wik (5.6) Setzt man die erhaltenen Werte in (5.3) ein, dann erhält man SSE 2t k o k si wik Technische Universität Chemnitz (5.7) Wintersemester 2006/07 Neurokognition Seite 77 Das Minuszeichen kann weggelassen werden, wenn man die relevante Variable, d.h. das Gewicht entgegen der Richtung der Ableitung verändert. Den Faktor 2 kann man unter die Lernrate subsumieren oder beim Fehlermaß den Faktor ½ einführen, wodurch die 2 in der Ableitung verschwindet. So entsteht die Regel von Gleichung (5.2). 5.2.2. Bias-Gewichte Die Bias-Gewichte können für das Erlernen geeigneter Repräsentationen wichtig sein, indem man z.B. Einheiten erlaubt, schwächere Eingaben zu repräsentieren. Beim Hebbschen Lernen gibt es keine direkte Möglichkeit die Bias-Gewichte zu trainieren, weil sie keine Korrelations-Information wiedergeben. Beim Fehler getriebenen Lernen ist es dagegen möglich, die Bias-Gewichte sinnvoll zu trainieren. Die übliche Art Bias-Gewichte zu trainieren ist, sie als von einer ständig aktiven Einheit kommende Gewichte zu behandeln. In Gleichung (5.2) setzt man dazu si = 1 und erhält k t k ok (5.8) Das Bias-Gewicht passt sich also immer so an, dass der Fehler vermindert wird. Entsprechend der Häufigkeit, mit der eine Einheit aktiv ist wenn sie es nicht sein sollte, wird die Veränderung des Bias-Gewichts eher negative als positiv sein, vermindert also das Bias-Gewicht und bewirkt, dass die Einheit weniger aktiv ist. Das Bias-Gewicht lernt also, irgendwelche verhältnismäßig konstanten Fehler zu korrigieren, die durch Einheiten hervorgerufen werden, die allgemein zu aktiv oder zu inaktiv sind. 5.3. Fehlerfunktionen, Gewichtsbeschränkung und Aktivierungsphasen Die Deltaregel in der abgeleiteten Form kann aus drei Gründen nicht als Aufgaben basierter Lernmechanismus verwendet werden: 1. Die Deltaregel wurde mit einer linearen Aktivierungsfunktion abgeleitet, die hier verwendeten Einheiten benutzen aber die Punktneuron-Aktivierungsfunktion. 2. Die Deltaregel entspricht nicht der biologischen Restriktion, dass Gewichte nur entweder positiv oder negativ sein können, sie erlaubt vielmehr, dass die Gewichte das Vorzeichen wechseln und jeden Wert annehmen können. 3. Die Ziel-Ausgabewerte sind von fragwürdiger biologischer und psychologischer Realität. Diese Probleme sind aber lösbar, was in den folgenden Abschnitten dargestellt wird. 5.3.1. Cross Entropie-Fehler Hier wird eine Deltaregel für die Punktneuron-Aktivierungsfunktion abgeleitet. Dazu wird als Näherung an die Punktneuron-Aktivierungsfunktion eine sigmoidale Funktion verwendet. Dann wird eine andere Fehlerfunktion definiert, mittels derer die Ableitung der sigmoidalen Aktivierungsfunktion zum Verschwinden gebracht wird, so dass dieselbe Regel übrig bleibt wie für die lineare Aktivierungsfunktion. Die neue Fehlerfunktion berücksichtigt die Sättigungseigenschaft der sigmoidalen Funktion, wodurch die Gewichtsveränderungen linear bleiben. Die neue Fehlerfunktion wird Cross Entropie (CE) genannt und ist ein distanzartiges Maß für Wahrscheinlichkeitsverteilungen. Sie ist definiert durch Technische Universität Chemnitz Wintersemester 2006/07 Neurokognition Seite 78 CE t k log ok 1 t k log 1 ok t (5.9) k Die aktuelle Ausgabeaktivierung ok und die Zielaktivierung tk müssen wahrscheinlichkeitsartige Variable im Wertebereich [0, 1] sein, wobei tk entweder 0 oder 1 ist. Die Entropie einer Variablen x ist definiert als x log x, CE repräsentiert deshalb ein Cross Entropie-Maß, weil es die Entropie über die beiden Variablen ok und tk hinweg ist, wobei sowohl die Wahrscheinlichkeit, dass beide Einheiten an sind (der erste Term), als auch die Wahrscheinlichkeit, dass beide aus sind (der zweite Term), berücksichtigt wird. CE ist null, wenn ok = tk, denn dann gilt CE = log 1 (weil tk entweder 0 oder 1 ist), und es ist größer als null, wenn ok tk. CE ist aber im Wertebereich [0, 1] nicht so gleichmäßig verteilt wie SSE, für die beiden Grenzfälle, bei denen die eine Variable den Wert 1 hat und die andere nahe bei 0 liegt (und umgekehrt), ist der Wert von CE wesentlich höher als der von SSE, vgl. Abbildung 5.1. CE berücksichtigt also den zugrunde liegenden binären Aspekt der Einheiten als Detektoren, indem es besonderes Gewicht auf die Grenzfälle legt. 3,5 3 CE SSE 2,5 Fehler 2 1,5 1 0,5 0 0,05 0,25 0,45 0,65 0,85 Ausgabeaktivierung (t = 1) Abbildung 5.1 Die Sigmoidfunktion wird als (k) geschrieben, wobei k i si wik die Nettoeingabe ist. Es ist ok k 1 1 e k (5.10) Die Ableitung von CE nach dem Gewicht erfolgt wieder nach der Kettenregel. Die Aktivierungsfunktion hängt jetzt von der Nettoeingabe ab und diese vom Gewicht, so dass gegenüber SSE noch ein Zwischenschritt hinzukommt: CE CE dok k wik ok d k wik (5.11) Die einzelnen Komponenten des Ausdrucks werden folgendermaßen berechnet: t ok CE t k 1 t k k ok ok 1 o k ok 1 ok Technische Universität Chemnitz (5.12) Wintersemester 2006/07 Neurokognition Seite 79 do k ' k o k 1 ok d k (5.13) k si wik (5.14) Eingesetzt in Gleichung (5.11) erhält man die Ableitung von CE, die identisch ist mit der Deltaregel: CE t k ok si wik (5.15) Durch die CE-Fehlerfunktion wird also in der Lernregel die sigmoidale Aktivierungsfunktion wieder eliminiert. 5.3.2. Weiche Gewichtsbeschränkung Um das unbeschränkte Wachstum der Gewichte und den Wechsel zwischen positiven und negativen Werten beim Fehler getriebenen Lernen zu verhindern, wird die Regel für die Gewichtsveränderung wie folgt definiert: wik ik 1 wik ik wik (5.16) ik ist die vom Fehler getriebenen Lernalgorithmus berechnete Gewichtsveränderung (vgl. Gleichung (5.2)) und die Klammerausdrücke [x]+ und [x] sind wie folgt definiert: x x falls x 0 0 sonst x x falls x 0 0 sonst (5.17) Es ist also wik ik 1 wik falls ik > 0 und wik ik wik falls ik < 0. Ist wik positiv, dann wird es an die 1 angenähert, falls ik > 0, und zwar in dem Maß, wie es von der 1 entfernt ist, und es wird entsprechend seiner Größe an die 0 angenähert, falls ik < 0, es bleibt also im Intervall [0, 1]. Ist aber der initiale Wert von wik negativ, dann gilt folgendes: Ist ik > 0, dann ist wik > ik, d.h. die Anhebung des Gewichts wird gegenüber dem mit der Deltaregel berechneten Wert noch gesteigert, ist ik < 0, dann ist wik = ikwik > 0, also auch in diesem Fall steigt das Gewicht an. Das heißt, von einem anfangs negativen Wert aus wird sich das Gewicht zu einem positiven Wert verändern und dann in diesem Bereich bleiben. Gewichtsbeschränkung ist aus biologischer Sicht sinnvoll, weil die synaptische Wirksamkeit begrenzt ist. Da die Synapsen ihr Vorzeichen nicht ändern, müssen sie am unteren Ende durch null beschränkt sein. Die obere Schranke ist wahrscheinlich durch Faktoren wie die maximale Menge an Neurotransmitter, die ausgeschüttet werden kann, und die maximale Dichte und Anordnung der postsynaptischen Rezeptoren beschränkt. Der Mechanismus zur weichen Gewichtsbeschränkung beruht auf der Annahme, dass diese natürlichen Schranken exponentiell langsam angenähert werden – solche exponentiellen Verläufe sind in natürlichen Systemen oft zu finden. Es gibt allerdings bis jetzt keinen empirischen Beleg dafür. Technische Universität Chemnitz Wintersemester 2006/07 Neurokognition Seite 80 5.3.3. Aktivierungsphasen beim Lernen Schließlich muss noch das Problem des Ziel-Ausgabewerts gelöst werden. Die einfachste Interpretation ist, sich den Zielwert als einen weiteren Aktivierungszustand vorzustellen, aber einen, der einer besonderen Erfahrung entspricht, entweder einer expliziten Vorgabe von einer äußeren Quelle oder einem beobachteten Ergebnis eines Ereignisses in der Welt. Der vom Netz erzeugte Aktivierungszustand ok kann in diesem Fall entweder als eine erkennbare Reaktion oder als eine interne Erwartung oder Vorhersage eines Ergebnisses betrachtet werden. Auf eine Eingabe folgen bei dieser Betrachtungsweise zwei Aktivierungszustände: ein Erwartungswert gefolgt von einem aktuellen Ergebnis oder eine erkennbare Reaktion gefolgt von einer Rückmeldung auf die Reaktion. Der Erwartungs- und der Ergebnis-Aktivierungszustand können als zwei verschiedene Phasen der Aktivierung implementiert werden, dies ist in Abbildung 5.2 illustriert. Zielwert Ausgabe Eingabe Eingabe (a) Minusphase (Erwartung) (b) Plusphase (Ergebnis) Abbildung 5.2 Die der Erwartung entsprechende Phase heißt Minusphase, die dem Ergebnis entsprechende Phase heißt Plusphase. Die Anwendung der Deltaregel erfordert bei dieser Implementierung die Differenz von Plusphase und Minusphase, das erklärt die Bedeutung der beiden Namen. Man kann die Deltaregel so umschreiben, dass sie die beiden Phasen berücksichtigt, und zwar sind jetzt Zielwert und Ausgabewert des Netzes beide Ausgaben. Sie werden durch hochgestelltes Plus- bzw. Minuszeichen unterschieden: wik ok ok si (5.18) Damit dieses Phasen basierte Lernen funktioniert, muss ein Protokoll beider Aktivierungsphasen verfügbar sein, wenn das Lernen stattfindet. Die beiden Zustände treten wahrscheinlich in rascher Folge von Erwartung und Ergebnis auf, deshalb ist es plausibel, dass ein solches Protokoll vorhanden sein muss. 5.4. Die verallgemeinerte Deltaregel: Backpropagation Die einfache Deltaregel funktioniert nur bei einschichtigen Netzen (Ein- und Ausgabeschicht), nicht bei mehrschichtigen. Sie lässt sich aber verallgemeinern auf Netze mit beliebig vielen verborgenen Schichten und wird dann Backpropagation genannt. Damit kann bei ausreichender Zahl von Schichten jede Funktion gelernt werden. Das ist dadurch möglich, dass eine Eingabe über die verborgenen Schichten hinweg so transformiert wird, dass die gewünschte Ausgabe entsteht. Technische Universität Chemnitz Wintersemester 2006/07 Neurokognition Seite 81 Die Transformationen von Eingaben über die Schichten hinweg in einem mehrschichtigen Netz kann man sich als Re-Repräsentierung der Eingabe vorstellen. Kognition beruht in starkem Maß auf der Entwicklung geeigneter Re-Repräsentationen von Eingabemustern. Repräsentationen spielen bei der Entwicklung von Algorithmen eine wichtige Rolle. Deshalb hat die Entwicklung von Lernmechanismen wie Backpropagation, die solche Re-Repräsentationen über eine Folge verborgener Schichten hinweg erzeugen können für die Neurokognition große Bedeutung. Die Lernregel wird für das Backpropagation etwas abgeändert, so dass sie für alle Schichten gilt: wij j xi (5.19) xi ist die Aktivierung der sendenden Einheit, j der Beitrag der empfangenden Einheit j zum Gesamtfehler an der Ausgabeschicht und die Lernrate. Für die Bias-Gewichte ergibt sich aus dieser Regel die folgende: j j (5.20) j hat für die Ausgabeeinheiten nach der Deltaregel folgenden Wert: k t k ok (5.21) Das heißt, k ist der Beitrag der Ausgabeeinheit k zum Gesamtfehler des Netzes. Der Beitrag der verborgenen Einheit j zum Gesamtfehler lässt sich durch den folgenden Ausdruck berechnen: j k w jk h j 1 h j k (5.22) Der erste Teil von j ist die gewichtete Summe der Fehler an der Ausgabeschicht, d.h. dieser Wert wird entsprechend berechnet wie die Aktivierung bei der Vorwärtspropagierung. Der zweite Teil von j ist die Ableitung der Aktivierungsfunktion, also ’(j). Die Multiplikation mit der Ableitung ist analog zu der Berechnung der Aktivierung bei der Vorwärtspropagierung, man kann also die Rückpropagierung des Fehlers als die Umkehrung der Vorwärtspropagierung betrachten. 5.4.1. Ableitung von Backpropagation Für die Ableitung werden die Nettoeingabe und die Aktivierungsfunktion benötigt. Die Nettoeingabe für die Einheit j ist j i si wij . Die sigmoidale Aktivierungsfunktion der Einheit ist hj = (j), die Ableitung ist ’(j) = hj(1 hj). Als Fehlerfunktion wird CE verwendet. Die Funktion CE wird mit der Kettenregel nach den Gewichten an den Kanten von den Eingabeeinheiten zu den verborgenen Einheiten abgeleitet. Das ergibt: CE wij dCE dok k dh j j k d k h j d j wij do k (5.23) Die ersten drei Teile der Summe beschreiben wie stark die Aktivierung der verborgenen Einheit j den Fehlerwert an der Ausgabeschicht beeinflussen. Die Größe des Einflusses wird durch die Gewichte an den Kanten von den verborgenen zu den Ausgabeeinheiten bestimmt. Der Ausdruck Technische Universität Chemnitz Wintersemester 2006/07 Neurokognition Seite 82 CE dCE dok k h j k dok d k h j (5.24) ist dem mit der Kettenregel ermittelten Ausdruck sehr ähnlich, aus dem die Deltaregel abgeleitet wurde. Die ersten zwei Teile der Summe sind gleich wie dort, nur der dritte Teil ist anders. Bei der Deltaregel ist er die Ableitung der Nettoeingabe in die Ausgabeeinheit nach den Gewichten, hier ist es die Ableitung nach der Aktivierung hj der sendenden Einheit j, und diese ist gleich dem Gewicht wjk, denn die Ableitung von hjwjk nach wjk ist hj und die Ableitung nach hj ist wjk. (5.24) ist also fast identisch mit der Deltaregel, nur dass am Ende nicht die Aktivierung der Eingabeeinheit, sondern ein Gewicht steht: CE dCE dok k t k ok w jk h j k dok d k h j k (5.25) Die letzten beiden Teile der Summe von (5.23) beschreiben die Ableitung der Aktivierungsfunktion nach der Nettoeingabe und die Ableitung der Nettoeingabe nach den Gewichten: h j wij h j j j wij h j 1 h j si (5.26) Das Ergebnis der gesamten Ableitung ist somit CE CE h j t k ok w jk h j 1 h j si wij h j wij k (5.27) 5.4.2. Generische rekursive Formulierung In der zuletzt abgeleiteten Form der Berechnung der Gewichtsveränderungen ist die Rekursivität von Gleichung (5.22) verschwunden. Um wieder eine solche Formulierung zu bekommen, muss der -Ausdruck wieder eingeführt werden. Die Definition von enthält nur den ersten Teil des AusCE drucks von Gleichung (5.25), und dieser entspricht der Ableitung CE k , nicht der Ableitung h j . Für die verborgenen Einheiten bekommt man also als Wert für j: j CE h j dCE dok k dh j t k ok w jk h j 1 h j k k d k h j d j do k (5.28) Man sieht an dieser Gleichung, dass man j mit Ausdrücken der k-Variablen über der darüber liegenden Schicht (hier der Ausgabeschicht) beschreiben kann: j k w jk h j 1 h j (5.29) k 5.4.3. Die biologische Unplausibilität von Backpropagation Trotz der Einfachheit und Eleganz der Backpropagation-Lernregel erscheint es als ganz unplausibel, dass so etwas wie die Gleichungen (5.19) und (5.22) im Kortex berechnet wird. Das größte Problem stellt Gleichung (5.22) dar, denn biologisch würde sie bedeuten, dass der -Wert von den Dendriten des Empfängerneurons durch die Synapse in das Axonende des Senderneurons zurück propagiert wird, dann durch das Axon zurück, multipliziert mit der Stärke der Synapse und irgendTechnische Universität Chemnitz Wintersemester 2006/07 Neurokognition Seite 83 einer Art von Ableitung, dann weiter zurück zu den Dendriten usw. Es wurde auch noch nichts gefunden, was auf der elektrischen oder chemischen Ebene des Neurons entsprechen würde. Man kann aber die Gleichungen für Backpropagation so umschreiben, dass die Fehlerpropagierung zwischen den Neuronen nur mit Hilfe von gewöhnlichen Aktivierungssignalen erfolgt. Die Idee dazu beruht auf dem Konzept der Aktivierungsphasen von Abschnitt 5.3.3, damit passt sie auch zu der psychologischen Interpretation des Lehrersignals als eines aktuellen Zustands der Erfahrung, der so etwas wie ein Ergebnis oder eine korrigierte Antwort darstellt. Man erhält einen leistungsfähigen Aufgaben basierten Lernmechanismus, der gleichzeitig biologisch plausibel ist. 5.5. Der verallgemeinerte Rückkreislauf-Algorithmus Der verallgemeinerte Rückkreislauf-Algorithmus (generalized recirculation algorithm, GeneRec) benutzt das Konzept der Aktivierungsphasen. In der Minusphase repräsentiert die Ausgabe des Netzes die Erwartung oder die Reaktion des Netzes, abhängig von dem üblichen Prozess zur Erzeugung der Aktivierung als Reaktion auf eine Eingabe. In der Plusphase ist die Umgebung dafür verantwortlich, das Ergebnis oder die Ziel-Ausgabeaktivierung zu liefern. In den folgenden Gleichungen werden die Variablen der Plusphase durch +-Hochindex und die der Minusphase durch Hochindex gekennzeichnet. Abbildung 5.3 illustriert die beiden Phasen. Externer Zielwert Aktuelle Ausgabe ok tk ... wkj wjk hj wkj wjk hj ... wji wij si ... + ... wji wij si ... ... Externe Eingabe Externe Eingabe (a) Minusphase (b) Plusphase Abbildung 5.3 In beiden Phasen erfolgt während des Einschwingprozesses bidirektionale Propagierung der Information. Der einzige Unterschied zwischen den beiden Phasen besteht darin, dass in der Minusphase die Ausgabeeinheiten vom Netz aktualisiert werden und in der Plusphase auf die externen Ergebnis/Zielwerte gesetzt werden. Insbesondere benötigen die verborgenen Einheiten die Top-down-Aktivierung in beiden Phasen um ihren Beitrag zum Ausgabefehler zu bestimmen. Die Lernregel ist für alle Einheiten gleich, sie ist im Wesentlichen die Deltaregel: wij y j y j xi (5.30) Die Empfängereinheit j hat dabei die Aktivierung yj und die Sendereinheit i die Aktivierung xi, vgl. Abbildung 5.4. Die Aktualisierungsregel für die Bias-Gewichte sind ähnlich, nur die Aktivierung der Sendereinheit ist auf 1 gesetzt: Technische Universität Chemnitz Wintersemester 2006/07 Neurokognition Seite 84 j y j y j (5.31) Aktuelle Ausgabe ok ... wjk = (tk - ok)hj hj ... wij = (hj - hj)si + si ... Externe Eingabe Abbildung 5.4 Die Phasen basierte Differenz der Aktivierungszustände der Empfängereinheit (yj+ yj) ist äquivalent zu dem Wert in der Backpropagation-Regel (Gleichung (5.19)). Das heißt, die Differenz zwischen den Aktivierungszuständen der beiden Phasen zeigt den Beitrag der Einheit zum Gesamtfehler. Die Bidirektionalität kommt dadurch zustande, dass beide Teile dieses Signals durch das ganze Netz propagiert werden, das Lernen wird durch die Berechnung der Differenz bewirkt. Die Aktivierungszustände liegen lokal an den Synapsen an, an denen die Gewichtsveränderungen vorkommen müssen. Die GeneRec-Lernregel hat einige wichtige Eigenschaften. Die erste ist, dass ein Fehlersignal, das irgendwo im Netz auftritt, verwendet werden kann um überall das Lernen zu veranlassen, wodurch es möglich ist, viele verschiedene Quellen für Fehlersignale zu verwenden. Die zweite Eigenschaft ist, dass diese Form des Lernens mit der bidirektionalen Verknüpfung kompatibel ist, die im ganzen Kortex existiert und für verschiedene wichtige Berechnungseigenschaften verantwortlich ist, wie Constraint Satisfaction, Mustervervollständigung und Attraktordynamik. Die dritte Eigenschaft bezieht sich auf die Subtraktion der Aktivierungen, die implizit die Berechnung der Ableitung der Aktivierungsfunktion realisiert, die in den Backpropagation-Gleichungen explizit erscheint. Das macht die GeneRec-Regel nicht nur biologisch plausibler, sondern erlaubt auch, jede beliebige Aktivierungsfunktion zu verwenden, z.B. die Punktneuronfunktion mit kWTA-Inhibition, ohne die Ableitung explizit bilden zu müssen. 5.5.1. Ableitung von GeneRec Die Gleichung der Variable j an der verborgenen Einheit bei Backpropagation lautete (Gleichung (5.28)): j t k ok w jk h j 1 h j k Die unplausible Fehlerpropagierungsprozedur kann dadurch vermieden werden, dass die Berechnung der Fehlerinformation multipliziert mit den Gewichten in die Berechnung der Nettoeingabe in die verborgenen Einheiten umgewandelt wird. Die bidirektionalen Verknüpfungen werden als symmetrisch angenommen, d.h. wjk = wkj. Das Ergebnis der Ableitung hängt allerdings nicht von der Symmetrie ab. Man erhält: Technische Universität Chemnitz Wintersemester 2006/07 Neurokognition Seite 85 j t k ok w jk h j 1 h j k t k ok wkj h j 1 h j k (5.32) t k wkj ok wkj h j 1 h j k k j j h j 1 h j Der Ausdruck hj(1 – hj) kann durch die Ableitung der Aktivierungsfunktion ’(j) ausgedrückt werden. Damit erhält man aus (5.32): j j j ' j (5.33) Dieses Produkt kann durch die Differenz der beiden sigmoidalen Aktivierungswerte, berechnet aus den Nettoeingaben, approximiert werden: j h j h j (5.34) Die Differenz in den Aktivierungswerten einer verborgenen Einheit ist also annähernd äquivalent zur Differenz in den Nettoeingaben mal der Neigung der Aktivierungsfunktion. Das ist in Abbildung 5.5 illustriert, wo deutlich wird, dass die Differenzen in der Y-Achse annähernd gleich den Differenzen in der X-Achse mal der Neigung der Funktion sind, die X auf Y abbildet. () Aktivierung ’() h ( )’() + h + + Nettoeingabe Abbildung 5.5 Mit Gleichung (5.30), angewandt auf die Nettoeingabe in die Eingabeeinheit i, erhält man: wij j si h j h j si (5.35) Die verborgenen Einheiten berechnen also implizit die für die Fehlerminimierung im Backpropagation benötigte Information, benutzen aber dabei nur lokal verfügbare Aktivitätssignale. GeneRec ist nur eine Approximation an die tatsächliche Backpropagation-Prozedur. In einem bidirektionalen Netz mit einer potenziell komplexen Abklingdynamik ist es nicht gesichert, dass die getrennte Propagierung der beiden Phasen von Aktivierungswerten und die Berechnung ihrer Differenz dasselbe ergibt wie die direkte Propagierung der Differenz. Allerdings zeigen Experimente, dass das Verfahren selbst bei Netzen mit mehreren verborgenen Schichten gute Approximationen liefert. Technische Universität Chemnitz Wintersemester 2006/07 Neurokognition Seite 86 5.5.2. Symmetrie, Mittelwert und CHL Gleichung (5.30) zur Berechnung der Gewichtsanpassung kann noch auf zwei Arten etwas verbessert werden. Die eine ist, die Aktualisierung der Gewichte nach der Mittelwert-Methode vorzunehmen. Dabei wird der Aktualisierungswert der sendenden Einheit aus der Minusphase, xi, durch den Mittelwert der Aktivierungen in der Minus- und Plusphase der Einheit i ersetzt: wij y j y j xi xi 2 (5.36) Bei der zweiten Art versucht man, die Nicht-Symmetrie der GeneRec-Gleichung zu verbessern. Die mathematische Ableitung der Lernregel beruht auf der Symmetrie der Gewichte, die GeneRecGleichung hat diese aber nicht, d.h. die von Einheit j berechneten Veränderungen des Gewichts von Einheit i ist nicht die gleiche wie von Einheit i berechnete für das Gewicht von der Einheit j. Selbst wenn die beiden Gewichte zu Beginn gleich sind, werden sie es bei Anwendung der GeneRecGleichung wahrscheinlich nicht bleiben. Macht man die Gewichtsveränderungen symmetrisch, dann erhalten sie die bestehende Gewichtssymmetrie. Werden sie noch mit kleinen Abschwächungen der Gewichte und/oder weicher Gewichtsbeschränkung kombiniert, dann kann die GeneRecGleichung sogar anfangs unsymmetrische Gewichte symmetrisch machen. Eine einfache Art die Symmetrie zu erhalten ist, den Durchschnitt der Gewichtsaktualisierungen für verschiedene Veränderungsrichtungen der Gewichte zu verwenden: x xi y yi 1 wij y j y j i x j x j i xi y j xi y j 2 2 2 (5.37) Der Faktor ½ wird verwendet um die Gewichtsaktualisierung in die beiden Richtungen zu mitteln, er kann in die Lernkonstante integriert werden. Die Regel ist also im Wesentlichen die Differenz der Koaktivierungen der Einheiten i und j in der Plus- und der Minusphase. Eine solche Differenzbildung könnte im Gehirn durchaus möglich sein. Nach Regel (5.37) werden die Gewichte im Netz angepasst, zusätzlich wird noch die Prozedur der weichen Gewichtsbeschränkung verwendet. Die Bias-Gewichte werden nicht nach dieser Methode verändert, sondern nach der Gleichung (5.31). Regel (5.37) ist identisch mit dem kontrastiven Hebbschen Lernalgorithmus (CHL). Sie wird so genannt, weil sie der Kontrast (die Differenz) zwischen zwei Hebb-artigen Ausdrücken ist, nämlich dem Produkt der Aktivitäten von Sender und Empfänger. Deshalb wird im Folgenden Regel (5.37) CHL-Lernregel genannt. 5.6. GeneRec aus biologischer Sicht GeneRec hat einige Eigenschaften, die seine Realisierung im Gehirn plausibel erscheinen lassen. Dazu gehört, dass die Fehler-Rückpropagierung nur mittels lokal verfügbarer Aktivierungsvariablen erfolgt, ferner die Verwendung auf der Aktivierung basierender Signale anstelle von Fehlervariablen. Es gibt aber drei Merkmale des Algorithmus, die aus biologischer Sicht möglicherweise problematisch sind: 1) Die Gewichtssymmetrie, 2) der Ursprung der Aktivierungszustände der Minusund Plusphase und 3) die Fähigkeit der Aktivierungszustände die synaptische Modifikation nach der Lernregel zu beeinflussen. 5.6.1. Gewichtssymmetrie im Kortex Es gibt drei Punkte, die die biologische Plausibilität der Gewichtssymmetrie betreffen: Technische Universität Chemnitz Wintersemester 2006/07 Neurokognition Seite 87 Bei der in Abschnitt 5.5.2 beschriebenen modifizierten Form von GeneRec (Gewichtsabschwächungen, weiche Gewichtsbeschränkung) entsteht ein Gleichgewicht der Gewichte automatisch, selbst wenn es am Anfang noch nicht vorlag. Gibt es also im Kortex so etwas wie CHL, dann werden bei Vorhandensein bidirektionaler Verknüpfung die Verbindungen symmetrische Werte annehmen. Es kann als biologisch erwiesen betrachtet werden, dass der Kortex auf der Ebene der kortikalen Areale bidirektional verknüpft ist. Diese bidirektionale Verknüpfung im großen Maßstab lässt vermuten, dass der Kortex sie unter einem gewissen evolutionären Druck ausgebildet hat. Dieser könnte durch die Verwendung der Bidirektionalität zur Durchführung eines leistungsfähigen Fehler getriebenen Lernens bedingt sein. Bidirektionale Verknüpfungen zwischen einzelnen Einheiten, für die es keine biologische Evidenz gibt, sind für das richtige Funktionieren von CHL nicht entscheidend, wenn es andere Pfade zur Propagierung von Fehlersignalen gibt. Es konnte sogar gezeigt werden, dass CHL immer noch funktionierte, wenn die Verknüpfungen asymmetrisch waren. Danach muss es Redundanz in den Verbindungen zwischen Einheiten geben, d.h. eine verborgene Einheit kann das Fehlersignal direkt von der Ausgabeeinheit erhalten oder indirekt durch Verbindungen über andere verborgene Einheiten. GeneRec erfordert also nur eine grobe bidirektionale Verknüpfung, für die es biologische Evidenz gibt. Außerdem ist der Hebbsche Lernmechanismus, der in Verbindung mit GeneRec benutzt wird, nur näherungsweise symmetrisch, aber diese Form des Lernens verbessert ganz allgemein das Lernen, d.h. der Symmetriebedarf besteht nur approximativ. 5.6.2. Phasen basierte Aktivierungen im Kortex Um zu klären, ob es so etwas wie Phasen gibt, muss geklärt werden, woher das Lehrersignal als ein Wert der Erfahrung stammen soll. In GeneRec wird das Lehrersignal als ein Zustand der Erfahrung betrachtet, der von der Ausgabe früher vorhandener Konstellationen herrührt. Die Minusphase kann als Erwartung dieser Ausgabe betrachtet werden. Ein Beispiel ist das Hören eines Satzes. Nachdem man die ersten Wörter gehört hat, entwickelt man eine Erwartung darüber, welches Wort wahrscheinlich als nächstes kommt. Der Zustand der Neuronen bei der Erzeugung dieser Erwartung ist die Minusphase. Die Erfahrung des nächsten Worts führt zu einem Folge-Aktivierungszustand, der als die Plusphase dient. Die Idee, dass das Gehirn ständig Erwartungen erzeugt und dass die Diskrepanzen zwischen diesen Erwartungen und folgenden Ausgaben für das Fehler getriebene Lernen verwendet werden kann, stammt von McClelland, der sie als psychologische Interpretation des Backpropagation-Lernens vorgeschlagen hat. Sie ist für die GeneRex/CHL-Version von Backpropagation besonders attraktiv, denn diese Version benutzt nur Aktivierungszustände und erfordert keine weiteren zusätzlichen Mechanismen zur Bereitstellung spezieller Lehrersignale außer den Auswirkungen der Erfahrung auf neuronale Aktivierungszustände mittels gewöhnlichen Aktivierungs-Propagierungsmechanismen. Abbildung 5.6 illustriert, wie diese Erwartung basierten Signale unter verschiedenen Bedingungen entstehen können. 5.6(a) zeigt den Fall, den Leute typischerweise annehmen, wenn sie an Fehler getriebenes Lernen denken, z.B. wenn ein Lerner ein Wort falsch liest und der Lehrer in korrigiert. 5.6(b) zeigt, wie ähnliche Arten von Fehlersignalen aus einer impliziten Erwartung entstehen können, z.B. darüber, wie ein Wort ausgesprochen werden sollte, gefolgt von der aktuellen Erfahrung des gehörten Worts. 5.6(c) und (d) zeigen verschiedene Kontexte, in denen diese impliziten Erwartungen erzeugt werden können, einschließlich des erwarteten Ergebnisses einer motorischen Technische Universität Chemnitz Wintersemester 2006/07 Neurokognition Seite 88 Ausgabe, mit anschließender Erfahrung des tatsächlichen Ergebnisses oder sogar der Erwartung der tatsächlichen Eingabe die man gerade erhalten hat, was zu einer Art von generativem Modell führt. Eine andere Form von implizitem Fehlersignal, die in Abbildung 5.6 nicht dargestellt ist, kann durch Nicht-Zusammenpassen verschiedener sensorischer Repräsentationen desselben Ereignisses erzeugt werden. Das heißt, jede Modalität produziert eine Erwartung darüber, wie die andere Modalität das Ereignis repräsentieren wird, und die Differenz zwischen dieser Erwartung und der Form, wie die Modalität das Ereignis tatsächlich repräsentiert, ist ein Fehlersignal mit dem beide Modalitäten trainiert werden können. ERP-Untersuchungen der elektrischen Aktivität über dem Schädel während der Durchführung von Verhaltensaufgaben weisen daraus hin, dass kortikale Aktivierungszustände Erwartungen widerspiegeln und für abweichende Ergebnisse sensitiv sind. Zum Beispiel wird die viel untersuchte P300-Welle, eine positive Welle, die ungefähr 300 msec nach dem Setzen eines Stimulus auftritt, als Maß für die Verletzung subjektiver, durch vorausgegangene Erfahrung bestimmter Erwartung betrachtet. Man könnte also P300 so interpretieren, dass sie eine Plusphasen-Welle der Aktivierung wiedergibt, die in einer relativ kurzen Zeitspanne auf die Aktivierung der Minusphasen-Erwartungen folgt. Die Existenz von P300 legt die Möglichkeit nahe, dass Neuronen im Kortex von Säugern zwei Aktivierungszustande in relativ rascher Folge erleben, der eine als Entsprechung zur Erwartung und der andere als Entsprechung zum Ergebnis. (a) Expliziter Lehrer (b) Implizite Erwartung verborgen Eingabe Ausgabe’ t t + 0.5 verborgen … Ausgabe Eingabe Ergebnis’ t+1 t t + 0.5 (c) Implizite motorische Erwartung Ergebnis’ t t + 0.5 Ergebnis t+1 (d) Implizite Rekonstruktion verborgen motorisch … verborgen … Ergebnis Eingabe Eingabe’ t t + 0.5 t+1 … Eingabe t+1 Abbildung 5.6 Eine weitere Evidenz für die Erwartungs-Ergebnis-Zustände im Kortex wird von der Aktualisierung räumlicher Repräsentationen im parietalen Kortex in Abhängigkeit von der Augenbewegung geliefert. Die Neuronen antizipieren zuerst was ihre neue Eingabecodierung sein wird, abhängig von dem motorischen Plan, und dann aktualisieren sich die Neuronen um ihre tatsächliche Eingabecodierung wiederzugeben als Ergebnis der Ausführung des motorischen Plans. Anders gesagt, diese Neuronen repräsentieren zuerst, was sie nach einer Augenbewegung „sehen“ werden bevor diese ausgeführt wird, und aktualisieren sich danach um das zu repräsentieren, was sie nach der Augenbewegung tatsächlich sehen. Weichen die antizipatorische und die tatsächliche Repräsentation voneinander ab, dann liegt eine Erwartungs-Ergebnis-Differenz vor, die für das Lernen benutzt werden kann. Technische Universität Chemnitz Wintersemester 2006/07 Neurokognition Seite 89 Einige Details beim Lernen sind mit der Theorie von der Erwartungs-Ergebnis-Differenz noch nicht gelöst. Die bisherigen Modelle nehmen an, dass die Eingabe- und die Ausgabeschicht physisch voneinander verschieden sind und dass die Ausgabe einen Minus/Plusphasen-Übergang durchläuft, während die Eingabe konstant bleibt. Obwohl das für viele Arten von Fehlersignalen eine vernünftige Annahme ist, z.B. beim Lesen eines Wortes und der Bildung einer auditorischen Erwartung seiner Aussprache, gefolgt vom Hören der tatsächlichen Aussprache, machen andere Fehlersignale die Bildung einer Erwartung in derselben Modalität wie die Eingabe, die die Erwartung ausgelöst hat, erforderlich, z.B. wenn man einen Block sieht, der gerade von einem Sims fällt, und man eine Erwartung ausbildet, was danach passiert. In diesem Fall müssen dieselben Wahrnehmungseinheiten als Eingabe- und Ausgabeeinheiten dienen. Untersuchungen deuten darauf hin, dass auch hier derselbe Lernmechanismus anwendbar ist, aber es gibt noch keine gesicherten Ergebnisse. 5.6.3. Mechanismen der synaptischen Modifikation Auf der Grundlage der Theorie der raschen Aufeinanderfolge der Minus- und Plusphasen-Aktivierungen bleibt noch zu zeigen, wie dieses Phänomen die synaptische Modifikation beeinflussen kann und zwar so, dass sie im Großen und Ganzen mit der CHL-Version von GeneRec konsistent ist. Es stellt sich heraus, dass die biologischen Mechanismen für LTP/LTD in der Lage sind, den entscheidenden Aspekt von CHL zu implementieren. Es wurde bereits gezeigt, dass diese biologischen Mechanismen mit der Hebbschen CPCA-Lernregel übereinstimmen. Deshalb kann man in dem Maß, wie CHL nicht mit CPCA konsistent ist, nicht gut argumentieren, dass die Biologie beide unterstützt. Allerdings kann man zeigen, dass die Kombination beider mit dem biologischen Befund konsistent ist. Tabelle 5.1 zeigt, inwieweit die CHL- und die CPCA-Lernregel übereinstimmen und sich unterscheiden in der Richtung der Gewichtsveränderung für vier verschiedene qualitative Werte der Produkte der Aktivierungen xi und yj in der Plus- und in der Minusphase. Da CPCA keine Phasen basierten Variablen besitzt, wird festgelegt, dass es sich in der Plusphase vollzieht, denn es sinnvoll, die Korrelationsstruktur in der Plusphase zu lernen, nicht in der Minusphase. Die Lernregeln haben in der ersten Zeile übereinstimmende Werte, dies ist der Fall wo in der Minusphase keine Aktivität vorliegt. In der zweiten Zeile unterscheiden sich die Werte, sie sagen aber immerhin keine unterschiedlichen Richtungen der Gewichtsveränderungen vorher. Man kann also sagen, dass die beiden Regeln nicht in einem Konflikt miteinander stehen, so dass sie sich auch kombinieren lassen. Plusphase 0 CPCA Kombination 0 0 0 xi+yj+ Minusphase xiyj xiyj 0 1 CHL 0 CHL + 0 xi+yj+ 1 CPCA Kombination + + + + Tabelle 5.1 Die gewichtigste Abweichung von der CPCA-Lernregel liegt im linken unteren Feld der Tabelle vor. Hier ist das Produkt der Aktivitäten in der Minusphase aktiv, während es in der Plusphase inaktiv ist (viertes Feld der unteren Zeile). CHL erfordert hier eine Gewichtsverminderung. Das Feld wird als Fehlerkorrekturfall bezeichnet, denn sie stellt eine inkorrekte Erwartung dar, die durch Fehler getriebenes Lernen unterdrückt werden muss. Anders formuliert, diese Zelle repräsentiert eine Situation, in der in der Minusphase eine starke Erwartung mit diesen Einheiten verbunden war, die in Wirklichkeit im Ergebnis (Plusphase) nicht festgestellt werden konnte. Das ist ein wichtiger Beitrag des Fehler getriebenen Lernens zum Lernen, denn er ermöglicht es dem Technische Universität Chemnitz Wintersemester 2006/07 Neurokognition Seite 90 Netz, eine falsche Erwartung oder Ausgabe zu korrigieren. In anderen Fällen ist das Hebbsche Lernen nutzbar. Zur Erklärung des Fehlerkorrekturfalls wird auf die Beziehung zwischen der Calciumionen-Konzentration innerhalb der Zelle und der Richtung der synaptischen Modifikation zurückgegriffen, vgl. Abschnitt 4.2, Abbildung 4.2. Danach gibt es zwei Schwellenwerte für die synaptische Modifikation, nämlich + und . Eine Calciumkonzentration höher als + führt zu LTP, liegt die Konzentration zwischen + und , dann führt dies zu LTD. Wegen des Zwei-SchwellenMechanismus erscheint es plausibel, dass synaptische Aktivität in der Minusphase, auf die keine ähnlich hohe oder höhere Aktivität in der Plusphase folgt, zu einer Calciumkonzentration zwischen + und führt und damit zu LTD, das für die Fehlerkorrektur benötigt wird. Anders gesagt, die Minusphasen-Aktivierungen für sich allein sind nicht dauerhaft genug um ein LTP-Niveau an Calcium aufzubauen und führen deshalb zu LTD, wenn sie in der Plusphase nicht aufrecht erhalten werden, die vermutlich länger dauert und deshalb LTP-Niveaus von Calcium aufbauen kann. Mit diesem Mechanismus kann auch ein anderer Befund interpretiert werden, nach dem Folgen von Aktivierungspulsen niedriger Frequenz LTD erzeugen. Diese Folgen bilden möglicherweise eine Folge von Aktivierungsniveaus in der Minusphase, die nicht dauerhaft genug sind um LTP zu erzeugen und deshalb zu der Art von LTD führen, die durch den Fehlerkorrekturfall vorhergesagt wird. Der Mechanismus kann auch mit einem weiteren Mechanismus interagieren, der anzeigt, wann Aktivierungen als in der Plusphase erfolgend betrachtet werden sollten, und wann deshalb Lernen, basierend auf dem Calciumniveau an diesem Punkt, erfolgen sollte. Verhält es sich so, dann muss die Minusphase nicht unbedingt als flüchtig im Verhältnis zur Plusphase angenommen werden. Es erscheint plausibel, dass ein solches Plusphasen-Signal von Dopamin produzierenden Mechanismen erzeugt wird. Die Dopamin produzierenden Zentren im Mittelhirn feuern offensichtlich, wenn eine Diskrepanz zwischen Erwartung und Ergebnis vorliegt. Dopamin kann auch die Wirksamkeit von LTP modulieren, und das ist geeignet für ein Plusphasen-artiges „Lerne jetzt“Signal. Technische Universität Chemnitz Wintersemester 2006/07