Bemerkung — Die Änderung der Koordinaten eines Punktes im

Werbung

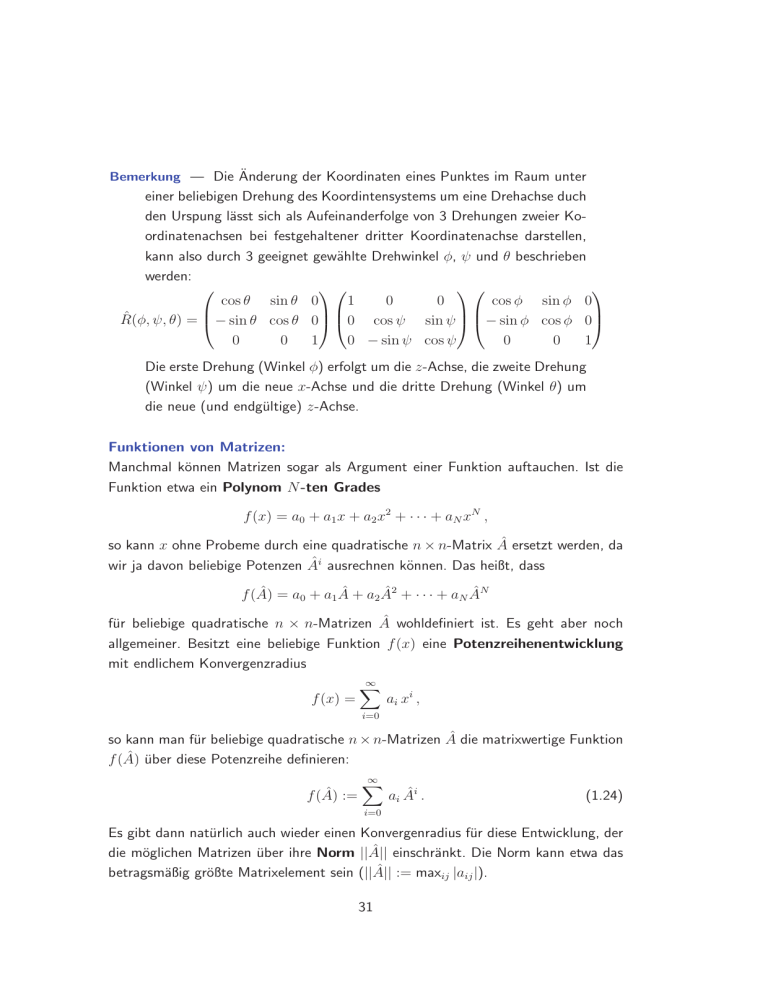

Bemerkung — Die Änderung der Koordinaten eines Punktes im Raum unter

einer beliebigen Drehung des Koordintensystems um eine Drehachse duch

den Urspung lässt sich als Aufeinanderfolge von 3 Drehungen zweier Koordinatenachsen bei festgehaltener dritter Koordinatenachse darstellen,

kann also durch 3 geeignet gewählte Drehwinkel φ, ψ und θ beschrieben

werden:

1

0

0

cos θ sin θ 0

cos φ sin φ 0

R̂(φ, ψ, θ) = − sin θ cos θ 0 0 cos ψ sin ψ − sin φ cos φ 0

0

0

1

0 − sin ψ cos ψ

0

0

1

Die erste Drehung (Winkel φ) erfolgt um die z-Achse, die zweite Drehung

(Winkel ψ) um die neue x-Achse und die dritte Drehung (Winkel θ) um

die neue (und endgültige) z-Achse.

Funktionen von Matrizen:

Manchmal können Matrizen sogar als Argument einer Funktion auftauchen. Ist die

Funktion etwa ein Polynom N -ten Grades

f (x) = a0 + a1 x + a2 x2 + · · · + aN xN ,

so kann x ohne Probeme durch eine quadratische n × n-Matrix  ersetzt werden, da

wir ja davon beliebige Potenzen Âi ausrechnen können. Das heißt, dass

f (Â) = a0 + a1 Â + a2 Â2 + · · · + aN ÂN

für beliebige quadratische n × n-Matrizen  wohldefiniert ist. Es geht aber noch

allgemeiner. Besitzt eine beliebige Funktion f (x) eine Potenzreihenentwicklung

mit endlichem Konvergenzradius

f (x) =

∞

X

ai x i ,

i=0

so kann man für beliebige quadratische n × n-Matrizen  die matrixwertige Funktion

f (Â) über diese Potenzreihe definieren:

f (Â) :=

∞

X

ai Âi .

(1.24)

i=0

Es gibt dann natürlich auch wieder einen Konvergenradius für diese Entwicklung, der

die möglichen Matrizen über ihre Norm ||Â|| einschränkt. Die Norm kann etwa das

betragsmäßig größte Matrixelement sein (||Â|| := maxij |aij |).

31

Beispiel 1.29 — Â sei eine reelle oder komplexe n × n-Matrix.

∞

X

1 i

.

e :=

i!

i=0

Â

Beim Rechnen mit Funktionen von Matrizen muss man allerdings etwas

Vorsicht walten lassen und es lassen sich die gewohnten Rechenregeln

für solche Funktionen oft nicht direkt verwenden, wenn als Argument der

Funktion eine Matrix auftaucht. Für reelle oder komplexe Zahlen a und

b hat man etwa

ea+b = ea eb = eb ea .

Ersetzt man die Zahlen durch n × n-Matrizen  und B̂, so ist im Allgemeinen

eÂ+B̂ 6=e eB̂ 6=eB̂ e !

Bemerkung — Es seien  und B̂ reelle oder komplexe n × n-Matrizen. Für

die Exponentialfunktion ihrer Summe gilt dann:

[Â, B̂] = 0

⇒

eÂ+B̂ = e eB̂ = eB̂ eÂ

und

[Â, B̂] = Ĉ ∧ [Â, Ĉ] = [B̂, Ĉ] = 0

⇒

1

eÂ+B̂ = eB̂ e 2 [Â,B̂] eB̂

Die zweite Formel ist eine der “Baker-Campbell-Hausdorff-Formeln”.

Beispiel 1.30 — Nehmen wir etwa

=

0 1

1 0

!

= σ̂1 ,

so ist Â2n = 1̂ und Â2n+1 = Â .

Damit erhalten wir

∞

X

in ϕ n n

Â

n!

n=0

ϕ2 ϕ4 ϕ6

ϕ 3 ϕ5

=

1−

+

−

± . . . 1̂ + ϕ −

+

± . . . iÂ

2!

4!

6!

3!

5!

{z

}

{z

}

|

|

cos ϕ

sin ϕ

!

cos ϕ i sin ϕ

=

.

i sin ϕ cos ϕ

eiϕÂ =

32

Das ist aber genau die komplexe Drehmatrix aus Beispiel 1.28. Ist ϕ sehr

klein, so kann die Matrixexponentialfunktion annähernd als

eiϕÂ = 1̂ + iϕÂ + O(ϕ2 )

geschrieben werden. Man nennt deshalb  auch den infinitesimalen

Generator so einer Drehung.

Ein weiterer wichtiger Begriff im Zusammenhang mit Vektorräumen ist jener der

linearen Abhängigkeit bzw. Unabhängigkeit.

Definition 1.17 — V sei ein K-Vektorraum. Die Vektoren v1 , v2 , . . . , vn heißen

linear unabhängig, wenn aus

α 1 v1 + α 2 v2 + α 3 v3 + · · · + α n vn = 0 ,

αi ∈ K ,

(1.25)

folgt, dass α1 = α2 = · · · = αn = 0. Ist das nicht der Fall, so nennt man

v1 , v2 , . . . , vn linear abhängig.

Beispiel 1.31 — Die Paulimatrizen aus Beispiel 1.26 sind linear unabhängig:

ασ̂1 + β σ̂2 + γ σ̂3 = 0̂

⇒

α = β = γ = 0.

Beispiel 1.32 — Um die lineare Unabhängigkeit der drei Vektoren

0

~a = 1 ,

1

0

~b =

2 ,

1

1

~c = 5

3

∈ R3

zu testen, müssen wir das (homogene) lineare Gleichungssystem

α~a + β~b + γ~c = ~0

in den 3 Unbekannten α, β und γ lösen. Wenn es eine eindeutige Lösung

gibt, so kann diese nur α = β = γ = 0 sein. Die lineare Unabhängigkeit

der 3 Vektoren ist also garantiert, wenn für die Determinante der Koeffizientenmatrix dieses Gleichungssystems

det(~a, ~b, ~c) 6= 0

gilt.

33

Beispiel 1.33 — Betrachten wir die Menge

C n−1 ((a, b)) = {f |f : (a, b) ⊂ R → R, f (n−1)-fach stetig differenzierbar}.

Das Nichtverschwinden der Wronski-Determinante (für alle x ∈ (a, b))

f (x)

f

(x)

f

(x)

.

.

.

f

(x)

2

3

n

1

df1 (x)

df2 (x)

dfn (x)

.

.

.

.

.

.

dx

dx

dx

6= 0

W (f1 , f2 , . . . , fn ; x) := ..

..

.

.

d(n−1) f1 (x) d(n−1) f2 (x)

d(n−1) fn (x) (n−1)

.

.

.

.

.

.

(n−1)

(n−1)

dx

dx

dx

bedeutet für die n Funktionen f1 , f2 , . . . , fn ∈ C n−1 ((a, b)), dass diese

Funktionen im Intervall (a, b) linear unabhängig sind. Umgekehrt hat lineare Abhängigkeit der Funktionen das Verschwinden der Wronski-Determinante zur Folge.

Mit dem Begriff der linearen Unabhängigkeit lässt sich eine weitere charakteristische

Eigenschaft von Matrizen, nämlich deren Rang definieren.

Definition 1.18 — Â = (aij ) ∈ Kn×m sei eine n × m-Matrix mit Matrixele-

menten aij aus dem Skalarenkörper K. Der Rang der Matrix  ist als

maximale Anzahl von linear unabhängigen Zeilen (Zeilenrang) oder Spalten (Spaltenrang) definiert. Der Zeilenrang und der Spaltenrang stimmen

überein.

Bemerkung — Für eine n × n-Matrix  mit det  6= 0 gilt Rang(Â) = n.

Ist hingegen det  = 0, so ist Rang(Â) = r < n. Der Rang erlaubt dann

den Grad der linearen Abhängigkeit der Zeilen oder Spalten festzustellen.

34