6._forschen - aktuelles [klasse

Werbung

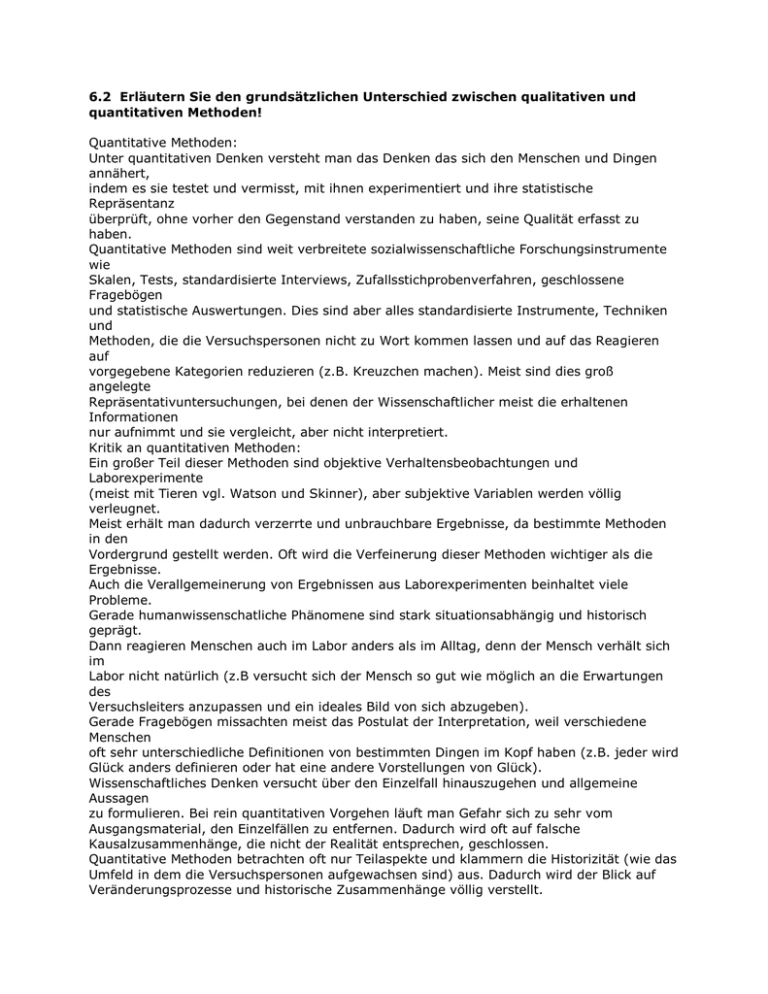

6.2 Erläutern Sie den grundsätzlichen Unterschied zwischen qualitativen und quantitativen Methoden! Quantitative Methoden: Unter quantitativen Denken versteht man das Denken das sich den Menschen und Dingen annähert, indem es sie testet und vermisst, mit ihnen experimentiert und ihre statistische Repräsentanz überprüft, ohne vorher den Gegenstand verstanden zu haben, seine Qualität erfasst zu haben. Quantitative Methoden sind weit verbreitete sozialwissenschaftliche Forschungsinstrumente wie Skalen, Tests, standardisierte Interviews, Zufallsstichprobenverfahren, geschlossene Fragebögen und statistische Auswertungen. Dies sind aber alles standardisierte Instrumente, Techniken und Methoden, die die Versuchspersonen nicht zu Wort kommen lassen und auf das Reagieren auf vorgegebene Kategorien reduzieren (z.B. Kreuzchen machen). Meist sind dies groß angelegte Repräsentativuntersuchungen, bei denen der Wissenschaftlicher meist die erhaltenen Informationen nur aufnimmt und sie vergleicht, aber nicht interpretiert. Kritik an quantitativen Methoden: Ein großer Teil dieser Methoden sind objektive Verhaltensbeobachtungen und Laborexperimente (meist mit Tieren vgl. Watson und Skinner), aber subjektive Variablen werden völlig verleugnet. Meist erhält man dadurch verzerrte und unbrauchbare Ergebnisse, da bestimmte Methoden in den Vordergrund gestellt werden. Oft wird die Verfeinerung dieser Methoden wichtiger als die Ergebnisse. Auch die Verallgemeinerung von Ergebnissen aus Laborexperimenten beinhaltet viele Probleme. Gerade humanwissenschatliche Phänomene sind stark situationsabhängig und historisch geprägt. Dann reagieren Menschen auch im Labor anders als im Alltag, denn der Mensch verhält sich im Labor nicht natürlich (z.B versucht sich der Mensch so gut wie möglich an die Erwartungen des Versuchsleiters anzupassen und ein ideales Bild von sich abzugeben). Gerade Fragebögen missachten meist das Postulat der Interpretation, weil verschiedene Menschen oft sehr unterschiedliche Definitionen von bestimmten Dingen im Kopf haben (z.B. jeder wird Glück anders definieren oder hat eine andere Vorstellungen von Glück). Wissenschaftliches Denken versucht über den Einzelfall hinauszugehen und allgemeine Aussagen zu formulieren. Bei rein quantitativen Vorgehen läuft man Gefahr sich zu sehr vom Ausgangsmaterial, den Einzelfällen zu entfernen. Dadurch wird oft auf falsche Kausalzusammenhänge, die nicht der Realität entsprechen, geschlossen. Quantitative Methoden betrachten oft nur Teilaspekte und klammern die Historizität (wie das Umfeld in dem die Versuchspersonen aufgewachsen sind) aus. Dadurch wird der Blick auf Veränderungsprozesse und historische Zusammenhänge völlig verstellt. Meist fehlt es zusätzlich an der nötigen Praxisorientierung, d.h. die Kluft zwischen Theorie und Praxis ist enorm. Zusätzlich kommt es zu einer Verzerrung der Realität durch Experimente, Fragebogenuntersuchungen und Interviewstudien, da sie in natürlich ablaufende Prozesse eingreifen. Dies hat zur Folge, dass rein quantitatives Vorgehen in der Wissenschaft stark kritisiert wird. Außerdem wird hier auf eine deduktive Geltungsbegründung zurückgegriffen. D.h. am Anfang der Untersuchung formuliert eine allgemeine Hypothese einen Zusammenhang, aus der Hypothese werden spezifische, am konkreten Gegenstand überprüfbare Sätze deduktiv abgeleitet. Wenn die spezifischen Sätze der Überprüfung standhalten, kann die allgemeine Hypothese als vorläufig bestätigt gelten; anderenfalls gilt sie ein für alle Mal widerlegt. Einzelfallanalyse kommen nur sehr selten zum Einsatz, folglich sind Rückgriffe auf Fallmaterial nach Abschluss der Datensammlung nicht mehr möglich und es kommt zu weniger genauen Ergebnisse. Auch der Aufbereitung des erhaltenen Materials kommt viel zu wenig Bedeutung zu, obwohl es sinnvoll wäre. Der Beforschte ist vor allem Datenlieferant, daher nimmt der Forscher auch keinen Dialog mit ihm auf. Qualitative Methoden: Rein quantitative Vorgehensweisen sind seit den 70er-Jahren in der BRD fast abgeschafft und qualitatives Denken setzt sich wieder mehr durch (Qualitative Wende). Aber die Wurzeln des qualitativen Denkens gehen schon auf Aristoteles (384-322 n. Chr.) zurück. Vor allem die „Qualitative Sozialforschung“ übte Kritik an den weitverbreiteten sozialwissenschaftlichen quantitativen Forschungsinstrumenten wie Skalen, Tests und Fragebögen, da diese standardisierten Instrumente Versuchspersonen nicht zu Wort kommen lassen. Durch qualitativen Methoden versucht man an die Tradition amerikanischer Feldforschung anzuknüpfen, mit offenen Befragungen und unstrukturierten Beobachtungen in natürlichen und alltäglichen Situationen. Ein Beispiel dafür ist die Biografieforschung. Hier versucht man durch einzelne ausführliche Lebenslaufanalysen relevante Erkenntnisse zu Gewinnen, und nicht durch groß angelegte Repräsentativuntersuchungen. Ein Grundgedanke der qualitativen Methoden ist das interpretative Paradigma. Der Mensch handelt nicht starr nach kulturell etablierten Rollen, Normen, Symbolen und Bedeutungen, sondern jede soziale Interaktion ist als interpretativer Prozess aufzufassen. D.h. jede soziale Situation wird vom Menschen für sich gedeutet, muss sich klar werden welche Rollen von ihm erwartet werden, ihm zu geschrieben werden und welche Perspektive er selbst hat. Wenn soziales Handeln selbst schon Interpretation ist, dann muss auch der Wissenschaftler selbst Interpret sein. Im qualitativen Ansätzen findet man ein, zu den quantitativen Vorgehen, alternatives methodisches Vorgehen. Entscheidend in der qualitativen Forschung sind die Einzelfallanalysen. Dadurch wird die Komplexität des ganzen Falles, die Zusammenhänge der Funktions- und Lebensbereiche in der Ganzheit der Person und der historische, lebensgeschichtliche Hintergrund besonders betont. Somit sind auch Rückgriffe auf Fallmaterial möglich, um gemachte Schlüsse nochmals zu überprüfen (Ist mein Vorgehen auch für den konkreten Fall X schlüssig? Stimmen meine Methoden?). Dadurch kommt man zu genaueren und tiefgreifenderen Ergebnissen als bei der quantitativen Forschung. Hier werden die Ergebnisse immer wieder auf die Einzelfälle bezogen um sich nicht zu weit vom eigentlichen Forschungsgegenstand zu entfernen. Weiter ist eine gewisse Offenheit dem Gegenstand gegenüber nötig, so dass Neufassungen, Ergänzungen und Revisionen der Hypothesen und Methoden weiter möglich bleiben. Sehr wichtig ist eine ganzheitliche Betrachtung des Gegenstands, die auch die Historizität nicht ausklammert. Denn jeder humanwissenschaftliche Gegenstand hat immer auch eine Geschichte, die sich auch verändert. Ganz entscheidend in der qualitativen Forschung ist die Feldforschung. Diese erlaubt viel näher an der Realität zu bleiben als durch Laborexperimente. Gerade durch eine hohe Flexibilität werden die Ergebnisse gegenstandsadäquater. Aber natürlich ist der Übergang zwischen Labor- und Feldforschung fließend. Entscheidend bei diesen Methoden ist ein induktives Vorgehen, d.h. aus einzelnen Beobachtungen setzen sich die ersten Zusammenhänge zusammen, die dann durch systematische weitere Beobachtungen zu erhärten versucht werden (vgl. das deduktive Vorgehen in der quantitativen Forschung). Außerdem werden die Ergebnisse bevor sie ausgewertet werden Aufbereitet, was auch bei den quantitativen Methoden keinerlei Rolle spielt. Hier dominiert ein viel spezifischeres Vorgehen, als in der quantitativen Forschung. Das Vorgehen ist viel stärker auf den jeweiligen Gegenstand bezogen und Methoden werden speziell für einen Gegenstand entwickelt oder differenziert. Hier kommen keine standardisierten Tests zur Anwendung. Der Beforschte ist hier nicht nur Objekt, sondern denkendes Subjekt. Zu den 5 Grundsätzen der qualitativen Methoden gehört: Eine stärkere Subjektbezogenheit bzw. Subjektorientierung der Forschung. Eine stärkere Betonung der Deskription, d.h. die genaue Beschreibung des Gegenstandes muss immer der Ausgangspunkt sein, bevor als 2. Schritt erklärende Konstruktionen benutzt werden können (Grundlage der Geisteswissenschaften). Eine stärkere Betonung der Interpretation der Forschungssubjekte, d.h. alles vom Menschen hervorgebrachte ist immer mit subjektiven Intentionen verbunden. Dieselbe „objektive“ beobachtbare Handlung kann sowohl für unterschiedliche Akteure, als auch für unterschiedliche Beobachter völlig andere Bedeutung haben. Die Bedeutung muss erst durch Interpretation erschlossen werden. Dies ist vor allem wichtig für verbales und schriftliches Material wie Interviews, Fragebögen und Dokumente. Als weiterer Punkt, die Forderung, Subjekte auch in ihrer natürlichen, alltäglichen Umgebung (statt im Labor) zu untersuchen, d.h. dadurch versucht man die Unschärfen der quantitativen Forschung zu verringern. Daher versucht man möglichst nahe an die alltägliche Lebenssituation anzuknüpfen. Wichtig ist die Generalisierung der Ergebnisse als Verallgemeinerungsprozess, aber dies muss im spezifischen Fall begründet werden. Es müssen Argumente angeführt werden, warum die hier gefundenen Ergebnisse auch für andere Situationen und Zeiten gelten. Es muss expliziert werden, für welche Situationen und Zeiten sie gelten. Wichtig: qualitative und quantitative Ansätze stellen keinen strikten Gegensatz dar, sondern sind gerade in der Realität eng miteinander verflochten. Auch in der qualitativen Forschung sind quantitative Methoden unumgänglich. 6.2.1 Definieren sie den Begriff „Hermeneutik“ und erläutern sie ihre Definition an einem selbstgewählten Beispiel! Hermeneutik ist ein Verfahren der Auslegung, Erklärung und Deutung von Texten, aber auch Kunstwerken. Unter Hermeneutik versteht man alle Bemühungen, Grundlagen wissenschaftlicher Interpretation zur Auslegung von Texten zu erarbeiten. Man spricht auch von der Wurzel qualitativen Denkens, von einem wissenschaftshistorischen Strang. Solche hermeneutischen Ansätze finden sich auch in der Theologie (Auslegung der Heiligen Schrift), Jura (Interpretation von Gesetzestexten) und in der Philosophie (allgemeine Interpretationslehre). Die Anfänge der Hermeneutik finden sich bei dem evangelischen Theologen Mathias Flacius Illyricus (1520-1575). Er sah den Grundsatz der Interpretation auf dem Hintergrund des Gesamtzusammenhangs. Das Entwicklungsende der Hermeneutik findet sich als „Kunstlehre des Verstehens“ und in der Hermeneutik des 20. Jahrhunderts. Der Grundgedanke dieser hermeneutischen Ansätze ist, dass Texte, wie alles vom Menschen hervorgebrachte, immer mit subjektiven Bedeutungen, mit Sinn verbunden sind. Eine Analyse der nur äußerlichen Charakteristika führt nicht weiter, wenn man nicht diesen subjektiven Sinn interpretativ herauskristallisieren kann. Dilthey stellt Hermeneutik, neben der beschreibenden Psychologie, als Grundsäule seiner Geisteswissenschaften: „Das Verstehen und Deuten ist die Methode, welche die Geisteswissenschaften erfüllt. Alle Funktionen vereinigen sich in ihm. Es enthält alle geisteswissenschaftlichen Wahrheiten in sich. An jedem Punkt öffnet das verstehen eine Welt.“ Die Erkenntnis der Interpretation ist der Hauptverdienst der Hermeneutik. Die Interpretation ist sehr wichtig, da alles vom Menschen hervorgebrachte immer mit subjektiven Intentionen verbunden ist. Aber auch das Vorverständnis beeinflusst die Interpretation (ein weiter Grundsatz der Hermeneutik), d.h. dass auch Deutungen nie voraussetzungslos möglich sind. Deshalb ist es wichtig das Vorverständnis zu Beginn der Analyse offen zulegen, am Gegenstand weiterzuentwickeln und so den Einfluss des Vorverständnisses überprüfbar zu machen. Die objektive Hermeneutik: will die hinter den subjektiven Bedeutungen stehenden objektiven Sinnstrukturen erschließen. Dazu werden mögliche und tatsächliche Bedeutungsgehalte des Materials schrittweise systematisch verglichen. Aber dies ist ein sehr aufwendiges Vorgehen und wird deshalb nur an kleinen Materialausschnitten durchgeführt. 6.2.2 Definieren sie die Begriffe „Experiment“, „Beobachtung“, „Befragung“, „Test“! Experiment: Ein Experiment ist ein wissenschaftlicher Versuch. Das Experiment gilt immer noch als Krone der Wissenschaft, als einzige Möglichkeit Kausalzusammenhänge aufzudecken. Gegen die heute übliche Form des Experimentierens – das quantitative Laborexperiment – wurde jedoch vehement Kritik vorgebracht und wird von qualitativ orientierten Vertretern in der Regel abgelehnt. Aber es gibt auch Formen qualitativer Experimente. Bereits bei Aristoteles findet sich dieses Vorgehen. Erst in den 60er-Jahren ist diese Methode völlig vom quantifizierenden, hypothesentestenden, mit Zufallsstichproben arbeitenden kontrollierten Laborexperiment verdrängt worden. Grundgedanke des qualitativen Experiments: Nicht der Test vorgefertigter Hypothesen, sondern das Aufdecken von Strukturen im Gegenstand steht im Vordergrund, dazu wird in den Untersuchungsbereich eingegriffen. Man verändert den Gegenstand, überprüft, was dann passiert und hofft darauf, dass man dadurch Einblicke in seine Struktur erhält. Wichtig für das qualitative Experiment ist nun, dass der Gegenstand dabei nicht beliebig manipuliert oder gar im Labor erst konstruiert wird. Der verändernde Eingriff soll möglichst gegenstandsadäquat vorgenommen werden. Qualitative Experimente sind immer dann sinnvoll wenn es um die Analyse von Strukturen im Gegenstandsbereich geht, die sich der einfachen Deskription (exakte und angemessene Beschreibung des Gegenstands) verschließen. Grundgedanke des ökologischen Experiments: Die Analyse fortschreitender Individuum-Umwelt-Anpassung durch systematischen Vergleich von Umweltsystemen oder ihren Strukturkomponenten. Beobachtung: Beobachten bedeutet seine Aufmerksamkeit bewusst auf etwas Bestimmtes richten. Es existieren verschiedene Arten der Beobachtung, wie die strukturierte Beobachtung ( feste Vorgehensweise, einen Leitfaden an den man sich hält) und die unstrukturierte Beobachtung ( keine feste Vorgehensweise), die alltägliche Beobachtung in natürlichen, alltäglichen Situationen und die Teilnehmende Beobachtung. Bei der Teilnehmenden Beobachtung wird am Leben des Beobachteten selbst teilgenommen. Der Beobachter steht nicht passiv-registrierend außerhalb seines Gegenstandsbereichs, sondern nimmt selbst teil an der sozialen Situation, in die der Gegenstand eingebettet ist. Er steht in direkter persönlicher Beziehung mit den Beobachteten, sammelt Daten, während er an deren natürlichen Lebenssituation partizipiert. Man verspricht sich davon, näher am Gegenstand zu sein, mehr die Innenperspektive erheben zu können. Dabei kann höchstens halb-standardisiert vorgegangen werden. Befragung: Befragen bedeutet dass man sich nach einen bestimmten Sachverhalt erkundigt. Meist können subjektive Bedeutungen nur schwer aus Beobachtungen abgeleitet werden, dazu muss das Subjekt selbst zur Sprache kommen. Dazu eignet sich die Befragung. Befragungen laufen meistens in Form von Interviews ab. Interviews sind nichts anderes als eine Befragung von Personen, eine Methode zur Erhebung von Daten, besonders gebräuchlich in der Soziologie und Psychologie. Es gibt sehr verschiedene Formen des Interviews. Offenes (vs. geschlossenes) Interview: bezieht sich auf den Freiheitsgrad des Befragten, d.h. der Befragte kann frei antworten, ohne Antwortvorgaben, er kann das formulieren was ihm in Bezug auf das Thema bedeutsam ist. Unstrukturiertes (vs. strukturiertes) bzw. unstandardisiertes (vs. standardisiertes) Interview: bezieht sich auf den Freiheitsgrad des Interviewers, d.h. der Interviewer hat keinen starren Fragenkatalog, er kann Fragen und Themen je nach Interviewsituation frei formulieren. Qualitatives (vs. quantitatives) Interview: bezieht sich auf die Auswertung des Interviewmaterials, d.h. die Auswertung geschieht mit qualitativ-interpretativen Techniken. Im speziellen gibt es folgende Formen Problemzentriertes Interview: Alle Formen der offenen halbstrukturierten Befragungen werden darunter zusammengefasst. Das Interview lässt den Befragten möglichst frei zu Wort kommen. Es ist aber zentriert auf eine gesellschaftliche Problemstellung die der Interviewer einführt, auf die er auch immer wieder zurückkommt. Die Problemstellung wurde vom Interviewer bereits vorher analysiert, er hat bestimmte Aspekte erarbeitet, die in einem Interviewleitfaden zusammengestellt sind und im Gesprächsverlauf von ihm angesprochen werden. Narratives Interview: Weniger standardisierte Variante, bei dem der Interviewpartner nicht mit standardisierten Fragen konfrontiert wird, sondern zum ganz freien Erzählen animiert wird. Damit bekommt man auch Eindruck über subjektive Bedeutungsstrukturen, die sich im freien Erzählen herausschälen. Der Interviewer greift während der Erzählung nicht ein, nur wenn der rote Faden der Geschichte verloren gehen sollte. Gruppendiskussion: Viele subjektive Bedeutungsstrukturen sind so stark in soziale Zusammenhänge eingebunden,dass sie nur in Gruppendiskussionen erhebbar sind. Hier können psychische Sperren durchbrochen werden, um auch zu kollektiven Einstellungen und Ideologien zu gelangen. Ein Beispiel: wenn man in Einzelinterviews Menschen nach ihren antisemitischen Vorurteilen befragt wird man wenig fündig. Lässt man dagegen eine Gruppe von 5 bis 15 Menschen über Juden diskutieren, so geschieht es leicht , dass sich das Gespräch hochschaukelt und so Vorurteile und Ideologien offenbart werden. Test: Ist ein Prüfverfahren, Kontrollversuch oder eine psychologische Eignungsprüfung um einen bestimmten Sachverhalt zu prüfen z.B der Intelligenztest um die Intelligenz zu testen. 6.3 Es gibt verschiedene Forschungsparadigmen im Bereich der Schulpädagogik – z.B. Lehrereffektivitätsforschung, Experten-Novizen-Theorie, Interaktionsforschung, Produkt-Prozess-Forschung, Kasuistik, Biografieforschung, Aktionsforschung usw. 6.3.1 Erläutern Sie, was ein Forschungsparadigma ist! In diesem Zusammenhang ist ein Paradigma eine festgelegte Richtung, eine Zielrichtung. Ein Forschungsparadigma ist also Forschung in eine bestimmte Richtung zu einem bestimmten Zweck, der ein bestimmtes Ziel verfolgt. 6.3.2 Charakterisieren Sie eines dieser Forschungsparadigmen in Hinblick auf 6.3.2.1 seinen Gegenstandsbereich 6.3.2.2 seine Grundannahmen 6.3.2.3 angenommene Vor- und Nachteile. Lehrereffektivitätsforschung Gegenstandsbereich: Sie beschreibt beobachtbares Lehrerverhalten, das zum Lerngewinn von Schülern beiträgt (im so genannten Prozess-Produkt-Paradigma). Es bezieht sich auf den Fachinhalt, der unumgänglich ist, wenn man die Bedingungen des Lerngewinns für Schüler besser verstehen will. Angestrebt wird aber eine genaue Beschreibung des beobachtbaren Lehrerverhaltens. Grundannahmen: Beispiele für als effektiv ermitteltes Lehrerverhalten sind: Klarheit des Ausdrucks, methodisch-didaktische Variabilität, Enthusiasmus und Kritik, die Verwendung indirekter Lehrstrategien, das Schaffen von Lerngelegenheiten, die Strukturierung des Unterrichts und die Variation des Anspruchsniveaus bei Fragen und Darbietungen. Vor- und Nachteile: Ein Vorteil ist z.B., dass untersucht wird, ob der vom Lehrer vermittelte Stoff auch bei den Schülern ankommt. Es ist wichtig, dass der Fachinhalt an den Schülern nicht vorbei geht. Ein weiterer Vorteil ist die Überprüfung der Lehrer an sich. Wenn man bei der Untersuchung seiner Effektivität feststellt, dass dieser keinen effektiven Unterricht halten kann, so kann man sich überlegen, ob der Lehrer tatsächlich eingestellt werden soll. Es würde sozusagen eine Selektion stattfinden. Diese Selektion ist aber zugleich ein Nachteil. Unerfahrene Lehrer haben automatisch geringere Chancen, da sie noch wenig Erfahrung mit der Effektivität ihres eigenen Unterrichts haben. Sie würden vielleicht zu unrecht selektiert. Ein weiterer Nachteil ist die Vernachlässigung der Schüler. Die Motivation der Schüler wird außer Acht gelassen. Ist ein Schüler total unmotiviert, kann der Unterricht noch so gut und effektiv sein, aber es kommt nichts an. Experten-Novizen-Theorie Gegenstandsbereich: Hier soll untersucht werden, welcher Lehrer Wissen und Fertigkeiten zu einer Einheit verbinden kann. Welcher nicht nur Fachwissen über sein Schulfach besitzt, sondern ebenso curriculares Wissen (was wird vom Lehrplan vorausgesetzt), Philosophie des Schulfachs (Überzeugungen über Sinn und Zweck des Fachs), pädagogisches Wissen (Lehrmethoden, Gestaltung usw.) und fachspezifisch-pädagogisches Wissen (wie wird das Fach vermittelt) hat. Das Expertenparadigma orientiert sich am relativen Lernzuwachs der Schulklassen und an der Berufserfahrung. Grundannahmen: Voraussetzung für eine erfolgreiche Berufsausübung ist ein bereichsspezifisches deklaratives und ein prozedurales Wissen. Vergleich zwischen Experten und Novizen: Experten Novizen - Vorwärtsstrategien - Rückwärtsstrategien - antizipieren aufgrund ihres Vorwissens - müssen permanent Vergleiche zwischen die Richtung der korrekten Lösung und Aufgabenstellung und Lösungsvorschlag können daher Probleme oft von der durchführen und von einer Lösungsidee Aufgabenstellung ausgehend (vorwärts) rückwärts arbeiten, um zu erkennen, ob lösen überhaupt das Ausgangsproblem damit bearbeitet werden kann - Fähigkeit, Infos aus ihrer Domäne sehr gut und schnell zu erinnern - können in vorgegebener Info offenbar sehr rasch semantisch bedeutsame Muster erkennen Vor- und Nachteile: Ein Vorteil ist, dass man Lehrer nicht nur nach ihrem Fachwissen auswählt, sondern auch danach, ob sie pädagogisch etwas können. Didaktisches Wissen ist ebenso wichtig wie fachliches Wissen und Können des Lehrers. Ein Nachteil ist wieder, dass die Unerfahrenheit von jungen Lehrern keine Rolle spielt. Die Fähigkeit, Wissen und Fertigkeiten zu verbinden, ergibt sich bei den meisten erst mit der Zeit. Dazu braucht man Berufserfahrung. Interaktionsforschung Gegenstandsbereich: Hier geht es um die Interaktion (= gegenseitige Beeinflussung von Individuen innerhalb von und zw. Gruppen und die dadurch entstehende Wechselwirkung) zwischen Lehrern und Schülern. Grundannahmen: Angenommen wird, dass sich Lehrer und Schüler gegenseitig beeinflussen. Interdependenz ist ein wichtiger Bestandteil der sozialen Interaktion. Die Interaktionspartner beeinflussen sich gegenseitig, wodurch man nicht mehr klar zwischen Ursache und Wirkung trennen kann. (z.B. Wenn ein Lehrer eine Bestrafung erklärt, so kann diese aus Sicht des Schülers genau umgekehrt sein.) Vor- und Nachteile: Ein Vorteil ist, dass man die wechselseitigen Handlungen zwischen Schülern und Lehrern beachtet. Es ist eben nicht so, dass der Lehrer vorne seinen Vortrag hält und keiner sitzt im Klassenzimmer. Es sind Schüler da, die reagieren und interagieren. Ein Nachteil sind mögliche Missverständnisse. Nachdem nicht mehr genau zwischen Ursache und Wirkung getrennt werden kann, können auch keine Missverständnisse aufgeklärt werden. Prozess-Produkt-Forschung Gegenstandsbereich: Diese Forschung entstand in dem Bemühen, Lehrer- und Schülerverhalten im Sinne einer wenn-dann Beziehung zwischen Lehrerverhalten und Schülerleistung zu erfassen. Prozesse sind die einzelnen Lehrerverhaltensweisen im Sinne eng umgrenzter Fertigkeiten. Produkte sind deren Auswirkungen auf die Schüler. Grundannahmen: Ein Lehrer unterrichtet Fachinhalte dann erfolgreich, wenn er: ein reichhaltiges Repertoire an Unterrichtsmethoden flexibel einsetzt Schüler aktiviert, sich mit Fachinhalt zu beschäftigen Tempo und Abfolge der Beschäftigung selbst kontrolliert und auf Schüler abstimmt sich klar und konsistent äußert mögliche Störungen erkennt und ihnen entgegensteuert Übergänge zwischen Themen und Methoden schafft eine optimistische Haltung hat und diese glaubhaft übermittelt Vor- und Nachteile: Ein Vorteil ist die Überprüfung der Fertigkeiten des Lehrers, d.h. es gibt verschiedene Variablen, die für einen erfolgreichen Unterricht sprechen. Nachteilig ist, dass es trotzdem nicht möglich ist, mit einem Pfad von Variablen und empirischen Methoden den guten Lehrer zu identifizieren. Es müsste also verschiedene Kombinationstypen des guten Lehrers geben. Ein weiterer Nachteil ist die Vernachlässigung der Schülerseite. Ob ein Unterricht erfolgreich ist, hängt schließlich auch von den Schülern ab. Kasuistik Gegenstandsbereich: Hier werden Einzelfälle untersucht, die sich auf Ursache und Wirkung beziehen. Es ist das Bemühen, für alle denkbaren Einzelentscheidungen immer Normen für den jeweiligen Fall aufzustellen. Grundannahmen: Jede Wirkung hat eine vernünftige Ursache. Vor- und Nachteile: Ein Vorteil bezieht sich auf die Einzelentscheidungen, die untersucht werden. Es wird immer zuerst von Einzelnen ausgegangen bevor auf Allgemeines geschlossen wird. Das verhindert zunächst, dass Wichtiges in der Verallgemeinerung untergeht. Ein Nachteil ist die Tatsache, dass man nicht für alle Einzelentscheidungen verallgemeinerbare Normen finden kann. Biografieforschung Gegenstandsbereich: Biografieforschung ist in der Soziologie ein Forschungsansatz der Qualitativen Sozialforschung und befasst sich mit der Rekonstruktion von Lebensverläufen und zugrunde liegender Sinnkonstruktionen auf der Basis biografischer Erzählungen oder persönlicher Dokumente. Die häufigsten Methoden zur Datenerhebung sind das narrative Interview und das offene Leitfadeninterview. Grundannahmen: Man kann von Einzelfällen auf die Allgemeinheit schließen. Vor- und Nachteile: Ein Vorteil ist, dass jedes Individuum persönliche Erlebnisse hat. Man muss nur Interviews durchführen um Antworten zu erhalten. Nachteile: Die Vorgehensweise, von einem Fall auf gesellschaftliche allgemeine Verhaltensund Deutungsmuster zu schließen, ist bisher nicht vollkommen ausgearbeitet. Außerdem besteht ein Problem in der Differenz zwischen der tatsächlich erlebten und der erzählten Lebensgeschichte. Der tatsächliche Verlauf der Erlebnisse kann nämlich nicht rekonstruiert werden, da er schon in der Wahrnehmung interpretiert wird. Aktionsforschung Gegenstandsbereich: In der Schule bedeutet Aktionsforschung, dass ein Wissenschaftler (als Pädagoge oder Fachdidaktiker) zusammen mit den Lehrern an einer Verbesserung des Unterrichts oder des schulischen Umfelds wirkt. Eine besondere Richtung ist die Lehrerforschung. Hier bemüht sich der Lehrer selbst, seinen Unterricht systematisch zu beschreiben und zu erforschen. Grundannahmen: Konkrete Probleme aus der Praxis werden in Angriff genommen und untersucht, um eine Verbesserung herbeizuführen. Vor- und Nachteile: Ein Vorteil ist der Ansatz in der Praxis. Eine Forschung, die nichts anderes als Bücher hervorbringt, nützt dem Schüler nichts. Außerdem übernehmen die Lehrer mit forschender Perspektive bewusst die Verantwortung für die Qualität ihrer Schule. Ein Nachteil ist, dass ein Wissenschaftler mit untersucht, der die Klasse nicht kennt und sich somit schwer damit tut, die Praxis zu verbessern.