DIE ML-DECODIERUNG

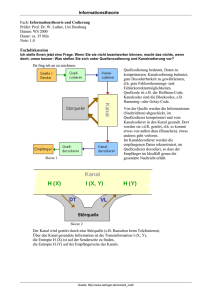

Werbung

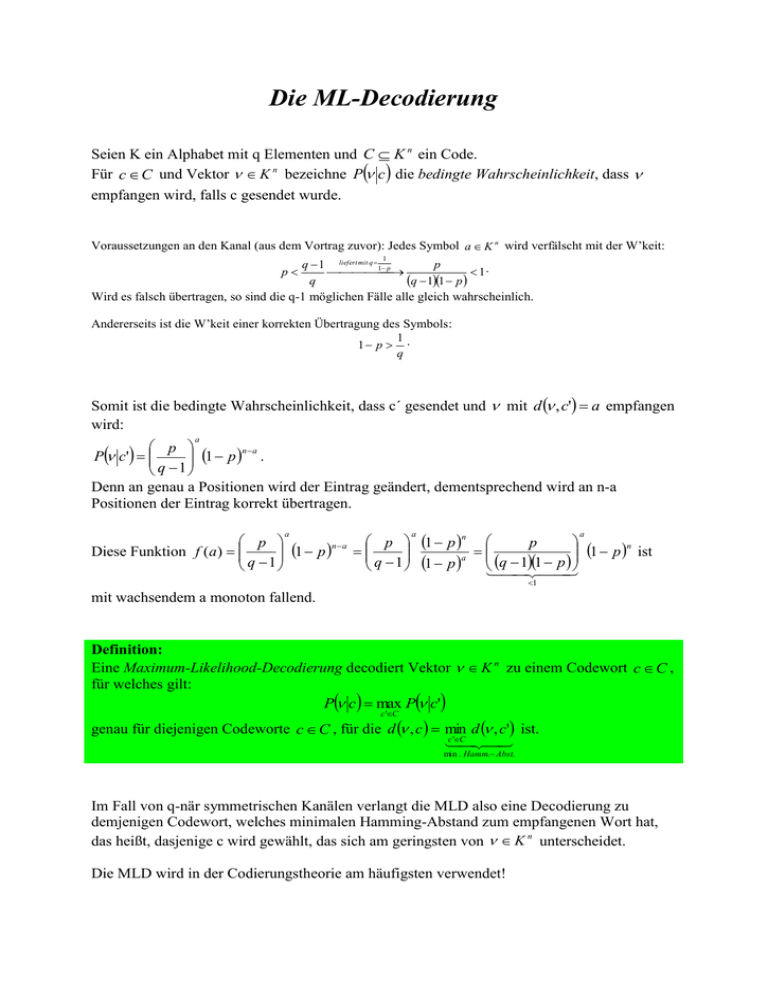

Die ML-Decodierung Seien K ein Alphabet mit q Elementen und C K n ein Code. Für c C und Vektor K n bezeichne P c die bedingte Wahrscheinlichkeit, dass empfangen wird, falls c gesendet wurde. Voraussetzungen an den Kanal (aus dem Vortrag zuvor): Jedes Symbol a K n wird verfälscht mit der W’keit: 1 q 1 liefert mit q 1 p p 1. q 11 p q Wird es falsch übertragen, so sind die q-1 möglichen Fälle alle gleich wahrscheinlich. p Andererseits ist die W’keit einer korrekten Übertragung des Symbols: 1 1 p . q Somit ist die bedingte Wahrscheinlichkeit, dass c´ gesendet und mit d , c' a empfangen wird: a p 1 p n a . P c' q 1 Denn an genau a Positionen wird der Eintrag geändert, dementsprechend wird an n-a Positionen der Eintrag korrekt übertragen. p p 1 p n p 1 p n a 1 p n ist Diese Funktion f (a ) a 11 p q 1 q 1 1 p q a a a 1 mit wachsendem a monoton fallend. Definition: Eine Maximum-Likelihood-Decodierung decodiert Vektor K n zu einem Codewort c C , für welches gilt: P c max P c' c 'C genau für diejenigen Codeworte c C , für die d , c min d , c' ist. c 'C min . Hamm. Abst. Im Fall von q-när symmetrischen Kanälen verlangt die MLD also eine Decodierung zu demjenigen Codewort, welches minimalen Hamming-Abstand zum empfangenen Wort hat, das heißt, dasjenige c wird gewählt, das sich am geringsten von K n unterscheidet. Die MLD wird in der Codierungstheorie am häufigsten verwendet! Mögliche Eigenschaften einer MLD: Die Quelle sendet ihre Buchstaben… 1. …gedächtnislos, d .h. Fehlerwahrscheinlichkeit für einen Buchstaben ist unabhängig von den zuvor gesendeten 2. …gleichverteilt Der Kanal ist… 1. …diskret, d.h. das Ausgangssignal kann nur endlich verschiedene Werte annehmen 2. …symmetrisch, d.h. die W’keit, dass ein Buchstabe, der gesendet wurde, auch richtig ankommt, ist für alle Buchstaben gleich groß 3. …gedächtnislos Wenn alle Codeworte mit der gleichen W’keit benutzt werden, liefert die Formel von Bayes: P c P c P c P Pc P Pc P C Pc Pc P P Pc Bei Gleichverteilung der Codeworte wird also das Maximum Pc in den gleichen Codeworten c C wie für P c angenommen. Bild (1) bei unkodierter Übertragung Bild (2) im Original Kanalkapazität und Informationsrate p 1 p log 2 1 p gibt an, wie viel q 1 an Information man maximal – also fehlerfrei – über einen gegebenen Kanal übertragen kann. p ist die W’keit, mit der eine Information verfälscht wird. Dies kann geschehen durch: Die Kanalkapazität q ( p) log 2 q p log 2 1. Störungen, die am Kanal Informationen verfälschen 2. gesendete Informationen, die am Kanal verloren gingen Beispielsweise kann der binäre Übertragungskanal nur zwei Arten von Informationen (0;1) annehmen: Die Kanalkapazität für q=2 vereinfacht sich so zu: 2 ( p) 1 p log 2 p 1 plog 2 1 p Die Entropiefunktion ergibt sich aus: 1 2 ( p) 1 1 p log 2 p 1 plog 2 1 p Bemerkung: Die Kanalkapazität stellt allerdings keine Übertragungsrate R dar, da keinerlei Zeitbezug (Bit/s) vorliegt. Hierzu müssen in einer zeitlichen Abfolge unterschiedliche Informationen übertragen werden. Dies ergibt eine von der Frequenz abhängige Informationsrate. Hierzu das Beispiel aus dem vorherigen Vortrag: Information wird durch k=2 Bits gegeben. Gesendet werden allerdings n=3 (6;5). k gibt Auskunft über den Anteil der gesendeten Bits, die reine Information sind. n k 2 1 2 für n=3: R ; n 3 3 5 R n kann dementsprechend als Zeitfaktor über den Mehraufwand Aufschluss geben. k n 3 3; 2,5 für n=3: R 1 k 2 R 1 Ergebnis: Die Übertragung der codierten Information dauert 1,5-, 3-, 2,5-mal so lange wie die der uncodierten. Definition: Ist C ein Code der Länge n über einem Alphabet mit q Elementen, so nennen wir log q C R RC die Informationsrate von C. n Shannons Hauptsatz der Kanalkodierung Seien 0 und 0 R q p . Dann gibt es für hinreichend großes n einen Code der Länge n über einem q-nären Alphabet mit der Rate wenigstens R, so dass die W’keit einer falschen Decodierung eines Wortes, die so genannte Restfehlerwahrscheinlichkeit, kleiner als ist. Heißt: Durch die Verwendung von geeigneten Codes kann also eine nahezu fehlerfreie Datenübertragung erreicht werden. Minimaldistanz und Fehlererkennung Definition: Sei C ein Code der Länge n über dem Alphabet K. Ist C 1 , so nennen wir d C min d (c, c' c, c' C, c c' die Minimaldistanz von C. Für C 1 setzen wir d C 0 . Ist d C d und M C , so sagen wir, dass C ein (n,M,d)-Code über K ist. Wir nennen (n,M,d) die Parameter von C. Der Quotient d/n heißt auch relative Minimaldistanz. Wie in euklidischen Räumen können wir über den Hamming-Abstand Kugeln definieren. Definition: Seien K ein Alphabet und r 0 . Für u K n definiert Br u v v K n , d u, v r die n j Kugel vom Radius r um den Mittelpunkt u K n . v v K n , d u, v j q 1 j r n j Ist K q , so gilt Br u q 1 (unabhängig vom Mittelpunkt u). j j 0 Diese Definitionen geben Auskunft über die Güte der MLD. e e c c´´ v e c´ Sei d die Minimaldistanz von C K n mit d 2e 1. Annahme: Im Kanal passieren höchstens e Fehler, d.h., wird c C gesendet, so wird ein Be c empfangen. Bedingung d 2e 1 sichert für c c' C , dass Be c Be c' 0 ist, d.h. dass die Kugeln paarweise disjunkt sind. Zwei mögliche Fälle: 1. c ist das zu nächstgelegene Codewort Der MLD liefert in der Tat das gesendete Wort d 1 Bei e treten keine Decodierfehler auf. 2 2. Das empfangene Wort liegt in der Kugel Bd 1 c mit c C Kugel Bd 1 c enthält nur c als Codewort Der MLD weiß, dass Fehler bei der Übertragung passiert sind. Definition: Sei C ein Code. a) Falls für alle c C die Kugel Bt c außer c kein weiteres Codewort enthält, heißt C tfehlererkennend. b) Falls Be c Be c' 0 ist für alle Codeworte c c' , heißt C e-fehlererkennend. Beispiele: Wiederholungscodes Kontrollcodes Paritätscheck-Code ISIN-Code EAN13-Code ISBN-Code