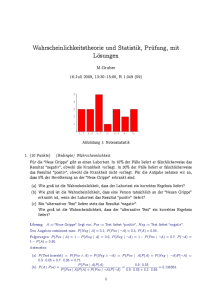

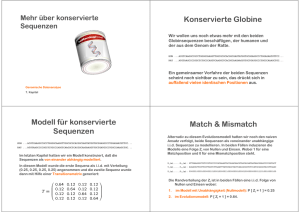

Die Aggregationsfragestellung

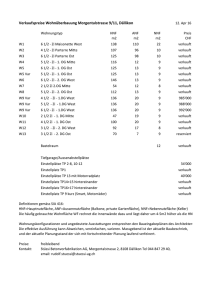

Werbung