Strukturgleichungsmodelle

Werbung

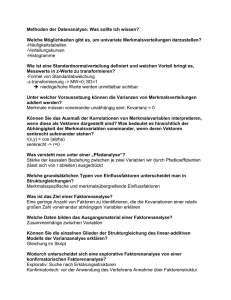

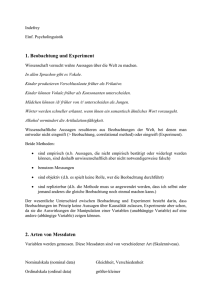

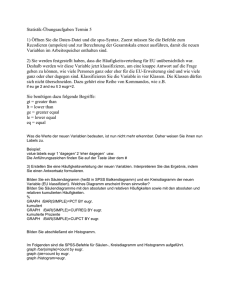

Strukturgleichungsmodelle Eine Einführung Kausalität und Korrelation • X1 ist korreliert mit X2. X1 X2 X X1 ist Ursache für X2. X X X2 ist Ursache für X1. X X1 und X2 beeinflussen sich gegenseitig. X1 und X2 werden von X3 beeinflußt. X 1 2 1 2 1 X1 X2 X3 X2 • X1 , X2 und X3 sind miteinander korreliert. X1 und X2 sind kausal für X3. X4 verursacht die Korrelation zwischen X1 und X2. X1 und X2 sind kausal für X3. X1 ist kausal für X2. X1 ist kausal für X2, X2 ist kausal für X3. .... Ein Strukturgleichungsmodell zurück Syntax, Terminologie X manifeste Variable (gemessen) X latente Variable (Konstrukt), auch: Fehler 1 Regression („kausale Beziehung“) (mit fixiertem Gewicht) Korrelation (deskriptiv) endogene (abhängige) Variablen: mindestens ein gerichteter Pfeil zeigt auf sie exogene (unabhängige) Variablen: kein gerichteter Pfeil zeigt auf sie. Exogene Variablen sind immer korrelativ verknüpft. Kein Pfeil: r=0. Messmodelle und Strukturmodell • Messmodell: Verknüpfung zwischen latenter Variable und ihren (manifesten) Indikatoren r10 r3 Verbal r4 r5 r11 Smiling 2 r12 Knowledge Grades Skills Family Analytic Quantitative Happiness r1 Aptitude Performance in Grad School r2 Social Support Laughing 2 Contentment 2 r15 Satisfaction 2 Friends r14 r13 • Strukturmodell: Verknüpfung zwischen latenten Variablen Performance in Grad School Aptitude Happiness Social Support Previous Happiness r16 Modellparameter • Diejenigen Größen, die durch das Modell festgelegt werden sollen: Alle exogenen Variablen (inkl. Fehler, Residuen) (endogene Variablen werden ja „erklärt“...) Alle (nicht fixierten) Pfade: • Regressionen (sofern kein fixiertes Gewicht dransteht) • Korrelationen (die man einzeichnet, der Rest ist auf 0 fixiert) Happiness Daten • Alle Varianzen von manifesten Variablen (Anzahl p) • Alle Kovarianzen zwischen manifesten Variablen (Anzahl p · (p – 1) / 2) • Alle Tripelvarianzen (Anzahl p · (p – 1) · (p – 2) / 6) • zusammen: p · (p + 1) / 2 Happiness Identifizierbarkeit • Anzahl Daten < Anzahl Modellparameter: unteridentifiziert Modell nicht lösbar. X + Y = 1. • Anzahl Daten = Anzahl Modellparameter: exakt identifiziert Modell lösbar, aber nicht prüfbar. X = 1. • Anzahl Daten > Anzahl Modellparameter: überidentifiziert Modell lösbar und prüfbar. X = 1 X = 2. Definitionsgleichungen • Jede endogene Variable wird per Regression erklärt: PGS = b1·A + b2·SS + b3·PH + d2 Performance in Grad School Aptitude Social Support Previous Happiness • Die Korrelation zwischen jedem denkbaren Paar exogener Variablen wird festgelegt: rr6,r16 = R1, rr7,r15 = R1, rr8,r14 = R3, rr9,f13 = R4, rr6,r7 = rr6,r8 = rr6,r9 = ... = 0. r6 Happiness d2 r7 r8 r9 r16 r15 r14 r13 Strukturgleichungen • Definitionsgleichungen für (p) manifeste Variablen auflösen, bis rechts nur noch exogene Variablen stehen. • Alle (p · (p+1) / 2) Varianzen und Kovarianzen mit Hilfe der Definitionsgleichungen „erklären“: Z = aX + bY: VZZ = a²VXX + b²VYY + 2abVXY. W = cU + dV: VZW = acVXU + adVXV + bcVYU + bdVYV. zurück Lineare Abhängigkeiten • Manchmal reichen viele Gleichungen nicht, um viele unbekannte Größen zu bestimmen: X + Y = 10. 2X + 2Y = 20. 3X + 3Y = 30. ... • Wenn alle fortführenden Pfade einer latenten Variable frei (nicht fixiert) sind, können Gewichte und Varianz gegeneinander ausgespielt werden. Previous Happiness r2 Happiness zurück Friends Smiling 1 Laughing 1 Contentment 1 Satisfaction 1 Ein einfaches Meßmodell 1 Konstrukt Messung 1 Messung 2 Messung 3 1 1 1 Fehler 1 was fehlt? Fehler 2 Fehler 3 • Identifizierbarkeit: exakt. 6 Modellparameter, 6 (Ko-)Varianzen. • Definitionsgleichungen: M1 = 1 · K + F1 M2 = a · K + F2 M3 = b · K + F3 cor(F1,F2) = cor(F1,K) = cor(F1,F3) = cor(F2,K) = cor(F2,F3) = cor(F3,K) = 0 • Strukturgleichungen VM1M1 = 1²·VKK + VF1F1 + 2·VKF1 VM2M2 = a²·VKK + VF2F2 VM3M3 = b²·VKK + VF3F3 VM1M2 = 1·a·VKK VM1M3 = 1·b·VKK VM2M3 = a·b·VKK Weitere einfache Meßmodelle 1 Konstrukt Messung 1 1 Messung 2 1 Messung 1 Messung 2 Konstrukt Messung 3 Messung 4 1 1 1 1 1 1 Fehler 1 Fehler 2 Fehler 1 Fehler 2 Fehler 3 Fehler 4 Identifikationsgleichungen 1 Konstrukt • Strukturgleichungen VM1M2 = 1·a·VKK VM1M3 = 1·b·VKK VM2M3 = a·b·VKK VM1M1 = 1²·VKK + VF1F1 VM2M2 = a²·VKK + VF2F2 VM3M3 = b²·VKK + VF3F3 Messung 1 1 Fehler 1 Messung 2 1 Fehler 2 Messung 3 1 Fehler 3 zurück • Identifikationsgleichungen umformen VKK = VM1M2VM1M3 / VM2M3 a = V M2 M3 / V M1 M3 b = V M2 M3 / V M1 M2 V F1 F1 = V M1 M1 – V M1 M2 V M1 M3 / V M2 M3 V F2 F2 = V M2 M2 – V M2 M3 V M1 M2 / V M1 M3 V F3 F3 = V M3 M3 – V M2 M3 V M1 M3 / V M1 M2 • lokal identifizierbar: Jede einzelne Unbekannte ist identifizierbar. Identifikationsgleichungen Messung 1 Messung 2 Konstrukt Messung 3 Messung 4 1 1 1 1 Fehler 1 Fehler 2 Fehler 3 Fehler 4 • 9 Unbekannte, 10 Ko/Varianzen, ... aber • nicht lokal identifizierbar: VKK ist nicht identifizierbar. Identifikationsgleichungen • dienen der Diagnostik (Identifizierbarkeit) • Die unbekannten Parameter werden anders bestimmt! • wäre ja auch zu peinlich, wenn für überbestimmte Variablen mehrere verschiedene Werte herauskommen Kovarianzmatrizen V11 V21 V22 V31 V32 V33 • Stichprobenkovarianzmatrix Vxy = <xy> – <x> <y> = (x–<x>)·(y–<y>) / n • geschätzte Populationskovarianzmatrix („beobachtete Kovarianzmatrix“) Sxy = (x–<x>)·(y–<y>) / (n–1) = Vxy · n / (n–1) • implizierte Kovarianzmatrix xy() ist eine Funktion des Vektors der unbekannten Parameter S-Gl. / I-Gl. S11 S21 S22 S31 S32 S33 Kovarianzmatrizen 11 21 22 31 32 33 • geschätzte Populationskovarianzmatrix Sxy • implizierte Kovarianzmatrix xy() • Diskrepanzfunktion F[S, ()] F[S,T] 0 F[S,T] = 0 S = T F[S,T] + F[T,U] F[S,U] • Iterativ verändern, so daß F kleiner wird. • Wenn F minimiert wurde, gilt als geschätzt. Diskrepanzfunktionen • unweighted least squares: FULS[S, ()] = Sum [Sxy – xy()]² S-Gl. / I-Gl. skaliert mit Wertebereich der manifesten Variablen • generalized least squares: FGLS[S, ()] = Sum [Sxy – xy()]² / ||S||² ist für große Stichproben df²-verteilt, mit df = m – p · (p+1) / 2 Freiheitsgraden. Hypothesenprüfung • Nullhypothese H0: S = () – diesmal nicht theoriefreie Verneinung von H1, sondern theoriekonforme Vorhersage. Grund: Verteilung bekannt, testbar. • Alternativhypothese H1: S () – theoriefreie Verneinung von H0. • -Fehler-Niveau festlegen, z. B. p = 0.05 • wenn p(²|H0) p: Modell verwerfen • wenn p(²|H0) > p: ??? Kausalität und Korrelation • X1 ist korreliert mit X2. X1 ist Ursache für X2. X2 ist Ursache für X1. e1 1 X1 und X2 beeinflussen sich gegenseitig. X1 und X2 werden von X3 beeinflußt. X1 X2 X1 X2 X1 X2 X1 X2 1 e2 X3 e1 1 X1 X2 1 e2 SGM für eine einfache Korrelation • X ist korreliert mit Y. X ist Ursache für Y. • Definitionsgleichungen: y=a+b·x+e cor(x,e) = 0 X Y X Y 1 e • Strukturgleichungen Vxx = Vxx Vyy = b²·Vxx + Vee + 2·Vxe Vxy = b·Vxx + Vxe • Identifikationsgleichungen Vxx = Vxx b = Vxy/Vxx = rxy · (Vyy/Vxx) Vee = Vyy – b²·Vxx = Vyy · (1 – rxy²)