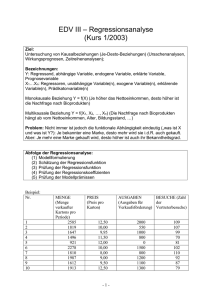

Multiple Regressionsanalyse

Werbung

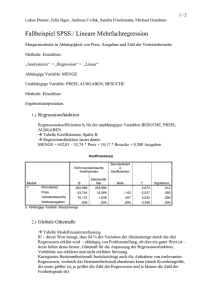

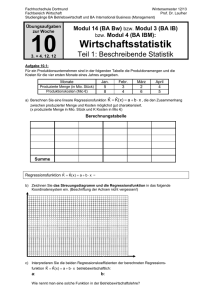

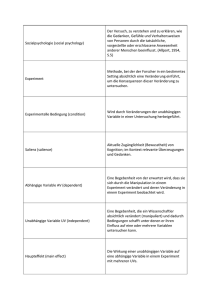

Seminar Statistische Forschungsmethoden Prof. B. Krause 16. April 2003 Multiple Regressionsanalyse Romy Rautenstrauch, Marian Gunkel Inhalt I. Einleitung – was ist das? II. Problemstellung – wozu braucht man das? III. Voraussetzungen – was braucht man? IV. Vorgehensweise – wie macht man es? Einleitung • Regressionsanalyse: – Analyse von Zusammenhängen zwischen Variablen (X,Y) – Vorhersage der Y-Werte aus X-Werten – Versuch, die Y-Werte auf die X-Werte „zurückzuführen“ • Einfache lineare RA: – Betrachtung einer Zielgröße Y und einer Einflußgröße X • Multiple lineare RA: – Betrachtung einer Zielgröße Y und mehr als einer Einflussgröße X – kann daher mehr Varianz aufklären X1 Y X2 Problemstellung • Ziel: Analyse des stochastischen Zusammenhangs zwischen einer Zielgröße Y und mehreren Einflussgrößen Xi bei verbundenen Stichproben. (Variabilität von Y durch die Variabilitäten der Xi erklären) - stochastisch – gegenseitige Abhängigkeit • Anwendungen – Ursachenanalysen: Wie stark ist der Einfluss von X auf Y? – Wirkungsanalysen: Wie verändert sich Y bei Veränderung von X? – Zeitreihenanalysen: Wie verändert sich Y im Zeitverlauf? Prognose! – Testkonstruktion: Auswahl der Items für Test Problemstellung • Vorteile: – Lineare Ansätze liefern eine hinreichend gute Anpassung an die Daten (vernünftig interpretierbar) – Lineare Ansätze sind i.d.R. mit geringem Rechenaufwand verbunden. – für die mehrfache Regressionsanalyse ist keine Varianzhomogenität gefordert. » die einzelnen Regressoren weisen unterschiedliche Variabilitäten auf. » die Varianz der Zielgröße wird nicht gleichmäßig durch die einzelnen Regressoren beeinflusst. » Um das zu vermeiden wird häufig eine Normierung der Zufallsgrößen durchgeführt, meist durch die Transformation in eine Standardnormalverteilung. » Entspricht einer Standard-RA (alle Varianzen=1). Voraussetzungen • Prämissen des linearen Regressionsmodells sollten erfüllt sein – lineare Beziehung zwischen Regressand und Regressor (d.h. Veränderung in konstanten Relationen) – metrisches Datenniveau der Ziel- und der Einflussgrößen » wenn Zielgröße ordinal skaliert: Rangregressionsanalyse » wenn Zielgröße nominal skaliert: pro-bit-Analyse – – – – Xm, Y und R normalverteilt E (R) = 0; D² (R) minimal (Modellvollständigkeit) D² (R) konst. (Homoskedastizität) Cov (Xi; Ri) = 0 Vorgehensweise 1. Bestimmung des Ursache-Wirkungs-Modells 2. Regressionsfunktion schätzen 3. Gilt die Regressionsfunktion auch für die Grundgesamtheit? / Wie gut ist mein Modell (wieviel Varianz kann ich erklären)? Vorgehensweise • Regressionsfunktion Y=b0+b1X – b0: absolutes Glied, das den Y-Wert für X=0 angibt – b1=ΔY/ΔX: Steigungsmaß b1, das die Neigung der Geraden bestimmt – Abweichungen durch Meßfehler, Beobachtungsfehler, andere Einflußgrößen... Vorgehensweise • Beispiel: Welche Faktoren können unsere Prüfungsnote Y beeinflussen? • Modell: – konsumierter Wein und Mokka in der Lernzeit beeinflussen die Note – je mehr Wein und Mokka, desto bessere Note » X1: Menge der konsumierten Tassen Mokka in der Lernzeit » X2: Menge der konsumierten Gläser Wein in der Lernzeit Mokka=X1 Y= Note Wein=X2 Vorgehensweise X1 b1 Y X2 b2 • Formulierung des Ursache-Wirkungs-Modells Theoretisch: Y Empirisch: 0 1 X 1 ... m X m R yˆ b 0 b1 x 1 ... b m x m Beispiel: Note = b0 + b1 * Mokka + b2 * Wein β0 ist das konstante Glied (= nix trinken) βm partielle Regressionskoeffizienten (Einflußgewicht) X wird als fehlerfrei und additiv wirkend angenommen Y ist fehlerbehaftet R ist Vorhersagefehler, ist der Anteil an Y, der nicht durch die Regressionsgerade erklärt wird Vorgehensweise • 2. Schätzen der Regressionsfunktion – Ziel: Modell bestmöglich an Daten anzupassen – Fehler R dabei möglichst minimal – Vorgehen: Methode der kleinsten quadratischen Abweichungen – Regressionsgerade soll in Punktwolke so liegen, dass Summe der quadrierten Abweichungen aller Werte von der Geraden so klein wie möglich ist. Vorgehensweise • 2. Schätzen der Regressionsfunktion n Formel: (y b i 1 0 b 1x 1i b 2 x 2i )² n (yi yˆ)² Min i 1 zur Minimierung werden die partiellen Ableitungen nach den einzelnen unbekannten Parametern gebildet - Einzelne Ableitungen werden gleich 0 gesetzt -> Gleichungssystem entsteht - Lösung des Gleichungssystems führt zu einzelnen bm Vorgehensweise Beispiel: Nicht standardisiert: Note Y = 0,465 + 0,27 * Mokka + 0,617 * Wein Standardisiert: Note Y = 0,518 * Mokka + 0,781 * Wein Nicht standardisierte Koeffizienten Standardisi erte Koeffizient en Modell B Standardfehler Beta 1 (Konstante) Mokka Wein ,465 ,270 ,617 ,191 ,045 ,069 a. Abhängige Variable: Note ,518 ,781 T Signifikanz 2,433 5,950 8,975 ,072 ,004 ,001 Vorgehensweise • Prüfung der Regressionsfunktion durch – das Bestimmtheitsmaß – Prüfung der Regressionskoeffizienten bm – Prüfung auf Verletzung der Prämissen Vorgehensweise • Prüfung der Regressionsfunktion durch das Bestimmtheitsmaß = prozentualer Anteil der Varianz der Y-Werte, der aufgrund der X-Werte erklärbar ist – Sagt aus, wie gut sich die Regressionsfunktion an die empirische Punktverteilung anpasst (bzw. wieviel Restschwankung übrigbleibt) n D ²(Re gr ) B R² D ²(Y ) Beispiel: Modell 1 n (yi y )² j 1 R 1 (yˆi y )² j R-Quadrat ,985 Korrigiertes R-Quadrat ,970 Einflußvariablen: (Konstante), Wein, Mokka ,955 Standardfeh ler des Schätzers ,297 Vorgehensweise • Prüfung der Regressionsfunktion durch das Bestimmtheitsmaß Signifikanzprüfung: – 1. Nullhypothese H0: B=0 B – n m 1 TG * 1B m n= Anzahl der Beobachtungsdaten m= Anzahl der βm 2. Nullhypothese H0: βm1=β2 =...=0 m TG - bjSP ( Xj ,Y ) j 1 msR ² Werte von TG sind F-verteilt mit df1=m und df2= n-m-1 H0 wird abgelehnt, falls TG>F(1- , df1, df2) ist das Modell insgesamt unbrauchbar, erübrigen sich die restlichen Überprüfungen! Vorgehensweise • Prüfung der Regressionskoeffizienten bm – – – Prüfung, ob und wie gut einzelne Variablen des Regressionsmodells zur Erklärung der abhängigen Variablen Y beitragen Maße: T-Wert und Konfidenzintervall der Regressionskoeffizienten T-Wert: Nullhypothese H0: βm=0 bm m TG sbm – - bei Gültigkeit von H0 wird βm=0 Werte von TG sind t-verteilt mit df= n-m-1 H0 wird abgelehnt, falls TG>t(1- , df) Aussage: ist der Einfluss der einzelnen Regressoren Xm signifikant? Vorgehensweise • Prüfung der Regressionskoeffizienten bm – – Konfidenzintervall: gibt an, in welchem Bereich der wahre Regressionskoeffizient mit einer bestimmten festgelegten Vertrauenswahrscheinlichkeit liegt Beispiel: Nicht standardisierte Koeffizienten Modell 1 (Konstante) Mokka Wein B ,465 ,270 ,617 Standar d-fehler ,191 ,045 ,069 Standard isierte Koeffizie nten Beta 95% Konfidenzintervall für B T ,518 ,781 2,433 5,950 8,975 Signifi kanz ,072 ,004 ,001 Untergrenze Obergrenze -0,66 ,426 ,144 ,997 ,808 ,396 Prüfung auf Verletzung der Prämissen Prämisse Prämissenverletzung Konsequenz Aufdeckung Ausweg Linearität in den Parametern Nichtlinearität Verzerrung der Schätzwerte über statistische Tests durch Transformation der Variablen Vollständigkeit des Modells Unvollständigkeit Verzerrung der Schätzwerte Homoskedastizität/ Unabhängigkeit der Störgrößen (Residuen) von den UVs Heteroskedastizität Ineffizienz Unabhängigkeit der Störgrößen untereinander Autokorrelation Ineffizienz Residuen optisch auf Regelmäßigkeiten hin überprüfen Regressoren müssen voneinander unabhängig sein Multikollinearität Ineffizienz 1. durch hohe Korrelationskoeffizienten zwischen den Regressoren (> .85); 2. Alternativrechnungen mit verschiedenen Variablenkombinationen Normalverteilung der Störgrößen Nicht normalverteilt Ungültigkeit der Signifikanztests 1. Entfernung einer/ mehrerer Variablen aus der Regressionsgleichung; 2. Stichprobe vergrößern Zusätzliches • Nichtlineare RA, Quasilineare RA – Ziel: nicht lineare Zusammenhänge bestimmen Beispiel: die Reproduzierbarkeit von Gedächtnisinhalten nimmt im Verlauf der Zeit nicht linear, sondern exponentiell ab Zusätzliches Alternative Bezeichnungen der Variable Y Zielgröße X Einflussgröße Regressand Regressor Abhängige Variable Unabhängige Variable Kriterium Prädiktor Endogene Variable Exogene Variable Erklärte Variable Erklärende Variable Literatur • Krause, B. / Metzler, P. (1988). Angewandte Statistik (2. Auflage) Berlin: VEB Deutscher Verlag der Wissenschaften • Backhaus, K. et al. (1987). Multivariate Analysemethoden. Berlin: Springer • Schilling, O. (1998). Grundkurs Statistik für Psychologen. München: Fink