Problemsupermarkt - Julian Wergieluk

Werbung

Problemsupermarkt

Regale

Wahrscheinlichkeitstheorie und Statistik

J ULIAN W ERGIELUK

Chemnitz, 2014

Inhaltsverzeichnis

Inhaltsverzeichnis

i

Detaliertes Inhaltsverzeichnis

iii

1 Wahrscheinlichkeitsrechnung

1.1 Mengensysteme . . . . . . . . . . . . . . . . . . . .

1.2 Wahrscheinlichkeitsmaße . . . . . . . . . . . . . .

1.3 Kombinatorik. . . . . . . . . . . . . . . . . . . . . .

1.4 Bedingte Wahrscheinlichkeiten . . . . . . . . . .

1.5 Unabhängigkeit . . . . . . . . . . . . . . . . . . . .

1.6 Elementare Maßtheorie . . . . . . . . . . . . . . .

1.7 Diskrete Zufallsvariablen . . . . . . . . . . . . . .

1.8 Ungleichungen der Wahrscheinlichkeitstheorie

1.9 Diskrete Zufallsvariablen - Textaufgaben . . . .

1.10 Stetige Zufallsvariablen . . . . . . . . . . . . . . .

1.11 Stetige Zufallsvariablen – Textaufgaben . . . .

1.12 Mehrdimensionale Verteilungen. . . . . . . . . .

1.13 Quantile . . . . . . . . . . . . . . . . . . . . . . . . .

1.14 Erwartungstreue . . . . . . . . . . . . . . . . . . .

1.15 Einfache Schätzer . . . . . . . . . . . . . . . . . .

1.16 Konfidenzintervalle . . . . . . . . . . . . . . . . .

1.17 Tests . . . . . . . . . . . . . . . . . . . . . . . . . . .

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

3

3

8

10

17

25

31

32

44

45

53

67

71

75

76

77

77

81

2 Wahrscheinlichkeitstheorie

89

2.1 Bedingte Erwartungen . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 92

2.2 Stochastische Prozesse . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 96

3 Mathematische Statistik

3.1 Identifizierbarkeit . . . . . . .

3.2 Suffizienz . . . . . . . . . . . . .

3.3 Exponentielle Familien . . . .

3.4 Momentenmethode . . . . . . .

3.5 Kleinste-Quadrate-Schätzer .

3.6 Maximum-likelihood Schätzer

3.7 UMVUE . . . . . . . . . . . . . .

3.8 Asymptotische Theorie . . . .

3.9 Konfidenzintervalle . . . . . .

3.10 Testtheorie . . . . . . . . . . . .

3.11 Lineare Regression . . . . . . .

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

i

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

99

99

99

103

108

113

114

121

138

142

145

157

ii

Literatur

INHALTSVERZEICHNIS

163

Detaliertes Inhaltsverzeichnis

Inhaltsverzeichnis

i

Detaliertes Inhaltsverzeichnis

iii

1 Wahrscheinlichkeitsrechnung

1.1 Mengensysteme . . . . . . . . . . . . . . . . . . . . . . . . . . . .

1. Ereignisse. Mengenoperationen. . . . . . . . . . . . . . .

2. Ereignisse. Kraftwerk. . . . . . . . . . . . . . . . . . . . .

3. Ereignisse. Aktienmarkt. . . . . . . . . . . . . . . . . . . .

4. Ereignisse. Fertigungsstraße. . . . . . . . . . . . . . . . .

5. Ereignisse. Kosten. . . . . . . . . . . . . . . . . . . . . . . .

6. Zufallsvariablen. Urbildmengen. . . . . . . . . . . . . . .

7. Zufallsvariablen. Zwei unterscheidbare Würfel. . . . . .

8. Zufallsvariablen. Indikatorfunktionen. . . . . . . . . . .

9. Zufallsvariablen. Schachmeister. . . . . . . . . . . . . . .

10. σ-Algebren. Schachspieler. . . . . . . . . . . . . . . . . . .

11. σ-Algebren. Potenzmenge. . . . . . . . . . . . . . . . . . .

12. σ-Algebren. Restriktion. . . . . . . . . . . . . . . . . . . .

13. Ereignisse. Würfel und Münze I. . . . . . . . . . . . . . .

14. Ereignisse. Würfel und Münze II. . . . . . . . . . . . . .

15. Ereignisse. Zerlegung des Würfels. . . . . . . . . . . . . .

16. Ereignisse. Elementare Wahrscheinlichkeiten. . . . . .

1.2 Wahrscheinlichkeitsmaße . . . . . . . . . . . . . . . . . . . . . .

17. Wahrscheinlichkeitsmaße. Monotonie. . . . . . . . . . . .

18. Wahrscheinlichkeitsmaße. Subaditivität. . . . . . . . . .

19. Wahrscheinlichkeitsmaße. Zerlegung der Vereinigung.

20. Wahrscheinlichkeitsmaße. Einfache Ungleichung. . . .

21. Arithmetik der Wahrscheinlichkeitsmaße. . . . . . . . .

1.3 Kombinatorik. . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

22. Grundformeln der Kombinatorik. . . . . . . . . . . . . . .

23. Kombinatorik. Passwörter. . . . . . . . . . . . . . . . . . .

24. Kombinatorik. PINs und runs. . . . . . . . . . . . . . . .

25. Laplacesche Modelle. Zwei Würfel. . . . . . . . . . . . . .

26. Kombinatorik. Würfel. 4 vs. 24. . . . . . . . . . . . . . . .

27. Kombinatorik. Single choice test. . . . . . . . . . . . . . .

28. Kombinatorik. Aufzug. . . . . . . . . . . . . . . . . . . . .

29. Kombinatorik. Karten. 6 aus 52. . . . . . . . . . . . . . .

30. Kombinatorik. Karten. 13 aus 52. . . . . . . . . . . . . . .

31. Kombinatorik. 2 Kartenspieler. . . . . . . . . . . . . . . .

3

3

3

3

4

4

4

4

4

5

5

5

6

6

6

7

7

7

8

8

8

9

9

9

10

10

10

11

11

12

12

13

13

14

14

iii

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

iv

DETALIERTES INHALTSVERZEICHNIS

1.4

1.5

1.6

1.7

32. Kombinatorik. 4 Kartenspieler. . . . . . . . . . . . . . . . . . . . . . . .

33. Gruppeneinteilung bei Fußball WM. . . . . . . . . . . . . . . . . . . . .

34. Kombinatorik. Schachbrett. . . . . . . . . . . . . . . . . . . . . . . . . .

Bedingte Wahrscheinlichkeiten . . . . . . . . . . . . . . . . . . . . . . . . . .

35. Bedingte Wahrscheinlichkeiten. Symmetrie. . . . . . . . . . . . . . . .

36. Bedingte Wahrscheinlichkeiten. 3 Würfel. . . . . . . . . . . . . . . . .

37. Bedingte Wahrscheinlichkeiten. 2 Münzen. . . . . . . . . . . . . . . .

38. Bedingte Wahrscheinlichkeit ist ein Wahrscheinlichkeitsmaß. . . .

39. Bedingte Wahrscheinlichkeiten. Urne mit Kugeln. . . . . . . . . . . .

40. Urnenmodell. 3 Farben. . . . . . . . . . . . . . . . . . . . . . . . . . . . .

41. Multiplikatives Urnenmodell von Pólya. . . . . . . . . . . . . . . . . .

42. Bedingte Wahrscheinlichkeiten. Urnenmodell von Pólya. . . . . . . .

43. Modifiziertes Urnenmodell von Pólya. . . . . . . . . . . . . . . . . . . .

44. Bedingte Wahrscheinlichkeiten. Unfaire Münzen. . . . . . . . . . . .

45. Bedingte Wahrscheinlichkeiten. Urne mit Loch. . . . . . . . . . . . .

46. Bedingte Wahrscheinlichkeiten. Urnen mit unbekanntem Inhalt. .

47. Bedingte Wahrscheinlichkeiten. Versicherungsunternehmen. . . . .

48. Bedingte Wahrscheinlichkeiten. Urnenmodell von Pólya. II. . . . . .

49. Bedingte bedingte Wahrscheinlichkeiten. . . . . . . . . . . . . . . . . .

50. Elfmeterschießen. . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

51. Schaltkreise. Qualitätskontrolle. . . . . . . . . . . . . . . . . . . . . . .

Unabhängigkeit . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

52. Disjunkt vs. unabhängig. Einfache Rechnungen. . . . . . . . . . . . .

53. Unvereinbar versus unabhängig. Einfache Rechnungen. . . . . . . .

54. Unabhängigkeit. Einfache Rechnungen. . . . . . . . . . . . . . . . . .

55. Unabhängigkeit. Disjunkte Ereignisse. . . . . . . . . . . . . . . . . . .

56. Unabhängigkeit. Gleichwahrscheinliche Ereignisse. . . . . . . . . . .

57. Unabhängigkeit. Münzen. . . . . . . . . . . . . . . . . . . . . . . . . . .

58. Unabhängigkeit. Karten. . . . . . . . . . . . . . . . . . . . . . . . . . . .

59. Unabhängigkeit. Abschätzung mit der Exponentialfunktion. . . . .

60. Unabhängigkeit. Notstromanlage. . . . . . . . . . . . . . . . . . . . . .

61. Unabhängigkeit. Sicherungen. . . . . . . . . . . . . . . . . . . . . . . .

62. Unabhängigkeit. 3-teiliges Gerät. . . . . . . . . . . . . . . . . . . . . . .

63. Unabhängigkeit. Fertigungsprozess. . . . . . . . . . . . . . . . . . . . .

64. Ausfälle der Notstromgeneratoren. . . . . . . . . . . . . . . . . . . . . .

65. Komplexes Gerät. . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

Elementare Maßtheorie . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

66. Maßtheorie. Borel-messbare Abbildungen. . . . . . . . . . . . . . . . .

67. Maßtheorie. Dirac-Maß. . . . . . . . . . . . . . . . . . . . . . . . . . . . .

68. Maßtheorie. Bildmaß. . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

69. Maßtheorie. Ereignisfelder und Information. . . . . . . . . . . . . . .

Diskrete Zufallsvariablen . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

70. Zufallsvariablen. Bernoulli-Verteilung. . . . . . . . . . . . . . . . . . .

71. Zufallsvariablen. Funktionen der Augenzahl. . . . . . . . . . . . . . .

72. Zufallsvariablen. Konstruktion über Wahrscheinlichkeitsfunktion.

73. Zufallsvariablen. Ausfälle der Bauelemente. . . . . . . . . . . . . . . .

74. Zufallsvariablen. Diskrete Gleichverteilung. . . . . . . . . . . . . . . .

75. Erwartungswert. Einfache Eigenschaften. . . . . . . . . . . . . . . . .

76. Geometrische Verteilung. Konstruktion. . . . . . . . . . . . . . . . . .

15

16

16

17

17

17

17

17

18

18

19

19

20

20

21

21

22

22

23

24

24

25

25

25

25

26

26

26

26

27

27

27

29

30

30

31

31

31

31

31

32

32

32

33

33

33

34

34

34

DETALIERTES INHALTSVERZEICHNIS

77.

78.

79.

80.

81.

82.

83.

84.

85.

86.

87.

88.

89.

90.

91.

92.

93.

Geometrische Verteilung. Erwartungswerte. . . . . . . . . . . . . . . .

Geometrische Verteilung. Gedächtnislosigkeit. . . . . . . . . . . . . .

Geometrische Verteilung. Gedächtnislosigkeit und Erwartungswert.

Binomialverteilung. Maximum der Wahrscheinlichkeitsfunktion. .

Binomialverteilung. Gerade Werte. . . . . . . . . . . . . . . . . . . . . .

Poisson-Verteilung. Eigenschaften. . . . . . . . . . . . . . . . . . . . . .

Binomialverteilung. Additionstheorem. . . . . . . . . . . . . . . . . . .

Poisson-Verteilung. Additionstheorem. . . . . . . . . . . . . . . . . . .

Binomialverteilung. Verteilungsfunktion. . . . . . . . . . . . . . . . .

Geometrische Verteilung. Zusammenhang mit der Gleichverteilung.

Negative Binomialverteilung. Konstruktion. . . . . . . . . . . . . . . .

Diskrete Gleichverteilung. Ordnungsstatistiken. . . . . . . . . . . . .

Diskrete Gleichverteilung ist nicht teilbar. . . . . . . . . . . . . . . . .

Geometrische Verteilung. Minima und Maxima. . . . . . . . . . . . .

Geometrische Verteilung. Additionstheorem. . . . . . . . . . . . . . .

Bernoulliverteilung. Momente. . . . . . . . . . . . . . . . . . . . . . . .

Binomialverteilung als Summe von unabhängigen Bernoulli Zufallsvariablen. . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

94. Binomialverteilung. Momente und momentenerzeugende Funktion.

95. Poisson-Verteilung. Momente. . . . . . . . . . . . . . . . . . . . . . . .

96. Zusammengesetzte Poisson-Verteilung. . . . . . . . . . . . . . . . . . .

97. Benfordsches Gesetz. . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

98. Rademacher-verteilte Zufallsvariablen. . . . . . . . . . . . . . . . . . .

1.8 Ungleichungen der Wahrscheinlichkeitstheorie . . . . . . . . . . . . . . . .

99. Tschebyscheff ’sche Ungleichung. 100 Würfel. . . . . . . . . . . . . . .

100. Markow’sche Ungleichung. Diskreter Fall. . . . . . . . . . . . . . . . .

1.9 Diskrete Zufallsvariablen - Textaufgaben . . . . . . . . . . . . . . . . . . . .

101. Busfahrerstreik. . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

102. Hochwasserereignisse. . . . . . . . . . . . . . . . . . . . . . . . . . . . .

103. Gasmelder. . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

104. Vulkanausbrüche. . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

105. Weinfehler. Verteilungsfunktion. . . . . . . . . . . . . . . . . . . . . . .

106. Grenzverteilungsätze. Weinfehler. . . . . . . . . . . . . . . . . . . . . .

107. Reifenpannen. . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

108. Beschichtungsfehler. . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

109. Übertragungskanal. . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

110. Übertragungskanal mit stochastischer Fehlerkorrektur. . . . . . . .

111. Übertragungskanal. II . . . . . . . . . . . . . . . . . . . . . . . . . . . .

112. Bitcoin. Einfaches Bubble-Modell. . . . . . . . . . . . . . . . . . . . . .

1.10 Stetige Zufallsvariablen . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

113. Exponentialverteilung. Minima. . . . . . . . . . . . . . . . . . . . . . .

114. Exponentialverteilung. Dichte des Maximums. . . . . . . . . . . . . .

115. Momente der Exponentialverteilung. . . . . . . . . . . . . . . . . . . .

116. Gedächtnislosigkeit der Exponentialverteilung. . . . . . . . . . . . . .

117. Momentenerzeugende Funktion der Exponentialverteilung. . . . .

118. Minimum von exponentialverteilten Zufallsvariablen. . . . . . . . .

119. Gleichverteilung und Exponentialverteilung. . . . . . . . . . . . . . .

120. Erlang-2-Verteilung. . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

v

34

35

35

35

36

36

36

37

37

38

38

39

39

40

40

41

41

41

42

42

43

44

44

44

45

45

45

46

47

47

48

48

49

50

50

51

51

52

53

53

53

53

54

54

55

55

55

vi

DETALIERTES INHALTSVERZEICHNIS

121. Stetige Gleichverteilung. Momente und Momentenerzeugende Funktion. . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

122. Stetige Gleichverteilung. Momente. . . . . . . . . . . . . . . . . . . . .

123. Stetige Gleichverteilung ist nicht teilbar. . . . . . . . . . . . . . . . . .

124. Cauchy-Verteilung. Gegenbeispiel. . . . . . . . . . . . . . . . . . . . . .

125. Cauchy-Verteilung. Ein Gegenbeispiel. . . . . . . . . . . . . . . . . . .

126. Cauchy-Verteilung ist hartneckig. . . . . . . . . . . . . . . . . . . . . .

127. Lévy-Verteilung. Dichtefunktion. . . . . . . . . . . . . . . . . . . . . . .

128. Mellin-Transformation. . . . . . . . . . . . . . . . . . . . . . . . . . . . .

129. Normalverteilung. Momentenerzeugende Funktion und Momente.

130. Normalverteilung. Momente. . . . . . . . . . . . . . . . . . . . . . . . .

131. Summen von normalverteilten Zufallsvariablen. . . . . . . . . . . . .

132. Dichte der multivariaten Normalverteilung. . . . . . . . . . . . . . .

133. Gaussche Zufallsvariablen und Unabhängigteit. . . . . . . . . . . . .

134. Log-Normalverteilung. Momente und Dichte. . . . . . . . . . . . . . .

135. Log-Normalverteilung. Dichtefunktion. . . . . . . . . . . . . . . . . . .

136. Log-Normalverteilung. Momente. . . . . . . . . . . . . . . . . . . . . . .

137. Normalverteilung. Abweichungen vom Mittelwert. . . . . . . . . . . .

138. Verteilung der Stichprobenvarianz. . . . . . . . . . . . . . . . . . . . .

139. Symmetrische Zufallsvariablen. . . . . . . . . . . . . . . . . . . . . . .

140. Rayleigh-Verteilung. . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

141. Beta-verteilung. . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

142. Gamma-Verteilung. Momente. . . . . . . . . . . . . . . . . . . . . . . . .

143. Momentenerzeugende Funktion einer Gamma-Verteilung. . . . . .

144. Transformationen der Gamma-Verteilung. . . . . . . . . . . . . . . .

145. Gamma-Verteilung und Exponentialverteilung. . . . . . . . . . . . .

146. Mittelwertvergleich bei Gamma-Verteilungen. . . . . . . . . . . . . .

147. χ2 -Verteilung mit einem Freiheitsgrad. . . . . . . . . . . . . . . . . . .

148. Dichte der χ2 -Verteilung. . . . . . . . . . . . . . . . . . . . . . . . . . . .

1.11 Stetige Zufallsvariablen – Textaufgaben . . . . . . . . . . . . . . . . . . . .

149. Widerstände. . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

150. Lebensdauer der Glühlampen. . . . . . . . . . . . . . . . . . . . . . . .

151. Radioaktivität. . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

152. Entfernungsmessung. . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

153. Ersatzteillieferung. . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

154. Grenzverteilungsätze. Cloudrechner. . . . . . . . . . . . . . . . . . . .

155. Grenzverteilungsätze. Schaltkreise. . . . . . . . . . . . . . . . . . . . .

156. Grenzverteilungsätze. Münzen. . . . . . . . . . . . . . . . . . . . . . . .

157. Grenzverteilungsätze. Kondensatoren. . . . . . . . . . . . . . . . . . .

158. Grenzverteilungsätze. Schaltgehäuse. . . . . . . . . . . . . . . . . . . .

1.12 Mehrdimensionale Verteilungen. . . . . . . . . . . . . . . . . . . . . . . . . .

159. Korrelationskoeffizient. Eigenschaften. . . . . . . . . . . . . . . . . . .

160. Bivariate Normalverteilung. Maximum. . . . . . . . . . . . . . . . . .

161. Korrelation und Symmetrie. . . . . . . . . . . . . . . . . . . . . . . . . .

162. Gleichverteilung auf dem Einheitskreis. . . . . . . . . . . . . . . . . .

163. Gleichverteilung auf der Ellipse. . . . . . . . . . . . . . . . . . . . . . .

164. Bedingte Dichten. Ein Rechenbeispiel. . . . . . . . . . . . . . . . . . .

165. Bivariate Rademacherverteilung. . . . . . . . . . . . . . . . . . . . . . .

1.13 Quantile . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

55

56

57

57

57

57

57

58

58

60

60

61

61

61

62

63

63

63

63

64

64

64

65

65

65

66

66

66

67

67

67

67

68

68

69

69

70

70

71

71

71

72

72

72

73

74

74

75

DETALIERTES INHALTSVERZEICHNIS

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

75

76

76

76

76

76

77

77

77

77

78

79

80

81

81

82

82

83

84

85

85

86

87

2 Wahrscheinlichkeitstheorie

185. Konvergenz einer Zufallsreihe. . . . . . . . . . . . . . . . . . . . . . . .

186. Kurtosis. Eigenschaften. . . . . . . . . . . . . . . . . . . . . . . . . . . .

187. Ordnungsstatistiken. Eigenschaften. . . . . . . . . . . . . . . . . . . .

188. Symmetrische Zufallsvariablen und L p Ungleichungen. . . . . . . . .

189. Dichtefunktionen. Scheffés Identitäten. . . . . . . . . . . . . . . . . . .

190. Selbstunabhängigkeit. . . . . . . . . . . . . . . . . . . . . . . . . . . . .

191. Eine Darstellung des Erwartungswertes. . . . . . . . . . . . . . . . .

192. Erwartungstreue einfacher Schätzer. . . . . . . . . . . . . . . . . . . .

193. Faltungsformel. . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

194. Abzählbare Familien disjunkter Mengen. . . . . . . . . . . . . . . . . .

2.1 Bedingte Erwartungen . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

195. Bedingte Erwartungen. II. . . . . . . . . . . . . . . . . . . . . . . . . . .

196. Zusammengesetzte Poissonverteilung. Momentenerzeugende Funktion und Momente. . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

197. Bedingte Erwartungen. Turmeigenschaft. Gegenbeispiel. . . . . . .

198. Bedingte Erwartungen. Turmeigenschaft. . . . . . . . . . . . . . . . .

199. Bedingte Varianz. . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

200. Bedingte Erwartungen. Einfache Eigenschaften. . . . . . . . . . . . .

201. Turmeigenschaft der bedingten Erwartung. . . . . . . . . . . . . . . .

202. Bedingte Erwartungen und Normalverteilung. . . . . . . . . . . . . .

203. Bedingte Erwartungen. Exponentialverteilung. . . . . . . . . . . . . .

2.2 Stochastische Prozesse . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

204. Poissonprozess. Charakteristische Funktion. . . . . . . . . . . . . . .

205. Zusammengesetzter Poissonprocess. Charakteristische Funktion. .

89

89

89

89

90

90

90

90

91

92

92

92

92

1.14

1.15

1.16

1.17

166. Exponentialverteilung. Quantile. . . . . . . . . . . . . . . .

167. Logistische Verteilung. Quantile. . . . . . . . . . . . . . . .

Erwartungstreue . . . . . . . . . . . . . . . . . . . . . . . . . . . .

168. Schätzung der Varianz bei bekanntem Erwartungswert.

169. Diskrete Gleichverteilung. Erwartungstreuer Schätzer. .

170. Log-Normalverteilung. Erwartungstreuer Schätzer. . . .

Einfache Schätzer . . . . . . . . . . . . . . . . . . . . . . . . . . .

171. Einfache Schätzer. Telefonzentrale. . . . . . . . . . . . . .

Konfidenzintervalle . . . . . . . . . . . . . . . . . . . . . . . . . .

172. Kondensatoren. Konfidenzintervall. . . . . . . . . . . . . .

173. Krankenversicherung. Konfidenzintervall. . . . . . . . . .

174. Qualitätssicherung. Konfidenzintervall. . . . . . . . . . .

175. Justierung. Konfidenzintervall. . . . . . . . . . . . . . . . .

Tests . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

176. Waschmittel. Test. . . . . . . . . . . . . . . . . . . . . . . . .

177. Messgerät. Test. . . . . . . . . . . . . . . . . . . . . . . . . .

178. Entfernungsmessung. Konfidenzintervall und Test. . . .

179. Erneuerbare Energien. Test. . . . . . . . . . . . . . . . . . .

180. Test. Trendvergleich bei Funds. . . . . . . . . . . . . . . . .

181. Konfidenzintervall und Test. Normalverteilung. . . . . .

182. Analyse des Zuckerpreises. . . . . . . . . . . . . . . . . . . .

183. Analyse des Kaffeebohnenpreises. . . . . . . . . . . . . . .

184. Aktie im Bachelier-Modell. . . . . . . . . . . . . . . . . . . .

vii

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

93

94

94

95

95

96

96

96

96

96

97

viii

DETALIERTES INHALTSVERZEICHNIS

206. Ornstein-Uhlenbeck SDE. . . . . . . . . . . . . . . . . . . . . . . . . . . 98

3 Mathematische Statistik

99

3.1 Identifizierbarkeit . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 99

207. Identifizierbarkeit im linearen Modell. . . . . . . . . . . . . . . . . . . 99

3.2 Suffizienz . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 99

208. Suffizienz. Invariante Transformationen. . . . . . . . . . . . . . . . . . 99

209. Qualitätskontrolle. . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 100

210. Inverse Gamma-Verteilung. Suffizienz. . . . . . . . . . . . . . . . . . . 100

211. Beta-Verteilung. Suffizienz. . . . . . . . . . . . . . . . . . . . . . . . . . 100

212. Pareto-Verteilung. Suffizienz. . . . . . . . . . . . . . . . . . . . . . . . . 100

213. Poisson-Verteilung. Suffizienz. . . . . . . . . . . . . . . . . . . . . . . . 100

214. Suffizienz. Beispiele. . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 101

215. Nichtzentrale Exponentialverteilung. Suffizienz. . . . . . . . . . . . . 102

3.3 Exponentielle Familien . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 103

216. Exponentielle Familie mit einer unvollständigen natürlichen Statistik. . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 103

217. Beta-Verteilung als exponentielle Familie. . . . . . . . . . . . . . . . . 103

218. Gamma-Momente und exponentielle Familien. . . . . . . . . . . . . . 103

219. Poisson-Momente und exponentielle Familien. . . . . . . . . . . . . . 104

220. Laplace-Verteilung ist keine exponentielle Familie. . . . . . . . . . . 104

221. Verteilung der natürlichen suffizienten Statistik. . . . . . . . . . . . 105

222. Cauchy-Verteilung ist keine exponentielle Familie. . . . . . . . . . . 105

223. Mixtures of Normal Verteilungen sind keine exponentielle Familien.105

224. Weibull-Verteilung als exponentielle Familie. . . . . . . . . . . . . . . 105

225. Invers-Gauß-Verteilung als exponentielle Familie. . . . . . . . . . . . 106

226. Invers-Gamma-Verteilung als exponentielle Familie. . . . . . . . . . 106

227. Lévy-Verteilung als exponentielle Familie. . . . . . . . . . . . . . . . . 107

3.4 Momentenmethode . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 108

228. Stetige Gleichverteilung. Momentenschätzer. . . . . . . . . . . . . . . 108

229. Dreiecksverteilung. Momentenschätzer. . . . . . . . . . . . . . . . . . 108

230. Momentenschätzer. Beispiele. . . . . . . . . . . . . . . . . . . . . . . . . 109

231. Weibull-Verteilung. Momentenschätzer. . . . . . . . . . . . . . . . . . . 109

232. Momentenschätzung vs Suffizienz. . . . . . . . . . . . . . . . . . . . . . 109

233. AR1. . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 110

234. Exponentialverteilung. Momentenschätzer. . . . . . . . . . . . . . . . 111

235. Rayleigh-Verteilung. Momentenschätzer. . . . . . . . . . . . . . . . . 111

236. Gamma-Verteilung. Momentenschätzer. . . . . . . . . . . . . . . . . . 111

237. Beta-Verteilung. Momentenschätzer. . . . . . . . . . . . . . . . . . . . 112

3.5 Kleinste-Quadrate-Schätzer . . . . . . . . . . . . . . . . . . . . . . . . . . . . 113

238. Einfache lineare Regression. Beispielrechnung. . . . . . . . . . . . . . 113

239. Gewichtete einfache lineare Regression. . . . . . . . . . . . . . . . . . 114

3.6 Maximum-likelihood Schätzer . . . . . . . . . . . . . . . . . . . . . . . . . . . 114

240. Mischung von Gleichverteilungen. MLE. . . . . . . . . . . . . . . . . . 114

241. Normalverteilung. MLE. . . . . . . . . . . . . . . . . . . . . . . . . . . . 114

242. Exponentialverteilung. MLE. . . . . . . . . . . . . . . . . . . . . . . . . 115

243. Maximum-Likelihood-Methode und Suffizienz. . . . . . . . . . . . . . 115

244. Zweidimensionale Exponentialverteilung. MLE. . . . . . . . . . . . . 116

245. Weibull-Verteilung. MLE. . . . . . . . . . . . . . . . . . . . . . . . . . . 116

DETALIERTES INHALTSVERZEICHNIS

3.7

3.8

3.9

3.10

3.11

246. Mischung der Verteilungen. MLE. . . . . . . . . . . . . . . . . . .

247. Beta-Verteilung. MLE. . . . . . . . . . . . . . . . . . . . . . . . . .

248. Pareto-Verteilung. Suffizienz und MLE. . . . . . . . . . . . . . . .

249. Gamma-Verteilung. MLE. . . . . . . . . . . . . . . . . . . . . . . .

250. Lévy-Verteilung. Dichte und MLS. . . . . . . . . . . . . . . . . . .

UMVUE . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

251. Ein Model für das kein erwartungstreuer Schätzer existiert. .

252. Verschobene Gleichverteilung. . . . . . . . . . . . . . . . . . . . .

253. UMVUE. Bernoulli-Verteilung. . . . . . . . . . . . . . . . . . . . .

254. Diskrete Gleichverteilung. MLE und UMVUE. . . . . . . . . . .

255. Vollständigkeit und UMVUE. . . . . . . . . . . . . . . . . . . . . .

256. Vollständigkeit. . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

257. Stichprobenvarianz als UMVUE bei Normalverteilung. . . . . .

258. UMVUE. Normalverteilung. . . . . . . . . . . . . . . . . . . . . .

259. Cramér-Rao Regularität und exponentielle Familien. . . . . . .

260. UMVUE. Exponentialverteilung. . . . . . . . . . . . . . . . . . . .

261. UMVUE. Gamma-Verteilung. . . . . . . . . . . . . . . . . . . . . .

262. Informationsungleichung und Normalverteilung. . . . . . . . .

263. Cramér-Rao-Schranke und die Gleichverteilung. . . . . . . . . .

264. Cramér-Rao-Schranke ist nicht scharf. . . . . . . . . . . . . . . .

265. Log-Normal-Verteilung. MLS und UMVUE. . . . . . . . . . . . .

266. UMVUE-Schätzer für Poisson-Verteilung. . . . . . . . . . . . . .

Asymptotische Theorie . . . . . . . . . . . . . . . . . . . . . . . . . . . .

267. Verschobene Gleichverteilung und Konsistenz. . . . . . . . . . .

268. Konsistenz. Hinreichende Bedingungen. . . . . . . . . . . . . . .

269. Asymptotische Verteilung von MLE. . . . . . . . . . . . . . . . . .

270. Asymptotische Effizienz. . . . . . . . . . . . . . . . . . . . . . . . .

Konfidenzintervalle . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

271. Konfidenzintervall. Normalverteilung. . . . . . . . . . . . . . . .

272. Konfidenzintervall. Exponentialverteilung. . . . . . . . . . . . .

273. Konfidenzintervall. Varianzenvergleich bei Normalverteilung.

274. Gleichverteilung. Konfidenzintervall. . . . . . . . . . . . . . . . .

275. Konfidenzintervall. Mittelwert der Normalverteilung. . . . . .

Testtheorie . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

276. Test. Mittelwertvergleich unter Normalverteilung. . . . . . . .

277. Poisson-Verteilung. Test. . . . . . . . . . . . . . . . . . . . . . . . .

278. Exponentialverteilung. Test. . . . . . . . . . . . . . . . . . . . . . .

279. Rayleigh-Verteilung. UMP-Test. . . . . . . . . . . . . . . . . . . .

280. Pareto-Verteilung. Optimaler Test. . . . . . . . . . . . . . . . . . .

281. Poissonverteilung. Optimaler Test. . . . . . . . . . . . . . . . . . .

282. Geometrische Verteilung. Neyman-Pearson-Test. . . . . . . . . .

283. Bernoulli-Verteilung. Neyman-Pearson-Test. . . . . . . . . . . .

284. Gamma-Verteilung. Konfidenzintervall und Test. . . . . . . . .

Lineare Regression . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

285. Lineare Regression mit Schalter. . . . . . . . . . . . . . . . . . . .

286. 3-Stichprobenproblem. . . . . . . . . . . . . . . . . . . . . . . . . .

287. KQS ist auch MLS im Normalverteilungsfall. . . . . . . . . . .

288. Einfache lineare Regression. . . . . . . . . . . . . . . . . . . . . .

289. Quadratisches Modell. KQS. . . . . . . . . . . . . . . . . . . . . . .

ix

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

117

118

118

119

120

121

121

121

123

125

126

127

127

128

129

130

132

133

133

134

136

137

138

138

139

140

141

142

142

143

143

144

144

145

145

146

148

150

151

152

154

155

157

157

157

158

159

160

161

x

DETALIERTES INHALTSVERZEICHNIS

290. Quadratisches Modell. Explizite Form des KQS. . . . . . . . . . . . . 161

Literatur

163

Einleitung

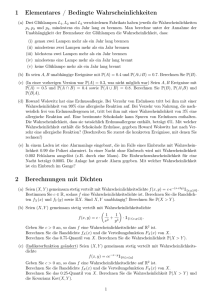

Die vorliegende Sammlung enthält über 287 Probleme und Aufgaben, die ich seit 2011

für meine Übungen an der TU Chemnitz verwendet habe. Die Aufgaben sind zum Teil

mit Lösungshinweisen oder mit vollständigen Lösungen versehen.

Quellen

Bei der Erstellung dieser Aufgabensammlung habe ich unter anderen folgende exzellente Bücher verwendet:

• Claudia Czado und Thorsten Schmidt. Mathematische Statistik. Statistik und

Ihre Anwendungen. Springer, 2011. ISBN: 9783642172601

• Jean Jacod und Philip Protter. Probability Essentials. 2. Aufl. Springer-Verlag,

2004. ISBN: 9783540438717

• Jacek Jakubowski und Rafał Sztencel. Wst˛ep do teorii prawdopodobieństwa.

Script, 2001. ISBN: 9788390456454

• Jun Shao. Mathematical Statistics. Springer Texts in Statistics. Springer, 2003.

ISBN : 9780387953823

• Übungsaufgaben zur Wahrscheinlichkeitsrechnung und Statistik. Fakultät für

Mathematik, Technische Universität Chemnitz

Kompilierung der Aufgabensammlung

Um die Datei problem-supermarkt.pdf aus den LATEX-Quellen zu erstellen wird

eine aktuelle TEX-Distribution benötigt, wie zum Beispiel TEXLive 2012.

Basierend auf den Aufgaben in dieser Sammlung können auch automatisiert

Übungsblätter erstellt werden. Dies ist mit Hilfe eines separaten Werkzeugs problemextractor möglich.

Fehler und Korrekturen

Wenn Sie einen Fehler gefunden haben, erstellen Sie bitte ein “Issue” in dem Fehlerverfolgunssystem des Projekts und verweisen Sie in dem Namen des Fehlers auf den

(innerhalb der Sammlung eindeutigen) Titel der Aufgabe.

1

2

DETALIERTES INHALTSVERZEICHNIS

Mitwirkende

Ich möchte mich bei folgenden Personen für das Beitragen der Aufgaben, Lösungen

und Verbesserungsvorschläge herzlich bedanken:

Thorsten Schmidt, Bernd Hofmann, Holger Langenau, Michael Pippig, Toni Volkmer, Susanne Lindner.

Weiterverwendung der Probleme aus dieser Sammlung

Problemsupermarkt ist lizenziert unter einer Creative Commons Namensnennung Weitergabe unter gleichen Bedingungen 4.0 International Lizenz.

Julian Wergieluk, Chemnitz, 2014.

K APITEL

1

Wahrscheinlichkeitsrechnung

1.1

Mengensysteme

1. Ereignisse. Mengenoperationen. Gegeben seien jeweils der Grundraum Ω

sowie zwei Teilmengen A und B :

(a) Ω = {1, 2, ..., 20}, A = {4, 5, 6, 7, 9, 11}, B = {3, 5, 9, 20}

(b) Ω = [−1, 3], A = [0, 1), B = ( 12 , 2]

(c) Ω = R, A = {x ∈ R : |x − 1| < 3}, B = [0, ∞).

Bilden Sie die Mengen A , B , A ∩ B , A ∪ B , A ∪ B , A ∩ B , B ∩ A , (A ∪ B ) ∩ B , B ∪ (B ∩ A).

2. Ereignisse. Kraftwerk. Die Arbeit eines Kraftwerkes wird durch drei unabhängig voneinander arbeitende Kontrollsysteme überwacht, die jedoch auch einer

gewissen Störanfälligkeit unterliegen. Es bezeichne S i das Ereignis, dass das i -te

System störungsfrei arbeitet (i = 1, 2, 3).

(a) Finden Sie einen geeigneten Grundraum Ω, der diese Zufallssituation beschreibt.

Ist Ω eindeutig bestimmt?

(b) Drücken Sie folgende Ereignisse mit Hilfe der Ereignisse S 1 , S 2 und S 3 aus:

A : Alle drei Systeme arbeiten störungsfrei.

B : Kein System arbeitet störungsfrei.

C : Mindestens ein System arbeitet störungsfrei.

D : Genau ein System arbeitet störungsfrei.

E : Höchstens zwei Systeme sind gestört.

(c) Welche der unter (b) genannten Ereignisse sind Elementarereignisse?

(d) Aus wie vielen Elementen bestehen die Ereignisse D und C ?

Lösung. Der Grundraum Ω kann als Ω = (i j k) : i , j , k ∈ {0, 1} gewählt werden. Diese

Wahl ist aber nicht eindeutig. Die Ereignisse A und B sind in diesem Fall Elementarereignisse.

©

3

ª

4

KAPITEL 1. WAHRSCHEINLICHKEITSRECHNUNG

3. Ereignisse. Aktienmarkt. Beim Monatsvergleich zweier Technologieaktien

wird für jede Aktie festgestellt, ob es zu einem Gewinn von mindestens 3% kam, ob

sich ein Verlust um mehr als 3% ergab oder ob sich die jeweilige Aktie innerhalb der

6%-Spanne bewegte.

(a) Finden Sie einen geeigneten Grundraum Ω, der diese Zufallssituation beschreibt.

Ist Ω eindeutig bestimmt?

(b) Stellen Sie folgende Ereignisse mit Hilfe der Elementarereignisse dar:

A : Beide Aktien erzielten einen Kursgewinn von mindestens 3%.

B : Die Kurse der beiden Aktien lagen innerhalb der 6%-Spanne.

C : Der Kurs von höchstens einer der beiden Aktien verschlechterte sich um

mehr als 3%.

D : Der Kurs von mindestens einer der beiden Aktien verschlechterte sich um

mehr als 3%.

(c) Welche Bedeutung haben die Ereignisse

E 1 = A ∪C , E 2 = A ∪ D , E 3 = A ∩C , E 4 = A ∩C , E 5 = A ∩ D ?

4. Ereignisse. Fertigungsstraße. Eine Fertigungsstraße bestehe aus einer Maschine vom Typ I, vier Maschinen vom Typ II und zwei Maschinen vom Typ III. Wir

bezeichnen mit A , B k bzw. C j (k = 1, 2, 3, 4; j = 1, 2) die Ereignisse, dass die Maschine

vom Typ I bzw. die k -te Maschine vom Typ II bzw. die j -te Maschine vom Typ III intakt

ist. Die Fertigungsstraße sei arbeitsfähig, wenn mindestens eine Maschine von jedem

Maschinentyp intakt ist. Dieses Ereignis werde mit D bezeichnet.

Beschreiben Sie die Ereignisse D und D mit Hilfe der Ereignisse A , B k , C j .

5. Ereignisse. Kosten. Drei Betriebsteile werden auf Einhaltung eines bestimmten Kostenfaktors überprüft. Das Ereignis A liege vor, wenn mindestens ein Betriebsteil nicht den geforderten Kostenfaktor einhält, das Ereignis B liege vor, wenn alle

drei Betriebsteile den geforderten Kostenfaktor einhalten.

Was bedeuten dann die Ereignisse A ∪ B und A ∩ B ?

6. Zufallsvariablen. Urbildmengen. Gegeben seien ein Grundraum Ω = R und

die Zufallsvariable

X : Ω → R : ω 7→ ω2 .

Geben Sie folgende Mengen explizit an:

{X = 0} ,

{X ∈ [1, 2)} ,

{X > 2} ,

{2X < 4} ,

7. Zufallsvariablen. Zwei unterscheidbare Würfel.

ein schwarzer Würfel werden geworfen.

{|X − 2| > 1} .

Ein weißer Würfel und

(a) Geben Sie einen geeigneten Grundraum Ω an, der diese Zufallssituation beschreibt.

(b) Die Zufallsvariablen W bzw. S geben die Augenzahl des weißen bzw. schwarzen

Würfels an. Geben Sie die Definitionen von W und S explizit an. Wie definieren

Sie den Zustandsraum?

1.1. MENGENSYSTEME

5

(c) Geben Sie folgende Ereignisse explizit an:

½

{W = 6} ,

{W + S = 4} ,

{W > S} ,

¾

W

>1 .

S

8. Zufallsvariablen. Indikatorfunktionen. Ein Experiment bestehe aus einfachem Würfelwurf und wird durch den Grundraum Ω = {1, 2, 3, 4, 5, 6} beschrieben. Die

Zufallsvariable X : Ω → R, ω 7→ ω liefert das Ergebnis des Würfelwurfs. Zeigen Sie

X = 1[1,6] + 1[2,6] + · · · + 1[6,6] .

9. Zufallsvariablen. Schachmeister. Ein Schachmeister besucht einen Schachverein und spielt eine Partie Simultanschach gegen die fünf anwesenden Clubmitglieder. Dazu werden fünf Schachbretter in einer Reihe aufgebaut. Auf der einen Seite

sitzen vor je einem Brett die Vereinsmitglieder, während auf der anderen Seite der

Schachmeister reihum auf jedem Brett zieht.

Es sei X die Anzahl der Spiele, die der Schachmeister gewinnt. (Ein Schachspiel

kann mit Remis beendet werden, so dass keiner gewinnt.)

(a) Geben Sie einen Grundraum Ω, die Zufallsvariable X und den Zustandsraum Z

an.

(b) Bestimmen Sie die Anzahl der Elemente von Ω.

(c) Wie viele Elementarereignisse besitzt das Ereigns {X ≥ 4}?

Lösung.

(a) Ω = {0, 1}5 (1 : gewonnen, 0 : nicht gewonnen), X : Ω → Z = {0, 1, 2, 3, 4, 5}, X (ω) =

P5

i =1 ωi wobei ω = (ω1 , . . . , ω5 ) ∈ Ω

(b) |Ω| = 25 = 32

(c) |{X ≥ 4}| = |{X = 5} ∪ {X = 4}| = 1 + 4 = 5

Die Wahl von Ω ist hierbei nicht eindeutig. Es könnte alternativ auch folgende Lösung

gewählt werden:

(a) Ω = {−1, 0, 1}5 (1 : gewonnen, 0 : nicht gewonnen, −1 : verloren), X : Ω → Z =

{0, 1, 2, 3, 4, 5}

(b) |Ω| = 35 = 243

(c) |{X ≥ 4}| = |{X = 5} ∪ {X = 4}| = 1 + 8 = 9

10. σ-Algebren. Schachspieler. Zwei Schachspieler spielen eine Partie. Das Ereignis A liege vor, falls der erste Spieler gewinnt, das Ereignis B , falls der zweite

gewinnt. Welche Ereignisse sind noch hinzuzufügen, damit eine σ-Algebra entsteht?

6

KAPITEL 1. WAHRSCHEINLICHKEITSRECHNUNG

Lösung. Für Ω 6= ; heißt A ⊂ P (Ω) Algebra, falls

(i) Ω ∈ A

(ii) A ∈ A ⇒ A ∈ A

(iii) A 1 , A 2 ∈ A ⇒ A 1 ∪ A 2 ∈ A

Für eine σ-Algebra wird statt (iii) allgemeiner gefordert

(iiiσ ) A i ∈ A , i ∈ N ⇒

S∞

i =1

Ai ∈ A

Für |A | < ∞ sind (iii) und (iiiσ ) äquivalent, d.h. jede endliche Algebra ist auch σAlgebra.

Interpretation: Jede und/oder-Verknüpfung sowie Verneinungen von Ereignissen

sind wieder als Ereignis darstellbar.

• Das Ereignis C liege bei Unentschieden vor.

• Das sichere Ereignis ergibt sich dann offenbar als Ω = A ∪ B ∪C ∈ A (“Ein Spieler

gewinnt oder Unentschieden” tritt immer ein).

• Wegen (ii) ist dann auch das unmögliche Ereignis ; = Ω ∈ A Element der Algebra

(es gibt keine anderen Spielausgänge).

• Wegen (iii) sind außerdem A ∪ B ∈ A , A ∪C ∈ A und B ∪C ∈ A .

• Offenbar gilt A ∪ B = C ∈ A , A ∪C = B ∈ A und B ∪C = A ∈ A

• A = {;, A, B,C , A ∪ B, A ∪ C , B ∪ C , Ω} erfüllt alle Bedingungen einer Algebra. Auf

Grund der Endlichkeit (|A | = 8) ist dies auch eine σ-Algebra.

11. σ-Algebren. Potenzmenge. Sei Ω ein endlicher nichtleerer Grundraum. Zeigen Sie, dass die Menge aller Teilmengen von Ω, also die Potenzmenge P (Ω), endlich

und eine σ-Algebra ist.

12. σ-Algebren. Restriktion. Sei A eine σ-Algebra von Teilmengen eines Grundraumes Ω und B ∈ A mit B 6= ;. Zeigen Sie, dass C = {A ∩ B : A ∈ A } eine σ-Algebra von

Teilmengen von B ist.

13. Ereignisse. Würfel und Münze I. Ein Experiment bestehe aus dem Werfen

eines sechsseitigen Würfels und einer Münze.

(a) Geben Sie einen Grundraum Ω an, der diese Zufallssituation beschreibt.

(b) Stellen Sie die folgenden Ereignisse sowohl formell als auch durch Aufzählung

der Elementareignisse dar.

A : Der Würfel zeigt eine 1 und die Münze zeigt Zahl.

B : Der Würfel zeigt eine gerade Augenzahl.

C : Der Würfel zeigt eine 6 oder die Münze zeigt kein Wappen.

D : Entweder A oder C tritt ein.

1.1. MENGENSYSTEME

7

Lösung.

(a)

Ω = {1, 2, 3, 4, 5, 6} × {W, Z }

= {(w, m) : w ∈ {1, 2, 3, 4, 5, 6}, m ∈ {W, Z }}

= {(1,W ), (2,W ), (3,W ), (4,W ), (5,W ), (6,W ), (1, Z ), (2, Z ), (3, Z ), (4, Z ), (5, Z ), (6, Z )}

(b)

A : W1 := {(1,W ), (1, Z )}, M Z := {(1, Z ), (2, Z ), . . . , (6, Z )},

A = W1 ∩ M Z = {(1, Z )}

B : B = W2 ∪ W4 ∪ W6 = {(2,W ), (2, Z ), (4,W ), (4, Z ), (6,W ), (6, Z )}

C : C = W6 ∪ MW = {(6,W ), (6, Z ), (1, Z ), (2, Z ), (3, Z ), (4, Z ), (5, Z )}

D : A = Ω \ {(1, Z )}, C = {(1,W ), . . . , (5,W )}

D = A4C = (A ∩C ) ∪ (A ∩C ) = Ω \ ((A ∩C ) ∪ (A ∩C )) = {(2, Z ), . . . , (6, Z ), (6,W )}

14. Ereignisse. Würfel und Münze II. Ein Experiment bestehe aus dem Werfen

eines fairen Würfels und einer fairen Münze.

(a) Geben Sie einen Wahrscheinlichkeitsraum (Ω, A , P) an, der diese Zufallssituation beschreibt.

(b) Zeigt die Münze Wappen, so wird die doppelte Augenzahl des Würfels notiert,

bei Zahl nur die einfache. Wie groß ist die Wahrscheinlichkeit, dass eine gerade

Zahl notiert wird?

15. Ereignisse. Zerlegung des Würfels. Ein Würfel, dessen Seitenflächen gleichartig gefärbt sind, werde in 1000 kleine Würfel einheitlicher Größe zerlegt.

Wie groß ist die Wahrscheinlichkeit dafür, dass ein zufällig ausgewählter Würfel

auf mindestens einer Seite gefärbt ist?

16. Ereignisse. Elementare Wahrscheinlichkeiten. Für die Ereignisse A und

B seien folgende Wahrscheinlichkeiten bekannt: P(A) = 0.25, P(B ) = 0.45, P(A ∪ B ) = 0.5.

Berechnen Sie die Wahrscheinlichkeiten:

(a) P(A ∩ B ),

(b) P(A ∩ B ) und

³

´

(c) P (A ∩ B ) ∪ (A ∩ B ) .

Lösung.

(a)

P(A ∪ B ) = P((A ∩ B̄ ) ∪ B ) = P(A ∩ B̄ ) + P(B )

P(A ∪ B̄ ) = P(A ∪ B ) − P(B ) = 0.05.

(b)

P( Ā ∩ B̄ ) = P(A ∪ B ) = 0.5.

8

KAPITEL 1. WAHRSCHEINLICHKEITSRECHNUNG

(c) Die symmetrische Differenz A∆B = (A \ B ) ∪ (B \ A) ist eine disjunkte Vereinigung,

und daher

P(A∆B ) = P(A ∩ B̄ ) + P( Ā ∩ B ).

Die vorherigen Überlegungen liefern

P(A ∩ B̄ ) = P(A \ B ) = P(A ∪ B ) − P(B ) = 0.05

P( Ā ∩ B ) = P(B \ A) = P(A ∪ B ) − P(A) = 0.25.

Insgesamt gilt also P(A∆B ) = 0.3.

1.2

Wahrscheinlichkeitsmaße

Wahrscheinlichkeitsmaße. Monotonie. Seien ein Wahrscheinlichkeitsraum

(Ω, A , P) und die Ereignisse A, B ∈ A gegeben. Zeigen Sie

17.

A⊆B

P(A) ≤ P(B ).

⇒

Lösung. P(B ) = P(A ∪ (B \ A)) = P(A) + P(B \ A) ≥ P(A).

18. Wahrscheinlichkeitsmaße. Subaditivität. Seien ein Wahrscheinlichkeitsraum (Ω, A , P) und die Ereignisse A 1 , A 2 , · · · ∈ A gegeben.

(a) Zeigen Sie, dass für alle n ∈ N

Ã

P

!

n

[

Ai ≤

i =1

n

X

P (A i )

i =1

gilt.

(b) Zeigen Sie, dass sogar gilt

Ã

P

∞

[

i =1

!

Ai ≤

∞

X

P (A i ) .

i =1

Lösung.

(a) Betrachte folgende Darstellung der Vereinigung als Summe disjunkter Elemente

von A .

n

[

A i = A 1 ∪ ( Ā 1 ∩ A 2 ) ∪ ( Ā 1 ∩ Ā 2 ∩ A 3 ) ∪ · · · ∪ ( Ā 1 ∩ Ā 2 ∩ · · · ∩ Ā n−1 ∩ A n ).

i =1

(b) Genau das gleiche Argument funktioniert für n = ∞. Das ist die Konsequenz der

σ-Additivität des Wahrscheinlichkeitsmaßes P .

1.2. WAHRSCHEINLICHKEITSMASSE

9

19. Wahrscheinlichkeitsmaße. Zerlegung der Vereinigung. Seien ein Wahrscheinlichkeitsraum (Ω, A , P) und die Ereignisse A, B,C ∈ A sowie A 1 , A 2 , . . . , A n ∈ A

gegeben. Zeigen Sie folgende Aussagen:

(a)

P (A ∪ B ∪C ) = P(A) + P(B ) + P(C ) − P(A ∩ B ) − P(A ∩C ) − P(B ∩C ) + P(A ∩ B ∩C ).

(b)

Ã

P

n

[

i =1

!

Ai =

n

X

P(A i ) −

i =1

X

P(A i ∩ A j )+

i<j

X

P(A i ∩ A j ∩ A k ) − · · · + (−1)n+1 P (A 1 ∩ · · · ∩ A n ) .

i < j <k

Lösung.

(a) Hier genügt eine Überlegung mit Hilfe der Venn-Diagrame.

(b) Die Menge A 1 ∪ · · · ∪ A n ist Vereinigung der Mengen der Form A i 1 ∩ · · · ∩ A i k ∩ Ā i k+1 ∩

· · · ∩ Ā i n , k ≥ 1, wobei i 1 , . . . , i n eine Umnumerierung von 1, . . . , n ist. Nun kommt

¡ ¢

solche Menge in der ersten Summe als Teilmenge von A i genau k1 vor. In der

¡ ¢

¡ ¢

P

zweiten Summe wird die Menge k2 mal abgezogen. Nachdem ki=0 (−1)i ki = 0,

¡ ¢

P

erhalten wir ki=1 (−1)i +1 ki = 1.

20. Wahrscheinlichkeitsmaße. Einfache Ungleichung. Seien ein Wahrscheinlichkeitsraum (Ω, A , P ) und die Ereignisse A und B gegeben. Beweisen Sie die Ungleichung

P (A ∩ B ) ≥ P (A) + P (B ) − 1.

21. Arithmetik der Wahrscheinlichkeitsmaße. Seien ein Wahrscheinlichkeitsraum (Ω, A, P ) und die Ereignisse A, B ∈ A gegeben.

(a) Angenommen P ( Ā) = 13 , P (A ∩ B ) = 14 und P (A ∪ B ) = 32 . Berechnen Sie P (B̄ ), P (A ∩ B̄ )

und P (B ∩ Ā).

(b) Angenommen P (A ∪ B ) = 12 , P (A ∩ B ) =

P (A) und P (A ∩ B̄ ).

Lösung.

(a) B ⊂ A .

(b) P (A) = 38 und P (A \ B ) = 18 .

1

4

und P (A ∩ B̄ ) = P (B ∩ Ā). Berechnen Sie

10

1.3

KAPITEL 1. WAHRSCHEINLICHKEITSRECHNUNG

Kombinatorik.

22. Grundformeln der Kombinatorik. Die Kugeln in einer Urne sind mit Zahlen 1, 2, . . . , n nummeriert. Es werden nacheinander m Kugeln aus der Urne entnommen

und die zugehörigen Zahlen notiert. Nach jeder Entnahme können die Kugeln wieder

in die Urne zurückgelegt oder beiseite gelegt werden. Es muss auch festgelegt werden, ob die Reihenfolge der notierten Zahlen eine Rolle spielt. Abhängig von diesen

Entscheidungen ergeben sich folgende Anzahlen der möglichen Ergebnisse:

geordnet (Variationen)

mit Zurücklegen

ohne Zurücklegen

n

ungeordnet (Kombinationen)

m

n!

(n−m)!

¡n+m−1¢

¡m

n¢

m

Betrachten Sie folgende Zufallssituationen

(a) Der Betreiber der Lotto Lotterie (6 aus 49) ermittelt die gewinnende Zahlenkombination.

(b) Ein Benutzer gibt ein zufälliges 8-stelliges Passwort ein.

(c) Es wird zufällig eine injektive (verschiedenwertige) Funktion

f : {1, . . . , m} → {1, . . . , n}

gewählt.

(d) Es wird zufällig eine k -elementige Teilmenge der Menge {1, 2, . . . , n} gewählt.

(e) Es wird zufällig eine Bijektion f : {1, . . . , n} → {1, . . . , n} gewählt.

(f) m Krapfen (nicht unterscheidbar) werden zufällig an n Programmierer verteilt.

(g) Es wird zufällig eine Folge nichtnegativer ganzer Zahlen (r 1 , . . . , r n ) gewählt, so

dass die Gleichung r 1 + · · · + r n = m erfüllt ist.

Geben Sie jeweils eine passende Formel an, die die Anzahl der möglichen Ergebnisse

für diese Zufallssituationen beschreibt.

23. Kombinatorik. Passwörter.

als gegebenen Zeichensatz.

Wir betrachten die Menge A = {a, b, . . . , z, 0, . . . , 9}

(a) Wie viele voneinander verschiedene Passwörter der Länge 8 können aus A

gebildet werden?

(b) Betrachten wir nun die Passwörter aus dem obigen Zeichensatz, die an der letzen

Stelle eine Ziffer aufweisen und sonst aus lauter Buchstaben bestehen. Wie viele

solche Passwörter gibt es?

(c) Vergleichen Sie die Größenordnungen der Mächtigkeiten der obigen Passwortmengen.

1.3. KOMBINATORIK.

11

Lösung.

(a) Die Menge A enthält 36 Elemente. Nachdem in einem Passwort die Reihenfolge der Zeichen wichtig ist und die Zeichen mehrmals vorkommen können,

ist die Anzahl der Passwörter gegeben durch die Anzahl der Variationen mit

Zurücklegen, also durch

368 = 2.821.109.907.456 ≈ 1012.45 .

(1.1)

(b) Es gibt 267 Passwörter mit Länge 7, die nur aus Buchstaben bestehen. Wenn wir

an jedem solchen Passwort eine Ziffer am Ende hinzufügen, erhalten wir 10 · 267

Möglichkeiten.

10 · 267 = 80.318.101.760 ≈ 1010.9 .

(1.2)

(c) Die Mächtigkeiten der obigen Mengen sind also fast zwei Größenordnungen

auseinander.

24. Kombinatorik. PINs und runs. In einem k -stelligen PIN (a1 , a2 , . . . , ak ) wird

eine n -fache Wiederholung (a, a, . . . , a) eines Elementes a mit n ≥ 2 als ein n -run bezeichnet. Zum Beispiel hat die Folge (0, 0, 1, 1, 1, 0) vier runs, nämlich einen 2-run (0, 0),

zwei 2-runs (1, 1), sowie einen 3-run (1, 1, 1).

Betrachten wir nun die Menge der 4-stelligen PINs, die aus den Ziffern {0, 1, . . . , 9}

gebildet werden können.

(a) Wie viele solche PINs gibt es?

(b) Wie viele PINs gibt es, die keine runs enthalten?

(c) Vergleichen Sie die Größenordnungen der Mächtigkeiten der obigen PIN-Mengen.

Zusatz: Führen Sie die obige Berechnung für die 5-stelligen PINs durch.

Lösung.

(a) Es gibt 104 solche PINs.

(b) Um die Anzahl der PINs ohne runs zu erhalten, zählen wir alle möglichen PINs

mit runs auf. Erste Spalte gibt die Form des PINs, zweite die Anzahl solcher

PINs und dritte die Anzahl der symmetrischen Fälle.

------*

--==

--**

*--*

10

10

10

10

10

9

9

9 9

9 9

1

2

1

2

1

Das sind insgesamt 2710 Fälle. Es gibt also 7290 PINs ohne runs.

(c) Wenn wir PINs mit runs ausschliessen, reduziert sich unser pool möglicher PINs

um ein Viertel.

25. Laplacesche Modelle. Zwei Würfel. Wie groß ist die Wahrscheinlichkeit

dafür, beim Werfen von zwei Würfeln eine Augensumme zu erzielen, die größer oder

gleich 10 ist?

12

KAPITEL 1. WAHRSCHEINLICHKEITSRECHNUNG

Lösung. Wir lösen die Aufgabe einmal unter der Annahme, dass die Würfel unterschieden werden können und einmal ohne diese Annahme.

Würfel werfen,

ist die 36-elementige Ergeb(a) Wenn wir zwei wohlunterscheidbare

©

ª

nismenge gegeben durch Ω = (i , j ) : i , j ∈ {1, . . . , 6} . Die günstigen Fälle sind

(4, 6), (5, 5), (5, 6), (6, 4), (6, 5), (6, 6).

(1.3)

Nachdem es sich hier um ein Laplace-Modell handelt, ist die Wahrscheinlichkeit,

6

dass die Summe größer als 10 ist, gleich 36

= 16 .

(b) In Falle der nichtunterscheidbaren Würfel ist das kein Laplace-Experiment

mehr. Deswegen muss geeignetes Wahrscheinlichkeitsmaß P betrachtet werden.

26.

Kombinatorik. Würfel. 4 vs. 24. Was ist wahrscheinlicher:

(a) Beim Werfen von vier Würfeln auf wenigstens einem eine Sechs zu erzielen, oder

(b) bei 24 Würfen von zwei Würfeln wenigstens einmal zwei Sechsen zu erhalten?

Lösung.

(a) Das Betrachen des komplementären Ereignisses liefert

1−

54

.

64

(b) Ein äquivalentes Model ist, 24 mal einen 36-Würfel werfen. Die Wahrscheinlichkeit wenigstens ein mal die Zahl 36 zu erhalten, berechnen wir indem wir das

komplementäre Ereignis betrachten:

1−

(c) Was ist größer?

54

64

= 0.4822530864 und

3524

.

3624

3524

3624

= 0.5085961239.

27. Kombinatorik. Single choice test. Bei einem single choice test werden n

Fragen gestellt, wobei jeweils genau eine richtige Antwort aus m Möglichkeiten

gewählt werden soll. Der Test wird als bestanden angesehen, wenn mindestens die

Hälfte der Fragen richtig beantwortet wurden.

Wir testen die Prüfmethode indem wir zufällig jeweils eine Antwort bei jeder Frage

ankreuzen.

(a) Finden Sie einen geeigneten Wahrscheinlichkeitsraum, der diese Zufallssituation

beschreibt.

(b) Wie hoch ist die Wahrscheinlichkeit, dass die zufällige Antwortwahl zum Bestehen des Tests führt?

(c) Berechnen Sie die obige Wahrscheinlichkeit explizit für n = 25 und m = 4.

1.3. KOMBINATORIK.

13

Lösung. Laplace-Modell. Anzahl der Möglichen: |Ω| = m n . Anzahl der Günstigen:

Ã

n

!

d n2 e

(m − 1)

n−d n2 e

Ã

!

à !

n

n

n−d n2 e−1

+ n

(m − 1)

+···+

(m − 1)n−n .

d 2 e+1

n

Hier zählen wir Anzahl der Tests mit d n2 e, d n2 e + 1, . . . richtigen Antworten. Eine andere

Möglichkeit ist die Anzahl der Test mit 0, 1, 2, . . . , b n2 c falschen Antworten zu zählen:

à !

Ã

!

n

n

n

2

1 + n(m − 1) +

(m − 1) + · · · + n (m − 1)b 2 c .

2

b2c

Die Wahrscheinlichkeit für das Bestehen der Prüfung beträgt also

à !

à !µ ¶ µ

¶

n

X

n (m − 1)n−i

n 1 i

1 n−i

=

1

−

.

mn

m

m

i =d n e i

i =d n e i

n

X

2

2

Die letzte Formel kann auch direkt hergeleitet werden. Für den Fall n = 25 und m = 4,

ist d n2 e = 13 und die Anzahl der günstigen Fälle gleich

3794787166756 ≈ 1012.5 .

Nachdem Anzahl der möglichen Fälle ist

m n = 425 = 1125899906842624 ≈ 1015.05 ,

ist die Wahrscheinlichkeit für eine zufällig bestandene Prüfung ungefähr gleich 0.0033.

28. Kombinatorik. Aufzug. In einem Aufzug eines 10-stöckigen Gebäudes befinden sich 7 Personen. Wie hoch ist die Wahrscheinlichkeit dafür, dass alle Personen auf

verschiedenen Stockwerken aussteigen?

Lösung.

o.W.

V10,7

V m.W.

10,7

=

10 · . . . 4

= 0, 06048.

107

29. Kombinatorik. Karten. 6 aus 52. Aus einem gut gemischten Spielkartensatz

bestehend aus 52 Karten werden zufällig 6 Karten gezogen. Wie hoch ist die Wahrscheinlichkeit dafür, dass sich unter den gezogenen Karten schwarze und rote Karten

befinden?

Lösung. Wahrscheinlichkeit dafür, dass nur rote Karten gezogen werden ist

¡26¢

6

p = ¡52

¢.

6

Daher ist die gesuchte Wahrscheinlichkeit 1 − 2p . Man kann die Zufallssituation auch

mit Hilfe der geordneten Ziehungen modellieren. Das Aufzeigen dieser Tatsache wird

sicher zum besseren Verständnis der Materie beitragen.

14

KAPITEL 1. WAHRSCHEINLICHKEITSRECHNUNG

30. Kombinatorik. Karten. 13 aus 52. Aus einem gut gemischten Spielkartensatz bestehend aus 52 Karten werden zufällig 13 Karten gezogen. Berechnen Sie die

Wahrscheinlichkeiten der folgenden Ereignisse:

(a) Es wurden alle Kartenwerte (d.h. A,2,3,4,5,6,7,8,9,10,B,D,K) gezogen.

(b) Es wurden 5 Piks, 4 Herzen, 3 Treffs und ein Karo gezogen.

(c) Es wurden 5 Karten der Farbe A , 4 Karten der Farbe B , 3 Karten der Farbe C

und eine Karte der Farbe D gezogen. Wir nehmen an, dass die Farben paarweise

verschieden sind.

Lösung.

(a)

413 · 13!

413

= ¡52¢ .

52 · · · (52 − 13)

13

Alternativ, wählen wir die erste Karte aus 52, die zweite aus 48, usw. Das ergibt

52 · 48 · · · 4

.

¡52¢

13

Nachdem jeder Term im Nenner durch 4 teilbar ist, erhalten wir wieder die obige

Formel.

(b) Es gibt

keit

¡13¢

5

verschiedene 5-Pik Mengen. Daher ist die gesuchte Wahrscheinlich-

13!

/(52 · · · (52 − 13))

p = 13 · · · (13 − 5)13 · · · (13 − 4)13 · · · (13 − 4)13

5!4!3!1!

¡13¢¡13¢¡13¢¡13¢

=

5

4

3

¡52¢

1

.

13

(c) 4!p .

31. Kombinatorik. 2 Kartenspieler. Aus einem gut gemischten Spielkartensatz

bestehend aus 52 Karten werden je 26 Karten an 2 Spieler verteilt. Berechnen Sie

folgende Wahrscheinlichkeiten:

(a) Der erste Spieler bekommt alle Asse und alle Könige.

(b) Der erste Spieler bekommt 7 Piks (♠), 8 Herzen (♥), 5 Treffs (♣) und 6 Karos (♦).

(c) Der zweite Spiele bekommt alle Farben (♣ ♠ ♥ ♦) von genau 5 Werten.

Begründen Sie Ihre Lösung.

1.3. KOMBINATORIK.

15

Lösung. Wir nehmen an, dass die Ordnung in welcher die Karten an die Spieler verteilt werden, keine Rolle spielt. Die Kartenverteilungen sind alle gleichwahrscheinlich,

es handelt sich also um ein Laplace

Modell. Die Anzahl der möglichen Verteilungen

¡52¢

ist dann in allen Fällen gleich 26 .

(a) Alle Asse und alle Könige (8 Karten) können nur auf eine Art an den ersten

Spieler verteilt werden. Zusätzlich erhält der erste Spieler 26 − 8 = 18 Karten aus

¡ ¢

den restlichen 52 − 8 = 44 Karten. Anzahl der möglichen Verteilungen ist also 44

18 .

Die Wahrscheinlichkeit für das beschriebene Ereignis beträgt

¡44¢

18

¡52¢ .

26

(b) Nachdem die Reihenfolge der Kartenverteilung keine Rolle spielt, verteilen wir

zuerst die 7 Piks an den ersten Spieler. Nachdem¡es¢ insgesammt 13 verschiedene

Piks in dem Spielkartensatz gibt, kann das auch 13

erfolgen.

7 verschiedene Arten

¡13¢

Anschliessend erhält der erste Spieler 8 Herzen – dies kann auf 8 Arten

¡ ¢

¡ ¢

geschehen, danach 5 Treffs – 13

und schliesslich 6 Karos – 13

5 Möglichkeiten,

6

¡ ¢¡13¢¡13¢¡13¢

Möglichkeiten. Insgesammt gibt es 13

verschiedene

Verteilungen,

die

7

8

5

6

die geförderte Bedingung erfüllen. Die Wahrscheinlichkeit für das beschriebene

Ereignis beträgt

¡13¢¡13¢¡13¢¡13¢

7

8

5

6

¡52¢

.

26

(c) Wir wählen zuerst 5 Werte aus 13 – 13

5 Möglichkeiten – und verteilen alle 5 × 4 =

20 Karten mit diesen Werten an den zweiten Spieler. Die restlichen 26 − 20 = 6

Karten

verteilen wir aus den übrigen 52 − 20 = 32 Karten. Dabei kommen aber

¡ ¢

8 28

solche

Verteilungen vor, in denen ein der 8 übriggebliebenen Werte 4 mal

2

vertreten ist. Die Wahrscheinlichkeit für das beschriebene Ereignis beträgt also

¡ ¢

¡13¢ ³¡32¢

5

6 −8

¡52¢

¡28¢´

2

.

26

32. Kombinatorik. 4 Kartenspieler. Aus einem gut gemischten Spielkartensatz

bestehend aus 52 Karten werden je 13 Karten an 4 Spieler verteilt. Berechnen Sie

folgende Wahrscheinlichkeiten:

(a) Jeder Spieler bekommt einen Ass.

(b) Erster Spieler bekommt genau 7 Karten einer Farbe.

(c) Erster Spieler bekommt genau 6 Karten einer Farbe.

Lösung.

(a) Wir zählen die Mengen und vernachlässigen dadurch die Reihenfolge der Karten.

Die Anzahl der möglichen Kartenverteilungen an vier Spieler ist

Ã

!Ã !Ã !Ã !

52 39 26 13

.

13 13 13 13

16

KAPITEL 1. WAHRSCHEINLICHKEITSRECHNUNG

Die Anzahl der günstigen Verteilungen: Der erste Spieler bekommt einen beliebigen Ass und 12 Karten die keine Asse sind. Der zweite Spieler bekommt

einen der drei übriggebliebenen Asse und 12 Karten die keine Asse sind. Diese

Überlegung liefert

à ! à ! à ! à !

4

48

36

24

12

3

2

1

.

12

12

12

12

Die gesuchte Wahrscheinlichkeit ist demnach

4!48! (13!)4

52! (12!)4

.

(b) Wahrscheinlichkeit für 7 Karten einer Farbe:

4

¡13¢¡39¢

7

¡52¢

6

.

13

(c) Anzahl der Günstigen wie oben. Anzahl der Möglichen:

Ã

13

4

6

! "Ã

!

à !à !#

39

13 26

−3

.

7

6

1

33. Gruppeneinteilung bei Fußball WM. Bei einer Fußballweltmeisterschaft

werden 32 Fußballteams zufällig in 8 Gruppen je 4 Teams eingeteilt. Wir nehmen an,

dass alle Gruppeneinteilungen gleichwahrscheinlich sind. Die Gruppenbezeichnungen

wie „A“, „B“, usw. werden nach erfolgter Einteilung vergeben und spielen hier keine

Rolle.

Wie viele mögliche Gruppeneinteilungen gibt es?

Lösung.

(a) Die Anzahl der möglichen Gruppeneinteilungen beträgt

Ã

!Ã ! Ã !Ã !

32 28

8 4

M=

...

/8!.

4

4

4 4

34. Kombinatorik. Schachbrett. Auf ein Schachbrett (entspricht einer 8 × 8Matrix) werden zufällig 8 Türme gestellt.

(a) Wie groß ist die Wahrscheinlichkeit dafür, dass sich die Türme nicht sehen

können, d. h. in jeder Zeile und jeder Spalte jeweils genau ein Turm steht?

(b) Wie groß ist die Wahrscheinlichkeit dafür, dass in jeder Zeile jeweils genau ein

Turm steht?

Lösung.

(a)

82 72 ···12

64···57

(b)

8! 88

64...57 .

=

8!

(648)

.

1.4. BEDINGTE WAHRSCHEINLICHKEITEN

1.4

17

Bedingte Wahrscheinlichkeiten

35. Bedingte Wahrscheinlichkeiten. Symmetrie. Seien ein Wahrscheinlichkeitsraum (Ω, A , P) und die Ereignisse A, B ∈ A mit P(A) > 0 und P(B ) > 0 gegeben.

Zeigen Sie die Äquivalenz:

P(A|B ) > P(A)

⇐⇒

P(B |A) > P(B ).

Lösung.

P (A|B ) > P (A) ⇐⇒

36.

P (A ∩ B )

> P (A) ⇐⇒ P (A ∩ B ) > P (A)P (B ).

P (B )

Bedingte Wahrscheinlichkeiten. 3 Würfel. Wir werfen drei ideale Würfel.

(a) Wie groß ist die Wahrscheinlichkeit, dass dabei kein Sechser geworfen wurde?

(b) Wie groß ist die Wahrscheinlichkeit, dass dabei kein Sechser geworfen wurde,

wenn bekannt ist, dass drei paarweise verschiedene Zahlen geworfen wurden.

Lösung. Die Menge aller Tripel aus Zahlen 1, . . . , 6 ist die Ergebnismenge. Sei A das

Ereignis, dass keine Sechser geworfen wurden und B das Ereignis, dass geworfene

3

Zahlen verschieden sind. Nun ist P (A) = 563 und P (B ) = 6·5·4

. Mit P (A ∩ B ) = 5·4·3

erhalten

63

63

1

wir P (A|B ) = 2 .

37. Bedingte Wahrscheinlichkeiten. 2 Münzen. Wir werfen zwei ideale Münzen.

(a) Die erste Münze zeigt Kopf. Berechnen Sie die Wahrscheinlichkeit, dass beide

Münzen Kopf zeigen.

(b) Eine der Münzen zeigt Kopf. Berechnen Sie die Wahrscheinlichkeit, dass beide

Münzen Kopf zeigen.

Lösung. Bezeichne mit K 1 bzw. K 2 das Ereignis, dass die erste bzw. die zweite Münze

Kopf zeigt.

(a)

P (K 1 ∩ K 2 |K 1 ) =

P (K 1 ∩ K 2 ∩ K 1 ) 1

= .

P (K 1 )

2

(b)

P (K 1 ∩ K 2 |K 1 ∪ K 2 ) =

P (K 1 ∩ K 2 ) 1

= .

P (K 1 ∪ K 2 ) 3

38. Bedingte Wahrscheinlichkeit ist ein Wahrscheinlichkeitsmaß. Seien ein

Wahrscheinlichkeitsraum (Ω, A, P ) und ein Ereignis B ∈ A mit P (B ) > 0 gegeben.

(a) Zeigen Sie, dass die Funktion Q : A → R, A 7→ P (A|B ) ein Wahrscheinlichkeitsmaß

auf (Ω, A) ist.

(b) Sei AB = {A ∩ B : A ∈ A}. Zeigen Sie, dass die Funktion R : AB → R, A 7→ P (A|B ) ein

Wahrscheinlichkeitsmaß auf (B, AB ) ist.

(c) Zusatz: Zeigen Sie, dass AB alle Eigenschaften eines Ereignisfeldes (σ-Algebra)

aufweist.

18

KAPITEL 1. WAHRSCHEINLICHKEITSRECHNUNG

Lösung.

(a) Es sollen die Axiome

von

Kologorov gelten: (A1) 0 ≤ P (A) ≤ 1 für alle A ∈ A, (A2)

¡

¢ P∞

P (Ω) = 1, (A3) P ∪∞

A

=

i =1 P (A i ) für paarweise disjunkte Mengen (A i )i ∈N .

i =1 i

)

Nun ist Q(A) = P (A|B ) = P (A∩B

P (B ) .

(b) Ein Ereignisfeld erfüllt folgende Axiome: (1) Ω ∈ A, (2) A ∈ A ⇒ Ā ∈ A, (3) A 1 , A 2 , · · · ∈

A ⇒ ∪i ∈N A i ∈ A.

39. Bedingte Wahrscheinlichkeiten. Urne mit Kugeln. In einer Urne befinden sich w weiße Kugeln und s schwarze Kugeln. Es wird eine Kugel aus der Urne

gezogen, beiseite gelegt und anschließend eine weitere Kugel gezogen. Berechnen Sie

die Wahrscheinlichkeiten der folgenden Ereignisse:

(a) Beide Kugeln sind weiß.

(b) Die erste Kugel ist weiß und die zweite Kugel ist schwarz.

Geben Sie die obigen Wahrscheinlichkeiten für w = 5 und s = 4 explizit an.

Lösung. Wir bezeichnen mit W1 das Ereignis, dass eine weiße Kugel als erste

gezogen wird, und mit W2 ein Ereignis, dass eine weiße Kugel als zweite gezogen

wird. Wir sind daran interessiert, die Wahrscheinlichkeit P (W1 ∩W2 ) zu berechnen. Wir

w

w−1

wissen aber P (W1 ∩W2 ) = P (W2 |W1 )P (W1 ) und P (W1 ) = w+s

. Es gilt auch P (W2 |W1 ) = w−1+s

.

Insgesamt ist also

P (W1 ∩ W2 ) =

w(w − 1)

.

(w + s)(w − 1 + s)

Ähnlich bezeichnen wir mit S 2 das Ereignis, dass eine schwarze Kugel als zweite

gezogen wird. Damit ergibt sich

P (W1 ∩ S 2 ) = P (S 2 |W1 )P (W1 ) =

ws

.

(w + s)(w + s − 1)

Für die oben angegebenen Werte sind die beiden Wahrscheinlichkeiten gleich

5

18 .

40. Urnenmodell. 3 Farben. Eine Urne enthält 2 weiße, 3 rote und 5 schwarze

Kugeln. Es wird eine Kugel gezogen, ihre Farbe notiert und wieder in die Urne gelegt.

Die Anzahl der Kugeln der gerade notierten Farbe wird anschließend verdoppelt falls

diese Anzahl ungerade ist. Die Prozedur wird anschließend wiederholt.

(a) Wie groß ist die Wahrscheinlichkeit dafür, dass die zweite gezogene Kugel weiß

ist, unter der Bedingung, dass die erste gezogene Kugel nicht weiß ist?

(b) Wie groß ist die Wahrscheinlichkeit dafür, dass die erste gezogene Kugel weiß

ist, unter der Bedingung, dass die zweite gezogene Kugel rot ist?

1.4. BEDINGTE WAHRSCHEINLICHKEITEN

19

Lösung.

(a) P (W2 | W̄1 ) = P (W1 ) = 15 .

(b)

P (R 2 |W1 )P (W1 )

.

P (R 2 )

P (W1 )P (R 2 |W1 )

=

P (R 2 |W1 )P (W1 ) + P (R 2 | R 1 )P (R 1 ) + P (R 2 | S 1 )P (S 1 )

P (W1 | R 2 ) =

= 0.2878.

41. Multiplikatives Urnenmodell von Pólya. Eine Urne enthält 2 schwarze

und 2 weiße Kugeln. Es wird eine Kugel zufällig gezogen, ihre Farbe notiert und