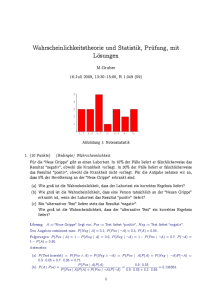

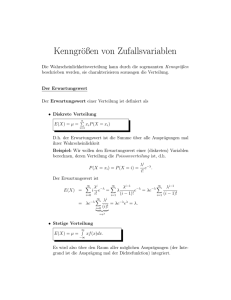

Stochastik - Hu

Werbung