Vorlesung 1 - ITET.ch.vu

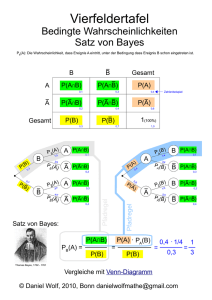

Werbung

Wearable Systems I Vorlesung 4 Vorlesung 4 14.10.2008 Bayes Klassifikator Page 01 to 13 Heute - Einstieg Datafusion, Machine Learning Bayes-Ansatz Übung Matlab: Gehen, Sitzen, Stehen Video: MIT Media-Lab Bayes Klassifikator 1. Data Fusion Definitionen - Zustand x z.B. Sägen, Schrauben - Beobachtung z z.B. markantes Geräusch - Entscheidungsregel zur Abbildung von Beobachtungen auf Zustände - Schätzen: x kontinuierlich, wir mit Hilfe von z geschätzt Entscheiden: x ist diskret Probalistische Data Fusion - Unsicherheit - Wahrscheinlichkeitstheorie - Modellierung von Zustand und Sensor 2. Wahrscheinlichkeitsmodelle Definitionen - Wahrscheinlichkeitsdichtefunktion P - Zufallsvariable y - Für die pdf (probablistic density function) P y muss gelten o P y 0 o P y dy 1 y - Verbundwahrscheinlichkeit (joint distribution) 1/5 Wearable Systems I Vorlesung 4 Verbundwahrscheinlichkeit, Modelle - Pxy x, y - Py y Pxy x, y dx x Bedingte Wahrscheinlichkeit P x, y - P x | y : P y Kettenregel - P x, y P x | y P y Vollständigkeit - Wenn die Zustände / Ereignisse x n sich gegenseitig ausschliessen unter der Voraussetzung dass y gegeben ist gilt: n n P xi | y P xi | y j1 i 1 Unabhängigkeit - x und y unabhängig, d.h. Kenntnis von y vermittelt keinerlei Informationen über x, dann gilt: P x | y P x oder P x, y P x P y bedingte Unabhängigkeit (conditional independence) - schwächere Form der Unabhängigkeit, häufig in Datafusion einsetzbar - drei Zufallsvariablen x, y und z - Kenntnis von z macht x unabhängig von y P x | y, z P x | z - Kettenregel P x, y, z P x, y | z P z P x | y, z P y | z P z P x, y | z P x | z P y | z Anwendung Datafusion - gegeben Zustand x und Beobachtungen z1 und z 2 (können nicht unabhängig sein) - Annahme: x einzige Gemeinsamkeit von z1 und z 2 Beobachtungen unabhängig voneinander, solange x bekannt ist P z1 , z2 | x P z1 | x P z 2 | x 2/5 Wearable Systems I - Vorlesung 4 Für n Beobachtungen n P z1 ,..., z n | x P z i | x i 1 3. Wahrscheinlichkeitsmodelle, Bayes’sche Theorem - Gegeben Zufallvariablen x und z sowie Verbundwahrscheinlichkeitsdichte P x, z P x, z P x | z P z P z | x P x Bays’sches Theorem: P z | x P x P x | z P z Interpretation - es sollen W’keiten verschiedener Werte des unbekannten Zustandes x bestimmt werden - a-priori Wissen über die Verteilung von x vorhanden: pdf P x - Beobachtung z, gekennzeichnet durch Signalmerkmale. Modelliert als bedingte pdf P z | x : Für jeden festen Zustand x die W’keit, dass die Beobachtung z gemacht wird - Posteriori Verteilung P x | z , berechnet durch Bayes’sche Regel, beschreibt (neue) Verteilung von x, basierend auf der Beoabachtung z P z kann zur Normalisierung von P x | z benutzt werden, oder berechnet gemäss P z P z, x i P z | x i P x i i i Sensormodell P z | x - Modellbildung: einen Wert x für x vorgeben, also x = x, und die pdf von z bestimmen - Sensorauswertung: den Wert z = z beobachten und daraus die pdf von x bestimmen - Normalerweise wird P z | x als Funktion beider Variablen (oder einer Matrix bei diskreten Werten) konstruiert - Für jeden festen Wert von x ist eine pdf in z definiert, eine Variation von x kreiert eine Familie von pdf in z 3/5 Wearable Systems I Vorlesung 4 Beispiel (Werkstatt) 4. Wiederholung und Übungsbeispiele - Buchstabenerkennung Spracherkennung Beispiel 4.1: 4/5 Wearable Systems I - Vorlesung 4 Beispiel 4.4: o Kann unterscheiden Ziel kein Ziel, jedoch nicht zwischen Ziel 1 und Ziel 2 o Wiederholte Anwendung der Bayes’schen Regel ändern nichts daran, dass Ziel 1 und Ziel 2 nicht unterschieden werden können 5. Data Fusion mit der Bayes’schen Regel - - - Beobachtungen von mehreren Quellen können durch die Bayes’sche Regel zusammengefasst werden Zn z1 Z1, z2 Z2 , z3 Z3 Benutzen, um die posteriori Verteilung P x | Zn zu bestimmen Erweiterung der Bayes’schen Regel P Zn | x P x P z1 , z 2 ,..., z n | x P x n Px | Z P z1 , z 2 ,..., z n P z1 , z 2 ,..., z n Zur Berechnung ist die Verbundw’keit P z1 , z2 ,..., zn | x erforderlich Bedingte Unabhängigkeit der Beobachtungen n P z1 ,..., z n | x P z i | x i 1 n Px | Z n P x P zi | x i 1 P Zn Beispiel 5.1 5/5