2.2 Binomialverteilung, Hypergeometrische Verteilung

Werbung

2.2

Binomialverteilung, Hypergeometrische Verteilung,

Poissonverteilung

Die einfachste Verteilung ist die Gleichverteilung, bei der P (X = xi) = 1/N

gilt, wenn N die Anzahl möglicher Realisierungen von X bezeichnet, auf die wir

hier nicht genauer eingehen wollen.

Definition 2.10. Ein Bernoulli-Experiment ist ein Zufallsexperiment, bei

dem es nur zwei mögliche Ausgänge A und B gibt. Das Ereignis A trete mit

W.K. p und das Ereignis B dann mit W.K. 1 − p = q ein. Damit wird {A, B}

zu einem Wahrscheinlichkeitsraum. Wir haben kein Laplace-Experiment, es sei

denn, p = q = 1/2.

Wenn wir ein Bernoulliexperiment n mal wiederholen, ist der Ereignisraum Ω =

{A, B}n. Die Elementarereignisse heißen Bernoulliketten. Eine Kette mit k

Ereignissen A und n − k Ereignissen B tritt mit W.K. pk q n−k ein. So wird auf

Ω ein Wahrscheinlichkeitsmaß definiert. Wir definieren nun eine Zufallsvariable

X auf diesem Wahrscheinlichkeitsraum wie folgt: Einer Bernoullikette mit k

Einträgen A und n − k Einträgen B wird die Zahl k (manchmal auch “Anzahl

32

Erfolge” genannt) zugeordnet. Offenbar gilt

n k

P (X = k) =

p (1 − p)n−k .

k

Dies ist eine Wahrscheinlichkeitsverteilung, die sogenannte Binomialverteilung

B(n, p). Sie ist komplett durch Angabe von n und p bestimmt. Wir nennen eine

Zufallsvariable binomialverteilt mit Parametern n und p, wenn ihre Wahrscheinlichkeitsverteilung B(n, p) ist. Die folgenden Bilder zeigen die Wahrscheinlichkeitsverteilungen für einige Werte von p und n:

B(21, 0.5) :

:

33

B(20, 0.2) :

:

B(100, 0.8) :

:

Kommen wir nun zur hypergeometrischen Verteilung H(n, M, N ): Wir

34

haben hier eine Urne mit N Kugeln, M davon seien rot. Wir ziehen ohne

Zurücklegen n Kugeln. Diesem Zufallsexperiment können wir ein Wahrscheinlichkeitsmaß zuordnen sowie eine Z.V. X definieren, nämlich die Anzahl k roter

Kugeln. Es gilt

P (X = k) =

M

k

N −M

n−k

N

n

.

Eine Zufallsvariable mit dieser Wahrscheinlichkeitsverteilung heißt hypergeometrisch

verteilt.

Abschließend betrachten wir die Poisson-Verteilung. Der Ereignisraum ist

hier {0, 1, . . .} die Menge der nicht-negativen ganzen Zahlen. Die Poissonverteilung

modelliert recht gut die Anzahl seltener Ereignisse, die in einem fest gewählten

Zeitraum auftreten (Tore pro Fußballspiel). Wir nennen eine Zufallsvariable P (λ)

Poisson-verteilt wenn

λk −λ

P (X = k) = e .

k!

Hier ist ein Bild für λ = 2.5, was etwa der Anzahl geschossener Tore in einem

Bundesligaspiel entspricht:

35

In der Vorlesung zeigen wir auch einige “Animationen” dieser drei wichtigen

Verteilungen.

Interessant ist, dass die Poissonverteilung als Grenzverteilung der Binomialverteilung

interpretiert werden kann: Gilt X ∼ B(n, p) mit großem n und kleinem p, so

können wir die Approximation

λk −λ

P (X = k) ≈ e .

k!

nutzen. Faustregel: n ≥ 50 und p ≤ 0.1.

36

2.3

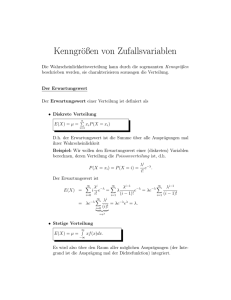

Lagemaße

Jeder Zufallsvariablen kann man gewisse Zahlen zuordnen kann, die wichtige

Eigenschaften der Z.V. beschreiben. Ein Beispiel haben wir bereits gesehen,

die Quantile (Definition 2.9). In diesem Abschnitt folgen Erwartungswert und

Varianz.

Definition 2.11. Sei X eine Zufallsvariable mit Realisierungen x1, x2, . . .. Der

Erwartungswert E(X) von X ist definiert als

E(X) :=

∞

X

i=1

xi · P (X = xi)

sofern diese Summe existiert (was im Fall endlicher Wahrscheinlichkeitsräume

immer der Fall ist).

P

Bemerkung 2.12. Es gilt E(X) = ω∈Ω X(ω)P (ω). Beachten Sie, dass auch

hier der Erwartungswert mit einer Zufallsvariablen zusammenhängt und keine

Größe des Zufallsexperimentes ist: Bei einem Zufallsexperiment kommen ja keine

Zahlen heraus. Zahlen, mit denen man dann rechnen kann, entstehen erst durch

das Anwenden von Zufallsvariablen!

37

Beispiel 2.13. Wenn wir mit zwei Würfeln werfen und als Zufallsvariable jedem Ausgang den Betrag der Differenz der Augenzahlen zuordnen, so ist der

Erwartungswert 35/18, siehe Vorlesung.

Definition 2.14. Sei X eine Zufallsvariable mit Realisierungen x1, x2, . . . und

Erwartungswert µ. Wir definieren die Varianz

V (X) := E((X − µ)2)

sofern dieser Erwartungswert existiert.

Bemerkung 2.15. Es gilt

V (X) =

∞

X

i=1

(xi − µ)2 · P (X = xi)

sowie

V (X) = E(X 2) − µ2.

Ferner wird die Wurzel aus der Varianz auch Standardabweichung σ genannt.

Entsprechend schreibt man für die Varianz manchmal σ 2.

Man kann die Abweichung einer Z.V. vom Mittelwert mit Hilfe der Varianz abschätzen:

38

Satz 2.16 (Tschebyscheff’sche Ungleichung).

P (|X − E(X)| ≥ ǫ) ≤

1

V (X).

ǫ2

Diese Abschätzung gilt für beliebige Zufallsvariablen.

Wir haben drei wichtige Wahrscheinlichkeitsverteilungen kennengelernt: Binomial, Poisson, hypergeometrisch. In der folgenden Tabelle fassen wir Erwartungswert

und Varianz dieser Verteilungen zusammen:

E(X)

V (X)

B(n, p)

np

np(1 − p)

M

M

N −n

H(n, M, N ) n N n N (1 − M

N N −1

P (λ)

λ

λ

Bemerkung 2.17. Wenn X eine Zufallsvariable ist, dann ist auch g(X) für

eine Funktion g : R → R eine Zufallsvariable. Man kann aber nicht unmittelbar

Erwartungswert, Varianz und Wahrscheinlichkeitsverteilung aus g ablesen. Es

39

gilt

E(g(X)) =

∞

X

g(xi)P (X = xi).

i=0

Satz 2.18. Sei X eine Zufallsvariable mit Erwartungswert µ und Varianz

σ 2. Dann gilt

E(aX + b) = a · µ + b

V (aX + b) = a2 · σ 2

X −µ

eine Zufallsvariable mit Erwartungswert 0 und VarInsbesondere ist

σ

ianz 1 (sofern σ =

6 0).

2.4

Gemeinsame Verteilungen und Maße von Zufallsvariablen

Satz 2.19. Seien X und Y Zufallsvariablen auf einem Wahrscheinlichkeitsraum (Ω, P ) mit Erwartungswerten E(X) und E(Y ). Dann gilt

E(aX + Y ) = aE(X) + E(Y )

40

Ein entsprechender Satz für die Varianz gilt zunächst einmal nicht.

Definition 2.20. Zwei Zufallsvariablen X und Y heißen unabhängig, wenn

für alle rellen Zahlen x, y gilt:

P (X = x und Y = y) = P (X = x) · P (Y = y).

Mit anderen Worten: Die beiden Ereignisse

{ω : X(ω) = x}

{ω : Y (ω) = y}

sind unabhängig. Allgemein nennen wir Z.V. X1, . . . , Xn auf (Ω, P ) unabhängig,

wenn für alle x1, . . . , xn ∈ R gilt

P (Xi = xi für i = 1, . . . , n) =

n

Y

P (X = xi).

i=1

Bemerkung 2.21. Beachten Sie, dass X und Y auf dem selben Wahrscheinlichkeitsraum definiert sind!

Bemerkung 2.22. Unabhängigkeit von mehr als zwei Zufallsvariablen ist eine

stärkere Bedingung als paarweise Unabhängigkeit!

41

Für unabhängige Zufallsvariablen gilt:

Satz 2.23. Seien X und Y unabhängige Zufallsvariablen auf einem W.R.

(Ω, P ). Dann gilt

E(X · Y ) = E(X) · E(Y )

sofern beide Erwartungswerte existieren, ebenso für das Produkt mehrerer

unabhängiger Zufallsvariablen

Im Fall unabhängiger Z.V. kann man auch etwas über die Summe der Varianz

sagen:

Satz 2.24. Seien X und Y unabhängige Zufallsvariablen auf einem W.R.

(Ω, P ). Dann gilt

V (X + Y ) = V (X) + V (Y )

sofern V (X), V (Y ) existieren.

Definition 2.25. Die Kovarianz zweier Zufallsvariablen X, Y ist definiert als

C(X, Y ) = E(X · Y ) − E(X) · E(Y )

sofern die entsprechenden Erwartungswerte existieren.

42

Die Bedeutung der Kovarianz wird im folgenden Satz deutlich:

Satz 2.26. Seien X und Y zwei Zufallsvariablen auf dem W.R. (Ω, P ).

Dann gilt

V (X + Y ) = V (X) + V (Y ) + 2C(X, Y ).

Eigenschaften der Kovarianz:

Proposition 2.27. X, Y, X1, . . . , Y1, . . . seien Z.V. auf W.R. (Ω, P ). Dann

gilt

(1.) C(X, X) = V (X),

C(X, Y ) = C(Y, X)

(2.) C(X, Y ) = E (X − E(X)) · (Y − E(Y ))

(3.) C(X + a, Y + b) = C(X, Y )

(4.) X und Y sind unabhängig genau dann wenn C(X, Y ) = 0

P

P

(5.) V (X1 + . . . + Xn) = ni=1 V (Xi) + 2 · 1≤i<j≤n C(Xi, Xj )

P

P

P

(6.) C( i aiXi, j bj Yj ) = i,j aibj C(Xi, Yj ).

43

(7.) C(X, Y )2 ≤ V (X) · V (Y )

Die letzte Eigenschaft zeigt, dass wir die Kovarianz normieren können. Wir nennen den Quotienten

C(X, Y )

p

V (X) · V (Y )

die Korrelation zwischen X und Y .

Beispiel 2.28. Wir würfeln zweimal nacheinander und betrachten die beiden

Z.V. X und Y , wobei X die kleinere Augenzahl ist und Y die Summe der beiden

Würfe. Die folgende kleine Tabelle zeigt die Ereignisse, die W.K. für die Ereignisse

44

sowie die Werte der Z.V.:

Ereignis

1, 1

2, 2

3, 3

4, 4

5, 5

6, 6

1, 2

1, 3

1, 4

1, 5

1, 6

2, 3

2, 4

2, 5

2, 6

3, 4

3, 5

3, 6

4, 5

4, 6

5, 6

P

X Y X ·Y

1/36 1

1/36 2

1/36 3

1/36 4

1/36 5

1/36 6

1/18 1

1/18 1

1/18 1

1/18 1

1/18 1

1/18 2

1/18 2

1/18 2

1/18 2

1/18 3

1/18 3

1/18 3

1/1845 4

1/18 4

1/18 5

2

4

6

8

10

12

3

4

5

6

7

5

6

7

8

7

8

9

9

10

11

2

8

18

32

50

72

3

4

5

6

7

10

12

14

16

21

24

27

36

40

55

Man rechnet nach:

91

≈ 2.53

36

E(Y ) = 7

2555

V (X) =

≈ 1.97

1296

35

≈ 5.83

V (Y ) =

6

35

C(X, Y ) =

≈ 2.92

12

p

Normierung der Kovarianz (d.h. Division durch V (X) · V (Y ) ergibt einen

Korrelationskoeffizienten von 0.86, die Zufallsvariablen sind also vergleichsweise

stark korreliert.

E(X) =

Was passiert, wenn wir Z.V. Xi haben, die auf verschiedenen Wahrscheinlichkeitsräumen

(Ωi, Pi) definiert sind. Dazu definieren wir Ω = Ω1 × . . . × Ωn und definieren auf

Ω das Produktmaß

P (ω1, . . . , ωn) = Πni=1P (ωi).

Zumindest im abzählbar unendlichen Fall ist das kein Problem und wir können

so jeder Teilmenge von Ω eine Wahrscheinlichkeit zuordnen. Die Xi kann man als

46

unabhängige Zufallsvariablen auf diesem Produktraum auffassen und wir können

damit arbeiten so wie oben für den Fall dass die verschiedenen Z.V. auf einem

W.R. definiert sind.

Der begriff der Unabhängigkeit mehrerer Zufallsvariablen wird wie folgt definiert:

Definition 2.29. Zufallsvariablen X1, . . . , XN heißen unabhängig wenn für alle

x1, . . . xn gilt:

P (X1 ≤ x1 ∩ . . . ∩ Xn ≤ xn) =

n

Y

i=1

P (Xi ≤ xi).

Man kann dann zeigen, dass für unabhängige Zufallsvariablen gilt E(X1 · · · Xn) =

E(X1) · · · E(Xn). Ferner gilt das für die Statistik wichtige schwache Gesetz der

großen Zahlen:

Satz 2.30. Es seien X1, . . . , Xn unabhängige Zufallsvariablen auf einem

Wahrscheinlichkeitsraum (Ω, P ) (im Fall der n-fachen Wiederholung eines

Zufallsexperimentes nimmt man hier den Produktraum, siehe oben), die

alle dieselbe Verteilungsfunktion haben (i.i.d.: independently identical distribution) mit Erwartungswert µ und Varianz σ 2. Dann ist auch X̃ =

47

1

n (X1

+ . . . + Xn) eine Zufallsvariable auf Ω mit

lim P (|X̃ − µ| < ǫ) = 1

n→∞

für jedes ǫ > 0.

2.5

Der kontinuierliche Fall

Im Fall eines Wahrscheinlichkeitsraumes mit einer überabzählbaren Ereignismenge

Ω kann man, wie bereits erwähnt, nicht mehr sinnvoll jedem Ereignis eine Wahrscheinlichkeit zuordnen. Deshalb muss man bei der Definition einer Zufallsvariablen

X : Ω → R darauf achten, dass den Ereignissen

{ω : X(ω) ≤ x}

Wahrscheinlichkeiten zugeordnet werden können. Wir wollen diese Annahme

ab jetzt stillschweigend machen. Dann können wir wie im diskreten Fall eine

Verteilungsfunktion F : R → R definieren:

F (x) := P (X ≤ x)

48

Die Definitionen 2.9 und 2.7 übertragen sich, ebenso wie Satz 2.5 und Proposition

2.3.

Es sei noch bemerkt: Wenn der Wahrscheinlichkeitsraum Ω unendlich viele Elemente, die Zufallsvariable X aber nur endlich viele Realisierungen hat, sprechen

wir von einer diskreten Zufallsvariable.

Die Frage ist nun, ob es auch so etwas wie eine Wahrscheinlichkeitsverteilung gibt.

Wir können im kontinuierlichen Fall in der Regel den einelementigen Ereignissen

keine positive Wahrscheinlichkeit zuordnen, ebenso kann man den Ereignissen

{ω : X(ω) = x} nicht immer eine positive W.K. zurodnen. Das Analogon zur

Wahrscheinlichkeitsverteilung ist hier die Dichtefunktion:

Definition 2.31. Wenn es für eine Verteilungsfunktion F eine Funktion f :

R → R gibt mit

Z x

f (t)dt,

F (x) =

−∞

so heißt f die zu F gehörende Dichtefunktion. Wir nennen X dann eine stetige

Zufallsvariable mit Verteilungsfunktion F und Dichte f .

Proposition 2.32. Sei X eine stetige Zufallsvariable mit Dichte f und

49

Verteilungsfunktion F . Dann gilt F ′(x) = f (x) und

Z b

f (t)dt.

P (a ≤ X ≤ b) =

a

Insbesondere gilt P (X = x) = 0.

Beispiel 2.33 (Normalverteilung). Die vermutlich bekannteste und wichtigste

Verteilungsfunktion ist die Normalverteilung mit Dichte

1 x−µ 2

1

f (x) = √ e− 2 ( σ )

σ π

Wir nennen eine Z.V. normalverteilt wenn es µ und σ > 0 so gibt, dass die

Verteilungsfunktion der Z.V. diese Dichte hat, geschrieben X ∼ N (µ, σ 2). Gilt

µ = 0 und σ = 1 nennen wir die Zufallsvariable standardnormalverteilt. Die

zugehörige Verteilungsfunktion wird oft mit Φ bezeichnet. Sie ist als (im wesentlichen)

2

das Integral der Funktion e−x nicht durch “einfache” Funktionen darstellbar.

Auch die Begriffe Varianz und Erwartungswert lassen sich auf kontinuierliche

Zufallsvariable übertragen:

50