Lernmaterialien_Abschlusspruefung_Muesseler - S-Inf

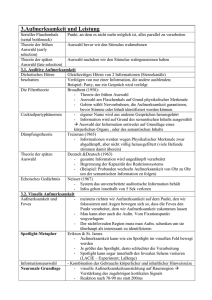

Werbung