Zusammenfassung der Buchkapitel vom Kleiter, gesendet von Yvonne

Werbung

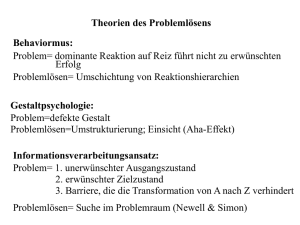

Summary: Thinking and Reasoning ©Kiwi Disclaimer: [email protected] Thinking and Reasoning Ed. By Keith J. Holyoak and Robert G. Morrison Chapter 1: A Reader’s Guide Ich denke, also bin ich. (Descartes) Denken macht unsere Identität aus, definiert uns also noch mehr als unsere Sprache: Wenn jemand die Fähigkeit zu Sprechen verliert, ist er bloß Stumm – verliert er aber durch eine Läsion die Fähigkeit zu Denken, so hat dies tief greifende Persönlichkeitsveränderungen zur Folge. Was ist Denken? Im alltäglichen Sprachgebrauch hat „Denken“ viele verschiedene Bedeutungen. Im Englischen wären das beliefs, foresight, judgment etc. Also ähnlich wie im Deutschen. Denken kann in Kinds-Orderings unterteilt werden oder in Part Orderings – part-ofs systematisiert werden. Somit hätten wir als mentale Aktivitäten eine Hierarchie von unten nach oben bei den Kinds und von oben nach unten bei den parts orderings, in welche sich die folgenden Begriffe einordnen: Thinking Conceptualizing Remembering-Reasoning-Reading (alternativ: bei part oderings ist rememb. Übergeordnet) Deciding Planning Schlussfolgern (Reasoning) basiert auf dem Ziehen von Schlüssen (conclusions) aus initialen Informationen (Premises). Man kann induktiv oder deduktiv schlussfolgern. Urteilen und Entscheiden bezieht sich auf Werte und Wahrscheinlichkeiten sowie Alternativen. Problemlösen bedeutet, eine Aktion zu konstruieren um ein bestimmtes Ziel zu erreichen. Def.: Denken ist eine systematische Transformation mentaler Repräsentationen von Wissen um aktuelle oder mögliche Zustände der Welt zu Charakterisieren. Dies dient oft Zielen. Das klingt jetzt ziemlich kompliziert und wird daher erstmal erläutert bzw. auf gebräuchliches Deutsch übersetzt: Denken ist eine Umformung, die bestimmten Regeln unterliegt (system. Trans) Dabei werden innere Beschreibungen umgeformt. (mentale Repräsentationen) Diese inneren Beschreibungen beziehen sich auf das was in der Welt ist, oder sein könnte (aktuelle oder mögliche Zustände der Welt) Solche Umformungen dieser Beschreibungen machen wir meistens nicht einfach so (schließlich sind wir nicht alle Philosophen) sondern sie haben ein Ziel: Kurzum, wir Denken, weil wir Denken müssen um zu einem sinnvollen Resultat zu kommen. Da steht vieles drinnen, aber es fehlt auch vieles. Z.B. steht nicht drinnen, dass nur Menschen denken können. Auch Tiere denken! Oder man denke an die künstliche 1 Summary: Thinking and Reasoning ©Kiwi Disclaimer: [email protected] Intelligenz… Und was noch nicht drin steht, ist das Denken rational, optimal, wünschenswert und klug sein müsste. Wir können also ganz schön blöd denken, es ist aber trotzdem „Denken“. Ein Stück Geschichte Denken und Schlussfolgern war und ist eines der Lieblingsthemen von Philosophen. Kant, Hume, Hobbes u.a. beschäftigten sich mit „unserer Materie“, bis später die Gestaltpsychologen das Ruder an sich rissen (Duncker, Wertheimer, Köhler). Sogar Freud beschäftigte sich mit kalten kognitionen und heißen Emotionen. Piaget, Vygotsky usw. beschrieben die Entwicklung des Denkens. In Russland brachte der Neurologe Luria die Thematik auf eine biologische Ebene. In den US wurde die Thematik von Simon auf die Wirtschaft angewandt und er erhielt sogar einen Nobelpreis. In GB beschäftigte man sich ab 1943 mit Modellen. Die moderne Forschung entspringt der computationalen Analyse des Denkens aus den 70ern. Rosch (stützte sich auf Bruner) fragte nun nach dem Warum der Kategorisierung in unserem Denken und fand die natürlichen Kategorien mit ihren „fuzzy boundaries“ mit zentralen Tendenzen und Prototypen. Tversky und Kahneman identifizierten kognitive Strategien (Heuristiken) für schnelle, sichere Entscheidungen. Marr löste mit seinem technisch-orientierten Buch Vision eine computationale Implementation psychischer Repräsentationen aus: Repräsentationen und Algorithmen waren nun eine Input-Output Relation in einen cash-Register. Dann folgten neurale Netzmodelle, kognitive Neurowissenschaften usw. Chapter 3: Concepts and Categories: memory, Meaning, and Metaphysics Einführung Konzepte sind allgemeinhin als mentale Repräsentationen akzeptiert, die sich auf eine bestimmte Kategorie von Objekten (Entitäten) bezieht. Was alles in diese Kategorie gehört wird durch Regeln definiert. Die grundsätzlichen Funktionen von Konzepten sind die Kategorisierung und die Kommunikation. Das Wissen über ein Konzept führt zu Verständnis und so zur Möglichkeit, Vorhersagen zu treffen. So kann anhand neuer Einheiten das KonzeptRepertoire einer Person erweitert werden: Kategorisierung erleichtert das lernen. Auch können Planungen von Handlungen zur Erreichung von Zielen anhand von Konzepten erleichtert werden. All diese Auswirkungen von Konzepten betreffen das Gedächtnis und die Gedächtnisorganisation, da Konzepte letztendlich nichts anderes als mentale Repräsentationen im Gedächtnis sind. Geschichte Die zwei zentralen Fragen der Forschung waren: 1. Werden Konzepte durch graduelle Zunahmen der Assoziativen Stärke gelernt oder lernen wir nach einem „alles oder nichts“-Prinzip? 2. Welche Art von Regeln oder Konzepten werden am einfachsten gelernt? Die erste Forschung basierte dabei v.a. auf künstlichen Konzepten. In diesem Sinne war Kategorielernen ein Herausfinden der Definition der Zugehörigkeit zu einer Kategorie. Ein erster Wendepunkt erfolgte im Zuge der Modelle zur Gedächtnisorganisation, wo Quillian (1967) das hierarchische Modell für semantische Information anhand eines Computerprogramms darstellte. Es gibt dabei generelle Regeln die ökonomisch für 2 Summary: Thinking and Reasoning ©Kiwi Disclaimer: [email protected] jede übergeordnete Kategorie gelten, aber nicht zwingend gelten müssen, da die Merkmale für untergeordnete Entitäten oder Kategorien auch Ausnahmen erlauben. Anhand des hierarchischen Zugriffes auf Informationen (z.B. Merkmalsinformation aus der übergeordneten Kategorieregel vs. Aus der über-übergeordneten Kategorieregel) wurden Vorhersagen zu Reaktionszeiten getroffen, die so auch bestätigt wurden. Andere Belege lieferten die Experimente des lexikalischen Primings, wo Wortbedeutungen leichter aufgefunden wurden, wenn zuvor ein semantisch-verwandtes Wort geprimed wurde. Der zweite Wendepunkt widersprach dem Modell der globalen Gedächtnisorganisation in Quillians Semanitschem Gedächtnis. Dieser findet sich in Eleanor Roschs (frühe 70er) „family resemblance“: Die Ähnlichkeiten eines Objektes zu den anderen Objekten einer Kategorie bestimmt die Stärke der Zugehörigkeit. Dies ließ sich in Typikalitäts-Beurteilungs-Experimenten nachweisen. Die Hierarchische Struktur behielt Rosch et. Al bei, indem sie „basic-level categories“ vorschlug, die sich wieder in der Realität bestätigen ließen: Überlappende Informationen von Kategorisierungen bestimmte die Reaktionszeit (ein Spatz ist ein Vogel vs. Ein Pinguin ist ein Vogel). Diese Ähnlichkeit zueinander, in einer Kategorie, nennt sich Typikalität. Semantik ist mehr als nur eine Bedeutungsbestimmung eines Wortes. Ein einzelnes Wort hat in verschiedenen Sätzen unterschiedliche Bedeutungen, sodass die Prototyp-Bedeutung des Wortes alleine vielschichtig einsetzbar ist. Die Fuzzy set theory von Zadeh, 1965 thematisiert genau diese unvorhersagbare Abweichung einer Bedeutung in einem Satz von der Prototyp-Bedeutung eines Wortes. Das Problem der Bedeutung neuer Sätze bleibt damit aber dennoch ungeklärt. Funktionen und Befunde Wie Roschs Family resemblance-Hypothese, so schlägt auch die Prototype-View vor, dass Menschen die Charakteristiken einer Kategorie lernen um diese zu Repräsentieren. Posner und Keele belegten den Vorschlag einer PrototypAbstraktion indem sie Evidenz für eine Abnahme korrekter Kategorisierung bei Zunahme der Abweichung von Prototypen verzeichneten. Es zeigte sich auch, dass das Gedächtnis für gelernte Muster schneller verfiel als jenes für gelernte Prototypen. Trotzdem werden gelernte Beispiele in der „exemplar view“ als Facilitatoren zum Erwerb neuer Kategorisierungen gesehen. Beispiele sind auch hilfreicher zur Kategorisierung anhand von within-category-Beziehungen. Neuere Modelle betreffen Rationelle Zugänge, Entscheidungsbezogene Modelle und Neurale-Netzwerkmodelle: Anderson (1990) beschrieb Kognition und Kategorisierung als (rationale) Analyse der verfügbaren Information in der relevanten Situation um abstrakt zu bestimmen was die effizienteste, wenn nicht gar optimale Strategie wäre. Entscheidungsbeozogene Modelle proklamieren dass Kategorielernen in der Entwicklung von Entscheidungsgrenzen einer Kategorie besteht. Je näher ein Item an der Entscheidungsgrenze liegt, desto schwieriger sei es zu kategorisieren. Neurale Netzwerkmodelle konzeptualisieren Konnektionistische Modelle, wo versteckte Einheiten, Aufmerksamkeitsprozesse, Rücklauf etc. eine Rolle spielen. Dabei ist v.a. wichtig, dass within-category-Beziehungen durch bottom-up Strukturen besser erklärbar werden. Die Modelle können anhand von mixed models ineinander überführt werden: Regeln, Beispiele und Entscheidungsgrenzen sowie Prototypen werden so miteinander kombiniert. Z.B. das Multiple Gedächtnissystem von Knowlton und Squire setzt eine Dissoziation zwischen Kategorisierung und Erkennung voraus: Explizites Gedächtnis wäre dabei für Beispiele zuständig und das Implizite System bezöge sich eher auf die 3 Summary: Thinking and Reasoning ©Kiwi Disclaimer: [email protected] Prototyp-Abstraktion. Amnesiepatienten hätten dann das explizite System verloren aber könnten wegen intaktem Gedächtnis ohne weiteres Klassifikationen vornehmen. Es gab aber auch Belege gegen diesen Zugang. Ein weiterer Zugang beschäftigte sich mit dem Inferenz-Lernen, welches auf dem Nutzen der Kategorisierung basiert, der in den anderen Modellen nicht beachtet wurde. Dabei wird auch vorgeschlagen, dass eine Kohäsive Kategoriestruktur für das Inferenzlernen wichtiger ist als für die Klassifikation. Die Regeln für Kategorisierung beziehen sich auf oberflächliche Merkmale und sind nicht relevant für die Kontexte multipler Funktionen oder Bedeutungen. Das Merkmalslernen setzte bislang voraus, dass diese Merkmale unveränderlich bleiben, was heute aber flexibler gesehen wird. Merkmalslernen ist auch für die Bedeutung von Ähnlichkeit bei Kategorisierung wichtig, da diese Ähnlichkeit dann unter dem Gesichtspunkt der Merkmale nur ein Nebenprodukt von Kategorielernen ist. Schlussfolgern wird durch between-category-Beziehungen geleitet. Sprachliche Funktionen werden auch durch Konzepte moduliert, da das Verständnis und diskursive Denken über Dinge auf Konzepten beruht. Konzepte können auch als Positionen in Gedächtnisstrukturen gesehen werden. Dazu stellt sich die Frage, inwiefern die Netzwerke verschiedener Personen übereinstimmen müssen, um dieselbe Bedeutung für ein und denselben Begriff zu finden. Goldstone und Rogosky (2002) testen die Verschiedenartigkeit in Form von „noise“ in der Distanz zwischen Begriffen und finden einen Zusammenhang zwischen Korrektheit der Kategorisierung und der Menge an Noise. Konzeptkombinationen produzieren eine breitere Einheit an linguistischer Bedeutung. In der Sprache heißen solche Kombinationen Komponenten, wobei man zwischen dem head-noun und dessen modifier (adjektiv) unterscheidet. Wie hängt die Typicalität in diesen Kombinationen von der Typikalität der einzelnen Komponenten ab? Man kann diese Abhängigkeit getrennt oder als gemeinsames gesamt-neues Konzept betrachten. Die Komplexität verschiedener Modelle variiert dabei. Z.B. hat Smith (1988) die adjectiv-Nomen Kombinationen anhand von Wertänderungen erklärt: Das Adjektiv ändert den Wert des Nomens (intersektion). Kompliziertere Modelle hingegen (noninsertective) sprechen von einer Beziehung die den Modifizierer und den Kopf verbindet, oder von einem Wert der dem Modifizierer entnommen und dem Kopf zugeschrieben wird. Eigenschaften können aber die Typicalität beeinflussen und somit ergibt sich die Typicalität aus Kombinationen nicht aus einer Funktion der Typicalität ihrer Komponenten. Rips (1995) nannte dies das „no peeking principle“, nämlich dass man nicht auf die einzelnen Bezüge der Komponenten zeigen darf. Manche Kombinationen sind erschwerend noch „compounds“ bzw. lexikalisierte Phrasen. Die Schwierigkeit bei deren Kategorisierung besteht in der über die einzel-Repräsentation hinausgehenden Bedeutung der Komponenten (z.B. geräucherte Äpfel: Geräuchertes schmeckt gut, Äpfel schmecken gut, aber geräucherte Äpfel…?). Inferentielle und Problemlösungs-Fähigkeiten sind komplexe Prozesse. Daher ist es kaum möglich, sie für die Geschwindigkeit beim Sprechen und Verstehen verantwortlich zu machen. Andere Modelle sind Atomistische Annahmen. Modelle über Latente semantische Analysen nehmen die Häufigkeit eines Wortes in spezifischen Kontexten und setzen sie aufgrund dessen in die Nähe der Kontexte. Dabei entsteht ein 300-Dimensionaler Raum wo in diesem Riesen-Daten-Körper die indirekten Verbindungen zwischen Wörtern über deren Bedeutung informieren. Dadurch bleibt aber der Erwerb neuer Sätze sowie der Satzstruktur ungeklärt. Beziehungen zwischen Semantiken sind asymmetrisch (vater=verwandter aber 4 Summary: Thinking and Reasoning ©Kiwi Disclaimer: [email protected] verwandter=?vater). Das Online-Satz-Verständnis erfolgt schnell und reliabel. Vielleicht sollte man zwischen der Interpretation und dem Verständnis solcher Phrasen unterscheiden. Verständnis wäre dann eine Wortbasierte Erkennung der Bedeutung neuer Phrasen. Interpretation hingegen beruht auf dem Ergebnis des Verständnisses plus Inferenz und Wissen. Man könnte Wortbedeutungen als mentale Einheiten repräsentieren, deren semantischer Wert von der kausalen Beziehung der Referenzen stammt. Generikum-Nomen-Phrasen haben einen normativen Inhalt (Vögel können Fliegen.). Diese Normativität wird akzeptiert, obwohl offensichtlich ist, dass es zahlreiche Ausnahmen gibt. Diese Sätze sind auch ein beliebtes Instruktionsmittel in der Erziehung. Sie werden nämlich bereits von 4jährigen von den Allquantor-Sätzen unterschieden. Polyseme Wörter haben mehrere gekoppelte Bedeutungen, im Gegensatz zu Homonyme, die haben viele ungekoppelte Bedeutungen, oder Kontextvariationen, das ist eine andere Benützung derselben Bedeutung. Die Beziehungen der Bedeutungen von Polysemen Wörtern hat dabei eine eigene Typikalität. Forscher beschäftigten sich mit der Frage, ob jede einzelne Bedeutung abgespeichert wird oder nur die Kernbedeutung. Diese Forschung stößt sich aber an der Irregularität, wie verschiedene Bedeutungen zustande kommen. Theorien, Module und Psychometaphysics Generelles Wissen über eine Kategorie ist bei der Nützung von Hintergrundwissen bei der Interpretation von Kombinationsphrasen relevant. Aber nicht nur dort: Hintergrundwissen wird auch aktiviert, wenn es einfache Entscheidungsregeln gäbe. Natürliche Kategorien implizieren meist kausale Information, da Physikalische Gründe die Kategorie bestimmen. Bei Artifacts ist die relevante Information die Absicht der Person, die dieses Objekt produziert hat. Die Psychometaphysics ist der Glaube der Personen über den Locus der Kausalen Kräfte. Dieser Glaube könnte sich auf eine Kausalität oder eine ganze menge solcher Kausalen Kräfte beziehen. Sie könnten modular (isoliert), angeboren, universal und in spezifischen Hirnregionen lokalisiert sein. Sie könnten aber auch frei fließend, gelernt, kulturspezifisch und im Kortex verteilt sein. Psychologischer Essentialismus bezieht sich auf die internale Eigenschaft – Essenz eines Objektes, das die Existenz, Kategorie, Merkmale usw. ausmacht. Dabei geht es aber nicht um die Natur sondern um den Glauben der Menschen über diese Objekte. Außerdem haben Menschen keine voll ausgearbeitete Erklärung dessen, was eine Essenz ist. Sie haben einen Glauben darüber, dass es da etwas geben muss, das relevant für dessen Essenz ist, auch wenn man das nicht beschreiben kann. Essenzen lassen Annahmen zu und motivieren zur genaueren Untersuchung von Charakteristika. Evidenz dafür ist aber nur indirekt nachweisbar - z.B: Tiefere Ursachen (die selbst wenig Ursachen und viele Effekte haben) spielen in der Kategorisierung bei Erwachsenen eine größere Rolle. Strevens minimalistische Alternative ist, dass Menschen für jede typische Eigenschaft eine Ursache besteht und dass es auch ein bisschen von verschiedenen Eigenschaften abweichen kann. Lernen Menschen Künstliche familiäre Ähnlichkeitskategorien, so glauben sie, dass jede Kategorie eine eigene definierende Eigenschaft besitzt. Also hat Essenzialismus nichts mit natürlichen Arten zu tun? Sortalismus geht nicht von der Essenz als Identität eines Objektes aus sondern von der Unterscheidung dieses Objektes von anderen. Die kritische identitäts-verleihende Kategorie beantwortet die Frage „Was ist es?“. Diese Identitäsbedingungen sind mit lediglich einer Kategorie für jedes Objekt verbunden und nennen sich dann Sortals. 5 Summary: Thinking and Reasoning ©Kiwi Disclaimer: [email protected] Sortalismus. Es gibt Evidenz aus Studien, dass kleinen Kindern diese Fähigkeit fehlt, Objekte über temporäre Brücken wieder zu erkennen – man führte dieses auf die fehlenden Konzepte zurück. Ein Widerspruch in dieser Theorie findet sich in der Unmöglichkeit, Existenz und Essenz zu vereinbaren. Mitglieder von sortalen Kategorien können ihre Essenz nicht verlieren, ohne ihre Existenz zu verlieren. Entsprechend können wir auch nicht Widerspruchsfrei glaub en, dass basic-level Kategorien Sortals sind und dass Objekte von einer zur anderen basic-level Kategorie springen können. Sortalismus beschreibt Identität also unzureichend. Domänenspezifität Lernen in gegebenen Domänen ist durch Prinzipien, Implikationen und möglicherweise angeborene Annahmen über die Welt geleitet. 2 Domänen können unterschieden werden wenn sie ontologisch verschiedene Einheiten und Phänomene repräsentieren und in verschiedene kausal-explanatorische Rahmen gefasst sind. Eine dieser Domäne ist die naive- oder Volks-Biologie und die dazugehörigen Universalitäten. Die Art-Spezien (generic species) stimmen oft mit den wissenschaftlichen Spezies überein. Kulturen organisieren die Biologie in eine Hierarchie, die in den verschiedenen Kulturen wenig variiert. Bei dieser Taxonomie geht es aber nicht um Nützlichkeit. Die Hierarchie schlägt sich auch im Schlussfolgern nieder (induktive Inferenz) indem unter Vorschülern von einer weißen Eiche auf alle weißen Eichen eher geschlossen wird, als von einem Baum auf weiße Eichen. Das widerspricht Roschs basic-level-Studien. Dabei spielt aber offensichtlich statt Wissen eher die Erwartung über eine Benennung eine Rolle, sodass dieser Widerspruch vorsichtig interpretiert werden muss. Differenzen zwischen Domänen wurden ausführlichst anhand der Unterscheidung Psychologie vs. Biologie untersucht. V.a. an Kindern zeigt sich eine eher biologische Sichtweise von Erblichkeit u.a., also eher ein eigenes biologisches Konzept. Die relevanten Hirnregionen für die Domänen werden evident, wenn man sich verschiedene Läsionsstudien vor Augen hält. Das könnte man aber auch interpretieren, indem man unterschiedliche Informationen (Wahrnehmung für Lebende Objekte, funktionale Information für Künstliche Objekte) für die Domänen annimmt. Ist etwa auch die Gedächtnisorganisation domänenspezifisch? Wir können auch mit Informationen arbeiten, die schlecht organisiert sind. Einerseits wurde semantisches Gedächtnis zunächst als hierarchisches Netzwerk thematisiert. Andererseits unterteilen Modularität und Domänenspezifität den Gedächtnisraum in getrennte theoretische Domänen. Dadurch werden aber nicht Kategorien taxonomiert, sondern Annahmen. So überlappen sich Kategorien, indem sie in mehrere Domänen passen. Dann müsste LTM Konzepte in jeder Bezugsdomäne speichern: Gedächtnismodule speichern ein und dasselbe Konzept in einem Individuum unterschiedlich ab. Das würde die Theorien zur Ähnlichkeit, zur Aussprache und Beziehungen zwischen den Begriffen ablösen – was genauso wenig Sinn machen würde. Gedächtnis steht bestimmt für bedeutungsvolle Beziehungen zwischen Konzepten, wobei es dabei um die Wortbedeutung an sich gehen könnte. Generelles Wissen (auch semantisches Gedächtnis oder generic memory genannt) steht der persönlichen Erfahrung gegenüber. Die Semantische Ebene muss aber nicht lexikalisch organisiert sein. Es könnte auch sein, dass auf einer subkonzeptuellen Ebene (Eigenschaften und versteckte Einheiten) doch eine rein semantische Dimension des Gedächtnisses vorhanden ist. Schlussfolgerungen und Ausblick 6 Summary: Thinking and Reasoning ©Kiwi Disclaimer: [email protected] Forscher fokussieren zunehmend Interaktionen zwischen Funktionen, d.h. werden sensitiv auf multiple Funktionen. Empirische Generalisierung und Computationale Modelle werden vor allem in der kognitiven Neurowissenschaft anhand multipler Kategorisierung und Gedächtnissysteme angewandt. Es stimmt nicht, dass Konzepte für unser online-Satzverständnis nicht mit den Konzepten zusammenhängen, die wir fürs Schlussfolgern und Kategorisieren verwenden. Es liegt also auch im Zukünftigen Interesse, eine Schnittstelle zwischen diesen Funktionen zu finden: Mehr Interaktion zwischen Arbeiten zu Konzepten und psycholinguistischer Forschung ist also in Aussicht. Es bleibt auch zu erwarten, dass in Zukunft die Versuchspersonen anderswo rekrutiert werden, als nur unter Studenten. Auch Studien mit mehreren Sprachen könnten fragen zu Linguistik und Konzeptentwicklung beantworten. Psychometaphysische Zugänge sind genauer als zunächst kritisiert und werden daher auch relevant bleiben. Kombinationen in Fragmentarischen Forschungen zu Konzepten in Konzepten werden notwendig sein, um die Beziehungen zwischen ihnen zu untersuchen. Chapter 14: Problem Solving Einführung Duncker 1945 definiert Problemlösen so: Ein Problem tritt auf wenn eine lebende Kreatur ein Ziel hat, aber nicht weiß, wie sie dieses Ziel erreichen kann. Wenn man nicht durch eine einfache Handlung von einer gegebenen Situation zu einer erwünschten Situation gelangt, so wird darüber nachgedacht. (recourse of thinking) Ein Problem bezieht sich auch immer auf die individuellen Möglichkeiten und das Hintergrundwissen einer Person. Daher muss man Denken verstehen, indem man die Repräsentation des Problems vom Lösungsweg (Schritte) des Problemlösers unterscheidet. Das Modell, das die Problemrepräsentation darstellt, enthält idealerweise Information über das Ziel, die Objekte und deren Interrelationen, die Operationen die angewandt werden können und Bedingungen zur Lösung des Problems. Für manche Probleme ist es am wichtigsten, die beste Repräsentation zu finden. Bei anderen hingegen muss der beste Lösungsweg vom Anfangsstatus zum Zielstatus gefunden werden. Beispiele sind Posner’s Züge und Vogel – Problem oder der Tower of Hanoi. Wenn Forscher also Problemlösen untersuchen, so stellen sie Personen vor eine Anzahl von Problemen für welche diese Personen keine Lösung gespeichert haben, sodass die Forscher Regelmäßigkeiten in dem resultierenden Problemlöseverhalten untersuchen können. Dabei untersuchen sie die Problemrepräsentation oder die Operationen im Lösungsweg. Geschichte Duncker und Wertheimer brachten im Rahmen der Gestaltpsychologie erste Forschungsansätze zum Problemlösen. Auch Mathematiker interessierten sich für diesen Zweig. Nach dem Untergang der Gestaltpsychologie beschäftigten sich erst wieder Newell und Simon 1972 mit dem menschlichen Problemlösen, allerdings nun als Schritt-für-Schritt-Prozess um generelle Eigenheiten zu finden. Daraus entwickelte sich der Computerorientierte (AI) Zugang mit dem Programm „General Problem Solver“. Die Kognitive Psychologie berücksichtigte dann zunehmend Hintergrundwissen. GPS hatte das Problem dass ihm Domänenspezifisches Wissen fehlte. Dieser Zugang über das Hintergrundwissen spielt auch eine Rolle in der 7 Summary: Thinking and Reasoning ©Kiwi Disclaimer: [email protected] Annäherung der 2 Forschungstraditionen zu einerseits Problemrepräsentation und andererseits Operationen im Lösungsweg. Generierung von Problemlösungen Die Untersuchung von Operationen im Lösungsweg brachte die Unterscheidung zwischen algorithmischen und heuristischen Strategien. Algorithmisches Problemlösen basiert auf einer Prozedur, die eine Lösung garantiert, z.B. eine mathematische Formel. Ein anderer Algorithmus ist die exhaustive Suche, die aber sehr schnell unpraktikabel oder gar unmöglich werden kann. Heuristiken garantieren zwar keine Lösung, aber versprechen mit hoher Wahrscheinlichkeit Erfolg. Es geht dabei meist um Puzzle-ähnliche Probleme, wo es darum geht, Lösungswege wie viele Astgabelungen zu generieren. Betrachtet man das Problemlösen als eine Suche durch einen Problemraum, so teilt man Newell und Simons Meinung. Die Autoren beschrieben den Problemraum als ein Set von Wissenszuständen (Beginn-, Intermediater-, Aktueller- und ZielZustand). Die Ergebnisse ihrer Forschung zeigte, dass sich diese Suche auf eine kleine Anzahl von Heuristiken stützt. Diese wurden über Laut-Denk-Protokolle (welche von Duncker übernommen wurden, nachdem sie von den Behavioristen für lange Zeit verachtet worden waren) oder Computersimulationen analysiert. Hill climbing (Bergsteigen?) ist eine Heuristik, wo in jedem Lösungsschritt der Operator angewandt wird, der einen neuen Zustand hervorruft, der am besten zum Zielzustand passt. Dazu zeigte sich, dass Probanden bei Problemen tatsächlich die größten Schwierigkeiten hatten, wenn in einem Schritt eine Entfernung zum Ziel gemacht werden musste, um dann tatsächlich zum Ziel zu kommen. Means-ends analysis ist eine Heuristik, die darin besteht 1) die Differenz zwischen dem aktuellen Zustand und dem Ziel (oder Subziel) zu identifizieren, 2) einen Operator zu finden, der diese Differenz beseitigt oder reduziert, 3a) diesen Operator anwenden, sofern dies geht, oder 3b) wenn er nicht direkt angewandt werden kann ein Subziel setzen um das Hindernis zu beseitigen das die Durchführung des gewünschten Operators behindert. 4) Die Schritte 1-3 wiederholen, bis das Problem gelöst ist. Der Unterschied zwischen hill-climbing und means-ends-analysis besteht in der online-Generierung von Subzielen in der MEA. Über Subziele können auch unvernünftige Schritte erklärt werden und die Verästelung der Lösungswege im Lösungsraum verzweigt sich weiter. MEA wurde auch mit GPS untersucht. Anscheinend ist MEA auch die von den meisten Personen präferierte Lösungsmethode für neue Probleme. Sobald aber ein Problem besonders partikulär wird, werden auch spezialisiertere Strategien herangezogen: Solche domänenspezifische Methoden beruhen auf dem Domänen-Hintergrundwissen. Problemrepräsentation In realen Problemstellungen muss der Problemlöser viele Problemkomponenten selbst definieren. In Schlecht-definierten Problemen ist weder das Ziel klar definiert, noch ist bekannt, wie man die Zielerreichung angehen soll. Die Problemrepräsentation beeinflusst nämlich die Generierung der Problemlösung. Eine Repräsentation hat 4 Komponenten: 1) eine repräsentierte Welt – in diesem Fall die Beschreibung des zu lösenden Problems 8 Summary: Thinking and Reasoning ©Kiwi Disclaimer: [email protected] 2) eine repräsentierende Welt – die Elemente, welche die Objekte und Beziehungen in der Repräsentierten Welt ausmachen 3) ein Regelwerk das die Elemente der repräsentierten Welt zu Elementen der repräsentierenden Welt zuordnet 4) ein Prozess der die Information der repräsentierenden Welt benutzt – in diesem Fall um das Problem zu lösen. Die Repräsentation, die zur Problemlösung benutzt wird kann entweder internal (WM) oder external (auf Papier) sein. Der Kontext eines Problemes ist relevant für die Repräsentation. Eine Größe im Kontext ist die Wahrgenommene Form des Problems, z.B. visuell. Z.B. das 9-PunkteProblem ist ein klassisches Einsichts-Problem (mit Aha-Effekt). Objektbasierte Inferenzen beziehen sich auf die Einheiten in einem Problem, z.B. die funktionelle Fixiertheit (Duncker): Wenn ein Objekt für einen Zweck benutzt wurde, darauf habituiert wurde, dann ist es schwierig zu sehen, dass es auch Eigenschaften hat, die für einen ganz andern Zweck nützlich sein können. Der Inhalt der Geschichte beeinflusst ebenfalls die Repräsentation des Problems. Je nachdem, wie die Einheiten des Problems repräsentiert werden, wird ein anderer Lösungsweg gesucht. Das Wissen zur Problemlösung ist, wie bereits erwähnt, von besonderer Bedeutung. So ist die Erfahrung mit strukturell ähnlichen oder analogen Problemen hilfreich, indem solche Erfahrungen als Beispiel für das neue Problem verwendet werden können. Die Problemstruktur muss dabei ähnlich sein, nicht die Geschichte! Man denke dabei an die Textaufgaben in der Schule. Analogität wurde z.B. von Gick und Holyoak untersucht, indem sie ein Radiationsproblem stellten. Einmal ging es um die Operation eines Tumors durch Konvergenz vieler Strahlen auf einem Punkt und einmal um einen Krieg, wo eine Armee auf dieselbe Weise zusammengeführt werden sollte. Das Lösungsbeispiel konnte in den Ergebnissen nur genutzt werden, wenn die Autoren die Probanden darauf hinwiesen, dass ein vergangenes Problem ähnlich gelöst worden war. Ein wichtiger Prädiktor für den Lösungserfolg ist dabei das Verstehen des gelernten Beispieles. Generelle Schemen im Gedächtnis enthalten abstrakte Information zur Problemlösung, sodass sie auf die spezifische idiosynkratische Information eines bestimmten Problems variabel anwendbar sind. Abstrakte Repräsentationen von Schemen sind hilfreicher als spezifische relevante Beispiele um die Struktur neuer Probleme zu verstehen, da sie keine spezifischen Informationen enthalten, der dann ignoriert werden müsste um das neue Problem zu lösen. Expertentum kann auch untersucht werden, indem man verschiedene Personen in verschiedenen Domänen untersucht: Experten repräsentieren Lösungsrelevante strukturelle Eigenschaften während Unerfahrene auch Lösungsirrelevante oberflächliche Merkmale repräsentieren. Experten fokussieren dabei schon die Aufmerksamkeit gezielter. Beispiele dafür finden sich im Schach oder in der Sortierung von Problemen anhand ihrer Lösungsart in Physik, ähnlich in Biologie, Mathematik, Geometrie… Der Zusammenhang zwischen Repräsentation und Lösung Die Repräsentation beeinflusst wie eine Lösung generiert wird, das hat schon Wertheimer gezeigt. Das Verständnis der Struktur erleichtert die Einsicht in die Ähnlichkeit zwischen Problemen die nur äußerlich unterschiedlich sind. Mathematisches Problemlösen ist ein willkommener Bereich für die Problemlöseforschung. Dabei ist Domänenwissen nicht nur für das schon vorher genannte Expertentum relevant, sondern auch schon für die Repräsentation und in der Folge für die Lösung eines Problems. Entsprechend sind oberflächliche Repräsentationen von Unerfahrenen störend beim Problemlösungsprozess. Ein 9 Summary: Thinking and Reasoning ©Kiwi Disclaimer: [email protected] falsch gelerntes Beispiel o. Strategie kann sogar öfter falsch auf ein anderes Problem angewandt werden. Unterziele können als Komponenten der Aufgabenstruktur gelehrt werden. So wird das Problem in konzeptuell distinkte, bedeutungsvolle Teile aufgeteilt. Damit steigt die Wahrscheinlichkeit den richtige Lösungsweg einzuschlagen. Objekt basierte Inferenzen aus dem Inhalt der Geschichte wurden schon bei der Repräsentation von Problemen besprochen. Sie beeinflussen also das Situationsmodel und auch die Lösung z.B. ein Mathematisches Modell das ausgewählt oder konstruiert wird. Studien hierzu zeigten, dass Personen, welche ein Situationsmodell mit bestimmten Veränderungen anwandten, die entsprechende Summen-Strategie zur Lösung anwandten. Auch mathematische Aufgaben, die semantisch dargeboten werden, werden von Probanden entsprechend der semantischen Struktur gelöst, anstatt eine eigene mathematische Repräsentation zu bilden (semantic alignment). Das geht so weit, dass die semantische Struktur sogar die Schwierigkeit des Problems determiniert. Diese Effekte zeigen sich auch in den ERPs von EEG Studien, wo Additionen von Objekten ungleicher Kategorien (Tulpen und Vasen) eine negativere Response berichten als für gleiche Kategorien. Insight-Problemlösen Revisited Insight-Problemlösen ist charakterisiert durch ein anfängliches Nichtstun, eine plötzliche Restrukturierung der Problemrepräsentation und durch eine plötzliche Lösung. Also hat so eine Lösung nichts mit einer Schritt-für-Schritt Lösung zu tun? Die Schwierigkeit solcher Probleme beruht auf Wahrnehmungsfaktoren, Hintergrundwissen und/oder Prozessfaktoren. Ein neuer Problemraum mit alternativen Operatoren muss also geschaffen werden, wo dann die Lösung gefunden wird. Die Lösungen werden auch Pop-out-Solutions genannt. Es geht dabei aber entgegen Gestaltpsychologischer Meinungen nicht um eine „full-blown“ Rekapitualtion: Die Einsichtspaare sind zunächst unähnlich, dann leicht ähnlich und dann sehr ähnlich – also gibt es einen Problemlöseprozess gradueller Accumulation partieller Information. Das Impasse ist das anfängliche Nichtstun bei solchen Problemen. Es wird dann ganz plötzlich (pop-out) durchbrochen. Ein Scheitern verursacht das Impasse: unangemessene Annahmen oder Versuche. Die Revision der Problemrepräsentation in einer „Contraint relaxation“ involviert die Deaktivation von Wissen, sodass neue Operatoren angewandt werden können. Oder aber eine „Chunk decomposition“ unterbricht die Beziehungen der Komponenten untereinander. Dieses Modell konnte durch Reaktionszeiten und Augenfixationen gestützt werden. Schlussfolgerungen und Ausblick Die Interaktion zwischen Repräsentation und Löseprozess wurde bislang noch zu wenig erforscht, ist aber eigentlich Kern der Sache. In der Zukunft sollte sich Forschung in Richtung anwendbarer Ergebnisse bewegen: In der Schule bzw. Pädagogik allgemein könnte ein besseres Verständnis zum Problemlösen das Lernen erleichtern. Sind die Faktoren bekannt, welche die Repräsentation einer Problemstruktur bestimmen, so können Probleme auch besser modelliert werden. Außerdem werden komplexere, Wissensintensive Probleme weiter untersucht werden. Dazu wie vor allem auf die Schlecht-Definierten Probleme hingewiesen. Letztendlich ist Problemlösen nach Duncker viel breiter konzeptualisiert, als es bisher untersucht wurde: 10 Summary: Thinking and Reasoning ©Kiwi Disclaimer: [email protected] 1) Objekte in Kategorien fassen und Inferenzen aufgrund Kategoriezugehörigkeit tätigen 2) Induktives Interferieren von multiplen Instanzen 3) Schlussfolgern aufgrund Analogien 4) Identifizieren der Gründe von Ereignissen 5) Deduktion lokaler Implikationen gegebener Information 6) Legales Urteilen 7) Diagnostik medizinischer Bedingungen von historischen und Labor-Daten Die Forschung zum Problemlösen sollte also allgemein in die Denkforschung integriert werden. 11