2. wahrscheinlichkeitsrechnung

Werbung

Folien zur Vorlesung

Statistik für LM- Chemiker

und Ernährungswissenschaftler

(Teil 2: Wahrscheinlichkeitsrechnung)

U. Römisch

http://www.tu-berlin.de/fak3/staff/roemisch/homepage1.html

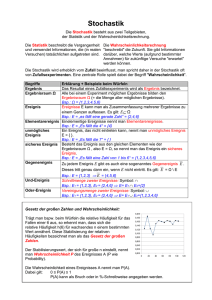

2. WAHRSCHEINLICHKEITSRECHNUNG

2.1. Zufällige Ereignisse, Ereignisfeld, Wahrscheinlichkeit

- Regeln für die Berechnung von Wahrscheinlichkeiten

2.2. Zufallsgrößen (ZG)

- Arten von Zufallsgrößen und ihre Verteilungen (diskrete

und stetige Zufallsgrößen)

- Kenngrößen von Zufallsgrößen (Erwartungswert u.

Varianz)

2.3. Spezielle Verteilungen

- Binomial-, Poisson- und Normalverteilung

- Prüfverteilungen (Chi2-, t- u. F- Verteilung)

2. WAHRSCHEINLICHKEITSRECHNUNG

Die Wahrscheinlichkeitsrechnung liefert mathematische

Modelle der Gesetzmäßigkeiten von Zufallserscheinungen.

Es werden solche Experimente betrachtet, deren Ergebnisse

einen zufälligen Ausgang haben, so genannte zufällige

Versuche.

2.1. Zufällige Ereignisse, Ereignisfeld

Begriffe und Definitionen:

Def.: Ein zufälliges Ereignis ist ein Ereignis, das bei

einem Versuch, bei dem bestimmte Bedingungen

("Ursachenkomplex") eingehalten werden, eintreten

kann, aber nicht notwendig eintreten muss. Es ist das

Ergebnis eines zufälligen Versuches.

Bez.: A,B,C,...,A1,B1,...

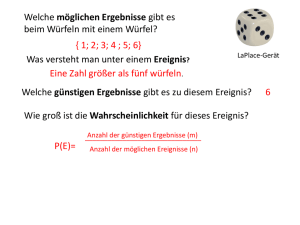

Bsp. 1: Würfeln mit einem idealen Würfel und Beobachtung

der geworfenen Augenzahl (zuf. Versuch)

● zufällige Ereignisse sind:

- Ai := "Augenzahl i wird gewürfelt, i=1,...,6 ",

- aber auch: A7:= "Eine gerade Augenzahl wird

gewürfelt"

Nur eine Zahl wird tatsächlich gewürfelt, alle übrigen nicht.

Begriffe: - Elementarereignis:

Elementarereignisse lassen sich nicht weiter in

zufällige Ereignisse zerlegen.

Bez.: ei ; i=1,...,n

Bsp.1: ei := "Würfeln der Augenzahl i, i=1,...,6 "

- Zusammengesetzte Ereignisse:

lassen sich weiter in zufällige Ereignisse zerlegen.

Bez.: Ai, Bi,... ; i=1,...,n

Bsp.1: A7 := "Würfeln einer geraden Zahl"

= {e2,e4,e6}

Def.: Die Menge E (oder: Ω) heißt Menge der zu einem

zufälligen Versuch gehörenden Elementarereignisse,

wenn jedem Versuchsausgang genau ein Element

dieser Menge E entspricht.

Bsp.1: E = {e1,...,e6}

⇒ Schlussfolgerung: Methoden der Mengenlehre könnten

anwendbar sein!

Def.: Ein zufälliges Ereignis A ist eine Teilmenge der

Menge E der Elementarereignisse, d.h. A ⊆ E .

Betrachten wir zunächst zuf. Ereignisse, die als Grenzfälle

angesehen werden können:

Def.: Sichere Ereignisse sind dadurch gekennzeichnet,

dass sie unter den Bedingungen, die den betrachteten

Versuch kennzeichnen, eintreten müssen. Sie bilden

die Teilmenge von E, die alle Elementarereignisse

enthält.

Bez.: S oder E

Bsp.1: E: = "Es wird eine Zahl zwischen 1 und 6 gewürfelt"

= {e1,...,e6}

Def.: Unmögliche Ereignisse sind dadurch charakterisiert,

dass sie nicht eintreten können. Sie sind die Teilmenge,

die kein Elementarereignis enthält.

Bez.: U oder Ø.

Bsp.1: Ø := "Es wird eine '0' gewürfelt!"

Relationen und Operationen zwischen zufälligen

Ereignissen:

Def.: Ein zufälliges Ereignis A ist genau dann in dem

zufälligen Ereignis B enthalten, wenn alle Elementarereignisse, die zu A gehören, auch zu B gehören.

D.h.: Wenn A eintritt, dann tritt auch B ein.

Bez.: A ⊆ B

Bsp.1: Würfeln mit 1 Würfel:

A2 ⊆ A7

Bem.: Für ein beliebiges zufälliges Ereignis A gilt immer:

Ø ⊆ A ⊆E

Def.: Zwei zuf. Ereignisse A und B heißen äquivalent (gleich),

wenn sowohl das Ereignis A in B enthalten ist ( A ⊆ B ),

als auch das Ereignis B in A enthalten ist (B ⊆ A ) .

Bez.: A = B

Def.: Sind A und B zuf. Ereignisse, so verstehen wir unter

der Summe von A und B (Vereinigung, Disjunktion)

das Ereignis, das genau die Elementarereignisse

enthält, die zu A oder zu B gehören.

E

A ∪B

Bez.:

Bsp.1: A 1 ∪ A 7 = {e1, e 2 , e 4 , e 6 }

A

B

Verallgemeinerung:

A1, ... , An sind zuf. Ereignisse. Die Summe der Ai (i = 1, ... , n)

ist das Ereignis, das genau dann eintritt, wenn mindestens

eines der Ereignisse Ai eintritt.

n

Bez.: A 1 ∪ A 2 ∪ ... ∪ A n = U A i

i =1

6

Bsp.1: U

i= 1

A

i

= E

Def.: Sind A und B zuf. Ereignisse, so verstehen wir unter

dem Produkt von A und B (Durchschnitt, Konjunktion)

das Ereignis, das genau die Elementarereignisse

enthält, die zu A und zu B gehören.

E

A ∩B

Bez.:

A

B

Bsp.1: A 1 ∩ A 7 = ∅

Verallgemeinerung:

A1, ... , An sind zuf. Ereignisse. Das Produkt der Ai ist das

Ereignis, das genau dann eintritt, wenn jedes der Ereignisse

Ai (i = 1, ... , n) eintritt.

n

Bez.:

A 1 ∩ A 2 ∩ ... ∩ A n = I A i

i =1

6

Bsp.1:

IA

i=1

i

= ∅

Def.: Zwei zufällige Ereignisse A und B heißen miteinander

unvereinbar (unverträglich, disjunkt), wenn sie keine

gemeinsamen Elementarereignisse besitzen. (D.h.

wenn A und B nicht gleichzeitig eintreten können!)

Bez.: A ∩ B = ∅

Bsp.1: A1 ∩ A7= ∅

Def.: Ist A ein zufälliges Ereignis, so nennen wir das Ereignis,

das genau die Elementarereignisse enthält, die nicht zu

A gehören, das zu A komplementäre (oder entgegengesetzte) Ereignis.

Bez.:

A

Bsp.1: A 7 = {1,3,5}

Offensichtlich gelten folgende Aussagen:

•

A ∪ A = E,

• A ∩B = A ∪B

• A ∪B = A ∩B

E =∅ ,

A ∩ A = ∅,

Verallgem.

IA = UA

i

UA

i

=

IA

i

∅=E

i

de Morgan’sche

Regeln

Def.: Sind A, B zufällige Ereignisse, so verstehen wir unter

der Differenz von A und B das Ereignis, das genau

die Elementarereignisse enthält, die zu A, aber nicht

zu B gehören. (d.h. wenn A, aber nicht B eintritt!)

Bez.: A \ B

Bsp.1: A7 \ A2 = {4, 6}

E

A

B

Es gelten folgende Aussagen:

•

A

=E\A

• A ∩B = A \ B

Bem.: Für die Vereinigung und den Durchschnitt gelten die

Gesetze der Kommutativität, Assoziativität und

Distributivität.

Def.: Ereignisfeld

Eine Menge von zufälligen Ereignissen heißt

Ereignisfeld ℰ, wenn folgende Eigenschaften gelten:

1. E ∈ ℰ

2. A, B ∈ ℰ

3. A ∈ ℰ

4. Ai ∈ ℰ

(E- sicheres Ereignis)

→

→

→

A∪B∈ℰ

A ∈ℰ

∞

UA

i =1

i

∈ℰ

(i=1,2,…)

Folgerungen:

• ∅∈ℰ

• A, B ∈ ℰ →

•

∞

IA

i =1

i

∈ℰ

A∩B∈ℰ

A \ B∈ℰ

(A \ B) äquivalent ( A ∩ B )

Bem.: Ein Ereignisfeld ist somit eine Menge von zufälligen

Ereignissen mit der Eigenschaft, dass Anwendungen

der eingeführten Operationen auf Elemente dieser

Menge ℰ nicht aus dieser Menge hinausführen, also

immer wieder Elemente dieser Menge liefern.

In der Mengenlehre sprechen wir von einer σ- Algebra.

Wahrscheinlichkeit:

Mit Wahrscheinlichkeiten wurde schon gerechnet, lange

bevor sich die Wahrscheinlichkeitsrechnung als eigenständige mathematische Disziplin formiert hatte, z.B. im

Rahmen der Bevölkerungsstatistiken, bei Versicherungsproblemen und Glücksspielen.

Auch im täglichen Sprachgebrauch verwendet man den

Begriff „wahrscheinlich“ als eine mögliche subjektive

Bewertung des Eintretens eines zufälligen Ereignisses

(hier: nur qualitative, keine quantitative Aussage!).

In der Mathematik löst man sich von dem subjektiven Urteil

und führt den Begriff der Wahrscheinlichkeit als Maß für

den Grad der Gewissheit des Eintretens eines zufälligen

Ereignisses A ein.

Bsp.: In einer Brauerei werden unter bestimmten Produktionsbedingungen im Mittel 1,6 % der Bierflaschen nicht

normgerecht abgefüllt.

D.h.: Von 1000 Bierflaschen sind im Mittel 16 nicht

qualitätsgerecht gefüllt worden, manchmal mehr,

manchmal weniger.

Mit anderen Worten: Der Prozentsatz an Ausschuss

oder auch die Wahrscheinlichkeit der Ausschussproduktion beträgt im Beispiel 1.6 % oder 0,016.

D.h.: Bei Massenerscheinungen, wie der Massenproduktion von Erzeugnissen ist die Anzahl

der uns interessierenden Ereignisse (hier:

unbrauchbare, nicht normgerecht gefüllte

Flaschen) annähernd gleich.

2 Fragen:

● Wie kann man die Wahrscheinlichkeit eines

zufälligen Ereignisses bestimmen?

● Welche Eigenschaften besitzen Wahrscheinlichkeiten, welchen Rechenregeln genügen sie?

1. Klassische Definition der Wahrscheinlichkeit:

(Laplace: 1749 – 1827)

Ausgangspunkt:

• zufälliger Versuch mit endlich vielen Versuchsausgängen n,

d.h. E = {e1, ..., en}

• jeder Versuchsausgang soll gleichmöglich sein

(Symmetrieeigenschaft)

Jedes mit dem betrachteten Versuch zusammenhängende

zufällige Ereignis A lässt sich durch Aufzählung derjenigen

Versuchsausgänge kennzeichnen, die für A günstig sind, d.h. die

das Eintreten von A bewirken.

• N(A) - sei die Anzahl der Versuchausgänge, bei denen A eintritt

• n = N(E) - sei die Gesamtzahl der Versuchsausgänge

⇒ das Verhältnis von N(A) zu n vermittelt eine Vorstellung

über den Grad der Gewissheit des Eintretens von A.

Def.: Klassische Wahrscheinlichkeit:

Sei E endlich und ei gleichmöglich.

Jedem zufälligen Ereignis A können wir eine positive

Zahl P(A) - die Wahrscheinlichkeit des zufälligen

Ereignisses A - zuordnen (A ∈ ℰ → P(A) ∈ [0,1] ⊆ R).

Sie ist der Quotient aus der Anzahl der in A enthaltenen

Elementarereignisse N(A) („der für A günstigen

Elementarereignisse“) und der Gesamtzahl n der

Elementarereignisse.

N( A)

P( A) =

n

Insbesondere gilt:

1

P( e i ) =

n

(i = 1, ... , n)

Satz: Eigenschaften der klassische Wahrscheinlichkeit:

1. 0 ≤ P(A) ≤ 1

2. P(E) = 1

(es gilt auch: P(A) = 1 → A = E !)

3. Sind A, B unvereinbare zuf. Ereignisse, d.h. A ∩ B = ∅,

so gilt: P(A ∪ B) = P(A) + P(B)

(Additionsregel für unvereinbare zuf. Ereignisse)

4. P(∅) = 0 (es gilt auch: P(A) = 0 → A = ∅ !)

5. P( A ) = 1 – P(A)

6. Sind A, B beliebige zuf. Ereignisse, so gilt:

P(A ∪ B) = P(A) + P(B) – P(A ∩ B)

(allg. Additionsregel für bel. zuf. Ereignisse)

7. Aus A ⊆ B folgt: P(A) ≤ P(B)

Verallgemeinerung der Additionsregel für drei beliebige

zufällige Ereignisse A, B und C:

P(A ∪ B ∪ C) = P(A) + P(B) + P(C) – P(A ∩ B) – P(A ∩ C) –

P(B ∩ C) + P(A ∩ B ∩ C) ist die Wahrscheinlichkeit, dass

mindestens eines der Ereignisse A, B, oder C eintritt.

A∩B∩ C

E

A∩ B ∩ C

B

A

C

A∩ B∩C

A∩B∩C

A∩B∩C

A∩B∩C

A∩B∩C

Bem.: Der klassischen Definition der Wahrscheinlichkeit

kommt deshalb besondere Bedeutung zu, weil man auf

dieser Grundlage für zahlreiche praktische Fragestellungen Wahrscheinlichkeiten berechnen kann.

Die Berechnung interessierender Wahrscheinlichkeiten

erfolgt nach Rechenregeln (s. Satz), wobei die

Berechnung der Anzahl der möglichen Fälle und der

Anzahl der günstigen Fälle für ein Ereignis häufig auf

der Basis der Methoden der Kombinatorik (Variation,

Kombination mit oder ohne Wiederholung), erfolgt.

Bsp.1: Würfeln mit einem „idealen“ Würfel

Wir betrachten n = 6 mögliche, gleichwahrscheinliche

Versuchsausgänge, d.h. E = {e1, ... , e6} , ei = {i} , i = 1, ... 6

Augenzahl i

a) Sei A6 das zufällige Ereignis, eine „6“ zu würfeln:

A6 = { e6 } = { 6 }

ges.: P(A6)

N( A 6 ) N(e 6 ) 1

P( A 6 ) = P(e 6 ) =

=

= = 0,1 6

n

n

6

b) Sei A7 das zufällige Ereignis, eine gerade Zahl zu würfeln:

A7 = {e2, e4, e6} = {2,4,6}

ges.: P(A7)

Lösung: 2 Varianten

- nach klass. Def. der Wahrscheinlichkeit gilt:

Für A7 sind e2, e4 oder e6 günstig

⇒ N(A7) = 3

3

⇒ P( A 7 ) = = 0,5

6

- nach Additionsregel für unvereinbare Ereignisse gilt:

P(A7) = P(A2 ∪ (A4 ∪ A6)) = P(e2 ∪ (e4 ∪ e6))

= P(e2) + P(e4 ∪ e6)

= P(e2) + P(e4) + P(e6) da e2, e4 und e6 paarweise

unvereinbar

1 1 1 3

+ + = = 0,5

=

6 6 6 6

Bsp.:

In einem Bierkasten befinden sich 25 Flaschen Bier, von

diesen sind 2 nicht qualitätsgerecht.

Der zufällige Versuch bestehe in der Entnahme einer

Flasche, wobei jede Flasche die gleiche Chance habe,

entnommen zu werden.

Frage: Wie groß ist die Wahrscheinlichkeit, dass eine zufällig

entnommene Flasche qualitätsgerecht ist (Ereignis A)?

Lösung: ● Anzahl der möglichen Versuchsausgänge n = 25

● Anzahl der für A günstigen Versuchsausgänge

N(A) = 25 – 2 = 23

N( A ) 23

=

= 0,92

Damit ergibt sich: P( A ) =

n

25

Bsp. 2: Würfeln mit 2 unterscheidbaren Würfeln

E = {(ei,ej), i,j = 1, ..., 6} = {(i, j), i,j = 1, ..., 6}

Anzahl der Elementarereignisse: n = 36

( W VmK = mk , m = 6, k = 2)

(Variation, d.h. mit Berücksichtigung der Anordnung, mit Wiederholung)

C:= „Die Summe der Augenzahlen aus beiden Würfeln (i + j) bzw.

(j + i) sei 10 oder 11“.

D:= „Die Summe der Augenzahlen aus beiden Würfeln sei

‚mindestens 10“ (10, 11 oder 12).“

ges.: P(C) und P(D)

C = {(4,6), (5,5), (5,6), (6,4), (6,5)}

Es gilt: P(C) ≤ P(D), da C ⊆ D

⇒ N(C) = 5

5

⇒ P (C ) =

= 0 ,139

36

D = {(4,6), (5,5), (5,6), (6,4), (6,5), (6,6)} ⇒ N(D) = 6

⇒ P(D) = 6 = 1 = 0,16

36 6

2. Statistische Definition der Wahrscheinlichkeit:

Wir betrachten das Bsp.1: Würfeln mit 1 Würfel

Sei A das zuf. Ereignis, das im Ergebnis des zuf. Versuches

eine „6“ gewürfelt wird.

Der Versuch wird n- mal wiederholt (n = 50, 100, ...).

Dabei trat das Ereignis A N(A)- mal (z.B. N(A) = 7, 18, ...)

auf, d.h. N(A) ist die absolute Häufigkeit des Auftretens von A.

Dann nennt man den Quotienten aus der absoluten Häufigkeit

und der Gesamtzahl der Versuche relative Häufigkeit

N( A )

hn ( A ) =

.

n

hn(A) kann die Zahlen

n

0 1 2

0 = , , ,...,

=1

n

n n n

annehmen.

Bem.: ● Welchen Wert die abs. bzw. rel. Häufigkeit bei einer

konkreten Versuchsserie annehmen wird, kann nicht

mit Sicherheit vorausgesagt werden, sie ist vom Zufall

abhängig, d.h. sie wird sich bei Wiederholung der

Versuchsreihe ändern.

● Mit zunehmender Anzahl der Versuche zeigt sich

jedoch eine gewisse Stabilität der rel. Häufigkeit, d.h.

die rel. Häufigkeiten schwanken um einen gewissen

Wert, den wir nicht genau kennen und stat. Wahrscheinlichkeit des Ereignisses A nennen und mit

P(A) bezeichnen.

Das Stabilisierungsverhalten der rel. Häufigkeit wird

durch Grenzwertsätze formuliert.

Def.: ● Die rel. Häufigkeit hn(A) kann also als Schätzwert der

Wahrscheinlichkeit P(A) aufgefasst werden, der um so

besser ist, je häufiger der Versuch wiederholt wird,

d.h.

hn(A) ≈ P(A)

für n → ∞

Bsp.: Münzwurf

Anzahl der

Würfe n

Anzahl des

Auftretens des

"Wappen" N(A)

relative

Häufigkeit

hn=N(A)/n

Buffon

4040

2048

0.5069

Pearson

12000

6019

0.5016

Pearson

24000

12012

0.5005

Stabilität der relativen Häufigkeit

hn(A)

P(A)

n

Die bedingte Wahrscheinlichkeit und die Unabhängigkeit

von Ereignissen:

Sei A ∈ ℰ. Die Zahl P(A) gibt die Wahrscheinlichkeit des

Ereignisses A im Rahmen der Bedingungen an, die den

betrachteten zufälligen Versuch kennzeichnen. Nehmen wir

gedanklich zu diesen Bedingungen noch die Bedingung „Das

zufällige Ereignis B ∈ ℰ ist bereits eingetreten“ hinzu, so wird

der Grad der Gewissheit des Eintretens von A nun durch eine

i.a. von P(A) verschiedene Zahl beschrieben.

Bsp.2: Würfeln mit 2 unterscheidbaren Würfeln

E = {(i,j) / i, j = 1, ..., 6}

C:= “ Summe der Augenzahlen 10 oder 11“

C = {(5,5), (4,6), (6,4), (5,6), (6,5)}

P(C) =

B1:= „1. Würfel zeigt eine 3“

B2:= „1. Würfel zeigt eine 5“

5

36

ges.: P(C/B1) und P(C/B2)

Lösung:

B2 = {(5,1), (5,2), (5,3), (5,4), (5,5), (5,6)}

Dann ist P(C/B1) = 0

P(C/B2) =

2

= 0 ,3

6

Es gilt: (C ∩ B2) = {(5,5), (5,6)}

Erweiterung von Zähler und Nenner mit 1/36:

2

P(C ∩ B 2 )

1

36

=

=

= 0,3

P(C/B2) =

6

P (B 2 )

3

36

⇒ Bedingte Wahrscheinlichkeiten können auf unbedingte

Wahrscheinlichkeiten zurückgeführt werden.

Def.: Seien A, B ∈ ℰ mit P(B) > 0, dann heißt die Wahrscheinlichkeit des Ereignisses A unter der Bedingung,

dass das Ereignis B schon eingetreten ist, bedingte

Wahrscheinlichkeit des Ereignisses A unter der

Bedingung B und wird nach der Formel

P( A ∩ B )

P( A / B ) =

P(B )

berechnet.

Satz: Seien A, B ∈ ℰ und P(B) > 0, dann gilt:

P(A ∩ B) = P(A/B) ⋅ P(B)

(Multiplikationsregel für bedingte Ereignisse)

Def.: Ist der Eintritt des Ereignisses B ohne Einfluss auf die

Wahrscheinlichkeit des Ereignisses A, d.h. wenn

P(A/B) = P(A) gilt, so heißen die Ereignisse A und B

(stochastisch) unabhängig.

Satz: Für unabhängige Ereignisse gilt:

P(A ∩ B) = P(A) ⋅ P(B) bzw.

n

⎛n ⎞

P⎜⎜ U Ai ⎟⎟ = P( Ai ) ⋅ ... ⋅ P( An ) = ∏P( Ai )

i=1

⎝ i=1 ⎠

(Multiplikationsregel für unabhängige Ereignisse)

Totale Wahrscheinlichkeit und Bayes‘ sche Formel:

Satz: Totale Wahrscheinlichkeit:

Seien A1, …, An paarweise disjunkte Ereignisse mit

n

UA

i

i =1

=E

, so gilt für ein beliebiges Ereignis B:

n

P(B ) = ∑ P(B / A i )P( A i )

i =1

Satz: Bayes‘ sche Formel:

Seien A1, …, An paarweise disjunkte Ereignisse mit

n

UA

i

=E

i =1

dann gilt:

, wobei für mindestens ein i (i=1,…,n)

P(Ai) >0 und P(B/Ai) >0 erfüllt ist,

P( A j / B) =

P(B / A j ) ⋅ P( A j )

n

∑ P(B / A ) ⋅ P( A )

i =1

i

i

, j=1,…,n.

Bsp.: Medizinische Diagnostik (Erkennen von Krankheiten)

Seien die Ereignisse A:= „Patient ist krank“

B:= „Testergebnis ist positiv“

Aus der Erprobungsphase des Tests können folgende

Wahrscheinlichkeiten als bekannt betrachtet werden:

P(B/A) = P(„Testergebnis ist positiv bei Kranken“) = 0,97

P(B / A) = P(„Testergebnis ist positiv bei Nichtkranken“)

P(A)

= 0,02

= 0,002

(d.h. sehr seltene Krankheit!)

ges.: Wahrscheinlichkeit P(A/B), dass der Patient auch wirklich

krank ist, wenn ein positives Testergebnis vorliegt!

Lösung: (Bayes‘sche Formel)

P(B / A ) ⋅ P( A )

P( A / B) =

= 0,08858 ≈ 0,09

P(B / A ) ⋅ P( A ) + P(B / A ) ⋅ P( A )

2.2. Zufallsgrößen (ZG)

Bisher haben wir uns mit zuf. Ereignissen und ihren Gesetzmäßigkeiten beschäftigt. Wir haben zuf. Ereignisse wie

Mengen behandelt und jedem beliebigen zuf. Ereignis A ∈ ℰ

als Grad für die Gewissheit des Eintretens von A die

Wahrscheinlichkeit P(A) zugeordnet.

Einige der betrachteten Beispiele zeigten, dass man zuf.

Ereignisse durch reelle Zahlen ausdrücken kann:

X

E

.

ei

0

xi

=X(ei)

R

Bem.: Die Abbildung X heißt Zufallsgröße (ZG), weil ihre

Werte über die zuf. Ereignisse vom Zufall abhängen.

X

X(ei) = xi

ei ∈ E → xi ∈ Beispiele

Elementarereignisse

Werte der ZG X

→1

…

→6

gewürfelte

Augenzahl

2. Würfeln mit 2

(1,1)

versch. Würfeln (1,2), (2,1)

(Augensumme) …

(1,6), (2,5), (3,4), (4,3), (5,2), (6,1)

…

(6,6)

→2

→3

…

→7

…

→ 12

gewürfelte

Augensumme

3. Herstellung von e0 – “genau 0 Erzeug. Ausschuss”

5 Erzeugnissen e1– “genau 1 Erzeug. Ausschuss”

…

e5– “genau 5 Erzeug. Ausschuss”

→0

→1

…

→5

Anzahl der

Ausschusserzeug.

1. Würfeln mit

einem Würfel

(Augenzahl)

e1 – “Würfeln einer 1”

…

e6 – “Würfeln einer 6”

Weitere Beispiele für Zufallsgrößen sind:

● Länge von Baumwollfasern einer bestimmten Sorte

(schwankt nicht nur für verschiedene Anbaugebiete sehr

stark, sondern auch für eine Samenkapsel)

● Masse von Weizenkörnern (ändert sich von Korn zu Korn,

da es unmöglich ist, den Einfluss aller Faktoren wie

Bodenqualität, Wasserhaushalt, Lichteinflüsse usw. zu

berücksichtigen)

● Anzahl der Stillstände einer Flaschenabfüllanlage

● Anzahl nicht qualitätsgerechter Joghurtbecher

● Stickstoffmon- und -dioxidgehalt, Kohlenmonoxid- und

Ozongehalt, sowie Schwebestaubgehalt in der Luft

● Natrium,- Kalium-, Eisen- und Cadmiumgehalt von Weinen

Def.: Es sei E die Menge der Elementarereignisse (Versuchsausgänge eines zufälligen Versuches) und ℰ ein

Ereignisfeld von E.

Eine auf E definierte Funktion X, die jedem Elementarereignis e∈E eine reelle Zahl x∈ zuordnet, heißt

Zufallsgröße, wenn die folgende Eigenschaft gilt:

Das Urbild A jedes beliebigen Zahlenintervalls (-∞, x],

x∈ bel., ist ein zuf. Ereignis, d.h. A={e/X(e)∈(-∞, x]} ∈ ℰ.

Bez.: Zufallsgrößen bezeichnet man mit: X, Y, Z bzw. Xi, Yi, Zi.

Bem.: Ist bei einem konkreten Versuch ein bestimmtes zuf.

Ereignis eingetreten, so ist X(e) ein fester Wert (reelle Z.)

und heißt Realisierung von X.

Bez.: Realisierungen von Zufallsgrößen werden mit kleinen

Buchstaben bezeichnet, z.B. x,y,z bzw. xi, yi, zi …

Bem.: Wir können A ∈ ℰ noch anders schreiben:

A={e/X(e) ∈ (-∞, x]}= {e/X(e) ≤ x} = {X ≤ x} = (X ≤ x)

Bez.

Analog bedeuten:.

{X = a}

= {e/X(e) = a} oder

{a < X ≤ b} = {e/a < X(e) ≤ b} = {X ≤ b} \ {X ≤ a}

a

b

Wenn A∈ ℰ → P(A) existiert, so ist diese Wahrscheinlichkeit P(A) darstellbar als P(A) = P({X ≤ x}) = P(X ≤ x)

Zufallsgrößen sind also Größen, die ihre Werte mit einer

bestimmten Wahrscheinlichkeit annehmen.

Bsp.: Münzwurf

e1:= “Wappen“

e2:= “Zahl“

→ P(e1) = 0,5

→ P(e2) = 0,5

P(e1) = P(X=0) = 0,5

P(e2) = P(X=1) = 0,5

Bsp. 1: Würfeln mit 1 Würfel

A:= “Würfeln einer Augenzahl i ≤ 3“

A = {e1, e2, e3} →

P( A ) =

3

= 0,5

6

P( A ) = P( X ≤ 3) = 0,5

1 1 1

P( X ≤ 3) = P( X = 1) + P( X = 2) + P( X = 3) = + + = 0,5

6 6 6

Def.: Sei X eine Zufallsgröße mit X: E → und

P: ℰ → [0,1] ⊆ Dann heißt die durch FX(x) = P(X ≤ x) definierte Funktion

FX Verteilungsfunktion der ZG X.

Bem.: Der Wert der Verteilungsfunktion FX(x) an der Stelle x

ist also gleich der Wahrscheinlichkeit, dass die ZG X

Zufallsgröße X einen Wert kleiner oder gleich x

annimmt.

Mittels der Verteilungsfunktion einer Zufallsgröße kann

man die Wahrscheinlichkeiten aller mit dieser Zufallsgröße in Zusammenhang stehenden zuf. Ereignisse

ausdrücken, z.B.

P(X > x) = 1- FX(x)

P(a < X ≤ b) = FX(b) – FX(a) , weil (-∞, a] ⊂ (-∞, b] für

a≤b

Satz : Eigenschaften der Verteilungsfunktion:

1. 0 ≤ FX(x) ≤ 1 ∀x∈

2. FX ist monoton wachsende Funktion,

d.h. x1 < x2 ⇒ FX(x1) < FX(x2)

3. FX ist rechtsseitig stetig, d.h.

lim F

x↑ x0

X

( x ) = FX ( x 0 )

bzw.

4. Grenzwerte:

lim F

x → −∞

lim

x → +∞

(x) = 0

( =ˆ P(∅)),

FX ( x ) = 1

( =ˆ P(E))

X

lim F

h→ 0

h >1

X

( x + h ) = FX ( x )

Diskrete Zufallsgrößen:

Def. : Eine Zufallsgröße X heißt diskret, wenn sie endlich

oder abzählbar unendlich viele Werte annehmen kann.

Beispiele:

● Anzahl nicht qualitätsgerechter Joghurtbecher

● Anzahl der Stillstände einer Flaschenabfüllanlage

● Anzahl der monatlichen Krankentage der Belegschaft eines

Betriebes

Bem.: Man beschreibt eine diskrete ZG X durch die Werte

xi, die sie annehmen kann und die sogenannten

Einzelwahrscheinlichkeiten pi = P(X = xi), mit denen

sie diese Werte annimmt.

Bem.: Man gibt die xi und pi, d.h. die Paare (xi, pi) oft in Form

einer Verteilungstabelle, die die ZG X vollständig

beschreibt, an.

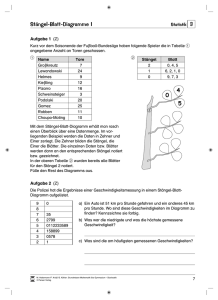

Bsp. 2: Würfeln mit 2 unterscheidbaren Würfeln

(X:= „Augensumme i+j“):

xi

2

pi = P(X = xi) 1

36

3

4

2

36

3

36

5

4

36

6

5

36

7

8

6

36

5

36

9

4

36

10

3

36

11

2

36

12

1

36

Grafische Darstellung der Einzelwahrscheinlichkeiten:

pi

1/6

0

1

2

3

4

5

6

7

8

9

10

11

12

xi

Def. : Sei X eine diskrete ZG.

Dann bezeichnet man P(X = x) als Wahrscheinlichkeitsverteilung der ZG X.

Satz: Eigenschaften der Einzelwahrscheinlichkeiten einer

diskreten ZG X :

1. 0 ≤ pi ≤ 1

∞

2.

∑p

i =1

i

=1

Def. : Die Verteilungsfunktion einer diskreten ZG X

bestimmt man nach der Formel:

FX ( x ) = P( X ≤ x ) = ∑ P( X = xi ) = ∑ pi

i

xi ≤ x

i

xi ≤ x

Bsp. 1: Würfeln mit 1 Würfel

(Gleichverteilung)

Verteilungstabelle mit Verteilungsfunktion:

xi

<1

1

2

3

4

5

pi = P(X = xi)

0

1/6

1/6

1/6

1/6

1/6

1/6

0

FX(xi)

0

1/6

2/6

3/6

4/6

5/6

1

1

FX (x)

6

>6

1

p1=1/6

x

1

2

3

4

5

6

FX ( x i ) = P ( X ≤ x i ) =

∑ P( X = x

k

xk ≤ xi

k

)

Bem.: Für eine diskrete ZG X gilt:

1. P( X ≤ x) = FX ( x) =

∑p

∀i mit xi ≤ x

i

i

2. P( X > x) = 1− FX (x) = 1−

∑p

∀i mit xi ≤ x

i

i

3. P(a < X ≤ b) = FX (b) − FX (a) =

∑p

i

i

∀i mit a < xi ≤ b

P(a < X ≤ b) ist die Wahrscheinlichkeit dafür, dass

eine Realisierung von X in das Intervall (a, b] fällt!

Stetige Zufallsgrößen:

Stetige Zufallsgrößen können überabzählbar unendlich viele

Werte (d.h. Werte aus einem reellen Zahlenintervall)

annehmen.

Beispiele:

● Eiweiß- und Fettgehalt von Milch

● Stammwürzegehalt von Bier

● Saccharosegehalt von Zuckerrüben

● Masse von Broten

Bem.: Die Wahrscheinlichkeit, dass eine solche stetige ZG

einen bestimmten festen Wert annimmt, z.B. dass

Milch genau einen Fettgehalt von 2,3 [%] aufweist, ist

„0“, denn es ist unwahrscheinlich („fast unmöglich“),

dass gerade dieser und kein dicht daneben liegender

Wert angenommen wird.

⇒ Wahrscheinlichkeitsfunktion ist hier nicht von

Interesse!

aber: Es ist von Interesse, mit welcher Wahrscheinlichkeit eine stetige ZG Werte in einem

gewissen Intervall (a, b] annimmt. Diese Wahrscheinlichkeit ist im Allg. von „0“ verschieden

und man kann sie berechnen!

Def. : Eine ZG heißt stetig, wenn es auf der Menge der

reellen Zahlen eine nichtnegative, integrierbare

Funktion fX gibt, so dass sich die Verteilungsfunktion

FX(x) = P(X ≤ x) ∀x∈ in der Form

x

FX ( x ) =

∫f

X

( t ) dt

darstellen lässt.

−∞

Die Funktion fX, von der wir fordern, dass

+∞

∫f

X

( x ) dx = 1

ist,

−∞

heißt Dichtefunktion (oder Verteilungsdichte) von X.

Die Verteilungsfunktion ist eine Stammfunktion der Dichte!

Dichtefunktion der Normalverteilung

0,4

0,1

Dichte

Ausgehend von der

geometrischen Deutung

des Integralbegriffes

erhalten wir FX(x0) als

Flächeninhalt der Fläche

zwischen der Kurve fX(x)

und der Abzissenachse in

den Grenzen – ∞ und x0.

0,3

0,2

0,1

0

-5

-3

-1 x

0

1

3

5

x

Verteilungsfunktion der Normalverteilung

Verteilungsfunktion

Bem.:

1

0,1

0,8

0,6

0,4

0,2

0

-5

-3

-1 x0

x

1

3

5

Satz : Eigenschaften der Dichtefunktion

Es sei X eine stetige ZG mit der Dichtefunktion fX.

1. fX(x) ≥ 0

+∞

2.

∫f

X

( x )dx = 1

−∞

x

3. FX ( x ) =

∫f

X

( t )dt

−∞

4. FX ist eine stetige Funktion, die an allen Stetigkeitsstellen von fX differenzierbar ist, wobei FX’(x) = fX(x)

gilt.

Satz : Eigenschaften der Dichtefunktion

Es sei X eine stetige ZG mit der Dichtefunktion fX.

1. fX(x) ≥ 0

+∞

2.

∫f

X

( x )dx = 1

−∞

x

3. FX ( x ) =

∫f

X

( t )dt

−∞

4. FX ist eine stetige Funktion, die an allen Stetigkeitsstellen von fX differenzierbar ist, wobei FX’(x) = fX(x)

gilt.

Bem.: Für eine stetige ZG X gilt:

x

1. P( X ≤ x) = FX ( x) =

∫ f(t)dt

−∞

x

∫

2. P( X > x) = 1− FX (x) = 1− f (t)dt

−∞

b

∫

3. P(a < X ≤ b) = FX (b) − FX (a) = f ( x)dx

a

∀x mit a < x ≤ b

(nach dem Hauptsatz der Differential- und

Integralrechnung!)

P(a < X ≤ b) ist die Wahrscheinlichkeit dafür, dass

eine Realisierung von X in das Intervall (a, b] fällt!

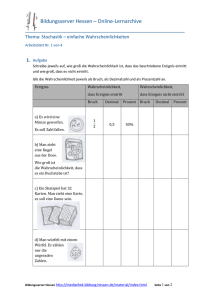

Bsp.: X sei eine stetige Zufallsgröße mit der Dichtefunktion

(gleichmäßig stet. Vert.)

fX(x) =

0,1 , x ∈ [0, 10]

0

, x ∉ [0, 10]

x

ges.: Verteilungsfunktion FX(x)

FX ( x) = ∫ fX (t )dt

−∞

zu beachten: fX ist nicht geschlossen analytisch

angebbar, sondern in 3 Intervallen:

(-∞, 0), [0, 10], (10, +∞)

Lösung:

x

∫ 0 dt = 0

, x ∈ (-∞, 0)

−∞

⇒ FX(x) =

0

x

−∞

0

0

10

x

−∞

0

10

∫ 0 dt + ∫ 0,1dt = 0,1x

∫ 0 dt + ∫ 0,1dt + ∫ 0 dt = 1

, x ∈ [0, 10]

, x ∈ (10, ∞)

Verteilungstabelle:

X = xi

<0

0

1

5

10

fX(xi)

FX(xi)

>10

0

0,1

0,1

0,1

0,1

0

0

0,1

0,1

0,5

1

1

FX(x)

1

fX(x)

0,5

0,1

x

0

5

Dichtefunktion

10

0,1

x

0

5

10

Verteilungsfunktion

Diskrete ZG

Stetige ZG

endlich oder abzählbar unendlich

viele Werte

überabzählbar unendlich viele Werte

Einzelwahrscheinlichkeiten pi:

pi = P(X = xi) i = 1, 2, …

0 ≤ pi ≤ 1

Dichtefunktion fX:

fX(x) ≥ 0

∞

∑p

i=1

i

+∞

=1

∫f

( x )dx = 1

−∞

Verteilungsfunktion:

FX(x) = P(X ≤ x)

FX ( x ) =

X

∑p

∀x∈

Verteilungsfunktion:

FX(x) = P(X ≤ x)

∀x∈

x

FX ( x ) =

i

i

xi ≤ x

X

( t )dt

−∞

FX rechtsseitig stetige Treppenfunktion, monoton wachsend

P(a < X ≤ b) =

∫f

∑p

i

i

a< xi ≤b

FX stetig, monoton wachsend

b

P ( a < X ≤ b ) = ∫ f X ( x )dx

a

Kenngrößen (Parameter) von Verteilungen:

1. Erwartungswert:

Def.: Als Erwartungswert EX einer ZG X bezeichnen wir das

Zentrum ihrer Verteilung:

∞

∑x

EX =

⋅ pi

, X diskr. ZG

∫ x ⋅ fX (x)dx

, X stet. ZG

i =1

i

+∞

EX ∈ −∞

Bem.: Der Erwartungswert einer diskr. ZG ist das gewogene

Mittel aller Werte xi von X, wobei die Einzelwahrscheinlichkeiten pi die Gewichte darstellen.

Bsp. 1: Würfeln mit 1 Würfel (Gleichvert.)

⇒ EX = 3,5

Bsp. 3: X auf [0,10] gleichmäßig stet. verteilt

⇒ EX = 5

Satz: Eigenschaften des Erwartungswertes

Für die Erwartungswerte von diskreten oder stetigen

Zufallsgrößen X, X1, … und Konstante a,b ∈ gelten

folgende Aussagen:

1. Ea = a

2. E [EX] = EX

3. E [X1 +…+ Xn] = EX1 +…+ EXn

(Additionsregel)

4. E [aX] = a EX

(Linearitätsregel)

5. E [aX + b] = a EX + b

(lin. Transformation)

6. X1,…,Xn unabhängig ⇒ E [X1•…•Xn] = EX1•…•EXn

(Multiplikationsregel)

7. X ≥ 0 ⇒ EX ≥ 0

und X ≥ Y

⇒

EX ≥ EY

2. Varianz:

Def.: Als Varianz bezeichnen wir die mittlere (erwartete)

quadratische Abweichung einer ZG X von ihrem

Erwartungswert:

D2X = E [X - EX]2

∞

2

(

x

−

EX

)

⋅ pi

∑ i

=

, X diskr. ZG

i =1

D2X ∈ +∞

2

(

x

−

EX

)

⋅ fX ( x)dx

∫

, X stet. ZG

−∞

D2 X

heißt Standardabweichung.

Bsp. 1: Würfeln mit 1 Würfel (Gleichvert.)

⇒ D2X = 2,92

Bsp. 3: X auf [0,10] gleichmäßig stet. verteilt

⇒ D2X = 8,3

Satz: Eigenschaften der Varianz: (Fehlerfortpflanzung)

Für die Varianz von diskreten oder stetigen Zufallsgrößen X,

X1, …, Y, Z und Konstanten a,b ∈ gilt:

1. D2X ≥ 0,

D2X = 0 ⇔ P(X = EX) = 1

2. D2X = EX2 – [EX]2

(Verschiebungsregel)

3. D2 [aX + b] = a2 • D2X

(lin. Transformation)

4. X1,X2 unabhängig ⇒

D2 [X1 + X2] = D2 [X1 - X2] = D2X1 + D2X2 (Summe, Differenz)

und für Y =X1• X2 und Z = X1/X2

2

2

⎛ D2 Y ⎞ ⎛ D X1 ⎞ ⎛ D X2

⎟ +⎜

⎟ ≈⎜

⎜

⎜ EY ⎟ ⎜ EX1 ⎟ ⎜ EX2

⎠ ⎝

⎝

⎠ ⎝

2

2

2

(Produkt und Quotient)

⎞ ⎛ D2 Z ⎞

⎟ ≈⎜

⎟

⎟ ⎜ EZ ⎟

⎠

⎠ ⎝

2

(Quadr. Variationskoeffizienten addieren sich!)

Bsp. 2: Würfeln mit 2 unterscheidbaren Würfeln,

X:=„ Augensumme“, X = X1 + X2

D2X = D2 [X1 + X2] = D2 X1 + D2 X2 = 5,83

Normierung und Standardisierung:

Def.: Eine ZG X heißt normiert, wenn D2X = 1 gilt.

Def.: Eine ZG X heißt standardisiert, wenn D2X = 1 und

EX = 0 gilt.

Satz: Für eine beliebige ZG X gilt:

1.

2.

Y=

Y=

X

D2 X

X − EX

2

D X

ist eine normierte ZG und

ist eine standardisierte ZG.

2.3. Spezielle Verteilungen von Zufallsgrößen

Wahrscheinlichkeitsverteilungen

Diskrete Verteilungen

Stetige Verteilungen

- 2- Pkt.- Verteilung

(Münzwurf)

- Gleichmäßig stet. Verteilung

(Bsp. 3: X stet. ZG auf [0,10])

- Gleichverteilung

(Bsp. 1: Würfeln mit 1 Würfel)

- Normalverteilung und log. NV

- Binomialverteilung

(Qualitätskontrolle)

- Exponentialverteilung

(Wachstumsprozesse)

- Hypergeometrische Vert.

- Weibullverteilung

(Abnutzungsprozesse)

- Poissonverteilung

- Prüfvert. (t-, χ2-, F- Vert.)

1. Binomialverteilung (Anwendung bei Qualitätskontrolle)

Beispiele:

- Zuf. Anzahl der in einem bestimmten Zeitabschnitt ausfallenden Maschinen von insgesamt n Maschinen gleicher

Bauart, wenn die Wahrscheinlichkeit, dass eine Maschine

ausfällt, p ist.

- Zuf. Anzahl nicht qualitätsgerecht produzierter Joghurtbecher von insgesamt n Joghurtbechern, wenn die Wahrscheinlichkeit, einen Ausschußbecher zu produzieren, p ist.

- Allgemein: X := „Anzahl der beobachteten (gezogenen)

Objekte aus einer Menge von n Objekten

mit der Eigenschaft A“

Bernoullisches Versuchsschema (Urnenmodell mit Zurücklegen):

- Urne enthält weiße und schwarze Kugeln, die Wahrscheinlichkeit, eine weiße Kugel zu ziehen (Ereignis A), sei P(A) = p.

- n- malige Entnahme einer Kugel und Feststellen, ob Kugel

weiß (A) oder schwarz ( A ) war, jeweils Zurücklegen der

Kugel.

(Durch Zurücklegen wird Unabhängigkeit der Einzelziehungen erreicht, die Wahrscheinlichkeit, eine weiße Kugel

zu ziehen, bleibt gleich!)

- Von Interesse: Wahrscheinlichkeit, bei n Entnahmen k weiße

Kugeln zu ziehen.

- Bei Qualitätskontrolle: A :=„ Entnahme eines guten Teils“

A :=„ Entnahme eines Ausschußteils“

Def.: Eine diskrete ZG X heißt binomialverteilt mit den

Parametern n und p (X ~ B(n,p)), wenn sie die Wahrscheinlichkeitsfunktion

⎛n⎞ k

P( X = k ) = ⎜⎜ ⎟⎟ ⋅ p ⋅ (1 − p)n−k

⎝k ⎠

,k = 0,…,n

besitzt.

Bem.: - Die Binomialverteilung wird durch die Parameter n

und p eindeutig bestimmt.

- EX = n • p

- D2X = n • p • (1-p) = n • p • q

- P(X ≤ k) = P(X=0)+…+P(X=k) =

⎛n⎞ i

n−i

⎜

⎟

⋅

p

⋅

(

1

−

p

)

∑

⎜i⎟

i =0 ⎝ ⎠

- P(X ≥ k) = P(X=k)+…+P(X=n) =

⎛n⎞ i

n−i

⎜

⎟

⋅

p

⋅

(

1

−

p

)

∑

⎜i⎟

i=k ⎝ ⎠

k

P(X ≥ 1) = 1- P(X=0)

n

Bsp.: 10 Äpfel einer Partie werden untersucht. Es ist bekannt,

dass 10% der Äpfel angeschlagen sind.

a) Wie groß ist die Wahrscheinlichkeit, 3 angeschlagene

Äpfel in der Stichprobe zu finden?

b) Wie groß ist die Wahrscheinlichkeit, höchstens einen

angeschlagenen Apfel in der Stichprobe zu finden?

Lösung:

geg.: n = 10,

P(A)= p = 0,1

⎛ 10 ⎞

a) P(X = 3) = ⎜⎜ ⎟⎟ ⋅ 0,13 ⋅ (1 − 0,1)10 − 3 = 0,057

⎝3⎠

b) P(X ≤ 1) = P(X = 0) + P(X = 1) = 0,736

⎛ ⎛ 10 ⎞

⎞ ⎛ ⎛ 10 ⎞

⎞

0

10

1

9

⎜ ⎜⎜ ⎟⎟ ⋅ 0,1 ⋅ 0,9 ⎟ + ⎜ ⎜⎜ ⎟⎟ ⋅ 0,1 ⋅ 0,9 ⎟ = 0,910 + 0,9 9

⎜ 0

⎟ ⎜ 1

⎟

⎝⎝ ⎠

⎠ ⎝⎝ ⎠

⎠

2. Poisson Verteilung (Verteilung der seltenen Ereignisse)

Versuchsschema: Es werden Ereignisse gezählt, die innerhalb eines festen, vorgegebenen Zeitintervalls eintreten können.

Von Interesse: Die ZG X := „Anzahl der (seltenen) Ereignisse,

die innerhalb des Intervalls [0,1] eintreten“

Bsp.: ● Anzahl von Schadensmeldungen einer Sachversicherung in einem Jahr

● Anzahl von Krankheitsfällen einer seltenen Krankheit

in einem Monat

● Anzahl von Kunden, die im Monat einen Immobilienkredit bei einer Bank aufnehmen.

Vorauss.: 1. 2 Ereignisse können nicht gleichzeitig auftreten.

2. Die Wahrsch., dass ein Ereignis während eines

kleinen Zeitintervalls der Länge ∆t stattfindet, ist

annähernd λ∆t

3. Die Anzahlen von Ereignissen in 2 disjunkten

Teilintervallen sind unabhängig.

Def.: Eine diskrete ZG X heißt Poisson- verteit mit dem

Parameter λ (X ~ Π(λ)), wenn sie die Wahrscheinlichkeitsfunktion

λk

P( X = k ) =

⋅ e −λ

k!

,k = 0,…,n

besitzt.

Bem.: - der Parameter λ > 0 heißt Intensitätsparameter.

- EX = λ

- D2X = λ

4. Normalverteilung (NV)

(Gauss, 1809: „Theorie der

Beobachtungsfehler“)

Hintergrund:

Führt man in der Praxis wiederholt Messungen an ein und

demselben Objekt (Fettgehalt in Milchprobe) durch, so ergibt

auf Grund zufälliger Einflüsse nicht jede Messung den gleichen

Wert. Es zeigt sich aber, dass bei häufiger Wiederholung der

Messung die erhaltenen Werte kleinere oder größere Abweichungen voneinander und von einem bestimmtem „wahren“

Wert, dem Erwartungswert, aufweisen.

Beispiele:

● zuf. Mess- und Beobachtungsfehler

● Fett- und Eiweißgehalt von Milch, Stammwürzegehalt von

Bier, Saccharosegehalt von Zuckerrüben

● Füllhöhe bestimmter Getränkeflaschen

Def.: Eine stetige ZG X heißt normalverteilt mit den

Parametern µ und σ2 (X ~ N (µ, σ2)), wenn ihre

Dichtefunktion die Form

2

fX ( x ) =

1

⋅e

2π ⋅ σ

−

(x − µ )

2 ⋅σ 2

x∈,

hat.

Satz: Eigenschaften der Dichtefunktion der NV

1. fX(x) ≥ 0

x∈

2. fX besitzt an der Stelle x = µ ein Maximum und

1

fX (µ) =

2π ⋅ σ

3. fX besitzt an den Stellen x1 = µ -σ und x2 = µ + σ

zwei Wendepunkte

4. fX ist symmetrisch bez. X = µ: fX(µ - x) = fX(µ + x)

Dichtefunktion der Normalverteilung

0,8

0,1

4,1

4,2

4,0,5

0,2

Dichte

0,6

0,4

0,2

fX(x; 0, 1) = ϕX(x)

0

-10

-6

-2

2

6

10

14

x

Verteilungsfunktion

Verteilungsfunktion der Normalverteilung

1

0,1

4,1

4,2

4,0,5

0,2

0,8

0,6

0,4

Standard- Normalverteilung

X ~ N (0, 1)

FX(x; 0, 1) = ΦX(x)

0,2

ist tabelliert!

0

-10

-6

-2

2

x

6

10

14

Bem.: - Für eine normalverteilte ZG X gilt:

EX = µ und D2X = σ2

- Der Parameter µ bedeutet : Verschiebung des

Symmetriezentrums

Der Parameter σ bedeutet: Streckung oder

Stauchung der Dichte

x

- Die Verteilungsfunktion: FX (x)= P(X ≤ x) =

aber:

∫ f (t )dt

X

−∞

Integral nicht geschlossen integrierbar!

⇒ Standardisierung der normalverteilten ZG X und

Bestimmen der standardisierten Verteilungsfunktion Φ (ist tabelliert!) !

Satz: Eine stet. ZG X mit X ~ N(µ, σ2), kann durch Y = (X-µ)/ σ

standardisiert werden, so dass Y ~ N(0, 1), und man

erhält:

fX(x) = (1/σ) • ϕY(y) und FX(x) = ΦY(y)

(Zusammenhang von Dichte- und Verteilungsfunktionen)

N(0,1)

0,4

0,1

Dichte

0,3

0,2

0,1

0

-5

-3

-1

1

3

x

ϕY(-y) = ϕY(y)

5

Verteilungsfunktion der Normalverteilung

Verteilungsfunktion

Dichtefunktion der Normalverteilung

N(0,1)

1

0,1

0,8

0,6

0,4

0,2

0

-5

-3

-1

1

3

5

x

ΦY(-y) = 1- ΦY(y)

Bestimmen von Intervallwahrscheinlichkeiten:

X−µ x −µ⎞

⎛

1. P( X ≤ x) = FX ( x) = P⎜

≤

⎟ = P( Y ≤ y) = Φ Y ( y)

σ ⎠

⎝ σ

2. P( X > x) = 1− P( X ≤ x) = 1− FX ( x) =

⎛ X−µ x −µ⎞

1− P⎜

≤

⎟ = 1− P( Y ≤ y) = 1− Φ Y ( y)

σ ⎠

⎝ σ

3. P( x1 < X ≤ x 2 ) = FX ( x 2 ) − FX ( x1 )

X−µ

⎛

⎞

= P⎜ y1 < Y =

≤ y 2 ⎟ = Φ Y ( y 2 ) − Φ Y ( y1 )

σ

⎝

⎠

⎛ x1 −µ⎞

y1 = ⎜

⎟

⎝ σ ⎠

⎛ x2 −µ⎞

y2 = ⎜

⎟

⎝ σ ⎠

4. Spezialfall von 3.

Seien x1 = µ - kσ und x2 = µ + kσ

Dann gilt: P(|X - µ|) ≤ kσ) = Φ(k) - Φ(-k) = 2 Φ(k) – 1

Bem.: Betrachtet man k = 1,2 und 3, so ergeben sich

folgende Wahrscheinlichkeiten:

P(|X - µ|) ≤ 1σ) = 0,638

P(|X - µ|) ≤ 2σ) = 0,955

P(|X - µ|) ≤ 3σ) = 0,997

3σ- Regel

d.h. es ist praktisch „fast sicher“, dass eine normalverteilte ZG X Werte zwischen µ - 3σ und µ - 3σ

annimmt.

Bem.: Ist die stet. ZG nicht normalverteilt, kann man dennoch

die Wahrscheinlichkeit, dass die ZG Werte zwischen µ

und dem k-fachen der Standardabweichung σ annimmt

mit Hilfe der Tschebyscheff‘schen Ungleichung

abschätzen:

P(|X - µ| < kσ) > 1- (1/k2)

Dann gilt für k = 3 und 4:

P(|X - µ|) < 3σ) > 0,89

P(|X - µ|) < 4σ) > 0,94

Bsp.: Eine Maschine füllt Tüten. Die Masse der Tüten (ZG X)

sei normalverteilt mit X~ N(31,4; 0,04) [g].

Eine Tüte ist normgerecht gefüllt, wenn X Werte im

Intervall [30,9; 31,7] annimmt.

a) Wieviel % der Tüten sind normgerecht gefüllt?

b) Wieviel % der Tüten sind nicht normgerecht gefüllt?

c) Wieviel % der Tüten sind unterdosiert?

d) Wieviel % der Tüten sind überdosiert?

e) Wie müßte die untere Grenze des Toleranzbereiches

xu sein, damit nur 0,2 % der Tüten unterdosiert sind?

f) Welchen Wert müßte die Standardabweichung σ

haben, damit bei ursprünglichem Toleranzbereich nur

2% der Tütenunterdosiert sind?

Lösung:

a) P(A) = P(30,9 < X ≤ 31,7) = ΦY(1,5) - ΦY(-2,5) = 0,93319(1-0,99379) = 0,92698 ≈ 92,7 %

b) P( A ) = 1- P(A) = 7,3 %

c) P(X ≤ 30,9) = ΦY(-2,5) = (1-0,99379) = 0,00621 ≈ 0,6 %

d) P(X > 31,7) = 1- P(X ≤ 31,7) = 1 - ΦY(1,5) = 0,06681 ≈ 6,7 %

e) P(X ≤ xu) = 0,002

⎛ x u − 31,4 ⎞

1-0,002 = 0,998

⎟ = 0,002

= ΦY ⎜

⎝ 0,2 ⎠

→ ΦY(2,88) = 0,998

⎛ x u − 31,4 ⎞

→ ΦY(-2,88) = 0,002 → ⎜

⎟ = −2,88

⎝ 0,2 ⎠

→ xu = 30,824

f) analog zu e)

⎛ 30,9 − 31,4 ⎞

⎛ 30,9 − 31,4 ⎞

⎟ = −2,88

ΦY ⎜

⎟ = 0,002 → ⎜

σ

⎝

⎠

σ

→ σ = 0,1736

⎝

⎠