Stochastik I - Lehrstuhl für Mathematik VIII - Statistik

Werbung

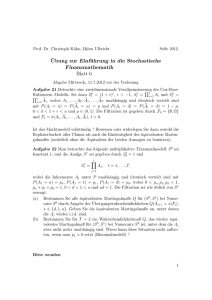

Stochastik I

Lehrstuhl für Mathematische Statistik

Universität Würzburg

Prof. Dr. Michael Falk

Inhaltsverzeichnis

1 Das Kolmogoroffsche Axiomensystem

1

2

2

Erste Folgerungen aus dem Axiomensystem

3 Grundlagen der Kombinatorik

8

4 Vermischte Aufgaben

12

5 Bedingte Wahrscheinlichkeiten

14

6 Unabhängigkeit

19

7 Zufallsvariablen

29

8 Integrationstheorie

39

9 Verteilungen und ihre Charakterisierungen

54

10 Momente

65

11 Gesetze der großen Zahlen

72

12 Der Zentrale Grenzwertsatz

85

2

1

Das Kolmogoroffsche Axiomensystem

[A. N. Kolmogoroff (1933)] Seit Euklid werden bei einem rein geometrischen Aufbau der Geometrie die Grundbegriffe Punkt“ und Gerade“ nicht

”

”

explizit definiert, sondern axiomatisch eingeführt.

1. Man vermittelt zunächst bewusst eine vage Vorstellung von dem, was

mit den Grundbegriffen gemeint ist, um die Theorie später anwenden

zu können ( Ein Punkt ist, was keinen Teil hat“, Eine Gerade ist

”

”

eine Linie, die gleich liegt mit den Punkten auf ihr selbst“ (Euklid)).

Die vage Vorstellung wird dann im Verlauf der Beschäftigung mit der

Theorie zwangsläufig immer präziser.

2. Man beschreibt mittels Axiomen“, welche Beziehungen zwischen den

”

Grundbegriffen bestehen.

Analog gehen wir nun bei der Axiomatisierung der Stochastik vor. Im ersten

Axiom fordern wir die Existenz von Wahrscheinlichkeiten.

Axiom 1’ Ist Ω die Menge der möglichen Ergebnisse eines Experimentes (d.h. genau ein ω ∈ Ω tritt bei der Durchführung des Experimentes

ein), so ist jeder Teilmenge A ⊂ Ω eine reelle Zahl P (A) ≥ 0 zugeordnet,

Wahrscheinlichkeit von A genannt, die den Grad der Sicherheit angibt, mit

dem A eintritt.

Axiom 2 P (Ω) = 1.

Axiom 3 (σ–Additivität von P ) S

Für eine Folge

P A1 , A2 , . . . paarweise disjunkter Teilmengen von Ω gilt: P ( n∈N An ) = n∈N P (An ).

Das System 1’,2,3 ist zu einschränkend, wie der folgende Satz zeigt.

Satz (G. Vitali 1905) Es existiert kein P zu Ω = [0, 1), welches die Axiome

1’,2 und 3 erfüllt und zusätzlich translationsinvariant ist, d.h. P (Ac ) = P (A)

für Ac := {a + c (mod 1) : a ∈ A}, c ≥ 0.

Beweis: Siehe Übungen.

2

Axiom 1’ wird nun abgeschwächt, indem P nicht mehr auf der gesamten

Potenzmenge P(Ω) = {A : A ⊂ Ω} definiert wird.

Axiom 1 Ist Ω die Menge der möglichen Ergebnisse eines Experimentes, so

ist einigen (nicht notwendig allen) Teilmengen von Ω, Ereignisse genannt,

eine reelle Zahl P (A) ≥ 0 zugeordnet, Wahrscheinlichkeit von A genannt, die

den Grad der Sicherheit angibt, mit dem A eintritt.

Ω ist ein Ereignis.

Das Komplement Ac = Ω\A eines Ereignisses A ist ein Ereignis.

Der Durchschnitt von zwei Ereignissen ist ein Ereignis.

Die Vereinigung von abzählbar vielen disjunkten Ereignissen ist ein

Ereignis.

Definition 1.1 Ω sei eine nichtleere Menge. Dann heißt A ⊂ P(Ω) (= Potenzmenge von Ω) σ–Algebra über Ω:⇔

1. Ω ∈ A,

2. A ∈ A ⇒ Ac ∈ A,

3. A, B ∈ A ⇒ A ∩ B ∈ A

4. Ai ∈ A, i ∈ N, Ai ∩ Aj = ∅ für i 6= j ⇒

S

i∈N

Ai ∈ A.

Definition 1.2 (Ω, A) heißt messbarer Raum :⇔ A ist σ–Algebra über

nichtleerer Menge Ω.

Definition 1.3 (Ω, A) sei messbarer Raum. Eine Funktion P : A → R+ =

[0, ∞), die die Axiome 2 und 3 erfüllt, heißt Wahrscheinlichkeitsmaß. Das

Tripel (Ω, A, P ) heißt in diesem Fall Wahrscheinlichkeitsraum.

2

Erste Folgerungen aus dem Axiomensystem

Satz 2.1 (Ω, A) messbarer Raum, An ∈ A, n ∈ N. Dann gilt:

S

(i) n∈N An ∈ A,

T

(ii) n∈N An ∈ A,

(iii)

lim sup An := {ω ∈ Ω : ω liegt in ∞ vielen An }

n∈N

=

∞ [

\

An ∈ A,

m=1 n≥m

(iv)

lim inf An := {ω ∈ Ω : ω liegt in fast allen An }

n∈N

=

∞ \

[

m=1 n≥m

Beweis:

2

An ∈ A,

(i) Setze B1 := A1 , Bn := An \(A1 ∪ . . . ∪ An−1S

) = An ∩ Ac1S∩ . . . ∩ Acn−1 ∈

A. Bn , n ∈ N, sind paarweise disjunkt mit n∈N An = n∈N Bn ∈ A.

(ii)

\

An =

\

n∈N

An

c c

=

n∈N

[

Acn

c

∈ A.

n∈N

(iii) und (iv) folgen unmittelbar aus (i), (ii).

2

Korollar 2.2 Ω 6= ∅, A ⊂ P(Ω). Dann: A ist σ–Algebra ⇔

(i) Ω ∈ A,

(ii) A ∈ A ⇒ Ac ∈ A,

(iii) An ∈ A, n ∈ N ⇒

S

n∈N

An ∈ A.

Satz 2.3 (Ω, A, P ) sei Wahrscheinlichkeitsraum. Dann gilt:

(i) P (∅) = 0,

(ii) P (A1 ∪ . . . ∪ An ) =

Pn

i=1

P (Ai ), falls A1 , . . . , An paarweise disjunkt,

(iii) 0 ≤ P (A) ≤ 1 stets,

(iv) A ⊂ B (∈ A) ⇒ P (A) ≤ P (B) (Monotonie von P ),

(v) P (Ac ) = 1 − P (A).

Beweis:

(i)

∅ = ∅ ∪ ∅ ∪ ...

⇒ P (∅) = P (∅) + P (∅) + . . .

⇒ P (∅) = 0.

(ii) Wegen P (∅) = 0 gilt:

P (A1 ∪ . . . ∪ An ) = P (A1 ∪ . . . ∪ An ∪ ∅ ∪ . . .)

= P (A1 ) + . . . + P (An ) + 0 + . . .

(v)

Ω = A ∪ Ac ⇒ 1 = P (Ω) = P (A) + P (Ac )

⇒ P (Ac ) = 1 − P (A).

3

(iii) Folgt unmittelbar aus (v):

0 ≤ P (A) = 1 − P (Ac ) ≤ 1.

| {z }

≥0

(iv)

⇒(ii)

B = A ∪ (B\A) = A ∪ (B ∩ Ac )

P (B) = P (A) + P (B\A) ≥ P (A).

2

Im folgenden sei (Ω, A, P ) ein Wahrscheinlichkeitsraum, A1 , . . . , An ∈ A. |M |

bezeichnet die Anzahl der Elemente einer Menge M (Mächtigkeit von M ).

Satz 2.4 (Allgemeiner Additionssatz)

!

X

P (A1 ∪ . . . ∪ An ) =

=

(−1)

∅6=T ⊂{1,...,n}

n

X

k−1

(−1)

|T |−1

P

\

Ai

i∈T

Sk

k=1

mit

X

Sk :=

P Ai1 ∩ Ai2 ∩ · · · ∩ Aik .

1≤i1 <i2 <...<ik ≤n

Beispiel: Im Fall n = 2 ergibt sich

P (A1 ∪ A2 ) = P (A1 ) + P (A2 ) − P (A1 ∩ A2 ).

Im Fall n = 3 ergibt sich

P (A1 ∪ A2 ∪ A3 )

= P (A1 ) + P (A2 ) + P (A3 )

−P (A1 ∩ A2 ) − P (A1 ∩ A3 ) − P (A2 ∩ A3 )

+P (A1 ∩ A2 ∩ A3 ).

Beweis: Mittels vollständiger Induktion; ”+” bedeutet Vereinigung disjunkter Mengen.

Der Fall n = 2:

A1 ∪ A2 = A1 + (A2 \A1 ),

A2 = (A2 ∩ A1 ) + (A2 \A1 )

⇒ P (A1 ∪ A2 ) = P (A1 ) + P (A2 \A1 ),

P (A2 ) = P (A2 ∩ A1 ) + P (A2 \A1 )

⇒ P (A1 ∪ A2 ) − P (A1 ) = P (A2 ) − P (A2 ∩ A1 )

⇒ Behauptung für den Fall n = 2.

4

Der Induktionsschritt n → n + 1:

P ((A1 ∪ . . . ∪ An ) ∪ An+1 )

= P ((A1 ∪ . . . ∪ An )) + P (An+1 )

−P ((A1 ∩ An+1 ) ∪ (A2 ∩ An+1 ) ∪ . . .

∪(An ∩ An+1 ))

!

X

\

=

(−1)|T |−1 P

Ai + P (An+1 )

i∈T

∅6=T ⊂{1,...,n}

!

X

−

(−1)|T |−1 P

\

Ai ∩ An+1

i∈T

∅6=T ⊂{1,...,n}

!

X

=

\

(−1)|T |−1 P

Ai

+ P (An+1 )

i∈T

∅6=T ⊂{1,...,n+1}, n+16∈T

!

X

+

(−1)|T |−1 P

\

Ai

i∈T

T ⊂{1,...,n+1}, n+1∈T, T ∩{1,...,n}6=∅

!

=

X

(−1)|T |−1 P

\

Ai

.

i∈T

∅6=T ⊂{1,...,n+1}

2

Satz 2.5 Sei Bk das Ereignis, dass genau k der Ereignisse A1 , . . . , An eintreten, d.h. ω ∈ Bk ⇔ ω ∈ Ai für genau k der Indizes i = 1, . . . , n. Dann

gilt:

!

X

\

|U |

P (Bk ) =

(−1)|U |−k P

Ai

k

i∈U

U ⊂{1,...,n}, |U |≥k

n X

m

=

(−1)m−k Sm ,

k

m=k

Sm wie in Satz 2.4, S0 := 1.

Bemerkung

B0 = (A1 ∪ . . . ∪ An )c ⇒ P (B0 ) = 1 − P (∪1≤i≤n Ai ) =2.4

Pn

m

m=0 (−1) Sm .

Beweis:

!

Bk =

X

S⊂{1,...,n}, |S|=k

\

i∈S

5

Ai

!!

∩

\

i∈S c

Aci

,

(disjunkte Zerlegung von Bk ). Es folgt:

P (Bk )

!

X

=

\

P

!!

\

∩

Ai

i∈S c

i∈S

S⊂{1,...,n}, |S|=k

!c

(

X

=

\

1−P

!!)

[

∪

Ai

(

X

Ai

i∈S c

i∈S

S⊂{1,...,n}, |S|=k

=2.4

Aci

!c !

"

\

1− P

Ai

i∈S

S⊂{1,...,n}, |S|=k

!

X

+

\

(−1)|T |−1 P

∅6=T ⊂S c

Ai

i∈T

!c

−P

[

\

i∈S c

j∈S

!!#)

∩ Ai

Aj

(

X

=

!

\

P

Ai

i∈S

S⊂{1,...,n}, |S|=k

\

Ai

i∈T

| {z }

=C

X

(−1)|T |−1 P

−

c

∅6=T ⊂S

−

X

|T |−1

(−1)

∅6=T ⊂S c

P

|

!c

\

\

;

Aj ∩

Ai

j∈S

i∈T

{z } | {z }

=C

=Dc

c

=

wegen P (C) − P (D ∩ C) = P (C ∩ D) folgt

(

!

X

\

P

Ai

i∈S

S⊂{1,...,n}, |S|=k

−

(−1)|T |−1 P

∅6=T ⊂S c

|

X

!

!

\

\

Aj ∩

Ai

j∈S

i∈T

{z

}

T

=

i∈S∪T

Ai

!

=

X

X

(−1)|T | P

S⊂{1,...,n}, |S|=k T ⊂S c

\

Ai

i∈S∪T

!

=

X

X

(−1)|U |−k P

S⊂{1,...,n}, |S|=k U ⊃S, U ⊂{1,...,n}

\

Ai

.

i∈U

T

Der Summand (−1)|U |−k P

i tritt hierbei so oft auf, wie es k–elementige

i∈U A

Teilmengen S von U gibt, also |Uk | –mal. Hieraus folgt der erste Teil der Be6

hauptung sowie

=

n X

m

m=k

k

!

X

m−k

(−1)

P

U ⊂{1,...,n}, |U |=m

|

\

Ai

.

i∈U

{z

=Sm

}

2

Satz 2.6 Sei Ck das Ereignis, dass mindestens k der Ereignisse A1 , . . . , An

eintreten. Dann gilt:

n X

m−1

P (Ck ) =

(−1)m−k Sm .

k

−

1

m=k

Beweis:

P (Ck )

=

=2.5

=

n

X

P (Bj )

j=k

n X

n X

m

(−1)m−j Sm

j

j=k m=j

!

n

m X

X

m

(−1)m−j Sm .

j

m=k

j=k

Für die innere Summe folgt aus der Beziehung nk = n−1

+

k

m

m

m

−

+

− ...

m

m−1

m−2

m−k m

+(−1)

k

m−1

m−1

m−1

=

+

−

m−1

m−1

m

{z

}

| {z } |

=0

=0

m−1

m−k m − 1

−

+ . . . + (−1)

m−2

k

|

{z

}

=0

m−k m − 1

+(−1)

k−1

m−k m − 1

= (−1)

.

k−1

n−1

k−1

:

2

Bemerkung Der Allgemeine Additionssatz 2.4 ist in 2.6 enthalten (k = 1).

Bemerkung Zur Geschichte der Stochastik: Briefwechsel (1654) zwischen P.

Fermat und B. Pascal (u.a. wg. Chevalier de Méré); inzwischen stürmische

Entwicklung (A.N. Kolmogoroff (1933)−→ . . .)

7

3

Grundlagen der Kombinatorik

Definition 3.1 Ein Wahrscheinlichkeitsraum (Ω, A, P ) heißt Laplace–Experiment :⇔ |Ω| < ∞ und alle einelementigen Teilmengen von Ω sind Ereignisse

mit der gleichen Wahrscheinlichkeit.

Satz 3.2 (Ω, A, P ) Laplace–Experiment, A ⊂ Ω. Dann gilt:

|A|

|Ω|

Anzahl der für A günstigen Ausgänge

.

=

Anzahl aller möglichen Ausgänge

P (A) =

Satz 3.3 (Additionsprinzip der Kombinatorik) Für disjunkte endliche

Mengen A1 , A2 gilt:

|A1 + A2 | = |A1 | + |A2 |.

Korollar Für disjunkte endliche Mengen A1 , . . . , Ak gilt:

|A1 ∪ . . . ∪ Ak | = |A1 | + . . . + |Ak |.

Satz 3.4 (Multiplikationssatz der Kombinatorik) A1 sei eine Menge

der Mächtigkeit n1 ∈ Z+ = N ∪ {0}, B2 eine beliebige Menge und n2 ∈

Z+ . Jedem a1 ∈ A1 sei genau eine n2 –elementige Teilmenge B(a1 ) ⊂ B2

zugeordnet, und es sei

A2 := {(a1 , a2 ) : a1 ∈ A1 , a2 ∈ B(a1 )}.

Dann gilt: |A2 | = n1 n2 .

Beweis: Folgt aus 3.3.

2

Korollar 3.5 |A1 | = n1 ∈ Z+ , B1 , . . . , Bn seien beliebige Mengen und n2 , . . . ,

nk ∈ Z+ . Für i = 1, . . . , k − 1 sei jedem i–Tupel (a1 , . . . , ai ) ∈ Ai eine ni+1 –

elementige Teilmenge B(a1 , . . . , ai ) ⊂ Bi+1 zugeordnet, und es sei

Ai+1 := {(a1 , . . . , ai , ai+1 ) : (a1 , . . . , ai ) ∈ Ai ,

ai+1 ∈ B(a1 , . . . , ai )},

(Definition durch Induktion (Rekursion)). Dann gilt:

|Ak | = n1 n2 . . . nk .

8

Korollar |A1 × A2 × . . . × Ak | = n1 n2 · · · nk , falls |Ai | = ni , i = 1, . . . , k.

Obiges Korollar ergibt speziell für Ai = A, i = 1, . . . , k: | A

. . × A} | =

| × .{z

k mal

|Ak | = |A|k .

Die Menge Ak aller k–Tupel von Elementen aus A heißt geordnete Probe zu

A vom Umfang k mit Wiederholung.

Satz 3.6 Es gibt nk geordnete Proben zu einer n–elementigen Menge vom

Umfang k mit Wiederholung.

Beispiel A,

endliche Mengen, B A := Menge aller Abbildungen von A nach

B

B. Dann: B A = |B||A| .

Korollar 3.7 Eine n–elementige Teilmenge besitzt 2n verschiedene Teilmengen.

Beweis: A sei eine n–elementige Menge, dann: |{0, 1}A | = 2|A| ; |Menge aller

Abbildungen von A → {0, 1}| = |P(A)|.

2

Ein k–Tupel (a1 , . . . , ak ) ∈ Ak mit ai 6= aj für j 6= i heißt geordnete Probe

aus A vom Umfang k ohne Wiederholung.

Satz 3.8 Zu einer n–elementigen Menge gibt es (n)k := n(n−1) · · · (n−k+1)

geordnete Proben vom Umfang k ≥ 1 ohne Wiederholung.

Beweis: Für eine geordnete Probe (a1 , . . . , ak ) vom Umfang k ohne Wiederholung gilt: a1 ∈ A, a2 ∈ A\{a1 }, a3 ∈ A\{a1 , a2 }, . . . , ak ∈ A\{a1 , . . . , ak−1 }.

Aus dem Multiplikationsprinzip, genauer 3.5, folgt nun die Behauptung. 2

Speziell für k = n erhalten wir

Satz 3.9 n verschiedene Elemente können auf (n)n = n! verschiedene Arten

angeordnet werden, d.h. es existieren n! Permutationen einer n–elementigen

Menge.

Eine ungeordnete Probe vom Umfang k mit bzw. ohne Wiederholung erhalten wir, indem wir geordnete Proben, die sich nur in der Reihenfolge

unterscheiden, identifizieren. Die ungeordneten Proben vom Umfang k ohne

Wiederholung sind demnach einfach die k–elementigen Teilmengen von A.

9

Satz 3.10 Eine n–elementige Menge besitzt

n!

n

(n)k

=

=

k!

k!(n − k)!

k

verschiedene k–elementige Teilmengen.

Beweis: Eine geordnete Probe vom Umfang k ohne Wiederholung besteht

aus einer k–elementigen Teilmenge und einer Anordnung. Es gibt k! verschiedene Möglichkeiten der Anordnung (3.9), also (3.8):

(n)k = Anzahl der k–elementigen Teilmengen × k!.

Hieraus folgt die Behauptung.

2

Korollar 3.11 (i) Es gibt nk Möglichkeiten, k unterscheidbare Kugeln auf

n unterscheidbare Urnen zu verteilen.

(ii) Es gibt (n)k Möglichkeiten, k unterscheidbare Kugeln so auf n unterscheidbare Urnen zu verteilen, dass keine Urne mehr als eine Kugel

enthält.

(iii) Es gibt nk Möglichkeiten, k ununterscheidbare Kugeln so auf n unterscheidbare Urnen zu verteilen, dass keine Urne mehr als eine Kugel

enthält.

Satz 3.12 Es gibt

k

k1 , k2 , . . . , kn

:=

k!

k1 !k2 ! · · · kn !

Möglichkeiten, k unterscheidbare Kugeln so auf n unterscheidbare Urnen zu

verteilen, dass genau ki Kugeln in die Urne Nummer i kommen (ki ≥ 0,

i = 1, . . . , n; k1 + k2 + . . . + kn = k).

Beweis: Es gibt

k

Möglichkeiten der k1

k1

k − k1

Möglichkeiten der k2

k2

.. ..

. .

k − k1 − . . . − kn−2

kn−1

Kugeln für Urne 1

Kugeln für Urne 2

..

.

Möglichkeiten der kn−1

Kugeln für Urne n − 1.

10

Ausmultiplikation liefert nun:

Möglichkeiten insgesamt

k

k − k1

k − k1 − . . . − kn−2

=

···

k1

k2

kn−1

(k − k1 )!

k!

×

× ...

=

k1 !(k − k1 )! k2 !(k − k1 − k2 )!

(k − k1 − . . . − kn−2 )!

×

kn−1 !(k − k1 − . . . − kn−1 )!

k!

=

.

k1 ! · · · kn !

2

k

Bemerkung Die Größen k1 ,...,k

heißen Polynomialkoeffizienten. Wegen

n

n

n

= k,n−k verallgemeinern sie die Binomialkoeffizienten nk .

k

Korollar 3.13

(a1 + . . . + an )k

X

=

k1 ≥0,...,kn ≥0, k1 +...+kn =k

Korollar 3.14

k

ak1 ak2 · · · aknn .

k1 , . . . , kn 1 2

(i)

n X

n

k

k=0

= 2n .

(ii)

r X

n

m

m+n

=

.

k

r−k

r

k=0

(iii)

n 2

X

n

k=0

k

2n

=

.

n

Beweis:

(i) Zerlegung der Potenzmenge einer n–elementigen Menge gemäß Mächtigkeit der Teilmenge; 3.7 ⇒ Behauptung.

(ii) m+n

= Anzahl der r–elementigen Teilmengen von {1, . . . , n, n+1, . . . ,

r

m+n}. Die Anzahl der Möglichkeiten, hierbei k Elemente aus {1, . .. , n}

m

.

und somit r − k aus {n + 1, . . . , n + m} auszuwählen, ist nk r−k

2

n (iii) Folgt mit m = r = n aus (ii) wegen nk = nk n−k

.

2

4

Vermischte Aufgaben

Aufgabe 4.1 Aus einer Schulklasse mit 20 Schülern wird eine Woche lang

(5 Tage) jeden Morgen ein Schüler zufällig ausgewählt. Wie groß ist die

Wahrscheinlichkeit, dass mindestens 1 Schüler mehrmals ausgewählt wird?

Lösung: Laplace–Experiment mit Ω = {1, . . . , 20}5 , |Ω| = 205 ; ungünstige

Fälle: alle geordneten Proben vom Umfang 5 ohne Wiederholung, d.h. (20)5 .

Also:

gesuchte Wahrscheinlichkeit

=

205 − (20)5

205

= 1−

20 × 19 × . . . × 16

= 0, 4186.

205

2

Aufgabe 4.2 Sack mit N Nüssen, darunter S schlechte Nüsse. Gezogen wird

eine Stichprobe vom Umfang n. Wie groß ist die Wahrscheinlichkeit p(s),

dass in der Stichprobe genau s schlechte Nüsse sind, s = 0, 1, . . . , n?

.

Lösung: {1, . . . , S} = Menge der schlechten Nüsse von {1, .. . , N }. Laplace–

Experiment mit Ω = {A ⊂ {1, . . . , N } : |A| = n}, |Ω| = Nn . Dann:

p(s)

=

|A ∈ Ω mit |A ∩ {1, . . . , S}| = s|

N

n

=

S

s

N −S

n−s

N

n

=: HN,S,n (s).

HN,S,n heißt Hypergeometrische Verteilung zu den Parametern N , S, n (Qualitätskontrolle).

2

Aufgabe 4.3 Skatspiel: 32 Karten, 3 Spieler, je 10 Karten; Skat“ mit 2

”

Karten. Es gibt vier Buben.

(i) Spieler A habe 2 Buben. Wie groß ist die Wahrscheinlichkeit, dass die

Spieler B und C jeweils 1 Buben besitzen?

22

Lösung: Es gibt 10,10,2

mögliche Verteilungen der 22 Karten, die A

nicht besitzt, auf B,C und den Skat. Diese sind gleich wahrscheinlich.

12

Die Anzahl der günstigen Möglichkeiten beträgt

beträgt die gesuchte Wahrscheinlichkeit

20

2

×

100

9,9,2

1,1,0

.

=

22

231

10,10,2

20

9,9,2

×

2

1,1,0

. Also

2

(ii) Gesucht: Wahrscheinlichkeit, dass einer der beiden Spieler beide Buben

besitzt.

Lösung:

2×

20

2

× 2,0,0

8,10,2

22

10,10,2

=

90

.

231

2

(iii) Gesucht: Wahrscheinlichkeit, dass beide Buben im Skat liegen.

Lösung:

20

10,10,0

2

0,0,2

×

=

22

10,10,2

1

.

231

2

(iv) Gesucht: Wahrscheinlichkeit, dass genau 1 Bube im Skat liegt:

Lösung:

2×

20

2

× 1,0,1

9,10,1

22

10,10,2

=

40

.

231

2

(v) Bilderschecks in Warenprodukten: k Warenpackungen (Cornflakes). In

jeder Packung ist genau 1 von n möglichen Sammelmarken (etwa n =

11 Fußballspieler).

Annahme: Laplace–Experiment, es gibt nk Möglichkeiten der Verteilung. Gesucht: Wahrscheinlichkeit pm , dass wenigstens m Sammelmarken fehlen.

Lösung: Ω = Menge aller möglichen Verteilungen von k unterscheid.

.

baren Kugeln (= Packungen) auf n unterscheidbare Urnen (= Sammelmarken). |Ω| = nk .

Ai := Menge aller Verteilungen, bei denen die i–te Urne leer ist.

Für 1 ≤ i1 < . . . < ir ≤ n gilt:

(n − r)k

.

P Ai1 ∩ . . . ∩ Air =

nk

Es folgt mit der Bezeichnung von 2.4

X

Sr =

P Ai1 ∩ . . . ∩ Air

1≤i1 <...<ir ≤n

n (n − r)k

=

nk

r

13

und damit aus 2.6

pm = P (Cm )

n

X

n (n − r)k

r−m r − 1

.

=

(−1)

nk

m−1

r

r=m

2

5

Bedingte Wahrscheinlichkeiten

(Ω, A, P ) sei Wahrscheinlichkeitsraum, B ∈ A mit P (B) > 0.

Es sei bekannt, dass das Ereignis B eingetreten ist.

Neues Experiment: Ergebnismenge Ω0 = B.

Heuristisch: Wahrscheinlichkeit, dass A eintritt, wenn bereits bekannt ist,

dass B eingetreten ist, ist P (A ∩ B)/P (B).

Definition 5.1 (Ω, A, P ) sei Wahrscheinlichkeitsraum, A ∈ A und B ∈ A

mit P (B) > 0. Dann heißt

P (A|B) := PB (A) :=

P (A ∩ B)

P (B)

bedingte Wahrscheinlichkeit von A unter (der Bedingung) B.

Beispiel 5.2 Für die beiden ersten Kinder einer Familie seien die 4 Geschlechtskombinationen J − J, M − M , J − M und M − J gleich wahrscheinlich. Von einer Familie sei bekannt, dass wenigstens eines der Kinder

ein Junge ist. Wie groß ist die Wahrscheinlichkeit, dass diese Familie sogar

zwei Jungen hat?

.

.

Lösung: A1 := 1. Kind ist ein Junge, A2 := 2. Kind ist ein Junge. Damit:

P (A1 ∩ A2 |A1 ∪ A2 )

T

P ((A1 ∩ A2 ) (A1 ∪ A2 ))

=

P (A1 ∪ A2 )

P (A1 ∩ A2 )

=

P (A1 ∪ A2 )

P (A1 ∩ A2 )

=

P (A1 ) + P (A2 ) − P (A1 ∩ A2 )

=

=

1

2

1

4

1

2

+ −

1

4

1

.

3

2

14

Satz 5.3 (Ω, A, P ) sei Wahrscheinlichkeitsraum, B ∈ A mit P (B) > 0. Die

bedingte Wahrscheinlichkeit PB : A → R+ ist eine Wahrscheinlichkeit, d.h.

PB erfüllt die Axiome 1,2,3.

Beweis: Trivial, Axiome nachprüfen.

2

Satz 5.4 A1 , . . . , An Ereignisse mit P (A1 ∩ . . . ∩ An−1 ) > 0. Dann:

P (A1 ∩ . . . ∩ An )

= P (A1 )P (A2 |A1 )P (A3 |A1 ∩ A2 ) × . . .

×P (An |A1 ∩ . . . ∩ An−1 ).

Beweis: n = 2 : P (A1 ∩ A2 ) = P (A1 )P (A2 |A1 );

n→n+1:

P (A1 ∩ . . . ∩ An+1 )

=

P (A1 ∩ . . . ∩ An )P (An+1 |A1 ∩ . . . ∩ An )

=Ind. V. P (A1 )P (A2 |A1 ) × · · ·

×P (An+1 |A1 ∩ . . . ∩ An ).

2

Beispiel 5.5 16 weiße, 16 schwarze Schachfiguren liegen im Kasten. 3 Figuren werden zufällig ohne Zurücklegen gezogen. Wie groß ist die Wahrscheinlichkeit, dass alle 3 Figuren schwarz sind?

Lösung: Ai sei das Ereignis, dass die i–te Figur schwarz ist. Dann:

P (A1 ∩ A2 ∩ A3 )

= P (A1 )P (A2 |A1 )P (A3 |A1 ∩ A2 )

!

16

16 15 14

3

.

×

×

= 32

=

32 31 30

3

2

Satz 5.6 (Totale Wahrscheinlichkeit) (Ω,

PnA, P ) Wahrscheinlichkeitsraum,

B1 , . . . , Bn seien disjunkte Ereignisse mit

i=1 Bi = Ω, P (Bi ) > 0, i =

1, . . . , n. Dann:

P (A) =

n

X

P (Bi )P (A|Bi ),

i=1

15

A ∈ A.

Beweis:

P (A) = P (Ω ∩ A)

!

n

X

= P

(Bi ∩ A)

i=1

=

=

n

X

i=1

n

X

P (Bi ∩ A)

P (Bi )P (A|Bi )

i=1

2

Beispiel 5.7 (Zweistufiges Experiment) In Urne 1 liegen 2 weiße und 8

schwarze Kugeln, in Urne 2 liegen 4 weiße und 6 schwarze Kugeln.

Zunächst wird gewürfelt. Bei einer 5 oder 6 erfolgt eine Ziehung aus Urne 1,

bei einer 1-4 wird aus Urne 2 gezogen.

Wie groß ist die Wahrscheinlichkeit, eine weiße Kugel zu ziehen?

.

Lösung: A = eine weiße Kugel wird gezogen,

.

B1 = 5 oder 6 beim Würfeln,

.

B2 = 1–4 beim Würfeln. Dann:

P (A) = P (B1 )P (A|B1 ) + P (B2 )P (A|B2 )

1

1 1 2 2

× + × = .

=

3 5 3 5

3

2

Satz 5.8 (Bayessche Formel) Zusätzlich zu den Voraussetzungen von Satz

5.6 gelte P (A) > 0. Dann gilt:

P (Bi )P (A|Bi )

.

P (Bi |A) = Pn

j=1 P (Bj )P (A|Bj )

Beweis:

P (A ∩ Bi )

P (A)

P (Bi )P (A|Bi )

= Pn

.

j=1 P (Bj )P (A|Bj )

P (Bi |A) =

2

16

.

Beispiel 5.9 (Fortsetzung von Beispiel 5.7) A = Ziehen einer weißen

Kugel, P (A) = 1/3.

Wie groß ist die Wahrscheinlichkeit von Bi , i = 1, 2, wenn bekannt ist, dass

eine weiße Kugel gezogen wurde, d.h. wie groß ist die Wahrscheinlichkeit,

dass eine weisse Kugel aus Urne i stammt?

Lösung:

P (B1 )P (A|B1 )

P (B1 )P (A|B1 ) + P (B2 )P (A|B2 )

1

1/3 × 1/5

=

=

1/3 × 1/5 + 2/3 × 2/5

5

4

⇒ P (B2 |A) = .

5

P (B1 |A) =

P (Bi |A) heißt a posteriori Wahrscheinlichkeit von Bi , P (Bi ) heißt a priori

Wahrscheinlichkeit von Bi .

2

.

Beispiel 5.10 (Überprüfung, ob radikal) R := Kandidat ist radikal,

.

B := Kandidat wird für radikal erklärt.

Eine Überprüfung ergebe mit der Wahrscheinlichkeit 0,95 ein richtiges Ergebnis, d.h.

P (B|R) = 0, 95; P (B c |Rc ) = 0, 95.

Es sei P (R) = 0, 005.

Wie groß ist die Wahrscheinlichkeit, das ein als radikal erklärter Kandidat

tatsächlich radikal ist?

Lösung: Gesucht:

P (R ∩ B)

P (B)

P (R)P (B|R)

=

P (R)P (B|R) + P (Rc )P (B|Rc )

5/1000 × 95/100

=

5/1000 × 95/100 + 995/1000 × 5/100

95

=

(!).

1090

P (R|B) =

2

Beispiel 5.11 (Brustkrebs-Screening durch Mammographie) 1

Die Wahrscheinlichkeit, dass eine 50jährige Frau Brustkrebs hat, ist bei etwa

0,8% anzusiedeln.

1

Aus: Christian Hesse (2010). Warum Mathematik glücklich macht. C.H. Beck,

München, S. 199ff.

17

Die Wahrscheinlichkeit, dass das Mammogramm einer Patientin positiv ist,

wenn sie Brustkrebs hat, liegt bei etwa 90% (sog. Sensitivität des Untersuchungsverfahrens).

Die Wahrscheinlichkeit, dass ein durchgeführtes Mammogramm positiv ist,

wenn die Patientin keinen Brustkrebs hat, liegt bei etwa 7% (sog. Falsch-Positiv-Rate).

Angenommen, eine 50-jährige Frau unterzieht sich einer Mammographie und

der Befund ist positiv. Wie wahrscheinlich ist es, dass die Frau tatsächlich

Brustkrebs hat?

.

.

Lösung: B := Brustkrebserkrankung, M := Mammogramm ist positiv.

Dann:

P (B) =

8

,

1000

P (M | B) =

90

,

100

P (M | B c ) =

7

.

100

Gesucht:

P (B | M ) =

=

P (B)P (M | B)

P (B)P (| B) + P (B c )P (M | B c )

8 90

1000 100

8 90

992 7

+ 1000

1000 100

100

720

7664

9

(!).

≈

100

=

2

Beispiel 5.12 (Laplacescher Folgesatz) In einer Urne liegen N Kugeln,

W weiße und N − W schwarze. W sei unbekannt; alle N + 1 möglichen

Mischungsverhältnisse besitzen die gleiche Wahrscheinlichkeit 1/(N + 1).

Es werden nacheinander n + 1 Kugeln ohne Zurücklegen gezogen.

Wie groß ist die Wahrscheinlichkeit, dass die n + 1-te Kugel weiß ist, wenn

die ersten n Kugeln weiß gewesen sind?

.

Lösung: Ai := nur weiße Kugeln unter den ersten i Ziehungen.

Offenbar gilt A1 ⊃ A2 ⊃ . . . und gesucht ist

P (An+1 |An ) =

P (An+1 )

P (An+1 ∩ An )

=

.

P (An )

P (An )

18

Wir erhalten:

N

X

P (An ) =

P {W = w}P (An |{W = w})

w=0

N

X

1

×

=

N

+

1

w=0

w

n

N

n

N X

w

1

=

(N + 1)

N

n

1

×

N +1

1

=

.

n+1

=

w=n

N +1

n+1

N

n

n

Behauptung:

N X

w

w=n

n

=

N +1

.

n+1

N +1

n+1

Denn:

ist die Anzahl der Möglichkeiten, aus der Menge {1, 2, . . . , N +1}

eine n + 1–elementige Teilmenge auszuwählen. Dabei gibt es wn Möglichkeiten, die Auswahl so zu treffen, dass w + 1 das größte der ausgewählten

Elemente ist, w = n, . . . , N .

Insgesamt erhalten wir somit:

P (An+1 |An ) =

n+1

n+2

unabhängig von N !

6

2

Unabhängigkeit

Gegeben ist ein Würfel, A := {2, 4, 6}, B := {5, 6}, P (A) = 1/2.

P (A|B) =

P (A ∩ B)

1/6

1

=

= = P (A),

P (B)

2/6

2

d.h. die zusätzliche Information des Eintretens von B hat in diesem speziellen

Fall keinen Einfluss auf die Wahrscheinlichkeit des Eintretens von A.

Definition 6.1 A, B Ereignisse mit P (B) > 0; dann:

A unabhängig von B :⇔ P (A) = P (A|B).

19

Satz 6.2 A, B Ereignisse mit P (A) > 0 und P (B) > 0; dann:

A unabhängig von B

⇔ B unabhängig von A

⇔ P (A ∩ B) = P (A)P (B).

Beweis:

A unabhängig von B

⇔ P (A) = P (A ∩ B)/P (B)

⇔ P (B) = P (A ∩ B)/P (A)

⇔ P (A ∩ B) = P (A)P (B).

2

Definition 6.3 A, B beliebige Ereignisse, dann:

A, B unabhängig :⇔ P (A ∩ B) = P (A)P (B).

Satz 6.4 A, B unabhängig, dann gilt:

Ac , B sind unabhängig,

A, B c sind unabhängig,

Ac , B c sind unabhängig.

Beweis:

P (Ac ∩ B) =

=

=

=

P (B) − P (A ∩ B)

P (B) − P (A)P (B)

P (B)(1 − P (A))

P (B)P (Ac ).

2

Satz 6.5 A, B seien unabhängig; A, C seien unabhängig; B ∩ C = ∅. Dann

gilt:

A, B ∪ C sind unabhängig.

20

Beweis:

P (A ∩ (B ∪ C)) =

=

=

=

P ((A ∩ B) + (A ∩ C))

P (A ∩ B) + P (A ∩ C)

P (A)P (B) + P (A)P (C)

P (A)P (B ∪ C).

2

Bemerkung A, B, C paarweise unabhängig 6⇒ P (A∩B∩C) = P (A)P (B)P (C).

Gegenbeispiele: Siehe Übungen.

Definition 6.6 Ω 6= ∅; A ⊂ P(Ω) ist Algebra über Ω :⇔

(i) Ω ∈ A,

(ii) A ∈ A ⇒ Ac ∈ A,

(iii) A, B ∈ A ⇒ A ∪ B ∈ A.

Definition 6.7 ∅ =

6 S ⊂ P(Ω). Dann:

\

D

α(S) :=

P(Ω)⊃D⊃S, D Algebra

=: kleinste Algebra, die S enthält,

\

D

σ(S) :=

P(Ω)⊃D⊃S, D σ –Algebra

=: kleinste σ–Algebra, die S enthält.

Beachte: Der beliebige Durchschnitt von (σ–) Algebren ist wieder eine (σ–)

Algebra; P(Ω) ist eine (σ–) Algebra mit P(Ω) 6= ∅.

Satz 6.8 ∅ 6= S ⊂ P(Ω). Dann: α(S) = Menge aller endlichen, disjunkten

Vereinigungen von endlichen Durchschnitten von Mengen aus S oder deren

Komplemente, d.h.

S1 := {S ⊂ Ω : S ∈ S oder S c ∈ S},

S2 := {S1 ∩ . . . ∩ Sn : n ∈ N, Si ∈ S1 , i = 1, . . . , n}

S3 := {T1 ∪ . . . ∪ Tn : Tj ∈ S2 , j = 1, . . . , n,

paarweise disjunkt, n ∈ N}

⇒ α(S) = S3 .

Beweis:

21

1. S3 ⊂ α(S) (trivial, da eine Algebra ∩–stabil, ∪–stabil und Komplement–

stabil ist).

2. S3 6= ∅, da S3 ⊃ S2 ⊃ S1 ⊃ S 6= ∅.

3. T ∈ S2 ⇒ T c ∈ S3 .

(Denn: T = S1 ∩ . . . ∩ Sn ∈ S2 mit Si ∈ S1 ⇒

T c = S1c ∪ . . . ∪ Snc

= S1c ∪ (S2c \S1c ) ∪ S3c \(S1c ∪ S2c ) ∪ . . .

c

∪Snc \(S1c ∪ . . . ∪ Sn−1

)

c

c

c

= S1 + (S2 ∩ S1 ) + (S3 ∩ S1 ∩ S2 ) + . . .

+(Snc ∩ S1 ∩ . . . ∩ Sn−1 ) ∈ S3 .

4. T1 , T2 ∈ S2 ⇒ T1 ∩ T2 ∈ S2 (trivial).

5. U1 , U2 ∈ S3 ⇒ U1 = T11 + . . . + T1n1 mit disjunkten T1j ∈ S2 , U2 =

T21 + . . . + T2n2 mit disjunkten T2j ∈ S2

[

⇒ U1 ∩ U2 =

( T1i ∩ T2j ) ∈ S3 .

| {z }

i,j

∈S2 wegen 4.

|

{z

}

disjunkte Vereinigung

6. U ∈ S3 ⇒ U = T1 + . . . + Tn , Ti ∈ S2 , i = 1, . . . , n, disjunkt ⇒ U c =

T1c ∩ . . . ∩ Tnc ∈ S3 wegen 3. und 5. (Tjc ∈ S3 wegen 3.).

Wegen 2., 5. und 6. ist S3 eine Algebra. Hieraus und aus 1. folgt, dass S3 =

α(S).

2

Definition 6.9 A1 , . . . , An seien beliebige Ereignisse, dann:

A1 , . . . , An (global) unabhängig

:⇔ Ai , B unabhängig für 1 ≤ i ≤ n

und B ∈ α({Aj : j 6= i}).

Satz 6.10 A1 , . . . , An sind unabhängig ⇔

P (Ai1 ∩ . . . ∩ Aik ) = P (Ai1 ) · · · P (Aik )

für 2 ≤ k ≤ n, 1 ≤ i1 < . . . < ik ≤ n.

Beweis:

22

(1)

⇒“

”

Ai2 ∩ . . . ∩ Aik ∈ α({Aj : j 6= i1 })

⇒ Ai1 , Ai2 ∩ . . . ∩ Aik unabhängig

⇒ P (Ai1 ∩ . . . ∩ Aik ) = P (Ai1 )P (Ai2 ∩ . . . ∩ Aik )

u.s.w. (Induktion)

⇐“ Es genügt zu zeigen: A1 ist unabhängig von jedem Ereignis aus α({A2 , . . . , An }).

”

In (1) beliebige der Aij durch Acij ersetzbar (z.B. P (Ai1 ∩ Aci2 ∩ . . . ∩

Aik ) = P (Ai1 )P (Aci2 ) · · · P (Aik ), siehe 6.4) ⇒

(c)

(c)

P (A1 ∩ Ai2 ∩ . . . ∩ Aik )

(c)

(c)

= P (A1 )P (Ai2 ) · · · P (Aik )

(c)

mit Aij = Aij oder Acij ,

d.h. A1 unabhängig von allen Ereignissen aus S2 (A2 , . . . , An )

⇒6.5 A1 unabhängig von allen Ereignissen aus S3 (A2 , . . . , An ) =6.8

α({A2 , . . . , An }).

2

Definition 6.11 Ai , i ∈ I, beliebige Ereignisse, dann:

Ai , i ∈ I, unabhängig

:⇔ Ai , G unabhängig für beliebiges

i ∈ I und G ∈ α({Aj : j ∈ I, j 6= i}).

Bemerkung 6.12

(i)

Ai , i ∈ I, unabhängig

⇔ Ai , i ∈ I0 unabhängig

für alle endlichen Teilmengen I0 von I.

(ii) A1 , A2 , . . . sei eine Folge von Ereignissen, dann:

A1 , A2 , . . . unabhängig

⇔ A1 , . . . , An unabhängig für alle n ∈ N.

Beweis:

(i)

⇒“ trivial.

”

23

⇐“ Nach Satz 6.8 existiert zu jedem G ∈ α({Aj : j 6= i}) ein I0 ⊂ I

”

mit |I0 | < ∞ und G ∈ α({Aj : j ∈ I0 }).

2

Definition 6.13

(i) Gi , i ∈ I, unabhängige Algebren von Ereignissen

:⇔ Gi ist Ereignis–Algebra, i∈ I, und für jedes i ∈ I ist jedes G ∈ Gi

S

unabhängig von allen H ∈ α

j6=i Gj .

(ii) Ai , i ∈ I, unabhängige σ–Algebren von Ereignissen

:⇔ Ai ist σ–Algebra von Ereignissen, i ∈ I, und für jedes i ∈ I ist

S

jedes A ∈ Ai unabhängig von allen B ∈ σ

j6=i Aj .

Satz 6.14 Ai , i ∈ I unabhängig ⇒ α({Ai }), i ∈ I, unabhängige Algebren.

Beweis:

α({Ai }) = {Ai , Aci , ∅, Ω},

d.h.

!

α({Aj : j ∈ I, j 6= i}) = α

[

α({Aj }) .

j6=i

∅ und Ω sind von allen Ereignissen unabhängig.

2

Satz 6.15 (Borel–Cantelli Lemma) A1 , A2 , . . . seien Ereignisse;

A := {ω ∈ Ω : ω ∈ An für unendlich viele n ∈ N}

\ [

=

Am .

n∈N m≥n

Dann gilt:

(i) P (A) = 0, falls

P

P (An ) < ∞.

(ii) P (A) = 1, falls

P

P (An ) = ∞ und A1 , A2 , . . . unabhängig.

n∈N

n∈N

Beweis: Es gilt (siehe Übungen):

(i)“

”

P (A) = P

\

[

Am

m≥n

n∈N

| {z }

absteigende Folge

!

[

= lim P

Am ,

n∈N

m≥n

24

wobei

!

P

[

Am

=

lim P

≤

s. Üb.

X

k

[

k∈N

m≥n

!

Am

m=n

P (Am ) →n∈N 0

m≥n

als Rest einer konvergenten Reihe.

(ii)“

”

P (Ac ) = P

[

\

Acm

m≥n

n∈N

| {z }

aufsteigende Folge

\

= lim P

Acm

n∈N

= lim P

n∈N

m≥n

\

\

N ≥n

Acm

n≤m≤N

| {z }

absteigende Folge

\

c

= lim lim P (

Am

|{z}

n∈N N ∈N

n≤m≤N

unabhängig

Y

= lim lim

( 1 − P (Am ) )

,

| {z }

n∈N N ∈N

n≤m≤N

|

≤exp

≤exp(−P (Am ))

{z

}

P

− N

m=n P (Am ) →N ∈N 0

denn 1 − x ≤ exp(−x) wegen Taylor–Entwicklung:

x2

exp(−x) = 1 − x + exp(−ϑx) ≥ 1 − x.

|

{z 2}

≥0

2

Satz 6.16 (Fortsetzungssatz) G sei Algebra über Ω, Q ein σ–additiver,

S

normierter

Inhalt

auf

G

(d.h.

Q

:

G

→

[0,

∞)

mit

Q(Ω)

=

1

und

Q(

n∈N Gn ) =

P

S

Q(G

)

für

disjunkte

G

∈

G,

n

∈

N

mit

G

∈

G).

n

n

n∈N

n∈N n

Dann gilt: Es existiert genau ein Wahrscheinlichkeitsmaß P auf A := σ(G)

mit P/G = Q/G.

Beweis: Siehe Maßtheorie. (Etwa Satz 4.9 im Maßtheorie-Skript (\ ∼falk\downloads\).

2

25

Satz 6.17 G1 , G2 seien unabhängige Ereignis–Algebren. Dann sind A1 :=

σ(G1 ), A2 := σ(G2 ) unabhängige σ–Algebren.

Beweis: Zu zeigen:

∀A1 ∈ A1 , ∀A2 ∈ A2 :

P (A1 ∩ A2 ) = P (A1 )P (A2 ).

Sei G1 ∈ G1 gegeben.

1. Fall: P (G1 ) = 0. Dann gilt:

0 = P (G1 ∩ A2 )

| {z }

⊂G1

= P (G1 )P (A2 ) = 0

für alle A ∈ A2 .

2. Fall: P (G1 ) > 0. Setze

Q(A2 ) :=

P (G1 ∩ A2 )

für A2 ∈ A2 .

P (G1 )

Dann gilt

1.

∀G2 ∈ G2 : Q(G2 ) = P (G2 )

wegen der Unabhängigkeit von G1 , G2 .

2. Q ist Wahrscheinlichkeitsmaß auf A2 ; denn:

(a) Q(Ω) = 1.

(b) A12 , A22 , . . . sei Folge disjunkter Mengen aus A2 , dann:

!

P

X

P G1 ∩ n∈N An2

n

Q

A2

=

P (G1 )

n∈N

P

n

(G

∩

A

)

P

1

2

n∈N

=

P (G1 )

P

n

n∈N P (G1 ∩ A2 )

=

P (G1 )

X

=

Q (An2 ) .

n∈N

Aus 1. und 2. folgt mittels des Fortsetzungssatzes 6.16, dass Q(A2 ) = P (A2 )

für alle A2 ∈ A2 , d.h.

P (G1 ∩ A2 ) = P (G1 )P (A2 ) für alle A2 ∈ A2 .

Analog schließt man: G1 ∈ G1 durch A1 ∈ A1 ersetzbar.

26

2

Satz 6.18 Gi , i ∈ I, seien beliebige Algebren von Ereignissen zum Wahrscheinlichkeitsraum (Ω, A, P ). Dann sind äquivalent:

(i) Gi , i ∈ I, sind unabhängig.

(ii) Ai := σ(Gi ), i ∈ I, sind unabhängig.

(iii) Für je endlich viele verschiedene i1 , . . . , ik ∈ I und Gi1 ∈ Gi1 , . . . , Gik ∈

Gik gilt:

P (Gi1 ∩ . . . ∩ Gik ) = P (Gi1 ) · · · P (Gik ) .

Beweis:

(ii)⇒(i)“ Trivial.

”

(i)⇒(iii)“ Gi1 ist unabhängig von allen Ereignissen aus α

”

ziell von Gi2 ∩ . . . ∩ Gik , d.h.

S

j6=i1

Gj , spe-

P (Gi1 ∩ (Gi2 ∩ . . . ∩ Gik ))

= . . . = P (Gi1 ) · · · P (Gik )

mittels Induktion.

(iii)⇒(ii)“ Zu zeigen ist: Ai0 ∈ Ai0 ist unabhängig von allen A ∈ σ

”

S

Sei Gi0 ∈ Gi0 und H ∈ α

G

j6=i0 j

⇒6.8

⇒6.10

S

H ∈ α({Gi1 , . . . , Gir }) für geeignete

Gi1 ∈ Gi1 , . . . , Gir ∈ Gir

Gi0 und H sind unabhängig, d.h.

!

[

Gi0 und α

Gj sind unabhängig

j6=i0

!!

⇒6.17 Ai0 = σ(Gi0 ), σ α

[

Gj

unabhängig .

j6=i0

Die Behauptung folgt nun aus den Gleichungen:

!!

!

[

[

σ α

Gj

= σ

Gj

j6=i0

j6=i0

[

= σ

σ(Gj ) .

| {z }

j6=i0

Zum zweiten =“:

”

⊂“: Trivial.

”

27

=Aj

A

j .

j6=i0

⊃“: Für i 6= i0 gilt:

”

[

Gj ⊃ Gi

j6=i0

!

⇒ σ

[

Gj

⊃ σ(Gi )

j6=i0

!

⇒ σ

[

Gj

⊃

j6=i0

⇒ σ

j6=i0

σ(Gi )

i6=i0

!

[

[

Gj

⊃ σ

[

σ(Gi )

| {z }

i6=i0 =A

i

2

Gegeben seien zwei Zufallsexperimente, die durchgeführt werden, ohne dass

sie sich gegenseitig beeinflussen. Gesucht ist ein Wahrscheinlichkeitsraum

(Ω, A, P ) zur mathematischen Beschreibung des Zufallsexperimentes, welches

darin besteht, dass die beiden Experimente ohne wechselseitige Beeinflussung

— also unabhängig — durchgeführt werden.

Die einzelnen Experimente werden durch (Ω1 , A1 , P1 ), (Ω2 , A2 , P2 ) beschrieben. Nahe liegend:

Ω := Ω1 × Ω2 := {(ω1 , ω2 ) : ω1 ∈ Ω1 , ω2 ∈ Ω2 }.

Jedes A1 ∈ A1 kann identifiziert werden mit A1 × Ω2 ,

jedes A2 ∈ A2 kann identifiziert werden mit Ω1 × A2 ,

d.h. Forderung:

A1 × Ω2 , Ω1 × A2 sind Ereignisse

⇒ (A1 × Ω2 ) ∩ (Ω1 × A2 ) = A1 × A2 Ereignis.

Daher:

A := σ ({A1 × A2 : A1 ∈ A1 , A2 ∈ A2 }) .

Ferner soll die Forderung

P1 (A1 ) = P (A1 × Ω2 ), P2 (A2 ) = P (Ω1 × A2 )

erfüllt sein.

Zur Unabhängigkeit: A1 × Ω2 und Ω1 × A2 sollen stets unabhängig sein für

A1 ∈ A1 , A2 ∈ A2 , d.h. es soll gelten

P (A1 × A2 ) = P ((A1 × Ω2 ) ∩ (Ω1 × A2 ))

= P (A1 × Ω2 )P (Ω1 × A2 )

= P1 (A1 )P2 (A2 ).

28

Satz 6.19 (Ω1 , A1 , P1 ), . . . , (Ωn , An , Pn ) seien Wahrscheinlichkeitsräume. Setze

Ω := Ω1 × . . . × Ωn

:= {(ω1 , . . . , ωn ) : ωi ∈ Ωi , 1 ≤ i ≤ n}

und

A := σ({A1 × . . . × An : Ai ∈ Ai , 1 ≤ i ≤ n}.

Dann gilt: Es existiert genau ein Wahrscheinlichkeitsmaß auf (Ω, A) mit

P (A1 × . . . × An ) = P1 (A1 ) · · · Pn (An ).

Beweisskizze: Definiere P auf Mengensystem Z := {A1 × . . . × An : Ai ∈

Ai , 1 ≤ i ≤ n} durch

P (A1 × . . . × An ) :=

n

Y

P (Ai ).

i=1

Dann Fortsetzung von P (zu einem (eindeutig bestimmten) σ–additiven Inhalt) auf α(Z). Die Behauptung folgt dann aus dem Fortsetzungssatz 6.16.

2

Definition 6.20 (Ω, A, P ) ist unabhängiges Produkt der Wahrscheinlichkeitsräume (Ω1 , A1 , P1 ), . . . , (Ωn , An , Pn ) :⇔ (Ω, A, P ) wird definiert gemäß

6.19.

Schreibweise: Ω = Ω1 × . . . × Ωn , A = A1 ⊗ . . . ⊗ An , P = P1 × . . . × Pn . Im

Fall

(Ω1 , A1 , P1 ) = . . . = (Ωn , An , Pn ) = (Ω, A, P ),

d.h. unabhängige n–fache Wiederholung von (Ω, A, P ), schreiben wir kurz

(Ωn , An , P n ).

7

Zufallsvariablen

(Ω, A, P ) zufälliges Experiment, f : Ω → Ω0 eine Abbildung. Es sei ω ein

Ergebnis; häufig interessiert weniger der exakte Ausgang ω sondern nur der

Wert f (ω). Beispielsweise interessiert beim Schuss auf eine Zielscheibe weniger die genaue Lage des Einschusses sondern der Abstand zum Mittelpunkt.

Daher wird man vor allem Ereignisse der Gestalt

f −1 (A0 ) := {ω ∈ Ω : f (ω) ∈ A0 }

betrachten, wobei A0 die im Bildraum von f interessierenden Ereignisse

durchläuft.

29

Satz 7.1 (Ω, A, P ) sei Wahrscheinlichkeitsraum und f : Ω → Ω0 eine Abbildung. Setze

A0 := {A0 ⊂ Ω0 : f −1 (A0 ) ∈ A}

und

P 0 (A0 ) := P (f −1 (A0 )) für alle A0 ∈ A0 .

Dann ist (Ω0 , A0 , P 0 ) ein Wahrscheinlichkeitsraum.

Beweis:

1. f −1 (Ω0 ) = Ω ∈ A, d.h. Ω0 ∈ A0 .

2. Sei A0 ∈ A0

⇒ f −1 (A0 ) =: A ∈ A

⇒ f −1 (Ω0 \A0 ) = Ac ∈ A

⇒ A0c = Ω0 \A0 ∈ A0 .

3. Sei A0n ∈ A0 , n ∈ N

⇒ f −1 (A0n ) ∈ A, n ∈ N

!

[

[

f −1 (A0n ) ∈ A

⇒ f −1

A0n =

n∈N

n∈N

⇒

[

A0n

0

∈A.

n∈N

Also ist A0 eine σ–Algebra. Ferner ist P 0 ein Wahrscheinlichkeitsmaß auf

(Ω0 , A0 ):

1. P 0 (Ω0 ) = P (f −1 (Ω0 )) = P (Ω) = 1.

2. Für paarweise disjunkte A0n , n ∈ N, gilt:

!

!!

X

X

P0

A0n

= P f −1

A0n

n∈N

n∈N

!

= P

X

f −1 (A0n )

n∈N

=

X

=

X

P f −1 (A0n )

n∈N

P 0 (A0n ) .

n∈N

2

Bemerkung 7.2 A0 heißt finale σ–Algebra bezüglich f ; P 0 heißt das durch

P und f auf A0 induzierte Wahrscheinlichkeitsmaß oder Bildmaß von P unter

f.

30

Definition 7.3 (Ω, A, P ) sei ein Wahrscheinlichkeitsraum, (Ω0 , A0 ) ein messbarer Raum, dann: f : Ω → Ω0 heißt A, A0 –messbar oder Zufallsgröße, falls

f −1 (A0 ) ⊂ A, d.h. falls für alle A0 ∈ A0 gilt:

f −1 (A0 ) ∈ A,

(d.h. A0 ist sub–σ–Algebra der finalen σ–Algebra.) Schreibweise:

f : (Ω, A) → (Ω0 , A0 ).

Satz 7.4 f : (Ω, A) → (Ω0 , A0 ). Dann:

f −1 (A0 ) := {f −1 (A0 ) : A0 ∈ A0 } ist sub–σ–Algebra von A.

(= zu f gehörende Vergröberung von A, durch f bestimmte Ereignisse von

A).

Beweis:

1. Ω = f −1 (Ω0 ).

2. A ∈ f −1 (A0 )

⇒ ∃A0 ∈ A0 : A = f −1 (A0 )

⇒ Ac = f −1 (A0c ) ∈ f −1 (A0 ).

3. An ∈ f −1 (A0 ), n ∈ N

⇒ ∃A0n ∈ A0 : An = f −1 (A0n ), n ∈ N

[

[

⇒

An =

f −1 (A0n )

n∈N

n∈N

!

= f −1

[

A0n

∈ f −1 (A0 ).

n∈N

2

Satz 7.5 (Ω, A), (Ω0 , A0 ) messbare Räume, S ⊂ P(Ω0 ) mit σ(S) = A0 . Dann

gilt:

f : Ω → Ω0 ist A, A0 –messbar

⇔ f −1 (S) ∈ A für alle S ∈ S.

Beweis:

⇒“ Trivial.

”

31

⇐“ Setze

”

F := {F ∈ P(Ω0 ) : f −1 (F ) ∈ A}.

F ist (die finale) σ–Algebra mit F ⊃ S ⇒

F ⊃ σ(S) = A0 .

2

Satz 7.6 (Ω, A), (Ω0 , A0 ), (Ω00 , A00 ) messbare Räume, f : (Ω, A) → (Ω0 , A0 ),g :

(Ω0 , A0 ) → (Ω00 , A00 ). Dann gilt:

g ◦ f : Ω → Ω00 ist A, A00 –messbar.

Beweis: Sei A00 ∈ A00 , dann:

(g ◦ f )−1 (A00 ) = f −1 (g −1 (A00 )) ∈ A.

| {z }

∈A0

2

Definition 7.7 In sei die Menge aller n–dimensionalen Intervalle im Rn .

Bn := σ(In ) ⊂ P(Rn )

ist das System der n–dimensionalen Borelmengen bzw. die Borel–σ–Algebra

des Rn .

Bemerkung 7.8 Setze

In0 := {(a, b] : {x = (x1 , . . . , xn ) ∈ Rn :

ai < xi ≤ bi , i = 1 . . . , n} für

a = (a1 , . . . , an ), b = (b1 , . . . , bn ) ∈ Rn }.

dann gilt:

Bn = σ(In0 ).

Denn z.B.:

\ 1

[a, b] =

a − ,b

m

m∈N

mit a − 1/m = (a1 − 1/m, . . . , an − 1/m);

[ 1

(a, b) =

a, b −

m

m∈N

u.s.w.

⇒ Bn ⊃ σ(In0 ) ⊃ In

⇒ Bn ⊃ σ(In0 ) ⊃ σ(In ) = Bn

⇒ σ(In0 ) = Bn .

32

Satz 7.9 Bn enthält alle (bezüglich der euklidischen Topologie des Rn ) offenen und abgeschlossenen Mengen des Rn .

Beweis: InQ := Menge aller n–dimensionalen Intervalle in In mit rationalen

Endpunkten. InQ ist abzählbar (denn Q2n ist abzählbar).

G ⊂ Rn sei offen

[

⇒ G=

I ∈ Bn (als abzählb. Vereinigung);

Q

I⊂G, I∈In

n

F ⊂ R abgeschlossen

⇒ F c offen und damit in Bn

⇒ F ∈ Bn .

2

Satz 7.10 Bn = B

· · ⊗ B} = Bn .

| ⊗ ·{z

n–mal

Beweis: n = 2; B ⊗ B = σ({B1 × B2 : B1 , B2 ∈ B}.

1. B2 ⊂ B ⊗ B, da I2 ⊂ B ⊗ B.

2. Zu zeigen: B ⊗ B ⊂ B2 .

Es genügt zu zeigen, dass B1 × B2 ∈ B2 , falls B1 , B2 ∈ B.

(a) Setze für I ∈ I

BI := {B ⊂ R : B × I ∈ B2 };

BI ist eine σ–Algebra(!) mit I ⊂ BI , d.h. B ⊂ BI .

Also gilt B1 × I ∈ B2 , falls B1 ∈ B, I ∈ I.

(b) Setze für B ∈ B

BB := {A ⊂ R : B × A ∈ B2 };

BB ist eine σ–Algebra(!) mit I ⊂ BB nach (a), d.h. B ⊂ BB .

Also gilt B1 × B2 ∈ B2 , falls B1 , B2 ∈ B.

Analog schließt man damit von n auf n + 1.

2

Definition 7.11 (Ω, A, P ) Wahrscheinlichkeitsraum;

f : Ω → R ist Zufallsvariable

:⇔ f ist A, B–messbar.

33

Satz 7.12 (Ω, A, P ) Wahrscheinlichkeitsraum, f : Ω → R beliebig. Dann

sind äquivalent:

1. f ist Zufallsvariable, d.h. f −1 (B) ∈ A für alle B ∈ B.

2. {f ≤ y} := {ω ∈ Ω : f (ω) ≤ y} ∈ A für alle y ∈ R.

3. {f < y} := {ω ∈ Ω : f (ω) < y} ∈ A für alle y ∈ R.

4. {f ∈ I} := {ω ∈ Ω : f (ω) ∈ I} ∈ A für alle Intervalle I in R.

5. {f ∈ G} := {ω ∈ Ω : f (ω) ∈ G} ∈ A für alle G ∈ G := Menge der

offenen Teilmengen von R.

6. {f ∈ F } := {ω ∈ Ω : f (ω) ∈ F } ∈ A für alle F ∈ F := Menge der

abgeschlossenen Teilmengen von R.

Beweis: Folgt aus 7.5 (s. 7.8 und 7.9), da

{(−∞, y] : y ∈ R}, {(−∞, y) : y ∈ R}, I1 , G, F

Erzeuger der σ–Algebra B sind.

2

Beispiel 7.13 Beispiele für Zufallsvariablen:

1.

f ∈ {0, 1}Ω ist Zufallsvariable

⇔ ∀y ∈ R : {ω ∈ Ω : f (ω) ≤ y} ∈ A

wobei

{ω ∈ Ω : f (ω) ≤ y}

Ω,

falls y ≥ 1,

∅,

falls y < 0,

=

∈A

{ω ∈ Ω : f (ω) = 0}, falls 0 ≤ y < 1.

⇔ f = 1A für ein geeignetes A ∈ A.

Dabei ist

1A (ω) =

1, falls ω ∈ A,

0 sonst,

die Indikatorfunktion der Menge A.

2. Falls A = {∅, Ω}, so sind nur konstante Funktionen Zufallsvariablen.

3. Falls A = P(Ω), so sind alle f : Ω → R Zufallsvariablen.

Definition 7.14 (Ω, A, P ) Wahrscheinlichkeitsraum; dann:

f : Ω → Rn ist n–dimensionaler Zufallsvektor

:⇔ f ist A, Bn –messbar.

34

Satz 7.15

f = (f1 , . . . , fn ) : Ω → Rn ist n–dim. Zufallsvektor

⇔ fi : Ω → R ist Zufallsvariable, i = 1, . . . , n.

Beweis:

⇒“ Sei B ∈ B, dann:

”

i−te

fi−1 (B)

⇐“

”

=f

−1

(R

| × ··· ×

Stelle

z}|{

B

{z

∈Bn

× · · · × R}) ∈ A.

1.

f −1 (B1 × · · · × Bn ) =

\

1≤i≤n

fi−1 (Bi ) ∈ A,

| {z }

∈A

falls Bi ∈ B, i = 1, . . . , n.

2. {B ⊂ Rn : f −1 (B) ∈ A} ist (finale) σ–Algebra (7.1).

Aus 1. und 2. folgt, dass

{B ⊂ Rn : f −1 (B) ∈ A} ⊃ B ⊗ · · · ⊗ B =7.10 Bn ,

d.h. f ist Zufallsvektor.

2

Definition 7.16

g : Rn → R ist Bairesche Funktion

:⇔ g ist Bn , B–messbar.

Satz 7.17 fi : Ω → R sei Zufallsvariable, i = 1, . . . , n, g : Rn → R Bairesche Funktion. Dann ist g ◦ (f1 , . . . , fn ) Zufallsvariable.

Beweis: Folgt aus 7.15 und 7.6.

2

Satz 7.18 g : Rn → R stetig ⇒ g ist Bairesche Funktion.

Beweis: g stetig ⇒ ∀ offenen Teilmengen O von R: g −1 (O) ist offen im Rn ,

d.h. g −1 (O) ∈ Bn . Nach Satz 7.5 gilt damit g −1 (B) ∈ Bn für alle B ∈ B, da

die offenen Mengen B erzeugen (7.9).

2

35

Satz 7.19 f1 , f2 seien Zufallsvariablen, a ∈ R. Dann gilt:

af1 ,

f1 + f2 ,

f1 f2 ,

f1 /f2 (falls f2 (ω) 6= 0 für alle ω ∈ Ω),

f1 ∨ f2 := max(f1 , f2 ),

f1 ∧ f2 := min(f1 , f2 )

sind wieder Zufallsvariablen.

Beweis: R 3 x 7→ ax, R2 3 (x1 , x2 ) 7→ x1 + x2 ∈ R u.s.w. sind stetige

Abbildungen von R → R bzw. R → R2 , d.h. Satz 7.17 und 7.18 anwendbar.

2

Bemerkung Der Raum der Zufallsvariablen über (Ω, A, P ) ist ein linearer

Raum.

Satz 7.20 f1 , f2 , . . . seien Zufallsvariablen.

1. fn (ω), n ∈ N, sei für jedes ω ∈ Ω nach oben beschränkt

⇒ sup fn ist Zufallsvariable.

n∈N

((supn∈N fn )(ω) = supn∈N (fn (ω))).

2. fn (ω), n ∈ N, sei für jedes ω ∈ Ω nach unten beschränkt

⇒ inf fn ist Zufallsvariable.

n∈N

3. fn (ω), n ∈ N, sei für jedes ω ∈ Ω beschränkt

⇒ lim inf fn , lim sup fn sind Zufallsvariablen.

n∈N

n∈N

4. fn (ω), n ∈ N, sei für jedes ω ∈ Ω konvergent

⇒ lim fn ist Zufallsvariable.

n∈N

Beweis:

T

1. ∀y ∈ R : {ω ∈ Ω : supn∈N fn (ω) ≤ y} = n∈N {ω ∈ Ω : fn (ω) ≤ y} ∈ A.

S

2. {ω ∈ Ω : inf n∈N fn (ω) < y} = n∈N {ω ∈ Ω : fn (ω) < y} ∈ A.

3. lim supn∈N fn (ω) = inf m∈N supn≥m fn (ω) , lim inf n∈N fn (ω) = supm∈N (inf n≥m fn (ω)),

d.h. die Behauptung folgt aus 1. und 2.

36

4. limn∈N fn = lim supn∈N fn = lim inf n∈N fn , d.h. 3. anwendbar.

2

Definition 7.21 fi , i ∈ I, sei eine Familie zufälliger Größen auf einem Wahrscheinlichkeitsraum (Ω, A, P ), wobei fi : (Ω, A) → (Ωi , Ai ), i ∈ I.

Die Familie fi , i ∈ I, heißt unabhängig :⇔ die Familie A(fi ) = fi−1 (Ai ),

i ∈ I, der zugehörigen Vergröberungen ist unabhängig.

Bemerkung 7.22 fi , i ∈ I, unabhängig ⇔ fi , i ∈ I0 , unabhängig für alle

endlichen Teilmengen I0 von I (s. 6.18).

Satz 7.23

fi : (Ω, A) → (Ω0i , A0i ), i = 1, . . . , n unabhängig

⇔ P ({f1 ∈ A01 , . . . , fn ∈ A0n }

= P ({f1 ∈ A01 }) · · · P ({fn ∈ A0n })

für beliebige A0i ∈ A0i , i = 1, . . . , n.

Beweis:

f1 , . . . , fn unabhängig

⇔ A(f1 ), . . . , A(fn ) unabhängig

⇔6.18 für beliebige A0i ∈ A0i , i = 1, . . . , n, sind die

Ereignisse {f1 ∈ A01 }, . . . , {fn ∈ A0n }

unabhängig.

2

Satz 7.24 fi : (Ω, A) → (Ω0i , A0i ), i ∈ I, unabhängig, gi : (Ω0i , A0i ) →

(Ω00i , A00i ), i ∈ I.

Dann sind gi ◦ fi : (Ω, A) → (Ω00i , A00i ), i ∈ I, unabhängig.

Beweis:

1. Nach Satz 7.6 ist gi ◦ fi A, Ai –messbar, i ∈ I.

2. Für endliches I0 ⊂ I und A00i ∈ A00i , i ∈ I0 , gilt:

P {gi ◦ fi ∈ A00i , i ∈ I0 }

= P {fi ∈ gi−1 (A00i ), i ∈ I0 }

| {z }

∈A0i

=

Y

P {fi ∈ gi−1 (A00i )} (da fi unabhängig)

i∈I0

=

Y

P {gi ◦ fi ∈ A00i }.

i∈I0

37

2

Definition 7.25 f1 , f2 , . . . seien Zufallsgrößen auf (Ω, A, P ). C ∈ A heißt

terminales Ereignis bzgl. f1 , f2 , . . . :⇔

!

[

C∈σ

A(fm ) für alle n ∈ N.

m≥n

T

n∈N

σ

S

m≥n

A(fm ) heißt die zu f1 , f2 , . . . gehörende terminale σ–Algebra.

Beispiel 7.26

1. {ω ∈ Ω : fn (ω) > 0 unendlich oft},

2. {ω ∈ Ω : fn (ω), n ∈ N, ist konvergent},

P

3. ω ∈ Ω : n1 ni=1 fn (ω), n ∈ N, ist konvergent

sind terminale Ereignisse.

Satz 7.27 (Kolmogoroffsches 0–1–Gesetz) C sei terminales Ereignis zur

Folge unabhängiger Zufallsvariablen f1 , f2 , . . . ⇒ P (C) = 0 oder 1;

Bemerkung 7.28 Vergleiche Borel–Cantelli Lemma: A1 , A2 , . . . unabhängige Ereignisse ⇒ 1A1 , 1A2 , . . . unabhängige Zufallsvariablen;

(

)

X

lim sup An = ω ∈ Ω :

1An (ω) = ∞

n∈N

n∈N

ist terminales Ereignis zu 1A1 , 1A2 , . . . mit

P

0, falls Pn∈N P (An ) < ∞,

P lim sup An =

1, falls

n∈N

n∈N P (An ) = ∞.

Beweis: Annahme: P (C) >S

0. Wir zeigen:

P (C) = 1.

Für A ∈ A(fn , n ∈ N) := σ n∈N A(fn ) definieren wir

P ∗ (A) := P (A|C) =

P (A ∩ C)

P (C)

⇒ P ∗ ist Wahrscheinlichkeitsmaß mit

P ∗ (A) = P (A) für alle A ∈ A0 :=

[

n∈N

38

A(fm : m ≤ n),

mit

!

A(fm : m ≤ n) := σ

[

A(fm ) ,

m≤n

denn für A ∈ A0 gilt: A, C sind unabhängig.

A0 ist eine Algebra(!) mit A(fn , n ∈ N) = σ(A0 ).

Fortsetzungssatz 6.16 ⇒ P ∗ = P auf A(fn , n ∈ N), d.h.

P (A ∩ C)

= P (A)

P (C)

für alle A ∈ A(fn , n ∈ N)

⇒ P (A ∩ C) = P (A)P (C)

insbesondere für A = C (C ∈ A(fn , n ∈ N))

⇒ P (C) = P (C)2

⇒ P (C) = 1.

P ∗ (A) =

2

8

Integrationstheorie

Es sei f eine Zufallsvariable, die nur die Werte a1 , . . . , am annimmt, pi :=

P {f = ai }, i = 1, . . . , m.

Bei N –facher unabhängiger Wiederholung des Experimentes seien α1 , . . . , αN

(∈ {a1 , . . . , am }) die beobachteten Werte von f . Die Erfahrung zeigt, dass

sich das arithmetische Mittel

N

1 X

αi

N i=1

offenbar gegen einen gewissen Wert stabilisiert. Was ist das für eine Zahl?

Dazu anschaulich: Hi (Häufigkeit) bezeichne die Anzahl des Eintretens von

ai unter den N Durchführungen des Experimentes, i = 1, . . . , m. Nach der

Erfahrung wird gelten:

Hi

≈ pi , d.h. Hi ≈ pi N.

N

Damit:

α1 + · · · + αN

N

H1 a1 + · · · + Hm am

N

m

X

Hi

=

ai

N

i=1

=

≈

m

X

ai p i .

i=1

Dies wird der zu erwartende, d.h. der Erwartungswert des arithmetischen

Mittels sein. Den Begriff des Erwartungswertes werden wir in diesem Kapitel

untersuchen.

Definition 8.1

1. e einfache Funktion :⇔

e=

m

X

αi 1Ai

i=1

mit geeignetem m ∈ N, αi ≥ 0, Ai ∈ A, i = 1, . . . , m.

2. E := Menge der einfachen Funktionen.

Bemerkung 8.2

1. E = Menge aller nicht–negativen Zufallsvariablen über (Ω, A, P ), die

nur endlich viele Werte annehmen.

2. e1 , e2 ∈ E, α ∈ R+

⇒ αe1 , e1 + e2 , e1 e2 , e1 ∨ e2 , e1 ∧ e2 ∈ E.

P

3. e ∈ E ⇒ e = 1≤i≤m αi 1Ai

S

mit disjunkten Ai ∈ A und 1≤i≤m Ai = Ω.

Satz 8.3 Es gelte

e=

X

αi 1Ai =

1≤i≤m

X

βj 1Bj ∈ E

1≤j≤n

mit disjunkten Ai ∈ A, i = 1, . . . , m, und disjunkten Bj ∈ A, j = 1, . . . , n.

Dann folgt:

X

X

αi P (Ai ) =

βj P (Bj ).

1≤i≤m

1≤j≤n

S

S

Beweis: O.B.d.A. annehmbar, dass 1≤i≤m Ai = 1≤j≤m Bj = Ω.

X

X

1Ai =

1Ai ∩Bj ; 1Bj =

1Ai ∩Bj

1≤j≤n

⇒e =

X

1≤i≤n

αi 1Ai

1≤i≤m

=

X

αi 1Ai ∩Bj ;

1≤i≤m;1≤j≤n

e =

X

βj 1Bj ∩Ai

1≤j≤n;1≤i≤m

⇒ ∀i, j mit Ai ∩ Bj 6= ∅ : αi = βj

X

⇒

αi P (Ai )

1≤i≤m

=

X

αi P (Ai ∩ Bj )

1≤i≤m;1≤j≤n

=

X

βj P (Bj ∩ Ai )

1≤i≤m;1≤j≤n

=

X

βj P (Bj ).

1≤j≤n

40

2

P

Definition 8.4 Für e = 1≤i≤m αi 1Ai ∈ E mit disjunkten Ai und αi ≥ 0

definieren wir

Z

Z

X

e dP :=

αi P (Ai ),

e dP :=

Ω

1≤i≤m

das Integral von e über Ω.

Satz 8.5 Für e, e1 , e2 ∈ E gilt:

1.

Z

Z

αe dP = α

2.

α ≥ 0,

e dP,

Z

Z

e1 + e2 dP =

Z

e1 dP +

e2 dP,

P

3. e = 1≤i≤m αi 1Ai mit αi ≥ 0 und beliebigen Ai , d.h. nicht notwendig

disjunkten Ai ⇒

Z

X

e dP =

αi P (Ai ),

1≤i≤m

4.

Z

e1 ≤ e2 ⇒

Z

e1 dP ≤

e2 dP.

Beweis:

P

P

αi 1Ai mit disjunkten Ai ⇒ αe =

1.“ e =

1≤i≤m (ααi )1Ai ⇒

1≤i≤m

”

Behauptung.

P

P

mit disjunkten

A

,

e

=

2.“ e1 = i αi 1Ai S

i

2

j βj 1Bj mit disjunkten Bj .

S

”

O.b.d.A. gelte i Ai = j Bj = Ω;

X

e1 =

αi 1Ai ∩Bj ,

i,j

e2 =

X

βj 1Ai ∩Bj

i,j

⇒ e1 + e2

X

=

(αi + βj )1Ai ∩Bj

i,j

mit Ai ∩ Bj , (i, j), disjunkt

Z

⇒

e1 + e2 dP

X

=Def.

(αi + βj )P (Ai ∩ Bj )

i,j

X

X

=

αi P (Ai ∩ Bj ) +

βj P (Ai ∩ Bj )

i,j

i,j

Z

=

Z

e1 dP +

41

e2 dP.

3.“ Folgt aus 1. und 2.:

”

Z X

αi 1Ai dP =

i

X

Z

αi

1Ai dP.

i

4.“ Nach Beweisteil 2. besitzen e1 und e2 die Darstellungen

”

X

X

e1 =

αi 1Ai , e2 =

βi 1Ai

1≤i≤m

1≤i≤m

mit disjunkten Ai 6= ∅

⇒ α i ≤ βi ,

1 ≤ i ≤ m,

Z

X

⇒ e1 dP =

αi P (Ai )

i

≤

X

βi P (Ai )

Zi

=

e2 dP.

2

Satz 8.6 Zu jeder Zufallsvariablen f ≥ 0 existieren en ∈ E, n ∈ N, mit

e1 ≤ e2 ≤ . . . und f = lim en .

n∈N

Beweis: Setze

en :=

X

0≤i<n2n

i

1A ,

2n n,i

mit An,i := {i/2n ≤ f < (i + 1)/2n }.

2

Satz 8.7 e, en ∈ E, n ∈ N, mit e ≤ limn∈N en , e1 ≤ e2 ≤ . . . Dann folgt:

Z

Z

e dP ≤ lim en dP.

n∈N

P

Beweis: Sei e = 1≤i≤m αi 1Ai .

Wähle a ∈ [0, 1) und setze Kn := {ae ≤ en }, n ∈ N.

Kn ∈ A,Pda ae − en A, B–messbar,

e1Kn = 1≤i≤m αi 1Ai ∩Kn ∈ E,

Kn ↑ Ω, also Ai ∩ Kn ↑ Ai und damit

42

limn∈N P (Ai ∩ Kn ) = P (Ai ), i = 1, . . . , m, ⇒

Z

X

a e dP = a

αi P (Ai )

1≤i≤m

X

= a lim

n∈N

αi P (Ai ∩ Kn )

1≤i≤m

Z

ae1Kn dP

| {z }

= lim

n∈N

≤en

Z

≤ lim

en dP.

n∈N

Für a ↑ 1 folgt nun die Behauptung.

2

Korollar 8.8 e1 ≤ e2 ≤ . . . , e01 ≤ e02 ≤ . . . ∈ E mit limn∈N en = limn∈N e0n

(≤ ∞). Dann gilt:

Z

Z

lim en dP = lim e0n dP.

n∈N

n∈N

Definition 8.9 Für eine Zufallsvariable f ≥ 0 setzen wir

Z

Z

f dP := lim en dP

n∈N

(Integral von f über (Ω, A, P )), falls

f = lim en ,

n∈N

e1 ≤ e2 ≤ . . . ∈ E.

Satz 8.10 Für nicht negative Zufallsvariablen f, f1 , f2 gilt:

1.

Z

Z

αf dP = α

2.

α ≥ 0,

f dP,

Z

Z

f1 + f2 dP =

3.

Z

f1 dP +

Z

f1 ≤ f2 ⇒

f2 dP,

Z

f1 dP ≤

f2 dP.

Beweis: Nach Satz 8.6 existieren Folgen einfacher Funktionen e1 ≤ e2 ≤ . . . ,

e01 ≤ e02 ≤ . . ., ẽ1 ≤ ẽ2 . . . mit limn∈N en = f , limn∈N e0n = f1 , limn∈N ẽn = f2 .

43

1.“ αen ∈ E, n ∈ N, αe1 ≤ αe2 ≤ . . . , limn∈N αen = αf . Damit:

”

Z

Z

αf dP =Def. lim αen dP

n∈N

Z

=8.5 lim α en dP

n∈N

Z

=

α lim en dP

n∈N

Z

=Def. α f dP.

2.“ e0n + ẽn ∈ E, n ∈ N, e01 + ẽ1 ≤ e02 + ẽ2 ≤ · · · , limn∈N (e0n + ẽn ) = f1 + f2 .

”

Damit:

Z

Z

f1 + f2 dP =Def. lim e0n + ẽn dP

n∈N

Z

Z

0

en dP + ẽn dP

=8.5 lim

n∈N

Z

Z

=

f1 dP + f2 dP.

3.“

”

e0n

≤

lim ẽn (= f2 )

Z

0

⇒8.7 en dP

≤

lim ẽn dP

n∈N

Z

=Def.

f2 dP

Z

Z

⇒Def. f1 dP

=

lim e0n dP

n∈N

Z

≤

f2 dP.

n∈N

Z

2

Satz 8.11 f, f1 , f2 , . . . seien nicht negative Zufallsvariablen mit f1 ≤ f2 ≤

· · · und limn∈N fn = f . Dann gilt:

Z

Z

f dP = lim fn dP.

n∈N

Beweis: Zu fn existiert eine monoton wachsende Folge en,m , m ∈ N, in E

mit

lim en,m = fn ,

m∈N

44

also:

e1,1 ≤ e1,2 ≤ · · · ↑ f1

e2,1 ≤ e2,2 ≤ · · · ↑ f2

..

..

..

.

.

.

en,1 ≤ en,2 ≤ · · · ↑ fn

..

..

..

.

.

.

↑ f.

Setze en := max(e1,n , . . . , en,n ). Dann gilt:

1.

en ∈ E

(8.2,3.), e1 ≤ e2 ≤ · · ·

2.

en ≤ max(f1 , . . . , fn ) = fn ≤ f.

3.

∀m ≤ n : en

⇒ lim en

≥

≥

em,n

lim em,n = fm

⇒ lim en

≥

f

n∈N

n∈N

n∈N

⇒2. lim en

=

f

Z n∈N

Z

⇒ f dP =Def. lim en dP

n∈N

Z

≤2. lim fn dP ;

n∈N

Z

Z

f dP ≥8.10

fn dP

Z

Z

⇒ f dP

=

lim fn dP.

n∈N

2

Definition 8.12 f sei beliebige Zufallsvariable.

1. f + := max(f, 0) ist der Positivteil von f ,

f − := max(−f, 0) ist der Negativteil von f ; f = f + − f − .

R

R

2. f ist integrierbar :⇔ f + dP < ∞ und f − dP < ∞.

3. L := Menge aller integrierbaren Funktionen (auf (Ω, A, P )).

R

R

4. f ist quasiintegrierbar :⇔ f + dP < ∞ oder f − dP < ∞.

R

R

R

5. f dP := f + dP − f − dP , falls f quasiintegrierbar ist.

Satz 8.13 f, f1 , f2 beliebige Zufallsvariablen. Dann:

45

1. f ∈ L, α ∈ R ⇒ αf ∈ L und

R

αf dP = α

R

f dP .

R

R

2. f1 , f2 ∈ L ⇒ f1 + f2 ∈ L und f1 + f2 dP = f1 dP + f2 dP.

R

R

3. f1 ≤ f2 , f1 , f2 ∈ L ⇒ f1 dP ≤ f2 dP.

R

R

4. f ∈ L ⇔ |f | ∈ L und es gilt in diesem Fall | f dP | ≤ |f | dP.

R

5. g A, B–messbar mit f1 ≤ g ≤ f2 , f1 , f2 ∈ L ⇒ g ∈ L.

Beweis: Mittels 8.10.

2

Satz 8.14 (v. d. monotonen Konvergenz)

1. fRn ∈ L, n ∈ N, fn ↑ f < ∞ ⇒ f ist quasiintegrierbar und

f dP .

R

fn dP ↑

2. fRn ∈ L, n ∈ N, fn ↓ f > −∞ ⇒ f ist quasiintegrierbar und

f dP .

R

fn dP ↓

Beweis: Genügt 1. zu beweisen (Übergang zu −fn , −f ). O.E. sei fn ≥ 0

(sonst Übergang zu fn0 := fn − f1 ). Dann folgt die Behauptung aber aus 8.11.

2

Satz 8.15 (Lemma von Fatou)

1. fn ∈ L, n ∈ N, fn ≤ h, h ∈ L, lim supn∈N fn > −∞ ⇒ lim supn∈N fn

ist quasiintegrierbar und

Z

Z

lim sup fn dP ≥ lim sup fn dP.

n∈N

n∈N

2. fn ∈ L, n ∈ N, fn ≥ g, g ∈ L, lim inf n∈N fn < ∞ ⇒ lim inf n∈N fn ist

quasiintegrierbar und

Z

Z

lim inf fn dP ≤ lim inf fn dP.

n∈N

n∈N

Beweis: Genügt 1. zu beweisen (Übergang zu −fn ). Es gilt:

lim sup fn = lim sup fm .

n∈N

n∈N

m≥n

supm≥n fm ∈ L, da fn ≤ supm≥n fm ≤ h (8.13);

46

supm≥n fm ↓ lim supn∈N fn ⇒8.14 lim supn∈N fn ist quasiintegrierbar und

Z

Z

sup fm dP ↓

lim sup fn dP

m≥n

n∈N

Z

Z

⇒ lim sup fn dP = lim sup fm dP

n∈N m≥n

n∈N

Z

≤ lim

sup fm dP

n∈N

m≥n

Z

=

lim sup fn dP.

n∈N

2

Satz 8.16 (v. d. dominierten Konvergenz) fn , n ∈ N, Zufallsvariablen

mit limn∈N fn = f , |fn | ≤ g, g ∈ L. Dann gilt:

Z

Z

fn , f ∈ L und lim fn dP = f dP.

n∈N

Beweis: 8.13⇒ fn , f ∈ L. Das Lemma von Fatou liefert:

Z

Z

lim sup fn dP ≤

lim sup fn dP

n∈N

Z n∈N

=

f dP

Z

=

lim inf fn dP

n∈N

Z

≤ lim inf fn dP.

n∈N

2

Satz 8.17 (Transformationssatz für Integrale) (Ω, A, P ) Wahrscheinlichkeitsraum, (Ω0 , A0 ) messbarer Raum, T : (Ω, A) → (Ω0 , A0 ).

P 0 := P ∗T sei das durch P und T auf A0 induzierte Wahrscheinlichkeitsmaß

(Bildmaß), d.h.

P 0 (A0 ) = P (T −1 (A0 )), A0 ∈ A0 ,

s. Satz 7.1.

f 0 : Ω0 → R sei Zufallsvariable. Dann:

f 0 ∈ L(Ω0 , A0 , P 0 ) ⇔ f 0 ◦ T ∈ L(Ω, A, P )

und in diesem Fall gilt:

Z

0

0

Z

f dP =

Ω0

Ω

47

f 0 ◦ T dP.

Beweis:

1. Sei e0 ∈ E(Ω0 , A0 ), d.h. e0 =

P

1≤i≤m

αi 1A0i mit αi ≥ 0, A0i ∈ A0 ,

X

⇒ e := e0 ◦ T =

αi 1A0i ◦ T

1≤i≤m

X

=

αi 1Ai ∈ E(Ω, A)

1≤i≤m

mit Ai := T −1 (A0i ) und

Z

e0 dP 0 =

Ω0

X

αi P 0 (A0i )

1≤i≤m

X

=

αi P (T −1 (A0i ))

1≤i≤m

X

=

αi P (Ai )

1≤i≤m

Z

e dP.

=

Ω

2. Sei f 0 : Ω0 → R+ Zufallsvariable. Dann existieren e0n ∈ E(Ω0 , A0 ) mit

e0n ↑ f 0 ⇒ en := e0n ◦ T ↑ f 0 ◦ T , en ∈ E(Ω, A).

Somit gilt nach 1.:

Z

0

f dP

0

Ω0

Z

=Def. lim

n∈N

Ω0

e0n dP 0

Z

lim en dP

Ω

Z

=Def.

f 0 ◦ T dP.

=1.

n∈N

Ω

3. Für beliebiges f mittels Zerlegung f = f + − f − .

2

Definition 8.18

1. Es sei A ∈ A, f Zufallsvariable und f 1A quasiintegrierbar. Dann:

Z

Z

Z

f dP :=

f (ω) P (dω) := f 1A dP.

A

A

2. f sei quasiintegrierbar. Die Abbildung

Z

A 3 A 7→

f dP

A

heißt unbestimmtes Integral von f .

48

Bemerkung

Es Rseien A, BR∈ A, A ∩ B = ∅ und f quasiintegrierbar. Dann

R

gilt A∪B f dP = A f dP = B f dP .

Satz 8.19 f ≥ 0 sei Zufallsvariable mit

R

f dP = 1. Dann:

Z

Q : A → R mit Q(A) :=

f dP

A

ist ein Wahrscheinlichkeitsmaß auf A.

Beweis:

1. Q(A) ≥ 0 offensichtlich,

2. Q(Ω) = 1 trivial.

3. An ∈ A, n ∈ N, seien paarweise disjunkt. Dann:

!

[

Q

An

n∈N

Z

=

f dP

S

n∈N

An

Z

=Def.

=

f 1Sn∈N An dP

ZΩ X

f 1An dP

Ω n∈N

Z

=

lim

Ω n∈N

=mon. Konv. lim

n∈N

=

=Def.

=

=

lim

n∈N

lim

n∈N

lim

n∈N

X

n

X

Ω i=1

n

XZ

dP

f 1Ai dP

f 1Ai dP

i=1 Ω

n Z

X

i=1

f 1Ai

i=1

Z X

n

n

X

!

f dP

Ai

Q(Ai )

i=1

Q(An ).

n∈N

2

R

Definition 8.20 f ≥ 0 sei Zufallsvariable mit f dP = 1. Q sei definiert

wie in 8.19. Dann heißt f Dichte (genauer: eine Dichte) von Q bezüglich P .

Symbolisch:

dQ

Q = f P, f =

, dQ = f dP.

dP

49

Satz 8.21 f1 sei P –Dichte von Q, f2 ≥ 0 sei Zufallsvariable. Dann:

f2 ist P –Dichte von Q ⇔ P ({f1 6= f2 }) = 0.

Lemma 8.22 f sei Zufallsvariable, A ∈ A mit P (A) = 0 ⇒

R

A

|f | dP = 0.

Beweis: Es gilt |f 1A | = |f |1A . Es existieren en ∈ E, n ∈ N, mit en ↑ |f |

⇒ en 1A ∈ E mit en 1A ↑ |f |1A ;

Z

Z

|f |1A dP =Def. lim

n∈N

en 1A dP

X

αi P (Ai ∩ A) = 0,

lim

| {z }

n∈N

=

1≤i≤m

wobei en =

P

1≤i≤m

=0

αi 1Ai , 1Ai 1A = 1Ai ∩A ,

Z

Z

⇒8.13 | f dP | ≤

|f | dP = 0.

A

A

2

Beweis:[von 8.21]

⇐“ Sei A ∈ A;

”

Z

Q(A)

=

f1 1A dP

Z

=

Z

f1 1A∩{f1 =f2 } dP +

f1 1A∩{f1 6=f2 } dP

Z

=8.22

f1 1A∩{f1 =f2 } dP

Z

=

f2 1A∩{f1 =f2 } dP

Z

=

Z

f2 1A∩{f1 =f2 } dP +

f2 1A∩{f1 6=f2 } dP

Z

=

f2 1A dP.

⇒“ Aus den Voraussetzungen folgt:

”

Z

Z

∀A ∈ A :

f1 dP =

f2 dP

A

A

Z

Z

⇒ ∀A ∈ A :

f1 dP −

f2 dP

A

ZA

f1 − f2 dP = 0.

=

A

50

Speziell für

−

A+

n := {f1 − f2 > 1/n}, An := {f1 − f2 < −1/n}

gilt also:

Z

0

=

A+

n

Z

≥8.13

A+

n

f1 − f2 dP

1

dP

n

1

P (A+

n ),

n

=

d.h. P (A+

n ) = 0;

Z

0

=

A−

n

f1 − f2 dP

Z

1

− dP

n

A−

n

1

− P (A−

n ),

n

≤8.13

=

d.h. P (A−

n ) = 0. Es folgt:

!

[

P {f1 6= f2 } = P

−

(A+

n ∪ An )

n∈N

≤

X

−

P (A+

n ∪ An ) = 0.

n∈N

2

Satz 8.23 f sei P –Dichte von Q, g sei Zufallsvariable. Dann gilt:

g ist Q–integrierbar ⇔ gf ist P –integrierbar und in diesem Fall gilt:

Z

Z

g dQ = gf dP.

Beweis:

1. Es sei e =

P

1≤i≤m

αi 1Ai ∈ E

Z

m

X

⇒ e dQ =

αi Q(Ai )

i=1

=

=

m

X

i=1

m

X

Z

αi

f dP

Ai

Z

αi

f 1Ai dP

i=1

Z

=

f

m

X

αi 1Ai dP

i=1

Z

=

51

f e dP.

2. g ≥ 0 sei Zufallsvariable ⇒ g = limn∈N en mit geeigneten e1 ≤ e2 ≤

... ∈ E

Z

Z

⇒ g dQ =Def. lim en dQ

n∈N

Z

=1. lim en f dP

n∈N

Z

=8.14

lim(en f ) dP

n∈N

Z

=

f g dP.

3. Allgemeiner Fall mittels Zerlegung g = g + − g − .

2

Satz 8.24 (Fubini) (Ω, A, P ) sei das Produkt der beiden Wahrscheinlichkeitsräume (Ωi , Ai , Pi ), i = 1, 2, d.h.

Ω = Ω1 × Ω2 ,

A = σ({A1 × A2 : A1 ∈ A1 , A2 ∈ A2 },

P = P 1 × P2 .

f : Ω → R sei integrierbar bzgl. P . Dann gilt:

1.

f (ω1 , ·) : Ω2 3 ω2 7→ f (ω1 , ω2 ) ∈ R

ist für P1 –fast alle ω1 ∈ Ω1 P2 –integrierbar, d.h. es existiert N1 ∈

A1 , P1 (N1 ) = 0 und ∀ω1 ∈ N1c ist f (ω1 , ·) eine P2 –integrierbare Funktion.

2.

f (·, ω2 ) : Ω1 3 ω1 7→ f (ω1 , ω2 ) ∈ R

ist für P2 –fast alle ω2 ∈ Ω2 P1 –integrierbar, d.h. es existiert N2 ∈

A2 , P2 (N2 ) = 0 und ∀ω2 ∈ N2c ist f (·, ω2 ) eine P1 –integrierbare Funktion.

3. Die gemäß 1. bzw. 2. bis auf Nullmengen definierten Funktionen

Z

ω1 7→

f (ω1 , ·) dP2

Ω2

und

Z

ω2 7→

f (·, ω2 ) dP1

Ω1

52

sind P1 – bzw. P2 –integrierbar und es gilt:

Z

Z

f dP =

f d(P1 × P2 )

Ω

Ω1 ×Ω2

Z Z

=

f (ω1 , ·) dP2 P1 (dω1 )

Ω1

Ω2

Z Z

=

f (·, ω2 ) dP1 P2 (dω2 ).

Ω2

Ω1

Beweis: Siehe Maßtheorie.

2

Bemerkung Die bisher entwickelte Integrationstheorie ist auch für beliebige

σ–finite Maße µ anstelle eines Wahrscheinlichkeitsmaßes P gültig.

µ : A → [0, ∞] ist Maß :⇔

P

S

1. µ n∈N An = n∈N µ(An ) für disjunkte An ∈ A,

2. µ(∅) = 0.

µ : A → [0,S∞] ist σ–finites Maß :⇔ µ ist Maß und es existieren An ∈ A,

n ∈ N, mit n∈N An = Ω und µ(An ) < ∞, n ∈ N.

Definition 8.25 Definiere λ0n : In0 := {(a, b] = ×ni=1 (ai , bi ] : a, b ∈ Rn } →

[0, ∞] durch

Y

λ0n ((a, b]) :=

(bi − ai ).

1≤i≤n

λ0n

In0

ist σ–additiv auf

und kann eindeutig zu einem (σ–finiten) Maß auf Bn

fortgesetzt werden. Dieses Maß ist das Lebesgue–Maß, i.Z. λn , vgl. 7.8.

Satz 8.26 Es gilt:

λn = λn1 ,

wobei λn1 das n–fache Produkt von λ1 bezeichnet.

Beweis: Klar, da

λn ((a, b]) = λ0n ((a, b])

Y

=

(bi − ai )

1≤i≤n

=

=

Y

λ1 ((ai , bi ])

1≤i≤n

λn1 ((a, b]).

2

53

Definition 8.27 Es sei f ∈ L(Rn , Bn , λn ). Wir setzen:

Z

Z

Z

f (x) dx := f (x1 , . . . , xn ) dx1 · · · dxn := f dλn .

Bemerkung 8.28 Setze (Ω, A, P ) := ((0, 1], B∩(0, 1], λ1 /(0, 1]), fn := n1(0,1/n] ,

n ∈ N. Dann gilt:

fn (ω) →n→N 0, ω ∈ Ω,

aber

Z

Z

fn dλ1 = nλ1 ((0, 1/n]) = 1 6=

0 dλ1 = 0.

Die Monotonie– bzw. Beschränktheitsvoraussetzungen in den Integrationssätzen

sind also wesentlich.

9

Verteilungen und ihre Charakterisierungen

Definition 9.1 (Ω, A, P ) sei Wahrscheinlichkeitsraum, (Ω0 , A0 ) messbarer

Raum, f : (Ω, A, P ) → (Ω0 , A0 ).

Das Wahrscheinlichkeitsmaß P ∗ f : A0 → [0, 1], definiert durch

(P ∗ f )(A) := P (f −1 (A)),

A ∈ A0 ,

heißt Verteilung von f , (s. 7.1).

Bemerkung Jedes Wahrscheinlichkeitsmaß P 0 auf einem beliebigen messbaren Raum (Ω0 , A0 ) kann als Verteilung einer geeigneten Zufallsgröße aufgefasst werden: Setze

(Ω, A, P ) := (Ω0 , A0 , P 0 ), f (ω) := ω, ω ∈ Ω.

Definition 9.2 f sei Zufallsvariable über (Ω, A, P ), d.h. f : (Ω, A) → (R, B).

Definiere F : R → [0, 1] durch

F (x) := P ({f ≤ x})

= P ({ω ∈ Ω : f (ω) ≤ x})

= (P ∗ f )((−∞, x]),

x ∈ R.

F heißt Verteilungsfunktion von f bzw. von P ∗ f .

Beispiel 9.3

1. f sei das Ergebnis beim Würfeln, d.h. P ({i}) = 1/6, i = 1, . . . , 6. Dann

gilt:

für x < 1,

0

i/6 für i ≤ x < i + 1, i = 1, . . . , 5,

F (x) =

1

für x ≥ 6.

54

2. f sei gleichverteilt auf (0, 1), d.h. P ({f ∈ B} = λ1 (B) für B ∈ B∩(0, 1).

Dann gilt:

P ({f ≤ x})

P ({f ∈ (−∞, x]})

P ({f ∈ (0, x]})

λ1 ((0, x]) = x

für 0 ≤ x ≤ 1.

F (x) =

=

=

=

Bemerkung 9.4 Die Verteilungsfunktion F (x) = (P ∗ f )((−∞, x]) einer

Zufallsvariablen f hängt offenbar nur von der Verteilung P ∗ f von f ab,

nicht von den konkreten Werten von f .

Satz 9.5 F sei Verteilungsfunktion der Verteilung Q := P ∗ f . Dann gilt:

1. F ist monoton wachsend.

2. F ist rechtsseitig stetig.

3. limx→∞ F (x) = 1, limx→−∞ F (x) = 0.

Beweis:

1.“

”

x<y

⇒ (−∞, x] ⊂ (−∞, y]

⇒ F (x) = Q((−∞, x]) ≤ Q((−∞, y]) = F (y).

T

2.“ (−∞, x] = n∈N (−∞, xn ], falls xn ↓ x. Damit:

”

F (x) = Q((−∞, x])

!

\

= Q

(−∞, xn ]

n∈N

= lim Q((−∞, xn ])

n∈N

= lim F (xn ).

n∈N

3.“

”

xn ↑ ∞

⇒ R=

[

(−∞, xn ]

n∈N

⇒ 1 = Q(R) = lim Q((−∞, xn ]) = lim F (xn );

n∈N

n∈N

xn ↓ −∞

⇒ ∅=

\

(−∞, xn ]

n∈N