Statistik 1-2

Werbung

Statistische Formelsammlung

Statistik 1 und 2

Auf Basis des Vorlesungsskripts von M. Stöcklin WS / SS 2003/2004;

Bortz (2005) 6. Auflage, Statistik für Human- und Sozialwissenschaftler;

Hirsig (2004). Statistische Methoden in den Sozialwissenschaften, Bd. I, II.

Alle Angaben ohne Gewähr

© Marion Huber

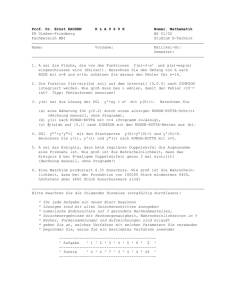

Inhaltsverzeichnis

Entscheidungsbaum

Skalenniveau

Quartile

Normalverteilung

Standardnormalverteilung (SNV)

z-Transformation

Standardabweichung

One sample t- Test (z- Test)

Einseitige Hypothese

Sp Pop

(z-Transformation)

One sample t-Test (z-Test)

Zweiseitige Hypothese

Sp Pop

Abschätzen des Stichproben-Umfangs

Effektstärke

Konfidenz-intervall (KI)

t – Test für unabhängige Stichproben

Sp Sp

Gleicher SP-Umfang (N)

Ungleicher SP-Umfang (N)

Interpolation für tk

Stichproben-umfang

Effektstärke

Power

Interpolation für n

t-Test für abhängige SPn

Abschätzen des Stichprobenumfangs für abhängige SPn

Effektstärke

Interpolation

Power

Abschätzen der Teststärke (Power)

Zusammenhangs-masse bei intervallskalierten Daten Regression

Regressionskoeffizient b

Inferenzstatistische Aussagen

Standardschätzfehler des Regressionskoeffizienten

Vergleich eines Regressionskoeffizienten mit einem vorgegebenen Wert β

2

3

3

4

4

5

6

7

7

7

7

8

8

8

9

9

10

12

12

12

12

12

13

13

13

13

14

15

15

15

15

16

17

17

19

19

19

Konfidenzintervall

Korrelation r

Das Bestimmtheits-mass r²

Der Korrelationskoefizient r nach Pearson

Signifikanztest

für r

Bedeutsamkeit eines Zusammenhangs r≠ 0

Poweranalyse für r

Interpolation für n

Fisher`s Z-Transformation

Konfidenzintervall (KI)

Drei Schritte der Berechnung des KI mit dem Taschenrechner

Vergleich Korrelationskoeffizient Konstante

Vgl. zweier Korrelationskoeffizienten

Binomialtest

U –Test von Mann –Whitney

für unabhängige SPn

Wilcoxon T-Test

für abhängige SPn

Korrelationen für ordinalskalierte Daten

unabhänge Stichproben Pearsonkorrelation

abhängige Stichproben Spearman´sche Rangkorrelation

Kendalls τ

χ² - Goodness of Fit

SP POP

Vierfelder χ2 – Test

Unabhängiger Stichproben

Sp Sp

Mc Nemar

χ² - Test für abhängige SPs

Zusammenhangsmasse für Vierfelder χ² -Test

k x l - χ² Test

Stärke eines Zusammenhangs:

Kontingenzkoeffizient C

Poweranalyse für nominalskalierte Daten

20

21

21

21

22

22

22

23

23

23

24

24

26

26

27

28

28

29

29

31

31

31

32

33

33

34

34

34

35

35

36

37

38

38

39

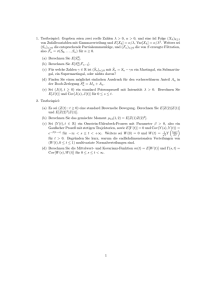

Entscheidungsbaum

N > 25

z – Test

N < 25

One Sample t- Test einseitig

zweiseitig

SP POP

intervallskaliert

normalverteilt

SP ↔ SP

intervallskaliert

Nicht

normalverteilt

Gepaart/ abhängig

t – Test für abhängige SPn

Ungepaart/

unabhängig

t – Test unabhängige SPn

gepaart

Wilcoxon Test

ungepaart

Mann Whitney – U – Test

Regression

Korrelationskoeffizient nach Pearson

Bestimmteheitsmass

Spearman`sche Rangkorrelation ,

Kendall`sτ

Ordinalskalierte

Daten

gepaart

ungepaart

Nominalskalierte

Daten

gepaart

ungepaart

Wilcoxon Test

Mann Whitney U-Test

Mc Nemar

Zwei

Ausprägungen

Viele

Ausprägungen

χ²- Test (32);

Φ -Phi (für 2 x 2 Tabellen)

Vierfelder χ² ,

Binomial

K x l -χ²;

χ² - Test

Kontingenzkoeffizient C

Kramer`S V

2

Skalenniveau

empirische Relevanz und sinnvolle Kennwerte:

emp.Relevanz

Nominal

keine

Ordinal

Ordnung der Zahlen

Intervall

Differenz der Zahlen

Verhältnis

Quartile

Differenz der Zahlen und

deren Verhältnis zueinander

1., 2., 3.-Quartil

Sie geben an, dass ein

bestimmter Prozentsatz aller

Werte unter dem entsprechenden

Quartilwert (QW) liegt.

1. Quartil gibt an, dass 25% aller

Werte unter dem entsprechenden

Wert liegen; es entspricht dem

25.Perzentil, das 3.Q. 75% aller

Werte liegen darunter

(75.Perzentil). Das 2.Q entspricht

dem Median ↑

sinnvolle Kennwerte

Modal

Median

Mittelwert, Standardabweichung, Varianz,

Transformationen, Modus, Modal

Mittelwert, Standardabweichung,Varianz,

Transformationen, Modus, Modal

1.QW =

xi ' 0.5 +

1 &n

#

( $ ' Fi '1 !

fi % 4

"

2.QW =

xi ' 0.5 +

1 &n

#

( $ ' Fi '1 ! =Me

fi % 2

"

3.QW =

xi ' 0.5 +

1 & 3( n

#

($

' Fi '1 !

fi % 4

"

F : kummulierte Häufigkeit

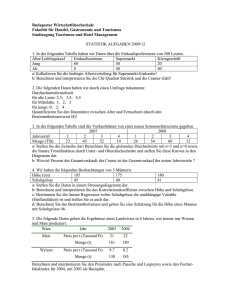

Bsp:

Das Befinden von Schülern auf einer Skala von 1-7

abgetragen.

Skalenwert Häufigkeiten kumulierte

xi

fi

Häufigkeit.

Fi

1

2

2

2

8

10

3

26

36

4

60

96

5

99

195

6

50

245

7

16

261

Der Median befindet sich bei N/2 130.5

(bei den kumulierten Häufigkeiten nachschauen!!!!

Dieser Wert liegt oberhalb des 4.Skalenwertes, also bei

5.

xi = 5 ; fi = 99 ; Fi-1 = 96 ; n/2 = 130.5

in Formel für Median einsetzen.

3

Normalverteilung

(NV)

Standardnormalverteilung (SNV)

NOTES

Mathematische

Eigenschaften der

Dichtefunktion (NV):

Glockenförmig

Symmetrisch zu µ

Kurve nähert sich

asymptotisch der x – Achse

zwischen µ-σ und µ+σ

liegen 2/3 aller Messwerte

(68%)

Verteilungsform hängt von

den Parametern σ und µ ab

es gibt unendlich viele

Normalverteilungen

Rein rechnerisch ist es

einfacher, wenn man nur

eine NV hat. Dies erreicht

man, indem man einen

neuen Maßstab für die

Messwerte wählt. Man

transformiert:

µ wird 0 und σ wird 1.

Somit gelangt man zur

Standardnormalverteilung

Bedeutsamkeit der NV:

NV als empirische

Verteilung

NV als Verteilungsmodell

statistischer Kennwerte

NV als mathematische

Basisverteilung

NV als statistische

Fehlertheorie

Es werden Dir immer wieder ...diese Striche begegnen. Sie umschliessen Formeln oder numerische Ausdrücke.

Man nennt sie Betragsstriche. Ihre Funktion: Der Wert , der zwischen ihnen steht wird immer positiv gerechent oder

dargestellt, auch wenn er eigentlich negativ wäre. Bsp.: 5-7 = -2 = 2.

4

z-Transformation

Genaue Berechnung der

Standardabweichung

Seite 5

Verteilungen, die sich aus

x "µ

z= i

Messungen ergeben,

#x

normalverteilt und

intervallskaliert sind, können

2

!xi2 " (!xi ) n

so transformiert werden,

#x =

n

dass sie mit anderen

2

Normalverteilungen

"xi2 ! ("xi ) n

ˆ

!

#

=

vergleichbar werden und

x

n !1

descriptive Werte berechnet

bei Mittelwertsverteilungen

werden können.

mit dem Standardfehler

rechnen:

z=

TIP: Wenn im Text n gegeben, ist

davon aus zu gehen, dass mit

dem Standardfehler gerechnet

werden muss!!

xi " µ

!x

n

!x =

!x

n

Typische Fragestellungen für z-transformierte

Berechnungen:

Wie gross ist die Wahrscheinlichkeit, dass ein in einer

Zufallsstichprobe ein Proband einen IQ > 120 aufweist?

Wie gross ist die Wahrscheinlichkeit, dass der Mittelwert einer

Sp grösser (>) ist als der Populationsmittelwert.

Unter welchem IQ liegen 5% aller IQ- Werte einer

Zufallsstichprobe?

Das xx – te Perzentil einer Messwertverteilung

↓

Wahrscheinlichkeit einen grösseren / kleineren Wert zu

finden, als das vorgegebene oder errechnete.

Hier als Beispiel:

120 -100

—————— = 1.33

15

in Tabelle unter obiger Graphik den Wert

suchen und den entsprechende Prozentwert ermitteln

Berechnung eines Perzentils:

Hier haben wir die Fläche unter der Kurve gegeben (Prozent)

und müssen nun den durch 100 dividierten Wert dessen in

der Tabelle suchen gehen und den entsprechenden z-Wert

ermitteln.

5

Standardabweichung

!

$( x

i

# x)

2

nicht für

n

Taschenrechner !!!

nach dem Binominalsatz

gilt:

(a-b)² = a² - 2ab + b²

zunäst wird für den

Mittelwert

"x =

x=

! xi eingesetzt, dann

n

ergibt sich mit obiger

Formel mit dem

Binominalsatz ungeformt

die Taschenrechnerformel:

"x =

!

$ x # ($ x )

2

i

i

2

Bsp.:

Wir überprüfen von 9 Probanden die Reaktionszeit in einem

Wiedererkennungstest

VP

t(sek)

Achtung:

Ihr müsst eine zusätzliche

Spalte mit xi² machen und

genau schauen, wo was

eingesetzt wird!!!!!

2

3

4

5

6

7

8

9

Σ

0.2

0.3

0.1

0.4

0.7

0.3

0.2

0.4

0.8

Σxi=3.4

0.04

0.09

0.01

0.16

0.49

0.09

0.04

0.16

0.64

Σ xi²=1.72

Xi

Xi²

2

#=

! xi2 " (! xi ) / n

n

Σxi = 3.4 (Σxi )² = (3.4)² = 11.56

Σxi² = 1.72

/n

n

=

1

σ=

1.72 " (3.4)! 2 / 9

=0.219

9

!

NOTES

Varianz:

Rein rechnerisch gesehen ist die Varianz das Quadrat der Standardabweichung. Da durch das Quadrieren

auch kleine Unterschiede zu Tage kommen, ergibt sich ein genaueres Ergebnis, was dazu führt, dass die

Varianz eher den Populationswert abbildet als eine Standardabweichung.

" x2

$( x

=

i # x)

n

2

nicht für Taschenerchner zu gebrauchen, da rechnet ihr mit der obigen Formel, einfach ohne Wurzel.

!

6

One sample t- Test

(z- Test)

Einseitige Hypothese

Intervallskalierte Daten

Sp Pop

Sp Pop

(z-Transformation)

Sechs-Punkte-Schema:

Auf alle Tests anwendbar!!!

Hypothesen aufstellen

Signifikanzniveau (α)

festlegen

Ablehnungsbereich

festlegen dem α

entsprechenden z-Wert in

Tabelle ablesen.

Prüfgrösse errechnen

Prüfgrösse mit dem

kritischen Wert (z-Wert von

α) vergleichen.

Schlussfolgerung

wenn σ (Populationswert)

nicht bekannt und

n <25 dann

mit t- Verteilung rechnen!

Beispiel:

Vergleich von Lesezeiten einer

SP mit POP

Lesezeiten der SP sind kürzer als

die des Durchschnitts.

Gegeben:

_

x = 80

µ = 90

σ = 30

n = 20

es handelt sich um eine

Mittelwertsverteilung!!!!

es muss mit dem

Standartfehler gerechnet

werden!!!

Tipp:

sobald es um Mittelwerte geht

und N gegeben ist kann man

davon ausgehen, dass mit

Standartfehler gerechnet werden

muss, und nicht mit

Standartabweichung!!!!!!!!!!!

Signifikanz:

zp ≥ z k

(hier wird das entsprechende

Vorzeichen vor zk gesetzt!!!!!!)

| tp | ≥ tk mit df = n-1

H 0: x > µ H 1 : x < µ

SP hat kürzere Lesezeiten als POP

α = 0.05

kritischer Wert aus Tabelle suchen: zk = -1.65

In Tabelle unter α=0.05 einseitig nachschauen!!!

z

Prüfgrösse berechnen:

für

n < 25 t- Verteilung;

n > 25 z (hier wird der zentrale Grenzwertsatz gültig:

ab ca.25 Vpn geht jede Verteilung in eine

Normalverteilung über)

Für Messwertverteilungen gilt:

z (t ) =

xi " µ

!x

wenn eine Mittelwertsverteilung vorliegt mit Standartfehler

im Nenner rechnen !!!

(Im Text darauf achten, ob SP-Umfang gegeben ist, dann in

der Regel Standadtfehler nehmen!)

z (t ) =

x"µ

!x

mit

!x =

!x

n

( n einer Stichprobe)

80 - 90

zp = ————

30 / √20

zp = - 1.49

zp > zk H0 wird abgelehnt.

Die in der Stichprobe ermittelte kürzere Lesezeit stellt

einen signifikanten Unterschied dar.

7

Zweiseitige Hypothese

Sp Pop

Intervallskalierte Daten

Sp Pop

One sample t-Test (zTest)

Hypothesen aufstellen

Signifikanzniveau (α)

festlegen

Ablehnungsbereich

festlegen dem α

entsprechenden z-Wert in

Tabelle ablesen.

Prüfgrösse errechnen

Prüfgrösse mit dem

kritischen Wert (z-Wert von

α vergleichen

Schlussfolgerung

Beispiel:

Vergleich von Lesezeitenmittelwerten einer Stichprobe mit

den Populationsmittelwerten.

Gegeben:

_

X = 80

µ = 90

σ = 30

n = 20

auch hier handelt es sich um eine

Mittelwertsverteilung

mit Standartfehler rechnen!!!

1. H0 : X = µ

H1 : X ≠ µ

α = o.o5 (5%)

Ablehnungsbereich festlegen

(hier wieder den z-Wert für α/2 (weil zweiseitig) aus der

Tabelle ablesen)

zk = ± 1.96 zp > ZK;

Prüfgrösse berechnen:

Signifikanz

zp ≥ zk(α/2)!!!!

|tp| ≥ tk mit df =n-1

zp = 80 - 90

= - 1.49

30 / √20

Prüfgrösse mit Ablehnungsbereich vergleichen.

Da tp(z) = -1.49 > t(z)k(α/2) = -1.96 wird H0

zugunsten H1 verworfen.

Das heisst, dass der Unterschied der Lesezeitenmittelwerte

signifikant ist.

z=

µ1 < µ2 tp ≤ - tk

µ1 > µ2 tp ≥ tk

µ1 ≠ µ2 I tpI ≥ tk

Merke:

x"µ

!ˆ x

!ˆ x =

!

n

Bei Messwertverteilungen mit Standardabweichung rechnen!

x "µ

z= i

!

2

mit

#x i2 $ ( #x i ) n

"ˆ x =

n $1

bei Mittelwertsverteilungen mit Standardfehler!!!!!!!!

!x =

!x

n

!

8

Abschätzen des

Stichproben-Umfangs

Abschätzen des

Stichprobenumfangs

Bei 50% iger Wahrscheinlichkeit

Signifikanz zu erreichen:

(1-β = 50%)

Merke:

Intervallskalierte Daten

In der Regel will man eine Power

von 0.80.

Dann gibt man sie vor und

berechnet zunächst die

Effektstärke!!

Effektstärke

wie viele

Standardabweichungen

beträgt ein Unterschied?

NOTES

Will man eine höhere

Wahrscheinlichkeit (Power),z.B.:

80% (entspricht einer guten

Power) oder will man allgemein

wissen wie viele n man braucht

um Signifikanz zu erreichen

Beispiel :

Vergleich von Lesezeitenmittelwerten einer Stichprobe mit

den Populationsmittelwerten.

Gegeben:

_

X = 80

µ = 90

σ = 30

Durch das Auflösen eines

Signifikanztests nach n erhalten

wir die Anzahl Versuchspersonen,

um mit 50-% iger

Wahrscheinlichkeit eine

Signifikanz zu erhalten

d=

| µ1 " µ 2 |

!

_

µ kann hier auch durch x ersetzt

werden. Es geht hier einfach um

Mittelwerte, entweder

Populationswerte oder

Stichprobenwerte

Für die Fragen:

Ab welchem Mittelwert ist ein Ergebnis signifikant?

Wer hat ein besseres Ergebnis zu erwarten?

z (t ) p =

x'µ

)

n

n einer SP!!!!

2

& ) ( z (t ) #

!!

n = $$

% x'µ "

2

(30 · 1.96 / 80 – 90 ) = 34.57

Mit 1- ß = 50% muss n > 35 Personen sein,

um mit 50% Wahrscheinlichkeit Signifikanz zu erreichen.

bei normalverteilten Messwertverteilungen:

Nomogramm

1-β (gibt man vor) in Abhängigkeit von α und n.

Die errechnete Effektstärke (d) suchen und schauen, bei

wieviel n man landet.

Bei Mittelwertsverteillungen in der

Tabelle:“Poweranalyse von Mittelwertsverteilungen mit

Hilfe des t-Tests“

x = µ + zk " ! x

( zk = z-Wert für α)

Diese Tabellenspalte: Cooligan Tab. 2 ist auch entscheidend, wenn man schauen möchte, wie gross die Wahrscheinlichkeit ist, ein

bestimmtes Ergebnis zu erhalten, das besser als ein anderes ist. Man schaut dann beide Wahrscheinlichkeiten nach und vergleicht diese direkt miteinander.

9

Intervallskalierte Daten

Konfidenzintervall (KI)

Gibt den Wertebereich an, in

dem mit vorgegebener

Wahrscheinlichkeit (meist

95%) der Populationswert zu

finden ist.

KI – Breite ist abhängig von n

und σ : je grösser n, desto

kleiner KI- Breite, je grösser

σ, desto grösser KI-Breite.

Ist quasi das Gegenstück zu

α.

t ( z) =

x"µ

!

wird umgeformt nach x

x( 2.5) = µ # t ( z ) ( 2.5) " !ˆ x (oder!ˆ x )

-2.5

97.5

↓

z-/t-Wert aus entsprechender

Tabelle raussuchen!!!

Die Grenzen müssen berechnet

werden!

Schlussendlich brauchen wir die

Werte auf der x-Achse, d.h. wir

suchen uns die z-Werte aus der

Tabelle für die Grenzen des KI.

Diese werden jeweils in unsere

schon bekannte Formel der zTransformation bzw. des OneSample-t-Tests eingesetzt.

Das gleiche gilt für den t-Test bei

Stichprobenvergleichen.

x(97.5) = µ + t ( z ) (97.5) " !ˆ x (oder!ˆ x )

CAVE:

t- / z-Werte für 2.5 und 97.5 sind die gleichen!!! !!!!!!!!

Man muss nur das eine mal addieren, das andere mal subtrahieren

10

Teststärke

Intervallskalierte

Daten

(Power)

(d.h. die

Wahrscheinlichkeit,

dass H0 richtigerweise

verworfen wurde)

für einseitige

Hypothese

Die Grenzen des

Ablehnungsbereiches festlegen

den kritischen Mittelwert

berechnen (d. h. den zu zk

gehörenden Mittelwert

berechnen)

Die Wahrscheinlichkeit für den

Mittelwert zk ≠ µ berechnen

Interpretation

Beispiel :

siehe oben

Ausser: Hs : µ1 = 75

z=

x " µ1

!

n

x = µ0 + zk "! x

! = !

x

NOTES:

n

Der Ablehnungsbereich endet bei zk = 1.65

Bestimmen von x zu diesem Ablehnungsbereich:

_

X = 90 – 1.65 x 30 / √20

_

x = 78.9

Die Wahrscheinlichkeit für x < 78.9 unter der Voraussetzung, dass

µ1 = 75

z = 76.84 - 75 = 0.58 Tabelle

30 / √ 20

1-ß = p (X< 78.9| Hs) = 72 %

Interpretation:

Die Wahrscheinlichkeit einen Unterschied zu finden beträgt 72%

p-Wert in SPSS - Output

Für das Signifikanzniveau wird p angegeben: dies entspricht α (in Prozent angegeben),

d. h. man muss diesen Wert in der Tabelle unter den Prozentwerten suchen und dann den entsprechenden

z-/t-Wert ablesen!!!

(wie man es sonst für den kritischen Wert auch macht).

P gibt die Wahrscheinlichkeit an, ein noch extremeres Ergebnis zu finden, als das was man hat.

P muss kleiner als α sein!!!! Wenn nichts angegeben ist, so wird α auf 0.05 angesetzt.

11

SP ↔ SP

t – Test für

unabhängige

Stichproben

SP SP

Gleicher

SP-Umfang (N)

Ungleicher

SP-Umfang (N)

Interpolation für tk

Voraussetzungen:

SPn müssen unabhängig sein

Messwerte müssen

intervallskaliert sein

Messwerte sollten

normalverteilten

Grundgesamtheiten

entstammen

Populationsvarianzen sollen

ungefähr gleich gross sein

wenn verletzt: MannWhitney- U- Test

t=

x1 ! x2

"ˆ x1 ! x 2

Gleicher SP-Umfang (N):

!ˆ x1 " x 2 = !ˆ12 + !ˆ 22 n

n einer

Gruppe!!!Ungleicher

SP-Umfang (N)

Es ergeben sich nun für die

Berechnung leicht andere

Formeln:

)ˆ x1 ( x 2 =

)ˆ12 (n1 ( 1)+ )ˆ 22 (n2 ( 1) & 1 1 #

' $$ + !!

n1 + n2 ( 2

% n1 n2 "

Signifikanz:

µ1 ≠ µ2 I tpI ≥ tk ,

mit df = n1+n2 -2

Intervallskalierte Daten

µ1 < µ2 tp ≤ - tk

µ1 > µ2 tp ≥ tk

Allgemeines Beispiel:

Zwei Gruppen werden hinsichtlich eines Merkmals untersucht

Zwei Gruppen werden mit zwei verschiedenen Lernmethoden

unterrichtet.

Unterscheiden sich die Mittelwerte der Gruppen signifikant?

Gegeben:

µ1 = 33 µ2 =27.1

σ1 = 14.76

σ2 = 12.65

n = 10 (pro SP)

df= 18 (n – 2)

Hypothesen:

H0: µ 1 =µ2

H1: µ 1 ≠µ2

2. α = 0.05

3. Ablehnungsbereich festlegen

tk = 1.734, bei df = 18; tp ≥ tk für Signifikanz

Falls wir die Anzahl der df in der Tabelle nicht finden, kann man auch hier

interpolieren:

tk =

t unten ! t oben

! Abst.zu _ Grenze _ oben + t oben

10

Prüfgrösse berechnen:

33 -27

tp = ———————————

2

2

√ 14.76 + 12.65 / √ 10

tp = 0.96

tp = 0.96 und damit < tk

Die Lernmethoden weisen keinen signifikanten Unterschied auf.

Hat man jedoch sehr ungleiche SP-Umfänge, so liegt es nahe, dass die Kennwerte

unterschiedlich ins Gewicht fallen.

Das heisst für uns, dass wir die Kennwerte gewichten müssen:

Bei sehr verschiedenen Vpn – Umfängen muss man die Mittelwerte gewichten

x gew =

n1 x1 + n2 x 2

n1 + n2

12

Stichprobenumfang

Effektstärke

_

∧

Berechnen von D;

Effektstärke berechnen:

d=

D = x1 " x 2

Ungleicher SP-Umfang (N):

D = $ D / ND

d=

!

!ˆ D =

Intervallskalierte Daten

Interpolation für n

#ˆ 12 + #ˆ 22

2

x1 " x 2

#ˆ 12 ( n1 "1) + #ˆ 22 ( n 2 "1)

n1 + n 2 " 2

!ˆ12 + !ˆ 22 / 2

bei ungleichem n

"

Power

x1 " x 2

x " x2

d= 1

#ˆ x1 "x 2

mit:

bei gleichem n

!

Effektstärke:

Gleicher SP-Umfang (N):

σD ; nD

α = 0.05;

D

=

"ˆ12 (n1 ! 1) + "ˆ 22 (n2 ! 1)

n1 + n2 ! 2

!

1- β = .80

Mit der errechneten Effektstärke nun in der Tabelle

„Poweranalyse für Mittelwerts-vergleiche mit Hilfe des tTests“ nachschauen.

In der Regel muss nun wieder interpoliert werden:

Wir suchen uns den zugehörigen Wert zu n.10 in der Tabelle

raus und fügen ihn in nebenstehende Formel ein

Man gibt in der Regel eine Power von 0.80 vor!

Über die Interpolationsformel kann auch die aktuelle Power ausgerechnte

werden. Man hat dann die iegenen Werte als Basis, setzt diese in die

Interpolationsformel ein und löst diese nach n..10 auf. Mit der erhaltenen Anzahl

Probanden kann dann rückwärtig in Tabelle geschaut werden, bei welcher

Power man die entsprechende Anzahl Vpn unter n.10 findet.

Interpolation:

n=

n.10

+1

100 ! d ?

13

NOTES:

Intervallskalierte Daten

SP ↔SP

t-Test für

abhängige SPn

bei Messwertverteilungen schauen wir mit dem errechneten d ins Nomogramm, ,bei Mittelwertverteilungen in die

Tabelle „Poweranalyse für Mittelwertsvergleiche mit Hilfe des t-Tests“

Voraussetzungen:

SPs müssen abhängig sein,

d.h. gepaart oder

Messwiederholung

N > 25, dh. möglichst

normalverteilt

Messwerte müssen

intervallskaliert sein

Streuungen bzw. Varianzen

sollten ziemlich gleich sein

Der t-Test ist so robust, dass

es reicht, wenn Verteilung

nicht übermässig schief ist

wenn verletzt Wilcoxon

t=

D

#̂ D

D=

! (x1 " x 2 )

n

_

D = Mittelwert der Differenzen

! D =

#ˆ

!ˆ D2

!ˆ

= D

nD

nD

2

D

=

" Di2 ! (" Di )

n

n !1

Signifikanz:

|tp| ≥ tk , dann H0 verwerfen

Paar

1

2

3

4

5

6

7

8

9

10

Methode A

15

45

16

41

7

48

46

37

40

35

Methode B

5

36

18

25

10

40

43

30

35

29

5

6

Differenz A - B 10 9

- 2 16 -3

8

3

7

Hypothesen:

H0: Methode A unterscheidet sich nicht von Methode B

H1: Methode A unterscheidet sich von Methode B.

α = 0.05

tk in Tabelle nachschauen: bei df= nd – 1 ( hier: 9) :

tk= 2.262 ( zweiseitig)

Prüfgrösse errechnen:

_

D = 5.9 ;

σD = 5.626 ()

t=

5.9

5.625

10

= 3.316

tp ≥ tk, mit df = 9 für α = 0.05; H0 wird zu Gunsten H1 verworfen.

14

Berechnen der

Abschätzen des

Stichprobenumfangs für

abhängige SPn

D=

!D

nD

deskriptiven Werte der Differenzen

2

i

;

" Di2 ! (" Di )

#ˆ D =

n

n !1

Effektstärke

Berechnen der Effektstärke:

Interpolation

d=

D

# 2

"ˆ D

;

2

#ˆ D =

" Di2 ! (" Di )

n

n !1

Interpolieren, falls Wert nicht direkt aus Tabelle ablesbar

n=

!

Power

Wenn nicht gegeben: siehe

S 15

!

n.10

+1

100 " d 2 !

n = Anzahl Paare !!!!

Power:

Wird vorgegeben : 1 - β = .80 (80 %)

wird vorgegeben oder abgeschätzt

(wenn man es noch genauer haben will)

Ermittlung des erforderlichen SP-Umfangs mit Tabelle:

„Poweranalyse für Mittelwerte mit Hilfe des t – Tests“

15

Abschätzen der

Teststärke (Power)

Gegeben:

n.10

d

n ( bei einer Power von 80%)

Voraussetzungen:

abhängige SP

intervallskalierte Messwerte

normalverteilte Differenzwerte

(nicht Mittelwerte oder

Messwerte!!!!)

Man formt die Interpolationsformel

nach n.10 um:

n.10 = 100 " d 2 " (n ! 1)

Man nutzt die Seitenverhältnisse zweier Dreiecke aus.

1-βo

1-βu

n.10u

n.10

n.10o

Daraus ergibt sich die Berechnung der genauen Power:

(1 " ! o )" (1 " !u ) = (1 " ! )" (1 " !u )

intervallskalierte Daten

n.10o " n.10u

n.10 " n.10u

$ (1 " ! ) = [(1 " ! o )" (1 " ! u )]#

Interpolation:

(1 ! # )= Pu + (Po ! Pu )" n.10 ! n.10u

n.10o ! n.10u

n.10 " n.10u

+ (1 " ! u )

n.10o " n.10u

↓

Po

Pu

P = Wahrscheinlichkeit für den jeweiligen n.10 Wert

Interpolation:

(1 ! # )= Pu + (Po ! Pu )"

n.10 ! n.10u

n.10o ! n.10u

man kann nun alle Werte aus der Tabelle

„Poweranalyse für Mittelwertsvergleiche mit Hilfe des t-Tests“

heraussuchen.

16

Zusammenhang

s-masse bei

intervallskaliert

en Daten

Regression

Intervallskalierte Daten

Regressionskoeffizient b

Regressionen beschreiben

Zusammenhänge bezüglich ihrer

Art.

Typische Fragestellungen:

Hängt etwas von etwas anderem

ab?

Wie gross ist ein voraussichtlicher Erfolg mit bestimmter

Punktezahl in Vor-test

Voraussetzung:

Es müssen Paare von

Messwerten vorliegen

(typischerweise zwei Messwerte

derselben Person)

Es gibt verschiedenartige

Zusammenhänge:

lineare und nicht-lineare

unterschiedlichster Art.

Wir befassen uns zunächst mit

der linearen Regression.

Die Parameter b und b0 sind so

zu beschreiben, dass die Summe

der quadrierten vertikalen

Abstände der Punkte zur

Geraden minimal wird. = Summe

der kleinsten quadrierten

Abweichungen (least-squarecriterion) = QSe

Lineare Regression:

Definiert durch die Gleichung:

y = b0 + b·x

b0 =

y-Achsenabschnitt

b1 =

Steigung der Geraden bzw.

Regressionskoeffizient

b1 =

n " # xi y i ! # xi # y i

2

n " # x ! (# xi )

2

i

b0 = y ! b1 x

_

_

y und x sind Koordinaten eines

Punktes auf der

Regressionsgeraden.

Ich beschränke mich hier auf die

Taschenrechnerformel !!!!

Mit Zwischenergebnissen:

b=

cov(x, y )

s x2

b>0

positiver

Zusammenhang,

d. h. je grösser die einen Werte,

desto grösser auch die anderen.

Je grösser x desto grösser y

b<0

negativer

Zusammenhang, d.h. je grösser die

einen Werte, desto kleiner die

anderen.

Je grösser x desto kleiner y

pos. Regr.

neg. Regr.

kein Zusammenhang

y= b0+bx

y= b0 – bx

hier ist b = o y=b0

_

_

∑(xi – x) · (yi – y)

= ———————

nicht geeignet mit dem Taschenrechner

∑(xi – x)²

_

_

∑(xi – x) · (yi – y)

Cov (x, y) = ————————

N

Covarianz erfasst das durchschnittliche Produkt korrespondierender

Abweichungen aller Messwerte vom Mittelwert.

Grosses x Grosses y positive cov

(kleines x kleines y positive cov)

Grosses x kleines y negative cov

(kleines x Grosses y negative cov

Taschenrechnertipp:

Der Taschenrechner muss unter dem Statistikmodus auf

LIN umgestellt werden. Dann geht man auf DATA und

kann nacheinander die x- und y- Werte eingeben. Weiter

auf CALC. Es werden alle Zwischensummen

ausgerechnet und auch die Koeffizienten.

b0 ist bei vielen Taschenrechnern unter a zu finden, b1

unter b. Es wird auch der Korrelationskoeffizient r

berechnet.

17

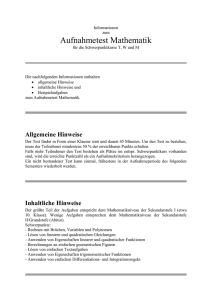

Beispiel Regression

Streudiagramm SPSS-Output

_

5,00

tochter = 0,50 + 1,50 * mutter

R-Quadrat = 0,94

_

tochter

4,00

_

3,00

_

2,00

1,00

_

0,00

_

0,00

1,00

2,00

3,00

mutte r

Intervallskalierte Daten

b1 =

n " # xi y i ! # xi # y i

2

n " # xi2 ! (# xi )

b0 = y ! b1 x

y = b0 + b1 x

Lineare Regression

Rechenbeispiel für eine lineare Regression:

Besteht ein Zusammenhang zwischen der von Müttern und Töchtern am Gymnasium

verbrachten Zeit?

Paar

Mütter X

Töchter y

xy

X²

Y²

1

0

0

0

0

0

2

0

1

0

0

1

3

1

2

2

1

4

4

2

3

6

4

9

5

2

4

8

4

16

6

3

5

15

9

25

∑xy = 31

∑x² = 18

∑y² =55

∑x =

8

∑y =

15

SPSS- Output der deskriptive Statistiken

Mittelwert

Standardabweichung

N

TOCHTER

2,5000

1,87083

6

MUTTER

1,3333

1,21106

6

N · ∑xy -∑x∑y

6 · 31 – 8· 15

b = ————————— = ———————— = 1.5

n·∑x² - (Σx)²

6·18 - 64

_

_

b0 = y – 1.5·x

Wir gehen davon aus, dass die Mittelwerte auf der Regressionsgeraden liegen und

setzen diese nun für x und y ein :

b0 = 2.5 – 1.5 · 1.33

b0 = 0.5

y = 0.5 + 1.5·x

NOTES:

Manchmal soll man einen y-Wert aufgrund eines x-Wertes vorhersagen:

wenn b0 und b1 bekannt sind,so setzt man den vorgegebenen x-Wert und die beiden b´s in die Formel ein und

erhält so den für x vorhergesagten ŷ -Wert!!!

18

Inferenzstatistische

Aussagen

Standardschätzfehler des

Regressionskoeffizienten

Intervallskalierte Daten

Vergleich eines

Regressionskoeffizienten mit

einem vorgegebenen

Wert β

!

Beschreibt die Güte der Anpassung!

d. h. wie gut beschreibt die Regressionsgerade den

Zusammenhang.

Die Formel für die kleinsten quadrierten Abweichungen

lautet:

∧

OSe = ∑(yi –

yi)² = ∑(yi – b·xi – b0)

∧

y=

der aufgrund der Gleichung vorhergesagte y-Wert.

Voraussetzung:

Abhängige Variable y sollte für jeden Wert der

unabhängigen Variablen x normalverteilt sein

Varianz der abhängigen Variablen sollte für jeden Wert der

unabhängigen Variablen gleich sein

t=

b"#

$b

#ˆ b =

*ˆ ( y| x ) =

Uns interressiert aber wieder die mittlere quadriete Abweichung, die dem

Standardschätzfehler entspricht!

Auch hier dividieren wir durch die Freiheitsgrade:

df= n -2.

QS e

*ˆ (y|x ) =

=

n"2

=

2

(

[

1

n)xy " ()x )()y )] %

2

2

#

! & n)y " ()y ) "

2

#

n(n " 2 ) &'

n)x 2 " ()x )

$

n "1 2

! sy ! 1 " r 2 =

n"2

(

)

n

s y2 ! b 2 ! s x2

n(n " 2 )

(

)

β ist der Mittelwert des Regressionskoeffizienten und wird in der Regel Null

gesetzt

# (y | x ) " n

2

n " ! x 2 " (! x )

&

[n'xy ( ('x )('y )]2 #!

1

2

) $$ n'y 2 ( ('y ) (

2

n(n ( 2) %

n'x 2 ( ('x ) !"

Signifikanz:

tp ≥ tk , mit df= n -2

!

Beispiel:

(Wir nehmen die Werte von oben)

Hypothese:

H0 : β = 0

H1 : β≠ 0

Signifikanzniveau festlegen :

α = 0.05

Ablehnungsbereich für H0, bei α = .05, mit df = n-2 ist t ≥ 2.776

Prüfgrösse berechnen:

"ˆ b =

0.5 # 6

6 #18 $ 8 2 !

=0.185

b–0

1.5 – 0

tp = ———

= ———— = 8.12

σb

0.185

Prüfgrösse liegt im Ablehnungsbereich für H0 ; tp ≥ tk H0 verwerfen

Schlussfolgerung Je länger die Mutter am Gymnasium war, desto länger auch die

Tochter

19

für eine

Schätzung an der

Stelle xi = 1

t=

b#"

!b

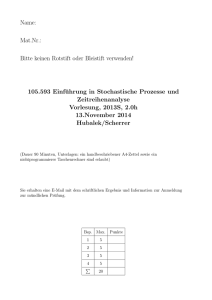

KI (oben) = yˆi + t( n " 2,% / 2) # $ˆ ( y| x ) # 1 +

KI (unten ) = yˆ i " t( n " 2,% / 2) # $ˆ ( y | x ) # 1 +

MERKE

6,00

Lineare Regression mit

95,00% Vorhersageintervall f ür Mittelwert

_

tochter = 0,50 + 1,50 * mutter

R-Quadrat = 0,94

_

4,00

tochter

Intervallskalierte Daten

Konfidenzintervall

1

n # ( xi " x ) 2

+

n n # !xi2 " (!xi ) 2

1

n # ( xi " x ) 2

+

n n # !xi2 " (!xi ) 2

_

_

2,00

_

0,00

_

0,00

1,00

2,00

3,00

mutte r

Wir sehen hier dass das KI immer breiter wird, je

weiter wir vom Mittelwert wegkommen

Die KI-Breite ist bei xi = x am kleinsten je weiter x i vom Mittelwert entfernt ist, desto breiter das KI und damit desto

ungenauer die Schätzung!

Die Genauigkeit nimmt also mit zunehmendem Abstand vom Mittelwert ab!

NOTES

20

Korrelation r

Das

Bestimmtheitsmass r²

ntervallskalierte Daten

Intervallskalierte Daten

Der Korrelationskoefizient r nach

Pearson

auch Pearson`s R

genannt

= r² beschreibt die prozentuale Verteilung der erklärten

und nicht erklärten (gemeinsame und nicht gemeinsame)

Varianzanteile.

Durch das Bestimmtheitsmass wird es uns ermöglicht zu

beurteilen, wie gut die Messpunkte durch die

Regressionsfunktion repräsentiert werden.

Dieses Mass basiert auf einer Zerlegung der

Gesamtstreuung in einen mit der Regressionsfunktion

gemeinsamen und einen nicht erklärten Anteil.

Vom Betrag her ist der Korrelationskoeffizient die

Wurzel des Bestimmtheitsmaßes.

Er verfügt jedoch über ein Vorzeichen:

-1 bis +1

(Man kann auch sagen, dass der

Korrelationskoeffizient die Effektstärke der Regression

ist)

Im Umkehrschluss ist das Bestimmtheitsmass das

Quadrat des Korrelationskoeffizienten

Das Bestimmtheitsmass berechnet sich aus:

2

# (y " yˆ )

r? =

# (y " y )

2

=

s y2 " s (2y| x )

s y2

=

2

cov 2 ( x, y )

2 sx

=

b

!

s x2 ! s y2

s y2

Der grösst möglichste Zusammenhang ergibt sich, falls alle Punkte auf der Geraden

liegen.

Das Bestimmtheitsmass liegt zwischen 0 und 1. ( 0 – 100%)

r=

n# xi yi " # xi # yi

=

[n# x " (# x ) ]! [n# y " (# y ) ]

2

2

i

2

2

i

cov( x, y )

s

= b! x

sx ! s y

sy

Beispiel:

Wir nehmen wieder die Daten der Mütter-Töchter-Studie:

6 · 31 – 8 · 15

r = ——————————— = 0.971

[6·18 – 8²][6· 55 – 15²]

√¯¯¯¯¯¯¯¯¯¯

Dies bedeutet, dass ein sehr starker Zusammenhang vorliegt.

Da der Korrelationskoeffizient positiv ist bedeutet das, dass mit steigender Anzahl Jahre

der Gymnasialzeit der Mütter die Töchter ebenfalls eine längere Gymnasialzeit haben

Der gemeinsame Varianzanteil (der durch die Regressionsfunktion erklärte Varianzanteil

= Bestimmtheitsmass) beträgt dann demzufolge 0,942841, was einer sehr hohen

Übereinstimung entspricht.

Wir können unser Ergebnis von r quadrieren und erhalten das Bestimmtheitsmass.

Bedeutsamkeit

(Hypothesenprüfung )

Zur Gewöhnung ein SPSS - Output

Korrelationen

MUTTER

TOCHTER

Korrelation nach

Pearson

Signifikanz

(2-seitig)

N

Korrelation nach

Pearson

Signifikanz

(2-seitig)

N

MUTTER

TOCHTER

1

,971(**)

.

,001

6

6

,971(**)

1

,001

.

6

6

** Die Korrelation ist auf dem Niveau von 0,01 (2-seitig) signifikant.

21

MERKE:

Voraussetzungen

für Kausalinterpretationen

X geht y zeitlich voraus

Es lässt sich ein Kausalmechanismus formulieren

Änderung von x ist von Änderungen von y begleitet

Einfluss von x auf y kann von Einflüssen anderer potentieller Variablen isoliert werden.

NOTES:

Signifikanztest

Intervallskalierte Daten

für r

Bedeutsamkeit eines

Zusammenhangs r≠ 0

Unterscheidet sich der Korrelationskoeffizient signifikant von

o?

Auch hier benutzen wir das Sechs- Punkte- Schema:

Für n > 25 gilt:

tp =

r n!2

1 ! r2

n einer Stichprobe

Hypothesen:

H0 : ρ = 0 zweiseitig

H0 : ρ ≤ / ≥ 0 einseitig

H1 : ρ ≠ 0 zweiseitig

H1 : ρ < / > 0 einseitig

α = .05

Ablehnungsbereich für H0 für α = 0.05 mit df = 4 : |t| ≥ 2.776

Prüfgrösse berechnen:

t verteilt mit df = n - 2

Signifikanz:

| tp| ≥ tk , mit df = n-2

tp =

√¯¯¯

0.971 · 6 - 2

———————

1√¯¯¯¯¯¯¯¯

– 0.971²

= 8.12

Prüfgrösse mit Kritischem Wert vergleichen: tp ≥ tk ( = 2.776) H0 ist zu verwerfen

Schlussfolgerung: Da der Korrelationskoeffizient positiv ist, können wir nun sagen, dass

die Gymnasialzeit der Töchter mit zunehmender Gymnasialzeit der Mütter signifikant

ansteigt.

Diese Grösse ist t – verteilt mit df = n -2

22

NOTES

Poweranalyse für r

Interpolation für n

Fisher`s ZTransformation

Obere Grenze kann nicht grösser

als 1 sein

Bei sehr kleinem n können die

Verteilungen asymmetrisch sein

1 $1+ r '

Z = " ln& )

2 % 1# r (

Intervallskalierte Daten

ln= 10 er - Logarithmus

Interpolation:

!

& 0.1 #

n = n.10 ' $

!+2

% Z "

Auch hier führt der Weg wieder über

die Effektstärke.

Diese entspricht genau dem

Korrelationskoeffizienten!!

Korrelationen werden bezüglich dem

Effekt wie folgt beurteilt:

.01 = kleiner Effekt

.03 mittlerer Effekt

.05 starker Effekt

Zunächst müssen wir den Fisher`s ZWert berechnen:

Dies ist nichts anderes als eine

transformierte Grösse, also eine

Standardisierung, damit wir auch im

Fall von asymmetrischen Intervallen

oder Verteilungen (kleines n) quasi

Richtwerte haben, die uns einen

Vergleich erst ermöglichen, d.h. die

uns inferenzstatistische

Berechnungen mit dem

Korrelationskoeffizienten erlaubt.

(Eine zwischen -1 bis 1 liegende

Grösse wird auf das Intervall -∞ bis

∞ transformiert)

(Nach der Transformation sind die

Grössen intervallskaliert)

z-Wert berechnen:

Z=

1 &1+ r #

( ln$

!

2 %1' r "

Wir ermitteln n mit Hilfe der Tabelle nach Cohen „ Poweranalyse für

Korrelationen mit Hilfe von t -Tests“ ( Z-Wert suchen und die

dazugehörigen n)

Für nicht tabellierte Zwischenwerte wird auch hier interpoliert:

& 0.1 #

n = n.10 ' $

!+2

% Z "

n.10 ist die Versuchspersonenzahl bei der gewünschten Power und r = 0.01

aus der Tabelle abgelesen.

23

NOTES

Intervallskalierte Daten

Konfidenzintervall

(KI)

Zunächst wieder die Fisher`s Z - Transformation,

da bei kleinem N das Intervall asymmetrisch sein

kann.

Vorteile durch Transformation:

KI für ζ

(= transformiertes ρ) ist symmetrisch

Seine Mitte liegt bei Z

Die Standardabweichung von Z beträgt

"=

1

n!3

Drei Schritte der Berechnung des KI mit dem Taschenrechner

1 &1+ r #

Z = ( ln$

!

2 %1' r "

ln = 10 er Logarithmus

Um nun wieder

Z u = Z $ z (" / 2 ) # ! z

Z o = Z + z (" / 2 ) # ! z

Korrelation

swerte zu

erhalten

muss man

hier eine Rücktransformation

durchführen

e 2 Zu ! 1

ru = 2 Zu

e +1

mit

" z =

1

n!3

zk wird aus der

Normalverteilungstabelle zur

vorgegebenen

Irrtumswahrscheinlichkeit α

herausgesucht

ro =

e 2 Zo ! 1

e 2 Zo + 1

Die nun errechneten Werte

werden in der

Schlussformulierung als die

Grenzen des KI`s

angegeben.

NOTES

24

Beispielrechnung

Gegeben:

r = 0.971

n =6

Intervallskalierte Daten

1

σz = ———— = 0.577

√¯¯¯¯¯¯

6–3

Z=

1 & 1 + 0.971 #

ln$

! = 2.110

2 % 1 ' 0.971 "

Zu = 2.110 – 1.96 · 0.577 = 0.979

Zo = 2.110 + 1.96 · 0.577 = 3.241

Rücktransformation:

man muss das Ergebnis ja in

Korrelationskoeffizienten

angeben:

2·0.979

e

-1

ru = —————— = 0.753

2·0.979

e

+1

2· 3.241

e

-1

r0 = —————— = 0.997

2·3.241

e

+1

mit einer Wahrscheinlichkeit

von 95% liegt

Korrelationskoeffizient ρ

zwischen

0.753 und 0.997.

NOTES

25

Intervallskalierte Daten

Fisher ZTransformation

Vergleich

Korrelationskoeffizient

Konstante

Vgl. zweier

Korrelationskoeffizienten

Um auch hier wieder

irgendeinen

Korrelationskoeffizienten mit

einer Konstanten oder mit

einem anderen

Korrelationskoeffizienten

vergleichen zu können, muss

das Ganze standardisiert

werden (einheitlich skaliert),

d.h. die Koeffizienten müssen

transformiert werden.

Z=

1 &1+ r #

( ln$

!

2 %1' r "

Z1 ! #

= (Z ! # ) " n ! 3

$z

ζ = transformiertes ρ

Bei genügend grossem n

normalverteilt

Z ! Z2

zp = 1

" Z1 ! Z 2

zp =

"

Z1 ! Z 2

=

1

1

+

n1 ! 3 n2 ! 3

Z = transformiertes r

bei genügend grossem n

normalverteilt

Signifikanz:

| z| ≥ zk ,dann H0 verwerfen

MERKE

Beispiel:

Wir wollen schauen, ob unser r signifikant von 0.5 verschieden ist: ( Vgl. R

mit Konstante)

Hypothese:

H0 : ρ = ζ

H1 : ρ ≠ ζ

α = 0.05

Ablehnungsbereich für H0 für α = .05 ,normalverteilt: | z| ≥ 1.96

Prüfgrösse berechnen

Z=

1 & 1 + 0.971 #

1 & 1 + 0.5 #

ln$

! = 2.110; ( = ln$

! = 0.549

2 % 1 ' 0.971 "

2 % 1 ' 0.5 "

nun müssen wir in die Formel einsetzten:

(Z ! # )"

n!3

( 2.110 – 0.549) ·

6-3 √¯¯¯

= 2.70

Vgl. zp mit zk

Da die Prüfgrösse im Ablehnungsbereich liegt wird H0 verworfen.ρ ist

signifikant von 0.5 verschieden

.

Das Verändern von Masseinheiten kann Einfluss auf den Regressionskoeffizienten haben!

Skalenveränderung: x – Achse unterschiedlich zu y- Achse: Verzerrung

Verschieben des Nullpunktes:

keine Änderung an den Koeffizienten

Grösse des Koeffizienten kann von Messeinheizen abhängen. damit Korrelationskoeffizienten vergleichbar sind : Fisher´s z-Transformation

Für standardisierte Daten ist der Regressionskoeffizient = dem Korrelationskoeffizient, wobei die Korrelationskoeffizienten der Rohdaten mit denen der

Transformierten Daten gleich sind.

Cov (zx,zy)

Cov (zx,zy)

B = ————

und

R = ————

wobei szx = 1 , szy = 1 ist , df. B = R = cov(zx, zy)

Sz ²

Sz ² · s y ²

Die Steigung der Regressionsgeraden kann bei standardisierten Daten nicht grösser als 45° (für B = r = 1) und nicht kleiner als – 45° (für B = r = -1)

sein.

26

Intervallskalierte Daten

Binomialtest

Voraussetzung:

zwei alternative Ereignisse

häufiges Wiederholen der

Untersuchung

Eine typische Binomialverteilung liegt

vor, wenn wir uns das Würfelbeispiel

anschauen

Es geht darum, die

Wahrscheinlichkeit eines der

Ereignisse zu errechnen

bei kleinem n Fisher-Yates-Exact

Test

bei grossem n χ²

µ = n" p

# = n " p " (1 ! p )

Die Form der Binomialverteilung ist

abhängig von n und p.

p=

Wahrscheinlichkeit für das

Auftreten eines Ereignisses

p<.50 linkssteil

p=.50 symmetrisch

p>.50 rechtssteil

Signifikanztest:

n *n'

p ( x"#k / n ) = + (( %% $ , 2 $ (1 ! n )n !i

i =k ) i &

Beispiele :

krank / gesund

exponiert / nicht exponiert

4Würfelbeispiel

Münzwurf

für n·p·(1-p) > 9 z- Transformation

mit

zp =

# k = n " p " (1 ! p )

k " Ek

!x

zp =

k # n "!

n " ! " (1 # ! )

µ = n " p (p = ! )

n = Anzahl auftretender Ereignisse

π = Wahrscheinlichkeit innerhalb der

Grundgesamtheit: muss gegeben sein

bei einer zweiseitigen Hypothese werden nun die entsprechenden

Ereigniswahrscheinlichkeiten beidseitig addiert (rot), bei einer einseitigen nur die auf

der entsprechenden Seite. Die Wahrscheinlichkeiten sind in Abhängigkeit zu n

tabelliert. ( Die in Tabelle angegebenen Werte müssen einfach zusammengezählt

werden)

Für kleine n wird in der Praxis der Fisher-Yates Exact –Test empfohlen, für grosse n

χ²-Tests.

27

Wenn Vorraussetzungen für t-

Test verletzt sind.

Der U –Test rechnet streng

genommen immer noch mit

intervallskalierten Werten, die

für unabhängige SPn wir jedoch auf ordinal Niveau

herabbrechen.

Es werden keine Annahmen zur

Verteilung gemacht und auch

SP SP

keine deskriptiven Werte

errechnet, deshalb non –

parametrische Tests.

U –Test von Mann

–Whitney

Für n1 und n2 < 20

1. Hypothesen aufstellen:

H0 : µU =µ0

H1 : µU ≠ µ0

2. α = 0.05

3. Kritischer Wert für α: z ≥ I 1.65I

4. Prüfwert berechnen

Rangreihe bilden

T ausrechnen

In Formel einsetzten

n1 " (n1 + 1)

! T1

2

n " (n 2 + 1)

U 2 = n1 " n 2 + 2

! T2

2

U 1 = n1 " n 2 +

n1 " (n1 + 1)

! T1 wenn n1/n2< 20 wird der kleinere

2

U- Wert mit dem kritischen U

n2 " (n2 + 1)

U 2 = n1 " n2 +

! T2 Wert aus Tabelle verglichen.

2

z=

Wenn n1/n2 > 20 mit zTransformation und dem

grösseren U-Wert rechnen

U " µU

!U

"U =

wenn...n1 # n2 :

µU =

z=

| U " µU | "0.5

!U

Gruppe2

x1

R1

x2

R2

3

1

17

7

8

2

20

9

10

3.5

40

12.5

10

3.5

48

14

15

5

53

15

16

6

55

16

20

9

61

17

20

9

72

18

21

11

40

12.5

Für n1 +n2 < 20 :

U 1 = n1 " n2 +

wenn n1 und n2 > 20:

Gruppe 1

n1 ! n2 (n1 + n2 + 1)

12

n1 ( n2 & n 3 ' n k t 3 + t #

!!

($

')

n(n ' 1) $% 12

i =1 12 "

t = Anzahl Personen, die sich einen

bestimmten Rangplatz teilen

k= Anzahl verschiedene Gruppen mit

verbundenen Rängen

T2 = 108.5

und dann die entsprechenden Rangplätze zuordnen.

Danach wieder auf zwei Spalten verteilen und die jeweilige

Rangsummen ( T1 und T2) errechen.

Dann U1 und U2 berechnen:

10·(10 + 1)

U1 = 10·8+—————— -62.5

=72.5

2

8·(8+1)

U2 = 10·8+ —————— - 108.5 =7.5

2

Dann die deskriptiven Werte berechnen:

10 ! 8

= 40

2

10 ! 8 ! (10 + 8 + 1)

"U =

= 11.26

12

n1 ! n 2

2

mit verbundenen Rängen:

* U korr =

T1 = 62.5

Die Messwerte beider Gruppen in eine Reihe bringen

µU =

U - µU

z= ————

σU

Für uns ist der grössere der beiden

U - Werte wichtig !!!!!!!!!!!!!!!!!!!!!!!

72.5 - 40

Z = ———— = 11.26 zp > zk H0 wird verworfen

11.26

Berechnung des t :

im obigen Bsp. Kommen die Werte 10, 20, 40, mehrfach vor.

10 kommt 2 mal vor

20 kommt 3 mal vor

40 kommt 2 mal vor

Daraus ergibt sich: zweimal wird ein Rang doppelt belegt, einmal dreifach:

∑ 2 ·(2³ -2) + 1· ( 3³ -3)

28

Wilcoxon TTest

für

abhängige

SPn

Für grosse SPn

⇓

Voraussetzungen:

wenn Voraussetzungen für tTest nicht erfüllt

Differenzwerte sollten in der

Population symmetrisch

verteilt sein

bei Normalverteilung t-Test

nur symmetrisch verteilt

Wilcoxon

Wenn Differenzwerte

asymmetrisch verteilt

Vorzeichentest

Ausreisser nach beiden

Verteilungsästen

Vorzeichentest

Daten müssen intervallskaliert

sein

Beispiel:

Bis n= 33 sind die kritischen Werte

tabelliert!!!

wir müssen also bis n = 33 nicht

rechnen, sondern nur in Tabelle

nachschauen.

B

Rang R

R+

R-

B

8

15

-7

6

6

4

7

-3

4

4

Nulldifferenzen werden vom Gesamt N

abgezogen.

17

17

0

12

13

-1

1.5

1.5

Gibt es mehrere Nulldifferenzen, so

werden diese alle mit dem Rangplatz

(p+1)/2 belegt und je zur Hälft R+ und Rzugeordnet.

10

8

2

3

3

13

13

0

3

2

1

1.5

1.5

Vorgehen:

Für jede VP wird die Differenz der beiden

Werte errechnet

Den Beträgen ( ohne Vorzeichen) werden nun

Ränge zugeordnet

Differenzen von 0 werden nicht berücksichtigt

die kleinste Differenz erhält Rang 1, die

grösste Np = n – Anzahl Nulldifferenzen

In die Spalte R+ werden alle positiven Ränge

(hier gilt das Vorzeichen des Differenzbetrags)

eingetragen, in R- alle negativen.

Der gesuchte Prüfwert Tp entspricht dem

kleineren der beiden Ts

7

18

-11

8

8

8

12

-4

5

5

6

14

-8

7

7

Signifikanz:

wenn Tp≤ Tk , kann H0 verworfen

werden

Ordinale Daten

D=AA

Np= 8

ohne

T1=4.

Nulldiffere

5

T2=31.5

nzen

T = Die Summe der jeweiligen Rangplätze. Der kleinere der beiden

Werte ist für uns entscheidend.

N = Summe der Gesamtrangplätze, ohne Nulldifferenzen

Hypothesenüberprüfung:

1. H0: µ1 =µ2

H1 :µ1 ≠µ2

2.α = 0.05 / 0.01

3.Ablehnungsbereich für H0: für n < 33 in Tabelle

nachschauen; für`das Beispiel: Tk = 3

4.Tp ermitteln: Tp ist für uns der kleinere der beiden

T –Werte, die sich aus der obigen Tabelle ermitteln liessen.

5. Tp mit Tk vergleichen. Wenn Tp ≤ Tk dann kann H0

verworfen werden. ( Im Beispiel ist Tp = 4.5 keine

Signifikanz,H0 wird beibehalten)

6. Schlussfolgerung

29

Zum Wilcoxon –

Test

SPn mit grossem N

Berechnung für

grosse Stichproben

k

Hypothesenprüfung bei grossen Stichproben: Als Beispiel rechnen

wir zwar auch mit n = 8,

dies dürften wir in der Realität jedoch nicht machen!!!!!

1. Hypothesen aufstellen.

2. α festlegen = 0.05

3. Ablehnungsbereich festlegen: z = I 1.96 I;

I zP I ≥ 1.96

4. (Wir müssen nun mit dem z – Wert rechnen,

da wir bei hohem N uns der

Normalverteilung angleichen !!!!!!!!)

Berechnen des kritischen Wertes: Dazu müssen wir die

deskkriptiven Werte berechnen.

8·(8+1)

µT =———— = 18

4

j =1

#T =

Deskriptive Werte:

n p (n p + 1)

µT =

4

np = N des kleineren T- Wertes

!T

n p (n p + 1)(2n p + 1)

24

Tritt eine grössere Anzahl verbundener Ränge

auf, so muss σ korrigiert werden:

n p (n p + 1)(2n p + 1) + ! (t i3 " t i ) / 2

#T =

24

ti = siehe Einschub

Für 33 < n < 60 :

( Annäherung an Normalverteilung)

| T " µ T | "0.5

z=

!T

8(8 + 1)(2 " 8 + 1)

= 7.14

24

| T ! µ T | 4.5 ! 18

z=

=

= 1.89

#T

7.14

5. Da zP nicht ≥ 1.96 muss H0 beibehalten werden.

6. Interpretation des Ergebnisses.

Die Schreibstile unterscheiden sich nicht von einander.

Für n > 60 gilt:

z=

| T " µT |

!T

Ordinale Daten

Signifikanz

zp ≥ zk; dann H0 verwerfen

Einschub: Wie komme ich zu ti?

Der Rangplatz 1.5 tritt 2-mal auf.

damit ist t = 2

Dies ergäbe in unseren Beispiel für ∑ (t³ - t)

(2³ -2) .Gibt es nun mehrere Ränge, die 2mal vorkommen ,

so multipliziert man vor Klammer mit diesem Faktor : x · ( 2³

- 2)

Der eigentliche Rangplatz tut nichts zur Sache. Es geht nur

darum wie oft Rangplätze belegt sind und wie oft

unterschiedliche Rangplätze gleich oft belegt sind.

30

Voraussetzungen:

Korrelationen für

ordinalskalierte

Daten

unabhänge

Stichproben

Pearsonkorrelation

abhängige

Stichproben

Überpüfung einer

Zusammenhangshypothese

Variablen müssen mindestens

ordinalskaliert sein

kleiner Stichprobenumfang

Verteilungsform nicht klar ersichtlich

Für unabhängige Variablen

berechnet sich der

Spearman´sche

Korrelationskoeffizient wir der

Pearson´sche.

Für abhängige Variablen gilt:

Wir müssen hier Rangreihen

bilden und deren Differenz

errechnen (siehe Tabelle

nebenan). Bei gleichen Werten

wird derselbe Rang vergeben.

Die Summe der quadrierten

Differenzen bildet unseren

Ausgangswert zur Berechnung

der Prüfgrösse.

Spearman´sche

Rangkorrelation

rs = 1 !

6 " # D2

n3 ! n

Ordinale Daten

zur Signifikanzüberprüfung:

Kendall´s τ

⇓

Siehe

32

t = rs

n!2

1 ! rs2

Signifikanz:

| tp| ≥ tk , mit df = n – 2

Für unabhängige SPs gilt die Formel des Pearson´s r:

Zunächst Rangreihen bilden, dann die Differenzen der Ränge und diese

dann in die Pearson´sche Formel einsetzten.

r=

n# xi yi " # xi # yi

=

[n# x " (# x ) ]! [n# y " (# y ) ]

2

2

2

2

i

i

cov( x, y )

s

= b! x

sx ! s y

sy

Für abhängige SPs gilt : Beispiel

Mutter (x)

Tochter (y)

Rang x

Rang y

D= Rx - Ry

D²

0

0

1,5

1

0,5

0,25

0

1

1,5

2

-0,5

0,25

1

2

3

3

0

0

2

3

4,5

4

0,5

0,25

2

4

4,5

5

-0,5

0,25

3

5

6

6

0

0

∑x= 15

∑y = 21

∑D = 0

∑D² = 1.00

rs = 1 !

6 " # D2

n3 ! n

Zur Signifikanzüberprüfung :

Für n < 30 kann errechneter Wert direkt mit kritischem aus Tab.9

Coolican verglichen werden

Für n> 30 : Prüfgrösse muss berechnet werden

t p = rs

n!2

1 ! rs2

t-verteilt mit df = n – 2

dann wieder in der t-Tabelle nachschauen und die Werte vergleichen.

31

Kendalls τ

τ ist ebenfalls ein Mass um

Zusammenhänge ordinalskalierter

Daten zu beschreiben. Im

Gegensatz zu Spearman behandelt

Kendall´s τ nur Ordinaldaten

-1 < τ < +1

für n < 40 :

"=

P!I

n(n ! 1) / 2

P = Anzahl Proversionen

I = Anzahl Inversionen

n = Anzahl Zeilen der Tabelle

Ordinale Daten

Für n > 40 :

z=

P!I

n(n ! 1)(2n + 5)

18

Beispiel:

Vorgehen :

Für jede Variable eine Rangreihe bilden

Eine der beiden Reihen wird als Ankerreihe verwendet

Die andere Rangreihe ist die Vergleichsreihe

Für jeden Rangplatz der Vergleichsreihe wird überprüft, ob die folgenden Ränge

höher (+) oder niedriger (-) sind.

Anzahl Proversionen (+) und Inversionen(-) dann in die Formel einfügen

x

6

5

15

9

2

y

7

4

11

14

10

R(X)

3

2

5

4

1

7-3

τ = ————— = 0.4

5·(5-1)/2

R(Y)

2

1

4

5

3

R´x

1

2

3

4

5

R`y

3

1

2

5

4

R`y

3

3

3

3

1

1

1

2

2

5

∑R´y

1

2

5

4

2

5

4

5

4

4

(-)

(-)

( +)

(+)

(+)

(+)

(+)

(+)

(+)

(-)

NOTES

32

Vorraussetzungen:

χ² - Goodness of

Fit

Nominale Daten

SP POP

Zufallsstichprobe

Nominalskalierte Daten

jede Beobachtung ist genau

einer Kategorie zugeordnet

Die erwarteten absoluten

Häufigkeiten sollten mind. 5 sein

Beobachtete Häufigkeit

Erwartete Häufigkeit

Relativ

Relativ

Persönlichkeitsmerkmal

Goodness of fit –Test ist auch ein

Anpassungstest. Es wird geschaut,

wie angepasst die SP-Verteilung an

eine Normalverteilung ist

( fb- – fe)²/fe

absolut fb

absolut fe

A

0.50

30

0.67

40

3.33

B

0.25

15

0.08

5

6.67

C

0.25

15

0.25

15

0.00

n = 60

χ²= 10.00

Absolute und relative Häufigkeiten der Persönlichkeitsmerkmale A, B, C

Das was wir errechnen müssen. Häufig müssen auch noch entweder die absoluten aus den relativen

oder die relativen aus den absoluten Häufigkeiten errechnet werden. 〈 ( fb- fe)/fe gibt die mittlere

quadrierte Abweichung einer jeden Gruppe an〉. ( In den Tabellen, die wir von Stöcklin bekommen

fehlt

die graue Spalte selbst hinzufügen)

Beispielrechnung

( fb " fe )2

# =!

fe

2

mit fb , fe als beobachtete bzw.

vorhergesagte absolute Häufigkeiten.

Bei hinreichend grossem n χ² verteilt ,

mit :

df = k – 1; k = Anzahl Kategorien

Signifikanz

χ²p ≥ χ² k dann H0 verwerfen.

Gegeben : Relative Häufigkeiten ( siehe Tabelle)

Hypothesen aufstellen

α festlegen

χ²k aus Tabelle ermitteln, mit df = k-1

Gegebene Tabelle u absolute Häufigkeiten

Erweitern ( rosa markiert). Meist gibt Herr

Stöcklin die relativen Häufigkeiten an . Aber hier

aufpassen !!!!!

fe = erwartete relat. Häufigk. x n (/ 100)

fb = beobachtete rel. Häufigk. x n ( /100)

relativ. Häufigkeiten = absolute Häufigk. / n x 100

5.

∑ (fb – fe)² / fe = χ²p

6.

χ²p mit χ²k vergleichen. χ²p ≥ χ² k dann H0 verwerfen.

33

Vorraussetzungen:

Vierfelder χ2 – Test

Unabhängiger

Stichproben

SP SP

Zufallsstichproben

Nominalskalierte Daten

Dichotom gestufte Variablen.(

Dh. Es gibt jeweils zwei

Möglichkeiten einer Zuordnung)

Die erwarteten absoluten

Häufigkeiten sollten mind. 5 sein

Beachte:

χ² - Test sollte nicht für n< 20

verwendet werden.

(SPSS bietet uns den Fisher

Exakttest)

Nominale Daten

Signifikanz

Wenn χ²p ≥ χ²k, dann H0

verwerfen.

Beispiel: Untersuchung von geschlechtsspeziefischem Rauchverhalten,

das heisst: Unterscheiden sich die relativen Häufigkeiten der Rauchenden bei Männern und Frauen?

Geschlecht

Raucher

Nichtraucher

Total

Männer

14

36

50

Frauen

8

32

40

Absolute Häufigkeiten der Raucher und

Nichtraucher

Hypothesen aufstellen:

H0 : Relative Häufigkeiten der

Rauchenden bei Männern und

Total

22

68

90

unterscheiden sich nicht.

H1: Rel. Häufigk. der rauchenden Männer und Frauen unterscheiden sich.

α festlegen

Ablehnungsbereich : χ²k aus Tabelle ermitteln mit df= k-1

Auch hier interessieren uns die erwarteten Häufigkeiten:

Wir müssen also zunächst mal umsortieren

4. Prüfgrösse berechnen:

Frauen

Berechnung der Prüfgrösse für unser Beispiel:

Die erwarteten Häufigkeiten berechnen sich allgemein durch:

fe = Zeilensumme x Spaltensumme / n

Beispiel für erste Zeile: 50 x 22 / 90 = 12.222

50 x 68 / 90 = 37.778 ; mit der zweiten Zeile analog verfahren

Errechnen von ( fb-fe)²/ fe : für die erste Zeile: (14 – 12.222)² / 12.222 = 0.259

Geschlecht

Rauchverhalten

fb

fe

(fb – fe)² / fe

Männer

Raucher

14

12.222

0.259

Männer

Nichtraucher

36

37.778

0.084

Frauen

Raucherinnen

8

9.778

0.323

Frauen

Nichtraucherinnen

32

30.222

0.105

χ² = 0.771

5. χ²p mit χ²k vergleichen: χ²p ≥ χ²k , damit H0 verworfen werden kann.

6. Schlussfolgerung bzw. Interpretation.

34

NOTES

Mc Nemar

Nominale Daten

χ² - Test für

abhängige SPs

Zweimalige Messung eines

dichotomen ( alternativen )

Merkmals

(b-c)²

χ² = ————

b+c

( | b-c | - 1)²

χ² = ————

b+c

Signifikanz:

χp² ≥ χk²

für b+c >30

für b+c < 30

Untersuch 1

Beispiel

Untersuch 2

M1

+

-

+

a

b

-

c

d

Unter H0 geht man davon aus, dass gleich viele

Probanden von „+“ nach „-„ wechseln und

umgelehrt.

Frage: Unterscheidet sich die Differenz zweier

Prozentwerte aus abhängigen Stichproben

signifikant?

a+b

a+c

P1 = ————— ·100% ; P2 = ———— · 100%

n

n

Dies sind die Wahrscheinlichkeiten unter H0

exponiert und z.B. krank zu sein:

a+b · a+c

P(e∧k) = —————

n

N ist hier die Gesamtstichprobengrösse

M2

bestanden

Nicht

best.

Bestanden

a =35

b=5

Nicht best.

c = 20

d = 10

Uns interessiert nur die Diagonale c +b in der

keine Übereinstimmung stattfindet. A und d

bleiben unverändert.

1.Wir müssen nun wieder die erwarteten

Häufigkeiten errechnen:

fe = (b+c) / 2

Unter H0 erwartet man, dass die Zellen b und c

gleichbesetzt sind.

( | 5 – 20 | - 1)²

χ² = ——————— = 7.84

5+20

χ² k = 3.84,mit df = 1 bei α = 0.05

χ² p ≥ χ²k

35

Zusammenhangsmasse für Vierfelder

χ² -Test

( man kann mit dem

Vierfelder χ² -Test also nicht

nur Unterschiedshypothesen

überprüfen, sondern auch

Zusammenhänge dichotomer

Variablen)

Hier wird geschaut, ob es

einen Zusammenhang gibt.

Für die Stärke des

Zusammenhangs benötigt

man die Assoziationsmasse:

Stärke eines

Zusammenhangs

Nominale Daten

Phi - φ:

Assoziationsmass

(Zusammenhangsmasse =

Kontingenzmass)

Für 2 x 2 Tabellen

Für n< 20 sollte der Fisher Exakttest von

SPSS benutzt werden.

Für 20 < n < 60 gilt:

n(| a ! d " b ! c | "n / 2)?

# 2 (r ?) =

(a + b)(c + d )(a + c)(b + d )

n( a ! d " b ! c )

r=

(a + b)(c + d )(a + c)(b + d )

Wir haben es hier mit einer

Kontiguitätskorrektur zu tun.Man bildet die

Prüfgrösse so in einer kontinuierlichen

Verteilung ab, obwohl sie diskret abgebildet

ist.

In den Büchern wird r angegeben, nicht χ²,

dh. Wir müssen für r noch die Wurzel aus

dem Ganzen ziehen: Für Stöcklin würde ich

Sicherheits halber mit χ² rechnen.

Für n < 60 gilt:

# 2 (r ?) =

"=

n(a ! d " b ! c)?

(a + b)(c + d )(a + c)(b + d )

Gibt die Art des Zusammenhangs an, bzw.ob überhaupt einer besteht:

Beispiel: allgemein

a

c

a+c

b

d

b+c

a +b

c+ d

n

In dieser Form können wir uns die Zusammenhänge klarer machen.

Es ist nötig, dass die Daten in einer Vierfeldertafel vorliegen.

Weitere Voraussetzungen sind:

Unabhängige Zufallsstichprobe

Jede Beobachtung wird genau einer Kategorie zugeordnet

Die erwarteten absoluten Häufigkeiten solltenmind. 5 sein

NOTES

Es gibt noch andere Assoziationsmasse ( Kontingenzkoeffizient,Kramers V).

Für 2x2 Tabellen eignet sich jedoch am besten das φ.

Gibt die Stärke des Zusammenhangs an !!!!

Alle Assoziationsmasse sind direkt von n abhängig!!!!!!

!2

n

36

Voraussetzung:

k x l - χ² Test

Zusammenhangsüberprüfung:

Siehe nächste Seite

⇓

⇓

Mehrfachgestufte Variablen, nominal

skaliert

Unabhängige Zufallsstichproben

Jede Beobachtung wird genau einer

Kategorie zugeordnet

Die erwarteten Häufigkeiten sollten

mindestens 5 sein

Vorgehen:

Hypothesen aufstellen

α festlegen

Ablehnungsbereich für H0 suchen in

Tabelle bei df = (k-1)(l-1)

K= Kategorien/ Spalten

L = Zeilen ( bezogen auf die Tabelle ohne

zu erwartende Werte)

4. Prüfgrösse errechnen: siehe

nebenan

5. Prüfgrösse mit kritischem Wert

vergleichen

6. Schlussfolgerung

Zeilensumme x Spaltensumme

fe = ——————————————

n

(fb – fe)² / fe

Nominale Daten

Signifikanz:

χp² ≥ χk²

Beispiel:

Unterscheiden sich Jugendliche verschiedener Altersklassen in der Art ihrer Rohrschachdeutungen?

Beobachtete absolute Häufigkeiten

Beobachtete absolute Häufigkeiten

Altersklasse

Deutungsart

Total

Mensch

Tier

Pflanze

10 – 12 J.

12

80

30

122

13 – 15

20

70

50

140

16 - 18

35

50

30

115

19 - 21

40

55

28

123

107

255

138

500

Wir müssen nun wieder die erwarteten absoluten Häufigkeiten

Zeilensumme x Spaltensumme

fe = ——————————————— über alle Zeilen und Spalten hinweg !!!!

n

und (fb – fe)/fe errechnen. Dies geht genauso, wie bei Vierfeldertest: Wir müssen die Tabelle umkonstruieren

Alter

Deutung

fb

fe

(fb – fe)² / fe

10-12

Mensch

12

26.108

7.624

10-12

Tier

80

62.220

5.081

10-12

Pflanze

30

33.627

0.391

13-15

Mensch

20

29.960

3.311

13-15

Tier

70

71.400

0.027

13-15

Pflanze

50

38.640

3.340

16-18

Mensch

35

24.610

4.387

16-18

Tier

50

58.650

1.276

16-18

Pflanze

30

31.740

0.095

19-21

Mensch

40

26.322

7.108

19-21

Tier

55

62.730

0.953

19-21

Pflanze

28

33.948

1.042

χ² =34.64

Nun gilt es noch χk² aus der Tabelle zu suchen: mit df = (k-1)(l-1)

und mit χp² zu vergleichen. (Hier wäre es dann: (3-1)(4-1)= 6 zu errechnen aus

χp² ≥ χk² , dann kann H0 verworfen werden

Wichtig: Für df > 1 lassen sich keine einseitigen Hypothesen berechnen

der ersten Tabelle

37

Zusammenhangsüberprüfung

Stärke eines

Zusammenhangs:

r!( " !) = $ $

fe

:Kramers V

⇓

V =

Nominale Daten

2

Der Vollständigkeit halber sei C hier

genannt, aber für uns besser

!

Kontingenzkoeffizient

C

Assoziationsmass

(entspricht den

Korrelationsmassen)

( fb # fe )

#2

N " ( N ! L)

Im Prinzip ist genau das Gleiche wie wenn ich Unterschiede darstelle. Entscheidend auch für

!2

oder nicht. Hier

! +n

beschreibe ich, ob es überhaupt einen Zusammenhang gibt oder eben nicht. Dann kann

auch die Art des Zusammenhangs beschrieben werden, wie schon bei der Regression.

χ² ist der errechnete Prüfwert !!!!!!

Auch hier ist die Korrelation direkt von n abhängig.

mit einer Erhöhung von n kann Einfluss auf den Zusammenhang genommen werden.

den Zusammenhang ist, ob das Ergebnis signifikant ist C =

Merke

2

Alle Zusammenhangsmasse sind auch Effektstärken!!!!!!!

χ², ϕ, r, C, V,….

(Beschreibt die Stärke bzw. die

Enge des

Zusammenhangs)

Kramers V

NOTES

38

Poweranalyse für

nominalskalierte

Daten

Der Weg geht auch hier wieder über die

Effektstärke:

Ohne Zwischenergebnisse, mit der Formel nach

Cohen:

W =

m

!

Nominale Daten

i =1

NOTES

( P1i " P0i )

P0i

P0i = Wahrscheinlichkeit unter H0 Element von

Zelle 1 zu sein

P1i = Wahrscheinlichkeit, unter H1 Element von

Zelle i zu sein

Mit Zwischenergebnis:

W =

!2

n

39