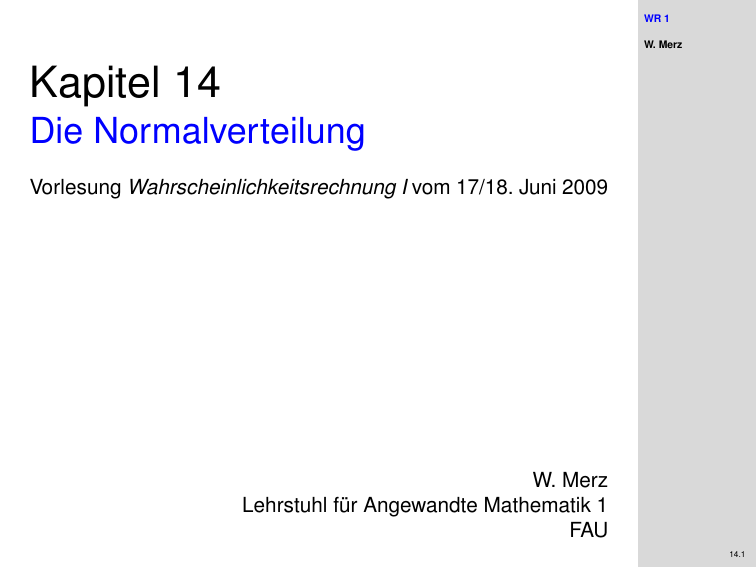

Die Normalverteilung

Werbung

WR 1 W. Merz Kapitel 14 Die Normalverteilung Vorlesung Wahrscheinlichkeitsrechnung I vom 17/18. Juni 2009 W. Merz Lehrstuhl für Angewandte Mathematik 1 FAU 14.1 Die standardisierte Normalverteilung WR 1 W. Merz Definition Die eindimensionale Verteilung P0 mit der Dichte t2 1 ϕ(t) = √ e− 2 2π heißt die standardisierte Normalverteilung oder N (0, 1)-Verteilung. Mittelwert m1 (P0 ) = R tϕ(t)dt = 0 Varianz m̂2 (P0 ) = m2 (P0 ) = R t 2 ϕ(t)dt = 1 Bezeichnung Eine N (0, 1)-verteilte Zufallsvariable heißt eine Gaußsche Einheitsvariable 14.2 WR 1 Lineare Transformation W. Merz P X sei die Verteilung der Zufallsvariablen X (t) = σt + µ mit σ 6= 0 auf dem Wahrscheinlichkeitsraum (R, B, P0 ) mit der N (0, 1)-Verteilung P0 . X (R, B, P0 ) −→ (R, B, P X ) Mittelwert von P X Z Z m1 (P X ) = EX = X (t)P0 (dt) = (σt + µ)ϕ(t)dt Z Z = σ tϕ(t)dt + µ ϕ(t)dt = σ · m1 (P0 ) + µ · 1 = µ 14.3 WR 1 Lineare Transformation W. Merz X X (R, B, P0 ) −→ (R, B, P ) Varianz von P X m̂2 (P X ) = var(X ) = E(X − EX )2 Z 2 = E(X − µ) = (X (t) − µ)2 P0 (dt) Z Z = (σt + µ − µ)2 ϕ(t)dt = σ 2 t 2 ϕ(t)dt = σ 2 · m̂2 (P0 ) = σ 2 14.4 WR 1 Lineare Transformation W. Merz Dichte von P X : Nach dem Transformationssatz besitzt ein Zufallsvektor G(x) = Ax + b die Dichte g(y ) = 1 f A−1 (y − b) | det(A)| Spezialfall der Dimension 1: X (t) = At + b mit A = (σ) und b = (µ), also det(A) = σ, A−1 = ( σ1 ) P X besitzt die Dichte 2 1 1 1 1 f (x) = ϕ (x − µ) = √ e− 2σ2 (x−µ) |σ| σ 2πσ 2 14.5 WR 1 Die eindimensionale Normalverteilung W. Merz Definition Die eindimensionale Verteilung mit der Dichte f (x) = √ 1 2πσ 2 1 e− 2σ2 (x−µ) 2 heißt die Normalverteilung mit Mittelwert µ und Varianz σ 2 oder kurz N (µ, σ 2 )-Verteilung. 14.6 Normalverteilte Zufallsvariable WR 1 W. Merz Theorem Ist X eine N (µ, σ 2 )-verteilte Zufallsvariable auf einem Wahrscheinlichkeitsraum (Ω, A, P), so ist 1 E = √ (X − µ) σ2 eine Gaußsche Einheitsvariable. 14.7 WR 1 Normierte Zufallsvariable W. Merz Generell gilt: Theorem Ist X eine Zufallsvariable auf einem Wahrscheinlichkeitsraum (Ω, A, P) und 1 Y =p (X − EX ) var(X ) so gilt EY = 0 und var(Y ) = 1. Beweis. EY = E = 1 p var(X ) ! (X − EX ) 1 =p E(X − EX ) var(X ) 1 p (EX − EX ) = 0 var(X ) 14.8 WR 1 Normierte Zufallsvariable W. Merz Beweis. var(Y ) = ! p (X − EX ) var(X ) !2 1 p var(X − EX ) var(X ) = var = 1 1 var(X ) = 1 var(X ) 14.9 WR 1 Beweis des Theorems W. Merz X (Ω, A, P) - (R, B, P X ) HH HH H HH E =G◦X G H HH j H ? (R, B, P E ) y = G(x) = √1 (x σ2 − µ) = Ax + b mit A = ( √1 2 ) und b = (− √µ 2 ). σ ∗ G :y = √1 (x σ2 σ − µ) ⇒ x= √ σ2 y + µ 14.10 Beweis des Theorems √ 1 x = σ 2 y + µ, det(A) = ( √ ) σ2 WR 1 W. Merz Nach dem Transformationssatz besitzt P E = P G die Dichte g(y ) √ √ 1 f A−1 (y − b) = σ 2 f ( σ 2 y + µ) | det(A)| √ √ 2 1 2 1 2 1 1 = σ2 √ e− 2σ2 ( σ y +µ−µ) = √ e− 2 y 2 2π 2πσ = D.h. E ist eine Gaußsche Einheitsvariable. Folgerung Zu jeder N (µ, σ 2 )-verteilten Zufallsvariablen X gibt es eine √ Gaußsche Einheitsvariable E mit X = σ 2 E + µ 14.11 WR 1 Der Zentrale Grenzwertsatz W. Merz Unter welchen Voraussetzungen kann in der Praxis angenommen werden, dass eine Zufallsvariable zumindest näherungsweise normalverteilt ist? Definition Y1 , Y2 , Y3 , . . . sei eine Folge von Zufallsvariablen auf einem Wahrscheinlichkeitsraum (Ω, A, P) mit Verteilungen P Yn und Verteilungsfunktionen Fn (t) = P Yn (−∞, t] = P(Yn ≤ t) Konvergieren diese Verteilungsfunktionen für alle Argumente t gegen die Verteilungsfunktion der N (0, 1)-Verteilung: limn→∞ Fn (t) = Φ(t) = √1 2π Rt s2 e− 2 ds −∞ so sagt man, dass für die Folge dieser Zufallsvariablen der Zentrale Grenzwertsatz (ZGS) gilt. Verteilungskonvergenz: Nicht die Zufallsvariablen, sondern ihre Verteilungen konvergieren. Für „große“ n kann man annehmen, dass Yn näherungsweise normalverteilt ist. 14.12 Normierte Partialsummen WR 1 W. Merz Für welche Folgen von Zufallsvariablen gilt der Zentrale Grenzwertsatz? Klassischer Fall: Normierte Partialsummen. X1 , X2 , X3 , . . . stochastisch unabhängige Zufallsvariable, die alle die gleiche Verteilung besitzen. EXk = µ und var(Xk ) = σ 2 für alle k . Die Partialsummen: Sn = X1 + X2 + · · · + Xn besitzen die Erwartungswerte µn = ESn = nµ und die Varianzen σn2 = var(Sn ) = nσ 2 . Für die Folge der normierten Partialsummen 1 1 (Sn − nµ) Sn∗ = p (Sn − µn ) = √ 2 σn nσ 2 gilt der Zentrale Grenzwertsatz. 14.13 WR 1 Der Grenzwertsatz von Moivre und Laplace W. Merz Berechnung von Wahrscheinlichkeiten bei der Binomialverteilung. X1 , X2 , . . . seien stochastisch unabhängige Zufallsvariable, die nur die Werte 0 und 1 mit P(Xk = 1) = p und P(Xk = 0) = 1 − p annehmen. Dann ist Sn = X1 + X2 + . . . + Xn binomialverteilt: P(Sn = k ) = m X n k n k p (1−p)n−k , P(Sn ≤ m) = p (1−p)n−k k k k =0 Wegen ESn = np und var(Sn ) = np(1 − p) ist 1 (Sn − np) Sn∗ = p np(1 − p) und m − np Sn ≤ m ⇔ Sn∗ ≤ p np(1 − p) 14.14 WR 1 Der Grenzwertsatz von Moivre und Laplace W. Merz Für „genügend große“ n gilt daher m X n k =0 k pk (1 − p)n−k = P(Sn ≤ m) = P ≈ Φ Sn∗ ≤ p m − np ! np(1 − p) ! m − np p np(1 − p) Statistische Faustregel: Gute Approximation für np(1 − p) ≥ 9 14.15 Der Grenzwertsatz von Moivre und Laplace WR 1 W. Merz Exercise Bei einer Prüfung werden vierzig Fragen gestellt, die nur mit „ja“ oder „nein“ zu beantworten sind. Die Prüfung ist bestanden, wenn mehr als dreißig Fragen richtig beantwortet werden. Wie groß ist die Wahrscheinlichkeit, dass man diese Prüfung nur durch Raten der richtigen Antworten besteht? Raten bedeutet, dass man eine Frage mit Wahrscheinlichkeit p = 1/2 richtig beantwortet. Die Anzahl Sn der richtig beantworteten Fragen ist dann binomialverteilt mit Parametern n = 40 und p = 1/2. Wegen np(1 − p) = 10 kann man den Grenzwertsatz von Moivre und Laplace verwenden. P(Sn > 30) 30 − 1/2 40 √ = 1 − P(Sn ≤ 30) = 1 − P Sn∗ ≤ 10 √ 10 ≈ 1−Φ √ = 1 − Φ( 10) ≈ 0.0008 10 14.16 Die n-dimensionale Normalverteilung WR 1 W. Merz Die Verteilung eines Zufallsvektors E = (E1 , E2 , . . . , En ) mit stochastisch unabhängigen N (0, 1)-verteilten Komponenten besitzt die Dichte ϕn (y1 , y2 , . . . , yn ) = ϕ(y1 )ϕ(y2 ) · · · ϕ(yn ) n 2 2 2 1 1 √ e− 2 (y1 +y2 +···+yn ) = 2π Definition Die n-dimensionale Verteilung Pn mit dieser Dichte heißt die n-dimensionale standardisierte Normalverteilung Bezeichnung Ein Zufallsvektor E mit dieser Verteilung heißt ein Gaußscher Einheitsvektor. 14.17 Vektorschreibweise x = WR 1 W. Merz x1 x2 .. . x > = (x1 , x2 , . . . , xn ) xn Skalarprodukt: x > y = x1 y1 + x2 y2 + · · · + xn yn q √ Euklidische Norm: kxk = x > x = x12 + x22 + · · · + xn2 Dichte: ϕn (y ) = √1 2π n 1 e− 2 y > y = √1 2π n 1 e− 2 ky k 2 14.18 WR 1 Affin lineare Transformationen W. Merz Bestimmung der Verteilung des Zufallvektors X (y ) = Ay + b auf dem Wahrscheinlichkeitsraum (Rn , Bn , Pn ). X1 (y ) X2 (y ) .. . Xn (y ) = a11 a21 .. . a12 a22 .. . an1 an2 . . . a1n . . . a2n .. .. . . . . . ann y1 y2 .. . + yn b1 b2 .. . bn Ist die Matrix A nichtsingulär, so besitzt gemäß Transformationssatz die Verteilung von X die Dichte f (x) = 1 ϕn A−1 (x − b) | det(A)| 14.19 Affin lineare Transformationen WR 1 W. Merz 1 f (x) = ϕn A−1 (x − b) | det(A)| Mit der Transponierten A> der Matrix A ist p p p | det A| = pdet(A)2 = det(A) det(A) = det(A) det(A> ) p = det(AA> ) =: det(C) Aus den Rechenregeln für Matrizen folgt weiter ||A−1 (x − b)||2 > −1 A−1 (x − b) A (x − b) > −1 = (x − b)> A−1 A (x − b) −1 = (x − b)> A> A−1 (x − b) −1 = (x − b)> AA> (x − b) = = (x − b)> C −1 (x − b) 14.20 WR 1 Die n-dimensionale Normalverteilung W. Merz Dichte von P X : f (x) = 1 √ 2π n 1 p det(C) 1 e− 2 (x−b) > C −1 (x−b) Theorem Ist C eine symmetrische und positiv definite n × n-Matrix und b ein n-dimensionaler reeller Spaltenvektor, so ist die Funktion f (x) eine Wahrscheinlichkeitsdichte. Definition Die Verteilung mit der Dichte f (x) heißt die n-dimensionale Normalverteilung mit Parametern b und C oder kurz N (b, C)-Verteilung. 14.21 WR 1 Beweis des Satzes W. Merz Für Matrizen von der Form C = AA> mit einer nichtsingulären n × n-Matrix A wurde die Behauptung dadurch bewiesen, dass f (x) die Dichte der Verteilung des Zufallsvektors X (y ) = Ay + b ist. Man muss sich also nur noch überlegen, dass jede symmetrische und positiv definite Matrix C eine Zerlegung der Form AA> besitzt. C besitzt n positive reelle Eigenwerte λ1 , λ2 , . . . , λn mit zugehörigen orthonormierten Eigenvektoren u1 , u2 , . . . , un : Cuk = λk uk 14.22 WR 1 Beweis des Satzes W. Merz Zusammenfassen der Eigenwertgleichungen: λ1 0 0 λ2 C(u1 , u2 , . . . , un ) = (u1 , u2 , . . . , un ) . .. .. . 0 0 ... ... .. . 0 0 .. . ... λn ⇐⇒: CU = UΛ 14.23 WR 1 Beweis des Satzes W. Merz CU = UΛ U ist eine Orthogonalmatrix: UU > = I 1 1 1 1 C = UΛU > = (UΛ 2 )(Λ 2 U > ) = (UΛ 2 )(UΛ 2 )> =: AA> mit der Diagonalmatrix √ 1 Λ2 = λ1 0 .. . √0 λ2 .. . 0 0 0 0 .. √. λn ... ... ... .. . 14.24 Normalverteilte Zufallsvektoren WR 1 W. Merz Theorem Ist X ein n-dimensionaler N (b, C)-verteilter Zufallsvektor, so besitzt X eine Darstellung der Form X = AE + b mit einer nichtsingulären Matrix A und einem Gaußschen Einheitsvektor E. Beweis: Sei A die Matrix aus der Zerlegung C = AA> und H(x) = A−1 (x − b). 1. Für E(ω) := H(X (ω)) = A−1 (X (ω) − b) ist dann X (ω) = AE(ω) + b Jetzt ist nur noch nachzurechnen, dass E(ω) ein gaussischer Einheitsvektor ist. 14.25 WR 1 Beweis W. Merz X (Ω, A, P) - (Rn , Bn , P X ) H HH H HH E =H ◦X H H(x) = A−1 (x − b) HH HH j ? n (R , Bn , P E = P H ) Die affin lineare Abbildung y = H(x) = A−1 (x − b) besitzt die Funktionaldeterminante JH (x) = det(A−1 ) und die Umkehrabbildung x = H ∗ (y ) = Ay + b. 14.26 WR 1 Beweis W. Merz 3. Verteilung von H: H(x) = A−1 (x − b) besitzt die Umkehrabbildung H ∗ (y ) = Ay + b und |JH (x)| = | det(A−1 )| = 1 | det A| = √ 1 det C Dichte nach Transformationssatz: g(y ) 1 = f H ∗ (y ) · JH H ∗ (y ) n > √ 1 1 − 21 H ∗ (y )−b C −1 H ∗ (y )−b √ √ e = · det C 2π det C n n > −1 > −1 1 1 > 1 1 √ = e− 2 (Ay ) C (Ay ) = √ e− 2 y (A C A)y 2π 2π 14.27 WR 1 Beweis g(y ) = 1 √ 2π n 1 e− 2 y > (A> C −1 A)y W. Merz A> C −1 A = A> (AA> )−1 A = A> (A> )−1 A−1 A = I ergibt g(y ) = 1 √ 2π n 1 e− 2 y > y = ϕn (y ) 14.28 WR 1 Bedeutung von b und C W. Merz Xi = Pn k =1 aik Ek + bi EEi = m1 (N (0, 1)) = 0 EXi = Pn k =1 aik EEk + bi = bi (EX )> := (EX1 , EX2 , . . . , EXn ) = b> var(Ei ) = E(Ei − EEi )2 = E(Ei2 ) = m̂2 (N (0, 1)) = 1 Für i 6= k sind Ei und Ek stochastisch unabhängig: cov(Ei , Ek ) = E(Ei − EEi )(Ek − EEk ) = E(Ei Ek ) = 0 14.29 WR 1 Bedeutung von b und C cov(Xi , Xj ) W. Merz = E(Xi − EXi )(Xj − EXj ) = E n X ! aik Ek + bi − bi k =1 = = = n X n X ! ajl El + bj − bj l=1 aik ajl E(Ek El ) k =1 l=1 n X n X X k =1 k =1 l6=k aik ajk E(Ek2 ) + n X n X aik ajl E(Ek El ) aik ajk k =1 14.30 Bedeutung von b und C Pn cov(Xi , Xj ) = k =1 aik ajk ist das Skalarprodukt der i-ten und der j-ten Zeile der Matrix A, WR 1 W. Merz also das Element cij der Matrix C = AA> Theorem Ist X ein N (b, C)-verteilter Zufallsvektor, so ist b = EX der Erwartungswert und C = CX die Kovarianzmatrix dieses Zufallsvektors. 14.31 WR 1 Stochastische Unabhängigkeit 2 σ1 0 0 σ2 2 C= . .. .. . 0 W. Merz 0 (x − b)> C −1 (x − b) = ... ... .. . 0 0 .. . ... σn2 n X 1 (xk − bk )2 2 σ k =1 k n q Y p det(C) = σk2 k =1 14.32 Stochastische Unabhängigkeit n > −1 1 1 1 √ p f (x1 , x2 , . . . , xn ) = e− 2 (x−b) C (x−b) det(C) 2π = f1 (x1 )f2 (x2 ) · · · fn (xn ) WR 1 W. Merz mit fk (t) = − √ 1 2e 2πσk (t−bk )2 2σ 2 k Die Komponenten eines N (b, C)-verteilten Zufallsvektors sind genau dann stochastisch unabhängig, wenn C eine Diagonalmatrix ist. 14.33 Stochastische Unabhängigkeit WR 1 W. Merz Theorem Ist X ein normalverteilter Zufallsvektor, so sind seine Komponenten genau dann stochastisch unabhängig, wenn je zwei verschiedene Komponenten Kovarianz Null besitzen. Dies gilt nur bei der Normalverteilung! 14.34 Funktionen von Zufallsvariablen WR 1 W. Merz Theorem Ist X ein n-dimensionaler N (b, C)-verteilter Zufallsvektor mit den Komponenten X1 , X2 , . . . , Xn , so ist die Zufallsvariable Y = a1 X1 + a2 X2 + · · · + an Xn + c = a> X + c normalverteilt mit Mittelwert µ= n X ai bi + c = a> b + c i=1 und Varianz σ2 = n X n X ai cik ak = a> Ca i=1 k =1 14.35 WR 1 Funktionen von Zufallsvariablen W. Merz Hilfssatz Ist E ein n-dimensionaler Gaußscher Einheitsvektor und U eine n × n-Orthogonalmatrix, so ist H = UE ebenfalls ein Gaußscher Einheitsvektor. Beweis: E (Ω, A, P) - (Rn , Bn , P E ) HH HH H H HH X (y ) = Uy H HH j H ? (Rn , Bn , ·) 14.36 WR 1 Funktionen von Zufallsvariablen W. Merz Beweis: H besitzt die gleiche Verteilung wie X (y ) = Uy + 0. Da P E die standardisierte Normalverteilung ist, ist X normalverteilt mit b = 0, C = UU > = I und det(C) = 1. Dichte: f (x) = 1 √ 2π n 1 e− 2 x > x = ϕn (x) 14.37 WR 1 Beweis des Theorems W. Merz 1. Mit der Darstellung X = AE + b ist Y von der Form Y kαk = q = a> (AE + b) + c = (a> A)E + (a> b + c) =: α> E + µ = α1 E1 + α2 E2 + . . . + αn En + µ α12 + α22 + . . . + αn2 und u1k := αk kαk Y = kαk(u11 E1 + u12 E2 + . . . + u1n En ) + µ 14.38 WR 1 Beweis des Theorems 2. n X k =1 2 u1k = W. Merz n 1 X 2 αk = 1 kαk2 k =1 (u11 , . . . , u1n ) ist Vektor mit Norm 1. Ergänzung zu Ortogonalmatrix u11 . . . u1n u21 . . . u2n U= . .. .. . un1 . . . unn und nach Hilfsatz 14.39 Beweis des Theorems WR 1 W. Merz H1 H2 .. . Hn =U E1 E2 .. . En ist ein Gaußscher Einheitsvektor und speziell H1 (d.h. obige Ergänzung wieder verwerfen) eine N (0, 1)-verteilte Zufallsvariable. 3. Y = kαk H1 + µ =: σ H1 + µ µ = a> b + c σ 2 = kαk2 = ka> Ak2 = a> AA> a = a> Ca. 14.40 WR 1 Beweis des Satzes W. Merz H1 (Ω, A, P) - (R, B, P0 ) HH HH Y H HH Z (s) = σs + µ H HH j H ? (R, B, . ) Y ist N (µ, σ 2 )-verteilt. 14.41