Technisch-Ökonomische Wartesysteme - WiSo

Werbung

Operations Research und Wirtschaftsinformatik

Prof. Dr. P. Recht // M.Radermacher, M.Sc.

DOOR

Mastermodul Operations Research IV:

Technisch-Ökonomische Wartesysteme

Skriptum zur Veranstaltung

im Sommersemester 2016

Stand: 12. Juli 2016

Das Fachgebiet im Internet:

• http://www.wiso.tu-dortmund.de/wiso/or/de/ •

Inhaltsverzeichnis

1 Einführung

2 Eine

2.1

2.2

2.3

2.4

2

kurze Wiederholung zur Wahrscheinlichkeitstheorie

Begrifflichkeiten . . . . . . . . . . . . . . . . . . . . . . . . .

Unabhängigkeit und bedingte Wahrscheinlichkeit . . . . . .

Zufallsvariablen und Verteilungen . . . . . . . . . . . . . . .

Zusammenstellung von im Weiteren benötigten Sachverhalte

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

10

10

11

13

22

3 Stochastische Prozesse in Wartesystemen, „Gedächtnislosigkeit“

24

4 Das Wartesystem M |M |1

4.1 Stationären Verteilungen in M |M |1-Wartesystemen . . . . . . . . . . . . . . . .

4.1.1 Zeitabhängige Analyse des Systems . . . . . . . . . . . . . . . . . . . . .

4.1.2 Zeitunabhängige Analyse; stationärer Zustand bzw. Gleichgewichtszustand

4.2 Die Pasta-Eigenschaft . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

4.3 Verkehrsintensität; Auslastung eines Wartesystems . . . . . . . . . . . . . . . .

4.4 Little’sche Formeln oder Little’sches Gesetz . . . . . . . . . . . . . . . . . . . .

4.5 Ein M |M |1-System mit einer (speziellen) Prioritätsbedienung . . . . . . . . . .

4.6 Der Austrittsprozess; Burke’sches Gesetz . . . . . . . . . . . . . . . . . . . . . .

4.7 Eine (elementare) Supply Chain als M |M |1-Wartesystem . . . . . . . . . . . .

37

37

38

40

42

42

48

50

51

54

5 Markov-Ketten als Instrumente zur Modellierung technisch-ökonomischer

systeme

5.1 Homogene Markov-Ketten mit stetiger Zeit, stationäre Markov-Ketten .

5.2 Bestimmung einer stationären Verteilung p∗ . . . . . . . . . . . . . . . .

5.3 Modellierung allgemeinere Ankunfts- und Bedienprozesse . . . . . . . .

6 Wartesysteme mit „Einzelankünften“ und „Einzelbedienungen“

6.1 Wartesystem vom Typ M |M |1 mit ungeduldig ankommenden Kunden

6.1.1 Erfassungsrate und effektive Ankunftsrate . . . . . . . . . . . .

6.2 Wartesysteme vom Typ M |M |m . . . . . . . . . . . . . . . . . . . . .

6.3 Ein Wartesystem vom Typ M |M |∞: Selbstbedienung . . . . . . . . .

6.4 Ein Wartesystem vom Typ M |M |m|K . . . . . . . . . . . . . . . . . .

6.5 Wartesysteme vom Typ M |M |m|0 bzw. M |G|m|0 . . . . . . . . . . . .

6.6 Ein spezielles „geschlossenes“ Wartesystem vom Typ M |M |m . . . . .

.

.

.

.

.

.

.

Warte. . . .

. . . .

. . . .

58

59

62

66

.

.

.

.

.

.

.

69

69

71

72

78

81

84

87

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

7 Wartesysteme mit Gruppenbedienungen bzw. Gruppenankünften

93

7.1 Ein Wartesystem vom Typ M |M |1|K mit Gruppenbedienung . . . . . . . . . . 93

7.2 Ein M |M |m|0 Wartesystem mit Gruppenbedienung . . . . . . . . . . . . . . . 96

7.3 Ein M |M |m|K|SIRO Wartesystem mit Gruppenankünften . . . . . . . . . . . . 100

i

7.4

Ein Wartesystem vom Typ M |Erl(µ, r)|1 . . . . . . . . . . . . . . . . . . . . . 103

8 Netzwerke von Wartesystemen

108

8.1 Ein elementares Netzwerk . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 108

8.2 Offene Netzwerke von Wartesystemen . . . . . . . . . . . . . . . . . . . . . . . 111

9 Wartesysteme mit Prioritäts-Bedienung

117

9.1 Das System M|M|m|K1 = 0, K2 = 0|Prio| – mit Unterbrechung . . . . . . . . . 117

9.2 Das System M|M|m|K1 , K2 |Prio| – mit Unterbrechung . . . . . . . . . . . . . . 119

10 Anhang: Eine kleine Einführung in die Simulation

10.1 Simulation von Zufallsexperimenten . . . . . . . . . . . . . . . . . . . . .

10.2 Verfahren zur Erzeugung gleichverteilter Zufallszahlen . . . . . . . . . . .

10.2.1 Linearer Kongruenz-Generator (Methode der linearen Kongruenz)

10.2.2 Inverser Kongruenzgenerator . . . . . . . . . . . . . . . . . . . . .

10.3 Erzeugung nicht gleichverteilter Zufallsvariablen . . . . . . . . . . . . . . .

10.3.1 Allgemeiner Ansatz/Inversionsmethode . . . . . . . . . . . . . . .

10.3.2 Rejektions-/Verwerfungsmethode . . . . . . . . . . . . . . . . . . .

10.3.3 Verfahren zur Erzeugung spezieller Zufallszahlen . . . . . . . . . .

10.3.4 Gütetests der erzeugten Verteilungen . . . . . . . . . . . . . . . . .

Literaturverzeichnis

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

121

122

123

123

124

125

125

127

127

128

131

ii

Kapitel 1

1

1 Einführung

In dieser Veranstaltung soll ein Überblick gegeben werden über

• Eine Theorie der technisch-ökonomischen Wartesysteme,

• ihre Bedeutung innerhalb technisch-ökonomischer Entscheidungsprobleme,

• Techniken und Methoden zur Analyse von Wartesystemen.

Die Kenntnis des „Funktionierens“ von Wartesystemen ist oft von großem ökonomischen Nutzen, deshalb muss man Informationen gewinnen, die eine effiziente Gestaltung eines Wartesystems zulassen.

Beispiele in denen Wartesysteme auftreten:

• Kasse im Lebensmittelgeschäft

• Tankstelle

• Abfüllanlagen

• Studentensekretariat

• Hotlines

• Mensa

• Fertigungssysteme

• Fußgängerampel

• Pannenservice des ADAC

• Operationen im Krankenhaus

• Organverpflanzungen

Definition 1.1

Unter einem technisch-ökonomischen Wartesystem verstehen wir ein technisch-ökonomisches System, bestehend aus einer Menge von „Kunden“, einer Menge von „Bedienstationen“ (an denen die Kunden bedient werden sollen bzw. wollen) und einem Regelwerk,

nach welchem die Kunden an die Bedienstationen herantreten („Ankunftsmuster“) bzw.

einem Regelwerk, nach welchem die Kunden von den Bedienstationen abgefertigt werden

(„Bedienungsmuster“). Die Menge von ankommenden Kunden vor der (den) Bedienstation(en), die noch nicht abgefertigt werden, heißt „Warteschlange“.

2

1 Einführung

OR II c, Master-Modul IV

Beispiel 1.2

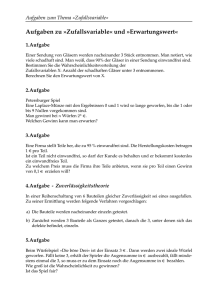

Die nachfolgenden Abbildungen 1.1, 1.3 und 1.2 stellen drei technisch-ökonomische Wartesysteme dar, einmal mit einer Warteschlange vor einer Bedienstation, einmal mit einer Warteschlange vor zwei Bedienstationen und einmal mit zwei Warteschlangen vor zwei Bedienstationen.

Bedienstation

Warteschlange

Kunden- Ankunftsquelle

muster

Bedienungsmuster

Systemaustritt

Abbildung 1.1: Wartesystem mit einer Warteschlange vor einer Bedienstation

Bedienstation 1

Warteschlange 1

Warteschlange 2

Bedienstation 2

Kunden- Ankunftsquelle

muster

Bedienungsmuster

Systemaustritt

Abbildung 1.2: Wartesystem mit zwei Warteschlangen vor zwei Bedienstationen

Bedienstation 1

Warteschlange

Bedienstation 2

Kunden- Ankunftsquelle

muster

Bedienungsmuster

Systemaustritt

Abbildung 1.3: “Amerikanische“ Warteschlange: eine Warteschlange vor zwei Bedienstationen;

Wir werden in dieser Veranstaltung Modelle technisch-ökonomischer Wartesysteme betrachten,

die Abbild gewisser realer Wartesysteme sind. Bei dieser Modellbildung werden wir uns auf

die wesentlichen Eigenschaften der organisatorischen Struktur konzentrieren. Bereits im OR I

haben wir versucht, eine bestimmte Typisierung vorzunehmen.

Wir haben bereits kennengelernt, dass wir technisch-ökonomische Wartesysteme durch folgende

fünf wesentlichen Komponenten charakterisieren können.

3

1 Einführung

OR II c, Master-Modul IV

(i) Das Ankunftsmuster

Das Ankunftsmuster, d. h. die Gesetzmäßigkeit, nach der „Kunden“ das technisch-ökonomische Wartesystem „betreten“, wird normalerweise durch die „Zwischenankunftszeiten“ τ = (τi )i=1,2,... , d. h. die Zeit zwischen den aufeinanderfolgenden Ankünften zweier

Kunden angegeben. Diese kann deterministisch (d. h. a priori exakt bekannt) sein. Im Allgemeinen ist sie jedoch eine Zufallsvariable, deren Verteilung als bekannt vorausgesetzt

wird oder aufgrund von Beobachtungen ermittelt werden kann.

Zwischenankunftszeit ¿

Ankunftszeitpunkt des

i-ten Kunden

¿1

¿2

¿3

¿4

¿5

t

T=0

Kunden

T1

T2

T3

T4

T5

Kunde 1 Kunde 2 Kunde 3 Kunde 4 Kunde 5

τ deterministisch: τ a priori exakt bekannt, d. h. (τi )i=1,2,... bekannt.

τ Zufallsvariable: Verteilung von τ bekannt, d. h. P (τ ≤ t) ist bekannt für alle t ∈ R+ .

Darüber hinaus kann es auch sein, dass die Kunden nicht einzeln das Wartesystem betreten, sondern in Gruppen zusammengefasst und dann in das Wartesystem aufgenommen

werden.

(ii) Das Bedienungsmuster

Das Bedienungsmuster, d. h. die Gesetzmäßigkeit, nach der die einzelnen Kunden von den

Bedienstationen abgefertigt werden, wird durch folgende drei Größen charakterisiert:

a) Die „Bedienzeit“ (engl. service) S, d. h. die Zeit, die eine Bedienstation benötigt,

um einen Kunden zu bedienen.

Kunde Nr.

1

2

3

4

5

Bedienzeit S

S1

S2

S3

S4

S5

Auch hier kann S deterministisch sein, d. h. die einzelnen Bedienzeiten der Kunden

(Si )i=1,2,... sind a priori exakt bekannt. Dies ist beispielsweise bei bestimmten Fertigungsprozessen der Fall, bei denen etwa die Bearbeitungszeit eines Objektes auf

einer Maschine stets die exakt gleiche Zeitdauer benötigt. Meist ist jedoch S eine

zufällige Größe. Wir werden voraussetzen, dass für die Dauer der Bedienzeit eines

Kunden diese Bedienstation nicht für neu eintreffende Kunden zugänglich ist.

b) Die Anzahl m von „Bedienstationen“ (engl. server), die für die Bedienung der

Kunden zur Verfügung steht. Wird dabei angenommen, dass ein ankommender Kunde sofort bedient wird, falls er eine freie Service-Station vorfindet, und dass alle freien

Geräte in gleicher Weise für alle ankommenden Kunden zugänglich sind, so spricht

4

1 Einführung

OR II c, Master-Modul IV

man manchmal von einem System mit vollkommener Erreichbarkeit. Dies ist im

Allgemeinen bei Kassen, Fahrkartenschaltern, etc. der Fall. Davon zu unterscheiden

sind Systeme mit unvollkommener Erreichbarkeit, bei denen die eintreffenden

Kunden nach bestimmten Kriterien in „Kundengruppen“ unterteilt werden und jede dieser Kundengruppen ihre eigenen Bedienstationen hat. (Bsp.: Kasse im Supermarkt für Kunden mit geringer Anzahl von Artikeln, Frauenparkplätze im Parkhaus,

Klassifikation nach Buchstaben im Studentensekretariat)

In bestimmten technisch-ökonomischen Wartesystemen sind die Bedienstationen

nach der Beendigung einer Bedienung nicht sofort wieder „servicebereit“ (Pause,

Umrüstung, Reparatur). D. h. die Zahl m ist abhängig von t, und die Bedienstationen haben die möglichen Zustände „besetzt“, „frei“ oder „ausgefallen“.

c) Die „Bedienungsdisziplin“ (engl. queueing discipline), d. h. die Reihenfolge, in

der die Kunden bedient werden.

Das Festlegen einer solchen Disziplin ist immer dann notwendig, wenn Kunden keine

freien Bedienstationen vorfinden. Mit ihr wird entschieden: „Wer ist der nächste

Kunde aus der Warteschlange, der bedient wird?“

• Die Mehrheit der Systeme arbeitet nach der FIFO-Disziplin/FCFS Disziplin

(First-In-First-Out /First-Come-First-Serve))

• Manchmal jedoch auch – etwa in Produktionssystemen mit Zwischenlagern,

wo Teile auf Bearbeitung warten – nach dem Last-In-First-Out-Prinzip (LIFODisziplin).

• In einer weiteren Klasse von technisch-ökonomischen Wartesystemen arbeiten

die Bedienstationen nach Prioritätsregeln (PRI-Disziplin). Die Kunden bestehen dabei aus „Teil-Kundengruppen“ K1 , K2 , ..., Kp , die untereinander einen

Vorrang genießen. Kundengruppe K1 wird vor allen anderen bedient, und Kunden aus Ki+1 werden nur dann bedient, wenn sich keine Kunden aus Ki in der

Warteschlange befinden (z. B. Behandlung von Unfällen in Krankenhäusern,

kürzeste Bedienzeit zuerst).

• Ebenso ist eine zufällige Auswahl der wartenden Kunden für die einzelnen Bedienstationen möglich. Eine solche SIRO-Disziplin (Service-In-Random-Order)

bei der Auswahl des nächsten Kunden für die Bediennung sieht man beispielsweise bei Verarbeitung von Kleinteilen in der Fertigung oder auch innerhalb

eines Kollektivs von Versicherungsnehmern bei einer Lebensversicherung.

(iii) Die Kapazität K des Systems

Die Systemkapazität K ist die maximale Anzahl von Kunden, die gleichzeitig in der

Warteschlange zugelassen sind. Diese kann endlich oder unendlich sein. Im Falle K < ∞

wird ein Kunde aus dem technisch-ökonomischen Wartesystem abgewiesen, falls bei seiner

Ankunft die Warteschlange die Länge K hat. Man spricht in einem solchen Fall häufig

von einem Warte-Verlust-System. Der Spezialfall K = 0 trifft etwa in einem Telefonnetz

zu, wenn alle Verbindungsleitungen besetzt sind.

5

1 Einführung

OR II c, Master-Modul IV

In der Literatur hat sich für die Darstellung der organisatorischen Struktur eines technischökonomischen Wartesystems die sogenannte Kendall’sche Notation durchgesetzt, in der für

jedes konkrete Wartesystem die charakteristischen Größen (in einem Fünf-Tupel) zusammengefasst werden.

Kendall’sche Notation: τ /S/m/K/Disziplin

Die angesprochenen Komponenten für eine Charakterisierung der technisch-ökonomischen Wartesysteme beschreiben also im Wesentlichen die organisatorische Struktur der Systeme.

Die Zielsetzung, die wir verfolgen wollen, besteht darin, aus dieser Charakterisierung für konkrete, gegebene technisch-ökonomische Wartesysteme ökonomische Bewertungen zur Einschätzung dieser speziellen organisatorischen Struktur des Systems zu gewinnen (sog. measures of

performance). Solche Bewertungen wird man gewinnen können, wenn man bestimmte Vergleichsgrößen ermittelt, die Aussagen darüber erlauben, dass ein Wartesystem „besser arbeitet“ als ein anderes. Erst auf diese Weise erhält man als Entscheider eines Unternehmens die

Möglichkeit, Empfehlungen zu einer rationalen Gestaltung von technisch-ökonomischen Wartesystemen zu geben, etwa hinsichtlich:

• einer sinnvollen Dimensionierung des technisch-ökonomischen Wartesystems.

• einer effizienten Ausnutzung bzw. Steuerung des technisch-ökonomischen Wartesystems.

Beispiel 1.3

a) Supermarkt: Um wieviel muss die durchschnittliche Bedienzeit verringert werden, damit

pro Zeiteinheit durchschnittlich mindestens 10 Kunden abgefertigt werden? oder

Wann und für wie lange sollte eine zusätzliche Kasse geöffnet werden, damit die maximale

Wartezeit eines Kunden mindestens 2, höchstens aber 4 Minuten beträgt?

b) Dimensionierung eines Parkhauses: Wie viel Parkplätze sollten beim Bau eines Parkhauses für ein Einklaufszentrum vorgesehen werden, damit durchschnittlich mindeseten 80

% der ankommenden Autos einen freien Platz vorfinden können? Wieviele dieser Parkplätze sollen als „Behindertenparkplätze“ ausgewiesen werden, damit mindestens 90%

der ankommenden Autofahrer, die behindert sind, einen freien Parkplatz vorfinden?

c) Hotlines: Das Call-Center einer Hotline eines Mobilfunkanbieters klassifiziert ankommende Kundenanrufe nach deren Inhalten (etwa: Fragen zur Rechnung, Neuanmeldungen,

Technische Unterstützung). Ist für jeden dieser Kundenbereiche genügend Personal vorhanden, damit ein Anrufer im Mittel höchstens 3 Minuten, bei den „Neuanmeldungen“

höchstens 30 Sekunden, warten muss?

d) Bearbeitung von Steuererklärungen im Finanzamt: Wie hoch ist die durchschnittliche

Zeit, die zwischen Abgabe der Steuererklärung und Erteilung des Steuerbescheides vergeht. Sollten zwei zusätzliche Mitarbeiter für die Bearbeitung der Steuererklärungen eingestellt werden? Wie reduziert sich dadurch die Bearbeitungszeit“? Sollte das Finanzamt

den eingehenden Anträge Prioritäten zuweisen?

6

1 Einführung

OR II c, Master-Modul IV

e) Check-in an Flughäfen: Wegen der aktuellen Terrorwarnungen wurde die durchschnittliche Zeit für den Check- in und für die Sicherheitsüberprüfung jeweils verdoppelt. Reicht

die bisherige Empfehlung an die Kunden, spätestens zwei Stunden vor Abflug am Flughafen Ckeck-in einzutreffen noch aus?

f) Kreisverkehr: Der Autoverkehr aus 4 verschiedenen Richtungen passiert eine Strassenkreuzung. Derzeit wird der verkerh durch eine Ampelanlage gesteuert. Aus Umweltgründen sollen die ampelbedingten Halte vermieden werden. Daher soll die Kreuzung zu einem

Kreisverkehr umgebaut werden. Wie gross muss der „Radius“ des Kreisels im Kreisverkehr sein, damit der Verkehr tatsächlich „flüssig“ läuft?

Die Beantwortung von Entscheidungsfragen derartigen Typs lassen sich häufig aufgrund von

quantitativen Größen, welche aus den Charakteristika des im jeweilig konkreten Fall vorliegenden technisch-ökonomischen Wartesystems hervorgehen, durchführen.

Die Beantwortung von Entscheidungsfragen derartigen Typs lassen sich häufig aufgrund von

quantitativen Größen, welche aus den Charakteristika des im konkreten Fall vorliegenden technisch-ökonomischen Wartesystems hervorgehen, durchführen.

Solche interessierenden Größen könnten beispielsweise sein:

T1 , T2 , T3 , . . . , Ti , . . .

Ankunftszeit des i-ten Kunden, i = 1, 2, . . .

S 1 , S 2 , . . . , Si , . . .

Bedienungsdauer des i-ten Kunden, i = 1, 2, . . .

E(S)

Durchschnittliche Bedienungsdauer der Kunden

ϑ 1 , ϑ 2 , . . . , ϑi , . . .

Austrittszeitpunkt des i-ten Kunden aus dem System,

i = 1, 2, . . .

W 1 , W 2 , . . . , Wi , . . .

Wartezeit des i-ten Kunden, bis Bedienung erfolgt,

i = 1, 2, . . .

E(W )

durchschnittliche Wartezeit der Kunden

V1 , V2 , . . . , Vi , . . .

Verweildauer des i-ten Kunden im technisch-ökonomischen

Wartesystem, i = 1, 2, . . .

E(V )

durchschnittliche Verweildauer der Kunden im Wartesystem

Ut

Arbeitsvorrat der Bedienstationen, also die notwendige Zeit

bis zur Abfertigung aller Kunden, welche sich zum Zeitpunkt t im Wartesystem befinden, t ∈ [0, ∞[

αt

Anzahl aller bis zum Zeitpunkt t angekommenen Kunden,

t ∈ [0, ∞[

δt

Anzahl aller bis zum Zeitpunkt t abgefertigten Kunden, t ∈

[0, ∞[

Lt

Anzahl der sich zum Zeitpunkt t im System befindenden

Kunden, t ∈ [0, ∞[

7

1 Einführung

OR II c, Master-Modul IV

E(L)

durchschnittliche Anzahl der Kunden im Wartesystem

pj

relativer zeitlicher Anteil, in dem sich j Kunden im System

befinden (j = 0, 1, 2, . . . ,).

rj

relativer Anteil der neu ankommenden Kunden, die j Kunden im System vorfinden (j = 0, 1, 2, . . . ,).

Nt

Zahl der wartenden Kunden zum Zeitpunkt t, t ∈ [0, ∞[

E(N )

durchschnittliche Anzahl der wartenden Kunden

Y 1 , Y 2 , Y 3 , . . . , Yj , . . .

Länge der Perioden, in denen die Bedienungsstation unproduktiv ist

Abbildung 1.4 auf Seite 9 stellt für ein Beispiel die Zusammenhänge derartiger Grössen einmal

dar.

Da wir im Weiteren formale (d. h. mathematische) Modelle bestimmter technisch-ökonomischer

Wartesysteme aufstellen wollen, um notwendige Größen für eine ökonomische Bewertung zu

ermitteln, müssen wir in die Lage versetzt werden, die Charakteristika der Systeme analytisch

zu beschreiben. Dies geschieht zunächst durch eine entsprechende Beschreibung des Ankunftsmusters (d. h. der Zwischenankunftszeiten τ ) und der Bedienzeit S.

Nun ist das Ankunftsmuster der Kunden im Allgemeinen eine zufällige Größe, d. h. die einzelnen

Kunden treffen zu zufälligen Zeitpunkten Ti , i = 1, 2, . . . im Wartesystem ein. Die Anzahl αt der

in einem Zeitintervall [0, t] ankommenden Kunden ist also ebenfalls zufällig und in Abhängigkeit

von t ein sogenannter stochastischer Prozess. Ebenso sind etwa die Bedienzeiten der einzelnen

Kunden Si , i = 1, 2, . . . zufällige Größen.

Also: Zufälligkeit ist ein wesentlicher Aspekt bei der Analyse technisch-ökonomischer Wartesysteme. Es ist deshalb notwendig, dass wir eine Reihe von Grundbegriffen und Sachverhalten aus

dem Bereich der Wahrscheinlichkeitstheorie bzw. Statistik wiederholen bzw. bereitstellen.

8

1 Einführung

OR II c, Master-Modul IV

¿1

Kundenankunfte

Ä

T0=0

¿2

¿4

¿3

T3

T2

T1

¿5

¿6

T5

T4

T6

t

U(t)

Arbeitsvorrat

im System

S2

S1

W1=0

S6

S5

W4

W3

W2

T0=0

Kundenaustritte

S4

S3

#1

#2

W5=0

W6

#3 #4

#5 #6

T0=0

t

t

®(t)

±(t)

akkumulierte

Ä

Ankunfte

und

Austritte

T0=0

T1

T3

T2

T5

T4

T6

t

L(t)

Z1

Y1

Z2

Y2

Zahl der

Kunden im

System

T0=0

T1

T2

#1

T3

T4 #2

#3 #4 T5

Abbildung 1.4: Wartesystem mit m = 1, K = ∞

9

T6

#5 #6

t

2 Eine kurze Wiederholung zur

Wahrscheinlichkeitstheorie

In diesem kleinen Kapitel sind eine Reihe von Sachverhalten aus dem Bereich der Statistik

bzw. der Wahrscheinlichkeitstheorie überblicksmässig zusammengestellt. Diese Zusammenstellung ersetzt natürlich nicht die (für das weitere Verständnis vorausgesetzten !) Kenntnisse einer

Einführungsveranstaltung aus dem Bereich der Statistik. Für eine umfangreichere Wiederholung sei hier das Buch [13] (ggf. zum Eigenstudium) empfohlen.

2.1 Begrifflichkeiten

Die Wahrscheinlichkeitstheorie beschäftigt sich mit der Bereitstellung von Methoden zur Beschreibung und Analyse von Experimenten mit zufälligem Ausgang. Man interessiert sich hierbei unter anderem für die Beobachtung von „Ereignissen“ bzw. von „Zufallsgrößen“ und deren

Wahrscheinlichkeiten.

Definition 2.1

Als Zufallsexperiment bezeichnet man einen zufälligen Versuch, wenn dessen Ausgang unter

den gegebenen Versuchsbedingungen a priori nicht feststeht und der – zumindest gedanklich –

beliebig oft wiederholt werden kann. Die Menge aller möglichen Versuchsergebnisse nennt man

Zustandsraum, Merkmalsraum oder Ereignissraum Ω.

Definition 2.2

Unter einem zufälligen Ereignis verstehen wir ein Ereignis, das im Rahmen eines Zufallsexperiments eintreten kann, nicht aber eintreten muss. Es wird als Teilmenge des Merkmalsraums

Ω aufgefasst. Die einelementigen Teilmengen von Ω nennt man Elementarereignisse ω. Sie

repräsentieren die möglichen Versuchsergebnisse des Experiments.

Für zwei Ereignisse A und B repräsentiert

• Ac das sog. komplementäre Ereignis zu A,

• A ∪ B das Ereignis, dass mindestens eines der beiden Ereignisse A oder B eintritt,

• A ∩ B das Ereignis, dass sowohl das Ereignis A als auch das Ereignis B eintritt,

• A \ B das Ereignis, dass zwar das Ereignis A, nicht aber das Ereignis B eintritt,

10

2 Eine kurze Wiederholung zur Wahrscheinlichkeitstheorie

OR II c, Master-Modul IV

• Ω das sichere Ereignis und

• ∅ das unmögliche Ereignis.

Die Wahrscheinlichkeitstheorie bezeichnet eine Menge von Teilmengen von Ω als sog. σ-Algebra

A, wenn folgende Bedingungen erfüllt sind:

(i) Ω ∈ A

(ii) A ∈ A ⇒ Ac ∈ A

(iii) Für eine abzählbare Familie (Ai )i∈I von Mengen von A gilt

S

i∈I

Ai ∈ A.

Ein Ereignis A entspricht demnach einem Element der σ-Algebra A, d. h. A ∈ A.

Beispiel 2.3

Die Menge aller möglichen Teilmengen von Ω, die sog. Potenzmenge P(Ω) von Ω, ist stets eine

σ-Algebra.

Grundlage für alle weiteren Betrachtungen in der Wahrscheinlichkeitstheorie bildet ein sog.

Wahrscheinlichkeitsraum (Ω, A, P ). Dabei ist Ω eine beliebige Menge (Merkmalsraum), A eine

σ-Algebra in Ω und P ein auf der σ-Algebra A definiertes Wahrscheinlichkeitsmaß, also eine

Abbildung P : A → [0, 1] mit den folgenden Eigenschaften:

(i) P (Ω) = 1

(ii) P (A) ≥ 0 für alle A ∈ A

S

P

(iii) P ( i Ai ) = i P (Ai ) für jede abzählbare Familie von paarweise disjunkten Ereignissen

A1 , A2 , . . . ∈ A.

Beispiel 2.4

Bei in der Praxis vorkommenden Problemen hat man es manchmal mit sog. Laplace-Experimenten

zu tun. Es handelt sich um Zufallsexperimente mit nur endlich vielen möglichen „elementaren

Ereignissen“, deren jeweiliger Eintritt als gleichwahrscheinlich angenommen wird. Das zugehörige mathematische Modell ist ein Wahrscheinlichkeitsraum (Ω, A, P ), der sog. Laplace’scher

Wahrscheinlichkeitsraum, mit einer endlichen (n-elementigen) Menge Ω, A = P(Ω) und P als

Wahrscheinlichkeitsmaß mit P ({ω}) = 1/n. Mittels einfacher Überlegungen erhält man die

Wahrscheinlichkeiten für ein beliebiges Ereigniss A ∈ A als

P (A) =

1

· |A|.

n

2.2 Unabhängigkeit und bedingte Wahrscheinlichkeit

Es sein (Ω, A, P ) ein Wahrscheinlichkeitsraum und A, B ∈ A zwei Ereignisse mit P (B) > 0.

Interessiert man sich für die Wahrscheinlichkeit des Eintritts von A unter der Bedingung,

dass das Ereignis B eintritt, bzw. schon eingetreten ist, hat man mit den sog. bedingten

Wahrscheinlichkeiten zu tun.

11

2 Eine kurze Wiederholung zur Wahrscheinlichkeitstheorie

OR II c, Master-Modul IV

Definition 2.5

Die bedingte Wahrscheinlichkeit P (A|B) des Eintritts von A unter der Bedingung, dass

das Ereignis B eintritt bzw. eingetreten ist, wird durch

P (A|B) :=

P (A ∩ B)

P (B)

definiert.

Bemerkung 2.6

Mit der Zuordnung

P (A ∩ B)

P (B)

A 7→

wird ein Wahrscheinlichkeitsmaß PB (·) auf A definiert. Offenbar gilt PB (B) = 1. Durch den

Übergang von P zu PB ist B zu einem Ereignis mit Wahrscheinlichkeit 1 geworden. Für jedes

A ∈ A bezeichnet man daher PB (A) als die bedingte Wahrscheinlichkeit unter (der Hypothese)

B und schreibt PB (A) für P (A|B).

Verallgemeinernd führt die Definition der bedingten Wahrscheinlichkeit auf die Formel der

totalen Wahrscheinlichkeit: Es sei (Ω, A, P ) ein Wahrscheinlichkeitsraum. Sei weiterhin eine

endliche oder abzählbar unendliche Familie (Bi )i∈I gegeben mit paarweise disjunkten EreigS

nissen Bi ∈ A, P (Bi ) > 0 für alle i ∈ I und i Bi = Ω („Zerlegung von Ω“). Dann gilt für

jedes Ereignis A ∈ A

P (A) =

X

i∈I

P (A|Bi ) · P (Bi ).

(2.1)

Speziell ergibt sich wegen Ω = B ∪ B c :

P (A) = P (A|B) · P (B) + P (A|B c ) · P (B c ).

Aus der Formel von der totalen Wahrscheinlichkeit ergibt sich unter der Annahme, dass P (A) >

0 die der Satz von Bayes 1 :

und wiederum speziell

P (B|A) =

P (Bk |A) = P

P (A|Bk ) · P (Bk )

,

i∈I P (A|Bi ) · P (Bi )

P (A|B) · P (B)

P (A|B) · P (B)

=

.

P (A)

P (A|B) · P (B) + P (A|B c ) · P (B c )

Aufgabe(siehe Übungsblatt 1): Wie jedes Jahr im Semester wird auch diesmal das Blutspendemobil des Roten Kreuzes wieder Station auf dem Martin-Schmeißer-Platz machen. Das

1

Benannt nach dem engl. Mathematiker Th. Bayes, geb. 1702 gest. 1761.

12

2 Eine kurze Wiederholung zur Wahrscheinlichkeitstheorie

OR II c, Master-Modul IV

dort gespendete Blut wird untersucht, unter anderem auch auf das Vorkommen von HIV. Das

Testverfahren des hiesigen Blutlabors habe eine Genauigkeit von 99 % und einer von 1 000

Studenten Ihrer Altersgruppe sei HIV-positiv. Außerdem betrage die Rate für falsch positiv

erkannte HIV-Infektionen 5 %. Angenommen, die Analyse eines Testes fällt HIV-positiv aus.

Mit welcher Wahrscheinlichkeit ist die untersuchte Person wirklich HIV-positiv? Hinweis: Die

angegebenen 99 % beziehen sich auf die Wahrscheinlichkeit P(Test ist positiv|Person ist HIVpositiv). Gesucht ist die Wahrscheinlichkeit P (Person ist HIV-positiv|Test ist positiv).

Gilt in der Gleichung der bedingten Wahrscheinlichkeit, dass P (A|B) = P (A), so hängt die

Wahrscheinlichkeit für das Ereignis A nicht vom Eintritt des Ereignisses B ab.

Definition 2.7

Zwei Ereignisse A und B heißen (stochastisch) unabhängig, wenn gilt P (A ∩ B) = P (A) ·

P (B). Eine (möglicherweise unendliche) Familie von Ereignissen (Ai )i∈I heißt unabhängig,

wenn für jede endliche Teilmenge J ⊂ I

P(

\

Ai ) =

Y

P (Ai )

i∈J

i∈J

gilt.

Bemerkung 2.8

Aus der Unabhängigkeit der (Ai )i∈I folgt die paarweise Unabhängigkeit je zweier Ereignisse Ai

und Aj mit i, j ∈ I und i 6= j. Die Umkehrung gilt jedoch nicht!

2.3 Zufallsvariablen und Verteilungen

Bei einem Zufallsexperiment interessiert man sich häufig nicht direkt für den Ausgang des

Experiments, sondern für mit dem Ausgang verbundenen Werte, also quantitativen Grössen

Definition 2.9

Es sei (Ω, A, P ) ein Wahrscheinlichkeitsraum. Eine (A-messbare) Abbildung X : Ω → R heißt

(reelle) Zufallsvariable.

Bemerkung 2.10

Die Abbildung X ordnet damit jedem Elementarereignis ω ∈ Ω eines zufälligen Versuchs eine

reelle Zahl x = X(ω) zu. Man nennt x ∈ R eine Realisierung von X. Wegen der Messbarkeit

gilt für jede (Borelsche) Menge B ⊂ R, dass deren Urbildmenge X −1 (B) in A liegt, also ein

Ereignis ist. Für derartige Mengen B ⊂ R setzt man

{X ∈ B} := {ω ∈ Ω | X(ω) ∈ B} = X −1 (B)

13

2 Eine kurze Wiederholung zur Wahrscheinlichkeitstheorie

OR II c, Master-Modul IV

und definiert

PX (B) := P ({X ∈ B}) = P (X −1 (B)).

Man bezeichnet {X ∈ B ∈ B} als das Ereignis „X liegt in B“ und PX (B) als die Wahrscheinlichkeit dieses Ereignisses. Man spricht auch oft von dem durch P induzierten Bildmaß auf

(R, B) bzw. der Verteilung der Zufallsvariablen X. .

Bemerkung 2.11

Wie schon erwähnt, entspricht der Verteilung von X das Bildmaß X(P ) =: PX . Mit Hilfe

der Verteilung PX können somit die Wahrscheinlichkeiten P (X ∈ B) berechnet werden. Von

besonderer Bedeutung ist hierbei, dass der im Allgemeinen „komplizierte“ und das zufällige

Geschehen beschreibende Wahrscheinlichkeitsraum (Ω, A, P ) nicht explizit bekannt sein muss.

Die Verteilung einer Zufallsvariablen X ist vollständig bestimmt, wenn man für jede Zahl x ∈ R

den Wert FX (x) := P (X ∈] − ∞, x]) = P (X ≤ x) = P ({ω ∈ Ω | X(ω) ≤ x}) kennt.

Definition 2.12

Es sei X eine reelle Zufallsvariable. Dann heißt die Funktion FX : R → R mit

FX (x) := PX (x ≤ x)

die Verteilungsfunktion von X.

In der Praxis unterscheiden wir üblicherwiese zwei Arten von Zufallsvariablen

Definition 2.13

Eine reelle Zufallsvariable X : Ω → R heißt diskret verteilt (kurz: diskret), falls sie nur Werte aus einer abzählbaren Menge M ⊂ R annehmen kann (d. h. X(ω) ∈ M = {xk |k ∈ I, I ⊂ N}.

Man nennt pk := P (X = xk ) = P ({ω ∈ Ω | X(ω) = xk }) häufig die „Einzelwahrscheinlichkeit“ von X. Manchmal spricht man hier auch von der diskreten Dichte-Funktion.

Für diskrete Zufallsvariablen ist die Verteilung von X durch die Dichtefunktion vollständig

bestimmt. Die Werte der Verteilungsfunktion FX lassen sich nämlich für jedes x ∈ R über

FX (x) =

X

pk

{k|xk ≤x}

bestimmen.

Beispiele für das Vorkommen diskrete Zufallsvariablen in technisch-ökonomischen Wartesystemen sind:

• Länge der Warteschlange (zu einem Zeitpunkt t),

• Anzahl der abgewiesenen Kunden (bis zu einem Zeitpunkt t),

14

2 Eine kurze Wiederholung zur Wahrscheinlichkeitstheorie

OR II c, Master-Modul IV

• Anzahl der abgefertigten Kunden (bis zu einem Zeitpunkt t),

• Anzahl der ankommenden Kunden (bis zu einen Zeitpunkt t).

Definition 2.14

Der Erwartungswert E(X) einer diskreten Zufallsvariablen X wird definiert als

E(X) :=

X

k∈I

sofern

P

k

xk · pk ,

|xk · pk | < ∞.

Der Erwartungswert der Zufallsvariable X kann dabei als der Sachverhalt interpretiert werden,

dass bei „genügend häufiger“ Durchführung des Zufallsexperiments der mit den pk gewichtete

Durchschnitt der beobachteten Werte von X „in der Nähe“ von E(X) liegt .

Als ein praktisches Maß für die Größe der Abweichungen der Realisierungen wird üblicherweise

die Varianz herangezogen.

Definition 2.15

Unter der Varianz V ar(X) einer diskreten reellen Zufallsvariablen X wird definiert als

V ar(X) :=

X

k∈I

sofern

P

k

(xk − E(X))2 · pk

x2k · pk < ∞.

Die Grösse

p

V ar(X) wird als Standardabweichung

√ oder Streuung von X bezeichnet.

V ar(X)

Falls E(X) 6= 0, dann heisst die Grösse cX := E(X) der Variationskoeffizient von X. Der

Variationskoeffizient ist eine dimensionslose Grösse, die die Standardabweichung durch den

Erwartungswert „relativiert“ wird. Ist die Standardabweichung größer als der der Erwartungswert, so ist der Variationskoeffizient offenbar größer 1, im entgegengesetzten fall kleiner 1.

Beispiel 2.16

(i) Binomialverteilung: Gegeben seien zwei Parameter p, 0 < p < 1 und n ∈ N sowie

eine diskrete Zufallsvariable X : Ω → {0, . . . , n}. Dan heisst X binomial-verteilt mit

Parametern n und p, kurz: X ∼ B(n, p) falls die Wahrscheinlichkeitsverteilung von X

durch

!

n k

P (X = k) =

p (1 − p)n−k , k = 0, 1, . . . , n,

k

gegeben ist. Für eine mit den Parametern n und p binomial-verteilte Zufallsvariable X

gilt

1−p

.

E(X) = n · p,

V ar(X) = n · p · (1 − p),

c2X =

n·p

15

2 Eine kurze Wiederholung zur Wahrscheinlichkeitstheorie

OR II c, Master-Modul IV

Die Dichte und die Verteilungsfunktion der Binomialverteilung ist in Abb. 2.1 dargestellt.

Verwendung: Tritt als Folge eines Zufallsexperiments ein bestimmtes Ereignis A mit

Wahrscheinlichkeit 0 < p < 1 auf, und wird das Experiment n-mal unabhängig voneinander wiederholt, dann lässt sich die „Anzahl k des Auftretens des Ereignisses A in

diesem n Experimenten“ (offenbar ist 0 ≤ k ≤ n) durch eine eine Zufallsvariable X

darstellen, die der Binomialverteilung mit den Parametern p und n folgt.

0.5

1

0.4

0.8

0.3

0.6

0.2

0.4

0.1

0.2

0

0

0

5

10

15

0

5

10

15

Abbildung 2.1: Dichte und Verteilungsfunktion von B(15, 0.5)

Hat man zwei Zufallsvariablen X und Y , wobei X ∼ B(n1 , p) und Y ∼ B(n2 , p) (der

Parameter p ist also bei beiden derselbe), so gilt für die Zufallsvariable Z = X + Y :

Z ∼ B(n1 + n2 , p).

(ii) Geometrische Verteilung: Es sei 0 < p < 1. Eine diskrete Zufallsvariable X : Ω →

{0, 1, . . .} = N0 heisst geometrisch -verteilt mit Parameter p (kurz: X ∼ G(p)), falls

pk = P (X = k) = p · (1 − p)k−1 .

Für die Verteilungsfunktion von FX ergibt sich:

FX (n) = P (X ≤ n) = 1 − P (X > n) = 1 − (1 − p)n ,

Erwartungswert, Varianz und Variationskoeffizient errechnen sich als

1

E(X) = ,

p

V ar(X) =

1−p

,

p2

c2X =

1

.

p

Anwendung: geometrisch-verteilte Zufallsvariable werden typischerweise für die Beschreibung des

„Wartens auf den ersten Erfolg“

benutzt. Es sei A ein Ereignis, welches innerhalb eines Experimentes mit Wahrscheinlichkeit p eintritt („Erfolgswahrscheinlichkeit“). Die Zufallsvariable X beschreibe die Anzahl

der (unabhängigen) Versuche im Experiment, die durchgeführt werden, bis zum ersten

mal A eintritt. Dann wird die Wahrscheinlichkeit, dass dies genau im k-ten Versuch

geschieht durch p · (1 − p)k−1 beschrieben, d.h. X ∼ G(p).

16

2 Eine kurze Wiederholung zur Wahrscheinlichkeitstheorie

OR II c, Master-Modul IV

1

0.25

0.2

0.8

0.15

0.6

0.1

0.4

0.05

0.2

0

−0.05

0

0

10

20

30

0

10

20

30

Abbildung 2.2: Dichte und Verteilungsfunktion von P o(6)

Satz 2.17

Eine diskrete Zufallsvariable X : Ω → {0, 1, 2, . . .} ist geometrisch-verteilt genau dann,

wenn sie folgender Bedingung („Gedächtnislosigkeit“) genügt:

P (X = n + k | X > n) = P (X = k) für alle

n, k ≥ 1.

(iii) Poisson-Verteilung 2 : Es sei λ > 0. Eine diskrete Zufallsvariable X : Ω → {0, 1, . . .}

heisst Poisson-verteilt mit Parameter λ (kurz: X ∼ P o(λ)), falls

pk = P (X = k) =

λk −λ

e .

k!

Für den Erwartungswert, Varianz und Variationskoeffizient rechnet man aus:

E(X) = λ,

V ar(X) = λ,

c2X =

1

.

λ

Abb. 2.2 auf Seite 17 zeigt die Dichte und Verteilungsfunktion der Poisson-Verteilung.

Anwendung: Poisson-verteilte Zufallsvariable werden typischerweise für eine

Beschreibung von „Zähl-Ereignissen“ innerhalb eines bestimmten festgelegten

Zeitintervalls

benutzt. Sind innerhalb dieses Zeitintervalls die Auftritte dieses Ereignisses unabhängig

voneinander und tritt es dort durchschnittlich λ-mal auf, so ist die Wahrscheinlichkeit,

k

dass das Ereignis während dieser Zeit k-mal auftritt gerade λk! e−λ .

Im Zusammenhang mit technisch-ökonomischen Wartesystemen werden typischerweise

„Ankunft eines Kunden (im Intervall [0, t])“ oder „Verlassen eines Kunden (im Intervall

[0, t])“ als solche angesehen und und das „Zählen“ des Auftretens durch Poisson-verteilte

Zufallsvariable beschrieben.

Wichtig ist auch noch der folgende Sachverhalt

2

Benannt nach dem frz. Mathematiker S.D. Poisson, geb. 1781 gest. 1840.

17

2 Eine kurze Wiederholung zur Wahrscheinlichkeitstheorie

OR II c, Master-Modul IV

Satz 2.18

Es seien X1 ∼ P o(λ1 ) und X2 ∼ P o(λ2 ).

Dann ist die Zufallsvariable Z = X1 + X2 Poisson-verteilt mit Parameter λ1 + λ2 . Also

X1 + X2 ∼ P o(λ1 + λ2 ).

Beweis: Als Übungsaufgabe

Die Summe zweier Poisson-verteilter Zufallsvariablen ist also ebenfalls Poisson-verteilt

und die Parameter addieren sich.

Definition 2.19

Eine Zufallsvariable X : Ω → R heißt stetig verteilt (oder kurz: stetig), falls es eine integrierbare Funktion f : R → R+ gibt, derart, dass für die Verteilungsfunktion FX gilt

FX (x) =

Z

x

f (s)ds.

−∞

In einem solchen Fall heißt f die Wahrscheinlichkeitsdichte oder Dichte der Zufallsvariablen X.

Bemerkung 2.20

Im diskreten Fall entspricht der Wahrscheinlichkeitsdichte der diskrete Funktion f : R → R+

P

P

mit f (xk ) = pk . Es gilt weiterhin, dass k pk = k f (xk ) = 1. Im stetigen Fall gilt wegen

1 = P (Ω) = P (X ∈ R) = lim FX (x) = lim

x→∞

für die Dichte der Zufallsvariablen X, dass

Z

x

x→∞ −∞

R∞

−∞ f (s)ds

f (s)ds

= 1.

Definition 2.21

Der Erwartungswert E(X) bzw. die Varianz V ar(X) einer stetigen reellen Zufallsvariablen

wird definiert als

E(X) :=

V ar(X) :=

Z

∞

−∞

Z ∞

−∞

s · f (s)ds

(s − E(X))2 · f (s)ds

sofern die jeweiligen Integrale existieren.

Auch für stetige Zufallszahlen versteht man unter

p

V ar(X) die

√ Standardabweichung oder

V ar(X)

Streuung von X. Falls E(X) =

6 0, dann heisst die Grösse cX := E(X) auch hier der Variationskoeffizient von X.

Beispiele für stetige Zufallsvariablen in technisch-ökonomischen Wartesystemen sind:

18

2 Eine kurze Wiederholung zur Wahrscheinlichkeitstheorie

OR II c, Master-Modul IV

• Zwischenankunftszeit τi des i-ten Kunden,

• Bedienzeit Si des i-ten Kunden,

• zeitlicher Arbeitsvorrat Ut einer Bedienstation,

• Betriebszeiten Zk der Bedienstation,

• Leerlaufzeiten Yk der Bedienstation.

Beispiel 2.22

(i) Stetige Gleichverteilung (Rechteckverteilung): Es sei eine stetige reelle Zufallsvariable

X : Ω → [a, b] ⊂ R gegeben. Man nennt X gleichverteilt auf dem Intervall [a, b], kurz

X ∼ U (a, b), falls für die Dichtefunktion gilt, dass

f (x) =

1

, a≤x≤b

b−a

0,

sonst.

Die Dichte einer gleichverteilten Zufallsvariablen ist also auf dem Intervall [a, b] konstant.

Für den Erwartungswert und die Varianz einer gleichverteilten Zufallsvariable rechnet

man aus:

(b − a)2

a+b

und V ar(X) =

.

E(X) =

2

12

Anwendung: Gleichverteilte Zufallsvariable sind grundlegend für den Bereich der „Simulationsverfahren“ (siehe späteres Kapitel ??). Im Rahmen einer solchen Simulation wird

dann gefordert dass zu generierenden „Zufallszahlen“ einer bestimmten Verteilung gehorchen sollen. Diese Verteilung erhält man durch Transformation von Zufallszahlen, die

auf dem Einheitsintervall [0, 1] gleichverteilt sind (X ∼ U (a, b)).

(ii) Gauß’sche Normalverteilung: Es sei µ ∈ R und σ 2 > 0„Eine stetige Zufallsvariable

X : Ω → R heisst normal-verteilt mit Parametern µ und σ 2 (kurz: X ∼ N (µ, σ 2 )), falls

X die Dichtefunktion

1

2

2

f (x) = √

e−(x−µ) /2σ

2πσ

besitzt. Für den Erwartungswert bzw Varianz erhält man

E(X) = µ

und V ar(X) = σ 2 .

Für den Spezialfall µ = 0 und σ 2 = 1 heisst X ∼ N (0, 1) standard-normalverteilt. Abb.

2.3 zeigt die als Gauß’sche Glockenkurve bekannte Dichte und die Verteilungsfunktion

der Normalverteilung graphisch.

Die Normalverteilung stellt eine äusserst wichtige Verteilung dar. Ihre Bedeutung erhält

sie durch den Zentralen Grenzwertsatz, der besagt, dass die Summe unabhängiger und

identisch verteilter Zufallsvariablen beliebiger Verteilungen annähernd normal-verteilt

sind (Konvergenz in Verteilung gegen eine normal-verteilte Zufallsvariable).

Anwendung: Die Normalverteilung tritt häufig im Zusammenhang mit der Beschreibung

von zufälligen Meßfehlern und Fabrikationsfehlern auf.

19

2 Eine kurze Wiederholung zur Wahrscheinlichkeitstheorie

OR II c, Master-Modul IV

0.5

1

0.4

0.8

0.3

0.6

0.2

0.4

0.1

0.2

0

0

−2

0

2

−2

0

2

Abbildung 2.3: Dichte und Verteilungsfunktion von N (0, 1)

(iii) Exponentialverteilung: Es sei λ > 0. Eine stetige Zufallsvariable X : Ω → [0, ∞[ heisst

exponential-verteilt mit Parameter λ (kurz: X ∼ E(λ), falls X die Dichte

f (x) =

(

0,

x<0

−λx

λ·e

, x≥0

besitzt. Für die Verteilungsfunktion von FX gilt dann für t > 0:

FX (t) = P (X ≤ t) = 1 − P (X > t) = 1 − e−λt ,

d.h.

P (X > t) = 1 − FX (t) = e−λt .

Für den Erwartungswert, die Varianz bzw. den Variationskoeffizienten erhält man

E(X) = 1/λ,

V ar(X) = 1/λ2 ,

cX = 1.

Die Dichte und die Verteilungsfunktion der Exponentialverteilung ist in Abb. 2.4 graphisch dargestellt.

2.5

1

2

0.8

1.5

0.6

1

0.4

0.5

0.2

0

0

0

2

4

0

2

4

Abbildung 2.4: Dichte und Verteilungsfunktion von E(2)

Anwendung: Die Exponentialverteilung gehört zu den wichtigen und häufig anzutreffenden Verteilungen. Sie wird oft genutzt, um die Lebensdauer von Objekten zu modellieren,

die „nicht altern“, also immer „wie neu“ sind. Dies wird bspw. oft von elektronischen

Bauteilen angenommen. Auch zur Beschreibung von Zwischenankunftszeiten bzw. Bedienzeiten wird sie herangezogen. Es gilt nämlich der fundamentale Zusammenhang:

20

2 Eine kurze Wiederholung zur Wahrscheinlichkeitstheorie

OR II c, Master-Modul IV

Satz 2.23

Eine reelle Zufallsvariable X : Ω → [0, ∞[ ist exponential-verteilt genau dann, wenn sie

folgender Bedingung („Gedächtnislosigkeit“) genügt:

P (X > s + t | X > s) = P (X > t) für alle

s, t ≥ 0.

Die zufällige Lebensdauer von Glühbirnen oft mit Hilfe der Exponentialverteilung modelliert. Die damit unterstellt Gedächtnislosigkeit weist darauf hin, dass es nicht viel

Sinn ergibt, eine funktionierende Glühbirne durch eine neue zu ersetzen. Die Eigenschaft

besagt nämlich, dass die Wahrscheinlichkeit dafür, dass eine Glühbirne, die bisher s

Stunden funktionsfähig war, noch t weitere Stunden funktioniert, genauso groß ist wie

die Wahrscheinlichkeit, dass eine neue Glühbirne t Stunden funktioniert. Die Eigenschaft

der Gedächtnislosigkeit einer Exponentialverteilung führt – wie wir noch sehen werden –

zu der sog. „Markov-Eigenschaft“ von Poisson-Prozessen.

Eine weitere wichtige Eigenschaft von exponentialverteilten Zufallsvariablen ist die folgende

Satz 2.24

Es seinen X1 , X2 , . . . , Xk k voneinander stochastisch unabhängige, exponentialverteilte

Zufallsvariablen mit den Parametern λ1 , λ2 , . . . , λk

Dann ist die Zufallsvariable

X = min{X1 , X2 , . . . Xk }

exponentialverteilt mit Parameter λ = λ1 + λ2 + · · · + λk

Beweis: In der Übung als Übungsaufgabe.

(iv) Erlang-Verteilung 3 : Es sein λ > 0 und r ∈ N, r ≥ 2. Eine stetige Zufallsvariable

X : Ω → [0, ∞[ heisst Erlang-verteilt mit Parameter λ und r (kurz: X ∼ Erl(λ, r), falls

X die Dichte

(

0,

x<0

f (x) =

λn ·xr−1

−λx

, x≥0

(r−1)! · e

besitzt.

Als Verteilungsfunktion von FX ergibt sich dann für t > 0:

−λt

FX (t) = P (X ≤ t) = 1 − P (X > t) = 1 − e

d.h.

−λt

P (X > t) = 1 − FX (t) = e

3

·

r−1

X

i=0

·

r−1

X

i=0

(λ · t)i

i!

!

(λ · t)i

i!

!

,

.

Benannt nach dem dänischen Mathematiker und Ingenieur A.K. Erlang, geb. 1878 gest. 1929.

21

2 Eine kurze Wiederholung zur Wahrscheinlichkeitstheorie

OR II c, Master-Modul IV

Für den Erwartungswert, die Varianz bzw. den Variationskoeffizienten erhält man hier

r

,

λ

E(X) =

V ar(X) =

r

,

λ2

c2x =

1

.

r

Anwendung: Erlang-Verteilungen gehören bei der Modellierung von Bedienzeiten ebenfalls zu wichtigen und häufig anzutreffenden Verteilungen. In der Realität besteht ein

„Bedienungsvorgang“ häufig aus mehreren einzelnen (also etwa n ≥ 1) "Bedienungsschritten“. Sind die Dauern Si , i = 1, 2, . . . r dieser einzelnen Bedienungsschritte voneinander

unabhängig und exponential-verteilt mit gleichem Parameter λ, so ist die Dauer S des

gesamten Bedienungvorgangs Erl(λ, r)-verteilt.

2.4 Zusammenstellung von im Weiteren benötigten Sachverhalte

a) Es ist

(i) Reihenentwicklung für die Exponentialfunktion:

ea·x =

∞

X

(a · x)i

i!

i=0

, für alle a, x ∈ R

•

∞

X

xi =

i=0

1

, für |x| < 1

1−x

•

n

X

1 − xn+1

für |x| < 1.

1−x

xi =

i=0

•

∞

X

i=0

i · xi =

x

, für |x| < 1

(1 − x)2

•

∞

X

i=0

i2 · xi =

x · (1 + x)

, für |x| < 1

(1 − x)3

b) Abschätzung von Wahrscheinlichkeiten: Es sei X eine nicht-negative Zufallsvariable, dann gilt für alle t > 0:

P (X ≥ t) ≤

E(X)

t

22

(Markov-Ungleichung).

2 Eine kurze Wiederholung zur Wahrscheinlichkeitstheorie

OR II c, Master-Modul IV

c) Satz vom totalen Erwartungswert

Satz 2.25

Es sei X eine integrierbare Zufallsvariable und (Bi )i∈I eine endliche oder abzählbar unS

endliche Familie von Teilmmengen Bi ⊂ R, P (Bi ) > 0, paarweise disjunkt und i Bi = Ω

(„Zerlegung von R“). Dann gilt

E(X) =

X

i∈I

E(X|Bi ) · P (Bi ).

d) Faltungssatz (siehe etwa [13]):

Satz 2.26 (Faltungssatz)

Es seien X1 und X2 zwei unabhängige Zufallsvariablen mit Dichtefunktionen fX1 bzw.

fX2 . Dann ergibt sich die Dichtefunktion fX der Zufallsvariablen X = X1 + X2 als:

fX (t) = fX1 ∗ fX2 (t) =

Z

+∞

−∞

fX1 (t − s) · fX2 (s)ds.

Der Ausdruck fX1 ∗ fX2 (t) heißt Faltung von fX1 und fX2 .

23

3 Stochastische Prozesse in Wartesystemen,

„Gedächtnislosigkeit“

Die meisten zufälligen Größen in einem technisch-ökonomischen Wartesystem unterliegen zeitlichen Veränderungen. Beispiele hierfür sind:

• Die Anzahl αt von Kunden, die bis zum Zeitpunkt t an einer Bedienstation angekommen

sind.

• Die Anzahl δt von Kunden, die bis zum Zeitpunkt t an einer Bedienstation bedient

worden sind. Diese, vom zufälligen Eintreten der Kunden in das Wartesystem und von

seiner (zufälligen) Bedienzeit abhängige, Zahl ist mit t veränderlich.

• Die Anzahl Bk der am Tag Nr. k insgesamt bearbeiteten Einkommensteuerbescheide in

einem Finanzamt.

Statt einer einzelnen Zufallsvariablen zu einem bestimmten Moment hat man also eine Familie

von Zufallsvariablen, die zu jedem Zeitpunkt (t ≥ 0, oder k ∈ N) bestimmte (zufällige) Werte

annehmen.

Definition 3.1

Es sei T = [0, ∞[ oder T = {0, 1, . . .}. Für jedes t ∈ T sei eine Zufallsvariable Xt : Ω → R

gegeben. Dann nennen wir die Gesamtheit der Zufallsgrößen (Xt )t∈T einen stochastischen

Prozess. Ist T = [0, ∞[, so heißt (Xt )t∈T ein stochastischer Prozess mit stetigem oder kontinuierlichem (Zeit-) Parameter, im Falle T = {0, 1, . . .} ein stochastischer Prozess mit

diskretem (Zeit-) Parameter. Oft spricht man auch salopp von einem stochastischen Prozess mit stetiger (bzw. diskreter) Zeit.

Beispiele für das Auftreten stochastischer Prozesse im Zusammenhang mit technisch-ökonomischen Wartesystemen sind beispielsweise:

(i) mit diskretem (Zeit-)Parameter:

• Zwischenankunftszeit τk := Tk −Tk−1 , k = 1, 2, . . . zwischen Kunde k −1 und Kunde

k

• Bedienzeit des k-ten Kunden, Sk , k = 1, 2, . . .

• Ankunftszeitpunkte des k-ten Kunden, Tk , k = 1, 2, . . .

• Zeitpunkt sk an dem der k-te Kunde das Wartesystem verlässt

24

3 Stochastische Prozesse in Wartesystemen, „Gedächtnislosigkeit“

OR II c, Master-Modul IV

• Dauer bis zum Zeitpunkt, in dem die Warteschlange zum ersten Mal k Kunden lang

ist

(ii) mit stetigem (Zeit-)Parameter:

• Länge der Warteschlange Nt zum Zeitpunkt t

• Anzahl der Kunden Lt , die sich zum Zeitpunkt t im Wartesystem befinden

• Anzahl der abgefertigten Kunden δt bis zum Zeitpunkt t

• Anzahl der zurückgewiesenen Kunden bis zum Zeitpunkt t

• Anzahl der zum Zeitpunkt t eintreffenden Kunden Xt

Um Kenngrössen für das Wartesystem zu ermitteln, wird es also notwendig sein, bestimmte

stochastische Prozesse des Systems zu untersuchen.

Beispiel 3.2 (Stochastische Prozesse an einem Ski-Lift:)

Wir betrachten als Wartesystem einen Ski-Teller-Lift innerhalb eines Skigebietes. Dieser

Teller-Lift befördert die Skifahrer, die bei ihm ankommen, wieder „nach oben“ und zwar

jeweils einen Skifahrer im Abstand von einer Zeiteinheit (z. B. 10 Sek.).

Auf Grund von statistischen Untersuchungen hat man festgestellt, dass ein Anteil von α

(0 < α < 1) aller abfahrenden Skifahrer den Teller-Lift benutzen wollen und der übrige

Anteil der Skifahrer , also (1 − α), an der Teller-Lift-Station vorbei fährt. Diese Information interpretieren wir so, dass mit Wahrscheinlichkeit α das Ereignis „ein abfahrender

Skifahrer hält am Lift und will wieder „nach oben“ befördert werden“ eintritt. Mit Wahrscheinlichkeit (1 − α) fährt er vorbei.

Wir bezeichnen mit {0, 1, . . .} die einzelnen Zeitpunkte, zu denen der Tellerlift bedienen

kann, betrachten die Zeitintervalle zwischen zweier solcher Bedienungen und nummerieren diese durch. Während eines Zeitintervalles [k, k − 1[ kommt also eine vom Zufall

abhängige Anzahl, nämlich Xk , von Skifahrern am Tellerlift an, um bedient zu werden.

Ein ankommender Skifahrer stellt sich, falls er nicht sofort befördert werden kann, in

einer Warteschlange an. Die Beförderungsdisziplin sei zunächst unerheblich. Die Grösse

Xk (also die Anzahl der im Zeitintervall [k − 1, k[ (k = 1, 2, . . .) am Tellerlift ankommenden Skifahrer) ist also eine Zufallsvariable und (Xk )k∈{1,2,...} ein stochastischer Prozess

mit diskreter Zeit.

Nehmen wir nun an, dass diese Zufallsvariablen Xk identisch verteilt (d. h. ihre Verteilung ist unabhängig vom Zeitintervall k immer dieselbe) und voneinander unabhängig

seien (d. h. die Ankünfte der innerhalb zweier verschiedenen Zeitintervalle ankommenden

Kunden seien voneinander unabhängig). Für die Verteilung gelte

pn := P (Xk = n) = (1 − α) · αn ,

n ≥ 0,

0 < α < 1,

d.h. die Zuvallsvariablen Xk sind jeweils gemäss einer geometrischen Verteilung mit Parameter α verteilt.1

Wenn wir wissen, dass die Ankünfte Xk auf diese Weise verteilt sind, so können wir

beispielsweise als eine Kenngrösse des Wartesystems die durchschnittliche Anzahl der

1

Dies entspricht der Wahrscheinlichkeit, dass die ersten n Skifahrer am Lift ankommen, bevor zum ersten Mal

ein Skifahrer vorbeifährt.

25

3 Stochastische Prozesse in Wartesystemen, „Gedächtnislosigkeit“

OR II c, Master-Modul IV

ankommenden Skifahrer am Lift, also die mittlere Anzahl der im Zeitintervall [k − 1, k[

(bzw. der in irgendeinem Zeitintervall) ankommenden Skifahrer, berechnen als:

E(Xk ) =

∞

X

n=0

=

n · P (Xk = n) = (1 − α) ·

α

.

1−α

∞

X

n=0

n · αn

Kennen wir also den Anteil α aller Skifahrer, die den Lift überhaupt benutzen wollen,

so haben wir auch bereits Kenntnis über die erwartungsgemäss in einem Zeitintervall

[k − 1, k[ dort ankommenden Skifahrer!

Ein weiterer, sich aus dem Prozess (Xk )k∈{1,2,...} ergebender, stochastischer Prozess mit

diskreter Zeit ist der Prozess (Nk )k∈{1,2,...} der Länge der Warteschlange (= Anzahl der

Wartenden) zum Zeitpunkt k (am Ende des Zeitintervalls [k − 1, k[ nach Ankunft der X

Skifahrer, aber vor Abfahrt des k-ten Tellers). Dieser Prozess lässt sich durch

Nk+1 =

(

Nk − 1 + Xk , falls Nk ≥ 1

X,

falls Nk = 0

beschreiben.

Wir sehen, dass bei diesem stochastischen Prozess die (zufällige) Warteschlangenlänge

Nk+1 unmittelbar vor dem Zeitpunkt k + 1 nur von der Länge der Warteschlange zum

Zeitpunkt k und von X, also den im Zeitintervall [k, k + 1[ ankommenden Skifahrern

abhängig ist, nicht jedoch davon, wie sich die Warteschlange in den Zeitpunkten vor k

verhalten hat. Stochastische Prozesse mit diskreter Zeit, bei denen der Wert zum Zeitpunkt k + 1 ausschließlich vom Wert zum Zeitpunkt k abhängt (und nicht von noch

früheren Werten), haben die sogenannte Markov-Eigenschaft.

Für den Prozess (Nk )k∈{1,2,...} könnten wir nun beispielsweise die Frage stellen, wie wahrscheinlich es ist, dass wir am Ende von Intervall [k, k + 1[ genau j Skifahrer in der

Warteschlange sehen, sofern wir zum Ende des vorhergehenden Zeitintervalls [k − 1, k[

i wartende Skifahrer beobachtet haben. Um diese Wahrscheinliochkeite zu beschreiben

überlegen wir uns, welches Ereignis im Intervall [k, k + 1[ stattgefunden haben muss.

Damit rechnen wir dann die sog. „Übergangswahrscheinlichkeiten“, d. h. die bedingten

Wahrscheinlichkeiten der Warteschlangenlänge

Pij

:= P (Nk+1 = j | Nk = i)

=

P (im Zeitintervall [k, k + 1[ stehen j Skifahrer in der Warteschlange |

im Zeitintervall [k − 1, k[ standen i Skifahrer in der Warteschlange)

aus. Wir überlegen uns:

– 0 ≤ j < i − 1: da zu jedem Zeitpunkt k nur ein Teller für die Beförderung zur

Verfügung steht, kann nicht mehr als eine Person abgefertigt werden, also

Pij = 0.

– Falls j ≥ i−1 ≥ 0, so entspricht diese Situation dem Ereignis: „Im Intervall [k, k+1[

kommen j − i + 1 Personen an, eine Person wird befördert“). Also:

Pij = (1 − α) · αj−i+1 .

26

3 Stochastische Prozesse in Wartesystemen, „Gedächtnislosigkeit“

OR II c, Master-Modul IV

– Falls i = 0, j ≥ 1, heisst das „Im Intervall [k, k + 1[ kommen j Personen an“. )

Daher

P0j = P (Xk = j) = (1 − α) · αj .

– Für i = 0, j = 0, liegt das Ereignis vor „Im Intervall [k, k + 1[ kommen 0 Personen

an“). D.h.

P00 = P (Nk+1 = 0 | Nk = 0) = P (X = 0) = p0 = (1 − α).

Wir bezeichnen eine nicht-negative, ganzzahlige Zufallsvariable Z als gedächtnislos, falls

P (Z ≥ n + i|Z > n) = P (Z ≥ i), für alle n, i

gilt.

Interpretation: Wenn man weiß, dass Z den Wert n überschritten hat, so ist die Wahrscheinlichkeit, dass Z diesen Wert n auch noch um den Wert i überschreitet, genau so gross wie

die Wahrscheinlichkeit, dass Z den Wert i überschreitet. Der Wert ist also unabhängig von

n, die Zufallsvariable Z „merkt“ sich also den Wert n nicht . Daher kommt der Begriff der

„Gedächtnislosigkeit“.

Achtung: „gedächtnislos“ heisst nicht: P (Z ≥ n + i|Z ≥ n) = P (Z ≥ n + i).

Die Eigenschaft der Gedächtnislosigkeit spielt bei der Modellierung und Analyse technischökonomischer Wartesysteme eine sehr wichtige Rolle, da sie (zumindest idealisiert) häufig in

der Realität beobachtet werden kann. (Natürlich haben nicht alle stochastischen Prozesse eine

derartige Eigenschaft.)

Übung: Zeigen Sie, die Eigenschaft der Gedächtnislosikteit für eine geoemetrisch verteilte Zufallsvariable.

Interessant dabei ist nämlich, dass für ganzzahlige, nicht-negative Zufallsvariablen die geometrische Verteilung die einzige Verteilung ist, welche die Eigenschaft der Gedächtnislosigkeit

besitzt.

Kann man also die Gedächtnislosigkeit einer diskreten, nicht-negativen Zufallsvariable Z beobachten, so muss diese Zufallsvariable Z geometrisch verteilt sein.

Wenn man dies also weiß (beobachtet hat) , geht es nun „nur noch“ darum, den Parameter α

zu „ermitteln“.

Die „Gedächtnislosigkeit“ von Zufallsgrössen kann auch im Falle stetiger Zufallsvariablen beobachtet werden.

27

3 Stochastische Prozesse in Wartesystemen, „Gedächtnislosigkeit“

OR II c, Master-Modul IV

Definition 3.3

Eine nicht-negative (rellwertige) Zufallsvariable Z heisst exponential-verteilt mit Parameter λ > 02 , falls für alle t ≥ 0

P (Z ≤ t) = P (Z < t) = 1 − e−λt

gilt.

Die Exponentialverteilung ist deshalb von so großer Bedeutung bei der Analyse technischökonomischer Wartesysteme, weil sie die einzige Verteilung ist, die für stetige, nicht-negative

Zufallsgrössen Z die sog. „Markov-Eigenschaft“ (oft als Eigenschaft der „Gedächtnislosigkeit“

bezeichnet) besitzt. Wir nennen eine nicht-negative Zufallsvariable Z als gedächtnislos, falls

P (Z ≥ t + s|Z ≥ t) = P (Z ≥ s), für alle t, s

gilt.

Interpretation: Wenn man weiß, dass Z den Wert t überschritten hat, so ist die Wahrscheinlichkeit, dass Z diesen Wert t auch noch um weitere s überschreitet, genau so gross wie die

Wahrscheinlichkeit, dass Z den Wert s überschreitet. Der Wert ist also unabhängig von t, die

Zufallsvariable Z „merkt“ sich also den Wert t nicht . Daher kommt der Begriff der „Gedächtnislosigkeit“.

Achtung auch hier: „gedächtnislos“ heisst nicht: P (Z ≥ t + s|Z ≥ t) = P (Z ≥ t + s).

Für eine exponentialverteilte Zufallsvariable gilt:

P (Z ≥ t + s | Z ≥ t) =

=

P (Z ≥ t + s und Z ≥ t)

P (Z ≥ t)

P (Z ≥ t + s)

e−λ·(t+s)

=

= e−λ·s = P (Z ≥ s).

P (Z ≥ t)

e−λ·t

Exponentialverteilte Zufallsvariablen werden typischerweise zur Modellierung von Lebensdauern von Objekten herangezogen, die „nicht altern“, die also stets „so gut, wie neu“ sind. Beispielsweise wird sie oft für eine adäquate Beschreibung

i. der Länge von Telefongesprächen,

ii. der Zeit, welche zwischen zwei aufeinander folgenden eingehenden (ausgehenden) Anrufen

vergeht,

iii. der Lebensdauern von Bauteilen, bei denen Verschleisserscheinungen nicht berücksichtigt

werden (müssen), siehe etwa „LED-Leuchtmittel“,

2

In der Literatur findet man auch manchmal die Bezeichnung „negativ exponential-verteilt“.

28

3 Stochastische Prozesse in Wartesystemen, „Gedächtnislosigkeit“

OR II c, Master-Modul IV

herangezogen.

Die obige Formel zeigt dies gerade: denn beschreibt Z etwa das Alter eines „nicht alternden“

Objektes, so sagt die Formel aus, dass im Falle einer Exponentialverteilung die Verteilung der

„Restlebensdauer“ s, gilt P (Z ≤ s) = P (Z ≤ t + s | Z > t), sie also unabhängig vom jetzigen

Alter t ist. „Die Überlebenswahrscheinlichkeit des Objektes in Bezug auf einen bestimmten

Zeitpunkt ist also unabhängig vom bisher erreichten Alter“.

Bei vielen in der Praxis vorkommenden, technisch-ökonomischen Wartesystemen kann man

nun (zumindest idealisiert) qualitativ beobachten, dass

(i)

a) die Zwischenankunftszeiten τk := Tk − Tk−1 , k = 1, 2, . . . jeweils stochastisch

unabhängige Zufallsvariablen sind,

b) die Zufallsvariablen τk identisch verteilt sind (also die Verteilung unabhängig von k

ist) und daher durch eine Zufallsvariable τ beschrieben werden kann

c) die Zufallsvariable τ die Eigenschaft der Gedächtnislosigkeit besitzt

(ii)

a) die Bedienzeiten Sk , k = 1, 2, . . . stochastisch unabhängige Zufallsvariablen sind.

b) die Zufallsvariablen Sk identisch verteilt sind (also die Verteilung unabhängig von

k ist) und daher durch eine Zufallsvariable S beschrieben werden kann

c) die Zufallsvariable S die Eigenschaft der Gedächtnislosigkeit besitzt

Kann man dies also für die einzelnen Zufallsvariablen „Zwischenankunftszeiten“ τ bzw. „Bedienzeiten“ S – zumindest idealisiert – feststellen, so muss die entsprechende Zufallsvariable

exponentialverteilt sein, d.h.

P (τ ≤ t) = 1 − e−λt , für geeignetes λ > 0,

bzw.

P (S ≤ t) = 1 − e−µt , für geeignetes µ > 0,

Damit geht es also nun aber „nur noch“ darum, die geeigneten Parameter λ ( bzw. µ) zu

„ermitteln“.

Hierzu macht man sich das Folgende zunutze: ist Z eine exponential-verteilte Zufallsvariable

(also P (Z ≤ t) = 1 − e−λt ), dann gilt für den Erwartungswert:

E(Z) =

1

.

λ

Die Grösse λ kann also angegeben werden, sofern man den Erwartungswert der Zufallsvariablen

kennt. Bei der Analyse eines konkreten Wartesystems könnte man daher also etwa so vorgehen,

und die beiden Erwartungswerte E(τ ) bzw. E(S) schätzen (bzw. experimentell bestimmen),

und auf diese Weise die Parameter λ bzw. µ ermitteln.

Bemerkung 3.4

Für eine exponential-verteilte Zufallsvariable Z mit Erwartungswert E(Z) =

aus :

29

1

λ

rechnen wir

3 Stochastische Prozesse in Wartesystemen, „Gedächtnislosigkeit“

•

1

− E(Z)

·E(Z)

P (Z ≤ E(Z)) = 1 − e

•

= 1 − e−1 = 1 − 0, 367 ≈ 0, 63

1

·0,5·E(Z)

− E(Z)

P (Z ≤ 0, 5 · E(Z)) = 1 − e

OR II c, Master-Modul IV

= 1 − e−0,5 = 1 − 0, 6065 ≈ 0, 40

Die Wahrscheinlichkeit, dass eine exponential-verteilte Zufallsvariable Z einen Wert annimmt,

der kleiner als ihr Mittelwert E(Z) ist, beträgt also mehr als 60%, und die Wahrscheinlichkeit, dass sie einen Wert annimmt, der kleiner als 12 · E(Z) ist, beträgt immer noch ungefähr

40%. Exponentialverteilte Zufallsvariabeln „bevorzugen“ also (gemessen am Mittelwert) kleinere Zwischenankunftszeiten.

Beispiel 3.5

In einer ALDI-Filiale wird im Rahmen einer Service-Analyse das Bedienverhalten an einer

der Kassen Kasse untersucht. Es wird dabei festgestellt, dass sich die Bedienzeiten der Kunden

„gedächtnislos“ verhalten und eine Bedienung im Durchschnitt 1 min 40 sec (= 100 sec) dauert.

Der Filialleiter gewinnt daraus folgende Informationen:

• die Bedienzeit S eines Kunden ist exponential-verteilt, d.h. P (S ≤ t) = 1 − e−µt

• Um µ zu bestimmen, führt man den Ansatz durch:

100 sec = E(S) =

1

1

⇔µ=

sec−1

µ

100

.

Mit diesen Daten kann man nun beispielsweise die Wahrscheinlichkeit berechnen, dass die

Bedienzeit eines Kunden nicht länger als 10 sec dauert:

−1

P (S ≤ 10 sec ) = 1 − e−0,01 sec ·10 sec = 1 − e−0,1 = 0, 0951 ≈ 0, 1

Oder die Wahrscheinlichkeit, dass sie länger als 80 sec ist :

−1

P (S ≥ 80 sec ) = 1 − P (S ≤ 80 sec ) = 1 − (1 − e−0,01 sec ·80 sec ) = e−0,8 = 0, 449 ≈ 0, 45

Der Filialleiter interpretiert diese Größen nun so, dass bei ca. 10 % der Kunden der Kassiervorgang nicht länger als 10 Sekunden benötigt und ca. 45 % der Kunden länger als 80 Sekunden

an der Kasse stehen.

Übung

In einer Zahnarztpraxis befinden sich 2 Behandlungsstühle. Die Behandlungszeiten der einzelnen Patienten sind voneinander unabhängig und exponential-verteilt mit Mittelwert 20 Minuten. Innerhalb der den nächsten 30 Minuten kommen genau 3 Patienten, nämlich A (zum

Zeitpunkt 0), B (zum Zeitpunkt 15 min) und C ( zum Zeitpunkt 30 min) in der Praxis an,

um dort behandelt zu werden. Zum Zeitpunkt 0 wird kein Patient behandelt.

Wenn B ankommt, wird A noch behandelt, wenn C ankommt befinden sich beide, A und B,

noch in Behandlung.

• Wie gross ist die Wahrscheinlichkeit, dass A vor B mit der Behandlung fertig ist?

30

3 Stochastische Prozesse in Wartesystemen, „Gedächtnislosigkeit“

OR II c, Master-Modul IV

• Wie gross ist die Wahrscheinlichkeit, dass C vor A mit der Behandlung fertig ist?

• Wie gross ist die Wahrscheinlichkeit, dass C vor B mit der Behandlung fertig ist?

Überlegen Sie sich dies bitte selbst.

Im Weiteren werden wir nun zunächst davon ausgehen, dass alle betrachteten Wartesysteme

exponentialverteilte Zwischenankunftszeiten (Parameter λ) und exponentialverteilte Bedienzeiten (Parameter µ) besitzen. In diese4m Fall so können wir dann auch eine Aussage über die

„Anzahl der Ankünfte“ in einem bestimmten Beobachtungsintervall [0, t] treffen.

Wir machen dazu zunächst die folgende allgemeine Definition:

Definition 3.6

Es sei (Zk )k∈N0 ist ein stochastischer Prozess mit diskreter Zeit, 0 = Z0 ≤ Z1 ≤ Z2 ≤ . . .,

so dass die Differenzen zk := Zk − Zk−1 , k = 1, 2, . . . voneinander unabhängige Zufallsvariable

sind, welche alle mit demselben Parameter λ > 0 exponentialverteilt sind. Für t ≥ 0 sei die Zufallsvariable Xt definiert als Xt := j, falls Zj ≤ t < Zj+1 . Dann nennen wir den stochastischen

Prozess mit stetiger Zeit (Xt )t∈[0,∞[ einen Poisson-Prozess mit Intensität λ.

Bemerkung 3.7

(i) Beschreibt der stochastische Prozess (Zk )k∈N0 speziell die Ankunftszeitpunkte Tk (wir

haben also den Prozess (Tk )k∈N0 ), so spricht bei dem zugehörigen stochastischen Prozess

(Xt )t∈[0,∞[ auch häufig von einem Poisson’schen Ankunftsprozess mit Intensität

λ. Statt Xt schreibt man in diesem Fall αt . Die Zufallsvariable αt zählt also gerade die

im Intervall [0, t[ am Wartesystem angekommenen Kunden.

Xt=®t

5

4

3

2

1

T1

T2 T3

T4

T5

t

(ii) Der Begriff „Poisson-Prozess“ rührt daher, dass sich aus der Exponentialverteilung der

Differenzen zk = Tk −Tk−1 (also P (zk ≤ t) = 1−e−λt ) die Verteilung der Zufallsvariablen

αt im stochastischen Prozess (Xt )t∈T ergibt als

P (αt = k) =

31

(λ · t)k −λt

·e .

k!

3 Stochastische Prozesse in Wartesystemen, „Gedächtnislosigkeit“

OR II c, Master-Modul IV

Für einen festen Zeitpunkt t ist die Zufallsvariable Xt also Poisson-verteilt mit Parameter λ · t. (siehe Übung)

(iii) Wir haben genauer (siehe bspw. [30]):

(αt )t≥0 Poisson-verteilt mit Intensität λ ⇔ τ exponentialverteilt mit Parameter λ.

Sind in einem Wartesystem die Zwischenankunftszeiten der Kundenankünfte exponentialverteilt mit Parameter λ, dann ist die Zufallsvariable αt , die die Anzahl

der Ankünfte beschreibt, die im Zeitintervall [0, t[ stattfinden, Poisson-verteilt

mit Parameter λ · t. Und umgekehrt.

(iv) Ist (Xt )t∈[0,∞[ ein Poisson-Prozess mit Intensität λ, so gilt (bekanntlich) für den Erwartungswert und die Varianz der Zufallsvariablen Xt :

E(Xt ) =

∞

X

k=0

k · P (Xt = k) = λ · t

und

Var(Xt ) = λ · t.

Beschreibt (αt )t∈[0,∞[ einen Poisson’schen Ankunftsprozess mit Intensität λ, so ist die

„durchschnittliche Anzahl“ von Kunden, die bis zum Zeitpunkt t in das System eingetreten sind, also gleich λ · t.

Die Größe λ entspricht also gerade der „durchschnittlichen Anzahl“ von Kunden, die

pro Zeiteinheit in das System eintreten, d. h. der Ankunftsrate für das technischökonomische Wartesystems.

(v) Durch Satz 2.18 (siehe Seite 18) wissen wir, dass sich Poisson-Prozesse „addieren“.

Haben wir beispielsweise „Kunden eines Typs I“, deren Ankunftsprozess am System

durch einen Poisson-Prozess (αIt )t∈[0,∞[ einen mit Ankunftsrate λI , beschrieben werden kann und „Kunden eines Typs II“, deren Ankunftsprozess am System durch einen

II

Poisson-Prozess (αII

t )t∈[0,∞[ mit Ankunftsrate λ , erfolgt, so ist der gemeinsame Ankunftsprozess beider Kundentypen ebenfalls ein Poisson-Prozess mit der Ankunftsrate

λ = λI + λII .

Eine analoge Aussage gilt natürlich auch für mehr als zwei „Kundentypen“.

(vi) Betrachten wir die „umgekehrte“ Situation: Gegeben sei ein Poisson’scher Ankunftsprozess mit Ankunftsrate λ. Angenommen jeder Kunde, der ankommt, gehört zu einem von

zwei Kundentypen („Typ 1“ bzw „Typ II“).

Mit Wahrscheinlichkeit p ist er „Kunde des Typs I“, mit Wahrscheinlichkeit 1− p „Kunde

des Typs II“. Die die Ankünfte der beiden Typen sind unabhängig voneinander. Dann

sind die so aufgeteilten Ankunftsprozesse (αIt )t∈[0,∞[ bzw. (αII

t )t∈[0,∞[ der jeweiligen

Kundentypen ebenfalls Poisson’sche Ankunftsprozesse mit den Parametern λI = p · λ

bzw. λII = (1 − p) · λ.

Diese „Splitting-Eigenschaft“ gilt auch hier für mehr als zwei solcher Aufteilungen.

Beispiel 3.8

Bei der Situation in Beispiel 3.5 werde zudem festgestellt, dass durchschnittlich alle 10 Sekunden ein Kunde an die Kasse herantritt, wobei die Zeit, die zwischen dem Herantreten vergeht

sich gedächnislos verhält. Der Filialleiter ist daran interessiert, zu erfahren

32

3 Stochastische Prozesse in Wartesystemen, „Gedächtnislosigkeit“

OR II c, Master-Modul IV

• wie gross die Wahrscheinlichkeit ist, dass innerhalb einer Minute mehr als 6 Kunden an

die Kasse herantreten

• wie gross die Wahrscheinlichkeit ist, dass innerhalb einer Minute genau 3 Kunden an die

Kasse herantreten

Um dies zu ermitteln, schliesst er aus der Gedächtnislosigkeit der Zwischenankunfstzeit τ

zunächst, dass diese exponentialverteilt sind (mit Parameter λ). Wenn er die Zeiteinheit als

„Minute“ festlegt, beobachtet er also durchschnittlich 6 Personenankünfte pro Minute erhält

6

= 6 · min−1 .

so die Ankunftsrate λ = min

Nun ermittelt er für das Intervall [0, 1] (also t = 1 min) die Wahrscheinlichkeiten

P (α1 = k) =

(6 · t)k −6·t

·e

.

k!

Er erhält

Kunden k

0

1

2

3

4

5

6

7

8

usw.

P (α1 = k)

0,0025

0,015

0,0446

0,0892

0,1339

0,1606

0,1606

0,1307

0,1033

usw.

Damit haben wir dann

P (α1 > 6) = 1 −

6

X

i=0

P (α1 = i) ≈ 1 − 0, 604 = 0, 396

und

P (α1 = 3) ≈ 0, 09.

Für die Untersuchung von Wartesystemen benötigt man – wie wir sehen werden – auch den

Zuwachs αt − αs der innerhalb eines bestimmten Zeitintervalls [s, t] in das System eingetretenen Kunden. Die zufällige Größe ∆s,t = αt − αs , welche diesen beschreibt, kann offenbar

nur die Werte 0, 1, . . . annehmen. Eine Eigenschaft, die für man für die Beschreibung dieser

Zuwächse ausnutzt, wird durch den folgenden wichtigen allgemeinen Sachverhalt beschrieben

(siehe [30]).

Satz 3.9

Ein monoton wachsender, stochastischer Prozess (Xt )t∈[0,∞[ ist ein Poisson-Prozess mit der

Intensität λ > 0 genau dann, wenn die beiden folgenden „Prozess-Eigenschaften“ vorliegen:

33

3 Stochastische Prozesse in Wartesystemen, „Gedächtnislosigkeit“

OR II c, Master-Modul IV

(i) („Prozess mit unabhängigen Zuwächsen“)

Es gilt X0 = 0, und für jedes s ∈ [0, t[ sind die Zufallsvariablen ∆s,t = Xt −Xs voneinander

stochastisch unabhängig .

(ii) („Prozess mit Poisson-verteilten Zuwächsen“)

Für alle festen s, t mit 0 ≤ s < t ist ∆s,t = Xt − Xs eine Poisson-verteilte Zufallsvariable

mit dem Parameter λ · (t − s), d. h.

P (∆s,t = k) = P (Xt − Xs = k) =

(λ(t − s))k −λ(t−s)

·e

k!

Bemerkung 3.10

Aus der Tatsache, dass ein Poisson-Prozess auch Poisson-verteilte Zuwächse besitzt, ergibt

sich zunächst

P (αt+h − αs+h = k) = P (αt − αs = k) = P (αt−s = k) für alle k ≥ 0.

Diese Eigenschaft beschreibt die sog. Stationarität bzw. die zeitliche Homogenität des Prozessen

(αt )t∈[0,∞[ .

Nutzt man nun die Reihendarstellung der e-Funktion (siehe Kap. 2.4), d.h.

∞

X

e−x =

i=0

(−1)i ·

xi

x1 x2 x3

=1−

+

−

...,

i!

1!

2!

3!

dann schliesst man für s = t + h und h „klein“:

(i) P (αt+h − αt = 1) =

(λ·h)1

1!

· e−λ·h = λ · h · (1 − λ · h +

(ii) P (αt+h − αt = 0) =

(λ·h)0

0!

· e−λ·h = 1 · (1 − λ · h +

(iii) P (αt+h − αt = k ≥ 2) =

(λ·h)k

k!

· e−λ·h =

(λ·h)k

k!

(λ·h)2

2!

(λ·h)2

2!

−

· (1 − λ · h +

−

(λ·h)3

3!

(λ·h)3

3!

(λ·h)2

2!

. . .) = λ · h + o(h)

. . .) = 1 − λ · h + o(h)

−

(λ·h)3

3!

. . .) = o(h)

Beispiel 3.11

Als Fan des Fussball-Vereins „Borussia Dortmund“ gehen Sie durchschnittlich einmal im Monat (= 30 Tage) in das heimische Stadion, besuchen dort ein Bundesligaspiel, schauen sich

Trainings an oder besuchen die Vereins-Kneipe, um dort gegebenenfalls Spieler zu treffen, etc.

Sie haben festgestellt, dass die Zeit zwischen zwei solcher Besuche exponentialverteilt ist. Beantworten Sie bitte die folgenden Fragen:

• Wie groß ist die Wahrscheinlichkeit, dass Sie in einer Zweimonatsperiode das Stadion

nicht besucht haben?

• Wie groß ist die Wahrscheinlichkeit, dass Sie mehr als 6 mal im Jahr das Stadion besucht

haben?

• Wie groß ist die Wahrscheinlichkeit, dass zwischen 2 Besuchen mehr als 3 Monate vergangen sind?

34

3 Stochastische Prozesse in Wartesystemen, „Gedächtnislosigkeit“

OR II c, Master-Modul IV

• Wie gross ist die Wahrscheinlichkeit, dass Sie innerhalb der nächsten beiden Tage zweimal

das Stadion besuchen?

• Wie groß ist die Wahrscheinlichkeit, dass Sie sowohl heute als auch morgen einmal ins

Stadion gehen?

• Wie groß ist die Wahrscheinlichkeit, dass Sie während eines gesamten Jahres nicht im

Stadion waren?

Siehe auch Übungsblatt 2.

Zusammenstellung der Eigenschaften des Ankunftsprozesses (αt )t∈[0,∞[ mit Intensität λ

Wenn die Zwischenankuftszeiten τ mit Parameter λ exponentialverteilt sind, dann gilt:

(i) Für festes t ist die Zufallsvariable αt Poisson-verteilt mit Parameter λ · t

P (αt = k) =

(λ · t)k −λt

·e

k!

(ii) Als durchschnittliche Anzahl der bis zum Zeitpunkt t angekommenen Kunden ergibt sich:

E(αt ) = λ · t

(iii) Die durchschnittliche Anzahl der pro Zeiteinheit angekommenen Kunden entspricht der

Ankunftsrate =

E(αt )

=λ

t

(iv) Als Wahrscheinlichkeitsverteilung für die Anzahl der „Neukunden“ im Intervall [t, s] erhält man:

(λ(s − t))k −λ(s−t)

P (αs − αt = k) =

·e

k!

(v) Speziell für s = t + h und h „klein“, d. h. h → 0 gilt † :

P (αt+h − αt = 1) = P (αh = 1) = λ · h + o(h)

P (αt+h − αt = 0) = P (αh = 0) = 1 − λ · h + o(h)

P (αt+h − αt ≥ 2) = P (αh ≥ 2) = o(h)