Zusammenfassung.

Werbung

PROBABILISTISCHE KOMBINATORIK

GOETHE-UNIVERSITÄT FRANKFURT, WINTERSEMESTER 2013/14

YURY PERSON

Abstract. Material covered so far.

Contents

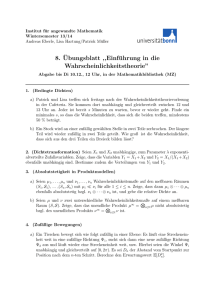

1. Taubenschlagprinzip (Schubfachprinzip, pigeonhole principle)

1.1. Begriffe aus der Graphentheorie

1.2. Ramseyzahlen

2. Probabilistische Methode: ”erste Schritte”

2.1. Untere Schranken an r(k)

2.2. Diskrete Wahrscheinlichkeitstheorie

2.3. Das Grundprinzip der probabilistischen Methode

2.4. Erste Anwendungen der probabilistischen Methode

2.5. Weitere Anwendungen

2.6. Asymptotisches Verhalten

2.7. Eine asymptotische untere Schranke an die Ramseyzahl r(k)

2.8. Alterations: wenn man die Zufallsvariablen miteinander kombiniert

2.9. Graphen mit großer chromatischer Zahl und ohne kurze Kreise

2.10. Zwei berühmte Geometrieprobleme von Erdős

2.11. Lovász local Lemma

2.12. Zweite Momentmethode

2.13. Graphenigenschaften

3. Exponentell kleine Wahrscheinlichkeiten

3.1. Chernoff-Ungleichung

3.2. FKG-Ungleichung

3.3. Martingale

3.4. Jansons Ungleichung

4. Kombinatorische Theoreme

4.1. Schnitttheoreme

4.2. Entropie

5. Regularitätslemma und seine Anwendungen

5.1. Removal Lemma und Roths Theorem

References

1

2

2

2

3

3

3

4

4

6

6

7

7

9

10

10

11

12

15

15

17

18

21

24

24

25

30

30

33

2

YURY PERSON

1. Taubenschlagprinzip (Schubfachprinzip, pigeonhole principle)

Einfachste Form: fliegen n + 1 Tauben in n Löcher, so gibt es mindestens ein

Loch mit mindestens zwei Tauben.

(1) Bei 13 Menschen gibt es zwei, die im selben Monat Geburtstag haben.

(2) Seien a1 , . . . , am ganze Zahlen. Dann gibt es aufeinanderfolgende Zahlen

ai , ai+1 ,. . . , aj , deren Summe durch m teilbar ist.

Pi

Beweisidee: teilt m die Summen Si :=

`=1 a` für alle i ∈ [m] nicht, so muss

es i < j geben mit Si ≡ Sj ( mod m). Also teilt m die Summe

ai+1 , . . . , aj .

(3) Ein Schachgroßmeister bereitet sich auf ein Turnier vor, welches in 11

Wochen stattfindet. Dabei entscheidet er sich, jeden Tag mindestens ein

Spiel zu bestreiten, aber pro Woche höchstens 12 Spiele zu spielen. Zeigen

Sie: es gibt einen zusammenhängenden Zeitraum von (ganzen) Tagen, in

dem der Schachgroßmeister genau 21 Spiele spielt.

Beweisidee: Sei ai die Anzahl bestrittener Spiele bis zum Tag i. Es gilt: 1 ≤ a1 <

a2 < . . . < a77 ≤ 132 = 11 · 12. Betrachten Sie die Folge bi := ai + 21,

i ∈ [77] und wenden Sie das Schubfachprinzip an.

P

Starke Form: seien q1 ,. . . , qn ∈ N. Verteilt man ( i∈[n] qi ) − n + 1 auf n

Schubladen, so gibt es entweder in der ersten mindestens q1 Objekte, oder in der

zweiten mindestens q2 Objekte oder in der dritten mindestens q3 Objekte, oder ...

oder in der nten mindestens qn Objekte. (Beweis durch Widerspruch).

1.1. Begriffe aus der Graphentheorie.

• Ein Graph G ist ein Tupel (V, E) mit E ⊆ V2 . V heißt Knotenmenge und

E heißt Kantenmenge.

• Die Elemente aus V heißen Knoten und die Elemente aus E Kanten.

• Knoten werden graphisch durch Punkte dargestellt, während eine Kante

e = {u, v} durch eine Verbindungstrecke (Kurve), die u und v miteinander

verbindet, dargestellt wird.

• Für eine Kante e = {u, v} heißen u und v deren Endknoten. Ferner heißen

u und v benachbart (adjazent), und man sagt u und v sind mit e inzident.

• Kn bezeichnet den Graphen ([n], [n]

2 ), den vollständigen Graphen auf n

Knoten.

1.2. Ramseyzahlen.

Definition 1 (Ramseyzahl r(k)). Die Ramseyzahl r(k) ist die kleinste

natürliche

[n]

Zahl n, so dass es in jeder Färbung der Kanten von Kn = [n], 2

eine einfarbige

Kopie von Kk gibt.

Formal:

o

n

[n]

S

r(k) := min n ∈ N | ∀ c : [n]

→

{rot,blau}

∃

S

∈

s.t.

|c

|

=

1

.

2

k

2

• Beispiele für kleine Ramseyzahlen: r(2) = 2, r(3) = 6 (der Beweis wurde in

der Vorlesung präsentiert), r(4) = 18, 43 ≤ r(5) ≤ 49, 102 ≤ r(5) ≤ 165. . .

Date: February 14, 2014.

15.Oktober 2013

PROBABILISTISCHE KOMBINATORIK

3

• Möchte man also zeigen, dass r(k) > ` ist, so braucht man eine rotblau Färbung des K` zu finden mit der Eigenschaft, dass es auf jeder kelementigen Teilmenge von [`] mindestens eine rote und mindestens eine

blaue Kante gibt.

• Möchte man aber zeigen, dass r(k) ≤ ` so muss man argumentieren, dass

egal wie man die Kanten des K` färbt, eine einfarbige Kopie unvermeidbar

ist.

• Satz von Ramsey (1930) Für jedes k ∈ N gilt r(k) ist endlich.

2k−3 • (Beweisskizze für r(k) ≤ 22k−3 ): sei c : [2 2 ] → {rot,blau} beliebig aber

fest. Nimm’ einen Knoten v1 ∈ [22k−3 ] heraus. Er ist zu mindestens 22k−4

Knoten (bezeichne diese Menge V2 ) in derselben Farbe F1 ∈ {rot,blau}

verbunden. Sei v2 ∈ V2 , er ist zu mindestens 22k−5 Knoten aus V2 in

derselben Farbe F2 ∈ {rot,blau} verbunden (bezeichne die Menge der zu v2

verbundenen Knoten aus V2 in der Farbe F2 als V3 )). Iteriere den Prozess.

Am Ende hat man Knoten v1 ,. . . , v2k−2 mit der Eigenschaft, dass vi zu

allen Knoten in {vi+1 , . . . , v2k−2 } in der Farbe Fi verbunden ist. Da es

2k − 3 Fi s gibt, sind mindestens k − 1 von ihnen entweder rot oder blau.

Es findet sich also eine monochromatische (einfarbige) Kopie von Kk .

Buchreferenzen:[3, Kapitel 3],[11, Kapitel 3 und 4].

2. Probabilistische Methode: ”erste Schritte”

2.1. Untere Schranken an r(k).

• r(k) > (k − 1)2 : partitioniere [(k − 1)2 ] Knoten in k − 1 Gruppen á k − 1

Knoten, färbe innerhalb jeder Gruppe alle Kanten rot, und zwischen je zwei

Gruppen alle Kanten blau. Es ist klar, dass es kein monochromatisches Kk

gibt.

• Erdős 1947: r(k) > 2k/2 für k ≥ 3. (Bemerke: diese untere Schranke ist

exponentiell in k, wächst also viel schneller als jedes Polynom in k. Wir

kommen auf asymptotisches Wachstum etwas später zu sprechen)

• Beweisidee (Erdős): sei c : [n]

→ {rot, blau} schlecht, falls es ein

2

k/2

monochromatisches Kk ”erzeugt”, sonst gut. Nimm an n =

und zeige,

2

n

dass die Anzahl der schlechten Färbungen kleiner als 2 2 ist. Also muss

es eine gute Färbung geben, also r(k) > n.

• Wir halten fest: 2k/2 < r(k) < 22k . Diese Schranken sind (asymptotisch)

das Beste, was man kennt!

• $100/$250 Erdősprobleme: existiert limk→∞ r(k)1/k ? Wenn es existiert, was ist es?

2.2. Diskrete Wahrscheinlichkeitstheorie.

• denselben Beweis von Erdős könnte man auch so formulieren: färbe zufällig

(gleichwahrscheinlich und unabhängig) alle Kanten von Kn mit rot/blau.

Dann ist die Wahrscheinlichkeit,

dass es eine monochromatische Kopie von

k

n 1− 2

Kk gibt kleiner als k 2

. Ist diese kleiner alsP

1, so folgt: r(k) > n.

• (Ω, P) mit |Ω| < ∞ und P : Ω → [0, 1] mit

ω∈Ω P(ω) = 1 heisst

(diskreter) Wahrscheinlichkeitsraum. (In dieser Vorlesung beschränken wir

uns meistens auf endliche Wahrscheinlichkeitsräume mit der σ-Algebra

18.Oktober 2013

4

YURY PERSON

•

•

•

•

•

P(Ω) (Potenzmenge von Ω)). P heisst dabei Wahrscheinlichkeitsmaß

(Wahrscheinlichkeitsverteilung).

Wenn wir ein zufälliges Element aus Ω ziehen, so ziehen wir ω mit

1

Wahrscheinlichkeit P(ω). Falls P(ω) = |Ω|

für alle ω ∈ Ω, so heißt P

Gleichverteilung (auch uniforme Verteilung genannt.)

Eine Teilmenge A ⊆ Ω heißt

P Ereignis (engl. event). Dessen Wahrscheinlichkeit ist durch P(A) := a∈A P(a) definiert.

Meistens werden Funktionen X studiert, die den Elementen aus Ω Werte

in R zuweisen. Solche Funktionen heißen Zufallsvariable (engl. random

variable).

Der Erwartungswert (engl.

Pexpectation) E[X] einer Zufallsvariable X : Ω →

R ist durch E[X] :=

Im Falle der Gleω∈Ω X(ω)P(ω) definiert.

ichverteilung ist das der Durchschnitt aller Werte von X(ω), ω ∈ Ω.

Linearität des Erwartungswerts (engl. linearity of expectation):

Seien

Pn X1 , . . . , Xn Zufallsvariable und λ1 ,. . . , λn ∈ R. Dann gilt für X :=

i=1 λi Xi :

n

X

E[X] =

λi E[Xi ].

i=1

S

• Union bound (Bonferroni Ungleichung): Oft wird P( i∈[n] Ei ) durch

P

S

P

i∈[n] P(Ei ) abgeschätzt, d.h. P( i∈[n] Ei ) ≤

i∈[n] P(Ei ). (Gleichheit

gilt, falls alle Ei disjunkt sind.)

• Gegeben seien (Ωi , Pi ) W-Räume

Q (i ∈ [n]). Dann ist Ω := ×i∈[n] Ωi (kartesisches Produkt) mit P(ω) := i∈[n] Pi (ωi ) für jedes ω = (ω1 , . . . , ωn ) ∈ Ω

der Produktraum.

2.3. Das Grundprinzip der probabilistischen Methode.

• SeiS(Ω, P) ein (diskreter) W-Raum. Seien E1 ,. . . , En Ereignisse. Gilt nun

P( i∈[n] Ei ) < 1, so existiert ein ω ∈ Ω, welches keine der Eigenschaften

S

c

besitzt, die durch Ei s ”beschrieben” werden (ω ∈

).

i∈[n] Ei

• Gilt E[X] ≥ a, so gibt es ein ω ∈ Ω mit X(ω) ≥ a. (Dasselbe gilt für ≤).

Es ist oft hilfreich, X als Summe von geeigneten Indikatorzufallsvariablen

darzustellen um dann die Linearität des Erwartungswerts auszunutzen.

2.4. Erste Anwendungen der probabilistischen Methode.

• Erdős 1947, Beweisidee: färbe die Kanten des Kn zufällig, mit

Wahrscheinlichkeit

1/2 rot oder blau. (Ω, P) ist dabei der Produktraum

der n2 identischen W-Räume ({rot, blau}, Pi ) mit Pi (rot) = Pi (blau) =

1/2. P ist also die Gleichverteilung auf der Menge aller Kantenfärbungen

[n]

{rot, blau} 2 . (AB bezeichnet die Menge aller Funktionen von B nach

A). Für jedes S ∈ [n]

definiert man das Ereignis ”zufälliges ω induziert

k

ein monochromatisches

K

k ”. Da die Kanten unabhängig gefärbt sind, gilt:

k

P(AS ) = 21− 2 . Union bound-Argument liefert die Behauptung.

• Property B:

– H = (V, E) heißt k-uniformer Hypergraph, falls E ⊆ Vk . Elemente

aus E heißen (Hyper-)Kanten und Elemente aus V heißen Knoten.

PROBABILISTISCHE KOMBINATORIK

5

– Erdős 1963: Jeder k-uniforme Hypergraph mit weniger als 2k−1 Kanten hat eine rot-blau Färbung seiner Knoten ohne monochromatische

Kanten.

– Beweisidee: färbe die Knoten zufällig rot/blau (gleichwahrscheinlich).

Die erwartete Anzahl der monochromatischen Kanten ist kleiner als 1.

Also ist H bipartit (d.h. rot/blau-färbbar).

Buchreferenzen:[1, Kapitel 1],[11, Kapitel 3 und 5].

Weitere Begriffe aus der W-Theorie (gegeben ein W-Raum (Ω, P))

−1

• Für ein A ⊆ R bezeichnet {X ∈ A} das Ereignis X (A) = {ω : X(ω) ∈ A}.

• Ereignisse

E1 ,.Q. . , En ⊆ Ω heißen unabhängig, falls für alle J ⊆ [n] gilt

T

P( i∈J Ei ) = i∈J P(Ei ).

• Für ein Ereignis E bezeichnet 1E die Indikatorzufallsvariable mit 1E (ω) = 1

falls ω ∈ E und 1E (ω) = 0 falls ω 6∈ E. Es gilt: E[1E ] = P[E].

• Zufallsvariable X1 , . . . , Xn heißen unabhängig, falls für alle Ai ⊂ R, i ∈ [n]

gilt:

P(X1 ∈ A1 ∧X2 ∈ A2 ∧. . .∧Xn ∈ An ) = P(X1 ∈ A1 )·P(X2 ∈ A2 )·. . .·P(Xn ∈ An ).

• Die Varianz (engl. variance) misst den quadratischen Abstand der Werte

von X zum Erwartungswert E[X]: Var[X] := E[(X − E[X])2 ] = E[X 2 ] −

(E[X])2 .

Beispiel (zufällige rot-blau-Färbung von V ): Viele der Anwendungen, die wir

nun sehen werden, “laufen” wie folgt ab: typischerweise werden wir eine gegebene

Grundmenge V = {v1 , . . . , vn } zufällig mit 2 (oder mehr) Farben färben. Dabei

wird in der Regel v ∈ V zufällig und unabhängig von den anderen Elementen

aus V gefärbt. Wir assozieren also mit jedem vi eine Zufallsvariable Xi , so dass

alle X1 ,. . . , Xn unabhängig und identisch verteilt sind (engl. i.i.d.(independently

identically distributed)) und die Werte 0 und 1 annehmen. Zum Beispiel, falls

Xi = 1 ist, so färben wir vi rot und falls Xi = 0, so färben wir vi blau. Mithilfe der

Zufallsvariablen X1 , . . . , Xn können wir dann viele ”Situationen” beschreiben.

2.4.1. Beispiele.

• Sei A ⊂ V mit A = {vi1 , . . . , vik }, dann gilt P(A ist monochromatisch) =

P(Xi1 = . . . = Xik ) = P(Xi1 = . . . = Xik = 1) + P(Xi1 = . . . = Xik = 0) =

pk + (1 − p)k . Dabei: P(A ist rot) = pk und P(A ist blau) = (1 − p)k .

• Falls p = 1/2, so gilt: P(A ist monochromatisch) = 21−k .

• Sei E das Ereignis “A ist monochromatisch”, dann gilt E[1E ] = P(E) =

k

pk + (1

P− p) .

• X := i Xi ist dann binomialverteilt mit Parametern n und p. D.h. P(X =

k) = nk pk (1 − p)n−k .

• Property B

Der Wahrscheinlichkeitsraum, den wir dabei betrachten, können wir wie folgt als

Produktraum von Bernoulliräumen auffassen. Ein einzelner Bernoulliraum ist

gegeben durch (Ω, P) mit Ω = {0, 1} und P(1) = p und P(0) = 1−p. Dann definieren

P

wir den

Produktraum (Ωn , Pn ) durch Ωn := {0, 1}n und Pn (ω) = p i ωi (1 −

P

p)n− i ωi , sowie Xi : Ωn → {0, 1} durch Xi (ω) = ωi für ω = (ω1 , . . . , ωn ) ∈ Ωn .

22.Oktober 2013

6

YURY PERSON

Man kann leicht nachrechnen, dass Xi unabhängig sind. Ferner sind alle Zufallsvariable (bzw. Ereignisse unabhängig), die von verschiedenen Koordinaten aus

[n] “abhängen”.

Mehr als 2 Farben: falls die Anzahl der Farben s > 2 dann betrachten wir

Produkträume, d.h. Ω = 1, . . . , s mit P(i) = pi , und der Produktraum Ωn := Ωn

Qs

#{ω =i}

mit Pn (ω) = i=1 pi j . Die entsprechenden Zufallsvariablen bzw. Ereignisse

bleiben unabhängig. Ferner kann man eine Färbung von V mit s Farben eins-zueins (bijektiv) mit einer Partition von V in höchstens s Teilmengen identifizieren.

2.5. Weitere Anwendungen.

• Bipartite Teilgraphen: Sei G = (V, E) ein Graph mit m Kanten, dann

enthält G einen bipartiten Teilgraphen mit mindestens m/2 Kanten.

• Beweis: Färbe die Knoten zufällig rot oder blau. D.h. der Wahrscheinlichkeitsraum ist Ω = {rot, blau}V und P(ω) = (1/2)|V | für ω = (ωv )v∈V

(ωv ist die Farbe von v in der Färbung ω). Sei X die Zufallsvariable,

die die

P

nichtmonochromatischen Kanten zählt. Wir können X als e=uv∈E Xuv

schreiben, wobei Xuv = 1 falls u und v verschiedene Farben bekommen und

0 sonst (Xuv ist also die Indikatorvariable für das Ereignis ist “Kante uv

ist zweifarbig”). Da P[“Kante uv ist zweifarbig”] = P[ωu 6= ωv ] = P[ωu =

rot ∧ ωv = blau] + P[ωu = blau ∧ ωv = rot] = (1/2)2 + (1/2)2 = 1/2 ist,

gilt E[Xuv ] = 1/2 und somit E[X] = m/2 und es gibt eine Bipartition mit

mindestens m/2 Kanten im Schnitt.

• A heißt summenfrei, falls (A + A) ∩ A = ∅.

• Satz (Erdős 1965): Jede n-elementige Menge B = {b1 , . . . , bn } ganzer

Zahlen mit 0 6∈ B enthält eine summenfreie Teilmenge A der Kardinalität

größer als n/3.

• Beweis: Sei x ein (uniform verteiltes) zufälliges Element aus Z∗p . Dann

bildet man B in die Menge Z∗p (p > 2 max |bi | und p eine Primzahl der

Form 3k + 2) via φx (bi ) := bi · x( mod p) ab.

Sei Ax P

:= {b : b ∈ B und φx (b) ∈ {k + 1, . . . , 2k + 1}} und setze X =

|Ax | =

b∈B Xb , wobei Xb = 1 falls φx (b) ∈ {k + 1, . . . , 2k + 1} und

k+1

, da φx (b) uniform verteilt in Z∗p ist.

Xb = 0 sonst. Es gilt E[Xb ] = 3k+1

P

k+1

Der Erwartungswert von X ist b∈B E[Xb ] = 3k+1

n > n/3, also gibt es

ein x mit |Ax | > n/3. Da {k + 1, . . . , 2k + 1} summenfrei ist, muss auch Ax

summenfrei sein.

• Satz (Bollobás 1965): Seien Mengenpaare (A1 , B1 ),. . . , (Ah , Bh ) mit

den folgenden Eigenschaften gegeben:

(i) |Ai | = k und |Bi | = ` für alle i ∈ [h],

(ii) Ai ∩ Bi = ∅ für alle i ∈ [h],

(iii) Ai ∩ Bj 6= ∅ für alle i 6= j ∈ [h].

Dann gilt h ≤ k+`

k S.

S

• Beweis: Sei X = i Ai ∪ i Bi (⊂ N o.B.d.A.) und τ eine zufällige Permutation von X. Für jedes i ∈ [h], definiere dann folgendes

Ereignis Ei :

“max τ (Ai ) < min τ (Bi )”. Beobachtung: P(Ei ) = 1/ k+`

und

alle Ei sind

k

P

˙ i ] = i P(Ei ) = h/ k+`

disjunkt. Mit 1 ≥ P[∪E

folgt

die

Behauptung.

k

2.6. Asymptotisches Verhalten. Oftmals ist es mühsam, genaue untere/obere

Schranken herzuleiten bzw. man ist oftmals an Schranken interessiert, die erst für

PROBABILISTISCHE KOMBINATORIK

7

“große” Werte eine interessante, asymptotische Aussage liefern. Beispiele dieser Art

sind Schranken an die Laufzeit für Algorithmen, Fehlerapproximation, Primzahlsatz

u.v.m. Dazu führen wir eine weit verbreitete Landau-Notation ein. Im folgenden

werden wir Notation für Verhältnis zweier Funktionen f und g einführen. Deren

Definitionsbereich ist typischerweise N, Z, Q oder R (R+ ) und Wertebereich N oder

allgemeiner R≥0 . Wir schreiben . . .

• g = O(f ), falls es ein C > 0 und n0 gibt mit g(n) ≤ Cf (n) für alle n ≥ n0 ;

• g = Ω(f ), falls es ein c > 0 und n0 gibt mit g(n) ≥ cf (n) für alle n ≥ n0

(d.h. falls f = O(g));

• g = Θ(f ), falls f = O(g) und g = O(f ), d.h. es gibt c, C > 0 und n0 mit

cf (n) ≤ g(n) ≤ Cf (n) für n ≥ n0 ;

• g = o(f ), falls für alle ε > 0 es ein n0 gibt mit g(n) ≤ εf (n) für n ≥ n0 ;

• Spezialfall: g = o(1) bedeutet also, dass limn→∞ g(n) = 0;

• g = ω(f ), falls für alle C > 0 es ein n0 gibt mit g(n) ≥ Cf (n) für n ≥ n0 ;

• g ∼ f , falls limn→∞ fg(n)

(n) = 1.

Ferner ist es oft nützlich eine gute Abschätzung an die Binomialkoeffizienten zu

haben. Oftmals reichen:

n

,

• nk ≤ k!

k

n

• k ≤ e·n

, sowie

k

n

n k

• k ≥ k .

√

k

• Eine genauere Schranke liefert die Stirlings Formel: n! ∼ 2πn ne .

2

• Weitere Abschätzungen: 1 − x ≤ e−x für alle x, und 1 − x ≥ e−x−x für

x ∈ (0, 1/2).

2.7. Eine asymptotische untere Schranke an die Ramseyzahl r(k).

k

• Zur Erinnerung: wir haben gesehen, dass aus nk 21− 2 < 1 =⇒ r(k) > n.

k

Wenn man nk durch e·n

abschätzt, die k-te Wurzel zieht und nach

k

n auflöst, so folgt: r(k) > (1 − o(1)) √12·e k2k/2 . Die asymptotisch beste

bekannte untere Schranke ist nur um den Faktor 2 besser!

Buchreferenzen:[2, Kapitel 1-2].

29.Oktober 2013

2.8. Alterations: wenn man die Zufallsvariablen miteinander kombiniert.

2.8.1. Ramsey again.

k

• Satz: Es gilt: r(k) > n − nk 21− 2 .

• Beweisidee: färbe E(Kn ) rot-blau zufällig und sei X die Anzahl der

k

monochromatischen Kk s. Es gilt E[X] = nk 21− 2 , und es gibt also eine

k

Färbung mit höchstens nk 21− 2 monochromatischen Kk s. Man erhält

durch Löschen je eines Knotens

aus jeder solchen Kopie eine Färbung auf

k

n 1− 2

mindestens n − k 2

Knoten ohne rote und blaue Kk s.

k

• Wir brauchen nur noch die Funktion f (n) = n − nk 21− 2 zu maximieren

k

n 1− 2

(genau genommen, es reicht g(n) = n − k 2

zu maximieren). Und

wir erhalten n = (1 − o(1)) 1e k2k/2 .

8

YURY PERSON

k

• Einsetzen von n = (1 − o(1)) 1e k2k/2 in n − nk 21− 2 liefert: r(k) > (1 −

√

o(1)) 1e k2k/2 . (Verbesserung um 2.)

• Bemerkung: wegen asymptotischer Analysis (k → ∞), brauchen wir nicht

abzurunden (Das Ergebnis verändert sich nicht.)

2.8.2. Unabhängige Mengen.

• Eine unabhängige

Menge (engl. independent set) im Graphen G ist S ⊂

V (G) mit S2 ∩ E(G) = ∅. Die Kardinalität einer größten unabhängigen

Menge wird durch α(G) bezeichnet.

• Satz: Sei G = (V, E) ein Graph mit n Knoten und nd/2 Kanten, d ≥ 1.

Dann gilt α(G) ≥ n/(2d).

• Beweisidee: sei S eine zufällige

von V (n-maliger p-Münzwurf).

Teilmenge

S

Seien X = |S| und Y = 2 ∩ E , d.h. X ist die Anzahl der Knoten in

S und Y ist die Anzahl der Kanten in G[S]. Man kann nun alle Kanten

G[S] löschen indem man Y Endknoten entfernt. Dann ergibt sich eine

unabhängige Menge der Größe X −Y . Maximiere E[X −Y ] für ein p ∈ [0, 1]!

2.8.3. Planare Graphen und crossing lemma.

1.November 2013

• Ein planarer Graph lässt sich kreuzungsfrei in der Ebene (R2 ) zeichnen.

Es gilt die Eulerformel für zusammenhängende planare Graphen: |V | −

|E| + |F | = 2. Daraus folgt, dass ein planarer Graph G mit n ≥ 3 Knoten

höchstens 3n − 6 Kanten enthält (siehe Diskrete Mathematik 1). Jeder

Graph auf n Knoten mit mehr als 3n − 6 Kanten, lässt sich also nicht ohne

Kreuzungen zeichnen.

• Definiere cr(G) als die kleinste Anzahl an Kreuzungen, mit der G sich in

die Ebene zeichnen lässt. Offensichtlich: cr(G) ≥ |E(G)| − 3|V |.

• Crossing Lemma 1982 (Ajtaj, Chvátal, Newborn und Szemerédi

/ Leighton; Beweis von Székely): Sei G = (V, E) mit |E| ≥ 4|V |, dann

cr(G) ≥ |E|3 /(64|V |2 ).

• Beweis: Es sei eine optimale Zeichnung c von G gegeben. Sei S eine

zufällige

von V (P(v ∈ S) = p für alle v ∈ V ). Sei X = |S|,

Teilmenge

S

Y = 2 ∩ E und Z sei die Anzahl der Kreuzungen von c auf der Knotenmenge S. Es gilt Z ≥ cr(G[S]) ≥ Y − 3X, und mit E[X] = |V |p,

E[Y ] = |E|p und E[Z] = cr[G]p4 , folgert man cr(G) ≥ |E|/p2 − 3|V |/p3 .

Setzt man p = |E|/(4|V |) so folgt die Behauptung.

• Szemerédi-Trotter Theorem: Seien P eine n-elementige Menge von

Punkten und L eine m-elementige Menge von Geraden in R2 . Dann ist die

Anzahl I der Inzidenzen (d.h. Paare (p, `) mit p ∈ P und ` ∈ L) höchstens

4m2/3 n2/3 + 2m + 4n (d.h. O(m2/3 n2/3 + m + n)).

• Beweisidee: o.B.d.A. jede Gerade enthält einen Punkt. Konstruiere

einen Hilfsgraphen, dessen Knotenmenge P ist und deren Kanten den

Verbindungstrecken zwischen zwei Punkten entsprechen (zwischen denen

kein weiterer Punkt liegt). Bemerke: |E| = I − m und die Anzahl der

Kreuzungen ist höchstens m

2 . Wende nun crossing lemma an.

• Sei P ⊂ R2 . Eine Gerade ` heißt k-reich, falls sie mindestens k Punkte aus

P enthält.

PROBABILISTISCHE KOMBINATORIK

9

• Korollar: Seien n Punkte und (m viele) Geraden gegeben. Dann ist die

2

Anzahl der k-reichen Geraden O( nk3 + nk ).

• sum-product Phänomen: sei A ⊂ R mit |A| = n. A + A := {a +

a0 : a, a0 ∈ A}, A · A := {a · a0 : a, a0 ∈ A}. Eine arithmetische Progression

der Länge k (k-AP) ist die Folge a, a + d, . . . , a + (k − 1)d für a, d ∈ R.

Eine geometrischen Progression der Länge k ist die Folge a, ad, . . . , adk−1

für a, d ∈ R. Allgemeine Schranken an |A + A| und |A · A| sind 2|A| − 1

und |A|+1

. Dabei wird untere Schranke von den Progressionen erreicht.

2

• Vermutung (Erdős und Szemerédi, 1983): max{|A+A|, |A·A|} ≥ |A|2−o(1) .

D.h. mindestens eine Menge von beiden muss groß sein.

• Korollar: max{|A · A|, |A + A|} = Ω(|A|5/4 ).

• Beweisidee: Sei P := (A + A) × (A · A) und L := {y = (x − a)a0 : a, a0 ∈ A}

und o.B.d.A. sei 0 6∈ A. Dann enthält jede Gerade ` ∈ L mindestens |A|

Punkte aus P . Anwendung des Korollars über k-reiche Geraden liefert die

Behauptung.

Buchreferenzen:[2, Kapitel 3 und Seite 285].

2.9. Graphen mit großer chromatischer Zahl und ohne kurze Kreise.

2.9.1. Weitere Begriffe aus der Graphentheorie.

• Die chromatische Zahl von G ist χ(G) := min{k | ∃ c : V (G) → [k] mit uv ∈

E(G) ⇒ c(u) 6= c(v)}. D.h. χ(G) ist die kleinste Anzahl der Farben, die

man benötigt, um V (G) so zu färben, dass keine benachbarten Knoten

dieselbe Farbe erhalten.

• Zwei Graphen G1 = (V1 , E1 ) und G2 = (V2 , E2 ) heißen isomorph, falls es

eine Bijektion φ : V1 → V2 gibt mit uv ∈ E1 genau dann, wenn φ(u)φ(v) ∈

E2 für alle u, v ∈ V1 . Wir schreiben G1 ∼

= G2 .

• Man spricht deswegen vom vollständigen Graphen auf n Knoten. Ferner

spielen die ”Namen” der Knoten keine Rolle und wir nehmen oft an, dass

ein Graph G die Knotenmenge [n] := {1, 2, . . . n} hat (für ein geeignetes

n ∈ N).

• Ein vollständiger Graph Kn wird oft als Clique bezeichnet.

• Wir sagen, dass ein Graph F = (V 0 , E 0 ) ein Teilgraph (auch Subgraph

genannt) von G = (V, E) ist, falls V 0 ⊆ V und E 0 ⊆ E. Wir schreiben

F ⊆ G. Ferner heißt G Supergraph (Obergraph) von F .

• G enthält eine Kopie von F , falls es einen Teilgraphen F 0 in G gibt, so dass

F und F 0 isomorph sind.

• Ein Kreis C` der Länge ` ist der Graph ([`], {12, 23, . . . , {` − 1, `}, 1`}).

• Die Taillenweite (engl. girth) von G ist die Länge eines kürzesten Kreises

in G und wird mit girth(G) bezeichnet. Enthält G keine Kreise, so setzt

man girth(G) = ∞.

• Der Graph G heißt zusammenhängend, falls es zu je zwei Knoten v, u ∈

V (G) eine Folge x1 , x2 . . . , xi gibt mit xj xj+1 ∈ E(G) für alle j ∈ [i − 1]

und x1 = u, xi = v.

• Ein Baum T ist ein zusammenhängender Graph, der keine Kreise enthält.

Es gilt: falls |E(T )| ≥ 1, so χ(T ) = 2.

• Markovs Ungleichung: sei X ≥ 0 eine Zufallsvariable und a > 0. Dann

gilt: P(X ≥ a) ≤ E[X]

a .

5.November 2013

10

8.November 2013

YURY PERSON

• Speziallfall: X ist ganzzahlig und nicht negativ. Gilt dann P(X ≥ 1) < 1

so gibt es ein ω ∈ Ω mit X(ω) = 0. Ein Beispiel war die Ramseyzahlberechk

nung: nk 21− 2 < 1 =⇒ r(k) > n.

• Theorem (Erdős 1959): Seien k, ` ∈ N. Dann existiert ein Graph G mit

χ(G) > k und girth(G) > `.

• Interpretation: es werden zwei “sich widersprechende Eigenschaften” verlangt, denn falls girth(G) groß ist, so sieht G lokal aus wie ein Baum, aber

eben nicht global. Denn ein Baum hat chromatische Zahl 2.

• Der W-Raum G(n, p) und seine Interpretation:

P

P

[n]

n

– Ω = {0, 1} 2 und P(ω) = p 1≤i<j≤n ωij (1 − p) 2 − 1≤i<j≤n ωij .

– Jeder {0, 1}-Vektor ω entspricht einem (zufälligen) Teilgraphen G von

Kn , nämlich durch ij ∈ E(G) ⇐⇒ ωij = 1.

– Man kann nachrechnen, dass die Zufallvariable Xij := ωij unabhängig

und Bernoulliverteilt sind mit Parameter p. Man sagt, G ist ein

zufälliger Graph auf n Knoten und seine Kanten existieren unabhängig

mit Wahrscheinlichkeit p.

– E(G) wird auch p-zufällige Teilmenge von E(Kn ) = [n]

genannt.

2

• Proposition: Es gilt: χ(G) ≥ v(G)/α(G), wobei v(G) := |V (G)|.

• Beweisskizze (Theorem): Seien 0 < θ < 1/` und p = nθ−1 . Sei X := X(G)

die Anzahl der kurzen Kreise in G ∈ G(n, p). Man zeigt: P(X ≥ n/2) =

o(1) (mit Markovs Ungleichung), und P(α(G) ≥ b3n1−θ ln nc) = o(1). Also

gilt: P(α(G) < 3n1−θ ln n und X < n/2) > 0. Folglich gibt es ein G ⊆ Kn

mit höchstens n/2 Kreisen der Länge ` und α(G) < 3n1−θ ln n. Lösche alle

kurze Kreise und erhalte G∗ mit girth(G∗ ) > ` und χ(G∗ ) ≥ n/(2α(G)) =

nθ

6 ln n > k für n groß genug.

Buchreferenzen:[2, Seiten 41–42] und[11, Kapitel 3 und 5].

2.10. Zwei berühmte Geometrieprobleme von Erdős.

• Sei P ⊆ R2 mit |P | = n.

• unit distances problem: zeige, dass |{(p, p0 ) : |p − p0 |2 = 1, p, p0 ∈ P }| =

O(n1+o(1) ) (offen !). Beste Schranke(Hausaufgabe 4, Problem 1): O(n4/3 ).

• distinct distances problem: zeige, dass |{|p − p0 |2 = 1 : p, p0 ∈ P }| =

n

Ω( √log

) (offen !). Beste bekannte untere Schranke: Ω( logn n ). Bemerkung:

n

mit crossing lemma kann man zeigen: Ω(n4/5 ) und Ω(n2/3 ) folgt aus der

unit distances problem.

√

√

n

) liefert ist [ n] × [ n]• eine mögliche optimale Konstruktion, die Θ( √log

n

√

Gitter: P := {(i, j) : i, j ∈ [ n]}. Es folgt aus einem Theorem von Landau.

Buchreferenzen:[5].

2.11. Lovász local Lemma.

• Motivation: falls die union-bound nicht funktioniert, so kann man dennoch

oft P((∪i Ei )c ) = P(∩i Eic ) > 0 zeigen. Zum Beispiel, falls Ei unabhängig

sind und P(Ei ) < 1. Local lemma erlaubt einige Abhängigkeiten zwischen

den Ereignissen.

• Erinnerung (bedingte Wahrscheinlichkeit): seien A, B Ereignisse mit

P(B) > 0. Dann sei P(A|B) := P(A∩B)

P(B) . Falls also P(A|B) = P(A) so

ist dies zu A und B sind unabhängig äquivalent.

PROBABILISTISCHE KOMBINATORIK

11

• Def. A ist unabhängig von B1 ,. . . , Bm , falls: P(A ∩ C1 ∩ . . . ∩ Cm ) =

P(A) · P(C1 ∩ . . . ∩ Cm ) für alle Ci ∈ {Bi , Bic }.

• LLL: Local lemma (Lovász): seien A1 ,. . . , An Ereignisse mit P(Ai ) ≤

p < 1 für alle i ∈ [n]. Ferner sei jedes Ai unabhängig von allen bis auf d

viele Ereignisse Aj , j 6= i. Falls e · p(d + 1) ≤ 1 gilt, so

P(∩ni=1 Aci ) > 0.

• Bemerkung: betrachte ein zweimaligen fairen Münzwurf (ω1 , ω2 ) und die

Ereignisse A, B1 , B2 : A := {ω1 = ω2 }, Bi := {ωi = Kopf}. Dann gilt A

und Bi sind unabhängig, aber A ist nicht unabhängig von B1 , B2 . D.h. in

der Anwendung von local lemma wäre d = 1 in diesem Fall.

• Beweis: siehe [9].

• Satz: Sei k ≥ 9. Sei H = (V, E) ein k-uniformer k-regulärer Hypergraph

(d.h. jeder Knoten ist in genau k Kanten enthalten). Dann ist H 2-färbbar.

• Beweisidee: färbe jeden Knoten v ∈ V zufällig rot/blau mit Wahrscheinlichkeit 1/2 unabhängig von den anderen Knoten. Betrachte Ereignisse

Ae := e ist monochromatisch, Ae hängt von höchstens k(k − 1) Af s ab

(mit f ∩ e 6= ∅). Wende LLL an: e21−k (k(k − 1) + 1) ≤ 1.

• Bemerkung: seien X1 ,. . . , Xm unabhängige Zufallsvariable und jedes Ereignis Ai sei durch Si ⊆ {X1 , . . . , Xm } definiert. Falls Si ∩ Sj = ∅ für

j = j1 ,. . . , jk , dann ist Ai unabhängig von Aj1 ,. . . , Ajk .

• Im Satz oben hängt jedes Ae von den Zufallsvariablen Xv , v ∈ e ab, die

die Farbe von v beschreiben, z.B. durch Xv = 1 falls v rot und Xv = 0

falls v blau. Da die Knoten unabhängig voneinander gefärbt sind, sind Xv s

(v ∈ V ) unabhängig, und√ Ae = {Xv1 = . . . = Xvk }, wobei {v1 , . . . , vk } = e.

• Satz: r(k) > (1 − o(1)) e2 k2k/2 .

• Beweisidee: Sei n ∈ N. Färbe jede Kante von Kn zufällig rot/blau mit

Wahrscheinlichkeit 1/2 unabhängig von den anderen Kanten. Für S ∈ [n]

k

k

sei AS := alle Kanten in S sind in derselben Farbe, P(AS ) = 21− 2 . AS

hängt von AT ab genau dann wenn

T | ≥ 2. Es sind weniger als

|S ∩

k

n 1− 2 k

k

n

2 k−2 solcher T s. Aus e2

2 k−2 ≤ 1 folgt r(k) > n. Nun “löse

nach n auf”.

Buchreferenzen:[2, Kapitel 5], [7, Kapitel 19] und [9].

12.November 2013

15.November 2013

2.12. Zweite Momentmethode.

• E(X i ) heißt zweites Moment von X.

• Chebyshevs Ungleichung: P(|X − EX| ≥ a) ≤ Var[X]

a2 .

• Spezialfall: P(X = 0) ≤ Var(X)

.

(EX)2

• Distinct Sums:

sei

f

(n)

die größtmögliche Kardinalität der Teilmenge

P

M ⊂ [n] mit x∈A x paarweise verschieden für A ⊆ M .

• untere Schranke: f (n) ≥ blog2 nc + 1, da {1, 21 , . . . , 2blog2 nc } die

gewünschte Eigenschaft (distinct sums) hat.

• Satz: f (n) ≤ log2 n + 12 log2 log2 n + O(1).

• Beweisidee: sei M = {x

, . . . xm } ⊂ [n] eine Menge mit der distinct sums P1m

Eigenschaft. Sei X := i=1 xi Ii , wobei I1 ,. . . , Im unabhängige Bernoulliverteilte Zufallsvariable mit Parameter p = 1/2 sind. Man

√ zeigt: Var(X) ≤

mn2 /4, und mit Chebyshev-Ungleichung: P(|X −EX| ≥ mn) ≤ 1/4. Also

12

YURY PERSON

•

•

•

•

•

•

19.November 2013

•

•

•

√

√

gilt:

EX| < mn) √

≥ 3/4. Andererseits: P(|X − EX| < ( mn) ≤

√ P(|X −−m

2 mn + 1)2

und aus (2 mn + 1)2−m ≥ 3/4 folgt die Behauptung.

Nachtrag zur o, O-Notation: wir erweitern o bzw. O-Notation auf die

Fälle, wenn g : N → R und f : N → R≥0 .

– g = O(f ), falls es ein C > 0 und n0 gibt mit |g(n)| ≤ Cf (n) für alle

n ≥ n0 ;

– g = o(f ), falls für alle ε > 0 es ein n0 gibt mit |g(n)| ≤ εf (n) für

n ≥ n0 ;

– Spezialfall: g = o(1) bedeutet also, dass limn→∞ g(n) = 0.

– “Neuerung”: in O und o wird also + bzw. − “versteckt”. Dies macht

n

es manchmal schwer, die Ausdrücke der Form

zu

√

√ (1 + o(1)) richtig

interpretieren (Beispiel: sowohl 1/n, −1/n, 1/ n als auch −1/ n sind

o(1)). Der Vorteil ist allerdings eine übersichtliche Handhabung vieler

Abschätzungen (approximatives Rechnen) und dies überwiegt jedoch

bei Weitem die damit verbundenen “Risiken”.

P = {2, 3, 5, 7, . . .} bezeichnet die Menge der Primzahlen.

Definition: sei ν(n) die Anzahl verschiedener Primzahlfaktoren von n,

d.h. ν(n) := |{p : p ∈ P, p|n}|.

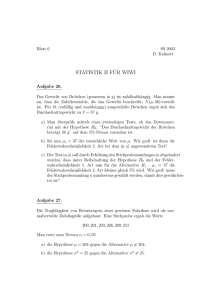

Theorem (Hardy und Ramanujan, 1917): Sei ω(1) → ∞ beliebig

langsam (mit n → ∞). Dann gilt für alle bis auf

√ o(n) viele ganze Zahlen x

zwischen 1 und n, dass |ν(x) − ln ln n| ≤ ω(n) ln ln n.

mit anderen Worten: die “meisten” ganzen Zahlen zwischen 1 und n haben

∼ ln ln n viele verschiedene Primzahlfaktoren.

zwei P

Ergebnisse aus der (elementaren) Zahlentheorie:

1

–

p∈P,p≤n p = ln ln n + O(1).

– π(n) := |P ∩ [n]| = Θ(n) (Theorem von Chebyshev) - inzwischen weiß

man mehr, z.B. den Primzahlsatz: π(n) ∼ lnnn .

Filmempfehlung: “N is a number”.

Buchempfehlung: “A Mathematician’s Apology” (G.H. Hardy)

Beweisskizze: sei x ∈ [n] gleichverteilt und sei X := X(x) = ν(x).

P

Wir schreiben X =

Xp , wobei Xp (x) = bn/pc

= p1 + O(1/n).

p∈P∩[n]

n

P

1

Es folgt, dass E(X) =

+ O(1) = ln ln n + O(1) (letzte

p∈P∩[n] p

Gleichung

ohne Beweis).

Ferner berechnen wir die Varianz Var(X) =

P

P

Cov(Xp , Xq ). Für p 6= q: Cov(Xp , Xq ) ≤

p∈P∩[n] Var(Xp ) +

p6=q∈P∩[n]

1

1

1

1

1

1

1

n

1

pq − ( p − n )( q − n ) ≤ n p + q . Unter Benutzung von π(n) = O( ln n ),

folgt: Var(X) ≤ EX √

+ o(1). Die Chebyshevs Ungleichung liefert: P(|X −

ln ln n + O(1)| > ω(1) ln ln n) ≤ ω22(1) = o(1), also folgt dass es für alle, bis

√

auf o(n) viele,

√ x ∈ [n] gilt: ν(x) ∈ (ln ln n + O(1) − ω(1) ln ln n, ln ln n +

O(1) + ω(1) ln ln n), und das impliziert (für ein anderes langsam wachsendes ω(1))

√

√

ν(x) ∈ (ln ln n − ω(1) ln ln n, ln ln n + ω(1) ln ln n).

Buchreferenzen:[2, Kapitel 4], [7, Kapitel 21].

2.13. Graphenigenschaften.

• Notation: für G = (V, E) schreiben wir v(G) := |V | und e(G) := |E|.

PROBABILISTISCHE KOMBINATORIK

13

• Gilbert/ Erdős-Renýi Model G(n, p): die Grundmenge ist Gn :=

n

{G : G ⊆ Kn = ([n], n2 ) und v(G) = n}, P(G) = pe(G) (1 − p) 2 −e(G)

(jede Kante existiert unabhängig mit Wahrscheinlichkeit p).

• Spezialfall: G(n, 1/2), dann ist P die Gleichverteilung.

• Schreibweise: oft schreiben wir (und sprechen wir von) G(n, p), meinen

dabei aber ein zufälliges Element(Graph) G ∈ G(n, p), der gemäß der oben

beschriebenen Verteilung auf G(n, p) ausgewählt wurde. Daher der Name

der zufällige Graph.

• Definition: A ⊆ ∪n≥0 Gn heißt Grapheneigenschaft (engl. graph property), falls A unter Isomorphie abgeschlossen ist (d.h. G ∈ A und G ∼

=

G0 −→ G0 ∈ A).

• Notation P(G(n, p) ∈ A):

sei A eine Grapheneigenschaft. Es gilt

P(G(n, p) ∈ A) = P(Gn ∩ A) (denken Sie an unser Gebrauch von G(n, p)Notation als zufälliges Element aus dem W-Raum G(n, p)!)

– Sei p = 1/2: P(G(n, 1/2) ∈ A) = P(Gn ∩ A) =

n→∞

|A∩Gn |

|Gn |

= |A ∩ Gn |2−

n

2

.

– Sprechweise: falls P(G(n, p) ∈ A) −−−−→ 1 so sagen wir, dass fast alle

Graphen die Eigenschaft A haben.

n→∞

– Sprechweise: gilt dagegen: P(G(n, p) ∈ A) −−−−→ 0, so sagen wir, dass

fast kein Graph A hat.

• Satz: fast alle Graphen haben Durchmesser 2.

• Definition: der Durchmesser von G wird diam(G) bezeichnet, und ist

definiert als: max{dist(u, v) : u, v ∈ V (G)}. Dabei ist dist(u, v) die Länge

des kürzesten Wegs von u nach v in G.

• Beweisskizze: sei Z die Anzahl der Paare (i, j), die keine gemeinsamen

Nachbarn in G(n, 1/2) haben. Falls G(n, 1/2) 6= Kn und Z = 0, so gilt dass

G(n, 1/2) den Durchmesser 2 hat (gemeint

P ist natürlich hier ein zufälliger

Graph G aus G(n, 1/2)!). Man kann Z = i<j Zij schreiben, wobei Zij = 1

falls i und j keine gemeinsamen Nachbarn haben (und sonst ist Zij = 0).

Es gilt P(Zij = 1) = (3/4)n−2 . Nun gilt: 1 ≥ P(diam(G(n, 1/2)) = 2) ≥

n

•

•

•

•

•

n→∞

1 − P(G(n, 1/2) = Kn ) − P(Z ≥ 1) ≥ 1 − 2− 2 − E(Z) −−−−→ 1.

Korollar: fast alle Graphen sind zusammenhängend.

Bemerkung: man kann zeigen, dass G(n, 1/2) viele weitere schöne Eigenschaften hat.

Sei A eine Grapheneigenschaft. Wir können den Graphen von P(G(n, p) ∈

A) zeichnen (x-Achse: p ∈ [0, 1] und y-Achse y = P(G(n, p) ∈ A) ∈ [0, 1]).

Oft kann man dann beobachten, dass zuerst P(G(n, p) ∈ A) sehr nahe bei

Null ist, und dann plötzlich auf den Wert nahe bei 1 “springt”. Man spricht

vom Phasenübergang (ähnlich wie bei Wasser um 0 Grad Celsius).

Eine große Entdeckung von Erdős und Renyi ist, dass viele schöne Eigenschaften den Phasenübergang besitzen. Dies werden wir im folgenden

studieren.

Definition: sei A eine Grapheneigenschaft und p = p(n) : N → [0, 1]. . .

n→∞

– falls P(G(n, p) ∈ A) −−−−→ 1, so sagen wir: “G(n, p) hat A asymptotisch fast sicher (a.f.s.)” (engl.: asymptotically almost surely (a.a.s.))

n→∞

– falls P(G(n, p) ∈ A) −−−−→ 0, so sagen wir: “G(n, p) hat A asymptotisch fast sicher nicht”

22.November 2013

14

YURY PERSON

• Definition: eine Funktion t = t(n) : N → [0, 1] heißt Schwellenwertfunktion (engl. threshold function, threshold) für die Eigenschaft A, falls

n→∞

(1) p = o(t) (manchmal als p t bezeichnet) =⇒ P(G(n, p) ∈ A) −−−−→ 0

(0-Aussage), und

n→∞

(2) p = ω(t) (manchmal als p t bezeichnet) =⇒ P(G(n, p) ∈ A) −−−−→ 1

(1-Aussage) gelten.

• Bemerkung: die Schwellenwertfunktion ist nicht eindeutig, eher ganze

Klasse (Θ(t(n)))

• Satz: Die Eigenschaft “enthält eine Kopie von K4 ” hat Schwellenwertfunktion n−2/3 .

• Beweisidee: betrachte Xn (G) = XP:=die Anzahl der Kopien von K4 in

G ∈ G(n, p), und schreibe: X =

n XS , wobei XS (G) ist die InS∈ 4

•

•

•

•

•

•

•

26.November 2013

•

•

dikatorzufallsvariable

für das Ereignis G[S] ∼

= K4 . Es folgt: E(XS ) = p6

n 6

und E(X) = 4 p . Die 0-Aussage folgt mit Markov-Ungleichung für

p = o(n−2/3 ). Für die 1-Aussage wendet man Chebyshev-Ungleichung an

(vorher muss man noch zeigen, dass Var(X) = o((E(X))2 ), indem man

Cov(XS , XT ) für S 6= T ∈ [n]

mit |S ∩ T | ∈ {0, 1, 2, 3, 4} analysiert).

4

Bemerkung: es gilt sogar, dass falls p(n) n−2/3 , so ist X um ihren

Erwartungswert konzentriert ist, d.h. es gilt a.f.s., dass P(X = (1 +

n→∞

o(1))E(X)) −−−−→ 1.

Der Satz lässt sich auf allgemeine Graphen F verallgemeinern. Dazu

e(F 0 )

definiert man die m-Dichte mF := maxF 0 ⊆F,v(F 0 )>0 v(F

0) .

Satz (ohne Beweis): Die Eigenschaft “enthält eine Kopie von F ” hat

Schwellenwertfunktion n−1/mF .

e(F 0 )

Bemerkung: man muss das Maximum v(F

über alle (induzierten)

0)

Teilgraphen betrachten, denn falls der dichteste Teilgraph a.f.s. nicht

vorkommt, so gibt es auch keine Kopie von F in G(n, p) a.f.s.

Satz: Die Eigenschaft “δ(G) ≥ 1” hat Schwellenwertfunktion ln n/n (und

ist scharf).

Beweisidee:

sei X die Anzahl der isolierten Knoten in G(n, p). Schreibe

P

X =

X

v∈[n] v , wobei Xv die Indikatorvariable für “v ist isoliert” ist.

Es gilt: E(Xv ) = (1 − p)n−1 und daher: E(X) = n(1 − p)n−1 . Die 1n→∞

Aussage folgt mit Markov-Ungleichung, da E(X) −−−−→ 0 selbst für p ≥

(1 + ε) lnnn für jedes fixierte ε > 0. Die 1-Aussage folgt mit Chebyshev’s

Ungleichung (man muss zeigen, dass Var(X) = o((E(X))2 ), wieder sogar

für p ≤ (1 − ε) lnnn .

Bemerkung: wir haben gezeigt, dass der Phasenübergang im viel kleineren

Intervall stattfindet, nämlich in [(1 − ε) lnnn , (1 + ε) lnnn ] (für jedes ε > 0).

Man spricht von einem scharfen Schwellenwert (engl. sharp threshold) für

diese Eigenschaft.

Satz: Die Eigenschaft “G ist zusammenhängend” hat Schwellenwertfunktion ln n/n (und ist scharf).

Beweisidee:

0-Aussage:

P(G(n, p) ist nicht zusammmenhängend) ≥

n→∞

P(δ(G(n, p)) = 0) −−−−→ 1. Für die 1-Aussage betrachtet man X(G) :=

X :=die Anzahl der Komponenten in G mit ≤ n/2 Knoten und schreibt

Pn/2

X =

`=1 X` , wobei X` ist die Anzahl der Komponenten mit genau

PROBABILISTISCHE KOMBINATORIK

•

•

•

•

•

•

15

` Knoten. Für S ∈ [n]

` , betrachte das Ereignis ES :=“es gibt keine

Kanten in G(n, p) zwischen S und [n] \ S” (bemerke: P(ES ) = (1 −

p)`(n−`) ) und die Zufallsvariable XS : XS = 1, falls es eine Komponente auf S Knoten in G(n, p) existiert und XS = 0 sonst. Es ist klar

Pn/2 E(XS ) ≤ P(ES ), da {XS = 1} ⊂ ES . Also gilt: E(X) ≤ `=1 n` (1 −

n→∞

p)`(n−`) −−−−→ 0 für p ≥ (1 + ε) ln n/n (Hausaufgabe) und deswegen

n→∞

P(G(n, p) ist zusammenhängend) −−−−→ 1.

Beispiel: seien G1 ∈ G(n, p1 ) und G2 ∈ G(n, p2 ), dann hat G := G1 ∪

G2 := ([n], E(G1 ) ∪ E(G2 )) dieselbe Verteilung wie G(n, p) mit p = p1 +

p2 − p1 p2 , denn für jede Kante e ∈ [n]

2 gilt: P(e 6∈ G) = P(e 6∈ G1 und e 6∈

G2 ) = P(e 6∈ G1 )P(e 6∈ G2 ), also P(e ∈ G) = 1 − P(e 6∈ G1 )P(e 6∈ G2 ) =

1 − (1 − p1 )(1 − p2 ), da G1 und G2 unabhängig ausgewählt sind.

Lemma: seien G1 ∈ G(n, p1 ),. . . , Gk ∈ G(n, pk ), dann hat G := ∪ki=1 Gi

Qk

dieselbe Verteilung wie G(n, p) mit p = 1 − i=1 (1 − pi ).

Definition: Sei A eine Grapheneigenschaft. A heißt monoton

wachsend

(engl. monotone increasing), falls für jedes G ∈ A und e ∈ [n]

2 \ E(G) gilt

G ∪ e ∈ A. Falls für jedes G ∈ A und e ∈ E(G) gilt G \ e ∈ A, so heißt A

monoton fallend (engl. monotone decreasing).

Satz: jede monoton wachsende Eigenschaft besitzt eine Schwellenwertfunktion.

Beweisidee: Vorüberlegung: sei ε ∈ (0, 1/2] und pε (n) so definiert, dass

P(G(n, pε ) ∈ A) = ε für alle n. Ferner sei m minimal mit (1 − ε)m ≤ ε

Kopien von G(n, pε ): G(n, pi ),

(m ≤ d 1ε ln 1ε e). Betrachte m unabhängige

Q

i ∈ [m]. Aus P(∪G(n, pi ) 6∈ A) ≤ i P(G(n, pi ) 6∈ A) = (1 − ε)m ≤ ε

folgt: P(∪G(n, mpε )) ≥ P(∪G(n, pi )) ≥ 1 − ε. D.h. der Anstieg von ε auf

1 − ε geschieht im Intervall [pε , mpε ]. Alles was man jetzt zeigen muss ist

folgendes: aus der Annahme, dass p1/2 (n) keine Schwellenwertfunktion für

A ist (wobei P(G(n, p1/2 ) ∈ A) = 1/2 ist), leitet man den Widerspruch zu

folgender Aussage her:

n→∞

entweder es existiert eine p : N → [0, 1] mit P(G(n, p) ∈ A) −

6 −−−→ 0 (falls

n→∞

p p1/2 ) oder P(G(n, p) ∈ A) −

6 −−−→ 1 (falls p p1/2 ).

p̂ heißt scharfe Schwellenwertfunktion für A falls für jedes ε > 0 gilt:

(

0, p ≤ (1 − ε)p̂

n→∞

P(G(n, p) ∈ A) −−−−→

0, p ≥ (1 + ε)p̂.

Falls eine Schwellenwertfunktion nicht scharf ist, heißt sie unscharf.

• Bemerkung:

viele Schwellenwertfunktionen besitzen sogar scharfen

Phasenübergang. Oft kann man solche Situation charakterisieren. Intuition dabei ist, dass lokale Eigenschaften einen unscharfen Phasenübergang

besitzen, während globale Eigenschaften einen scharfen Phasenübergang

haben. Beispiel: “G ist zusammenhängend” ist scharf (und global),

während “G enthält eine Kopie von K4 ” ist unscharf (und lokal).

Buchreferenzen:[2, Kapitel 4], [7, Kapitel 21] und [6, Kapitel 1].

3. Exponentell kleine Wahrscheinlichkeiten

3.1. Chernoff-Ungleichung.

29.November 2013

16

YURY PERSON

• Motivation:p man möchte zeigen, dass die Wahrscheinlichkeit P(|X −

E(X)| ≥ λ Var(X)) oft viel kleiner ist als die Chebyshev-Ungleichung,

die 1/λ2 “garantiert”. Dazu benötigt man höhere Momente E(X i ).

• Definition: EetX heißt Exponentialmoment von X und die Funktion

i

P∞ i

)

f (t) := EetX = i=0 t E(X

die momenterzeugende Funktion.

i!

tX

• Sei t > 0 und λ ∈ R, dann gelten: P(X ≥ λ) ≤ Ee

bzw. P(X ≤ −λ) ≤

etλ

−tX

Ee

. Ziel wird es nun sein die rechte Seite jeweils zu minimieren bez.

etλ

t > 0.

• Lemma: Sei X eine Zufallsvariable mit |X| ≤ 1 und E(X) = 0. Dann gilt

2

für t ∈ [−1, 1] : EetX ≤ et Var(X) .

• Beweis: weil |tX| ≤ 1 gilt: etX ≤ 1 + tX + t2 X 2 . Wenn man nun die

2

Erwartungswerte berechnet, so folgt: EetX ≤ 1 + t2 Var(X) ≤ et Var(X) .

• Satz (Chernoff-Ungleichung): seien X1 ,. . . , Xn eine Familie

unP

abhängiger Zufallsvariable mit |Xi − E(Xi )| ≤ 1 ∀i. Sei X =

i∈[n] Xi

p

und σ := Var(X) die Standardabweichung. Dann gilt für λ > 0:

2

P(|X − E(X)| ≥ λσ) ≤ 2 max{e−λ

/4

, e−λσ/2 }.

t(X−E(X))

• Beweisidee: man braucht die rechte Seite in P(X −E(X) ≥ λ) ≤ Ee etλσ

geeignet abzuschätzen und zu minimieren (die Abschätzung für P(X −

E(X) ≤ −λ) folgt analog). Da Xi − E(Xi ), i ∈ [n], unabhängig sind, folgt

Q

Q 2

(mit obigem Lemma): Eet(X−E(X)) = i Eet(Xi −E(Xi )) ≤ i et Var(Xi ) =

2 2

2 2

et σ . Die BehauptungPfolgt, indem man et σ −tλσ minimiert.

• Korollar: Sei X =

i∈[n] Xi , wobei Xi s unabhängig und jedes Xi ist

Bernoulli-verteilt zum Parameter pi ∈ (0, 1). Dann gilt für jedes ε > 0:

P(|X − E(X)| ≥ εE(X)) ≤ 2e− min{ε

2

/4,ε/2}E(X)

.

• Proposition: Sei p ln n/n. Dann hat jeder Knoten in G(n, p) a.f.s. den

Grad (1 + o(1))pn.

• Beweisidee: Wir können G(n, p) erzeugen, indem wir eine Folge Xi,j , mit

1 ≤ i < j ≤ n, von unabhängigen Bernoulliverteilten Zufallsvariablen zum

Parameter p betrachten. (Dabei heißt Xi,j =P

1 falls die Kante ij in G(n, p)

n

liegt und 0 sonst.) Sei Yi := degG(n,p) (i) = j=1,j6=i Xi,j , für i ∈ [n]. Es

folgt E(Yi ) = (n − 1)p. Ferner sei ε > 0 beliebig aber fest. Nun wollen wir

das Ereignis abschätzen, dass es einen Knoten i gibt mit |Yi − (n − 1)p| >

εpn:

X

P(∃i ∈ [i] : |Yi − (n − 1)p| > εpn) ≤

P(|Yi − (n − 1)p| > εpn)

i∈[n]

Chernoff/Korollar

≤

3.Dezember 2013

n2e− min{ε

2

/4,ε/2}p(n−1)

.

Da pn ln n, so gilt z.B., dass die Gesamtwahrscheinlichkeit kleiner als

1/n = o(1) ist und wir sind fertig (Frage: was passiert, wenn man die

Chebyshev-Ungleichung anwendet? Kann man sich dann um alle Knotengrade gleichzeitig “kümmern”?).

• Definition: seien x, y ∈ {0, 1}n , dann heißt dist(x, y) := |{i : xi 6= yi }| der

Hammingabstand von x und y (auch Abstand in der `1 -Norm: dist(x, y) :=

P

n

i=1 |xi − yi |).

PROBABILISTISCHE KOMBINATORIK

17

• Proposition: Es gibt eine Menge M ⊂ {0, 1}n mit |M | ≥ ben/32 c so dass

je zwei Vektoren aus M den Hammingabstand ≥ n/4 haben.

• Beweisidee: für zufällige x, y ∈ {0, 1} (d.h. alle xi s und yj s sind unabhängig

und Bernoulli zum Parameter 1/2-verteilt)P

gilt: E(dist(x, y)) = n/2 und

n

Var(dist(x, y)) = n/4 (denn dist(x, y) =

i=1 Xi , wobei Xi := 1xi 6=yi

unabhängig und Bernoulli zum Parameter 1/2 verteilt). Mit ChernoffUngleichung folgt: P(dist(x, y) ≤ n/4) ≤ 2e−n/16 . Nun sei M zufällig

erzeugt, indem man ben/32 c zufällige Vektoren x1 ,. . . , xben/32 c aus {0, 1}n

zieht. Sei E das Ereignis, dass es i < j gibt mit dist(xi , xj ) ≤ n/4.

n/32 Durch Union bound-Argument folgt: P(E) ≤ be 2 c 2e−n/16 < 1, also

gilt P(E c ) > 0, d.h. es gibt ben/32 c Vektoren mit paarweisem Hammingabstand ≥ n/4.

• Folgerung: Die Einheitssphäre Sn−1 ⊂ Rn enthält ben/32 c Punkte mit

paarweisem Euklidischem Abstand ≥ 1.

• Beweisidee:

seien xi die Vektoren aus {0, 1}n aus der Proposition.

√

Definiere für jedes xi den Vektor yi ∈ Sn−1 wie folgt: yi (j) := (−1)xi (j) / n.

Es folgt |yi − yk |2 ≥ 1 für i 6= k.

Buchreferenzen: [7, Kapitel 18] und [10, Kapitel 1].

3.2. FKG-Ungleichung.

• Motivation: seien P := {G : v(G) = n, G ist planar} und H :=

{G : v(G) = n, G enthält einen Hamiltonkreis}. Was ist “wahrscheinlicher”: P(G(n, p) ∈ P | G(n, p) ∈ H) oder P(G(n, p) ∈ P)? D.h. wie sind

diese Ereignisse korreliert? (Antwort: negativ!)

• Definition: sei f : {0, 1}n → R eine Funktion. Wir nennen f monoton

wachsend falls aus t, t0 ∈ {0, 1}n mit ti ≥ t0i für alle i ∈ [n] folgt: f (t) ≥

f (t0 ). Wir nennen f monoton fallend, falls −f monoton wachsend ist.

• Definition: sei E ⊆ 2Ω . Wir nennen E monoton wachsend, falls aus E ∈ E

und E ⊆ D folgt D ∈ E. Gilt dagegen für alle E ∈ E und E ⊇ D, dass

D ∈ E, so nennen wir E monoton fallend.

• Beispiele:

– sei

P f ∈ R[t

Q1 , . . . , tn ] ein Polynom der Form f := f (t1 , . . . , tn ) =

a

S⊆[n] S

i∈S ti mit allen aS ≥ 0. Dann ist f monoton wachsend.

– sei A eine monoton wachsende/fallende Grapheneigenschaft, dann ist

[n]

An := {E(G) : v(G) = n, G ∈ A} ⊆ 2 2 monoton wachsend/fallend.

– sei Ei := {E(G) : v(G), degG (i) ≤ k} ist monoton fallend (ist aber keine

Grapheneigenschaft, da nicht abgeschlossen ist unter Isomorphie).

– sei E ⊆ 2Ω monoton wachsend/fallend, dann ist E c := {Ω \ E : E ∈ E}

monoton fallend/wachsend.

– sei E ⊆ 2Ω monoton wachsend/fallend, dann ist E := 2Ω \ E monoton

fallend/wachsend.

– sei f eine monoton wachsende Funktion. Sei Ek := {S : f (1S ) ≥ k} ⊆

2[n] is monoton wachsend. Dabei bezeichnet 1S den charakteristischen

Vektor für S (d.h. 1S (i) = 1 ⇔ i ∈ S).

[n]

– sei

wachsend/fallend. Definiere f := f (t1 , . . . , tn ) :=

P E ⊆Q2 monoton

Q

t

(1

− ti ). Dann ist f monoton wachsend/fallend.

S∈E

i∈S i

i6∈S

Außerdem gilt: f (1S ) = 1 ⇔ S ∈ E und f (1S ) = 0 ⇔ S 6∈ E.

18

YURY PERSON

• Theorem (FKG-Ungleichung): Sei n ≥ 0, ({0, 1}n , P) Produktraum.

Seien f, g : {o, 1}n → R monoton wachsend. Dann gilt E(f g) ≥ Ef Eg.

Dasselbe gilt, falls f und g beide monoton fallend sind.

• Beweisidee: Induktion nach der n, siehe [10, Kapitel 1].

• Einschub (bedingter Erwartungswert): sei (Ω, P) W-Raum, X : Ω → R ZVe,

E ⊆ Ω ein Ereignis mit P(E) > 0. Der bedingte Erwartungswert von X

gegeben E ist

X

EX1E

P(ω)

.

=

X(ω) P(E)

E[X|E] :=

E1E

ω∈E

Falls P(E) = 0, so setze E[X|E] := 0.

• E[X|Y ](ω) := E[X|E], wobei E = {Y = Y (ω)} = Y −1 (Y (ω));

E[X|Y1 , . . . , Yi ] wird analog definiert.

• Rechenregeln: E[X + Y |E] = E[X|E] + E[Y |E], E (E[X|E]) = EX, EX =

E[X|E]P(E) + E[X|E c ]P(E c ), etc.

• Gegeben ({0, 1}N , P) Produktraum, wir identifizieren ihn mit dem W-Raum

(2[N ] , P0 ), wobei P0 (S) = P(1S ).

• Korollar: Seien A, B ⊆ 2[N ] monoton wachsend. Dann gilt: P(A ∩ B) ≥

P(A)P(B).

Qt

Falls A1 ,. . . , At monoton wachsend sind, so gilt: P(∩ti=1 Ai ) ≥ i=1 P(Ai ).

Dasselbe gilt, falls alle monoton fallend sind.

• Korollar: A, B ⊆ 2[N ] , A monoton wachsend, B monoton fallend. Dann

gilt: P(A ∩ B) ≤ P(A)P(B).

• Beispiele:

– seien A1 ,. . . , An ⊆ [N ]; sei A ⊆ [N ] eine zufällige Teilmenge, d.h.

P(i ∈ A) = pi unabhängig für alle i ∈ [N ]. Dann gilt:

P(∀i : A ∩ Ai 6= ∅) ≥

n

Y

P(A ∩ Ai 6= ∅).

i=1

– Grapheneigenschaften: G(n, p);

H := {E(G) : v(G) = n, G ist hamiltonsch}, P := {E(G) : v(G) =

n, G ist planar} Dann gilt: P(G(n, p) ∈ H ∩ P) ≤ P(G(n, p ∈ H)) ·

P(G(n, p) ∈ P).

Buchreferenzen: [2, Kapitel 6] und [10, Kapitel 1].

10.Dezember 2013

3.3. Martingale.

• Definition: Ein Martingal ist eine Folge von Zufallsvariablen X0 , X1 , . . . ,

Xm so dass E[Xi+1 |Xi , . . . , X0 ] = Xi für alle 0 ≤ i < m, X0 = const.

• Beispiele:

– seien Z1 ,. . . , Zn unabhängige, zum Parameter p Bernoulli-verteilte

Pi

ZVe. Dann ist Xi := j=1 Xj − ip ein Martingal.

– seien alle Kanten aus Kn durch e1 ,. . . , em nummeriert (m = n2 );

für einen Graphen H auf n Knoten definiere: He (i) := ([n], E(H) ∩

{e1 , . . . , ei }) und Hv (i) := ([n], E(H) ∩ [i]

2 ).

– sei f : Gn → R eine Funktion (Graphenparameter, z.B. χ, α, ω. . . ).

– Kantenmartingal: Xi (H) := EG∼G(n,p) [f (G)|Ge (i) = He (i)], i =

0, . . . , m; (also X0 (H) = E[f (G(n, p))] und Xm (H) = f (H))

6.Dezember 2013

PROBABILISTISCHE KOMBINATORIK

19

– Knotenmartingal: Xi (H) := EG∼G(n,p) [f (G)|Gv (i) = Hv (i)], , i =

1, . . . , n; (also X1 (H) = E[f (G(n, p))] und Xn (H) = f (H))

• Theorem (Azuma-Ungleichung): Sei 0 = X0 , X1 ,. . . , Xm ein Martingal mit |Xi+1 − Xi | ≤ 1 für alle 0 ≤ i < m. Sei λ > 0, dann gilt:

√

2

P[Xm > λ m] < e−λ /2 .

• Beweisidee: ähnlich zu Chernoff-Ungleichung (Abschätzung der momenterzeugenden Funktion von Xm + Markov-Unlgeichung). Siehe [2,

Kapitel 1].

• Einschub (konvexe Funktionen): I ⊆ R ein (offenes) Intervall. Die Funktion

f : I → R heißt konvex, falls für alle λ ≥ 0 und a, b ∈ I:

f (λa + (1 − λ)b) ≤ λf (a) + (1 − λ)f (b).

Die Funktion f heisst konkav, falls −f konvex ist.

• Proposition: sei f : I → R 2-mal stetig differenzierbar. Dann gilt: f ist

konvex genau dann, wenn f 00 (x) ≥ 0 für alle x ∈ I.

• Korollar: Sei 0 = X0 , X1 ,. . . , Xm ein Martingal mit |Xi+1 − Xi | ≤ 1 für

alle 0 ≤ i < m. Sei λ > 0, dann gilt:

√

2

P[Xm < −λ m] < e−λ /2 .

• Korollar: Sei X0 = c, X1 ,. . . , Xm ein Martingal mit |Xi+1 − Xi | ≤ 1 für

alle 0 ≤ i < m. Sei λ > 0, dann gilt:

√

2

P[|Xm − c| > λ m] < 2e−λ /2 .

• Definition: Sei f : Gn → R ein Graphenparameter.

– f genügt der Kanten-Lipschitz-Bedingung, falls für alle H, H 0 ∈ Gn

mit |E(H)∆E(H 0 )| ≤ 1 gilt: |f (H) − f (H 0 )| ≤ 1.

– f genügt der Knoten-Lipschitz-Bedingung, falls für alle H, H 0 ∈ Gn so

dass es ein i ∈ [n] gibt mit H − i = H 0 − i gilt: |f (H) − f (H 0 )| ≤ 1.

– f (G) = χ(G), f (G) = α(G), f (G) = ω(G).

• Proposition: sei f : Gn → R ein Graphenparameter.

(a) genügt f der Kanten-Lipschitz-Bedingung, so gilt für das Kantenmartingal Xi (H) := EG∼G(n,p) [f (G)|Ge (i) = He (i)], dass |Xi+1 (H) −

Xi (H)| ≤ 1 für alle H ∈ Gn .

(b) genügt f der Knoten-Lipschitz-Bedingung, so gilt für das Knotenmartingal Xi (H) := EG∼G(n,p) [f (G)|Gv (i) = Hv (i)], dass |Xi+1 (H) −

Xi (H)| ≤ 1 für alle H ∈ Gn .

• Satz: Seien n, p beliebig. Es gilt:

√

2

P(|χ(G(n, p)) − EG∼G(n,p) [χ(G)]| > λ n − 1) ≤ 2e−λ /2 .

• Korollar: Seien Z1 ,. . . , ZN unabhängige Zufallsvariable mit Zi : Ω → Λi ,

∀i ∈ [NQ

]. Sei f : Λ1 × . . . × ΛN → R gegeben mit |f (z) − f (z 0 )| ≤ 1 für alle

z, z 0 ∈ i∈[N ] Λi mit dist(z, z 0 ) = 1. Dann gilt:

2

P (|f (Z1 , . . . , ZN ) − E[f (Z1 , . . . , ZN )]| > t) < 2e−t

/(2N )

.

• Beweisidee: betrachte das Martingal Xi := E[f (Z1 , . . . , ZN )|Z1 , . . . , Zi ]

und wende Azuma-Ungleichung an.

13.Dezember 2013

20

YURY PERSON

• balls into bins: werfe m Bälle zufällig im n Körbe (so dass sich jeder Ball

unabhängig, gleichverteilt einen Korb “aussucht”). Sei Zi : Ω → [n] die

Zufallsvariable, die dem i-ten Ball den Korb Zi zuweist. Sei f (Z1 , . . . , Zn )

die Anzahl leerer Körbe. Es ist klar: E[f (Z1 , . . . , Zn )] = n(1 − 1/n)m ≈

ne−m/n (für m = o(n2 )). Mit dem obigen Korollar folgt:

√ 2

P |f (Z1 , . . . , Zn ) − E[f (Z1 , . . . , Zn )]| > λ n < 2e−λ /2) .

17.Dezember 2013

• Satz: Wirft man n Bälle in n Körbe zufällig, so gilt für die Anzahl L leerer

Körbe folgendes:

√

2

P[|L − ne | > λ n + 1] < 2e−λ /2 .

• Sei A ⊆ {0, 1}n , dann definiere B(A, s) := {y : ∃x ∈ A mit dist(x, y) ≤ s}.

2

• Satz: seien ε, λ > 0 mit e−λ /2 = ε. Dann gilt:

√

|A| ≥ ε2n =⇒ |B(A, 2λ n)| ≥ (1 − ε)2n .

20.Dezember 2013

• Beweisidee: betrachte Z1 ,. . . , Zn unabhängige gleichverteilte 0-1-ZVe.

Definiere f : {0, 1}n → N0 mit f (y) := minx∈A dist(x, y). Wende nun Ko√

2

rollar zweimal

an: P[f < E(f ) − λ n] < e−λ /2 = ε, was impliziert,

dass

√

√

E(f ) ≤ λ n (P[f = 0] = |A|2−n ); und aus P[f > E(f ) + λ n] < ε folgt

die Behauptung.

n

• Nächstes Ziel: Theorem (Bollobás 1988): χ(G(n, 1/2)) ∼ 2 log

a.f.s.

2n

V (G)

• Cliquenzahl ω(G) := max{k : ∃S ∈ k

mit G[S] ∼

= Kk }, d.h. die Kardinalität eines größten vollständigen

Graphen,

der

in

G enthalten ist.

k

−

• definiere f (k) := nk 2 2 , dies ist die erwartete Anzahl an Cliquen der

Größe k in G(n, 1/2).

n→∞

• sei k = k(n) mit f (k) −−−−→ 0, dann gilt a.f.s. ω(G(n, 1/2)) < k (Mit

Markovs Ungleichung)

n→∞

• Was passiert, wenn f (k) −−−−→ ∞? Wie groß kann ein solches k sein?

Kann man dann womöglich die Chebyshevs Ungleichung anwenden?

n→∞

• grobe Rechnung ergibt: f (k) −−−−→ 0 für k ≥ 2 log2 n + 10, während für

n→∞

k ≤ 2 log2 n − 10 log2 log2 n gilt: f (k) −−−−→ ∞.

n→∞

• Satz: Sei k = k(n) mit k ∼ 2 log2 n und f (k) −−−−→ ∞. Dann gilt:

ω(G(n, 1/2)) ≥ k a.f.s.

• Beweisidee: sei X die Anzahl der Cliquen der Größe k in G(n, 1/2); schätze

die Varianz ab und wende die Chebyshev-Ungleichung an. Schreibe X =

P

∼

[n] XS , wobei XS (G) die Indikatorvariable fürs Ereignis G[S] = Kk ,

S∈ k

P

wobei G ∼ G(n, 1/2). Nun gilt: Var(X) =

[n] Cov(XS , XT ) ≤

P

P S,T ∈ k

EX + S,T : 2≤|X∩S|≤k−1 EXS XT . Sei ∆ := S,T : 2≤|X∩S|≤k−1 EXS XT =

i

k

k

n − 2 Pk−1 k n−k − 2 + 2

2

2

. Es bleibt zu zeigen, dass ∆∗ :=

i=2 i k−i k

k

i

Pk−1 k n−k − +

Pk−2

2

2

= o(EX) ist. Schreibe ∆∗ als EX i=2 g(i),

i=2 i

k−i 2

wobei

i

k n−k

2 2

g(i) := i k−i

.

n

k

PROBABILISTISCHE KOMBINATORIK

21

−k

Es gilt g(2) ∼ k 4 /n2 und g(k − 1) ∼ 2kn2

= o(n−1+o(1) ), und die anderen

EX

Terme sind durch g(2) bzw. g(k − 1) beschränkt. Also gilt: ∆∗ = o(EX).

• Korollar: Es existiert k = k(n) ∼ 2 log2 n so dass P[ω(G(n, 1/2)) =

n→∞

k oder k+1] −−−−→ 1. (d.h. a.f.s. die Cliquenzahl auf höchstens zwei Werten

konzentriert).

• Sei k0 = k0 (n) so dass f (k0 ) < 1 ≤ f (k0 − 1) und wähle k := k0 − 4, aus

4

−k

folgt: f (k) ≥ n3+o(1) . Ferner gilt: ∆ ∼ f (k)2 nk 2 .

f (k + 1)/f (k) = n−k

k+1 2

2

8

• Satz: Es gibt ein c > 0 so dass P[ω(G(n, 1/2)) < k] ≤ e−cn / log2 n gilt.

• Beweisidee: sei Y (H) die größte Kardinalität einer Familie kantendisjunkter Cliquen Kk in H. Dann ist Xi (H) := EG∼G(n,1/2) [Y (G)|G(i) = H(i)]

ein Kantenmartingal, welches der Kanten-Lipschitz-Bedingung genügt (Die

Zufallsvariable Y0 für die Anzahl der Cliquen Kk wäre eine schlechte Wahl

als Martingal. Wieso?). Die Azuma-Ungleichung liefert:

P[ω(G(n, 1/2)) <

2

n

k] = P[Y = 0] ≤ P[Y − EY ≤ EY ] ≤ e−(EY ) /(2 2 ) . Nun brauchen wir

aber eine gute untere (!) Schranke an den Erwartungswert von EY (dann

wäre der Satz gezeigt).

• Lemma: EY ≥ (1 + o(1))n2 /(2k 4 ).

• Beweisidee: sei H ∼ G(n, 1/2), betrachte alle (ungeordneten) Paare

von k-Cliquen in H, die sich in mindestens einer Kante schneiden, d.h.

W(H) := {{S, T } : S, T ∈ K(H), H[S] ∼

= H[T ] ∼

= Kk , 2 ≤ |S ∩ T | ≤ k − 1},

∼

wobei K(H) := {S : : H[S] = Kk } die Menge aller k-Cliquen in H. Sei

[n]

C ⊆ [n]

ist in C unabhängig mit Wahrscheink , wobei jedes S ∈

k

lichkeit q. Definiere W 0 (H) als W(H) ∩ C2 . Intuitiv: W 0 (H, C) beschreibt

“Konflikte” in K(H) ∩ C. Es gilt also Y (H) ≥ |C ∩ K(H)| − |W 0 (C, H)|.

Wenn man Erwartungswerte nimmt, so folgt: EH∼G(n,1/2);C |C ∩ K(H)| =

k

q nk 2− 2 = qf (k), EH∼G(n,1/2);C |W 0 (C, H)| = q 2 EH∼G(n,1/2) |W(H)| =

q 2 ∆/2 (∆ wurde in der Vorlesung vom 20. Dezember definiert). Also gilt

EY ≥ qf (k) − q 2 ∆/2 und maximiert nach q die rechte Seite, so folgt das

4

gewünschte Ergebnis (mit ∆ ∼ f (k)2 nk 2 und f (k) > n3+o(1) ).

Buchreferenzen: [2, Kapitel 7], [6, Kapitel 2] und [4, Kapitel 6].

17.Januar 2014

14.Januar 2014

3.4. Jansons Ungleichung.

• sei S ⊂ [N ] zufällige Teilmenge mit P(i ∈ S) P

= pi ∈ (0, 1) unabhängig

[N ]

für

alle

i

∈

[N

],

A

⊂

2

\

{∅},

und

X

:=

A∈A IA , wobei IA (S) =

(

1, A ⊆ S

0, sonst.

• Problem(e): schätze P(X = 0), P(X ≤ EX − t), P(X ≤ EX + t) ab.

• Beispiele:

(1) P(G(n, p) 6⊇ K3 ) = P(X = 0), wobei N = | [n]

|, pi = p ∀i ∈ [N ], A =

2 P

{{ab, bc, ac} : a 6= b 6= c 6= a, a, b, c ∈ [n]}, X = A∈A IA =Anzahl von

K3 s in G(n, p).

(2) P(ω(G(n, 1/2)) < k) = P(X = 0), wobei N = | [n]

|, pi = 1/2 ∀i ∈

2

P

S

[n]

[N ], A = { 2 : S ∈ k }, X =

A∈A IA =Anzahl von Kk s in

G(n, 1/2).

• Abschätzung von P(X = 0) von “unten”:

– P(X = 0) = P(IA = 1 : ∀A ∈ A).

22

YURY PERSON

– es gilt, dass {X = 0}, sowie {IA = 0}(a ∈ A) monoton fallende

Familien in 2[N ] sind

– Korollar von FKG-Ungleichung

liefert (Vorlesung

Q

Q vom 6. Dezember): P(X = 0) ≥

P(I

=

0)

=

A

A∈A

A∈A (1 − EIA ) ≥

Q

−EIA /(1−EIA )

−EX/(1−maxA∈A EIA )

e

≥

e

,

wobei

1 − x ≥ e−x/(1−x)

A∈A

für x ∈ [0, 1) gilt (Hausaufgabe).

– betrachte G(n, p) mit p = c/n mit c > 0, dann gilt: EX =

P

c3

3

A∈A EIA ∼ 6 wobei EIA = p = o(1); Also gilt: P(G(n, p) 6⊇

−(1+o(1))c3 /6

K3 ) ≥ e

.

• Theorem (Jansons Ungleichung): sei S ⊂ [N ] zufällige Teilmenge mit

[N ]

P(i ∈ S) = pi ∈ (0, 1) unabhängig

( für alle i ∈ [N ], A ⊂ 2 \ {∅}, und

P

P

1, A ⊆ S

Sei ∆ =

X :=

A∈A IA , wobei IA (S) =

A∩B6=∅ EIA IB

0, sonst.

und φ(x) := (1 + x) ln(1 + x) − x (x ≥ −1, φ(−1) := 1). Dann gilt für alle

t mit 0 ≤ t ≤ EX:

P(X ≤ EX − t) ≤ e−φ(−t/EX)(EX)

2

/∆

2

≤ e−t

/(2∆)

.

−EX+∆

• Korollar: Mit

,

P den obigen Voraussetzungen gilt: P(X = 0) ≤ e

wobei ∆ = A∩B6=∅,A6=B EIA IB (es gilt also ∆ = ∆ + EX).

– Beweis: setze t = EX und schätze (EX)2 /(EX + ∆) ≥ EX − ∆ ab.

• Beispiel 1:

– P(G(n, p) 6⊇ K3 ) = P(X = 0), wobei N = | [n]

|, pi = p ∀i ∈ [N ], A =

2 P

{{ab, bc, ac} : a 6= b 6= c 6= a, a, b, c ∈ [n]}, X = A∈A IA =Anzahl von

K3 s in G(n, p).

– falls p 1/n so gilt G(n, p) enthält a.f.s. kein K3 (betrachte Er n→∞

wartungswert EX = p3 n3 −−−−→ 0 und wende Markovs Ungleichung

an)

n→∞

– falls p 1/n so gilt G(n, p) enthält a.f.s. kein K3 (es gilt: EX −−−−→

∞ und VarX = o(EX), also kann man Chebyshevs Ungleichung anwenden)

3

– betrachte G(n, p) mit p = c/n mit c > 0, dann gilt: EX ∼ c6 ,

P

∆ = A6=B,A∩B6=∅ EIA IB = n2 (n − 2)(n − 3)p5 = o(1), also folgt:

3

P(G(n, c/n) 6⊇ K3 ) ≤ e−(1+o(1))c /6 .

3

n→∞

– Zusammen mit FKG folgt: P(G(n, p) 6⊇ K3 ) −−−−→ e−c /6 (p = c/n).

n→∞

– Allgemeiner gilt (o.Beweis): P(G(n, p) enthält genau j K3 ) −−−−→

3

j

3

/6)

e−c /6 (c j!

(p = c/n) (Poisson Paradigma).

• Beispiel 2:

– P(ω(G(n, 1/2)) < k) = P(X = 0), wobei N = | [n]

|, pi = 1/2 ∀i ∈

2

P

S

[n]

[N ], A = { 2 : S ∈ k }, X =

A∈A IA =Anzahl von Kk s in

G(n, 1/2).

– Setup vom 20. Dezember:

k

∗ setze f (k) := nk 2− 2 , dies ist die erwartete Anzahl an Cliquen

der Größe k in G(n, 1/2)

∗ k0 := k0 (n) so dass f (k0 ) < 1 ≤ f (k0 − 1), es gilt k0 ∼ 2 log2 n

PROBABILISTISCHE KOMBINATORIK

23

−k

∗ wähle k := k0 − 4, aus f (k + 1)/f (k) = n−k

folgt: f (k) ≥

k+1 2

3+o(1)

n

.

∗ man kann ∆ wie folgt schreiben (siehe Vorlesung vom 20. Dezem

i

k n−k

P

2 2

k−1

ber): ∆ = f (k)2 i=2 g(i), wobei g(i) := i k−i

, und

n

k

g(2) > g(3) > . . . > g(i0 ) < . . . g(k − 1) (für ein i0 – analysiere

dazu g(i)/g(i + 1) – etwas technisch).

−k

=

∗ mit g(2) ∼ k 4 /n2 , g(3) ∼ n−3 und g(k − 1) ∼ 2kn2

EX

o(n−4+o(1) ) (denn EX = f (k) > n3+o(1) ) folgt: g(2) ∼

Pk−1

i=2 g(i).

– Mit dem Setup folgt (und EX > n3+o(1) ): ∆ ∼ ∆ ∼ E(X)2 k 4 /n2 .

2

– Somit gilt: P(ω(G(n, 1/2)) < k) = P(X = 0) ≤ e−(EX) /(2∆) =

2+o(1)

e−n

(vgl. Vorlesung vom 20. Dezember).

• chromatische Zahl χ(G(n, 1/2)): Es gilt a.f.s. χ(G(n, 1/2)) = (1+o(1))n

2 log2 n .

• Beweisidee:

n

– untere Schranke folgt mit χ(G) ≥ α(G)

und α(G(n, 1/2)) ∼ 2 log2 n

a.f.s. – weil G ∼ G(n, 1/2) gleichverteilt ist, folgt dies mit α(G) =

ω(G).

– für die obere Schranke setzen wir m = bn/ log22 nc. Es gilt ferner

k0 (m) ∼ 2 log2 m ∼ 2 log2 n. Also gilt

PG∼G(n,1/2) [∃ S ∈

[n]

m

: α(G[S]) < k0 (m)−4] <

n

m

2+o(1)

e−m

−2+o(1)

< 2 n en

17.Januar 2014

= o(1).

Nun färbe disjunkte unabhängige Mengen der Größe k := k0 (m) − 4 ∼

2 log2 n mit verschiedenen Farben, bis höchstens m Knoten übrig

bleiben. Jeder dieser Knoten erhält dann eine eigene Farbe. Zusammen haben wir a.f.s. für ein G ∼ G(n, 1/2) höchstens d n−m

k e+m =

n

(1 + o(1)) 2 log

Farben

verwendet.

2n

• grobe Beweisidee (Jansons Ungleichung): folgt demselben Muster wie Chernoffs Ungleichung und Azumas Ungleichung, d.h. man analysiert die momenterzeugende Funktion einer Zufallsvariablen. Mit Markovs Ungleichung

(s > 0): P(X ≤ EX − t) = P(−sX ≥ −s(EX − t)) = P(e−sX ≥

e−s(EX−t) ) ≤ Ee−sX es(EX−t) . Definiere Ψ(s) := Ee−sX . Das Herz des

Beweises ist die technische Abschätzung von: − ln(Ψ(s))0 ≥ EXe−s∆/EX

Rs

für ∀s > 0. Denn daraus folgt sofort: − ln Ψ(s) ≥ 0 EXe−u∆/EX du =

(EX)2

(1 − e−s∆/EX ). Also gilt: ln P(X ≤ EX − t) ≤ ln Ψ(s) + s(EX − t) ≤

∆

2

− (EX)

(1 − e−s∆/EX ) + s(EX − t) =: f (s). Die rechte Seit wird dabei

∆

t

bei s0 = − ln(1 − EX

) EX

minimiert. Setzt man s = s0 ein, so folgt:

∆

(EX)2

ln(P(X ≤ EX − t)) ≤ ∆ φ(−t/EX). Da φ(x) ≥ x2 /2 für x ∈ [−1, 0] gilt,

−t2 /(2∆)

.

folgt: ln P(X − EX − t) ≤ e

• Sei f : I → R eine konvexe Funktion (I ein Intervall) und X eine Zufallsvariable mit Werten in I. Dann gilt die Jensensche Ungleichung:

f (EX) ≤ Ef (X). (Hausaufgabenblatt 9)

21.Januar 2014

24

YURY PERSON

0

• Abschätzung − ln(Ψ(s))P

≥ EXe−s∆/EX für ∀s > 0: grobe Idee:

0

−sX

−sX

Ψ (s) = −EXe

=

. Nun gilt es, EIA e−sX nach unA∈A EIA e

−sX

−sX

ten abzuschätzen: EIA e

|IA = 1], zerlegt man

P= P(IA = 1)E[e

X = YA + ZA mit YA :=

I

,

so

folgt

mit

FKG-Ungleichung:

B∩A6=∅ B

−sX

−sYA

P(IA = 1)E[e

|IA = 1] ≥ P(IA = 1)E[e

|IA = 1]E[e−sZA |IA = 1] ≥

−sYA

P(IA = 1)Ψ(s)E[e

|IA = 1]. Zusammen gilt:

0

X

−Ψ (s)

− ln(Ψ(s))0 =

≥

P(IA = 1)E[e−sYA |IA = 1] ≥ EXe−s∆/EX ,

Ψ(s)

A∈A

durch zweimaliges Anwenden der Jensenschen Ungleichung.

Buchreferenzen: [2, Kapitel 7 und 10] und [6, Kapitel 2].

4. Kombinatorische Theoreme

4.1. Schnitttheoreme.

• Proposition: Sei F ⊆ 2[n] eine Familie mit der Eigenschaft: ∀ F1 , F2 ∈ F

gilt F1 ∩ F2 6= ∅. Dann gilt |F| ≤ 2n−1 .

• Beweis: F und sein Komplement F c können nicht beide in F liegen.

• Bemerkung: die Schranke ist scharf, denn die folgenden Familien nehmen

sie an:

– Fi := {F : i ∈ F, F ⊆ [n]},

– n ungerade: F := {F : |F | ≥ dn/2e}.

• Theorem (Erdős-Ko-Rado): Sei n ≥ 2k und F ⊆ [n]

mit

k eine Familie

der Eigenschaft: ∀ F1 , F2 ∈ F gilt F1 ∩ F2 6= ∅. Dann gilt |F| ≤ n−1

.

k−1

• Bemerkungen:

– die Schranke ist scharf, z.B. für Fi := {F : i ∈ F, F ⊆ [n]k};

– falls n ≤ 2k−1 so gilt die triviale Schranke nk , denn alle k-elementigen

Mengen von [n] haben einen nichtleeren Schnitt.

• Beweisidee: wir ersetzen [n] durch Zn (und rechnen modulo n). Sei σ

eine zufällige uniforme Permutation von Zn , und i ein zufälliges uniform

verteiltes Element aus Zn . Dann ist die Menge A := {σ(i), . . . , σ(i + k − 1)}

eine uniform

verteilte Menge aus [n]

k . Es ist klar, dass P(A ∈ F) =

|F|/ nk . Andererseits kann man zeigen, dass P[A ∈ F|σ] ≤ k/n , und

somit P[A ∈ F] ≤ k/n. Zusammen folgt: |F|/ nk ≤ k/n und durch die

Umformung die Behauptung.

• Theorem (Projektionstheorem): sei F ⊆ 2[n] , und seien A1 ,. . . , Am

Teilmengen von [n]. Ferner sei jedes i ∈ [n] in mindestens k der Ai s enthalten. Dann gilt:

m

Y

|F|k ≤

|Fi |,

i=1

wobei Fi := {F ∩ Ai : F ∈ F} die Projektion von F auf Ai .

• Theorem: sei n ≥ 4, und G eine Menge von (markierten) Graphen auf

der Knotenmenge [n] mit der Eigenschaft, dass für alle G1 = ([n], E1 ),

G1 = ([n], E2 ) ∈ G gilt G1 ∩ G2 := ([n], E1 ∩ E2 ) enthält ein Dreieck (K3 ).

Dann gilt:

n

|G| < 2( 2 )−2 .

PROBABILISTISCHE KOMBINATORIK

25

• Bemerkung: es war lange ein offenes Problem (vor 4 Jahren gelöst), die

n

obere Schranke auf die bestmögliche ≤ 2( 2 )−3 (betrachte alle markierten

Graphen, die ein fixiertes Dreieck enthalten) zu verbessern.

• Beweis: finde geeignete Kantenmengen ein, auf die G projiziert wer˙ Tc): T ∈

den kann. Genauer: definiere die Familie A := {E(KT ∪K

[n]

n

} mit m := bn/2c Elementen AT , d.h. die Kantenmenge AT ist

bn/2c

[bn/2c] ˙ n\[bn/2c]

∪

, und enthält

s := bn/2c

+ dn/2e

Kanten. Ferner

2

2

2

2

ist jede Kante in k = ms/ n2 Mengen AT enthalten (doppeltes Abzählen

der Paare (AT , e) mit e ∈ AT ; jede Kante liegt in gleich vielen AT s). Es

gilt auch, dass GT := {AT ∩ G : G ∈ G} eine Schnittfamilie ist und daher

|GT | ≤ 2s−1 (d.h. für G, G0 ∈ GT gilt G ∩ G0 6= ∅) – dies liegt daran, dass

Dreiecke nicht bipartit sind und [n]

2 \AT die Kantenmenge eines bipartiten

Graphen ist. Nach dem Projektionstheorem gilt:

Y

n

|G|ms/( 2 ) = |G|k ≤

|GT | ≤ (2s−1 )m .

T

n

2

n

2

Es folgt: |G| ≤ 2( )−( )/s . Mit s <

1 n

2 2

folgt die Behauptung.

4.2. Entropie.

• Definition: Sei X eine Zufallsvariable mit den Werten in einer endlichen

Menge S. Dann ist deren Entropie H(X) definiert als:

X

H(X) := −

P(X = a) log2 P(X = a).

a∈S

x→0

•

•

•

•

•

•

Als Konvention: 0 log2 0 := 0, da x log2 x −−−→ 0.

Intuitiv misst H(X) den Informationsgehalt von X, welcher die erwartete

Anzahl der Bits ist, die man übertragen muss, um X zu übermitteln.

Beispiele:

– p-Münze X: H(X) = −p log2 p − (1 − p) log2 (1 − p). Falls p = 1/2 so

ist H(X) = 1. Gilt p = 1, so ist H(X) = 0, die Münze ist “deterministisch”.

– sei F eine Familie von Mengen und X eine auf F uniform verteilte

Zufallsvariable. Dann gilt: H(X) = log2 |F|.

Proposition: Sei X eine Zufallsvariable mit den Werten in einer endlichen

Menge S. Dann gilt: H(X)

P ≤ log2 |S|.

P

Beweis: H(X) = − a∈S P(X = a) log2 P(X = a) =

a∈S P(X =

P

Jensen

1

1

a) log2 P(X=a) ≤ log2

= log2 |S|, weil log2 x

a∈S P(X = a) P(X=a)

P

P

auf (0, ∞) konkav ist (es gilt also φ( i λi xi ) ≥ i λi φ(xi ) falls φ konkav

ist (−φ ist konvex)).

Anwendung auf kombinatorische Probleme: um |F| abzuschätzen,

reicht es, eine Abschätzung an H(X) zu gewinnen, wobei X eine Zufallsvariable mit dem Wertebereich F ist.

bedingte Entropie:

(1) seiP

X eine ZV’e mit dem Wertebereich S, E ein Ereignis; H(X|E) :=

− a∈S P(X = a|E) log2 P(X = a|E) heißt bedingte Entropie von X

gegeben E

24.Januar 2014

26

YURY PERSON

•

•

•

28.Januar 2014

•

(2) seien

P X und Y ZV’e mit den Wertebereichen S, bzw. T ; H(X|Y ) :=

− b∈T H(X|Y = b)P(Y = b) heißt bedingte Entropie von X gegeben

Y (vergleiche mit der Definition des bedingten Erwartungswerts)

(3) ferner kann man X und Y als Vektoren von Zufallsvariablen auffassen: X = (X1 , . . . , Xn ) und Y = (Y1 , . . . , Ym ) ZV’e mit den Wertebereichen S1 × . . . × Sn bzw. T1 × . . . × Tm ; dann ist H(X|Y ) =

P

b=(b1 ,...,bm )∈T1 ×...×Tm H(X|Y = b)P(Y = b), wobei H(X|Y = b) =

P

− a=(a1 ,...,an )∈S1 ×...×Sn P(X = a|Y = b) log2 P(X = a|Y = b).

* Hinweis: P(X = a) steht für P(X1 = a1 , X2 = a2 , . . . , Xn = an ) und

P(Y = b) analog.

Weitere Eigenschaften der Entropie: seien X, Y und Z Zufallsvariablen (ZV’en) mit den Wertebereichen S, T und U . Dann gelten:

(i) H(X, Y ) ≥ H(X) (“Je mehr Zufallsexperimente, desto mehr Information”)

(ii) H(X, Y ) ≤ H(X) + H(Y ) (“Informationsgehalt ist subadditiv”)

(iii) H(X, Y ) = H(X) + H(Y |X) (Kettenregel)

(iv) H(X|Y, Z) ≤ H(X|Y ) (“wenn man weniger beobachtet hat (Y ), dann

ist der Informationsgehalt größer”)

* zusätzlich gilt in (ii): H(X, Y ) = H(X) + H(Y ) genau dann, wenn X

und Y unabhängig sind.

die Beweise nutzen Konvexität von x log2 x bzw. Monotonie von log2 x,

sowie Definitionen der Entropie bzw. der bedingten Entropie aus (siehe [2,

Kapitel 15])

Korollar: seien X1 ,. . .P

, Xn Zufallsvariablen (ZV’en). Dann gelten:

n

(i) H(X1 , . . . , Xn ) ≤ Pi=1 H(Xi ) (folgt sofort aus der Proposition (ii));

n

(ii) H(X1 , . . . , Xn ) = i=1 H(Xi |X1 , . . . , Xi−1 ) = H(X1 ) + H(X2 |X1 ) +

H(X3 |X1 , X2 ) + . . . + H(Xn |X1 , . . . , Xn−1 ) (folgt per Induktion aus

der Kettenregel).

3i,F ∈F }|

. Dann gilt: |F| ≤

Proposition: Sei F ⊆ 2[n] , pi = |{F : F |F

|

Pn

2 i=1 H(pi ) , wobei H(p) = −p log2 p − (1 − p) log2 (1 − p).

• Beweis: sei X eine ZVe, uniform verteilt auf F, d.h. P(F = X) = 1/|F|.

Wir können jedes F mit seinem charakteristischen Vektor vF ∈ {0, 1}n

assozieren; X lässt sich dann schreiben als (X1 , . . . , Xn ) ∈ {0, 1}n . Es ist

klar, dass H(X) = log2 |F|, und P(Xi = 1) = pi (und P(Xi = 0) = 1 − pi

und

i ) = H(pi )). Es gilt mit vorherigem Korollar: H(X) ≤

Pn daher H(XP

n

H(X

)

≤

die Behauptung.

i

i=1 H(pi ) und durch potenzieren folgt

i=1

Ppn n

• Korollar: Sei p ∈ [0, 1/2]. Es gilt die Abschätzung i=1 i ≤ 2H(p)n .

3i,F ∈F }|

• Beweis: sei F := {F : F ⊆ [n], |F | ≤ pn}, und pi := |{F : F |F

. Zähle

|

Paare (F, j) mit j ∈ F ∈ F auf doppelte Art ab:

pn n

X

X

n

pi |F| =

j

≤ pn|F|.

j

i=1

j=0

P

Daraus folgt:

i pi ≤ pn. Wegen Symmetrie gilt p1 = . . . = pn , und

somit

p

≤

p

für

alle i. Da H(x) monoton wachsend auf [0, 1/2] ist, gilt:

i

P

H(p

)

≤

H(p)n.

Mit der Proposition davor folgt dann die Behauptung.

i

i

• Theorem: sei X = (X1 , . . . , Xn ) ZVe mit dem Wertebereich S = S1 ×

. . . × Sn , und seien F1 , . . . , Fm ⊆ [n] Teilmengen mit |{i : Fi 3 j}| ≥ k für

PROBABILISTISCHE KOMBINATORIK

27

alle j ∈ [n]. Dann gilt:

kH(X) ≤

m

X

H(X(Fi )),

i=1

wobei X(F ) := (Xi )i∈F die Projektion von X auf F ⊆ [n] ist.

• Beweisidee: Induktion nach k. Für k = 1 folgt es aus den Fakten über