14a

Werbung

Vorlesung 13b

Relative Entropie

1

S sei eine abzählbare Menge (ein “Alphabet”).

Die Elemente von S nennen wir Buchstaben.

X sei eine S-wertieg Zufallsvariable

(ein “zufälliger Buchstabe”).

H2[X] := −

X

ν(a) log2 ν(a)

a∈S

heißt die Entropie von X (zur Basis 2).

2

Es ist sinnvoll, auch andere Basen zu erlauben.

Wir schreiben

H[X] := −

X

ν(a) log ν(a),

a∈S

wobei log zu einer beliebigen, festen Basis genommen wird:

Hb[X] := −

X

a∈S

ν(a) logb ν(a).

3

Die Entropie ist der fundamentale Begriff

der Informationstheorie.

Nach dem Quellenkodierungssatz gibt die Entropie

fast genau die mittlere Anzahl von Ja-Nein Fragen an,

die notwendig und

- bei guter Wahl des Codes - auch hinreichend ist,

um den unbekannten Wert von X von jemandem zu erfragen,

der X beobachten kann.

Dies ist gemeint, wenn man die Entropie beschreibt als den

Grad von Unbestimmtheit oder Ungewissheit

über den Wert, den X annimmt.

4

Die relative Entropie

Definition: Seien ν und ρ Wahrscheinlichkeitsverteilungen

mit Gewichten ν(a) und ρ(a), a ∈ S. Dann ist die relative

Entropie von ν bzgl. ρ definiert als

ν(a)

D(νkρ) :=

ν(a) log

,

ρ(a)

a∈S

X

wobei die Summanden mit ν(a) = 0

gleich 0 gesetzt werden.

5

Interpretation der relativen Entropie:

Man denke sich einen zufälligen Buchstaben mit Verteilung ν

mit einem Shannon-Code codiert, der nicht der Verteilung ν,

sondern der Verteilung ρ angepasst ist,

also mit Codewortlängen

− log ρ(a) ≤ ℓ(a) < − log ρ(a) + 1.

Dann ist die Zunahme der erwarteten Codelänge

bis auf ein Bit gleich

−

X

a

ν(a) log ρ(a) −

−

X

a

ν(a) log ν(a) = D(νkρ).

6

In der Tat gilt ja für die Länge ℓρ des

an ρ angepassten Shannon-Codes:

− a ν(a) log ρ(a) ≤ E[ℓρ(X)] < − a ν(a) log ρ(a) + 1.

P

P

Und für für die Länge ℓρ des

an ν angepassten Shannon-Codes gilt:

− a ν(a) log ν(a) ≤ E[kν (X)] < − a ν(a) log ν(a) + 1.

P

P

Daraus folgt für die Differenz:

E[ℓρ(X)] − E[ℓν (X)] ∈ [D(νkρ) − 1, D(νkρ) + 1). 2

7

Satz: (“Informationsungleichung”) D(νkρ) ≥ 0.

Beweis: Wieder verwenden wir die Abschätzung

log x ≤ c · (x − 1) mit passendem c > 0:

ρ(a)

D(νkρ) = −

ν(a) log

ν(a)

a:ν(a)>0

X

ρ(a)

−1

≥−

ν(a) c ·

ν(a)

a:ν(a)>0

X

= −c

X

a:ν(a)>0

ρ(a) −

X

a

ν(a) ≥ 0.

2

8

Bemerkung: Aus D(νkρ) = 0 folgt ν = ρ.

In der Tat: In

log x ≤ c(x − 1)

besteht abgesehen für x = 1 strikte Ungleichung.

Also folgt aus

X

X

ρ(a)

ρ(a)

−

ν(a) log

= −c

ν(a)

−1 ,

ν(a)

ν(a)

a:ν(a)>0

a:ν(a)>0

dass

ρ(a) = ν(a) für alle a mit ν(a) > 0.

Und aus

X

a:ν(a)>0

folgt

ρ(a) −

X

a

ν(a) = 0

ρ(a) = ν(a) für alle a mit ν(a) = 0. 2

9

Zusammenfassend ergibt sich der

Satz (von der relativen Entropie):

Die relative Entropie D(νkρ) ist nichtnegativ,

und verschwindet genau für ν = ρ.

10

In den folgenden Beispielen

benutzen wir den Satz in der Gestalt

(∗)

−

X

a

ν(a) log ν(a) ≤ −

X

a

ν(a) log ρ(a)

mit Gleichheit genau für ν = ρ.

Wir sehen:

Hat X die Verteilung ν,

so liefert jede Wahl von ρ eine Schranke für H[X],

mit Gleichheit genau für ν = ρ.

11

Beispiel: Vegleich mit der uniformen Verteilung:

Sei S endlich mit n Elementen

und sei ρ(a) = 1/n für alle a ∈ S.

Dann folgt aus (∗):

X

1

H[X] ≤ − ν(a) log( ) = log n .

n

a

H[X] ≤ log n.

Gleichheit gilt genau im Fall der uniformen Verteilung,

sie maximiert auf S die Entropie.

2

12

Beispiel: Vergleich mit (verschobener) geom. Verteilung:

Sei nun S = {0, 1, 2, . . .}, und ρ(k) := 2−k−1

Dann folgt aus (∗):

H2[X] ≤

=

∞

X

X

a

ν(a) log2(−2−k−1)

(k + 1)ν(k) = (E[X] + 1) .

k=0

Gleichheit gilt für ν(k) = 2−k−1, dann ist H2[X] = 2. Also:

Unter allen N0-wertigen ZV’en mit EW ≤ 1

hat das X mit Gewichten 2−k−1 die größte Entropie,

nämlich H2[X] = 2. 2

13

Beispiel: Vergleich mit einer “Gibbsverteilung”:

Gegeben sei u : S → R, β ≥ 0.

Wir definieren die Gewichte ρ(a) := e−βu(a)/z mit

z :=

X

e−βu(a) ( Annahme: z < ∞.)

a∈S

Die Abschätzung (∗) ergibt

He[X] ≤ β E[u(X)] + ln z .

Ist E[u(X)] ≤

He[X] ≤ β

X

a

X

a

u(a)ρ(a), so folgt

u(a)ρ(a) + ln z = −

X

a

ρ(a) ln ρ(a),

mit Gleichheit genau dann, wenn X die Verteilung ρ hat.

14

Zusammengefasst:

Unter allen Zufallsvariablen mit

Erwartungswert ≤

X

a

u(a)e−βu(a)/z

hat diejenige die größte Entropie,

die die Verteilungsgewichte e−βu(a)/z hat.

Die Verteilung mit diesen Gewichten heißt Gibbsverteilung

zum Potenzial u mit Parameter β.

2

15

Beispiel:

ν und ρ binomialverteilt zu den Parametern (n, α) bzw. (n, p)

D(νkρ) =?

ν(k)

αk (1 − α)n−k

1−α

α

log

= log k

= k log +(n−k) log

n−k

ρ(k)

p (1 − p)

p

1−p

Wegen

P

k ν(k) = nα ist somit

D(νkρ) =

=

n α log

X

ν(k)

ν(k) log

ρ(k)

α

1 − α

+ (1 − α) log

=: n h(α, p).

p

1−p

2

16

Beispiel: Für p ∈ (0, 1) sei Y1, Y2, . . . ein p-Münzwurf.

Kn := Y1 + . . . + Yn sei die “Anzahl der Erfolge” bis n.

Sei [c, d] ein Intervall rechts von p (mit p < c < d).

Satz (Boltzmann)

Kn

ln P

∈ [c, d] ∼ −n h(c, p)

n

(

)

für n → ∞,

mit h wie im vorigen Beispiel.

Beweis: siehe Skript Wakolbinger, Seite 96-98.

17

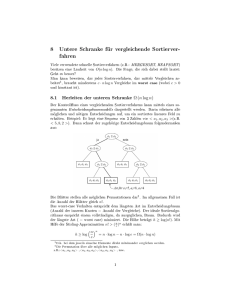

S = k log W

Entropie =

k mal

Logarithmus der

Wahrscheinlichkeit

Ludwig Boltzmann

1844-1906

Grabmal am

Wiener

Zentralfriedhof

18