Einführung in die statistische Sprachverarbeitung

Werbung

Einführung in die statistische Sprachverarbeitung

Johannes Goller

Centrum für Informationsund Sprachverarbeitung

Oettingenstr. 67

80538 München

3. Mai 2006

2

Inhaltsverzeichnis

1

2

3

4

Motivation und Grundlagen

1.1 Einführung . . . . . . . . . . . . . . . . . . . . . . . . . .

1.2 Literatur . . . . . . . . . . . . . . . . . . . . . . . . . . . .

1.3 Grundbegriffe und Notationen . . . . . . . . . . . . . . . .

1.3.1 Stochastik, Statistik und Wahrscheinlichkeitstheorie

1.3.2 Zählen und Messen . . . . . . . . . . . . . . . . . .

1.3.3 Mathematische Grundbegriffe und Notationen . . . .

1.3.4 Wahrscheinlichkeitsräume . . . . . . . . . . . . . .

1.4 Standardmodelle . . . . . . . . . . . . . . . . . . . . . . .

1.4.1 Gleichverteilung . . . . . . . . . . . . . . . . . . .

1.4.2 Urnenmodell: Ziehen mit Zurücklegen . . . . . . . .

1.4.3 Urnenmodell: Ziehen ohne Zurücklegen . . . . . . .

1.5 Frequenzlisten als Wahrscheinlichkeitsräume . . . . . . . .

1.6 Die Zipfverteilung . . . . . . . . . . . . . . . . . . . . . .

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

5

5

7

8

8

11

17

20

24

24

24

27

27

29

Bedingte Wahrscheinlichkeit

2.1 Wie man die Zukunft nicht voraussagt und die Formel von Bayes

2.2 Situationsabhängige Wahrscheinlichkeiten: Mehrstufige Modelle

2.3 Automatisiertes Gefasel: n-Gramm-Modelle . . . . . . . . . . .

2.4 Zufallsvariablen und Projektionen . . . . . . . . . . . . . . . .

2.5 Hidden-Markov-Modelle und POS-Tagging . . . . . . . . . . .

2.6 Anmerkung zur Multiplikation sehr kleiner Zahlen . . . . . . .

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

31

31

36

37

38

40

48

Rund um den Erwartungswert

3.1 Der Erwartungswert . . . . . . . . . .

3.2 Varianz und stochastische Konvergenz

3.3 Gesetz der großen Zahl . . . . . . . .

3.4 Korrelation von Zufallsvariablen . . .

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

51

51

54

57

58

Testtheorie und Extraktion von Kollokationen

4.1 Der Weg von Beobachtungen zu Modellen . . . . . . . . . .

4.2 Schätzer . . . . . . . . . . . . . . . . . . . . . . . . . . . .

4.2.1 Ein Beispiel und die Maximum-Likelihood-Methode

4.2.2 Gütekriterien für Schätzer . . . . . . . . . . . . . .

4.3 Stochastik im Kontinuum . . . . . . . . . . . . . . . . . . .

4.3.1 Wozu Stochastik auf R . . . . . . . . . . . . . . . .

4.3.2 Einige Standardverteilungen . . . . . . . . . . . . .

4.4 Alternativtests und Neyman-Pearson-Lemma . . . . . . . .

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

61

62

62

62

64

65

65

68

69

3

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

4

INHALTSVERZEICHNIS

4.5

4.6

5

Studentscher t-Test . . . . . . . . . . . .

Anwendungen in der Computerlinguistik .

4.6.1 Identifikation von Kollokationen .

4.6.2 Classifier-Fusion . . . . . . . . .

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

72

73

74

74

Informationstheorie

5.1 Entropie und Kompression . . . . . . . . . . . . . . . . . . . . . . .

5.2 Mutual Information . . . . . . . . . . . . . . . . . . . . . . . . . . .

75

76

80

Kapitel 1

Motivation und Grundlagen

1.1

Einführung

Hauptziel der Computerlinguistik ist es, Eigenschaften der natürlichen Sprache (oder

von bestimmten natürlichen Einzelsprachen) zu formalisieren, d.h. so zu charakterisieren, daß sie durch Algorithmen berechnet werden können. Hierzu bedient sich die

Computerlinguistik einer Reihe von Hilfsmitteln, die auch in anderen Wissenschaften

eine große Rolle spielen und überdies als eigene Wissenschaften erforscht werden. Zu

diesen Hilfsmitteln gehören v.a. Darstellungsmethoden aus der formalen Logik (etwa

um die Bedeutung von Sätzen formelhaft darzustellen), Strukturierungsmethoden aus

der diskreten und algebraischen Mathematik (etwa um die Struktur und gegenseitige

Ähnlichkeit von Dokumenten zu erfassen), Algorithmen aus der Theorie der formalen

Sprachen und Automaten (etwa um effizientes Syntaxparsing zu ermöglichen), aber

auch Programmiersprachen, Unix-Tools und -Kommandos, Konzepte aus der technischen Informatik und vieles mehr.

Ein ebensolches Hilfsmittel ist die Statistik, oder genauer gesagt, eine Gruppe von

Darstellungs-, Schätzungs- und Entscheidungs-Methoden aus der Stochastik. Die Stochastik gilt heute als derjenige Teil der Mathematik, der sich mit den Gesetzmäßigkeiten des Zufalls beschäftigt, d.h. der versucht, Regularitäten in Prozessen zu erfassen, die keinem bekannten Gesetz unterliegen – oder aber sehr vielen nicht eindeutig

vorhersehbaren Faktoren ausgetzt sind –, und diese Regularitäten zur Vorhersage von

Entwicklungen bzw. zur Unterstützung der Entscheidungsfindung auszunutzen.

Das Ziel des vierstündigen Proseminars “Einführung in die statistische Sprachverarbeitung”, dessen Begleitmaterial der vorliegende Text ist, besteht in der Vermittlung

der wichtigsten stochastischen Methoden, die in der Computerlinguistik zum Einsatz

kommen. Dabei ist unter “Vermittlung” die Erklärung der mathematischen Definitionen und Sätze zu verstehen, ebenso wie die Skizzierung ihrer Beweise, vor allem aber

die Herstellung ihres Zusammenhangs mit ausgewählten computerlinguistischen Anwendungen, sowie die Beschreibung und, soweit möglich, praktische Implementierung

dieser Anwendungen.

Zahlreiche Computerlinguisten sehen ihre Wissenschaft heute in einer statistischen

Phase, in einer Phase der Entwicklung also, in der statistische Methoden gegenüber

anderen Methoden überwiegen oder mit besonderer Aufmerksamkeit erforscht werden. In der Tat hat die Zahl der computerlinguistischen Veröffentlichungen (in Zeit5

6

KAPITEL 1. MOTIVATION UND GRUNDLAGEN

schriften, Konferenzen usw.) mit statistischem Schwerpunkt im Laufe des vergangenen Jahrzehnts sehr deutlich zugenommen, und eine ganze Reihe von Konzepten, die

bisher von ausschließlich symbolischer Natur waren (also nicht-statistische Methoden), wurden erweitert (“probabilistic context free parsing”, “naive Bayes classification” u.a.), und aus der Stochastik hervorgegangene Methoden wurden in die Computerlinguistik eingeführt (“machine learning of natural language grammars”). Dadurch

entsteht bisweilen der Eindruck, statistische oder statistisch motivierte Methoden seien

gewissermaßen der zentrale Forschungsgegenstand der Computerlinguistik, und ihre

mathematische Präzisierung und (ganz und gar auf dem Boden der Mathematik stattfindende) Verfeinerung verliehe der Computerlinguistik sozusagen den letzten Schliff.

Dieser Eindruck soll durch den von diesem Skript begleiteten Kurs nicht erweckt oder

verstärkt werden: Da es in der Computerlinguistik um Sprache und ihre Charakterisierung geht, müssen vielmehr Methoden der Klassifizierung sprachlicher Phänomene,

also Methoden, die aus der Linguistik hervorgehen, im Vordergrund stehen. Das sind

in erster Linie die adäquate Erstellung von Korpora, Lexika und Grammatiken, und

die sorgfältige Beschreibung einzelner sprachlicher Konstruktionen. Statistische Methoden können aber in sehr vielfältiger Weise die Arbeit des Linguisten erleichtern,

weswegen ihnen eine, wenn auch nicht zentrale, so doch grundlegende Bedeutung in

der Computerlinguistik zukommt.

Am Ende des Kurses soll jeder Teilnehmer in der Lage sein,

• Statistische Begriffe und Methoden, die in der Computerlinguistik vorkommen,

zu erklären;

• Wissenschaftliche Veröffentlichungen, die statistische oder statistische motivierte Verfahren der Computerlinguistik beschreiben, zu verstehen und zu implementieren;

• Vorschläge machen zu können, wie gewisse Problemstellungen mit statistischen

Verfahren angegangen werden könnten.

Das Skript gliedert sich daher im ersten Teil in eine Reihe von Kapiteln, die die

Hauptideen und wichtigen Begriffe der Stochastik und Statistik darlegen, und zu jeder

Beispiele für Standard-Anwendungen in der Computerlinguistik geben:

• Charakterisierung des Wahrscheinlichkeitsraums (Beispiele: Frequenzlisten und

andere einfache linguistische Verteilungen)

• Standardmodelle (z.B. Gleichverteilung, Urnenmodelle) und Zufallsvariablen (Beispiele: Invertierte Listen und Indizes von Suchmaschinen)

• Bedingte Wahrscheinlichkeit und mehrstufige Modelle (Beispiele: Bayes-Klassifikation,

statistisches Tagging)

• Erwartungswert, Korrelation und Gesetz der großen Zahl (Beispiele: Bibliometrie und einfaches Machine Learning)

• Parameterschätzung und Hypothesentests (Beispiele: Wortassoziation und Kollokationsextraktion)

Im zweiten Teil werden einige speziellere Entwicklungen stochastischer Grundideen betrachtet, die in der Computerlinguistik besonders nützlich sind:

1.2. LITERATUR

7

• Informationstheorie im Dienste der Datenkompression

• Informationstheorie im Dienste des Machine Learning

• Statistik im Vektorraum (Information Retrieval und Dokumentenklassifikation)

Ein Kurs, der Hilfsmittel und Methoden vermitteln will, die in einer Wissenschaft

verwendet werden, kann nur erfolgreich sein, wenn die Teilnehmer das Gelernte üben.

Die beste Gelegenheit dafür bietet sich in Form von Programmierübungen, bei denen

die stochastischen Methoden implementiert und direkt getestet werden. Zwar ist es

nicht möglich, im Rahmen kleiner Übungen sehr komplexe oder umfangreiche Programme zu zu entwickeln, aber an vielen Stellen bietet sich die Möglichkeit, die Kernmethode oder eine vereinfachte Version zu programmieren; das ist natürlich ideal, insofern dabei sowohl die statistische Methode als auch das Programmieren an sich geübt

werden. Jedes Kapitel wird daher von einer Reihe von Übungsaufgaben – die meisten

Programmieraufgaben – begleitet, die im Kurs zum größten Teil auch als Hausaufgabe

gestellt werden.

1.2

Literatur

Folgende Lehrbücher wurden als zusätzliches Begleitmaterial, bzw. als weiterführende

Literatur, für geeignet befunden. Für spezielle Zusammenhänge finden sich weitere

Literaturhinweise in den einzelnen Kapiteln.

[Manning & Schütze, 2004] Enthält eine große Anzahl computerlinguistischer Anwendungen mit Beschreibungen der zugrundeliegenden Idee, des Algorithmus

und bisweilen mit Implementierungshinweisen. Die Notation sowie die Beschreibung der mathematischen Zusammenhänge ist allerdings recht oberflächlich und

immer wieder auch etwas irreführend. Sicherlich einer guter Überblick über die

am häufigsten zitierten computerlinguistischen Anwendungen statistischer Methoden.

[Georgii, 2004] Eine ausgezeichnete mathematische Einführung in die Stochastik. Für

das Verständnis der Beweise, die alle detailliert beschrieben sind, sind sehr solide Kenntnisse in Analysis allerdings Voraussetzung. Gut geeignet für jeden, der

tiefer in die Mathematik der Statistik eindringen möchte, und evtl. zum Nachschlagen mathematisch sauberer Definitionen der wichtigsten Begriffe.

[Altmann, 1995] Gründliche Erklärung stochastischer Grundbegriffe, also v.a. ein mathematisches Buch, aber im wesentlichen ohne Beweise und für Nicht-Mathematiker

geschrieben. Zahlreiche Rechenbeispiele und -Übungen.

[Woods et al., 1986] Zeigt anhand vieler Beispiele die Zusammenhänge zwischen Linguistik (v.a. Korpuslinguistik) und Statistik. Deckt also v.a. die nicht-informatischen

Teile des Kurses ab.

8

KAPITEL 1. MOTIVATION UND GRUNDLAGEN

1.3

1.3.1

Grundbegriffe und Notationen

Stochastik, Statistik und Wahrscheinlichkeitstheorie

Definition 1 (Stochastik). Die Stochastik ist derjenige Teil der Mathematik, der

sich der Beschreibung und Untersuchung von zufälligen Vorgängen widmet, d.h.

von Vorgängen, die keinen vollständig bekannten Gesetzmäßigkeiten unterliegen.

Auf den ersten Blick erscheint das Vorhaben der Stochastik also weitgehend sinnlos,

oder zumindest nicht besonders wissenschaftlich; denn sie scheint ja nur das Unerklärliche näher beschreiben zu wollen. Tatsächlich kann eine solche nähere Beschreibung natürlich durchaus zu Einsichten führen, die letztlich helfen, präzise Erklärungen

zu finden. Die Stochastik befaßt sich allerdings nur mit der systematischen Auswertung von Beobachtungen über die zufälligen Vorgänge und versucht dann, Modelle

zu finden, die dazu geeignet sind, diese Vorgänge zu reproduzieren – oder auch, vorauszusagen, wie der Vorgang sich in Zukunft verhält, unter der Annahme, daß die im

bisherigen Verhalten gefundenen Regularitäten weiterhin auftreten werden. Sie erhebt

keinerlei Anspruch, Erklärungen für das Verhalten zu geben.

Mit diesem Ziel vor Augen, gliedert sie sich in zwei Teile: Die Wahrscheinlichkeitstheorie (oder Probabilistik), die sich mit den Modellen und den daraus ableitbaren Voraussagen, sowie mit den Methoden der Voraussage selbst, befaßt. Sodann die

Statistik, die Verfahren angibt, mit denen sich zu einer gegebenen Menge von Beobachtungen auf möglichst systematische und objektive Weise eines der von der Wahrscheinlichkeitstheorie vorgegebenen Modelle auswählen läßt. In anderen Worten, die

Wahrscheinlichkeitstheorie geht von Modellen aus und macht Vorhersagen, während

die Statistik von den Daten ausgeht und auf die Modelle schließt.

Definition 2 (Wahrscheinlichkeitstheorie (Probabilistik)). Derjenige Teil der

Stochastik, der festlegt, in welcher Form Modelle von zufälligen Vorgängen angegeben werden können, und wie aus den Modellen Voraussagen abgeleitet werden

können. Die Voraussagen sind stets stochastischer Natur, d.h. sie sind nicht entweder wahr oder falsch, sondern sie sind mit einer gewissen (jeweils spezifizierten)

Sicherheit wahr.

Definition 3 (Statistik). Derjenige Teil der Stochastik, der Verfahren beschreibt

und untersucht, die geeignet sind, schnell und systematisch aus Beobachtungen

Modelle zu konstruieren, die gemäß den Regeln der Wahrscheinlichkeitstheorie

die Beobachtungen möglichst akurat voraussagen.

Beispiel 1. Die Disambiguierung von Attributen vs. Adverbialen ist ein häufig auftretendes Problem bei der Syntaxanalyse; betrachte etwa:

1.3. GRUNDBEGRIFFE UND NOTATIONEN

(1)

X malt eine Blume im Garten.

(2)

X malt eine Blume im Wasser.

(3)

X malt eine Blume in der Vase.

9

In (1) ist nicht klar, ob sich die Blume oder der Maler im Garten befinden; in (2)

herrscht eine ähnliche Unklarheit, obwohl man eine gewisse Tendenz hat, anzunehmen, der Maler befände sich nicht im Wasser, und in (3) ist man praktisch völlig sicher,

daß es nur die Blume ist, die in der Vase ist. Ein (einfach gebautes) SyntaxanalyseProgramm würde aber vermutlich dieselbe Ambiguität in allen drei Beispielen vorfinden, es würde also auch für (2) und (3) jeweils zwei Analysen angeben.

Ein typischer stochastischer Ansatz wäre es nun, die Kookkurrenz (d.h. Häufigkeit

des gemeinsamen Vorkommens) der Paare

malen, im-Garten

malen, im-Wasser

malen, in-der-Vase

Blume, im-Garten

Blume, im-Wasser

Blume, in-der-Vase

in einer großen Menge von Beispielsätzen (also einem Korpus, das man z.B. aus

dem Internet extrahiert) zu betrachten und festzustellen, daß etwa im Fall von (3) “Blume” mit “in-Vase” wesentlich stärker assoziiert ist als “malen” mit “in-Vase”.

Diese Grundidee läßt sich im Sinne der Stochastik formalisieren: Man möchte Voraussagen machen bzgl. der Zusammengehörigkeit von Wortpaaren; hierzu sucht man

ein Modell, daß zu jedem Paar aus Wörtern (oder NP-Konstruktionen) mit einer gewissen Sicherheit voraussagt, daß sie zusammen vorkommen, d.h. zusammen eine Konstituente bilden. Ist nun ein gewisses Textkorpus gegeben, sagt uns die Statistik, auf

welche Weise wir die Wörter und Paare am besten zählen und wie wir dann die Parameter des Modells, d.h. die mit den diversen Voraussagen assoziierten Sicherheiten

berechnen müssen; die Wahrscheinlichkeitstheorie hingegen erlaubt es uns, aus einem

solcherart bestimmten Modell Aussagen in einem gegeben Einzelfall, also etwa in Beispiel (3) oben zu machen.

Das obige Beispiel zeigt recht gut, welche Daten und Hilfsmittel der Linguist benötigt, um einen stochastischen Ansatz zu verfolgen. Insbesondere:

Beobachtungen aus denen Modelle konstruiert werden. Die Beobachtungen macht

der Linguistik normalerweise anhand von elektronisch verfügbaren Texten, also

Korpora, die oft aus reinem Text bestehen, manchmal aber auch

• Wortarten-Tags

• Syntaxanalysen

• Thematische Kategorien

• Phonetische Transskriptionen

10

KAPITEL 1. MOTIVATION UND GRUNDLAGEN

und anderes enthalten. Wir werden später sehen, daß die Verläßlichkeit statistischer Modelle u.a. abhängt von der Zahl der Beobachtungen, die für ihre Konstruktion verwendet wurden. Man ist daher bestrebt, möglichst große Korpora

anzulegen, und es ist klar, daß die Existenz und Größe des WWW solchen Bestrebungen entgegenkommt. Es ist aber auch klar, daß die schiere Anzahl der

Beobachtungen nicht der einzige qualitätsbestimmende Faktor eines statistischen

Modells ist; auch die Repräsentativität, Einheitlichkeit und Leichtigkeit der Verarbeitung spielen eine große Rolle. Es gibt daher eine Reihe von Initiativen, die

für die Erzeugung von Korpora Empfehlungen geben und Standards festlegen.

Zu diesen Initiativen gehören beispielsweise

• Die European Language Resources Association (ELRA) 1 und die Evaluations and Language Resources Distribution Agency (ELDA) 2

• Das Linguistic Data Consortium (LDC) 3

• Die Text Encoding Initiative (TEI) 4

• Die Special Interest Group Lexicon (SIGLEX) der ACL (Association of

Computational Linguistics) 5, 6

• Das Penn-Treebank-Projekt der University of Pennsylvania 7

und zahllose kleinere, z.T. sprachspezifische Initiativen und Projektgruppen.

Software und Tools Die wichtigsten Tools sind

• XML-Parser und XML-Verarbeitungsprogramme, da viele Korpora in XML

vorliegen.

• für die Verarbeitung des reinen Textes Programme zum Editieren, Durchsuchen, Ersetzen, Zerlegen, Sortieren und Zählen. Auf Unix-Systemen stehen solche Tools unmittelbar zur Verfügung, insbesondere emacs und vi,

egrep, sed und perl, sort und uniq, sowie wc. Auch die Konversion

von Dokumentformaten (wie PDF, PS, HTML usw.) sowie von Encodings

(ASCII, Unicode, u.ä.) ist oft notwendig, bevor eigentliche statistische Verfahren angewandt werden können.

• Parser und Finite-State-Tools

• Programme zum Visualisieren von Zusammenhängen oder Tabellen. Besonders gnuplot, dot, Mathematica, Maple, aber auch die DiagrammErstellungsfunktionen von OpenOffice, StarOffice und MS Excel sind hier

zu nennen.

• Programme, die statistische Daten-Zusammenfassungen berechnen; hierzu

gehören der Mittelwert, die Standardabweichung u.ä. (s. spätere Kapitel),

aber auch Visualisierungen von Datenverteilungen, Streuung usw.

1 http://www.elra.info/

2 http://www.elda.org/sommaire.php

3 http://www.ldc.upenn.edu

4 http://www.tei-c.org/

5 http://www.siglex.org

6 http://www.clres.com/corparchive.html

7 http://www.cis.upenn.edu/~treebank/home.html

1.3. GRUNDBEGRIFFE UND NOTATIONEN

11

• Web-Suchmaschinen (sowohl allgemeine als auch speziell von und für Linguisten entwickelte, z.B. The Linguist’s Search Engine 8 , WebCorp 9 .

• Spezielle Suchprogramme, z.B. Tgrep2 10 , WordSmith 11 .

Modelle und standardisierte Formalisierungen Es macht Sinn, die Modelle, in die

man Beobachtungen übertragen will, den von der Wahrscheinlichkeitstheorie

vorgegebenen Standards anzupassen – sowohl hinsichtlich ihrer Struktur, als

auch hinsichtlich der verwendeten Notation und Terminologie. Das macht offensichtlich die Einpassung in vorhandene oder gut erforschte Verfahren einfacher

und erleichtert die Vergleichbarkeit mit bereits existierenden Verfahren.

Diese Standardnotationen und Vorgehensweisen zu erläutern ist eines der Hauptziele der ersten Kapitel dieses Seminars.

1.3.2

Zählen und Messen

Von den in Abschnitt 1.3.1 aufgelisteten Werkzeugen, wie XML-Parsern, Unix-Tools,

Visualisierungsprogrammen, wollen wir auf einige ausgewählte einen genaueren Blick

werfen. Um wenigstens einfachste statistische Verfahren anwenden zu können, muß

der Computerlinguist in der Lage sein, ein als plain text vorliegendes Korpus in Sätze

und Wörter zu zerlegen und gewisse einfache Messungen durchzuführen.

Frequenzliste

Eine der am häufigsten verwendeten Darstellungen eines Korpus ist die Frequenzliste,

das heißt die Liste der im Text vorkommenden Token, jedes assoziiert mit seiner Häufigkeit (Frequenz). Oft werden Frequenzlisten sortiert, entweder nach der Frequenz

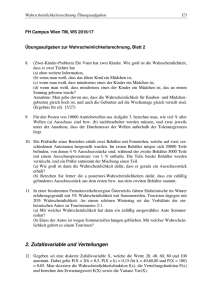

oder lexikographisch nach den Token. Abb. 1.1 zeigt den Anfang einer solchen Frequenzliste.

Um eine sortierte Frequenzliste zur erzeugen, sind i.a. drei Schritte erforderlich:

(1) Zerlegung des Korpus in Tokens

(2) Zählen der Tokens und Erzeugen der Frequenzliste

(3) Sortieren nach dem gewünschten Kriterium

Exemplarisch wollen wir hier ein einfaches Verfahren zur Erzeugung einer Frequenzliste mit Hilfe von Perl betrachten. Für den ersten Schritt kommt ein Substitute-Befehl

mit regulärem Ausdruck der Art

host> perl -pe ’s/[\s\.,\!\?]+/\n/;’ < korpus.txt

(auf der Unix-Kommandozeile) in Frage (wir nehmen an, die Korpusdatei heißt

korpus.txt). Das Zählen läßt sich beispielsweise mit den Unixtools sort und uniq

realisieren

| sort | uniq -c

8 http://lse.umiacs.umd.edu:8080/

9 http://www.webcorp.org.uk/

10 http://tedlab.mit.edu/~dr/Tgrep2/

11 http://www.lexically.net/wordsmith/

12

KAPITEL 1. MOTIVATION UND GRUNDLAGEN

74257911

72379329

61771938

39164812

27074901

24651126

23096105

22145573

22033884

19994901

19910132

18410125

17428627

17159728

16001966

14022494

der

und

die

in

von

den

zu

für

mit

des

ist

das

im

auf

Die

nicht

Abbildung 1.1: Anfang einer nach Häufigkeit sortierten Frequenzliste eines deutschsprachigen Korpus.

(zu verstehen als Fortsetzung der obigen Zeile). Eine anschließende Sortierung

nach Frequenz wird etwa durch

| sort -nr >frequenzliste.txt

ermöglicht. Natürlich können unzählige andere Methoden (etwa der Aufbau einer

Hashtabelle) oder andere Programmiersprachen verwendet werden.

Typische Überlegungen, die man vor dem Erstellen einer Frequenzliste anstellen

sollte, sind die folgenden:

• In welchem Encoding liegt die Datei vor (z.B. ASCII, UTF-8 usw)?

• Wie soll tokenisiert werden? Insbesondere welche Zeichen gelten (in welchen

Kontexte) als Wort- bzw. Satztrenner? Wie sollen Zahlen, Datumsangaben, Geldbeträge, Uhrzeiten, Temperaturangaben usw. behandelt werden?

• Wie soll mit Groß- und Kleinschreibung umgegangen werden? Sollen die großgeschriebenen Varianten separat gezählt werden oder nicht?

Letztlich geht es v.a. um die Frage, was eigentlich ein Token ist. Der traditionelle

Wortbegriff der abendländischen Linguistik erweist sich schnell als sehr schlecht definiert und für die meisten Zwecke ungeeignet. In eher agglutinierenden Sprachen (z.B.

Türkisch, Ungarisch, Koreanisch) wird innerhalb eines “Tokens”, also morphologisch,

Wesentliches von dem ausgedrückt, was in eher flektierenden Sprachen (z.B. Deutsch)

mit zusätzlichen Tokens, also syntaktisch, ausgedrückt wird; in vielen asiatischen Sprachen (z.B. Chinesisch, Japanisch, Koreanisch) werden überhaupt keine Leerzeichen zur

Markierung von Tokens verwendet. Tokenisierung, also auch die Erstellung einer guten Frequenzliste ist also ein nicht-triviales Problem, das im Grunde die Klärung vieler

anderer, sehr grundlegender linguistischer Fragen voraussetzt.

1.3. GRUNDBEGRIFFE UND NOTATIONEN

13

Ein für die semantische Analyse besser geeigneter Begriff als Token oder Wort ist

der der lexikalischen Einheit (der beispielsweise in Einführungskursen zur Semantik

und Syntax besprochen wird). Was die oben erstellte Frequenzliste darstellt, ist freilich

nur die Tokenfrequenz, also eine extrem grobe Annäherung an eine Frequenzliste lexikalischer Einheiten, wie man sie eigentlich gerne hätte. Trotzdem ist das die Art von

Frequenzliste, wie wir sie die meiste Zeit verwenden werden, und auch die einzige, die

man ohne größeren Aufwand jederzeit herstellen kann.

n-Gramme

Den Problemen, die bei der Erstellung und Benützung von Frequenzlisten für Einzeltokens auftreten (s. oben), also insbesondere denjenigen Problemen, die daher kommen,

daß wir eben nur Wörter (im Sinne von “durch Leerzeichen getrennte Einheiten”),

und nicht semantische Einheiten betrachten, versucht man z.T. dadurch zu begegnen,

daß man Paare, Tripel oder noch längere Ketten von Wörtern extrahiert, und dann die

statistischen Eigenschaften dieser Einheiten untersucht, also z.B. Frequenzlisten von

Wortpaaren betrachtet.

Längere Wortketten sind aber auch interessant, weil sie die Einzelwörter in Kontext

enthalten, so daß sich an ihnen beispielsweise untersuchen läßt, mit welchen Präpositionen oder Quantoren bestimmte Wörter häufig oder selten zusammen vorkommen.

Auch bei der statistischen Phrasen und Keyword-Extraktion spielen n-Gramme, also

Kettern von n aufeinanderfolgenden Wörtern eine große Rolle. Wir werden später darauf zurückkommen.

Definition 4 (n-Gramm, Unigramm, Bigramm, Trigramm, Tetragramm).

Sei T = t1 , . . . ,tn ein tokenisierter Text, die ti also seine Tokens in der OriginalReihenfolge. Jede Folge von n ∈ N aufeinanderfolgenden Tokens ti , . . . ,ti+n−1 ist

ein n-Gramm (aus T ). 1-Gramme heißen auch Unigramme, 2-Gramme Bigramme,

3-Gramme Trigramme und 4-Gramme Tetragramme.

Normalerweise interessiert man sich für die Menge aller n-Gramme eines Textes (für

jeweils gegebenes n, z.B. 2,3,4).

Beispiel 2. Die Menge aller Bigramme aus dem Text

(4)

In the beginning, God created the heavens and the earth.

ist {(In,the), (the,beginning), (beginning,God), (God,created), (created,the), (the,heavens),

(heavens,and), (and,the), (the,earth)}.

Anmerkungen

• Manchmal fügt man dem Text noch ein erstes und letztes “leeres” Token hinzu,

und erhält dann zwei weitere Bigramme, in o.g. Beispiel wären das: (∅,In) und

(earth,∅).

14

KAPITEL 1. MOTIVATION UND GRUNDLAGEN

• Die Frequenzlisten aus dem vorigen Abschnitt sind offensichtlich UnigrammFrequenzlisten. Auch Bigramm- und sonstige n-Gramm-Frequenzlisten werden

häufig betrachtet und als Grundlage statistischer Untersuchungen benützt.

• Was wir bisher als Token-Trenner betrachtet haben, wird mitunter auch selbst

als Token angesehen, z.B. Interpunktionszeichen wie Komma. Dementsprechend

würde man dann anstelle des Bigramms (beginning,God) zwei andere Bigramme

in die Liste aufnehmen: (beginning,<comma>) und (comma,God).

• Groß- und Kleinschreibung (und bei Nicht-Lateinischen Schriften auch andere

Phänomene wie vorhandene/fehlende Diakritika, Vokalisierungszeichen, Hiragana/Kanji-Variationen u.ä.) müssen je nach Anwendung verschieden behandelt werden. In unserem Beispiel haben wir die Groß- und Kleinschreibung der Bigramme einfach wie im Original belassen; oft machen Normalisierungen jedoch Sinn.

Visualisierung

Da die Statistik damit befaßt ist, Beobachtungen in Texten zu machen und aus diesen

stochastische Modelle abzuleiten, also insbesondere Wahrscheinlichkeitsverteilungen

zu erschließen, kommt sie nicht umhin, die Häufigkeit des Auftretens gewisser Phänomene zu zählen, etwa im Sinne einer Frequenzliste von Uni- oder anderen n-Grammen.

Um Häufigkeiten sehr vieler verschiedener Phänomene, z.B. die Häufigkeiten vieler

tausend unterschiedlicher Wörter, so darzustellen, daß auch ein Mensch gewisse Regularitäten schnell erkennen kann, ist es oft angebracht, sie zu visualisieren anstatt in

langen Tabellen widerzugeben. Solche Visualisierungen werden oft Diagramme genannt.

Eine einfache Art, zu einer gegebenen Reihe von Zahlen ein Linien-Diagramm zu

zeichnen, ist die Verwendung des Open-Source-Programmes gnuplot. gnuplot ist ein

Funktionsplotter (man kann es auch verwenden, um Kurven zu Funktionsgleichungen

zu zeichnen), der über enorm viele Optionen und eine umfangreiche Dokumentation

verfügt; wir wollen das Programm aber nur beispielhaft für den simplen Zweck der

Visualisierung einer kurzen Frequenzliste verwenden.

Die Darstellung soll die Frequenzen der Wörter als Kurve darstellen, als hätte man

die Tokens des Textes auf der X-Achse aufgereiht, und würde senkrecht über jedem

seine Frequenz auftragen. gnuplot kann Datenpaare der Art (x, y) aus einer Datei einlesen, und zwar ein Paar pro Zeile, zuerst den X-Wert, dann ein Leerzeichen, dann den

Y-Wert. Klammern und Kommata werden nicht benötigt.

Sowohl X- als auch Y-Werte müssen Zahlen sein, wir können die Wörter also nicht

so stehen lassen. Wir benutzen einen Perl-Aufruf auf der Kommandozeile, um die Frequenzliste entsprechend umzuformen:

host> perl -pe ’s/^(.*?)\s.*/$. $1/;’ < frequenz.txt > gnuplot.txt

Dann rufen wir gnuplot auf und erzeugen ein Liniendiagramm:

host> gnuplot

gnuplot> plot ’gnuplot.txt’ smooth unique

Das plot-Kommando bewirkt das Einlesen der Datenpaare, das Skalieren des Koordinatensystems, und das Zeichnen der Kurve. smoothunique führt dazu, daß die einzelnen Datenpunkte durch Linien verbunden werden, so daß eine “glatte” Kurve entsteht.

Ohne diese Option sieht man die als kleine Kreuze dargestellten diskreten Punkte. Ein

Beispiel findet sich in Abb. 1.2.

15

1.3. GRUNDBEGRIFFE UND NOTATIONEN

8e+07

’tt’

7e+07

6e+07

5e+07

4e+07

3e+07

2e+07

1e+07

0

0

10

20

30

40

50

60

70

80

90

100

Abbildung 1.2: Visualisierung einer Frequenzliste.

Zusammenfassen von Daten

In der Statistik ist man oft bestrebt, große Menge von Beobachtungsdaten (z.B. Frequenzlisten) in Form von wenigen Zahlen zusammenzufassen, die die wesentlichen

Eigenschaften der Daten widerspiegeln. Die einfachsten Möglichkeiten der Zusammenfassung sind Mittelwert, Standardabweichung und Median.

Definition 5 (Mittelwert und Standardabweichung). Ist f1 , . . . , fn eine endliche Folge von Zahlen, so ist

n

m :=

1X

fi der Mittelwert der fi

n

i=1

n

X

1

( fi − m)2 die Varianz der fi

n

i=1

√

s :=

v die Standardabweichung der fi

v :=

(1.1)

(1.2)

(1.3)

Statt Mittelwert sagt man auch arithmetisches Mittel (im Unterschied zum geometrischen Mittel, das wir hier nicht betrachten wollen). Statt Standardabweichung

sagt man auch Streuung.

P

(Die Bedeutung der -Schreibweise usw. wird in Abschnitt 1.3.3 erläutert, für den

Fall, daß der Leser Schwierigkeiten damit hat.)

Der Mittelwert drückt aus, welchen Wert eine zufällig gezogene Stichprobe aus

16

KAPITEL 1. MOTIVATION UND GRUNDLAGEN

Abbildung 1.3: Gaußsche Glockenkurve für verschiedene Mittelwerte und Varianzen.

Entnommen aus http://en.wikipedia.org/wiki/Normal_distribution.

einer Reihe von Daten wahrscheinlich ungefähr hat. Sind beispielsweise alle Daten

gleich, so hat der Mittelwert (wie man leicht nachrechnet) auch diesen selben Wert.

Die Varianz ist selbst auch ein Mittelwert, und zwar gibt sie die durschnittliche quadratische Abweichung vom Mittelwert wieder; die Streuung ist die Wurzel aus der Varianz

(um die Quadrierung der Abweichungen zu neutralisieren). Die Streuung gibt an, wie

verläßlich der Mittelwert ist, d.h. wie gut wir uns darauf verlassen können, daß eine

beliebig gezogene Stichprobe tatsächlich in der Nähe des Mittelwertes liegen wird. Je

kleiner die Streuung, desto verläßlicher der Mittelwert.

Beispiel 3. Das arithmetische Mittel über die Wortlänger deutscher Wörter, gemessen

an den 50 Tausend häufigsten deutschen Wörtern, ist 8.45; d.h. wenn wir ein beliebiges

Wort herausgreifen, erwarten wir, daß es wahrscheinlich ungefähr 8.45 Buchstaben

lang ist. Die Streuung beträgt 4.17.

Nimmt man die Normalverteilung der Einzelwerte an (zur genauen Klärung dieses

Begriffs später), so kann man aus Mittelwert und Varianz die tatsächliche Verteilung

der Werte rekonstruieren: Die meisten Werte liegen dann genau beim Mittelwert, etwas

weniger von ihnen liegen in kleinen Abständen unterhalb und oberhalb von ihm, noch

weniger haben noch größeren Abstand, usw. Zeichnet man eine Kurve nach denselben Prinzipien wie das Frequenzlisten-Diagramm in Abschnitt 1.3.2, so ergibt sich die

Gaußsche Glockenkurve (Abb. 1.3).

In diesem Fall hat man dann tatsächlich die gesamte Häufigkeitsverteilung der Einzelwerte in Form von zwei Zahlen dargestellt: Mittelwert und Varianz. Und dies ist

auch der Grund, warum man diese beiden Werte häufig berechnet; sie geben einen

groben Eindruck von der ungefähren Größenordnung und Verteilung der Werte in der

gesamten Stichprobe.

1.3. GRUNDBEGRIFFE UND NOTATIONEN

17

Ein weiterer Wert, der in ähnlicher Weise nützlich ist und oft berechnet wird, ist

der Median:

Definition 6 (Median). Sei f1 , . . . , fn eine Folge von Zahlen, n ≥ 1. Der Median

ist der Mittelwert derjenigen f j , für die gilt:

n−1

n−1

|{ fi : fi < f j }| =

oder |{ fi : fi > f j }| =

2

2

(Es gibt immer nur entweder ein solches f j (falls n ungerade ist), oder zwei (falls

n gerade ist).)

D.h. sortiert man die Datenmenge, so ist der Median derjenige Wert, der genau in der

Mitte liegt: Die eine Hälfte der Daten ist kleiner als er, die andere größer. Bei Normalverteilung (und jeder symmetrischen Verteilung) ist der Median mit dem Mittelwert

identisch.

Beispiel 4. Der Median der Zahlenfolge (2, 4, 7) ist 4. Der Median von (2, 4, 7, 9) ist

(4 + 7)/2 = 5.5.

Der Median ist also auch eine Art “Mittelwert”, und er hat gewisse Vorteile gegenüber

dem artithmetischen Mittel; insbesondere ist er “stabiler”, d.h. nicht so empfindlich

wenn “outliers”, d.h. seltene, aber sehr stark vom Durchschnitt abweichende Werte

in den Daten vorkommen. Etwa in der Datenreihe (1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 20) ist der

Median gleich 1, was recht gut den “typischen” Wert wiedergibt, während das arithmetische Mittel bei etwa 2.73 liegt.

1.3.3

Mathematische Grundbegriffe und Notationen

Auf Fragen zur Definition der grundlegendsten Begriffe “Menge”, “Zahl” u.ä. soll hier

nicht eingegangen werden (siehe aber etwa das Skript zum Proseminar Mathematik I).

Jedoch die wichtigsten Notationen sollen im folgenden wiederholt werden.

Explizit angegebene Mengen schreiben wir mit geschweiften Klammern (Mengenklammern): M = {a, b, c}. Die Schreibweise M = {x : ϕ(x)} bedeutet “M ist die Menge

aller Objekte mit der Eigenschaft ϕ”. Diese Objekte müssen keineswegs den Namen

“x” haben; “x” ist nur eine Variable, die innerhalb der Definition verwendet wird, gebunden durch den Allquantor, der dieser Definition implizit ist:

für alle Objekte, nennen wir sie x, gilt: falls ϕ(x) wahr ist, so ist x ∈ M.

Es steht

N = {1, 2, . . .} für die Menge der natürlichen Zahlen;

Z = {. . . , −2, −1, 0, 1, 2, . . .} für die Menge der ganzen Zahlen;

Q = {a/b : a, b ∈ Z} für die Menge der Brüche (rationalen Zahlen);

18

KAPITEL 1. MOTIVATION UND GRUNDLAGEN

R für die Menge der reellen Zahlen, also Q zusammen mit den Grenzwerten aller

konvergenten Folgen.

Wir schreiben P(M) für die Potenzmenge von M, d.h. diejenige Menge, deren

Elemente gerade die Teilmengen von M sind:

P(M) := {x : x ⊆ M}

Bezüglich der Mächtigkeit einer Menge M sagt man “M ist (höchstens) abzählbar”,

wenn man den Elementen von M natürliche Zahlen zuordnen kann, und zwar so, daß

jede natürliche Zahl nur einmal benutzt wird, aber jedes Element in M einer Zahl zugeordnet ist. N, Z und Q sind abzählbar, R ist es nicht. Gemäß dem Satz von Cantor gilt,

daß die Potenzmenge einer abzählbaren, aber unendlichen Menge nicht mehr abzählbar ist. P(N) ist also beispielsweise nicht mehr abzählbar. Solche Mengen heißen auch

überabzählbar. Für die Mächtigkeit einer Menge M schreiben wir |M|. Ist M endlich,

so ist |M| gerade die Anzahl seiner Elemente. Ist M abzählbar unendlich, so gilt also

|M| = |N|. Überabzählbare “Unendlichkeiten” lassen sich auch noch weiter unterscheiden, das wird aber für unsere Zwecke nicht notwendig sein.

Sind A1 , A2 , . . . Mengen, so schreiben wir A1 × A2 × . . . für ihr kartesisches Produkt,

d.h. für die Menge der Tupel, die sich aus ihren Elementen zusammensetzen lassen. Wir

schreiben A1 ∪ A2 ∪ . . . für ihre Vereinigung und A1 ∩ A2 ∩ . . . für ihren Durchschnitt.

Zwei Mengen A und B heißen disjunkt, falls sie keine gemeinsamen Elemente besitzen,

d.h. falls ihr Durchschnitt leer ist: A ∩ B = ∅. Betrachtet man mehr als zwei Mengen, so

spricht man von paarweise disjunkt, falls für je zwei von ihnen (also für alle denkbaren

Paare aus diesen Mengen) Disjunktheit gilt.

Hat man eine Menge M und eine Teilmenge A ⊆ M, so schreibt man AC für die

Komplementmenge von A (in M), d.h.

AC := M − A

(es findet sich auch die Schreibweise Ā in der Literatur). Beachte, daß diese Schreibweise nicht explizit ausdrückt, in welcher Menge das Komplement betrachtet wird, welche Menge also die Rolle von M spielt. Das muß dann jeweils aus dem Zusammenhang

klar gemacht werden.

Betrachtet man sehr viele beteiligte Mengen Ai , so empfiehlt sich für Vereinigung,

Schnitt usw. die kürzere Schreibweise:

[

Ai := A1 ∪ A2 ∪ . . .

i≥1

\

Ai

:= A1 ∩ A2 ∩ . . .

Ai

:= A1 × A2 × . . .

i≥1

Y

i≥1

In diesem Zusammenhang meint man mit “i ≥ 1” (unter dem großen Symbol): “der

Zähler i durchläuft alle natürlichen (!) Zahlen ab 1.” Gelegentlich soll der Zähler andere

Wertemengen durchlaufen; allgemein schreibt man oft

[

Ai

i∈I

19

1.3. GRUNDBEGRIFFE UND NOTATIONEN

um anzudeuten, daß eine gewisse “Indexmenge” I die möglichen Werte des Zählers

enthält. Man unterstellt implizit, daß eine lineare Ordnung auf diesen Werten existiert,

so daß auch die Reihenfolge des Durchlaufens festgelegt ist (sofern die Reihenfolge

nicht ohnehin gleichgültig ist, wie das in o.g. Beispielen ja der Fall ist).

Ähnlich benutzt man zur kürzeren Schreibweise von Summen und Produkten:

n

X

i=1

n

Y

ai

:= a1 + a2 + . . . + an

ai

:= a1 · a2 · . . . · an

i=1

wobei in diesem Beispiel die Indexmenge I := {1, . . . , n} ist. Auch für solchen Summen

und Produkte kommen u.U. unendliche Indexmengen in Betracht; im Falle der Summe

spricht man dann von einer unendlichen Reihe. Viele solche Reihen haben keinen Wert

innerhalb der reellen Zahlen, sondern werden sozusagen immer größer, z.B.

∞

X

i

i=0

Andere hingegen konvergieren gegen einen gewissen Grenzwert, d.h. ihr Abstand zu

diesem Wert wird immer geringer, z.B.

∞

X

ri

i=0

was gegen 1/(1 − r) konvergiert, falls r < 1 (!) (was wir hier nicht beweisen wollen).

Man schreibt dann

!

n

∞

n

X

X

X

1

1

i

i n→∞ 1

oder lim

r =

oder

ri =

r −→

n→∞

1−r

1−r

1−r

i=0

i=0

i=0

Solche unendlichen Summen verhalten sich nicht in allen Fällen wie gewöhnliche Summen. Beispielsweise gilt nicht unbedingt Kommutativität, d.h. wenn man die Reihenfolge der Summanden an unendlichen vielen Stellen ändert, kann sich auch der Wert

(d.h. der Grenzwert) ändern. Bei jeder in einer Rechnung auftretenden unendlichen

Reihe muß man sich daher überlegen, ob sie konvergiert und wenn ja gegen welchen

Grenzwert – und dann darf man sie durch ihren Grenzwert ersetzen. Wir werden unendlichen Reihen nur gelegentlich begegnen.

Induktionsbeweis Ein Beweisverfahren, das in Zusammenhang mit stochastischen

Aussagen häufig vorkommt, und insbesondere auch in der computerlinguistischen Literatur oft verwendet wird, ist der Induktionsbeweis oder Beweis durch (vollständige)

Induktion (über die natürlichen Zahlen). (Er ist eng verwandt mit dem Beweis durch

Induktion über den Aufbau, der z.B. in der Prädikatenlogik eine Rolle spielt, wenn

Aussagen bewiesen werden sollen, die für alle Formeln gelten; das wollen wir hier

aber nicht betrachten.)

Dieses Beweisverfahren ist immer dann sinnvoll, wenn es darum geht zu zeigen,

daß alle natürlichen Zahlen größer gleich einem gewissen n0 eine gewisse Eigenschaft

ϕ besitzen, daß also gilt

ϕ(n) für alle n ∈ N mit n ≥ n0

20

KAPITEL 1. MOTIVATION UND GRUNDLAGEN

Man führt den Beweis durch, indem man zunächst ϕ(n0 ) beweist, und dann die

Aussage:

Falls ϕ(n), dann ϕ(n + 1) für alle n ∈ N

Dann ist man fertig, denn dann hat man ϕ(n0 ) bewiesen, und mit dem zweiten Teil

folgen ϕ(n0 + 1), ϕ(n0 + 2) usw.

Beispiel 5. Wir wollen beweisen, daß

n

X

i=1

i=

n(n + 1)

für alle n ∈ N, n ≥ 1

2

Wir beweisen also zunächst durch Rechnung, daß es für n = 1 gilt:

1

X

i=1=

i=1

1·2

2

Jetzt müssen wir die kompliziertere Aussage beweisen, daß

Falls

n

X

i=1

i=

n+1

X

n(n + 1)

(n + 1)(n + 2)

, dann

i=

für alle n ∈ N

2

2

i=1

Das entspricht gerade dem

Falls ϕ(n), dann ϕ(n + 1) für alle n ∈ N

Wir machen also die Annahme ϕ(n) und versuchen mit Hilfe dieser Annahme ϕ(n + 1)

zu beweisen. n bleibt dabei als Variable stehen. Die genannte Annahme nennt man

Induktionsvoraussetzung, den zu führenden Beweis Induktionsschritt.

Hierzu rechnen wir:

!

n+1

n

X

X

n(n + 1) 2(n + 1)

(∗) n(n + 1)

i=

i + (n + 1) =

+ (n + 1) =

+

=

2

2

2

i=1

i=1

=

n(n + 1) + 2(n + 1) (n + 2)(n + 1)

=

2

2

Bei (∗) haben wir die Induktionsvoraussetzung benutzt, über die dort vorliegende Gleichung sagt man auch “sie gilt nach Induktion”.

Analog kann man sich den Beweis als ein rekursives Programm vorstellen, daß

versucht eine Funktion ϕ(n + 1) auszuführen und hierzu rekursiv die Funktion ϕ(n)

aufruft, und wieder rekursiv ϕ(n − 1) usw., bis ϕ(1), was explizit (im ersten Schritt des

Beweises) angegeben worden war.

1.3.4

Wahrscheinlichkeitsräume

Wahrscheinlichkeitsräume sind die formalen Repräsentationen von stochastischen Modellen, d.h. es sind mathematische Objekte, die Information darüber enthalten, mit welcher Sicherheit (Wahrscheinlichkeit) man glaubt, daß gewisse Ereignisse eintreten oder

gewisse Sachverhalte gegeben sind. Ein Wahrscheinlichkeitsraum hat drei Teile:

1.3. GRUNDBEGRIFFE UND NOTATIONEN

21

Ergebnismenge Ω: Die Menge von Sachverhalten, die sich unmittelbar beobachten

lassen.

Ereignismenge F: Die Menge von verallgemeinerten Ergebnissen, deren Wahrscheinlichkeit man später berechnen können möchte.

Wahrscheinlichkeitsmaß P: Eine Funktion, die jedem verallgemeinerten Ergebnis

(also jedem Element der Ereignismenge) eine Zahl zwischen 0 und 1 zuordnet,

die man als Wahrscheinlichkeit des Eintretens dieses Ereignisses betrachtet.

Beispiel 6. Geht es etwa um das Werfen eines gewöhnlichen, sechsseitigen Würfels,

so wäre {1, 2, 3, 4, 5, 6} eine vernünftige Darstellung der Ergebnismenge. Dagegen die

Ereignismenge sollte auch solche verallgemeinerten Ereignisse wie “es fällt eine gerade Zahl” oder “es fällt eine Zahl kleiner als 3” enthalten. Das Wahrscheinlichkeitsmaß sollte sinnvollerweise allen sechs direkt beobachtbaren Ereignissen die gleiche

Wahrscheinlichkeit (1/6) zuordnen, dagegen den verallgemeinerten Ereignissen entsprechend umso höhere Wahrscheinlichkeit, je allgemeiner sie sind. Etwa das Ereignis

“eine gerade Zahl fällt” sollte, der Intuition entsprechend, die Wahrscheinlichkeit 1/2

haben.

Die verallgemeinerten Ereignisse werden stets als Mengen von Ergebnissen beschrieben; etwa das Ereignis “es fällt eine gerade Zahl” entspricht ja in der Tat der

Menge der Ergebnisse {2, 4, 6}. Ereignisse sind daher immer Teilmengen von Ω – es

müssen aber nicht notwendig immer alle möglichen Teilmengen auch als relevante Ereignisse betrachtet werden. Daher wird die Ereignismenge bei der expliziten Angabe

des Wahrscheinlichkeitsraums eigens erwähnt, sie besteht immer aus Teilmengen von

Ω: F ⊆ P(Ω).

Definition 7 (Wahrscheinlichkeitsraum). Sei Ω eine Menge, F ⊆ P(Ω) und

P : F → [0, 1] eine Funktion von F in das reelle Intervall [0, 1]. (Ω, F, P) ist ein

Wahrscheinlichkeitsraum, falls gilt:

(a) Ω ∈ F

(b) für alle A ∈ F gilt AC := Ω − A ∈ F

(c) für je abzählbar viele A1 , A2 , . . . ∈ F gilt:

[

Ai ∈ F

i≥1

(d) (Normierung) P(Ω) = 1

(e) (σ-Additivität) Für je abzählbar viele, paarweise disjunkte A1 , A2 , . . . ∈ F gilt

!

[

X

P

Ai =

P(Ai )

i≥1

i≥1

(Ω, F) ist dann ein Ereignisraum und F eine Ereignis-σ-Algebra (und hierfür sind

die Bedingungen (d) und (e) natürlich nicht erforderlich).

22

KAPITEL 1. MOTIVATION UND GRUNDLAGEN

Wir brauchen uns nicht mit allen Konsequenzen dieser Definition im einzelnen

beschäftigen. Jedoch sollte man in der Lage sein, gegebene Situationen in diese Formalisierung zu übertragen; eine solche Übertragung ist die Voraussetzung für die Anwendbarkeit stochastischer Methoden auf die Situation.

Beispiel 7. In gewissen Zusammenhängen betrachtet man das Zustandekommen eines

(natürlich-sprachlichen) Dokumentes als einen zufälligen Vorgang, d.h. als ein Geschehen, das keinen näher bekannten Gesetzmäßigkeiten unterliegt. Das ist natürlich

eine drastische Vereinfachung, da man sehr wohl eine Menge darüber weiß, nach welchen Regeln ein Text aufgebaut wird. Derartige Vereinfachungen können aber trotzdem

nützlich sein, entweder weil man an bestimmten Einzelheiten gar nicht interessiert ist,

oder weil ein vereinfachtes Modell eine schnellere oder speicherplatz-sparsamere Implementierung erlaubt.

Eine der einfachsten stochastischen Modellierungen von Dokumenten ist daher die

folgende. Sei Ω die Menge aller Wörter einer Sprache (wir unterstellen, daß diese

Menge in eindeutiger Weise darstellbar ist. Das ist zwar bereits nicht ganz akurat, da

neue Wörter gebildet, Fremdwörter und Eigennamen importiert werden können usw.,

aber diese Ungenauigkeit nehmen wir vorläufig in Kauf).

Ein direkt beobachtbares Ergebnis ist daher: “ein gewisses Wort ω ∈ Ω tritt in einem Dokument auf”. Sind alle Wörter gleich wahrscheinlich (was eine extrem schlechte Annäherung ist), so ist die Wahrscheinlichkeit für das Auftreten eines Wortes

P({ω}) = 1/|Ω|

Beachte, daß wir nicht P(ω) schreiben können, denn P ist nur definiert auf der Ereignisσ-Algebra F, die Teilmengen von Ω enthält. Wir müssen das Einzelereignis daher als

eine (ein-elementige) Teilmenge darstellen.

Wir können aber auch verallgemeinerte Ereignisse betrachten; liegt beispielsweise

eine Klassifikation der Wörter in Verben, Adjektive, Nomen usw. vor, so könnte man die

Wahrscheinlichkeit

X

P(“ein Nomen kommt vor”) = P({ω ∈ Ω : ω ist Nomen}) =

P({ω})

ω∈{ω∈Ω:ω ist Nomen}

betrachten. Die letzte Gleichung gilt nach Def. 7e und weil die Einzelereignisse

{ω}, über die hier summiert wird, natürlich paarweise disjunkt sind.

Tatsächlich können wir für jede Teilmenge von Ω auf diese Weise eine Wahrscheinlichkeit berechnen, so daß wir bedenkenlos F := P(Ω) setzen können und dann definieren: Sei A ∈ F.

X

|A|

.

P(A) :=

P({ω}) =

|Ω|

ω∈A

Damit sind alle drei Teile des Wahrscheinlichkeitsraums, Ω, F und P, definiert.

Das ist allerdings nur deswegen so leicht gefallen, weil Ω endlich ist und wir als Wahrscheinlichkeitsmaß die Gleichverteilung angenommen haben. Im allgemeinen ist die

präzise Angabe des Wahrscheinlichkeitsraumes komplizierter.

Im übrigen müssen wir noch zeigen, daß die fünf Bedingungen von Def. 7 erfüllt

sind: (a) Gilt wegen F = P(Ω). (b) gilt aus demselben Grund. (c) ebenfalls. (d) ist der

23

1.3. GRUNDBEGRIFFE UND NOTATIONEN

Fall, denn P(Ω) = |Ω|/|Ω| = 1, und für (e) seien A1 , . . . paarweise disjunkte Teilmengen von Ω, dann gilt wegen der paarweisen Disjunktheit

[ X

|Ai |

Ai =

i≥1

i≥1

woraus die geforderte Bedingung folgt.

Welches F muß man nehmen? In obigem Beispiel konnten wir F = P(Ω) wählen,

und das scheint ja auch das beste zu sein, denn dann ist man später sicher, daß man

für jedes nur denkbare Ereignis, also für jede nur denkbare Teilmenge von Ω, eine

Wahrscheinlichkeit angeben kann. Andererseits verpflichtet einen diese Definition auch

dazu, P so zu definieren, daß es tatsächlich für jede Teilmenge bestimmt ist und die

Bedingung von Def. 7 erfüllt. Ist Ω überabzählbar, so ist das i.a. nicht mehr machbar

(s. [Georgii, 2004], Satz 1.5). Vorläufig werden wir allerdings nur mit endlichen oder

höchstens abzählbaren Ergebnismengen zu tun haben, und hier muß man automatisch

F = P(Ω) wählen, falls man zumindest alle Einzelereignisse {ω} in F haben möchte

(und das will man immer). Denn sei A ⊆ Ω eine beliebige Teilmenge, dann läßt sich A

darstellen als die disjunkte Vereinigung

[

A=

{a}

a∈A

weswegen A ∈ F gelten muß, andernfalls wären die Bedingungen von Def. 7 verletzt. Da also jede beliebige Teilmenge in F liegen muß, ist F = P(Ω).

Die Frage welches P muß man nehmen ist i.a. schwieriger zu beantworten, und in

der Tat in vielfacher Hinsicht die Hauptbeschäftigung der Statistik: Wie muß man das

Wahrscheinlichkeitsmaß P definieren, damit es eine gegebene Menge von Beobachtungen möglichst gut widergibt, d.h. möglichst gut in der Lage ist, sie vorauszusagen?

Jedoch gibt es eine Reihe von Standardmodellen, die in Abschnitt 1.4 besprochen

werden.

Abschließend noch die Definition eines Begriffes, der für die Darstellung komplizierter Wahrscheinlichkeitsmaße nützlich ist, die der sog. Zähldichte.

Definition 8 (Zähldichte). Sei (Ω, F, P) ein Wahrscheinlichkeitsraum, Ω höchstens abzählbar und

ρ : Ω → [0, 1]

eine Funktion. ρ ist eine Zähldichte (zu P), falls gilt:

ρ(ω) = P({ω}) für alle ω ∈ Ω.

Eine Zähldichte ist also gewissermaßen die Reduktion des Wahrscheinlichkeitsmaßes

auf die Einzelereignisse. Kennt man ρ und (Ω, F), so ist P eindeutig bestimmt, denn

sei A ∈ F, dann ist

X

X

P(A) =

P({ω}) =

ρ(ω)

(1.4)

ω∈A

ω∈A

24

KAPITEL 1. MOTIVATION UND GRUNDLAGEN

wegen Def. 7e.

1.4

1.4.1

Standardmodelle

Gleichverteilung

Sind alle Einzelereignisse, d.h. alle ein-elementigen Teilmengen von Ω, gleich wahrscheinlich, so spricht man von Gleichverteilung. In Bsp. 7 hatten wir die Gleichverteilung von Wörtern angenommen; jedoch ist eine solche Annahme nicht besonders

realistisch. Und in der Tat spielt die Gleichverteilung für die Computerlinguistik praktisch keine Rolle. Allerdings zum Einüben von Schreibweisen und um die einfachsten

Zusammenhänge von Ω, F und P, sowie einfache Rechnungen durchzuführen, ist sie

als Beispiel gut geeignet. Genauer definiert man:

Definition 9 (Gleichverteilung). Sei (Ω, F, P) ein Wahrscheinlichkeitsraum, Ω

höchstens abzählbar. P ist die Gleichverteilung auf Ω, in Zeichen P = UΩ , falls

für alle A ∈ F gilt

P(A) = |A|/|Ω|

Natürlich ist ρ(ω) := 1/|Ω| die Zähldichte der Gleichverteilung.

1.4.2

Urnenmodell: Ziehen mit Zurücklegen

Ein in der Stochastik klassisches Modell für diskrete Ungleichverteilung ist die Urne,

also ein Behälter, in dem sich Objekte verschiedener Art befinden, z.B. Kugeln verschiedener Farben, aber nicht von allen Farben gleich viele.

Zunächst einmal betrachten wir einen Ereignisraum mit Ω als der Menge der Kugeln und wie immer F = P{Ω}. Zieht man einmal aus der Urne, so ist die Wahrscheinlichkeit, eine bestimmte Kugel ω zu ziehen gleich groß für alle Kugeln, es gilt

also P = UΩ .

Hat man Farben F = { f1 , . . . , fm } und von jeder Farbe

P fi seien N fi Kugeln in der

Urne, dann befinden sich darin insgesamt offenbar N = f ∈F N f Kugeln. Klar ist dann

die Wahrscheinlichkeit, eine Kugel der Farbe f zu ziehen, gleich

P({ω ∈ Ω : ω hat Farbe f }) =

Nf

n

Man interessiert sich nun für das n-malige Ziehen von je einer Kugel, und man nimmt

an, daß die gezogene Kugel sofort wieder zurückgelegt wird, bevor man die nächste

zieht (“Ziehen mit Zurücklegen”), so daß sich also an den Verhältnissen in der Urne

nichts ändert.

Um das n-malige Ziehen mit Zurücklegen zu beschreiben, benötigt man natürlich

ein neues Modell, (Ω0 , F0 , P0 ). Und zwar ist

Ω0 = Ωn , F0 = P(Ω0 )

(Dabei steht Ωn für das n-fache kartesische Produkt von Ω mit sich selbst.) Es ist also

jedes beobachtbare Ergebnis ω0 ∈ Ω0 eine Folge von n Kugeln. Wiederum ist P0 = UΩ0 ,

25

1.4. STANDARDMODELLE

denn die Wahrscheinlichkeit, eine bestimmte Folge von Kugeln zu ziehen, ist für alle

Folgen gleich. D.h.

1

P0 ({ω0 = (ω01 , . . . , ω0n )}) =

|Ω|n

Man interessiert sich nun dafür, mit welcher Wahrscheinlichkeit eine bestimmte Abfolge von Farben auftritt, z.B. ( f3 , f1 , f1 ). Betrachte hierzu Ff als die Menge der Kugeln

ω mit Farbe f ∈ F. Angenommen, (h1 , . . . , hn ) ist die Abfolge von Farben (d.h. alle

hi ∈ F). Gesucht ist also

|A|

P({ω0 = (ω01 , . . . , ω0n ) : ω0j ∈ Fh j }) =

n

|Ω|

{z

}

|

=:A

Aber wie groß ist |A|? Mit anderen Worten, wie viele Möglichkeiten gibt es, eine Folge

aus n Kugeln so zu konstruieren, daß die erste aus Fh1 ist, die zweite aus Fh2 , usw.?

Ausflug in die endliche Kombinatorik I

Derartige Fragen bewegen die Kombinatorik. Und die antwortet hier mit einer einfachen Überlegung: Angenommen, wir wollen eine Folge der Länger n wie oben beschrieben konstruieren, beginnend beim ersten Glied. Da haben wir zunächst |Fh1 | =

Nh1 viele Möglichkeiten, die erste Kugel zu wählen. Bei der zweiten Kugel gibt es Nh2

viele Möglichkeiten. Das macht insgesamt bereits Nh1 · Nh2 viele, da ich ja jede erste

mit jeder zweiten kombinieren kann. Und so “multipliziert sich” das weiter, bis man

insgesamt

n

Y

Nh1 · Nh2 · . . . · Nhn =

Nhi

i=1

Möglichkeiten erhält. Somit ist die Wahrscheinlichkeit, eine solche Farbfolge zu ziehen

Qn

Nh

P(A) = i=1 n i

|O|

Beispiel 8. Angenommen, wir haben 10 Kugeln, davon 3 grün, 2 blau und 5 gelb. Wie

wahrscheinlich ist es, beim Ziehen mit Zurücklegen die Abfolge “grün-gelb-grün” zu

erzielen?

Nach obiger Rechnung gilt:

P({ω0 ∈ Ω0 : ω01 , ω03 ∈ Fgrün , ω2 ∈ Fgelb }) =

3·5·3

= 0.045

103

also 4.5%.

Man interessiert sich nun weiterhin dafür, mit welcher Wahrscheinlichkeit eine Kugel

der Farbe f ∈ F k-mal gezogen wird, bei insgesamt n nacheinander gezogenen (und

zurückgelegten) Kugeln (für ein vorgegebenes k ≤ n). Das ist natürlich

P0 ({ω0 ∈ Ω0 : die Folge ω0 enthält genau k Kugeln der Farbe f }) =

=

|{ω0 ∈ Ω0 : die Folge ω0 enthält genau k Kugeln der Farbe f }|

|Ω|n

26

KAPITEL 1. MOTIVATION UND GRUNDLAGEN

Aber wie groß ist die Menge auf dem Zähler dieses Bruches? D.h. wie viele Möglichkeiten gibt es, eine Folge aus n Elementen so zu konstruieren, daß an k vielen Stellen

ein Element eines bestimmten Typs, also einer bestimmten Farbe, vorkommt? Hierzu

noch ein

Ausflug in die endliche Kombinatorik II

Wiederum hilft eine einfache Überlegung: Angenommen, wir haben bereits eine solche

Folge, sagen wir diejenige, die mit k Kugeln der Farbe f beginnt, und dann noch n − k

Kugeln anderer Farben hat. Wenn wir nun alle denkbaren Vertauschungen von Kugeln

vornehmen, bekommen wir nach jeder Vertauschung wieder eine andere Folge, die aber

auch wieder k Kugeln der Farbe f , und n − k Kugeln anderer Farben enthält, denn wir

haben ja nur die Reihenfolge vertauscht, nichts hinzugefügt oder entfernt. In der Tat

können wir durch bilden aller “Anagramme” der Folge alle die Varianten erzeugen, die

uns interessieren. Aber wie viele Anagramme gibt es? Stellen wir uns vor, wir hätten

alle n Kugeln der Folge auf einen Haufen geworfen. Jetzt wollen wir ein “beliebiges”

Anagramm konstruieren. Für die erste Kugel ziehen wir einmal aus dem Haufen, da

gibt es n viele Möglichkeiten. Um die zweite Kugel zu wählen, gibt es nur noch n − 1

viele, dann n − 2, usw. Wir erhalten also

n · (n − 1) · (n − 2) · . . . · 1 = n!

viele Möglichkeiten, ein Anagramm aus den n Kugeln der Folge zu bilden. Leider sind

da jetzt viele Duplikate dabei, also viele Anagramme, die gleich aussehen. Das passiert immer dann, wenn die eine Folge sich von der anderen nur dadurch unterscheidet,

daß zwei Kugeln derselben Farbe f , oder zwei Kugeln, die beide nicht die Farbe f

haben, vertauscht wurden. Nun, wie viele Möglichkeiten gibt es, Kugeln der Farbe f

miteinander zu vertauschen? Nach derselben Überlegung gibt es k! viele Möglichkeiten, denn wir haben ja insgesamt k Kugeln der Farbe f in unserer Folge. Ebenso gibt es

(n − k)! viele Möglichkeiten, Kugeln anderer Farben miteinander zu vertauschen. D.h.

wir haben letztlich

n

n!

=:

k!(n − k)!

k

viele Anagramme, ohne Duplikate, d.h. ohne daß zwei Anagramme sich nur durch

Vertauschen f -farbiger oder nicht- f -farbiger Kugeln untereinander unterscheiden.

Diese Zahl nennt man den Binomialkoeffizienten, und man sagt “n aus k” oder “k

über n”.

Zurück zur Wahrscheinlichkeitsberechnung. Wir wissen nun, wie viele Farbfolgen

es gibt, die an genau k Stellen die Farbe f haben. Jede dieser Folgen hat die gleiche

Wahrscheinlichkeit

Nf N − Nf

·

|Ω|k |Ω|n−k

nach der vorigen Überlegung. Also ist die Gesamtwahrscheinlichkeit

P0 ({ω0 ∈ Ω0 : die Folge ω0 enthält genau k Kugeln der Farbe f }) =

n Nf N − Nf

n Nf k

=

·

=

p (1 − p)n−k

k |Ω|k |Ω|n−k

k |Ω|k

mit p := N f /|Ω|n die Wahrscheinlichkeit für eine Kugel der Farbe f . Es ist nicht wichtig, sich diese Formel zu merken; aber das Prinzip, nach dem wir die “Anagramme”

1.5. FREQUENZLISTEN ALS WAHRSCHEINLICHKEITSRÄUME

27

einer Folge gebildet haben, und die Einsicht, daß es dafür n!/(k!(n − k)!) Möglichkeiten gibt, sollte man sich ein paar mal durch den Kopf gehen lassen. Siehe auch die

dazugehörige Übungsaufgabe (alle Anagramme einer Buchstabenfolge).

Ohne formale Definition noch zwei Begriffe: Das zuerst betrachtete Wahrscheinlichkeitsmaß (für eine bestimmte Farbfolge) nennt man Produktmaß, weil es ja durch

Multiplikation der farbspezifischen Wahrscheinlichkeiten entsteht. Letztere kann man

als Zähldichte auf einem Ω auffassen, das gerade die Menge der möglichen Farben ist

(für diese Sichtweise s. [Georgii, 2004], Abschnitt 2.2.1).

Das anschließend betrachtete Wahrscheinlichkeitsmaß ist die Binomialverteilung,

die in der Stochastik enorme Bedeutung hat. Summen von Werten der Binomialverteilungen

b X

n k

p (1 − p)n−k

k

k=a

die sehr umständlich auszurechnen sind (siehe Übungsaufgabe) kann man durch die

Normalverteilung annähern, worauf wir in einem späteren Kapitel nocheinmal kurz

zurückkommen werden.

1.4.3

Urnenmodell: Ziehen ohne Zurücklegen

Legt man die gezogenen Kugeln nicht mehr in die Urne zurück, so ändert sich das

Wahrscheinlichkeitsmaß nach jedem Zug. Das kann man am besten durch die sog. bedingte Wahrscheinlichkeit ausdrücken, auf die wir später sehr genau eingehen werden,

und die eine weit über die Urnenmodelle hinausgehende Bedeutung, auch für computerlinguistische Anwendungen, hat.

Für einfache Fälle kommt man allerdings mit einer “Variante” der oben dargstellten

Binomialverteilung aus, der sog. hypergeometrischen Verteilung. Das ist hier nur der

Vollständigkeit halber gesagt, für die Computerlinguistik ist es eher nebensächlich. Für

Interessierte finden sich Erklärung und Definition in [Georgii, 2004], Abschnitt 2.2.2.

1.5

Frequenzlisten als Wahrscheinlichkeitsräume

In Abschnitt 1.3.2 haben wir Frequenzlisten und ihre Erzeugung betrachtet, und wir

werden noch sehr häufig darauf zurückkommen. Inwiefern sind auch sie Wahrscheinlichkeitsmaße (auf einem geeignet definierten Wahrscheinlichkeitsraum)?

Beschränken wir uns für diese Betrachtung auf den Fall einer Unigramm-Frequenzliste,

erstellt aus einem Korpus T . Dann können wir setzen

Ω := {w : w ist Unigramm, das in T vorkommt}

d.h. als mögliche Einzelereignisse betrachten wir die einzelnen Unigramme. Da Ω endlich ist, können wir bedenkenlos F := P(Ω) setzen, damit sind die ersten drei Bedingungen aus Def. 7 erfüllt. Um nun P zu definieren, wird es das einfachste sein, die

Zähldichte P({w}) für jedes w ∈ Ω festzulegen. Schreiben wir f (w) für die Frequenz

des Unigramms w, so erscheint folgende Definition sinnvoll:

f (w)

v∈Ω f (v)

P({w}) := P

denn damit sind die beiden verbleibenden Bedingungen erfüllt:

28

KAPITEL 1. MOTIVATION UND GRUNDLAGEN

• Es ist

X

X

P({w}) =

w∈Ω

X

f (w)

1

=P

f (w) = 1.

v∈Ω f (v)

v∈Ω f (v)

P

w∈Ω

w∈Ω

wegen Distributivität.

• Und seien A1 , A2 , . . . höchstens abzählbar viele Ereignisse aus F und paarweise

disjunkt, dann gilt für das aus obiger Zähldichte definierte Wahrscheinlichkeitsmaß (siehe auch Gleichung 1.4 auf Seite 23):

!

[

X

X

Ai =

P(Ai )

P

P({w}) =

i≥1

S

w∈ i≥1 Ai

i≥1

Diese Definition des Wahrscheinlichkeitsmaßes hat aber das Problem, daß sie nur den

Wörtern, die in T vorkamen, nachträglich eine Wahrscheinlichkeit zuweist. Will man

diese geschätzte Wahrscheinlichkeit auf andere Korpora anwenden (z.B. weil man für

einen unbekannten Text T 0 schätzen will, wie spezifisch ein bestimmtes Wort w für ihn

ist, indem man die Häufigkeit von w in T 0 vergleicht mit der Wahrscheinlichkeit des

Auftretens von w0 , die aus dem ursprünglichen Korpus T vorausgesagt wurde), dann

kann man das nur für Wörter tun, die im ursprünglichen Korpus vorkamen; alle anderen

haben Wahrscheinlichkeit Null, denn wenn ein w nicht in T vorkommt, ist f (w) = 0.

Man verwendet daher oft ein korrigiertes Wahrscheinlichkeitsmaß, bei dem man

eine (mehr oder weniger subjektive) Schätzung der Zahl der zufällig nicht in T vorkommenden Wörter vornimmt und diesen Wörtern eine minimale Wahrscheinlichkeit

zuordnet. Als Inspiration für diese Maßnahme mag der Verlauf der Frequenzkurve (z.B.

Abb. 1.1, S. 12) dienen: Offenbar gibt es nur relativ wenige häufige Wörter, aber extrem viele Wörter, die nur einmal vorkommen (“Hapax legomena” 12 ). Man kann sich

also leicht überlegen, daß etwa bei einer “Verlängerung” des Korpus (z.B. in dem man

T 0 an T anhängt), v.a. Wörter hinzukommen werden, die in T gar nicht und in T 0

einmal vorkommen. Empirisch kann man abschätzen, wie viele das ungefähr sind (in

Abhängigkeit vom Größenunterschied zwischen T und T 0 ). Diese “vermutete Anzahl

unbekannter Wörter” kommt in folgender Definition als Variable K vor:

Satz 1 (Frequenzliste als Wahrscheinlichkeitsmaß). Sei T ein Textkorpus, Ω die Menge der in T vorkommenden

P Unigramme und f : Ω → N die Frequenzliste dieser Wörter

und K ∈ N. Sei N := w∈Ω f (w) Es ist mit

P({w}) :=

f (w) + K

N + K · |Ω|

(Ω, F, P) ein Wahrscheinlichkeitsraum.

Beweis. Die Bedingungen aus Def. 7 sind alle erfüllt (s. obige Rechnungen, der zusätzliche Summand K stellt kein Problem dar, wie der Leser durch Nachrechnen leicht

verifiziert).

Die annäherungsweise Berücksichtigung von unbekannten Wörtern wird auch als

Smoothing bezeichnet. Wir werden noch öfter darauf zurückkommen. Eine recht ausführliche Diskussion verschiedener Smoothing-Methoden finden sich in [Manning & Schütze, 2004]

(Abschnitt 6.2), dort allerdings bereits bezogen auf die komplizierteren n-GrammModelle; diesen Fall diskutieren wir in eine späteren Abschnitt genauer.

12 Singular

“Hapax legomenon”

29

1.6. DIE ZIPFVERTEILUNG

1.6

Die Zipfverteilung

Die charakteristische Verteilung von Wörtern einer Sprache, die wir etwa in der Frequenzliste von Abb. 1.1 (S. 12) beobachten konnten, entspricht einem Muster, das an

vielen Stellen der Natur auftritt und explizit erstmals von George Kingsley Zipf 1949

beschrieben wurde; man faßt solche Verteilungen daher unter der Bezeichnung Zipfsches Gesetz zusammen. Das Zipfsche Gesetz besagt, daß in vielen Zusammenhängen,

in denen gewisse Phänomene ungleich verteilt sind, einige wenige Ausprägungen existieren, die extrem häufig sind, aber sehr viele, die extrem selten sind. Etwa im Falle

der natürlichsprachlichen Frequenzliste haben wir ja in der Tat gesehen, daß es sehr

wenige Wörter gibt, die extrem häufig vorkommen (v.a. geschlossene Wortklassen wie

Konjunktionen, Präpositionen und Pronomen), aber eine riesige Menge von extrem

seltenen Wörtern. Ähnlich ist es beispielsweise mit Webseiten (einige wenige werden

extrem häufig besucht bzw. ein Link auf sie gesetzte, eine große Masse nur ein einziges

Mal), oder mit der Größe von Städten (wenige sind gigantisch, eine breite Masse von

ihnen extrem klein).

Formal kann man das Zipfsche Gesetz etwa so beschreiben: Sei (a1 , . . . , an ) eine

nach Häufigkeit sortierte Liste von Phänomenen (z.B. Wörtern) und f (ai ) die Häufigkeit jedes Phänomens. Dann gilt ungefähr:

f (ai ) ≈

1

ia

mit einem festen Parameter a ∈ R, der normalerweise ein bißchen größer als 1 ist.

Im Falle der natürlichen Sprache ist davon auszugehen, daß die Folge der Phänomene

unendlich ist (da es potentiell unendlich viele Wörter gibt). Für die Wahrscheinlichkeit

eines einzelnen Wortes würde man dann ansetzen:

1/ia

P({ω}) = P∞ 1

j=1 ja

(nämlich die Häufigkeit des Wortes, dividiert durch die Gesamthäufigkeit aller Wörter).

Das geht natürlich nur, falls

∞

X

1

ja

j=1

konvergiert (d.h. nicht unendlich groß wird, s. S. 17), was für a > 1 in der Tat der Fall

ist 13 .

13 Vgl.

etwa http://encyclopedia.lockergnome.com/s/b/Zipf’s_law

30

KAPITEL 1. MOTIVATION UND GRUNDLAGEN

Kapitel 2

Bedingte Wahrscheinlichkeit

2.1

Wie man die Zukunft nicht voraussagt und die Formel von Bayes

Im vorigen Kapitel (Bsp. 7 auf S. 22) haben wir das wohl einfachste denkbare stochastische Modell von Sprache betrachtet: Die Gleichverteilung der Wörter, d.h. die

Annahme, alle Wörter würde mit derselben Wahrscheinlichkeit in Dokumenten auftreten. Das ist kein sehr gutes Modell, da die von ihm vorausgesagten Dokumente ja alle

Wörter etwa gleich häufig enthalten müssten, was für authentische Dokumente aber

keineswegs gilt. Im Gegenteil, anhand der Frequenzlisten haben wir gesehen, daß eine

relativ kleine Menge von Wörtern extrem häufig vorkommt, ein mittelgroßer Anteil

einigermaßen regelmäßig, und die weitaus meisten Wörter überhaupt nur ein einziges

Mal, selbst in großen Korpora.

Ein besseres Modell schien die am Ende des letzten Kapitels vorgestellte ZipfVerteilung zu sein, wo man eine Ordnung der Wörter nach Häufigkeit annimmt und

dann die Wahrscheinlichkeit des n-häufigsten Wortes als P(wn ) ≈ 1/ns mit s = 1 + ε

angibt.

Jedoch auch dieser Verteilung gelingt es noch nicht, einer wesentlichen Eigenschaft

der natürlichen Sprache Genüge zu tun, die darin besteht, daß nicht nur das Vorkommen eines bestimmten Wortes, sondern die Reihenfolge der Wörter untereinander eine

zentrale Rolle spielt. Anders ausgedrückt, die Wahrscheinlichkeit eines Wortes w wird

stark davon abhängen, welche Wörter links und rechts von w stehen. Etwa nach einem

Artikel “der” werden im Deutschen z.B. maskuline Substantive im Singular sehr viel

wahrscheinlicher sein als etwa intransitive Verben in der zweiten Person Singular.

Wir müssen also die Wahrscheinlichkeiten für ganze Folgen von Wörtern betrachten, nicht nur von Unigrammen in Isolation. Eine Möglichkeit hierfür, aus der Reihe

der stochastischen Standardmodelle, haben wir ebenfalls im letzten Kapitel betrachtet: Die Produkt- und Binomialverteilung, die es uns erlaubt, die Wahrscheinlichkeit

für das Auftreten bestimmter Folgen zu berechnen. Allerdings waren wir dabei eben

gerade von der falschen Annahme ausgegangen, die Wahrscheinlichkeiten für gewisse Wörter (Kugeln) oder Farben (Wortarten) würde sich nach jedem Zug nicht ändern

(Ziehen mit Zurücklegen). Wir brauchen nun also einen Begriff für situationsabhängige Wahrscheinlichkeiten.

31

32

KAPITEL 2. BEDINGTE WAHRSCHEINLICHKEIT

Einen solchen Begriff liefert uns die Stochastik anhand folgender Überlegung. Sei

(Ω, F, P) ein Wahrscheinlichkeitsraum, A, B ∈ F Ereignisse. Angenommen, wir kennen

P(A) und P(B). Nehmen wir weiter an, wie hätten davon erfahren, daß das Ereignis

B tatsächlich eingetreten sei. Dann befinden wir uns nun in einer neuen Situation, in

der wir ein revidiertes Wahrscheinlichkeitsmaß, sagen wir PB , betrachten. Sicherlich

wollen wir festlegen

PB (B) = 1

(2.1)

denn B ist ja nun sicher. Außerdem werden wir vernünftigerweise davon ausgehen, daß

die Wahrscheinlichkeit von Ereignisses, die B implizieren, jetzt proportional größer ist

als vorher, daß also gilt

PB (A ∩ B) = c · P(A ∩ B)

(2.2)

für eine geeignete Konstante c. Aus diesen beiden Bedingungen läßt sich aber PB (A)

bereits eindeutig bestimmen, denn zunächst gilt natürlich

(2.1)

PB (A) = PB (A ∩ B) + PB (A − B) = PB (A ∩ B)

| {z }

(2.3)

=0 wegen (2.1)

Die erste Gleichung gilt nach Def. 7e, denn A ∩ B und A − B sind disjunkt. Die zweite

Gleichung gilt wegen PB (B) = 1. Da das für alle A ∈ F gilt, also auch für den Spezialfall

A := B, folgt aber

(2.1)

(2.3)

1 = PB (B) = PB (B ∩ B) = c · P(B ∩ B) = c · P(B), also c =

(2.3)

(2.2)

D.h. PB (A) = PB (A ∩ B) = cP(A ∩ B) =

P(A∩B)

P(B)

1

P(B)

für alle A ∈ F.

Wir definieren daher:

Definition 10 (Bedingte Wahrscheinlichkeit). Sei (Ω, F, P) ein Wahrscheinlichkeitsraum, A, B ∈ F Ereignisse. Die bedingte Wahrscheinlichkeit für A unter der

Annahme B ist

P(A ∩ B)

P(A|B) :=

P(B)

Beachte, daß wir nun P(·|B) für das neue Wahrscheinlichkeitsmaß schreiben (statt

PB (·) wie in der Herleitung oben).

Beispiel 9. Einmaliges Würfeln mit einem sechseitigen, gleichmäßigen Würfel. Ω =

{1, . . . , 6}, F = P(Ω), P = UΩ . Es gilt P({1}) = 1/6, aber die Wahrscheinlichkeit für

eine 1, falls man schon weiß, daß eine ungerade Zahl gefallen ist, ist

P({1}|{1, 3, 5}) =

P({1} ∩ {1, 3, 5})

P({1})

1/6 2 1

=

=

= = .

P({1, 3, 5})

P({1, 3, 5}) 1/2 6 3

Jedoch die Wahrscheinlichkeit für eine 1, wenn man schon weiß, daß eine gerade Zahl

gefallen ist:

{1} ∩ {2, 4, 6} P(∅)

P({1}|{2, 4, 6}) =

=

= 0.

P({2, 4, 6})

1/2

2.1. WIE MAN DIE ZUKUNFT NICHT VORAUSSAGT UND DIE FORMEL VON BAYES33

Bemerkung Aussagen über die bedingte Wahrscheinlichkeit werden häufig als Aussagen über Kausalitätsbeziehungen zwischen zwei Ereignisse mißverstanden, so als

wäre P(A|B) die Wahrscheinlichkeit von A, nachdem B eingetreten ist (und womöglich

verursacht von B). Das ist aber nicht gemeint – im Gegenteil: In obigem Beispiel treten A und B ja gleichzeitig ein (es geht um einen einzigen Würfelwurf!). Was P(A|B)

ausdrückt, ist vielmehr unsere Einschätzung der Wahrscheinlichkeit dafür, daß A vorliegt, wenn wir wissen, daß B vorliegt. Man stelle sich also eine Situation vor, in der

jemand würfelt und uns nur mitteilt “es ist eine ungerade Zahl”. Dann schätzen wir die

Wahrscheinlichkeit für “1” als 1/3 ein.

In Zusammenhang mit linguistischen Modellen, insbesondere mit sog. n-GrammModellen, betrachtet man aber häufig die bedingte Wahrscheinlichkeit für das Auftreten eines Wortes w, wenn unmittelbar vorher ein anderes Wort w0 aufgetreten ist, und

schreibt dann P(w|w0 ). Hier hat man es also scheinbar mit einer bedingten Wahrscheinlichkeit von zwei Ereignissen zu tun, die gewissermaßen nacheinander eintreten. Klugerweise sollte man eine solche Situation aber besser als ein Ereignis “Wortpaar” betrachten, und w und w0 als zwei Eigenschaften desselben Ereignisses, nämlich w =“das

rechte Wort ist w” und w0 =“das linke Wort ist w0 ”.

Die Kenntnis von der bedingten Wahrscheinlichkeit P(A|B) eröffnet eine einfache

Möglichkeit zur Berechnung der Wahrscheinlichkeit für das gleichzeitige Vorliegen

beider Ereignisse, also P(A ∩ B):

P(A ∩ B) = P(A|B) · P(B)

Das folgt unmittelbar aus Def. 10.

Definition 11 (Unabhängigkeit). Sei (Ω, F, P) ein Wahrscheinlichkeitsraum,

A, B ∈ F. A und B heißen unabhängig, falls gilt:

P(A|B) = P(A)

Die Unabhängigkeit von zwei Ereignissen drückt also aus, daß unsere Einschätzung der Wahrscheinlichkeit für das Vorliegen von A nicht von unserem eventuellen

Wissen über das Vorliegen von B beeinflußt wird. Ist man sich der Unabhängigkeit

zweier Ereignisse sicher, so ist mit Hilfe obiger Formel P(A ∩ B) besonders einfach zu

berechnen:

Satz 2. Sei (Ω, F, P) ein Wahrscheinlichkeitsraum, A, B ∈ F. A und B sind unabhängig,

genau dann wenn

P(A ∩ B) = P(A) · P(B)

Beweis. Sind A und B unabhängig, so gilt offenbar

P(A ∩ B) = P(A|B) · P(B) = P(A)P(B).

Falls umgekehrt P(A ∩ B) = P(A)P(B), so folgt:

P(A|B) =

P(A ∩ B) P(A)P(B)

=

= P(A).

P(B)

P(B)

34

KAPITEL 2. BEDINGTE WAHRSCHEINLICHKEIT

Eine sehr nützliche Formel, die sich auch in vielen computerlinguistischen Anwendungen großer Beliebtheit erfreut, ist die Formel von Bayes. Sie stellt eine einfache

Umformung der oben bewiesenen Gleichungen dar und erlaubt es uns, P(B|A) aus

P(A|B) abzuleiten: