Mathematische Modelle WS2011/12

Werbung

Mathematische Modelle WS2011/12

Michael Schmuckenschläger

INHALTSVERZEICHNIS

ii

Inhaltsverzeichnis

1

2

Diffusionshalbgruppen

1.1 Diffusions- und Schrödingeroperatoren . . . . .

1.2 Maximumprinzip für Diffusionsoperatoren . . .

1.3 Die Ornstein-Uhlenbeck Halbgruppe . . . . . . .

1.4 Die Ornstein-Uhlenbeck Halbgruppe auf L p (γn )

1.5 Log-Sobolev Ungleichung für γn . . . . . . . . .

Markovketten

2.1 Neuronale Netze und Markovketten . . . .

2.2 Markovsche Übergangsmatrizen . . . . . .

2.3 Markovoperatoren . . . . . . . . . . . . . .

2.4 CLT für Markovketten . . . . . . . . . . . .

2.5 Ein probabilistisches Modell der Diffusion .

2.6 PageRank . . . . . . . . . . . . . . . . . . . .

2.7 Hastings bzw. Gibbs Algorithmus . . . . .

2.8 Der Entropiesatz . . . . . . . . . . . . . . .

Literatur: [?], [?], [?], [?], [?], [?], [?], [?], [?], [?].

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

1

1

4

7

15

16

.

.

.

.

.

.

.

.

20

20

21

24

26

27

28

29

33

1

1 Diffusionshalbgruppen

1.1 Diffusions- und Schrödingeroperatoren

Im folgenden sei Ω ein Gebiet in Rn , d.h. Ω ist eine offene und zusammenhängende

Teilmenge von Rn . Weiters seien für j, k = 1, . . . , n glatte Funktionen a jk , b j : Ω →

R definiert – dann sind a jk und b j lokal beschränkt sind, d.h. sie sind auf jeder

kompakten Teilmenge von Ω beschränkt, so daß für alle x ∈ Ω die n × n-Matrix

A( x ): = ( a jk ( x )) symmetrisch und strikt positiv definit ist. Dann nennt man den

Operator

n

H f ( x ): = −

∑

a jk ( x )∂ j ∂k f ( x ) + ∑ b j ( x )∂ j f ( x )

j,k=1

(1)

j

einen Diffusionsoperator auf Ω. Unter dem Γ-Operator eines Diffusionsoperators H versteht man den Operator

Γ( f , g): = 21 (−H( f g) + f H g + gH f ) =

∑ a jk ∂ j f ∂k g .

(2)

j,k

Ferner ist für jede glatte Funktion u : R → R:

H u ◦ f = u′ ( f )H f − u′′ ( f )Γ( f , f )

(3)

Sei h : Ω → R+ und Hh f : = H( h f )/h die h-Transformierte des Operators H. Es

gilt:

Hh f = H f − 2Γ( f , log h) + (H h/h) f .

(4)

Hh ist i.a. kein Diffusionsoperator sondern ein sogenannter Schrödingeroperator.

Ist H ein Diffusionsoperator und V : Ω → R, so nennt man den durch HV f ( x ): =

H f ( x ) + V ( x ) f ( x ) definierten Operator einen Schrödingeroperator mit dem Potential V.

Unter einem Geschwindigkeitsmaß eines Diffusionsoperators H auf Ω versteht

man ein Maß µ mit der Dichte ρ, so daß für alle f , g ∈ Cc∞ (Ω):

Z

H f ( x ) g( x ) µ(dx ) =

Z

f ( x )H g( x ) µ(dx ) .

Dies bedeutet, daß der Diffusionsoperatorperator H ein symmetrischer linearer Operator auf dem Unterraum Cc∞ (Ω) des Hilbertraumes L2 (µ) ist. Das Geschwindigkeitsmaß des Schrödingeroperators HV ist dasselbe wie das Geschwindigkeitsmaß des Diffusionsoperators H. Ein solches Maß muß i.a. nicht existieren; wir betrachten im weiteren nur einen besonderen Fall, nämlich a jk ( x ) = δjk

und b j ( x ) = ∂ j U ( x ) mit einer glatten Funktion U : Ω → R.

1 DIFFUSIONSHALBGRUPPEN

2

Proposition 1.1.1 Sei U : Ω → R+ glatt und H ein Diffusionsoperator auf Ω mit

a jk ( x ) = δjk und b j ( x ) = ∂ j U ( x ). Dann ist für jede Konstante c > 0 durch ρ( x ) =

ce−U ( x) die Dichte eines Geschwindigkeitsmaßes von H gegeben. Ferner gilt für alle

f , g ∈ Cc∞ (Ω):

Z

Z

H f ( x ) g( x ) µ(dx ) =

Γ( f , g)( x ) µ(dx ) .

B EWEIS : Nach partieller Integration erhalten wir:

Z

H f ( x ) g( x ) µ(dx ) =

Z

=

Z

=

Z

=

Z

− ∑ ∂2j f gρ + ∑ b j ∂ j f gρ dλ

j

j

∑ ∂ j f ∂ j ( gρ) + ∑ bj ∂ j f gρ dλ

j

j

∑ ∂ j f ∂ j gρ + ∂ j f ∂ j ρg + ∑ bj ∂ j f gρ dλ

j

j

∑ ∂ j f ∂ j gρ + ∂ j f g(∂ j ρ + bj ρ) dλ

j

Nach Voraussetzung ist aber ∂ j ρ + b j ρ = ∂ j (e−U ) + ∂ j Ue−U = 0.

B EMERKUNGEN: 1. ρ: = e−U ist genau dann ein Geschwindigkeitsmaß des Diffisionsoperators 1, wenn

∑ a jk ∂k U = bj + ∑ ∂k a jk .

∀j :

k

k

Definieren wir die j-te Komponente von g : Ω → Rn durch g j : = ∑k ∂k a jk , so

ist die obige Beziehung genau dann erfüllt, wenn x 7→ A−1 ( x )(b( x ) + g( x )) ein

Gradientenfeld ist. Insbesondere folgt für n = 1: U ′ = (b + a′ )/a.

2. Die Matrix ( g jk ): = A−1 ist wie A eine strikt positiv definite symmetrische Matrix und definiert somit eine Riemannsche Metrik auf Ω. Der Laplace-Operator

der Riemannschen Mannigfaltigkeit M: = (Ω, ( g jk )) ist dann gegeben durch:

∆ M f = − ∑ a jk ∂ j ∂k f + ∑ b j ∂ j f ,

j,k

j

√

√

wobei b j : = −(∑k ∂k ( a jk G )/ G und G: = det( g jk ) = 1/ det A.

Proposition 1.1.1 zeigt u.a. auch den Grund für das negative Vorzeichen in der

Definition eines Diffusionsoperators (1): H wird dadurch zu einem positiven

Operator, d.h. für alle f ∈ Cc∞ (Ω) gilt:

Z

H f ( x ) f ( x ) µ(dx ) ≥ 0 .

1.1 Diffusions- und Schrödingeroperatoren

3

R

Wir nehmen weiters noch an, daß e−U dλ < ∞, dann können wir erstens die

Konstante c in Proposition 1.1.1 so wählen, daß µ ein Wahrscheinlichkeitsmaß auf

Ω ist, und zweitens ist Cc∞ (Ω) dicht in L2 (µ) (dazu reicht es, daß µ ein Radonmaß

ist)! Unter diesen Bedingungen existiert eine symmetrische Markovhalbgruppe

Pt , t ≥ 0, auf L2 (µ) mit dem Generator −H, d.h. Pt ist für alle t ≥ 0 ein selbstadjungierter Operator auf L2 (µ) mit folgenden Eigenschaften:

1. P0 = id und für alle s, t ≥ 0 gilt: Ps Pt = Ps+t – Halbgruppeneigenschaft!

2. Für alle t ≥ 0 gilt: k Pt k ≤ 1 – man sagt: Pt ist eine Kontraktionshalbgruppe.

3. Ist 0 ≤ f ≤ 1, so ist 0 ≤ Pt f ≤ 1.

4. Für alle Funktionen f ∈ Cc∞ (Ω) gilt:

lim 1t ( Pt f − f ) + H f = 0 .

(5)

t →0

Es ist genau diese Beziehung, die man meint, wenn man sagt, daß −H der Generator der Halbgruppe Pt ist.

Es folgt dann für alle f ∈ L2 (µ): limt→0 k Pt f − f k = 0 – man sagt: die Halbgruppe Pt ist stetig. Falls ferner noch Pt 1 = 1, dann nennt man die Halbgruppe Pt

konservativ.

Setzen wir für f ∈ Cc∞ (Ω): u(t, x ): = Pt f ( x ), so besagt die Gleichung (5) i.w., daß

u eine Lösung der sogenannten Wärmeleitungsgleichung: ∂t u = −H u ist mit

u(0, x ) = f ( x ).

Das wohl bekannteste Beispiel ist die Wärmeleitungsgleichung auf Rn : ∂t u =

−∆u mit der Lösung:

u(t, x ): = Pt f ( x ): = e

−t∆

f ( x ): = (4πt)

−n/2

Z

f (y)e−k x−yk

2

/4t

dy .

(6)

B EMERKUNG: In vielen Fällen ist eine konservative, symmetrische Markovhalbgruppe Pt auf z.B. L2 (Rn , µ) – µ ist hierbei das normierte Geschwindigkeitsmaß

– auch eine stetige Kontraktionshalbgruppe auf C0 (Rn ). Die duale Halbgruppe

Pt∗ : M (Rn ) → M (Rn ) auf dem Raum M (Rn ) aller endlichen, signierten Borelmaße mit der Norm kνk : = sup{|ν( A)| : A ∈ B(Rn )} ist zwar i.a. keine stetige Halbgruppe, sie hat aber erstens die Eigenschaft, daß sie ein Wahrscheinlichkeitsmaß auf ein Wahrscheinlichkeitsmaß abbildet und zweitens ist µ unter

ihr invariant, d.h.R für alle t ≥ 0 gilt: Pt∗ µ = µ, denn

R wegen HR1 = 0 gilt fRür alle

f ∈ C0 (Rn ): t 7→ Pt f dµ ist konstant; damit folgt: f dPt∗ µ: = Pt f dµ = f dµ,

also: Pt∗ µ = µ.

Diskretisierung: Wir betrachten der Einfachheit halber einen Diffusionsoperator

H auf dem Torus! Zu jedem N ∈ N sei für k ∈ Z N : zk = e2πik/N und yk (t): =

u(t, zk ), ak = a(zk ) und bk : = b(zk ). Setzen wir δ: = 2π/N, so wählen wir für

u′ (zk ) bzw. u′′ (zk ) folgende Näherungen:

y k +1 − y k −1

2δ

bzw.

yk+1 − 2yk + yk−1

δ2

1 DIFFUSIONSHALBGRUPPEN

4

Die Gleichung ∂t u = −H u lautet dann

y′k (t) = ak (yk+1 − 2yk + yk−1 )/δ2 − bk (yk+1 − yk−1 )/2δ

∀k :

Dies ist eine lineare Differentialgleichung y′ (t) = Ay(t) für y = (y1 , . . . , y N ),

wobei die k-te Zeile der Matrix A in der (k − 1)-ten, der k-ten und der (k + 1)-ten

Spalte die Einträge

ak /δ2 + bk /2δ,

−2ak /δ2 und ak /δ2 − bk /2δ

besitzt und sonst nur die Einträge 0. Zunächst bemerken wir, daß jede Zeilensumme 0 ergibt. Ferner können wir wegen sup b < ∞ und inf a > 0 die Zahl δ so

klein wählen, daß |bk | < 2ak /δ; dann sind alle Einträge außerhalb der Diagonale

strikt positiv.

Lemma 1.1.2 Sei A ∈ M(n, R), so daß erstens jede Zeilensumme 0 ergibt und zweitens

alle Einträge außerhalb der Diagonale strikt positiv sind. Dann ist für alle t > 0 die

Matrix etA eine stochastische Matrix, genauer, sie besitzt nur strikt positive Einträge

und jede Zeilensumme ergibt 1.

B EWEIS : Sei b1 ∈ Rn der Vektor, der in jeder Komponente den Eintrag 1 besitzt.

b1 ist denn ein Eigenvektor zum Eigenwert 0 und somit ist nach Definition von

etA der Vektor b1 ein Eigenvektor von etA zum Eigenwert 1.

Sei l > max{2ak /δ2 : k }, dann besitzt die Matrix A + λ nur strikt positive Einträge, also besitzt auch e−tλ et( A+λ) = etA nur strikt positive Einträge.

1.2 Maximumprinzip für Diffusionsoperatoren

Cf. e.g. [?]: Sei weiterhin Ω ein Gebiet in Rn und H der durch (1) definierte Diffusionsoperator. Da die Matrix ( a jk ( x )) in jedem Punkt von Ω strikt positiv definit

und stetig ist, ist H auf jeder kompakten Teilmenge von Ω gleichmäßig elliptisch, d.h. zu jeder kompakten Teilmenge K von Ω gibt es eine positive Konstante

λK , so daß für alle x ∈ K und alle ζ ∈ Sn−1 :

∑ a jk ( x)ζ j ζ k ≥ λK .

(7)

j,k

Angenommen für eine Funktion u ∈ C2 (Ω) gilt für alle x ∈ Ω: H u( x ) < 0 –

wir schreiben hierfür einfach: H u < 0. Falls u in x0 ∈ Ω ein lokales Maximum

besitzt, dann ist H u( x0 ) ≥ 0, denn ∂ j u( x0 ) = 0 und −Hess u( x0 ) ist positiv definit; da auch A( x ): = ( a jk ( x )) positiv definit ist, folgt – wir benötigen hierzu eine

einfaches Ergebnis aus der linearen Algebra, nämlich, daß die Spur des Produkts

zweier positiv definiter Matrizen nicht negativ ist:

n

−

∑

j,k=1

a jk ( x0 )∂ j ∂k u( x0 ) = tr ( A( x0 )(−Hess u( x0 ))) ≥ 0 .

1.2 Maximumprinzip für Diffusionsoperatoren

5

Dieser Fall kann also niemals eintreten.

Wir verstehen im weiteren unter einem relativen Maximum von u im Punkt x0 ,

daß zu einer Zusammenhangskomponente Z von [u = u( x0 )] in Ω eine offene

Umgebung U existiert, so daß für alle x ∈ U \ Z: u( x ) < u( x0 ).

Beispiel 1.2.1 Sei h( x ): = exp(−hCx, x i/2) mit einer symmetrische Matrix C. Dann

gilt:

H h( x ) = (−h A( x )Cx, Cx i + tr ( A( x )C ) − hCx, b( x )i) h( x ) .

Sei f ( x ) = hCx, x i/2, dann ist h = e− f und nach der Beziehung (3) erhalten wir:

H h = −e− f H f − e− f Γ( f , f )

Die behauptete Beziehung folgt nun aus: Γ( f , f )( x ) = h A( x )Cx, Cx i und H f ( x ) =

−tr ( A( x )C )/2 + hCx, b( x )i.

Satz 1.2.2 (Hopf) Genügt u auf Ω der Ungleichung H u ≤ 0, so nimmt u in keinem

Punkt x0 von Ω ein relatives Maximum M an.

B EWEIS :

Br/2 ( x0 )

Z

x0

b

b

x1

Br ( x1 )

U

Sei Z eine Zusammenhangskomponente von [u = M ] und U ⊆ Ω eine offene

Umgebung von Z, so daß für alle x ∈ U \ Z: u( x ) < M. Wir wählen einen Punkt

x1 ∈ U \ Z, so daß für r: = d( x1 , Z ) gilt: Br ( x1 ) ∪ Br/2 ( x0 ) ⊆ U und es gibt genau

einen Punkt x0 ∈ Z mit k x0 − x1 k = r – falls diese Bedingungen für x1 nicht

erfüllt sind, dann wähle einen neuen Punkt x1 auf der Strecke zwischen x0 und

dem alten Punkt x1 !

1 DIFFUSIONSHALBGRUPPEN

6

Dann gibt es ein δ > 0, so daß für alle x ∈ Br ( x1 ) \ Br/2 ( x0 ): u( x ) ≤ M − δ.

Definieren wir nun

2

2

h( x ): = e−ck x− x1 k /2 − e−cr /2 ,

dann ist h| Br ( x1 )c < 0 und aufgrund der gleichmäßigen Elliptizität sowie Beispiel 1.2.1, folgt für λ: = λ B( x0 ,r/2) :

2

H h( x ) = ce−ck x−x1 k /2 − ch A( x )( x − x1 ), x − x1 i + 21 tr A( x ) − hb( x ), x − x1 i

≤ ce−ck x−x1 k

2

/2

(−cλ k x − x1 k2 + 12 tr A + kbk k x − x1 k) .

Wir können daher c > 0 so groß wählen, daß für alle x ∈ B( x0 , r/2) gilt: H h < 0.

2

Zu ε < δ/(1 − e−cr /2 ) sei schließlich v: = u + εh, dann folgt:

2

1. Für x ∈ Br ( x1 ) ∩ ∂Br/2 ( x0 ): v( x ) ≤ M − δ + ε(1 − e−cr /2 ) < M.

c

2. Für x ∈ Br ( x1 ) ∩ ∂Br/2 ( x0 ): v( x ) < u( x ) ≤ M.

3. Für alle x ∈ Br/2 ( x0 ): H v < 0.

Nach 1. und 2. ist v|∂Br ( x0 ) < 0; da aber v( x0 ) = M, muß v auf Br/2 ( x0 ) ein

Maximum besitzen, was unmöglich ist.

Folgerungen: 1. Ist Ω beschränkt, u auf Ω stetig, und gilt auf Ω: H u ≤ 0. dann

gilt: max{u( x ) : x ∈ Ω} = max{u( x ) : x ∈ ∂Ω}.

2. Die obige Voraussetzung der Beschränktheit des Gebietes ist notwendig, denn

die Funktion u(z): = ℜ exp(ez ) ist harmonisch, d.h. ∆u = 0, sie ist weiters auf

dem Rand von Ω: = [|ℑz| < π/2] beschränkt, aber sie ist auf Ω unbeschränkt.

3. Ist u eine Lösung der PDE H u = 0, so nimmt u in keinem Punkt von Ω ein relatives Extremum an. Insbesondere gibt es für beschränkte Gebiete Ω höchstens

eine stetige Lösung u : Ω → R der PDE H u = f , die auf ∂Ω mit einer vorgegebenen Funktion g übereinstimmt.

Korollar 1.2.3 (Zaremba Prinzip) u ≤ M genüge auf Ω der Ungleichung H u ≤ 0

und es existiere ein x0 ∈ ∂Ω und eine Kugel Br ( x1 ) ⊆ Ω, so daß x0 ∈ ∂Br ( x1 ),

u( x0 ) = M, u auf Br ( x1 ) stetig und die Ableitung von u in Richtung der äußeren

Normalen N in x0 existiert. Dann gilt: ∂ N u( x0 ) > 0, falls u nicht konstant ist.

B EWEIS : Sei v wie im Beweis zu Satz 1.2.2, nur daß wir hier Z durch ∂Ω ersetzen.

∂Ω

x0

b

Br/2 ( x1 )

Ω

b

x1

Br ( x1 )

1.3 Die Ornstein-Uhlenbeck Halbgruppe

7

Für v gilt auf Br ( x1 ) \ Br/2 ( x1 ): H v < 0, also nimmt sie ihr Maximum auf diesem

Gebiet entweder auf ∂Br ( x1 ) oder auf ∂Br/2 ( x1 ) an. Auf letzterer Menge gilt aber

für ein δ > 0: u ≤ M − δ und folglich können wir in der Definition von v die

Zahl ε > 0 so klein wählen, daß auf ∂Br/2 ( x1 ) gilt: v < M. Andererseits liegt

x0 auf ∂Br ( x1 ) und es gilt v( x0 ) = M und h|∂Br ( x1 ) = 0; somit folgt, daß v auf

Br ( x1 ) \ Br/2 ( x1 ) ihr Maximum im Punkt x0 annimmt.

Dies bedeutet aber, daß ∂ N v( x0 ) = ∂ N u( x0 ) + ε∂ N h( x0 ) ≥ 0 und daher genügt es

zu zeigen, daß ∂ N h( x0 ) < 0:

2

2

∂ N h( x0 ) = −2ce−cr h N, x0 − x1 i = −2cre−cr .

Korollar 1.2.4 Sei V : Ω → R0+ ein nicht negatives (glattes) Potential. Erfüllt die

(glatte) Funktion u : Ω → R die Beziehung (H + V )u ≤ 0, so nimmt u in keinem

Punkt ein nicht negatives relatives Maximum an.

Stabilität der Wärmeleitung: Seien u1 , . . . , u N : (0, T ) × Ω → R und ζ : R N →

R N von der Klasse C2 . Ferner sei C eine abgeschlossene, konvexe Teilmenge von

R N , so daß für alle x ∈ ∂C: ζ ( x ) ∈ Tx C, i.e. ζ ( x ) ist tangential zu ∂C im Punkt x.

Satz 1.2.5 (R. Hamilton) Falls unter den oben stehenden Voraussetzungen gilt:

∀ k = 1, . . . , N :

∂t uk = −H uk + ζ (u1 , . . . , u N )

und falls für alle x ∈ Ω: (u1 (0, x ), . . . , u N (0, x )) ∈ C, dann gilt für alle t > 0:

(u1 (t, x ), . . . , u N (t, x )) ∈ C.

Für ζ = 0 folgt z.B., daß für jede Lösung der Wärmeleitungsgleichung ∂t u =

−H u die Funktionen t 7→ sup{u(t, x ) : x ∈ Ω} bzw. t 7→ inf{u(t, x ) : x ∈ Ω}

monoton fallend bzw. monoton steigend sind.

Beispiele: 1. Sei C = [0, 1] und ζ : [0, 1] → R mit ζ (0) = ζ (1) = 0 und u(0, x ) ∈

[0, 1], dann folgt: u(t, x ) ∈ [0, 1] falls ∂t u = −H u + ζ (u).

2. Sei C = {(y1 , y2 ) : y21 + y22 ≤ 1 und ζ : C → R mit ζ 1 (y1 , y2 )y1 + ζ 2 (y1 , y2 )y2 =

0 und (u(0, x ), u2 (0, x )) ∈ C, dann folgt: u1 (t, x )2 + u2 (t, x )2 ≤ 1 falls ∂t u1 =

−H u1 + ζ (u1 , u2 ) und ∂t u2 = −H u2 + ζ (u1 , u2 ).

3. Sei U (0, x ) = (u jk (0.x )) eine positiv definite Matrix. Falls für alle j, k: ∂t u jk =

−H u jk , dann ist U (t, x ): = (u jk (t, x )) eine positiv definite Matrix.

1.3 Die Ornstein-Uhlenbeck Halbgruppe

Die Hermite-Polynome auf R: Die Hermite-Polynome hn : R → R, n ∈ N0 auf R

sind definiert durch die erzeugende Funktion – cf. Wikipedia: 1

1 http://en.wikipedia.org/wiki/Hermite

polynomials

1 DIFFUSIONSHALBGRUPPEN

8

exp xy − 12 y2 =

yn

∑ n! hn ( x)

n ≥0

Mit γ1 bezeichnen wir im weiteren das standardisierte Gaußmaß auf R, also:

γ1 (dx ) = (2π )−1/2 e− x

2 /2

dx .

Lemma 1.3.1 1. Die Polynome bilden einen dichten Teilraum von L2 (γ1 ).

2. Für y ∈ R sei ϕy ( x ) = exp( xy − y2 /2). Dann ist [ ϕy ; y ∈ R] ein dichter Teilraum

von L2 (γ1 ).

B EWEIS : 2. Angenommen dieser Raum ist nicht dicht, dann gibt es eine Funktion

g ∈ L2 (γ1 ) mit k gk = 1, so daß für alle y ∈ R:

Z

R

e xy g( x ) γ1 (dx ) = 0 .

R

Definieren wir u : C → C durch u(z): = R e xz g( x ) γ1 (dx ), so ist u eine ganze Funktion auf C – d.h. u ist als Potenzreihe darstellbar und dies besitzt den

Konvergenzradius +∞. Andererseits verschwindet: u auf R nach Voraussetzung;

eine ganze Funktion, die auf R verschwindet muß aber auf ganz C verschwinden,

also: u = 0.

Insbesondere verschwindet y 7→ u(−iy), dies ist aber die Fourier-Transformierte

2

von ge: = g( x )e− x /2 ; da die Fourier-Transformation eine Isometrie von L2 (R) in

L2 (R) ist – cf. Wikipedia 2 , folgt schließlich: ge = 0 und damit: g = 0.

1. Falls

eine Funktion g ∈ L2 (γ1 ) existiert mit

R

R k gk2 = 1, so daß für alle Polynome

p: pg dγ1 = 0, dann folgt für alle y ∈ R: ϕy g dγ1 = 0 – wir benutzen hier, daß

die Funktionen hn tatsächlich Polynomfunktionen sind, also nach 2.: g = 0.

Beispiel 1.3.2 Sei u(z): =

u(n) ( z ) =

Z

R

R

R

e xz g( x ) γ1 (dx ). Zeigen Sie:

x n e xz g( x ) γ1 (dx )

und

√

|u(n) (z)|1/n ≤ C (z) n

2

Ähnlich kann man zeigen, daß der von den Funktionen x 7→ ϕy ( x )e− x /2 aufgespannte Unterraum E ein dichter Unterraum von C0 (R) ist – dies folgt z.B. nicht

unmittelbar aus dem Satz von Stone-Weierstraß, denn E ist keine Unteralgebra

von C0 (R).

2 http://en.wikipedia.org/wiki/Fourier

transform

1.3 Die Ornstein-Uhlenbeck Halbgruppe

9

Proposition 1.3.3 1. hn sind monische Polynome des Grades n, d.h. hn ( x ) = x n + · · ·,

genauer:

(−1)k n!

x n−2k .

hn ( x ) = ∑

k

n−2k≥0 2 k! ( n − 2k ) !

√

2. Die Polynome hn / n!, n ∈ N0 , bilden eine orthonormale Basis von L2 (γ1 ).

2

3. Die Funktion p( x ): = e− x /2 ist eine Eigenfunktion

√ der Fourier-Transformation zum

Eigenwert 1. Allgemeiner: die Funktion x 7→ hn ( x 2) p( x ) ist eine Eigenfunktion der

Fourier-Transformation

(−i )n .

R zum Eigenwert

4. Es gilt: hn ( x ) = ( x + iy)n γ1 (dy).

B EWEIS : Nach Definition ist

exp xy − 21 y2 =

m

ym 1

y

x

−

∑

2

m=0 m!

∞

∞

=

m

1

x m−k 2−k (−1)k yk+m

k!

(

m

−

k

)

!

m =0 k =0

∑ ∑

∞

(−1)k

∑ ∑ k!(n − 2k)! xn−2k 2−k yn

n=0 n−2k≥0

∞

yn (−1)k n!

n−2k

x

.

= ∑

∑ k

n=0 n! n−2k≥0 2 k! ( n − 2k ) !

=

2. Aus den Identitäten

exp xy − 21 y2 exp xz − 21 z2 =

und

folgt:

Z

yn zm

hn ( x ) hm ( x )

∑

n,m≥0 n!m!

exp xy − 21 y2 exp xz − 12 z2 γ1 (dx ) = exp(yz)

yn zn

yn zm

h hn , hm i = ∑

n≥0 n!

n,m≥0 n!m!

∑

Also h hn , hm√

i = n!δn,m und da nach Lemma 1.3.1 die Polynome dicht in L2 (γ1 )

sind, ist hn / n!, n ∈ N0 eine orthonormale Basis von L2 (γ1 ).

R

2

3. Wir benutzen im folgenden die Beziehung e−( x+z) /2 dx = (2π )1/2 , die für

alle z ∈ C gilt. Die Fourier-Transformierte einer Funktion f ∈ L1 (R) ist definiert

R

durch: F f (t): = fb(t): = (2π )−1/2 f ( x ) exp(−ixt) dx.

F ( p)(t) = (2π )

−1/2

Z

e

− x2 /2−ixt

dx = (2π )

−1/2

Z

e−( x+it)

2 /2− t2 /2

dx = p(t) .

1 DIFFUSIONSHALBGRUPPEN

10

Allgemeiner

erhalten wir nach

Funktion mit e

hn ( x ) =

√

√ Definition der erzeugenden

2

√

hn ( 2x ) und ψy ( x ): = ϕ 2y ( 2x ) = exp(2xy − y ):

√

Z

2

2

1

( 2y)n e

∑ n! F (hn p)(t) = F (ψy p)(t) = √2π e2xy−y −ixt−x /2 dx

n ≥0

Z

2

2

2

1

e−( x+(it−2y)) /2−y +(it−2y) /2 dx

= √

2π

Z

2

2

2

1

e−( x+(it−2y)) /2+y −t /2−2ity dx

= √

2π

= ey

2 − t2 /2−2ity

2

= p(t)e−2ity+y = p(t)ψ−iy (t)

√

(−i 2y)n e

= ∑

(hn p)(t)

n!

n ≥0

4. Wiederum folgt nach Definition der erzeugenden Funktion:

yn

∑

n≥0 n!

Z

n

( x + it) γ1 (dt) =

Z

yn ( x + it)n

γ1 (dt)

∑

n!

n ≥0

1

= √

2π

Beispiel 1.3.4 Für alle z ∈ C gilt:

R

Z

ey( x+it)−t

e−( x+z)

2 /2

2 /2

dt = ϕy ( x ) =

yn

∑ hn (y) .

n≥0 n!

dx = (2π )1/2 .

Proposition 1.3.5 1. h0 ( x ) = 1, h1 ( x ) = x und hn+1 ( x ) = xhn ( x ) − nhn−1 ( x ).

2. Sei H : C ∞ (R) → C ∞ (R) der Operator H f ( x ) = − f ′′ ( x ) + x f ′ ( x ), dann gilt:

Hhn = nhn . Die Hermite-Polynom bilden also ein vollständiges Orthogonalsystem von

Eigenfunktionen des Diffusionsoperators H.

B EWEIS : 1. Sei ϕ( x, y) = ϕy ( x ) = exp( xy − y2 /2), dann gilt einerseits: ∂y ϕ( x, y) =

xϕ( x, y) − yϕ( x, y) und andererseits

∂y

yn

∑ n! ( xhn−1 ( x) − (n − 1)hn−2 ( x) = xϕ( x, y) − yϕ( x, y) .

n =1

∞

2. In diesem Fall haben wir erstens

yn

∑ n! nhn ( x) = y∂y ϕ( x, y) = ( xy − y2 ) ϕ( x, y)

n

und zweitens:

yn

∑ n! Hhn ( x) = H ϕy ( x) = −y2 ϕy ( x) + xyϕy ( x) = ( xy − y2 ) ϕ( x, y)

n

1.3 Die Ornstein-Uhlenbeck Halbgruppe

11

Die Hermite-Polynome auf Rn : Sei A: = Nn ; α = (α j ) ∈ A, |α|: = ∑ α j , α!: =

α1 ! . . . αn !. Für x, y ∈ Rn , α ∈ A sei hα ( x ) definiert durch

exp h x, yi − 21 k x k2 =

yα

∑ α! hα ( x)

α∈ A

Weiters bezeichne γn das standardisierte Gaußmaß auf Rn , i.e.

1

2

γn (dx ) = (2π )−n/2 e− 2 k xk dx

Analog zum eindimensionalen Resultat folgt, daß hα ein Polynom des Grades

|α| ist und daß jedes Polynom als Linearkombination der Hermite-Polynome hα ,

√

2

α ∈ Nn , darstellbar ist. Ferner sind die Funktionen hα ( x 2)e−k xk /2 die Eigenfunktionen der Fourier-Transformation F : L2 (Rn ) → L2 (Rn ):

F ( f )(y): = (2π )−n/2

∀ f ∈ L1 ( R n ) :

Z

f ( x )e−ih x,yi dx .

zum Eigenwert (−i )|α| oder: für jedes Polynom q : Cn → C gilt:

Z

Rn

q( x )e−k xk

2

/2 −i h x,yi

e

dx = q(−iy)(2π )n/2 e−kyk

2

/2

also

ist z.B. jedes homogene Polynom eine Eigenfunktion Ferner gilt: hα ( x ) =

R

( x + iy)α γn (dy).

√

Proposition 1.3.6 1. ( hα / α!)α∈ A ist eine orthonormale Basis von L2 (γn ).

2. Bezeichnet H n (k ) die abgeschlossene lineare Hülle von { hα : |α| = k } und Qk : L2 →

H n (k ) die orthogonale Projektion, so definieren wir für alle |ε| ≤ 1:

T (ε) f : =

∑ εk Qk f

k ≥0

also insbesondere: T (1) = id und T (0) f =

T (ε)( ϕy ) = ϕεy und für alle ε ∈ [−1, 1]:

T (ε) f ( x ) =

Z

f (εx +

R

p

f dγn . Es gilt dann für alle y ∈ Rn :

1 − ε2 y) γn (dy)

3. Sei H der Diffusionsoperator H f ( x ): = − ∑ ∂2j f ( x ) + x j ∂ j f ( x ), so ist hα eine Eigenfunktion zum Eigenwert |α|.

4. Die durch Pt : = T (e−t ) definierte Halbgruppe heißt die Ornstein-Uhlenbeck Halbgruppe; sie besitzt den Generator − H.

1 DIFFUSIONSHALBGRUPPEN

12

B EWEIS : 1. Aus den Identitäten

exp h x, yi − 21 kyk2 exp h x, zi − 12 kzk2 =

yα z β

∑ α!β! hα ( x)hβ ( x)

α,β

und

Z

1

2

exp h x, yi − kyk

2

1

2

exp h x, zi − kzk

2

γn (dx ) = exp(hy, zi)

folgt:

yα z β

1

hy, zin

h

h

,

h

i

=

∑ α!β! α β ∑ n! = ∑ ∑ yα zα α!

n ≥0

n≥0 |α|=n

α,β

Also h hα , h β i = α!δα,β .

2. Da

∑ h h α , ϕ y i h α k h α k −2

Qk ( ϕy ) =

yα

k h α k2

α!

und

h hα , ϕy i =

ε|α|

=

α!

(εy)|α|

∑ α! hα = ϕεy

α∈ A

|α|=k

folgt:

∑

εk Qk ( ϕy ) =

∑

α∈ A

k ≥0

hα

k hα k

h h , ϕy i

2 α

Definieren wir andererseits einen linearen Operator S(ε) durch S(ε) f ( x ) =

√

1 − ε2 y) γn (dy), so gilt:

Z

R

p

ϕy (εx + 1 − ε2 z) γn (dz)

Z

p

=

exp εh x, yi + 1 − ε2 hz, yi − 12 kyk2 γn (dz)

= (2π )−n/2 exp εh x, yi − 21 kεyk2

Z

p

2

2

2

1

1

2

exp − 2 kzk + 1 − ε hz, yi − 2 (1 − ε ) kyk dz

Z

2 p

− n2

1

2

exp − 2 z − 1 − ε y

= ϕεy ( x )(2π )

dz = ϕεy ( x )

S ( ε ) ϕ y ( x ): =

f (εx +

Da sowohl T (ε) wie S(ε) beschränkte lineare Operatoren auf L2 (γn ) sind (warum?),

folgt aufgrund der Dichtheit des von den Funktionen ϕy , y ∈ Rn , aufgespannten

Raumes: S(ε) = T (ε).

3. Es gilt einerseits mit ϕ( x, y) = ϕy ( x ):

yα

∑ α! Hhα ( x) = H ϕy ( x) = (− kyk2 + h x, yi) ϕ( x, y)

α

1.3 Die Ornstein-Uhlenbeck Halbgruppe

13

Andererseits ist wegen y j ∂y j yα = α j yα :

∑

α

|α|yα

hα ( x ) =

α!

1

∑ α! (∑ y j ∂yj )yα hα ( x)

α

= (∑ y j ∂y j ) ϕ( x, y) = (− kyk2 + h x, yi) ϕ( x, y)

4. Zunächst ist Pt Qk f = e−tk Qk f , also

Ps Pt f = T (e−s ) ∑ e−tk Qk f =

∑ e−tk T (e−s )Qk f

= Ps+t f

i.e. Pt ist eine Halbgruppe. Da t 7→ Pt f stetig ist und k Pt f k ≤ k f k, ist Pt eine

stetige Kontraktionshalbgruppe. Schließlich gilt für alle α ∈ A mit k: = |α|:

Pt hα = T (e−t ) hα = e−kt hα

und damit: limt→0 ( Pt hα − hα )/t = −khα = − Hhα .

2

B EMERKUNGEN: 1. Sei für p( x ): = e−k xk /2 : M : L2 (γn ) → L2 (Rn ) der Multiplikationsoperator: f 7→ f p, dann ist MT (−i ) M−1 i.w. die Fourier-Transformation.

2. Für f ∈ L2 (γn ) ist u(t, x ): = Pt f ( x ) die Lösung der PDE ∂t u(t, x ) = − Hut ( x ) =

+

n

−∆ut ( x ) − h x, gradx ut i mit

√ u(0, x ) = f ( x ); ferner ist u : R × R glatt! – nach

Substitution y = (z − εx )/ 1 − ε2 , folgt:

2

Pt f ( x ) = (2π (1 − ε ))

−n/2

Z

f (z) exp(− kz − εx k2 /2(1 − ε2 )) dy

und damit ist der Integrand eine glatte Funktion (von x).

3. Ist En , n ∈ N0 , eine orthonormale Zerlegung eines (komplexen) Hilbertraumes

E und Qn : E → En die orthogonalen Projektionen, so ist T : D → L( E), z 7→

∑n≥0 zn Qn eine auf D: = [|z| < 1] analytische Funktion und Pt : = T (e−t ) ist eine stetige, selbstadjungierte Kontraktionshalbgruppe mit dem Generator − Hx: =

− ∑ nQn , d.h. für x ∈ dom ( H ): = { x ∈ E : ∑ n k Qn x k2 < ∞} ist u : t 7→ Pt x die

Lösung der Wärmeleitungsgleichung u′ (t) = − Hu(t).

Ein weiteres bedeutendes Beispiel dieser Konstruktion ist die Poisson-Halbgruppe:

E = L2 (Sd−1 ) mit dem normalisierten Haarmaß σ, und En der von den Kugelfunktionen des Grades n aufgespannte Unterraum; in diesem Falls ist

2

T (r ) f ( ζ ) = (1 − r )

Z

f (ξ )

S d −1

krζ − ξ kd

σ (dξ ) =

Z

S d −1

f (ξ ) P(rζ, ξ ) σ (dξ )

wobei P( x, ξ ): = (1 − k x k2 )/ k x − ξ kd den sogenannten Poisson-Kern von B2d

bezeichnet; da P ≥ 0 ist auch in diesem Beispiel T (r ) positiv, d.h. T (r ) bildet

positive Funktionen auf positive Funktionen ab. Wir erhalten also wiederum eine symmetrische Markovhalbgruppe T (e−t ). Der wesentlichen Unterschied zur

1 DIFFUSIONSHALBGRUPPEN

14

Ornstein-Uhlenbeck Halbgruppe ist, daß der Generator − H kein Diffusionsoperator ist!

q

1

H = − 2 (d − 2) + 14 (d − 2)2 + ∆Sd−1

4. Für x ∈ dom ( H ) ist u : t 7→ Pt x die Lösung der Wärmeleitungsgleichung

u′ (t) = − Hu(t) mit u(0) = x und ψ : t 7→ St x: = T (e−it ) x ist die Lösung der

zeitabhängigen Schrödingergleichung ψ′ (t) = −iHψ(t) mit ψ(0) = x.

Der harmonische Oszillator: Das Geschwindigkeitsmaß des Diffusionsoperators

H ist nach Proposition 1.1.1: γn und somit ist die Ornstein-Uhlenbeck Halbgruppe eine symmetrische, konservative Markov Halbgruppe auf L2 (γn ) mit dem ΓOperator:

Γ( f , g): = ∑ ∂ j f ∂ j g = h∇ f , ∇ gi .

j

Setzen wir insbesondere log h( x ) = k x k2 /4, dann ist nach (4) Hh + n/2 der

Schrödingeroperator:

− ∑ ∂2j f + 41 k x k2 f

j

Man nennt diesen Operator auch den n-dimensionalen harmonischen Oszillator.

Er besitzt die Eigenfunktionen hα ( x ) exp(− k x k2 /4) zum Eigenwert |α| + n/2.

Wir benötigen im weiteren folgende Eigenschaften der Ornstein-Uhlenbeck Halbgruppe, die alle aus Proposition 1.3.6 bzw. Proposition 1.1.1 für beschränkte, glatte Funktionen f , g, . . . : Rn → R folgen:

1. Pt besitzt den Generator − H, d.h. es gilt:

d

dt Pt f

= − HPt f .

2. ∇ Pt f = e−t Pt ∇ f – wobei Pt ∇ f komponentenweise definiert ist.

3. Für alle f , g gilt: Γ( f , g) = h∇ f , ∇ gi und

Z

f .Hg dγn =

Z

Z

H f .g dγn = Γ( f , g) dγn

R

R

R

insbesondere folgt hieraus mit 1.: Hg dγn = 0 und Pt f dγn = f dγn .

4. Nach (3) gilt für alle glatten Funktionen u : R → R:

Hu( f ) = −u′′ ( f )Γ( f , f ) + u′ ( f ) H f .

5. Ist ϕ eine konvexe Funktion, so gilt: ϕ( Pt f ) ≤ Pt ( ϕ ◦ f ) – dies folgt aus der

Jensen-Ungleichung sowie der in Proposition (1.3.6.2) gegebenen Darstellung von Pt = T (e−t ).

6. Die Cauchy-Schwarz Ungleichung: Für f , g ∈ L2 (γn ) gilt:

q

Pt ( f g) ≤ Pt ( f 2 ) Pt ( g2 )

dies folgt wiederum aus der in Proposition 1.3.6.2 gegebenen Darstellung.

1.4 Die Ornstein-Uhlenbeck Halbgruppe auf L p (γn )

15

1.4 Die Ornstein-Uhlenbeck Halbgruppe auf L p (γn )

Das folgende elementare Resultat zeigt, daß die Ornstein-Uhlenbeck Halbgruppe

Pt eine Kontraktionshalbgruppe auf L p (γn ) ist:

Proposition 1.4.1 Für alle 1 ≤ p ≤ ∞ gilt:

k T (ε) : L p (γn ) → L p (γn )k = 1 .

B EWEIS : Wir beschränken uns auf den Fall p < ∞. Da T (ε) die konstante Funktion 1 auf sich abbildet, ist die Norm ≥ 1. Nach der Jensen-Ungleichung gilt andererseits:

p

Z Z

p

p

′

′

f (εx + 1 − ε2 x ) dγn ( x ) dγn ( x )

k T (ε) f k p =

Z Z

p

≤

| f (εx + 1 − ε2 x ′ ))| p dγn ( x ′ ) dγn ( x )

Z

=

| f ( X )| p dγn ⊗ γn

wobei X : Rn × Rn → Rn die Abbildung ( x, x ′ ) 7→ εx +

γn ⊗ γn ( X ∈ A) = γn ( A) (warum?), folgt:

Z

p

| f ( X )| dγn ⊗ γn =

Z

√

1 − ε2 x ′ bezeichnet. Da

| f ( x )| p dγn ( x ) = k f k pp

Weniger elementar ist die sogenannte Hyperkontraktivität der Ornstein-Uhlenbeck

Halbgruppe – wir folgen im anschließenden Abschnitt dem Beweis von L. Gross,

der die Hyperkontraktivität mit sogenannten Log-Sobolev Ungleichungen in Beziehung bringt.

Satz 1.4.2 [E. Nelson, L. Gross: Hyperkontraktivität] Sei 1 < p < q < ∞. Dann gilt:

q

T ( ε ) : L p ( γn ) → L q ( γn ) ≤ 1 .

∀ | ε | ≤ ( p − 1) / ( q − 1) :

B EWEIS : Cf. Satz 1.5.1 und Satz 1.5.2.

Da T (ε) Qk = εk Qk impliziert die Hyperkontraktivität:

|ε|k k Qk f kq ≤ k Qk f k p

i.e.

k Qk f kq ≤

q − 1 k/2

p−1

k Qk f k p .

Dies bedeutet, daß auf jedem der Räume H n (k ) die von L p (γn ) und die von

Lq (γn ) induzierten Normen äquivalent sind und zwar unabhängig von der Dimension n.

1 DIFFUSIONSHALBGRUPPEN

16

[K. Babenko, W. Beckner]: Sei 1 < p ≤ 2 und 1/p + 1/q = 1. Dann gilt:

F : L p (Rn ) → Lq (Rn ) ≤ ( p1/p /q1/q )n/2 (≤ 1) .

Da MT (−i ) M−1 i.w. die Fourier-Transformation

auf Rn ist, ist die

Babenko

Beckner-Ungleichung eine Aussage über T (−i ) : L p (γn ) → Lq (γn ).

1.5 Log-Sobolev Ungleichung für γn

Satz 1.5.1 Für alle beschränkten differenzierbaren Funktionen f : Rn → R gilt die

logarithmische Sobolev Ungleichung:

Z

f 2 log f 2 dγn −

Z

f 2 dγn log

Z

f 2 dγn ≤ 2

Z

k∇ f k2 dγn .

(8)

B EWEIS : Sei f > 0 und u(Rx ) = x log x – diese Funktion ist, nebenbei bemerkt, auf

R+ konvexR und F (t): = u( Pt f ) dγn , dann istR nach dem Hauptsatz: − F (∞) +

∞

F (0) = − 0 F ′ (t) dt. Nun ist aber F ′ (t) = − u′ ( Pt f ) HPt f dγn und nach 3. ist

R ′′

dies u ( Pt f ) k∇ Pt f k2 dγn , also wegen u′′ ( x ) = 1/x und 2.:

−u

Z

f dγn +

Z

u( f ) dγn =

=

Z ∞Z

e−2t

≤

Z ∞Z

e−2t

0

0

Z ∞Z

k∇ Pt f k2

0

Pt f

dγn dt

( Pt ∂ j f )2

∑ Pt f dγn dt

j =1

n

n

∑ Pt

j =1

( ∂ f )2 j

dγn dt =

f

1

2

Z

k∇ f k2

dγn .

f

p

Wobei wir die Cauchy-Schwarz Ungleichung (cf. 6.) mit X = ∂ j f und Y =

f

2

2

2

2

wie folgt nutzten: ( Pt X ) = ( Pt (Y ( X/Y ))) ≤ Pt (Y ) Pt ( X/Y ) ! Die Behauptung

folgt nun nach Substitution f → f 2 .

1. Der Beweis zeigt, daß die Gleichheit in der Log-Sobolev Ungleichung (8) genau

dann eintritt, wenn f ( x ) = exp(h a, x i) für ein a ∈ Rn .

2. Setzen wir u( x ) = x2 , so folgt aus demselben Beweis wegen u′′ ( x ) = 2 unmitR

R

R

telbar die Poincaré Ungleichung: f 2 dγn − ( f dγn )2 ≤ k∇ f k2 dγn – Gleichheit gilt in diesem Fall nur für konstante Funktionen.

Zum Nachweis der Hyperkontraktivität der Halbgruppe Pt benötigen wir nun

nur noch folgends: Ist µ ein (σ-endliches) Maß, f ∈ L1 (µ) ∩ L∞ (µ) nicht negativ

und G ( p): = log k f k p , so gilt:

G′ ( p) = −

1

p2

Z

. Z

1Z

f p dµ .

f p log f dµ

f p dµ +

p

1.5 Log-Sobolev Ungleichung für γn

17

Ferner ist f 7→ log k f k p differenzierbar mit der Ableitung (im Punkt f 6= 0):

g 7→

Z

f p−1 g dµ/

Z

f p dµ .

Satz 1.5.2 (Gross) Folgende Bedingungen sind äquivalent.

1. Hyperkontraktivität: ∀ p ≥ 1, t ≥ 0, 1 ≤ q ≤ 1 + ( p − 1)e2t :

k Pt : L p (γn ) → Lq (γn )k ≤ 1 .

2. Es gilt die logarithmische Sobolev Ungleichung

Z

2

2

f log f dγn −

Z

2

f dγn log

Z

2

f dγn ≤ 2

Z

k∇ f k2 dγn .

B EWEIS : Die Substitution f → f q/2 zeigt, daß die logarithmische Sobolev Ungleichung gleichbedeutend ist mit

Z

q

q

f log f dγn −

Z

q

f dγn log

Z

q

f dγn ≤

q2

2

Z

f q−2 k∇ f k2 dγn .

(9)

Nun definiere q(t): = 1 + ( p − 1)e2t und F (t): = k Pt f kq(t) . Falls (9) gilt, dann

folgt: F ′ (t) ≤ 0. Andererseits folgt aus F ′ (0) ≤ 0 die Gültigkeit von

R (9).

′

Zur Berechnung von F setzen wir der Einfachheit halber h f i: = f dγn ; definieren wir nun ϕ(t, q) = h( Pt f )q i1/q , dann ist F (t): = ϕ(t, q(t)). Da

h− HPt f , ( Pt f )q−1 i

hΓ( Pt f , ( Pt f )q−1 )i

∂1 log ϕ(t, q) =

=

h( Pt f )q i

h( Pt f )q i

1 h( Pt f )q log Pt f i

1

,

∂2 log ϕ(t, q) = − 2 logh( Pt f )q i +

q

h( Pt f )q i

q

und

folgt mit h: = Pt f wegen Γ( h, hq−1 ) = (q − 1) hq−2 k∇ hk2 und q′ = 2(q − 1):

′

′

F (t) = F (t) ∂1 log ϕ(t, q(t)) + q (t)∂2 log ϕ(t, q(t))

(q − 1)hhq−2 k∇hk2 i

= F (t) −

+

h hq i

F (t)(q − 1) =

− hhq−2 k∇hk2 i +

q

hh i

q′ qh hq log hi q

− loghh i +

h hq i

q2

2

q

q

q

q

−

h

h

i

log

h

h

i

+

h

h

log

h

i

.

q2

F ′ (t) ist also genau dann kleiner oder gleich 0, wenn die Log-Sobolev Ungleichung (9) gilt.

1 DIFFUSIONSHALBGRUPPEN

18

Proposition 1.5.3 (Concentration of Measure) Für alle 1-Lipschitz-Funktionen f :

R

2

Rn → R und alle ε > 0 gilt: γn (| f − f dγn | > ε) ≤ 2e−ε /2 .

R

R

B EWEIS : (Herbst). SeiRo.B.d.A. f dγn = 0. Definiere für t > 0: F (t): = et f dγn .

Dann folgt: tF ′ (t) = t f et f dγn und nach der Log-Sobolev Ungleichung 8 – mit

der Substitution f → et f /2 wegen k∇ f k ≤ 1:

tF ′ (t) − F (t) log( F (t)) ≤ t2 F (t)/2 .

Mit G (t): = log( F (t)) heißt dies: tG ′ − G ≤ t2 /2 oder ( G/t)′ ≤ 1/2 und wegen

limt↓0 G (t)/t = 0 erhalten wir: G (t) ≤ t2 /2, also: F (t) ≤ exp(t2 /2).

Aus der Chebychev-Ungleichung folgt schließlich für alle t > 0:

γn ( f > ε ) = γn ( e

t f −tε

> 1) ≤

und für die Wahl: t = ε: γn ( f > ε) ≤ e−ε

2 /2

Z

et f −tε dγn ≤ et

2 /2− τε

.

Beispiel: Für ∞ > p ≥ 2 gilt z.B. k.k p ≤ k.k2 und M p : =

also: γn (| k.k p − M p | > n1/p /2) ≤ 2 exp(−n2/p /8).

R

k x k p γn (dx ) ∼ n1/p ,

Satz 1.5.4 (D. Bakry, M. Ledoux) Für jede differenzierbare Funktion mit Werten in

[0, 1] gilt:

Z

p

2

2

2t

k f k2 − k f k p(t) ≤ arctan e − 1 k∇ f k dγn ,

wobei p(t) = 1 + e−t .

B EWEIS : Zunächst ist mit F (s): = Ps ( Pt−s f )2 nach Definition von Γ( f , f ) sowie der

Beziehung: k∇ Pt f k2 = k∇ Ps Pt−s f k2 = e−2s k Ps ∇ Pt−s f k2 ≤ e−2s Ps k∇ Pt−s f k2 :

2

Pt f − ( Pt f )

2

=

Z t

= 2

≥ 2

also: k∇ Pt f k2 ≤

Z

k f k2∞

0

′

F (s) ds =

Z t

Z t

0

− HPs ( Pt−s f )2 + 2Ps ( Pt−s f HPt−s f )) ds

Z t

Ps (k∇ Pt−s f k2 ) ds

0

Ps Γ( Pt−s f , Pt−s f ) ds = 2

0

e2s dsk∇ Pt f k2 = (e2t − 1)k∇ Pt f k2 ,

Z t

0

/(e2t − 1). Sei nun f : Rn → [0, 1] differenzierbar, dann ist

f ( f − Pt f ) dγn =

≤

Z Z t

0

Z tZ

0

Z t

√

f HPs f ds dγn =

Z tZ

0

h∇ f , ∇ Ps f i dγn ds

k∇ f kk∇ Ps f k dγn ds

1

Z

k∇ f k dγn

e2s − 1

Z

p

2t

≤ arctan e − 1 k∇ f k dγn .

≤

0

ds k f k∞

1.5 Log-Sobolev Ungleichung für γn

19

Andererseits ist nach Satz 1.5.2 wegen 1 + ( p(t) − 1)et = 2:

Z

f ( f − Pt f ) dγn =

Z

2

f dγn −

Z

f Pt f dγn

= k f k22 − k Pt/2 f k22 ≥ k f k22 − k f k2p(t) .

Die voranstehende Ungleichung ist eine sogenannte isoperimetrische Ungleichung

für den Gaußraum mit der Schar (1

p < p < 2) von isoperimetrischen Funktio2/p

nen: U p ( x ) = ( x − x )/ arctan( p(2 − p)/( p − 1)), also z.B. für p = 3/2:

√

√

U3/2 ( x ) = ( x − x4/3 )/ arctan( 3) oder für p = 4/3: U4/3 ( x ) = ( x − x3/2 )/ arctan( 8).

Offensichtlich ist sup{U p ( x ) : 1 < p < 2} ebenfalls eine isoperimetrische Funktion für den Gaußraum.

2 MARKOVKETTEN

20

2 Markovketten

2.1 Neuronale Netze und Markovketten

Sei ψ : R → [0, 1] eine Funktion, X eine endliche Menge (z.B. Zellen, Computer, etc.), N ∈ N, R eine symmetrische Relation auf X und p : R → R - das

Paar ( X, p) nennt man ein neuronales Netz. Sei J0 : X → [0, 1] eine weitere

Funktion (Zustandsfunktion der Zellen zum Zeitpunkt 0), dann definieren wir

für n ∈ {0, 1, . . . , N } Funktionen Jn : X → [0, 1] (Zustandsfunktion der Zellen

zum Zeitpunkt n) durch

Jn+1 (y) = ψ

p

(

x,

y

)

J

(

x

)

.

(10)

n

∑

x ∈ R(y)

Seien I, O ⊆ X (Input- bzw. Outputmenge). Unter einer Input- bzw. Outputfunktion versteht man Funktionen F : I → [0, 1] bzw. G : O → [0, 1]. Ist F eine

Inputfunktion so setzen wir J0 | I: = F und J0 | I c = 0, bestimmen G: = JN |O und

nennen G die von dem Netz ( X, p) in N Schritten produzierte Outputfunktion

zur Inputfunktion F.

I.a. hat man das Problem zu einer vorgegebenen Menge von Input- und Outputfunktionen ein möglichst “einfaches”Netz ( X, p) zu bestimmen, das aus den

Inputfunktionen nach N Schritten Outputfunktionen produziert, die die vorgegebenen Outputfunktionen möglichst “genau”wiedergeben.

Falls ψ( x ) = x, p( x, y) ≥ 0 und für alle x ∈ X: ∑y∈X p( x, y) = 1, dann nennt

man p eine Markovsche Übergangsfunktion. Ein besonders instruktives Beispiel

ist in diesm Zusammenhang die sogenannte Irrfahrt auf einem einfachen Graph:

Sei (V, E) ein einfacher endlicher Graph mit den Ecken V und den Kanten E. Wir

starten zum Zeitpunkt 0 in einer vorgegebenen Ecke x0 , wählen mit Wahrscheinlichkeit 1/ deg( x0 ) eine der Ecken aus, die mit x0 durch eine Kante verbunden

sind - etwa x1 - und begeben uns in die ausgewählte Ecke, so daß wir uns zum

Zeitpunkt 1 in x1 befinden. Erneut wählen mit Wahrscheinlichkeit 1/ deg( x1 ) eine der Ecken aus, die mit x1 durch eine Kante verbunden sind - etwa x2 - und

begeben uns in die ausgewählte Ecke, so daß wir uns zum Zeitpunkt 2 in x2 befinden; u.s.w. Man bezeichnet diesen Prozeß als eine Irrfahrt auf dem einfachen

Graph (V, E).

Satz 2.1.1 Starten wir zum Zeitpunkt 0 in x ∈ V eine Irrfahrt auf dem einfachen zusammenhängenden Graph (V, E), so ist

∑y∈V deg(y)

deg( x )

bzw.

deg(y)

deg( x )

die mittlere Zeit, die wir benötigen um zum ersten Mal zu x zurückzukehren bzw. die

mittlere Anzahl der Male da wir vor der ersten Rückkehr zu x die Ecke y besuchen.

2.2 Markovsche Übergangsmatrizen

21

In einer Ecke eines ansonsten leeren Schachbretts befinde sich ein Springer; führt

der Springer seine Züge zufällig aus, so benötigt er im Mittel 168 Sprünge um in

jene Ecke zurückzukehren, von der aus er seine Irrfahrt gestartet hat. Ferner hat

er dann jedes Feld im Mittel mindestens einmal besucht. Startet der Springer in

einem der mittleren Felder, so benötigt er im Mittel nur 42 Sprünge um zu diesem

Feld zurückzukehren.

2.2 Markovsche Übergangsmatrizen

Sei Ω eine i.a. endliche oder abzählbare Menge von sog. “Zuständen”eines “Systems”, also Ω = { x1 , . . . , x N }. Jede Funktion µ : Ω → [0, 1], so daß ∑ x∈Ω µ( x ) =

1 nennt man eine Verteilung auf Ω. Sei nun µ eine vorgegebene Verteilung auf

Ω; wir interpretieren µ( x ) als die Wahrscheinlichkeit dafür, daß das System zum

Zeitpunkt t = 0 im Zustand x ist: man sagt auch, daß µ die Verteilung des Systems zum Zeitpunkt 0 ist.

Die Zustandsänderungen des Systems sind wie folgt mit gewissen Wahrscheinlichkeiten verbunden: mit p( x, y) bezeichnen wir die Wahrscheinlichkeit, daß das

System zum Zeitpunkt t = 1 im Zustand y ist, nachdem es zum Zeitpunkt 0 im

Zustand x war. Da das System in irgendeinen Zustand übergehen muß, erhalten

wir folgende

Definition 2.2.1 Unter einer Markovschen Übergangsmatrix (oder einer stochastischen Matrix) auf Ω verstehen wir eine N × N- Matrix P = ( p( x, y)) x,y∈Ω mit folgenden Eigenschaften:

1. ∀ x, y ∈ Ω p( x, y) ≥ 0.

2. ∀ x ∈ Ω ∑y∈Ω p( x, y) = 1.

Die Wahrscheinlichkeit, daß sich das System zum Zeitpunkt 1 im Zustand x befindet ist gegeben durch ∑y∈Ω µ(y) p(y, x ) - oder in Matrizenschreibweise: µP mit

der 1 × N-Matrix µ = (µ( x1 ), . . . , µ( x N )): µ1 : = µP ist also die Verteilung des Systems zum Zeitpunkt 1.

Der Übergang während der nächsten Zeiteinheit soll nun unabhängig von aller

Vorgeschichte durch dieselbe Übergangswahrscheinlichkeit geregelt sein, folglich ist die Übergangsmatrix, die die Verteilung µ zum Zeitpunkt 0 mit der Verteilung µ2 zum Zeitpunkt 2 in Beziehung setzt gegeben durch P2 , i.e. in Matrizenschreibweise: µ2 = µP2 (µ2 und µ sind hierbei wiederum als 1 × N Matrizen

geschrieben!). Die Matrix, die den Übergang vom Zeitpunkt 0 zum Zeitpunkt n

beschreibt ist dann gegeben durch Pn =: ( pn ( x, y)).

Diffusionsmodell von Bernoulli-Laplace: Angenommen wir haben zwei Behältnisse A und B, von denen jedes genau N Kugeln enthält. n Kugeln seien schwarz

und 2N − n Kugeln weiß. Wir sagen, daß sich die Kugeln im Zustand j, j =

0, . . . , n, befinden, wenn das Behältnis A j schwarze Kugeln enthält. Wählen wir

22

2 MARKOVKETTEN

“zufällig”je eine Kugel aus den Behältnissen und vertauschen sie, so ist Wahrscheinlichkeit dafür, daß die Kugeln im Zustand k sind, wenn sie vorher im Zustand j waren:

( N − j)(n− j)

falls k = j + 1 und k ≤ n

2

j(n− j)+( N −Nj)( N −(n− j))

falls k = j

N2

p( j, k ) =

j

(

N

−(

n

−

j

))

falls k = j − 1 und k ≥ 0

N2

0

sonst

Ehrenfest Kette: In zwei Kammern A und B befinden sich insgesammt N Moleküle; wir wählen “zufällig”eines dieser Moleküle aus und geben es in die andere Kammer: Sei Ω = {0, 1, . . . , N } und p( j, j + 1) = ( N − j)/N - dies ist die

Wahrscheinlichkeit, daß in der Kammer A j Moleküle sind und wir ein Molekül

aus Kammer B ausgewählt haben (sich die Anzahl der Moleküle in Kammer A

also um 1 erhöht) p( j, j − 1) = j/N und sonst p( j, k ) = 0. Zustand j bedeutet in

diesem Modell: j Moleküle befinden sich in der Kammer A.

Irrfahrt auf einem einfachen Graph: Sei G = (V, E) ein einfacher Graph, V die

Menge der Ecken und E die Menge der Kanten. Bezeichnen wir mit d( x ) den

Grad einer Ecke x, d.h. d( x ) = |{y ∈ V : ( x, y) ∈ E}|, so ist durch p( x, y) =

1/d( x ) falls ( x, y) ∈ E und 0 sonst eine stochastische Matrix definiert.

Genetische Ketten: Aus einer Serie von j Einsen und N − j Nullen wählten wir

“zufällig”eines ihrer Elemente und kopieren es, danach wiederholen wir diesen

Kopiervorgang bis wir eine Serie von Einsen und Nullen der Länge N erhalten;

die Wahrscheinlichkeit k Einsen und N − k Nullen zu erhalten (wir nennen dies

den Zustand k) ist binomialverteilt:

N

p( j, k ) =

( j/N )k (1 − j/N ) N −k

k

Zellteilung: Ein jede Zelle eines Organismus bestehe aus N Teilchen, die entweder des Typs A oder des Typs B sind. Wir sagen, daß sich eine Zelle im Zustand

j ∈ {0, . . . , N } = Ω befindet, wenn sie genau j Teilchen des Typs A enthält.

Die Bildung einer Tochterzelle verläuft nun wie folgt: zunächst replizieren sich

sämtliche Teilchen einer Zelle, die Tochterzelle bildet sich dann durch “zufällig”Auswahl

von N Teilchen aus den vorhandenen 2j Teilchen des Typs A und 2N − 2j Teilchen des Typs B. Die Wahrscheinlichkeit, daß die Tochterzelle im Zustand k ist,

ist durch die hypergeometrische Verteilung gegeben:

2j

2N − 2j

2N

p( j, k ) =

/

.

k

N−k

N

2.2 Markovsche Übergangsmatrizen

23

Lineare Irrfahrt: Sei ∆x > 0, Ω: = R und p( x, x + ∆x ) = p( x, x − ∆x ) = 1/2

und p( x, y) = 0 falls y 6= x ± ∆x. Starten wir im Punkt x, so ist p2n ( x, x + 2k∆x )

die Wahrscheinlichkeit, daß wir nach 2n Schritten im Punkt x + 2k∆x: p2n ( x, x +

−2n .

2k∆x ) = (n2n

+ k )2

Definition 2.2.2 Sei P eine Markovsche Übergangsmatrix auf Ω. Eine Verteilung µ auf

Ω heiß stationär (bzgl. P) oder P-invariant , wenn µ = µP, i.e. wenn für alle x ∈ Ω:

µ( x ) = ∑ µ(y) p(y, x ).

Die Verteilung µ ∈ M(1, N ) ist genau dann P-invariant, wenn µt ∈ M( N, 1) ein

Eigenvektor der transponierten Matrix Pt zum Eigenwert 1 ist.

Satz 2.2.3 Sei P eine Markovsche Übergangsmatrix auf der endlichen Menge Ω und ν

eine beliebige Verteilung auf Ω.

1. P besitzt stets eine stationäre Verteilung µ, diese ist i.a. jedoch nicht eindeutig.

2. Gibt es für alle x, y ∈ Ω ein m ∈ N, so daß pm ( x, y) > 0 – man nennt dies die

sogenannte Positivitätsbedingung, dann existiert der Limes

µ( x ): = lim

n

1

n+1

n

∑ νPn ( x)

j =0

für alle x ∈ Ω und es gilt:

i. ∀ x ∈ Ω: µ( x ) > 0, ii. µ ist unabhängig von ν und iii. µ ist die einzige P-invariante

Verteilung auf Ω.

B EWEIS : 1. Sei für n ∈ N: An : = n−1 (1 + P + · · · + Pn−1 ), Q ein Häufungspunkt

von An und Ak(n) eine gegen Q konvergierende Teilfolge von An . Dann gilt:

Ak(n) − Ak(n) P = k (n)−1 (1 − Pk(n) ), also: Q = QP. Jede Zeile von Q ist dann

eine stationäre Verteilung.

2. Wir nehmen an, daß für alle x, y ∈ Ω gilt p( x, y) > 0 und zeigen, daß unter

dieser Voraussetzung der Limes Q = limn Pn existiert und daß die Matrix Q

identische Zeilen µ: = (µ( x1 ), . . . , µ( x N )) mit µ( x ) > 0 besitzt; somit ist µ das

einzige invariante Wahrscheinlichkeitsmaß.

Für 1 ≤ k ≤ N seien mn (y): = minx pn ( x, y) ≥ ε und Mn (y): = maxx pn ( x, y).

Dann gilt:

pn+1 ( x, y) =

∑

z∈Ω

p( x, z) pn (z, y) ≥

∑

p( x, z)mn (y) = mn (y) .

z∈Ω

Daher ist mn+1 (y) ≥ mn (y). Analog gilt: Mn+1 (y) ≤ Mn (y). Zu jedem y ∈ Ω sei

nun x (y) so bestimmt, daß Mn (y) = pn ( x (y), y), dann ist

pn+1 ( x, y) =

∑

p( x, z) pn (z, y)

z∈Ω

n

= εM (y) + ( p( x, x (y)) − ε) pn ( x (y), y) +

∑

z6= x (y)

p( x, z) pn (z, y)

2 MARKOVKETTEN

24

≥ εMn (y) + mn (y) p( x, x (y)) − ε +

= εMn (y) + mn (y)(1 − ε)

∑

p( x, z)

z6= x (y)

Folglich ist mn+1 (y) ≥ εMn (y) + mn (y)(1 − ε). Analog gilt wiederum Mn+1 (y) ≤

εmn (y) + Mn (y)(1 − ε) und somit

Mn+1 (y) − mn+1 (y) ≤ (1 − 2ε)( Mn (y) − mn (y)) .

Sind alle Einträge von Pm strikt positiv, so konvergiert Pmk gegen Q und für alle

l = 1, . . . , m − 1 gilt: limn Pmk+l = QPl = Q.

Ein verwandtes Beispiel ist folgendes Resultat von 0. Perron (c.f. e.g. Wikipedia 3

Beispiel 2.2.4 Sei A = ( a jk ) ∈ M(R, n) eine n × n-Matrix, so daß für alle j, k: a jk > 0.

Dann besitzt A einen strikt positiven Eigenwert λ zu einem Eigenvektor x mit strikt

positiven Komponenten. Ferner ist dim ker( A − λ) = 1 und λ ist der einzige positive

Eigenwert von A.

2.3 Markovoperatoren

Sei µ eine unter der Markovschen Übergangsmatrix P invariante Verteilung auf

Ω, so daß für alle x ∈ Ω: µ( x ) > 0. Auf der Menge aller Funktionen f : Ω → R

definieren wir ein inneres Produkt

h f , g i: =

∑

f ( x ) g( x )µ( x )

x ∈Ω

mit der entsprechenden Norm

k f k2 : =

q

hf, fi =

∑

x ∈Ω

| f ( x )|2 µ( x )

1/2

und bezeichnen den entsprechenden euklidischen Raum mit L2 (µ). Für alle f ∈

L2 (µ) sei

P f ( x ): = ∑ p( x, y) f (y) .

(11)

y∈Ω

Dann heißt der durch f 7→ P f definierte linearere Operator P : L2 (µ) → L2 (µ)

der Markovoperator (wir verwenden sowohl für die Markovschen Übergangsmatrix

als auch für den Markovoperator denselben Buchstaben, weil aus dem Kontenxt

onehin ersichtlich sein sollte, welcher Begriff gemeint ist). Da µ P-invariant ist,

folgt für alle x ∈ Ω: ∑y µ(y) p(y, x )/µ( x ) = 1, d.h. die durch p∗ ( x, y): = µ(y) p(y, x )/µ( x )

3 http://en.wikipedia.org/wiki/Perron-Frobenius

theorem

2.3 Markovoperatoren

25

definierte Matrix ist wiederum eine Markovschen Übergangsmatrix Q und µ ist

Q-invariant.

Für f , g ∈ L2 (µ) seien P, Q : L2 (µ) → L2 (µ) die entsprechenden Markov Operatoren, also

P f ( x ): =

∑ p( x, y) f (y)

und

Q f ( x ): =

∑ p∗ ( x, y) f (y) .

x

y

Dann folgt:

h P f , gi =

=

∑ P f ( x) g( x)µ( x) = ∑ f (y) g( x) p( x, y)µ( x)

x,y

x

∑ f (y) g( x ) p

∗

(y, x )µ(y) = ∑ f (y) Qg(y)µ(y) = h f , Qgi

y

x,y

i.e. P∗ = Q, Q ist also der adjungierte Operator zu P und somit ist P genau dann

selbstadjungiert, wenn

∀ x, y ∈ Ω :

µ( x ) p( x, y) = µ(y) p(y, x ) .

(12)

Ist nun P = ( p( x, y)) eine beliebige Markovsche Übergangsmatrix auf Ω und existiert eine Verteilung µ auf Ω, die die Bedingung (12) erfüllt, so nennt man µ eine

reversible Verteilung für P; reversible Verteilungen (für P) sind stets stationäre

Verteilungen (bzgl. P).

Satz 2.3.1 (Ergodensatz) Sei P eine Markovsche Übergangsmatrix auf einer endlichen

Menge Ω. Falls P der Positivitätsbedingung genügt, dann gilt für alle f ∈ L2 (µ):

1

lim

n n+1

n

∑ f (xj ) = ∑

j =0

f ( x )µ( x )

x ∈Ω

wobei wir die Folge x j ∈ Ω wie folgt wählen: x0 ist beliebig; haben wir xn ∈ Ω gewählt,

so wählen wir xn+1 ∈ Ω mit Wahrscheinlichkeit p( xn , xn+1 ).

Zyklische, tridiagonale Markovsche Übergangsmatrizen: Sei Ω = {0, . . . , N −

1} = Z N , p( j, j + 1) = p( j), p( j, j) = r ( j) und p( j, j − 1) = q( j). In diesem Fall

reduziert sich die Bedingung (12) auf µ( j) p( j) = µ( j + 1)q( j + 1). P besitzt genau

dann eine reversible Verteilung, wenn

N −1

∏

j =1

p ( j − 1)

=1.

q( j)

Dann ist

∀n ∈ Ω :

n −1

µ(n) = c ∏

j =0

p( j)

,

q ( j + 1)

(13)

die reversible Verteilung (c > 0 ist so zu wählen ist, daß ∑nN=−01 µ(n) = 1). Falls

z.B. p( N − 1) = q(0) = 0, dann besitzt P eine reversible Verteilung. Beachtenswert ist, daß die Diagonalwerte r ( j) für µ keine Rolle spielen.

2 MARKOVKETTEN

26

Irrfahrt mit Barriere und Drift: Ω = N0 , p( j, j + 1) = p( j), p( j, j − 1) = q( j)

mit q0 = 0, q( j + 1) = e−U ( j) und p( j) = e−U ( j+1) . Die reversible Verteilung ist

gegeben durch

e −U ( j )

(14)

µ ( j ) = ∞ −U ( k )

∑ k =0 e

Also z.B. für U ( j) = j log 2: µ( j) = 2− j /2.

Diffusionsmodell von Bernoulli-Laplace: Die reversible Verteilung ist die hypergeometrische Verteilung:

n

2N − n

2N

µ( j) =

/

.

j

n−j

n

i.e. die Wahrscheinlichkeit aus einer Stichprobe des Umfangs n aus 2N genau j

schwarze Kugeln auszuwählen.

Die Bedingung für eine reversible Verteilung reduziert sich auf die Rekursion:

µ( j) p( j, j + 1) = p( j + 1, j)µ( j + 1), i.e.:

N · · · ( N − j + 1) n · · · ( n − j + 1)

j!( N − n + j) · · · ( N − n + 1)

N!n!( N − n)!

n

N!( N − n)!

=

=

j ( N − j)!( N − n + j)!

( N − j)!(n − j)!j!( N − n + j)!

n

N!( N − n)!(2N − n)!

N!( N − n)! n

2N − n

=

=

j ( N − j)( N − n + j)!(2N − n)!

(2N − n)! j

n−j

µ( j) =

Ehrenfest Kette: Die reversible Verteilung ist die Binomialverteilung µ( j) = ( Nj )2− N ,

dann aus der Rekursion: µ( j) p( j, j + 1) = p( j + 1, j)µ( j + 1), folgt:

p( j, j + 1)

N−j

( N − j) · · · N

µ( j) =

µ( j) =

µ (0)

p( j + 1, j)

j+1

( j + 1) !

N

N!

µ (0) =

µ (0) .

=

( j + 1) ! ( N − j − 1)

j+1

µ ( j + 1) =

Irrfahrt auf einem einfachen Graph (V, E): Die reversible Verteilung ist gegeben

durch

deg( x )

.

∀ x ∈ V : µ( x ) =

∑y∈V deg(y)

2.4 CLT für Markovketten

Sei Xn eine Markovkette auf dem endlichen Zustandsraum Ω mit der Übergangsmatrix P. Ferner erfülle P die Positivitätsbedingung. Dann gibt es nach Satz 2.1.1

2.5 Ein probabilistisches Modell der Diffusion

27

ein eindeutig bestimmtes stationäres Wahrscheinlichkeitsmaß µ auf Ω. Sei für

f : Ω → R: h f i: = ∑ x f ( x )µ( x ).

Satz 2.4.1 Für alle Funktionen f : Ω → R mit h f i = 0 konvergiert

1 n −1

√ ∑ f (Xj )

n j =0

in der Verteilung gegen eine normalverteilte Zufallsvariable mit dem Mittelwert 0 und

der Varianz σ2 = h P f 2 − ( P f )2 i.

Beispiel: Sei Ω = Z N und p( x, y) = 1/2 falls y = x − 1 oder y = x + 1. Dann

ist die stationäre Verteilung die Gleichverteilung auf den N Punkten von Ω. Sei

f : Ω → R mit h f i = 0, dann ist

P f ( x ) = 21 ( f ( x − 1) + f ( x + 1))

und

P f 2 ( x ) = 12 ( f ( x − 1)2 + f ( x + 1)2 )

und damit: P f 2 ( x ) − ( P f )2 ( x ) = 14 ( f ( x + 1) − f ( x − 1))2 , also: σ2 = 14 ∑ x ( f ( x +

1) − f ( x − 1))2 . Insbesondere folgt z.B. für f ( x ) = cos(2πx/N ): σ2 = N sin2 (2π/N )/2,

also für z.B. N = 3, 4, 6: σ2 = 9/8, 2, 9/4.

2.5 Ein probabilistisches Modell der Diffusion

Seien ∆x, ∆t > 0 und b : R → R. Ein Teilchen (oder was auch immer) bewege

sich auf R, nach folgender Vorschrift:

1. Zum Zeitpunkt t = 0 befindet sich das Teilchen im Punkt y ∈ R.

2. Ist das Teichen zum Zeitpunkt t = 0, ∆t, 2∆t, . . . im Punkt x, so ist es zum

Zeitpunkt t + ∆t mit Wahrscheinlichkeit 1/2 entweder im Punkt x − b( x )∆t + ∆x

oder im Punkt x − b( x )∆t − ∆x.

Dies ist nichts anderes als eine Markovkette mit dem Zustandsraum S = R und

dem Markovoperator

∀ f ∈ C ∞ (R) : P∆t f ( x ): = 21 ( f ( x − b( x )∆t + ∆x ) + f ( x − b( x )∆t − ∆x )) . (15)

Die Funktion b heißt die Drift der Diffusion; für b = 0 ist dies eine einfache

n und u ( t, x ): = P f ( x ); dann gilt

lineare Irrfahrt. Seien n ∈ N0 , t = n∆t, Pt : = P∆t

t

nach dem Satz von Taylor:

u(t + ∆t, x ) − u(t, x ) = P∆t Pt f ( x ) − Pt f ( x )

= 12 (u(t, x − b( x )∆t + ∆x ) − 2u(t, x ) + u(t, x − b( x )∆t − ∆x ))

=

1

2 ( u ( t, x

− b( x )∆t + ∆x ) − 2u(t, x − b( x )∆t) + u(t, x − b( x )∆t − ∆x ))

+u(t, x − b( x )∆t) − u(t, x )

= 12 ∂2x u(t, x − b( x )∆t)(∆x )2 − ∂ x u(t, x )b( x )∆t + o((∆x )2 ) + o(∆t) .

2 MARKOVKETTEN

28

Wählen wir nun (∆x )2 = ∆t, so erhalten wir für ∆t → 0 die partielle Differentialgleichung:

(16)

∂t u(t, x ) = 21 ∂2x u(t, x ) − b( x )∂ x u(t, x ) .

Ist b = 0, so nennt man dies die Wärmeleitungsgleichung auf R. Für alle y ∈ R

ist die Funktion

py (t, x ): = √ 1 exp − 2t1 ( x − y)2

(17)

2πt

die einzige Lösung der partiellen Differentialgleichung (16) (für b = 0) mit folgenden Eigenschaften:

py (t, x ) ≥ 0,

Z

R

py (t, x ) dx = 1 und ∀ r > 0 : lim

t ↓0

Z y +r

y −r

py (t, x ) dx = 1 .

(18)

Die ersten beiden Eigenschaften besagen, daß x 7→ py (t, x ) die Dichte einer

Wahrscheinlichkeitsverteilung ist: die Wahrscheinlichkeit das Teilchen zum Zeitpunkt t im Intervall (α, β) anzutreffen ist

Z β

a

py (t, x ) dx .

(19)

Die dritte Eigenschaft spiegelt die Startbedingung wider: Zum Zeitpunkt t = 0

befindet sich das Teilchen im Punkt y, d.h. die Wahrscheinlichkeit das Teilchen in

einer beliebig Umgebung von y zu finden ist 1.

2.6 PageRank

Cf. [?] p.367-p.370: Folgendes Bewertungsverfahren von Seiten kommt bei der

Suchmaschine Google zum Einsatz: Die Links von n Seiten beschreibt man durch

die Adjazenzmatrix A = ( a jk ) des entsprechenden Graphs, also a jk = 1, falls es

einen Link von Seite j auf Seite k gibt und a jk = 0 falls es keinen Link von Seite

j auf Seite k gibt (a jj setzt man stets gleich 0). Eine der einfachsten Formen einer

Bewertung besteht nun darin einer Seite k die Anzahl der Seiten zuzuordnen, die

auf sie verweisen, also ordnet man der Seite k die Bewertung

µk : =

∑ a jk

j

zu. Will man Seiten, die auf wenige andere Seiten verweisen, mehr Gewicht geben als stark verlinkten Seiten, so definiert man

µk : =

∑ a jk /n j

j

wobei

n j : = deg− ( j) =

∑ a jk .

k

Das Problem dieser Festlegung ist nun, daß ein Betreiber einer Seite beliebig viele

andere Seiten erstellen kann, die nur auf seine Seite verweisen. Dies umgeht man

2.7 Hastings bzw. Gibbs Algorithmus

29

i.w. dadurch, daß man jeder Seite j nicht das Gewicht 1/n j zuweist, sondern das

Gewicht µ j /n j ; wir erhalten somit für die Bewertungen das lineare Gleichungssystem

µk = ∑ µ j a jk /n j

j

oder mit P = ( p jk ), p jk : = a jk /n j : µ = µP, wobei µ = (µ1 , . . . , µn ). µ ist also ein

stationäres Maß der stochstischen Matrix P. Erfüllt P die Positivitätsbedingung,

so ist µ eindeutig bestimmt und kann i.w. durch Iteration berechnet werden. Gibt

es aber z.B. zwei Seiten, die nur gegenseitig aufeinander verweisen, so konvergiert Pn , n ∈ N, nicht – die Folge der Mittelwerte n−1 (ν + νP + . . . + νPn−1 ) kann

hingegen konvergieren. Man weist daher jeder Seite nur einen Teil α ∈ (0, 1) an

Bewertung zu, die durch ihre Vernetzung bestimmt ist und der restliche Bewertungsanteil kommt jeder Seite für sich genommen zu. Sei also ν = (1, . . . , 1), dann

erfüllt µ das lineare Gleichungssystem

µ = (1 − α)ν + αµP

i.e.

µ = (1 − α)(1 − αP)−1 ν

d.h. µ = (1 − α)(1 + αP + α2 P2 + · · ·)ν.

2.7 Hastings bzw. Gibbs Algorithmus

Hastings: 4 Sei Ω eine diskrete Menge und µ ein Wahrscheinlichkeitsmaß auf Ω

mit µ( x ) > 0 für alle x ∈ Ω. Sei Xn eine Markovkette in Ω mit der irreduziblen

Markovschen Übergangsmatrix p( x, y). Wir definieren nun eine weitere Markovsche Übergangsmatrix q( x, y) durch

∀ x 6= y :

q( x, y) = p( x, y) ∧

µ(y)

p(y, x ) = p( x, y) ∧ p∗ ( x, y) .

µ( x )

(20)

und q( x, x ) = 1 − ∑y q( x, y). Das Maß µ ist dann nach der Beziehung (12) ein

reversibles Maß für q( x, y):

µ( x )q( x, y) = µ( x ) p( x, y) ∧ µ(y) p(y, x ) = µ(y)q(y, x ) .

Ferner hängt q nur von dem Verhältnis µ(y)/µ( x ) ab, das i.a. viel leichter zu

bestimmen ist als die absoluten Werte µ( x ), x ∈ Ω. Ist p selbst symmetrisch, also

p( x, y) = p(y, x ), so folgt:

∀ x 6= y :

q( x, y) = (1 ∧ µ(y)/µ( x )) p( x, y) .

4 http://en.wikipedia.org/wiki/Metropolis-Hastings

algorithm

2 MARKOVKETTEN

30

Wie realisiert man – ausgehend von der Markovkette Xn – eine Markovkette

Yn mit der Markovschen Übergangsmatrix q( x, y), also P(Yn+1 = y|Yn = x ) =

q( x, y)? Sei Yn = x, Xn+1 = y mit Wahrscheinlichkeit p( x, y) und

p: =

q( x, y)

µ(y) p(y, x )

= 1∧

p( x, y)

µ( x ) p( x, y)

Sei β n+1 eine unabhängige Bernoulli Variable mit P( β n+1 = 1) = p und P( β n+1 =

0) = 1 − p. Falls β n+1 = 1, dann setze Yn+1 = Xn+1 = y, andernfalls setzen wir

Yn+1 = Xn = x. Es gilt dann

P(Yn+1 = y|Yn = x ) = P( β n+1 = 1)P( Xn = y| Xn = x ) = q( x, y),

i.e. Yn ist eine Markovkette mit der Markovschen Übergangsmatrix q( x, y).

Im folgenden Beispiel ist weder Ω noch das invariante Maß endlich!

Beispiel: Sei Ω = Z, p( x, x ± 1) = 1/2 – dann ist das invariante Maß das Zählmaß.

2

Ferner sei µ( x ) = Ze− x . In diesem Fall ist q( x, x + 1) = 1/2 für x ≤ −1 und

e−2x−1 /2 für x ≥ 0, q( x, x − 1) = 1/2 für x ≥ 1 und e2x−1 /2 für x ≤ 0 q( x, x ) =

1 − q( x, x + 1) − q( x, x − 1) (cf. tridiagonale Markovsche Übergangsmatrizen).

Der Hastings Algorithmus funktioniert auch in einem viel abstrakteren Rahmen:

Sei λ ein Borelmaß auf dem Polnischen Raum S, Xn eine reversible

Markovkette

R

mit Werten in S – also P( x, A): = P( Xn+1 ∈ A| Xn = x ) und B P( x, A) λ(dx ) =

R

R −U

−1

e dλ <

A P ( x, B ) λ ( dx ) – und U : S → R eine meßbare Funktion, so daß Z : =

−

U

(

x

)

∞ – dann ist µ(dx ): = Ze

λ(dx ) ein Wahrscheinlichkeitsmaß. Sei Yn = x; wir

wählen Xn+1 entsprechend der Verteilung P( x, .). Falls U ( Xn+1 ) < U ( x ), dann

setzen wir: Yn+1 = Xn+1 , andernfalls wählen wir eine unabhängige 0, 1-wertige

Zufallsvariable β mit P( β = 1) = eU ( x)−U ( Xn+1 ) und setzen Yn+1 = Xn+1 falls

β = 1 und Yn+1 = x falls β = 0.

Beispiel: Sei Ω = [0, 1], Xn eine Folge unabhängig und gleichverteilter Zufallsvariablen mit Werten in [0, 1]. Sei Yn = x Zunächst wählen wir ‘zufällig’– i.e.

entsprechend der Gleichverteilung auf [0, 1] – einen Punkt y ∈ [0, 1] und setzen Yn+1 = y falls U (y) < U ( x ); falls U (y) ≥ U ( x ), dann wählen wir eine unabhängige 0, 1-wertige Zufallsvariable β mit P( β = 1) = eU ( x)−U (y) und setzen

Yn+1 = y falls β = 1 und Yn+1 = x falls β = 0.

Beispiel: Sei B ein konvexer, symmetrischer Körper (i.e. B ist kompakt, konvex,

symmetrisch und B◦ 6= ∅) in Rn , Xn eine Folge unabhängig und gleichverteilter

Zufallsvariablen mit Werten in B und K eine konvexer Körper in Rn . Sei Yn = x

und Xn+1 = y ein ‘zufällig’ gewählter Punkt in B. Wir setzen Yn+1 = x + y falls

x + y ∈ K und sonst Yn+1 = x. Das normalisierte Lebesguemaß auf K ist dann

das reversible Wahrscheinlichkeitsmaß.

Wie erzeugt man die Gleichverteilung auf z.B. B = B2n oder B = B1n ?

2.7 Hastings bzw. Gibbs Algorithmus

31

1. Seien Z1 , . . . , Zn unabhängig und normalverteilt und R eine von Z1 , . . . , Zn unabhängige Zufallsvariable auf dem Wahrscheinlichkeitsraum ((0, 1), λ) mit R(t) =

t1/n , dann gilt λ( R ≤ r ) = r n und

X: =

R( Z1 , . . . , Zn )

q

∑ Z2j

ist gleichverteilt auf B2n .

2. Seien Z1 , . . . , Zn unabhängig und Laplace-verteilt, i.e. Z1 besitzt die Dichte

1 −| x |

und R wie oben, dann ist

2e

X: =

R( Z1 , . . . , Zn )

∑ | Zj |

gleichverteilt auf B1n .

Gibbs: 5 Dies ist i.w. eine vereinfachte Form des Hastings-Algorithmus’: Sei S

eine diskrete Menge, N ∈ N, U eine Zufallsvariable mit Werten in S N und µ( x ) =

P(U = x ). Für ω, η ∈ S N schreiben wir ω ∼ j η, wenn für alle k 6= j gilt: ωk = ηk

(ω und η unterscheiden sich daher höchstens in der j-ten Komponente). Definiere

q(ω, η ): =

(

µ(η )

N ∑ζ ∼ ω µ(ζ )

j

0

falls η ∼ j ω

sonst

so ist µ ein reversibles Maß für q, denn unterscheiden sich ω und η nur in der

j-ten Komponente, so gilt ζ ∼ j ω genau dann, wenn ζ ∼ j η

µ(ω )q(ω, η ) =

µ(ω )µ(η )

µ(ω )µ(η )

=

= µ(η )q(η, ω ) .

∑ζ ∼ j x µ(ζ )

∑ζ ∼ j y µ(ζ )

Der Quotient µ(η )/ ∑ζ ∼ j ω µ(ζ ) ist die bedingte Wahrscheinlichkeit

P(Uj = η j |U1 = ω1 , . . . , Uj−1 = ω j−1 , Uj+1 = ω j+1 , . . . , UN = ω N )

denn dies ist

P(Uj = η j , U1 = ω1 , . . . , Uj−1 = ω j−1 , Uj+1 = ω j+1 , . . . , UN = ω N )

P(U1 = ω1 , . . . , Uj−1 = ω j−1 , Uj+1 = ω j+1 , . . . , UN = ω N )

=

P (U = η )

.

P(U ∈ {ζ : ζ ∼ j ω })

Die der Übergangsmatrix q entsprechende Markovkette Yn auf S N realisiert man

auf folgende Weise: sei Yn = x, dann wählen wir mit Wahrscheinlichkeit 1/N

5 http://en.wikipedia.org/wiki/Gibbs

sampling

2 MARKOVKETTEN

32

eine der Komponenten aus; haben wir etwa j ausgewählt so setzen wir mit Wahrscheinlichkeit q( x, y): Yn+1 = y; Yn und Yn+1 unterscheiden sich dann nur in der

j-ten Komponente.

Ein Modell eines ferromagnetischen Metalls nach Ising: Cf. e.g. Wikipedia 6 Sei

A ⊆ Z3 endlich mit | A| = N und Ω = {−1, +1} A = {−1, +1} N – in diesem Fall

ist also S = {±1}. Wir interpretieren A als die Menge der Positionen von Atomen

eines kubischen Kristalls und für ω ∈ Ω und x ∈ A ω ( x ) = ±1 als den Spin des

Atoms in der Position x. Ist die Energie eines Zustandes ω ∈ Ω gegeben durch

H ( ω ): = α

∑ ω ( x) − 21 β ∑

x∈ A

ω ( x ) ω ( y ),

(21)

( x,y)∈ R

wobei ( x, y) ∈ R genau dann, wenn für ein j ∈ {1, 2, 3}: | x j − y j | = 1, Dann

ist nach dem Entropiesatz die Wahrscheinlichkeit den Zustand ω vorzufinden

gleich µ(ω ): = Z exp(− H (ω )/T ). Die Bestimmung der Normierungskonstante Z

erfordert jedoch die Berechnung aller möglichen 2 N Werte von H (ω ); also selbst

für die sehr geringe Anzahl von N = 100 Atomen ist diese Aufgabe nicht zu

bewältigen. Will man z.B. den Mittelwert einer Funktion F : Ω → R bestimmen,

so ist z.B. der Gibbs Algorithmus von Vorteil, der auf der Konstruktion einer

Markovkette beruht: sei ω ∼ x η, d.h. für alle y 6= x gelte ω (y) = η (y) und

η ( x ) = −ω ( x ); dann ist

q(ω, η ) =

e− H (η )/T

N (e− H (η )/T + e− H (ω )/T )

und

q(ω, ω ) =

e− H (ω )/T

.

N (e− H (η )/T + e− H (ω )/T )

In Nenner und Zähler von beiden Ausdrücken kürzen sich alle Summanden von

H, in denen x nicht vorkommt, also bleibt in H (ω )/T:

T −1 ω ( x ) α − β ∑ ω ( y ) .

z∈ R( x )

Setzen wir nun p( x ): = exp(−ω ( x )(α − β ∑z∈ R( x) ω (y))/T ), so erhalten wir:

q(ω, η ) =

1/p( x )

N ( p( x ) + 1/p( x ))

und

q(ω, ω ) =

p( x )

.

N ( p( x ) + 1/p( x ))

Wir wählen daher die Folge ω0 , ω1 , . . . von Zuständen auf folgende Weise:

1. Zum Zeitpunkt 0 setzen wir ω0 ( x ) = ±1 beliebig.

2. Sei ωn der Zustand zum Zeitpunkt n, dann wählen wir mit Wahrscheinlichkeit

1/N eine Position – etwa x – aus, bestimmen

p( x ): = exp(−ωn ( x )(α − β

6 http://en.wikipedia.org/wiki/Ising

model

∑

z∈ R( x )

ωn (y))/T )

2.8 Der Entropiesatz

33

und ändern den Spin des Atoms in Position x mit Wahrscheinlichkeit 1/( p( x )2 +

1).

3. Da µ die reversible (also stationäre) Verteilung dieser Markovkette ist gilt nach

Satz 2.3.1:

n

1

lim

∑ F (ω j ) = ∑ F (ω )µ(ω )

n→∞ n + 1

ω ∈Ω

j =0

2.8 Der Entropiesatz

Wir bezeichnen von nun an die Elemente des Zustandsraumes Ω mit {1, . . . , d}

und die Verteilungen auf der Menge Ω mit x; M1 (Ω): = { x ∈ R+d : x1 + · · · +

xd = 1} ist dann die Menge der Verteilungen auf Ω. Ferner sei H : Ω → R eine

beliebige Funktion. Für ( x1 , . . . , xd ) ∈ M1 (Ω) interpretieren wir wie oben xk als

die Wahrscheinlichkeit für den Zustand k (cf. Abschnitt 15.2). Ist F : Ω → R, so

nennt man ∑k F (k ) xk den Mittelwert von F bezüglich der Verteilung x1 , . . . , xd .

Die Funktionen n, e, Ent : M1 (Ω) → R seien schließlich definiert durch

d

n ( x ): =

∑

d

kxk ,

e ( x ): =

k =1

∑

d

H (k ) xk ,

k =1

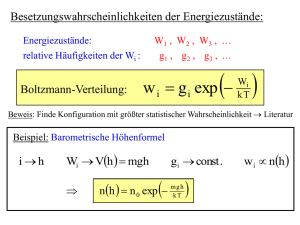

Ent( x ): = −

∑ xk log xk ,

(22)

k =1

i.e. n( x ) und e( x ) sind Mittelwerte bezüglich der Verteilung x (n( x ) ist i.a. die

mittlere Teilchenzahl, d.h. der Zustand k beschreibt ein Teilchensystem mit k Teilchen; H (k ) ist dann i.a. die Energie dieses Zustands). Da −Ent strikt konvex und

n, e : M1 (Ω) → R linear sind erhalten wir den sogenannten Entropiesatz: Unter den Bedingungen n( x ) = N und e( x ) = E gibt es genau eine Verteilung

( p1 , . . . , pd ) ∈ M1 (Ω) in der Ent ihr Maximum annimmt.

Sei M ( x ): = ∑ x j und

f ( x, λ1 , λ2 , λ3 ): = Ent( x ) − λ1 ( M ( x ) − 1) − λ2 (n( x ) − N ) − λ3 (e( x ) − E) .

In der Thermodynamik ist es üblich die Lagrange Multiplikatoren wie folgt zu

bezeichnen: 1/T: = λ3 , µ/T: = −λ2 und U/T: = −1 − λ1 . Es gilt dann für alle

k = 1, . . . , d:

pk = e(U +µk− H (k))/T wobei U = − T log ∑ e(µk− H (k))/T .

(23)

k

Die Werte von µ und T sind durch die Nebenbedingungen eindeutig festgelegt:

U, T und µ sind Funktionen von E und N. Im Punkt p nimmt die Funktion Ent

den Wert S an:

S = Ent( p) = − ∑ pk log pk

k

= − ∑ pk (U + µk − H (k))/T = −(U + µN − E)/T

k

(24)

2 MARKOVKETTEN

34

Dies ist eine der Grundgleichungen der Thermodynamik. Wir betrachten nun T

und µ als freie Variablen und U, N, S bzw. E als Funktionen von T und µ. Partielle

Differentiation der Beziehung ∑ pk = 1 nach µ bzw. T ergibt nach (23) und (24):

0 =

0 =

∑(∂µ U + k ) pk = ∂µ U + N

∑(−(U + µk − Hk )/T2 + ∂T U/T ) pk

= (−U + µN − E)/T 2 + ∂ T U/T = (S + ∂ T U )/T .

und damit:

∂µ U ( T, µ) = − N ( T, µ)

bzw.

∂ T U ( T, µ) = −S( T, µ) .

(25)

Ersetzt man die Konstanten H (k ) durch Funktionen H (k )(V ) eines Parameters

V, so ändern sich diese Beziehungen nur insofern als U, E, N und S dann auch

von V abhängen. Definiert man P: = −∂V U, so folgen die Grundgleichungen der

Thermodynamik

dU = − N dµ − S dT − P dV

und

E = U − µ∂µ U − T∂ T U .

(26)

Kennt man also die Funktion U (als Funktion von T, µ und V), so erlauben diese

Gleichungen die Bestimmung der übrigen thermodynamischen Größen. In der

Thermodynamik heißen V, T, µ, U, E, N, S bzw. P das Volumen, die Temperatur,

das chemische Potential, das thermodynamische Potential, die Energie, die Teilchenzahl, die Entropie bzw. der Druck. Ferner nennt man die durch F: = E − TS,

H: = E + PV und G: = H − TS definierten Funktionen die freie Energie, die Enthalpie und die freie Enthalpie.

Beispiel: Unter allen Verteilungen auf Ω: = {1, . . . , d} besitzt die Gleichverteilung

pk = 1/d maximale Entropie.

Beispiel: Wir wollen unter allen Verteilungen auf Ω: = N0 jene Verteilung p ∈

M1 (N0 ) finden, die unter der Bedingung ∑n nxn = N ∈ R+ maximale Entropie

besitzt. Nach (23) gilt für alle n ∈ N0 mit s: = U/T und t: = µ/T:

pn = es+tn

mit

s = − log( ∑ etj ) = log(1 − et )

j ≥0

also

es = 1 − et

Aus der Bedingung ∑ npn = N folgt:

N=

∑ jes+tj = es ∑ ∂t etj = es ∂t (1 − et )−1 = (1 − et )−2 es+t = e−2s+s+t .

j ≥0

j ≥0

Woraus folgt: t = s + log N. Aus et = 1 − es folgt dann: t = log(1 − es ) =

s + log N, also: 1 − es = Nes , d.h. es = ( N + 1)−1 und et = N ( N + 1)−1 . Damit

erhalten wir: pn = N n /( N + 1)n+1 – man nennt dies die geometrische Verteilung

auf N0 mit dem Mittelwert N.

2.8 Der Entropiesatz

35

Beispiel: Bestimmen Sie jene Verteilungen auf Ω: = Z die unter den Bedingungen

∑ kpk = 0 und ∑ k2 pk = 2E maximale Entropie besitzt. Dies ist ein Modell einer Geschwindigkeitsverteilung: die möglichen Geschwindigkeiten sind der Zustandsraum Z, die mittlere Geschwindigkeit soll verschwinden und die mittlere

Energie soll E sein!

Thermodynamische Prozeße: Bisher betrachteten wir V, T, µ als freie Variablen

und alle weiteren Größen als Funktionen dieser drei Variablen. Man kann jedoch

unter all diesen Größen drei beliebige als freie Variablen auswählen und alle weiteren als Funktion dieser drei betrachten. Wählt man z.B. T, V und N als freie

Variablen, so folgt aus den Grundgleichungen 26:

∂ T U dT + ∂V U dV + ∂ N U dN = dU = − N dµ − S dT − P dV

= − N (∂ T µ dT + ∂V µ dV + ∂ N µ dN ) − S dT − P dV

= (− N∂ T µ − S) dT + (− N∂V µ − P) dV + (− N∂ N µ) dN

d.h.: ∂ T U + N∂ T µ = −S, ∂V U + N∂V µ = − P und ∂ N U + N∂ N µ = 0 Mit F: =

E − TS und ST = −(U + µN − E) folgt: F = U + µN, also: ∂ T F = ∂ T U + N∂ T µ,

∂V F = ∂V U + N∂V µ und ∂ N F = ∂ N U + ∂ N µ + µ; also erhalten wir:

S = −∂ T F,

P = −∂V F,

µ = ∂N F .

(27)

In der Chemie wählt man häufig T, P und N als freie Variablen:

S = −∂ T G,

V = ∂ P G,

µ = ∂N G .

(28)

Wir betrachten der Einfachheit halber im weiteren N als konstant und T, V als

freie Variablen. Unter einem thermodynamischen Prozeß versteht man eine Kurve t 7→ ( T (t), V (t)); wir setzen:

E(t): = E( T (t), V (t)),

S(t): = E( T (t), V (t)),