Lernpsychologie

Werbung

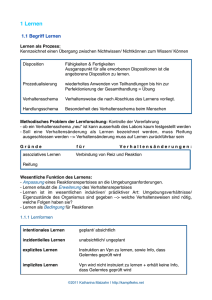

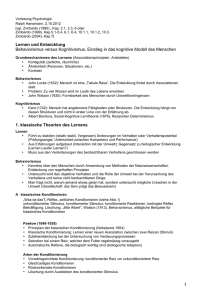

Lernpsychologie Definition von Lernen (ein Satz) / Abgrenzung (Gemeinsamkeit und Unterschied) von Lernen, Reifung und Evolution in 2-3 Sätzen. Arbeitsdefinition Lernen: „Mittelfristige Veränderungen von Verhalten als Folge von Erfahrungen“ Verhalten: willkürliches Verhalten, Instinkte, Reflexe und physiologische Reaktionen Erfahrung: Einwirkung von Sinnesreizen auf das Nervensystem mittelfristig: nicht kurzfristig, kein aktueller Reflex Abgrenzung von Reifung: kein Lernen, da nicht erfahrungsabhängig gengesteuerte Entfaltung von Funktionen (Motorik, Pubertät) Abgrenzung von Evolution: kein individuelles Lernen extrem langsame Veränderung von Verhaltensdispositionen von Arten über Generationen durch (natürliche) Selektion Wichtigster Vorteil der experimentellen Methode gegenüber der Beobachtung in einem Satz. Experiment ermöglicht Kausalaussagen, weil ich Drittvariablen kontrollieren kann Bei der Beobachtung sind Drittvariablen unbekannt, daher Kausalität unklar Anwendung der Begriffe UV, AV, IV in 2-3 Sätzen. Intervenierende Variable: rein theoretischer Natur und kann nicht direkt beobachtet werden. Zwischen Ursache und Wirkung, also UV und AV, gibt es nicht im Behaviorismus unabhängige Variable: Ursache, kann verändert werden, wie Wellenlänge abhängige Variable: Wirkung, wird beobachtet, Veränderung der Wahrnehmung oder der Auftretenswahrscheinlichkeit Vier wichtige Gütekriterien wissenschaftlicher Theorien nennen (und in Stichpunkten erklären) können. Notwendig: Testbarkeit (Vorbedingung, widerlegen oder bestätigen muss möglich sein) Formale Adäquatheit (Vorbedingung, nicht unlogisch, mit vernünftigen Definitionen) - Fruchtbarkeit (Wie groß ist der Einfluss auf Psychologie?) Bestätigung (wenn sie testbar ist, wie häufig erfolgreich getestet?) Generalisierbarkeit (auf möglichst viele anwendbar, kann mehr Phänomene erklären; Lerntheorien z.B.) Einfachheit (soll nicht unnötige Dinge enthalten; nicht notwendig, aber einfach ist vorzuziehen) Die wichtigste Besonderheit des Behaviorismus gegenüber anderen Ansätzen in der Psychologie in 1-2 Sätzen. - Beobachten von Verhalten - Naturwissenschaft - Introspektion nicht nützlich und nicht zulässig - keine Trennlinie zwischen Mensch und Tier; egal, ob ich Mensch oder Tier untersuche - viel tierexperimentelle Forschung Bemühen um Einfachheit durch Induktion wird versucht auf allgemeine Gesetze zu schließen, Betonung äußerer Ereignisse - Abneigung ggüber Spekulation über Nichtbeobachtbares Kognitionspsychologischer Ansatz: mentale Inhalte Kognition, alle unbeobachtbaren Vorgänge im Gehirn Tierexp. Forschung in der Lernpsychologie (jeweils 2 können): Pro - Reaktanz der Messung gering (kein anderes Verhalten unter Beobachtung, Menschen neigen dazu sich anders zu verhalten) - Placeboeffekte gering, keine Erwartungseffekte - geringe Kosten, hohe Verfügbarkeit (mit Einschränkungen) - vorherige Lernerfahrung kann genau kontrolliert werden - Verhaltensmechanismen von Tieren sind relativ einfach - Ethische Aspekte: Gehirn in Scheiben schneiden, naiver Versuchstiere Contra – Komplexe Leistungen nicht untersuchbar – Selbst bei einfachen Verhaltensweisen ist nicht immer klar, ob Mensch und Tier sie gleich lösen – Ethische Probleme Aristoteles Gesetze der Assoziation als Stichpunkte mit Beispiel -Kontiguität (Nähe in Zeit und Raum), Tisch und Stuhl, spielt besondere Rolle in der Lernpsychologie -Ähnlichkeit, Apfel und Birne -Kontrast, Tag und Nacht Grundannahme des britischen Empirismus in einem Satz - Alles Wissen geht von der Erfahrung (Empirie) aus - Der Mensch wird als tabula rasa (leere Tafel) geboren (J.Locke) - Ablehnung der Hypothese angeborener Ideen (wie sie z.B. von Kant als Nativisten vertreten wurde) - Alles Wissen ist gelernt, Assoziation grundlegendes Lernprinzip Die reduktionistische Gedächtnistheorie von Mill in 3-4 Sätzen - Hierarchie von Ideen: Am Anfang stehen die einfachen Sinneseindrücke, wenn mindestens zwei einfache Sinneseindrücke zusammen auftreten entstehen zunächst einfache und später komplexe Ideen. Diese komplexen Ideen können sich zu Duplexideen kombinieren (Mill) Beispiel Haus: komplexe Ideen sind Ziegelstein und Mörtel, Duplexidee ist Fenster, Verknüpfung von verschiedenen Duplexideen bilden dann Haus → Jede komplexe Idee ist nichts weiter als die Summe einfacherer Ideen und diese Zurückführung kann fortgeführt werden bis man bei den Elementen der Wahrnehmung (Vorstellung) ankommt (wie in Chemie, Reduzierung auf einzelne Moleküle) semantische Netzwerke sind Beispiele dafür, auch Embodiment Wie berechnet Ebbinghaus die Ersparnis (ein Satz/Term)? - lernte Listen mit sinnlosen (um Vorerfahrung auszuschließen) Silben mit 3 Buchstaben auswendig Maß für Gedächtnis/Lernleistung= Maß der Ersparnis Wenn ich die Liste, nachdem ich sie einmal gelernt habe wieder lerne, muss ich dann den gleichen Aufwand aufbringen wie beim ersten Mal oder ist der Aufwand geringer? Der geringere Aufwand im Vergleich zum ersten Mal ist die Ersparnis. Ersparnis = (alt-neu)/alt Was ist Überlernen und wie wirkt sich das aus (2 Sätze)? Was passiert, wenn man nicht aufhört zu lernen, nachdem man die Liste fehlerfrei kann?Überlernen führt zu verbesserter Leistung und Ersparnis beim Wiederholen. Wie maß Ebbinghaus den Einfluss von Nähe und Abfolge als Merkmale der Kontiguität (2-3 Sätze)? Kontiguität: Nähe in Raum und Zeit Kontiguitätsprinzip: Die Stärke der Assoziation zwischen zwei Items hängt von der ihrer Nähe ab; je näher, desto größer (erst Liste 0 gelernt; dann aus Liste 0 neue Liste gebildet, wo alle Silben bereits einmal vorgekommen sind, aber Reihenfolge verändert (je 1 Item übersprungen bis etwa Hälfte, dann wieder oben beim 2. Item angefangen/beim 2. Versuch 2 Items übersprungen) Ergebnis: Ersparnis wird geringer, Fazit: Stärke der Assoziation hängt von der Nähe zwei aufeinanderfolgenden Items ab Grenze des Kontiguitätprinzips: Nicht nur Kontiguität, sondern auch die Abfolge wichtig (Beweis durch Inversion/ Rückwärtsgerichtete Assoziation, er sagte die Liste rückwärts auf. Definition von Habituation und ein Beispiel (Furcht, Schreck oder OR) in je einem Satz. Abnahme der Reaktionsstärke nach wiederholter Präsentation des Stimulus, der die Reaktion auslöst (Beispiel Schreck, Furcht oder OR, beim ersten Donner eines Gewitters erschrecke ich mich ganz doll, dann immer weniger) Nonassoziatives Lernen (auch Sensitisierung), da nur 1 Reiz dargeboten wird Begründung, warum Habituation, etwa der OR, adaptiv ist (1 Satz). Habituation ist adaptiv und universell Adaptivität (nützlich, angemessen) führt dazu, dass ein Tier in seiner natürlichen Ugebung besser überlebt Orientierungsreaktion (OR) Ein neuer optischer oder akustischer Reiz führt zu einer OR, einer Hinwendung der Sinnesorgane (Kopfdrehen, Ohrenspitzen, Pupillenvergrößerung) zum Ort des Reizes Funktion: Zuwendung zu einem neuen Reiz (OR) ist adaptiv, denn es muss festgestellt werden, ob der Reiz positive oder negative Fitnesskonsequenzen hat; nicht vorteilhaft auf unrelevante Reize zu reagieren → Ablenkung. Sie können auf die Stichworte Verlauf, Zeit, erneutes Lernen, Reizintensität, Überlernen und Generalisierung allgemeine Prinzipien der Habituation nennen. 1. Verlauf: Typischerweise kontinuierliche, anfangs stärkste, Abnahme der Reaktionsstärke. 2. Zeit: Spontanerholung bei längerer Stimulationspause (aber schwächer) 3. Erneutes Lernen: Ersparnis 4. Reizintensität: Reaktionen auf intensive Reize sind stärker und habituieren weniger. 5. Überlernen: Unter-null-Habituation. Der Lernprozess geht auch weiter, wenn Habituation vollständig ist 6. Generalisierung: Unähnliche Reize führen zur Dishabituation (Tool der Entwicklungspsychologie, Balkensichtbeispiel), bei ähnlichen Reizen bleibt die Habituation bestehen Ort der Habituation (motorisch, sensorisch). Warum ist Habituation nicht einfach Ermüdung? Alle Ergebnisse deuten darauf hin, dass sensorische (vor motorischen Stadien) der neuralen Reizleitung von der Habituation betroffen sind. Nicht die Reaktion habituiert und ermüdet, sondern der Reiz ist nicht mehr geeignet eine Reaktion auszulösen. Keine Ermüdung der Reaktion! Aber warum??? Einschub zum besseren Verständnis: Beim KK werden zwei Reize, der unkonditionierte Reiz (US) und der konditionierte Reiz (CS), zusammen dargeboten; als Folge der gemeinsamen Darbietung verändert sich die Reaktion auf den CS, die konditionierte Reaktion (CR) genannt wird. Eine elementare Form des assoziativen Lernens, bei der die Bildung einer Assoziation zwischen zwei Elementen betrachtet wird. Beim KK werden CS und US unabhängig vom Verhalten des Organismus vorgegeben (Unterschied zum operanten Konditionieren). Welche Phasen unterscheidet man beim Klassischen Konditionieren (Begriffe und Erklärung!)? Besteht aus 4 Phasen: 1. Kontroll-/Testphase 2. Konditionierungsphase 3. Löschungsphase 4. Spontanerholung 1. In der Kontrollphase werden die beteiligten Reize vorgegeben und die möglichen Reaktionen getestet. Ein Reiz ist der US (unkonditionierter Reiz; Reaktion, die das Tier nicht gelernt hat, zum Beispiel Speichelfluss auf Fleischpulver) & ein neutraler Reiz, z.B. Glockenton. 2. Konditionierungsphase: Durch immer dieselbe Wiederholung des ursprünglich neutralen Reizes, nun CS und des unkonditionierten Reizes, US, lernt das Tier eine Assoziation von zwei Reizen und „erwirbt“ sich so sein Wissen. Es folgt eine Speichelsekretion des Hundes. 3. Löschungsphase: Es wird immer wieder nur der konditionierte Reiz, CS, dem Tier dargeboten und das Fleischpulver als unkonditionierter Reiz weggelassen. Wenn Konditionierung stattgefunden hat, sollte allein der CS eine Speichelabsonderung, CR auslösen. 4. Die Spontanerholung basiert auf dem Auslösen der konditionierten Reaktion in schwacher Form nach einer Ruhepause, sobald die Glocke oder das Licht dargeboten wurden. Sie ist gekennzeichnet durch das Wiederauftreten einer scheinbar gelöschten konditionierten Reaktion, der keine neuen Durchgänge mit beiden Reizen vorausgegangen ist. Welche Reize und Reaktionen unterscheidet man beim KK (Begriffe und Erklärung)? Der unkonditionierte Reiz (US) löst immer eine Reaktion aus, ohne vorherige Konditionierung. In dem typisch Pawlow’schen Experiment ist dies das Fleischpulver, das eine Speichelabsonderung auslöst ohne dass eine Konditionierung erfolgte. Dieser Reiz ist angeboren und braucht somit nicht erlernt werden. Der Speichelfluss, den wir schon erwähnt haben, ist in diesem Zusammenhang die unkonditionierte (UR) Reaktion. Dies ist die ursprüngliche Reaktion auf den unkonditionierten Reiz. Der konditionierte Reiz (CS) ist ein zuvor neutraler Reiz, der infolge der Assoziation mit einem unkonditionierten Reiz eine konditionierte Reaktion auslöst. Im Experiment ist es entweder die Glocke oder das Licht, die an die Stelle des konditionierten Reizes tritt und auch wieder einen Speichelfluss auslöst. Somit kann der Speichelfluss auch eine konditionierte Reaktion (CR) beziehungsweise bedingte Reaktion darstellen. In diesem Zusammenhang ist die konditionierte Reaktion die erlernte oder erworbene Reaktion auf einen neutralen Reiz, das diese Reaktion ursprünglich nicht hervorrufen kann. 4 Varianten des KK (Lidschluss, CER, GSR, Geschmacksaversion): Was ist jeweils US und UR, was kommt als CS in Frage? – Lidschlussreflex (protektiver Reflex), US Luftstoß (oder leichter Elektroschock), UR: Lidschluss, heftig und schnell, CS: Ton, Vibration viele Wiederholungen nötig – Konditionierte Unterdrückung/Konditionierte emotionale Reaktion (CER): US: unangenehmer Reiz, häufig Elektroschock, UR: Anzeichen von Schmerz und Vermeidung, Erstarren der Tiere, CS: Ton, Licht, aber recht lang, wird z.B. 60s vor dem US dargeboten wenig Wiederholungen reichen um deutliche Unterdrückung zu bewirken – elektrogalvanische Hautreaktion (GSR), US: Elektroschock, UR: Galvanische Reaktion, CS-Vielfalt: z.B. Wörter misst Veränderung der Leitfähigkeit der Haut/Lügendetektor – Geschmacksaversionslernen, US: Gift, das starke Übelkeit auslöst, Emetikum, harte Röntgenstrahlen, UR: Übelkeit, erbrechen, CS: ursprünglich neutraler Geschmack eines Nahrungsmittels, z.B. Wasser mit Saccharin (süß) extrem langanhaltend Wie unterscheiden sich CR und UR (4 Merkmale, in Stichworten)? Unterscheiden sich in ihrer Intensivität Nicht alle Bestandteile der UR werden Bestandteil der CR Die CR kann Reaktionen umfassen, die nicht zur UR gehören Die CR ist manchmal das Gegenteil der UR (oder teilweise) Sie können das Vorgehen bei der US-Abwertung beschreiben (3-4 Sätze). Devaluation (Abwertung): Schwächung der US-UR-Verknüpfung Zuerst werden CS (bei Rescorla Licht) und US (Krach) gemeinsam dargeboten bis Akquisition abgeschlossen ist und CS eine Reaktion auslöst. Dann wird US habituiert. Wirksamkeit US zu reduzieren, nachdem ein exzitatorischer CS geschaffen wurde Was wird durch US-Abwertung getestet (in einem Satz)? Durch die US- Abwertung soll die Verbindung zwischen US- Zentrum und Reaktionszentrum getestet werden. Es wird hauptsächlich mit der Habituation gearbeitet, um zu zeigen, dass eine US- Reaktions- Assoziation- Schwächung auch eine geringere Intensität der CR hervorruft. Somit wäre eine S-S Verbindung bestätigt, somit wird auch die SST (Pawlows Stimulussubstitutionstheorie: besagt, dass der CS durch wiederholte Kombi von CS und US ein Ersatz für den US wird, sodass die ursprünglich nur vom US ausgelöste Reaktion nunmehr auch vom CS ausgelöst wird) getestet. Einschub: Erstes Argument gegen die SST: CR ist nicht gleich UR Zweites Argument gegen die SST: CR wird erworben, auch wenn UR blockiert wird Drittes Argument gegen die SST: US- Abwertung schwächt die CR Auch Sättigung ist eine US-Abwertung. Viertes Argument gegen die SST: Sensorische Vorkonditionierung zeigt SS-Assoziationen Sensorische Vorkonditionierung (wenn vorher 2 neutrale Reize miteinander gepaart werden, aber nur einer darauf mit der US, lösen auch später beide eine CR hervor, folglich kann der 2. Reiz gar keine Assoziation mit der UR gebildet haben, da die beiden nie zusammen dargeboten wurden) Gegenteil von SST: Erwartungstheorie Sie können auf die Stichworte Akquisition, Löschung, Vergessen, Erneutes Lernen, Reizintensität und Generalisierung allgemeine Merkmale des KK- Lernens nennen. Akquisition: Messung, Verlauf, Trials 1. Die Stärke der CR wird verschieden gemessen, je nachdem, was untersucht wird 2. Typischer Verlauf der Kurve (sigmoid= s-förmig), dann Asymptote 3. Anzahl erforderlicher Trials abhängig vom System, das untersucht wird (bei Lidschlag zum Beispiel mehr) Timing von CS und US 1. bester Erfolg: delayed conditioning (verzögerte Konditionierung, CS wird dargeboten und einige Zeit später, aber während der CS noch an ist, der US.), CR klein bei langem SOA (Abstand Beginn CS&Beginn US). Optimales SOA hängt von Reizsystem ab. Bei Geschmacksaversion kann SOA ruhig beliebig ausgedehnt sein. 2. bester Erfolg: trace conditioning (Spurenkonditionierung) Erst wird der CS dargeboten, anschließend der US. bei CER trace= delayed Simultane Konditionierung, CS und US werden gleichzeitig dargeboten und rückwärtsgerichtete Konditionierung, CS wird nach dem US dargeboten, ungeeignet. Extinktion (Löschung): Wiederholte Darbietung des CS ohne US Vergessen Das bloße Verstreichen von Zeit wirkt sich kaum auf die CR aus!! Erneutes Lernen: Schneller Wiedererwerb: Folgt auf eine Akquisitionsphase (A) eine Extinktionsphase (E) und dann wieder eine Akquisitionsphase, dann ist die zweite Akquisitionsphase erheblich kürzer. _ In einer A E A E A … Sequenz werden die Akquisitionsphasen immer kürzer Die drei Phänomene, Spontanerholung, Disinhibition und schneller Wiedererwerb zeigen, dass KK nicht leicht rückgängig gemacht werden kann. Reizintensität von CS und US Allgemein: Je stärker CS und US, desto besser (schneller, stabiler, höher) die CR Ein salienter (starker, hervorragender) CS führt zu einer stärkeren CS (z.B. lauter Ton mehr als leiser Ton). Diskriminationshypothese: Konkurrenz des CS mit vielen Hintergrundreizen Ein starker US führt zu einer stärkeren CR, genauer gesagt zu einer höheren Asymptote. Generalisierung und Diskrimination: Nach der KK mit einem CS lösen auch andere, ähnliche Stimuli konditionierte Reaktionen aus, selbst wenn diese nie mit dem US kombiniert wurden Dieser Transfer der Konditionierungsfolgen auf ähnliche Stimuli wird Generalisierung genannt. - Je ähnlicher ein Stimulus dem Stimulus in der Lernphase ist, umso höher ist das Potenzial eine CR auszulösen. Sie können begründen, dass bei der Löschung kein Abbau der Assoziationen stattfindet. 3 Fakten sprechen gegen eine Löschung der Assoziation während der Extinktion 1. Spontanerholung: Am Beginn des nächsten Tages wird das Verhalten zunächst wieder stärker gezeigt. Beleg dafür, daß die Assoziation nicht dauerhaft gelöscht wird. 2. Disinhibition: Extinktionsphase so weit fortgeschritten, dass CS keine Reaktion mehr auslöst wird wenige Sekunden vor CS ein neuer Stimulus präsentiert, CS löst wieder CR aus Präsentation eines ablenkenden Stimulus unterbricht Inhibition 3. Schneller Wiedererwerb: Folgt auf eine Akquisitionsphase (A) eine Extinktionsphase (E) und dann wieder eine Akquisitionsphase, dann ist die zweite Akquisitionsphase erheblich kürzer. In einer A E A E A … Sequenz werden die Akquisitionsphasen immer kürzer Sie können die Inhibitionstheorie der Spontanerholung in 3-4 Sätzen darstellen. Gegen Ende der Extinktion bestehen zwei gegenläufige Assoziationen, eine exzitatorische (in Erwerbsphase entstanden) und eine inhibitorische (entsteht parallel dazu in der Löschungsphase). Erfolgreiche Extinktion wäre es, wenn die inhibitorische Assoziation gleich ist. Aber die inhibitorische Assoziation ist fragiler als EA, daher Spontanerholung • nach weiteren Extinktionssitzungen: Spontanerholung lässt immer mehr nach, schließlich Verschwinden dies geschieht, da inhibitorische Assoziation mit jeder Experimentalsitzung stärker wird Sie können Disinhibition (die nach erfolgter Extinktion auftreten kann) in 2-3 Sätzen erklären. Wenn nach einer erfolgreichen Löschung kurz vor dem CS ein neuer Reiz gezeigt wird. z.B. vor Klingel ein anderer neutraler Reiz, z.B. Rassel, dann löst die Klingel wieder eine CR aus. Inhibitorische Assoziation ist empfindlich und kann leicht unterbrochen werden. Sie können erklären wie man einen konditionierten Inhibitor (CS-) erhält. (3 Methoden) „latente Inhibition“ (CS wiederholt alleine vorgegeben (CS-Präexposition). Dann in CS+ umgewandelt wie im Retardationstest. Ergebnis: verzögerter Erwerb. Wahrscheinlich keine Inhibition, sondern eine Folge der Nichtbeachtung des CS aufgrund von Habituation) „Konditionierte Inhibition“ (Pawlow; Zwei Arten von Durchgängen: erst CS+ und US, dann CS+ und CS-; je besser der CS+, desto besser der CS-) „Konditionierte Inhibition“ (Rescorla; Zwei Arten von Durchgängen: erst CS-, aber kein US, dann US, aber kein CS-; inhibitorische Wirkung umso stärker, je häufiger der US auftritt) „differenzielle Konditionierung“ (Zwei Arten von Durchgängen: erst CS+ (Ton) und US (Futter), dann CS- alleine; wenn CS- vorher exzitatorische Eigenschaften hatte, tritt zwar Löschung ein, aber der CS ist nicht inhibitorisch) Sie kennen die zwei Methoden zur Testung konditionierter Inhibition und können diese je mit einem Satz beschreiben. Retardationstest (Zuerst wird ein CS- (inhibitorischer CS=Ton, wenn nix folgt, kündigt also Ausbleiben des US an) etabliert, der später als CS+ (exzitatorischer CS, kündigt Auftreten des US an) verwendet wird. Hierbei ist die Ausbildung der CR auf CS+ verzögert (retardiert).) Summationstest (CS- und CS+ werden unabhängig voneinander etabliert, dann gemeinsam vorgegeben (summiert). CR fällt geringer aus.) Sie kennen die vier wichtigsten Möglichkeiten der Reizpräsentation beim KK und ihre Wirksamkeit (zu jedem 1-2 Sätze, und /oder eine Abbildung). 1. bester Erfolg: delayed conditioning (verzögerte Konditionierung, CS wird dargeboten und einige Zeit später, aber während der CS noch an ist, der US.), CR klein bei langem SOA (Abstand Beginn CS&Beginn US). Optimales SOA hängt von Reizsystem ab. Bei Geschmacksaversion kann SOA ruhig beliebig ausgedehnt sein. 2. bester Erfolg: trace conditioning (Spurenkonditionierung) Erst wird der CS dargeboten, anschließend der US. bei CER trace= delayed Simultane Konditionierung, CS und US werden gleichzeitig dargeboten und rückwärtsgerichtete Konditionierung, CS wird nach dem US dargeboten, ungeeignet. CS-US-Korrelation: Sie können definieren, wann ein CS exzitatorisch oder inhibitorisch wird (1-2 Sätze). Faustregel: Korrelation zwischen US und CS muss nicht 1.0 sein – Ein CS wird exzitatorisch in dem Ausmaß, in dem er das Auftreten eines US zuverlässig ankündigt (Korrelation positiv) -Ein CS wird inhibitorisch in dem Ausmaß, in dem er das Ausbleiben eines US zuverlässig ankündigt (Korrelation negativ) Sie können in knappen Worten wiedergeben, was eine Konditionierung erster und zweiter Ordnung ist. Sie sollen auch in der Lage sein, Beispiele für Konditionieren höherer Ordnung anzugeben. (2 Sätze) Wird ein neutraler Reiz mit einem US gepaart, spricht man von Konditionierung erster Ordnung. Paart man einen neutralen Reiz mit einem CS, sodass der vormals neutrale Reiz ebenfalls die bedingte Reaktion auslöst, ist dies eine Konditionierung zweiter Ordnung. Sie gelingt nur, wenn der zweite CS biologisch schwächer ist als der erste CS. Konditionierung in der Natur?! – Wölfe sind Jäger des Rotwilds – Junge Rehe fürchten Wölfe nicht, müssen das erst lernen durch Schauen auf Artgenossen – Kond. 1. Ordnung: • CS-Wolf-Geruch; • US-Rudel zeigt Furcht; • UR-Angst – Kond. 2. Ordnung • CS2-Anblick des Wolfes; • CS1-Wolf • CR1-Angst Konditionieren 2. Ordnung kann die Ausweitung von Assoziation erklären, z.B. Gefühl (Spinne) – Anblick (Spinne). Konditionieren 3. Ordnung klappt nicht mehr im Labor. Sie kennen den Blocking-Effekt (Kamin) und können die Vorgehensweise beschreiben (z.B. in Form einer Tabelle, die die Phasen und Versuchsgruppen darstellt). Kamin konnte mit seinem Blocking-Experiment beweisen, dass nur eine Konditionierung stattfindet, wenn der CS informativ ist. Vortraining: Die Experimentalgruppe bekam zuvor nur den Ton mit dem Schock. Der Ton kündigte also den Schock perfekt an. Nach dieser Phase hatten die Tiere gelernt den Schock aufgrund des Tonreizes zu erwarten. Als das Licht dazu kam, war das ein völlig überflüssiger Reiz, kein Informationsgewinn. Trainingsphase: Alle Tiere in beiden Gruppen bekamen zusammen Licht und Ton (CSVerbundreiz) präsentiert gemeinsam mit einem Schock (US). In der Testphase gab es für beide Gruppen nur das Licht als CER-Paradigma. Die Kontrollgruppe zeigte fast perfekte Unterdrückung (.05). Die Experimentalgruppe zeigte praktisch keine Unterdrückung (.45). Sie kennen die Bedeutung des Blocking für die Theorie des klassischen Konditionierens (ein Satz). Die traditionelle Sicht des KK geht davon aus, dass die gemeinsame Darbietung von CS und US (Kontiguität) hinreichend und notwendig ist für die Konditionierung. Kamins Experiment zeigt, dass dies falsch ist. Der CS muss den US nicht nur ankündigen, er muss darüber hinaus mehr Informationen über den US haben, als die bereits bekannten Reize, damit eine KK stattfindet. Sie wissen was der Übererwartungseffekt ist (1-2 Sätze). beeindruckend, weil kontraintuitiv Versuchstier erwartet bei zwei voneinander unabhängigen und einzeln präsentierten CS eine Belohnung. Werden beide CS nun zusammen präsentiert, findet eine Schwächung der CS-US- Paarung statt, weil das Versuchstier nun eigentlich 2 Belohnungen (für jeden CS eine) erwartet. Bekommt es nun wie bisher nur 1 Belohnung, ist dies eine inhibitorische Konditionierung. Resultiert aus dem 6. Punkt des Rescorla-Wagner-Modells Sie können die Vorhersagen des Rescorla-Wagner Modells auf Stichworte hin angeben (6 Aussagen). Erwartungen des US werden erworben 1. Wenn die Intensität des aktuellen US größer ist als die erwartete Intensität, dann werden alle konditionierten Stimuli, die mit dem US kombiniert werden, exzitatorisch konditioniert Phi>V (ich erwarte nichts und bekomme einen großen Schreck) 2. Wenn die Intensität des aktuellen US kleiner ist als die erwartete Intensität, werden alle konditionierten Stimuli, die mit dem US kombiniert werden, inhibitorisch konditioniert Phi<V 3. Wenn die Intensität des aktuellen US der Intensität der Erwartung entspricht, dann findet keine Konditionierung statt. Phi=V 4. Je größer die Diskrepanz zwischen erwarteter und tatsächlicher Intensität des US (also Überraschung), desto stärker ist die Konditionierung 5. Saliente Reize führen schneller zur Konditionierung als weniger saliente Reize. 6. Wenn zwei oder mehr konditionierte Stimuli zusammen präsentiert werden, summiert sich die erwartete Intensität. Sie können mit dem mathematischen Rescorla-Wagner-Modell umgehen. Delta V = alpha (Lamda-V) Lamda = Stärke des US V = Stärke der Erwartung Lernfortschritt = Delta V Lernrate = alpha (wie schnell gelernt wird) Zu Beginn der Akquisition: Lambda = 1 (US ist vorhanden), V=0 (Erwartung null), Lernparameter= 0.1, Veränderung 0.1*(1-0)=0.1 In der Mitte der Akquisition: Lambda = 1, V=0.5 (Erwartung schwach), 0.1*(1-0.5)=0.05 Zum Ende der Akquisition: Lambda=1, V=1 (Erwartung vorhanden), 0.1*(1-1)=0 Kein Lernfortschritt mehr Sie können das Experiment von Garcia und Koelling (1966) darstellen (z.B. als Tabelle). Haben die Äquipotenzialitätsannahme geprüft. 2 Gruppen mit Ratten Helles -lautes (CS1) und süßes (CS2) Wasser wurde entweder mit Schock oder Emetikum (US) gepaart. Die zwei Gruppen Schock und Emetikum wurden anschließend entweder mit hellem und lautem Wasser oder mit süßem Wasser gestestet. Ergebnis: Gruppe Emetikum: CER bei süßem Wasser, nicht bei hellem und lautem Wasser Gruppe Schock: CER bei hellem und lauten Wasser, nicht bei süßem Wasser Sie kennen die Bedeutung des Experimentes von Garcia und Koelling (1966) für die Annahme der Äquipotenzialität. (1-2 Sätze) Die Äquipotenzialitätsannahme: CS ist im Prinzip austauschbar und beliebig. Als CS kann dienen, was gerade zur Hand ist. Ergebnis aus dem Experiment von Garcia und Koelling: CS sind nicht gleichwertig, sie müssen zu den US passen! Der Garcia-Effekt zeigt, dass biologische Randbedingungen entscheidend bei der Wahl von CS und US sind und dass die Äquipotenzialitätsannahme nicht richtig ist. Beziehung zwischen CS und US ist wichtig, aufgrund der biologischen Ausstattung gibt es die Neigung bestimmte Stimuli miteinander in Verbindung zu bringen. Sie können den Begriff der Preparedness erläutern (1-2 Sätze). Organismen bringen Lernbereitschaften bestimmte Zusammenhänge (besser und schneller) zu lernen als andere. Diese sind zwischen den Arten verschieden (Vögel z.B. eher visuell orientiert, Ratten geschmacksorientiert). Man entfernt sich von der tabula rasa-Annahme. Sie können das Vorgehen der aversiven Gegenkonditionierung bei Alkoholmissbrauch beschreiben und als Klassisches Konditionieren analysieren (2-3 Sätze). Veränderung einer bestehenden positiven konditionierten Reaktion, z.B.Esssucht, Alkoholmissbrauch, Rauchen, Drogensucht Diese Verhaltensweisen schaffen häufig kurzfristig positive Affekte, schaden jedoch langfristig Freiwillige Therapie. Patienten bekamen in einer „Bar“ ein Emetikum (US) & Bestandteile zum Stabilisieren des Kreislaufs. Nach der Injektion der Wirkstoffe, kurz vor Einsetzen der Übelkeit (Timing ist wichtig!, wie beim KK, optimales Intervall zwischen CS und US), bekamen sie z.B. einen Whiskey, den sie genau wahrnehmen (riechen, sehen, schmecken) sollten, und anschließend bis zum Erbrechen austrinken sollten (anschließend weitere Durchgänge mit anderen Alkoholika). Anschließend wird Magen gewaschen, 5-7 Behandlungen pro Patient. Extinktion (CS ohne US) ist wahrscheinlich Ziel: kurzfristige, aversive Reaktion auf Reize zu lernen Operantes Konditionieren (=Instrumentelles Lernen) Sie können den Unterschied zwischen KK und OK erklären (1-2 Sätze). Die Erforschung des operanten Konditionierens erfolgt mit dem Ziel, Regelhaftigkeiten willkürlichen Verhaltens und Gewohnheiten (Verhalten wie Gehen, Sprechen, Essen, Arbeiten oder Spielen) aufzufinden und zu erklären, und diese Erkenntnisse für die Vorhersage und Beeinflussung von Verhalten, etwa in der Erziehung oder der Therapie, nutzbar zu machen. Im Gegensatz zum Klassischen Konditionieren = unwillkürliches Verhalten wie Speichelfluss, Reflexe, das (mehr oder weniger) zuverlässig durch einen äußeren Reiz ausgelöst wird. Sie kennen Setting und AV von Thorndikes Experimenten (1-2 Sätze). "Animal Intelligence" Learning by Trial and Error Thorndike setzte ein hungriges Tier (Katzen) in einen "Problemkäfig". Die Tür konnte durch eine oder mehr Aktionen geöffnet werden, worauf das Tier Zugang zu Futter bekam. Die Lösung fanden die Tiere zuerst zufällig durch Versuch und Irrtum (trail and error). Anschließend wurde die Zeitspanne bis zum Öffnen der Tür immer kürzer (also: AV=Zeit bis zum Öffnen der Tür, Latenz!), die Katzen lernen also! → Thorndike maß die Performanz anhand der Zeitspanne, die die Versuchstiere benötigen, um in einem Durchgang aus dem Käfig zu entkommen. Sie können das Law of Effect in 1-2 Sätzen zusammenfassen. „Von verschiedenen Reaktionen auf dieselbe Situation werden jene, die von einer Befriedigung des Willens des Tieres begleitet oder gefolgt werden, mit der Situation stärker verbunden, sodass sie bei einem erneuten Auftreten der Situation mit größerer Wahrscheinlichkeit wieder gezeigt werden. Jene, die von einer Frustration des Willens des Tieres begleitet oder gefolgt werden, führen zu einer Schwächung der Assoziation mit der Situation, sodass sie vermutlich mit geringerer Wahrscheinlichkeit wieder auftreten. Je größer die Befriedigung oder Frustration, desto intensiver die Stärkung oder Schwächung der Verbindung.“ •Befriedigung und Frustration -„ Ein befriedigender Zustand bedeutet, dass das Tier nichts tut, um ihn zu vermeiden, sondern vielmehr versucht, ihn herbeizuführen und zu erhalten. Ein frustrierender oder unangenehmer Zustand wird normalerweise vermieden und rasch beendet.“ Law of Effect ist ein mechanistisches Lernzprinzip! Sie kennen das Stop-Action-Prinzip (1-2 Sätze). = Abnahme der Verhaltensvariabilität Genau die Bewegung, die der Verstärkung/Belohnung unmittelbar vorausgeht, wird verstärkt. Beleg für mechanistische Verstärkung, also Law of effect Sie kennen Skinner`s mechanistische Erklärung abergläubischen Verhaltens (2-3 Sätze). Das mechanistische Stop-Action-Prinzip lässt vermuten, dass zufällige Verstärkung vorkommen kann. Skinner belohnte Taube, egal, was diese machte. Futtertrog wurde automatisch alle 15 sec an Käfig gebracht. (lerntheoretische) Erklärung abergläubischen Verhaltens: Taube zeigt im Käfig alle möglichen Aktionen. Die Aktion, die unmittelbar vor der Belohnung gezeigt wurde wird verstärkt (bei Menschen und bei Tieren). Die verstärkte Aktion wird anschließend ein klein wenig häufiger gezeigt als alternative Aktionen. Somit steigt die Wahrscheinlichkeit einer Verstärkung genau dieser Aktion, Verhaltensvariabilität sinkt. Aber: Timing ist wichtig – bei langem Intervall macht das Tier zwischen den Verstärkungen alles mögliche... Sie wissen, was Shaping ist und wozu man es verwendet (3-4 Sätze). Das Gesetz des Effekts besagt, dass die Variabilität des Verhaltens mit dem Training abnimmt (und die Stereotypie zunimmt). Aber die Variabilität ist nie null, es gibt immer Abweichungen. Shaping macht sich gerade die natürliche Variabilität des Verhaltens zunutze. Grundlage des Shaping ist die schrittweise Annäherung an ein gewünschtes Verhalten, wenn dieses noch nicht gezeigt wird und es somit noch nicht verstärkt werden kann. Hierfür werden auch kleine Schritte in die richtige Richtung belohnt, wobei das Kriterium fortschreitend verschärft wird. Anwendungsbereiche: Schule, Verhaltenstherapie, Psychiatrie (Kaugummi-Bsp, Patient hat seit 19 Jahren nicht gesprochen, aber er mochte Kaugummi; er bekam Kaugummi, wenn er den Theraputen ansah, dann Lippenbewegungen, dann vokalisierte, dann Kaugummi sagte) Sie kennen Verhaltensketten, und wie man sie trainiert (1-2 Sätze). Jeder Stimulus in der Mitte einer Verhaltenskette erfüllt zwei Funktionen: Er ist ein konditionierter Verstärker für das vorausgehende Verhalten und ein diskriminativer Hinweisreiz für das nächste Verhalten der Kette. Wie kann man einem Versuchstier eine VK beibringen? •Rückwärtsverkettung – Man beginnt mit der letzten Aktion, die dann verstärkt wird. – Der Startpunkt der letzten Aktion wird somit zum sekundären Verstärker. – Dann wird die vorletzte Aktion gelernt, u.s.w. •Vorwärtsverkettung Man verstärkt jede Aktion, beginnend mit der ersten. (hat aber das Problem, irgendwann alle bis auf die letzte Verstärkung zu entfernen) Sie wissen, was ein konditionierter Verstärker ist und warum man den braucht (1-2 Sätze). Konditionierte Verstärker, insbesondere sekundäre Verstärker (= ein zuvor neutraler Stimulus, der die Fähigkeit erworben hat, Reaktionen zu stärken, weil er wiederholt mit einem primären Verstärker gepaart wurde) • Primäre Verstärker: Dinge oder Vorgänge, für die Tiere bereit sind, zu "arbeiten". Beispiele sind Nahrung, Süßes, Sexualpartner u.ä.; eignen sich nicht immer gut zum Konditionieren, weil sie meist nicht zeitlich präzise angeboten werden können. Daher verwendet man oft konditionierte Verstärker. Auch Sättigungseffekte sind Gründe. • Sekundäre Verstärker: Reize, die einen primären Verstärker ankündigen und durch KK erhält, z.B. Lob (hat erstmal keine positiven Auswirkungen, aber weitere positive Entwicklungen) Sie wissen, was eine Skinner-Box ist (1-2 Sätze). Automatische Boxen im Gegensatz zu Thorndike, Hebel zum Manipulieren, Lautsprecher, verschiedene Lampen, Futterspender, für verschiedenen Fragestellungen Heute am Computer angeschlossen, damit bestimmte Reize präsentiert werden. Lernexperimente können dort komplett automatisiert durchgeführt werden können. Sie kennen ein Beispiel für „Misbehavior of Organisms” und was das zeigt (2-3 Sätze). Bsp: The Bantam Chicken Tür öffnet sich, Huhn sollte nur auf einer Glasplatte stehen, stattdessen fing es an kratzende Bewegungen auszuführen (unnötig). Das Ganze sah so aus, als ob das Huhn eine Jukebox anwirft und zu Tanzen beginnt. Dieses Ergebnis war völlig ungeplant, Hühner sollten eigentlich nur stehen. Huhn hätte auch ohne Bewegungen alle 15 sec Futter bekommen. Stellen Abweichungen vom lerntheoretischem Wohlverhalten dar. Erklärung: → Instinctive Drift/ Instinktneigung Breland & Breland vermuten, dass instinktives Verhalten, dass durch den Reiz ausgelöst wird, die Ausführung erlernter Aktionen verdrängen kann (instinktives Verhalten ist also stärker). Hierbei scheint es eine Rolle zu spielen, dass das „Instrument“ zu einem konditionierten Verstärker wurde (Assoziation zwischen Objekt und Verstärker), jedenfalls wurden häufig Aktionen gezeigt, die normalerweise gegenüber dem Verstärker gezeigt werden. Trotz der enormen Anwendbarkeit des operanten Konditionierens gibt es also Grenzen. Instinktives Verhalten ist Stolperstein. Sie können erklären, was ein Verstärkerplan ist (1 Satz). Ein Verstärkerplan ist eine Regel, die angibt, unter welchen Bedingungen (wie und wann) eine Verstärkung erfolgt. Sie sind reversibel. Sie können erklären, was CRF, FR, VR, FI und VI Pläne sind (je 1-2 Sätze). Kontinuierliche Verstärkung (CRF): jede einzelne Reaktion wird verstärkt, schneller Erwerb intermittierende (eben nicht jede Reaktion wird verstärkt) Verstärkung eher löschungsreistent Quotenpläne: Bei Quotenplänen steht der Aufwand (Anzahl der Reaktionen) in einem direkten Verhältnis zum Gewinn (Anzahl der Verstärkungen). fixer Quotenplan=FR nach jeder n-ten Reaktion gibt es einen Verstärker (FR-10: nach jeder 10. Reaktion) Hohe Rate Nachverstärkungspause hängt von der Quote ab, ist umso länger je höher Quote variabler Quotenplan=VR nach jeder n-ten Reaktion im Durchschnitt gibt es Verstärkung hohe Rate sehr gleichmäßig Nachverstärkungspausen sind nicht vorhanden Intervallpläne: Fixes Intervall (FI): die erste Reaktion, die nach einem festgelegtem Zeitintervall auftritt, wird verstärkt Verstärkung hängt von der verstrichenen Zeit und der Ausführung einer Reaktion ab, wobei die Zeitintervalle immer gleich lang sind. variables Intervall (VI): Zeitintervall ist nur im Durchschnitt eine bestimmte Dauer lang, variiert Tiere reagieren seltener Sie kennen den typischen Verlauf der Akquisition bei FR, VR, FI und VI Plänen (gerne auch graphisch). Sie kennen Alltagsbeispiele für FR und VR-Pläne (Je eine Aussage). - Tischler kriegt nach z.B. 10 Tischen eine Pause oder einen bestimmtem Geldbetrag, Akkordarbeit (fixer Quotenplan=FR) - Teilnahme an Lotterie oder Verlosung, je mehr Lose er kauft desto häufiger erhält er im Durchschnitt einen Gewinn; aber die Anzahl der Lose, die er kaufen muss, ist unklar (variabler Quotenplan=VR) Sie wissen, was eine Token-Economy ist. Token Economies (Gutschein-Ökonomie): Belohnungs- und Bestrafungssystem. Es gab z.B. mal Bethelgeld. Token werden bei erwünschtem Verhalten gegeben, z.B. für Körperpflege, soziale Interaktion. Mit Token können Nahrungsmittel und Luxusgüter (Zigaretten, Freizeitaktivitäten) erworben werden. Sind selten geworden wg. Gerichtsurteile. Sie können Verstärkung von Bestrafung abgrenzen (1 Satz). Sie können negative und positive Verstärkung (bzw. Typ I und Typ II Bestrafung) abgrenzen (1 Satz). 4-Felder-Schema, das jeweils zwei Arten von Verstärkung und Bestrafung darstellt Stimulus präsentiert Wegnehmen od. Weglassen des Stimulus Verhaltens -Zunahme Positive Verstärkung Bsp: Leckerli für Männchenmachen Negative Verstärkung Bsp: Leinelösen für Kampfvermeidung Verhaltens-Abnahme Bestrafung (Typ I) Bsp: Unterwerfung für Jagen durch anschreien Entzug (Negative Bestrafung Typ II) Bsp: Anleinen fürs Jagen Sie kennen das Vermeidungsparadox; Sie können die lerntheoretische und die kognitive Erklärung skizzieren (3 Sätze). Vermeidungslernen (Solomon & Wynne, 1953) - Aufbau des Experiments - Hunde in Zweikammerkäfig, wobei in der ersten Elektroschock verabreicht wird und vorher eine Lampe leuchtet - Hund springt nach >10s: Fluchtverhalten - Hund springt nach <10s, also bevor der Schock einsetzt: Vermeidung - Die meisten Hunde lernten schnell Vermeidung (bekamen nur 1mal einen Schock) Die Latenzen wurden immer kürzer (1-2s) Vermeidungsparadox: Warum halten die Tiere ein Verhalten aufrecht, das nur 1x verstärkt wurde (durch Schock)? Erklärungen: 2-Faktorentheorie Kognitive Theorie Kognitive Theorie Erwartung 1: die Erwartung des Schocks nach Verhalten (bei Flucht kein Schock), Erwartung = 0 Erwartung2: die Erwartung des Schocks ohne Verhalten (ohne Flucht Schock), Erwartung= 1 Es wird Erwartung gewählt, die mit möglichst hoher W`keit ein möglichst positives Ergebnis erzielt. E1 besser als E2, daher wird die Vermeidung ausgeführt. Erwartungen werden nicht gelöscht, sondern erst verändert, wenn sie diskonfirmiert werden, also bis der Gegenbeweis passiert. 2-Faktorentheorie 1. Phase: Klassisches Konditionieren – US eSchock – CS Dunkelheit – UR, CR = Angst 2. Phase: Operantes Konditionieren – Dunkelheit (Diskriminativer Hinweisreiz), erzeugt Angst – Flucht (operantes Verhalten), beendet Angst - Furchtreduktion (negativer Verstärker=Beenden des CS) →Der Trick der 2FT besteht eigentlich darin, dass die schwer erklärbare Vermeidung als Flucht (vor der Angst) umgedeutet wird. Sie wissen, was Flooding ist, und warum Flooding nach der Lerntheorie helfen soll (2-3 Sätze). siehe Dschungel-Camp mit Prüfungen, VP wird gezwungen in Situation zu verharren, kann Vermeidungsreaktion nicht ausführen, Erwartung wird gelöscht, Vermeidungsverhalten verschwindet man sieht also, dass wirklich nix passiert, wenn man sich z.B. in einem Raum mit vielen Spinnen aufhält Flooding in der Verhaltenstherapie: Ethik: offensichtlich problematischer als systematische Desensibilisierung - Erfolg: Flooding = Systematische Desensibilisierung (aber SD ist angenehmer) - Ergo: Flooding nur als ultima ratio; äußerstes, letztes Mittel Sie wissen, wie gelernte Hilflosigkeit hervorgerufen werden kann, und wie sie sich äußert (2-4 Sätze). Overmier & Seligman (1967) Seligmans Begriff für eine Minderung der Fähigkeit, eine Vermeidungsreaktion zu erlernen, die auftritt, nachdem ein Individuum unvermeidbaren aversiven Reizen ausgesetzt wurde. Exp: Eine Gruppe Hunde, die zunächst Elektroschocks ausgesetzt waren ohne die Möglichkeit diesen zu entfliehen, versuchten dies in der 2. Versuchsanordnung, in der sie hätten flüchten können auch gar nicht mehr. → Erwartung: Verhalten wirkt sich nicht auf die erlernten aversiven Ereignisse aus. (Bei Menschen führt dies zu Hilflosigkeit und Depression) Die Theorie der gelernten Hilflosigkeit Parallelen zwischen GH und (reaktiver) Depression _ Verringerte Motivation zu willentlichen Reaktionen – GH: geringe Initiative; Depr.: Passiv, Verlangsamung _ Negative Denkmuster – GH: kognitive Störung; Depr.: Unfähigkeitsüberzeugung _ Verfällt mit der Zeit – bei beiden meist nicht chronisch _ Verringerte Aggressivität – bei beiden wenig Feindseligkeit und Konkurrenzverhalten _ Appetit- und Interessenverlust – Gewichtsabnahme, vermindertes Interesse, z.B. sexuell, gesellige Aktivitäten Sie kennen Faktoren, die sich auf die Bestrafung auswirken (5 Stichworte mit Erläuterung). ist gekennzeichnet durch die Präsentation eines Reizes, und einer daraufhin einsetzenden Verringerung der Verhaltensrate. Bsp: Anfassen der Herdplatte – Schmerz Faktoren der Wirksamkeit von Bestrafung Intensität: Bei zu schwacher Bestrafung kann Gewöhnung auftreten Also: wenn schon bestrafen, dann gleich mit voller Intensivität Azrin, Holz & Hake (1963): bei konstanter Stärke reichten 80V, um bei Tauben ein Tastenpicken völlig zum Verschwinden zu bringen Bei anfangs geringer Stärke waren am Ende 130V nötig! Unmittelbarkeit: Es gibt einen direkten Zusammenhang zwischen der Unmittelbarkeit von Bestrafung und der Verhaltensunterdrückung! Also wenn schon Bestrafung, dann sofort! Im Alltag wird dieser Zusammenhang ganz häufig missachtet...(Warte nur, bis deine Mutter nach Hause kommt…) ... und fast alle institutionalisierten Strafen haben enorme Verzögerungen – Bestrafungsplan: Kontinuierliche Bestrafung führt schneller zum Erfolg als intermittierende Wird ein FI-Plan verwendet, ist die Reduktion am Ende des Intervalls am größten Wird ein FR-Plan verwendet, ist die Reduktion nach 70-90% der Quote am größten – Verhaltensmotivation: Motivierte Tiere müssen stärker bestraft werden als weniger motivierte Tiere - Azrin & Holz (1966): hungrige Tauben ertrugen stärkere Schocks als wenig hungrige Tauben. - Mazur: Das ist nicht weiter überraschend, aber bedeutungsvoll für die Praxis: Wenn man es schafft, den Verstärker für das unerwünschte Verhalten abzuwerten, dann braucht man weniger Bestrafung!! (Handtuchhorten-Beispiel) – Verfügbarkeit alternativer Verhaltensweisen: •Wenn alternative Verhaltensweisen verfügbar sind, die verstärkt werden, gelingt die Bestrafung schnell. - Azrin und Holz (1966). Tauben werden bei Picken-für- Futter bestraft; sie reduzieren ihr Verhalten um 10%, aber um 100% wenn sie eine alternative Taste haben. - Auch hier gilt: nicht wirklich kontraintuitiv, aber immens wichtig für Erziehung und Therapie: Bestrafe das Problemverhalten (z.B. Zanken) und stelle gleichzeitig Verstärker für alternatives Verhalten (z.B. zusammen spielen) in Aussicht! Erklärung des instrumentellen Lernens. Welche drei Argumente sprechen gegen Thorndikes „Law of effect“ (3 Sätze)? Law of effect: Eine Belohnung führt zu einer Stärkung der S-R-Verknüpfung, eine Bestrafung/Frustration zu einer Schwächung. Es geht also um die Verknüpfung von Stimuli und Reaktionen wie beim KK. Etliche Ergebnisse sprechen gegen diese Erklärung: Latentes Lernen zeigt, dass Verstärkung für Lernen nicht notwendig ist. Kontrasteffekte zeigen, dass insbesondere R-S-Erwartungen gelernt werden. Eine Vielzahl von Befunden spricht für den Erwerb von S-S-Erwartungen. Sie kennen das Experiment von Tolman & Honzik (1930) zum latenten Lernen (UV, AV, Ergebnis), und die anschließende Unterscheidung von Kompetenz und Performanz. multiples 14-Einheiten-T-Labyrinth, 17 Trials (1 pro Tag) AV: Anzahl Fehlerrate, wie oft Ratte in Sackgasse geht (Leistung) UV: Futtergabe 3 Gruppen: Gruppe 1 wurde nie gefüttert. Wenn das Tier die Zielbox erreichte, wurde es einfach herausgenommen, nicht verstärkt. Verbessert sich auch ohne Verstärkung Gruppe 2 erhielt jeden Tag Futter in der Zielbox, kontinuierlich verstärkt. Besser als Gruppe 1, sehr wenige Fehler Gruppe 3 erhielt bis zum 11.Tag kein Futter, dann schon; müsste eigentlich gleiches Ergebnis haben wie Gruppe 2, nur um 11 Tage verschoben, aber abrupte Verhaltensänderung und wenig Fehler; vorher schon latentes (verborgenes) Lernen, zeigt sich aber erst wenn der Reiz (Futter) eingesetzt wird Verstärkung ist also nicht notwendig fürs Lernen. Sie kennen Crespis (1942) Experiment zu Verstärkererwartungen (UV, AV, Ergebnis). Erwartungen, dass ein bestimmtes Verhalten einen bestimmten Verstärker folgen lässt. UV: Ratten bekommen 1, 16 oder 256 Futterpillen. AV: ? Nach 20 Trials bekamen alle 16 Futterpillen. Ergebnis: Ratten, die vorher 256 Pillen bekamen, starke Abnahme des Verhaltens nach der Gabe von nur 16 Pillen. Gleichbleibend bei denen, die vorher auch 16 bekamen. Zunahme, bei denen, die vorher nur 1 bekamen. Es werden Verhaltens – Verstärker (R-S) Erwartungen gelernt. Sie kennen Belege für die Entstehung von S-S Assoziationen (3 Punkte). Lernen ohne Verhalten: Ratten lernen auch die Position einer Futterbox, wenn sie zuvor nie dorthingelaufen sind sondern nur abgesetzt worden waren. Verhaltensäquivalenz: Ratten, die mit einem Wagen durch ein Labyrinth gezigen wurden, laufen auch in die Zielbox. Ratten, die für durchlaufen des Labyrinth verstärkt wurden, schwimmen zur Zielbox nach einer Flutung des Labyrinths. Autoshaping: Tauben erhielten ein Scheibenlicht als CS und eine Futterpille als US. Sie entwickelten ein zuverlässiges Scheibenpicken was völlig unnötig war. Offenbar assoziieren die Tauben die Scheibe mit dem Futter (S-S-Lernen) Sie kennen Beispiele für Imitation bei Tieren (1-2 Sätze). Affen tradieren Goldwäschermethode, um Körner oder Süßkartoffeln vom Sand zu trennen. Vögel lernten voneinander das Aufpicken des Aluminiumdeckels der Milchflaschen Was ist der Unterschied zwischen social facilitation, Mimikry und echter Imitation (ein Satz)? Social facilitation Verhalten aus vorhandenem Repertoire wird nach Beobachtung eines anderen Tieres ausgeführt (z.B. Huhn wird in Gesellschaft pickender Hühner häufiger picken als allein). Radfahrer fahren in der Gruppe schneller als allein. Mimikry – Wiederholung der physischen Handlung ohne dabei ein Ziel (außer ev. der Imitation selbst) zu verfolgen Kleine Kinder imitieren etwa die Bewegungen der Erwachsenen in diesem Sinn, wenn sie spielen. Echte Imitation – Wenn eine Handlung übernommen wird, um selbst das zugehörige Handlungsziel zu erreichen Völlig neues Verhalten wird nach Beobachtung ausgeführt. Affen tradieren Goldwäschermethode, um Körner oder Süßkartoffeln vom Sand zu trennen. Vögel lernten voneinander das Aufpicken des Aluminiumdeckels der Milchflaschen. Wenn größere Kinder etwa lernen, einen Computer und ein Programm zu starten, um selbst ein Spiel zu spielen Sie kennen das Experiment von Meltzof&Moore (1977) in den Grundzügen (2-3 Sätze). Imitation bei Neugeborenen Babies zwischen 12-21 Tage sowie zwischen 0,7-71 Stunden Imitation von Mundöffnen, Zunge rausstrecken (am meisten erkannt hinterher), Fingerbewegung Sie können etwas mit dem Begriff Spiegelneuronen anfangen (2-3 Sätze). Giacomo Rizzolatti und Mitarbeiter fanden sogenannte Spiegelneurone im prämotorischen Kortex von Affen. Diese Neurone feuern kurz vor einer bestimmten Bewegung (z.B. eine Erdnuss nehmen und essen), aber auch, wenn die Bewegung nur beobachtet wird! (Nicht aber bei Erdnuss ohne Bewegung oder Bewegung ohne Erdnuss) Sie kennen Miller und Dollards (1941) Erklärung von Imitation als erworbene Dreifachkontingenz (1 Satz). SD-R-SV Hinweisreiz: Verhalten des Modells Verhalten: Imitation des Modells Verstärkung: Lob, Belohnung Sie kennen Banduras Kritik an dieser Interpretation (2 Aussagen). häufig wird das Verhalten nicht sofort nach der Beobachtung imitiert (nur SD vorhanden während R und SV fehlt) häufig wird Imitation nicht verstärkt (nur R vorhanden, SD und SV fehlen) Bsp: Junge beobachtet Mutter bei zubereiten des Müslis. Später ist er allein in der Küche und imitiert die Aktionen der Mutter. Sie kennen in den Grundzügen das typische Vorgehen von Bandura in den Experimenten mit der Puppe Bobo. Welche UV`s kennen Sie (2-3 Sätze)? ● Bandura (1965) 66 4-jährige sahen einen 5-min Kurzfilm, in dem ein Erwachsener „Rocky“ vier neuartige aggressive Verhaltensweisen gegenüber „Bobo“ ausführt (z.B. boxte er Bobo ins Gesicht und sagte „Peng, voll auf die Nase, peng, peng“). Drei Gruppen, Erwachsene bekamen: 1) Belohnungen (verbal, Süßigkeiten) 2)Bestrafung 3)keine Konsequenz Imitatives aggressives Verhalten wurde in Gruppe 1 mehr gezeigt als in den Gruppen 2 & 3. Fazit: Die beobachteten Konsequenzen des Verhaltens waren ausschlaggebend für das Zeigen (Performanz) von Verhalten! Wurde den Kindern anschließend eine Belohnung versprochen, zeigten alle Kinder das aggressive Verhalten Fazit: Gelernt (Kompetenz) hatten alle Kinder! Bandura, Ross&Ross (1963): 96 Kinder (Alter M=4 Jahre) wurden in vier Gruppen eingeteilt 1. Die Kinder beobachten eine erwachsene Person, die einer Plastikpuppe körperlich und verbal aggressiv zusetzte. 2. Gruppe: Gleiche Szene als Realfilm. 3. Gruppe: Pseudo-Cartoon-Film. 4. Die vierte Gruppe erhielt kein Treatment. (Kontrollgruppe) Kinder wurden nach der Wegnahme ihres momentanen Spielzeugs zu der Plastikpuppe gebracht. Gruppen 1-3 zeigten sich aggressiver als Gruppe 4. Offenbar bewirkt die Beobachtung eines aggressiven Modells, ob nun real oder medial vermittelt, eine Zunahme an aggressivem Verhalten. Vor allem zeigte sich eine Zunahme an imitativem aggressiven Verhalten. Sie wissen welche vier Prozesse nach Banduras Theorie am Modellernen beteiligt sind und wie. „Können“ umfasst nur die ersten drei Prozesse. Für die Ausführung müssen Motivationsprozesse hinzukommen. Gelernt werden insbesondere Verhalten-Effekt-Kontingenzen Sie wissen, was das Premack-Prinzip besagt. Verhalten , das mit höherer Wahrscheinlichkeit auftritt, dient als Verstärker für Verhalten, das mit geringerer Wahrscheinlichkeit auftritt und ein weniger wahrscheinliches Verhalten als Bestrafung für ein wahrscheinlicheres Verhalten fungiert