Zufallsexperiment

Werbung

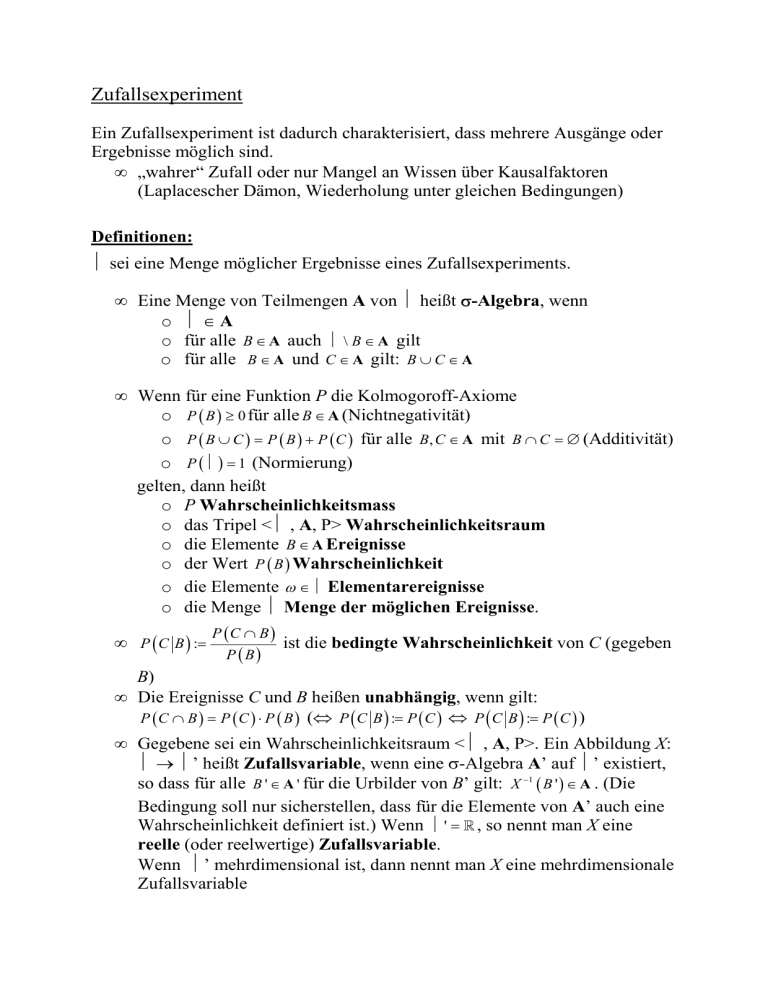

Zufallsexperiment Ein Zufallsexperiment ist dadurch charakterisiert, dass mehrere Ausgänge oder Ergebnisse möglich sind. • „wahrer“ Zufall oder nur Mangel an Wissen über Kausalfaktoren (Laplacescher Dämon, Wiederholung unter gleichen Bedingungen) Definitionen: Ω sei eine Menge möglicher Ergebnisse eines Zufallsexperiments. • Eine Menge von Teilmengen A von Ω heißt σ-Algebra, wenn o Ω∈A o für alle B ∈ A auch Ω \ B ∈ A gilt o für alle B ∈ A und C ∈ A gilt: B ∪ C ∈ A • Wenn für eine Funktion P die Kolmogoroff-Axiome o P ( B ) ≥ 0 für alle B ∈ A (Nichtnegativität) o P ( B ∪ C ) = P ( B ) + P ( C ) für alle B, C ∈ A mit B ∩ C = ∅ (Additivität) o P ( Ω ) = 1 (Normierung) gelten, dann heißt o P Wahrscheinlichkeitsmass o das Tripel <Ω , A, P> Wahrscheinlichkeitsraum o die Elemente B ∈ A Ereignisse o der Wert P ( B ) Wahrscheinlichkeit o die Elemente ω ∈ Ω Elementarereignisse o die Menge Ω Menge der möglichen Ereignisse. • P ( C B ) := P (C ∩ B ) P (B) ist die bedingte Wahrscheinlichkeit von C (gegeben B) • Die Ereignisse C und B heißen unabhängig, wenn gilt: P ( C ∩ B ) = P ( C ) ⋅ P ( B ) (⇔ P ( C B ) := P ( C ) ⇔ P ( C B ) := P ( C ) ) • Gegebene sei ein Wahrscheinlichkeitsraum <Ω , A, P>. Ein Abbildung X: Ω → Ω’ heißt Zufallsvariable, wenn eine σ-Algebra A’ auf Ω’ existiert, so dass für alle B ' ∈ A ' für die Urbilder von B’ gilt: X −1 ( B ' ) ∈ A . (Die Bedingung soll nur sicherstellen, dass für die Elemente von A’ auch eine Wahrscheinlichkeit definiert ist.) Wenn Ω ' = \ , so nennt man X eine reelle (oder reelwertige) Zufallsvariable. Wenn Ω’ mehrdimensional ist, dann nennt man X eine mehrdimensionale Zufallsvariable Die durch P X ( B ' ) := P ( X −1 ( B ' ) ) definierte Funktion P X : A ' → \ heißt Verteilung von X (hinsichtlich P). • Zwei Zufallsvariable X und Y sind stochastisch unabhängig, wenn für alle BX′ , BY′ ∈ A ′X × AY′ gilt: P ( X −1 ( BX′ ) ∩ Y −1 ( BY′ ) ) = P ( X −1 ( BX′ ) ) ⋅ P (Y −1 ( BY′ ) ) Zwei Zufallsvariablen sind genau dann stochastisch unabhängig, wenn die Randverteilungen der einen Variablen unabhängig von der Ausprägung der anderen Variablen sind (Bsp: Farben und Automarken, Laufleistung und Preis). Aufgabe: Zeige, dass zwei Ereignisse B und C genau dann unabhängig sind, wenn die Wahrscheinlicht eines Ereignisse gleich der bedingten Wahrscheinlichkeit (gegeben das andere Ereignis) ist. Erwartungswerte • Wenn die Menge B aller Intervalle Bx = ]−∞, x ] mit x ∈ \ eine Teilmenge von A’ ist, dann ist P X ( Bx ) die kumulative Verteilungsfunktion und f ( x ) := ∂P X ( Bx ) die Wahrscheinlichkeitsdichtefunktion. ∂x • Der Erwartungswert der Zufallsvariablen ist dann: E ( X ) = ³ x ⋅ f ( x ) ⋅ ∂x Bei diskreten Zufallsvariablen gilt: E ( X ) = ¦ x ⋅ P ( x) • Der bedingte Erwartungswert E ( X Y = y ) wird analog definiert. Man ersetzt jeweils nur die Wahrscheinlichkeit durch die bedingte Wahrscheinlichkeit. • Die bedingte Erwartung (synonym: die Regression) E ( X Y ) ist diejenige Zufallsvariable, deren Werte die bedingten Erwartungen sind. • X ist von Y regressiv unabhängig, wenn der bedingte Erwartungswert von X (stochastisch) unabhängig von (der Ausprägung von) Y ist. Regressive Abhängigkeit ist nicht kommutativ (Bsp.: Risikobereitschaft und Vermögen bzw. SÖS). Rechnen mit Erwartungswerten • E(X +Y ) = E(X )+ E(X ) • E (c ⋅ X ) = c ⋅ E ( X ) Kovarianz, Varianz, Standardabweichung, Korrelation • Kovarianz: σ X ,Y := E ( ( X − E ( X ) ) ⋅ (Y − E (Y ) ) ) = E ( X ⋅ Y ) − E ( X ⋅ E (Y ) ) − E ( E ( X ) ⋅ Y ) + E ( X ) ⋅ E ( X ) = E ( X ⋅Y ) − E ( X ) ⋅ E ( X ) − E ( X ) ⋅ E ( X ) + E ( X ) ⋅ E ( X ) = E ( X ⋅Y ) − E ( X ) ⋅ E ( X ) Rechenregeln: σ ( a0 + a1 ⋅ X , b0 + b1 ⋅ Y ) = a1b1σ X ,Y σ ( X + Y , Z ) = σ X ,Z + σ Y , Z • Varianz: σ X2 := σ X , X =E (( X − E ( X ) ) ) 2 = E ( X 2 ) − ( E ( X )) 2 Rechenregeln: σ 2 ( a0 + a1 ⋅ X ) = a12σ X2 σ 2 ( X + Y ) = σ X2 + σ Y2 + 2 ⋅ σ X ,Y • Standardabweichung: σ X := σ X2 • Korrelation: ρ X ,Y := σ X ,Y σ X ⋅σY • Zwei Zufallsvariablen sind korrelativ unabhängig, wenn ihre Korrelation null ist. Logische Beziehungen zwischen den Unabhängigkeitsrelationen Stochastisch Regressiv Korrelativ Tests als Zufallsexperimente (genaue Definitionen: siehe Anhänge bei Steyer & Eid, 2001) • Formal lässt sich die Durchführung eines Tests als Zufallsexperiment auffassen, da man davon ausgehen kann, dass verschiedene Verhaltensweisen der Testperson in der Testsituation möglich sind und u.U. auch die Auswahl der Testperson(en) vor Beginn der Untersuchung nicht feststeht. • Jeder mögliche Ausgang des Tests (bei Ziehung einer Testperson und Durchführung des Test) wird als Ergebnis bezeichnet. • Als Ereignis bezeichnet man eine Menge von Ausgängen eines Tests, die man (in gewisser Hinsicht) als äquivalent betrachtet (z.B. Ankreuzen oder Umranden einer Antwortalternative). • Ein Wahrscheinlichkeitsmass ordnet jedem Ereignis eine Wahrscheinlichkeit zu. • Man unterstellt die Existenz der beiden folgenden Zufallsvariablen Xi und pU, wobei 1. X den beobachteten Testscore der Person wiedergibt. 2. pU wiedergibt, welche Person getestet wurde. Dann wird der (bedingte) Erwartungswert der Zufallsvariablen Xi bei Testung der Person u als wahrer Wert τi bezeichnet. ( τ i := E ( X i | pU = u ) ). • Der Fehler bzw. das Residuum εi von Xi bzgl. τi ist die Differenz zwischen dem beobachtetem und dem wahren Wert: ε i := X i − τ i