IngenieurmathematikIV | Statistik | Wintersemester 1996/97 Umfang

Werbung

anstaltung

Skript von

Ingenieurmathematik IV

| Statistik |

Wintersemester 1996/97

Umfang: 2V + 2U

Dr. Rainer Schmidt

Technische Universitat Clausthal

Dr. Stefan Rettig

Technische Hochschule Darmstadt

Literatur

Lehrbucher

hoeck & Ruprecht 1979.

Lehn, J., Wegmann, H.: Einfuhrung in die Statistik. 2. Auage, Teubner 1992.

Kreyszig, E.: Statistische Methoden und ihre Anwendungen. 7. Auage, Vanden-

Ang, A. H.{S.; Tang, W. H.: Probability Concepts in Engineering Planning and

Design. Volume I: Basic Principles, Volume II: Decision, Risk, and Reliability.

Wiley & Sons 1975 bzw. 1984.

Heinhold, J.; Gaede, K.{W.: Ingenieur{Statistik. 4. Auage, Oldenbourg 1979.

Plate, E. J.: Statistik und angewandte Wahrscheinlichkeitslehre fur Bauingenieure. Ernst & Sohn 1993.

Ruegg, A.: Wahrscheinlichkeitsrechnung und Statistik { Eine Einfuhrung fur

Ingenieure. Oldenbourg 1994.

Weber, H.: Einfuhrung in die Wahrscheinlichkeitsrechnung und Statistik fur

Ingenieure. Teubner 1992.

Nachschlagewerke

Hartung, J.: Statistik. 9. Auage, Oldenbourg 1993.

Hartung, J.; Elpelt, B.: Multivariate Statistik. Oldenbourg 1984.

Sachs, L.: Angewandte Statistik. 7. Auage, Springer 1992.

Aufgabensammlungen

Oldenbourg 1973.

Lehn, J.; Wegmann, H.; Rettig, S.: Aufgabensammlung zur Einfuhrung in die Statistik. 2. Auage, Teubner 1994.

Heinhold, J.; Gaede, K.{W.: Aufgaben und Losungen zur Ingenieur{Statistik.

Sonstige Literatur

Dutter, R.: Geostatistik. Teubner 1985.

Chatterjee, S.; Handcock, M. S.; Simono, J. S.: A Casebook for a First Course in

Statistics and Data Analysis. Wiley & Sons 1995.

Kramer, W.: So lugt man mit Statistik. 4. Auage, Campus 1992.

2

2.2.2 Unabhangigkeit von Ereignissen . . . . . . . . . . . . . . . . . . . . . . . 44

2.2.3 Geometrische Verteilung . . . . . . . . . . . . . . . . . . . . . . . . . . . 47

2.2.4 Binomialverteilung . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 49

2.2.5 Poisson{Verteilung und Poissonscher Grenzwertsatz . . . . . . . . . . . . 51

2 Zweidimensionale Mereihen . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 18

1.1.5 Boxplots . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 16

1.1.4 Quantile . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 15

1.1.3 Streuungsmazahlen . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 13

1.1.2 Lagemazahlen . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 12

1.1.1 Graphische Darstellungen . . . . . . . . . . . . . . . . . . . . . . . . . .

1 Eindimensionale Mereihen . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

eschreibende Statistik

8

7

7

2.4.2 Erwartungswert einer stetig verteilten Zufallsvariable . . . . . . . . . . . 69

2.4.1 Erwartungswert einer diskret verteilten Zufallsvariable . . . . . . . . . . 67

2.4 Erwartungswert und Varianz . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 67

2.3.6 Normalverteilung . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 62

2.3.5 Exponentialverteilung . . . . . . . . . . . . . . . . . . . . . . . . . . . . 61

2.3.4 Rechteckverteilung . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 61

2.3.3 Eigenschaften der Verteilungsfunktion F . . . . . . . . . . . . . . . . . . 58

2.3.2 Stetig verteilte Zufallsvariable . . . . . . . . . . . . . . . . . . . . . . . . 57

2.3.1 Diskret verteilte Zufallsvariable . . . . . . . . . . . . . . . . . . . . . . . 55

haltsverzeichnis

1.2.1 Punktediagramm und Kontingenztafel . . . . . . . . . . . . . . . . . . . 18

2.4.3 Varianz einer Zufallsvariable . . . . . . . . . . . . . . . . . . . . . . . . . 72

2.3 Zufallsvariable und Verteilungsfunktion . . . . . . . . . . . . . . . . . . . . . . . 54

1.2.2 Korrelation . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 20

4

2.5 Zentraler Grenzwertsatz . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 81

2.4.6 Summen von Zufallsvariablen . . . . . . . . . . . . . . . . . . . . . . . . 77

2.4.5 Tschebyschesche Ungleichung . . . . . . . . . . . . . . . . . . . . . . . . 76

2.4.4 Rechenregeln fur Erwartungswerte . . . . . . . . . . . . . . . . . . . . . 74

28

1.2.3 Regression . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 23

Wahrscheinlichkeitstheorie

1 Zufallsexperiment und Wahrscheinlichkeit . . . . . . . . . . . . . . . . . . . . . 29

2.1.1 Grundbegrie . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 29

2.1.2 Laplace { Annahme . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 32

2.1.3 Zufallsvariablen . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 35

2 Bedingte Wahrscheinlichkeiten und Unabhangigkeit . . . . . . . . . . . . . . . . 38

2.2.1 Bedingte Wahrscheinlichkeiten . . . . . . . . . . . . . . . . . . . . . . . . 38

3

chlieende Statistik

84

1 Schatzverfahren . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 85

3.1.1 Erwartungstreue . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 86

3.1.2 Konsistenz . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 89

3.1.3 Momentenmethode . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 90

3.1.4 Maximum{Likelihood{Methode . . . . . . . . . . . . . . . . . . . . . . . 92

2 Kondenzintervalle . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 97

3.2.1 Kondenzintervalle bei Binomialverteilungsannahme . . . . . . . . . . . 98

3.2.2 2 {Verteilung . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 100

3.2.3 t{Verteilung . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 101

3.2.4 Kondenzintervalle bei Normalverteilungsannahmen . . . . . . . . . . . . 103

3 Empirische Verteilungsfunktion . . . . . . . . . . . . . . . . . . . . . . . . . . . 108

3.3.1 Zentralsatz der Statistik . . . . . . . . . . . . . . . . . . . . . . . . . . . 108

3.3.2 Wahrscheinlichkeitspapier . . . . . . . . . . . . . . . . . . . . . . . . . . 110

3.3.3 Kolmogoro{Smirnov{Test . . . . . . . . . . . . . . . . . . . . . . . . . . 113

4 Tests bei Normalverteilungsannahmen . . . . . . . . . . . . . . . . . . . . . . . 117

3.4.1 Einstichprobentests . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 117

3.4.2 Operationscharakteristik und Gutefunktion . . . . . . . . . . . . . . . . . 123

3.4.3 Zweistichprobentests . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 126

5 2{Anpassungstests . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 133

3.5.1 Prufen bei endlich vielen Merkmalswerten . . . . . . . . . . . . . . . . . 133

3.5.2 Prufen auf eine bestimmte Verteilung . . . . . . . . . . . . . . . . . . . . 136

3.5.3 Prufen auf einen Verteilungstyp . . . . . . . . . . . . . . . . . . . . . . . 139

5

Themen:

1. Beschreibende (deskriptive) Statistik

Aufbereitung von Daten

Darstellung und Analyse von Mereihen

Daten ordnen, praphisch aufbereiten, Kennzahlen berechnen

2. Wahrscheinlichkeitstheorie

Mathematische Modelle fur zufallige Vorgange

3. Schlieende (induktive) Statistik

Beurteilung von statistischen Daten

Schlufolgerungen aus statistischen Daten

Quantizierung der Risiken fur Fehlschlusse aus statistischen Daten

6

apitel 1

eschreibende Statistik

male:

qualitative Merkmale

z.B. Geschlecht, Familienstand, Religionszugehorigkeit, Wohnort

Rangmerkmale

z.B. Grad des Interesses am technischen Fortschritt

quantitativ{diskrete Merkmale

z.B. Anzahl defekter Stucke in einem Los, Kettenlange (Anzahl Kohlenstoatome) von

n{Alkanen in Dieselol

Merkmalsauspragungen entstehen in der Regel durch Zahlen

quantitativ{stetige Merkmale

z.B. Korperlange, Temperatur, Druck, Spannung

Merkmalsauspragungen entstehen in der Regel durch Messen

Eindimensionale Mereihen

n = Anzahl der Mewerte (Stichprobenumfang)

x1; : : :; xn (reelle Zahlen)

reihe (Merkmalsauspragungen)

i

7

1.1.1 Graphische Darstellungen

Stabdiagramm (bei quantitativ{diskreten Merkmalen)

j

j

#

h

s"

1

s

s

s

s

s

s

s

s

9

10

zeigt die relative Haugkeit einer Merkmalsauspragung innerhalb der beobachteten Mereihe

Beispiel

9

>

=

> n = 20

;

Anzahl defekter Stucke in Losen aus jeweils 1000 gleichartigen Bauteilen

3 1 0 0 2 2 0 5 4 7

0 1 6 9 0 4 2 1 0 2

s

0

8

Anzahl defekter Stucke 0 1 2 3 4 5 6 7 8 9

relative Haugkeit in % 30 15 20 5 10 5 5 5 0 5

zugehoriges Stabdiagramm

40

30

relative

Haugkeit 20

[%]

10

0

2 3 4 5 6 7

Anzahl defekter Stucke

Darstellung einer Mereihe durch ein Stabdiagramm nicht sinnvoll bei quantitativ{stetigen

Merkmalen, denn meist alle Werte x1 ; :::; xn verschieden, d.h. alle Stabe hatten Hohe n1 .

8

s

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

j

#j

h

s"

.

.

.

.

.

.

.

.

.

.

.

1

s

.

.

.

.

.

.

.

.

.

.

.

.

.

.

H : R! [0; 1]

s

.

.

.

.

s

.

.

.

.

.

.

.

s

.

.

.

.

.

.

.

.

s

.

.

.

.

3 4 5 6 7

Anzahl defekter Stucke

8

empirische Verteilungsfunktion

2

s

9

.... .... .... .... .... ..... ..... ..... ..... ..... .... .... .... .... ..... ..... ..... ..... ..... ..... .... .... .... .... .... ..... ..... ..... ..... ..... .... .... .... .... ..... ..... ..... ..... ..... .... .... .... .... .... ..... ..... ..... ..... ..... ..... .

.

.

.

.

s

H (x) = n1 (Anzahl der Mewerte x)

ive Summenhaugkeit

1.0

0.9

0.8

0.7

0.6

H (x) 0.5

0.4

0.3

0.2

0.1

0.0

0

10

eis: Die empirische Verteilungsfunktion spielt eine entscheidende Rolle in der Schlieenden

stik

9

Histogramm (bei quantitativ{stetigen Merkmalen)

Einteilung des Wertebereichs in k Klassen: (a0 ; a1 ]; (a1; a2 ]; : : :; (ak;1 ; ak]

Abtragen von Rechtecken uber den einzelnen Klassen, wobei

Breite eines Rechtecks = Klassenbreite

Klassenhaugkeit

Hohe eines Rechtecks = relativeKlassenbreite

Fazit: Die Flache des Rechtecks entspricht der relativen Klassenhaugkeit

Beispiel

1.000

20.0

absolute relative relative Klassenhaugkeit

Klasse

Klassenh. Klassenh.

Klassenbreite

(14:10; 14:15]

2 0.010

0.2

(14:15; 14:20]

4 0.020

0.4

(14:20; 14:25]

12 0.060

1.2

(14:25; 14:30]

23 0.115

2.3

(14:30; 14:35]

39 0.195

3.9

(14:35; 14:40]

42 0.210

4.2

(14:40; 14:45]

36 0.180

3.6

(14:45; 14:50]

24 0.120

2.4

(14:50; 14:55]

12 0.060

1.2

(14:55; 14:60]

6 0.030

0.6

Klassen

(14:10; 14:60] = (14

| :10; 14:15] [ (14:15; 14{z:20] [ : : : [ (14:55; 14:60]}

200 Nietkopfdurchmesser [mm] x1; : : :; x200 , alle im Intervall

Daten:

Nr.

1

2

3

4

5

6

7

8

9

10

200

10

gramm:

lt stets:

5.0

4.0

3.0

2.0

1.0

0.0

i=1

k

X

14.6

14.7

Klassenhaugkeit = 1

Klassenbreite relativeKlassenbreite

14.2 14.3 14.4 14.5

Nietkopfdurchmesser

rel. Klassenhaugkeit

Klassenbreite

14.1

Histogrammache =

hte: Nicht die Hohen, sondern die Flachen der Histogrammrechtecke charakterisieren die

ven Klassenhaugkeiten. Wichtig insbesondere bei nicht aquidistanten Klasseneinteilun-

11

1.1.2 Lagemazahlen

Mereihe x1; ::; xn

arithmetisches Mittel

x7 x1

x2

x

.

.

.

.

.

.

.

.

.

.

.

.

x = n1

i=1

n

X

x5

xi

Beachte: x ist im allgemeinen kein beobachteter Wert

x4

geordnete Mereihe

x6

x~ = x(4)

x(5)

x(5)

x(6) x(7)

x(6)

x(8)

x(7)

x3

x(2) x(3)

x~ = x(4)

fur n gerade

fur n ungerade

x(1) x(2) x(3) x(4) x(5) x(6) x(7)

Median (mittlerer Wert)

8

>

x

>

n + 1!

>

<

2

x~ =

> >

x

n

>

:

2

x(1)

x(2) x(3)

Beachte: x~ ist stets ein beobachteter Mewert !

Beispiele

n=7

n=8

x(1)

-x

-x

-x

Interpretation: Mindestens 50% der Mewerte sind x~ und mindestens 50% der Mewerte sind

x~

12

3 Streuungsmazahlen

groe Streuung: Lagemazahl hat geringe Aussagekraft

x

kleine Streuung: Lagemazahl hat hohe Aussagekraft

x

er: Angabe einer Streuungsmazahl zu einer Lagemazahl

nnweite

d = x(n) ; x(1)

n

X

i=1

1

1

n ; 1 und nicht n !

s2 = n ;1 1

(xi ; x)2

x(n)

;;;;;;;;;;;;;;;;;;; d ;;;;;;;;;;;;;;;;;;;!

x(1)

irische Varianz

hte: Der Vorfaktor ist

13

-x

-x

-x

i=1

v

u

n

p

X

u

s = t n ;1 1 (xi ; x)2 = s2

empirische Streuung oder Standardabweichung

Es gilt die folgende Formel:

=nx

nx2

n

X

s2 = 1

(xi ; x)2

n

;

1

i=1

n

X

= 1

(xi2 ; 2xxi + x2 )

n

;

1

i=1

n

n

n

X

X

X

= n ;1 1 ( xi2 ; 2x xi + x2 )

|i=1{z } |i=1{z }

i=1

n

X

= n ;1 1 ( xi2 ; nx2 )

i=1

Beachte: Anfalligkeit gegen Rundungsfehler bei groen Mewerten !

Variationskoezient

v = s=x

Weitere Streuungsmazahlen, die im Vergleich zur Standardabweichung weniger empndlich

auf extrem hohe bzw. niedrige Werte in der Mereihe reagieren:

8

n

X

dx = n1 jxi ; xj

i=1

durchschnittliche Mittelwertabweichung

Dabei ist

>

< y falls y 0

jy j = >

: ;y falls y < 0

durchschnittliche Medianabweichung

n

X

dx~ = n1 jxi ; x~j

i=1

14

4 Quantile

antil

i0<p<1

i ist

falls np nicht ganzzahlig

falls np ganzzahlig

[a] = grote ganze Zahl a

8

>< x

xp = ([np+1])

:> x(np)

iele: [3.5] = 3, [0.7] = 0

x(21)

x(20)

-x

-x

xp Schranke fur die unteren 100 p% der beobachteten Werte

pretation: Mindestens 100 p% der Mewerte sind xp und mindestens 100 (1 ; p)% der

werte sind xp.

iele:

:1; n = 20 ) n p = 2 ganzzahlig

x(2) = x0:1

0.1{Quantil

x(5) = x0:2

:2; n = 21 ) n p = 4:2 nicht ganzzahlig, [4:2 + 1] = [5:2] = 5

x(1)

0.2{Quantil

lt:

x0:5 = x~ ;

das 0:5{Quantil ist gerade der Median der Mereihe

15

Bezeichnungen:

x0:25 = unteres Quartil

x0:75 = oberes Quartil

x(12) = x0:75

x(16)

-x

Ein mit Hilfe von Quantilen deniertes Streuungsma ist der Quartilabstand:

q = x0:75 ; x0:25

Beispiel

x(4) = x0:25

;;;;;;;;; q ;;;;;;;;;!

n = 16 ) n 0:25 = 4 und n 0:75 = 12 ) q = x(12) ; x(4)

x(1)

x(8)

x

x0:75

x(12)

x(16)

r

x(16)

Interpretation: Zwischen x0:25 und x0:75 liegen die mittleren 50% der Mewerte.

1.1.5 Boxplots

x(4)

x0:25 x~ = x0:5

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

Verwendung insbesondere zum Vergleich von Mereihen

Es sei n = 16.

x(1)

r

x(1)

x x~

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

x~ ; x0:25 x0:75 ; x~

x0:25

x0:75

x(n)

r

; untere 25% ;! ;;;;;;;; mittlere 50% ;;;;;;;;! ;;; obere 25% ;;;!

symmetrisches Datenmaterial:

r

x(1)

16

-x

iel

25:4

24:6

26:5

27:1

24:7

21:8

23:5

24:6

25:5

26:7

27:0

26:1

24:5

23:4

26:3

22:8

24:0

24:7

25:5

27:0

25:5

24:7

24:3

24:1

21:8

22:8

24:1

24:8

25:6

27:1

20:9

26:5

24:5

26:7

23:2

22:9

24:1

24:9

26:0

27:3

24:0

27:5

27:0

24:9

24:3

23:2

24:3

25:0

26:1

27:4

25:1

25:6

27:3

23:5

24:5

23:4

24:3

25:1

26:3

27:5

22:2

22:9

25:0

27:4

26:0

23:5

24:5

25:1

26:4

27:5

24:8

25:5

22:8

25:5

24:1

23:5

24:5

25:1

26:5

28:3

25:1

23:5

23:5

22:8

27:5

9

>

>

>

>

>

>

>

=

> n = 50

>

>

>

>

>

>

;

9

>

>

>

>

>

>

=

> n = 50

>

>

>

>

>

>

;

x~ x

...

..

..

..

..

..

..

..

...

...

...

28.0

r

x = 501 (20:9 + 21:8 + : : : + 28:3) = 501 1247:3 = 24:946

x~ = x(25) = 24:8

x0:25 = x([12:5+1]) = x(13) = 23:9

x0:75 = x([37:5+1]) = x(38) = 26:3

r

22.0

30.0

22:2

23:9

24:7

25:5

27:0

ergehalte in 25 Bodenproben [ppm]

28:3

23:5

23:9

26:4

25:1

20:9

23:5

24:5

25:4

26:5

nete Mereihe:

zahlen:

lot:

20.0

24.0

26.0

Kupfergehalt

17

1.2 Zweidimensionale Mereihen

Mereihe

(x1 ; y1); : : : ; (xn; yn)

fur 2 Merkmale x und y, wobei die beiden Merkmalswerte jeweils an derselben Beobachtungseinheit (Person, : : :) erhoben werden.

Analyse der jeweiligen eindimensionalen Mereihen:

v

u

n

n

X

X

u

x1; : : :; xn ) x = n1 xi ; sx = t n ;1 1 (xi ; x)2

i

=1

i

=1

v

u

n

n

X

X

u

y1 ; : : :; yn ) y = n1 yi ; sy = t n ;1 1 (yi ; y)2

i=1

i=1

Frage: Besteht ein Zusammenhang zwischen x und y der folgenden Form:

"je groer x, desto groer y\

oder

"je groer x, desto kleiner y\ ,

d. h. ist die Tendenz "steigend\ oder "fallend\ ?

genauer: Besteht ein linearer Zusammenhang der Form

y = ax + b

d. h. lassen sich die Datenpunkte naherungsweise durch eine Gerade beschreiben ?

1.2.1 Punktediagramm und Kontingenztafel

Beispiel

x = Alter gesunder Manner

y = systolischer Blutdruck

18

0

10

s

s

s

70

s

ss

s s

s s s

s

s

s

s s ss

s s

sss

s

s

60

(qualitatives Merkmal)

(Rangmerkmal)

30

40

50

Alter [Jahre]

s ss

20

ss

Alter und systolischer Blutdruck bei gesunden Mannern

eihe

(x1 ; y1); : : :; (x30 ; y30 )

e ermittelt an 30 gesunden Mannern

140

160

180

200

ktediagramm

Blutdruck

[mbar]

120

100

tingenztafel

iel

mbefall bei Zuchtpferden

x = Rassenzugehorigkeit

y = Wurmbefall

n in Form einer Kontingenztafel

19

80

x

y Rasse 1 Rasse 2 Rasse 3

gering

28

19

17

mittel

9

6

35

stark

13

14

20

50

39

72

64

50

47

161

Hinweis : Bei quantitativen Merkmalen erhalt man eine Kontingenztafel durch eine Klasseneinteilung

1.2.2 Korrelation

empirische Kovarianz

sxy

n

X

(x ; x)(yi ; y)

= 1

n

;

1 i=1 i

n

X

= 1

n ; 1 i=1 (xi yi ; xi y ; x yi + x y)

0

1

B

C

B

C

B

C

B

C

n

n

n

n

X

X

X

X

B

C

B

C

= n ;1 1 B

C

Bi=1 xi yi ; i=1 xi y ; i=1 x yi + i=1 x y}C

C

B

|

{z

}

|

{z

}

|

{z

B

C

@

=ynx

=xny

=nxy A

{z

}

|

=;nxy

!

n

1 X

n ; 1 i=1 xi yi ; nx y

=

empirischer Korrelationskoezient

r = s sxy s

x y

20

y

6

;m

r>0

pretation von sxy :

y

+m

x

+m

sxy = n ;1 1

;m

i=1

y

y

6

;m

r<0

x

+m

;m

- x

viele Produkte negativ, wenige Produkte

positiv ) sxy < 0

negative Korrelation

+m

(xi ; x)(yi ; y)

n

X

- x

;1 r 1

viele Produkte positiv, wenige Produkte

negativ ) sxy > 0

positive Korrelation

lt:

rr

r

r

r

-

6 r r r = ;1

rr

r

-r

......

......

......

......

......

...

.

.

.

.

.....

......

.....

......

......

......

.....

......

......

.

.

.

.

.

......

......

......

.....

......

......

.....

......

....

.

.

.

.

.

......

.....

......

......

......

......

..

r

pretation : jrj ist ein Ma fur die "Tendenz\ zu einem linearen Zusammenhang der x- und

erte.

6 r=1

r r

.

.......

......

......

.....

......

......

.....

.....

......

......

.....

......

.......

......

......

......

......

......

.....

.....

......

......

......

......

......

......

......

......

......

......

.....

......

jrj = 1: Mewerte liegen auf einer Geraden

21

Beispiel

;1

r

positive Korrelation

r

;2

r

0

r

r

r

2

r

3

r

4

5

x = 11

9

y = ; 3 = ; 31

v9

u

2 !

u

= 1:922

sx = t 1 43 ; 9 119

8

v

u

2 !

u

sy = t 81 91 ; 9 ; 13 = 3:354

sxy = 81 32 ; 9 119 ; 31 = 4:458

1

r

4:458 = 0:692

r = 1:922

3:354

yi xi2 yi 2 xi yi

-3 4 9 6

-7 1 49 7

0 0 0 0

-2 1 4 -2

0 4 0 0

2 4 4 4

4 4 16 8

3 9 9 9

0 16 0 0

-3 43 91 32

Stichprobenumfang n = 9; Mereihe (x1 ; y1); : : :; (x9; y9 )

xi

-2

-1

0

1

2

2

2

3

4

Summe 11

Man erhalt:

;3

Punktediagramm:

4

2

0

;2

;4

;6

;8

Achtung : Korrelation nicht "blind\ ausrechnen !

Beispiel: 2 Untergruppen im Datenmaterial (Manner/Frauen)

insgesamt: r > 0

aber: in den Untergruppen jeweils r < 0

22

3 Regression

arer Zusammenhang der Form

unterstellt !

yi

6

s

y = ax + b

"

j

j

s

ax + b

Losung: a^; ^b

Regressionsgerade

y = ^ax + ^b

wird oft fur Prognosezwecke benutzt ! ("Schlu von x auf y\)

Bestimmung von a^ und ^b

i=1

n

X

@S (a; b)

@b = i=1 2(yi ; axi ; b)(;1)

n

X

=! 0

= ;2 (xi yi ; axi2 ; bxi)

n

@S (a; b) = X

2(yi ; axi ; b)(;xi )

@a

i=1

n

X

Nullsetzen des Gradienten von S :

also gilt

und man erhalt

Daraus folgt

i=1

ny ; anx ; nb = 0 ;

b = y ; ax

(xi yi ; axi2 ; yxi + axxi) = 0

i=1

n

X

xiyi ; nx y = a( xi2 ; nx2 ) ;

24

n

X

xiyi ; n x y

Kovarianz

a^ = i=1X

= sxy2 = empirische

n

empirische Varianz

sx

xi2 ; nx2

i=1

n

X

i=1

Einsetzen von b = y ; ax in die erste Gleichung liefert

n

X

i=1

= ;2 (yi ; axi ; b)

j

j

}

Aus der zweiten Gleichung folgt

ri

-

=! 0

xi

{z

=! minimal

s#

.

....

....

....

...

....

...

....

...

....

....

...

....

...

....

...

....

....

...

....

...

....

...

...

....

....

....

...

....

...

...

....

....

...

....

....

...

...

....

....

...

....

....

...

...

....

....

...

....

....

...

...

....

....

...

....

....

...

....

....

....

....

...

....

....

....

....

....

....

....

...

....

....

....

....

...

....

....

....

....

....

....

....

....

...

....

....

....

....

....

....

...

....

....

...

....

...

....

...

....

...

....

....

lem: Bestimmung von a und b ?

rium:

i ist

n

X

|i=1

(yi ; axi ; b)2

ri = yi ; (axi + b) ; i = 1; : : :; n

Werte heien Residuen.

n

X

i=1

ri2 =

hode der kleinsten Quadrate\:

S (a; b) =

Summe der vertikalen

Abstandsquadrate

23

t ergibt sich ^b zu

^b = y ; ^ax

Untersuchung der zweiten partiellen Ableitungen zeigt, da die Funktion S an der Stelle

tatsachlich ein Minimum besitzt !

y = ^ax + (y ; a^x) = ^a(x ; x) + y

;

;

^b = ; 1 ; 1:207 11 = ;1:809

3

9

x = 119 ; y = ; 13 ; sx = 1:922; sxy = 4:458

458 = 1:207

a^ = 14::922

2

(siehe oben)

hte : Der Punkt (x; y) liegt stets auf der Regressionsgeraden, wegen

iel

us folgt:

iel

^a = 1:493

{ Blutdruck bei gesunden Mannern; aus den Daten ergibt sich

^b = 80:7

formel:

Blutdruck 1.5 Alter + 80

Approximation kann zur Prognose herangezogen werden.

tediagramm mit Regressionsgerade:

25

Blutdruck

[mbar]

200

180

160

140

120

100

0

s ss

ss

20

n

X

ri2 =

s

s

ss

s s

s s s

s

s

s

s s ss

s s

ss

s s

s

30

40

50

Alter [Jahre]

s

70

(|yi ; ^a{zxi ; ^b})2 = (n ; 1) (1 ; r2 ) sy2

Residuum

n

X

i=1

B = r2

1 ssr

B = 1 ; n ; s12

y

i=1

60

80

....

....

...

....

....

...

....

...

....

...

....

....

...

....

...

....

...

....

....

...

...

....

....

....

...

....

...

....

....

...

...

....

...

....

....

....

....

....

....

....

....

....

....

....

....

...

....

...

....

....

...

....

....

....

...

....

...

...

....

...

....

....

....

....

...

....

...

....

...

....

....

...

....

....

....

....

....

...

....

....

....

...

....

....

....

....

....

...

....

....

....

...

....

....

....

....

....

....

....

...

....

....

....

...

....

....

....

....

....

...

....

....

....

s

Alter und systolischer Blutdruck bei gesunden Mannern

10

=

Zusammenhang mit Korrelationskoezienten

ssr

|{z}

Summe der

Residuenquadrate

Bestimmtheitsma

Es gilt

26

pretation

und

1.Fall: B = 0

Wegen r = 0 gilt fur die Parameter der Regressionsgerade

^b = y

a^ = 0

Die Regressionsgerade hangt somit nicht von x ab:

y ( x) = y

Es gilt insbesondere

1

2

n ; 1 ssr = sy ;

d. h. kein Anteil der Varianz der y{Werte kann durch einen linearen Zusammenhang

erklart werden.

2. Fall: B = 1

Wegen r2 = 1 gilt ssr = 0, d. h. alle vertikalen Abstande verschwinden und somit liegen

alle Punkte auf der Regressionsgeraden.

Fazit: Die gesamte Varianz der y{Werte ist in diesem Fall durch den linearen Zusammenhang erklart.

gressionsgeraden

Schlu von x auf y

Prinzip: Summe der quadrierten senkrechten Abstande minimal !

y ; y = ssxy2 (x ; x)

x

Schlu von y auf x

Prinzip: Summe der quadrierten waagrechten Abstande minimal !

;

;

x ; x = ssxy2 (y ; y)

y

Geraden fallen genau dann zusammen, falls

sxy = sy2

sx2 sxy

falls

2

sxy

sx2 sy2 = 1

B = r2 = 1

27

Kapitel 2

Wahrscheinlichkeitstheorie

Zufalligkeiten beeinussen Experimente und damit auch Meergebnisse; Versuchsergebnisse in

diesen Fallen meist nicht reproduzierbar; mogliche Ursachen:

gleich)

technische Variabilitat (keine zwei Untersuchungsgegenstande in ihrer Struktur vollig

Anderung

der Versuchsbedingungen (z. B. Ort und Zeit der Messung)

Mefehler (Storeekte uberlagern den wahren Wert)

Folge : Daten sind mit Streuung behaftet (Restvariabilitat)

stochastische Vorgange oder Zufallsexperimente

Vorgange, bei denen Ergebnis nicht aus Versuchsbedingungen vorhersagbar:

Beispiele

(Probenvariabilitat + Mefehler)

Messung des Spannungszustands einer Werkstoprobe in einem Zugversuch

(raumliche Variabilitat)

Anteil des Kupfergehalts in Bodenproben

(Variabilitat durch Zeitpunkt der Messung + Mefehler)

Verkehrsdichte an einer Kreuzung

Bestimmung der Nahrstokonzentration im Ablauf von Abwasserbehandlungsanlagen

(variierende Versuchsbedingungen [Industrie, Landwirtschaft, Haushalte] + zeitliche Abhangigkeiten + Mefehler)

28

monatliche Bestimmung der Biomasse in einem Wald

(variierende Versuchsbedingungen [Klima] + Probleme der Stichprobenauswahl)

Glucksspiele (Wurfeln, Roulette, Lotto, : : : )

rscheinlichkeitstheorie: mathematische Beschreibung von Zufallsexperimenten

! Ergebnis !

Zufallsexperiment und Wahrscheinlichkeit

1 Grundbegrie

hfuhrung eines Zufallsexperiments

ebereich oder Ergebnismenge: (! 2 )

iele

Wurfelwurf: = f1; 2; 3; : : :; 6g

Werfen zweier unterscheidbarer Wurfel:

= f(i; j ) j i; j = 1; : : :; 6g = f(1; 1); (1; 2); (2; 1); : : :g 36 Elemente

Werfen zweier nicht unterscheidbarer Wurfel:

= f(i; j ) j i; j = 1; : : :; 6 ; i j g

= f(1; 1); (1; 2); (2; 2); (1; 3); : : :g 21 Elemente

Lebensdauer eines Systems: = f! 2 Rj ! 0g = R+

Gerat defekt oder intakt: = f0; 1g ; 0 =b defekt, 1 =b intakt

gnisse: Teilmengen von (A )

(siehe oben)

hweise : Ereignis A tritt ein, falls Ergebnis ! 2 A beobachtet wird

iele

A = f1; 3; 5g beim Wurfelwurf

"ungerade Zahl\

A = f(1; 1); (1; 2); (2; 1)g "Summe 3\

29

3. A = f(1; 1); (1; 2); (2; 2); (1; 3); (2; 3); (3; 3)g "beide Augenzahlen 3\

4. A = f! 2 Rj ! > 100g = (100; 1) "langer als 100 Stunden\

5. A = f0g "Gerat defekt\

Zusammengesetzte Ereignisse

Es seien A und B Ereignisse

A\B = ; :

:

;:

Elementarereignis

unvereinbare oder disjunkte Ereignisse

sicheres Ereignis

leere Menge; unmogliches Ereignis

"A oder B\ : mindestens eines tritt ein , ! 2 A [ B

"A und B\ : beide treten gleichzeitig ein , ! 2 A \ B

Ac , "nicht A\ : komplementares Ereignis

f!g; ! 2 :

Ai

Ai

: "mindestens eines davon\

: "alle Ereignisse gleichzeitig\

sei A1 ; A2; : : : eine Folge von Ereignissen

1

\

i=1

1

[

i=1

Frage: Wie gro ist die Wahrscheinlichkeit dafur, da die Betriebsdauer eines Gerates exakt

100 Stunden betragt ?

Antwort: praktisch = 0

besser: Wie gro ist die Wahrscheinlichkeit dafur, da die Betriebsdauer eines Gerates

zwischen 90 und 100 Stunden liegt ?

also: Wahrscheinlichkeit fur das Eintreten des Ereignisses A = [90; 100]

Fazit : Ereignisse haben Wahrscheinlichkeiten !

30

P (A) = Wahrscheinlichkeit von A pretation : Bewertung des Ereignisses A nach dem Grad, wie sehr mit seinem

Eintreten zu rechnen ist.

A = System der Ereignisse, die betrachtet werden

P (f!g) = Wahrscheinlichkeit dafur, da ! auftritt

(Wahrscheinlichkeit des Elementarereignisses f!g)

nschaften

je zwei unvereinbar

9

>

P (A ) 0 ;

fur A 2 A

>

>

>

P (

) = 1;

hundertprozentig sicher\ =

"

1 1

> Kolmogoro 1933

>

P S Ai = P P (Ai ); falls A1 ; A2; :::: 2 A;

i=1

i=1

>

>

>

;

enregeln

P (A c ) = 1 ; P ( A )

P (;) = 0

0 P (A) 1 "Grad des Eintretens\

A B ) P (A) P (B )

Wahrscheinlichkeit des zusammengesetzten Ereignisses "A oder B\:

P (A [ B ) = P (A) + P (B ) ; P (A \ B )

Wahrscheinlichkeit des zusammengesetzten Ereignisses "A oder B oder C\:

P (A [ B [ C ) = P (A) + P (B ) + P (C )

; P (A \ B ) ; P (A \ C ) ; P (B \ C )

+ P (A \ B \ C )

[ : : : [ An )

1in

+

P (Ai \ Aj \ Ak )

1i<j<kn

; : : : + (;1)n+1 P (A1 \ : : : \ An )

X

X

=

P (Ai ) ;

P (Ai \ Aj )

1i<jn

X

allgemein: Wahrscheinlichkeit fur die Vereinigung endlich vieler Ereignisse

P (A1

lem: Festlegung von P

31

2.1.2 Laplace { Annahme

Falls = f!1 ; : : :; !ng eine endliche Menge ist und alle Elementarereignisse f!i g; i = 1; ::; n;

die gleiche Wahrscheinlichkeit haben, so gilt:

P (f!i g) = n1 ; i = 1; ::; n

der fur A gunstigen Ergebnisse

P (A) = Anzahl

Anzahl der moglichen Ergebnisse

in A = jAj

P (A) = Anzahl der Elemente

n

j

j

Aus der Laplace-Annahme folgt fur ein Ereignis A :

Interpretation

Beispiele

Werfen eines Wurfels: = f1; 2; 3; 4; 5; 6g

P ("ungerade Zahl\) = P (f1; 3; 5g) = 63 = 12

Werfen zweier unterscheidbarer Wurfel

= f1; : : :; 6g f1; : : :; 6g = f(i; j ) j i; j = 1; : : :; 6g

Es gilt bei Laplace{Annahme

P ("mindestens eine 6\) = P (f(1; 6); (2; 6); : : :; (6; 6); (6; 5); : : : ; (6; 1)g)

= 11

36

Achtung : Werfen zweier nicht unterscheidbarer Wurfel

= f(i; j )ji; j = 1; : : :; 6 ; i j g 21 Elemente

bei Laplace{Annahme:

1

P (f(1; 1)g) = 21

32

nicht gerechtfertigt ! besser:

A = "Summe betragt 12\

B = "Summe betragt 13\

C = "Summe betragt 11\

1

|P (f(1{z; 1)g)} = 2 |P (f(1{z; 2)g)}

1

2

36

36

oder allgemein

P (f(i; i)g) = 21 P (f(i; j )g) fur i 6= j

Diese Festlegung von P entspricht also nicht mehr der Laplace{Annahme, da die Elementarereignisse unterschiedliche Wahrscheinlichkeiten besitzen.

3 Wurfel werden geworfen; Ereignisse:

Mogliche Augenzahlen:

fur A : 1+5+6 2+4+6 2+5+5 3+3+6 3+4+5 4+4+4

fur B : 1+6+6 2+5+6 3+4+6 3+5+5 4+4+5

fur C : 1+4+6 1+5+5 2+3+6 2+4+5 3+3+5 3+4+4

= f(i; j; h) : i; j; h = 1; :::; 6g; j

j = 6 6 6 = 216

Anzahl der Moglichkeiten:

jAj = 6 + 6 + 3 + 3 + 6 + 1

jB j = 3 + 6 + 6 + 3 + 3

jC j = 6 + 3 + 6 + 6 + 3 + 3

Bei Laplace{Annahme gilt:

25

21

27

P (A) = 216

P (B ) = 216

P (C ) = 216

Werfen von 4 unterscheidbaren Munzen

= f(i; j; k; l) : i; j; k; l = 0; 1g = f0; 1g f0; 1g f0; 1g f0; 1g

wobei 0 =b Wappen, 1 =b Zahl. Es gilt

j

j = 24 = 16

Es sei

A = "mindestens einmal Wappen\

Aus der Laplace{Annahme folgt

1 = 15

P (A) = 1 ; P (Ac) = 1 ; P (f(1; 1; 1; 1)g) = 1 ; 16

16

33

Abzahlregeln

1. Platz 2. Platz : : : k. Platz insgesamt

n

n

:::

n

nk

Anzahl = nk

Es sei j

1 j = n1 und j

2j = n2. Dann gilt:

1 2 = f(!1 ; !2 ) : !1 2 1 ; !2 2 2 g

hat n1 n2 Elemente.

j

j = n ; k 2 N

geordnete Proben von k Elementen mit Wiederholungen:

Begrundung:

Moglichkeiten

1. Platz 2. Platz : : : k. Platz

n

n ; 1 : : : n ; (k ; 1)

n (n ; 1) : : : 2 1 = n! Permutationen

Moglichkeiten

Anzahl = n (n ; 1) : : : (n ; k + 1)

j

j = n ; k n

geordnete Proben von k Elementen ohne Wiederholung:

Begrundung:

Spezialfall: n = k

123 ; 132 ; 213 ; 231 ; 312 ; 321

Beispiel

Es sei n = 3. Permutationen

Anzahl Permutationen

Anzahl der k{elementigen Teilmengen von 1 2 3 = 3! = 6

j

j = n ; k n

ungeordnete Proben von k{Elementen ohne Wiederholungen:

!

n

k

34

Anzahl der geordneten Proben:

n (n ; 1) : : : (n ; k + 1)

da ungeordnet: je k! viele der geordneten Proben sind gleich, also

n (n ; 1) : : : (n ; k + 1)

k!

Durch Erweiterung des Bruches erhalt man

!

n (n ; 1) : : : (n ; k + 1) (n ; k) : : : 1 = n! =: n

k!

(n ; k) : : : 1 k!(n ; k)!

k

Binomialkoezienten

!

n

k

= "Anzahl der k{elementigen Teilmengen aus einer n{elementigen Menge\

= k! (nn;! k)!

!

4

4! 4 3 2 1

2 = 2!2! = 2 1 2 1 = 6

Beispiel

Es sei n = 4 und k = 2. Anzahl der 2-elementigen Teilmengen einer 4-elementigen Menge:

Aufzahlung der Teilmengen

f1; 2g; f1; 3g; f1; 4g; f2; 3g; f2; 4g; f3; 4g f1; 2; 3; 4g

3 Zufallsvariablen

Nicht das genaue Ergebnis !, sondern nur ein damit verbundener Zahlenwert ist von

esse.

iel: Augensumme beim Werfen von zwei Wurfeln

Zufallsvariable X : ! R

35

P (X = k) = P (A)

Von besonderem Interesse sind Ereignisse der Form "X = k\. Mit

A = f! 2 : X (!) = kg

gilt

Beispiel

X = Summe der Augenzahlen

Augensumme beim Wurf zweier unterscheidbarer Wurfel. Ergebnismenge des Zufallsexperiments:

= f1; : : :; 6g f1; : : :; 6g = f(i; j ) j i; j = 1; : : :; 6g 36 Elemente

Zufallsvariable

36

X:

ebereich von X : f2; 3; : : :; 12g.

2.2 Bedingte Wahrscheinlichkeiten und Unabhangigkeit

! R

(i; j ) 7! i + j

Wahrscheinlichkeit eines Ereignisses A : P (A)

Interpretation

eilung von X unter der Laplace{Annahme:

P (X = 2) = P (f(1; 1)g)

= 361

P (X = 3) = P (f(1; 2); (2; 1)g)

= 362

P (X = 4) = P (f(1; 3); (2; 2); (3; 1)g)

= 363

P (X = 5) = P (f(1; 4); (2; 3); (3; 2); (4; 1)g)

= 364

P (X = 6) = P (f(1; 5); (2; 4); (3; 3); (4; 2); (5; 1)g)

= 365

P (X = 7) = P (f(1; 6); (2; 5); (3; 4); (4; 3); (5; 2); (6; 1)g) = 366

P (X = 8)

P (X = 9)

P (X = 10)

P (X = 11)

P (X = 12)

= P (X = 6)

= P (X = 5)

= P (X = 4)

= P (X = 3)

= P (X = 2)

P (A) relative Haugkeit des Eintretens von A in langen Serien gleicher,

getrennter Versuche

Beispiel

Munzwurfe

= 365

= 364

= 363

= 362

= 361

n

lt:

P (X = k )

s

2

12

X

k=2

s

3

s

4

s

5

6

k

7

2048

12012

0.5069

0.5005

2.2.1 Bedingte Wahrscheinlichkeiten

s

8

Serie:

s

s

s

s

A

A

B

B

A

A

B

B

A

B

P (X = k) = 1 = P (

)

A

B

Es sei

nA = Anzahl Versuche mit A

nB = Anzahl Versuche mit B

nA\B = Anzahl Versuche mit A und B gleichzeitig

9 10 11 12

In der obigen Serie:

37

12

12

Gegeben seien zwei Ereignisse A und B

s

s

nWappen relative Haugkeit

Buon 4040

Pearson 24000

diagramm

6

36

5

36

4

36

3

36

2

36

1

36

P ("Wappen\) = P ("Zahl\) = 12

n = 12;

nA = 7 ;

nB = 6;

38

nA\B = 4

A

nA\B = nA\B =n

nA

nA=n

nA = 7

n 12

falls P (A) > 0

nA\B = 4 = 1 ;

n

12 3

rscheinlichkeit fur B unter der Bedingung, da A eintritt (d. h. zahle nur die Versuche, in

n A eintritt):

r obigen Serie:

nA\B = 4 ;

nA 7

pretation legt nahe:

ngte Wahrscheinlichkeit von B unter A

\ B)

P (B jA) = P (PA(A

)

mel der totalen Wahrscheinlichkeit

nisse A1 ; : : :; An seien paarweise unvereinbar (d. h. Ai \ Aj = ; fur i 6= j ).

i=1

i=1

n

X

i=1

n

X

P

(

B \ Ai )

P (Ai ) P (Ai )

P (B jAi ) P (Ai )

P (B jAi ) P (Ai ) =

P (B ) =

n

r sei S Ai = und P (Ai ) > 0 fur i = 1; : : :; n.

gilt

undung

n

X

i=1

39

Verallgemeinerung

P (B ) =

i=1

1

X

=

n

X

=

P (B \ Ai )

i=1

!

[n

= P

(B \ Ai)

1

0i=1

C

B

[n !C

C

B

B

= PB

B\

A C

@ | i=1{z i }A

= P (B )

P (B jAi ) P (Ai )

n

Es sei A1 ; A2; : : : eine Folge von paarweise unvereinbaren Ereignissen mit S Ai = und

i=1

P (Ai ) > 0 fur i = 1; 2; : : :

Dann gilt

Beispiel

4 ;

P (B jA1 ) = 31

A1 = "kein As beim 1. Zug\

A2 = "As beim 1. Zug\

B = "As beim 2. Zug\

P (A2 ) = 324 ;

3

P (B jA2 ) = 31

32 Karten (Skat), 4 Asse, 2 Karten ziehen (ohne Zurucklegen der ersten Karte);

Ereignisse:

Laplace{Annahme:

28 ;

P (A1 ) = 32

Mit der Formel der totalen Wahrscheinlichkeit folgt:

P (B ) = 4 28 + 3 4 = 1

31 32 31 32 8

40

mel von Bayes

Multiplikationsformel

0:001

0:01

Begrundung

Sei

2 ) P (A1 \ A2 \ A3 )

= P (A1 ) P (PA1(A\ A

P (A \ A ) : : :

1)

1

2

A1 \ : : : \ An;1 ) P (A1 \ : : : \ An)

: : : PP ((A

1 \ : : : \ An;2 ) P (A1 \ : : : \ An;1 )

= P (A1 \ : : : \ An )

42

A1 = "2. Person hat anderen Geburtstag als 1. Person\

A2 = "3. Person hat anderen Geburtstag als 1. und 2. Person\

A = "4. Person hat anderen Geburtstag als 1., 2. und 3. Person\

3

...

A

= "k{te Person hat anderen Geburtstag als 1., 2., : : : , (k ; 1){te Person\

k

;

1

...

An;1 = n{te Person hat anderen Geburtstag als alle vorher\

"

P (A1 \ : : : \ An;1 ) = ?

P (A1 ) = 364

365

363

P (A2 jA1) = 365

P (A3 jA1 \ A2 ) = 362

365

...

(n ; 1) = 365 ; n + 1

P (An;1 jA1 \ : : : \ An;2 ) = 365 ;365

365

n zufallig ausgewahlte Personen

P ("keine 2 Personen haben am selben Tag Geburtstag\ ) = ?

Beispiel

P (A1 ) P (A2 jA1) P (A3 jA1 \ A2 ) : : :

: : : P (An;1 jA1 \ : : : \ An;2 ) P (An jA1 \ : : : \ An;1 )

P (A1 \ : : : \ An ) = P (A1 ) P (A2 jA1) P (A3 jA2 \ A1 ) : : : P (An jA1 \ : : : \ An;1 )

A1 ; : : :; An Ereignisse mit P (A1 \ : : : \ An;1 ) > 0

P (B jAi ) P (Ai )

P (Ai jB ) = P (PA(i B\)B ) = X

n

P (B jAk ) P (Ak )

k=1

eignis mit P (B ) > 0 ; A1 ; : : :; An wie bei der Formel der totalen Wahrscheinlichkeit

iel

(korrektes Ergebnis)

0:999

A = "untersuchter Patient hat Tbc\

B = "positiver Befund\

P("untersuchter Patient hat Tbc\ j "positiver Befund\) = ?

Rontgenreihenuntersuchung

ahmen:

P (B jA) = 0:92

(falsches Ergebnis)

P (A) = 0:001

P (B jAc) = 0:01

der Formel der totalen Wahrscheinlichkeit folgt:

0:92

P (B ) = |P (B{zjA)} |P ({zA)} + |P (B{zjAc)} |P ({zAc)} = 0:01091

Bayessche Formel liefert:

0:001 = 0:0843

P (AjB ) = P (B jPA()B )P (A) = 0:092:01091

P (Ac jB ) = 1 ; P (AjB ) = 0:9157 92%

41

Werfen von 3 Munzen

Multiplikationsformel liefert:

: : (365 ; n + 1)

P (A1 \ : : : \ An;1 ) = 364 363 :365

n;1

: (365 ; n + 1) (Laplace{Annahme)

= 365 364 : :365

n

Pfaddiagramm:

Z

0.973

0.589

0.294

0.030

0.006

W

1/2

1/2

1/2

Z

W

Z

X=0

X=1

X=1

X=2

X=1

W

P (X = 0)

P (X = 1)

P (X = 2)

P (X = 3)

iele

W

1/2

W

phische Methode (Pfadregel)

1/2

Z

X=2 X=2

2. Munze

1/2

W

3. Munze

X=3

= 12 12 12 = 18

= 3 18 = 38

= 3 18 = 38

= 12 12 12 = 18

bei n Munzen:

! n

P (X = k) = nk 12

k = 0; : : :; n

P ("As beim 2. Zug\) = ?

Pfaddiagramm:

1/2

Z

Z

also

32 Karten (Skat), 4 Asse, 2 Karten ziehen (ohne Zurucklegen der 1. Karte)

1/2

1/2

Z

1/2

1. Munze

W

1/2

endung der Multiplikationsformel:

(Binomialverteilung, siehe unten)

2.2.2 Unabhangigkeit von Ereignissen

4/32

28/32

kein As

also

1/2

1/2

n P (A1 \ : : : \ An;1 )

5

20

30

50

60

X = Anzahl Munzen mit Wappen sichtbar

Beispiel

As

27/31

4/31

28/31

3/31

kein As

As

kein As

As

3 4 + 4 28 = 1

P ("As beim 2. Zug\) = 31

32 31 32 8

43

1. Zug

32 Karten (Skat), 4 Asse, 2 Zuge mit Zurucklegen der 1. Karte ; die Asse seien die Karten mit

den Nummern 1, 2, 3 und 4

2. Zug

Ergebnismenge:

= f1; 2; 3; 4; : : :; 31; 32g f1; 2; 3; 4; : : :; 31; 32g

Ereignisse:

= f1; 2; 3; 4g f1; 2; : : :; 32g

= f1; 2; : : :; 32g f1; 2; 3; 4g

A \ B = f1; 2; 3; 4g f1; 2; 3; 4g

A

B

44

322 Elemente

"1. Karte ein As\

"2. Karte ein As\

"zweimal As\

ace{Annahme:

1

P (A) = 432 32

2 = 8 = P (B )

16 = 1

P (A \ B ) = 32

2

64

"B hat keinen Einu auf A\

"A hat keinen Einu auf B\

"getrennte Versuchsteile bestimmten das Eintreten von A und B\

, P (A \ B ) = P (A) P (B )

P (AjB ) = P P(A(B\B) ) = 648 = 81 = P (A)

P (B jA) = P P(B(A\A) ) = 648 = 81 = P (B )

ngte Wahrscheinlichkeiten:

ition

P (A \ B ) = P (A) P (B )

nisse A und B heien unabhangig, falls gilt

endung

(A1 1 )

(B2 2 )

= 1 2 = f(!1 ; !2 )j!1 2 1; !2 2 2 g

1. Zufallsexperiment : Ergebnismenge 1

2. Zufallsexperiment : Ergebnismenge 2

truktion von Modellen bei mehrstugen Experimenten

samt:

nisse:

A = A1 2

B = 1 B2

ussetzung: Experimente ohne gegenseitige Beeinussung

:

P (A \ B ) = P (A) P (B )

45

Beispiele

Ai = "Bauteil i intakt\ ; i = 1; 2

G = "Gerat intakt\

2 Bauteile, I = Serienschaltung, II = Parallelschaltung;

Ereignisse:

Es sei

pi = P (Ai ); i = 1; 2

P (A1 \ A2 ) = P (A1 ) P (A2 ) = p1 p2

Annahme: A1 ; A2 stochastisch unabhangig. Dann gilt:

Daraus folgt:

P I (G) = P (A1 \ A2 ) = P (A1 ) P (A2 ) = p1 p2

P II (G) = P (A1 [ A2 ) = P (A1 ) + P (A2 ) ; P (A1 \ A2 ) = p1 + p2 ; p1 p2

Es gilt:

P I (G) < P II (G)

= f1; 2; 3; 4g; P (fig) = 14 ; i = 1; : : :; 4; Laplace{Annahme;

Sei

A = f1; 2g; B = f1; 3g; C = f2; 3g

Es gilt:

P (A \ B ) = 14 = 21 21 = P (A) P (B )

46

Es gilt also fur i = 1; 2; 3; : : :

ebenso:

P (A \ C ) = P (A) P (C )

P (B \ C ) = P (B ) P (C )

aber:

Verallgemeinerung

P (A \ B \ C ) = 0 6= P (A) P (B ) P (C )

"A; B; C paarweise unabhangig, aber nicht vollstandig unabhangig\

3 Geometrische Verteilung

iel

"Warten auf den ersten Erfolg\

Es sei

p = Erfolgswahrscheinlichkeit pro Experiment

und

X = Anzahl der benotigten Versuche bis zum 1. Erfolg

Falls die einzelnen Experimente sich nicht gegenseitig beeinussen (Unabhangigkeitsannahme),

gilt

en auf die erste "6\ beim Wurfeln

i

X = Anzahl der benotigten Wurfe

P (X = i) = p (1 ; p)i;1 ;

r der Annahme, da die einzelnen Wurfe ohne gegenseitige Beeinussung erfolgen (Unngigkeitsannahme), gilt:

X=1

X=2

X=3

X=4

=6

=6

=6

=6

1/6

1/6

1/6

<6

5/6

<6

5/6

i;1

P (X = i) = 16 65

"X geometrisch verteilt mit Parameter p\

Es gilt:

1

X

1

1

X

X

P (X = i) = p (1 ; p)i;1 = p

(1 ; p)i

i=1

i=1

i|=0 {z }

1/6

<6

5/6

<6

5/6

i = 1; 2; 3; : : :

= p 1 ; (11 ; p) = 1

geometrische

Reihe

.......

us folgt:

P (X = 1) = 61

P (X = 2) = 56 16

2

P (X = 3) = 65 16

3

P (X = 4) = 56 16

47

(beachte : P (

) = 1 !)

Beispiel

Wurfelwurf

X = Anzahl der Versuche bis zur ersten 6

Gesucht ist die Wahrscheinlichkeit fur das Ereignis

usw

A = "erste 6 spatestens beim 3. Wurf\

48

erhalt:

i wurde benutzt:

fur q > 0

91 = 0:4213

= 216

n+1

qi = 1 1;;q q

i;1

3

3

X

X

P (X 3) =

P (X = i) = 1 5

i=1

i=1 6 6

5 3

2 5 i 1 1 ;

X

6

= 1

= 6

6

i=0 6

1 ; 56

n

X

i=0

4 Binomialverteilung

hfuhrung von n gleichen Zufallsexperimenten ohne gegenseitige Beeinussung (! Unngigkeitsannahme)

= f(!1 ; !2 ; : : :; !n) j !i 2 f0; 1gg

X = Anzahl Experimente mit A ("Anzahl Erfolge\)

nis A vorgegeben; "Erfolg\ = "A tritt ein\

bnismenge:

i

!i = 0 , kein Erfolg

!i = 1 , Erfolg

X : ;! N

(!1 ; !2 ; : : :; !n) 7! Anzahl i mit !i = 1

0p1

"k Erfolge\

p = P (A) = Erfolgswahrscheinlichkeit pro Experiment ;

lsvariable X :

i

! = (!1 ; !2 ; : : :; !n ) 2 mit X (!) = k

49

k

n

pk

|{z}

k Erfolge

n;k

|(1 ;{zp) }

n ; k Mierfolge

k = 0; 1; : : :; n

solcher ! mit X (!) = k (Anzahl Serien mit genau k Erfolgen). Daraus

P (f!g) =

Dann gilt aufgrund der Unabhangigkeitsannahme:

Es gibt insgesamt

folgt:

!

P (X = k) = nk pk (1 ; p)n;k ;

!

"X binomialverteilt mit Parametern n und p\

Schreibweise: X B (n; p)

Es gilt:

n

n n

X

X

P (X = k) =

pk (1 ; p)n;k

k=0

k=0 k

= (p + (1 ; p))n

= 1 (P (

) = 1 !)

n n!

X

k n;k

k a b

k=0

k = 0; 1; 2; 3

X B (n; p) mit n = 3 und p = 61 ;

X = Anzahl der "Sechsen\

(a + b)n =

Dabei wurde die binomische Formel benutzt:

Beispiel

3 Wurfe eines Wurfels

Es gilt:

also

! k 3;k

P (X = k) = k3 61 65

;

50

Formel liefert:

samt gilt:

P (X = 0)

P (X = 1)

P (X = 2)

P (X = 3)

3

= 0:5787

= 0:3472

= 0:0694

= 0:0046

216 = 1

P (X = k) = 216

125

5

=

=

56 2 216

75

=3 1

=

6 2 56 216

15

=3 1

= 216

16 3 6

=

= 2161

6

3

X

k=0

em : Berechnung von P (X = k) bei groem n !

k

= k) = k! e; ; k = 0; 1; 2; : : :

nlim

!1 n pn = > 0

5 Poisson{Verteilung und Poissonscher Grenzwertsatz

nlim

!1 P (Xn

Xn B (n; pn ) ; n = 1; 2; : : : ;

sonscher Grenzwertsatz

gilt:

undung

kn

!

P (Xn = k) = n pk (1 ; pn )n;k

n

k

n

k 1 ; npn

n

= n(n ; 1) : :k: ! (n ; k + 1) npnn

(1 ; pn )k

!

0 ! 1n 1 z}|{C 1 1 ; n : : : 1 ; k ;n 1

k B

= (npn ) B1 ; npn C A

k

n

(1

;

| k{z! } @

|

{zpn )

}

k |

{z }

!1

!

!e;

k!

k e;

k!

n;!

!1

51

i

P (X = i) = i! e; ;

Eine Zufallsvariable X mit

ex =

1 xi

X

i!

i=0

1

X

i=0

i = 0; 1; 2; : : :;

1 i

X

; i! = e e = 1

i=0

>0

(Reihenentwicklung der Exponentialfunktion)

P (X = i) = e;

heit "Poisson{verteilt\ mit Parameter . (Verteilung fur die Anzahl des Auftretens seltener

Ereignisse.)

Es gilt:

wegen

Anwendung

Anzahl der "Erfolge\, falls

Zufallsexperiment sehr oft wiederholt wird und

Erfolgswahrscheinlichkeit p bei einem Experiment gering.

Beispiele:

Anzahl der Unfalle eines Autofahrers pro Jahr

Anzahl der Anrufe in einer Telefonzentrale zwischen 10.00 Uhr und 10.05 Uhr

fur k = 0; 1; : : :; n

X B (n; p) ; wobei n gro und p klein

Approximation von Binomialwahrscheinlichkeiten

Dann gilt mit = n p

k

P (X = k) k! e;

52

iel

2.3 Zufallsvariable und Verteilungsfunktion

Beispiele

Werfen eines Wurfels

6; 6; 1; 3

mogliche Werte von X : 1, 2, 3, 4, 5, 6

bei 5{maliger Versuchswiederholung konnten folgende Ergebnisse auftreten:

4;

|{z}

Realisation

von X

X = Gewicht eines Huhnereies

mogliche Werte von X : alle positiven reellen Zahlen

aber: Das Auftreten bestimmter Werte ist sehr unwahrscheinlich

54

Problem : Beschreibung (Darstellung) der Verteilung von X

d. h. man kennt die Verteilung von X .

"Man kennt die Wahrscheinlichkeiten, mit denen X bestimmte Werte annimmt.\

Annahme :

X = geworfene Augenzahl

spezielles Versuchsergebnis x: Realisation von X

Zufallsvariable X beschreibt den Ausgang eines Zufallsexperiments

X B (200; 0:02)

X = Anzahl herausgegriener Personen mit Blutgruppe AB

erden 200 Personen zufallig gewahlt. Anteil der Personen mit Blutgruppe AB in der

lkerung betrage 2%. Sei

lt

= 200 0:02 = 4 erhalt man naherungsweise nach dem Poissonschen Grenzwertsatz:

P (X > 3) = 1 ; P (X 3)

3 k

X

1 ; e;4 k!

k=0

= 1 ; e;4 1 + 4 + 8 + 32

3

= 1 ; e;4 71

3

= 0:5665

53

1 Diskret verteilte Zufallsvariable

Darstellung der Verteilung von X als Stabdiagramm

endung meistens beim Zahlen

Beispiel

iele

X B (3; 12 ) , also

geometrisch{verteilte Zufallsvariable

binomial{verteilte Zufallsvariable

!

! 3

P (X = k) = k3 21 = k3 18 ;

Man erhalt:

Poisson{verteilte Zufallsvariable

Werte xi

x1 x2 x3 . . .

Wahrscheinlichkeit P (X = xi ) p1 p2 p3 . . .

iele

P (X = 1) = 38

P (X = 3) = 18

P (X = 0) = 18

P (X = 2) = 83

tetabelle

k = 0; 1; 2; 3

P(X=k)

1

1/2

Wurfelwurf

X = geworfene Augenzahl

1/8

xi

1 2 3 4 5 6

P (X = xi ) 16 16 16 16 16 16

X B (n; p) (Binomialverteilung)

Dann gilt fur k = 0; 1; : : :; n:

die Wahrscheinlichkeiten pi gilt stets:

0 pi 1

i

pi =

2

3

Analogie: Stabdiagramm in der beschreibenden Statistik bei quantitativ{diskreten Merkmalen

Verteilungsfunktion

xk = k

!

pk = P (X = k) = nk pk (1 ; p)n;k ; 0 p 1

X

x

1

0

X

i

fur alle i

F (x) := P (X x) =

X

i mit

xi x

P (X = xi )

= Wahrscheinlichkeit dafur, da X Werte x annimmt

P (X = xi ) = 1

55

56

iel

Dichtefunktion f

B (3; 12 )

Eine Funktion f : R! [0; 1) heit Dichte von X , wenn die Verteilungsfunktion von X gegeben

ist durch

Zx

F (x) = P (X x) = f (t)dt

F(x)

1

P(X=3)=1/8

;1

f(t)

P(X=2)=3/8

1/2

P(X=1)=3/8

P(X=0)=1/8

0

1

2

3

x

ogie : relative Summenhaugkeitsfunktion in der beschreibenden Statistik (empirische

eilungsfunktion)

lt:

P (a < X b) = F (b) ; F (a) ;

P (a X b) = F (b) ; F (a) + P (X = a)

t

x

Flacheninhalt = F(x) = P(X < x)

Insbesondere gilt dann

Z1

;1

f (t)dt = 1

Gesamtache

f(t)

Flache = 1

2 Stetig verteilte Zufallsvariable

endung: in der Regel beim Messen

Wert eines Intervalls ist moglich, nicht nur diskrete Werte wie ganze Zahlen.

t

2.3.3 Eigenschaften der Verteilungsfunktion F

eilungsfunktion F

F (x) := P (X x)

= Wahrscheinlichkeit dafur, da X Werte x annimmt

t wei man alles uber die Zufallsvariable X , z. B.

P (a < X b) = F (b) ; F (a)

57

Es sei F die Verteilungsfunktion einer Zufallsvariablen X . Dann gilt:

F ist stetig von rechts.

F ist monoton wachsend.

0 F (x) 1 fur alle x 2 R

x!;1

lim F (x) = 0

58

P (a < X b) = F (b) ; F (a) = Ra f (t)dt = P (a X b)

b

F(x)

1

f(t)

Flache = P(a < X < b)

0

x

xlim

!1 F (x) = 1

F ist eine Treppenfunktion, falls X diskret verteilte Zufallsvariable

F(x)

0

t

a

b

R f (t)dt = P (X < b)

P (X b) = F (b) = ;1

b

1

P (X > a) = 1 ; F (a) = Ra f (t)dt = P (X a)

1

f(t)

0

x

Flache = P(X > a)

F ist eine stetige Funktion (keine "Sprunge\), falls X stetig verteilt mit Dichte f

Zx

F (x) = f (t)dt

;1

beachte : Integral hangt nur von der oberen Grenze ab.

0

t

a

P (jX j c) = P (;c X c) = ;Rc f (t)dt = F (c) ; F (;c)

F(x)

c

1

f(t)

Flache = P(|X| < c)

0

x

i X eine stetig verteilte Zufallsvariable mit Dichte f . Dann gilt:

0

t

-c

P (X = c) = 0 fur beliebiges c

59

c

0

60

4 Rechteckverteilung

teckverteilung (Gleichverteilung)

e:

X R(a; b)

a

b

8

<> 1 fur a t b

f (t) = b ; a

:> 0 sonst

f(t)

0.5

1

1.5

2

3

3.5

4.5

5

t

Verteilungsfunktion:

Es gilt im Fall x < 0:

Im Fall x 0 erhalt man:

Insgesamt also:

1

0.9

0.8

0.7

0.6

0.5

0.4

0.3

0.2

0.1

0

0

0

Zx

Zx

;1

f (t)dt

e;tdt

F (x) = 0

F (x) =

F (x) =

= ;e;tj0x = ;e;x + 1

8

>

<

0

x<0

F (x) =

>

: 1 ; e;x x 0

0.5

1

1.5

62

2.5

x

3

3.5

4

4.5

2 R; 2 > 0

5

2

;(t ; )2

;1 t ; 22 = p1 e 2 2

X N (; 2) ;

f (t) = p1 e

2

2

Verteilungsfunktion der Exponentialverteilung mit Parameter = 1:0

Dichte:

Normalverteilung mit Parametern und 2

2.3.6 Normalverteilung

F(x)

1/(b-a)

5 Exponentialverteilung

0

4

8

>

< 0 fur t < 0

f (t) =

>

: e;t fur t 0

X Exp()

nentialverteilung mit Parameter > 0

e:

1

0.9

0.8

0.7

0.6

0.5

0.4

0.3

0.2

0.1

0

61

2.5

x

e der Exponentialverteilung mit Parameter = 1:0

f(x)

en der Normalverteilungen mit Parametern

= 0:0 ;

= 5:0

1

= 1:0

;

0.9

0.8

= 4:0

0.7

0.6

F(x)

0.4

0.35

0.5

0.4

0.3

0.3

0.25

0.2

0.2

0.1

0.15

0

0.1

-4

-3

-2

-1

0

x

1

2

3

4

3

4

0.05

Integral nicht geschlossen losbar, deshalb in Tabellen !

0

-6

-4

-2

0

2

4

6

8

10

12

14

16

x

Es gilt:

(;x) = 1 ; (x)

Standard{Normalverteilung

meter = 0; 2 = 1

e:

; 1 t2

f (t) = p1 e 2

2

fur alle x 2 R

0.4

0.35

0.3

0.4

0.25

f(x)

0.35

0.2

0.3

0.15

f(x)

0.25

0.2

0.1

0.15

0.05

0.1

0

0.05

-4

0

-4

-3

-2

-1

0

x

1

ilungsfunktion der Standard{Normalverteilung:

Zx

e; t dt

(x) = p1

2 ;1

1 2

2

63

2

3

4

-3

-2

-1

0

x

1

Sei X N (; 2) mit Verteilungsfunktion F; (x). Dann gilt:

2

F; (x) = x ; 2

64

2

mit der Substitution u = t; (du = dt) erhalt man:

F; (x) =

Zx

p1

t;

e; ( ) dt

2

1

2

2 ;1

x;

Z

= p1

e; u du

2 ;1

= x ; 2

1

2

r gilt:

P; (a < X b) = F; (b) ; F;

2

Beispiel

2

2

X N (; 2)

P (jX ; j 2) = P ( ; 2 X + 2)

= F; ( + 2) ; F; ( ; 2)

= + 2 ; ; ; 2 ; = (2) ; (;2)

2

2

2

= 2(2) ; 1

! (a) = b ; ; a ; = 0:9544 95%

"2{Regel\

e und Verteilungsfunktion von X

Interpretation : Abweichungen von , die groer als 2 sind, treten bei normalverteilten Zufallsvariablen nur mit einer Wahrscheinlichkeit von 5% auf.

f(t)

Veranschaulichung im Falle der Standard{Normalverteilung

0.4

0.35

0.3

f(x)

0.25

0.2

1

0.15

0.841

F(x)

0.1

0.05

0.5

0

-4

0.159

-3

-2

-1

0

x

0

65

66

1

2

3

4

Erwartungswert und Varianz

hreibende Statistik

Mereihen

Kennzahlen: Lageparameter

Streuungsparameter

rscheinlichkeitstheorie

Verteilungen von Zufallsvariablen

Kennzahlen: Erwartungswert (Mitte der Verteilung)

Varianz (Breite der Verteilung)

1 Erwartungswert einer diskret verteilten Zufallsvariable

ilung von X gegeben als Wertetabelle:

X

xi P (X = xi)

Werte xi

x1 x2 x3 . . .

Wahrscheinlichkeit P (X = xi ) p1 p2 p3 . . .

artungswert von X

E (X ) =

i

"gewichtete Summe\

die Reihe absolut konvergent ist !

67

Beispiele

X B 3; 21

bzw.

P (X = 0) = 81

P (X = 3) = 81

P (X = 1) = 83

k = 0; 1; 2; 3

P (X = 2) = 83

, also

! 3

!

P (X = k) = k3 21 = k3 81 ;

Erwartungswert von X :

i = 0; 1; 2; : : :

E (X ) = 0 P (X = 0) + 1 P (X = 1) + 2 P (X = 2) + 3 P (X = 3)

= 0 1 +1 3 +2 3 +3 1

8

8

8

8

3

= 12

8 =2

i

X

i=1

=1

h(xi ) P (X = xi )

= 1 i

X

= i! e;

|i=0 {z }

= 1 i

X

E (X ) =

i e;

i=0 i!

1 i;1

X

;

(i ; 1)! e

P (X = i) = i! e; ;

i

X Poisson{verteilt mit Parameter > 0 , also

Erwartungswert von X :

Transformationen

Es sei h : R;! R beliebig. Dann gilt

E (h(X )) =

68

E (X 2 ) =

die Reihe absolut konvergent ist !

endungen

h(x) = x2

Beispiel

X B 3; 12

X

i

xi2 P (X = xi)

= xi )

E (X 2) = 0 P (X = 0) + 1 P (X = 1) + 4 P (X = 2) + 9 P (X = 3)

X

E (X k ) = xik P (X

k{tes Moment der Zufallsvariable X

i

= 0 81 + 1 83 + 4 38 + 9 81

= 24 = 3

8

h(x) = xk ; k 2 N

in diesem Sinne:

E (X ) = 1. Moment (Erwartungswert)

E (X 2 ) = 2. Moment

E (X 3 ) = 3. Moment

:::

2 Erwartungswert einer stetig verteilten Zufallsvariable

i X eine stetig verteilte Zufallsvariable mit Dichte f

artungswert von X

69

E (X ) =

falls der Integrand absolut integrierbar !

Beispiel

Z1

;1

x f (x) dx

X exponentialverteilt mit Parameter > 0 ; Dichte:

8

>

<

0

x<0

f (x) =

>

: e;x x 0

;1

= ;(0 ; 1 ) = 1

Z1

;1

0

h(x) f (x) dx

1

= (0 ; 0) ; 1 e;x

0

0

= ;xe;x0 + e;x dx

1 Z1

Z1 1

= x ; 1 e;x ; ; 1 e;xdx

0

0

E (X ) =

Erwartungswert von X (durch partielle Integration):

Z1

Z1

x f (x)dx = xe;xdx

Transformationen

Es sei h : R;! R stetig. Dann gilt

E (h(X )) =

falls der Integrand absolut integrierbar !

70

"quadratische Abweichung von E (X )\

h(x) = [x ; E (X )]2

2.4.3 Varianz einer Zufallsvariable

x2 f (x) dx

endungen

Z1

;1

Es sei

E (X 2) =

V ar(X ) = E (h(X )) = E ([X ; E ({zX )}]2)

|

feste

Zahl

"mittlere (erwartete) quadratische Abweichung vom Erwartungswert E (X )\

X

i

V ar(X ) =

[xi ; E (X )]2 P (X = xi)

Z1

;1

[x ; E (X )]2 f (x) dx

i = 1; 2; : : :; 6

X = Augenzahl beim Wurfelwurf

P (X = i) = 61 ;

72

E (X ) = 1 16 + 2 61 + : : : + 6 61 = 61 (1 + 2 + : : : + 6) = 61 21 = 27 = 3:5

Erwartungswert von X :

Es gilt

Sei

Beispiele

im Falle einer stetig verteilten Zufallsvariable X mit Dichte f

V ar(X ) =

im Falle einer diskret verteilten Zufallsvariable X

Es gilt

Varianz von X

h(x) = x2

Z1

0

Beispiel

X exponentialverteilt mit Parameter > 0

Z1

x2 f (x)dx = x2 e;xdx

E (X 2 ) =

;1

1 Z1

= x2 ; 1 e;x ; 2x ; 1 e;xdx

0

0

=E(X )

Z1

= (0 ; 0) + 2 xe;xdx

{z }

|0

xk f (x) dx

= 2 E (X ) = 2 1 = 22

Z1

;1

k{tes Moment der Zufallsvariable X

E (X k ) =

h(x) = xk ; k 2 N (stetige Funktion)

in diesem Sinne:

E (X ) = 1. Moment (Erwartungswert)

E (X 2 ) = 2. Moment

E (X 3 ) = 3. Moment

:::

71

Varianz von X :

V ar(X ) = [1 ; 3:5]2 1 + [2 ; 3:5]2 1 + : : : + [6 ; 3:5]2 61

6

6

= 61 [;2:5]2 + [;1:5]2 + [;0:5]2 2

= 1 25 + 9 + 1

3

4

35 = 2:917

= 12

E (X ) = V ar(X ) = 2

73

"Mitte der Verteilung\ ;! E (X )

V ar(X ) ; oder besser

"Breite der Verteilung\ ;! q

V ar(X ) (Streuung)

Fur X N (; 2) gilt:

e:

f(t)

2.4.4 Rechenregeln fur Erwartungswerte

fur alle t 0

Bei der Berechnung von Erwartungswerten konnen folgende Regeln angewandt werden:

E (X ) = ;

"Verteilung symmetrisch zu \

P (X = ; t) = P (X = + t)

Es sei X eine diskret verteilte Zufallsvariable.

Gilt fur ein 2 R

dann ist

Erwartungswert = Symmetriepunkt

falls der Erwartungswert existiert.

Interpretation :

Beispiele

{ X B (3; 12 ). Fur = 23 gilt:

E (X ) = 3:5

P (X = 23 ; t) = P (X = 32 + t) ; t 0

also:

E (X ) = 23

(vgl. Berechnung oben)

{ Sei

X = Augenzahl beim Wurfelwurf

Verteilung von X ist symmetrisch zu = 3:5, also

(vgl. Berechnung oben)

E (X ) = ;

Es sei X eine stetig verteilte Zufallsvariable mit Dichte f .

Gilt fur ein 2 R

f ( ; t) = f ( + t) fur alle t 0 ;

dann ist

falls der Erwartungswert existiert.

74

Beispiel

X N (; 2) (Normalverteilung); Dichte:

2

;1 x ; f (x) = p1 e 2 2

ist "die Mitte der Verteilung\ !

E (X ) = Hier gilt

f ( ; t) = f ( + t) ; t 0 ;

und man kann zeigen, da E (X ) existiert, also

Interpretation :

Es seien a; b 2 R. Dann gilt:

E (aX + b) = aE (X ) + b

V ar(aX + b) = a2 V ar(X )

2

E (X ) = 23 ; E (X 2) = 3

Dann gilt (siehe oben):

V ar(X ) = E X 2 ; [E (X )]2

Die Varianz einer Zufallsvariable X kann mit folgender Formel berechnet werden:

Beispiele

{ Es sei X B (3; 21 ).

Daraus folgt:

E (X ) = 1 ; E (X 2) = 22

V ar(X ) = 3 ; 23 = 12 4; 9 = 43

{ Es sei X exponentialverteilt mit Parameter > 0. Dann gilt (siehe oben):

Daraus folgt:

2

V ar(X ) = 22 ; 1 = 12

75

2.4.5 Tschebyschesche Ungleichung

Zusammenhang zwischen Erwartungswert E (X ) und Varianz V ar(X ) einer Zufallsvariable X :

P (jX ; E (X )j c) V arc2(X ) ; fur c > 0

Die Tschebyschesche Ungleichung liefert also eine obere Schranke fur die Wahrscheinlichkeit

dafur, da Abweichungen vom Erwartungswert auftreten, die groer oder gleich c sind.

Man beachte:

P (jX ; E (X )j c) = 1 ; P (jX ; E (X )j < c)

= 1 ; P (E (X ) ; c < X < E (X ) + c)

und

V ar(X ) = 2

P (jX ; E (X )j < c) = P (E (X ) ; c < X < E (X ) + c) 1 ; V ar2(X )

c

Daraus ergibt sich folgende Abschatzung fur c > 0:

Beispiel

E (X ) = Es sei X N (; 2) und c = 2.

Es gilt:

Aus der Tschebyscheschen Ungleichung erhalt man:

2

P (jX ; j 2) 42 = 41 = 0:25

Die Tschebyschesche Ungleichung ist hier sehr grob, denn es gilt nach der "2{Regel\ (siehe

oben):

P (jX ; j 2) = 0:0456 0:05

76

77

erung: Die Ereignisse A1 ; : : :; An sollen vollstandig unabhangig sein !

= 1; : : :; n sei

Ai = " Xi xi \

orgegebenen Werten x1 ; x2; : : :; xn.

isch: "Die Werte kommen ohne gegenseitige Beeinussung zustande.\

ematisch: Produktformel

bhangigkeit der Zufallsvariablen X1 ; X2; : : :; Xn

e : Gilt eine entsprechende Formel auch fur die Varianz ?

E (X1 + X2 + : : : + Xn) = E (X1 ) + E (X2) + : : : + E (Xn)

ien X1; X2; : : :; Xn Zufallsvariablen. Dann gilt:

6 Summen von Zufallsvariablen

f(t)

Dies bedeutet:

P (A1 \ : : : \ An) = P (A1 ) : : : P (An )

1

Fur die sogenannte gemeinsame Verteilungsfunktion F(X ;:::;Xn)(x1 ; : : :; xn) gilt also:

1

F(X ;:::;Xn)(x1 ; : : :; xn) = P (X1 x1 ; X2 x2; : : :; Xn xn)

= P (A1 \ : : : \ An )

= P (A1 ) : : : P (An )

= P (X1 x1 ) P (X2 x2) : : : P (Xn xn)

2

9

8

>

> Produkt der einzelnen

=

<

> = :

> Verteilungsfunktionen

;

1

= FX (x1 ) FX (x2 ) : : : FXn (xn )

wobei (x1 ; x2; : : :; xn) 2 Rn beliebig.

Merkregel :

gemeinsame

Verteilungsfunktion

Die Zufallsvariablen X1 ; X2; : : :; Xn heien unabhangig, falls diese Gleichheit gilt.

Wichtig:

Die Annahme der Unabhangigkeit soll immer gemacht werden, wenn die Zufallsvariablen X1; X2; : : :; Xn Beobachtungen beschreiben, die durch Vorgange ohne gegenseitige Beeinussung zustande kommen !

V ar(X1 + X2 + : : : + Xn) = V ar(X1) + V ar(X2 ) + : : : + V ar(Xn)

Fur unabhangige Zufallsvariablen X1; : : :; Xn gilt:

sowie

E (X1 X2 : : : Xn) = E (X1) E (X2 ) : : : E (Xn)

78

endungen

Binomialverteilung

Xi = 1 , Erfolg

;

"Anzahl Erfolge bei n Versuchen\

Xi = 0 , kein Erfolg

p = "Erfolgswahrscheinlichkeit\ ; 0 p 1

X1; : : :; Xn seien unabhangig und Xi B (1; p) fur i = 1; : : :; n.

Es gilt also

P (Xi = 1) = p und P (Xi = 0) = 1 ; p

wobei

Interpretation :

Es gilt:

Y = X1 + : : : + Xn B (n; p)

Fur i = 1; : : :; n erhalt man

E (Xi ) = 0 (1 ; p) + 1 p = p

E (Xi 2 ) = 02 (1 ; p) + 12 p = p

V ar(Xi ) = p ; p2 = p(1 ; p)

Daraus folgt fur die B (n; p){verteilte Zufallsvariable Y :

E (Y ) = E (X1 ) + : : : + E (Xn) = n p

V ar(Y ) = V ar(X1) + : : : + V ar(Xn) = n p (1 ; p)

Normalverteilung

X1; : : :; Xn seien unabhangig und E (Xi) = i sowie V ar(Xi ) = i2 fur i = 1; : : :; n.

Es folgt:

E (X1 + X2 + : : : + Xn) = 1 + 2 + : : : + n

V ar(X1 + X2 + : : : + Xn) = 12 + 22 + : : : + n2

Fur eine normalverteilte Zufallsvariable X gilt:

X N (; 2) =) aX + b N (a + b; a22 )

Es gilt sogar: Summen von unabhangigen normalverteilten Zufallsvariablen sind wiederum

normalverteilt.

79

Achtung:

X1 + : : : + Xn N (1 + : : : + n; 12 + : : : + n2 )

X1 ; : : :; Xn unabhangig ; X1 N (1 ; 12); : : :; Xn N (n; n2 )

=)

Fur groes n gilt die letzte Aussage naherungsweise auch fur nicht{

normalverteilte Zufallsvariablen Xi !

80

Zentraler Grenzwertsatz

"Lange Summen von unabhangigen Zufallsvariablen sind naherungsweise normalverteilt.\

unabhangig ;

fur

i = 1; : : :; n

hte : Dies gilt auch ohne die Voraussetzung, da die Summanden selbst normalverteilt

ussetzungen

X1; : : :; Xn

E (Xi ) = i ; V ar(Xi ) = i2

gilt (unter schwachen Zusatzbedingungen) fur groes n die Approximation

0

1

P @ X1 + : : :q+ X2 n ; (1 + : : : + n) yA (y) ; y 2 R

1 + : : : + n2

Approximation

a

np

b

b + 0:5

1

f (t) = p2 pnp

e;

(1;p)

1

2

t;np

pnp

(1;p)

Y B (n; p), n gro, p nicht zu klein (sonst Poisson{Approximation !)

0

1 0

1

P (a Y b) @ q b ; np A ; @ q a ; np A

np(1 ; p)

np(1 ; p)

graphisch:

a ; 0 :5

Stetigkeitskorrektur

Stetigkeitskorrektur liefert i. allg. eine bessere Naherung:

0

1 0

1

P (a Y b) @ bq+ 0:5 ; np A ; @ aq; 0:5 ; np A

np(1 ; p)

np(1 ; p)

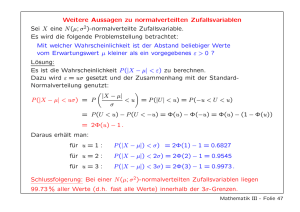

pretation : Eine "lange\ Summe X1 + : : : + Xn ist naherungsweise N (; 2){verteilt mit