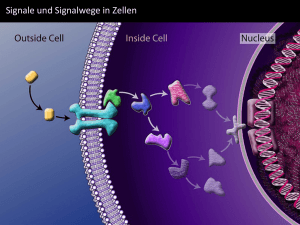

Signale

Werbung

Universität Koblenz

Institut für integrierte Naturwissenschaften

Abteilung Physik

Signale

Seminar Digitale Signalverarbeitung

Dr. Merten Joost

von

Ralf Töppner

Matrikelnr.: 201210387

Koblenz, den 10. Juni 2005

Inhaltsverzeichnis

1

Vorwort

2

2

Signale und Systeme

2

3

Elementarsignale

3

4

Dirac-Impuls

4

5

6

7

Einteilung von Signalen

6

5.1

Diskrete und kontinuierliche Signale

. . . . . . . . . . . . . . . . . . . . . . .

6

5.2

Deterministische und stochastische Signale . . . . . . . . . . . . . . . . . . . .

7

5.3

Periodische, kausale, gerade und ungerade Signale . . . . . . . . . . . . . . . .

8

5.4

Reelle und komplexe Signale . . . . . . . . . . . . . . . . . . . . . . . . . . . .

8

5.5

Energie- und Leistungssignale . . . . . . . . . . . . . . . . . . . . . . . . . . .

5.6

Orthogonale Signale

. . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

LTI-Systeme

9

10

12

6.1

Besondere Eigenschaften linearer Systeme

. . . . . . . . . . . . . . . . . . . .

12

6.2

Weitere Eigenschaften von Systemen . . . . . . . . . . . . . . . . . . . . . . .

14

Zusammenfassung

14

1

1

Vorwort

Im Studium der Informatik ist das Thema

Signale kaum mehr vertreten. Wir gehen in der In-

formatik von den Bits als atomare Einheiten aus. Alles ist aus Nullen und Einsen aufgebaut.

Wenn Daten übertragen werden, werden auch nur eben diese Einsen und Nullen übertragen.

Was sich physikalisch auf der Leitung bzw. in den Geräten abspielt wird weitestgehend auÿer

Acht gelassen, dabei könnte die Informatik ohne die digitale Signalverarbeitung gar nicht

existieren. Schlieÿlich müssen bei der Datenübertragung die Bits immer wieder in Signale

umgewandelt werden. Diese Signale können sich je nach verwendetem Medium stark voneinander unterscheiden. Am anderen Ende müssen diese Signale abgetastet und analysiert

werden. Für das Verständnis dieser Vorgänge ist es nötig eine allgemeine Vorstellung von

Signalen zu bekommen. Diese soll hier geschaen werden.

2

Signale und Systeme

Das Wort Signal ist vom lateinischen Begri signalis abgeleitet. Es bedeutet soviel wie

1

dazu bestimmt, ein Zeichen zu geben . Unter diesem Begri werden die in einem physikalischen System auftretenden Variablen, wie etwa Spannungen, Ströme, Temperaturen,

Kräfte usw., zusammengefasst. In den meisten Fällen ändern sich diese Signale mit der Zeit

und können daher, mathematisch betrachtet, als Funktionen der Zeit dargestellt werden.

Diese wird meist mit dem Buchstaben

t

chung

i, der

i von der Zeit t abhängt durch die Glei-

abgekürzt. Betrachten wir etwa den Strom

durch einen Leiter ieÿt, so kann die Tatsache, dass

i = f (t) oder durch i = i(t) ausgedrückt werden. Die zweite Schreibweise ist allerdings

inkonsequent, da mit dem gleichen Symbol sowohl die Funktion, als auch der Funktionswert

zum Zeitpunkt

t

bezeichnet wird. Allerdings stellt das kein Problem dar, da zu jeder Zeit

erkennbar ist, ob Funktion, oder Funktionswert gemeint ist. Bei der Festlegung der Formelzeichen wird dabei meist keine Rücksicht auf die physikalische Natur der Signale genommen.

Stattdessen verwendet man meist Bezeichnungen wie

x(t), y(t)

oder

z(t).

Die Verarbeitung bzw. Umwandlung (Transformation) eines Eingangssignals zu einem

Ausgangssignal wird formal durch die Formel

x(t) → y(t)

oder umgekehrt

y(t) = T {x(t)}

ausgedrückt.

Abbildung 1: Zeitdarstellung

Abbildung 2: Darstellung als Spektrum

Signale lassen sich jedoch nicht nur im Zeitbereich, sondern auch im Frequenzbereich,

im sogenannten Spektrum, des Signals beschreiben. Die Kenntnis des Spektrums ist die

entscheidende Voraussetzung um Probleme in der Digitalen Signalverarbeitung zu lösen.

So kann z.B. eine ausreichende Abtastfrequenz nur mit Kenntnis des Spektrums ermittelt

werden. In Abbildung 1 ist eine zeitliche Darstellung eines Signals, in Abbildung 2 eine

Darstellung als Spektrum gezeigt. In der zeitlichen Darstellung ist zu sehen, wie sich die

Amplitude des Signals mit der Zeit ändert. In der Grak eines Spektrums lässt sich ablesen,

aus welchen Frequenzen ein Signal zusammengesetzt ist, und zu welchem Anteil diese am

Signal beteiligt sind.

Ein weiterer Begri, der oft im Zusammenhang mit Signalen verwendet wird, ist der

Begri System. Ein System ist ein technisches oder physikalisches Gebilde, das ein Signal,

das Eingangssignal

x(t),

in ein anderes Signal, das Ausgangssignal

y(t),

umformt. Statt

Eingangs- und Ausgangssignal spricht man auch von Erregung und Reaktion. Grasch

1 http://www.wikipedia.org

2

Abbildung 3: System

wird ein System durch einen Block dargestellt, in welchem die Signale gekennzeichnet werden. Die Signalrichtung wird dabei durch Pfeile ausgedrückt (siehe Abbildung 3). Kapitel 6

auf Seite 12 befasst sich noch einmal ausführlicher mit Systemen, vor allem mit sog.

Systemen.

3

LTI-

Elementarsignale

Unter Elementarsignalen versteht man eine Klasse von Zeitfunktionen, aus denen jeder beliebige Signalverlauf zusammensetzbar ist. Elementarsignale lassen sich eindeutig durch eine

Funktion

x(t)

beschreiben. Im Folgenden sollen einige typische Elementarsignale vorgestellt

werden.

•

Sprungfunktion (auch Einheitssprung oder Schrittfunktion)

σ(t) =

0:t<0

1:t≥0

Abbildung 4: Sprungfunktion

•

Rampenfunktion

r(t) = t · σ(t) =

0:t<0

t:t≥0

Abbildung 5: Rampenfunktion

•

Rechteckfunktion

3

rect

t

T0

=

0 : |t| >

1 : |t| ≤

T0

2

T0

2

Abbildung 6: Rechteckfunktion

•

sinc- oder Spalt-Funktion

sinc

t

T0

sin

=

πt

T0

πt

T0

Abbildung 7: sinc-Funktion

Die in der Signalverarbeitung wohl wichtigste Funktion ist die Cosinusfunktion oder

Cosinusschwingung:

x(t) = X̂ cos(2πf0 t)

X̂

gibt dabei die Amplitude oder den Scheitelwert und

man die Cosinusfunktion um

2π

(1)

f0

die Frequenz an. Verschiebt

nach rechts, so erhält man die Sinusfunktion. Multipli-

ziert man nun die Sinusfunktion mit der imaginären Einheit

j

und addiert das Ergebnis

zur Cosinusfunktion (1) so erhalten wir mithilfe der Eulerschen Formel (2) die komplexe

Sinusschwingung oder komplexe Exponentialfunktion (3).

x(t)

ejx = cos(x) + j sin(x)

(2)

x(t) = X̂ cos(2πf0 t) + j X̂ sin(2πf0 t) = X̂ej2πf0 t

(3)

X̂ und

2πf0 (= ω) in

kann man sich dabei als Drehzeiger mit der Länge

vorstellen, welcher mit der Winkelgeschwindigkeit

tiert. Die Frequenz

f0

dem Winkel

2πf0 t(= ωt)

der komplexen Ebene ro-

ist dabei gleich der Anzahl der Umdrehungen pro Zeiteinheit (siehe

Abbildung 8: Die komplexe Exponentialfunktion als Drehzeiger

Abbildung 8).

4

Dirac-Impuls

Die

tol;

δ -Funktion, die zu Ehren des Mathematikers Paul A. M. Dirac (* 8. August 1902 in Bris† 20. Oktober 1984 in Tallahassee)2 auch Diracfunktion genannt wird, ist im mathema-

2 http://www.calsky.com/lexikon/de

4

tischen Sinne eigentlich keine Funktion, sondern eine Distribution, d.h. eine verallgemeinerte

Funktion. Das bedeutet, dass ein Funktionswert sich nicht durch Einsetzen eines Arguments

ergibt, sondern durch Ausführen einer Rechenvorschrift. Es gibt mehrere Möglichkeiten, die

Deltafunktion zu denieren, eine Variante lautet:

δ(t)

H ∞ = 0 für t 6= 0

δ(t)dt = 1

−∞

Für t = 0 ist der Funktionswert

(4)

unbestimmt!

Die Diracfunktion kann man sich als Rechteckfunktion mit der Fläche

Rechteckfunktion hat die Höhe 1 und die Breite

T0

und lässt anschlieÿend

T0 .

1

vorstellen. Die

1

T0

welcher

Multipliziert man die Funktion mit

gegen Null gehen, so entsteht ein Rechteckimpuls

δ(t)

unendlich hoch und unendlich dünn ist.

Die Denition der Diracfunktion (4) kann so interpretiert werden, dass die Diracfunktion nur dort existiert, wo ihr Argument

t

verschwindet. Die Deltafunktion an der Stelle

t0

kann also auch durch Gleichung (5) beschrieben werden.

δ(t − t0 ) = δ(t0 − t)

(5)

Betrachten wir nun das Integral

∞

Z

∞

Z

x(t) · δ(t − t0 )dt =

x(t) · δ(t0 − t)dt =?

−∞

−∞

Der Integrand ist ein Produkt, wobei einer der Faktoren (nämlich der Dirac-Impuls) auÿer

bei

t = t0

stets verschwindet. Der andere Faktor (nämlich

x(t))

hat darum nur bei

t = t0

einen Einuss auf das Produkt. Das Produkt und damit auch obiges Integral kann deshalb

anders geschrieben werden:

Z

∞

Z

∞

x(t) · δ(t0 − t)dt =

−∞

Z

∞

x(t) · δ(t0 − t)dt = x(t0 ) ·

−∞

−∞

|

δ(t0 − t)dt = x(t0 )

{z

}

1

Damit haben wir nun die wichtigste Eigenschaft des Dirac-Impulses (Gleichung (6)).

Z

∞

Z

∞

x(t) · δ(t − t0 )dt =

x(t) · δ(t0 − t)dt = x(t0 )

−∞

(6)

−∞

Man sagt, dass der Dirac-Impuls

δ(t − t0 )

das Signal

x(t)

an der Stelle

t = t0

abtastet. Man

spricht daher von der Abtasteigenschaft [1] des Dirac-Impulses. Diese Eigenschaft wird auch

3 erhalten wir:

Ausblendeigenschaft[2] genannt. Mithilfe der Fouriertransformation

Z

∞

δ(t) ◦−−•

−∞

δ(t) · e−jωt dt =

Z

∞

−∞

δ(t) · e|−jω0

{z } dt =

=1

Z

∞

δ(t)dt = 1

−∞

δ(t) ◦−−•1

Das bedeutet also, dass der Dirac-Impuls alle Frequenzen enthält.

Abbildung 9: Der Dirac-Impuls

3 Siehe

Vortrag Fouriertrnsformation des Seminars Digitale Signalverarbeitung

5

(7)

Dargestellt wird der Dirac-Impuls, wie Abbildung 9 zeigt, mit einem Pfeil. Die neben

dem Pfeil stehende Zahl gibt das Gewicht, d.h. die Fläche des Dirac-Impulses an. Mithilfe

des Dirac-Impulses sind wir nun in der Lage die sogenannte Abtastfunktion oder DiracImpulsreihe zu bilden. Zu diesem Zweck addiert man zum Dirac-Impuls seine um das Vielfache von

T

verschobenen Duplikate (siehe Gleichung (8)).

δT (t) =

∞

X

δ(t − nT )

(8)

−∞

Die so denierte Funktion ist in Abbildung 10 zu sehen. Neben Dirac-Impulsreihe und Ab-

Abbildung 10: Abtastfunktion

tastfunktion wird sie auch Dirac-Kamm genannt.

5

Einteilung von Signalen

Signale lassen sich aufgrund verschiedener Eigenschaften in verschiedene Klassen einteilen.

In diesem Kapitel sollen verschiedene solche, zum Teil unabhängige Einteilungen vorgenommen werden. Zunächst werden Signale in Bezug auf ihren Werte- und Denitionsbereich

untersucht.

5.1

Diskrete und kontinuierliche Signale

s(t), dessen Funktionswerte s nur für diskrete - meist äquidistante - Zeitpunkte

tv ; v = 0, ±1, ±2, ±3, ... deniert ist, nennt man zeitdiskret. Ist der Funktionswert s hingegen

für jeden Punkt t eines kontinuierlichen Zeitbereichs deniert, dann nennt man das Signal

Ein Signal

zeitkontinuierlich. Entsprechend nennt man das Signal wertdiskret bzw. wertkontinuierlich,

in Abhängigkeit davon, ob der Wertebereich diskret oder kontinuierlich ist.

Man kann also bezüglich des Werte- und Denitionsbereiches zwischen vier verschiedenen

Signaltypen unterscheiden:

a) zeitkontinuierliche wertkontinuierliche Signale

b) zeitdiskrete wertkontinuierliche Signale

c) zeitkontinuierliche wertdiskrete Signale

d) zeitdiskrete und wertdiskrete Signale

Signalart (a) wird auch kurz als analoge Signale bezeichnet und Signalart (d) als digitale

Signale, für den Fall, dass der Wertebereich von

s(t)

endlich ist. Diese Signale sind für die

DSV (Digitale Signalverarbeitung) natürlich die bedeutendsten. In Abbildung 11[4] ist zu

jeder Signalart ein Beispielgraph abgebildet. Zu beachten ist, dass bei zeitdiskreten Funktionen der Funktionswert zwischen den diskreten Zeitpunkten

dv nicht Null ist, sondern

s(t) kann man sich auch

undeniert (Fälle (b) und (d)). Ein reelles zeitdiskretes Signal

als Folge reeller Zahlen vorstellen. Erzeugt wird solch ein Signal, indem man ein analoges Signal mit äquidistanten Abständen abtastet. Der entsprechend umgekehrte Vorgang

wird Interpolation genannt. Ein zeitkontinuierliches wertdiskretes Signal erhält man durch

6

Abbildung 11: Signale in Bezug auf Wert- und Denitionsbereich

Quantisierung eines analogen Signals. In diesem Fall nennt man den umgekehrten Vorgang

Glättung. Während eine Interpolation unter bestimmten Bedingungen das Originalsignal

fehlerfrei wiederherstellen kann, ist eine Glättung stets mit Fehlern behaftet. Dieser Fehler

wird auch Quantisierungsrauschen genannt. Die Entstehung eines digitalen Signals kann

man sich vorstellen, als Abtastung und Quantisierung eines analogen Signals, wobei die Reihenfolge dabei keine Rolle spielt.

In der nachfolgenden Tabelle sind nocheinmal die Beziehungen zwischen den verschiedenen Signalarten dargestellt:

(a)

(a)

(a)

(d)

(c)

(b)

5.2

→

→

→

→

→

→

(b)

:

(c)

:

Abtastung

Quantisierung

(d)

:

analog-digitale-Umsetzung (ADU)

(a)

:

digital-analog-Umsetzung (DAU)

(a)

:

Glättung

(a)

:

Interpolation

Deterministische und stochastische Signale

Deterministische Signale sind Funktionen, deren Funktionswerte durch einen mathematischen Ausdruck oder eine bekannte Regel bestimmt (determiniert) sind. Eines der bekanntesten deterministischen Signale ist die schon erwähnte Cosinusfunktion (Gleichung (1)).

Abbildung 12: Beispiel für ein deterministisches und ein stochastisches Signal

Ein stochastisches Signal wird durch den Zufall bestimmt und lässt sich daher nur mit

statistischen Mitteln beschreiben. D.h. die Amplitude eines stochastischen Signals lässt sich

zu keiner Zeit exakt vorherbestimmen. Das bedeutet aber nicht, dass sich nichts über derartige Signale sagen lässt. So sind oft z.B. Mittelwert, Varianz und Autokorrelationsfunktion

eines solchen Signals bestimmbar. Abbildung 12 zeigt für beide Signalarten jeweils ein Beispiel.

7

Allein stochastische Signale, wie z.B. Sprach- oder Bildsignale, sind Träger von Informationen. Vielfach sind stochastische Signale aber auch unerwünschte Signale, bzw. Störsignale.

Solche Signale sind der Grund für die Tatsache, dass jedes reale Signal streng genommen ein

stochastisches Signal ist, denn jedes Signal wird von Störsignalen überlagert. In der Theorie

werden diese Signale allerdings durch idealisierte, determinierte Signale ersetzt, da sich diese

mathematisch leichter handhaben lassen.

5.3

Periodische, kausale, gerade und ungerade Signale

Ein Signal

xP (t) heiÿt periodisch mit der Periode T0 , wenn es die Bedingungen aus Gleichung

(9) erfüllt.

xP (t) = xP (t + T0 )

Die sog. fundamentale Periode ist der kleinste positive Wert

(9)

T0

welcher Gleichung (9) erfüllt.

Im Allgemeinen nennt man dies kurz Periode. Bei periodischen Signalen genügt die Kenntnis

der Signal-Funktion während einer einzigen Periode, um das komplette Signal zu kennen.

Ein Beispiel hierfür ist die Cosinusfunktion aus Abbildung 5.2.

Eine weitere wichtige Klasse von Signalen sind die kausalen Signale. Ein Signal

xcs (t)

nennt man kausal, wenn es auf der negativen Zeitachse Null ist. Es wird deniert durch

Gleichung (10).

xcs (t) =

Dabei beschreibt

x(t)

x(t) : t ≥ 0

0:t<0

(10)

ein beliebiges Signal. Das bekannteste kausale Signal ist die Schritt-

funktion (oder Sprungfunktion aus Kapitel 3 auf Seite 3)

u(t),

die durch Gleichung (11)

deniert ist (siehe Abbildung 13).

u(t) =

1:t≥0

0:t<0

(11)

Abbildung 13: Beispiel für ein kausales Signal

Gerade und ungerade Signale sind in Gleichung (13) deniert.

xo (t) = −xo (−t)

xe (t) = xe (−t),

(12)

Ein gerades Signal ist spiegelsymmetrisch zur y-Achse, wie beispielsweise die Cosinusfunktion oder die Rechteckfunktion. Ein ungerades Signal hingegen ist punktsymmetrisch zum

Ursprung. Beispiele hierfür sind die Sinusfunktion und die Sägezahnfunktion in Abbildung

14. Jedes beliebige Signal lässt sich in ein gerades und ein ungerades Teilsignal zerlegen.

Dies geschieht einfach mit Gleichung (13).

x(t) =

x(t) x(−t) x(t) x(−t)

+

+

−

| 2 {z 2 } | 2 {z 2 }

xe (t)

5.4

(13)

xo (t)

Reelle und komplexe Signale

Die meisten Signale, sowohl in der Theorie als auch in der Praxis, sind reelle Signale und es

gilt Gleichung (14).

xr (t) = x(t),

mit

8

x(t)

reell

(14)

Abbildung 14: Ungerade Sägezahnfunktion

Ein reelles Signal ist eine Funktion, die der unabhängigen reellen Zeitvariablen

len Funktionswert

xr (t)

zuordnet. Mathematisch ausgedrückt:

t

einen reel-

xr : R → R.

Die Signalverarbeitung arbeitet jedoch auch mit komplexen Signalen, die durch Gleichung

(15) deniert werden.

xc (t) = x(t),

Mathematisch ausgedrückt:

xc : R → C.

x(t)

mit

komplex

(15)

Das klassische Beispiel hierfür ist die komplexe

Sinusschwingung (Gleichung ( 3 auf Seite 4)). Jedes komplexe Signal kann man sich aus

zwei reellen Signalen zusammengesetzt vorstellen, nämlich dem Realteil

ginärteil

xi (t)

xr (t) und dem Ima-

(siehe Gleichung (16)),

xc (t) = xr (t) + jxi (t)

(16)

wobei j die imaginäre Einheit ist.

5.5

Energie- und Leistungssignale

Eine weitere Möglichkeit der Einteilung von Signalen orientiert sich an den Begrien Energie

und Leistung.

R=

U

I

(17)

Abbildung 15: Einfache Schaltung mit Widerstand

Abbildung 15 zeigt eine einfache Schaltung mit Widerstand

R.

Den Zusammenhang

zwischen Spannung, Strom und Widerstand, der aus dem Ohm'schen Gesetz gefolgert ist,

beschreibt Gleichung (17). Die im Zeitintervall

t 1 ≤ t ≤ t2

gelieferte elektrische Energie

Eel

berechnet sich allgemein nach Gleichung (18).

Z

t2

u(t) · i(t)dt

Eel =

(18)

t1

Aus (17) und (18) folgt Gleichung (19).

Eel =

1

R

Z

t2

u2 (t)dt = R

Z

t1

t2

i2 (t)dt

(19)

t1

Die (mathematische) Energie ist also proportional zum Integral über die quadrierte Zeitfunktion. Die Energie eines zeitkontinuierlichen Signals

s(t)

nicht festgelegter physikalischer

Dimension ist also bestimmt durch Denition 20.

Z

∞

s2 (t)dt

E=

−∞

9

(20)

Ein Signal heiÿt nun Energiesignal, wenn es der Gleichung (21) genügt.

Z

∞

s2 (t)dt < ∞

0<E=

(21)

−∞

Ein Energiesignal besitzt also ein Signal mit endlicher und nicht verschwindender Energie

E.

Die Energie

E=0

wird oftmals auch zugelassen. Ein Beispiel für Energiesignale ist die

Rechteckfunktion aus Kapitel 2 auf Seite 2 (siehe Abbildung 16). Die Energie dieses Signals

Abbildung 16: Rechtecksignal mit Amplitude

berechnet sich nun so:

A

T0 /2

Z

A2 dt = A2 · T0

E=

−T0 /2

Die im Intervall

−θ ≤ t ≤ +θ

umgesetzte mittlere elektrische Leistung berechnet sich

allgemein:

1

Pel =

2θ

Z

θ

u(t) · i(t)dt

(22)

−θ

Daraus folgt nach Gleichung (17):

Pel =

1 1

R 2θ

θ

Z

u2 (t)dt = R

−θ

1

2θ

Z

θ

i2 (t)dt

(23)

−θ

Überträgt man Beziehung (24) nun auf ein unendlich langes Zeitintervall, so erhalten wir die

s(t)

mittlere Leistung eines zeitkontinuierlichen Signals

Z

1

θ→∞ 2θ

nicht festgelegter Dimension durch:

θ

s2 (t)dt

P = lim

(24)

−θ

Mithilfe Gleichung (24) können wir Leistungssignale jetzt wie folgt denieren:

1

θ→∞ 2θ

θ

Z

s2 (t)dt < ∞

0 < P = lim

Man kann also sagen, dass ein Leistungssignal

(25)

−θ

s(t)

in einem unendlich langen Zeitintervall

eine nichtverschwindende endliche mittlere Leistung

P

umsetzt. Das für die DSV bedeu-

tendste Leistungssignal ist die Cosinusschwingung.

Allgemein lässt sich sagen, dass ein Leistungssignal kein Energiesignal ist, da für ein

solches gilt:

gilt:

5.6

E → ∞.

Ebenso ist ein Energiesignal kein Leistungssignal, da in diesem Fall

P = 0.

Orthogonale Signale

Zur Denition orthogonaler Signale braucht es den Begri des Skalarprodukts. Dieses ist für

x(t) und y(t) wie folgt

Z ∞

< x, y >=

x(t)y ∗ (t)dt

zwei Energiesignale (siehe Kapitel 5.5)

−∞

10

deniert:

(26)

Wobei

y ∗ (t)

y(t)

das konjugiert komplexe Signal zu

Skalarprodukt zweier

T0 -periodischer

ist. Analog dazu deniert man das

Leistungssignale (siehe Kapitel 5.5)

Z

T0 /2

< xp , yp >T0 =

xp (t)

und

yp (t):

xp (t)yp∗ (t)dt

(27)

−T0 /2

Anhand des Skalarproduktes können wir nun die Orthogonalität zweier Energiesignale

und

y(t)

respektive zweier

T0 -periodischer

Leistungssignale

xp (t)

yp (t)

und

x(t)

denieren. Und

zwar herrscht Orthogonalität genau dann, wenn ihre Skalarprodukte Null sind:

< x, y >= 0,

respektive

< xp , yp >T0 = 0

(28)

Anhand dieser Denition lässt sich nun zeigen, dass komplexe Sinusschwingungen mit verschiedenen Frequenzen orthogonal zueinander stehen[1].

ϕk (t) = ej2πkf0 t und ϕl (t) = ej2πkf0 t mit

lf0 , wobei k und l ganze Zahlen sind. Für das Skalarprodukt zweier

Sinusschwingungen ϕk (t) und ϕl (t) gilt:

R T0 /2

Z T0 /2

−T0 /2 ej0 dt = T0 für k = l

j2π(k−l)f0 t

hϕk , ϕl iT0 =

e

dt =

j2π(k−l)f0 t T0 /2

e

für k 6= l

−T0 /2

j2π(k−l)f0 Gegeben sind zwei komplexe Sinusschwingungen

den Frequenzen

komplexer

kf0

und

−T0 /2

T0 /2

ej2π(k−l)f0 t =

j2π(k−l)f0 −T0 /2

=

cos(2π(k−l)f0

T0

2

)+j sin(2π(k−l)f0

=

cos(2π(k−l)f0

T0

2

)−cos(2π(k−l)f0

=

2 sin(π(k−l)f0 T0 )

2π(k−l)f0

=

2 sin((k−l)π)

2π(k−l)f0 mit

T0

2

)−cos(2π(k−l)f0

j2π(k−l)f0

T

0

2 )+j sin(2π(k−l)f0

j2π(k−l)f0

−T0

2

T0

2

)−j sin(2π(k−l)f0

)+j sin(2π(k−l)f0

−T0

2

T0

2

)

)

|k − l| ∈ N

=0

Diese Eigenschaft ist von entscheidender Bedeutung bei der Herleitung der Fourier-Reihe.

Mit dem Skalarprodukt lässt sich allerdings nicht nur die Orthogonalität zweier Funktionen denieren, sondern auch die Norm

kxk

eines Energiesignals, bzw die Norm

kxp k

eines

periodischen Signals:

kxk =

√

< x, x >,

respektive

kxp k =

p

< xp , xp >T0

(29)

In Anlehnung an die Vektorrechnung kann man unter der Norm auch die Länge eines Signals

verstehen. So können wir mithilfe Gleichung (20) für die Energie

E

eines Energiesignals

schreiben:

E = kxk2 =< x, x >

Für die Energie

E

eines

T0 -periodischen

(30)

Signals während der Periode

T0

können wir analog

schreiben:

E = kxp k2 =< xp , xp >T0

Woraus sich für die mittlere Leistung

P =

P

des

T0 -periodischen

(31)

Signals ergibt:

1

1

kxp k2 =

< xp , xp >T0

T0

T0

(32)

1

R multipliziert werden (je nachdem, ob das Signal einen Strom oder eine Spannung darstellt), wobei

Wie schon in Kapitel 5.5 auf Seite 9 gesehen, muss das Ergebnis noch mit

R

R

oder

den Widerstand darstellt, um physikalisch sinnvolle Ergebnisse zu erhalten.

11

6

LTI-Systeme

Eine besondere Klasse von Systemen bilden diejenigen, deren Verhalten von den Eingangssignalen unabhängig ist. Solche Signale heiÿen linear. Es gilt:

c1 x1 (t) + c2 x2 (t) linearesSystem c1 y1 (t) + c2 y2 (t)

−−−−−−−−−−−→

für beliebige Konstanten

•

c1 , c2 .

(33)

Darin enthalten sind zwei unabhängige Eigenschaften:

Die Homogenität

c · x(t) → c · y(t)

(34)

Ein System heiÿt also homogen, wenn eine Änderung der Amplitude des Eingangssignals, eine identische Änderung der Amplitude im Ausgangssignal bewirkt. Für diskrete Signale schreibt man auch:

c · x[n] → c · y[n].

Ein Widerstand ist ein einfaches Beispiel, sowohl für ein homogenes als auch für ein

nichthomogenes System. Nehmen wir an, das Eingangssignal des Systems sei die Spannung

v(t),

die am Widerstand abfällt, und die Ausgabe des Systems sei der Strom

i(t)

durch den Widerstand. Nach dem Ohm'schen Gesetz in der Elektrotechnik, welches

sagt, dass der Spannungsabfall

U

über einem metallischen Leiter bei konstanter Tem-

peratur proportional zu dem hindurchieÿenden elekrischen Strom mit der Stromstärke

I

ist (U

∼ I ),

gilt, dass eine Erhöhung oder Senkung der Spannung eine vom Faktor

äquivalente Erhöhung oder Senkung der Stromstärke bewirkt. Dieses System ist also

homogen.

Nehmen wir nun an, das Eingangssignal sei wieder die Spannung

das Ausgangsignal sei nicht mehr der Strom

am Widerstand abfallende Leistung

p(t).

i(t)

v(t) am Widerstand,

durch den Widerstand, sondern die

Da Leistung proportional zum Quadrat der

Spannung ist, steigt bei einer Verdopplung der Spannung die Leistung am Transistor

um den Faktor vier. Dieses System ist also nicht homogen und damit auch nicht linear.

•

Die Additivität

x1 (t) + x2 (t) → y1 (t) + y2 (t)

(35)

Ein System heiÿt also Additiv, wenn es von addierten Signalen durchquert wird, ohne dass diese interagieren. Handelt es sich wieder um diskrete Signale, so können wir

schreiben: Wenn gilt

y1 [n] → x1 [n]

und

y2 [n] → x2 [n]

dann gilt auch

y1 [n] + y2 [n] →

x1 [n] + x2 [n].

Als Beispiel kann man sich ein Telefon vorstellen: Wenn man mit einer Person telefoniert und im Hintergrund spricht noch eine andere Person, so kann man am anderen

Ende die beiden Personen klar voneinander unterscheiden. Die Daten interagieren also

nicht. Dieses Beispielsystem ist also additiv.

Ein System, welches sowohl die Homogenität, als auch die Additivität erfüllt heiÿt linear.

Angenommen, ein System

y(t) = V · x(t)

mit einer beliebigen Verstärkung

V

sei linear. Die

Linearität gilt auch noch dann, wenn sich die Verstärkung zeitlich ändert.

y(t) = V (t) · x(t)

mit z.B.

V (t) = sin(t)

So ein System nennt man zeitvariant. Ändert sich die Systemeigenschaft zeitlich nicht, so

heiÿt das System zeitinvariant:

x(t − τ ) linearesSystem y(t − τ )

−−−−−−−−−−−→

(36)

Linearität und Zeitinvarianz sind völlig unabhängige Eigenschaften. Erfüllt ein System diese

beiden Eigenschaften, nennt man es ein LTI-System (Linear TimeInvariant). Solche Systeme

sind besonders einfach zu handhaben.

6.1

Besondere Eigenschaften linearer Systeme

Eine besondere Eigenschaft linearer Systeme ist die Kommutativität. Dies betrit das Zusammenspiel zweier oder mehrerer Systeme. Nehmen wir an, zwei Systeme sind in Reihe

12

Abbildung 17: Reihenschaltung zweier Systeme

geschaltet (Siehe Abbildung 17). Das Ausgangssignal des einen Systems (A) ist dann das

Eingangssignal des anderen Systems (B). Ist jedes dieser Signale linear, so ist auch die Kombination dieser beiden Systeme linear. Die Kommutativität bedeutet, dass die Reihenfolge

der Systeme im Gesamtsystem keine Rolle für das Gesamtsystem spielt. Im Beispiel könnte

also auch System B vor Signal A stehen. Angenommen ein System besteht aus zwei Teilen,

einer für die Verstärkung eines Signales, der andere für Filterung. Sind beide Einzelsysteme

linear, so muss man sich nicht überlegen in welcher Reihenfolge die beiden Teile geschaltet

werden sollen. Da es in der Elektrik aber nichtlineare Eekte wie Interferenz oder interne

Störsignale gibt, lässt sich das nicht für die Realität verallgemeinern.

Abbildung 18: System mit mehreren Ein- und Ausgängen

Gehen wir nun einen Schritt weiter und betrachten Systeme mit mehreren Ein- und

Ausgängen (Siehe Abbildung 18). Solch ein System ist genau dann linear, wenn es eine

Komposition aus linearen Subsystemen ist. Die Addition von Signalen ändert dabei nichts

an der Linearität. Die Komplexität des Systems spielt keine Rolle. Wichtig ist nur, dass es

keine nichtlinearen Einüsse im System gibt.

Um die Linearität eines Systems mit mehreren Ein- bzw Ausgängen zu verstehen betrachten

wir nun ein solches System. Wir legen auf einen der Eingänge ein Signal, während die anderen Eingänge auf Masse gezogen werden. Nun erhalten wir auf den Ausgängen verschiedene

Muster von Signalen. Als nächstes wiederholen wir den Vorgang mit einem anderen Signal

und einem anderen Eingang. D.h. wir legen diesmal ein Signal an einen anderen Eingang an,

während alle anderen wieder auf Masse gezogen werden. Das hat nun andere Ausgangssignale zur Folge. Als letztes legen wir beide Signale gleichzeitig an den jeweiligen Eingängen

an. Die Signale, die nun an den Ausgängen erscheinen sind einfach jeweils die Summe der

beiden vorigen Ausgangssignale.

Eine weitere wichtige Frage bei linearen Systemen ist, ob die Multiplikation in linearen

Systemen erlaubt ist. Tatsächlich hängt dies davon ab, mit was ein Signal multipliziert wird.

Wird es mit einer Konstanten multipliziert, so ist das System linear. Dies kommt einer

Verstärkung oder einer Dämpfung gleich. Die Multiplikation mit nichtkonstanten Signalen

13

hingegen ist nichtlinear.

6.2

Weitere Eigenschaften von Systemen

Im Folgenden sollen noch drei allgemeine Typen von Systemen erklärt werden:

•

Kausale und deterministische Signale

Ein kausales System reagiert erst dann mit einem Ausgangssignal, wenn ein Eingangssignal anliegt. Die Stoÿantwort eines kausalen Systems verschwindet für

t < 0. Technisch

realisierbare Systeme sind stets kausal. Die Kausalität ist eine Eigenschaft von zeitabhängigen Signalen.

Ein deterministisches System reagiert bei gleicher Anfangsbedingung und gleicher Anregung stets mit demselben Ausgangssignal. Im Gegensatz dazu stehen die stochastischen Systeme. Wir haben festgestellt, dass stochastische Signale häuger vorkommen

als deterministische. Bei Systemen ist dies genau umgekehrt. Ein Beispiel für ein stochastisches Signal sind Zufallsgeneratoren.

•

Dynamische Systeme

Ein System heiÿt dynamisch, wenn sein Ausgangssignal auch von vergangenen Werten

des Eingangssignales abhängt. Das System muss somit mindestens ein Speicherelement

enthalten. Bei gedächtnislosen (statischen) Systemen hängt das Ausgangssignal nur

vom momentanen Wert des Eingangssignales ab.

•

Stabilität

Beschränkte Eingangssignale ergeben bei stabilen Systemen stets auch beschränkte

Ausgangssignale (BIBO-stabil = bounded input - bounded output):

| x(t) |≤ A < ∞ ⇒| y(t) |≤ B < ∞; A, B ≥ 0

7

(37)

Zusammenfassung

In diesem Dokument sollte ein kurzer Überblick über den Grundbegri Signale gegeben

werden. Es sollte ein Grundverständnis des Themas geschaen werden, mit dem der Einstieg

in die Digitale Signalverarbeitung erleichtert werden sollte. Zu diesem Zweck wurden erst

die Begrie Signal und System erklärt, dann wurden einige Elementarsignale vorgestellt und

dann mithilfe des Rechtecksignals der Dirac-Impuls (oder Diracstoÿ) eingeführt und mit ihm

die Abtastfunktion bzw. der Dirackamm. Im folgenden Kapitel wurden einige Einteilungen

von Signalen vorgenommen, z.B. in Energie- und Leistungssignale. Das letzte Kapitel handelt

von Systemen und da speziell von linearen Systemen, welche eine entscheidende Rolle in

der digitalen Signalverarbeitung spielen. Mit diesem Wissen sollte nun der Einstieg in die

DSV geschat sein und weiterführende Themen wie die Fourier-Transformation angegangen

werden können.

14

Literatur

[1] Daniel Ch. von Grüningen, Digitale Signalverarbeitung, 2. Auage, Fachbuchverlag

Leipzig

[2] Martin Meyer: Grundlagen der Informationstechnik - Signale Systeme und Filter, 1.

Auage, Vieweg-Verlag

[3] M.

versity

Huemer:

of

Vorlesung

Applied

Signal-

Sciences

und

of

hagenberg.at/sta/wbackfri/Teaching/BSV/

Upper

Biosignalverarbeitung,

Uni-

http://webster.fh-

Austria

[4] Prof. Dr.-Ing. R. Urbansky: Vorlesung Grundlagen der Informationsübertragung, Technische Universität Kaiserslautern

[5] Steven

cessing

W.

Smith:

Second

The

Edition,

http://www.dspguide.com

http://nt.eit.uni-kl.de/lehre/guet/

Scientist

and

California

Engineer's

Technical

15

Guide

Publishing,

to

Digital

San

Signal

Diego,

Pro-

California