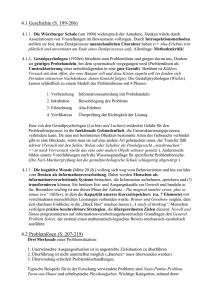

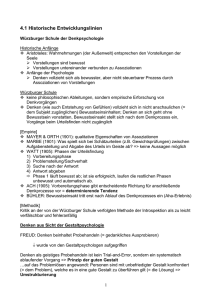

spada-kap4-denken-und - Fachschaft Psychologie Freiburg

Werbung