Zusammenfassung Kapitel 4 1-4

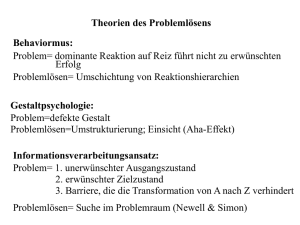

Werbung

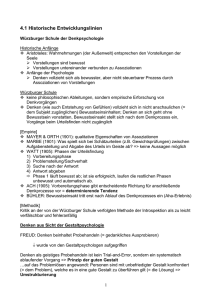

4.1 Geschichte (S. 199-206) 4.1.1. Die Würzburger Schule (um 1900) widersprach der Annahme, Denken würde durch Assoziationen von Vorstellungen im Bewusstsein vollzogen. Durch Introspektionsmethoden stellten sie fest, dass Denkprozesse unanschaulichen Charakter haben (=> Aha-Erlebnis tritt plötzlich und unvermutet am Ende eines Denkprozesses auf). Allerdings: Methodenkritik! 4.1.2. Gestalpsychologen (1920er) forschten zum Problemlösen und gingen davon aus, Denken sei geistiges Probehandeln, bei dem systematisch vorgegangen wird (Problemlösen als Umstrukturierung einer unbefriedigenden in eine gute Gestalt). Berühmt ist Köhlers Versuch mit dem Affen, der eine Banane will und dazu Kisten stapeln soll (es fanden sich Perioden intensiven Nachdenkens, denen Einsicht folgte). Die Gestaltpsychologen (Wallas) kamen schließlich zu einem Modell des Problemlösens mit 4 Phasen: 1. Vorbereitung Informationssammlung mit Probehandeln 2. Inkubation Beiseitelegung des Problems 3. Erleuchtung Aha-Erlebnis 4. Verifikation Überprüfung der Richtigkeit der Lösung Eine von den Gestaltpsychologen (Luchins und Luchins) entdeckte Gefahr für den Problemlöseprozess ist die funktionale Gebundentheit, die Umstrukturierungsprozesse verhindern kann. Da man mit bestimmten Objekten bestimmte Arten des Gebrauchs verbindet gibt es eine Blockade, wenn man sie auf eine andere Art gebrauchen muss, der Transfer fällt schwer (Versuch mit den Seilen; Relais oder Schalter als Pendelgewicht „missbrauchen“ =>Je nach Vorversuch wurde das eine oder andere Objekt seltener genutzt.). Andererseits bilden unsere Vorerfahrungen auch die Wissensgrundlage für spezifische Problembereiche. (Die Nazi-Machtergreifung hat die gestaltpschologische Schule schlagartig abgewürgt.) 4.1.1. Die kognitive Wende (Mitte 20.Jh.) vollzog sich weg vom Behaviorismus und hin zur Idee vom Denken als Informationsverarbeitung. Dabei werden Menschen als informationsverarbeitende Systeme betrachtet, die Information aufnehmen, speichern und (!) transformieren können. Sie besitzen Ein- und Ausgangskanäle zur Umwelt und handeln in ihr. Besonders wichtig ist aus dieser Phase der Aufsatz „The magical number seven, plus or minus two“ (Miller), in dem die Kapazität unseres Kurzzeitspeichers (ca. 7 Elemente) mit verschiedenen menschlichen Leistungen verbunden wurde. Bruner und Goodnow zeigten, dass sich durchaus Einblicke in die „Black Box“ machen lassen („A study of thinking“; Menschen verfolgen präzise beschreibbare Strategien, die übergeordneten Zielen dienen). Newell und Simon programmierten auf informationsverarbeitungstheoretischen Grundlagen den General Problem Solver, der erstmal einen mathematisch-logischen Beweis mechanisch-symbolisch ausführte. 4.2 Problemlösen (S. 207-219) Drei Merkmale einer Problemsituation: 1. Unerwünschte Ausgangssituation ist in angestrebte Zielsituation zu überführen 2. Überführung ist nicht unmittelbar möglich („Barriere“ muss überwunden werden) 3. Überwindung erfordert Problemlösehandlungen. Typische Beispiele für in der Forschung verwendete Probleme sind Neun-Punkte-Problem, Turm-von-Hanoi und schultypische Physikaufgaben. Wichtige Kategorien, anhand derer Problemsituationen charakterisierbar sind, sind: Gut definiertes Problem (Ausgangs- und Zielzustand sind bekannt und genau beschrieben) Schlecht definiertes Problem (Ausgangs- oder Zielzustand oder beide sind unklar) Einsichtsproblem (Lösung hängt vom Gelingen einiger kritischer Einzelschritte ab) Transformationsproblem (Durch längere Abfolge von Schritten charakterisiert) Vorwissensarmes Problem (erfordern kein Wissen, dass über die Instruktion hinausgeht) Problem mit bereichsspezifischem Vorwissen (ist ohne Vorwissen nicht lösbar) 4.2.1. Problemlösen wird in der Tradition der Gestaltpsychologie (=> Umstrukturierung; AhaErlebnis) als Informationsverarbeitung, als zielgerichtete Suche im Problemraum verstanden. Beforscht werden hierbei Problemrepräsentation und Problemlösestrategien. 4.2.1.1. Gerade bei Transformationsaufgaben wie dem Turm-von-Hanoi eignet sich der Problemraum als graphische Darstellung der Komplexität eines Problems. Hierbei zeichnet man einen Graphen, bei dem jeder Knotenpunkt jeweils einen möglichen Zustand (eine Problemsituation) und jede Kante einen Übergang (Problemlöseschritt) darstellt. Problemlösen ist dann die Suche nach dem „günstigsten“ Weg vom Anfang zum Ziel. Dieser Problemraum ist explizit und vollständig. Alle möglichen Zustände und Übergänge sind darsgestellt. Man erkennt sofort viele Charakteristika des Problems (minimum 7 Züge nötig, keine Sackgassen, verschiedene Lösungswege). Doch diese theoretische, statische Beschreibung erleichtert die Analyse dynamischer Abläufe beim Problemlösen, da er hilft, unterschiedliche Phänomene aus einer einheitlichen Betrachtungsweise zu analysieren. 4.2.1.2. Forschung mit Problemräumen hat ergeben, dass isomorphe Probleme (die sich auf identische Problemräume abbilden lassen) nicht gleich schwierig sind. Es wurden fünf Faktoren gefunden, die die Problemschwierigkeit beeinflussen. 1. Wie einfach sind die Problemlöseregeln zu lernen bzw zu verstehen? 2. Wie einfach sind sie anzuwenden? 3. Wie stark korrespondieren sie mit vorhandenem Weltwissen? 4. Wie stark wird das Gedächtnis belastet? (Bisherige Entscheidungen erinnern) 5. Wie wird der Problemraum subjektiv repräsentiert? Auswahl und Anwendung von Problemlösehandlungen (es gibt oft mehrere mögliche) ist von zentraler Bedeutung. Hierbei wurde beobachtet, dass Personen anfangs häufig Heuristiken verwenden, um den Problemraum bei vorwissensarmen Problemen zu verkleinern („nicht zweimal die selbe Scheibe verschieben!“). Diese werden bei mehrmaligem Durchführen durch global formulierte Strategien ersetzt. 4.2.1.3. Es wird zwischen erschöpfenden (den gesamten Problemraum durchsundenden) und nicht erschöpfenden (ausschnittsweise vorgehenden) Suchstrategien unterschieden. Außerdem spricht man von allgemeinen, uninformierten Suchstrategien (breite Anwendbarkeit auf alle Problemräume, systematische Regeln, Vernachlässigung der Besonderheiten eines Problems) oder heuristischen Suchstrategien (von Menschen selbst bei einfachen Problemen angewandt, berücksichtigen problemspezifisches Wissen, bewertet alternative Problemlöseschritte nach der Unterschiedsreduktion zwischen aktuellem Zustand und Ziel). Beispiel für eine heuristische Suchstrategie ist die Mittel-Ziel-Analyse: Bei der Mittel-Ziel-Analyse wird eine vorwärtsgerichtete Suche mit einer rückwärtsgerichteten Teilzielbildung integriert. Eine andere klassische heuristische Methode ist das Bilden von Analogien (Lösen mit Hilfe der bekannten Lösung eines analogen Problems). Diese Problemlösestrategien wurden oft mit der Methode des lauten Denkens erforscht. 4.2.2. Es werden folgende Formen des Wissens unterschieden: 1. Deklaratives Wissen beschreibt Objekte, Situationen 2. Prozedurales Wissen stellt Operationen zu Nutzung und Erwerb von Wissen zur Verfügung 3. Kontrollwissen steuert das Zusammenspiel von 1 und 2 Man spricht auch von „Wissen, was“, „Wissen, wie“ und „Wissen, wann“. Deklaratives Wissen wird in Form von Propositionen dargestellt, prozedurales in Form regelartiger „wenn-dann“-Strukturen, die mit den Inhalten des deklarativen Wissens gefüllt werden. Man spricht von wissensbasierten Systemen. Mit ihrer Hilfe lassen sich sowohl vorwärts- als auch rückwärtsverkettendes Problemlösen modellieren. Beim datenorientierten Vorwärtsverketten werden die Aktionen im Dann-Teil der Regel ausgeführt, wenn die Inhalte des Wenn-Teils bekannt sind. Beim ziel- oder hypothesenorientierten Rückwärtsverketten werden so lange alle Bedingungen im Wenn-Teil, die nicht erfüllt sind, als neue Unterziele definiert, bis alle Bedingungen erfüllt sind (dann folgt vorwärtsverkettendes Problemlösen). Die Frage nach der kognitiven Architektur ist ebenfalls von Bedeutung, da jede Informationsverarbeitung ein System voraussetzt, dass sie ausführt (wahrnehmen, speichern, abrufen, anwenden). Eine bekannte Architektur ist Andersons ACT (Adaptive Character of Thought),bei der Chunks (als elementare Einheit des deklarativen Wissens) und Produktionen ( als elementare Einheit des prozeduralen Wissens) mit Stärkeparametern versehen sind. Diese berechnen sich (u.a.) aus der Häufigkeit ihrer früheren Verwendung und beeinflussen, ob sie erneut verwendet werden (wenn-dann-Regeln auf höherer Ebene). Lernen findet statt, wenn Stärkeparameter verändert werden oder völlig neue Produktionen hinzukommen (ich denke auch neue Chunks sind lernen, aber steht nicht explizit im Buch). Neue Produktionen werden durch Analogien gebildet. Fazit: Derartige Modellierungen haben sich als fruchtbar erwiesen, aber ihr Geltungsbereich sit eingeschränkt (fokussierten zu sehr auf vorwissensarme, gut definierte Probleme) 4.2.3. Die Frage nach dem Wissenserwerb spielt bei neuerer Forschung zum Problemlösen eine große Rolle. Anderson postuliert drei Phasen: 1. Verwendung deklarativen Wissens: nicht unmittelbar in Verhalten umsetzbar, interpretiert durch bereichsunspezifische Problemlöseprozeduren 2. Wissenskompilierung: bereichsspezifische Regelbildung; Umwandlung von deklarativem in prozedurales Wissen 3. Wissensoptimierung: Generalisation, Diskrimination, Verstärkung Hierbei wird aber der Einfluss des Vorwissens nicht beachtet, der sehr groß zu sein scheint. Breits auf Basis weniger (teils nur einem) Beispiele erwerben Lernende neues Wissen (=> Selbsterklärungseffekt). Dieser Effekt wurde von Chi und Al untersucht. Es ist der Versuch, wo ein Kapitel im Physikbuch gelesen und dann ein Kapitel klassische Mechanik mit Musterlösungen durchgearbeitet wurde. Dann mussten die VP selbst Aufgaben lösen. Es ergaben sich zwei Gruppen (gute und schlechte Problemlöser) die auf ihre Unterschiede hin untersucht wurden. Die Guten hatten: 1. Bei der Bearbeitung der Musterlösungen mehr Bezug auf die physikalsichen Konzepte genommen. 2. Dabei auch deutlich mehr eigene Verständnisprobleme artikuliert (Selbstüberwachung) 3. Sich beim Problemlösen seltener, aber dafür gezielter, die Musterlösungen bezogen. Aus diesen Resultaten haben Chi und Al das Simulationsmodell Cascade zum Verstehen von Musterlösungen entwickelt. Grundannahme: Schlechte Problemlöser speichern die Musterlösung ohen weitere Verarbeitung. Gute Problemlöser nutzen die Musterlösung effizienter. Im (simulierten) Idealfall wird jede einzelne Zeile der Musterlösung auf den Lehrbuchtext zurückgeführt (Dieser ist als Wissensbasis Teil des Modells). Ist dies nicht möglich, werden neue Gleichungen aus anderen abgeleitet und ebenfalls gespeichert. Ist auch dies nicht möglich, gibt es zwei Wege, weiteres Wissen zu erwerben: 1. EBLC (Erklärungsbasiertes Lernen korrekter Lösungsschritte): Hier wird generalisiertes Allgemeinwissen und naives physikalisches Wissen über Heuristiken für die Verbindung von beidem verbunden. Wenn dies Erfolg hat, wird es als neue Regel dem Wissensschatz hinzugefügt 2. Analogie-Abduktion: Von den Konsequenzen einer Regel auf die Gültigkeit ihrer Voraussetzungen schließen (Also „weil an diesem Punkt der Musterlösung dieser Schritt ausgeführt wird, muss er richtig sein, wenn so ein Problem vorliegt“). Diese Regeln werden ab sofort in analogen Situationen angewandt. Cascade versucht danach, mit dem so erweiterten Wissenschatz, Aufgaben zu lösen. Hier wird rückwärtsverkettet gesucht (Problemraum sind die bekannten physikalischen Gleichungen) und bei Sackgassen EBLC angewandt. Abduktion ist nicht möglich, da ja nicht wie bei Musterlösungen die Konsequenzen bekannt sind. Man merkt also, dass eine gute Verarbeitung der Musterlösung die Problemlösung erleichtert. Schlechte Problemlöser können meist nur oberflächliche Analogien ziehen, wenn die Gleichungen des Lehrbuchtextes nicht ausreichen. (Bei einer Simulation arbeitete das Modell drei Musteraufgaben durch und entwickelte dabei acht neue Regeln. Danach konnte es 23 Aufgaben lösen und erneut 15 Regeln ableiten. Ohne die Elaboration der Musteraufgaben gelang nur die Lösugn von 9 der 23 Aufgaben, wobei nur drei neue korrekte Regeln abgeleitet wurden). 4.2.4. Die Neurowissenschaftler haben in der letzten Zeit für viele kognitive Prozesse Hirnkorrelate gefunden und lokalisiert, allerdings kaum für das Problemlösen, Denk- und Entscheidungsaufgaben. Problemlösen ist neuronal komplex verschaltet und schwer zu lokalisieren. Sicher spielt der präfrontale Kortex eine Rolle (exekutive Funktion), Studien zeigten hier eine Beteiligung des fronto-parietalen Systems (rechter dorsolateraler Kortex, linker inferiorer präfrontaler Kortex sowie bilateraler parietaler und prämotorischer Kortex). Links- und beidseitige Läsionen behindern die Patienten dabei deutlich mehr als rechtsseitige. 4.3 Expertiseforschung (S. 219-226) Im Alltag fordern die meisten Probleme von dem Menschen Sachkenntnis, Vorwissen, sprich: Expertise. Experten haben (im Unterschied zu Novizen) großes Wissen und herausragende Fertigkeiten in einem bestimmten Bereich, deren Erwerb VIEL Zeit gekostet hat (deliberate practice). Im folgenden wird Expertiseforschung an drei Themenfeldern erläutert und danach noch einmal zusammengefasst. 4.3.1. Ihren Ursprung nahm die Expertiseforschung bei Versuchen zum Schachspielen, wo gezeigt werden konnte, dass Schachmeister Novizen nicht durch Intelligenz, Gedächtnis oder rasches Denken voraus sind, sondern auf Grund langjähriger Erfahrung. Deshalb haben sie umfangreicheres und besser organisiertes, bereichsspezifisches Wissen. Sie erinnern bei kurz gezeigten Schachstellungen auch ein Vielfaches an Figuren (Chi fand, dass dies sogar den Alterstrend überdecken kann, so dass Schachkinder besser erinnern als erwachsene Novizen). Diese Befunde wurden darauf zurückgeführt, dass sich Experten wie Novizen rund sieben Chunks merken können, Experten aber ganze Figurengruppen als einen Chunk speichern. Novizen nur einzelne Figuren (Chase und Simon). Dies wird auch dadurch belegt, dass Meister beim Nachbauen einer Stellung nach jedem Blick auf die Vorlage mehr Figuren stellen, als Novizen. Über die Gruppierung der Figuren zu sinnvollen Einheiten hinaus wird noch angenommen, dass Meister über Schablonen (templates) verfügen, in denen eine ganze Reihe ähnlicher Schachstellungen zusammengefasst ist (zentrale Figuren stehen gleich). Dies erlaubt, deutlich mehr Stellungen und zielführende Züge zu erinnern, ohne deutlich mehr kognitive Ressourcen zu benötigen (als Beleg mussten Schachmeister gegen viele Novizen zugleich spielen und konnten deshalb nicht jeden Zug in jeder Partie lange bedenken. Dennoch war ihr Spiel kaum schlechter als gegen einen Gegner, da sie eben über templates schnell auf die meisten Routine-Reaktionen zugreifen können). Die Überlegenheit von Schachmeistern ist also auf ihre langjährige Erfahrung und ihr breites Wissen zurück zu führen. Dass diese Meister mittlerweile von Computern an die Wand gespielt werden liegt an der unvorstellbaren Speicherleistung der Computer. 4.3.2. Ein weiteres Themenfeld ist die Physik, wo sich zeigt, dass Experten meist vorwärtsverkettende Lösungsstrategien anwenden. Dies ist ihnen nur möglich, da sie über großes Fachwissen verfügen und deshalb wissensbasierte Entscheidungen für jeden Problemschritt treffen können (bei genug Vorwissen entwickelt der Experte auch bereichsspezifische Problemlöseschemata). Novizen dagegen müssen rückwärtsverkettend Suchen. Sie betrachten die unbekannten gesuchten Größen und versuchen, Gleichungen zu finden, in denen diese Vorkommen (was dann nach rekursivem Anwenden dazu führen kann, dass man den Überblick vollkommen verliert). Außerdem verwechseln Novizen Konzepte wie Geschwindigkeit und Beschleunigung, da ihnen die Routine fehlt (Novizen Suchen also uninformiert im Problemraum, während Experten sozusagen heuristische Suchstrategien anwenden). Ebenso wie beim Schach erlaubt das größere Vorwissen den Physikexperten auch, flexibler auf neue Probleme zu reagieren. Chi zeigte auch, dass Experten Probleme viel sinnvoller klassifizieren als Novizen, wenn die diese nach Ähnlichkeit klassifizieren sollen. Novizen nutzten oberflächliche Merkmale („sich drehendes Objekt“), während Experten die Probleme gruppierten, denen die gleichen physikalische Gesetze zu Grunde lagen. Ein weiterer Aspekt ist die unterschiedliche Problemrepräsentation. Experten repräsentieren Probleme auf zwei Arten: quantitativ-numerisch (das tun auch Novizen) und qualitativkonzeptuell. Ersteres beinhaltet (bei physikalischen Aufgaben) vor allem Gleichungen, während letzteres z.B. die Information beinhaltet, welche Kräfte auf einen Körper im System einwirken. Das Wissen, das für korrekte qualitative Repräsentationen nötig ist, besitzen Novizen nicht, sie sind also gezwungen, das Problem ganz auf der abstrakten Ebene der Gleichungen zu lösen (Das ist schwer und geht oft schief). Novizen haben zudem oft naive Alltagskonzepte von physikalischen Phänomenen, die von der wissenschaftlichen Sicht abweichen. Experten haben gelernt, wie sich diese Phänomene wirklich erklären lassen und machen deshalb keine Fehler auf Grund falscher Grundannahmen. Expertise-Erwerb im Bereich der Physik hat (laut Spada-Forschung!) drei Phasen: 1. Novize hat naiv-qualitatives Alltagswissen (im Alltag nützlich und deshalb robust) 2. Novize erlernt quantitativ-numerisches und qualitativ-konzeptuelles Wissen (in der Schule oft zu wenig qualitatives, weshalb Phase 3 schwer zu erreichen ist) 3. Der Experte hat konsolidiertes qualitatives und quantitatives Wissen. 4.3.3. Auch Mediziner sind (hoffentlich) Experten und wurden diesbezüglich beforscht. Diagnose und Behandlung kann man als Problemlösehandlung betrachten, aber Expertise auf diesem Feld geht nicht unbedingt einher mit allgemein hohen Problemlösefertigkeiten. Vielmehr ist es erneut großes bereichsspezifisches Fachwissen, das Experten auszeichnet, und auf dem Diagnose- und Therapiestrategien aufbauen. Diese Wissensstrukturen werden während dem Studium und zu beginn der beruflichen Tätigkeit aufgebaut und lassen sich den Expertisestufen Anfänger (=Novize), Übergangsstadium und Experte zuordnen. Anfänger erwerben ein weit verzweigtes aber nur lose verknüpftes Wissensnetzwerk (Anatomie, Bio, Chemie) und können medizinische Fachprobleme kaum und nur langsam lösen, da sie ihr Wissen sehr weiträumig durchsuchen müssen. Im Übergangsstadium wird das Wissen sicherer und vor allem enger verknüpft. Zwischenschritte von Begründungen werden ausgeblendet (Einkapselung) und umfassendere Konzepte werden gebildet. Dies erlaubt den Medizinern rasche Entscheidungen ohne das all ihr Wissen berücksichtigt werden muss. Experten bilden schließlich Krankheitsschemata aus, wodurch die Diagnose routiniert wird. Wenn einzelne Elemente des Schemas in der Anamnese auftreten wird das ganze Krankheitsschema aktiviert (vergleichbar mit den templates der Schachforschung und den bereichsspezifischen Schemata der Phsysikexperten) 4.3.4. Fazit: Knowledge is Power. Experten sind Novizen nicht kognitiv überlegen, sondern auf Grund ihres Domänenspezifischen Wissens. Hierbei zählt nicht nur die Menge, sondern auch die Organisation (sie ermöglicht schnellen Zugriff und simultane Verarbeitung). Dadurch sind die Gedächtnisleistungen und Problemlösefertigkeiten von Experten auf ihrem Fachgebiet besser als die von Novizen. Zentral scheint der Übergang von deklarativem Wissen (über Fakten) auf prozedurales Wissen (wie Operationen auszuführen sind), also die Wissenskompilierung nach Anderson (=> Abschnitt 4.2.3). Belege hierfür finden sich auch in der Forschung zu den einzelnen Fachgebieten. Ein Indikator für den Erwerb von Expertise kann ein Wechsel in der Problemlösestrategie sein (Vorwärtsverkettung => Rückwärtsverkettung). Dieser Wechsel muss nicht immer quantitativer Natur sein, wenn sich grundlegende Konzepte ändern kann es auch zu qualitativen Sprüngen kommen (conceptual change). Newell nennt es „Chunking von Prozeduren“, wenn nach häufigem Ablauf der selben Sequenz ein Operator entsteht, der diese Abfolge automatisiert ablaufen lässt (routiniert, aber auch unreflektiert!). Dies kann auch dazu führen, dass Experten die einzelnen Teilschritte ihrer Problemlösung nur noch schwer verbalisieren und hinterfragen können (bis zu dem Punkt, wo aus Routine festgefahrene Bahnen werden, die die Flexibilität einschränken). 4.4 Deduktives Denken (S. 226-242) Beim deduktiven Denken werden aus als gültig vorausgesetzten Prämissen Schlussfolgerungen gezogen. Diese sind dann zwingend gültig (wenn die Prämissen tatsächlich gültig sind). Beforscht werden die Fragen, ob Personen ohne spezielle Vorbildung Kompetenzen besitzen, die ihnen erlauben, logische Schlüsse zu ziehen, ob es systematische Fehler (biases) gibt und welche mentalen Repräsentationen und Schlussmechanismen richtigen und falschen Schlüssen zu Grunde liegen. Hierzu müssen VP sprachliche Argumente auf ihre logische Gültigkeit hin beurteilen oder selbst Schlussfolgerungen aus einer Menge an Prämissen ableiten. 4.4.1. Ein logischer Kalkül ist ein System von Regeln zur Formulierung von Ausdrücken und zur Ableitung neuer Ausdrücke aus gegebenen Ausdrücken. Ein Kalkül transportiert die Gültigkeit von Prämissen auf Konklusionen, garantiert aber nicht die Gültigkeit der Prämissen. Der bekannteste Kalkül ist die Prädikatenlogik, aus der ein Ausschnitt, die Aussagenlogik im Folgenden näher betrachtet wird. Die Ausdrücke dieses Kalküls folgen einer Syntax. Zu Grunde liegen hierbei atomare Aussagen, die entweder wahr oder falsch sein können (abgekürzt mit A, B, C, ...). Syntaktisch korrekte Aussagen sind deshalb in diesem System zum einen die atomaren Aussagen und die beiden Wahrheitswerte („wahr“ und „falsch“) sowie die folgenden Aussagen mit logischen Operatoren (wenn A und B korrekt sind): Diese Regel gilt rekursiv (wenn „A und B“ und „C und D“ korrekt sind, dann ist auch „Wenn A und B, dann C und D“ korrekt). Komplexe Aussagen lassen sich durch Kombination dieser Aussagen repräsentieren. Ob eine syntaktisch korrekte Aussage aber auch gültig ist, ist damit noch nicht geklärt. Hierfür werden zwei Methoden vorgestellt, die modelltheoretische Methode und die Methode der natürlichen Abduktion: Bei der modelltheoretischen Methode wird versucht, die Bedeutung logischer Operatoren durch Wahrheitstafeln zu definieren. Diese Wahrheitstafeln enthalten alle möglichen Kombinationen der Wahrheitswerte der atomaren Aussagen; der Wahrheitswert einer komplexen Aussage wird dann auf die Wahrheitswerte ihrer atomare Aussagen zurükgeführt. Interessant ist hier vor allem, dass ein Konditional „wenn P, dann Q“ nur dann als falsch angesehen werden kann, wenn das Antezedens P wahr, die Konsequenz Q aber falsch ist. Mit Wahrheitstafeln kann man prüfen, ob zwei Aussagen logisch äquivalent sind (gleiche Wahrheitswerte), ob eine Schlussfolgerung zwingend ist (Gegenteil ist unmöglich) und ob eine Menge von Aussagen widerspruchsfrei ist (mindestens eine Kombination, in der die Konjunktion aller Aussagen wahr ist). Die Methode der natürlichen Deduktion orientiert sich am mathematischen Beweis. Zentrales Element sind Schlussregeln, die jeweils aus einer oder mehreren Aussagen und einer Folgerung bestehen. Mit diesen Regeln wird Schritt für Schritt ein logischer Beweis geführt. Die Schlussregeln folgen dabei einer Systematik, für jeden logischen Operator gibt es eine Einführungsregel und eine Eliminationsregel. Darüber hinaus gibt es die Regel der Reductio-ad-absurdum, was bedeutet dass „nicht P“ wahr ist, wenn aus „P“ ein Widerspruch folgt. Es ist jederzeit möglich, eine Annahme zur Gültigkeit einer Aussage zu machen („sagen wir mal, A wäre wahr...“), ob diese wieder verworfen werden muss zeigt sich dann in der Folge. Die Gültigkeit eines Arguments kann bewiesen werden, in dem man die einzelnen Regeln geschickt kombiniert. Hier ein Beispiel, in dem auch eine neue Annahme gemacht wird: In der Forschung kann man die atomaren Aussagen entweder nur als Buchstaben darstellen (wie hier), um zu beweisen, dass Personen die logischen Operatoren abstrakt nutzen können und um zu ergründen, ob sie eher modelltheoretisch oder beweistheoretisch vorgehen, oder man stellt inhaltliche Aufgaben, für die man Prämissen mit identischen logischen Operatoren konstruiert und gezielt den Inhalt der As und Bs variiert, um eventuelle Inhaltseffekte zu finden. Diese beiden Methoden werden weiter unten erklärt. 4.4.2. Als Grundlage für den folgenden Teil (konditionales Schließen) müssen zuerst die vier folgenden Schlussfiguren erläutert werden. Auf der Basis dieser Schlüsse wird erforscht, ob Personen mentale Modelle oder mentale Regeln nutzen, wenn sie schlussfolgern. Modus Ponens (MP) – Aus „Wenn P, dann Q“ und „P“ aussagenlogisch gerechtfertigt schließe „Q“ Modus Tollens (MT) – Aus „Wenn P, dann Q“ und aussagenlogisch gerechtfertigt „nicht-Q“ schließe „nicht-P“ Negation des Antezedens (NA) – aussagenlogisch nicht gerechtfertigt Aus „Wenn P, dann Q“ und „nicht-P“ schließe „nicht-Q“ Affirmation der Konsquenz (AK) – aussagenlogisch nicht gerechtfertigt Aus „Wenn P, dann Q“ und „Q“ schließe „P“ Die letzte beiden Schlüsse sind nicht logisch gerechtfertigt (die ersten beiden schon). Dennoch werden sie häufig von Menschen gezogen. Versuche ergaben, dass der Modus Ponens konstant von fast allen VP gezogen werden kann, dass sich die Anzahl derer, welche die anderen drei Schlüsse ziehen jedoch ändert, wenn man verschiedene Teile des Konditionals negiert. Es zeigte sich, dass sowohl der MT als auch die beiden Fehlschlüsse NA und AK weniger oft gezogen werden, wenn sie zu einer affirmativen Antwort führen (negative conclusion bias). Aus „Wenn nicht-P, dann Q“ und „Q“ folgern ca. 80% der VP „nicht-P“, während nur ca. 40% aus „Wenn nicht-P, dann Q“ und „nicht Q“ „P“ folgern (abstrakt!). Die markierten Prozentwerte sind jene, bei denen die negierte Konklusion zu ziehen war. Es gibt also trotz grundlegender logischer Kompetenzen systematische Abweichugenn von der Logik als Norm. Die beiden Theorien von den mentalen Modellen bzw. den mentalen Regeln sind Ansätze, die versuchen, das Schlussfolgern von Menschen unter Berücksichtigung der starken Wirkung der Negation zu erklären. Die Theorie der mentalen Modelle postuliert, dass Menschen die Bedeutung der Prämissen in einem mentalen Modell repräsentieren und daraus logische Folgerungen ableiten. Ein mentales Modell ist dabei eine Repräsentation der Situationen, die durch die Prämissen beschrieben werden. Der Prozess des Schließens besteht hier aus drei Schritten: 1. Ein initiales Modell wird gebildet (Die Information aus allen Prämissen wird integriert) 2. Antwortgenerierung aus diesem Modell 3. Antwort wird an allen weiteren Modell validiert (Nur wenn sie für alle Modelle gilt, ist sie logisch zwingend) Die folgende Grafik demonstriert die hier üblichen Schreibweisen. Eine Aussage in [eckigen Klammern] ist eine Aussage, zu der es keine weitere Modelle gibt, während eine Aussage ohne Klammern noch in weiteren Modellen vorkommen kann. Logischerweise sind alle Aussagen der vollständigen Modelle in [eckigen Klammern], da man sonst ja nicht von Vollständigkeit sprechen könnte. Diese Darstellungsform zeigt bereits, dass sich die Theorie der mentalen Modell eng am modelltheoretischen Schlussfolgern orientiert. Änderungen sind, dass nur Modelle gebildet werden, die mit der Gültigkeit der Prämissen vereinbar sind (Prinzip der Wahrheit), dass ein Mechanismus formuliert wird, wie eine Aufgabe konkret angegangen wird (oben genannter Dreischritt) und dass zwischen initialen und vollständigen Modellen unterschieden wird. Da Menschen Modelle nicht parallel sondern sequenziell bilden (Arbeitsgedächtnis!) kann es (gerade bei vielen Modellen) passieren, dass einzelne Modelle vergessen werden. Die Theorie der mentalen Modelle erklärt die Einfachheit des MP also damit, dass nur ein Modell gebildet werden muss (das erste Modell [A] [3] reicht aus, um „Wenn A, dann 3“ und „A“ zu integrieren). Die AK ist ebenso leicht zu bilden (wenn auch falsch), was erklärt, warum diese am zweit häufigsten gezogen wird. Um MT und NA zu ziehen, muss das dritte Modell [-A][-3] gebildet werden (auch hier: der NA-Schluss ist dann trotzdem falsch). Warum der negative conclusion bias existiert, ist noch nicht endgültig geklärt, aber eine Annahme ist, dass es mit der doppelten Verneinung zu tun hat, die im dritten Modell aufgelöst werden muss, wenn [-A] statt [A] gegeben ist. Das würde erklären, warum vor allem MT und NA von diesem Phänomen betroffen sind. (Dieses Modell war für die Forschung sehr fruchtbar und hat nebenbei noch das Phänomen der illusionären Inferenz ans Licht gebracht: Wenn entweder gilt „Wenn A, dann B“ oder „Wenn nicht-A, dann B“ und außerdem sicher gilt „A“, kann man nicht sagen ob „B“ gilt, obwohl das fast alle Menschen dann schlussfolgern). Auch die Theorie der mentalen Regeln orientiert sich eng en einer bereits besprochenen Methode, der Methode der natürlichen Deduktion. Auch hier wird postuliert, dass allgemeine Regeln angewandt werden. Bei Rips (PSYCOP) handelt es sich um Einführungs- und Eleminationsregeln. Die Reductio-ad-absurdum wird hier in die „Nicht-Einführung“ und die „Nicht-Elimination“ aufgeteilt, je nach dem, ob die Annahme, aus der ein Widerspruch abgeleitet wird positiv oder negiert war. Doppelte Negationen werden aufgelöst (Aus „nichtnicht-P“ schließe „P“). Rips geht davon aus, das Menschen einen logischen Beweis vorwärts und rückwärts angehen, wobei Vorwärts-Regeln direkt logische Schlüsse aus bekannten Aussagen ziehen, während Rückwärts-Regeln Beweisziele definieren. Wenn das Beweisziel mit den Prämissen verbunden werden kann, ist ein logischer Beweis gelungen (auch hier werden Annahmen gemacht, die sich als wahr oder falsch erweisen können). Je mehr Regeln angewandt werde müssen, desto schwerer ist ein Beweis. Auch diese Theorie kann die Befunde zum Konditionalen Schließen erklären. Der MP ist einfach, da er exakt der „Wenn-Dann-Elimination“ entspricht. Der MT erfordert dagegen die Kombination mehrerer Schlussregeln (incl. Reductio-ad-absurdum). Für NA und AK erklärt das Modell den Fehlschluss dadurch, dass die VP das Konditional zu „Wenn Q, dann P“ umkehren. In einem solchen Konditional entspricht der AK einem einfachen MP und die NA einem MT. Entsprechend werden MP und AK häufiger gezogen als MT und NA (again: AK und NA sind falsch). Der negative conclusion bias kann dadurch erklärt werden, dass der MP und die AK von einer Negation unberührt bleiben, bei der Herleitung des MT und der NA aber eine doppelte Negation in der Reductio-ad-absurdum aufgelöst werden muss – auch wenn das in PSYCOP kein Problem sein sollte, da es eine Regel zur Vermeidung doppelter Negierung enthält (nichtElimination). Untersuchungen haben jedoch gezeigt, dass diese Regel, ebenso wie die NichtEinführung und die Oder-Einführung (welche die Präzision einer Formulierung reduziert), von VP kaum verwendet werden. Die Anwendung der anderen Regeln konnte jedoch in Experimenten empirisch untermauert werden, und auch Versuche zum lauten Denken sprechen dafür. Es finden sich empirische und theoretische Argumente für und gegen beide hier vorgestellten Theorien finden. Gegen die Theorie mentaler Modelle spricht z.B., dass es sehr einfache Problemstellungen gibt, die sich sofort lösen lassen, obwohl sie hunderte von Modellen benötigen müssten. Gegen die Theorie mentaler Regeln spricht der Effekt, dass eine entsprechende inhaltliche Bedeutung der Aussagen sogar den MP-Schluss auf unter 40% drücken kann (Inhaltseffekt). Vermutlich verwenden Menschen je nach Situation eine der beiden Strategien („Wann welche?“ ist die Frage). 4.4.3. Der eben erwähnte Inhaltseffekt wirft die Frage auf, ob Theorien deduktiven Denkens bereichsübergreifend oder bereichsspezifisch konzipiert werden sollten. Als experimentelles Paradigma haben sich hier Versionen von Wasons Wahlaufgabe durchgesetzt: In der ursprünglichen Version sah man vier Karten, die auf der einen Seite Zahlen, auf der anderen Buchstaben hatten. Die Symbole A, K, 5 und 8 waren zu sehen. Die Regel dazu lautet „Wenn auf der einen Seite ein A ist, ist auf der anderen eine 5.“ und die Probanden müssen entscheiden, welche Karten umgedreht werden müssen, um zu überprüfen, ob die Regel verletzt wird (korrekte Lösung: A und 8). Weniger als 10% der Leute können diese Aufgabe lösen. Man kann den abstrakten Inhalt der Aufgabe nun aber durch konkreten Inhalt ersetzen, z.B. in dem man als Regel „Wenn die Gemeinde einen Zuschuss zahlt, dann modernisiert der Hausbesitzer die Heizung“ formuliert und auf die Karten die Aussagen „Bekam einen Zuschuss“, „Bekam keinen Zuschuss“, „Modernisiert“ und „Modernisiert nicht“ druckt. In Diesem Fall lösten 50% der VP die Aufgabe korrekt, bei stärker normativen Regeln sogar 70% (obwohl das Konditional exakt gleich ist). Evolutionspsychologen gehen davon aus, dass es sich um einen Beleg für bereichsspezifische Kompetenzen handelt, die sich evolutionär herausgebildet haben. Sie verwenden die Analogie eines Schweizer Taschenmessers, bei dem man viele spezifische Module hat, die unspezifischen Mechanismen vorgezogen werden, falls sie greifen. In diesem speziellen Fall gehen sie davon aus, dass Menschen bei der Entwicklung von Kooperation gelernt haben, Betrüger zu entlarven. Sie haben eine Version der Wahlaufgabe erfunden, die mit der inhaltlichen identisch ist, aber bei der am Ende gefragt wird, welche Karten man drehen muss, um zu erfahren, ob die Gemeinde die Regel verletzt. Dies ist überhaupt nicht möglich, dennoch wählen die meisten VP die beiden Karten, die im ursprünglichen Versuch falsch waren. Fragt man die VP allerdings, ob die Gemeinde die Regel verletzen kann, so antworten die meisten mit „Nein“. Es wäre also möglich, dass sie das Konditional im Kopf umgedreht haben, um es zur Perspektive passend zu machen. All diese Befunde sind außerdem selbst dann keine Belege für eine evolutionäre Theorie, wenn sie sich als stichhaltig erweisen, da sie nur zeigen, dass bereichsspezifisches Denken über unspezifische Schlussmechanismen dominiert. Dieses Denken könnte sich ein Mensch jedoch auch in der individuellen Lerngeschichte angeeignet haben. Hierzu haben Beller und Spada (!) den Zwei-Quellen-Ansatz geschaffen. Er postuliert, dass die syntaktische Form eines Arguments die eine Quelle für logische Folgerungen ist, während der Inhalt der Aussagen die zweite Quelle ist. „Wenn Petra in Paris ist, ist sie im Louvre. Sie ist nicht in Paris, also ist sie nicht im Louvre“ ist eigentlich eine NA, also falsch. Unsere Inhaltskompetenz erlaubt uns jedoch, zu verstehen, warum die Aussage wahr ist. Die Schlussfolgerungen aus beiden Quellen können sich decken, oder nicht. Der Inhalt kann also formal korrekte Antworten erleichtern, oder unterdrücken (wie hier). Personen wissen außerdem, wann ein Konditional zum Inhalt passt (Formkompetenz). Im Beispiel mit den Heizungen heißt das: Das inhaltliche Wissen, dass zu Grunde liegt, ist das Wissen um konditionale Versprechen („Wenn du..., dann gebe ich dir...“). VP besitzen die Formkompetenz, zu wissen, dass die Gemeinde in dem Bespiel ihr Versprechen gar nicht brechen kann, doch der Inhaltseffekt überwiegt, wenn man sie bittet, die Perspektive der Hausbesitzer zu übernehmen. Sie interpretieren dann die Regel als umkehrbar und wählen die entsprechenden Karten. Der Zwei-Quellen-Ansatz ist keine eigene Theorie, sondern eine Überlegung, die von anderen Theorien berücksichtigt werden soll. Auch neuropsychologische Untersuchungen deuten darauf hin, dass inhaltsneutrale Schlüsse in anderen Hinrarealen gezogen werden als inhaltliche. 4.4.4. Die Forschung weist auf Kompetenzen zu deduktiven Schlüssen ebenso hin wie auf systematische Einflüsse logisch irrelevanter Merkmale. Theorien müssen beiden Aspekten gerecht werden. Das menschliche Denken folgt nicht in jeder Schlussfolgerung den Maßstäben der Logik. Es ist aber auch nicht irrational und chaotisch. Man spricht von begrenzter Rationalität (bounded rationality).