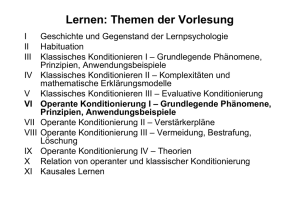

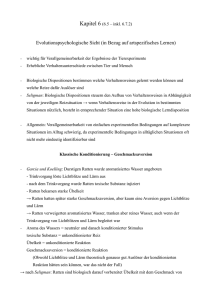

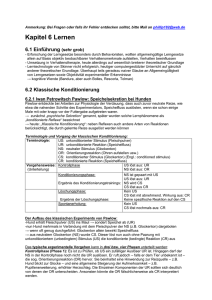

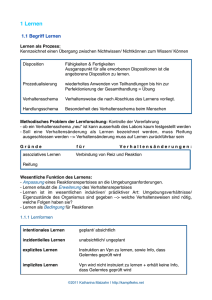

apii_skript_lernen_klass_u_operante_kond

Werbung