Things I have learned (so far)

Werbung

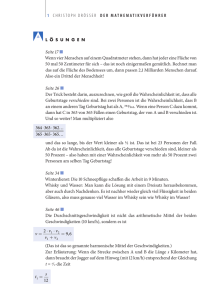

Summary Articles „Evaluationsmeth.SS06“ ©Kiwi - Disclaimer: [email protected] Things I have learned (so far) Jacob Cohen 1990 Abstract Die Prinzipien „weniger ist mehr“ (weniger variablen – gezieltere Themen, scharfe grenzen), „einfacher ist besser“ (grafik, gewichtseinheiten) und „einige Dinge welche du lernst sind nicht so“ sind in der Statistik relevant. Falsche Auffassungen zu Fishers NullhhypothesenTesten, Effektgrößen zu beachten statt Signifikanzwerte, eine kritische Einstellung zur Induktion, das Urteil des Versuchsleiter bestimmt die Interpretation und gut Ding braucht Weile seien auch wichtige Einsichten in der Statistik. 1. Einige Dinge sind nicht so, wie du es gelernt hast Früher beinhalteten alle statistischen Studien 30 Versuchspersonen. Mit der Power Analyse stellte sich aber heraus, dass die Wahrscheinlichkeit, mit so einer kleinen Stichprobe einen signifikanten Effekt zu finden, nur 47% betrug, mit 20 Personen nur mehr 33% usw. 2. Weniger ist mehr Dieses Prinzip gilt für alles, außer die Stichprobengröße. Eine nicht exploratorische Untersuchung sollte so wenig wie möglich abhängige sowie unabhängige Variablen untersuchen: Die Anzahl der zu testenden Hypothesen entspricht nämlich mind. dem Produkt der Variablen (abh.*unabh.). Somit ist die Wahrscheinlichkeit für ein signifikantes Ergebnis sehr hoch und jene für einen unkontrollierten Alpha Fehler ebenfalls – was auch nicht durch eine Bonferroni-Korrektur behoben werden kann. Es ist also besser, einer Studie eine nützliche zentrale Idee zugrunde zu legen, sodass zielgerichtetes Testen von Hypothesen anhand bestimmter Variablen sehr wahrscheinlich zu signifikanten Ergebnissen führt. Auch bei multiplen Regressionen ist dem so, indem Redundanz mit der Anzahl von Variablen steigt. Ein weiterer Anwendungsbereich für dieses Prinzip ist die Anzahl der Dezimalstellen: Zuviele sind nur verwirrend! 3. Einfacher ist besser Graphiken sind numerischen Berichten vorzuziehen, da sie eine Verteilung besser anschaulich machen. Besonders gilt dies für bivariate Korrelationen (Scatterplot), wo zudem ersichtlich wird, auf wie vielen Punkten eine solche Berechnung beruht. Die Berechnung selbst war früher zu Bleistift- und Papier-Zeiten äußerst aufwändig, ist aber heute eine Frage von Computer-Millisekunden. Dabei verliert man aber oft die eigentlichen Daten aus den Augen, auch da man nicht mehr weiß, welche mathematische Prozedur der Statistik zugrunde liegt. Die Komposition von Werten aufgrund Standardisierten Z-Scores sei ein Beispiel: Die Stichprobengröße hat auf units-weighted Korrelationen keinen Einfluss, da keine instabilen Korrelationskoeffizienten angenommen werden. Cross validated multiple Korrelation anhand der Beta-weights variiert hingegen mit der Stichprobengröße. Die unit-weights funktionieren auch außerhalb der multiplen Regression: Da U-W auf standardisierten Werten basieren, funktionieren sie besser als Faktorwerte aus einem PC Programm. Mehrwertige graduelle Variablen sollten aber nicht durch einen Cut „vereinfacht“ und z.B. dichotomisiert werden. 4. Die Fishersche Rechtsprechung Das Null-Hypothesentesten ist die Methode der induktiven Inferenz. Man kann aufgrund der Ergebnisse klare Entscheidungen treffen. Die 0,05 – p – Grenze führte auch zu zwanghaften Daten-fehler-suchen, um diesem Urteil gerecht zu werden. 5. Die Null Hypothese testet uns 1 Summary Articles „Evaluationsmeth.SS06“ ©Kiwi - Disclaimer: [email protected] Wenn man einen p-Wert erhält, der mit Signifikanz von z.B. .026 zulässt, die 0-Hypothese zu verwerfen, dann bedeutet das nicht, dass diese 2,6% die Wahrscheinlichkeit für das Zutreffen der 0-Hypothese sind, sondern es ist die Wahrscheinlichkeit, dass unsere Daten vorliegen, wenn die 0-Hypothese zutrifft! Dementsprechend sagt dieser Wert auch nichts über die Wahrscheinlichkeit aus, dass die Alternativhypothese zutrifft. Andererseits bedeutet es nicht, dass die 0-Hypothese zutrifft, wenn wir sie nicht verwerfen können. Ebenso ist ein Effekt nicht signifikant oder wichtig aufgrund eines p-Wertes. Eigentlich ist eine (definitionsgemäß eng in Zahlen konkretisierte) Nullhypothese falsch, egal ob p.03, p.001 oder p.000000001 ist. In der Realen Welt ist die Nullhypothese immer falsch. Erreicht man ein Signifikanzlevel nicht, so bedeutet das nicht, dass die Nullhypothese richtig ist, sondern das bedeutet nur, dass man nicht schlussfolgern kann, dass die Nullhypothese falsch ist. Mit der Einführung der Effektstärke konnte daraus und der Wahrscheinlichkeit für Alpha- und Beta-Fehler die notwendige Stichprobengröße berechnet werden: Pearson und Neyman setzten einen Rahmen für das Hypothesentesten mit 4 Parametern: Die Alpha Signifikanz, die Stichprobengröße, die Populations-Effektstärke und die Power des Tests. Jeder dieser Parameter ist eine Funktion der anderen drei. Daraus entwickelte Cohen die Metaanalyse – die er anwandte indem er die (meist sehr niedrige) Power der damals (bis 1969) publizierten Studien berechnete. Demgemäß lässt sich auch die Schwerwiegende Annahme der Nullhypothese (wenn die Studie nicht signifikant ist) kritisch betrachten, wenn die Wahrscheinlichkeit, einen Effekt zu übersehen (Beta Fehler) größer als .05 ist. Aber für Beta unter so eine Grenze zu kommen, bedarf enormer Stichprobengrößen! Je kleiner der Effekt ist, den man entdecken möchte, desto größer muss die Stichprobe sein. Effektstärke aufgrund der Poweranalyse ist jedenfalls wesentlich aussagekräftiger als ein Signifikanzwert. Trotzdem dauerte es sehr lange, bis sich diese Ansicht durchgesetzt hatte. Beachtet man die Effektstärke nicht, so kann man auch eine Korrelation von r=.0278 zwischen Größe und IQ als hochsignifikantes Ergebnis publizieren… Die Metaanalyse forcierte die Durchsetzung der Überprüfung von Effektstärken. Trotzdem sei noch einmal darauf hingewiesen, dass wir vergessen haben, woher unsere Zahlen kommen, z.B. ist die Fehlervarianz auf eine Komponente im F reduziert, anstatt dass sie selbst reduziert werden würde! 6. Wie Statistik genutzt werden sollte Die Exploratorische Datenanalyse nach Tukey ist vielfach in Vergessenheit geraten, ist aber nützlicher als man denkt! Die Untersuchung selbst sollte auch gut geplant werden – man kann dies anhand Alpha, Effekt, (Beta bzw. :Power = 1- Beta) Power und Stichprobengröße tun. Effektstärken werden in Form von Differenzen berechnet – aber zur Verständlichkeit und Generalisierbarkeit in d-Werte Standardisiert. Ein Konfidenzintervall ist informativer als ein p-Wert: Es zeigt zwar auch die Signifikanz, aber zudem die Breite der p-Werte. Statistiker müssen sich auch immer bewusst sein, dass sie ein informiertes Urteil fällen, das also die Schlussfolgerung beeinflusst. Sie bestimmen was sie untersuchen, welche Daten sie brauchen und wie sie diese bekommen. Ein einziges Ergebnis ist noch keine fertige Forschung sondern nur ein Beleg: Weitere Belege sind notwendig und machen das Ergebnis nur immer noch ein Stück wahrscheinlicher. Letztendlich muss auch gesagt sein, dass die Dinge ihre Zeit brauchen. Power berechnet heute jedes Computerprogramm, aber aktuelle Forschung beschäftigt sich nicht mit dem Thema. Aber das wird wohl noch kommen… 2 Summary Articles „Evaluationsmeth.SS06“ ©Kiwi - Disclaimer: [email protected] The Earth is round (p<.05) Jacob Cohen, 1994 Noch immer werden 0-Hypothesen mit einem p<.05 Signifikanztest verworfen und die Theorie bestätigt. Exploratorische Datenanalyse, graphische Methoden, Verbesserung und Standardisierung der Messung, Effektstärken schätzen, Konfidenzintervalle, und informierte Nutzung der statistischen Methoden sollte in Zukunft wichtiger werden. Generalisierung beruht immer noch auf Replikation. Statistik und der Streit rundum sind schon lange nicht mehr aufregend bzw. originell. Hypothesentesten (NHST) ist ein Ritual und wurde viel beschimpft. Das Problem mit NHST ist, dass sie uns sagt: „Wenn H0 wahr ist, was ist die wahrscheinlichkeit von diesen oder extremeren Daten?“. Aber wir wollen eigentlich wissen: „Wenn es diese Daten gibt, was ist die Wahrscheinlichkeit, dass H0 wahr ist?“ Und viele glauben, das zu erfahren. Eine permanente Illusion! Deduktives syllogistisches Schlussfolgern wird falsch angewandt: Wenn die Null Hypothese korrekt ist, dann kann es diese Daten (D) nicht geben. Es gibt diese Daten. Also, die Null Hypothese ist falsch. Wenn das das Schlussfolgern des H0-testens wäre, dann wäre es formal korrekt, ein Modus Tollens, wo der antecendent verneint wird und somit auch der consequent. Aber NHST ist ein probabilistisches Schlussfolgern: Wenn die Null Hypothese korrekt ist, dann sind diese Daten sehr unwahrscheinlich. Es gibt diese Daten. Also, die Null Hypothese ist sehr unwahrscheinlich. Das stimmt jetzt nicht mehr! Warum nicht? Wenn eine Person ein Martianer ist, dann ist er kein Mitglied des Kongresses. Die Person ist Mitglied des Kongress. Also, sie ist kein Martianer. Ein Modus Tollens kann unsensibel sein, insofern als dass die Form stimmt aber der antecedenz falsch ist. Wenn eine Person Amerikaner ist, dass ist sie kein Mitglied des Kongresses. (FALSCH!!!) Die Person ist ein Mitglied des Kongresses. Die Person ist kein Amerikaner. Man könnte den antesedens probabilistsisch anstatt absolut formulieren, damit er sensibel ist. Dann ist aber der syllogismus formal inkorrekt und die konklusion nicht mehr sensibel. Wenn eine Person Amerikaner ist, dann ist sie wahrscheinlich kein Mitglied des Kongress (WAHR, RICHTIG?) Diese Person ist ein Mitglied des Kongress. Daher ist sie wahrscheinlich kein Amerikaner. Das entspräche der Formulierung: Wenn die H0 wahr ist, dann würde dieses Resultat (statistisch Signifikant) nicht auftreten. Das Resultat trat auf. Also, die H0 ist wahrscheinlich nicht wahr und darum formal invalide. Diese Formulierung ist aber in etwa das, was man in jedem psychologischen Artikel wieder findet: Die Illusion Unwahrscheinlichkeit zu beschreiben. Warum P(D|H0) =not P(H0|D). Beim Testen einer H0 findet man die Wahrscheinlichkeit, dass die Daten D auftreten konnten, wenn H0 wahr wäre P(D|H0). Bei kleiner Wahrscheinlichkeit sind die Daten 3 Summary Articles „Evaluationsmeth.SS06“ ©Kiwi - Disclaimer: [email protected] unwahrscheinlich. Interessant ist aber die inverse Probabilität, nämlich die Wahrscheinlichkeit für die Richtigkeit von H0 sofern es die Daten gibt P(H0|D). Man will ja die H0 mit einer bestimmten Wahrscheinlichkeit verwerfen. Dazu müsste man aber zuerst die Wahrscheinlichkeit für H0 finden – und die wissen wir nicht. Als Beispiel führt Cohen an, dass ein Schizophrenie-Test von den 2%Prävalenten Schizophrenie-Fällen mit 95% Sensitivität (richtig positive Diagnose) und 97% Spezifität (richtig negative Diagnose) nicht mit p<.05 Schizophrenie erfasst sondern mit p=.6, da die Wahrscheinlichkeit der Null Hypothese nicht berücksichtigt wurde. Natürlich kann aber nicht für jede Wissenschaft vorausgesetzt werden, dass die Wahrscheinlichkeit der 0Hypothese bekannt sein muss. (Bayesian prior) Auch Popper testete wissenschaftliche Theorien indem er versuchte, sie zu falsifizieren. Aber man darf eben nicht behaupten, eine Theorie wäre bestätigt, wenn eigentlich nur die Null-Hypothese verworfen wurde. Der Fehler inverser Wahrscheinlichkeit bei der Interpretation der H0 wurde in der Literatur von vielen Forschern begangen. Man glaubte auch, dass ein signifikanter Befund mit hoher Wahrscheinlichkeit repliziert werden könnte, was aber in Anbetracht der typischen .50-Power solcher Studien lustig klingt: Wir hätten eine 50:50 Chance für eine Replikation! Außerdem, wenn eine H0 verworfen werden kann, so kann dies aufgrund der falschen Theorie über die Instrumentation oder aufgrund der Natur der Psyche oder aufgrund anderer Umstände sein und nicht aufgrund der Theorie, welche die Forschung anleitet. Hypothesentesten ist also nicht einfach eine objektive Angelegenheit, sondern die z.T. nicht gemessenen oder gar nicht messbaren Rahmenbedingungen spielen eine beträchtliche Rolle wenn es um die Aussagekraft eines Ergebnisses geht. Die Nil-Hypothese Die Null Hypothese ist immer falsch, weil es unmöglich ist, dass genau 0 rauskommt. Man könnte jede beliebige 0 Hypothese aufstellen: Die Effektstärke ist 0, die Reliabilität ist 0 etc. und das kann alles ganz einfach sogar durch eine sehr kleine Stichprobe widerlegt werden. Und egal wie klein der Effekt ist, es lässt sich jeder noch so winzige Effekt nachweislich signifikant machen, wenn nur die Stichprobe groß genug ist. Meehl führte eine Riesenstudie durch, wo hoch signifikante Korrelationen zwischen verschiedenen Eigenschaften resultierten – klar! Aber die Korrelationen waren nicht einmal gar so niedrig – auch klar, wenn man bedenkt, dass irgendwie alles mit allem anderen zusammenhängt (crud factor). Und nach einer genaueren Untersuchung zeigte sich, dass aufgrund dieses crud factors eine WK von 1:1 mit einer Power von .75 angenommen werden kann, und dass die Bayesian posterior probability sowie die prior probability <=.1 ist, kommt man zu dem Schluss, dass die Theorie 9:1 wahrscheinlich doch nicht stimmt... Meta-Analysen brachten auch eine tiefere Einsicht in das Thema. Schmidt erinnerte die Forscher, dass, da die 0Hypothese immer falsch ist, keine Beta Fehler mehr gemacht werden können und nur noch Alpha Fehler gemacht werden, und diese sogar mit 50% Wahrscheinlichkeit. Weiters ist die für ein signifikantes Ergebnis notwendige Effektgröße deutlich größer in einer Stichprobe als in der eigentlichen Population und der Mittelwert der statistisch signifikanten Effektgrößen ist viel größer als die eigentliche Effektgröße. D.h. man überschätzt Effektgrößen. Eine Bonferronikorrektur (o.a. Sophisticates) würde einen nichtexistenten Alpha-Fehler korrigieren und – sofern das Resultat dann noch signifikant ist – die Effektstärke vergrößern – also überschätzen. Das Ergebnis-Berichten anhand von pWerten bedeutet eine Quantifizierung der Wissenschaft. Aber auch eine korrekte Interpretation macht nicht alles gut. Meistens wird ein signifikantes Ergebnis als „Richtung“ (das ist mehr als das) interpretiert, selten aber mit einem Konfidenzintervall. Tukey wies auch darauf hin, dass Korrelationen (nicht wie Regressionen) als Funktion der auserwählten Population variieren. Korrelationen sagen nichts über eine 4 Summary Articles „Evaluationsmeth.SS06“ ©Kiwi - Disclaimer: [email protected] Kausalität aus. Um eine echte Regression zu erarbeiten, bedarf es einer tieferen Einsicht in die Einheiten, mit denen auf der Basis operiert wird. Also was tun? Erstens, es gibt keine Alternative für NHST. Zweitens, bevor von Daten aus generalisiert wird, sollten die Forscher diese Daten selbst verstanden und verbessert haben – man denke auch an die Exploratorische Datenanalyse und graphische Darstellungen. Drittens sollten Ergebnisse besser anhand von Konfidenzintervallen berichtet werden, da diese alle und mehr Informationen enthalten, da sie die nil hypothese blosstellen sowie auch non-nil null hypothesen und an die Operation mit einem crud-Factor erinnern. So zeigen sie auch den Zusammenhang zur Power anhand der Stichprobengröße in ihrer Breite. Inference by Eye: confidence Intervals and How to read Pictures of Data G. Cumming and S. Finch, 2005 Einleitung Konfidenzintervalle werden noch immer kaum von Psychologen verwendet um ihre Resultate zu berichten. Besonders geeignet für Abbildungen sind Fehler-Balken. Konfidenzintervalle sind generell die beste Art, empirische Daten zu berichten. Sie sollten graphisch dargestellt werden. Leider gibt es aber noch keine offiziellen Richtlinien, wie diese Darstellung zu erfolgen hat. Konfidenzintervalle und Fehlerbalken: Grundsätzliches Der Mittelwert einer Stichprobe ist ein punktueller Schätzwert des Mittelwertes der Population. Das Konfidenzintervall (95%) ist eine Intervall-Schätzung, welche die Präzision unseres punktuellen Schätzwertes angibt. Die 95% sind das Konfidenzniveau und folgt einer Konvention. Das Konfidenzintervall ist ein Bereich um den Mittelwert im Zentrum, welches sich um eine Distanz von w (width, breite) um den Mittelwert erstreckt. Diese Distanz auf jeder Seite des Mittelwertes nennt sich „margin of error“ bzw. Standardfehler des Mittelwertes (w= SE*t[(n-1),c] d.h. SE multipliziert mit dem kritischen Wert der Signifikanz, und SE= SD/√n). Um mit größerer Sicherheit sagen zu können, dass das Konfidenzintervall den Populationsmittelwert μ enthält, wählen wir ein breiteres Konfidenzintervall, z.B. 99% statt 95%. Konfidenzintervalle sind also geschätzte Wertbereiche, die mit einer hohen Wahrscheinlichkeit den wahren Populationsmittelwert enthalten. Aber Vorsicht: Es ist korrekt zu sagen, dass die Wahrscheinlichkeit für (M-w≤μ≤M+w)=.95, aber diese oberen und unteren Grenzen variieren von Stichprobe zu Stichprobe. Man darf also nicht behaupten, ein bestimmtes, in Zahlen ausgedrücktes Konfidenzintervall (z.B. 55, 98) enthielte mit einer bestimmten Wahrscheinlichkeit μ, denn das würde bedeuten dass der Populationsmittelwert variabel ist, hingegen ist μ ein fixer Wert! Auf lange Sicht wird erwartet, dass 95% (bzw. C%) der Konfidenzintervalle μ enthalten. Die Vorteile von Konfidenzintervalle sind, - dass sie eine verständliche punktuelle und Intervallschätzung der Messeinheiten geben - es gibt einen verständlichen Zusammenhang zwischen Konfidenzintervall, p-Wert und wohl bekanntem Nullhypothesentesten 5 Summary Articles „Evaluationsmeth.SS06“ ©Kiwi - Disclaimer: [email protected] - Evidenz verschiedener Experimente kann gut kombiniert werden, da Konfidenzintervalle Metaanalysen und solches Denken für Schätzungen stützen - es steckt eine gute Information über Präzision in Konfidenzintervallen, die nützlicher ist, als die Berechnung von Statistischer Power. Es gibt gewiss auch Studien, wo die Anwendung von Konfidenzintervallen etwas komplizierter wird, doch für diesen Zweck gibt es entsprechende Literatur. Auch im klassischen, dichotomen Nullhypothesentesten schlug die APA vor, nicht einfach eine Ja/Nein Entscheidung mit einem Signifikanzniveau zu berichten sondern den exakten pWert. Dies ist auf jeden Fall ein Fortschritt, zumal es zu einer quantitativeren Theoriebildung führen sollte. Graphisch stehen wir vor einem Ambiguitätsproblem, da die Darstellung mit Fehlerbalken des Konfidenzintervalles (CI) gleich aussieht, wie jene konventionelle für Standardabweichungen (SD) und Standardfehler (SE). Außerdem sollte der C Wert im Bildtext immer angegeben werden, da er 95%, 99% oder etwas anderes sein könnte. Graphisch dargestellt, könnte man für ein klassisches 2-Gruppen-Versuchsdesign ein zusätzliches Konfidenzintervall darstellen, welches mit einer eigenen Skala versehen, die Differenz zwischen den beiden Gruppen angibt. Das Konfidenzintervall dieses dritten Balkens ist deshalb breiter, da es die Messfehler beider Gruppen enthält. Für ein Messwiederholungsdesign empfiehlt sich die dieselbe Darstellung, mit dem Unterschied, dass das Differenz-Konfidenzintervall nun schmäler ist, da die Messfehler aus einer Gruppe stammen. Eine dritte Möglichkeit ist die Darstellung einer Metaanalyse, wo mehr als ein Experiment in einen gepoolten Mittelwert zusammengefasst werden und wo das Konfidenzintervall wiederum schmäler ist: Der neue Mittelwert ist eine bessere Schätzung des Populationsmittelwertes. Diese drei Versionen sind deshalb besonders Vorteilhaft, weil aus einem Balken direkt die relevante Information für die Fragestellung (Differenz oder Gesamtmittelwert) abgelesen werden kann. So können auch Haupteffekte, Interaktionen oder jegliche Kontraste dargestellt werden. Regeln zur visuellen Interpretation: “Rules of Eye for Reading Data Pictures with Cis” 1. Identifikation der Bedeutung des Mittelwertes und der Fehlerbalken: a. Welche ist die abhängige Variable? Ist sie in originalen Einheiten oder Standardisiert dargestellt? b. Zeigt das Bild CI, SD oder SE und welcher C-Wert gilt? c. Welches experimentelle Design liegt vor? d. Welcher Effekt ist relevant und wie wird er dargestellt? 2. Eine substantielle Interpretation der Mittelwerte vornehmen: Wie wichtig und wie groß ein Effekt ist, sollte aufgrund praktischer oder klinischer Signifikanz anstatt Statistischer Signifikanz beurteilt werden. 3. Eine substantielle Interpretation des Konfidenzintervalles vornehmen: - Dabei sollte der C-Wert und der Wertebereich im Konfidenzintervall berücksichtigt werden. - Das Konfidenzintervall ist eine Spannbreite plausibler Werte für den Populationsmittelwert (Wahrscheinlichkeit p>.05). Jene Werte außerhalbe des Konfidenzintervalles sind relativ unplausibel (p<.05 im klassischen Nullhypothesentesten). - w ist mit der Wahrscheinlichkeit C die geschätzte, größtmögliche Fehlerabweichung vom Populationsmittelwert und somit ein Präzisionsindex. 4. Für den Vergleich zweier unabhängiger Mittelwerte gilt p≤.05, wenn die Überlappung der 95% Konfidenzintervalle nicht mehr als ca. die Hälfte des mittleren Standardfehlers ist (die Proportion der Überschneidung ist .05 oder weniger). p≤.01 6 Summary Articles „Evaluationsmeth.SS06“ ©Kiwi - Disclaimer: [email protected] gilt, wenn die zwei Konfidenzintervalle keine Überlappung haben, also die Proportion der Überschneidung 0 ist oder sogar ein positiver Abstand dazwischen liegt. Diese Richtlinien gelten, wenn beide Stichproben mind. 10 VPs enthalten und wenn sich die Standardfehler nicht mehr voneinander unterscheiden als durch einen Faktor von 2. Natürlich ist diese Schätzmethode etwas konservativ. 5. Für den Vergleich von abhängigen Mittelwerten muss ein zusätzlicher Balken zur Interpretation der Differenz herangezogen werden – dieser ist für (4) eher nicht zu empfehlen, hier aber die einzig richtige Möglichkeit. w ist schmäler als die einzelnen w der Stichprobenmittelwerte, wenn die Korrelation positiv ist, gleich groß, wenn die Korrelation 0 ist und größer, wenn die Korrelation negativ ist. p-Werte zu interpretieren ist eine Entscheidung aufgrund der Theorie, die dahinter steckt – es ist demgemäß ein Leichtsinn den feinen Unterschied zwischen .04 und .07 für eine schwere Entscheidung relevant zu machen. Daher sind Konfidenzintervalle eher für die Inferenz eines Ergebnisses, nicht aber für eine Entscheidung oder anstatt eines p-Wertes zu Interpretieren. 6. SE-Balken bedeuten etwas anderes als CI-Balken: Es ist aber schwieriger, sich die visuelle Darstellung von SE anhand der Stichprobengröße und C mental multipliziert vorzustellen. Daher folgende Empfehlung: Wenn n mind. 10 ist, dann können SEBalken in etwa verdoppelt werden um 95% CI zu erhalten. Der SE Balken selbst gibt in etwa 68% des CI wieder, sodass 2/3 der SE Balken den Populationsmittelwert enthalten würden. Wenn n kleiner 10 ist, so geben SE-Balken ein Konfidenzintervall mit weniger als 68% C wider. 7. Für einen Vergleich zweier unabhängiger Mittelwerte von Stichproben mit n=mind. 10 und SE unterscheiden sich nicht mehr als durch einen Faktor von 2, ist p≤.05, wenn der Abstand zwischen den SE-Balken mindestens die Größe des mittleren SE beträgt. p≤.01 wenn das Verhältnis des Abstandes zum SE 2:1 oder mehr ist. Außerdem... Ein Problem ist die graphische Darstellung eines Designs mit einem between- und einem within- (Messwiederholungs-) Faktor. Die Konfidenzintervalle können den Between-Effekt darstellen, für den within-Effekt müssten aber separate Differenz-Konfidenzintervalle gezeigt werden. Es gibt inzwischen auch Studien über Statistische Kognition. Das ist die Untersuchung der mentalen Repräsentation statistischer Methoden. So sollten die Darstellungsweisen verbessert werden können. Statistical, Practical and Clinical: How many Kinds of Significance do counselors need to consider? Bruce Thompson, 2002 Im Hinblick auf diese 3 Arten der Signifikanz werden ein Konzept für die vielen Praktischen Effektgrößen, Größenindizes für Therapeuten, die Schätzung korrigierter Interventionseffekte vorgestellt. Leser sollten also Praktische oder Klinische signifikanz-Berichte erwarten und lesen können, wobei manche Fachzeitschriften den Bericht solcher Daten sogar von den Autoren verlangen. 7 Summary Articles „Evaluationsmeth.SS06“ ©Kiwi - Disclaimer: [email protected] Kleine Zeittafel und Einführung 1710 Arbuthnot: Statisische Analysen Londoner Geburtsraten 1900 Pearson: Chi-Square 1908 Gossett, Pseudonym „Student“: t-test 1918 Fisher: Varianzanalyse 1934 Snedecor: ANOVA mit F nach Fisher Kritik gibt es auch seit es Signifikanztests gibt: 1919 Boring „Mathe vs. Wissenschaft“ Praktische und/oder Klinische Signifikanz sind für Therapieforschung wichtig und sollten daher auch berichtet werden. Drei Arten der Signifikanz Statistische Signifikanzschätzungen geben die Wahrscheinlichkeit p an, dass die Daten auftreten konnten, wenn H0 wahr wäre. Das heißt sie sagen NICHTS über die Wahrscheinlichkeit der Populationswerte aus. Außerdem sagen sie nichts über die Relevanz der Ergebnisse aus: Auch wenn ein Ergebnis sehr unwahrscheinlich ist (Zufall?) oder sehr wahrscheinlich, aber nicht ungewöhnlich und ohnehin erwartet wird, so kann es dennoch wichtig sein. Außerdem sollte man sich auch immer vor Augen halten, dass die Statistischen Signifikanztests die Zahlen verrechnen, die man in den Computer getippt hat – und diese können fehlerhaft sein... Praktische Signifikanz entfernt sich von dieser ordinalen Denkweise des mehr oder weniger bzw. des Unterschiedes. Demgemäß haben Fisher den eta squared, Kelley den epsilon squared u.ä. zur Messung der Effektstärke vorgeschlagen, da damit der Effekt der Stichprobengröße auf das Signifikanztesten ausgeglichen wird. Klinische Signifikanz ist die Grundlage für Entscheidungen in Therapie und Medikation. Sie werden in diagnostischen Kriterien operationalisiert und angewandt. Diese Signifikanz bezieht sich auf den praktischen oder angewandten Wert oder die Relevanz eines Effektes einer Intervention. Das heißt, die Frage ist, ob eine Intervention eine wirkliche Veränderung im Alltag der Klienten bzw. der Angehörigen bzw. damit tätigen Personen ausmacht. Interventionen können also klinisch Signifikant sein, auch wenn sie keinen „Effekt“ aufweisen, da es hier um Lebensqualität geht, wo jeder Zuwachs relevant ist! Wie viele Arten der Signifikanz sind notwendig? Statistische Signifikanz reicht nicht aus, wenn es sich um wirklich wichtige, lebensnotwendige Interventionen handelt: Effekte, die in z.B. 200 Studien p=.06 erreichen, seien mit dem Zitat von Rosnow&Rosenthal (1989) bedacht: „surely, God loves the .06 nearly as much as the .05“. Es sollte also keine Ja/Nein Frage sein, sondern etwas mehr als A ist besser als B: Wir wollen wissen, um wie viel A besser ist. Außerdem sollten Studien nicht nur die Effektgrößen berichten, sondern sich auch auf die Konsistenz der Intervention in verschiedenen Settings beziehen, indem vorangegangene Studien mit dem aktuellen Befund verglichen werden. Effektgrößen sollten auch berichtet und interpretiert werden. APA „ermutigte“ Autoren zunächst nur dazu, doch inzwischen gibt es zahlreiche Zeitschriften, die Effektgrößenberichte verlangen. Das APA 2001 Pubblication Manual schreibt nun auch dass es fast immer notwendig ist, Effektstärken zu berichten. Idealerweise enthalten Forschungsartikel also die praktische und die klinische Signifikanz – wobei anzumerken ist, dass die klinische Signifikanz Methodisch und Philosophisch viel schwieriger zu bewerten ist. Effektmaße werden unterteilt in: 8 Summary Articles „Evaluationsmeth.SS06“ ©Kiwi - Disclaimer: [email protected] Unkorrigiert Korrigiert Standardisierte Differenzen Glass’s g’ Cohen’s d Thompson’s „Corrected“ d* Relationship VarianceAccounted-For eta² (η²; auch correlations-ratio genannt (kein Korrelationskoeffizient!) Hay’s omega² (ω²) Adjusted R² Standardisiert bedeutet, dass die Skalierung einheitlich vorgenommen wird: Ein Wert wird durch einen anderen dividiert, und schon hat man eine standardisierte Skalierung. Glass g’ ergibt sich, wenn man die mittlere Differenz durch die Standardabweichung der Kontrollgruppe dividiert. Cohen’s d hingegen verlangt eine gepoolte Standardabweichung (aus Interventionsgruppen und Kontrollgruppe) für diese Division. Er gab auch Richtwerte für die Interpretation an: .2 ist klein, .5 ist mittel und .8 ist groß. Diese Werte sollten allerdings auch nicht blind angewandt werden. Man kann jede ANOVA auch als Korrelation berechnen, wie auch aus dem General Linear Model hervorgeht. R² ergibt sich in der multiplen Regression aus der Division der Summe der Quadrate durch die Total-Summe der Quadrate. Dieser Effekt sagt aus, welcher Prozentanteil der Variabilität der individuellen Differenzen durch die Prädiktorvariablen erklärt bzw. vorausgesagt werden kann. In der ANOVA ist der analoge Effekt-Messwert eta² (η²) und ergibt sich aus der Division der Summe der Quadrate between durch die Summe der Quadrate Total. Da jede Stichprobe im Prinzip irreproduzierbaren Charakter hat (jeder Mensch ist anders…), wird mit allen GLM-Analysen (ANOVA, Regression…) der wahre Populationseffekt überschätzt, da diese Variabilität in den gemessenen Effekt mit einfließt. Bei der Berechnung gibt es drei Design-Faktoren, welche eine größere Fehlervarianz hervorrufen: Kleine Studien haben einen größeren Messfehler, mehr gemessene Variablen haben einen größeren Messfehler und der Messfehler ist auch größer, wenn der Populationseffekt kleiner ist. Da wir den wahren Populations Varianz-gemessen-für-Effektstärke –Wert wissen, wird nämlich immer der gemessene Effekt als der geschätzte Populationseffekt in den Korrigierungen verwendet. Man kann die Effektwerte auch ineinander transponieren (umrechnen), wobei zu beachten ist, dass die Standardisierten Differenzen nicht quadriert sind, die variance-accounted-for Effektstärken aber Quadriert-metrisch sind. Zur Umrechnung gibt es entsprechende Formeln. Z.B. Eine Korrigierte, standardisierte Differenz (d*) kann berechnet werden, indem man d in r umwandelt und das r quadriert. r² wird mit der Messfehler-Varianz-Korrigierformel korrigiert und in r* zurückgewandelt und dann in d* zurückgewandelt. Die standardisierte Differenz ist kleiner, da der originale Effektstärkenwert vom Messfehler bereinigt wurde. So ein Wert ist zwar konservativer aber dafür leichter replizierbar (und natürlich genauer!). Zu den Effektstärken empfiehlt die Task Force (APA) auch den Bericht von Konfidenzintervallen. Diskussion p-Werte reichen also nicht aus um eine Studie zu berichten. Wir benötigen dazu die Effektstärke, um den Einfluss der Stichprobengröße zu berücksichtigen. Außerdem müssen die Effekt-Indizes den typischen Effekt und einen Bereich klinischer Effekte für alle Studien bezeichnen. Effektstärken sind nützlich um Voraussagen aufgrund vorliegender Befunde aus älteren Studien zu treffen und um aktuelle Studien zu interpretieren. Dazu kommt, dass die Replizierbarkeit dadurch besser beurteilt werden kann. Klinische Signifikanz hängt mit dieser Praktischen Signifikanz zusammen. Sie beruht aber auch auf einer gewissen Subjektivität. 9