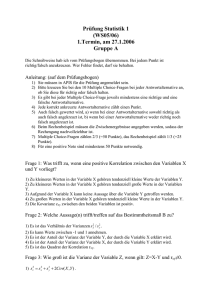

QMAxy_hm_2004

Werbung

I.

Skalenniveaus

Nominalskala:

Gleichheit / Ungleichheit (ja/nein)

Ordinalskala:

Gleichheit / Ungleichheit; größer / kleiner

Reihenfolge wichtig, d.h. nur streng monotone Transformation

Rangreihe:

Kleinster Messwert:1 usw.

Gleiche Messwerte: Durchschnitte der Plätze, die sie belegen würden

Intervallskala:

Unterschied zweier Messwerte

nur positiv lineare Transformationen

ordered metric:

>, <, = (z.B. Klausurpunkte)

Rational-/ Verhältnisskala:

Ursprung = Nullpunkt (z.B. Länge)

nur positiv lineare Transformationen

Absolutskala:

Keine Transformationen möglich (z.B. Kinderzahl)

Man unterscheidet stetige (kontinuierliche) und diskrete (diskontinuierliche) Skalenniveaus.

II.

Darstellen

1. Häufigkeitsverteilung

- Kategorienzahl k:

k 1 ln n

-

Intervallbreite d:

Streubreite sb:

sb x max x min

sb

d

k

-

Intervallmitten: ganzzahlige Vielfachen von d (manchmal auch variabel)

Auszählen der Häufigkeiten

n < 9: jeder Messwert = eigene Kategorie

2. Abgeleitete Verteilungen

- relative Häufigkeit:

1

rf j p j

-

Prozentwertverteilung

Prozentwert:

f%

-

fj

n

100 rf

j

f % j 100 rf j

j

Summenverteilung

(Wie viele x haben einen Messwert der Obergrenze des Intervalls?)

j

cf j f l

l 1

-

Summenprozentwert

cf %

j

100 rcf

j

cf % j 100 rcf j

rcf j

cf j

n

(Welcher Prozentsatz der Messwerte ist der Obergrenze des Intervalls?)

Verteilung von rcf: empirische Verteilungsfunktion F(x)

3. Graphische Darstellung

- Histogramm:

Intervall = Balken mit Fläche = rel. Häufigkeit; Breite = Intervallbreite;

Höhe y:

y

rf j

dj

gleiche Intervallbreite: y-Achse beschreibt Häufigkeiten

nominalskaliert: Balken gleichbreit, Lücken zwischen den Balken

-

Kreisdiagramm

-

Häufigkeitspolygon:

beschreibt Stetigkeiten; Anfang = Ende = 0

Intervallmitten bzgl. Relative Häufigkeit / Intervallbreiten

gleiche Intervallbreite: y-Achse beschreibt Häufigkeiten

Sonderform: ausgegelichenes Häufigkeitspolygon (schwächt Ausreißer):

y neu

j

y j 1 y j y j 1

3

-

Summenprozentkurve:

Auftragen von cf%(j) an den Intervallenden beginnend bei 0

-

Maßfunktion:

diskrete Merkmale

senkrechte Linie mit Länge = rf(j)

2

Treppenfunktion:

diskrete Merkmale

waagrechte Linie, bis zum Beginn des nächsten Merkmals, mit Höhe = cf%(j)

-

4. Prozentränge und Fraktilpunkte

- Prozentrang:

P

cf %(u ) [cf %( o) cf %(u )] P

x (o) x(u )

x( P)

x( P) x(u ) [ x(o) x(u )]

x(u ) [ x (o) x (u )]

P cf %(u )

cf %( o) cf %(u )

P cf %(u )

cf %(o) cf %(u )

Besonderheiten:

Median: x(50%) = md

Quartilpunkte: x(25%) = q1

Dezilpunkte: x(10%) = d1

x(50%) = q2

x(20%) = d2

....

x(75%) = q3

x(90%) = d9

-

Bei wenigen Beobachtungen (n<9):

Intervallgrenzen = Mitte zweier Messwerte

Untergrenze des ersten Intervalls genausoweit wie Obergrenze des ersten;

Obergrenze des letzten Intervalls genau umgekehrt

Anwendung der Formeln

-

Daten als Rangreihen:

pr (rg )

III.

x( P) x(u )

x(o) x(u )

Fraktilpunkt:

-

-

x ( P ) x(u )

P cf %(u ) [cf %(o) cf %(u )]

100%

(rg 0,5)

n

Beschreiben

1. Maße der Lage

a) arithmetisches Mittel (m):

Rohdaten:

m

1 n

xi

n i 1

Häufigkeiten:

1 k

m f j xi

n j 1

Empfindlichkeit gegen Ausreißerwerte; Gegenmaßnahmen:

a) Trimmen: Weglassen einer festen Zahl der kleinsten und größten Werte

b) Winsorisieren: man erstezt den/die weggelassenen Wert(e) durch den/die

verbliebenen kleinsten/größten

3

b) Median (md):

Md = x(50%)

Rangreihe: md = mittlerer Wert bzw. Durchschnitt der beiden mittleren Werte

c) Modus (mo):

diskret: mo = häufigster Wert

stetig: mo = Wert mit der größten Häufigkeitsdichte y

mo x(u ) [ x(o) x(u )]

y j y j 1

2 y j y j 1 y j 1

Vergleich von m, md, mo:

Informationsausnutzung: m>md>mo

Einfluss von Ausreißern: mo,md>m

mo: nominal; mo, md: ordinal; mo, md, m: ab intervall

d) mid-range (mr):

Mitte zwischen x(min) und x(max)

e) geometrisches Mittel (g):

bei multiplikativen Größen:

Rohdaten:

1

n

g ( xi ) n

i 1

Häufigkeiten:

1

k

g ( x j j ) n

f

j 1

f)

harmonisches Mittel (hm):

Mittelung von Größen (nur Rationalskalen)

Rohdaten:

hm

n

n

1

x

i 1

i

Häufigkeiten:

hm

n

k

f

j 1

j

1

xj

2. Maße der Variabilität (Dispersion)

a) Varianz s2:

s2 beschreibt die Abweichung von m, d.h. Unterschiedlichkeit der Messwerte; sie ist

unabhängig von der Anzahl der Messwerte

4

Rohwerte:

1 n

s 2 ( xi2 ) m 2

n i 1

Häufigkeiten:

1 k

s 2 ( f j x 2j ) m 2

n j 1

b) Varianzschätzer ^2:

Varianz der Grundgesamtheit, aus der die Stichprobe stammt

s2

n

1

( x i m) 2

n 1 i 1

c) Standardabweichung s:

statistische Maßeinheit für die Beurteilung von Unterschieden

sx s 2

d) Standardwerte:

Abweichung eines Messwerts vom Mittelwert, ausgedrückt in Vielfachen von s

zi

xi m x

sx

mz 0;

sz 1

Verschiedene Verteilungen werden vergleichbar

meist weitere Umwandlung in Skalenwerte (z.B. T-Norm)

e) Variationskoeffizient:

Wie aussagekräftig ist m?

relativiert s am Mittelwert

macht verschiedene Variabilitäten vergleichbar

v

f)

s

m

Durchschnittsabweichung (selten):

Rohdaten:

ad

1 n

| xi md |

n i 1

Häufigkeiten:

ad

1 k

f j | x j md |

n j 1

g) Variabilität (Diversität) bei nominalskalierten Merkmalen:

„Informationsmaß h“: h beschreibt die durchschnittliche Fragenzahl, die benötigt wird,

um Kategorie zu raten

1 k

h

p j ln p j

ln 2 j 1

5

3. Maße der Schiefe (ab intervallskaliert)

Stärke der Abweichung von der Symmetrie = Schiefe

a) Quartilsschiefekoeffizient (grobes Maß):

sq 25%

(q3 md ) (md q1)

q3 q1

b) Momentenkoeffizient:

Rohdaten:

g1

1 n 3

zi

n i 1

Häufigkeiten:

1 k

g1 f j z 3j

n j 1

4. Maße für den Exzess

Abweichung von Normalverteilung mit s als Maßeinheit

Momentenkoeffizient

Rohdaten:

g2

1 n 4

zi 3

n i 1

Häufigkeiten:

g2

1 k

f j z 4j 3

n j 1

g > 0: Verteilung spitzer als Normalverteilung

g = 0: Normalverteilung

g < 0: Verteilung flacher als Normalverteilung

5. Momente einer Verteilung:

a) Momente:

m1`'

1 n 1

xi

n i 1

m2'

1 n 2

xi

n i 1

usw...

b) Zentrale Momente:

6

m1

1 n

1

xi m

n i 1

m2

1 n

2

xi m

n i 1

usw...

g1

g2

m3

m2

3

m4

3

m22

Verteilungen, die in all ihren Momenten übereinstimmen, sind gleich!

6. Graphische Darstellung von Maßzahlen

Box-Plots / Box-and-Whiskers-Darstellung

Ausreißer

X(95%)

q3

m

q2

q1

X(5%)

Ausreißer

Ausreißer

<x(1%) bzw. > x(99%)

IV.

Zusammenhang

uV:Prädiktor, aV: Kriterium

7

1.

Bivariate Häufigkeitsverteilung

Kontingenztafel

Reihen r werden mit i bezeichnet

Spalten c werden mit j bezeichnet

Häufigkeit in Zeile i, Spalte j: n(ij)

Randsumme/ Zeile: n(i.)

Randsumme/ Spalte: n(.j)

Gesamtsumme: n(..) = n

graphische Darstellung als Säulendiagramm

2.

Zusammenhang und Vorhersage bei intervallskalierter aV

zu jedem x soll ein ^y geschätzt werden, der das wahre y möglichst gut repräsentiert

Durchschnitt der Schätzwerte = Durchschnitt der wahren y-Werte

a) Zerlegung der Abweichungsquadratsumme:

n

SS total ( y i m y ) 2

i 1

n

SS Fehler ( y i yˆ i ) 2

i 1

n

SS aufgeklärt ( yˆ i m y ) 2

i 1

SS total SS Fehler SS aufgeklärt

b) Determinationskoeffizient:

0 SS aufgeklärt SS total

2

Y .X

r

SS aufgeklärt

SS total

s y2ˆ

s y2

Der Determinationskoeffizient beschreibt den Anteil an aufgeklärter Variation (Was

kann durch X erklärt werden?); d.h. den Anteil der durch die Schätzwerte erklärten

Varianz

Fehleranteil:

1 rY2. X

Unaufgeklärte Varianz:

sY2| X s y2 (1 rY2. X )

sY | X s y *

y* y yˆ

8

Standardschätzfehler:

sY | X sY2| X

Gibt es keine Einzelwerte, schätzt man nach Mittelwerten

c) Das ²-Verhältnis (uV: nominalskaliert)

man schätzt mit dem Kategorienmittelwert m(j)

n(j): Anzahl der aV in Kategorie x(j)

² entspricht r²

n m

k

Y2. X

j 1

j

my

2

j

n s y2

Bei intervallskalierter uV muss diese erst in Kategorien eingeteilt werden; so sind

sowohl ²(Y.X) als auch ²(X.Y) zu berechnen.

3.

Lineare Regression und Korrelation

X, Y sind mindestens intervallskaliert

Regressionsgleichung = lineare Gleichung zur Schätzung von y aus x

a) Herleitung und Berechnung:

yˆ i a o a1 x

a1 r

sx

sy

a 0 m y a1 m x

r

s xy

sx s y

r rY2. X

s xy

1 n

( xi y i ) m x m y

n i 1

r heißt linearer Korrelationskoeffizient

s(xy) = Kovarianz; Wie gut ist y aus x schätzbar? Sie beschreibt die Richtung der

Steigung

s xx s x2

Bei Standardwerten:

zˆ yi r z xi

9

b) Eigenschaften und Interpretation des linearen Korrelationskoeffizienten

- invariant gegenüber pos. Iin. Transformationen

- Rohwert- und Standardwert-Korrelationen sind gleich

rxy ryˆy

-

-

r bzw. r² als Gütemaß der linearen Schätzgleichung

r liegt zwischen (-1) und (1)

-

r < 0,3

0,3 < r < 0,5

0,5 < r < 0,7

o,7 < r

unwesentlich

niedrige Korrelation

mittlere Korrelation

hohe Korrelation

Bei linearer Korrelation gilt:

rxy ryx

c) Die beiden Regresionsgeraden

Schätzung von x aus y

xˆ i b0 b1 y1

b1 r

sx

sy

b0 m x b1 m y

a1 b1 r ²

Schnittpunkt ist [m(x) / m(y)]

je höher die Korrelation, desto kleiner ist der Winkel zwischen den Geraden:

r =1 = 0°

r = 0 = 90°

d) Regression und Korrelation bei Standardwerten

zˆ yi r z xi

zˆ xi r z yi

Schnittpunkt der Geraden im Nullpunkt

Steigung: jeweils r

geschätzte Werte sind stets kleiner als ihre Ausgangswerte, d.h. sie liegen näher an

ihrem Mittelpunkt als diese an ihrem (Regression auf den Mittelwert).

e) Sonderfälle

- Punkt-biseriale Korrelation:

X: kann nur zwei Werte annehmen; Y: intervallskaliert

r heißt hier r(pbi); er bezeichnet die Richtung des Zusammenhang

2

rpbi

Y2: X

yˆ i mo (m1 m0 ) xi

10

-

Punkt-Vierfelder-Korrelation

X, Y: können je nur zwei Werte annehmen

r heißt hier r()

Y

X

0

1

0 1

r

a b

c d

ad bc

(a b) (c d ) (a c) (b d )

r() wird maximal, wenn a*d maximal und b*c minimal

r() wird minimal, wenn a*d minimal und b*c maximal

r() = 1, wenn a+b = a+c

r() = (-1), wenn a+b = b+d

nur wenn alle Randsummen gleich sind, kann r() sowohl (-1) als auch (1)

einnehmen

a kann nicht größer werden als die kleinere der beiden Randsummen a+b oder

a+c

d kann nicht ... Randsummen c+d oder b+d

um verschiedene Vierfeldertafeln zu vergleichen, berechnet man den

Assoziationskoeffizienten:

C XY

C XY

f)

r

, wenn r 0

rmax

r

rmn

, wenn r 0

-

Spearmansche Rangkorrelationskoeffizienten

X,Y als Rangreihen

r heißt hier r(s)

-

Autokorrelation

zur Untersuchung von zeitlichen Verläufen, Perioden (Zeitreihenanalyse)

Man schreibt die Messreihen zeitversetzt nebeneinander; in der ersten Reihe fällt

die letzte Beobachtung weg, in der 2. Fehlt die erste

Berechnung von r zwischen den beiden (künstlichen) Messreihen

wegen Verschiebung um einen Wert: lag(1)

Summen und Differenzen

- 2 Merkmale X(1), X(2)

Mittelwerte:

m1 2 m1 m2

m1 2 m1 m2

11

Varianzen:

s12 2 s12 s 22 2 s12

s122 s12 s 22 2 s12

je größer r(12), desto größer s²(1+2), desto kleiner s²(1-2)

Bei Standardwerten:

m1 2 m12 0

s12 2 2 (1 r12 )

s122 2 (1 r12 )

s12 s1 s 2 r12

-

4 Merkmale X(1), X(2), X(3), X(4)

Kovarianzen und Korrelationen

Y1 X 1 X 2

Y2 X 3 X 4

Varianz :

s y21 s12 s 22 2 s12

s y22 s32 s 42 2 s34

Ko var ianz :

sY1Y2 s13 s14 s 23 s 24

Korrelatio nskoeffizient :

sY1Y2

rY1Y2

sY21 sY22

S tan dardwerte :

rY1Y2

r13 r14 r23 r24

2 (1 r12 ) (1 r34 )

Kovarianzen lassen sich wie Klammern auflösen

g) Testtheorie

Test mit X(1)bisX(p) Fragen, je 1/0 wählbar

-

Testwert (wie oft „1“ als Antwort):

p

y i xij

j 1

12

-

Eigenschaften von Testaufgaben

Schwierigkeit: Wie viele Personen haben die Aufgabe lösen können?

( Aufgabenmittelwert)

mj

1 n

xij

n i 1

Trennschärfe: Wie gut trennt die Aufgabe Leute mit hohem y von denen mit

niedrigem?

( Korrelationskoeffizient zwischen Aufgabenbeantwortung und

Gesamtwert)

rit ( X j ) rX jY

Da aber die untersuchte Aufgabe im Gesamttestwert ebenfalls mit

einberechnet ist, errechnet man die part-whole-korrigierte

Trennschärfe:

ri ,t i ( X j ) rX j ,Y X j

-

( rit )

Eigenschaften des Gesamttestwerts:

Reliabilität (=Zuverlässigkeit): Wie präzise misst der Test?

(1) Retest-Reliabilität: Korrelation zwei verschiedener Testdurchgänge zu

unterschiedlichen Zeitpunkten

rtt rY1Y2

(2) Innere Konsistenz: Man bildet zwei Testhälften (meist gerade-ungerade

Fragennummer)

r12 rH1H 2

rtt

2 r12

( Spearman)

1 r12

Sind die Standardabweichungen der Testhälften sehr unterschiedlich,

verwendet man diese Formel:

rtt

4 s1 s 2 r12

( Flanagan)

s s 22 2s1 s 2 r12

2

1

Validität (= Gültigkeit): Wie gut misst der Test die Eigenschaft, die er messen

soll?

Korrelation zwischen eigenem und Experten-Ranking

13

4.

Erweiterung des linearen Ansatzes

a) Partielle Korrelation

- 3 Merkmale: X(1) und X(2)

X(3) beeinflusst deren Korrelation

X(1) lässt sich aus X(3) schätzen, X(2) lässt sich aus X(3) schätzen

Anteil von X(1), der sich nicht durch X(3) schätzen lässt:

xi*1 xi1 xˆ i1

x*(1) und x*(2) sind nun von X(3) „bereinigt“

Berechnung des von X3 breinigten Zusammenhangs zwischen X1 und X2:

rX * X * r12.3

1

2

r12 r13 r23

(1 r132 ) (1 r232 )

r12max r13 r23 (1 r132 ) (1 r232 )

r12min r13 r23 (1 r132 ) (1 r232 )

Bei Standardwerten: z*(1) und z*(2) sind keine Standardwerte mehr!

-

4 Merkmale: X(1) und X(2)

X(3), X(4) beeinflussen deren Korrelation

Auspartialisieren von X(4) Berechnung von r(12.4), r(13.4), r(23.4)

Auspartialisieren von X(3)

r12.34

-

r12.4 r13.4 r23.4

(1 r132 .4 ) (1 r232 .4 )

Semipartialkorrelationen: X(3) wird nur aus X(2), nicht aber aus X(1) auspartialisiert

r1( 2.3)

r12 r13 r23

1 r232

b) Multiple Regression und Korrelation

Aus den Prädiktoren X(1), X(2), ..., X(p) soll Y geschätzt werden

multipler linearer Ansatz:

yˆ i a 0 ai xi1 a 2 xi 2 ... a p xip

(i bezeichnet die Vp-Nummer)

-

Regressionskoeffizient

Standardwert-Regressionsgleichung:

zˆYi b1 z i1 b2 z i 2 ... b p z ip

Rohwert-Regressionskoeffizienten:

a j bj

sy

sj

a 0 mY (a1 m1 a 2 m2 ... a p m p )

14

Berechnung von b(j) für p>2 benötigt technische Hilfe

p2

-

b1

r1Y r12 r2Y

1 r122

b2

r2Y r12 r1Y

1 r122

Multiple Bestimmtheit und multiple Korrelation

Güte der multiplen Schätzgleichung (= Anteil aufgeklärter Varianz)

2

Y .12... p

R

s y2ˆ

s y2

p

b j r jY rYˆ2Y

j 1

Multiple Korrelation:

RY2.12... p RY2.12... p

-

Interpretation der multiplen Bestimmtheit und der multiplen Regressionskoeffizienten

RY2.12... p riymax

wenn keine Korrelation der Prädiktoren vorliegt, dann sind alle b(j) gleich r(jy); hier ist

R²(Y.12...p) interpretierbar

Kollinearität bzw. Multikollinearität: Prädiktoren korrelieren sehr hoch miteinander

Suppressionseffekt: X(1) korreliert niedrig mit Y, mit dem X(2) nicht korreliert; X(2)

korreliert hoch mit X(1)

Dennoch wird X(2) in die Regressionsgleichung einbezogen, da

es den Teil von X(1) auspartialisiert, auf den es Einfluss hat

-

Spezielle Anwendung multipler Regression

Nichtlineale/ Polynomiale Regression

yˆ i a 0 a1 xi a 2 xi2 ... a m xim

Umwandlung in multiple lineare Gleichung:

xi xi1

xi2 x12

Allgemein lineares Modell

(1) Ein 3-kategoriales Merkmal Y kann durch zwei 2-kategoriale Merkmale D(1), D(2),

D(3) ausgedrückt werden.

(2) D(1): Gehört x zu Kategorie 1 (D(1) = 1) oder nicht (D(1) = 0)?

D(2): Gehört x zu Kategorie 2 oder nicht?

D(3): D(1) = 0, D(2) = 0

sog. Dummy-Kodierung

(3) Um y aus D(1) und D(2) zu schätzen, kann statt ² auch R² berechnet werden (²

= R²)

(4) Es gilt:

a0 mD3

a1 mD1 mD2

a 2 mD2 mD3

15

rYX2 max RY2.12... p Y2. X

-

Faktorenanalyse:

nicht beobachtbare Faktoren sollen eine Reihe von beobachteten Variablen erklären;

Ziel ist, dass möglichst wenig Faktoren möglichst viel Varianz aufklären und die

beobachteten Korrelationen möglichst gut reproduzieren

für jede Variable wird eine multiple Regressionsgleichung aufgestellt (uV: unbekannte

Prädiktoren, aV: beobachtete Variable)

n Vpn mit Nr.i

m Variablen mit Nr. j

p Faktoren mit Nr. l

Standardwerte sollen durch unbekannte Prädiktoren verhergesagt werden:

zˆij a j1 f i1 a j 2 f i 2 ... a jl f il ... a jp f ip

f ip : Pr ädiktor

a jl : Faktorenladung Korrelatio n zwischen Faktoren und Variablen

wichtig: Prädiktoren müssen voneinander unabhängig sein, weil nur dann ihr

Regressionskoeffizient gleich der Korrelation zwischen Prädiktor und Kriterium ist

Die multiplen Korrelationen zwischen den Faktoren und den beobachtbaren Variablen

lassen sich ausrechnen, wenn a bekannt ist:

RZ2 j .1, 2,.., p a 2j1 a 2j 2 ... a 2jp

RZ2 j .1, 2,.., p h 2j ( Kommunalität )

h² beschreibt den Anteil der Variable Nr.j, der durch die Faktoren aufgeklärt wird

Varianz, die durch den Faktor l aufgeklärt wird:

2

sl2 a12l a 22l ... a ml

sl2

Varianzant eil :

m

(Bei Standardwerten sind Varianzanteile und Varianzen gleich)

Die erklärte Kovarianz der Variablen j und k ist die Kovarianz zwischen den

geschätzten Werten dieser Variablen

s Zˆ Zˆ a j1 ak1 a j 2 ak 2 ... a jp akp

j

5.

k

Zusammenhang bei ordinalskalierten Merkmalen

Beschreibung des monotonen Zusammenhangs durch den Kendall`schen

Rangkorrelationskoeffizienten r(T). Er verwendet nur Anordnungseigenschaften (>, <) der

Daten und entspricht dem Goodman-Kruskal-Maß r().

a)

-

Herleitung

Messwertpaare werden nach aufsteigendem x geordnet (Ankerreihe)

Die zugeordneten y-Werte bilden eine Vergleichsreihe

Vergleich jedes y mit den anderen: wie gut sind sie geordnet?

(r) = aufsteigend geordnet = Proversion (P)

16

-

(f) = absteigend geordnet = Inversion (I)

getrennte Auszählung von P und I

insgesamt P+I Vergleiche

P>I: pos. Zusammenhang

P<I: neg. Zusammenhang

S = P-I (Kendall-Summe) > 0, wenn P>I, < 0, wenn P<I

S wird an P+I relativiert:

r

-

PI

(Goodman Kruskal Koeffizient )

PI

r() beschreibt nur ein relatives Überwiegen von entweder Pro- oder Inversionen;

invariant gegen pos. lin. Transformationen

Es geht auch anders:

n(n 1)

2

2( P I )

rT

n(n 1)

PI

r(T) und r() sind gleich, wenn keine Bindungen vorhanden sind

r(T), r() sind symmetrisch, d.h. r(YX) = r(XY)

b) Berechnung bei Rangbindungen

- bei einem Merkmal

Ordnen nach der Variablen ohne Bindung

Auszählen von P und I, wobei Gleichheitsbeziehungen weggelassen werden

jetzt ist P+1 nicht mehr durch ½ n (n-1) ersetzbar, da ein bindungskorrigierter Wert

verwendet werden muss

rT r

-

bei beiden Merkmalen

Ordnen nach einer Variablen (1)

Innerhalb von gleicher Werte von (1) werden keine Vergleiche vollzogen

Es gilt:

(1) gleiche Y-Werte können nicht miteinander verglichen werden

(2) Y-Werte, die zum gleichen X-Wert gehören, können nicht miteinander verglichen

werden

c) Berechnung aus einer geordneten Kontingenztafel

- Anordnen in 2-dimensionaler Häufigkeitstabelle

- Zu jedem Messwertpaar sucht man

die Summe s der Häufigkeiten bei größerem X und größerem Y

Häufigkeit Messwertpaar * S = Proversionen

die Summe T der Häufigkiten bei kleinerem Y, aber größerem X

Häufigkeit Messwertpaar * T = Inversionen

- Summieren aller Pro- und Inversionen

17

d) Spezialfall: geordnete 4-Felder-Tafel

Y

X

1

2

1

2

n11

n 21

n12

n22

r

n11 n22 n12 n21

n11 n22 n12 n21

Yule ' scher Q Koeffizient

Entspricht nicht r() wegen dessen Stichprobenabhängigkeit

6.

Zusammenhang bei nominalskalierten Merkmalen

a) Transinformationsquotienten

gemeinsame Info von X und Y

hY . X

Informationsmaß für Y

Häufigkeitstabelle mit relativen Häufigkeiten p:

r

hx pi. ldp i.

i 1

r

h y p. j ldp . j

i 1

hY . X

h y hx hxy

hy

h entspricht dem Determinationskoeffizienten

b) Der symmetrische Transinformationsquotient

lineare Abhängigkeit: r(Y.X) = r(X.Y)

bei quadratischen Tafeln: h(Y.X) = h(X.Y) = h(XY)

durchschnittlich aufklärbarer Informationsanteil:

h( XY )

2 (hx h y hxy )

hx h y

IV. Ereignisse

1. Ereignisräume

: Ereignisraum: Menge aller möglichen Ausgänge eines Experiments

(=Elementarereignisse); man unterscheidet abzählbare und nicht abzählbare (=stetige)

18

2. Ereignisse als Mengen

Ereignisse bestehen aus mehreren Elementarereignissen (z.B. König beim Kartenspiel

()) oder sind selbst Elementarereignis (z.B. -König)

= sicheres Ereignis

= unmögliches Ereignis

3. Rechnen mit Ereignisse

- Ereignisse: Großbuchstaben, Elementarereignisse: Kleinbuchstaben

- Unterscheidung: Ereignis a Ereignis {a} a {a}

- Zahl der Ereignisse eine Ereignisraums: Potenzmenge P() bzw. Ereignisfamilien in

einem Ereignis A

a) Operationen mit einem Ereignis

Komplement von

EE

ABB A

AA

b) Operationen mit zwei Ereignissen

- Durchschnitt: AB („sowohl A als auch B“)

disjunktes Ereignis: AB=

AA = A

A= A

A=

A A

-

Vereinigung: AB („entweder A oder B oder beide“)

AA = A

A=

A= A

A A

-

Nachsichziehen: AB

Ist AB= A, so „zieht A B nach sich“: AB

Gibt es mdst. ein Elementarereignis in B, das nicht zu A gehört, gilt AB

-

Partition/ Zerlegung von

Es gilt:

E(i) E(j) =; ij

19

E(1) E(2) ... E(k) =

c) Verallgemeinerung auf mehr als zwei Ereignisse

- Durchschnitt: „alle Elemente seien gleichzeitig eingetroffen“

k

D E1 E 2 ... E k E j

j 1

-

Vereinigung: „mindestens eines der Ereignisse sei eingetroffen“

k

V E1 E 2 ... E k E j

j 1

d) Ereignisalgebra

= {A, B, C}

-

Identitätsgesetze:

A= A

A=

A=

A= A

-

Komplement-Gesetze:

A A

A A

AA

-

Idempotenz-Gesetze:

AA=A

AA=A

-

Kommutativ-Gesetze:

AB = BA

AB=BA

-

Assoziativ-Gesetze:

(AB)C = A(BC)

(AB)C = A(BC)

-

Distributiv-Gesetze:

A(BC) = (AB)(AC)

A(BC) = (AB)(AC)

-

De Morgan’s Gesetze:

A B A B

( A B) A B

20

4. Definition der Wahrscheinlichkeit

a) Laplace-Wahrscheinlichkeit

jedes Elementarereignis hat dieselbe Wahrscheinlichkeit W(E)

W (E)

n( E )

n()

b) axiomatische Definition (Kolmogroff)

(1) W(A) O

(2) W() = 1

(3) W(A1A2...) = W(A1) + W(A2)+...

[A(i)A(j) = ]

5. Kombinatorik

a) Grundregel

Zwei unabhängige Ereignisse E1 und E2 können auf n1 bzw. n2 Möglichkeiten zustande

kommen es gibt n1*n2 Ereigniskombinationen

b) Variationsproblem

Ziehen mit Zurücklegen, mit Anordnung

V nk

n k

c) Permutationsproblem

Ziehen ohne Zurücklegen, mit Anordnung

n

Pk

n!

(n k )!

d) Kombinationsproblem I

Ziehen ohne Zurücklegen, ohne Anordnung

n

n

C k ( Binomialko effizient )

k

(weil Reihenfolge egal, ist (1/2) = (2/1))

mehrere Zerlegungen von n

n n1 n2 ... n p 1

n n n1

...

np

n1 n2

Multinomia lkoeffizient :

n

n!

n1!n2 !... n p ! n1 , n2 ,..., n p

e) Kombinationsproblem II

Ziehen mit Zurücklegen, ohne Anordnung

n k 1 (n k 1)!

Wk

k

k!(n k )!

n

21

VI. Wahrscheinlichkeit

1. Einfache Sätze über Wahrscheinlichkeiten

a) Der Satz vom Komplement

W ( A ) 1 W ( A)

W () 0

b) Der Additionssatz

W ( A B) W ( A) W ( B) W ( A B)

W ( A B C ) W ( A) W ( B) W (C ) W ( A B) W ( A C ) W ( B C ) W ( A B C )

c) Der Partitionssatz

Bilden k Ereignisse eine Partition von , ist die Summe ihrer Wahrscheinlichkeiten 1.

k

W ( E1 ) W ( E2 ) ... W ( Ek ) W ( E j ) 1

j 1

2. Bedingte Wahrscheinlichkeit

Wahrscheinlichkeit für A, wenn B bereits eingetroffen ist oder sicher eintreffen wird

[=W(A|B)]

W ( A B)

W ( B)

W ( A | B) W ( B | A), außer : W ( A) W ( B)

W ( A B C)

W ( A | B C)

W (B C)

W ( A | B)

Es gelten alle Regeln, z.B. Additionssatz:

W ( A B | C) W ( A | C) W (B | C) W ( A B | C)

3. Der Multiplikationssatz

W ( A B) W ( B) W ( A | B)

W ( A B) W ( A) W ( B | A)

W ( A B C ) W ( A) W ( B | A) W (C | A B)

verdeutlicht im Baum-Diagramm

4. Totale Wahrscheinlichkeit

A setzt sich aus den fünf Ereignissen aus zusammen:

W ( A) W ( E1 A) W ( E 2 A) ... W ( E5 A)

k

k

j 1

j 1

W ( A) W ( E j A) W ( E j ) W ( A | E j )

22

-Maß von Goodman&Kruskal

-

Häufigkeitstafel: Zu welcher Y-Kategorie gehört eine Beobachtung, wobei man nicht

weiß, welche X-Kategorie (X,Y: nominalskaliert)

Man nimmt die y-Kategorie mit höchstem p

Wahrscheinlichkeit für Fehler: 1-p(.j)max = WFU(x)

Ist die x-Kategorie bekannt, wählt man in dieser die Kategorie j von Y, für die p(ij) in

Zeile i am größten ist: p(ij)max

Richtigwahrscheinlichkeit (für Raten von y bei bekanntem x):

pijmax

pi .

-

pijmax( j )

r

W (Yrichtig | Xgegeben) pi.

pi.

i 1

r

pijmax( j )

i 1

r

Fehlerwahrscheinlich keit : 1 pijmax( j ) WFK ( x)

i 1

r

Y . X

WFU ( x) WFK ( x)

WFU ( x)

p

i 1

max( j )

.j

j)

1 p.max(

j

c

X .Y

-

WFU ( y ) WFK ( y )

WFU ( y )

j)

p.max(

j

p

i 1

max( i )

ij

i)

pimax(

.

i)

1 pimax(

.

ist gerichteter Determinationskoeffizient

aus Häufigkeiten:

r

Y . X

n

i 1

max( j )

ij

j)

n n.max(

j

c

X .Y

j)

n.max(

j

n

j 1

max( i )

ij

i)

nimax(

.

i)

n nímax(

.

5. Satz von Bayes

W (D S )

W (S )

W ( D S ) W ( S | D) W ( D)

W (D | S )

W ( S ) W ( D S ) W ( D S ) W ( D) W ( S | D) W ( D ) W ( S | D )

W ( D) W ( S | D)

W (D | S )

( Satz)

W ( D) W ( S | D) W ( D ) W ( S | D )

23

D=Diagnose, S=Bauchschmerzen

W ( S | D) Sensitivität

W ( S | D ) Spezifität

W ( D) Pr ävalenz

mehr Diagnosen:

W (D j | S )

W ( D j ) W (S | D j )

k

W ( D ) W ( S | D )

i 1

i

i

Prävalenzen heißen a-priori-Wahrscheinlichkeiten

aufgrund eines Befunds berechnete p heißen a-posteri-Wahrscheinlichkeiten

Bedingte Wahrscheinlichkeiten für Auftreten eines Symptoms unter bestimmten

Bedingungen heißen Likelihoods

6. Unabhängigkeit von Ereignissen

Abhängigkeit bedeutet keine Kausalität!

W ( B | A) W ( B ), W ( A | B ) W ( A)

W ( A B) W ( A) W ( B )

W ( A B) W ( A) W ( B ) W ( A) W ( B )

paarweise Unabhängigkeit:

W ( E1 E 2 ) W ( E1 ) W ( E 2 )

W ( E 2 E3 ) W ( E 2 ) W ( E3 )

W ( E1 E3 ) W ( E1 ) W ( E3 )

aber : W ( E1 E 2 E3 ) W ( E1 ) W ( E 2 ) W ( E3 )

VII. Verteilungen

1. Zufallsvariable

Jedem Elementarereignis aus wird eine reelle Zahl zugeordnet; dieses X heißt

Zufallsvariable oder stochastische Variable

2. Wahrscheinlichkeitsverteilungen

= Menge der den Elementarereignissen aus zugeordneten Wahrscheinlichkeiten

24

3. Diskrete Zufallsvariable

Die Zufallsvariable X kann nur eine endliche oder abzählbar unendliche Anzahl von Werten

annehmen.

W ( X xi ) 0

k

W ( X x ) 1

i

i 1

W ( a X b)

W ( X x)

a X b

W ( X a)

W ( X x)

X a

W ( X a ) W ( X x)

xa

Grafische Darstellung durch Maßfunktion

Formelschreibweise

1

für x 1,2,..., k

W ( X x) k

0 sonst .

4. Stetige Zufallsvariable

- Der Ereignisraum kann jede reelle Zahl annehmen; es gilt:

W ( X u) W ( X v), wenn W (u X v) 0

-

X kann nicht genau einen Wert annehmen, sondern man betrachtet Intervalle: W(a<X<b)

so sucht man für die Wahrscheinlichkeit nicht einen bestimmten Wert, sondern betrachtet

die Wahrscheinlichkeitsdichte f(x) von X an der Stelle x

-

Wahrscheinlichkeiten für Intervalle werden durch die Fläche unter der Kurve der

Wahrscheinlichkeitsdichtefunktion zwischen den Intervallgrenzen a und b repräsentiert:

Zerlegung dieser Fläche in Breitstreifen der Länge dx

Fläche eines Balkens = f(x)*dx

Summe all dieser Flächen zwischen a und b ist W(a < X < b)

b

W (a X b) f ( x) dx

a

es ist egal, ob Intervalle offen oder geschlossen sind

-

Es gilt:

f ( x) 0 für alle x

f ( x) dx 1

25

5. Verteilungsfunktionen

Für beide gilt die kumulative Verteilungsfunktion (^= rel. Summenhäufigkeitsverteilung):

F(x) = W(X<x)

a) Es gilt:

0 F ( x) 1

Ist a b, ist F (a ) F (b)

F () 1, F () 0

b) X diskret:

F ( x0 ) W ( X x0 )

W ( X x) Treppenfunktion

x x0

c) X stetig:

F ( x0 ) W ( X x0 )

x0

f ( x) dx stetigeVerteilungsfunktion

F ( x) f ( x)

Dichtefunktion als Steigung von F(x)

d) Sonstiges:

W (a X b) F (b) F (a)

Median x50% F ( ) 0,5

xp

Fraktilpunkte( stetig ) :

f ( x) dx p

6. Erwartunsgwerte

Theoretischer Mittelwert

a) Definition

- diskrete ZV:

E ( X ) x i W ( X xi )

xi

-

stetige ZV:

E( X )

x f ( x) dx

b) Erweiterte Definition

g(X) bezeichnet eine Funktion, z.B. (X-)²

- diskrete ZV:

E[ g ( X )] g ( xi ) W ( X xi )

xi

-

stetige ZV:

E[ g ( X )]

g ( x) f ( x) dx

26

c) Rechenregeln

a bezeichnet eine Konstante

(1) E(a)=a

(2) E(a*X)= a*E(X)

(3) E(a+X)=a+E(X)

(4) E(a0+a1X)=a0+a1*E(X)

(5) E(X+Y)=E(X)+E(Y)

n

n

j 1

i 1

E ( X 1 X 2 ... X n ) E ( X j ) E ( X i )

Y a 0 a1 X 1 a 2 X 2 ... a n X n

E (Y ) a 0 a1 E ( X 1 ) a 2 E ( X 2 ) ... a n E ( X n )

d) Varianz einer Zufallsvariablen

- Varianz: E[(X-)²]=²

2 E ( X ²) ²

Y a 0 a1 X y2 a12 x2

-

Standardabweichung:

²

-

Standardwerte:

Z

x

E (Z ) 0

z2 1

-

Verteilung mit endlicher Erwartung und endlicher Varianz: Chebyshev-Ungleichung

b : pos.Kons tan te W (| X | b)

2

b²

| X |

1

S tan dardwerte W

k

k²

Ungleichung zeigt, dass große Abweichungen vom Durchschnitt immer

unwahrscheinlich sind

-

Momente:

E(X²): 2. Moment

E(X-)²: 2. Zentrales Moment

3. Zentrales Moment: Schiefe

4. Zentrales Moment: Exzess

27

7. Mehrdimensionale Wahrscheinlichkeitsverteilungen

a) diskrete ZV:

- Bivariate Wahrscheinlichkeitsverteilung von X und Y

W(X=x, Y=y): X nimmt einen bestimmten Wert an und gleichzeitig nimmt Y einen

bestimmten Wert ein

- Bivariate Verteilungsfunktion

Wahrscheinlichkeit, dass X<x und gleichzeitig Y<y:

W ( X x0 , Y y0 ) Fxy ( x0 , y0 )

-

W ( X x, Y y)

x x0 y y0

Rand- oder Marginalwahrscheinlichkeiten

c

W ( X xi ) W ( X xi , Y y j )

j 1

r

W (Y y j ) W ( X xi , Y y j )

i 1

-

Bedingte Wahrscheinlichkeiten

W ( X x, Y y )

W (Y y )

W ( X x, Y y )

W (Y y | X x)

W ( X x)

W ( X x | Y y)

b) stetige ZV:

- Statt W(X=x, Y=y) werden bivariate Dichtefunktionen f(x,y) untersucht; f(x,y) stellt eine

Fläche im 3-dimensionalen Raum dar.

Untersuchung verbundener Intervalle:

d b

W (a X b; c Y d ) f ( x, y) dx dy

c a

-

Bivariate Verteilungsfunktion:

W ( X x0 , Y y 0 ) FXY ( x0 , y 0 )

x0 y0

f ( x, y) dx dy

W (a X b, c X d ) FXY (b, d ) FXY (a, c)

-

Randdichten:

f ( x)

f ( x, y ) d ( y )

f ( y)

f ( x, y ) d ( x )

-

Unabhängige Zufallsvariable:

f(x,y) = f(x)*f(y)

28

c) Verallgemeinerung auf mehr als zwei Variablen

- diskrete ZV:

Wahrscheinlichkeitsfunktion: Man muss für ein beliebiges Variablenpaar aus X1,

X2, ..., Xp W(X1=x1, X2=x2, ..., Xp=xp) über die verbleibenden p-2 Variablen

aufsummieren

Verteilungsfunktion:

... W ( X

x1 x01 x2 x02

-

x p x0 p

1

x1 , X 2 x2 ,..., X p x p )

stetige ZV:

Randdichte für eine der p Zufallsvariablen erhält man durch Integrieren der

gemeinsamen Dichte über die verbleibenden p-1 Zufallsvariablen

Verteilungsfunktion:

x01x02

x0 p

... f ( x , x ,..., x

1

2

p

) dx1 dx2 ... dx p

8. Unabhängigkeit von Zufallsvariablen

diskret : W ( X x, Y y ) W ( X x) W (Y y )

stetig : f ( x, y ) f ( x) f ( y )

W [( a X b), c Y d )] W (a X b) W (c Y d )

auf mehrere Variablen erweiterbar

Funktionen von X und Y sind unabhängig, wenn X und Y unabhängig sind

Die Verteilung von X ist dann unabhängig davon, an welcher Stelle in der Reihe die

Beobachtung steht.

9. Erwartungswerte bei bedingten und gemeinsamen Verteilungen

a) bedingte Erwartung

diskret : E ( X | Y ) x W ( x | y )

x

stetig : E ( X | Y )

x f ( x | y) dx

b) verbundene Variablen

diskret : E[ g ( X , Y )] g ( x, y ) W ( x, y )

x

y

stetig : E[ g ( X , Y )]

g ( x, y) f ( x, y) dx dy

c) Erwartungswerte von zweidimensionalen Momenten

- Unabhängigkeit:

E(X*Y)=E(X)*E(X) auch erweiterbar

29

-

Maß für die lineare Beziehung: Kovarianz

XY E[( X x ) (Y y )]

XY E ( X Y ) E ( X ) E (Y )

lin .Unabhängigkeit : XY 0

-

linearer Korrelationskoeffizient:

-

XY

X y

Summen und Differenzen

X2 Y X2 Y2 2 XY

X2 Y X2 Y2 2 XY

x2 x ... x 12 22 ... k2

1

2

k

30