Langzeitauswirkungen 1

Werbung

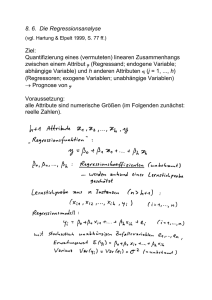

SS 2006 Langzeitauswirkungen von frühpädagogischen Betreuungen Statistische Auswertungsverfahren 1 Statistische Auswertungsverfahren Grundideen • Analyse von Gruppenunterschieden t-Test einfache und multiple Varianzanalyse Kovarianzanalyse • Analyse von Zusammenhängen Korrelation Regression hierarchische Regression 2 Gruppenunterschiede – t-Test Fragestellung • Werte von 2 Gruppen von Kindern in einer Variablen; z.B. von Mädchen (n1) und Jungen (n2) in einem Indikator des Sozialverhalten • Unterscheiden sich die beiden Gruppen signifikant, d.h. nicht nur zufällig, in dieser Variablen? • Das Merkmal Geschlecht, das die beiden Gruppen definiert, wird unabhängige Variable oder Faktor genannt. • Der Indikator des Sozialverhaltens, der evtl. vom Geschlecht abhängig ist, wird abhängige Variable genannt. 3 Gruppenunterschiede – t-Test Was heißt Unterschiede? 1. Unterschiede schlagen sich in den Mittelwerten und in den Streuungen nieder. Getestet werden Mittelwertunterschiede. 2. Stichprobenmittelwerte können sich auch zufällig unterscheiden. Gefragt ist aber, ob die Mittelwerte in den beiden Grundgesamtheiten (Populationsmittelwerte) sich unterscheiden. 3. Einladung zu einem Gedankenspiel: 4 Gruppenunterschiede – t-Test • Wir ziehen nicht nur 1 Stichprobe von Mädchen und 1 Stichprobe von Jungen aus den jeweiligen Populationen, sondern sehr viele Paare von Stichproben mit fixem n1 und n2. • Wir berechnen für jedes Paar die Mittelwertdifferenz. • Unter der Annahme, dass zwischen den Mittelwerten in den Populationen kein Unterschied besteht, folgt die Verteilung der Stichprobendifferenzen einer bestimmten Form t-Verteilung (ab n1 + n2 ≥ 30 oder 50 Normalverteilung). • Diese t-Verteilung ist abhängig von den Stichprobenumfängen (n1 + n2) – genauer von den Freiheitsgraden (n1 + n2 – 2). • Aus der t-Verteilung kann abgelesen werden, wie wahrscheinlich Mittelwertdifferenzen sind, die größer als die von uns gefundenen sind. • Voraussetzung ist bei „kleinen Stichproben“ (n1 + n2 ≥ 30 oder 50): Merkmal muss normalverteilt sein. 5 Gruppenunterschiede – t-Test 4. Vergleich der gefundenen Stichprobendifferenz mit tabellierten „kritischen“ Werten: Ist die gefundene Differenz größer als der tabellierte Wert, wird die Nullhypothese verworfen. Ist sie kleiner oder gleich, wird sie beibehalten. 5. Je nach gewünschtem „Sicherheitsniveau“ müssen andere kritische Werte betrachtet werden. Üblicherweise 5 %-, 1 %- oder 0,1 %Niveau, z.B. 5 %-Niveau: Ich akzeptiere, in weniger als 5 von 100 Fällen die Nullhypothese zu verwerfen, obwohl sie richtig ist. 6 Gruppenunterschiede – t-Test 6. Leider ist die Testgröße nicht die einfache Differenz zwischen den beiden Mittelwerten, sondern etwas komplizierter (das ist aber nur rechnen). x1 - x 2 t (n1 1)s1 (n2 - 1)s2 1 1 ( ) n1 n2 2 n1 n 2 2 2 7 Gruppenunterschiede – t-Test 7. Achtung: Je größer n1 und n2 sind, desto eher wird ein Mittelwertunterschied statistisch signifikant! Unterschied zwischen statistischer und praktischer Signifikanz. 8. t-Test für unabhängige Stichproben und t-Test für abhängige Stichproben 8 Gruppenunterschiede – einfache und multiple Varianzanalyse Einfache Varianzanalyse 1. Nicht mehr 2 Ausprägungen der unabhängigen Variablen, sondern mehrere; Beispiel: mütterlicher Bildungsabschluss in niedrig, mittel und hoch und der Einfluss auf das Sozialverhalten. 2. Frage nach dem Zusammenhang zwischen einer qualitativen und einer quantitativen Variablen. 3. Frage nach den Unterschieden ist wieder Frage nach den Mittelwertunterschieden in den Populationen. 9 Gruppenunterschiede – einfache und multiple Varianzanalyse 4. Formalisiert: • Nullhypothese H0: Alle Populationsmittelwerte sind gleich - μ1 = μ2 = μ3 • Alternativhypothese H1: Mindestens ein Mittelwert unterscheidet sich von den anderen. • Welche Hypothese ist bei einem festzulegenden Sicherheitsniveau wahrscheinlicher? 5. Grundidee: Wir setzen die Unterschiede zwischen den Gruppenmittelwerten in Beziehung zu den Unterschieden innerhalb der Gruppen. 10 Gruppenunterschiede – einfache und multiple Varianzanalyse Zwei Möglichkeiten: • Sind die Unterschiede zwischen den Gruppenmittelwerten klein im Verhältnis zu den Unterschieden innerhalb der Gruppen: Beibehalt von H0 = Ablehnung von Gruppenunterschieden • Sind die Unterschiede zwischen den Gruppenmittelwerten fast so groß wie die Unterschiede innerhalb der Gruppen: Ablehnung von H0 = Annahme von Gruppenunterschieden 11 Gruppenunterschiede – einfache und multiple Varianzanalyse 6. Formalisierung der Grundidee: Zerlegung der Messwerte in: xi x (xi xG ) (xG x) Es gilt dann (SAQ = Summe der Abweichungsquadrate): SAQtotal SAQwithin SAQbetween SAQs sind abhängig von den Fallzahlen Bildung mittlerer Abweichungsquadrate MAQ: MAQ between SAQbetween g 1 g = Anzahl Gruppen MAQ within SAQwithin Ng N = Anzahl Fälle insgesamt 12 Gruppenunterschiede – einfache und multiple Varianzanalyse Testgröße ist dann: MAQ between F MAQ within oder SAQbetween g 1 F SAQwithin Ng Der F-Wert wird mit tabellierten kritischen F-Werten verglichen (nachschauen α, Freiheitsgrade Zähler = g – 1; Freiheitsgrade Nenner = N – g): • falls unser F-Wert > dem tabellierten Wert Ablehnung von H0 • falls unser F-Wert ≤ dem tabellierten Wert Beibehalt von H0 13 Gruppenunterschiede – einfache und multiple Varianzanalyse 7. Bei Ablehnung von H0 wissen wir, dass mindestens ein Populationsmittelwert von den anderen verschieden ist. Aber wo liegen die Unterschiede? anschließender Test, z.B. DUNCAN-Test: Welche Sets von Mittelwerte unterscheiden sich signifikant und welche nicht? 14 Gruppenunterschiede – einfache und multiple Varianzanalyse Multiple oder mehrfaktorielle Varianzanalyse 1. Erweiterung: Wir haben nicht mehr nur einen Faktor (z.B. mütterlicher Bildungsstand), sondern mehrere, die gleichzeitig auf die abhängige quantitative Variablen wirken (z.B. zusätzlich Zugehörigkeit zu Kindergarten A, B oder C). Was wirkt sich aus: • mütterlicher Bildungsstand (Haupteffekt) • Zugehörigkeit zu einem Kindergarten (Haupteffekt) • besondere Wechselwirkungen zwischen Bildungsstand und Kindergartenzugehörigkeit (Interaktionseffekt) 15 Gruppenunterschiede – einfache und multiple Varianzanalyse 2. Haupteffekte und Interaktionseffekte sollen unabhängig sein (Sonderfall gleiche Zellenbesetzungen – orthogonales Design; geht aber auch sonst) 3. Formalisiert: Nullhypothesen • HBildung 0: Bildungsstand hat keinen Effekt, • HZugehörigkeit 0: Zugehörigkeit hat keinen Effekt, • HInteraktion 0: es gibt keine Wechselwirkungen • sowie die entsprechenden Alternativhypothesen. 16 Gruppenunterschiede – einfache und multiple Varianzanalyse 3. Idee ist wieder, Unterschiede zwischen Gruppenmittelwerden in Beziehung zu den Unterschieden innerhalb der Gruppen zu setzen. 4. Dazu berechnen wir: • • • • Abweichungen der Gruppenmittelwerte im mütterlichen Bildungsstand vom Gesamtmittelwert (SAQBildung) Abweichungen der Gruppenmittelwerte der verschiedenen Kindergärten vom Gesamtmittelwert (SAQZugehörigkeit) Abweichungen der Gruppenmittelwerte einer Kombination (z.B. niedriger Bildungsstand in Kindergarten A) von dem, was man bei additiven Effekten erwarten kann (Summe der Mittelwerte in den Variablen Bildungsstand und Zugehörigkeit minus Gesamtmittelwert) (SAQInteraktion) restliche Abweichungen innerhalb jeder Kombination (SAQResidual) 17 Gruppenunterschiede – einfache und multiple Varianzanalyse Es werden dann die jeweiligen mittleren Abweichungsquadrate (MAQ) gebildet: • MAQBildung = SAQBildung / dfBildung mit dfBildung = Anzahl Kategorien Bildung – 1 • MAQZugehörigkeit = SAQZugehörigkeit / dfZugehörigkeit mit dfZugehörigkeit = Anzahl Kategorien Zugehörigkeit - 1 • MAQInteraktion = SAQInteraktion / dfInteraktion mit dfInteraktion = dfBildung x dfZugehörigkeit • MAQResidual = SAQResidual / dfResidual mit dfResidual = N – (Anzahl Kategorien Bildung x Anzahl Kategorien Zugehörigkeit) 18 Gruppenunterschiede – einfache und multiple Varianzanalyse • Für das Testen einer Quelle für Unterschiedie werden jeweils die MAQ dieser Quelle durch die MAQResidual dividiert (F-Wert). • Der kritische F-Wert wird bestimmt durch α, df der Quelle (df Zähler) und dfResidual (df Nenner) 19 Gruppenunterschiede – einfache und multiple Varianzanalyse • Beispiel: MAQB ildung FB ildung MAQ Re sidual Nachschauen in F-Tabelle für α,df Zähler und df Nenner • falls unser F-Wert > dem tabellierten Wert Ablehnung von H0 • falls unser F-Wert ≤ dem tabellierten Wert Beibehalt von H0 20 Gruppenunterschiede – Kovarianzanalyse Kovarianzanalyse 1. Problemstellung: Vergleich des Sozialverhaltens von Kindern aus einer Experimentalund einer Kontrollgruppe bei evtl. unterschiedlicher Ausgangslage Beispiel: Evaluation des „Kindergartens der Zukunft in Bayern – KiDZ“ 2. t-Test oder Varianzanalyse geben nur eine unbefriedigende Antwort auf die Forschungsfrage. 3. Gewünscht: nachträgliche „Angleichung“ der Ausgangslage der Kinder 21 Gruppenunterschiede – Kovarianzanalyse 4. Sprachgebrauch: Die Variable, in der die Kinder „angeglichen“ werden sollen, wird Kovariate genannt. 5. Grundidee: Wir filtern den Effekte der Kovariaten aus der abhängigen Variablen heraus und führen mit der „bereinigten“ abhängigen Variablen eine einfache Varianzanalyse (Faktor: Zugehörigkeit zur Experimental- oder Kontrollgruppe) durch. 6. Herausfiltern technisch: Wir führen eine Regression der abhängigen Variablen auf die Kovariate durch und berechnen die Residualvariable. 22 Gruppenunterschiede – Kovarianzanalyse 7. Vielfältige Erweiterungsmöglichkeiten: • mehrere Kovariaten • mehrere Faktoren • mehrere Kriterien gleichzeitig 23 Zusammenhänge – Korrelation 1. Fragestellung • Gibt es einen Zusammenhang zwischen zwei quantitativen Variablen? • Beispiel: Zusammenhang zwischen Körpergröße und Gewicht = Frage nach dem durchschnittlichen Zusammenhang: Ist im Durchschnitt jemand, der schwerer als der Durchschnitt ist, auch größer als der Durchschnitt? pos. Zusammenhang Ist im Durchschnitt jemand, der schwerer als der Durchschnitt ist, kleiner als der Durchschnitt? neg. Zusammenhang 24 Zusammenhänge – Korrelation • Zusammengang meint damit das Überwiegen von gleichläufigen oder gegenläufigen Abweichungen vom Mittelwert 2. Technische Umsetzung: Korrelation (genauer: Produkt-Moment-Korrelation) • Bildung der Kreuz-Produkt-Summe ( x x) ( y y ) i i i • Problem: Kreuz-Produkt-Summe ist abhängig von n, deshalb Division durch = Kovarianz = sxy ( x x) ( y i i y) i n 25 Zusammenhänge – Korrelation • Problem: Kovarianz hängt von den Skalen von x und y ab. Um die unterschiedlichen Skalen herauszubekommen, wird durch die Standardabweichungen von x und y dividiert. Dadurch liegt der Korrelationskoeffizient immer zwischen -1 und +1; d.h., er ist auf diesen Bereich standardisiert: ( x x) ( y y ) i rxy i i n sx sy 26 Zusammenhänge – Korrelation 3. Besonderheiten der Korrelation • Korrelation sagt nichts über Kausalität aus! • rxy = standardisiertes Maß. Es verändert sich nicht bei Standardisierung der Variablen. • Das Vorzeichen gibt die Richtung an. • Die Zahl sagt „etwas“ zur Größe des Zusammenhangs aus; man kann sagen, welcher Zusammenhang größer ist. • Absolutes Maß für einen Zusammenhang ist das Quadrat von rxy (Anteil der gemeinsamen Varianz). • rxy gilt nur für lineare Zusammenhänge. 27 Zusammenhänge – Regression 1. Fragestellung • Kann ich aufgrund der Werte einer Variablen (x) die Werte in einer anderen Variablen (y) vorhersagen, schätzen? • Beispiel: Kann ich aufgrund der Intelligenz eines Kindes sein Sozialverhalten vorhersagen? • x wird Prädiktor und y Kriterium genannt. • y wird kaum exakt vorgesagt werden können. Wir können nur schätzen; die Schätzvariable wird mit ŷ bezeichnet. 28 Zusammenhänge – Regression • Eine Schätzung ist dann gut, wenn für jeden Fall die Differenz zwischen gegebenem Wert yi und dem Schätzwert ŷi (aufgrund der Kenntnis von xi) klein ist, d.h. für alle Fälle muss (ŷi – yi) minimiert werden, da sich bei der Summenbildung Abweichungen nach oben und unten ausgleichen, wird über alle Fälle (ŷi – yi)2 minimiert = Kleinstquadratkriterium. • Im Folgenden beschränkt auf lineare Beziehungen. 29 Zusammenhänge – Regression 2. Technische Umsetzung: • Im Falle einer linearen Gleichung liegen für alle Fälle i die Schätzwerte auf der Gerade: ŷi bxi a mit b = Steigung der Geraden und a = Schnittpunkt auf der y-Achse • • • • • Gesucht sind dann a und b so, dass die Summe aller Abweichungsquadrate (ŷi – yi)2 minimiert wird. Mathematisch letztlich einfach und bekannt: Bilden der 1. Ableitung usw. b = sxy2 / sx2; a = y¯ – bx¯. b = Regressionskoeffizient = Um wie viele Einheiten verändert sich ŷi, wenn ich x um eine Einheit verändere. a = Regressionskonstante, gleicht die unterschiedlichen Ska-len von x und y aus. 30 Zusammenhänge – Regression 3. Besonderheiten der Regression: • a und b hängen davon ab, was Prädiktor und was Kriterium ist. • Anders als bei der Korrelation: a und b ändern sich, wenn die Variablen standardisiert werden. Im Fall der einfachen Regression mit nur einem Prädiktor a = 0 und b = rxy. • Anteil der erklärten Varianz = rxy2 • Anteil der nicht erklärten Varianz = 1 - rxy2 31 Zusammenhänge – Regression 4. Besonderheiten der multiplen Regression: • Um ein Kriterium y angemessen vorhersagen zu können, benötigt man in der Realität mehrere Prädiktoren x1 bis xn. • In der Realität korrelieren Prädiktoren miteinander. Wir sind aber speziell auch an den jeweils eigenständigen Beiträgen der Prädiktoren interessiert. • Gleichzeitig ist aber auch die gesamte Erklärungskraft eines Satzes von Prädiktoren wichtig. 32 Zusammenhänge – Regression • Die multiple Regressionsrechnung gibt uns für jeden Prädiktor k einen Regressionskoeffizienten bk, der die eigenständige Bedeutung indiziert (bildlich = wenn alle anderen Prädiktoren gleich wären). • Ebenfalls erhalten wir einen Wert für die Gesamtbedeutung: R2 = Anteil der im Kriterium durch alle Prädiktoren gemeinsam erklärten Varianz. • Die bk hängen jeweils von den Skalengrößen ab (schwierig zu interpretieren) Standardisierung aller Variablen ßk 33 Zusammenhänge – Regression • -1 ≤ ßk ≤ Um wie viele Standardeinheiten verändert sich y, wenn ich den Prädiktor k um eine Standardeinheit verändere. • Achtung: In der multiplen Regression sind die Regressionskoeffizienten aus Analysen mit standardisierten Variablen nicht mehr identisch mit den Korrelation. 34 Zusammenhänge – Regression Hierarchische Regression 1. Oftmals sind wir daran interessiert, was verschiedene (Teil-) Blöcke von Prädiktoren für eine gemeinsame Bedeutung haben. 2. Evtl. ist auch von Bedeutung, was ein Block dann noch erklärt, wenn andere schon berücksichtigt sind. 3. Grundidee der hierarchischen Regression: Blöcke werden nacheinander betrachtet. Bei dem jeweils späteren Block wird nur das berücksichtig, was der vorherige nicht bereits erklärt hat. 35