Lineare Regressionsanalyse mit SPSS von Susanne Konrath

Werbung

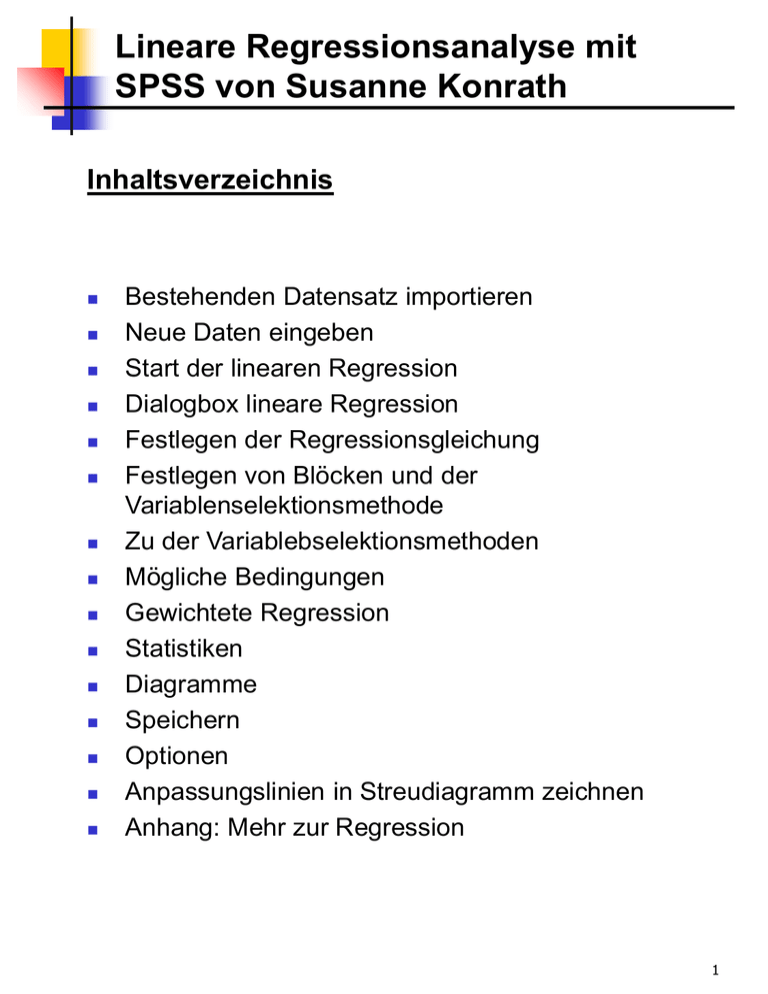

Lineare Regressionsanalyse mit SPSS von Susanne Konrath Inhaltsverzeichnis Bestehenden Datensatz importieren Neue Daten eingeben Start der linearen Regression Dialogbox lineare Regression Festlegen der Regressionsgleichung Festlegen von Blöcken und der Variablenselektionsmethode Zu der Variablebselektionsmethoden Mögliche Bedingungen Gewichtete Regression Statistiken Diagramme Speichern Optionen Anpassungslinien in Streudiagramm zeichnen Anhang: Mehr zur Regression 1 Bestehenden Datensatz importieren Nach dem Start von SPSS öffnet sich automatisch der Daten-Editor Es können hier bestehende Daten mit Hilfe der Menüwahl Datei>Öffnen>Daten geladen werden. Es können verschiedene Dateitypen geladen werden. Der Import wird durch eine Dialogbox gesteuert. 2 Neue Daten eingeben Neue Variablen können mit der Registerkarte „Variablenansicht“ am unteren Rand des Spreadsheets definiert werden. Die neuen Daten können dann in der „Datenansicht“ eingegeben werden. Variablendefinition Dateneingabe 3 Start der linearen Regression Auswahl des Menüpunktes „Linear...“ unter Analysieren Regression Linear... 4 Dialogbox lineare Regression Es öffnet sich die Dialogbox „Lineare Regression“ Alle zur Verfügung stehenden Variablen befinden sich im linken Feld Zur Variablenselektion ist die Methode Einschlußverfahren voreingestellt 5 Festlegen der Regressionsgleichung Die abhängige Variable (hier: y) und die unabhängigen Variablen (hier: x1, x2) werden durch ziehen mit der Maus in die dafür vorgesehenen Felder eingefügt Der Intercept (hier: x0) muß nicht extra mit in die Modellgleichung aufgenommen werden 6 Festlegen von Blöcken und der Variablenselektionsmethode Bestimmung von Variablenblöcken Einstellung des Verfahrens zur Variablenselektion pro Block Durch die Auswahl der Methode kann festgelegt werden, wie unabhängige Variablen in die Analyse eingeschlossenen werden. Die verfügbaren Methoden sind: Einschluß Auschluß Vorwärts Rückwärts Schrittweise Es besteht die Möglichkeit die unabhängigen Variablen in Blöcke zusammenzufassen. Es können dann verschiedene Methoden für unterschiedliche Untergruppen von Variablen angegeben werden. Beispielsweise kann man einen Block von Variablen durch schrittweises Auswählen und einen zweiten Block durch Vorwärtsselektion in das Regressionsmodell einschließen. 7 Zu den Variablenselektionsmethoden Einschluß Alle unabhängigen Variablen des Blockes werden auf einmal in die Analyse einbezogen. Auschluß Um die Variablen in einem einzigen Schritt aus dem Block zu entfernen Schrittweise Methoden Vorwärts Es werden nacheinander die Variablen des Blockes mit dem höchsten partiellen Korrelationskoeffizienten mit der abhängigen Variablen in die Gleichung aufgenommen Rückwärts Zunächst werden alle unabhängige Variablen des Blockes in einem einzigen Schritt in die Gleichung eingeschlossen und anschließend diejenigen Variablen mit dem kleinsten partiellen Korrelationskoeffizienten mit der abhängigen Variablen nacheinander entfernt soweit der zugehörige Regressionskoeffizient nicht signifikant ist (Signifikanzniveau: 0,1) Schrittweise Funktioniert ähnlich wie die Vorwärtsmethode. Allerdings werden nach jedem Schritt die jeweils aufgenommenen Variablen nach der Rückwärtsmethode untersucht. 8 Mögliche Bedingungen (optional) Es kann eine Auswahlvariable zum Begrenzen der Analyse auf eine Untergruppe von Fällen mit einem bestimmten Wert oder bestimmten Werten für diese Variable angegeben werden. Es können Variablen zur Fallunterscheidung unter Fallbeschriftungen ausgewählt werden, um Punkte in Diagrammen zu identifizieren. 9 Gewichtete Regression (optional) Gewichtete kleinste Quadrate (WLS) geben Beobachtungen verschiedene Gewichtungen, zum Beispiel zum Ausgleich unterschiedlicher Meßgenauigkeit. Als Gewicht kann nur eine numerische Variable verwendet werden Die effektive Stichprobengröße wird nicht geändert. 10 Statistiken Regressionskoeffizienten Mit Schätzer werden die Regressionskoeffizienten B = Betadach, die Standardfehler von B, das Beta des standardisierten Koeffizienten?, die t-Werte für B und das zweiseitige Signifikanzniveau von t angezeigt. ->Viewer: Koeffizienten Mit Konfidenzintervalle werden die individuellen 95%Konfidenzintervalle für jeden Regressionskoeffizienten angezeigt. ->Viewer: Koeffizienten Mit Kovarianzmatrix wird eine Varianz-Kovarianz-Matrix und die Korrelationsmatrix der Regressionskoeffizienten angezeigt ->Viewer: Korrelation der Koeffizienten 11 Statistiken Anpassungsgüte des Modells Die aufgenommenen und entfernten Variablen aus dem Modell werden aufgelistet ->Viewer: Aufgenommene/Entfernte Variable Die folgenden Statistiken der Anpassungsgüte werden angezeigt: multiples R, R-Quadrat und korrigiertes R-Quadrat, Standardfehler des Schätzers ->Viewer: Modellzusammenfassung Und die Tabelle zur Varianzanalyse. ->Viewer: ANOVA Änderung in R-Quadrat Hier werden Änderung in R-Quadrat, Änderung in F und die Signifikanz der Änderung in F angezeigt. (siehe z.B. Toutenburg, LINEARE MODELLE, 2. Auflage, 2003, S147f.) ->Viewer: Modellzusammenfassung, Änderungsstatistiken Deskriptive Statistik Liefert die Anzahl gültiger Fälle, Mittelwert und Standardabweichung für jede Variable in der Analyse. ->Viewer: Deskriptive Statistiken Außerdem wird eine Korrelationsmatrix der Variablen nach Pearson mit einem einseitigen Signifikanzniveau und die Anzahl der Fälle für jede Korrelation angezeigt. ->Viewer: Korrelationen 12 Statistiken Teil- und partielle Korrelationen Hiermit werden Korrelationen nullter Ordnung, Teil- und partielle Korrelationen ? angezeigt. ->Viewer: Koeffizienten, Korrelationen Kollinearitätsdiagnose Eigenwerte der skalierten und unzentrierten Kreuzproduktmatrix, Konditionsindex, Proportionen der Varianzzerlegung ->Viewer: Kollinearitätsdiagnose Varianzfaktoren (VIF), Toleranzen für einzelne Variablen ->Viewer: Koeffizienten Residuen Durbin-Watson-Test für Reihenkorrelationen der Residuen ->Viewer: Modellzusammenfassung Fallweise Diagnose für die Fälle, die das Auswahlkriterium (Ausreißer über n Standardabweichungen) erfüllen werden standardisierte, nichtstandardisierte Residuen, nichtstandardisierter Vorhersagewert ausgegeben. ->Viewer: Fallweise Diagnose 13 Diagramme Streudiagramme Es können je zwei der folgenden Elemente aufgetragen werden: DEPENDENT *ZPRED *ZRESID *DRESID *ADJPRED *SRESID *SDRESID die abhängige Variable Y standardisierte vorhergesagte Werte für Y standardisierte Residuen ausgeschlossene Residuen korrigierte vorhergesagte Werte studentisierte Residuen studentisierte ausgeschlossene Residuen Es können mehrere Streudiagramme im Feld „Streudiagramm 1 von 1“ über die Schaltfläche Weiter erzeugt werden. 14 Diagramme Alle partiellen Diagramme erzeugen. Erzeugt Streudiagramme der Residuen aller unabhängigen Variablen und der Residuen der abhängigen Variablen, wenn für den Rest der unabhängigen Variablen beide Variablen einer getrennten Regression unterzogen werden. Zum Erzeugen eines partiellen Diagramms müssen mindestens zwei unabhängige Variablen in der Gleichung enthalten sein. Diagramme der standardisierten Residuen. Histogramme standardisierter Residuen Normalverteilungsdiagramme, welche die Verteilung standardisierter Residuen mit einer Normalverteilung vergleichen. Bemerkung: Beim Anfordern von Diagrammen werden Auswertungsstatistiken für standardisierte vorhergesagte Werte und standardisierte Residuen (*ZPRED und *ZRESID) angezeigt. 15 Speichern Mit jedem Auswahlvorgang werden der Datendatei die ausgewählten Größen als neue Variablen hinzugefügt. Vorhergesagte Werte. Dies sind die nach dem Regressionsmodell für die abhängige Variable vorhersagten Werte. Nicht standardisiert (pre*) Standardisiert (zpr*) Korrigiert (adj*) Standardfehler des Mittelwerts (sep*) ->Viewer: Residuenstatistik 16 Speichern Distanzen Dies sind Maße zum Auffinden von Fällen mit ungewöhnlichen Wertekombinationen bei der unabhängigen Variablen und von Fällen, die einen großen Einfluß auf das Modell haben könnten. Mahalanobis (mah*) Nach Cook (coo*) Hebelwerte (lev*) ->Viewer: Residuenstatistik Vorhersageintervalle Die oberen und unteren Grenzen sowohl für Mittelwert als auch für einzelne Vorhersageintervalle. Mittelwert (lmci*,umci*) Individuell (lici*,uici*) Konfidenzintervall 17 Speichern Residuen Der tatsächliche Wert der abhängigen Variablen minus dem vorhergesagten Wert aus der Regressionsgleichung. Nicht standardisiert (res*) Standardisiert (zre*) Studentisiert (sre*) Ausgeschlossen (dre*) Studentisiert, ausgeschlossen (sdr*) ->Viewer: Residuenstatistik Einflußstatistiken Die Änderung in den Regressionskoeffizienten und vorhergesagten Werten, die sich aus dem Ausschluß eines bestimmten Falls ergibt. DfBeta: (dfb0*,dfb1*, ...) Regressionskoeffizienten Standardisierte(s) DfBeta: (sdb0*,sdb1*, ...) DfFit: (dff*) vorhergesagten Werten Standardisiertes DfFit (sdf*) Kovarianzverhältnis: (cov*) Dies ist das Verhältnis der Determinante der Kovarianzmatrix für einen bestimmten ausgeschlossenen Fall zur Determinante der Kovarianzmatrix für alle Fälle. 18 Speichern In neuer Datei speichern Hiermit werden Regressionskoeffizienten in einer anzugebenen Datei gespeichert. Modellinformation in XML-Datei exportieren Hiermit werden Modellinformationen in die angegebene Datei exportiert. Diese Datei kann von SPSSZusatzprodukten wie SmartScore und zukünftigen Versionen von WhatIf? verwendet werden. 19 Optionen Kriterien für schrittweise Methode. Diese Optionen eignen sich für den Fall, daß die Vorwärts, Rückwärts- oder schrittweise Methode der Variablenauswahl angegeben wurde. Variablen im Modell werden eingeschlossen/entfernt in Abhängigkeit von F-Wahrscheinlichkeit, d.h. der Signifikanz (Wahrscheinlichkeit) des F-Werts F-Wert 20 Optionen Konstante in Gleichung einschließen Als Voreinstellung enthält das Regressionsmodell einen konstanten Term (intercept). Wenn diese Option deaktiviert ist, wird die Regression durch den Ursprung gezwungen. Achtung: Manche Resultate einer durch den Ursprung verlaufenden Regression lassen sich nicht mit denen einer Regression vergleichen, die eine Konstante aufweist. Beispielsweise kann R-Quadrat nicht in der üblichen Weise interpretiert werden. Tip: Option deaktivieren und Intercept eigenhändig als Variable einfügen. Dies führt zur vollständigen Ausgabe der Kovarianzmatrix und der Korrelationsmatrix Fehlende Werte Listenweiser Fallausschluß. Nur Fälle mit gültigen Werten für alle Variablen werden in die Analyse einbezogen. Paarweiser Fallausschluß. Fälle mit vollständigen Daten für das korrelierte Variablenpaar werden zum Berechnen des Korrelationskoeffizienten verwendet, auf dem die Regressionsanalyse basiert. Durch Mittelwert ersetzen. Alle Fälle werden für Berechnungen verwendet, wobei der Mittelwert der Variablen die fehlenden Beobachtungen ersetzt. 21 Anpassungslinien in Streudiagramm zeichnen Doppelklick auf das Streudiagramm, dann Diagramme Optionen... 22 Anhang: Mehr zur Regression Folgende Menüpunkte stehen zur Verfügung unter Analysieren Regression Linear... Abhängige Variable: Unabhängige Variablen: intervallskaliert / ordinalskaliert. beliebiges Skalenniveau 23 Anhang: Mehr zur Regression Kurvenanpassung... Mit der Prozedur "Kurvenanpassung" werden Regressionsstatistiken zur Kurvenanpassung und zugehörige Diagramme für 11 verschiedene Regressionsmodelle zur Kurvenanpassung erstellt. Binär logistisch... Binär logistisch... Abhängige Variable: Unabhängige Variablen: Multinomial logistisch... Abhängige Variable: Unabhängige Variablen: dichotom, d.h. 2 Kategorien beliebiges Skalenniveau mehr als 2 Kategorien, nominal nominal / ordinal Ordinal... (ab V.10.0) Abhängige Variable: mehr als 2 Kategorien, ordinal Unabhängige Variablen: nominal / ordinal Probit... Dosis-Wirkungskurven-Analyse. Diese Prozedur mißt die Beziehung zwischen der Stärke eines Stimulus und dem Anteil der Fälle, die eine bestimmte Response auf den Stimulus zeigen. 24 Anhang: Mehr zur Regression Nichtlinear... Mit der nichtlinearen Regression können Modelle mit willkürlichen Beziehungen zwischen den abhängigen und unabhängigen Variablen geschätzt werden. Dies wird durch den Einsatz eines iterativen Schätzungsalgorithmus erreicht. Gewichtungsschätzung... Bei Verletzung der Varianzhomogenität liefert die lineare Regression unter Verwendung der gewöhnlichen kleinsten Quadrate keine optimalen Modellschätzungen. Wenn die Differenzen in der Variabilität von einer anderen Variablen vorhergesagt werden können, dann können die Koeffizienten eines linearen Regressionsmodells mit der Prozedur "Gewichtungsschätzung" unter Verwendung von gewichteten kleinsten Quadraten (WLS) berechnet werden. Dabei wird den genaueren Beobachtungen (jene mit kleinerer Variabilität) ein größeres Gewicht beim Bestimmen der Regressionskoeffizienten zugewiesen. Mit der Prozedur "Gewichtungsschätzung" werden eine Reihe von Gewichtungstransformationen getestet, und es wird angezeigt, welche die beste Anpassung an die Daten ergibt. Zweistufige kleinste Quadrate... Standardmodelle für die lineare Regression gehen davon aus, daß Fehler in der abhängigen Variablen nicht mit den unabhängigen Variablen korrelieren. Ist dies nicht der Fall (zum Beispiel, wenn zwischen den Variablen eine Wechselwirkung besteht), dann liefert die lineare Regression unter Verwendung von gewöhnlichen kleinsten Quadraten keine optimalen Modellschätzungen mehr. Man verwendet die zweistufige Regressionsmethode der kleinsten Quadrate. 25 Anhang: Mehr zur Regression Optimale Skalierung... Durch die kategoriale Regression werden kategoriale Daten quantifiziert, indem den Kategorien numerische Werte zugewiesen werden. Dadurch ergibt sich für die transformierten Variablen eine optimale lineare Regressionsgleichung. Das Standardverfahren der linearen Regressionsanalyse beinhaltet die Minimierung der Summe von quadrierten Differenzen zwischen einer Antwortvariablen (abhängig) und einer gewichteten Kombination von Einflußvariablen (unabhängig). Variablen sind in der Regel quantitativ, wobei (nominale) kategoriale Daten in Binär- oder Kontrastvariablen umkodiert werden. Infolgedessen dienen kategoriale Variablen einer Aufteilung in verschiedene Gruppen von Fällen, so daß jeweils separate Parametersätze für jede Gruppe geschätzt werden. Die geschätzten Koeffizienten geben die Auswirkung einer Änderung in den Einflußvariablen auf die Antwortvariable wider. Die Antwort kann für jede beliebige Kombination von Einflußwerten vorhergesagt werden. Eine andere Methode besteht darin, daß die Antwort auf die kategorialen Einflußwerte selbst einer Regression unterzogen wird. Folglich wird für jede Variable ein Koeffizient geschätzt. Bei kategorialen Variablen sind die Kategoriewerte jedoch willkürlich. Durch verschiedene Kodierungsarten der Kategorien ergeben sich jeweils unterschiedliche Koeffizienten, wodurch ein analysenübergreifender Vergleich gleicher Variablen erschwert wird. CATREG erweitert die Standardmethode durch eine gleichzeitige Skalierung nominaler, ordinaler und numerischer Variablen. Die Prozedur quantifiziert kategoriale Variablen, so daß in den Quantifikationen die Merkmale der ursprünglichen Kategorien zum Ausdruck kommen. Dadurch werden quantifizierte kategoriale Variablen auf dieselbe Weise wie numerische Variablen behandelt. Durch die Verwendung nichtlinearer Transformationen können Variablen auf einer Vielzahl von Ebenen analysiert und somit das jeweils geeignetste Modell gefunden werden. 26