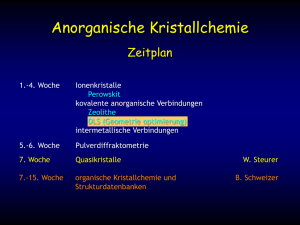

y - Empirische Wirtschaftsforschung und Ökonometrie

Werbung

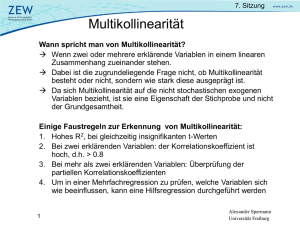

Sitzung 2 Einfache Regressionsgleichung Ökonomische Theorie leitet Beziehungen zwischen unterschiedlichen ökonomischen Variablen ab Ziel der Ökonometrie: Verifizierung und Quantifizierung der abgeleiteten theoretischen Beziehung Beispiel: Wodurch und in welchem Ausmaß werden individuelle Löhne bestimmt? durch Ausbildung, Berufserfahrung? durch das Geschlecht ? 1 Alexander Spermann WS 2007/2008 Sitzung 2 Einfache Regressionsgleichung Beispiel: y = Lohn x = Schuljahre Ökonomische Theorie lässt positive Beziehung zwischen beiden Variablen vermuten allgemein: z.B. lineare Beziehung y = f(x) y= + x (Ökonomisches Modell) Quelle: Dougherty 2 Alexander Spermann WS 2007/2008 Sitzung 2 Einfache Regressionsgleichung reale Beobachtungen werden kaum auf einer Gerade liegen x ist eine nicht-stochastische exogene Variable yi = + xi + ui (Ökonometrisches Modell); i = 1,..., n (= 4) y = abhängige Variable, x = erklärende Variable u = Störterm (error term), erfasst zufällige sowie nicht beobachtbare Einflussfaktoren, die auf y wirken 3 Alexander Spermann WS 2007/2008 Sitzung 2 Einfache Regressionsgleichung - die Gauss-Markov Bedingungen Der Annahmen der Methode der kleinsten Quadrate liegen folgende Gauss-Markov Bedingungen zugrunde: 1. Bedingung: Durchschnittswert der Störterme gleich Null 2. Bedingung: Störterme Homoskedastizität = gleiche Varianz der 3. Bedingung: den Keine Autokorrelation (autocorrelation) zwischen Störtermen 4. Bedingung: erklärenden 4 Der Störterm soll unabhängig verteilt von den Variablen sein Alexander Spermann WS 2007/2008 Sitzung 2 Einfache Regressionsgleichung Ökonometr. Modell: yi xi ui zufällige Komponente nicht zufällige Komponente u Zufallsvariable y ebenfalls Zufallsvariable E(y) = E( + x + u) = E( + x) + E(u) = + x lineare Beziehung zwischen E(y) und x y = E(y) + u Var(y) = E(y - E(y))2 = E(y - - x)2 = E(u)2 = Var(u) 5 Alexander Spermann WS 2007/2008 Sitzung 2 Einfache Regressionsgleichung – 1. Gauss-Markov (GM) Bedingung 1. Gauss-Markov Bedingung: E(ui lxi) = 0 Durchschnittswert der Störterme gleich Null E( y i ) xi Quelle: Gujarati Intuition: Die positiven Störterm-Werte gleichen die negativen ui-Werte aus, so dass der Durchschnittswert bezogen auf y Null ist. 6 Alexander Spermann WS 2007/2008 Sitzung 2 Einfache Regressionsgleichung – 2. Gauss-Markov Bedingung (1) 2. Gauss-Markov Bedingung: Homoskedastizität oder gleiche Var(ui|xi) = E[ui -E(ui)]² = E(ui)² wegen GM1 = ², z.B. ² = 5 Varianz der Störterme. E( y i ) xi Quelle: Gujarati 7 Alexander Spermann WS 2007/2008 Sitzung 2 Einfache Regressionsgleichung – 2. Gauss-Markov Bedingung (2) Zum Vergleich: Heteroskedastizität: konst. Var(ui|xi) = i² , d.h. Var ≠ E( y i ) xi Quelle: Gujarati 8 Alexander Spermann WS 2007/2008 Sitzung 2 Einfache Regressionsgleichung – 3. Gauss-Markov Bedingung Cov(ui,uj) = E[ui -E(ui)] E[uj - 3. Gauss-Markov Bedingung: E(uj)] = E[ui uj] Keine Autokorrelation zwischen den Störtermen =0 wegen GM1 i ≠j Beispiel: Positive Autokorrelation Negative Autokorrelation keine Autokorrelation Quelle: Gujarati 9 Alexander Spermann WS 2007/2008 Sitzung 2 Einfache Regressionsgleichung – 4. Gauss-Markov Bedingung 4. Gauss-Markov Bedingung: Kovarianz Null zwischen u und x : Cov(x, u) = 0. Intuition: Störterm und erklärende Variablen sind in verschiedenen Perioden (Zeitreihe) bzw. über verschiedene Individuen (Querschnitt) unabhängig voneinander. Der Störterm fängt alle fehlenden Variablen auf. Besonderheit: GM4 ist automatisch erfüllt, wenn x keine Zufallsvariable, d.h. nicht zufällig oder nicht stochastisch ist, oder GM1 gilt. 10 Alexander Spermann WS 2007/2008 Sitzung 2 Einfache Regressionsgleichung – GM und Zentrales Grenzwerttheorem Annahme der Normalverteilung (normality assumption) der Störterme f (u )ui: i n sehr groß n groß n klein 0 ui Zentrales Grenzwerttheorem (central limit theorem): die theoretische Rechtfertigung für die Annahme der Normalverteilung von ui. Aussage zur Angleichung an Normalverteilung mit steigendem n: „Wenn eine Zufallsvariable X den Durchschnittswert und die Varianz 2 hat, dann wird die Verteilung der Stichprobe von X normal, wenn die Anzahl der Observationen n zunimmt.“ gilt auch für die Verteilung der Störterme ui 11 Alexander Spermann WS 2007/2008 Sitzung 2 Einfache Regressionsgleichung Ökonometrisches Modell: yi = + xi + ui , i = 1,..., n Ziel: Schätzwerte a und b für „wahre“ Parameter und geschätzte Werte sind dann: ŷi=a+bxi a und b sind die Schätzer für Quelle: Dougherty 12 Alexander Spermann WS 2007/2008 Sitzung 2 Einfache Regressionsgleichung 1. ei y i yˆ i 2. ei y i a bx i 3. S e12 e22 e32 e42 OLS = Ordinary Least Squares = Methode der kleinsten Quadrate Minimiere S (Ableiten nach a und b) ! ŷi=a+bxi = Kleinstquadratvorhersagen ei = Kleinstquadratresiduen Quelle: Dougherty 13 Alexander Spermann WS 2007/2008 Sitzung 2 Einfache Regressionsgleichung Kleinstquadrat- oder OLS-Schätzer: aOLS und bOLS sind Schätzer für die wahren Parameter und n ( y i y )( xi x ) bOLS i 1 n ( xi x ) 2 Stichprobe nkovarianz Cov(x, y) 2 Stichprobe nvarianz s xx i 1 aOLS y b x 14 Alexander Spermann WS 2007/2008 Sitzung 2 Einfache Regressionsgleichung 15 Alexander Spermann WS 2007/2008 Sitzung 2 Einfache Regressionsgleichung – Streudiagramm Streudiagramm (scatterplot) für: 16 Alexander Spermann WS 2007/2008 Sitzung 2 Interpretation der Koeffizienten in empirischen Schätzgleichungen Lineares Modell: y = + x + u y x gibt an, um wie viel Einheiten sich y verändert , wenn x sich um eine Einheit verändert 17 Alexander Spermann WS 2007/2008 Sitzung 2 Interpretation der Koeffizienten in empirischen Schätzgleichungen Logarithmisches Modell: ln( y) = + ln(x) + u ln y y / y ln x x / x gibt an, um wie viel Prozent sich y verändert , wenn x sich um ein Prozent verändert 18 Alexander Spermann WS 2007/2008 Sitzung 2 Interpretation der Koeffizienten in empirischen Schätzgleichungen Semi-Logarithmisches Modell: ln(y) = + x + u ln y y / y x x gibt an, um wie viel Prozent sich y verändert , wenn x sich um eine Einheit verändert 19 Alexander Spermann WS 2007/2008 Sitzung 2 Interpretation der Koeffizienten in empirischen Schätzgleichungen Lohngleichungen werden üblicherweise als semi-logarithmisches Modell spezifiziert: ln(y)= ln(y0) + ß ·x + ... + u x = Schuljahre ß wird dann als Ertragsrate eines weiteren Schuljahres bzw. Berufserfahrungsjahres interpretiert (ß = „return to education“) 20 Alexander Spermann WS 2007/2008 Sitzung 2 Bestimmtheitsmaß R2 (=Goodness of Fit) 1. aus ei y i yˆ i y i yˆ i ei 2. ( yi y ) 2 ( yˆ i yˆ ) 2 (ei e ) 2 erklärter Anteil der Varianz 2 3. syy 21 unerklärter Anteil der Varianz sy2ˆyˆ 4. TSS ESS Total sum of squares Explained sum of squares 2 see RSS Re sidual sum of squares Alexander Spermann WS 2007/2008 Sitzung 2 Bestimmtheitsmaß R2 2 R s y2ˆyˆ 2 s yy 1 2 see 2 s yy ESS exp lained sum of squares R TSS total sum of squares 2 ( yˆ i yˆ )² ( y i y )² TSS = ESS + RSS ESS RSS 22 } TSS Alexander Spermann WS 2007/2008 Sitzung 2 Bestimmtheitsmaß R2 = 0 Zwischen den Variablen Y und X herrscht keine Beziehung: 23 Alexander Spermann WS 2007/2008 Sitzung 2 Bestimmtheitsmaß R2 = 1 Alle Beobachtungen von Y und X liegen auf der Regressionsgeraden, folglich werden diese vollständig von dem Modell erklärt: 24 Alexander Spermann WS 2007/2008